Curso

La adopción masiva de herramientas como ChatGPT y otras herramientas de IA generativa ha dado lugar a un gran debate sobre las ventajas y los retos de la IA y sobre cómo remodelará nuestra sociedad. Para evaluar mejor estas cuestiones, es importante saber cómo funcionan los llamados Grandes Modelos Lingüísticos (LLM) que están detrás de las herramientas de IA de próxima generación.

Este artículo ofrece una introducción al Aprendizaje por Refuerzo a partir de la Retroalimentación Humana (RLHF), una técnica innovadora que combina técnicas de aprendizaje por refuerzo y orientación humana para ayudar a LLMS como ChatGPT a obtener resultados impresionantes. Trataremos qué es el RLHF, sus ventajas, limitaciones y su relevancia en el futuro desarrollo del vertiginoso campo de la IA generativa. ¡Sigue leyendo!

Comprender el RLHF

Para comprender el papel de los RLHF, primero tenemos que hablar del proceso de formación de los LLM.

La tecnología subyacente de los LLM más populares es un transformador. Desde su desarrollo por investigadores de Google, los transformadores se han convertido en el modelo de vanguardia en el campo de la IA y el aprendizaje profundo, ya que proporcionan un método más eficaz para manejar datos secuenciales, como las palabras de una frase.

Para obtener una introducción más detallada a los LLM y los transformadores, consulta nuestro Curso de Conceptos de Modelos de Lenguaje Amplios (LLM).

Los Transformadores se entrenan previamente con un enorme corpus de texto recogido de Internet mediante aprendizaje autosupervisado, un tipo innovador de entrenamiento que no requiere la acción humana para etiquetar los datos. Los transformadores preentrenados son capaces de resolver una amplia gama de problemas de procesamiento del lenguaje natural (PLN).

Sin embargo, para que una herramienta de IA como ChatGPT proporcione respuestas atractivas, precisas y similares a las humanas, no bastará con utilizar un LLM preentrenado. Al final, la comunicación humana es un proceso creativo y subjetivo. Lo que hace que un texto sea "bueno" está profundamente influido por los valores y preferencias humanos, por lo que es muy difícil de medir o captar mediante una solución algorítmica clara.

La idea que subyace a la ELF es utilizar la información humana para medir y mejorar el rendimiento del modelo. Lo que hace que el RLHF sea único en comparación con otras técnicas de aprendizaje por refuerzo es el uso de la participación humana para optimizar el modelo en lugar de una función predefinida estadísticamente para maximizar la recompensa del agente.

Esta estrategia permite una experiencia de aprendizaje más adaptable y personalizada, lo que hace que los LLM sean adecuados para todo tipo de aplicaciones específicas del sector, como la asistencia de códigos, la investigación jurídica, la redacción de ensayos y la generación de poemas.

¿Cómo funciona el RLHF?

El RLHF es un proceso difícil que implica un proceso de entrenamiento con varios modelos y diferentes etapas de despliegue. En esencia, puede dividirse en tres pasos diferentes.

1. Selecciona un modelo preentrenado

La primera etapa consiste en seleccionar un LLM preentrenado que luego se afinará mediante RLHF.

También podrías preparar tu LLM desde cero, pero es un proceso costoso y que requiere mucho tiempo. Por lo tanto, recomendamos encarecidamente elegir uno de los muchos LLM preformados disponibles para el público.

Si quieres saber más sobre cómo entrenar LLM, nuestro tutorial Cómo entrenar un LLM con PyTorch proporciona un ejemplo ilustrativo.

Ten en cuenta que, para satisfacer la necesidad específica de tu modelo, antes de iniciar la fase de ajuste fino mediante la retroalimentación humana, podrías ajustar tu modelo sobre textos o condiciones adicionales.

Por ejemplo, si quieres desarrollar un asistente jurídico de IA, podrías perfeccionar tu modelo con un corpus de texto jurídico para que tu LLM esté especialmente familiarizado con la redacción y los conceptos jurídicos.

2. Retroalimentación humana

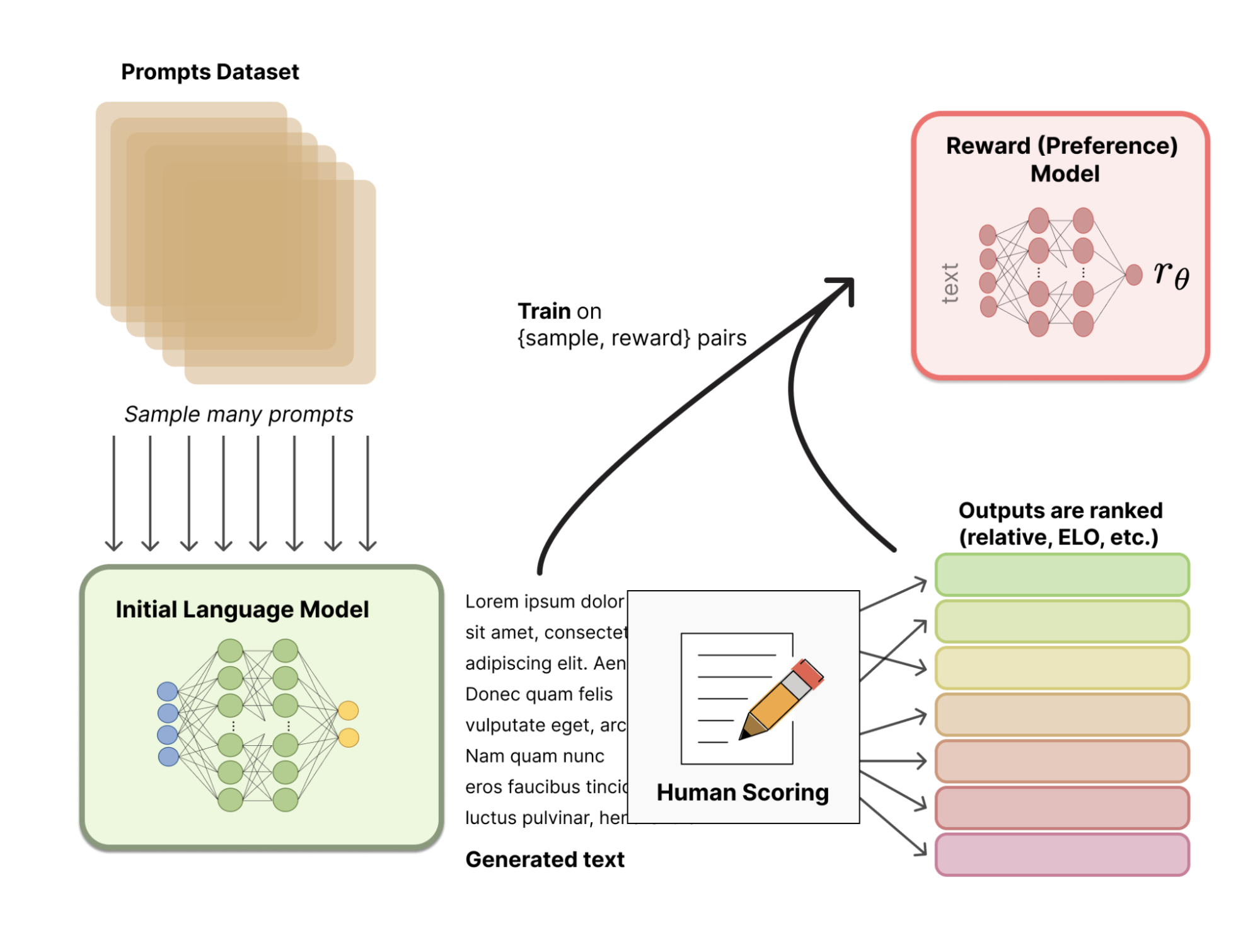

En lugar de utilizar un modelo de recompensa predefinido estadísticamente (que sería muy restrictivo para calibrar las preferencias humanas), RLHF utiliza la retroalimentación humana para ayudar al modelo a desarrollar un modelo de recompensa más sutil. El proceso es el siguiente:

- En primer lugar, el modelo preentrenado crea un conjunto de entrenamiento de pares de texto de entrada/texto generado mediante el muestreo de un conjunto de mensajes.

- A continuación, los probadores humanos dan un rango a los textos generados, utilizando ciertas directrices para alinear el modelo con los valores y preferencias humanos, así como para mantenerlo seguro. A continuación, estas clasificaciones pueden transformarse en resultados de puntuación mediante diversas técnicas, como los sistemas de clasificación Elo.

- Por último, el sistema utiliza la información humana acumulada para evaluar su rendimiento y desarrollar un modelo de recompensa.

La siguiente imagen ilustra todo el proceso:

Fuente: Cara de abrazo

3. Ajuste fino con aprendizaje por refuerzo

En la última etapa, el LLM produce nuevos textos y utiliza su modelo de recompensa basado en la retroalimentación humana para obtener una puntuación de calidad. A continuación, el modelo utiliza la puntuación para mejorar su rendimiento en las siguientes indicaciones.

De este modo, la retroalimentación humana y el ajuste con técnicas de aprendizaje por refuerzo se combinan en un proceso iterativo que continúa hasta que se alcanza un cierto grado de precisión.

Aplicaciones del aprendizaje por refuerzo a partir de la retroalimentación humana

RLHF es una técnica de vanguardia para afinar los LLM, como ChatGPT. Sin embargo, la RLHF es un tema popular, con una creciente literatura que explora otras posibilidades más allá de los problemas de PNL. A continuación encontrarás una lista de otros ámbitos en los que se ha aplicado con éxito el RLHF:

- Chatbots. ChatGPT es el ejemplo más destacado de las posibilidades de RLHF. Para saber más sobre cómo ChatGPT utiliza RLHF, consulta este artículo, '¿Qué es ChatGPT?', donde preguntamos directamente a ChatGPT cómo funciona.

- Robótica. La robótica es una de las principales áreas en las que el RLHF está obteniendo resultados prometedores. El uso de la retroalimentación humana puede ayudar a un robot a realizar tareas y movimientos que pueden ser difíciles de especificar en una función de recompensa. Los investigadores de OpenAI consiguieron enseñar a un robot a dar volteretas hacia atrás -una tarea bastante difícil de modelar- utilizando RLHF.

- Juego. Se han utilizado técnicas de aprendizaje por refuerzo para desarrollar robots de videojuegos. Sin embargo, el RLHF puede utilizarse para entrenar a los robots basándose en las preferencias humanas, haciéndolos jugadores más parecidos a los humanos en lugar de simples máquinas maximizadoras de recompensa. Por ejemplo, OpenAI y DeepMind entrenaron bots para jugar a juegos de Atari con RLHF.

Los beneficios del RLHF

El RLHF es una técnica potente y prometedora sin la cual no serían posibles las herramientas de IA de próxima generación. Éstas son algunas de las ventajas del RLHF:

- Aumento del rendimiento. La retroalimentación humana es la clave para que los LLM como ChatGPT "piensen" y suenen como humanos. El HLHF permite a las máquinas abordar tareas complejas, como los problemas de PNL, que implican valores o preferencias humanas.

- Adaptabilidad. Como los LLM se afinan utilizando la retroalimentación humana en todo tipo de indicaciones, el RLHF permite a las máquinas realizar una serie de tareas múltiples y adaptarse a las situaciones esperadas. Esto hace que los LLM nos acerquen al umbral de la IA de propósito general.

- Mejora continua. RLHF es un proceso iterativo, lo que significa que el sistema se mejora continuamente a medida que su función de aprendizaje se actualiza siguiendo las nuevas reacciones humanas.

- Mayor seguridad. Al recibir información humana, el sistema no sólo aprende cómo hacer las cosas, sino también lo que no debe hacer, garantizando sistemas eficaces, más seguros y fiables.

Limitaciones del RLHF

Sin embargo, el RLHF no es a prueba de balas. Esta técnica también plantea ciertos riesgos y limitaciones. A continuación, puedes ver algunas de las más relevantes:

- Retroalimentación humana limitada y costosa. RLHF se basa en la calidad y disponibilidad de la retroalimentación humana. Sin embargo, hacer el trabajo puede ser lento, laborioso y costoso, sobre todo si el trabajo en cuestión requiere mucha información.

- Sesgo en la retroalimentación humana. A pesar del uso de directrices normalizadas para proporcionar información, la puntuación o la clasificación están influidas en última instancia por las preferencias y los valores humanos. Si las tareas de clasificación no están bien enmarcadas, o la calidad de la retroalimentación humana es deficiente, el modelo puede sesgarse o reforzar resultados indeseables.

- Generalización a nuevos contextos. Aunque los LLM se afinen con una retroalimentación humana sustancial, siempre pueden surgir contextos inesperados. En este caso, el reto es hacer que el agente sea robusto ante situaciones con retroalimentación limitada.

- Alucinaciones. Cuando la retroalimentación humana es limitada o escasa, los agentes pueden experimentar las llamadas alucinaciones, es decir, comportamientos indeseables, falsos o sin sentido.

Tendencias y desarrollos futuros en RLHF

RLHF es una de las columnas vertebrales de las herramientas modernas de IA generativa, como ChatGPT y GPT-4. A pesar de sus impresionantes resultados, la RLHF es una técnica relativamente nueva, y aún queda un amplio margen de mejora. La investigación futura sobre las técnicas de RLHF es fundamental para que los LLM sean más eficientes, reduzcan su huella medioambiental y aborden algunos de los riesgos y limitaciones de los LLM.

Para estar al día de los últimos avances en IA generativa, aprendizaje automático y LLM, te recomendamos encarecidamente que consultes nuestros materiales de aprendizaje curados:

- Introducción al aprendizaje por refuerzo - Este tutorial cubre los conceptos y terminologías básicos del aprendizaje por refuerzo.

- Aprendizaje profundo en Python - Este tema ayuda a los alumnos a ampliar sus conocimientos de aprendizaje profundo y a llevar sus habilidades de aprendizaje automático al siguiente nivel.

- Tutorial de aprendizaje profundo - Este tutorial proporciona una visión general del aprendizaje profundo y del aprendizaje por refuerzo.

- Cómo utilizar éticamente el aprendizaje automático para tomar decisiones - Esta entrada de blog analiza la importancia de las consideraciones éticas al utilizar modelos de aprendizaje automático.

Soy analista de datos autónomo y colaboro con empresas y organizaciones de todo el mundo en proyectos de ciencia de datos. También soy instructor de ciencia de datos con más de 2 años de experiencia. Escribo regularmente artículos relacionados con la ciencia de datos en inglés y español, algunos de los cuales se han publicado en sitios web consolidados como DataCamp, Towards Data Science y Analytics Vidhya Como científico de datos con formación en ciencias políticas y derecho, mi objetivo es trabajar en la interacción de las políticas públicas, el derecho y la tecnología, aprovechando el poder de las ideas para promover soluciones y narrativas innovadoras que puedan ayudarnos a abordar retos urgentes, como la crisis climática. Me considero autodidacta, aprendiz constante y firme partidaria de la multidisciplinariedad. Nunca es demasiado tarde para aprender cosas nuevas.