El reciente lanzamiento de GPT-4 marca un hito importante en el campo de la inteligencia artificial, en particular en el procesamiento de lenguaje natural. En este artículo, ofrecemos un análisis exhaustivo de sus capacidades avanzadas y profundizamos en la historia y el desarrollo de los transformadores generativos preentrenados (GPT), y en las nuevas capacidades que GPT-4 desbloquea. Consulta nuestro artículo sobre GPT-4 Turbo, la última iteración de GPT, para saber más.

Obtén más información sobre grandes modelos lingüísticos como GPT-4 en nuestro Programa de fundamentos de la IA.

¿Qué son los transformadores generativos preentrenados?

Los transformadores generativos preentrenados (GPT) son un tipo de modelo de aprendizaje profundo utilizado para generar texto similar al humano. Entre sus usos comunes se encuentran

- responder preguntas

- resumir texto

- traducir texto a otras lenguas

- generar código

- generar entradas de blog, historias, conversaciones y otros tipos de contenido

Las aplicaciones de los modelos GPT son infinitas, e incluso puedes afinarlos sobre datos concretos para crear resultados aún mejores. Utilizando transformadores, ahorrarás costes de informática, tiempo y otros recursos.

Antes de GPT

La actual revolución de la IA para el lenguaje natural solo fue posible con la invención de los modelos transformadores, a partir del BERT de Google en 2017. Antes de esto, la generación de texto se realizaba con otros modelos de aprendizaje profundo, como las redes neuronales recursivas (RNN) y las redes neuronales de memoria a corto y largo plazo (LSTM). Funcionaban bien para emitir palabras sueltas o frases cortas, pero no podían generar contenidos más largos realistas.

El enfoque del transformador de BERT supuso un gran avance, ya que no es una técnica de aprendizaje supervisado. Es decir, no necesitó un costoso conjunto de datos anotados para entrenarse. Google utilizó BERT para interpretar búsquedas en lenguaje natural, pero no puede generar texto a partir de un prompt.

GPT-1

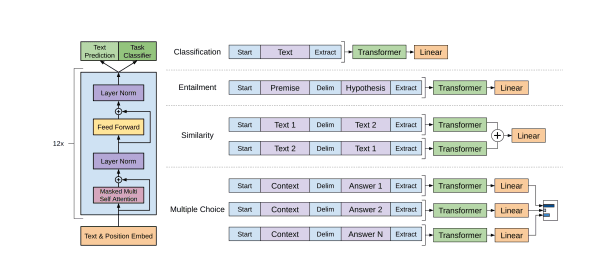

Arquitectura de transformador | Artículo GPT-1

En 2018, OpenAI publicó un artículo (Improving Language Understanding by Generative Pre-Training) sobre el uso de la comprensión del lenguaje natural mediante su modelo de lenguaje GPT-1. Este modelo era una prueba de concepto y no se hizo público.

GPT-2

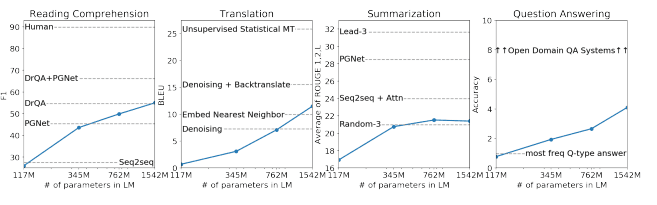

Rendimiento del modelo en varias tareas | Artículo GPT-2

Al año siguiente, OpenAI publicó otro artículo (Language Models are Unsupervised Multitask Learners) sobre su último modelo, GPT-2. Esta vez, el modelo se puso a disposición de la comunidad de machine learning y encontró cierta adopción para tareas de generación de texto. GPT-2 a menudo podía generar un par de frases antes de venirse abajo. Esto fue lo más avanzado en 2019.

GPT-3

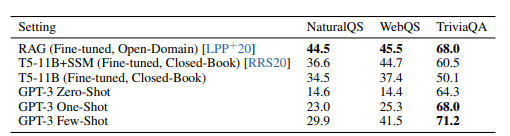

Resultados en tres tareas de aseguramiento de la calidad de dominio público | Artículo GPT-3

En 2020, OpenAI publicó otro artículo (Language Models are Few-Shot Learners) sobre su modelo GPT-3. El modelo tenía 100 veces más parámetros que GPT-2 y se entrenó con un conjunto de datos de texto aún mayor, lo que dio como resultado un mejor rendimiento del modelo. El modelo siguió mejorándose con diferentes iteraciones conocidas como la serie GPT-3.5, incluido ChatGPT, centrado en la conversación.

Esta versión tomó el mundo por asalto tras sorprender al mundo con su capacidad de generar páginas de texto similar al humano. ChatGPT se convirtió en la aplicación web de más rápido crecimiento de la historia, y alcanzó los 100 millones de usuarios en solo dos meses.

Puedes obtener más información sobre GPT-3, sus usos y cómo utilizarlo en otro artículo.

Aprende a utilizar ChatGPT con nuestro curso Introducción a ChatGPT

¿Qué hay de nuevo en GPT-4?

GPT-4 se ha desarrollado para mejorar la "alineación" del modelo, es decir, su capacidad para seguir las intenciones del usuario y, al mismo tiempo, para que sea más veraz y genere resultados menos ofensivos o peligrosos.

Mejoras de rendimiento

Como era de esperar, GPT-4 mejora los modelos GPT-3.5 en cuanto a la corrección factual de las respuestas. El número de "alucinaciones", en las que el modelo comete errores factuales o de razonamiento, es menor, y GPT-4 obtiene una puntuación un 40 % superior a GPT-3.5 en el parámetro interno de rendimiento factual de OpenAI.

También mejora la "dirigibilidad", que es la capacidad de cambiar su comportamiento según las peticiones del usuario. Por ejemplo, puedes ordenarle que escriba en un estilo, tono o voz diferentes. Prueba a empezar los prompts con "Eres un experto en datos charlatán" o "Eres un experto en datos seco" y pídele que te explique un concepto de ciencia de datos. Puedes leer más sobre el diseño de grandes prompts para modelos GPT aquí.

Otra mejora es la adherencia del modelo a las barandillas. Si le pides que haga algo ilegal o desagradable, es mejor rechazando la petición.

Utilizar entradas visuales en GPT-4

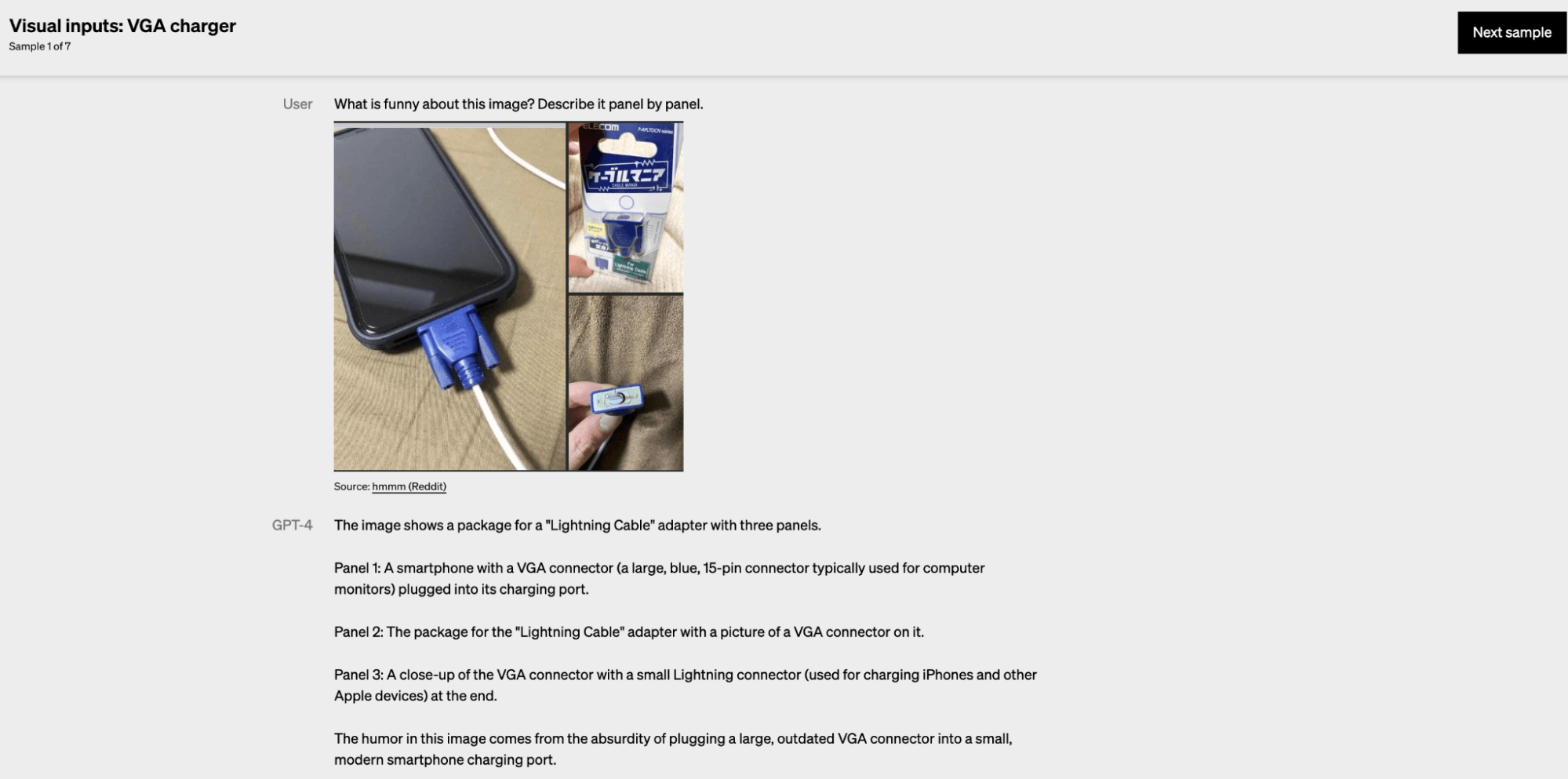

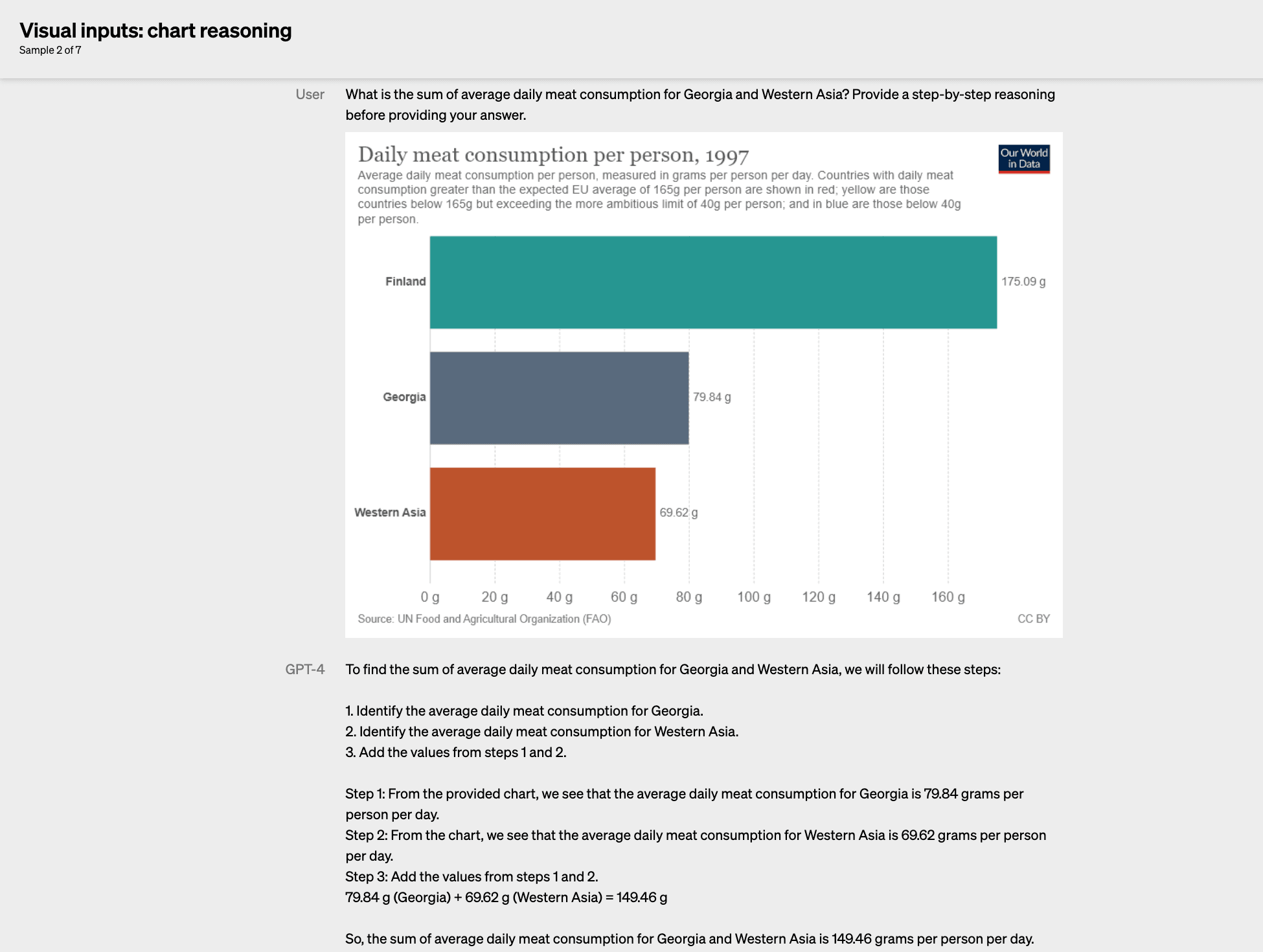

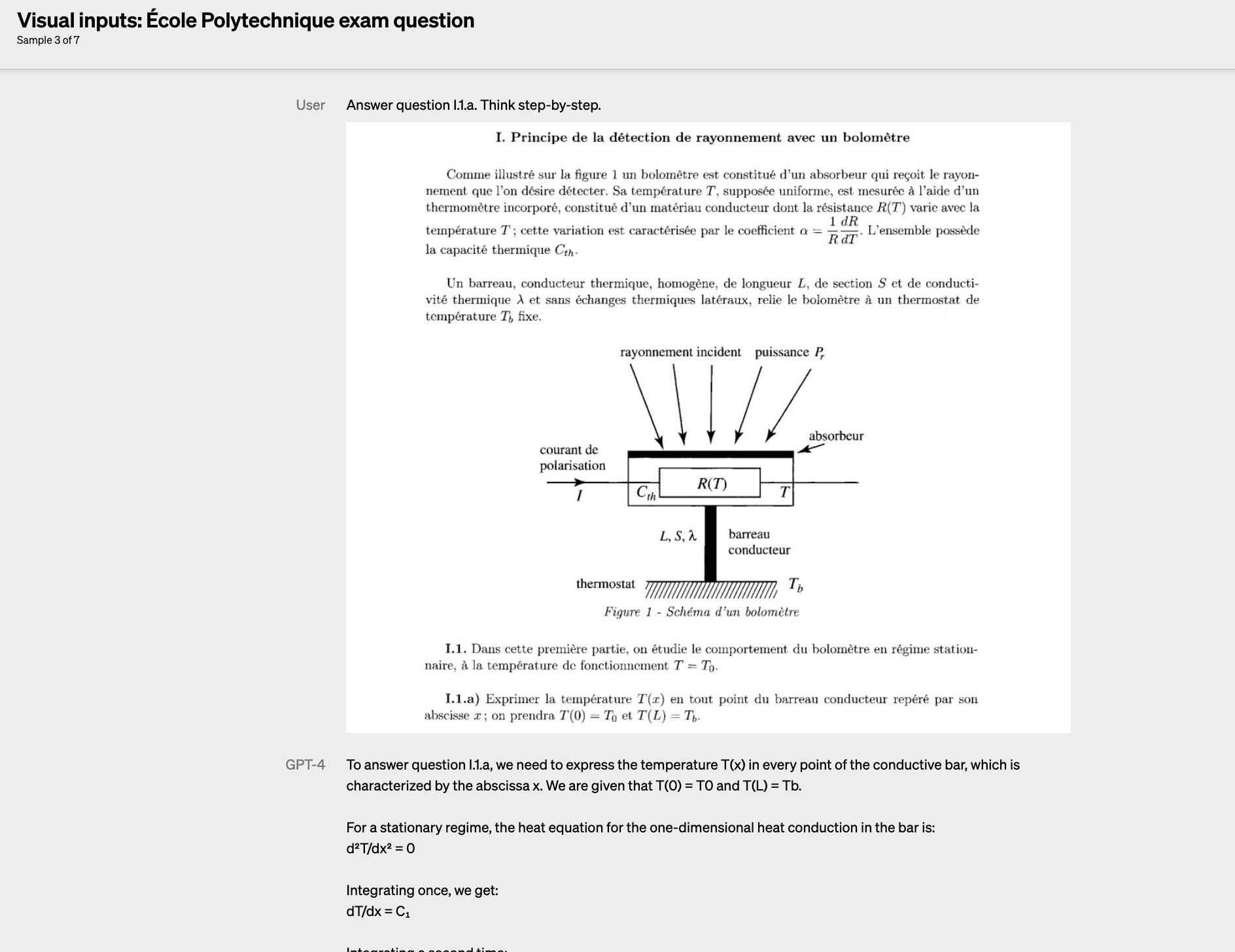

Un cambio importante es que GPT-4 puede utilizar entradas de imagen (solo vista previa de investigación; aún no está disponible para el público) y texto. Los usuarios pueden especificar cualquier tarea de visión o lenguaje introduciendo texto e imágenes intercalados.

Los ejemplos mostrados destacan que GPT-4 interpreta correctamente imágenes complejas como gráficos, memes y capturas de pantalla de artículos académicos.

A continuación puedes ver ejemplos de la entrada de visión.

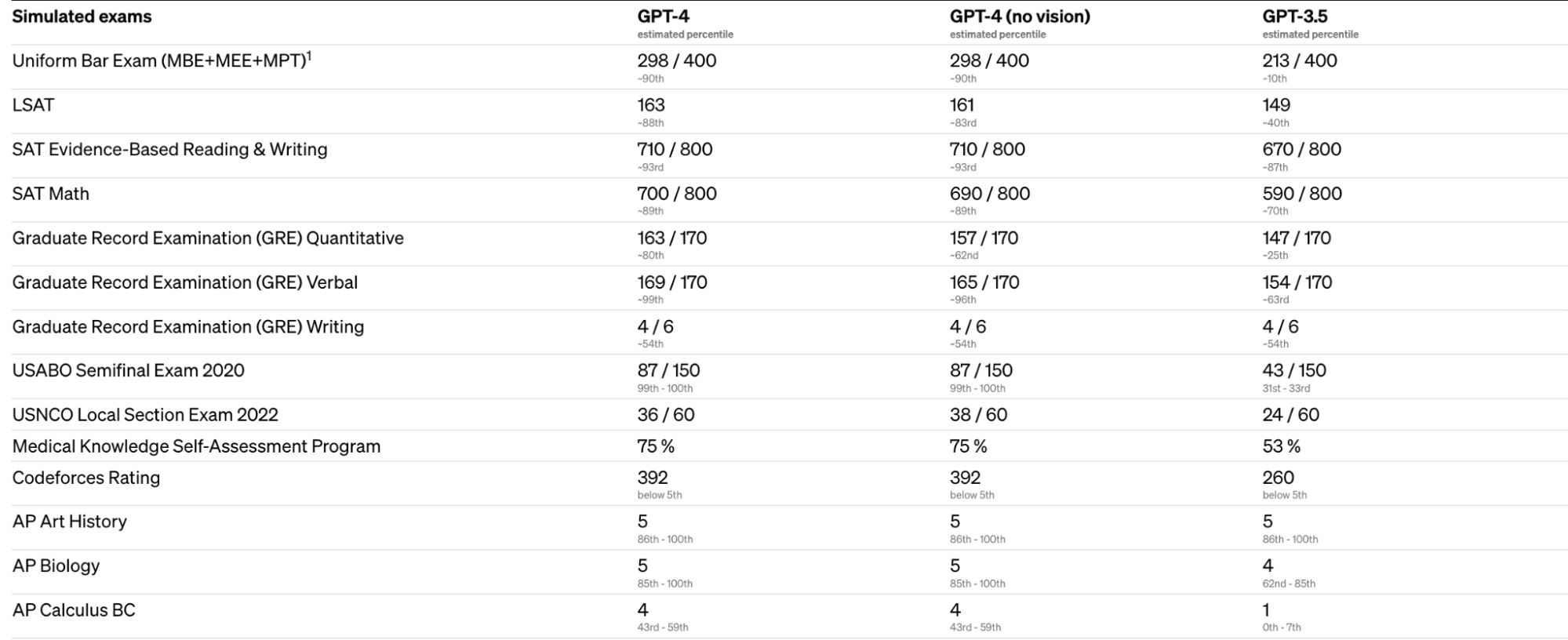

Parámetros de rendimiento de GPT-4

OpenAI evaluó GPT-4 simulando exámenes diseñados para humanos, como el examen jurídico estatal y el LSAT para abogados y el SAT para acceder a la universidad en Estados Unidos. Los resultados mostraron que GPT-4 alcanzó un rendimiento de nivel humano en diferentes parámetros profesionales y académicos.

OpenAI también evaluó GPT-4 en parámetros tradicionales diseñados para modelos de machine learning, en los que superó a los grandes modelos lingüísticos existentes y a la mayoría de los modelos de última generación que pueden incluir elaboración específica para parámetros o protocolos de entrenamiento adicionales. Estos parámetros incluían preguntas de opción múltiple de 57 asignaturas, razonamiento de sentido común sobre sucesos cotidianos, preguntas de opción múltiple de ciencias de primaria y mucho más.

OpenAI puso a prueba la capacidad de GPT-4 en otros idiomas traduciendo el parámetro MMLU, un conjunto de 14 000 problemas de opción múltiple que abarcan 57 asignaturas, a diferentes idiomas utilizando Azure Translate. En 24 de los 26 idiomas probados, GPT-4 superó el rendimiento en inglés de GPT-3.5 y de otros grandes modelos lingüísticos.

En general, los resultados más fundamentados de GPT-4 indican un progreso significativo en los esfuerzos de OpenAI por desarrollar modelos de IA con capacidades cada vez más avanzadas.

Cómo acceder a GPT-4

OpenAI lanza la capacidad de introducción de texto de GPT-4 mediante ChatGPT. Actualmente está disponible para los usuarios de ChatGPT Plus. Hay lista de espera para la API GPT-4.

Todavía no se ha anunciado la disponibilidad pública de la función de introducción de imágenes.

OpenAI ha abierto OpenAI Evals, un marco para la evaluación automatizada del rendimiento de los modelos de IA, para que cualquiera pueda informar de las deficiencias de sus modelos y orientar nuevas mejoras.

Llévalo al siguiente nivel

Mientras tanto, puedes aprender IA y leer más sobre temas como GPT-4 y ChatGPT en los siguientes recursos:

- Curso Aprende a utilizar eficazmente ChatGPT

- Aprende a crear tus propios modelos de generación de texto con aprendizaje profundo en el curso Generación de lenguaje natural en Python.

- Descárgate esta práctica hoja de trucos de referencia de prompts de ChatGPT para la ciencia de datos.

- Escucha este episodio de podcast sobre Cómo ChatGPT y GPT-3 aumentan los flujos de trabajo para comprender cómo ChatGPT puede beneficiar a tu empresa.

Preguntas frecuentes

¿Qué es GPT-4?

GPT-4 es la última versión de los transformadores generativos preentrenados, un tipo de modelo de aprendizaje profundo utilizado para el procesamiento de lenguaje natural y la generación de textos. Marca un hito importante en el campo de la inteligencia artificial, en particular en el procesamiento de lenguaje natural.

¿Cuáles son las capacidades de los modelos GPT?

Los modelos GPT pueden generar texto similar al humano, responder preguntas, resumir texto, traducir texto a otros idiomas, generar código y generar diferentes tipos de contenido, como entradas de blog, historias y conversaciones.

¿Cuál es la historia de los modelos GPT?

Los modelos GPT fueron posibles gracias a la invención de los modelos transformadores, a partir del BERT de Google en 2017. Antes de esto, la generación de texto se realizaba con otros modelos de aprendizaje profundo, como las redes neuronales recursivas (RNN) y las redes neuronales de memoria a corto y largo plazo (LSTM).

¿En qué mejora GPT-4 a los modelos anteriores?

GPT-4 mejora la "alineación" del modelo, es decir, su capacidad para seguir las intenciones del usuario, al tiempo que lo hace más veraz y genera resultados menos ofensivos o peligrosos. También mejora la corrección factual y la "dirigibilidad", que es la capacidad de cambiar su comportamiento según las peticiones del usuario. Además, GPT-4 puede utilizar entradas de imagen además de texto.

¿Cómo se comporta GPT-4 en los parámetros?

GPT-4 alcanzó un rendimiento de nivel humano en diferentes parámetros profesionales y académicos, como el examen jurídico estatal y el LSAT para abogados y el SAT para acceder a la universidad en Estados Unidos. También superó a los grandes modelos lingüísticos existentes y a la mayoría de los modelos más avanzados en los parámetros tradicionales de machine learning.

¿Cómo puedo acceder a GPT-4?

La capacidad de introducción de texto de GPT-4 está actualmente disponible para los usuarios de ChatGPT Plus, y hay una lista de espera para la API GPT-4. Todavía no se ha anunciado la disponibilidad pública de la función de introducción de imágenes.