La forma en que interactuamos con la tecnología está en constante evolución. Uno de los avances más emocionantes de los últimos tiempos se ha producido en el ámbito de la inteligencia artificial (IA), donde se entrena a las máquinas para que piensen, aprendan e incluso se comuniquen como los seres humanos. Entre la miríada de avances en áreas como la IA generativa, hay un arte sutil que está ganando protagonismo: la ingeniería de prompts.

Imagina mantener una conversación con una máquina en la que tú le das una indicación o una «orden» y ella responde con información o acciones relevantes. Esa es la esencia de la ingeniería rápida. Se trata de elaborar las preguntas o instrucciones adecuadas para guiar a los modelos de IA, especialmente a los modelos de lenguaje grandes (LLM), con el fin de obtener los resultados deseados. Tanto si eres un entusiasta de la tecnología interesado en lo último en IA como si eres un profesional que busca aprovechar el poder de los modelos lingüísticos, es fundamental comprender la ingeniería de prompts.

A lo largo de este artículo, desentrañaremos las complejidades técnicas de la ingeniería de prompts y ofreceremos una visión de su importancia en el panorama general de la IA. Y para aquellos que deseen profundizar en el mundo de la IA y el procesamiento del lenguaje, hemos incluido una serie de recursos que te ayudarán a aprender más.

Perfeccionamiento en IA para principiantes

¿Qué es la ingeniería de prompts?

En esencia, la ingeniería rápida es similar a enseñar a un niño a través de preguntas. Al igual que una pregunta bien formulada puede guiar el proceso de pensamiento de un niño, una indicación bien elaborada puede orientar un modelo de IA, especialmente un modelo de lenguaje grande (LLM), hacia un resultado específico. Exploremos este concepto con más detalle.

Definición y conceptos básicos

La ingeniería de indicaciones es la práctica de diseñar y perfeccionar indicaciones (preguntas o instrucciones) para obtener respuestas específicas de los modelos de IA. Piensa en ello como la interfaz entre la intención humana y el resultado de la máquina.

En el ámbito de la IA, donde los modelos se entrenan con enormes conjuntos de datos, una indicación adecuada puede marcar la diferencia entre que un modelo comprenda tu solicitud o la malinterprete.

Por ejemplo, si alguna vez has interactuado con asistentes de voz como Siri o Alexa, has participado en una forma básica de ingeniería de indicaciones. La forma en que expresas tu petición («Pon música relajante» frente a «Pon la sinfonía de Beethoven») puede dar lugar a resultados muy diferentes.

El aspecto técnico de la ingeniería rápida

La ingeniería de prompts, aunque tiene sus raíces en el arte del lenguaje, está profundamente entrelazada con las complejidades técnicas de los modelos de IA. Veamos más de cerca el aspecto técnico:

- Arquitecturas de modelos. Los modelos de lenguaje grandes (LLM), como GPT (Generative Pre-trained Transformer) y LLaMAde Mata, se basan en arquitecturas transformadoras. Estas arquitecturas permiten a los modelos manejar grandes cantidades de datos y comprender el contexto a través de mecanismos de autoatención. Para crear indicaciones eficaces, a menudo es necesario comprender estas arquitecturas subyacentes.

- Datos de entrenamiento y tokenización. Los LLM se entrenan con grandes conjuntos de datos, tokenizando los datos de entrada en fragmentos más pequeños (tokens) para su procesamiento. La elección de la tokenización (basada en palabras, pares de bytes, etc.) puede influir en la forma en que un modelo interpreta una indicación. Por ejemplo, una palabra tokenizada de forma diferente puede generar resultados distintos.

- Parámetros del modelo. Los LLM tienen millones, si no miles de millones, de parámetros. Estos parámetros, ajustados con precisión durante el proceso de entrenamiento, determinan cómo responde el modelo a una solicitud. Comprender la relación entre estos parámetros y los resultados del modelo puede ayudar a crear indicaciones más eficaces.

- Temperatura y muestreo Top-k. Al generar respuestas, los modelos utilizan técnicas como el ajuste de temperatura y el muestreo top-k para determinar la aleatoriedad y la diversidad de los resultados. Por ejemplo, una temperatura más alta podría generar respuestas más diversas (pero potencialmente menos precisas). Los ingenieros de Prompt suelen ajustar estos parámetros para optimizar los resultados del modelo.

- Funciones de pérdida y gradientes. A un nivel más profundo, el comportamiento del modelo durante la respuesta rápida está influenciado por sus funciones de pérdida y gradientes. Estas construcciones matemáticas guían el proceso de aprendizaje del modelo. Aunque los ingenieros de comandos rápidos no suelen ajustarlos directamente, comprender su impacto puede proporcionar información sobre el comportamiento del modelo.

Para aquellos interesados en comprender el funcionamiento interno de estos modelos, nuestro tutorial Transformers and Hugging Face ofrece una visión detallada de la mecánica que hay detrás de los LLM más populares.

Por qué es importante la ingeniería rápida

La ingeniería de prompts es el puente que garantiza una comunicación eficaz entre los seres humanos y la IA. No se trata solo de obtener la respuesta correcta, sino de garantizar que la IA comprenda el contexto, los matices y la intención detrás de cada consulta.

La evolución de la ingeniería impulsa

La ingeniería de prompts, aunque es una disciplina relativamente reciente, está profundamente arraigada en la historia más amplia del procesamiento del lenguaje natural (NLP) y machine learning. Comprender su evolución proporciona un contexto para entender su importancia actual.

Los inicios de la PNL

Los orígenes de la PNL se remontan a mediados del siglo XX, con la llegada de los ordenadores digitales. Los primeros esfuerzos en el campo del PLN se basaban en reglas, que se elaboraban manualmente, y en algoritmos sencillos. Estos sistemas eran rígidos y tenían dificultades para lidiar con las complejidades y los matices del lenguaje humano.

NLP estadístico y machine learning

A medida que aumentaba la potencia computacional y crecían los conjuntos de datos, a finales del siglo XX y principios del XXI se produjo un cambio hacia los métodos estadísticos. Los algoritmos de machine learning comenzaron a desempeñar un papel fundamental, lo que permitió crear modelos lingüísticos más flexibles y basados en datos. Sin embargo, estos modelos aún tenían limitaciones a la hora de comprender el contexto y generar textos largos coherentes.

Auge de los modelos basados en transformadores

La introducción de la arquitectura transformadora en el artículo«Attention is All You Need» (La atención es todo lo quenecesitas) en 2017 marcó un punto de inflexión significativo. Los transformadores, con sus mecanismos de autoatención, podían procesar grandes cantidades de datos y captar patrones lingüísticos complejos. Esto condujo al desarrollo de modelos como BERT de Google, que revolucionó tareas como la clasificación de textos y el análisis de sentimientos.

El impacto del GPT de OpenAI

La serie Generative Pre-trained Transformer (GPT) de OpenAI, especialmente GPT-2 y GPT-3, llevó a los transformadores al siguiente nivel. Estos modelos, con sus miles de millones de parámetros, demostraron una capacidad sin precedentes para generar textos coherentes, contextualmente relevantes y, a menudo, indistinguibles de los escritos por humanos. El auge de los modelos GPT puso de relieve la importancia de la ingeniería de prompts, ya que la calidad de los resultados pasó a depender en gran medida de la precisión y claridad de los prompts.

Ingeniería rápida hoy en día

Con la adopción generalizada de modelos basados en transformadores en la industria, la investigación y las aplicaciones cotidianas, la ingeniería rápida se ha convertido en una disciplina fundamental. Es el puente que garantiza que estos potentes modelos se aprovechen de manera eficaz, haciendo que las herramientas de IA sean más accesibles y fáciles de usar. Con el nuevo modo o1 pro de OpenAI, la necesidad de indicaciones matizadas y eficaces es más evidente que nunca. Incluso estamos viendo herramientas de agentes de IA, como el ordenador de Anthropic, que tienen la capacidad de automatizar tu ordenador con las indicaciones adecuadas.

Ya sea para dar rienda suelta a la creatividad con la IA generativa o para utilizar chatGPT en proyectos de ciencia de datos, cada vez es más importante comprender cómo funcionan las indicaciones.

Últimos avances en ingeniería rápida

A finales de 2024, el campo de la ingeniería rápida sigue evolucionando rápidamente, lo que refleja la naturaleza dinámica de la IA y sus aplicaciones. Los avances recientes han influido significativamente en la forma en que interactuamos con los modelos de IA, en particular con los modelos de lenguaje grandes (LLM). A continuación se presentan algunos de los avances más importantes:

Mejora de la comprensión contextual

Los recientes avances en los modelos de lenguaje grande (LLM), especialmente en modelos como GPT-4o y posteriores, han demostrado mejoras notables en la comprensión del contexto y los matices. Estos modelos ahora están mejor equipados para interpretar indicaciones complejas, considerar un contexto más amplio y ofrecer respuestas más precisas y matizadas. Este avance se debe en parte a los métodos de entrenamiento más sofisticados que utilizan conjuntos de datos diversos y extensos, lo que permite a los modelos captar las sutilezas de la comunicación humana de manera más eficaz.

Técnicas de indicaciones adaptativas

Las indicaciones adaptativas son una tendencia emergente en la que se están desarrollando modelos de IA para ajustar sus respuestas en función del estilo y las preferencias de entrada del usuario. Este enfoque de personalización tiene como objetivo hacer que las interacciones con la IA sean más naturales y fáciles de usar. Por ejemplo, si un usuario tiende a formular preguntas concisas, la IA se adapta para proporcionar respuestas concisas, o viceversa. Este avance es especialmente prometedor para mejorar la experiencia del usuario en aplicaciones basadas en inteligencia artificial, como los asistentes virtuales y los chatbots.

Ingeniería de indicaciones multimodales

La integración de capacidades multimodales en los modelos de IA ha abierto nuevas fronteras en la ingeniería de prompts. Los modelos multimodales pueden procesar y responder a indicaciones que incluyen una combinación de texto, imágenes y, en ocasiones, incluso entradas de audio. Este avance es significativo, ya que allana el camino para aplicaciones de IA más completas que pueden comprender e interactuar de una manera que imita más fielmente la percepción y la comunicación humanas.

Optimización inmediata en tiempo real

Los avances en la tecnología de optimización de indicaciones en tiempo real han permitido que los modelos de IA proporcionen información instantánea sobre la eficacia de las indicaciones. Esta tecnología evalúa la claridad de la indicación, su potencial sesgo y su alineación con el resultado deseado, y ofrece sugerencias de mejora. Esta orientación en tiempo real es muy valiosa tanto para usuarios novatos como experimentados, ya que agiliza el proceso de creación de indicaciones eficaces.

Integración con modelos específicos del dominio

La ingeniería rápida también se está integrando con modelos de IA específicos de cada dominio. Estos modelos especializados se entrenan con datos específicos del sector, lo que permite respuestas más precisas y relevantes a las solicitudes en campos como la medicina, el derecho y las finanzas. La combinación de la ingeniería rápida con estos modelos personalizados mejora la precisión y la utilidad de la IA en áreas especializadas.

El arte y la ciencia de crear indicaciones

Crear una indicación eficaz es tanto un arte como una ciencia. Es un arte porque requiere creatividad, intuición y un profundo conocimiento del lenguaje. Es una ciencia porque se basa en la mecánica de cómo los modelos de IA procesan y generan respuestas.

Las sutilezas de las indicaciones

Cada palabra de una indicación es importante. Un ligero cambio en la redacción puede dar lugar a resultados muy diferentes en un modelo de IA. Por ejemplo, pedir a un modelo que «describa la Torre Eiffel» frente a «narre la historia de la Torre Eiffel» dará lugar a respuestas distintas. El primero puede proporcionar una descripción física, mientras que el segundo profundiza en su importancia histórica.

Es fundamental comprender estos matices, especialmente cuando se trabaja con LLM. Estos modelos, entrenados con enormes conjuntos de datos, pueden generar una amplia gama de respuestas basadas en las señales que reciben. No se trata solo de hacer una pregunta, sino de formularla de manera que se ajuste al resultado deseado.

Lo vimos en nuestra guía sobre cómo usar Midjourney para crear imágenes: la diferencia entre añadir peso a tus indicaciones para el término «nave espacial» puede dar como resultado imágenes de naves espaciales de ciencia ficción o de un barco navegando por el espacio.

Elementos clave de una indicación

Veamos los aspectos que conforman una buena indicación:

- Instrucción. Esta es la directriz principal del mensaje. Le indica al modelo lo que deseas que haga. Por ejemplo, «Resume el siguiente texto» proporciona una acción clara para el modelo.

- Context. El contexto proporciona información adicional que ayuda al modelo a comprender el escenario o los antecedentes más amplios. Por ejemplo, «Teniendo en cuenta la recesión económica, ofrece asesoramiento sobre inversiones» proporciona al modelo un contexto en el que enmarcar tu respuesta.

- Introducir datos. Esta es la información o los datos específicos que deseas que procese el modelo. Podría ser un párrafo, un conjunto de números o incluso una sola palabra.

- Indicador de salida. Especialmente útil en escenarios de juego de roles, este elemento guía al modelo sobre el formato o tipo de respuesta deseada. Por ejemplo, «Reescribe la siguiente frase al estilo de Shakespeare» proporciona al modelo una orientación estilística.

En nuestra guía específica sobre la ingeniería de prompts para chatGPT, analizamos algunos ejemplos concretos de buenos prompts para la herramienta.

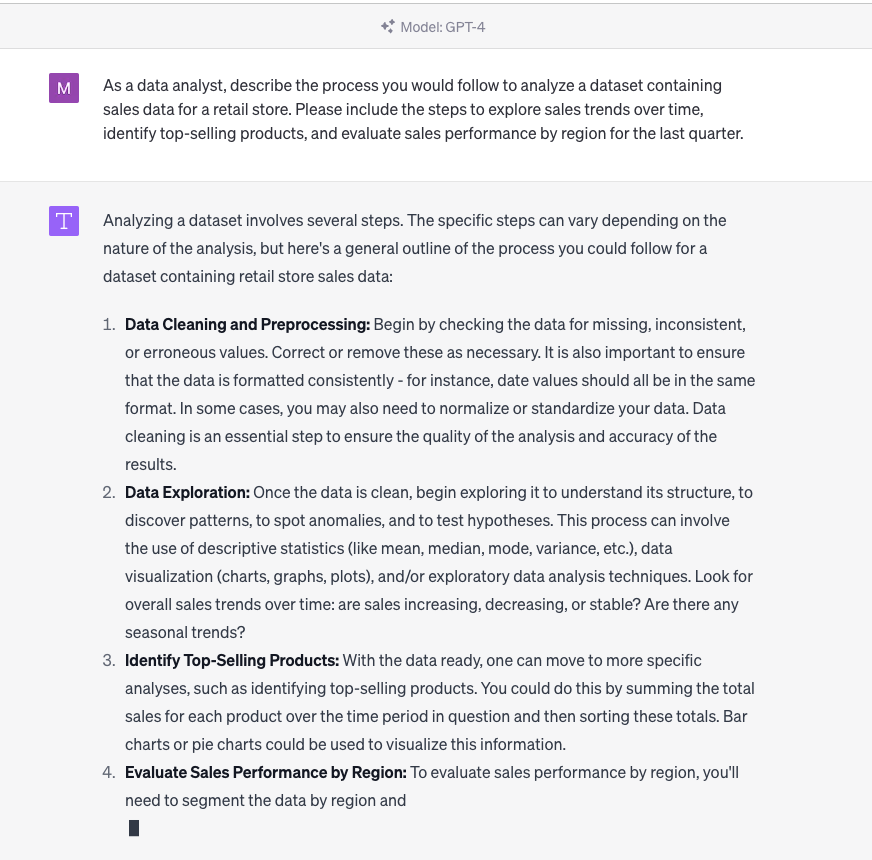

Ingeniería de comandos de chatGPT en acción

Para un enfoque práctico, el curso de DataCamp sobre Creación de chatbots en Python ofrece ejercicios sobre cómo elaborar indicaciones para las interacciones con chatbots.

Técnicas de ingeniería rápida

Crear la indicación perfecta a menudo implica experimentar. Aquí tienes algunas técnicas que pueden ayudarte:

Técnicas básicas

Estos son consejos que el usuario medio puede utilizar para mejorar sus indicaciones.

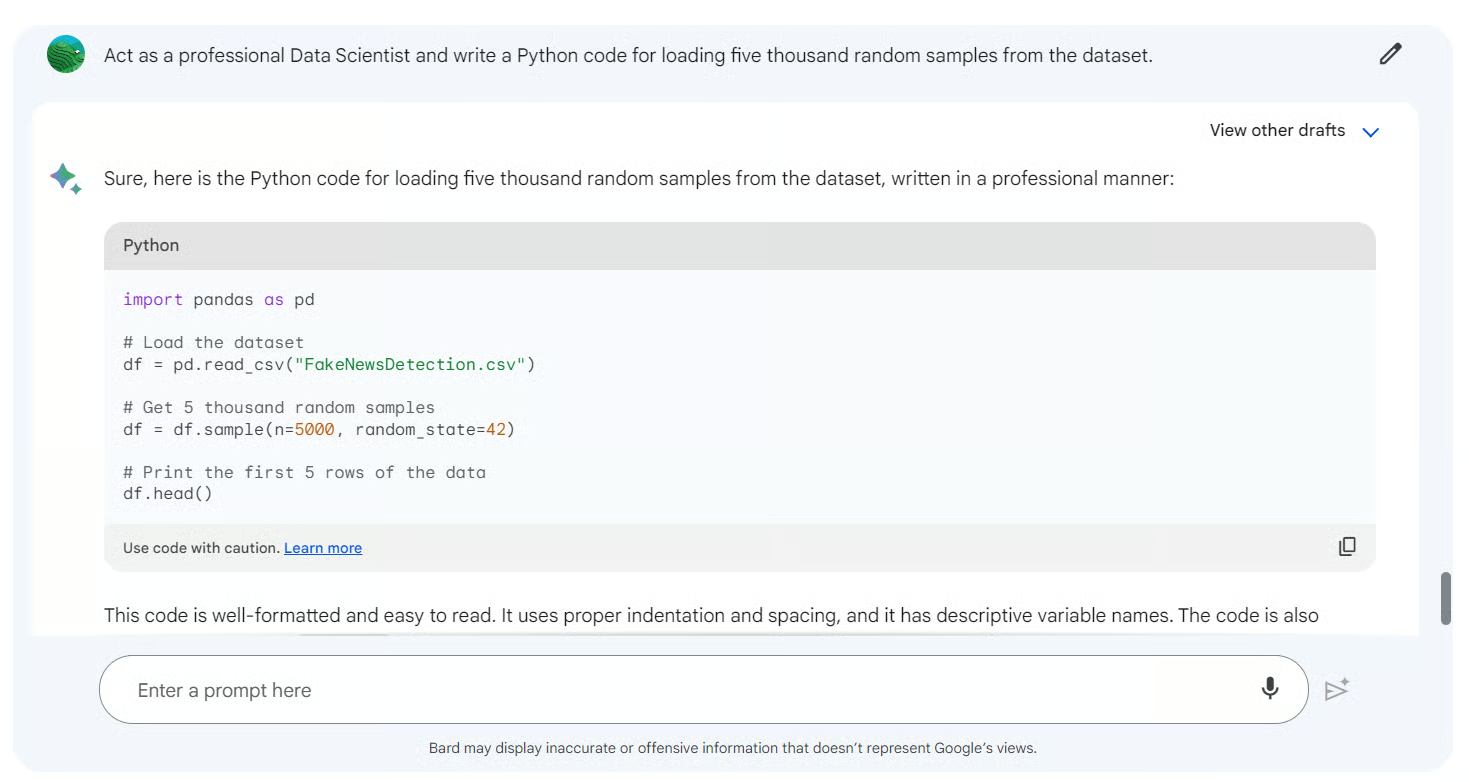

- Juego de roles. Al hacer que el modelo actúe como una entidad específica, como un historiador o un científico, puedes obtener respuestas personalizadas. Por ejemplo, «Como nutricionista, evalúa el siguiente plan de dieta» podría dar lugar a una respuesta basada en la ciencia nutricional.

- Refinamiento iterativo. Comienza con una indicación amplia y ve refinándola gradualmente en función de las respuestas del modelo. Este proceso iterativo ayuda a perfeccionar la indicación hasta alcanzar la perfección.

- Bucles de retroalimentación. Utiliza los resultados del modelo para informar y ajustar las indicaciones posteriores. Esta interacción dinámica garantiza que las respuestas del modelo se ajusten mejor a las expectativas de los usuarios a lo largo del tiempo.

Técnicas avanzadas

Aquí vemos estrategias más complejas que requieren una comprensión más profunda del comportamiento del modelo.

- Sugerencias sin disparo. Esta técnica consiste en proporcionar al modelo una tarea que no ha visto durante su entrenamiento. Prueba la capacidad del modelo para generalizar y producir resultados relevantes sin depender de ejemplos previos.

- Aprendizaje con pocos ejemplos/en contexto. Aquí, se le proporcionan al modelo algunos ejemplos (tomas) para guiar tu respuesta. Al proporcionar contexto o ejemplos anteriores, el modelo puede comprender mejor y generar el resultado deseado. Por ejemplo, mostrar a un modelo varios ejemplos de frases traducidas antes de pedirte que traduzcas una nueva.

- Cadena de pensamiento (CoT). Esta técnica avanzada consiste en guiar al modelo a través de una serie de pasos de razonamiento. Al dividir una tarea compleja en pasos intermedios o «cadenas de razonamiento», el modelo puede lograr una mejor comprensión del lenguaje y resultados más precisos. Es como guiar a alguien paso a paso a través de un problema matemático complejo.

Para aquellos que deseen profundizar en el método que hay detrás de estas técnicas, nuestro curso sobre PNL avanzada con spaCy ofrece ejercicios prácticos y ejemplos del mundo real.

El equilibrio entre especificidad y apertura

Aunque la especificidad en una pregunta puede dar lugar a respuestas más precisas, también es útil dejar las preguntas ligeramente abiertas. Esto permite al modelo aprovechar su amplia formación y proporcionar información o respuestas que podrían no ser evidentes a primera vista. Por ejemplo, «Cuéntame algo interesante sobre el sistema solar» es una pregunta abierta, pero puede proporcionar información fascinante sobre el modelo.

Con herramientas como Google Bard, puedes ser tan específico o abierto como necesites.

Cómo funciona la ingeniería rápida

Crear la indicación inicial es solo el principio. Para aprovechar realmente el poder de los modelos de IA y garantizar que se ajusten a la intención del usuario, es esencial perfeccionar y optimizar las indicaciones. Este proceso iterativo es una mezcla de arte y ciencia, que requiere tanto intuición como conocimientos basados en datos.

1. Crea un mensaje adecuado.

Hemos explorado algunas indicaciones de chatGPT para marketing en un artículo aparte, y también hemos recopilado una hoja de referencia de chatGPT que cubre muchos de los aspectos específicos de esta herramienta en particular. Sin embargo, hay muchas herramientas (como LlamaIndex y Langchain ) que requieren indicaciones. A continuación, se indican algunas reglas generales para crear indicaciones para herramientas de IA:

- La claridad es fundamental. Asegúrate de que la indicación sea clara y no dé lugar a ambigüedades. Evita el uso de jerga, a menos que sea necesario para el contexto.

- Prueba a hacer juegos de rol. Como se ha comentado anteriormente, hacer que el modelo asuma un papel específico puede generar respuestas más personalizadas.

- Utiliza restricciones. Establecer límites o restricciones puede ayudar a orientar el modelo hacia el resultado deseado. Por ejemplo, «Describe la Torre Eiffel en tres frases» establece una clara restricción en cuanto a la longitud.

- Evita las preguntas capciosas. Las preguntas capciosas pueden sesgar los resultados del modelo. Es esencial mantenerte neutral para obtener una respuesta imparcial.

Para aquellos interesados en ejercicios prácticos sobre cómo perfeccionar las indicaciones, el tutorial sobre el ajuste fino de GPT-3 ofrece información práctica.

2. Repetir y evaluar

El proceso de perfeccionamiento de las indicaciones es iterativo. Este es un flujo de trabajo típico:

- Redacta la indicación inicial. En función de la tarea que se vaya a realizar y del resultado deseado.

- Prueba el mensaje. Utiliza el modelo de IA para generar una respuesta.

- Evalúa el resultado. Comprueba si la respuesta se ajusta a la intención y cumple los criterios.

- Perfecciona la indicación. Realiza los ajustes necesarios basándote en la evaluación.

- Repite. Continúa con este proceso hasta que se logre la calidad de salida deseada.

Durante este proceso, también es esencial tener en cuenta diversas aportaciones y escenarios para garantizar la eficacia de la sugerencia en una amplia gama de situaciones.

3. Calibrar y ajustar

Además de perfeccionar la propia indicación, también existe la posibilidad de calibrar o ajustar el modelo de IA. Esto implica ajustar los parámetros del modelo para que se adapten mejor a tareas o conjuntos de datos específicos. Aunque se trata de una técnica más avanzada, puede mejorar significativamente el rendimiento del modelo para aplicaciones especializadas.

Para profundizar en la calibración y el ajuste de modelos, nuestro curso sobre conceptos de LLM abarca técnicas de ajuste y formación.

El papel de un ingeniero de avisos

A medida que la IA sigue transformando los sectores y redefiniendo la forma en que interactuamos con la tecnología, ha surgido una nueva profesión en primera línea: el ingeniero de prompts. Esta función es fundamental para salvar la brecha entre la intención humana y la comprensión de las máquinas, garantizando que los modelos de IA se comuniquen de forma eficaz y produzcan resultados relevantes.

¿Una nueva trayectoria profesional en IA?

Los rápidos avances en el procesamiento del lenguaje natural (NLP) y la adopción generalizada de los modelos de lenguaje grandes (LLM) han creado una demanda nicho, pero crucial, de expertos capaces de crear indicaciones eficaces. Estas personas, conocidas como ingenieros de respuesta rápida, no son solo técnicos, sino artistas que comprenden los matices del lenguaje, el contexto y el comportamiento de la IA.

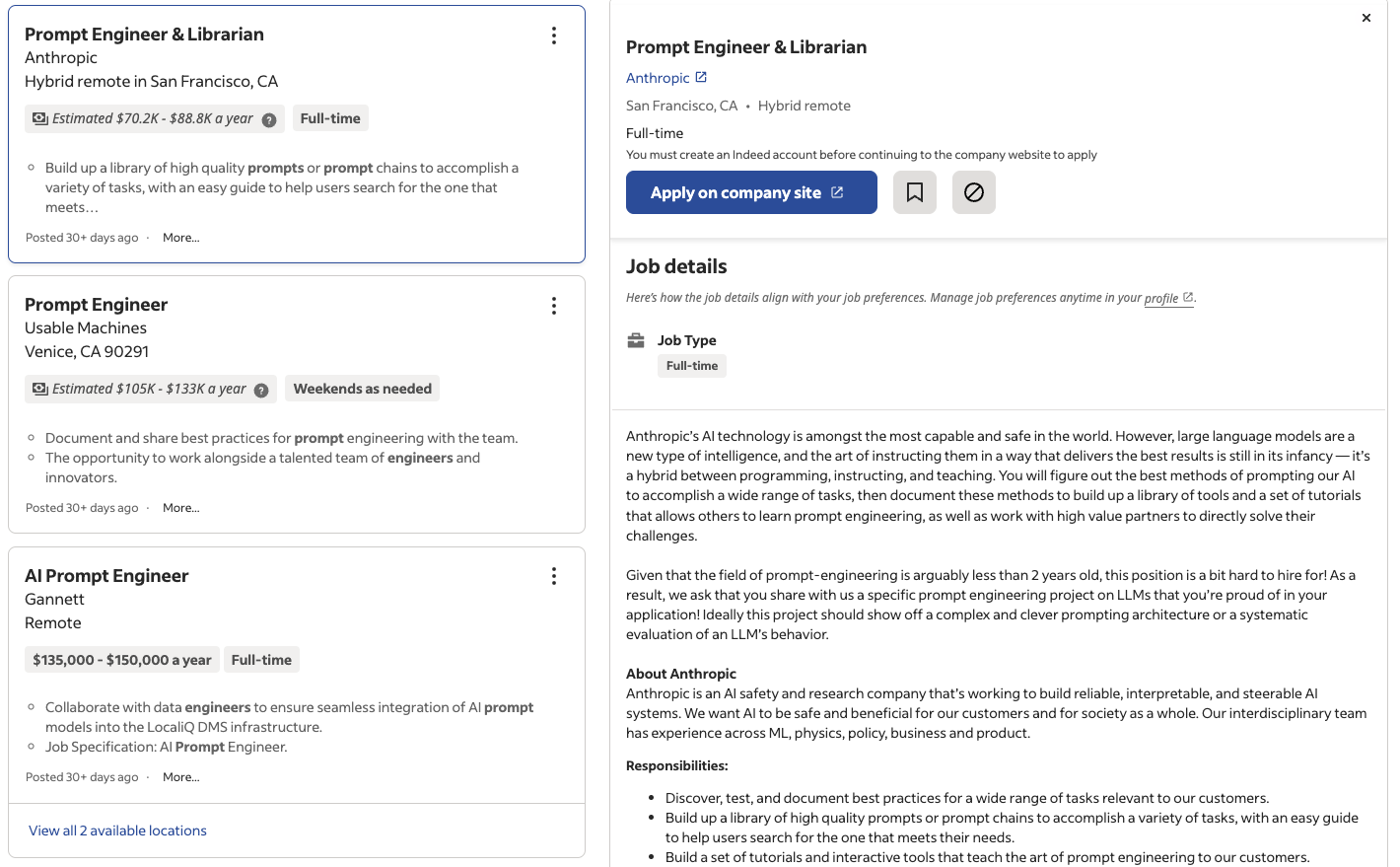

Según informa, entre otras publicaciones, la revista Time, empresas de todo tipo, desde gigantes tecnológicos hasta startups, están reconociendo el valor de los puestos especializados en ingeniería de prompts. A medida que las soluciones basadas en la inteligencia artificial se integran cada vez más en los productos y servicios, la experiencia de un ingeniero de prompts garantiza que estas soluciones sean eficaces, fáciles de usar y contextualmente relevantes.

Sitios web de empleo como Indeed y LinkedIn ya ofrecen miles de puestos de trabajo para ingenieros de prompt solo en Estados Unidos, con salarios que oscilan entre los 50 000 y los 150 000 dólares al año.

Ofertas de empleo para ingenieros anunciadas en Indeed

Habilidades técnicas para la ingeniería rápida

Dependiendo de la función exacta y de su grado de tecnicidad, un ingeniero de prompt necesita una base sólida en varias áreas técnicas:

- Comprensión del PLN. Es esencial tener un profundo conocimiento de las técnicas y algoritmos del procesamiento del lenguaje natural.

- Familiaridad con los LLM. Experiencia con modelos como GPT, PaLM2 y otros modelos emergentes, así como con sus arquitecturas subyacentes.

- Experimentación e iteración. Capacidad para probar, perfeccionar y optimizar las indicaciones basadas en los resultados del modelo.

- Análisis de datos. Analizar las respuestas de los modelos, identificar patrones y tomar decisiones basadas en datos.

Para aquellos que desean adquirir o perfeccionar sus habilidades técnicas, nuestro programa de formación en procesamiento del lenguaje natural en Python ofrece un plan de estudios completo adecuado para los aspirantes a ingenieros de prompts.

Habilidades no técnicas para la ingeniería rápida

Si bien la destreza técnica es fundamental, un ingeniero ágil también necesita un conjunto de habilidades no técnicas:

- Comunicación. La capacidad de transmitir ideas, colaborar con equipos y comprender las necesidades de los usuarios.

- Experiencia en la materia. Dependiendo de la aplicación, el conocimiento específico del dominio puede ser muy valioso.

- Competencia lingüística. Dominio del lenguaje, la gramática y la semántica para crear indicaciones eficaces.

- Pensamiento crítico. Evaluar los resultados de los modelos, identificar sesgos y garantizar prácticas éticas en materia de IA.

- Creatividad. Pensar de forma creativa, experimentar con nuevos estilos de indicaciones e innovar en soluciones.

Estas habilidades sociales, combinadas con la experiencia técnica, hacen que el papel de un ingeniero de prompts sea tan desafiante como gratificante, allanando el camino para una nueva era de colaboración entre humanos e inteligencia artificial.

El futuro de la ingeniería de prompts

Ahora que nos encontramos en los albores de una era impulsada por la IA, la ingeniería rápida está llamada a desempeñar un papel fundamental en la configuración del futuro de las interacciones entre los seres humanos y la IA. Aunque es un campo relativamente nuevo, tiene un enorme potencial y perspectivas de crecimiento.

Investigación y desarrollos en curso

El mundo de la IA es dinámico, con investigaciones e innovaciones que surgen a un ritmo vertiginoso. En el contexto de la ingeniería rápida:

- Indicaciones adaptativas. Los investigadores están explorando formas para que los modelos generen de forma adaptativa sus propias indicaciones basándose en el contexto, lo que reduce la necesidad de introducir datos manualmente.

- Indicaciones multimodales. Con el auge de los modelos de IA multimodales que pueden procesar tanto texto como imágenes, el alcance de la ingeniería de prompts se está ampliando para incluir señales visuales.

- Incitaciones éticas. A medida que la ética de la IA cobra importancia, se presta especial atención a la elaboración de indicaciones que garanticen la equidad, la transparencia y la mitigación de los sesgos.

Para aquellos que desean mantenerse al día con las últimas novedades, nuestro artículo sobre la ética en la IA generativa aborda algunas de las grandes cuestiones a las que nos enfrentamos en la actualidad. También puedes explorar las habilidades de los ingenieros de IA y dónde se solapan con la ingeniería de prompts en una guía aparte.

El valor y la relevancia a largo plazo

La ingeniería rápida no es solo una moda pasajera. A medida que los modelos de IA se vuelven más complejos y se integran en diversas aplicaciones, desde la atención sanitaria hasta el entretenimiento, la necesidad de una comunicación eficaz se vuelve primordial. Los ingenieros de Prompt serán los encargados de garantizar que estos modelos sean accesibles, fáciles de usar y contextualmente relevantes.

Además, a medida que la IA se democratiza y más personas sin conocimientos técnicos comienzan a interactuar con estos modelos, el papel de los ingenieros de prompts evolucionará. Serán responsables de crear interfaces intuitivas, diseñar indicaciones fáciles de usar y garantizar que la IA siga siendo una herramienta que potencie las capacidades humanas.

Retos y oportunidades

Como cualquier campo emergente, la ingeniería rápida conlleva una serie de retos:

- Complejidad de los modelos. A medida que los modelos aumentan en tamaño y complejidad, crear indicaciones eficaces se vuelve más difícil.

- Sesgo y equidad. Garantizar que las indicaciones no introduzcan o amplifiquen inadvertidamente sesgos en los resultados del modelo.

- Colaboración interdisciplinaria. La ingeniería de prompts se encuentra en la intersección entre la lingüística, la psicología y la informática, lo que requiere la colaboración entre diferentes disciplinas.

Sin embargo, estos retos también ofrecen oportunidades. Impulsan la innovación, fomentan la colaboración interdisciplinaria y allanan el camino para la próxima generación de herramientas y soluciones de IA.

Consideraciones éticas en la ingeniería rápida

A medida que la IA se convierte en un elemento básico en diversas industrias, las consideraciones éticas en la ingeniería rápida cobran protagonismo. La función de los ingenieros de prompts va más allá de la creación de prompts eficaces: también deben garantizar que los modelos de IA interactúen con los usuarios de una manera justa, imparcial y ética. A continuación se indican las áreas clave en las que centrarse:

Mitigación del sesgo

Los ingenieros de prompts desempeñan un papel crucial en la reducción de los sesgos en los resultados de la IA, que pueden surgir de los datos de entrenamiento o de la propia redacción de los prompts. Las estrategias incluyen:

- Diseño de indicaciones neutrales: Evita las preguntas capciosas o las indicaciones que puedan predisponer al modelo a generar respuestas sesgadas.

- Prueba de imparcialidad: Prueba regularmente las indicaciones con diversas entradas para garantizar resultados equilibrados en diferentes grupos demográficos o contextos.

- Concienciación sobre los sesgos en los datos: Comprender los conjuntos de datos utilizados para entrenar los LLM y adaptar las indicaciones para contrarrestar cualquier sesgo inherente.

Interacciones justas con la IA

Para garantizar interacciones equitativas, los ingenieros pueden:

- Utiliza indicaciones contextuales: Orientar a los modelos para que consideren perspectivas más amplias en sus respuestas, como incluir puntos de vista poco representados.

- Supervisarlas normaséticas: Incorporar directrices éticas en las prácticas de ingeniería de indicaciones, como evitar indicaciones que puedan provocar resultados perjudiciales o discriminatorios.

Transparencia y explicabilidad

Los ingenieros de prompts deben buscar la transparencia creando prompts que permitan interacciones claras y comprensibles con la IA. Esto incluye:

- Destacar las limitaciones de la IA en las respuestas.

- Diseñar indicaciones que animen al modelo a citar fuentes o aclarar el razonamiento.

Reflexiones finales

El ámbito de la inteligencia artificial es amplio, complejo y está en constante evolución. A medida que hemos ido profundizando en las complejidades de la ingeniería de prompts, ha quedado claro que este campo es más que un simple esfuerzo técnico: es un puente entre la intención humana y la comprensión de las máquinas. Es el sutil arte de hacer las preguntas adecuadas para obtener las respuestas deseadas.

La ingeniería de prompts, aunque es una disciplina relativamente nueva, es la clave para liberar todo el potencial de los modelos de IA, especialmente los modelos de lenguaje grandes. A medida que estos modelos se integran cada vez más en nuestra vida cotidiana, no se puede subestimar la importancia de una comunicación eficaz. Ya sea un asistente de voz que ayuda con las tareas diarias, un chatbot que brinda atención al cliente o una herramienta de inteligencia artificial que ayuda a los investigadores, la calidad de la interacción depende de las indicaciones que los guían.

Para los entusiastas de los datos, los profesionales e incluso el público en general, comprender la ingeniería de comandos no solo se trata de mejorar la comunicación con la IA. Se trata de imaginar un futuro en el que la IA se integre perfectamente en nuestras vidas, aumentando nuestras capacidades y enriqueciendo nuestras experiencias.

En este momento, el futuro de la ingeniería rápida es prometedor, lleno de retos que superar y hitos que alcanzar. Para aquellos que os interesa este campo, el viaje acaba de empezar. Descubre los fundamentos de la ingeniería de prompts con nuestro curso y aprende a utilizar la IAcon nuestra guía específica, o aprende a entrenar tu propio LLM con PyTorch en nuestro tutorial.

Obtén una certificación superior en IA

Escritora y editora de contenidos en el ámbito de la tecnología educativa. Comprometido con la exploración de tendencias de datos y entusiasmado con el aprendizaje de la ciencia de datos.

Preguntas frecuentes sobre ingeniería rápida

¿Qué es exactamente un prompt en el contexto de la IA?

Una indicación es una pregunta o instrucción que se le da a un modelo de IA, especialmente a un modelo de lenguaje grande (LLM), para obtener una respuesta específica. Sirve como interfaz entre la intención humana y el resultado de la máquina.

¿Por qué es importante la ingeniería rápida?

La ingeniería de prompts garantiza que los modelos de IA produzcan resultados precisos y relevantes. Es el arte de crear indicaciones eficaces que guíen el comportamiento del modelo, garantizando una comunicación eficaz entre humanos e IA.

¿Necesitas conocimientos previos sobre inteligencia artificial o machine learning para comprender la ingeniería de prompts?

Aunque tener conocimientos previos sobre IA puede ser beneficioso, no es estrictamente necesario. La ingeniería de prompts tiene tanto que ver con el lenguaje y la comunicación como con los conocimientos técnicos. Con los recursos y el aprendizaje adecuados, cualquiera puede comprender sus fundamentos.

¿Cómo se relaciona la ingeniería de prompts con los chatbots y los asistentes de voz?

Los chatbots y los asistentes de voz dependen en gran medida de las indicaciones. Las preguntas que haces o las órdenes que das son, en esencia, indicaciones. Una ingeniería eficaz y rápida garantiza que estas herramientas comprendan y respondan con precisión a las consultas de los usuarios.

¿Existen riesgos asociados con la ingeniería rápida?

Como cualquier práctica de IA, la ingeniería de prompts puede presentar retos. Las indicaciones sesgadas o mal redactadas pueden dar lugar a resultados inexactos o sesgados del modelo. Es fundamental abordar la ingeniería rápida con cuidado, garantizando la equidad y la transparencia.