Curso

Con el lanzamiento de ChatGPT, en medio del revuelo de la IA, OpenAI lanzó GPT-4, su producto estrella con extraordinarias capacidades de IA generativa. Durante su lanzamiento en marzo de 2023, habló de las posibilidades de la IA generativa multimodal a través de GPT-4. La multimodalidad en la IA generativa se refiere a la capacidad de un sistema para procesar, comprender y/o generar resultados para más de un tipo de datos.

Obtenga más información sobre cómo funcionan los LLM hoy mismo iniciando nuestro Curso de Conceptos de Modelos de Lenguaje de Gran Tamaño (LLM).

Tras meses de silencio, en septiembre de 2023, OpenAI anunció esta capacidad multimodal para ChatGPT, que ahora puede ver, oír y hablar, lo que indica nuevas capacidades de imagen y voz desplegadas en ChatGPT. Se espera que la capacidad multimodal de los sistemas de IA, una vez perfeccionados, abra nuevas posibilidades e innovaciones para múltiples industrias.

En este tutorial, presentaremos las capacidades de imagen y comprenderemos el modelo de visión GPT-4, que permite al ChatGPT "ver". Por fin comprenderíamos las limitaciones actuales del modelo y le dejaríamos más recursos.

¿Qué es GPT-4 Vision?

GPT-4 Vision (GPT-4V) es un modelo multimodal que permite al usuario cargar una imagen como entrada y entablar una conversación con el modelo. La conversación podría incluir preguntas o instrucciones en forma de aviso, que dirijan al modelo a realizar tareas basadas en la información proporcionada en forma de imagen.

El modelo GPT-4V se basa en las capacidades existentes de GPT-4, ofreciendo un análisis visual además de las funciones de interacción de texto existentes. Hemos cubierto la introducción para principiantes a la API OpenAI que te ayudará a ponerte al día sobre los desarrollos previos al lanzamiento del modelo GPT-4V.

Principales funciones de GPT-4 Vision

- Entradas visuales: La principal característica del nuevo GPT-4 Vision es que ahora puede aceptar contenidos visuales como fotografías, capturas de pantalla y documentos y realizar diversas tareas.

- Detección y análisis de objetos: El modelo puede identificar y proporcionar información sobre objetos dentro de las imágenes.

- Análisis de datos: GPT-4 Visión es competente en la interpretación y análisis de datos presentados en formatos visuales como gráficos, tablas y otras visualizaciones de datos.

- Descifrado de textos: El modelo es capaz de leer e interpretar notas manuscritas y texto dentro de imágenes.

Ahora que ya conocemos algunas de las muchas funciones de GPT-4 Vision, vamos a probarlo nosotros mismos.

Manos a la obra: Primeros pasos con GPT-4 Vision

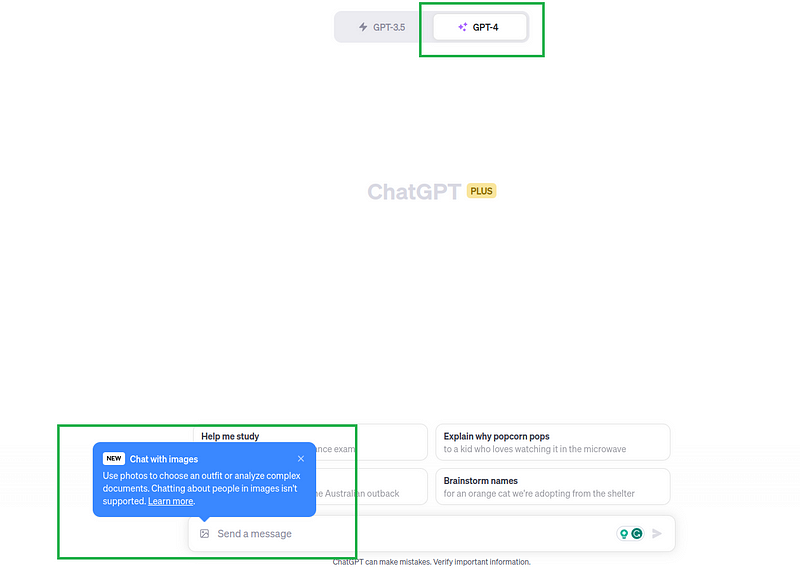

GPT-4 Vision está disponible actualmente (a partir de octubre de 2023) sólo para los usuarios de ChatGPT Plus y Enterprise. ChatGPT Plus cuesta 20 $/mes, a los que se puede actualizar desde las cuentas gratuitas normales de ChatGPT.

Suponiendo que seas completamente nuevo en ChatGPT, a continuación te explicamos cómo acceder a GPT-4 Vision:

- Visite el sitio web de OpenAI ChatGPT y regístrese para obtener una cuenta.

- Inicie sesión en su cuenta y vaya a la opción "Pasar a Plus".

- Siga adelante con la actualización para obtener acceso a ChatGPT Plus (Nota: se trata de una suscripción mensual de 20 $)

- Seleccione el "GPT-4" como su modelo en la ventana de chat, como se muestra en el siguiente diagrama.

- Haga clic en el icono de imagen para cargar la imagen, y añada un aviso indicando al GPT-4 que lo realice.

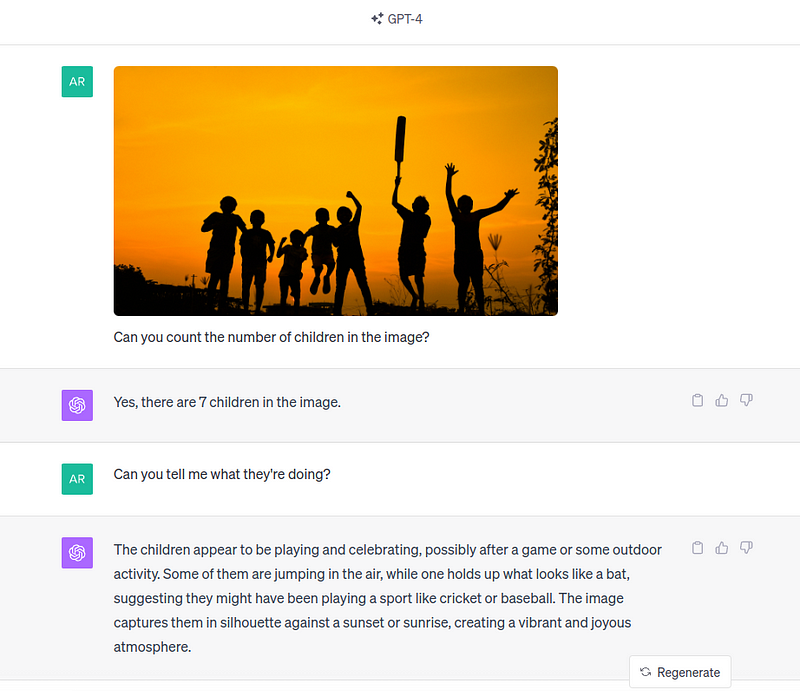

Aquí, GPT-4 Vision hace un trabajo bastante bueno al entender que los niños estaban jugando al cricket basándose en el bate en la mano de un niño. En el mundo de la IA, esta tarea se conoce como detección de objetos, donde los objetos identificados son los niños y el murciélago. Consulte nuestro tutorial sobre detección de objetos YOLO para obtener más información.

Del mismo modo, puede proceder a realizar mejor una tarea diferente en función de su caso de uso.

GPT-4 Visión Casos reales y ejemplos

Ahora que hemos comprendido sus capacidades, ampliémoslas a algunas aplicaciones prácticas en la industria:

1. Investigación académica

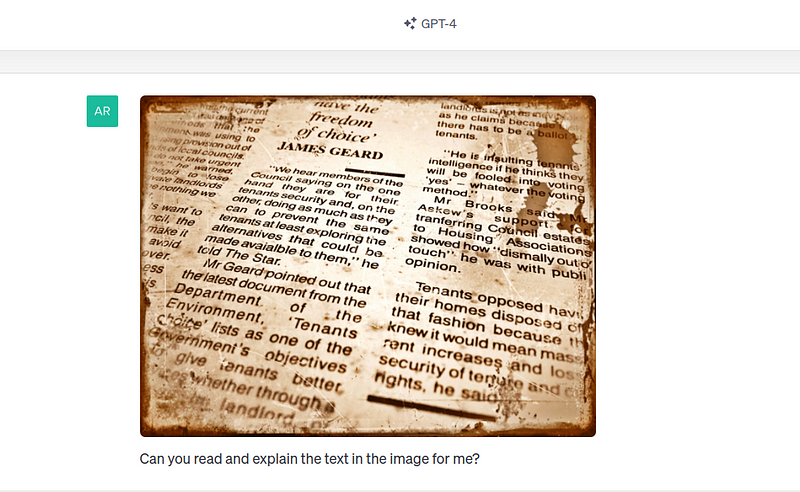

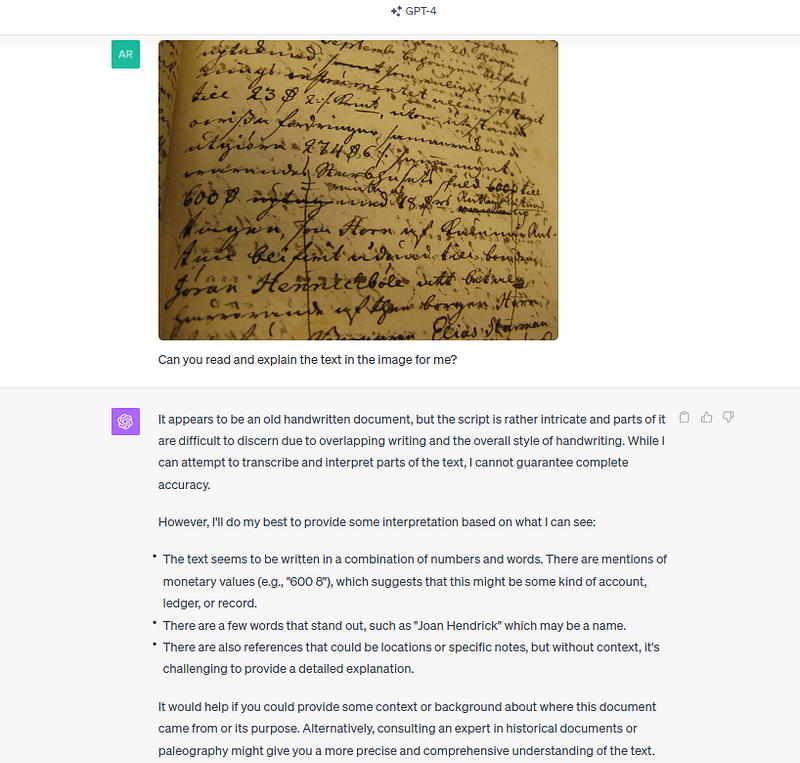

La integración por parte de GPT-4 Vision del modelado avanzado del lenguaje con capacidades visuales abre nuevas posibilidades en campos académicos, especialmente en el descifrado de manuscritos históricos. Tradicionalmente, esta tarea ha sido un empeño meticuloso y laborioso llevado a cabo por paleógrafos e historiadores expertos.

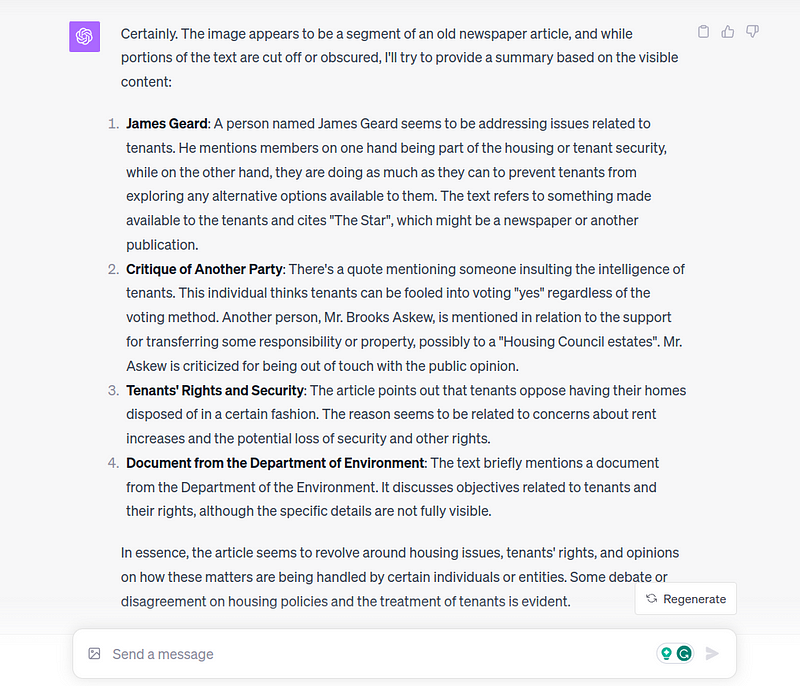

Primero damos una imagen que parece formar parte de un antiguo artículo de periódico:

GPT-4 Vision hace un buen trabajo leyendo el contenido de la imagen e interpretándolo:

El modelo fue capaz de leer, descifrar el contenido y proporcionar un análisis del mismo al tiempo que daba una respuesta realista, que algunas partes de la imagen están cortadas y oscurecidas.

Sin embargo, también hay que señalar que el modelo tiene dificultades cuando se trata de manuscritos complejos, sobre todo en otras lenguas (más adelante hablaremos de ello), como se ve a continuación:

2. Desarrollo web

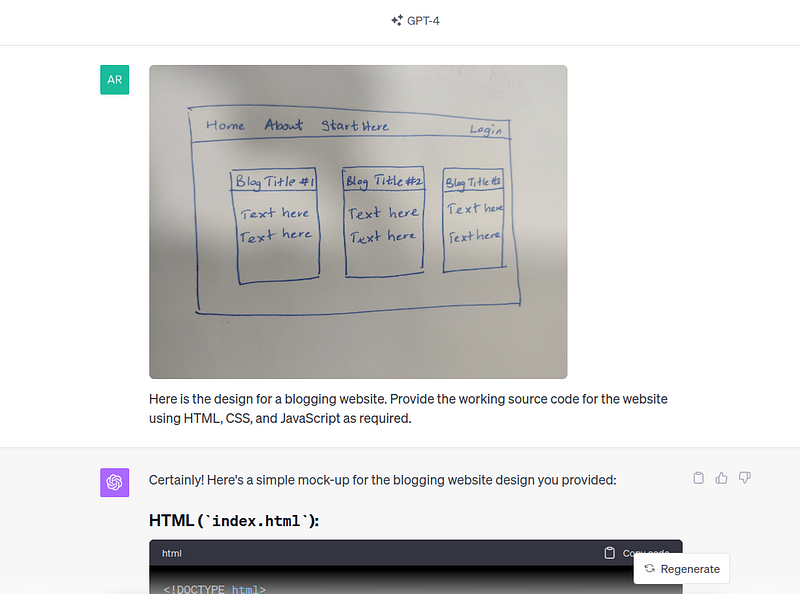

La visión GPT-4 puede escribir código para un sitio web cuando se le proporciona una imagen visual del diseño requerido. Lleva desde un diseño visual hasta el código fuente de un sitio web. Esta única capacidad del modelo puede reducir drásticamente el tiempo necesario para construir sitios web.

Impulsemos la visión GPT-4 con un diseño sencillo dibujado a mano para un sitio web de blogs.

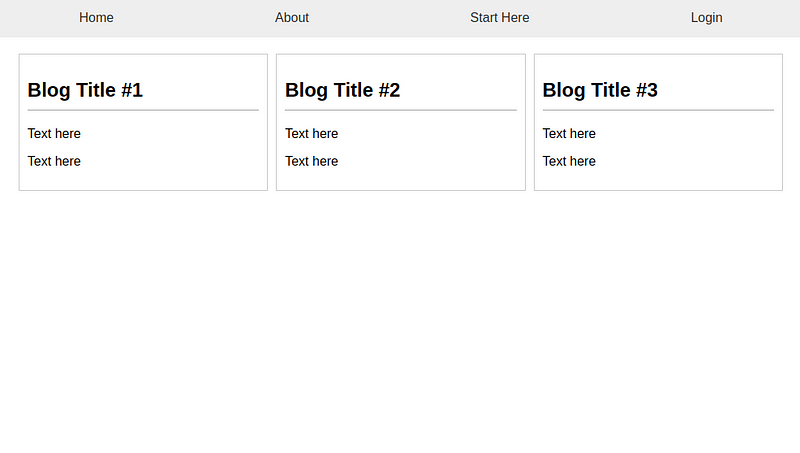

Una vez que proporciona el código fuente, simplemente copiamos-pegamos y creamos los archivos HTML y CSS según las instrucciones. Este es el aspecto del sitio web:

¿No se parece mucho? Por supuesto, hemos dado un ejemplo sencillo, pero usted podría partir de aquí y desarrollar un sitio web más complejo y a medida en una fracción del tiempo, gracias al modelo GPT-4 Vision recientemente introducido.

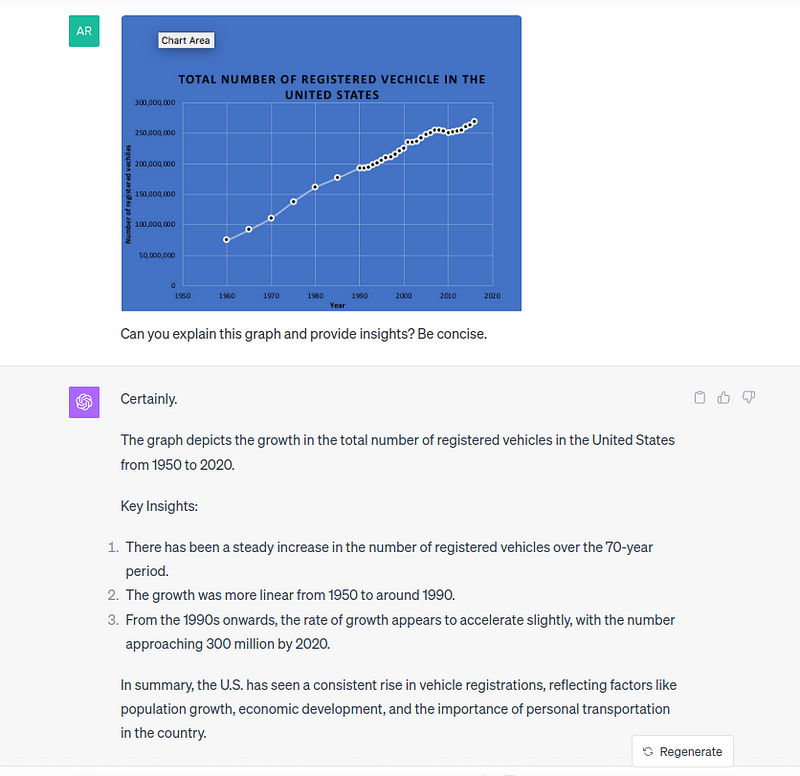

3. Interpretación de los datos

El modelo es capaz de analizar visualizaciones de datos para interpretar los datos subyacentes y proporcionar perspectivas clave basadas en las visualizaciones. Para probar esta función, podemos simplemente dar un argumento y pedir opiniones.

Aunque hace un buen trabajo para comprender el contexto general del gráfico y la tendencia lineal, comete errores al mencionar que el año de inicio es 1950, aunque los puntos de datos sólo comienzan a partir de 1960. El modelo también deduce factores como el crecimiento de la población y el desarrollo económico; aunque podrían ser ciertos, esos datos no pueden deducirse únicamente de este gráfico concreto.

Se pueden formular múltiples preguntas de seguimiento para afinar el resultado inicial del modelo GPT-4 Vision. Según nuestras pruebas, sigue siendo necesaria la intervención humana para revisar los resultados, y el modelo puede mejorar la productividad de los casos de interpretación de datos.

4. Creación de contenidos creativos

Con la llegada de ChatGPT, las redes sociales se han llenado de diversas técnicas de ingeniería de avisos, y muchos han encontrado formas sorprendentes y creativas de utilizar la tecnología generativa en su beneficio.

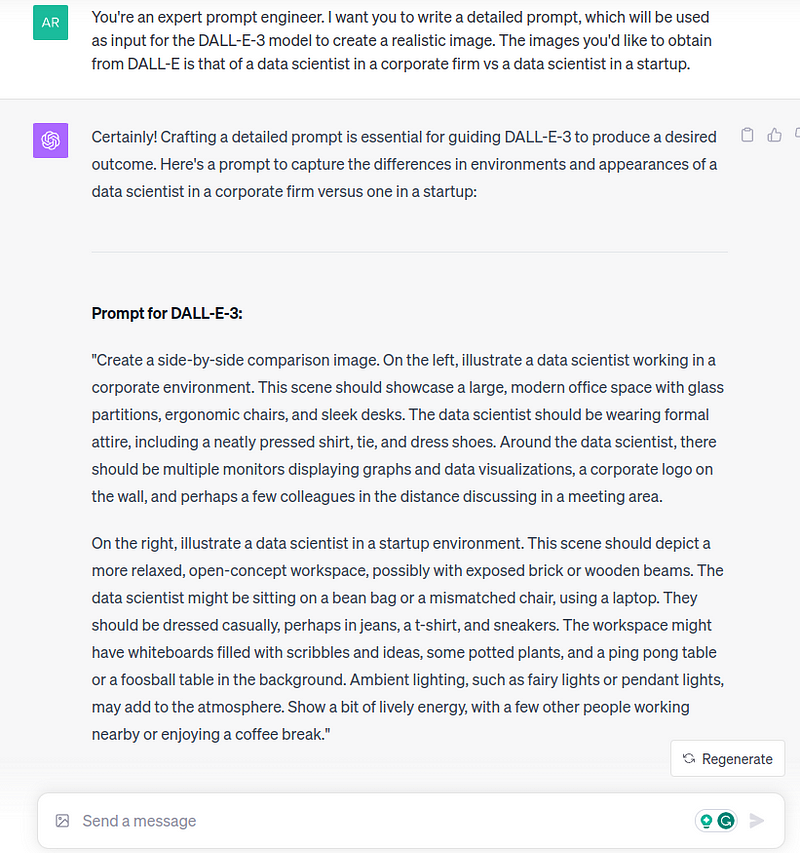

Para este tutorial, utilizaremos el DALL-E-3 (que también está disponible en ChatGPT Plus) junto con GPT-4 Vision, para crear de forma creativa un post para redes sociales.

Paso 1: Pide a GPT-4 que cree un prompt para generar una imagen. Digamos que quieres crear un post contrastando las diferencias entre el papel de un científico de datos en una startup frente a uno corporativo.

Segundo paso: Utiliza el indicador y genera una imagen de DALL-E. Puedes ajustar y perfeccionar el mensaje hasta que estés satisfecho con el resultado.

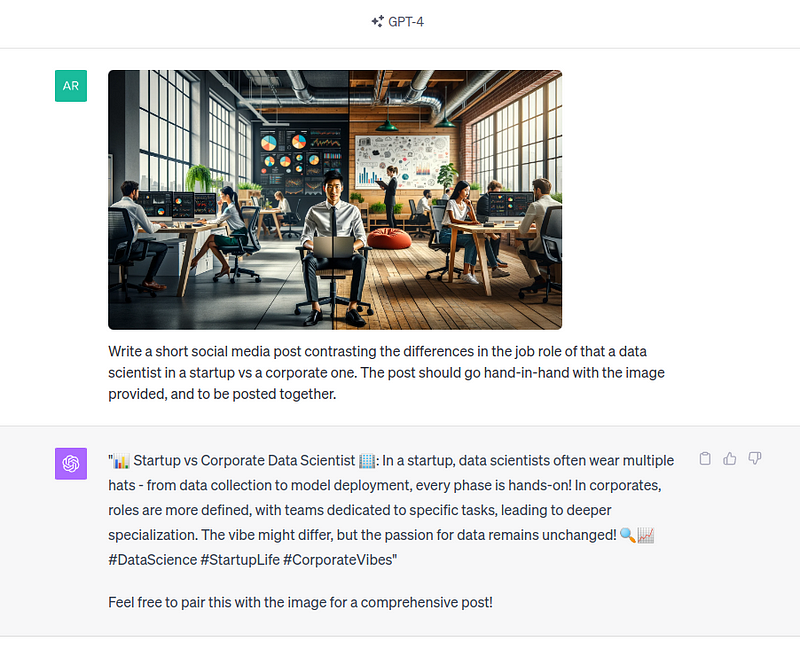

Tercer paso: Utiliza la imagen y pide a GPT-4 Vision que cree un post que acompañe a la imagen.

Si se retoca y se proporciona una indicación más detallada, se podría obtener un mejor resultado y explorar más a fondo la generación de contenidos creativos. Cabe señalar que no se recomienda bombardear Internet o las redes sociales con contenidos generados por IA, ya que estos contenidos tienen sus propias limitaciones. En su lugar, comprueba los hechos y refínalos con tus propias experiencias.

Por supuesto, esta no es una lista exhaustiva de los casos de uso posibles: GPT-4 Vision es capaz de muchos más. En lugar de eso, considérelo una fuente de inspiración y un punto de partida para explorar su curiosidad aplicando la tecnología a un ámbito de su elección.

Limitaciones y riesgos de la visión GPT-4

Hay una última cosa que debes tener en cuenta antes de utilizar GPT-4 Vision en casos de uso: las limitaciones y los riesgos asociados a ella.

Esto es especialmente importante porque la propia OpenAI se ha tomado unos meses extra desde el lanzamiento de GPT-4 en marzo de 2023 para probarlo con su ejercicio de "red-teaming" interno y externo para determinar las deficiencias de esta tecnología generativa, que han esbozado en la ficha del sistema.

1. Precisión y fiabilidad

Aunque el modelo GPT-4 representa un avance significativo hacia la fiabilidad y la precisión, no siempre es así. Según OpenAI, basándose en las pruebas internas, el GPT-4 Vision puede seguir siendo poco fiable e impreciso en ocasiones. El equipo llega incluso a mencionar que "ChatGPT puede cometer errores. Verificar información importante" debajo de la barra de chat cuando introducimos texto e imágenes.

Por lo tanto, es de suma importancia que los usuarios evalúen críticamente los resultados del modelo y se mantengan alerta.

2. Intimidad y parcialidad

Según OpenAI, al igual que sus predecesores, GPT-4 Vision sigue reforzando prejuicios sociales y visiones del mundo, incluidas asociaciones estereotipadas y degradantes perjudiciales para determinados grupos marginados. Por lo tanto, es importante comprender esta limitación y tomar otras medidas necesarias para manejar el sesgo dentro del propio caso de uso y no confiar en el modelo para resolverlo.

Además de los problemas de sesgo, los datos compartidos con ChatGPT pueden utilizarse para entrenar modelos a menos que se opte por no hacerlo; por lo tanto, es importante tener cuidado de no compartir información sensible o privada con el modelo. Los usuarios también pueden optar por no compartir datos para mejorar los modelos accediendo a "Controles de datos" en la sección "Ajustes y Beta".

3. Restringido para tareas de riesgo

GPT-4 Vision es incapaz de responder a preguntas que piden identificar individuos específicos en una imagen. Este es un comportamiento de "rechazo" esperado por diseño. Además, OpenAI aconseja abstenerse de utilizar GPT-4 Vision en tareas de alto riesgo, entre las que se incluyen:

- Competencia científica: El modelo podría pasar por alto texto o caracteres, pasar por alto símbolos matemáticos de las imágenes proporcionadas con información científica y ser incapaz de reconocer ubicaciones espaciales y mapeados de colores.

- Consejos médicos: El modelo proporciona a veces respuestas correctas para preguntas basadas en imágenes médicas, pero flaquea en ocasiones para la misma pregunta. Dadas las incoherencias en las respuestas, las respuestas o los resultados del modelo no deben considerarse sustitutivos del asesoramiento médico profesional.

- Riesgos de desinformación: Se dice que la gente cree las afirmaciones (independientemente de que sean ciertas o no) cuando van acompañadas de imágenes. El modelo puede utilizarse para generar contenidos de texto verosímiles, realistas y específicos, adaptados a la entrada de una imagen y, por tanto, poseedores del riesgo de desinformación.

- Contenido de odio: El modelo se niega a responder a preguntas con símbolos de odio y contenido extremista en algunos casos, pero no siempre es así. Este sigue siendo un problema difícil de resolver para OpenAI.

Por lo tanto, como usuarios, debemos estar atentos para utilizar GPT-4 Vision de forma responsable, especialmente en las tareas de alto riesgo y los contextos delicados mencionados anteriormente.

Conclusión

Este tutorial le ofrece una introducción completa al nuevo modelo GPT-4 Vision. También se le advirtió de las limitaciones y riesgos que plantea el modelo, y ahora entiende cómo y cuándo utilizarlo.

La forma más práctica de dominar la nueva tecnología es ponerte manos a la obra y experimentar dándole diversas indicaciones para evaluar sus capacidades y, con el tiempo, te irás sintiendo más cómodo con ella.

Aunque se trata de una herramienta relativamente nueva y con un mes de vida, se basa en los principios de los grandes modelos lingüísticos y GPT-4. Aquí tienes más recursos relacionados si quieres profundizar en los conceptos fundamentales y relacionados del modelo GPT-4 Vision: