Lernpfad

Große Sprachmodelle können Texte verstehen und schreiben, die sehr menschenähnlich klingen. Aber wenn es darum geht, dass diese Modelle genau das tun, was wir wollen, ist das nicht so einfach. Um eine zufriedenstellende Antwort zu erhalten, muss man geeignete Techniken wählen.

Eine dieser Techniken ist das "few-shot prompting". Es ist eine clevere Methode, die dabei hilft, das, was das Modell bereits weiß, mit dem zu verbinden, was es für eine bestimmte Aufgabe tun soll - du gibst dem Modell ein paar schnelle Beispiele, um ihm zu zeigen, was du willst, damit es die Aufgabe leichter versteht und richtig ausführt.

In diesem Lernprogramm lernst du:

- Was ein "few-shot prompting" ist und warum es wichtig ist.

- Wie das Souffleurverfahren mit wenigen Schüssen funktioniert, einschließlich Demonstrationen und Lernen am Beispiel.

- Die Vorteile des "few-shot prompting", wie z.B. die verbesserte Leistung und der geringere Datenbedarf.

- Verschiedene Anwendungen von "few-shot prompting", darunter komplexe Denkaufgaben, kreatives Schreiben und Codegenerierung.

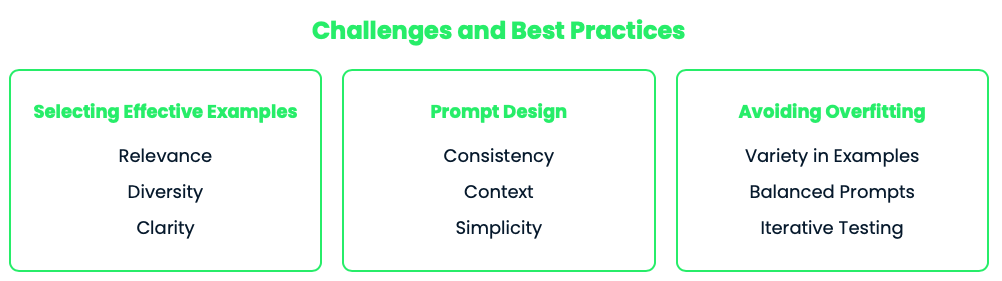

- Herausforderungen und bewährte Praktiken bei der Erstellung von Souffleusen, einschließlich der Auswahl effektiver Beispiele und der Gestaltung von Souffleuren.

Dieses Tutorial ist Teil meines "Prompt Engineering": Die Blogserie "From Zero to Hero":

- Promptes Engineering für alle

- Zero-Shot Prompting

- Few-Shot Prompting

- Prompt Chaining

Willst du mit generativer KI beginnen?

Lerne, wie du mit LLMs in Python direkt in deinem Browser arbeiten kannst

Was ist Few-Shot Prompting?

Few-Shot Prompting ist eine Technik, bei der ein Sprachmodell mit einer kleinen Anzahl von Beispielen versorgt wird, um seine Antwort auf eine bestimmte Aufgabe zu steuern. Diese Methode liegt zwischen dem Zero-Shot-Lernen (bei dem keine Beispiele gegeben werden) und der vollständig überwachten Feinabstimmung (die große Mengen an gelabelten Daten erfordert). Der Blog-Beitrag über few-shot learning erklärt diese Technik des maschinellen Lernens im Detail.

Mit anderen Worten: Beim "few-shot prompting" erhält das Sprachmodell eine Handvoll Demonstrationen oder Beispieleinnerhalb des Prompts selbst. Diese Beispiele dienen als Leitfaden und zeigen dem Modell, wie man an eine bestimmte Art von Aufgabe oder Frage herangeht und darauf reagiert. Wenn du diese Beispiele anführst, sagst du dem Modell: "So solltest du in ähnlichen Situationen reagieren.

Schauen wir uns ein Beispiel an.

Stell dir vor, wir wollen, dass das Modell die Stimmung von Filmkritiken klassifiziert. Eine kurze Aufforderung könnte so aussehen:

Prompt:

Classify the sentiment of the third movie review. Use the information from the first two examples:Review: "This movie was a waste of time."Sentiment: NegativeReview: "I couldn't stop laughing throughout the film!"Sentiment: PositiveReview: "The special effects were amazing, but the plot was confusing."Sentiment:```markdownIf we input this prompt to the LLM, and if it understands the task correctly, it will output:```markdownSentiment: MixedIn diesem Beispiel verwendet der LLM die Beispiele in der Eingabeaufforderung, um zu verstehen, wie das Sentiment der dritten Rezension zu klassifizieren ist, und erzeugt die entsprechende Ausgabe.

Wenige Prompts sind wichtig, weil sie LLMs nützlicher und zugänglicher machen. Erstens spart es Zeit und Mühe, da du das Modell nicht komplett neu trainieren oder große Datenmengen sammeln musst.

Zweitens ist es sehr flexibel - du kannst das Modell schnell an verschiedene Aufgaben anpassen, indem du einfach die Beispiele änderst, die du ihm gibst. Drittens hilft es dem LLM oft, bestimmte oder komplexe Aufgaben besser zu bewältigen, als wenn man ihn bittet, etwas ohne jegliche Anleitung zu tun. Diese Methode macht außerdem leistungsstarke KI-Tools für mehr Menschen zugänglich, nicht nur für Technikexperten mit vielen Ressourcen.

Wie Few-Shot Prompting funktioniert

Der Kern des "few-shot prompting" liegt darin, dem LLM eine kleine Anzahl relevanter Beispiele oder Demonstrationen innerhalb des Prompts selbst zu geben. Diese Beispiele dienen als Leitfaden für das Modell und zeigen, wie man eine bestimmte Art von Aufgabe oder Frage angeht und beantwortet. Demonstrationen sind in der Regel wie folgt aufgebaut:

- Input-Output-Paare: Jede Demonstration besteht in der Regel aus einem Input (z. B. einer Frage oder einem Text) und dem entsprechenden Output (der gewünschten Antwort oder Lösung).

- Formatkonsistenz: Die Demonstrationen haben ein einheitliches Format, das dem Modell hilft, das Muster zu erkennen, dem es folgen soll.

- Aufgabenrelevanz: Die Beispiele haben einen direkten Bezug zu der jeweiligen Aufgabe und zeigen, welche besonderen Fähigkeiten oder Kenntnisse erforderlich sind.

Wenn wir zum Beispiel wollen, dass das Modell Reimpaare erzeugt, könnte eine kurze Aufforderung wie folgt aussehen:

Generate a rhyming couplet about a tree:Input: "cat"Output: The curious cat, so sleek and fat, Curled up cozy on the welcome mat.Input: "sky"Output: Look up high into the endless sky, Where birds and clouds go drifting by.Input: "tree"Output:Wenn das Sprachmodell mit diesen Demonstrationen konfrontiert wird, führt es einen Prozess durch, der oft als "kontextbezogenes Lernen" oder "Lernen am Beispiel" bezeichnet wird. Das funktioniert so:

- Mustererkennung: Das Modell analysiert die bereitgestellten Beispiele und identifiziert Muster, wie Eingaben in Ausgaben umgewandelt werden.

- Ableitung von Aufgaben: Aus diesen Mustern schließt das Modell auf die Art der Aufgabe, die es erfüllen soll.

- Verallgemeinerung: Das Modell versucht dann, von den gegebenen Beispielen auf neue, ungesehene Eingaben zu generalisieren.

- Anwendung: Schließlich wendet das Modell dieses gelernte Muster auf die neue Eingabe am Ende der Aufforderung an.

![]()

Dieser Prozess ermöglicht es dem Modell, sein Wissen und seine Fähigkeiten an eine bestimmte Aufgabe anzupassen, ohne dass die zugrunde liegenden Parameter geändert werden müssen.

Es ist wichtig zu wissen, dass die Effektivität von "few-shot prompting" von Faktoren wie der Komplexität der Aufgabe, der Qualität und Relevanz der Beispiele und den Fähigkeiten des zugrunde liegenden Sprachmodells abhängt. Wenn sie jedoch effektiv eingesetzt werden, können Sprachmodelle viele verschiedene Aufgaben mit beeindruckender Genauigkeit und Flexibilität erledigen.

Vorteile von Few Shot Prompting

Few-Shot Prompting hat ein paar Vorteile. Sehen wir uns an, warum diese Methode so hilfreich ist.

Verbesserte Leistung

Einer der bemerkenswertesten Vorteile von "few-shot prompting" ist die erhebliche Leistungssteigerung im Vergleich zu "zero-shot" Ansätzen.

- Verbesserte Genauigkeit: Das Modell versteht die jeweilige Aufgabe besser, was zu genaueren Ergebnissen führt, da es relevante Beispiele liefert.

- Erhöhte Relevanz: Die Beispiele leiten das Modell dazu an, Antworten zu geben, die dem gewünschten Ergebnis näher kommen.

- Aufgabenspezifische Anpassung: Ein paar kurze Anweisungen helfen dem LLM, das, was es bereits weiß, zu nutzen, um neue, spezifische Aufgaben zu verstehen und auszuführen.

Nehmen wir zum Beispiel ein Szenario, in dem das Modell Produktbeschreibungen in einem bestimmten Ton und Format erstellen soll.

Generate product descriptions:Product: Wireless EarbudsDescription: Immerse yourself in crystal-clear audio with our sleek wireless earbuds. Featuring noise-cancellation technology and a comfortable fit, these earbuds are perfect for music lovers on the go.Product: Smart WatchDescription: Stay connected and track your fitness with our advanced smart watch. With heart rate monitoring, GPS, and a vibrant touch screen, it's your perfect companion for an active lifestyle.Product: Ergonomic Office ChairDescription:Bei diesen Beispielen ist es wahrscheinlicher, dass das Modell eine relevante und angemessen gestaltete Beschreibung für den Bürostuhl erstellt, als wenn es bei einem Null-Schuss-Ansatz eine allgemeinere oder weniger fokussierte Beschreibung erstellen würde.

Eine mögliche Ausgabe könnte sein:``Markdown

Beschreibung: Verwandle deinen Arbeitsplatz mit unserem modernen ergonomischen Bürostuhl. Dieser Stuhl wurde für ultimativen Komfort und Unterstützung entwickelt und verfügt über eine verstellbare Lendenwirbelstütze, eine atmungsaktive Netzrückenlehne und anpassbare Armlehnen. Egal, ob du von zu Hause aus oder in einem Unternehmen arbeitest, dieser Stuhl ist die perfekte Mischung aus Stil und Funktionalität für den modernen Berufstätigen.

Faster adaptationFew-shot prompting helps the LLM to quickly learn new tasks or topics, making it fast and easy to switch between different jobs.Quick task learning: Models can quickly grasp new tasks with just a handful of examples, allowing for rapid prototyping and testing of new applications.Domain adaptation: It's easy to shift the model's focus to different domains or styles by simply changing the examples in the prompt.Iterative refinement: Users can quickly iterate and refine their prompts based on initial results, leading to a more agile development process.For example, if we wanted to adapt the model to generate different types of poetry, we could quickly switch between haikus, limericks, or sonnets just by changing the examples in our prompt:```markdownGenerate poetry based on the given theme and format.Theme: SpringHaiku: Cherry blossoms bloom Soft petals dance in the breeze Nature awakensTheme: SummerHaiku:Theme: A funny catLimerick: There once was a cat named Lou Who always knew just what to do He'd climb up a tree Then meow with glee And slide down as if on a chuteTheme: A clumsy dogLimerick:Eine mögliche Ausgabe wäre:

Haiku:Scorching sun aboveCicadas sing endlesslyBeach waves cool bare feetLimerick:There once was a dog quite unsteadyHis paws were not quite readyHe'd trip on his tailKnock over the mailBut his smile kept his owner steadyReduzierte Datenanforderungen

Few-Shot Prompting reduziert den Bedarf an großen Mengen an gelabelten Daten erheblich, was ein großer Vorteil gegenüber traditionellen Feinabstimmungsansätzen ist.

- Minimale Anzahl von Beispielen erforderlich: Oft reichen schon 2-5 Beispiele aus, um das Modell für viele Aufgaben effektiv zu steuern.

- Keine Feinabstimmung erforderlich: Im Gegensatz zu traditionellen Ansätzen des maschinellen Lernens müssen beim few-shot prompting die Parameter des Modells nicht aktualisiert werden, was Rechenressourcen und Zeit spart.

- Zugänglichkeit: Dieser Ansatz macht fortgeschrittene NLP-Fähigkeiten für Nutzer zugänglicher, die keinen Zugang zu großen Datensätzen oder die Ressourcen für umfangreiches Modelltraining haben.

Anwendungen von Few-Shot Prompting

Few-Shot Prompting kann in vielen Bereichen angewendet werden. Seine Flexibilität und Effizienz machen ihn besonders nützlich für Aufgaben, die Spezialwissen oder kreative Leistungen erfordern. Sehen wir uns einige wichtige Anwendungen an:

Komplexe logische Aufgaben

Wenige Aufforderungen können die Fähigkeit eines LLMs, Aufgaben zu bewältigen, die mehrstufiges Denken, logische Schlussfolgerungen oder domänenspezifisches Wissen erfordern, erheblich verbessern.

Schauen wir uns an, wie wir das "few-shot prompting" für eine medizinische Diagnose nutzen können:

Provide a possible diagnosis and explain your reasoning:Symptoms: Fever, cough, fatigueDiagnosis: Common coldExplanation: The combination of fever, cough, and fatigue is typical of a common cold. No severe symptoms are present, suggesting a mild viral infection.Symptoms: Chest pain, shortness of breath, dizzinessDiagnosis: Possible heart attackExplanation: The combination of chest pain, shortness of breath, and dizziness are warning signs of a possible heart attack. Immediate medical attention is required.Symptoms: Headache, sensitivity to light, nauseaDiagnosis:Explanation: Diese Aufforderung leitet das Modell dazu an, nicht nur eine Diagnose zu stellen, sondern auch die Gründe dafür zu erklären und so komplexes medizinisches Denken zu demonstrieren.

Der LLM würde ausgeben:``Markdown

Die Diagnose: Migraine

Erläuterung: Diese Symptome zusammen sind typisch für eine Migräne. Kopfschmerzen in Kombination mit Lichtempfindlichkeit (Photophobie) sind ein deutliches Anzeichen für Migräne, und Übelkeit begleitet diesen Zustand oft. Auch wenn andere Ursachen möglich sind, deutet diese Kombination stark auf Migränekopfschmerzen hin.

Creative writingFew-shot prompting is particularly effective in guiding LLMs to generate text in specific styles, formats, or genres.Let’s see how to generate movie synopsis in different genres using few-shot prompting:```markdownGenerate movie synopsis:Genre: Sci-FiSynopsis: In a world where dreams can be shared, a skilled "dream thief" is tasked with the impossible: planting an idea in someone's mind. As he delves deeper into the target's subconscious, the lines between reality and dreams blur, threatening to trap him forever.Genre: RomanceSynopsis: A chance encounter on a rainy day in Paris leads two strangers on a whirlwind 24-hour adventure. As they explore the city and each other's hearts, they must decide if their connection is strong enough to overcome the ocean that will separate them come morning.Genre: HorrorSynopsis: Diese Aufforderung leitet das Modell bei der Erstellung einer Zusammenfassung an, die die Schlüsselelemente und den Ton des angegebenen Genres einfängt.

Ausgabe:

Synopsis: A remote mountain town is plagued by a series of mysterious disappearances. As a skeptical detective investigates, she uncovers an ancient cult that awakens every hundred years to feed on the town's inhabitants. With time running out and the cult's power growing, she must confront her own dark past to save the remaining townspeople and herself from a terrifying fate.Code-Erstellung

Eine kurze Eingabeaufforderung kann unglaublich nützlich sein, wenn es darum geht, LLMs bei der Erstellung von Code zu unterstützen, der bestimmte Konventionen einhält, Best Practices befolgt oder bestimmte Anforderungen erfüllt. Beispiele können die richtige Syntax und Struktur für eine bestimmte Programmiersprache demonstrieren.

Sehen wir uns an, wie du mit Hilfe von few-shot prompting Python-Funktionen mit docstrings und type hints erzeugen kannst:

def calculate_area(length: float, width: float) -> float: """ Calculate the area of a rectangle. Args: length (float): The length of the rectangle. width (float): The width of the rectangle. Returns: float: The area of the rectangle. """ return length * widthdef celsius_to_fahrenheit(celsius: float) -> float: """ Convert temperature from Celsius to Fahrenheit. Args: celsius (float): Temperature in Celsius. Returns: float: Temperature in Fahrenheit. """ return (celsius * 9/5) + 32def calculate_bmi(weight: float, height: float) -> float: """ [Generate a docstring for this function] """ # [Generate the function body]Diese Aufforderung leitet das Modell dazu an, eine Funktion mit den richtigen Typ-Hinweisen und einem detaillierten Docstring zu erstellen, der dem festgelegten Muster folgt.

Die Ausgabe würde lauten:

def calculate_bmi(weight: float, height: float) -> float: """ Calculate the Body Mass Index (BMI) of a person. Args: weight (float): The weight of the person in kilograms. height (float): The height of the person in meters. Returns: float: The calculated BMI value. Note: BMI is calculated as weight (kg) divided by height squared (m^2). This function assumes weight is in kilograms and height is in meters. """ return weight / (height ** 2)Few-Shot Prompting: Herausforderungen und bewährte Praktiken

Auch wenn das Souffleurverfahren in vielen Fällen gut funktioniert, birgt es seine eigenen Herausforderungen. Wenn wir diese Herausforderungen verstehen und Best Practices befolgen, können wir die Wirksamkeit unserer Aufforderungen maximieren und bessere Ergebnisse erzielen.

Wirksame Beispiele auswählen

Die Qualität und Relevanz der Beispiele, die du auswählst, sind entscheidend für ein erfolgreiches few-shot prompting. Hier sind einige Tipps:

- Achte darauf, dass die Beispiele direkt mit der Aufgabe zu tun haben, die das Modell erfüllen soll. Irrelevante Beispiele können das Modell verwirren und zu einer schlechten Leistung führen.

- Verwende eine Reihe von Beispielen, die verschiedene Aspekte der Aufgabe abdecken. So kann das Modell besser auf neue Eingaben verallgemeinert werden.

- Die Beispiele sollten klar und eindeutig sein. Vermeide komplexe oder verschlungene Beispiele, die das Modell verwirren könnten.

Schnelles Design

Effektive Aufforderungen zu erstellen ist eine Kunst, bei der man genau überlegen muss, wie die Beispiele präsentiert werden und wie die Aufgabe formuliert ist. Hier sind einige Strategien, die du anwenden kannst:

- Achte auf ein einheitliches Format für alle Beispiele. Das hilft dem Modell, das Muster zu erkennen, dem es folgen muss.

- Gib in der Aufforderung genügend Kontext an, um die Aufgabe zu verdeutlichen. Manchmal kann eine kurze Anweisung oder Beschreibung helfen, die Bühne für die Beispiele zu bereiten.

- Halte die Aufforderung so einfach wie möglich und gib trotzdem die nötigen Informationen. Allzu komplexe Aufforderungen können zu Verwirrung führen.

Vermeiden von Überanpassung

Eines der Risiken von Prompting mit wenigen Schüssen besteht darin, dass das Modell zu sehr an die vorgegebenen Beispiele angepasst wird, was zu Ergebnissen führt, die den Beispielen zu ähnlich sind oder die sich nicht gut auf neue Eingaben verallgemeinern lassen. Um dies zu vermeiden:

- Verwende eine Vielzahl von Beispielen, die verschiedene Szenarien und Grenzfälle abdecken. So kann das Modell lernen, zu verallgemeinern, statt nur die Beispiele nachzuahmen.

- Vermeide es, zu viele Beispiele zu verwenden, da dies zu einer Überanpassung führen kann. Ein paar gut ausgewählte Beispiele sind oft effektiver als eine große Anzahl ähnlicher Beispiele.

- Teste die Leistung des Modells mit einer Reihe von neuen Inputs, um sicherzustellen, dass es gut verallgemeinert werden kann. Passe die Beispiele und die Aufforderung auf der Grundlage dieser Tests nach Bedarf an.

Wenn du diese Best Practices befolgst, kannst du effektivere Kurzanweisungen erstellen, die das Modell dazu anleiten, die gewünschte Aufgabe genau und effizient auszuführen.

Verdiene eine Top-KI-Zertifizierung

Fazit

Few-shot prompting ist eine Technik, die LLMs dabei hilft, ihr Wissen auf bestimmte Aufgaben anzuwenden.

Sie ermöglicht eine schnelle Anpassung an neue Aufgaben ohne umfangreiche Umschulungen. Es erhöht die Genauigkeit bei komplexen Aufgaben, indem es relevante Beispiele liefert. Sie ist in verschiedenen Bereichen nützlich, vom logischen Denken bis zum kreativen Schreiben und Programmieren, und macht fortgeschrittene Sprachmodelle leichter zugänglich und anpassbar.

Seine Wirksamkeit hängt jedoch von der sorgfältigen Auswahl der Beispiele und der zeitnahen Gestaltung ab. Die Qualität und Relevanz der Beispiele sind entscheidend für eine optimale Leistung.

Ich bin gespannt, wohin die Reise gehen wird. Stell dir Systeme vor, die automatisch die perfekten Beispiele auswählen oder sich spontan anpassen können, je nachdem, wie es ihnen geht.

So, da hast du es! Few-Shot Souffleur in einer Nussschale. Experimentiere weiter, lerne weiter, und wir sehen uns in der nächsten Runde!

FAQs

Gibt es eine Möglichkeit, die Verbesserung der Aufgabenleistung zu messen oder zu quantifizieren, wenn die Aufforderung mit wenigen Schüssen im Vergleich zum Null-Schuss-Ansatz erfolgt?

Ja, Verbesserungen können je nach Aufgabe mit Hilfe von Standardmetriken für maschinelles Lernen gemessen werden. Für Klassifizierungsaufgaben können Genauigkeit, Präzision, Wiedererkennung und F1-Score verwendet werden. Metriken wie BLEU, ROUGE oder menschliche Bewertung können für Generierungsaufgaben verwendet werden.

Gibt es bestimmte Branchen oder Sektoren, in denen das "few-shot prompting" besonders erfolgreich eingesetzt wird?

Few-Shot-Prompting hat sich in verschiedenen Bereichen bewährt, z. B. im Kundenservice (zur Generierung von Antworten), bei der Erstellung von Inhalten (als Schreibhilfe) und in der Softwareentwicklung (zur Codegenerierung). Sie erweist sich auch im Gesundheitswesen für Aufgaben wie die Zusammenfassung von Krankenakten und im Finanzwesen für Marktanalysen und die Erstellung von Berichten als wertvoll.

Wie könnte sich das Souffleusen auf den zukünftigen Arbeitsmarkt für Datenwissenschaftler/innen und Ingenieur/innen für maschinelles Lernen auswirken?

Das Prompting könnte die Entwicklung von KI-Anwendungen demokratisieren und es auch Nicht-Experten ermöglichen, spezialisierte KI-Lösungen zu entwickeln. Dadurch könnte sich der Fokus von Datenwissenschaftlern und ML-Ingenieuren auf komplexere Aufgaben, Prompt-Engineering und die Entwicklung fortschrittlicherer KI-Systeme verlagern. Es könnten auch neue Rollen geschaffen werden, die sich auf die Erstellung von effektiven Aufforderungen und Beispielen für verschiedene Anwendungen konzentrieren.

Wo liegen die Grenzen von "few-shot prompting", wenn es um hochspezialisierte oder technische Bereiche geht?

In hochspezialisierten Bereichen kann es schwierig werden, wenn das Modell nicht über das nötige Grundwissen in diesem Bereich verfügt. Es kann auch eine Herausforderung sein, komplexe domänenspezifische Regeln oder Verfahren mit nur wenigen Beispielen zu erfassen. In solchen Fällen kann eine umfangreichere Feinabstimmung oder ein domänenspezifisches Training notwendig sein.

Gibt es ethische Bedenken oder einen möglichen Missbrauch von "few-shot prompting", den die Nutzer/innen beachten sollten?

Ja, es gibt ethische Bedenken. Wenn die Beispiele nicht sorgfältig ausgewählt werden, können die KI-Modelle durch die Eingabe weniger Beispiele dazu verleitet werden, voreingenommene oder schädliche Inhalte zu erstellen. Außerdem besteht die Gefahr, dass ungewollt Daten weitergegeben werden, wenn sensible Informationen in den Aufforderungen enthalten sind.

Ana Rojo Echeburúa ist KI- und Datenspezialistin und hat einen Doktortitel in angewandter Mathematik. Sie liebt es, Daten in verwertbare Erkenntnisse umzuwandeln und hat umfangreiche Erfahrung in der Leitung technischer Teams. Ana arbeitet gerne eng mit ihren Kunden zusammen, um deren Geschäftsprobleme zu lösen und innovative KI-Lösungen zu entwickeln. Sie ist für ihre Problemlösungsfähigkeiten und ihre klare Kommunikation bekannt und hat eine Leidenschaft für KI, insbesondere für generative KI. Ana widmet sich dem kontinuierlichen Lernen und der ethischen KI-Entwicklung sowie der Vereinfachung komplexer Probleme und der Erklärung von Technologien auf verständliche Weise.