programa

La Plataforma AutoGPT es una plataforma que permite a los usuarios crear, desplegar y gestionar agentes continuos de IA. Utiliza una interfaz de usuario de bajo código para permitir a los usuarios automatizar miles de procesos digitales, con agentes que funcionan de forma autónoma entre bastidores.

La Plataforma AutoGPT tiene dos componentes básicos: el Servidor AutoGPT , la lógica y la infraestructura principales, y el Frontend AutoGPT, la interfaz de usuario para crear los agentes, gestionar los flujos de trabajo e implementar programaciones recurrentes.

Está preintegrado con proveedores de LLM como OpenAI, Anthropic, Groq y Llama, de modo que se puede automatizar una amplia gama de tareas como el procesamiento de datos, la creación de contenidos o incluso actividades lúdicas.

En este tutorial, guiaremos a los profesionales técnicos sobre cómo configurar localmente la plataforma AutoGPT y crear su primer agente. Puedes leer nuestra guía completa sobre Cómo entender los agentes de IA para saber más, y también descubrir los distintos tipos de agentes de IA en un artículo aparte.

¿Qué es AutoGPT?

AutoGPT es una plataforma/software de IA que permite a los usuarios crear, desplegar y gestionar agentes autónomos de IA. Estos agentes pueden realizar diversas tareas con una mínima supervisión humana a través de una interfaz de bajo código que se instala en la máquina del usuario.

En el momento de escribir esto, hay una lista de espera abierta para una próxima versión en la nube de AutoGPT, si quieres evitar la molestia de la configuración local.

Entre las características y capacidades clave de AutGPT se incluyen:

- Flujos de trabajo de bajo código: Crea flujos de trabajo sin grandes conocimientos de codificación.

- Funcionamiento autónomo: Despliega agentes que se ejecuten continuamente, activándose en función de desencadenantes específicos.

- Automatización inteligente: Automatiza los procesos repetitivos de procesamiento de datos, creación de contenidos y otras tareas.

- Sistema basado en bloques: Construye agentes utilizando bloques modulares que representen diferentes acciones e integraciones.

- Soporte LLM múltiple: Compatible con OpenAI, Anthropic, Groq y Llama.

- Mercado: Accede a agentes preconfigurados para casos de uso específicos.

Visión general de la arquitectura AutoGPT

La plataforma AutoGPT consta de dos componentes principales:

1. Servidor AutoGPT:

- Lógica central para agentes y automatización

- Infraestructura para un rendimiento fiable

- Mercado de agentes preconstruidos

2. AutoGPT frontend:

- Constructor de agentes para diseñar y configurar agentes

- Herramientas de gestión del flujo de trabajo

- Controles de despliegue

- Selección de agentes listos para usar

- Panel de control y análisis

El backend de AutoGPT utiliza Python con FastAPI como marco web y PostgreSQL con Prisma ORM para el almacenamiento de datos. Utiliza websockets para la comunicación en tiempo real e incluye gestores de ejecución, programación y notificaciones.

Este diseño mejora la escalabilidad y el mantenimiento a medida que crece la plataforma.

El frontend utiliza Next.js 14 con TypeScript, componentes Radix y CSS Tailwind, con visualización del flujo de trabajo mediante xyflow. Esto crea una interfaz intuitiva de bajo código en la que los usuarios pueden construir agentes de IA sin grandes conocimientos de programación.

La plataforma incluye estos servicios clave:

- Gestor de base de datos: Almacena las configuraciones de los agentes y los datos de ejecución

- Gestor de ejecución: Ejecuta flujos de trabajo y gestiona el estado del agente

- Programador: Gestiona la automatización basada en el tiempo y las tareas recurrentes

- Servidor Websocket: Proporciona actualizaciones en tiempo real

- API REST: Ofrece acceso programático a las funciones

- Protocolo de agente: Estandariza la comunicación con los servicios externos

- API de integración: Conecta con servicios de terceros y proveedores de IA

AutoGPT en 2025 frente a versiones anteriores

Cuando se anunció por primera vez hacia 2023, AutoGPT se hizo muy popular y se consideró el asesino de código abierto de ChatGPT. Por supuesto, eso no era más que una exageración impulsada por personas influyentes en las redes sociales, porque ahora estamos en 2025, y ChatGPT sigue aquí. Pero AutoGPT sí señaló el cambio de enfoque de la comunidad de IA hacia los agentes de IA.

Las versiones anteriores de AutoGPT prometían agentes totalmente autónomos que podían construirse sobre la marcha a partir de una sola instrucción. Sería capaz de dividir la petición en tareas manejables y reunir una serie de herramientas, software y API para realizar el trabajo, al tiempo que dispone de una memoria a corto y largo plazo reforzada por un bucle de retroalimentación autorreflexiva.

Sin embargo, por el camino, debieron darse cuenta de las limitaciones de este enfoque debido a la imprevisibilidad inherente a los LLM en escenarios de producción.

Hoy en día, AutoGPT no es esa plataforma "prompt-to-agent", sino algo mucho mejor: una plataforma de bajo código que pone a los usuarios en control de cómo se construyen sus agentes. Puedes ver este cambio desde la versión original de AutoGPT a la plataforma que tenemos en 2025 si lees los posts de hace 1-2 años o miras los vídeos de YouTube.

Esas publicaciones muestran instrucciones de configuración y ejemplos de flujo de trabajo completamente diferentes de lo que voy a enseñarte.

Así que, sin más preámbulos, veamos cómo puedes configurar la plataforma en tu máquina.

Instalación y configuración del AutoGPT

Configurar AutoGPT localmente requiere una configuración adecuada de tu entorno de desarrollo y una comprensión de las herramientas de contenedorización - consulta nuestro curso sobre Contenedorización y Virtualización con Docker y Kubernetes si necesitas un repaso. Esta sección te guía a través del proceso completo, desde los requisitos previos hasta el funcionamiento de la plataforma por primera vez.

Requisitos previos y configuración del entorno

Antes de instalar AutoGPT, asegúrate de que tienes los siguientes requisitos previos:

1. Node.js & NPM

- Mac:

brew install node- Linux/WSL2:

sudo apt update sudo apt install nodejs npm- Verifica la instalación:

node -v npm -v

2. Docker y Docker Compose

- Mac: Descarga e instala DockerDesktop

- Linux (WSL2 ya viene con el núcleo Docker y necesita instalación):

sudo apt update sudo apt install docker.io docker-compose sudo systemctl enable --now docker- Verifica la instalación:

docker -v docker compose -v

3. Git

- Mac:

brew install git- Linux/WSL2:

sudo apt update sudo apt install git

Clona el repositorio AutoGPT:

git clone https://github.com/Significant-Gravitas/AutoGPT.gitEstos requisitos previos son esenciales para ejecutar AutoGPT con eficacia. Se requiere Node.js y NPM para la aplicación frontend, lo que te permitirá interactuar con AutoGPT a través de una interfaz fácil de usar.

Docker y Docker Compose crean contenedores aislados que garantizan un rendimiento coherente en los distintos sistemas y simplifican la implantación de los servicios backend. Git te permite clonar el repositorio y mantenerte actualizado con las últimas mejoras.

Después de este paso, debes tener en tu máquina el directorio AutoGPT, que contiene todo lo necesario para ejecutar la aplicación. Lo único que queda es la configuración.

Alojamiento local con Docker

Docker proporciona un entorno aislado y consistente para ejecutar AutoGPT, garantizando que todas las dependencias funcionen correctamente independientemente de tu sistema anfitrión.

1. Configurar los servicios backend

cd AutoGPT/autogpt_platform

cp .env.example .env

docker compose up -d --buildEl nuevo archivo .env viene con variables de entorno rellenadas con valores por defecto sensatos. No es estrictamente necesario que configures tú mismo este archivo, pero su presencia es imprescindible. Lo utilizará la aplicación frontal cuando proporciones varias claves y secretos al crear tus agentes personalizados.

El último comando docker compose puede tardar hasta 15 minutos, dependiendo de tu velocidad de Internet en la primera ejecución. Configura los componentes del backend a los que se conectará el frontend.

2. Configurar la aplicación frontend

cd frontend

cp .env.example .env

npm install

npm run devEstos comandos configuran el archivo de entorno para el frontend, instalan sus dependencias con Node.js y ponen en marcha la interfaz de usuario.

3. Verifica la instalación

- Accede a la interfaz de usuario de AutoGPT en http://localhost:3000

- Los servicios backend se ejecutan en puertos:

- Servidor WebSocket: 8001

- API de ejecución: 8006

Visitar el puerto 3000 debe mostrarte la interfaz de usuario del Mercado, a través de la cual debes crear tu cuenta e iniciar sesión.

4. Personaliza tu clave de encriptación (opcional pero recomendado)

# Generate a new key with Python

from cryptography.fernet import Fernet

Fernet.generate_key().decode()

# Or use the built-in CLI

poetry run cli gen-encrypt-keySustituye la llave existente en autogpt_platform/backend/.env por tu nueva llave.

Nota para usuarios de Windows: Cuando utilices Docker en Windows, selecciona WSL2 en lugar de Hyper-V durante la instalación para evitar problemas de compatibilidad con Supabase. Si ya has instalado con Hyper-V, puedes cambiar a WSL 2 en la configuración de Docker Desktop.

Visión general de la interfaz de usuario del AutoGPT

Antes de crear un agente que funcione, vamos a familiarizarnos con la interfaz del constructor del AutGPT.

La interfaz es un gran lienzo en blanco con cuatro botones principales:

- Bloquea

- Botones deshacer/rehacer

- Guarda

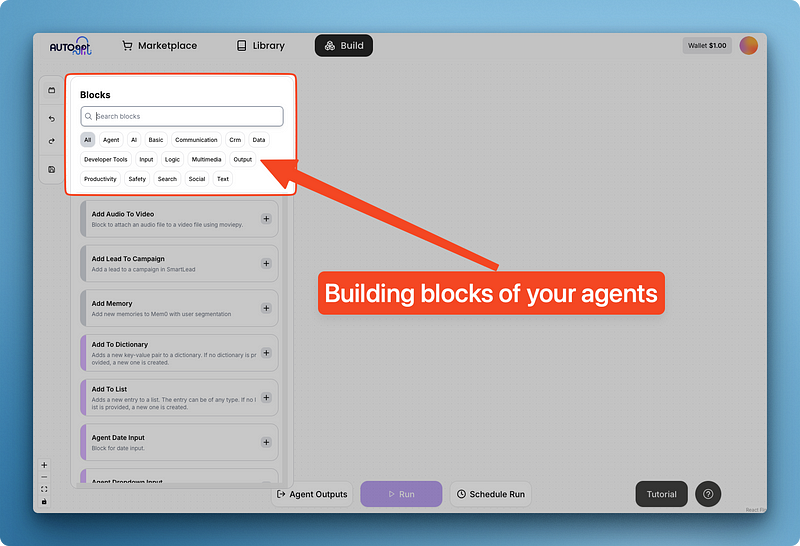

Al hacer clic en "Bloques" aparece un menú con los componentes reutilizables integrados en el AutoGPT agrupados por categorías.

Estos bloques proporcionan herramientas esenciales que pueden aplicarse universalmente en muchos escenarios de agentes.

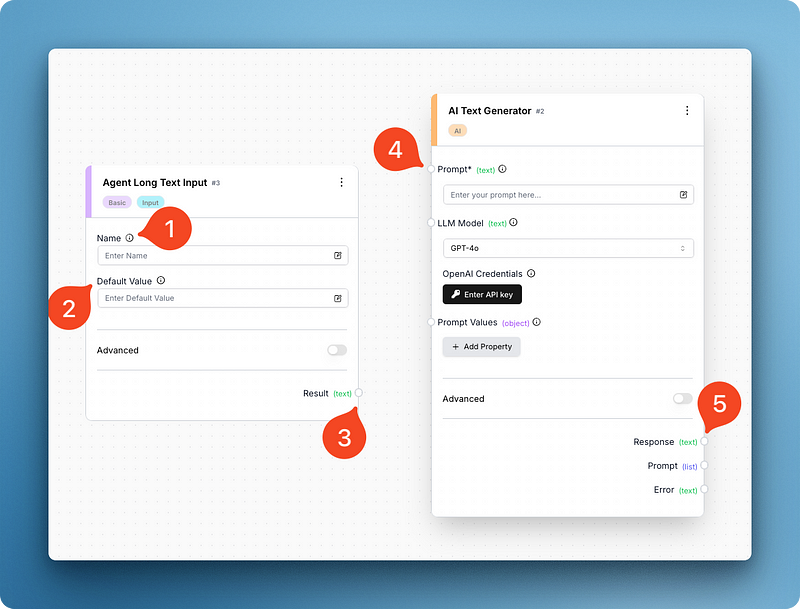

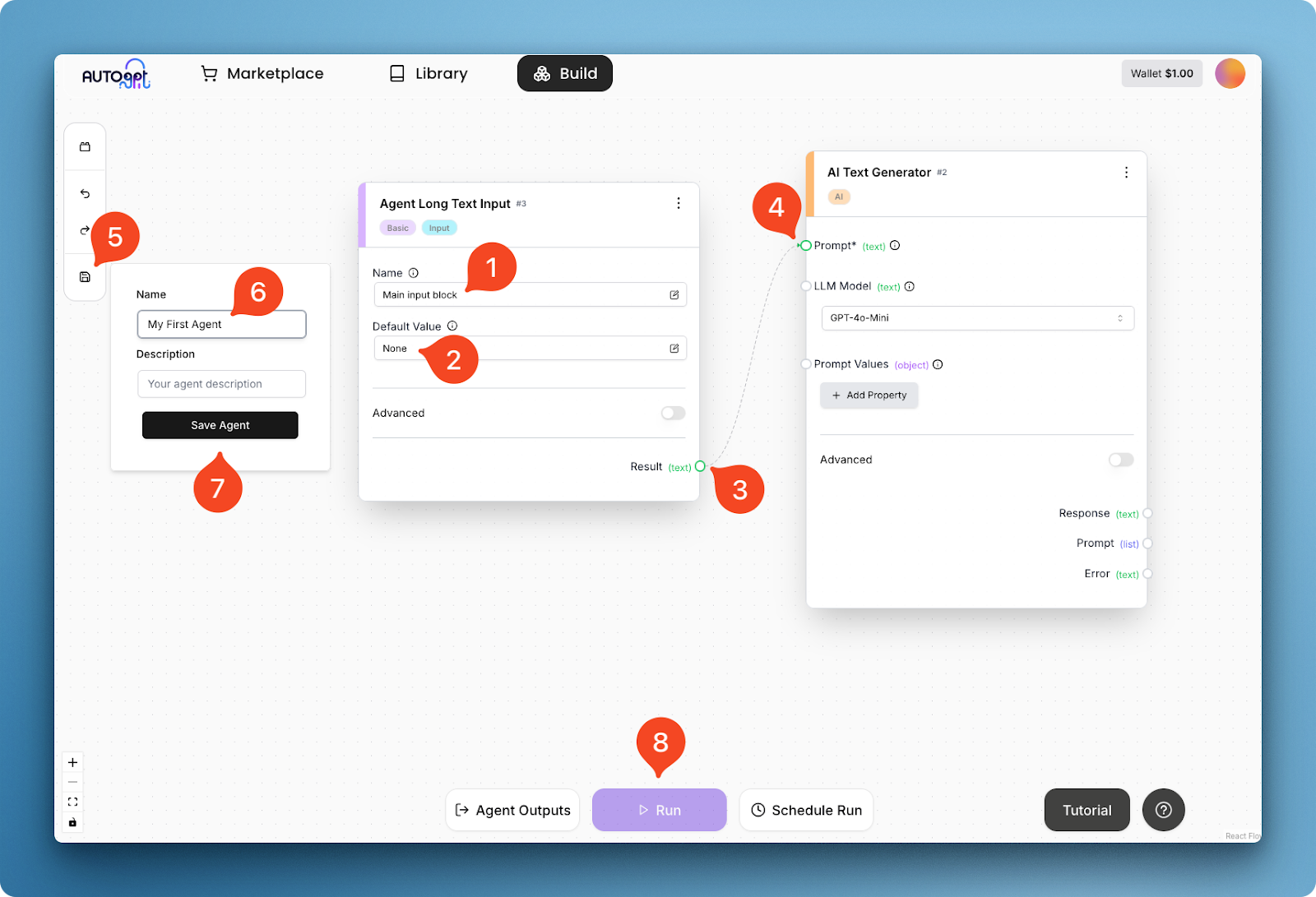

Por ejemplo, a continuación, he buscado y añadido dos bloques: introducción de texto largo y generador de texto AI. Estos dos componentes me bastan para recrear la versión básica de la interfaz de ChatGPT:

Observando la imagen, puedes ver que cada bloque tiene diferentes partes móviles. El bloque de entrada tiene campos para el nombre del bloque y un valor por defecto, mientras que el generador de texto tiene un campo para la pregunta, el modelo y las variables de la pregunta.

Este último también tiene un campo de entrada única para tu clave de API de OpenAI, que debes proporcionar antes de ejecutar el agente (hazlo ahora). El campo de la clave API cambia según el modelo que elijas y AutoGPT es compatible con la mayoría de los proveedores principales y secundarios.

Si te fijas, ambos bloques tienen pequeños bordes (mira el 3 y el 5) que te permiten conectarlos:

En la imagen anterior, estoy dando al bloque de entrada un nombre (1) y un valor por defecto (2), y conectando su resultado de texto (3) al campo prompt (4) del generador de texto. Esta conexión crea un flujo de trabajo básico del agente, que puede ejecutarse después de guardar el propio agente (pasos 5-8).

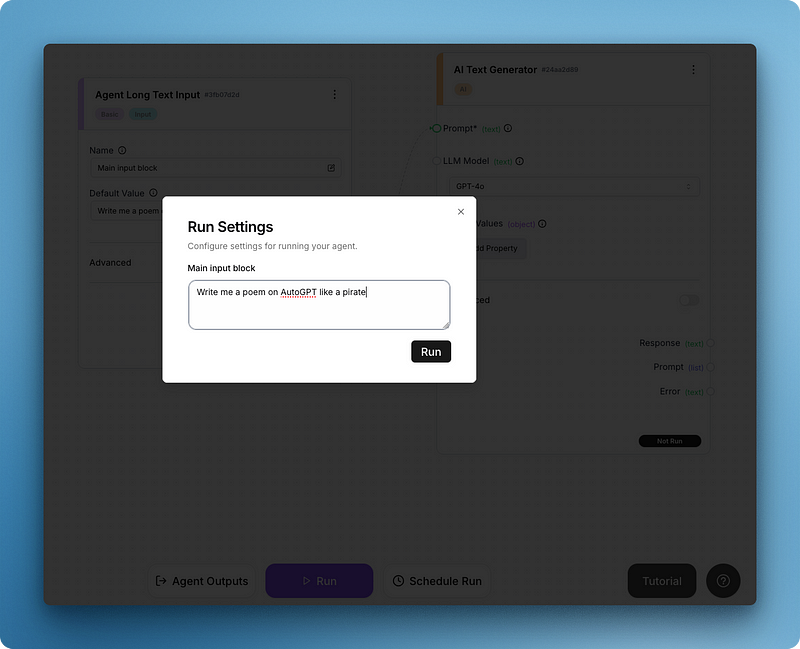

Tras hacer clic en Ejecutar, verás que aparece un menú emergente de "Ajustes de ejecución" para el campo de entrada:

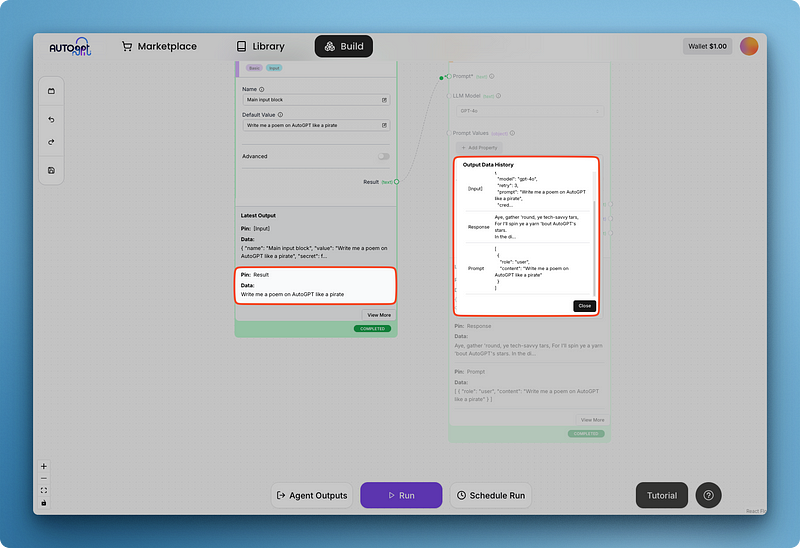

Escribe tu prompt y ejecútalo todo para obtener una primera salida como la siguiente:

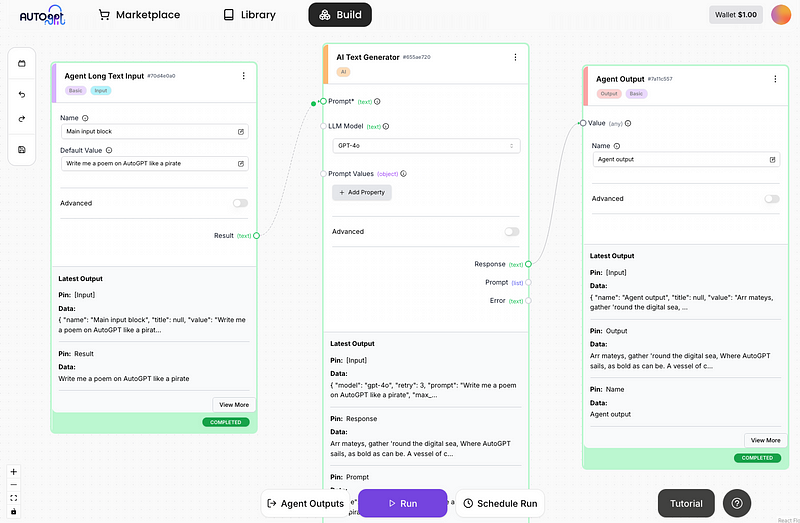

Puede que notes que la respuesta del modelo es difícil de leer dentro del bloque de generación de texto más grande. Por eso AutoGPT tiene bloques para las salidas de los agentes, que añado a continuación:

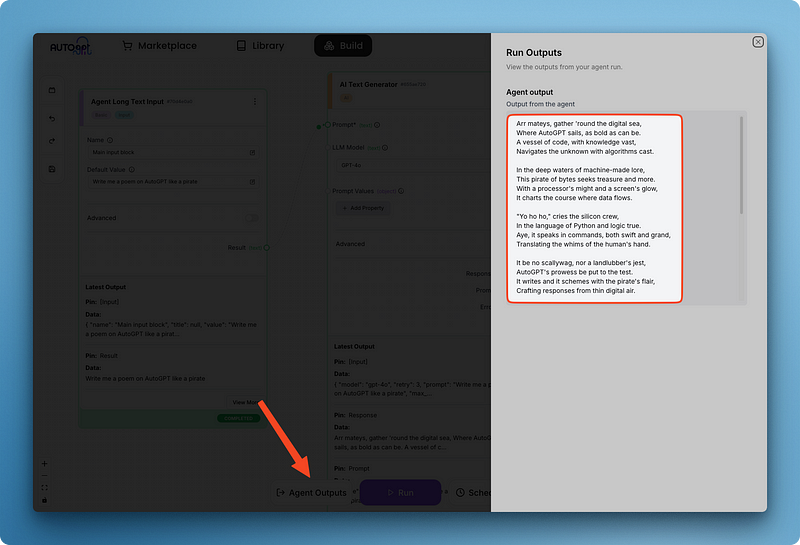

Observa cómo he conectado el campo de respuesta del generador de texto al valor del bloque de salida del agente. Añadir un bloque de salida también te permite ver todas las salidas de los agentes de diferentes bloques utilizando el panel "Salidas de los agentes" en un solo lugar:

Una vez que guardes tu agente, se guardará en tu biblioteca. Además, este agente completo puede utilizarse luego como bloque en otros agentes que crees. Este enfoque modular ofrece varias ventajas:

- Reutilización: Puedes reutilizar funciones complejas en varios proyectos sin tener que reconstruirlas.

- Composibilidad: Puedes combinar distintos agentes para crear flujos de trabajo más sofisticados.

- Mantenibilidad: Cuando actualices el agente original, todas las instancias que lo utilicen como bloque se beneficiarán de las mejoras.

- Abstracción: Los procesos complejos pueden encapsularse en un solo bloque, haciendo que los flujos de trabajo de tu agente principal sean más limpios y fáciles de entender.

- Colaboración: Puedes compartir bloques de agentes especializados con tus compañeros de equipo o con la comunidad, acelerando el desarrollo.

Este enfoque de bloques de construcción te permite crear sistemas de IA cada vez más potentes superponiendo capacidades.

Escribir bloques personalizados en AutoGPT en Python

Visión general de la sintaxis y el proceso general

La potencia de AutoGPT proviene de su sistema modular de bloques. Aunque la plataforma incluye muchos bloques útiles incorporados, puedes ampliar sus capacidades creando tus propios bloques personalizados en Python. Esta función te permite integrarte con cualquier API, servicio o herramienta a la que se pueda acceder mediante programación.

Crear un bloque personalizado implica estos pasos esenciales:

- Crea un nuevo archivo Python en el directorio

autogpt_platform/backend/backend/blocksutilizando el nombre snake_case - Define una clase que herede de la clase base

Block - Crear esquemas de entrada y salida utilizando

BlockSchemapara definir la estructura de datos - Implementa el método

__init__con un ID único y datos de prueba - Escribe el método

runque contiene la lógica central de tu bloque - Gestiona los errores adecuadamente para garantizar que el bloque falla correctamente

- Prueba tu bloque utilizando la infraestructura de pruebas de la plataforma

Vamos a desglosar cada componente en detalle:

Estructura de la clase Bloque

Cada bloque debe heredar de la clase base Block y definir sus esquemas de entrada/salida:

from backend.data.block import Block, BlockSchema, BlockOutput

class MyCustomBlock(Block):

class Input(BlockSchema):

# Define input fields with types

field1: str

field2: int

class Output(BlockSchema):

# Define output fields with types

result: str

error: str # Always include an error field

def __init__(self):

super().__init__(

id="xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxxxxxx", # Generate proper UUID

input_schema=MyCustomBlock.Input,

output_schema=MyCustomBlock.Output,

test_input={"field1": "test", "field2": 42},

test_output=("result", "expected output"),

test_mock=None # Only needed for external API calls

)

def run(self, input_data: Input, **kwargs) -> BlockOutput:

try:

# Your block logic here

result = f"Processed {input_data.field1} and {input_data.field2}"

yield "result", result

except Exception as e:

raise RuntimeError(f"Error in block: {str(e)}")Componentes importantes

- Esquemas de entrada/salida: Define la estructura de datos utilizando sugerencias de tipo

- Generación de UUID: Utiliza un generador UUID adecuado (no te inventes el tuyo propio)

- Datos de la prueba: Proporciona entradas de prueba realistas y resultados esperados

- Tratamiento de errores: Incluye siempre un tratamiento adecuado de los errores en el método de ejecución

- Obtención de resultados: Utiliza

yieldpara mostrar los resultados de uno en uno

Un ejemplo de bloque personalizado

Vamos a crear un ejemplo detallado de un bloque personalizado que realiza un análisis de sentimientos utilizando la API de OpenAI. Esto demuestra cómo integrarse con servicios externos de IA y manejar las claves API de forma segura.

Instrucciones de configuración de la clave API de OpenAI

Antes de utilizar este bloque, tienes que configurar tu clave API de OpenAI:

1. Instala los paquetes necesarios:

pip install openai python-dotenv

2. Crea un archivo .env en el directorio autogpt_platform/backend/blocks con tu clave de la API de OpenAI:

OPENAI_API_KEY=your_api_key_here

Ahora, vamos a crear el bloque:

Importar dependencias y configurar el entorno

En primer lugar, vamos a ocuparnos de las importaciones y de la configuración del entorno:

# autogpt_platform/backend/blocks/sentiment_analyzer.py

from backend.data.block import Block, BlockSchema, BlockOutput

from typing import Dict, Any, List

import os

from dotenv import load_dotenv

from openai import OpenAI

import json

# Load environment variables from .env file

load_dotenv()Esta sección importa las bibliotecas necesarias y carga las variables de entorno desde el archivo .env. La función load_dotenv() garantiza que tu clave API esté disponible a través de os.getenv().

Definir esquema de bloques e inicializar

A continuación, definimos la clase bloque con los esquemas de entrada y salida:

class OpenAISentimentBlock(Block):

"""Block to analyze sentiment of text using OpenAI API"""

class Input(BlockSchema):

text: str # Text to analyze

model: str = "gpt-3.5-turbo" # OpenAI model to use

detailed_analysis: bool = False # Whether to return detailed analysis

class Output(BlockSchema):

sentiment: str # Positive, Negative, or Neutral

confidence: float # Confidence score of the prediction

explanation: str # Brief explanation of the sentiment

detailed_analysis: Dict[str, Any] # Optional detailed analysis

error: str # Error message if analysis failsEl esquema de entrada define tres parámetros:

text: El contenido a analizar (obligatorio)model: El modelo OpenAI a utilizar (por defecto "gpt-3.5-turbo")detailed_analysis: Si se devuelven detalles adicionales (por defecto Falso)

El esquema de salida define la estructura de los resultados, incluyendo la categoría de sentimiento, la puntuación de confianza, la explicación y el análisis detallado opcional.

Inicializa el bloque con datos de prueba

El método __init__ configura el bloque con datos de prueba e inicializa el cliente OpenAI:

def __init__(self):

super().__init__(

id="8f67d394-9f52-4352-a78b-175d5d1d7182", # Generated UUID

input_schema=OpenAISentimentBlock.Input,

output_schema=OpenAISentimentBlock.Output,

test_input={

"text": "I really enjoyed this product, it exceeded my expectations!",

"detailed_analysis": True

},

test_output=[

("sentiment", str),

("confidence", float),

("explanation", str),

("detailed_analysis", dict)

],

test_mock={

"_analyze_sentiment": lambda text, model, detailed: {

"sentiment": "positive",

"confidence": 0.92,

"explanation": "The text expresses clear enjoyment and states that expectations were exceeded.",

"detailed_analysis": {

"emotions": {

"joy": "high",

"satisfaction": "high",

"disappointment": "none"

},

"key_phrases": ["really enjoyed", "exceeded expectations"],

"tone": "enthusiastic"

}

}

}

)

# Initialize OpenAI client

api_key = os.getenv("OPENAI_API_KEY")

if not api_key:

raise RuntimeError("OpenAI API key not found. Please set OPENAI_API_KEY in .env file.")

self.client = OpenAI(api_key=api_key)Este método:

- Establece entradas de prueba realistas y resultados esperados para las pruebas

- Proporciona un simulacro de la función de análisis de sentimientos para evitar llamadas a la API durante las pruebas

- Inicializa el cliente OpenAI con la clave API de las variables de entorno

- Lanza un error si falta la clave API

Aplicar el método de análisis de sentimientos

La funcionalidad básica se implementa en el método _analyze_sentiment:

@staticmethod

def _analyze_sentiment(self, text: str, model: str, detailed: bool) -> Dict[str, Any]:

"""Analyze sentiment using OpenAI API"""

# Create prompt based on whether detailed analysis is requested

if detailed:

system_prompt = """

You are a sentiment analysis expert. Analyze the following text and provide:

1. The overall sentiment (positive, negative, or neutral)

2. A confidence score from 0.0 to 1.0

3. A brief explanation of your assessment

4. A detailed analysis including:

- Key emotions detected and their intensity

- Key phrases that influenced your assessment

- Overall tone of the text

Format your response as a JSON object with the following structure:

{

"sentiment": "positive|negative|neutral",

"confidence": 0.0-1.0,

"explanation": "brief explanation",

"detailed_analysis": {

"emotions": {"emotion1": "intensity", "emotion2": "intensity"},

"key_phrases": ["phrase1", "phrase2"],

"tone": "description of tone"

}

}

"""

else:

system_prompt = """

You are a sentiment analysis expert. Analyze the following text and provide:

1. The overall sentiment (positive, negative, or neutral)

2. A confidence score from 0.0 to 1.0

3. A brief explanation of your assessment

Format your response as a JSON object with the following structure:

{

"sentiment": "positive|negative|neutral",

"confidence": 0.0-1.0,

"explanation": "brief explanation"

}

"""

try:

# Make API call using the latest OpenAI API syntax

response = self.client.chat.completions.create(

model=model,

response_format={"type": "json_object"},

messages=[

{"role": "system", "content": system_prompt},

{"role": "user", "content": text}

],

temperature=0.2 # Low temperature for more consistent results

)

# Extract and parse JSON response

content = response.choices[0].message.content

result = json.loads(content)

return result

except Exception as e:

raise RuntimeError(f"OpenAI API error: {str(e)}")Este método:

- Crea un aviso de sistema diferente en función de si se solicita un análisis detallado

- Utiliza la API OpenAI para generar un análisis de sentimientos estructurado

- Establece una temperatura baja (0,2) para obtener resultados más consistentes

- Analiza la respuesta JSON y la devuelve

- Maneja las excepciones que puedan producirse durante la llamada a la API

Implementa el método de ejecución

Por último, el método run lo une todo:

def run(self, input_data: Input, **kwargs) -> BlockOutput:

try:

# Validate input

if not input_data.text or not isinstance(input_data.text, str):

raise ValueError("Text must be a non-empty string")

# Process through OpenAI

results = self._analyze_sentiment(

input_data.text,

input_data.model,

input_data.detailed_analysis

)

# Yield the results

yield "sentiment", results["sentiment"]

yield "confidence", results["confidence"]

yield "explanation", results["explanation"]

# Only return detailed analysis if requested and available

if input_data.detailed_analysis and "detailed_analysis" in results:

yield "detailed_analysis", results["detailed_analysis"]

except ValueError as e:

raise RuntimeError(f"Input validation error: {str(e)}")

except Exception as e:

raise RuntimeError(f"Sentiment analysis failed: {str(e)}")Este método:

- Valida el texto introducido

- Llama al método de análisis de sentimientos con los parámetros de entrada

- Obtiene los resultados uno a uno utilizando la palabra clave yield

- Sólo proporciona un análisis detallado si se ha solicitado y está disponible

- Maneja diferentes tipos de errores con mensajes apropiados

Aspectos clave de este ejemplo

- Integración de la API OpenAI: Utiliza la sintaxis más reciente de la API de OpenAI con el punto final de finalización del chat

- Manejo seguro de la clave API: Carga la clave API desde las variables de entorno utilizando

dotenv - Análisis personalizables: Ofrece un análisis de sentimientos básico o detallado en función de las preferencias del usuario

- Salida estructurada: Devuelve la categoría de sentimiento, la puntuación de confianza, la explicación y un análisis detallado opcional

- Procesamiento JSON: Maneja respuestas JSON estructuradas de OpenAI

- Estrategia de prueba: Simula la llamada a la API de OpenAI para realizar pruebas sin utilizar los créditos reales de la API

Este bloque demuestra cómo integrarse con servicios de IA de última generación para mejorar las capacidades de tus agentes. La integración de OpenAI permite realizar sofisticados análisis de texto que serían difíciles de implementar con simples enfoques basados en reglas.

Cuando escribas tus propios bloqueos, ten siempre en cuenta

- Cómo manejar las claves API de forma segura

- Proporcionar mensajes de error claros para los fallos de la API

- Diseñar entradas que permitan flexibilidad en el uso del bloque

- Estructurar las salidas para que puedan ser consumidas fácilmente por los bloques posteriores

Para obtener información más detallada sobre la creación de bloques personalizados, incluidos los tipos de campo, la autenticación, la integración de webhooks y las mejores prácticas, consulta la documentación oficial del Bloque AutoGPT.

Conclusión

AutoGPT ofrece una potente plataforma para crear y desplegar agentes autónomos de IA a través de su intuitiva interfaz basada en bloques. Este tutorial te ha guiado a través de todo el proceso , desde la instalación y configuración local hasta la comprensión de la interfaz de usuario, la creación de agentes básicos y la ampliación de la funcionalidad con bloques personalizados.

Al adoptar la arquitectura modular de AutoGPT, los profesionales técnicos pueden automatizar flujos de trabajo complejos sin amplios conocimientos de codificación, al tiempo que disponen de flexibilidad para añadir funciones personalizadas cuando sea necesario.

Para los que quieran construir sobre esta base y explorar más a fondo los agentes de IA, la documentación oficial de AutoGPT proporciona una guía completa, mientras que DataCamp ofrece recursos complementarios como Comprender los agentes de IA y Fundamentos de ChatGPT.

El curso Introducción a los GPT puede ayudarte a consolidar tu comprensión de los grandes modelos lingüísticos, mientras que Construir Chatbots RAG para Documentación Técnica demuestra otra aplicación práctica de los agentes de IA. Mientras sigues experimentando con agentes de IA, puede que también quieras echar un vistazo a nuevas herramientas como Mistral Agents API, Dify AI y Langflow.

AutoGPT Preguntas frecuentes

¿Necesito experiencia en codificación para utilizar AutoGPT?

No, AutoGPT utiliza una interfaz de bajo código con un sistema basado en bloques que permite a los usuarios crear agentes sin grandes conocimientos de programación. Sin embargo, algunos conocimientos técnicos son útiles para la configuración, y se necesitan conocimientos de Python si quieres crear bloques personalizados.

¿Cuáles son los requisitos del sistema para ejecutar AutoGPT localmente?

Necesitas Node.js y NPM, Docker y Docker Compose, y Git instalados en tu sistema. La plataforma funciona en Mac, Linux y Windows (preferiblemente con WSL 2). También necesitarás claves API para los modelos lingüísticos que quieras utilizar.

¿Puedo integrar AutoGPT con servicios externos y API?

Sí, AutoGPT viene con muchas integraciones incorporadas como bloques, y puedes crear bloques personalizados en Python para conectar con prácticamente cualquier API o servicio al que se pueda acceder mediante programación.

¿Es gratuito el uso de AutoGPT?

La plataforma AutoGPT es de código abierto y gratuita para autoalojarse, aunque tendrás que pagar por cualquier uso de la API de proveedores de modelos lingüísticos como OpenAI. También hay una lista de espera para una versión beta alojada en la nube que puede tener un precio diferente.