programa

Para nosotros, los programadores, la codificación es quizá una de las aplicaciones más importantes de los LLM. La capacidad de generar código preciso, depurar y "comprender" adecuadamente el código es lo que convierte a un LLM en un asistente clave para muchos programadores, junto con sus muchas ventajas empresariales.

Mistral ha lanzado recientemente su último modelo, el Codestral 25.01, también conocido como Codestral V2, una actualización de su primer modelo Codestral. su primer modelo Codestral lanzado en 2024. En este artículo, revisaré Codestral 25.01, evaluaré su rendimiento en pruebas comparativas, te guiaré en su configuración y te lo demostraré en acción.

¿Qué es el Codestral 25.01 de Mistral?

Cita del anuncio de Mistral anuncio de MistralCodestral 25.01 es "ligero, rápido y competente en más de 80 lenguajes de programación (...) optimizado para casos de uso de baja latencia y alta frecuencia, y admite tareas como el relleno en el medio (FIM), la corrección de código y la generación de pruebas".

Muchos desarrolladores han utilizado el modelo anterior, Codestralpara las tareas relacionadas con el código. Codestral 25.01 es una versión actualizada, con un tokenizador mejorado y una arquitectura más eficiente que le permite generar código el doble de rápido.

Mistral aún no ha hecho público el modelo ni ha dado detalles sobre su arquitectura o tamaño. Sin embargo, sí sabemos que tiene menos de 100.000 millones de parámetros y admite una longitud de contexto de 256K.

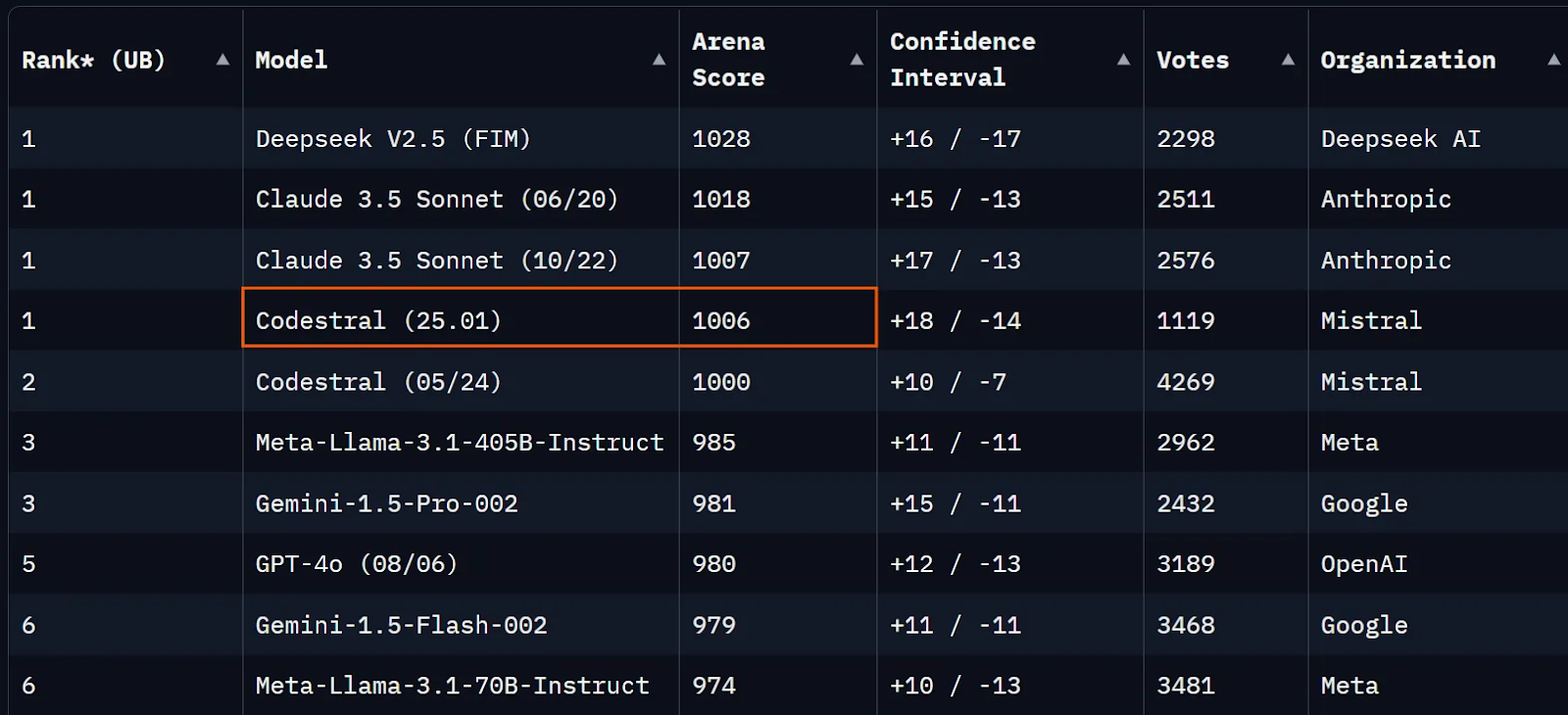

En el momento de escribir este artículo, Codestral 25.01 está sólo unos puntos por debajo de Soneto Claude 3.5 de la serie Chatbot Arena (antes LMSYS) y sólo ligeramente por encima de Codestral V1.

Fuente: Chatbot Arena

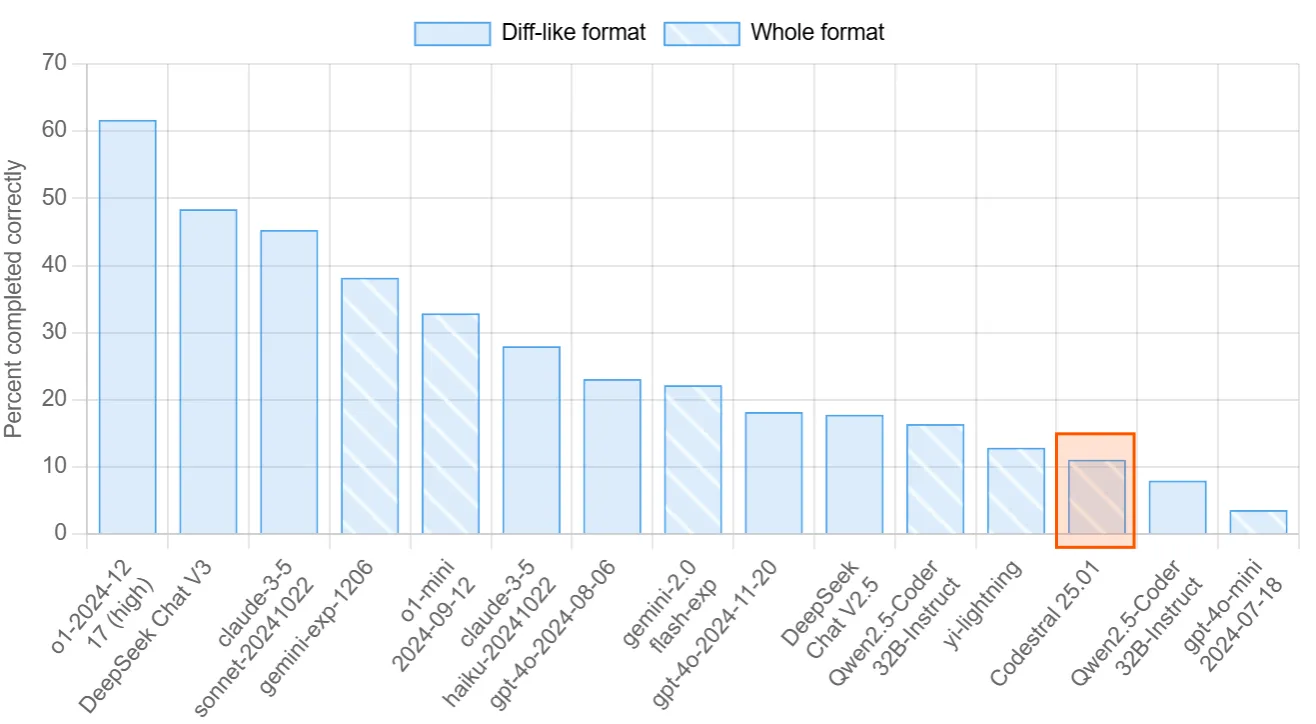

Otra tabla de clasificación centrada en evaluar las habilidades de codificación de los LLM es Aider's Polyglot. En este punto de referencia, se pide a los modelos que completen 225 ejercicios de codificación en lenguajes de programación populares. Codestral 25.01 obtuvo un 11%, mientras que Qwen2.5-Codificador-32B-Instrucción obtuvo un 16%.

Fuente: Tabla de clasificación Aider

Por último, veamos los puntos de referencia oficiales publicados por Mistral. Las puntuaciones de referencia publicadas demuestran un claro avance en comparación con Codestral V1, Codellama 70B o DeepSeek Coder 33B. Puede ser más informativo comparar las puntuaciones de Codestral 25.01 con la más reciente Qwen2.5-Coder-32B-Instruct (puedes leer las puntuaciones de Qwen aquí).

Visión general para Python:

|

Modelo |

Longitud del contexto |

HumanEval |

MBPP |

CruxEval |

LiveCodeBench |

RepoBench |

|

Codestral-2501 |

256k |

86.6% |

80.2% |

55.5% |

37.9% |

38.0% |

|

Codestral-2405 22B |

32k |

81.1% |

78.2% |

51.3% |

31.5% |

34.0% |

|

Instrucciones Codellama 70B |

4k |

67.1% |

70.8% |

47.3% |

20.0% |

11.4% |

|

Instrucción DeepSeek Coder 33B |

16k |

77.4% |

80.2% |

49.5% |

27.0% |

28.4% |

|

DeepSeek Coder V2 lite |

128k |

83.5% |

83.2% |

49.7% |

28.1% |

20.0% |

Puntos de referencia para varias lenguas:

|

Modelo |

HumanEval Python |

HumanEval C++ |

HumanEval Java |

HumanEval Javascript |

Juerga HumanEval |

HumanEval Typescript |

HumanEval C# |

HumanEval (media) |

|

Codestral-2501 |

86.6% |

78.9% |

72.8% |

82.6% |

43.0% |

82.4% |

53.2% |

71.4% |

|

Codestral-2405 22B |

81.1% |

68.9% |

78.5% |

71.4% |

40.5% |

74.8% |

43.7% |

65.6% |

|

Instrucciones Codellama 70B |

67.1% |

56.5% |

60.8% |

62.7% |

32.3% |

61.0% |

46.8% |

55.3% |

|

Instrucción DeepSeek Coder 33B |

77.4% |

65.8% |

73.4% |

73.3% |

39.2% |

77.4% |

49.4% |

65.1% |

|

DeepSeek Coder V2 lite |

83.5% |

68.3% |

65.2% |

80.8% |

34.2% |

82.4% |

46.8% |

65.9% |

Cómo configurar Codestral 25.01 en VS Code

Por desgracia, el modelo no es de peso abierto, y no puedes ejecutarlo localmente. La buena noticia es que puedes acceder al modelo mediante la API o a través de VsCode y PyCharm de forma gratuita como asistente de código.

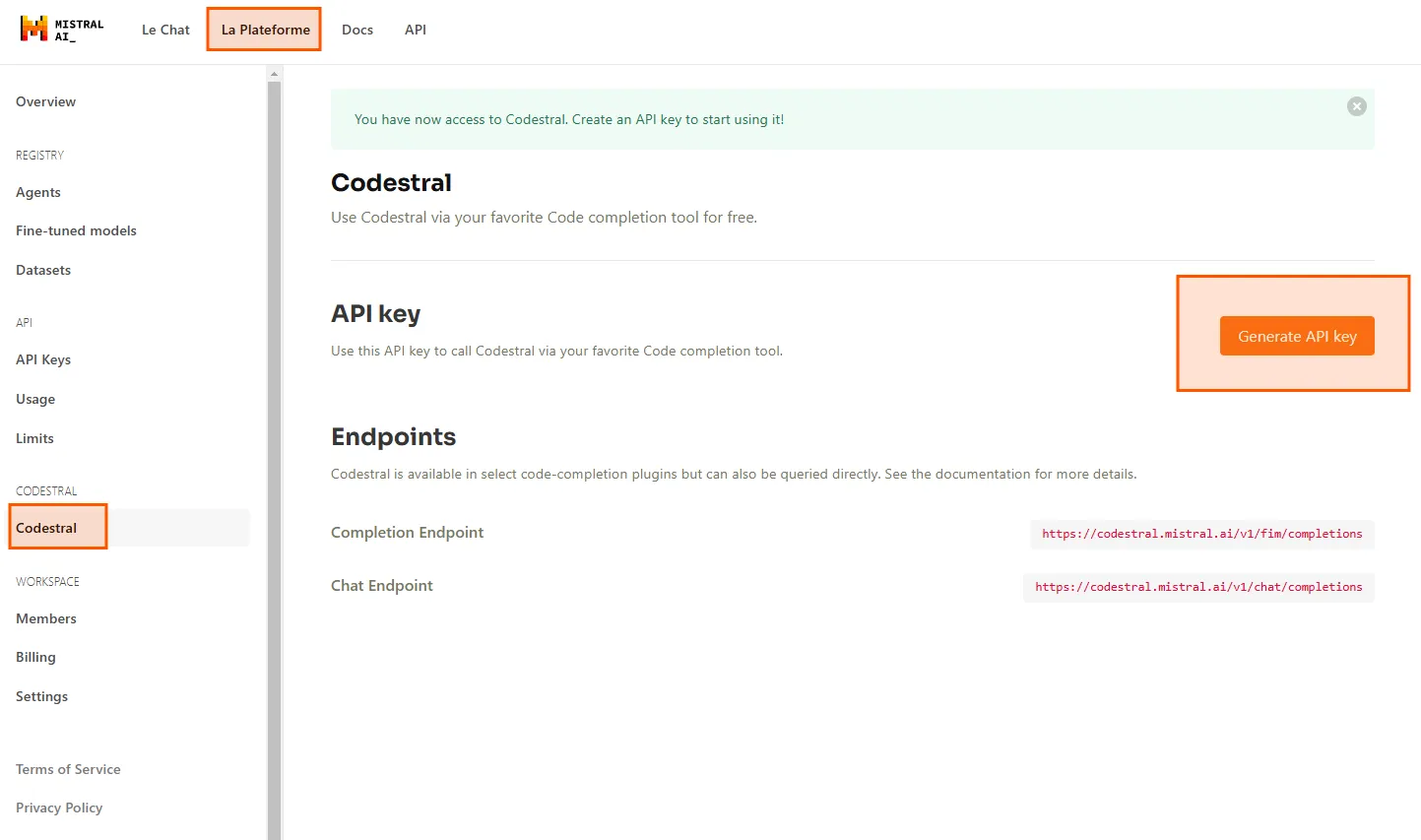

En primer lugar, necesitamos una clave API. Dirígete a La Plataformay navega hasta Codestral. Aquí puedes generar tu clave API para utilizar Codestral 25.01 en tu IDE.

Utilizaré Codestral en VS Code a través de la extensión Continue. Puedes buscarla en el mercado de extensiones e instalarla gratuitamente.

Después de instalar la extensión, haz clic en el botón Continuar en la parte inferior derecha de VsCode, selecciona Configurar opciones de autocompletar y pega tu clave API en Codestral. Ahora puedes utilizar Codestral como modelo de autocompletar.

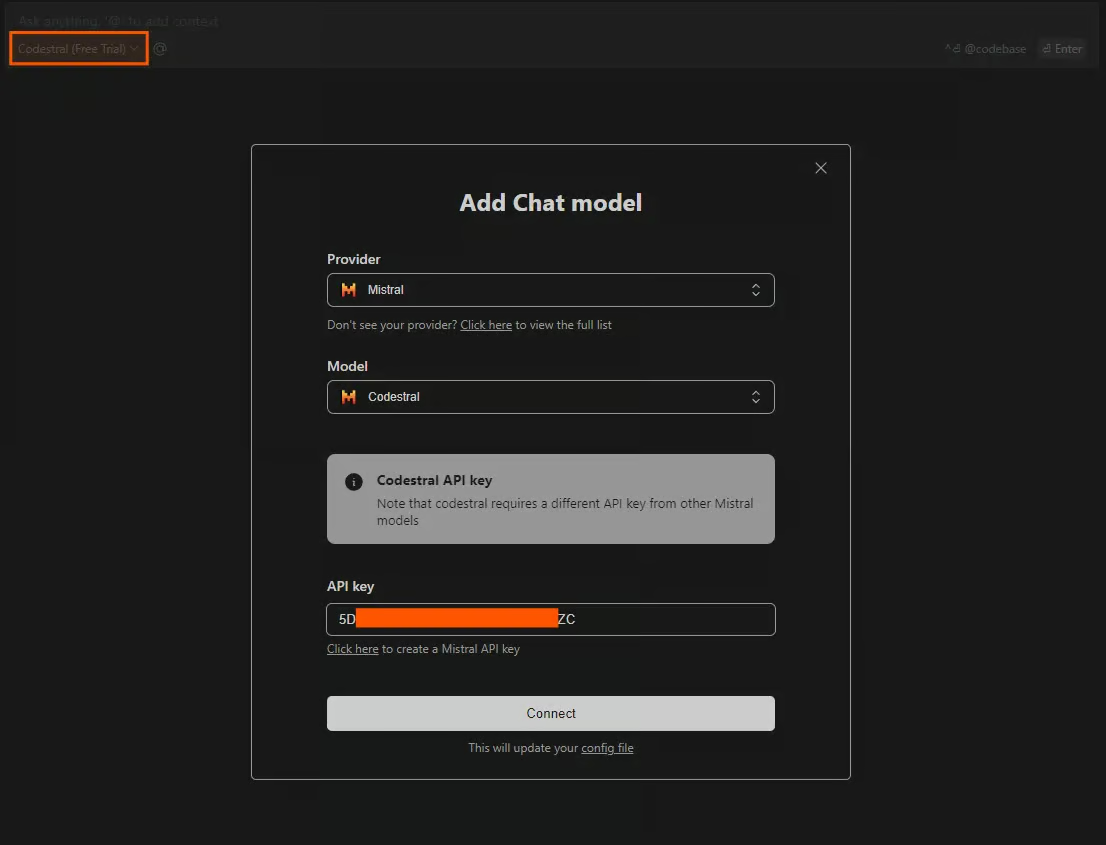

Otro método para utilizar Codestral en IDE es chatear con el modelo. Para acceder a la ventana de chat, pulsa CTRL+L. Puedes seleccionar varios modelos para utilizarlos como modelos de chat, pero están limitados si no proporcionas una clave API. Para acceder libremente a Codestral, haz clic en el modelo de la sección de chat y selecciona Añadir modelo de chat. Selecciona Mistral como proveedor, Codestral como modelo, y pega tu clave API.

Prueba Codestral 25.01

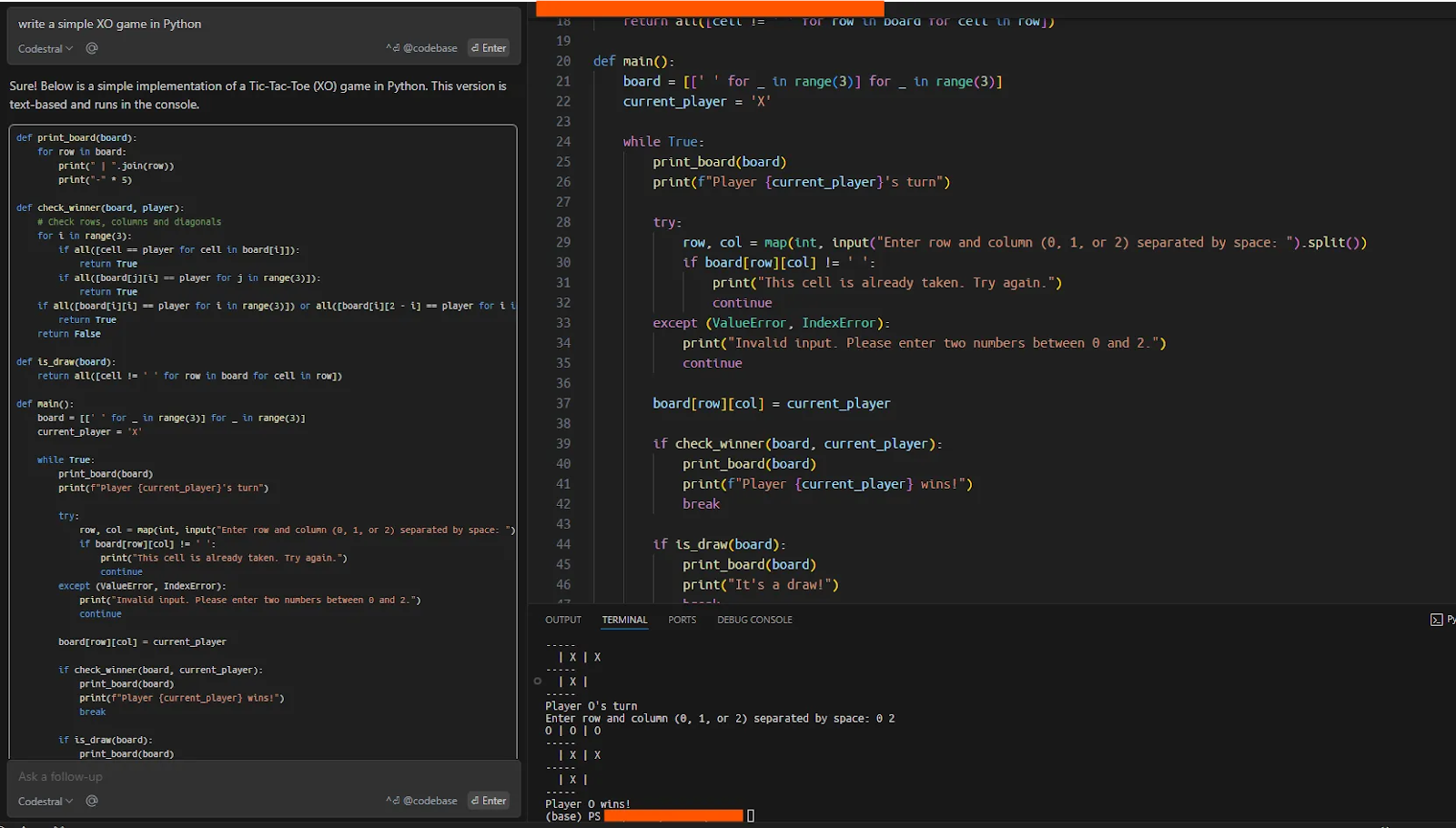

Ahora, para comprobar que todo funciona correctamente, pedí a Codestral que escribiera un sencillo juego XO en Python, que el modelo ejecutó correctamente de un tirón.

Utilizar Codestal en la ventana de chat

Una de las aplicaciones más comunes y útiles de un LLM de código es trabajar en bases de código existentes. Estas bases de código pueden ser lo suficientemente grandes y complejas como para simular un escenario del mundo real utilizando estos modelos. Aquí probaré la capacidad de Codestral para trabajar con el framework smolagents, que es el repositorio de Hugging Face para construir agentes (obtén más información en este tutorial sobre Smolagents de Hugging Face).

Clonaré el repositorio, daré la carpeta como contexto al modelo, y pediré a Codestral que me ayude a escribir una demo sencilla con smolagents.

Tras clonar el repositorio, entregué el código base completo a Codestral. Puedes elegir qué datos, código o documentos dar al modelo como contexto, utilizando "@" en el chat. Para dar todo el código base como contexto, la pregunta sería: "@Codebase ¿de qué trata esta codebase?".

Al principio, cuando pedí a Codestral que escribiera una demostración sencilla de smolagents (que se explica claramente en el README del repositorio con cuatro líneas de código), el modelo fue incapaz de dar una respuesta coherente.

A continuación, pedí al modelo que explicara el repositorio y en qué consistía, lo que dio lugar a un buen resumen.

Mi siguiente pregunta fue "¿cómo se puede ejecutar un agente simple con smolagents?" El modelo me dio una buena respuesta basándose en el archivo README.

En el tercer paso, pedí "constrúyeme un agente", a lo que el modelo respondió construyendo un agente sencillo tal y como indicaba la documentación. Fue sorprendente que el modelo fuera incapaz de construir una demostración cuando se lo pedí por primera vez, pero parece que preguntarle al modelo sobre el repositorio primero, le da más contexto con el que trabajar.

Trabajar en una base de código existente con Codestral

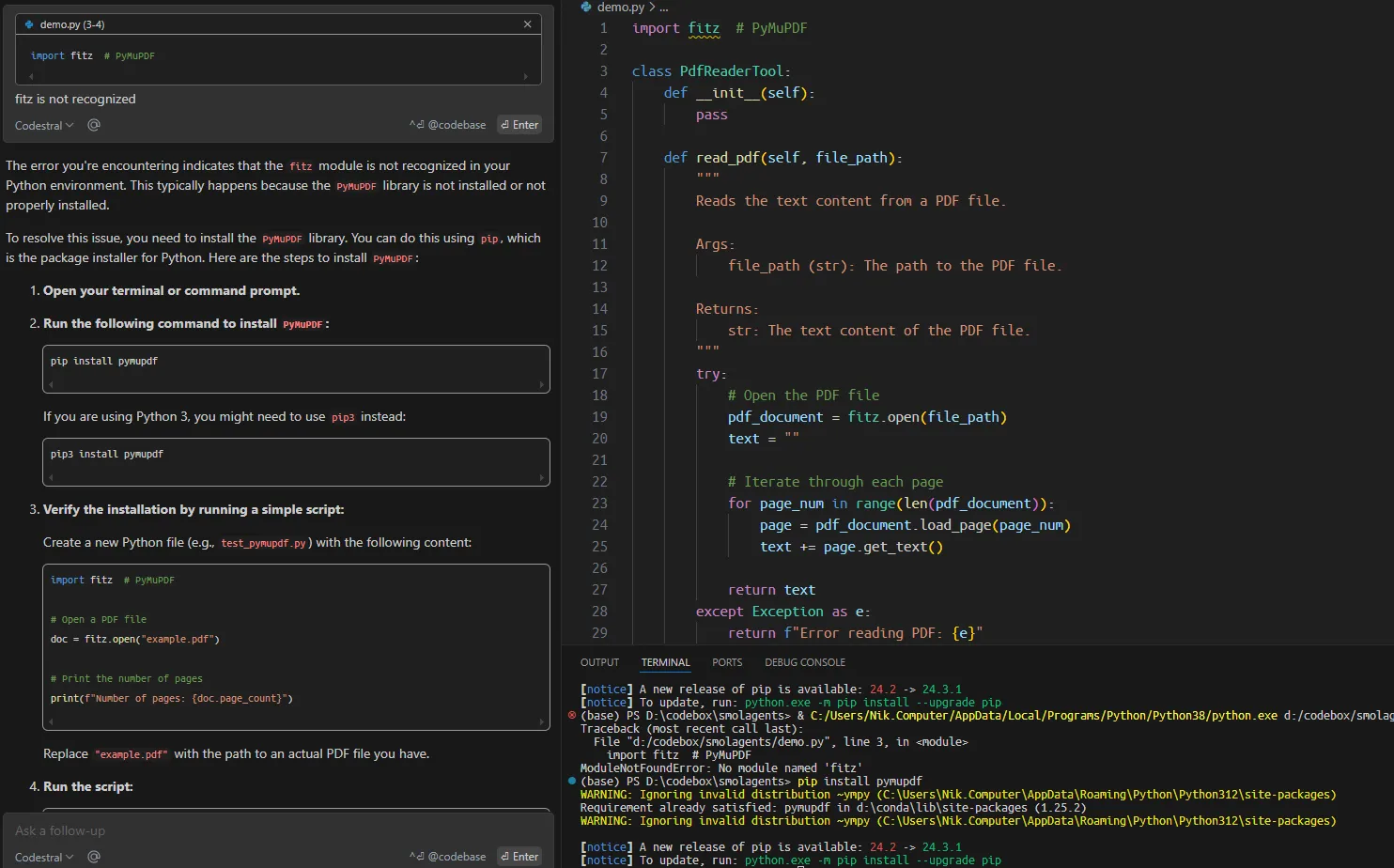

A continuación, pedí al modelo que construyera una herramienta agéntica personalizada para leer archivos PDF basada en la documentación del repositorio. Sorprendentemente, el código sugerido contenía múltiples errores que podrían haberse evitado fácilmente.

Aunque la velocidad de generación de respuestas es notable, y el modelo ofrece autocompletados productivos, en los casos más serios de creación de una aplicación o de trabajo en una base de código existente, debes dividir la tarea en piezas mucho más pequeñas y en un contexto específico para que cumpla su cometido.

Conclusión

Empezamos este artículo presentando Codestral 25.01 y revisando su rendimiento en pruebas comparativas, que demuestran que es un LLM de código potente. A continuación, mostramos cómo configurar Codestral 25.01 en VsCode y cómo utilizarlo en acción.

Aunque la nueva versión de Codestral puede que no sea el mejor LLM de codificación, es muy conveniente que podamos utilizarlo gratuitamente como asistente de código en IDEs. La experiencia general se parece a la de Cursor AIpero para los reacios a instalar Cursor o comprar créditos API de otros modelos, la experiencia gratuita de Codestral puede ser una buena alternativa.

Estudiante de Máster en Inteligencia Artificial y redactor técnico de IA. Comparto ideas sobre la última tecnología de IA, haciendo accesible la investigación en ML y simplificando los complejos temas de IA necesarios para mantenerte a la vanguardia.