Lernpfad

Für uns Programmierer/innen ist das Programmieren vielleicht eine der wichtigsten Anwendungen des LLMs. Die Fähigkeit, präzisen Code zu erstellen, zu debuggen und Code richtig zu "verstehen", macht ein LLM zu einem wichtigen Helfer für viele Programmierer/innen, zusammen mit seinen vielen Vorteilen für Unternehmen.

Mistral hat vor kurzem sein neuestes Modell, Codestral 25.01, auch bekannt als Codestral V2, herausgebracht - ein Upgrade des ihrem ersten Codestral-Modell aus dem Jahr 2024. In diesem Artikel stelle ich Codestral 25.01 vor, bewerte seine Leistung in Benchmarks, führe dich durch die Einrichtung und demonstriere es in Aktion.

Was ist Codestral 25.01 von Mistral?

Ich zitiere aus Mistrals AnkündigungCodestral 25.01 ist "leichtgewichtig, schnell und beherrscht über 80 Programmiersprachen (...), optimiert für Anwendungsfälle mit niedriger Latenz und hoher Frequenz und unterstützt Aufgaben wie FIM (Fill-in-the-Middle), Codekorrektur und Testgenerierung."

Viele Entwickler haben das vorherige Modell verwendet, Codestralfür codebezogene Aufgaben verwendet. Codestral 25.01 ist eine aktualisierte Version mit einem verbesserten Tokenizer und einer effizienteren Architektur, die es ermöglicht, Code doppelt so schnell zu erzeugen.

Mistral hat das Modell noch nicht veröffentlicht und keine Details über seine Architektur oder Größe bekannt gegeben. Wir wissen jedoch, dass er weniger als 100 Milliarden Parameter hat und eine Kontextlänge von 256K unterstützt.

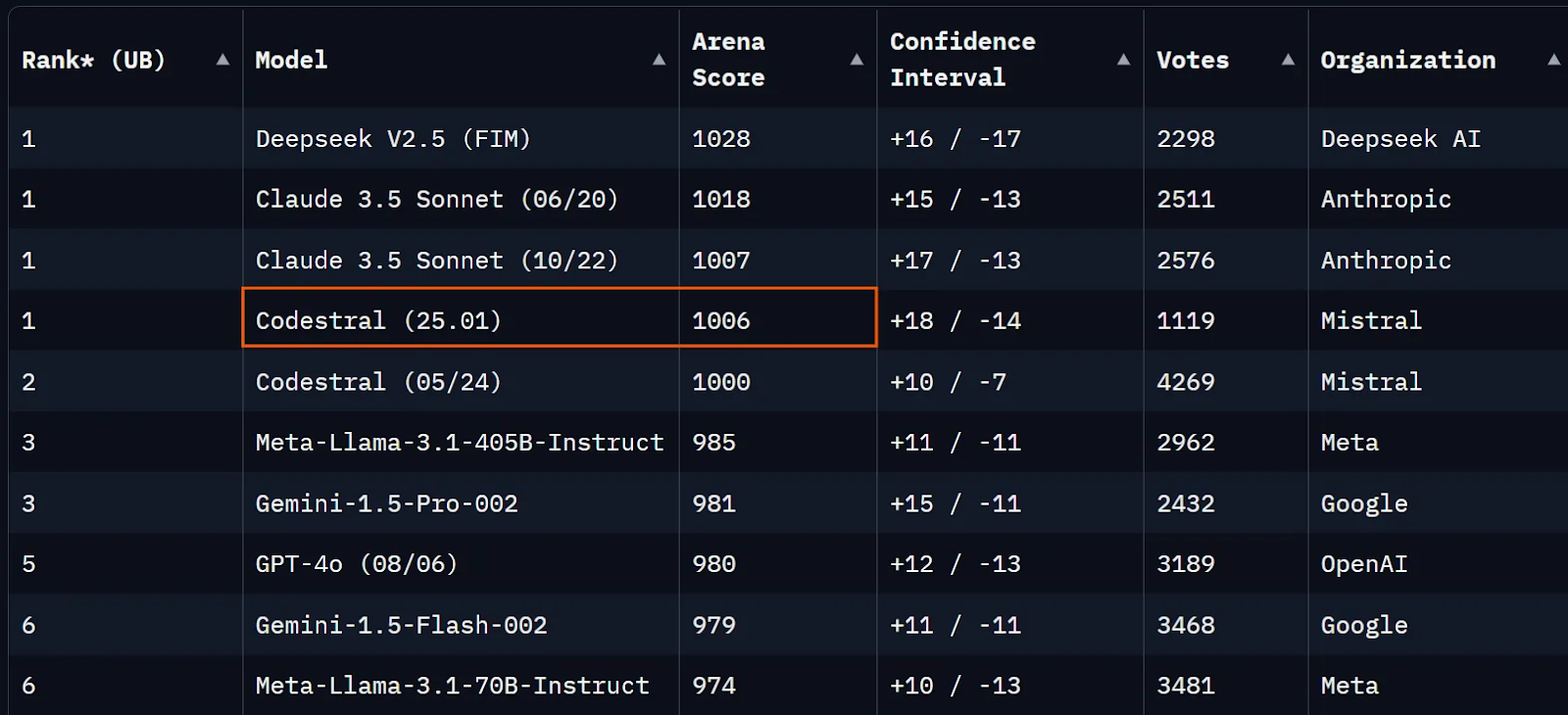

Zum Zeitpunkt der Erstellung dieses Artikels liegt Codestral 25.01 nur wenige Punkte unter Claude 3.5 Sonnet Serie in der Chatbot Arena (ehemals LMSYS) und nur knapp über Codestral V1.

Quelle: Chatbot Arena

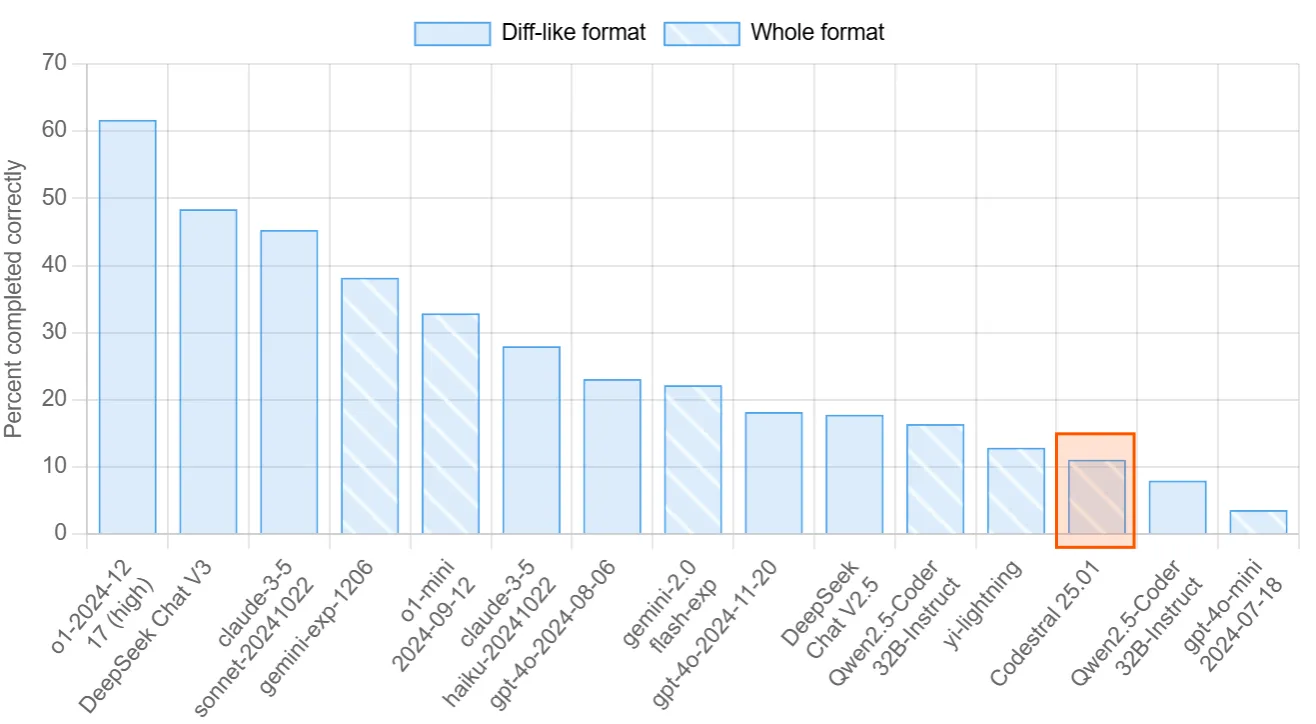

Eine weitere Rangliste, die sich auf die Bewertung der Programmierfähigkeiten von LLMs konzentriert, ist Aider's Polyglot. In diesem Benchmark werden die Modelle aufgefordert, 225 Programmieraufgaben in gängigen Programmiersprachen zu lösen. Codestral 25.01 erzielte 11 %, während Qwen2.5-Coder-32B-Instruct 16% erreichte.

Quelle: Aider-Rangliste

Schauen wir uns zum Schluss die offiziellen Benchmarks an, die von Mistral veröffentlicht wurden. Die veröffentlichten Benchmark-Ergebnisse zeigen einen deutlichen Fortschritt im Vergleich zu Codestral V1, Codellama 70B oder DeepSeek Coder 33B. Es kann aufschlussreicher sein, die Ergebnisse von Codestral 25.01 mit dem neueren Qwen2.5-Coder-32B-Instruct zu vergleichen (die Ergebnisse von Qwen kannst du hier).

Übersicht für Python:

|

Modell |

Kontext Länge |

HumanEval |

MBPP |

CruxEval |

LiveCodeBench |

RepoBench |

|

Codestral-2501 |

256k |

86.6% |

80.2% |

55.5% |

37.9% |

38.0% |

|

Codestral-2405 22B |

32k |

81.1% |

78.2% |

51.3% |

31.5% |

34.0% |

|

Codellama 70B instruieren |

4k |

67.1% |

70.8% |

47.3% |

20.0% |

11.4% |

|

DeepSeek Coder 33B instruieren |

16k |

77.4% |

80.2% |

49.5% |

27.0% |

28.4% |

|

DeepSeek Coder V2 lite |

128k |

83.5% |

83.2% |

49.7% |

28.1% |

20.0% |

Benchmarks für mehrere Sprachen:

|

Modell |

HumanEval Python |

HumanEval C++ |

HumanEval Java |

HumanEval Javascript |

HumanEval Bash |

HumanEval Typescript |

HumanEval C# |

HumanEval (Durchschnitt) |

|

Codestral-2501 |

86.6% |

78.9% |

72.8% |

82.6% |

43.0% |

82.4% |

53.2% |

71.4% |

|

Codestral-2405 22B |

81.1% |

68.9% |

78.5% |

71.4% |

40.5% |

74.8% |

43.7% |

65.6% |

|

Codellama 70B instruieren |

67.1% |

56.5% |

60.8% |

62.7% |

32.3% |

61.0% |

46.8% |

55.3% |

|

DeepSeek Coder 33B instruieren |

77.4% |

65.8% |

73.4% |

73.3% |

39.2% |

77.4% |

49.4% |

65.1% |

|

DeepSeek Coder V2 lite |

83.5% |

68.3% |

65.2% |

80.8% |

34.2% |

82.4% |

46.8% |

65.9% |

Wie man Codestral 25.01 auf VS Code einrichtet

Leider ist das Modell nicht offen, und du kannst es nicht lokal ausführen. Die gute Nachricht ist, dass du das Modell über die API oder über VsCode und PyCharm kostenlos als Code-Assistent nutzen kannst.

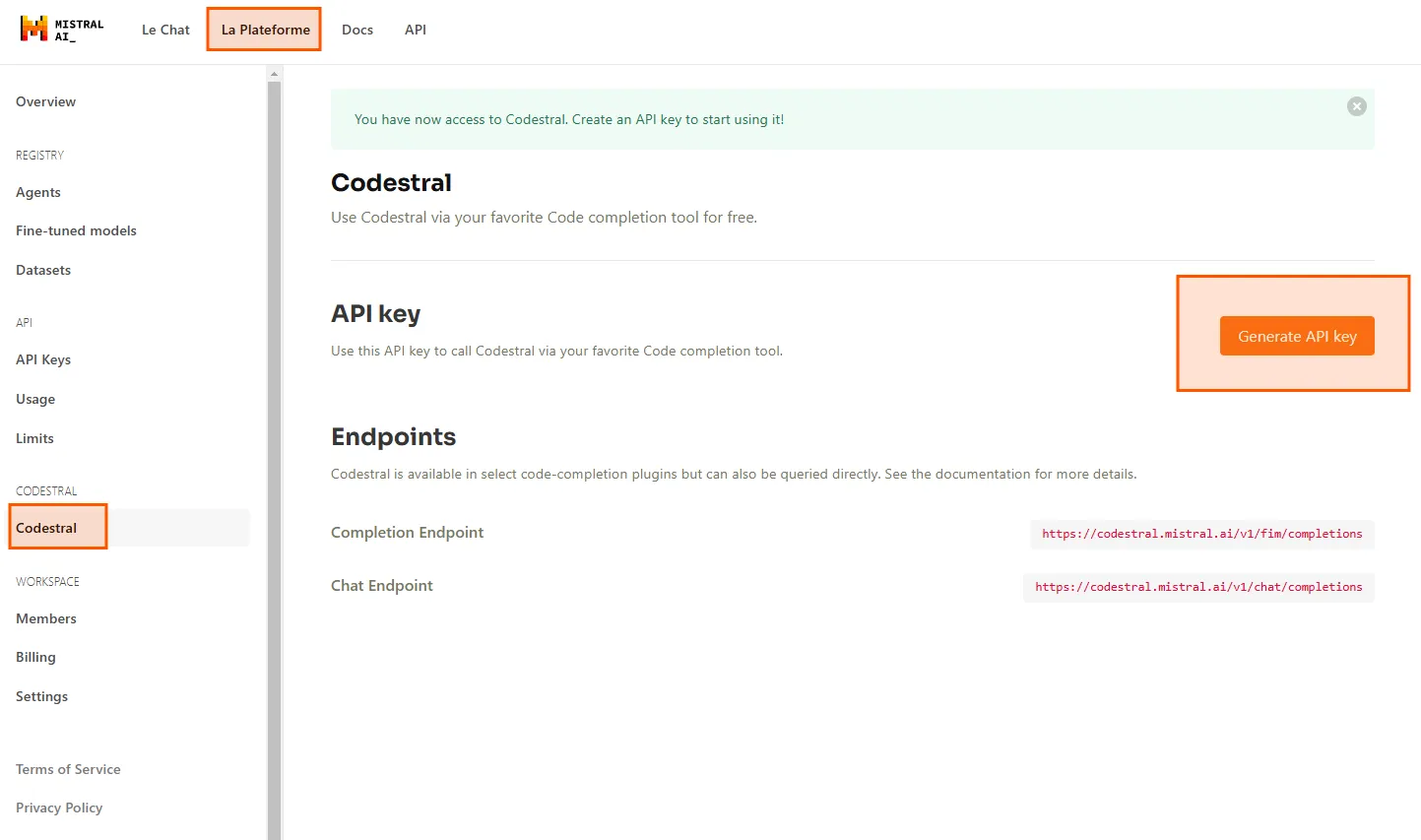

Zuerst brauchen wir einen API-Schlüssel. Geh rüber zu Le Plateformeund navigiere zu Codestral. Hier kannst du deinen API-Schlüssel generieren, um Codestral 25.01 in deiner IDE zu verwenden.

Ich werde Codestral in VS Code über die Erweiterung Continue verwenden. Du kannst auf dem Marktplatz für Erweiterungen danach suchen und sie kostenlos installieren.

Nachdem du die Erweiterung installiert hast, klicke unten rechts in VsCode auf die Schaltfläche Weiter, wähle Autovervollständigungsoptionen konfigurieren und füge deinen API-Schlüssel unter Codestral ein . Jetzt kannst du Codestral als Modell für die automatische Vervollständigung verwenden.

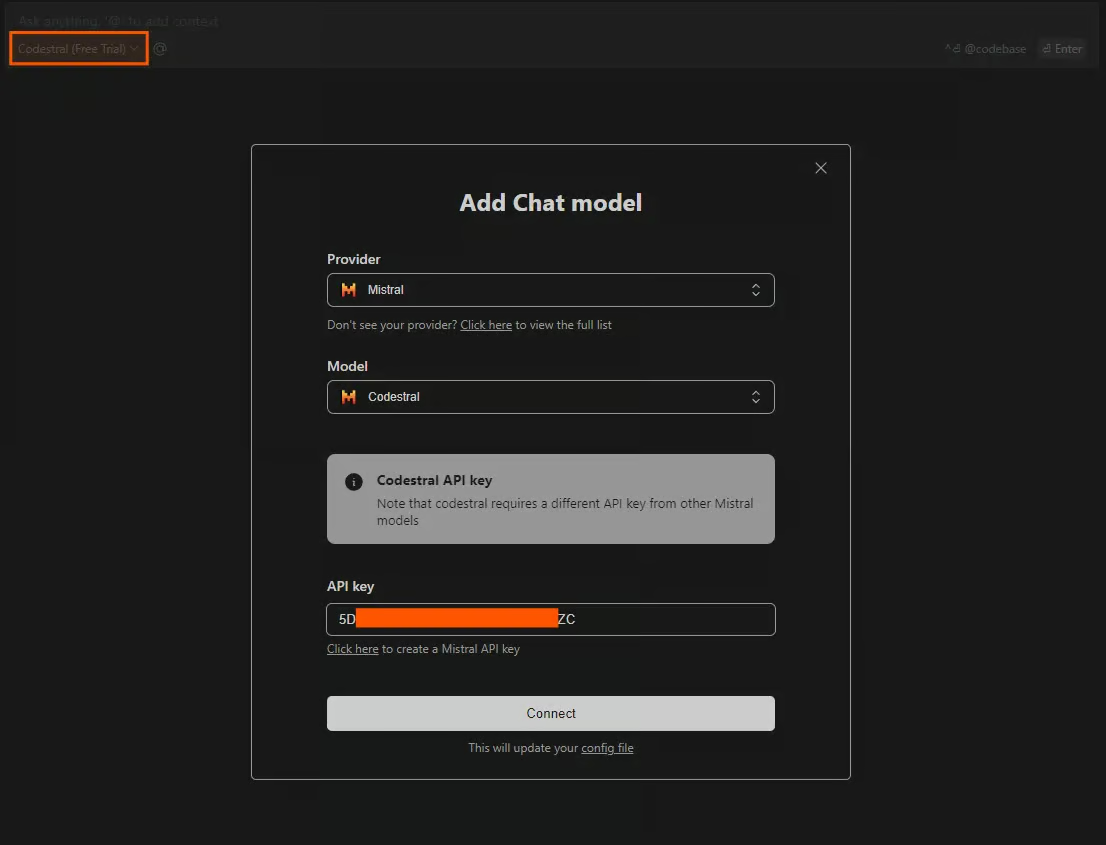

Eine andere Methode, Codestral in der IDE zu nutzen, ist der Chat mit dem Modell. Um das Chat-Fenster zu öffnen, drücke STRG+L. Du kannst eine Vielzahl von Modellen auswählen, die du als Chat-Modelle verwenden kannst, aber ohne Angabe eines API-Schlüssels sind sie begrenzt. Um freien Zugang zu Codestral zu haben, klicke auf das Modell im Chat-Bereich und wähle Chat-Modell hinzufügen. Wähle Mistral als Anbieter, Codestral als Modell und füge deinen API-Schlüssel ein.

Prüfung Codestral 25.01

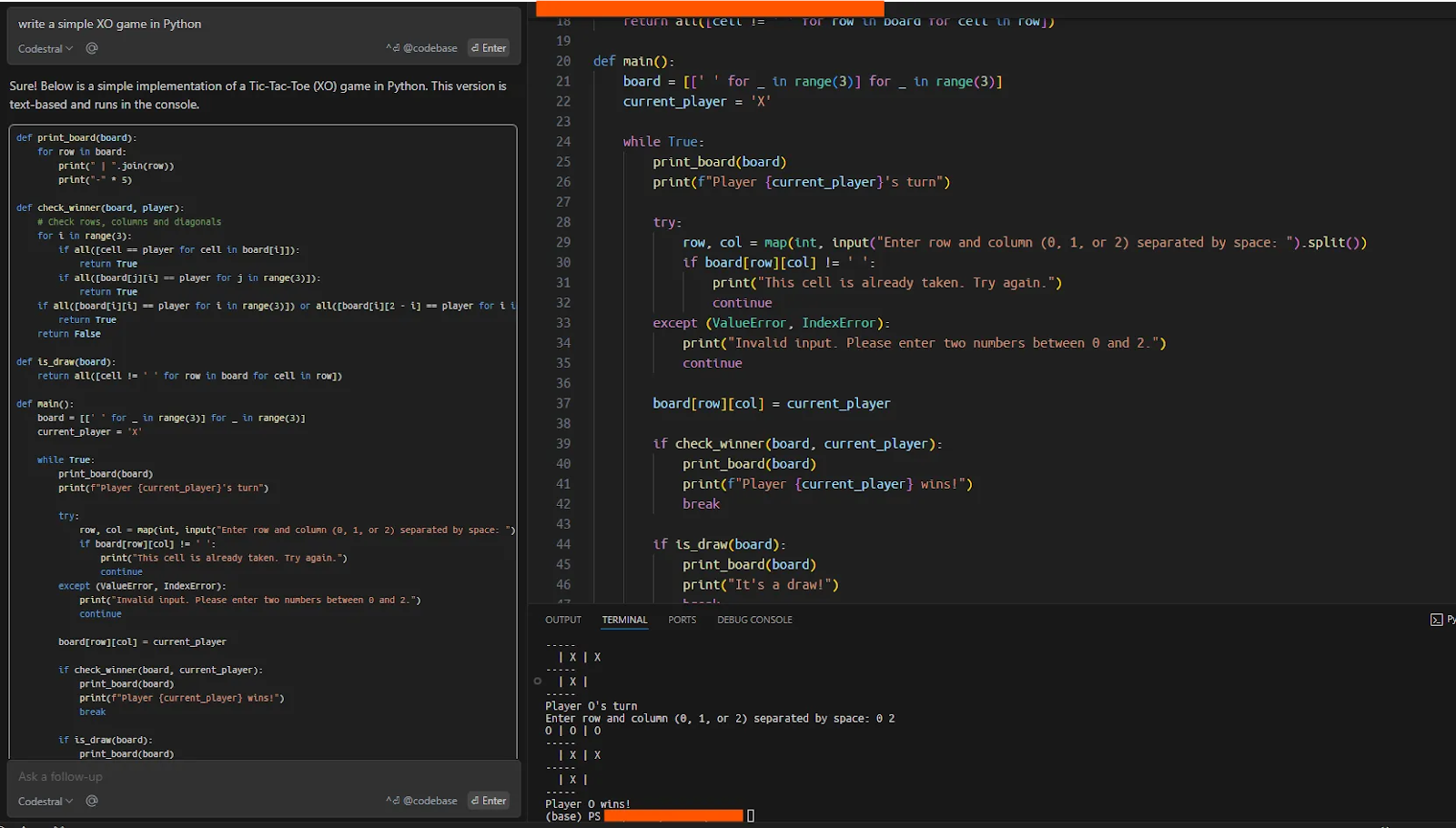

Um zu testen, ob alles reibungslos funktioniert, habe ich Codestral gebeten, ein einfaches XO-Spiel in Python zu schreiben, das das Modell auf Anhieb korrekt ausgeführt hat.

Codestal im Chatfenster verwenden

Eine der häufigsten und nützlichsten Anwendungen eines Code-LLMs ist die Arbeit an bestehenden Codebasen. Diese Codebasen können groß und komplex genug sein, um mit diesen Modellen ein reales Szenario zu simulieren. Hier werde ich testen, ob Codestral mit dem smolagents Framework zusammenarbeitet, dem Repository von Hugging Face zur Erstellung von Agenten (mehr dazu in diesem Tutorial über Hugging Face's Smolagents).

Ich klone das Repository, gebe den Ordner als Kontext für das Modell an und bitte Codestral, mir beim Schreiben einer einfachen Demo mit smolagents zu helfen.

Nachdem ich das Repository geklont hatte, übergab ich die komplette Codebasis an Codestral. Du kannst auswählen, welche Daten, Codes oder Dokumente dem Modell als Kontext übergeben werden sollen, indem du "@" im Chat benutzt. Um die gesamte Codebase als Kontext anzugeben, würde die Aufforderung lauten: "@Codebase worum geht es in dieser Codebase?".

Als ich Codestral aufforderte, eine einfache Demo von smolagents zu schreiben (was in der README des Repositorys mit vier Zeilen Code klar erklärt wird), war das Modell zunächst nicht in der Lage, eine kohärente Antwort zu geben.

Ich habe das Modell dann gebeten, das Repository zu erklären und zu erklären, worum es geht, was eine gute Zusammenfassung ergab.

Meine nächste Frage war: "Wie kann man einen einfachen Agenten mit smolagents betreiben?" Das Modell gab mir eine gute Antwort auf der Grundlage der README-Datei.

Im dritten Schritt fragte ich: "Baue mir einen Agenten", woraufhin das Modell einen einfachen Agenten baute, so wie es in der Dokumentation beschrieben war. Es war überraschend, dass das Modell nicht in der Lage war, eine Demo zu erstellen, als ich es zum ersten Mal fragte, aber es scheint, dass das Modell, wenn es zuerst nach dem Repository gefragt wird, mehr Kontext hat, mit dem es arbeiten kann.

Arbeiten an einer bestehenden Codebasis mit Codestral

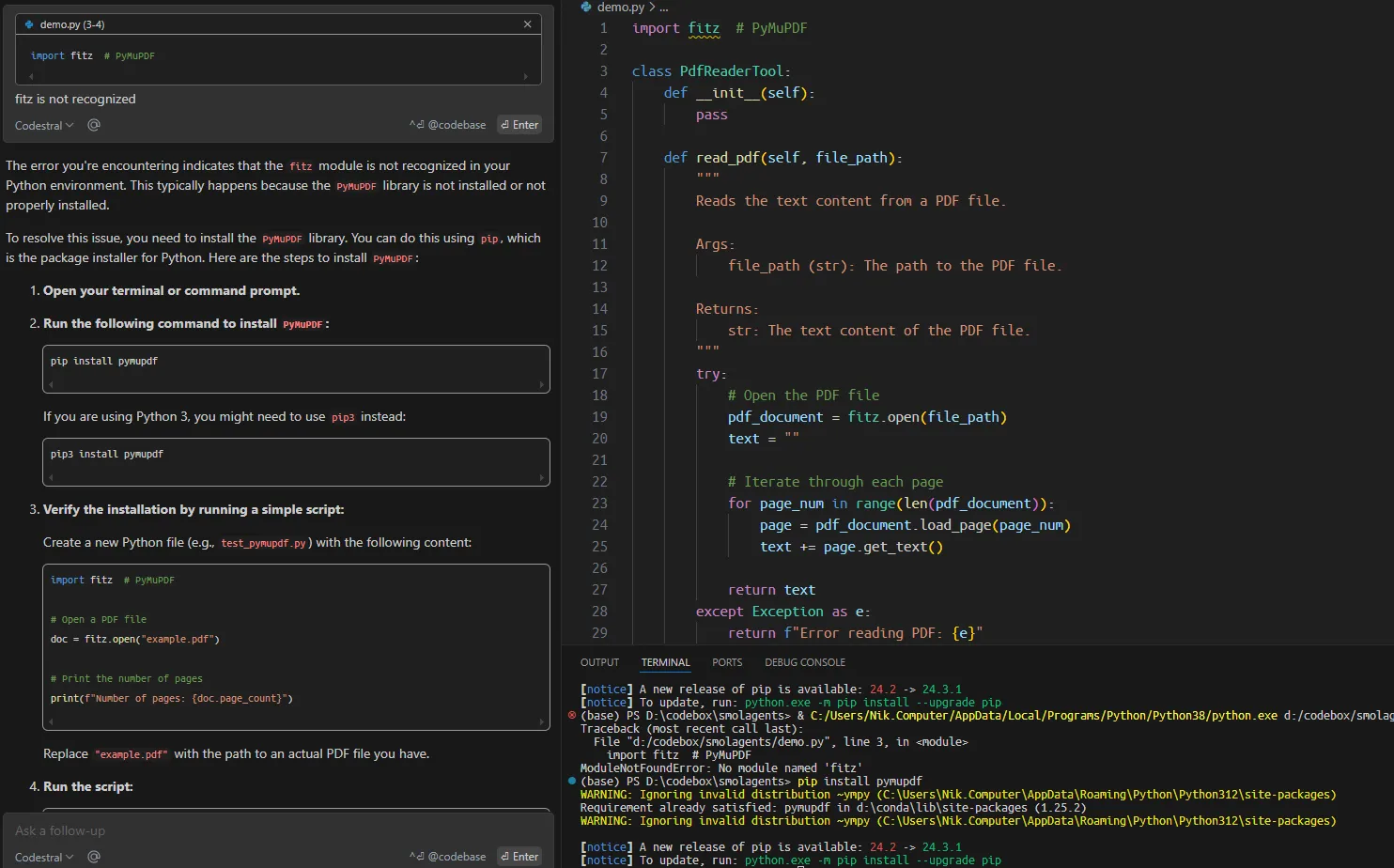

Dann habe ich das Modell aufgefordert, ein benutzerdefiniertes agenturisches Tool zum Lesen von PDF-Dateien zu erstellen, das auf der Dokumentation des Repositorys basiert. Überraschenderweise enthielt der vorgeschlagene Code mehrere Fehler, die leicht hätten vermieden werden können.

Während die Geschwindigkeit, mit der Antworten generiert werden, spürbar ist und das Modell produktive Autovervollständigungen bietet, musst du in ernsteren Fällen, wenn du eine Anwendung erstellst oder an einer bestehenden Codebasis arbeitest, die Aufgabe in viel kleinere Teile und einen spezifischen Kontext zerlegen, damit sie funktioniert.

Fazit

Zu Beginn dieses Artikels haben wir Codestral 25.01 vorgestellt und seine Leistung in Benchmarks überprüft, die zeigen, dass es ein starker Code LLM ist. Dann haben wir gezeigt, wie man Codestral 25.01 in VsCode einrichtet und wie man es in der Praxis einsetzt.

Die neue Version von Codestral ist zwar nicht die beste LLM, aber es ist sehr praktisch, dass wir sie kostenlos als Code-Assistent in IDEs verwenden können. Das Gesamterlebnis ähnelt dem von Cursor AIaber für diejenigen, die Cursor nicht installieren oder API-Credits anderer Modelle kaufen wollen, kann die kostenlose Erfahrung von Codestral eine gute Alternative sein.

Masterstudent der Künstlichen Intelligenz und technischer Redakteur für KI. Ich gebe Einblicke in die neuesten KI-Technologien, mache ML-Forschung zugänglich und vereinfache komplexe KI-Themen, die du brauchst, um ganz vorne mit dabei zu sein.