Kurs

Seit seinem Start im November 2022 hat ChatGPT weltweit Aufmerksamkeit erregt. Dieser bahnbrechende KI-Chatbot ist in der Lage, Anweisungen in natürlicher Sprache zu interpretieren und Antworten zu geben, die einer menschlichen Konversation in einem breiten Spektrum von Themen sehr ähnlich sind.

Das Aufkommen von großen Sprachmodellen wie GPT-4 hat neue Möglichkeiten im Bereich der Verarbeitung natürlicher Sprache eröffnet. Mit der Veröffentlichung der ChatGPT API von OpenAI können wir jetzt ganz einfach KI-Funktionen in unsere Anwendungen integrieren. In diesem Einsteigerhandbuch werden wir uns ansehen, was die ChatGPT-API bietet und wie du mit einem Python-Client einsteigen kannst.

KI-Anwendungen entwickeln

Was ist GPT?

GPT, kurz für Generative Pre-trained Transformer, ist eine Reihe von Sprachmodellen, die von OpenAI entwickelt wurden. Diese Modelle, die sich von GPT-1 bis GPT-4 entwickeln, werden auf umfangreichen Textdaten trainiert und können für bestimmte Sprachaufgaben weiter verfeinert werden. Sie zeichnen sich dadurch aus, dass sie zusammenhängende Texte erstellen, indem sie die nachfolgenden Wörter vorhersagen. ChatGPT, eine Konversations-KI, die auf diesen Modellen basiert, interagiert in natürlicher Sprache und ist so trainiert, dass sie sicher, zuverlässig und informativ ist und ihr Wissen bis März 2023 aktualisiert.

Was ist die ChatGPT API?

Eine API (Application Programming Interface) ermöglicht es zwei Softwareprogrammen, miteinander zu kommunizieren. APIs machen bestimmte Funktionen und Daten aus einer Anwendung für andere Anwendungen zugänglich. Die Twitter-API ermöglicht es Entwicklern zum Beispiel, auf Nutzerprofile, Tweets, Trends usw. von Twitter zuzugreifen und ihre eigenen Anwendungen mit diesen Daten zu erstellen.

Die ChatGPT-API ermöglicht den Zugriff auf die KI-Modelle von OpenAI wie GPT-4, GPT-4 turbo, GPT-3, etc. Sie ermöglicht es uns, diese Sprachmodelle über die API in unseren Anwendungen zu nutzen. Es gibt verschiedene Anwendungsfälle, in denen du mit diesen APIs interessante Funktionen und Features in deinen Anwendungen erstellen kannst, die für deine Nutzer/innen nützlich sind. Das kann Folgendes beinhalten:

- Chatbots und virtuelle Assistenten bauen

- Automatisierung der Kundensupport-Workflows

- Erstellung von Inhalten wie E-Mails, Berichten und mehr

- Beantwortung domänenspezifischer Fragen

Hauptmerkmale der ChatGPT API

Sehen wir uns einige der Gründe an, warum du die ChatGPT API für dein Projekt nutzen solltest:

Natürliches Sprachverstehen

ChatGPT verfügt über außergewöhnliche Fähigkeiten, natürliche Sprache zu verstehen. Sie basiert auf der GPT-3-Architektur, die es ihr ermöglicht, eine Vielzahl von natürlichsprachlichen Eingaben zu interpretieren und zu verarbeiten, darunter Fragen, Befehle und Aussagen.

Dieses Verständnis wird durch das Training auf einem riesigen Korpus von Textdaten erleichtert, so dass es verschiedene sprachliche Nuancen erkennen und Antworten generieren kann, die korrekt und kontextbezogen sind..

Generierung kontextbezogener Antworten

Die API zeichnet sich dadurch aus, dass sie Texte generiert, die nicht nur kohärent, sondern auch kontextuell relevant sind. Das bedeutet, dass ChatGPT Antworten geben kann, die sich nahtlos in den Gesprächsfluss einfügen und die Relevanz des zuvor bereitgestellten Kontexts beibehalten.

Dank seiner Fähigkeit, lange Textsequenzen zu verarbeiten, kann es die Abhängigkeiten innerhalb eines Gesprächs verstehen und so sicherstellen, dass die Antworten nicht nur korrekt, sondern auch im gegebenen Kontext sinnvoll sind.

Zu den wichtigsten Funktionen der API gehören:

- Natürliches Sprachverständnis

- Generierung kontextbezogener Antworten

- Die Fähigkeit, Folgefragen zu beantworten

- Unterstützung für dialogorientierte Arbeitsabläufe

So benutzt du die ChatGPT API

Die OpenAI Python API-Bibliothek bietet einen einfachen und effizienten Weg, um mit der REST-API von OpenAI aus jeder Python 3.7+ Anwendung zu interagieren. Dieser ausführliche Leitfaden soll dir helfen zu verstehen, wie du die Bibliothek effektiv nutzen kannst.

Installation

Um die Bibliothek zu verwenden, installiere sie mit pip:

!pip install openaiVerwendung

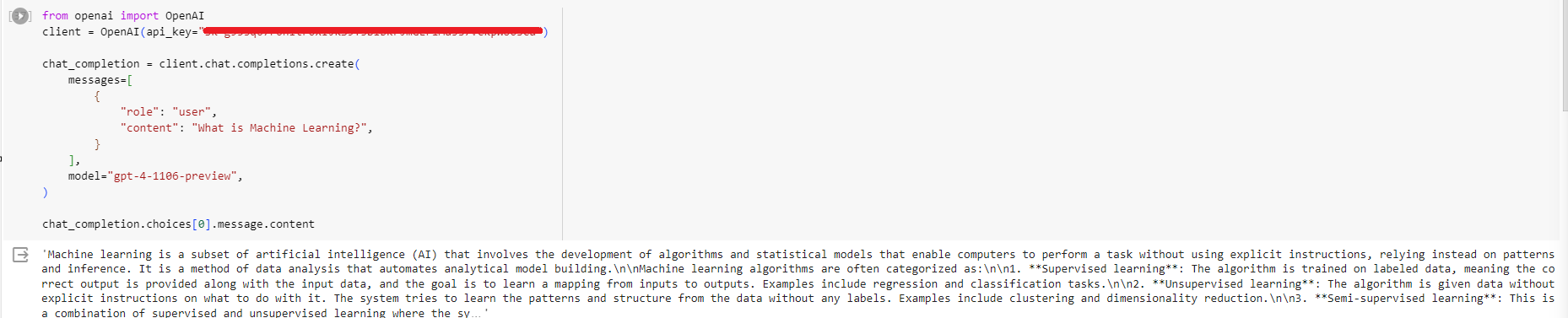

Um die Bibliothek zu nutzen, musst du sie importieren und einen OpenAI-Client erstellen:

from openai import OpenAI

client = OpenAI(api_key="...")

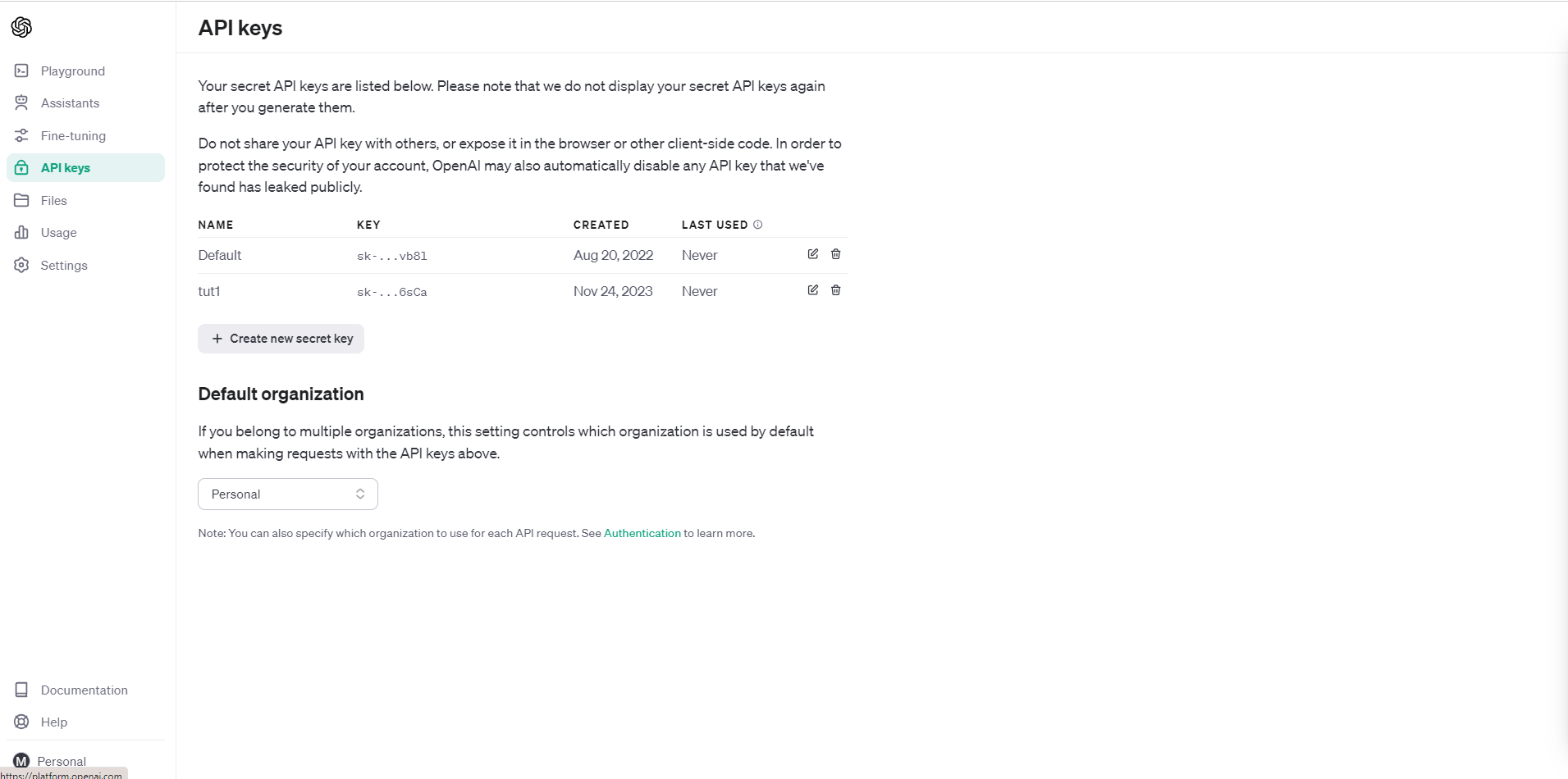

Du kannst einen Schlüssel generieren, indem du dich auf platform.openai.com anmeldest

Sobald du den Schlüssel hast, kannst du API-Aufrufe tätigen, z. B. Chatvervollständigungen erstellen:

chat_completion = client.chat.completions.create(

messages=[

{

"role": "user",

"content": "What is Machine Learning?",

}

],

model="gpt-4-1106-preview",

)

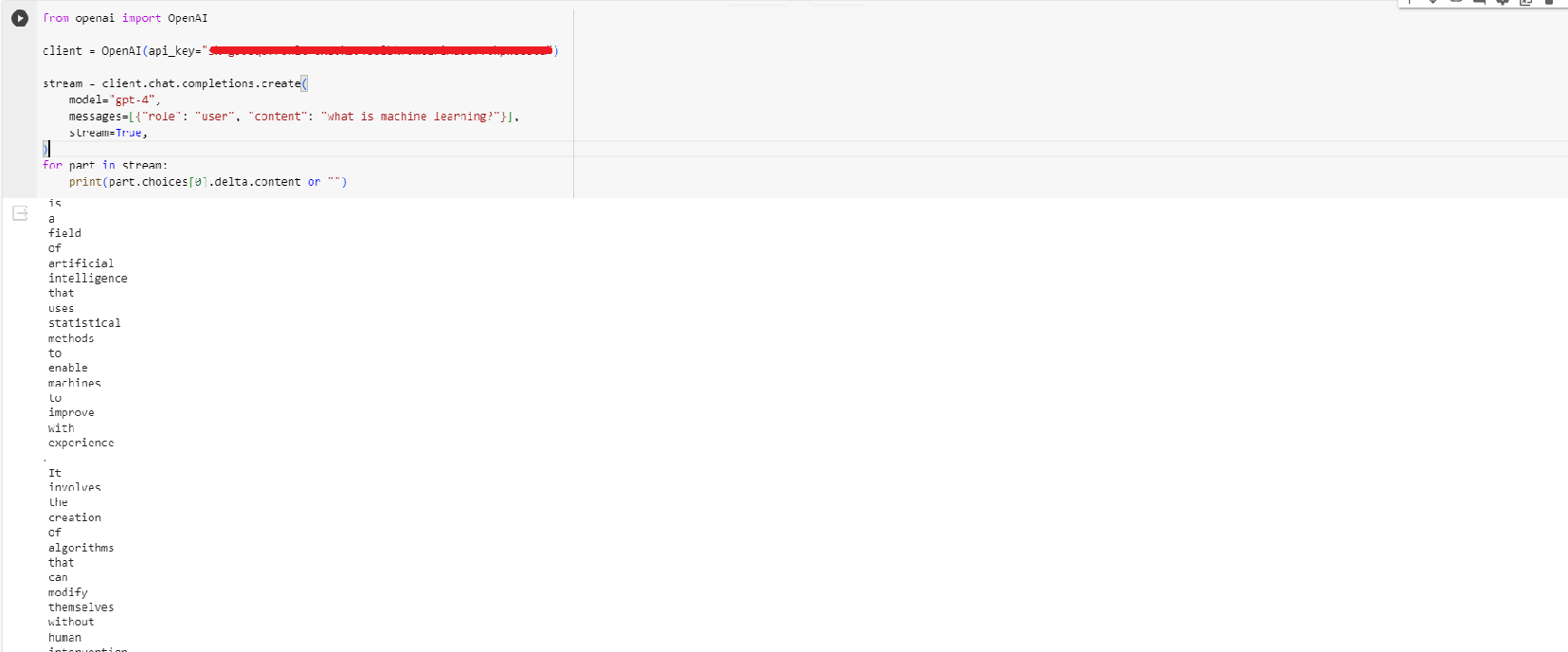

Die Bibliothek unterstützt auch Streaming-Antworten mit Server-Side Events (SSE). Hier ist ein Beispiel dafür, wie du Antworten streamen kannst:

from openai import OpenAI

client = OpenAI(api_key="...")

stream = client.chat.completions.create(

model="gpt-4",

messages=[{"role": "user", "content": "what is machine learning?"}],

stream=True,

)

for part in stream:

print(part.choices[0].delta.content or "")

OpenAI Modelle und Preisgestaltung

OpenAI bietet eine Reihe verschiedener KI-Modelle, die Nutzer über ihre API nutzen können. Die Modelle unterscheiden sich in ihren Funktionen, Preisen und Einsatzmöglichkeiten.

Das Flaggschiffmodell GPT-4 ist das leistungsfähigste und teuerste Modell. Es beginnt bei 0,03 $ pro 1.000 Token für die Eingabe und 0,06 $ pro 1.000 Token für die Ausgabe. GPT-4 repräsentiert den neuesten Stand der natürlichen Sprachverarbeitung und ist in der Lage, menschenähnliche Texte zu verstehen und zu erzeugen. Es unterstützt bis zu 128.000 Kontext-Tokens. Die GPT-4-Familie umfasst das Basismodell GPT-4 sowie das Modell GPT-4-32k, das 32.000 Token an Kontext verwendet.

Ein neu veröffentlichtes GPT-4-Turbomodell hat eine Kontextlänge von 128k, bietet Vision-Unterstützung und ist leistungsfähiger als GPT-4. Das Beste daran sind die Preise. Der Preis liegt bei nur 0,01 $ pro 1.000 Token für den Input und 0,03 $ pro 1.000 Token für den Output.

Für eine kostengünstigere Verarbeitung natürlicher Sprache bietet OpenAI die GPT-3.5-Modellfamilie an. GPT-3.5 Turbo ist für Konversationsanwendungen mit 16.000 Kontext-Token optimiert und kostet 0,0010 $ pro 1.000 Input-Token und 0,0020 $ pro 1.000 Output-Token. GPT-3.5 Turbo Instruct ist ein Instruct-Modell mit 4.000 Token Kontext, das mit $0,0015 pro 1.000 Input-Token und $0,0020 pro 1.000 Output-Token etwas teurer ist.

Zusätzlich zu den Kern-Sprachmodellen bietet OpenAI über seine API weitere Funktionen. Die Assistenten-API macht es einfach, KI-Assistenten zu erstellen, indem sie Werkzeuge wie die Abfrage und die Interpretation von Codes bereitstellt. Bildmodelle können Bilder erzeugen und bearbeiten. Einbettungsmodelle können Text als numerische Vektoren darstellen. Es gibt auch Optionen zur Feinabstimmung der Modelle für bestimmte Anwendungen.

OpenAI bietet eine Reihe von leistungsstarken KI-Modellen, die Entwickler über eine einfache, kostenpflichtige API nutzen können. Die Wahl des Modells hängt von den spezifischen Anwendungsanforderungen und dem Budget ab. Das GPT-4 bietet modernste Funktionen zu einem erstklassigen Preis, während Modelle wie das GPT-3.5 ein ausgewogenes Verhältnis zwischen Leistung und Kosten für viele Anwendungen bieten.

In der offiziellen Dokumentation erfährst du mehr über alle verfügbaren Modelle und ihre API-Preise.

Flexibilität und Anpassungsfähigkeit

Die API bietet viele Parameter, um das Verhalten des Modells an die Bedürfnisse deiner Anwendung anzupassen:

Authentifizierung

- api_key (str): Dein API-Schlüssel für die Authentifizierung von Anfragen. Erforderlich.

Modelle

- model (str): Die ID des zu verwendenden Modells. Gibt an, welches Modell für den Abschluss verwendet werden soll.

Eingabe

- prompt (str): Die Aufforderung(en), für die Vervollständigungen erstellt werden sollen. Typischerweise Text.

- Suffix (str): Das Suffix, das nach einer Vervollständigung des generierten Textes kommt.

Ausgabe

- max_tokens (int): Die maximale Anzahl von Token, die beim Abschluss erzeugt werden. Zwischen 1 und 4096.

- stop (str): Bis zu 4 Sequenzen, in denen die API keine weiteren Token mehr erzeugt.

- Temperatur (Float): Kontrolliert die Zufälligkeit. Die Werte reichen von 0,0 bis 2,0. Höhere Werte bedeuten, dass das Modell mehr Risiken eingehen wird.

- top_p (Float): Eine Alternative zur Probenahme mit Temperatur, die sogenannte Kernprobenahme. Die Werte reichen von 0,0 bis 1,0. Höhere Werte bedeuten, dass das Modell mehr Risiken eingehen wird.

- n (int): Wie viele Vervollständigungen für jede Aufforderung erstellt werden sollen.

- stream (bool): Ob ein Teil des Fortschritts übertragen werden soll. Wenn diese Option gesetzt ist, werden die Token als reine Server-Ereignisse gesendet, sobald sie verfügbar sind.

Gestaltung des ChatGPT-API-Verhaltens

Die drei wichtigsten Nachrichtentypen, die das Verhalten eines Chatbots bestimmen, sind "System"-, "Benutzer"- und "Assistent"-Nachrichten. Systemnachrichten stellen die internen Prozesse des Chatbots dar, Benutzernachrichten sind die Eingaben von Menschen und Assistenznachrichten sind die Antworten des Chatbots.

Die Systemnachrichten ermöglichen es dem Chatbot, den Gesprächsstatus zu verfolgen, den Kontext zu verstehen und angemessene Antworten festzulegen. Die Systemmeldungen können zum Beispiel das aktuelle Diskussionsthema, die Stimmung des Nutzers oder vergangene Unterhaltungen mit dem Nutzer aufzeichnen. Diese Metadaten bestimmen, wie der Chatbot die Nutzernachrichten interpretiert und Assistenznachrichten erstellt.

Nutzernachrichten liefern den rohen Konversationsinput, den der Chatbot analysieren und auf den er reagieren muss. Der Chatbot nutzt die Verarbeitung natürlicher Sprache, um aus diesen Nachrichten die Bedeutung zu extrahieren und die Absicht zu bestimmen. Unterschiedliche Formulierungen, Längen, Interpunktion und Inhalte von Nutzernachrichten führen zu unterschiedlichen Antworten des Chatbots.

Die Assistenznachrichten schließlich stellen die Antworten des Chatbots dar, die durch die Analyse des Systemzustands und der Benutzereingaben entstanden sind. Der Ton, die Persönlichkeit und der Informationsgehalt von Assistenznachrichten bestimmen letztendlich das Nutzererlebnis. Die sorgfältige Entwicklung der Chatbot-Regeln und der KI, die die Nachrichten der Assistenten generieren, ist der Schlüssel zu einem ansprechenden, hilfreichen Dialog.

Fazit

Die ChatGPT API ist ein bedeutender Schritt nach vorn im Bereich der KI und bietet Entwicklern und Innovatoren ein vielseitiges und leistungsstarkes Werkzeug. Seine Fähigkeit, natürliche Sprache zu verstehen und zu generieren, kombiniert mit der Flexibilität, in verschiedene Anwendungen integriert zu werden, macht es zu einem unschätzbaren Vorteil für die Entwicklung anspruchsvoller KI-gesteuerter Lösungen.

Egal, ob es darum geht, fortschrittliche Chatbots zu bauen, den Kundensupport zu automatisieren, kreative Inhalte zu erstellen oder spezifische Fragen zu beantworten, die ChatGPT API bietet die nötigen Werkzeuge und Fähigkeiten, um diese Ideen zum Leben zu erwecken.

Die breite Palette der von OpenAI angebotenen Modelle, die jeweils auf unterschiedliche Anwendungsfälle und Budgetüberlegungen zugeschnitten sind, stellt sicher, dass Entwickler das für ihre Bedürfnisse am besten geeignete Tool auswählen können. Vom hochmodernen GPT-4 bis zu den kostengünstigeren GPT-3.5-Varianten kann die Wahl des Modells genau auf die spezifischen Anforderungen der Anwendung abgestimmt werden.

Dieser umfassende Leitfaden ist ein hervorragender Ausgangspunkt für alle, die sich diese innovative Technologie zunutze machen wollen.

Willst du mehr über dieses Thema erfahren? Sieh dir dieses praktische Tutorial und die Best Practices für die OpenAI API an. Du kannst dich auch für einen kostenlosen Kurs über die Arbeit mit der OpenAI API anmelden.