programa

Kubernetes se ha convertido en la tecnología por defecto para gestionar aplicaciones en contenedores en los entornos modernos de nube. A medida que las organizaciones se orientan hacia los microservicios y las arquitecturas nativas de la nube, Kubernetes les proporciona todo lo que necesitan para automatizar el despliegue, escalar las aplicaciones y garantizar una alta disponibilidad.

Kubernetes es un orquestador de contenedores de código abierto que simplifica el complejo proceso de gestionar contenedores a escala. Abstrae los problemas de infraestructura, permitiendo a los desarrolladores centrarse en crear aplicaciones en lugar de preocuparse por los servidores subyacentes.

Comprender la arquitectura de Kubernetes es esencial para cualquiera que desee desplegar y gestionar aplicaciones escalables, resistentes y de nivel de producción.

Hoy quiero compartir una visión más profunda sobre la arquitectura de Kubernetes con alumnos de nivel intermedio ya familiarizados con los conceptos básicos de Kubernetes.

¿Qué es Kubernetes?

Kubernetes es un potente sistema distribuido diseñado para orquestar y gestionar aplicaciones en contenedores a escala. Permite a las organizaciones desplegar cargas de trabajo en varias máquinas físicas o virtuales, llamadas Nodos, garantizando que las aplicaciones sigan estando disponibles, sean escalables y resistentes a los fallos.

Uno de los principales puntos fuertes de Kubernetes es su capacidad para gestionar cargas de trabajo dinámicas de forma eficiente. Al distribuir automáticamente los contenedores entre los nodos, Kubernetes garantiza que las aplicaciones puedan escalar horizontalmente, equilibrando las cargas de trabajo en función de los recursos disponibles. Si un nodo se sobrecarga, Kubernetes reprograma las cargas de trabajo a nodos vecinos sanos, minimizando el tiempo de inactividad y manteniendo el rendimiento.

Si aún eres principiante con esta tecnología, consulta este Curso de Introducción a Kubernetes para empezar.

Breve historia de Kubernetes

Google desarrolló originalmente Kubernetes como sucesor de código abierto de Borg, su sistema interno de gestión de contenedores. Lanzado en 2014, Kubernetes se convirtió rápidamente en el estándar del sector para la orquestación de contenedores, con el apoyo de un vasto ecosistema de herramientas y proveedores de la nube. En la actualidad, la mantiene la Fundación para la Computación Nativa en la Nube (CNCF) y se adopta ampliamente en todos los sectores para gestionar aplicaciones nativas en la nube.

¿Qué es la arquitectura Kubernetes?

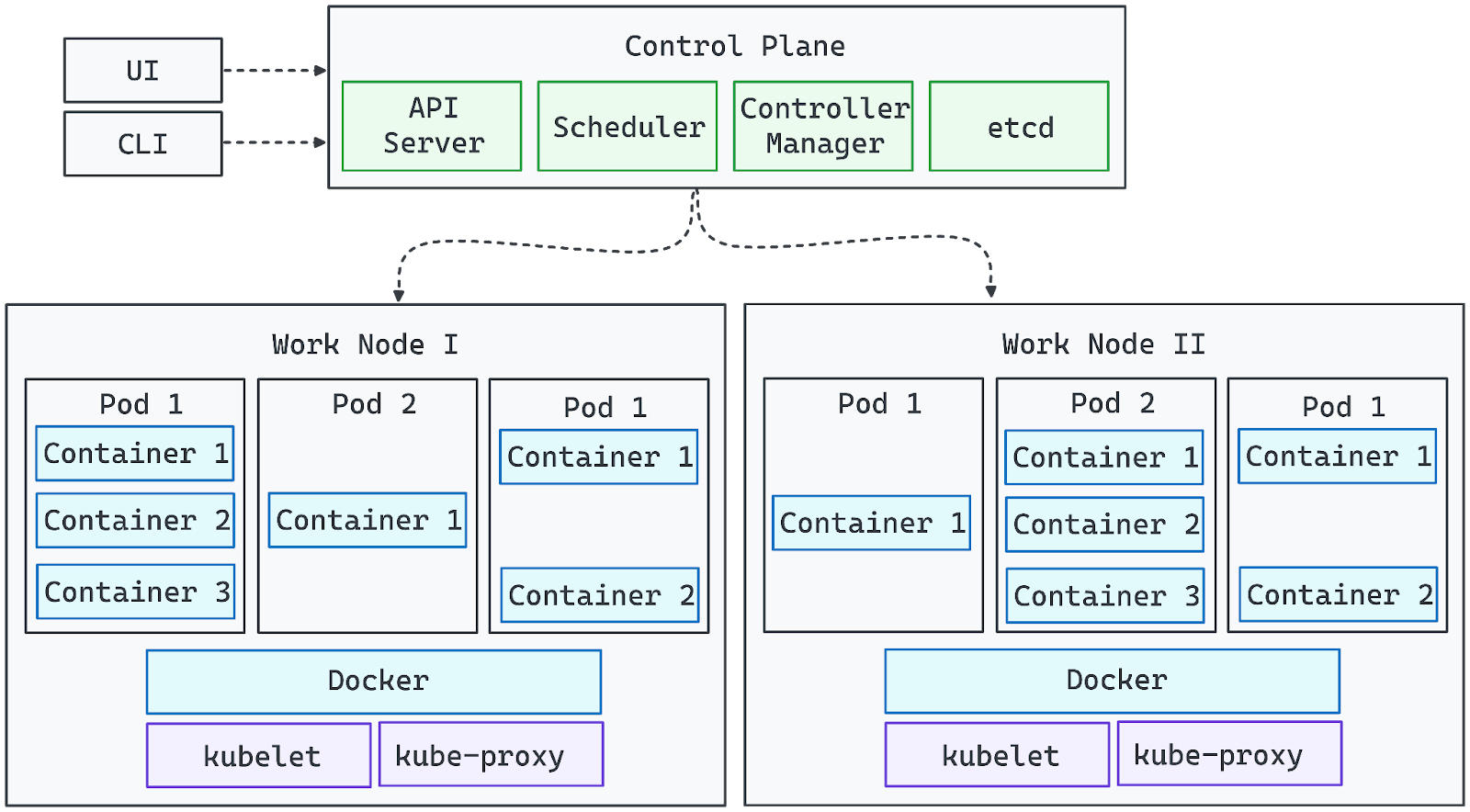

El siguiente diagrama representa visualmente la arquitectura de Kubernetes:

Imagen del autor. La arquitectura de Kubernetes.

- Los componentes del Plano de Control gestionan el clúster y garantizan que se mantenga el estado deseado.

- Los Nodos Trabajadores ejecutan cargas de trabajo, ejecutando contenedores dentro de Pods.

- El Servidor API actúa como puente entre las interacciones del usuario (a través de la UI o la CLI) y el clúster.

- Los complementos de red y almacenamiento amplían las capacidades de Kubernetes para entornos de producción.

Una vez sentadas estas bases, ahora podemos explorar las funciones detalladas de cada componente en la arquitectura de clústeres de Kubernetes.

Componentes básicos de la arquitectura de Kubernetes

Kubernetes consta de dos capas principales: el Plano de Control y los Componentes de Nodo. Exploremos cada uno de ellos:

Plano de control

El Plano de Control de Kubernetes es la capa de gestión central responsable de mantener el estado deseado del clúster, programar las cargas de trabajo y gestionar la automatización. Garantiza que las aplicaciones funcionen como se espera de ellas, supervisando continuamente las condiciones del clúster y realizando los ajustes necesarios.

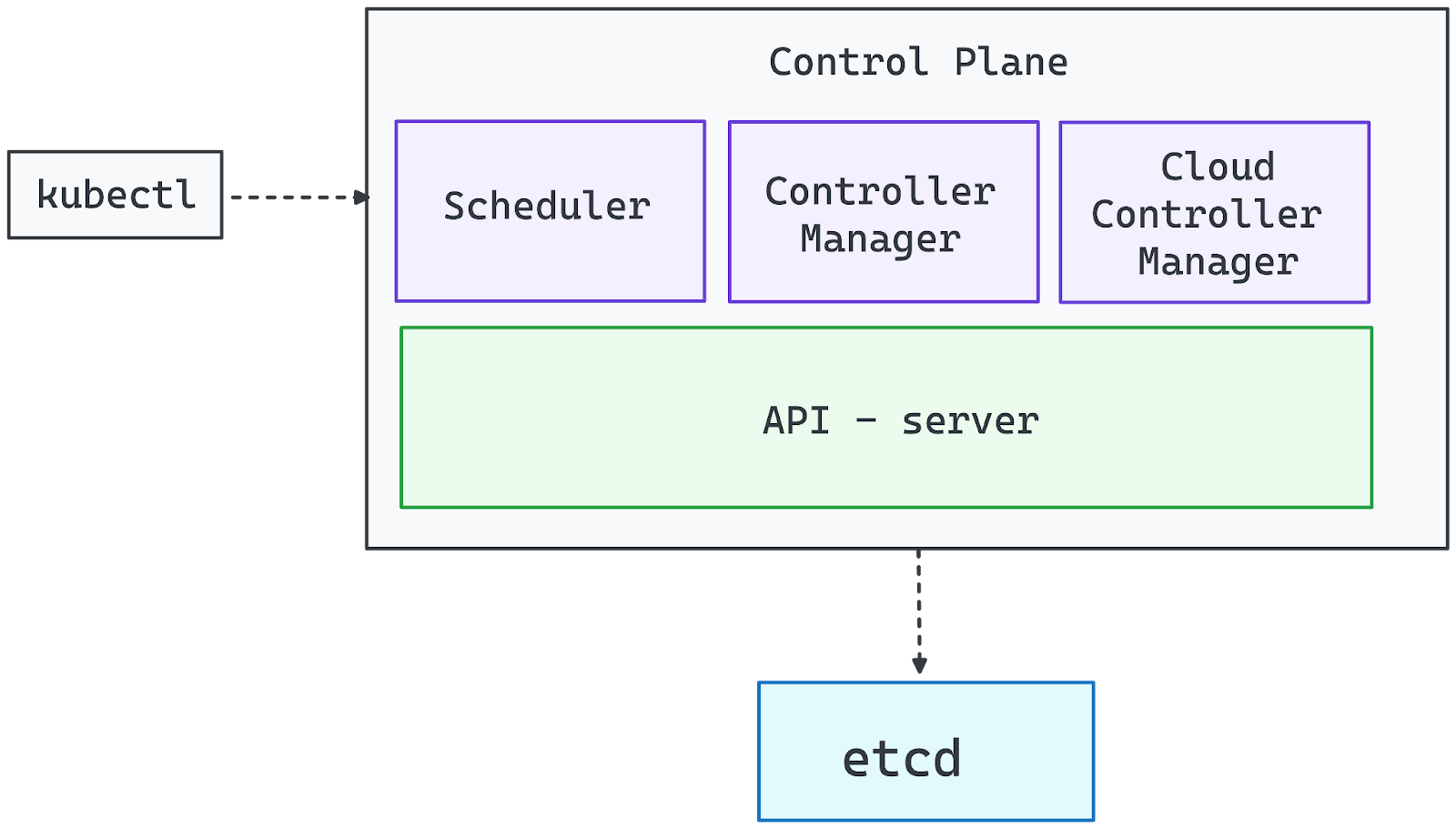

Imagen del autor. Componentes del Plano de Control.

Servidor API (kube-apiserver)

El Servidor API es la puerta de entrada al clúster Kubernetes. Procesa todas las solicitudes de gestión, ya procedan de la CLI (kubectl), de los paneles de la interfaz de usuario o de las herramientas de automatización. Sin un Servidor API en funcionamiento, el clúster sigue siendo funcional, pero los administradores pierden el control directo sobre las implantaciones y las configuraciones.

Gestor de controladores (kube-controller-manager)

Kubernetes funciona según el patrón del controlador, en el que los controladores supervisan el estado del sistema y toman medidas correctivas. El Director de Controladores supervisa a estos controladores, garantizando funciones esenciales como:

- Escala las cargas de trabajo en función de la demanda.

- Gestionar los nodos averiados y reprogramar las cargas de trabajo.

- Hacer cumplir los estados deseados (por ejemplo, garantizar que un Despliegue ejecute siempre el número especificado de réplicas).

Programador (kube-scheduler)

El Programador asigna Pods a nodos trabajadores, teniendo en cuenta factores como:

- Disponibilidad de recursos (CPU, memoria).

- Reglas de afinidad y antiafinidad de los nodos.

- Distribución de vainas para evitar sobrecargas.

Sigue un proceso de filtrado y puntuación para seleccionar el nodo óptimo para cada nuevo Pod, garantizando una utilización equilibrada de los recursos.

etcd (Almacén distribuido de claves y valores)

etcd sirve como única fuente de verdad de Kubernetes, almacenando todos los datos del clúster, incluyendo:

- Ajustes de configuración.

- Secretos y credenciales.

- Estados actuales e históricos de las cargas de trabajo.

Dado que comprometer el etcd otorga un control total sobre el clúster, hay que asegurarlo y dotarlo de los recursos de hardware adecuados para mantener el rendimiento y la fiabilidad.

Director de Controlador de Nube

Para los despliegues de Kubernetes basados en la nube, el Gestor del Controlador de la Nube integra el clúster con los servicios del proveedor de la nube, gestionándolos:

- Aprovisionamiento de equilibradores de carga.

- Asignar volúmenes de almacenamiento persistente.

- Escalar la infraestructura dinámicamente (por ejemplo, añadiendo máquinas virtuales como nodos)

Componentes de los nodos

Los Nodos Trabajadores son la columna vertebral computacional de un clúster Kubernetes, responsables de ejecutar las cargas de trabajo de las aplicaciones. Cada nodo funciona de forma independiente, al tiempo que mantiene una comunicación constante con el plano de control para garantizar una orquestación fluida.

Kubernetes programa dinámicamente los Pods en los nodos trabajadores en función de la disponibilidad de recursos y las demandas de carga de trabajo. Los nodos pueden ser máquinas físicas o virtuales, y un clúster listo para la producción suele constar de varios nodos para permitir el escalado horizontal y la alta disponibilidad. Cada nodo trabajador incluye los siguientes componentes esenciales:

Kubelet: El nodo agente

Kubelet es el agente principal a nivel de nodo que gestiona la ejecución de los contenedores. Ello:

- Se comunica continuamente con el Servidor API para recibir instrucciones.

- Garantiza que los Pods funcionan según lo definido en sus especificaciones.

- Extrae imágenes de contenedores e inicia los contenedores necesarios.

- Supervisa la salud de los contenedores y los reinicia si es necesario.

Sin Kubelet, el nodo se desconectaría del clúster, y las cargas de trabajo programadas no se gestionarían correctamente.

Kube-Proxy: Redes y equilibrio de carga

Kube-Proxy se encarga de gestionar la comunicación de red entre los servicios que se ejecutan en diferentes nodos. Ello:

- Configura las reglas de red para permitir una comunicación fluida entre Pods.

- Facilita el descubrimiento de servicios y el equilibrio de carga para la red inter-Pod.

- Garantiza que el tráfico se encamina correctamente entre los nodos y los clientes externos.

Si Kube-Proxy falla, los Pods del nodo afectado pueden quedar inalcanzables, interrumpiendo el tráfico de red dentro del clúster.

Tiempo de ejecución del contenedor: Contenedores en funcionamiento

El tiempo de ejecución del contenedor es el software que ejecuta las aplicaciones en contenedores dentro de los Pods. Kubernetes admite múltiples opciones de tiempo de ejecución, entre las que se incluyen:

- contenedord (el más utilizado)

- CRI-O (ligero y nativo de Kubernetes)

- Motor Docker (soporte heredado mediante dockershim)

El tiempo de ejecución interactúa con el sistema operativo para aislar las cargas de trabajo utilizando tecnologías como cgroups y namespaces, garantizando una utilización eficiente de los recursos.

Cómo interactúan los nodos trabajadores con el plano de control

- Los nodos se unen al clúster mediante un testigo emitido por el plano de control.

- Una vez registrado un nodo, el programador asigna las cargas de trabajo en función de sus recursos disponibles.

- El plano de control supervisa continuamente la salud de los nodos y puede reprogramar las cargas de trabajo si un nodo deja de estar sano o se sobrecarga.

Combinando Kubelet, Kube-Proxy y un tiempo de ejecución de contenedores, los nodos trabajadores forman una capa de ejecución escalable y resistente que potencia las aplicaciones Kubernetes.

Ampliar Kubernetes con complementos

Kubernetes está diseñado para ser altamente extensible, lo que te permite personalizar y mejorar su funcionalidad mediante complementos. Mientras que el plano de control y los nodos trabajadores forman la infraestructura central, los complementos proporcionan capacidades de red, almacenamiento, supervisión y automatización que hacen que Kubernetes sea más potente y esté listo para la producción.

Soluciones de red

La red Kubernetes sigue un enfoque basado en plugins, que requiere un plugin compatible con la Interfaz de Red de Contenedores (CNI) para permitir una comunicación fluida entre Pods. Algunas soluciones de red muy utilizadas son:

- Calico: Políticas de red seguras y encaminamiento de alto rendimiento.

- Cilium: Redes y seguridad basadas en eBPF.

- Franela: Redes superpuestas ligeras y fáciles de configurar.

La mayoría de las distribuciones gestionadas de Kubernetes vienen preconfiguradas con una solución de red, pero los clusters autogestionados requieren la instalación manual de un plugin CNI.

Soluciones de almacenamiento

Kubernetes proporciona un aprovisionamiento de almacenamiento dinámico a través de las Clases de Almacenamiento, permitiendo que las cargas de trabajo interactúen con varios backends de almacenamiento:

- Almacenamiento local: Utiliza el sistema de archivos de un nodo.

- Almacenamiento en bloque en la nube: Se integra con los proveedores de la nube (por ejemplo, AWS EBS, Azure Disk, GCP Persistent Disks).

- Almacenamiento distribuido: Soluciones como Ceph, Longhorn y Rook permiten un almacenamiento persistente y replicado entre nodos.

Como Kubernetes no incluye un registro de contenedores integrado, debes utilizar un registro externo (por ejemplo, Docker Hub, Harbor o Amazon ECR) para almacenar y distribuir imágenes de contenedores.

Seguimiento y observabilidad

La supervisión y el registro eficaces son esenciales para gestionar las cargas de trabajo de Kubernetes. Las soluciones más populares son:

- Prometeo: Recogida de métricas y alertas.

- Grafana: Cuadros de mando de visualización.

- Pila ELK (Elasticsearch, Logstash, Kibana): Agregación y análisis de registros.

Estas herramientas ayudan a controlar el estado del clúster, diagnosticar problemas y optimizar el rendimiento.

Controladores de entrada

Los controladores de entrada gestionan el acceso externo a las aplicaciones dentro del clúster, gestionando el tráfico HTTP/HTTPS y el equilibrio de carga. Las opciones más populares son:

- NGINX Ingress Controller - Muy utilizado para gestionar el tráfico web.

- Traefik - Enrutamiento dinámico con soporte integrado de Let's Encrypt.

- HAProxy Ingress - Equilibrio de carga de alto rendimiento.

Funcionalidad personalizada con CRDs

Kubernetes permite a los usuarios ampliar su API mediante definiciones de recursos personalizadas (CRD), lo que permite crear objetos personalizados y flujos de trabajo de automatización.

Los operadores y controladores pueden automatizar tareas complejas, como:

- Aprovisionar bases de datos cuando se añade un objeto PostgresDatabaseConnection personalizado.

- Gestionar dinámicamente las políticas de seguridad.

- Escalar aplicaciones en función de métricas personalizadas.

Aprovechando los CRD, Kubernetes puede transformarse en una plataforma totalmente personalizable, adaptándose a las necesidades empresariales específicas.

Arquitectura de clústeres Kubernetes

Kubernetes introduce varias capas de abstracción para ayudar a definir y gestionar eficazmente las aplicaciones. Estas abstracciones simplifican la implantación, el escalado y la gestión en entornos distribuidos.

Nodos maestro y trabajador

Un clúster Kubernetes consta de dos tipos principales de nodos:

- Nodos maestros (Plano de control): Responsable de orquestar y gestionar el clúster. Estos nodos ejecutan el Servidor API, el Programador, el Gestor de Controladores y etcd para garantizar que las cargas de trabajo se despliegan y mantienen como se espera.

- Nodos trabajadores (Plano de datos): Ejecuta cargas de trabajo de aplicaciones ejecutando pods, que contienen contenedores. Cada nodo trabajador está gestionado por el Kubelet, interactúa con el Kube-Proxy para la conexión en red y ejecuta un tiempo de ejecución de contenedor como Docker o containerd.

Juntos, los nodos maestro y trabajador forman una infraestructura escalable y autorregenerable donde las aplicaciones pueden ejecutarse sin problemas. Si quieres comprender mejor la contenedorización y la virtualización, sigue esta pista dirigida por expertos Containerización y Virtualización.

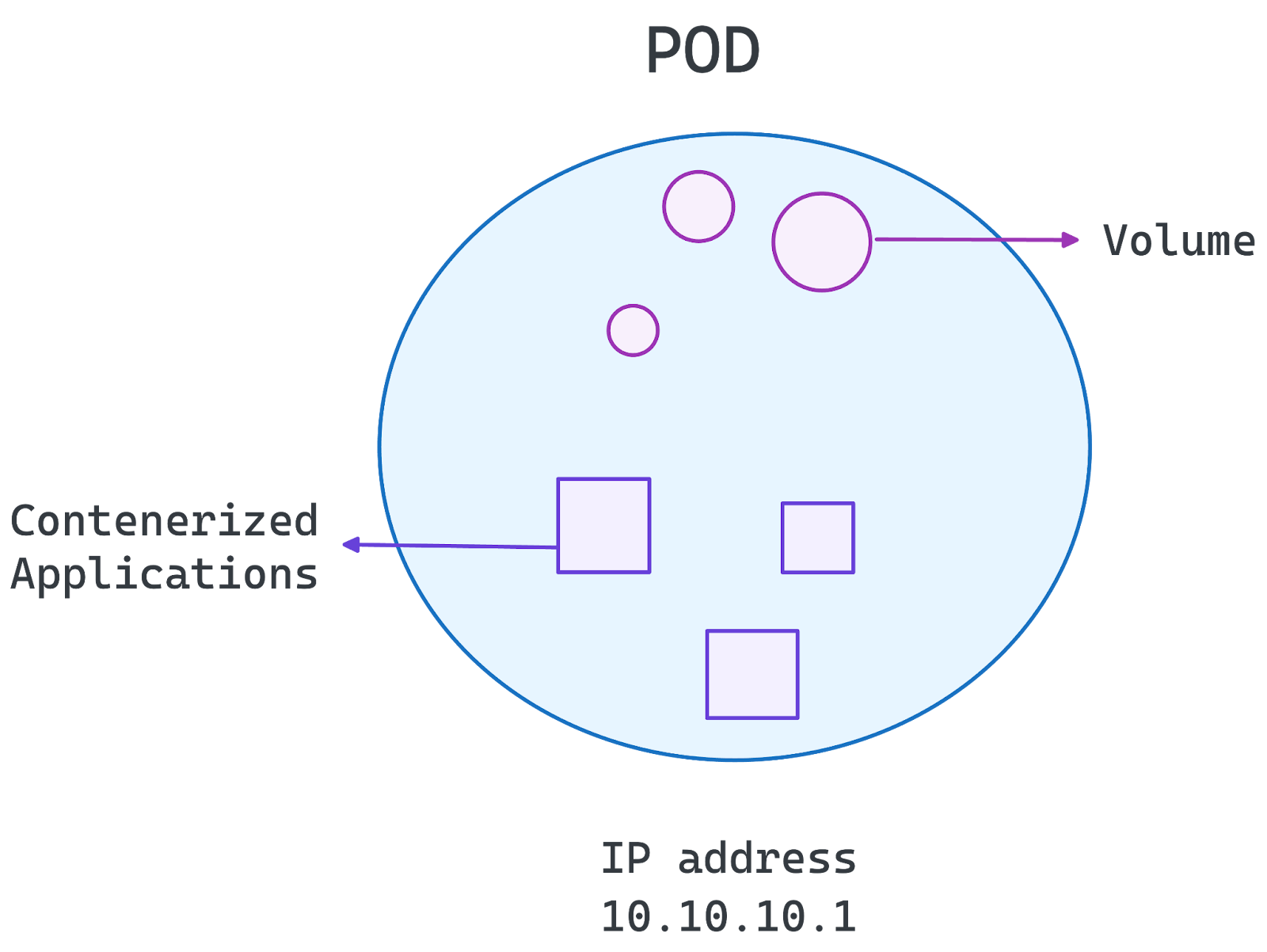

Arquitectura de vainas

En el núcleo de Kubernetes está el Pod, que es la unidad desplegable más pequeña del sistema. Un Pod encapsula uno o más contenedores que comparten almacenamiento, red y ajustes de configuración.

- Envases individuales: La configuración más común, en la que cada Pod contiene un contenedor que ejecuta un microservicio.

- Vainas multicontenedor: Se utiliza cuando los contenedores estrechamente acoplados necesitan compartir recursos y comunicarse eficazmente.

Los pods son efímeros, lo que significa que pueden reprogramarse o reiniciarse cuando sea necesario. Kubernetes gestiona los Pods mediante Deployments, StatefulSets y DaemonSets, garantizando la escalabilidad y la disponibilidad.

Imagen del autor. La Arquitectura de Pod.

Espacio de nombres y segmentación

Los espacios de nombres permiten la segmentación lógica dentro de un clúster Kubernetes. Ayudan:

- Aísla las cargas de trabajo para distintos equipos, proyectos o entornos (p. ej, desarrollo, puesta en escena, producción).

- Aplica el control de acceso basado en roles (RBAC) para restringir los permisos.

- Gestiona las cuotas de recursos para evitar un consumo excesivo de los mismos.

Al organizar las cargas de trabajo en espacios de nombres, Kubernetes permite mejorar la seguridad, la gestión de recursos y la escalabilidad dentro de un único clúster.

Una vez sentadas estas bases, en la siguiente sección podemos explorar cómo la arquitectura de Kubernetes soporta el despliegue de microservicios.

Kubernetes Microservices Architecture

Kubernetes es ideal para microservicios, ya que ofrece escalabilidad, resistencia y automatización para aplicaciones distribuidas. Permite:

- Escalado automatizado: Ajusta los recursos en función de la demanda.

- Autocuración: Detecta y sustituye los contenedores averiados.

- Descubrimiento de servicios y equilibrio de carga: Comunicación eficiente entre microservicios.

- Portabilidad: Funciona en la nube y en entornos locales.

- Configuración declarativa: Utiliza YAML para despliegues predecibles.

Una preocupación común de los profesionales es si utilizar Kubernetes o Docker Compose para tus microservicios. Si ese es tu caso, te recomiendo la siguiente guía Docker Compose vs Kubernetes para entenderlo mejor.

Buenas prácticas

A continuación, hemos destacado algunas de las mejores prácticas que debes seguir:

- Espacios de nombres para el aislamiento de la carga de trabajo: Organiza y aísla las cargas de trabajo para mejorar la seguridad y la gestión de recursos.

- Servicios Kubernetes & Ingress para la gestión del tráfico: Permite una comunicación eficaz entre los microservicios y los clientes externos.

- Autoescalado y actualizaciones continuas para un rendimiento sin fisuras: Utiliza el Autoescalador Pod Horizontal y despliegues continuos para mantener la disponibilidad.

- ConfigMaps y Secretos para configuraciones seguras: Gestiona de forma segura los datos sensibles y las configuraciones del entorno.

- Monitorización y registro con Prometheus y Grafana: Obtén información y soluciona los problemas eficazmente con sólidas herramientas de observabilidad.

Siguiendo estas prácticas, Kubernetes agiliza el despliegue de microservicios, garantizando flexibilidad y alta disponibilidad.

Casos de uso de la arquitectura Kubernetes

Kubernetes es ampliamente adoptado en todos los sectores por su capacidad para escalar aplicaciones, garantizar una alta disponibilidad y soportar entornos multi-nube. Su arquitectura permite una gestión fluida de las cargas de trabajo, lo que la convierte en la opción preferida para las aplicaciones modernas nativas de la nube.

Escalabilidad de la aplicación

Kubernetes permite el escalado horizontal, lo que permite a las aplicaciones manejar cargas de trabajo variables de forma eficiente:

- El Autoescalador Horizontal de Pods (HPA) ajusta el número de Pods en función de la CPU, la memoria o métricas personalizadas.

- El Cluster Autoscaler añade o elimina dinámicamente nodos trabajadores para adaptarse a la demanda.

- El equilibrio de carga garantiza que el tráfico se distribuya uniformemente entre las réplicas.

Esto hace que Kubernetes sea ideal para aplicaciones con tráfico fluctuante, como plataformas de comercio electrónico, servicios de streaming y aplicaciones SaaS.

Alta disponibilidad y tolerancia a fallos

Kubernetes garantiza un funcionamiento continuo mediante:

- Replicar las cargas de trabajo en varios nodos para evitar interrupciones del servicio.

- Mecanismos de autorreparación que reinician automáticamente los contenedores averiados.

- Elección del líder en el plano de control para mantener la estabilidad en caso de fallos.

Estas características hacen que Kubernetes sea adecuado para aplicaciones de misión crítica que requieren un tiempo de inactividad casi nulo.

Despliegues híbridos y multi-nube

Kubernetes abstrae la complejidad de la infraestructura, facilitando el despliegue de cargas de trabajo en entornos locales, híbridos y multi-nube:

- Gestión coherente de aplicaciones en AWS, Google Cloud, Azure y clústeres locales.

- Enrutamiento del tráfico entre los proveedores de la nube para una latencia y una rentabilidad óptimas.

- Estrategias de recuperación ante desastres con configuraciones de conmutación por error entre nubes.

Conclusión

Kubernetes ha revolucionado la orquestación de contenedores, convirtiéndose en el estándar del sector para desplegar, gestionar y escalar aplicaciones en entornos de nube modernos. Su arquitectura permite el escalado automatizado, la alta disponibilidad y la compatibilidad entre nubes, lo que la convierte en una poderosa herramienta para las organizaciones que adoptan microservicios y estrategias nativas en la nube.

Al comprender la arquitectura de Kubernetes, los desarrolladores y los equipos de TI pueden:

- Optimiza el rendimiento de las aplicaciones mediante una programación y un escalado eficaces.

- Mejora la resistencia del sistema con autorreparación y alta disponibilidad.

- Garantiza despliegues híbridos y multicloud sin fisuras, evitando la dependencia de un proveedor.

Desde la gestión del plano de control hasta la ejecución de nodos trabajadores y complementos personalizables, Kubernetes proporciona la flexibilidad necesaria para ejecutar aplicacionesde misión crítica a escala. A medida que evoluciona el ecosistema de la nube, Kubernetes se mantiene a la vanguardia, permitiendo a las empresas innovar con confianza.

Kubernetes es una potente herramienta para gestionar aplicaciones modernas, pero dominarla requiere experiencia práctica. Continúa tu aprendizaje con:

- Curso de Introducción a Kubernetes para aprender los fundamentos de Kubernetes y desplegar y orquestar contenedores utilizando Manifiestos e instrucciones kubectl.

- Docker Compose vs Kubernetes para elegir la herramienta adecuada a tus necesidades.

- Containerización para el Aprendizaje Automático para aplicar Kubernetes a los flujos de trabajo de IA/ML.

Josep es Científico de Datos y Gestor de Proyectos en la Agencia Catalana de Turismo, utilizando datos para mejorar la experiencia de los turistas en Cataluña. Su experiencia incluye la gestión del almacenamiento y procesamiento de datos, junto con la analítica avanzada y la comunicación eficaz de las perspectivas de los datos.

También es un dedicado educador, que imparte clases en el Máster de Big Data de la Universidad de Navarra, y contribuye regularmente con artículos perspicaces sobre ciencia de datos en Medium y KDNuggets.

Es Licenciado en Ingeniería Física por la Universidad Politécnica de Cataluña y Máster en Sistemas Interactivos Inteligentes por la Universidad Pompeu Fabra.

En la actualidad, se dedica con pasión a hacer que las tecnologías relacionadas con los datos sean más accesibles a un público más amplio a través de la publicación de Medium ForCode'Sake.