Lernpfad

Kubernetes ist zur Standardtechnologie für die Verwaltung von containerisierten Anwendungen in modernen Cloud-Umgebungen geworden. Da Unternehmen immer mehr zu Microservices und Cloud-nativen Architekturen übergehen, bietet Kubernetes alles, was sie brauchen, um die Bereitstellung zu automatisieren, Anwendungen zu skalieren und hohe Verfügbarkeit zu gewährleisten.

Kubernetes ist ein Open-Source-Container-Orchestrator, der den komplexen Prozess der Verwaltung von Containern im großen Maßstab vereinfacht. Es abstrahiert die Belange der Infrastruktur und ermöglicht es Entwicklern, sich auf die Entwicklung von Anwendungen zu konzentrieren, anstatt sich um die zugrunde liegenden Server zu kümmern.

Ein Verständnis der Kubernetes-Architektur ist für jeden unerlässlich, der skalierbare, robuste und produktionsreife Anwendungen bereitstellen und verwalten will.

Heute möchte ich einen tieferen Einblick in die Kubernetes-Architektur mit Lernenden der Mittelstufe teilen, die bereits mit den grundlegenden Kubernetes-Konzepten vertraut sind.

Was ist Kubernetes?

Kubernetes ist ein leistungsfähiges verteiltes System, das für die Orchestrierung und Verwaltung von Containeranwendungen im großen Maßstab entwickelt wurde. Sie ermöglicht es Unternehmen, Workloads auf mehreren physischen oder virtuellen Maschinen, den sogenannten Nodes, zu verteilen und so sicherzustellen, dass Anwendungen verfügbar, skalierbar und ausfallsicher bleiben.

Eine der Hauptstärken von Kubernetes ist die Fähigkeit, dynamische Workloads effizient zu handhaben. Durch die automatische Verteilung von Containern auf die einzelnen Knoten stellt Kubernetes sicher, dass Anwendungen horizontal skaliert werden können und die Arbeitslasten auf der Grundlage der verfügbaren Ressourcen ausgeglichen werden. Wenn ein Knoten überlastet wird, verteilt Kubernetes die Arbeitslasten auf gesunde Nachbarknoten, um Ausfallzeiten zu minimieren und die Leistung zu erhalten.

Wenn du noch ein Anfänger in dieser Technologie bist, schau dir diesen Kurs Einführung in Kubernetes um loszulegen.

Eine kurze Geschichte von Kubernetes

Google entwickelte Kubernetes ursprünglich als Open-Source-Nachfolger von Borg, seinem internen Container-Management-System. Kubernetes wurde 2014 veröffentlicht und entwickelte sich schnell zum Industriestandard für die Container-Orchestrierung, der von einem großen Ökosystem von Tools und Cloud-Anbietern unterstützt wird. Heute wird es von der Cloud Native Computing Foundation (CNCF) gepflegt und ist in vielen Branchen für die Verwaltung von Cloud-nativen Anwendungen verbreitet.

Was ist die Kubernetes-Architektur?

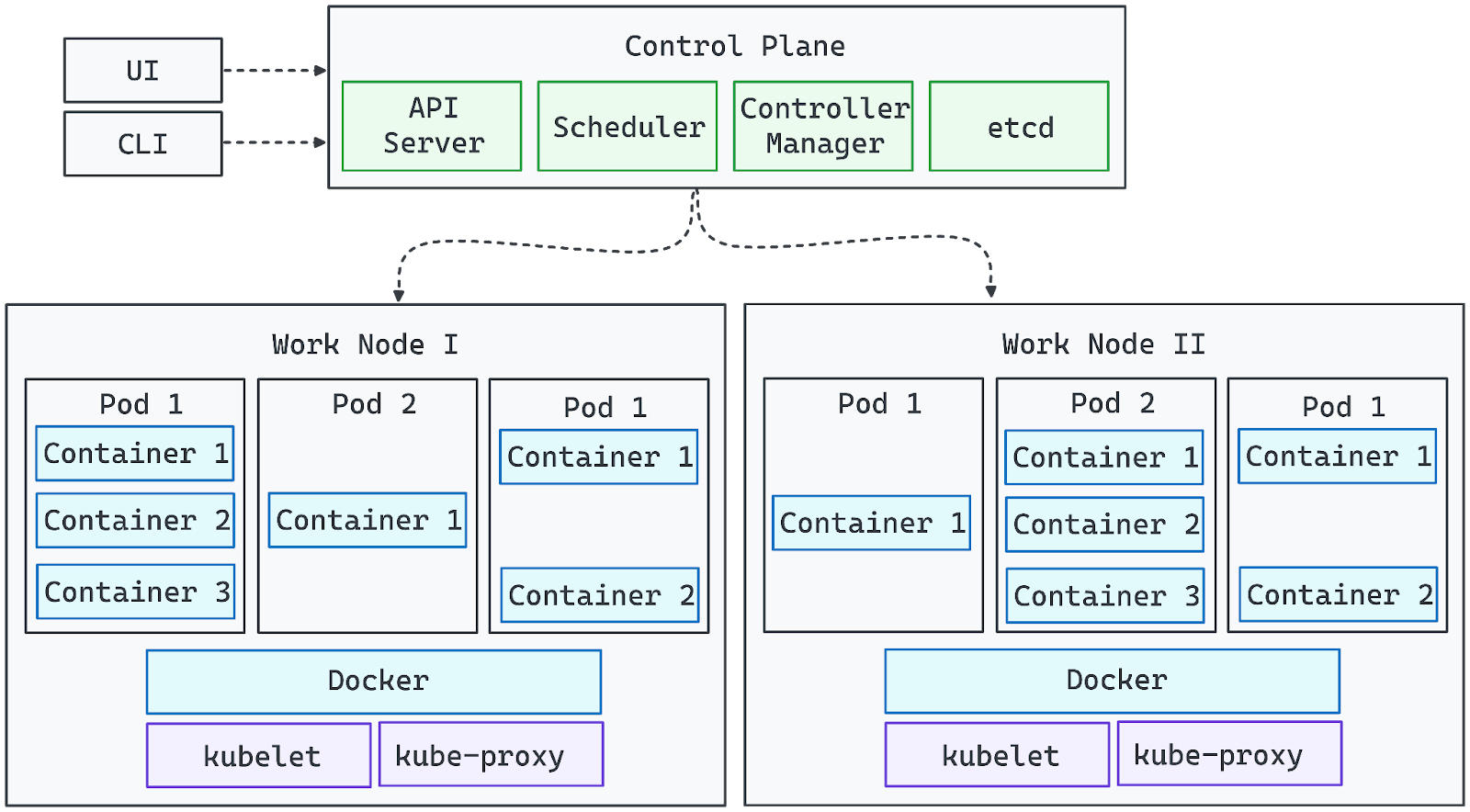

Das folgende Diagramm stellt die Architektur von Kubernetes visuell dar:

Bild vom Autor. Die Kubernetes-Architektur.

- Die Komponenten der Control Plane verwalten den Cluster und stellen sicher, dass der gewünschte Zustand aufrechterhalten wird.

- Die Worker Nodes führen Workloads aus, indem sie Container in Pods ausführen.

- Der API-Server fungiert als Brücke zwischen den Benutzerinteraktionen (über die Benutzeroberfläche oder CLI) und dem Cluster.

- Netzwerk- und Speicher-Add-ons erweitern die Möglichkeiten von Kubernetes für Produktionsumgebungen.

Mit dieser Grundlage können wir nun die detaillierten Rollen der einzelnen Komponenten in der Cluster-Architektur von Kubernetes untersuchen.

Kernkomponenten der Kubernetes-Architektur

Kubernetes besteht aus zwei Hauptschichten: der Control Plane und den Node Components. Gehen wir sie der Reihe nach durch:

Kontrollebene

Die Kubernetes Control Plane ist die zentrale Verwaltungsebene, die für die Aufrechterhaltung des gewünschten Zustands des Clusters, die Planung von Arbeitslasten und die Automatisierung zuständig ist. Sie stellt sicher, dass die Anwendungen wie erwartet laufen, indem sie die Clusterbedingungen kontinuierlich überwacht und notwendige Anpassungen vornimmt.

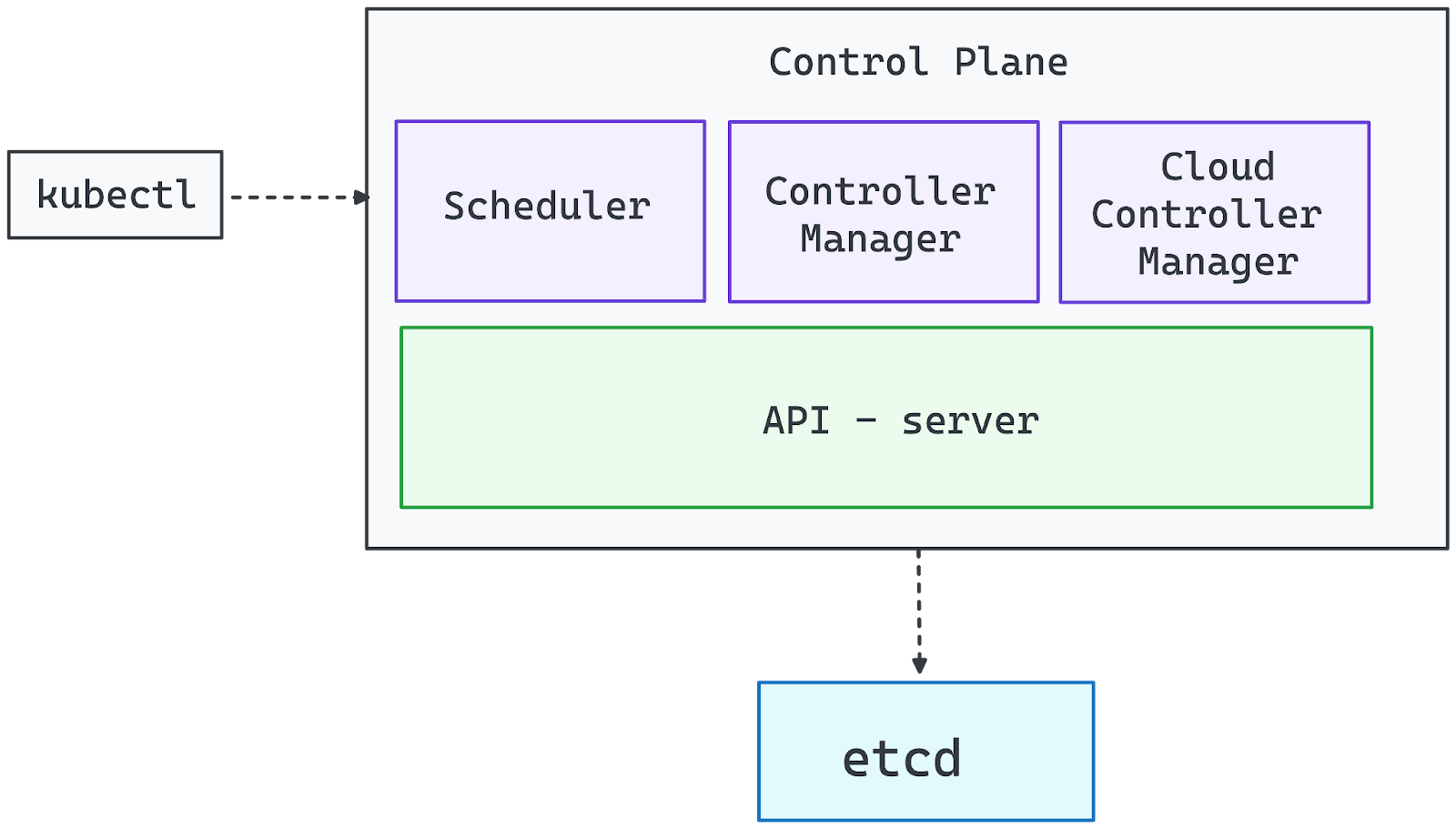

Bild vom Autor. Komponenten der Steuerungsebene.

API-Server (kube-apiserver)

Der API-Server ist das Tor zum Kubernetes-Cluster. Sie verarbeitet alle Verwaltungsanfragen, egal ob sie von der CLI (kubectl), den UI-Dashboards oder den Automatisierungstools kommen. Ohne einen laufenden API Server bleibt der Cluster funktionsfähig, aber die Administratoren verlieren die direkte Kontrolle über den Einsatz und die Konfigurationen.

Controller Manager (kube-controller-manager)

Kubernetes arbeitet nach dem Controller-Muster, bei dem die Controller den Zustand des Systems überwachen und korrigierende Maßnahmen ergreifen. Der Controller Manager beaufsichtigt diese Controller und stellt sicher, dass wichtige Funktionen wie z.B.:

- Skalierung der Arbeitslasten je nach Bedarf.

- Verwaltung ausgefallener Knotenpunkte und Neuplanung von Workloads.

- Erzwingen gewünschter Zustände (z. B. sicherstellen, dass ein Einsatz immer die angegebene Anzahl von Replikaten ausführt).

Planer (kube-scheduler)

Der Scheduler weist den Arbeiterknoten Pods zu und berücksichtigt dabei Faktoren wie:

- Verfügbarkeit von Ressourcen (CPU, Speicher).

- Regeln für die Affinität und Anti-Affinität von Knotenpunkten.

- Pod-Verteilung, um Überlastung zu vermeiden.

Es folgt einem Filter- und Scoring-Prozess, um den optimalen Knoten für jeden neuen Pod auszuwählen und eine ausgewogene Ressourcennutzung zu gewährleisten.

etcd (Verteilter Key-Value-Speicher)

etcd dient als einzige Quelle der Wahrheit für Kubernetes und speichert alle Clusterdaten, einschließlich:

- Konfigurationseinstellungen.

- Geheimnisse und Berechtigungsnachweise.

- Aktueller und historischer Stand des Arbeitsaufkommens.

Da die Kompromittierung von etcd die volle Kontrolle über den Cluster gewährt, muss er abgesichert und mit ausreichenden Hardwareressourcen ausgestattet werden, um Leistung und Zuverlässigkeit zu gewährleisten.

Cloud Controller Manager

Bei Cloud-basierten Kubernetes-Implementierungen integriert der Cloud Controller Manager den Cluster mit den Diensten des Cloud-Anbieters und verwaltet sie:

- Bereitstellen von Lastverteilern.

- Zuweisung von persistenten Speichervolumes.

- Dynamische Skalierung der Infrastruktur (z. B. Hinzufügen von virtuellen Maschinen als Knotenpunkte)

Knoten-Komponenten

Worker Nodes sind das rechnerische Rückgrat eines Kubernetes-Clusters und für die Ausführung von Anwendungs-Workloads verantwortlich. Jeder Knoten arbeitet unabhängig und kommuniziert ständig mit der Steuerungsebene, um eine reibungslose Orchestrierung zu gewährleisten.

Kubernetes plant Pods dynamisch auf Worker Nodes ein, je nach Ressourcenverfügbarkeit und Arbeitslast. Bei den Knoten kann es sich um physische oder virtuelle Maschinen handeln, und ein produktionsfähiger Cluster besteht in der Regel aus mehreren Knoten, um eine horizontale Skalierung und hohe Verfügbarkeit zu ermöglichen. Jeder Arbeitsknoten enthält die folgenden wesentlichen Komponenten:

Kubelet: Der Knotenpunkt-Agent

Kubelet ist der wichtigste Agent auf Knotenebene, der die Ausführung von Containern verwaltet. Es:

- Kommuniziert ständig mit dem API-Server, um Anweisungen zu erhalten.

- Stellt sicher, dass die Pods so laufen, wie in ihren Spezifikationen festgelegt.

- Zieht Container-Images und startet die benötigten Container.

- Überwacht den Zustand der Container und startet sie bei Bedarf neu.

Ohne Kubelet würde der Knoten vom Cluster getrennt und die geplanten Arbeitslasten könnten nicht ordnungsgemäß verwaltet werden.

Kube-Proxy: Vernetzung und Lastausgleich

Kube-Proxy ist für die Verwaltung der Netzwerkkommunikation zwischen Diensten, die auf verschiedenen Knotenpunkten laufen, zuständig. Es:

- Konfiguriert die Netzwerkregeln, um eine nahtlose Kommunikation zwischen Pods zu ermöglichen.

- Erleichtert die Erkennung von Diensten und den Lastausgleich für die Vernetzung zwischen den Pads.

- Stellt sicher, dass der Datenverkehr zwischen den Knotenpunkten und externen Clients korrekt weitergeleitet wird.

Wenn Kube-Proxy ausfällt, können die Pods auf dem betroffenen Knoten unerreichbar werden und den Netzwerkverkehr innerhalb des Clusters stören.

Container-Laufzeit: Laufende Container

Die Container-Laufzeit ist die Software, die containerisierte Anwendungen innerhalb von Pods ausführt. Kubernetes unterstützt mehrere Laufzeitoptionen, darunter:

- containerd (am häufigsten verwendet)

- CRI-O (leichtgewichtig und Kubernetes-nativ)

- Docker Engine (Legacy-Unterstützung über dockershim)

Die Laufzeitumgebung interagiert mit dem Betriebssystem, um Arbeitslasten mithilfe von Technologien wie cgroups und Namespaces zu isolieren und eine effiziente Ressourcennutzung sicherzustellen.

Wie Worker Nodes mit der Control Plane interagieren

- Die Knoten treten dem Cluster mit einem Token bei, das von der Steuerungsebene ausgegeben wird.

- Sobald ein Knoten registriert ist, weist der Scheduler Arbeitslasten auf der Grundlage seiner verfügbaren Ressourcen zu.

- Die Steuerebene überwacht kontinuierlich den Zustand des Knotens und kann die Arbeitslast umplanen, wenn ein Knoten ungesund oder überlastet wird.

Durch die Kombination von Kubelet, Kube-Proxy und einer Container-Laufzeitumgebung bilden die Worker Nodes eine skalierbare und robuste Ausführungsschicht, die Kubernetes-Anwendungen betreibt.

Erweiterung von Kubernetes mit Add-ons

Kubernetes ist so konzipiert, dass es in hohem Maße erweiterbar ist und du seine Funktionen durch Add-ons anpassen und erweitern kannst. Während die Control Plane und die Worker Nodes die Kerninfrastruktur bilden, bieten Add-ons Netzwerk-, Speicher-, Überwachungs- und Automatisierungsfunktionen, die Kubernetes leistungsfähiger und produktionsreif machen.

Vernetzungslösungen

Die Vernetzung von Kubernetes folgt einem Plugin-basierten Ansatz. Um eine nahtlose Kommunikation zwischen Pods zu ermöglichen, ist ein Container Network Interface (CNI)-kompatibles Plugin erforderlich. Einige weit verbreitete Netzwerklösungen sind:

- Calico: Sichere Netzwerkrichtlinien und leistungsstarkes Routing.

- Cilium: eBPF-basierte Vernetzung und Sicherheit.

- Flannel: Leichtes und einfach zu konfigurierendes Overlay-Netzwerk.

Die meisten verwalteten Kubernetes-Distributionen sind mit einer Netzwerklösung vorkonfiguriert, aber selbstverwaltete Cluster erfordern die manuelle Installation eines CNI-Plugins.

Speicherlösungen

Kubernetes bietet dynamische Speicherbereitstellung durch Speicherklassen, die es Workloads ermöglichen, mit verschiedenen Speicher-Backends zu interagieren:

- Lokale Lagerung: Benutzt das Dateisystem eines Knotens.

- Cloud-Blockspeicher: Integriert mit Cloud-Anbietern (z. B. AWS EBS, Azure Disk, GCP Persistent Disks).

- Verteilte Speicherung: Lösungen wie Ceph, Longhorn und Rook ermöglichen persistenten, replizierten Speicher über Knoten hinweg.

Da Kubernetes keine integrierte Container-Registry enthält, musst du eine externe Registry (z.B. Docker Hub, Harbor oder Amazon ECR) verwenden, um Container-Images zu speichern und zu verteilen.

Überwachung und Beobachtbarkeit

Effektive Überwachung und Protokollierung sind für die Verwaltung von Kubernetes-Workloads unerlässlich. Beliebte Lösungen sind:

- Prometheus: Metriksammlung und Alarmierung.

- Grafana: Visualisierung von Dashboards.

- ELK Stack (Elasticsearch, Logstash, Kibana): Log-Aggregation und -Analyse.

Diese Tools helfen dabei, den Zustand des Clusters zu überwachen, Probleme zu diagnostizieren und die Leistung zu optimieren.

Ingress-Kontrolleure

Ingress-Controller verwalten den externen Zugang zu den Anwendungen innerhalb des Clusters, indem sie den HTTP/HTTPS-Verkehr und den Lastausgleich verwalten. Beliebte Optionen sind:

- NGINX Ingress Controller - Wird häufig für die Verwaltung des Webverkehrs verwendet.

- Traefik - Dynamisches Routing mit eingebauter Let's Encrypt Unterstützung.

- HAProxy Ingress - Leistungsstarker Lastausgleich.

Benutzerdefinierte Funktionen mit CRDs

Kubernetes ermöglicht es den Nutzern, seine API durch Custom Resource Definitions (CRDs) zu erweitern und so benutzerdefinierte Objekte und Automatisierungsworkflows zu erstellen.

Bediener und Controller können komplexe Aufgaben automatisieren, wie zum Beispiel:

- Bereitstellung von Datenbanken, wenn ein benutzerdefiniertes PostgresDatabaseConnection-Objekt hinzugefügt wird.

- Sicherheitsrichtlinien dynamisch verwalten.

- Skalierung von Anwendungen auf der Grundlage benutzerdefinierter Metriken.

Durch den Einsatz von CRDs kann Kubernetes in eine vollständig anpassbare Plattform umgewandelt werden, die sich an spezifische Geschäftsanforderungen anpasst.

Kubernetes Cluster Architektur

Kubernetes führt mehrere Abstraktionsschichten ein , um Anwendungen effizient zu definieren und zu verwalten. Diese Abstraktionen vereinfachen die Bereitstellung, Skalierung und Verwaltung in verteilten Umgebungen.

Master- und Worker-Knoten

Ein Kubernetes-Cluster besteht aus zwei Haupttypen von Knotenpunkten:

- Master-Knoten (Control Plane): Verantwortlich für die Orchestrierung und Verwaltung des Clusters. Auf diesen Knoten laufen der API Server, der Scheduler, der Controller Manager und etcd, um sicherzustellen, dass die Workloads wie erwartet bereitgestellt und gewartet werden.

- Worker Nodes (Data Plane): Führe Anwendungs-Workloads aus, indem du Pods ausführst, die Container enthalten. Jeder Arbeitsknoten wird vom Kubelet verwaltet, interagiert mit dem Kube-Proxy für die Vernetzung und führt eine Container-Laufzeitumgebung wie Docker oder containerd aus.

Zusammen bilden die Master- und Worker-Knoten eine selbstheilende, skalierbare Infrastruktur, in der Anwendungen nahtlos laufen können. Wenn du Containerisierung und Virtualisierung besser verstehen willst, dann folge diesem von Experten geleiteten Lernpfad zur Containerisierung und Virtualisierung.

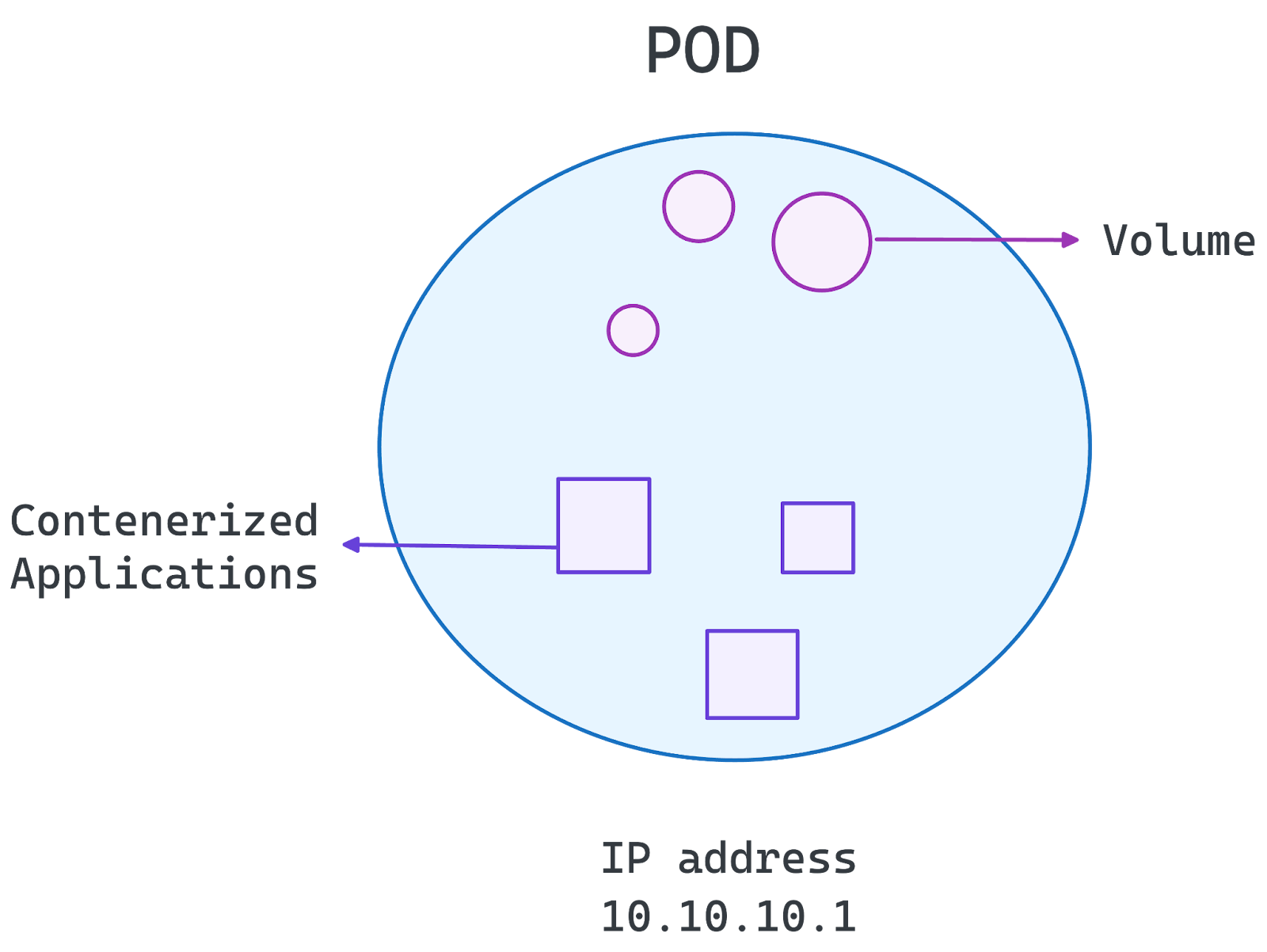

Pod Architektur

Das Herzstück von Kubernetes ist der Pod, die kleinste einsetzbare Einheit im System. Ein Pod kapselt einen oder mehrere Container, die Speicher-, Netzwerk- und Konfigurationseinstellungen gemeinsam nutzen.

- Einzelcontainer-Pods: Das häufigste Setup, bei dem jeder Pod einen Container enthält, in dem ein Microservice läuft.

- Multicontainer-Pods: Wird verwendet, wenn eng gekoppelte Container Ressourcen teilen und effizient kommunizieren müssen.

Pods sind kurzlebig, d.h. sie können bei Bedarf neu geplant oder neu gestartet werden. Kubernetes verwaltet Pods über Deployments, StatefulSets und DaemonSets und sorgt für Skalierbarkeit und Verfügbarkeit.

Bild vom Autor. Pod's Architecture.

Namespace und Segmentierung

Namespaces ermöglichen eine logische Segmentierung innerhalb eines Kubernetes-Clusters. Sie helfen:

- Isoliere Workloads für verschiedene Teams, Projekte oder Umgebungen (z.B., dev, Staging, Produktion).

- Wende rollenbasierte Zugriffskontrolle (RBAC) an, um Berechtigungen einzuschränken.

- Verwalte Ressourcenquoten, um einen übermäßigen Ressourcenverbrauch zu verhindern.

Durch die Organisation von Workloads in Namespaces ermöglicht Kubernetes eine bessere Sicherheit, Ressourcenverwaltung und Skalierbarkeit innerhalb eines einzelnen Clusters.

Mit dieser Grundlage können wir nun im nächsten Abschnitt untersuchen, wie die Kubernetes-Architektur Microservices-Bereitstellungen unterstützt.

Kubernetes Microservices Architektur

Kubernetes ist ideal für Microservices und bietet Skalierbarkeit, Ausfallsicherheit und Automatisierung für verteilte Anwendungen. Es ermöglicht:

- Automatisierte Skalierung: Passt die Ressourcen je nach Bedarf an.

- Selbstheilung: Erkennt ausgefallene Container und ersetzt sie.

- Diensterkennung und Lastausgleich: Effiziente Kommunikation zwischen Microservices.

- Tragbarkeit: Läuft in Cloud- und On-Premises-Umgebungen.

- Deklarative Konfiguration: Verwendet YAML für vorhersehbare Einsätze.

Eine häufige Sorge von Fachleuten ist, ob sie Kubernetes oder Docker Compose für ihre Microservices verwenden sollen. Wenn das dein Fall ist, empfehle ich dir den folgenden Leitfaden Docker Compose vs. Kubernetes um es besser zu verstehen.

Bewährte Praktiken

Im Folgenden haben wir einige der besten Praktiken zusammengestellt, die du einhalten solltest:

- Namensräume für die Workload-Isolation: Organisiere und isoliere Arbeitslasten für bessere Sicherheit und Ressourcenmanagement.

- Kubernetes Services & Ingress für Traffic Management: Ermögliche eine effiziente Kommunikation zwischen Microservices und externen Clients.

- Autoscaling & Rolling Updates für nahtlose Leistung: Verwende horizontale Pod-Autoscaler und rollierende Bereitstellungen, um die Verfügbarkeit zu erhalten.

- ConfigMaps & Secrets für sichere Konfigurationen: Verwalte sensible Daten und Umgebungskonfigurationen auf sichere Weise.

- Monitoring & Logging mit Prometheus und Grafana: Gewinnen Sie Einblicke und beheben Sie Probleme effektiv mit robusten Beobachtungstools.

Wenn du diese Praktiken befolgst, vereinfacht Kubernetes die Bereitstellung von Microservices und gewährleistet Flexibilität und hohe Verfügbarkeit.

Anwendungsfälle der Kubernetes-Architektur

Kubernetes wird in vielen Branchen eingesetzt, weil es Anwendungen skalieren, Hochverfügbarkeit gewährleisten und Multi-Cloud-Umgebungen unterstützen kann. Seine Architektur ermöglicht ein nahtloses Workload-Management, was ihn zur bevorzugten Wahl für moderne Cloud-native Anwendungen macht.

Skalierbarkeit der Anwendung

Kubernetes ermöglicht eine horizontale Skalierung, so dass die Anwendungen unterschiedliche Arbeitslasten effizient bewältigen können:

- Der horizontale Pod-Autoscaler (HPA) passt die Anzahl der Pods anhand von CPU-, Speicher- oder benutzerdefinierten Metriken an.

- Cluster Autoscaler fügt dynamisch Arbeiterknoten hinzu oder entfernt sie, um den Bedarf zu decken.

- Der Lastausgleich sorgt dafür, dass der Datenverkehr gleichmäßig auf die Replikate verteilt wird.

Das macht Kubernetes ideal für Anwendungen mit schwankendem Datenverkehr, wie z. B. E-Commerce-Plattformen, Streaming-Dienste und SaaS-Anwendungen.

Hohe Verfügbarkeit und Fehlertoleranz

Kubernetes sorgt für einen kontinuierlichen Betrieb durch:

- Replizieren von Workloads über mehrere Knoten, um Serviceunterbrechungen zu vermeiden.

- Selbstheilungsmechanismen, die ausgefallene Container automatisch neu starten.

- Leaderwahl in der Kontrollebene, um die Stabilität bei Ausfällen zu gewährleisten.

Dank dieser Funktionen eignet sich Kubernetes für geschäftskritische Anwendungen, die nahezu keine Ausfallzeiten erfordern.

Hybride und Multi-Cloud-Einsätze

Kubernetes abstrahiert die Komplexität der Infrastruktur und macht es einfacher, Workloads in lokalen, hybriden und Multi-Cloud-Umgebungen einzusetzen:

- Konsistentes Anwendungsmanagement in AWS, Google Cloud, Azure und lokalen Clustern.

- Verkehrsrouting zwischen Cloud-Anbietern für optimale Latenz und Kosteneffizienz.

- Disaster-Recovery-Strategien mit Cross-Cloud-Failover-Setups.

Fazit

Kubernetes hat die Container-Orchestrierung revolutioniert und ist zum Industriestandard für die Bereitstellung, Verwaltung und Skalierung von Anwendungen in modernen Cloud-Umgebungen geworden. Seine Architektur ermöglicht eine automatische Skalierung, hohe Verfügbarkeit und Cloud-übergreifende Kompatibilität, was es zu einem leistungsstarken Werkzeug für Unternehmen macht, die Microservices und Cloud-native Strategien einführen.

Wenn du die Kubernetes-Architektur verstehst, können Entwickler und IT-Teams:

- Optimiere die Anwendungsleistung durch effizientes Scheduling und Skalierung.

- Verbessere die Ausfallsicherheit deines Systems durch Selbstheilung und hohe Verfügbarkeit.

- Gewährleisten Sie nahtlose Multi-Cloud- und Hybrid-Implementierungen und vermeiden Sie die Bindung an einen bestimmten Anbieter.

Von der Verwaltung der Steuerebene über die Ausführung von Worker Nodes bis hin zu anpassbaren Add-ons bietet Kubernetes die Flexibilität, die für den Betrieb geschäftskritischer Anwendungen in großem Maßstaberforderlich ist . Während sich das Cloud-Ökosystem weiterentwickelt, bleibt Kubernetes an vorderster Front und ermöglicht es Unternehmen, mit Zuversicht zu innovieren.

Kubernetes ist ein mächtiges Werkzeug für die Verwaltung moderner Anwendungen, aber um es zu beherrschen, brauchst du praktische Erfahrung. Setze dein Lernen fort mit:

- Kurs Einführung in Kubernetes um die Grundlagen von Kubernetes zu erlernen und Container mithilfe von Manifesten und kubectl-Anweisungen einzusetzen und zu orchestrieren.

- Docker Compose vs. Kubernetes um das richtige Tool für deine Bedürfnisse zu wählen.

- Containerisierung für maschinelles Lernen um Kubernetes auf KI/ML-Workflows anzuwenden.

Josep ist Data Scientist und Projektmanager beim katalanischen Fremdenverkehrsamt und nutzt Daten, um die Erfahrungen von Touristen in Katalonien zu verbessern. Sein Fachwissen umfasst das Management von Datenspeicherung und -verarbeitung, gekoppelt mit fortschrittlichen Analysen und der effektiven Kommunikation von Datenerkenntnissen.

Er ist auch ein engagierter Pädagoge, der den Big-Data-Masterstudiengang an der Universität von Navarra unterrichtet und regelmäßig aufschlussreiche Artikel über Datenwissenschaft auf Medium und KDNuggets veröffentlicht.

Er hat einen BS in technischer Physik von der Polytechnischen Universität von Katalonien und einen MS in intelligenten interaktiven Systemen von der Universität Pompeu Fabra.

Derzeit engagiert er sich leidenschaftlich dafür, datenbezogene Technologien durch die Medium-Publikation ForCode'Sake einem breiteren Publikum zugänglich zu machen.