Curso

El equilibrio de carga es un concepto que aparece en más lugares de lo que cabría esperar.

Imagina un sábado por la mañana en un supermercado abarrotado con una sola caja abierta. Hay quince personas haciendo cola, todo el mundo está molesto y el pobre cajero parece estar reconsiderando todas las decisiones de su vida que lo han llevado a este momento. La tensión empieza a aumentar cuando tres miembros del personal aparecen de repente, abren algunas cajas más y empiezan a dirigir a la gente hacia las colas más cortas. Todo se acelera, la presión disminuye y las colas comienzan a avanzar con normalidad. Eso, en esencia, es el equilibrio de carga.

En este artículo, te explicaré qué es el equilibrio de carga, por qué es importante, cómo funciona internamente y cómo evita que el mundo digital se colapse cuando hay mucho tráfico. No necesitas ningún conocimiento específico para seguir este artículo, así que no te preocupes si no estás muy familiarizado con las redes o la arquitectura en la nube. Esta guía te ayudará a tener las cosas claras, será práctica y (esperemos) un poco divertida.

¿Qué es el equilibrio de carga y por qué es importante?

En tecnología, el equilibrio de carga es la forma en que distribuimos el tráfico entrante o las tareas entre varios servidores o recursos. En lugar de dejar que una máquina se ahogue bajo el peso de todo, un equilibrador de carga distribuye el trabajo para que todo siga siendo rápido, estable y escalable. Está presente en todas partes en la infraestructura moderna: las nubes lo utilizan para gestionar millones de usuarios, los procesos de inteligencia artificial dependen de él para distribuir las cargas de datos entre los nodos y los sitios de comercio electrónico cuentan con él para sobrevivir al Black Friday.

Imaginemos, solo por un segundo, que tu aplicación no tiene equilibrador de carga. Un servidor recibe todas las solicitudes, todo el tráfico, toda la presión. Quizás se mantenga durante un tiempo, hasta que (inevitablemente) deje de hacerlo. Se ralentiza, los usuarios se frustran y puede que incluso se bloquee por completo. Mientras tanto, los demás servidores están sin hacer nada, sin hacer nada.

Sin equilibrio de carga, básicamente te ves obligado a:

- Puntos únicos de fallo: Si un servidor falla, todo falla.

- Rendimiento deficiente bajo presión: Los servidores sobrecargados responden más lentamente (si es que responden).

- Escalabilidad limitada: Añadir más servidores no sirve de nada si no se utilizan.

- Usuarios frustrados: Lo cual, seamos sinceros, es el verdadero problema.

Ahora, añade un equilibrador de carga y las cosas se ven muy diferentes. Se sitúa delante de tus servidores backend, vigilando el funcionamiento de cada uno de ellos y distribuyendo las solicitudes entrantes al que esté en mejores condiciones o menos ocupado. Algunos incluso supervisan aspectos como el tiempo de respuesta o los recursos del servidor en tiempo real.

Esto es lo que obtienes:

- Alta disponibilidad: Si un servidor falla, el tráfico simplemente se redirige automáticamente.

- Mejor rendimiento: Nadie está sobrecargado, por lo que todo funciona más rápido.

- Escalabilidad: Puedes añadir o eliminar servidores según sea necesario, y el equilibrador de carga se ajustará automáticamente.

- Tolerancia a fallos: Los fracasos no lo arruinan todo.

- Rentabilidad: Aprovechas mejor tus recursos.

- Mayor seguridad: Algunos equilibradores de carga ayudan a bloquear el tráfico malicioso y a ocultar los servicios internos.

Si todavía estás pensando en el ejemplo del supermercado, imagina que esa cola de 15 personas se divide de forma inteligente entre cinco cajas. Nadie entra en pánico, nadie grita y tú llegas más rápido al pasillo de las pizzas congeladas. Ese es el objetivo.

Cómo funciona el equilibrio de carga

Por lo tanto, hemos hablado sobre por qué es útil el equilibrio de carga de. Ahora veamos cómo funciona realmente en realidad.

A alto nivel, un equilibrador de carga se sitúa entre los clientes (personas o sistemas que realizan solicitudes) y tus servidores backend (los que realizan el trabajo). Su función es recibir cada solicitud entrante y decidir dónde enviarla.

Este es el proceso básico:

- Un usuario intenta acceder a tu aplicación o servicio.

- La solicitud llega primero al equilibrador de carga.

- El equilibrador de carga comprueba qué servidores backend están disponibles, en buen estado y no demasiado ocupados.

- Reenvía la solicitud al servidor elegido.

- El servidor gestiona la solicitud y envía la respuesta, ya sea directamente o a través del equilibrador de carga.

En teoría es bastante sencillo, pero hay mucho que hacer entre bastidores y hay algunos conceptos clave que garantizan que todo funcione:

- Revisiones médicas: El equilibrador de carga envía periódicamente un ping a cada servidor backend para asegurarse de que sigue activo y en funcionamiento. Si uno no supera un control de salud, se retira temporalmente de la rotación hasta que se recupere.

- Conmutación por error: Si un servidor falla en medio de una solicitud (sucede), el equilibrador de carga puede redirigir el tráfico a uno que funcione correctamente sin molestar al usuario final.

- Persistencia de sesión (también conocida como «adherencia»): A veces, es conveniente que un usuario siga accediendo al mismo servidor, como durante una sesión de inicio de sesión. Las sesiones persistentes lo hacen posible, aunque tienen sus inconvenientes (lo veremos más adelante).

- Terminación SSL: Los equilibradores de carga pueden encargarse de descifrar el tráfico HTTPS para que los servidores backend no tengan que hacerlo. Esto alivia parte de la carga computacional y mantiene la rapidez.

Equilibrio de carga frente a equilibrador de carga

Nota rápida: «equilibrio de carga» es el concepto (distribución del tráfico), y un «equilibrador de carga» es la herramienta o el servicio que lo hace posible. A menudo se oye utilizar ambos términos indistintamente, pero es útil conocer la diferencia.

Algoritmos de equilibrio de carga

Aunque a veces los equilibradores de carga simplemente eligen un servidor al azar, existen estrategias reales, denominadas algoritmos de equilibrio de carga, que determinan cómo se distribuye el tráfico entrante entre los recursos del backend.

Algunos de ellos son bastante sencillos y predecibles, mientras que otros se ajustan en tiempo real en función del rendimiento del servidor, el número de conexiones o la velocidad de respuesta. Vamos a dividirlos en dos grandes categorías.

Algoritmos estáticos

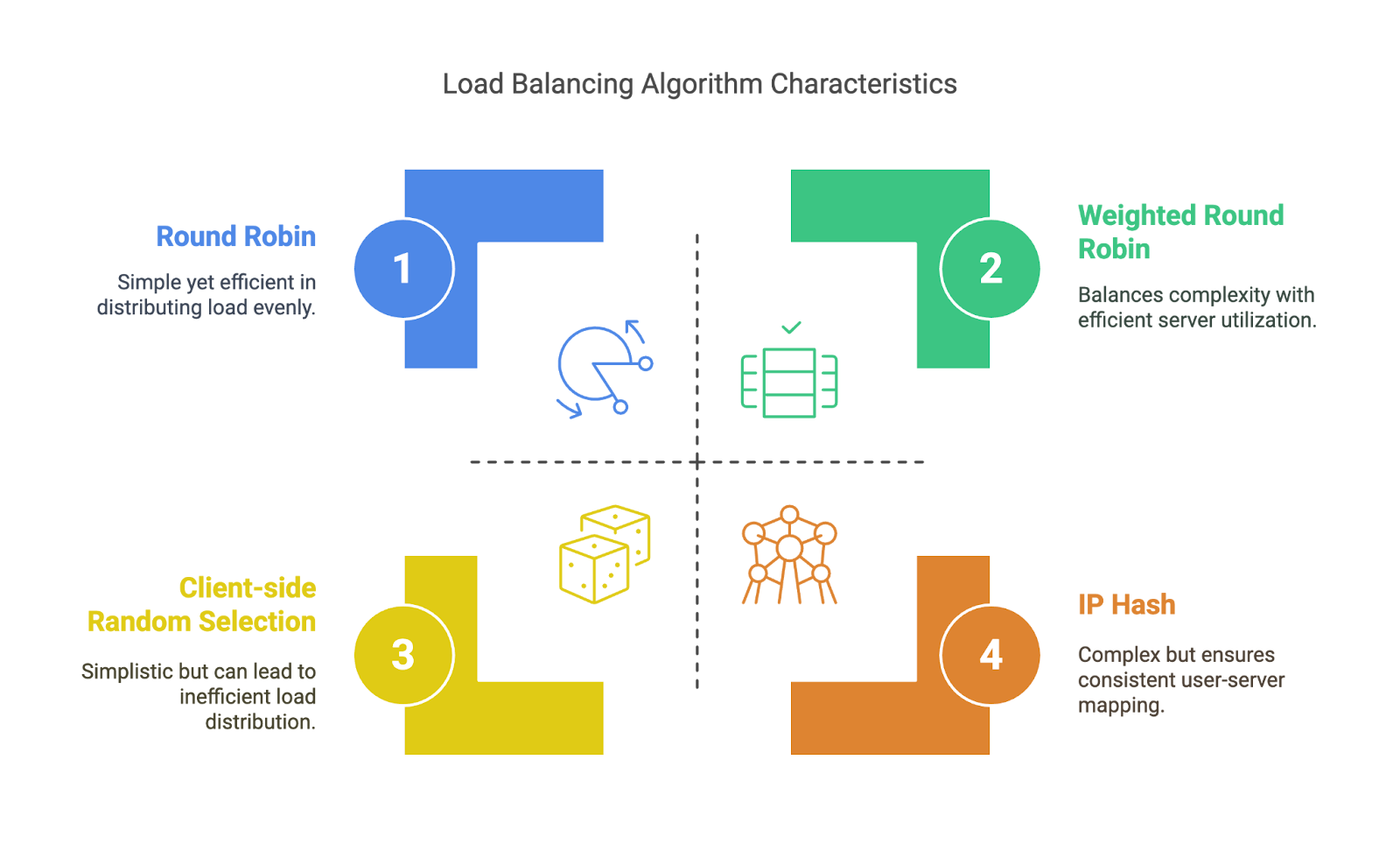

No se adaptan a lo que ocurre en el sistema, sino que simplemente siguen una regla predefinida. Eso los hace predecibles y fáciles de implementar, pero no siempre son ideales bajo la presión del mundo real.

- Ronda robin: El equilibrador de carga envía solicitudes a los servidores en orden rotativo: A, B, C, A, B, C... Es sencillo, pero no tiene en cuenta el nivel de actividad de cada servidor.

- Ronda rotativa ponderada: Similar a Round Robin, pero algunos servidores reciben más solicitudes que otros en función de las ponderaciones asignadas, lo que resulta útil si algunas máquinas son más potentes que otras.

- IP Hash: Utiliza la dirección IP del cliente para decidir a qué servidor dirigirte. Garantiza que el mismo usuario siga accediendo al mismo backend, lo cual es bueno para la persistencia básica de la sesión.

- Selección aleatoria del lado del cliente: Como su nombre indica, los clientes eligen un servidor al azar (a menudo de una lista proporcionada por el DNS). Esto elimina la sobrecarga del equilibrador de carga, pero puede dar lugar a una distribución desigual.

Algoritmos estáticos. Imagen del autor

Algoritmos dinámicos

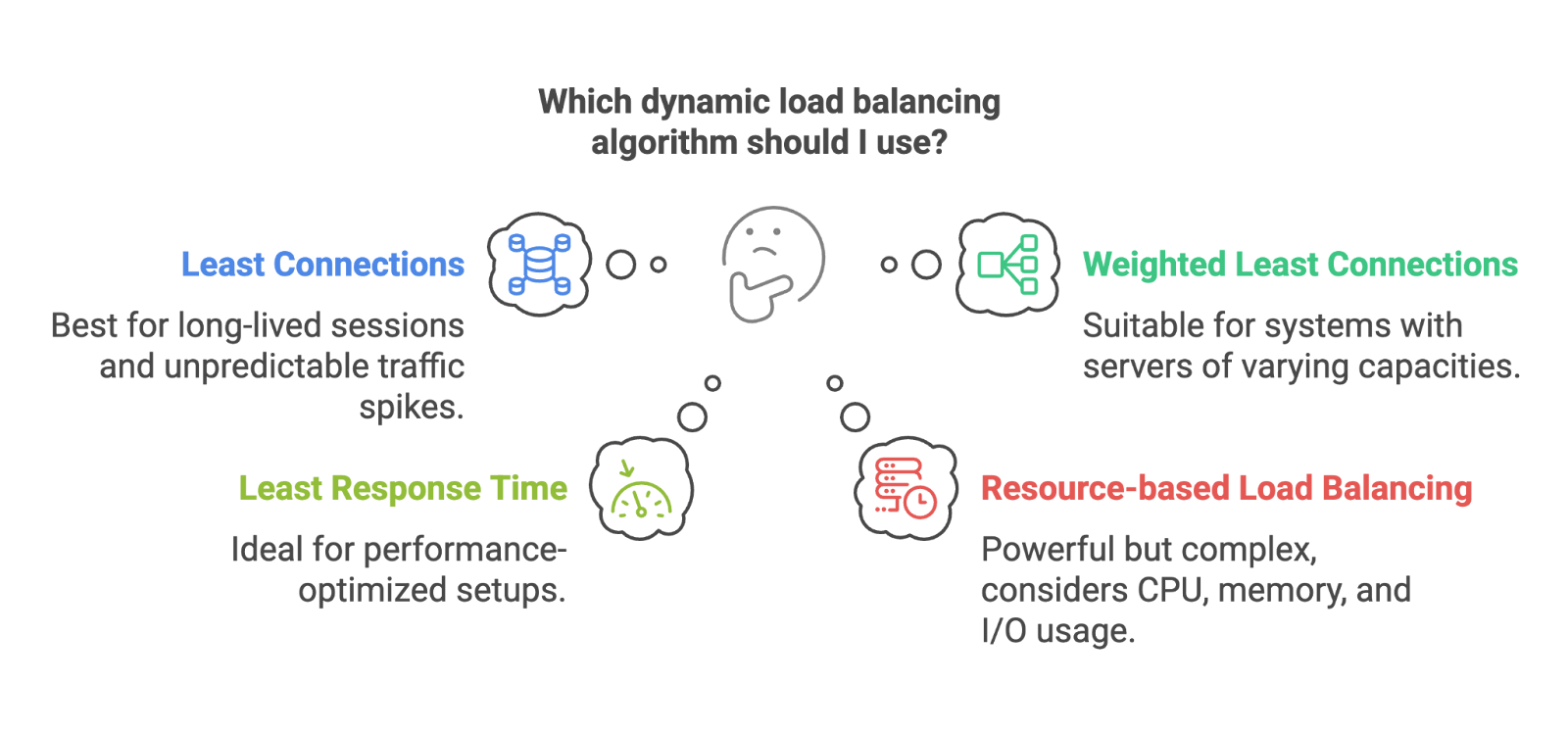

Estos algoritmos se adaptan en función de lo que realmente ocurre en el sistema. Son más inteligentes, pero requieren más supervisión y conocimiento del sistema.

- Menos conexiones: Envía la siguiente solicitud al servidor con menos conexiones activas. Ideal para sistemas con sesiones de larga duración o picos de tráfico impredecibles.

- Conexiones mínimas ponderadas: La misma idea, pero teniendo en cuenta las ponderaciones del servidor. Los servidores más grandes pueden gestionar más conexiones, por lo que reciben más tráfico.

- Tiempo de respuesta mínimo: Enruta las solicitudes al servidor con el tiempo de respuesta más rápido. Ideal para configuraciones optimizadas para el rendimiento.

- Equilibrio de carga basado en recursos: Tiene en cuenta aspectos como el uso de la CPU, la memoria o la E/S. Si los recursos de un servidor están sobrecargados, recibe menos tráfico. Este enfoque es eficaz, pero más complejo de implementar y supervisar.

Algoritmos dinámicos. Imagen del autor

Los algoritmos estáticos son excelentes cuando el tráfico es predecible y los servidores están equilibrados. Los algoritmos dinámicos brillan cuando las cosas se vuelven un poco más caóticas.

Muy bien, ahora hablemos de los diferentes tipos de equilibradores de carga: hardware, software, nativos de la nube y más.

Tipos de equilibradores de carga

No todos los equilibradores de carga son iguales. Algunos residen en hardware, otros se ejecutan como software, otros se incluyen con servicios de nube y otros se especializan en casos de uso muy específicos. El que utilices dependerá de tu arquitectura, tu escala y, en ocasiones, simplemente de tu presupuesto.

Basado en la implementación

Equipos de equilibrio de carga

Se trata de dispositivos físicos que se instalan en tu centro de datos y que están diseñados específicamente para equilibrar el tráfico. Son potentes y rápidos, pero caros y más difíciles de escalar según la demanda. Piensa en grandes empresas y configuraciones locales.

Equilibradores de carga de software

Se ejecutan como aplicaciones en servidores de uso general. Los controladores de carga de tipo «» como HAProxy, nginx (propiedad de F5) o Envoy entran en esta categoría. Son más baratos, más flexibles y más fáciles de integrar enla mayoría de los entornos.

Equilibradores de carga nativos de la nube

Si utilizas AWS, Azure o GCP, probablemente ya estés utilizando un equilibrador de carga nativo de la nube, como AWS ELB, Azure Load Balancer o GCP Load Balancing. Se gestionan por ti, se adaptan automáticamente y se integran perfectamente con otros servicios.

Si deseas familiarizarte con la forma en que AWS gestiona esto (y otras muchas piezas de infraestructura), echa un vistazo anuestrocurso Conceptos de tecnología y servicios en la nube de AWS.

Es posible que hayas oído hablar de los equilibradores de carga elásticos. Están diseñados para adaptarse al aumento o la disminución de tu carga de trabajo. A menudo forman parte de sistemas nativos de la nube, pero el término «elástico» solo significa que pueden adaptarse dinámicamente al tráfico, lo que resulta ideal para cargas irregulares o impredecibles.

Basado en la capa OSI

El modelo OSI es un marco conceptual utilizado para describir cómo se mueven los datos a través de una red. Tiene siete capas, desde el cable físico hasta la aplicación en tu navegador. Para el equilibrio de carga, las capas más relevantes son la capa 4 y la capa 7.

Equilibradores de carga de capa 4 (capa de transporte)

Estos toman decisiones de enrutamiento basadas en direcciones IP, puertos y tráfico TCP/UDP. Son rápidos y eficientes, pero no saben nada sobre el contenido que se envía.

Equilibradores de carga de capa 7 (capa de aplicación)

Estos analizan el contenido real de la solicitud, como los encabezados HTTP, las cookies o las URL. Esto les permite realizar tareas más avanzadas, como el enrutamiento basado en la ruta URL, pruebas A/B o preferencias de idioma. Por ejemplo, si deseas que las solicitudes /api/ vayan a un clúster y las solicitudes /login vayan a otro, necesitarás la capa 7.

Tipos especializados

Equilibradores de carga de servidores globales (GSLB)

Se utiliza para distribuir el tráfico entre centros de datos distribuidos geográficamente. Útil para configuraciones multirregionales, de baja latencia o de recuperación ante desastres.

Equilibradores de carga internos

Opera íntegramente dentro de redes privadas, utilizadas para equilibrar el tráfico entre servicios dentro de una nube o clúster.

Equilibradores de carga de diámetro

Especializado en sistemas de telecomunicaciones que utilizan el protocolo Diameter, que suele encontrarse en redes móviles para enrutamiento, autenticación y solicitudes de facturación.

Equilibradores de carga HTTP(S)

Están optimizados específicamente para gestionar el tráfico HTTP y HTTPS. A menudo incluyen terminación SSL, enrutamiento basado en URL y protección DDoS integrada.

Cada tipo de equilibrador de carga resuelve un tipo diferente de problema. Algunos se centran en la escala, otros en la latencia, la seguridad o la facilidad de uso. Saber cuál elegir puede marcar una gran diferencia en cuanto a la fluidez (o dificultad) con la que funciona tu infraestructura.

Arquitecturas y topologías de equilibradores de carga

Hasta ahora, hemos hablado de lo que hacen los equilibradores de carga y los tipos que puedes utilizar, pero ¿qué hay de cómo están construidos por dentro? La arquitectura de un sistema de equilibrio de carga afecta a todo, desde su capacidad de escalabilidad hasta su capacidad para gestionar los fallos con elegancia.

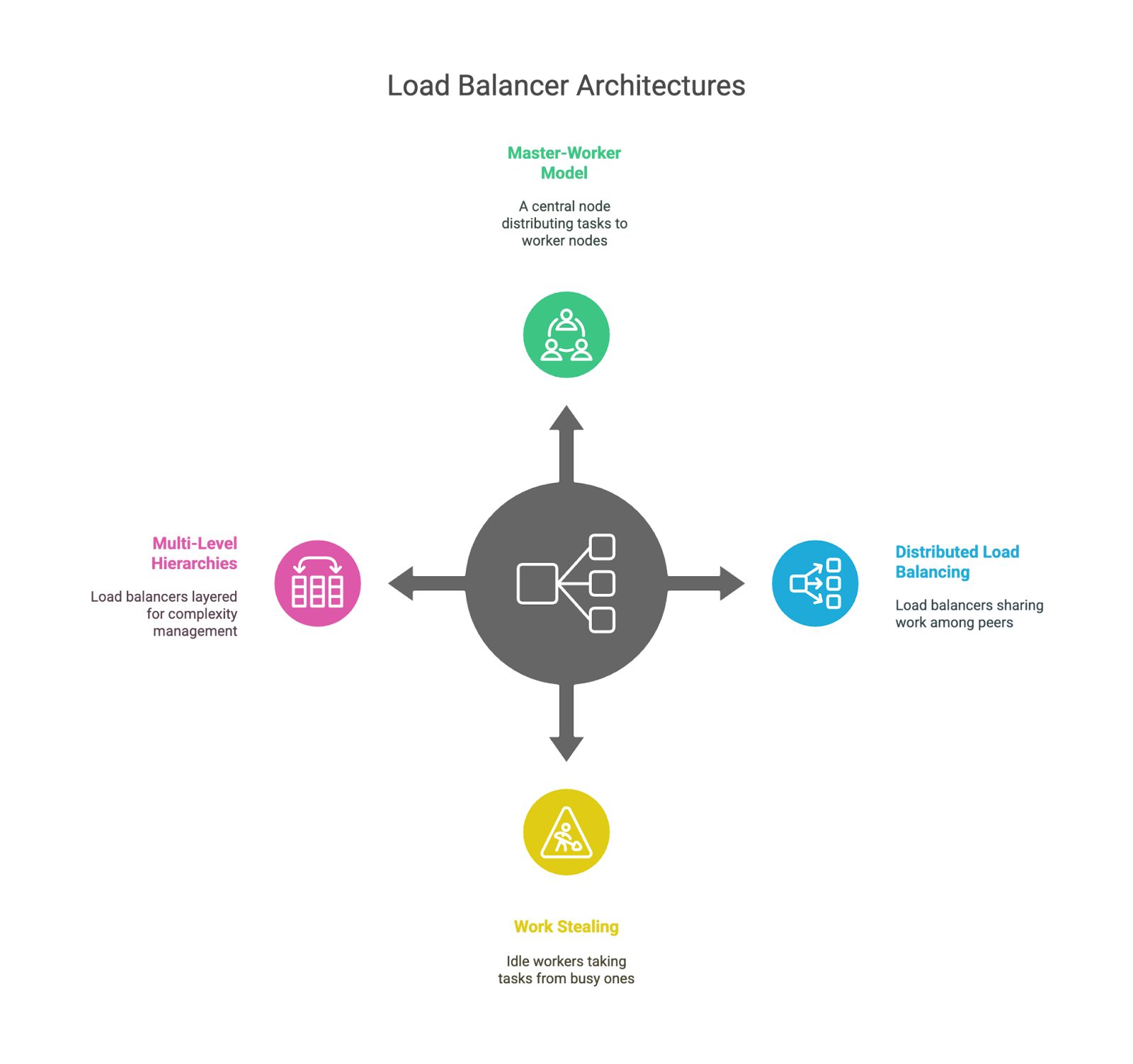

Modelo líder-seguidor

Esta es la configuración clásica: un nodo «líder» toma las decisiones y distribuye el trabajo a varios nodos «trabajadores». Es sencillo y fácil de entender, pero el líder puede convertirse en un cuello de botella o en un único punto de fallo si no cuenta con el respaldo adecuado.

Equilibrio de carga distribuido

En lugar de un cerebro central, cada equilibrador de carga es consciente de sus pares ycomparte el trabajo. Esto mejora la tolerancia a fallos y la escalabilidad, pero complica un poco la coordinación. Esto se ve a menudo en sistemas a gran escala con enrutamiento anycast o distribución basada en DNS.

En entornos contenedorizados, especialmente con Kubernetes, el equilibrio de carga se vuelve aún más interesante. Los servicios, los controladores de ingreso y los sidecars funcionan conjuntamente para enrutar el tráfico de forma inteligente dentro de los clústeres. Si acabas de empezar en este mundo, nuestro curso Introducción a Kubernetes es una forma práctica y sólida de aprender los conceptos básicos.

Robo de trabajo

En esta configuración, los trabajadores ociosos pueden «robar» tareas a los que están ocupados. Se utiliza habitualmente en entornos con gran carga computacional, como colas de tareas o canalizaciones de procesamiento de datos, pero no tanto para el tráfico web. Es un patrón útil para equilibrar cargas de trabajo impredecibles.

Jerarquías multinivel

Algunos sistemas organizan sus equilibradores de carga por capas, por ejemplo, uno a nivel global (por ejemplo, en todas las regiones), otro a nivel del centro de datos y un tercero dentro de un clúster de servicios específico. Esto ayuda a gestionar la complejidad y mantiene cada capa centrada en un ámbito específico.

Arquitecturas de equilibrio de carga.

Cada una de estas arquitecturas tiene sus ventajas e inconvenientes. Los modelos centralizados son fáciles de entender, pero corren el riesgo de convertirse en cuellos de botella; los modelos distribuidos se adaptan mejor, pero añaden complejidad, y las topologías en capas ofrecen modularidad, pero pueden introducir latencia si no se diseñan con cuidado. Como siempre, no hay una respuesta única válida para todos los casos. Depende del tamaño de tu sistema, los patrones de tráfico y la tolerancia al riesgo.

Retos y limitaciones

El equilibrio de carga es potente, pero no es mágico. Aunque puede hacer que los sistemas sean más fiables, escalables y eficientes, también introduce nuevas capas de complejidad y posibles puntos de fallo. Hablemos de algunas de las concesiones que tienen que hacer los ingenieros, tanto a nivel técnico como operativo.

Desafíos generales en el equilibrio de carga

El equilibrador de carga en sí mismo puede convertirse en un cuello de botella.

Irónicamente, la herramienta diseñada para distribuir el tráfico puede convertirse en un único punto de fallo si no se diseña correctamente, especialmente en modelos centralizados o basados en líderes. Por eso, muchos sistemas utilizan múltiples equilibradores de carga, mecanismos de conmutación por error o incluso equilibrio a nivel de DNS para distribuir el riesgo.

Añade sobrecarga.

Por muy rápido que sea, un equilibrador de carga sigue añadiendo un salto entre el cliente y el backend. Esto puede introducir latencia, especialmente en arquitecturas multicapa o con enrutamiento en la capa de aplicación (capa 7).

La terminación SSL es útil, pero costosa.

Gestión del tráfico HTTPS a nivel del equilibrador de carga (también conocido como La terminación SSL puede descargar el trabajo de la CPU de los servidores backend, pero también significa que el equilibrador de carga está haciendo más y se convierte en responsable de configuraciones de seguridad y certificados confidenciales.

Persistencia de sesión frente a ausencia de estado

Las sesiones persistentes son útiles para mantener a los usuarios vinculados al mismo backend (como durante el inicio de sesión), pero complican el escalado y dificultan la ejecución de servicios totalmente sin estado. Los ingenieros a menudo tienen que elegir entre la experiencia del usuario y la elegancia arquitectónica.

La configuración se vuelve compleja rápidamente.

Cuanto más inteligente sea tu lógica de enrutamiento, más posibilidades habrá de que se produzcan errores, enrutamientos incorrectos o problemas de rendimiento sutiles que sean difíciles de detectar. Te sentirás inteligente cuando lo configures, pero mucho menos cuando te despierten a las 2 de la madrugada para depurar fallos en las comprobaciones de estado.

Retos prácticos para ingenieros y administradores

Los algoritmos de ajuste no son válidos para todos los casos.

Cada aplicación se comporta de manera diferente bajo carga. Elegir entre algoritmos estáticos o dinámicos y ajustar aspectos como los umbrales de conexión o los intervalos de comprobación del estado puede requerir mucho ensayo, error y experiencia.

La resolución de problemas es más difícil con una capa intermedia.

Cuando algo sale mal, el equilibrador de carga añade otro lugar donde buscar. Las rutas mal configuradas, las solicitudes descartadas, las capas de almacenamiento en caché o los resultados inconsistentes de las comprobaciones de estado pueden enturbiar las aguas.

La seguridad añade una complejidad adicional.

Si tu equilibrador de carga gestiona SSL, debes asegurarte de que esté correctamente configurado, actualizado y supervisado. Cualquier error en este sentido puede crear vulnerabilidades o romper la seguridad de las comunicaciones.

La observabilidad cobra mayor importancia

Esto está relacionado en cierta medida con lo que hemos comentado sobre la complejidad añadida. Necesitas un registro, métricas y seguimiento sólidos para comprender cómo fluyen las solicitudes a través del sistema. Sin una buena observabilidad, puede resultar difícil detectar un equilibrador de carga que funciona mal, y aún más difícil solucionarlo.

Para que quede claro, ninguna de estas son razones parano utilizar el equilibrio de carga. Son simplemente la realidad de la creación de sistemas resilientes: cada capa que se añade puede ayudar, pero también añade nuevos retos que gestionar.

Tendencias futuras en el equilibrio de carga

Como todo en tecnología, el equilibrio de carga está evolucionando. A medida que los sistemas se vuelven más complejos, más distribuidos y más dinámicos, los enfoques tradicionales se están agotando y se están probando nuevas estrategias.

Equilibrio de carga impulsado por IA y ML

Esto es bastante obvio, dada la tendencia tecnológica mundial. Las plataformas modernas están empezando a integrar machine learning para predecir los patrones de tráfico y tomar decisiones de ruta más inteligentes. En lugar de limitarse a reaccionar ante la carga actual, estos sistemas pueden anticipar picos (como el lanzamiento de un producto o noticias de última hora) y preajustar el flujo de tráfico. Aún es pronto, pero el potencial de las infraestructuras autooptimizadas es real.

Si deseas explorar ese aspecto, nuestro tutorialsobre machine learning, procesos, implementación y MLOps es un excelente punto de partida.

Equilibrio de carga consciente de las aplicaciones

Los equilibradores de carga tradicionales no saben realmente qué hace tu aplicación; solo analizan el tráfico. El equilibrio de carga consciente de las aplicaciones va más allá. Puede tomar decisiones basadas en la identidad del usuario, el tipo de dispositivo o la importancia comercial de la solicitud. Por ejemplo, podría dar prioridad a los usuarios que hayan iniciado sesión durante un pico de tráfico o dirigir el tráfico sensible a clústeres con mayor seguridad.

Entornos de nube y híbridos

A medida que las empresas distribuyen las cargas de trabajo entre varios proveedores de nube (o combinan instalaciones locales con la nube), los equilibradores de carga se están adaptando. Deben ser más sensibles a la ubicación, admitir la conmutación por error entre nubes y gestionar el enrutamiento entre entornos muy diferentes. Es de esperar que en estas configuraciones haya más directores de tráfico globales y una mayor coordinación a nivel de DNS.

Equilibrio de carga localizado y en el borde

Con el auge de la computación periférica, el equilibrio de carga se está acercando más al usuario. En lugar de enviar todo a través de una nube central, las solicitudes se atienden desde nodos periféricos, lo que reduce considerablemente la latencia. El equilibrio de carga en el borde debe ser ligero, inteligente e hiperlocal.

Sistemas autónomos y basados en agentes

Algunas plataformas experimentales están explorando el equilibrio de carga basado en agentes, en el que los servicios individuales ayudan a decidir cómo debe fluir el tráfico en función de lo que ven a nivel local. Está más distribuido y puede responder rápidamente a cambios a pequeña escala, pero también plantea retos de coordinación.

Creo que está bastante claro que todas estas tendencias apuntan hacia una cosa: un equilibrio de carga más dinámico, inteligente y sensible al contexto. Los días del simple enrutamiento por turnos siguen vivos y coleando (¿por qué desechar algo que funciona?), pero están empezando a compartir protagonismo con sistemas que aprenden, se adaptan y toman decisiones en tiempo real basándose en mucho más que la carga del servidor.

Conclusión

A lo largo de este artículo, hemos analizado qué es el equilibrio de carga, por qué es importante y cómo funciona en realidad. Hemos hablado de algoritmos, arquitecturas y aplicaciones en el mundo real, y esperamos haber contribuido a que todo esto resulte un poco menos misterioso. ¡Espero que este artículo te haya ayudado a comprender mejor cómo encaja todo!

Como siguiente paso, si estás interesado en obtener más información, inscríbete en nuestros cursos especializados. Recomiendo, nuestro curso Introducción a Kubernetes y nuestro curso Conceptos de tecnología y servicios en la nube de AWS.

Soy un líder tecnológico con mentalidad de producto, especializado en el crecimiento de startups en fase inicial, desde el primer prototipo hasta la adaptación del producto al mercado y más allá. Siento una curiosidad infinita por saber cómo utiliza la gente la tecnología, y me encanta trabajar estrechamente con fundadores y equipos multifuncionales para dar vida a ideas audaces. Cuando no estoy creando productos, busco inspiración en nuevos rincones del mundo o me desahogo en el estudio de yoga.

Preguntas frecuentes sobre el equilibrio de carga

¿Se puede utilizar el equilibrio de carga con arquitecturas sin servidor?

Más o menos. Aunque los equilibradores de carga tradicionales no suelen intervenir en funciones sin servidor como AWS Lambda, el propio proveedor de nube se encarga del escalado y el enrutamiento entre bastidores. Así que sí, el equilibrio de carga sigue existiendo, solo que ahora está oculto.

¿Cuál es la diferencia entre el equilibrio de carga y el autoescalado?

El equilibrio de carga distribuye el tráfico entre los recursos disponibles, mientras que el autoescalado añade o elimina esos recursos en función de la demanda. Funcionan bien juntos: el escalado garantiza que haya suficientes servidores y el equilibrio de carga garantiza que esos servidores se utilicen de manera eficiente.

¿Cómo afecta el equilibrio de carga al rendimiento o la arquitectura de la base de datos?

Las bases de datos también pueden beneficiarse del equilibrio de carga, especialmente las cargas de trabajo con un uso intensivo de lectura. Herramientas como las réplicas de lectura, las capas proxy y el agrupamiento de conexiones ayudan a distribuir las consultas a la base de datos, pero las operaciones de escritura siguen requiriendo estrategias de consistencia, lo que puede resultar complicado.