Curso

O balanceamento de carga é um conceito que aparece em mais lugares do que você imagina.

Pense numa manhã de sábado num supermercado lotado, com só um caixa aberto. Quinze pessoas estão na fila, todo mundo está irritado e o pobre caixa parece estar repensando todas as decisões da vida que o levaram a esse momento. A tensão começa a aumentar quando três funcionários aparecem de repente, abrem mais algumas filas e começam a direcionar as pessoas para as filas mais curtas. Tudo fica mais rápido, a pressão diminui e as filas começam a andar normalmente. Isso, basicamente, é o balanceamento de carga.

Neste artigo, vou explicar o que é o balanceamento de carga, por que ele é importante, como funciona nos bastidores e como ele evita que o mundo digital desmorone quando as coisas ficam agitadas. Você não precisa de nenhum conhecimento específico para acompanhar este artigo, então não se preocupe se não for especialista em redes ou arquitetura em nuvem! Este guia vai deixar tudo claro, prático e (espero) um pouco divertido.

O que é balanceamento de carga e por que é importante?

Na tecnologia, o balanceamento de carga é como a gente distribui o tráfego ou as tarefas que chegam por vários servidores ou recursos. Em vez de deixar uma máquina sobrecarregada com tudo isso, um balanceador de carga distribui o trabalho para que tudo continue rápido, estável e escalável. Está em toda parte na infraestrutura moderna: plataformas em nuvem usam isso para lidar com milhões de usuários, pipelines de IA dependem disso para distribuir cargas de dados entre nós e sites de comércio eletrônico contam com isso para sobreviver à Black Friday.

Vamos imaginar, só por um segundo, que seu aplicativo não tem balanceador de carga. Um servidor recebe todas as solicitações, todo o tráfego, toda a pressão. Talvez isso continue por um tempo, até que (inevitavelmente) não continue mais. Ele fica lento, os usuários ficam frustrados e talvez até trave completamente. Enquanto isso, os outros servidores ficam sem fazer nada, sem ter nada pra fazer.

Sem o balanceamento de carga, você basicamente fica preso a:

- Pontos únicos de falha: Se um servidor parar de funcionar, tudo para de funcionar.

- Desempenho ruim sob pressão: Servidores sobrecarregados respondem mais lentamente (se é que respondem).

- Escalabilidade limitada: Adicionar mais servidores não adianta nada se eles não estiverem sendo usados.

- Usuários frustrados: O que, sejamos sinceros, é o verdadeiro problema.

Agora, acrescente um balanceador de carga e as coisas ficam bem diferentes. Ele fica na frente dos seus servidores backend, de olho no desempenho de cada um e distribuindo as solicitações recebidas para o que estiver mais saudável ou menos ocupado. Alguns até monitoram coisas como tempo de resposta ou recursos do servidor em tempo real.

E aí, o que você ganha:

- Alta disponibilidade: Se um servidor falhar, o tráfego é automaticamente redirecionado.

- Melhor desempenho: Ninguém fica sobrecarregado, então tudo funciona mais rápido.

- Escalabilidade: Você pode adicionar ou remover servidores conforme necessário, e o balanceador de carga se ajusta.

- Tolerância a falhas: Os fracassos não levam tudo com eles.

- Eficiência de custos: Você aproveita melhor seus recursos.

- Maior segurança: Alguns balanceadores de carga ajudam a bloquear tráfego malicioso e ocultar serviços internos.

Se você ainda está pensando no exemplo do supermercado, imagine aquela fila de 15 pessoas sendo dividida de forma inteligente entre cinco caixas. Ninguém entra em pânico, ninguém grita e você chega mais rápido à seção de pizzas congeladas. Esse é o objetivo.

Como funciona o balanceamento de carga

Então, a gente falou sobre por que o balanceamento de carga do é útil. Agora vamos dar uma olhada em e vercomo ele realmente funciona.

Em um nível mais alto, um balanceador de carga fica entre os clientes (pessoas ou sistemas que fazem solicitações) e seus servidores back-end (os que fazem o trabalho). A função dele é pegar cada pedido que chega e decidir para onde mandar.

Aqui está o fluxo básico:

- Um usuário tenta acessar seu aplicativo ou serviço.

- A solicitação chega primeiro ao balanceador de carga.

- O balanceador de carga verifica quais servidores backend estão disponíveis, funcionando bem e não estão muito ocupados.

- Ele encaminha a solicitação para o servidor escolhido.

- O servidor processa a solicitação e envia a resposta de volta, diretamente ou por meio do balanceador de carga.

Bastante simples na teoria, mas há muita coisa acontecendo nos bastidores, e existem alguns conceitos-chave que garantem que tudo funcione:

- Exames de saúde: O balanceador de carga faz ping regularmente em cada servidor backend para garantir que ele ainda esteja funcionando corretamente. Se um servidor não passar na verificação de integridade, ele será temporariamente retirado da rotação até que se recupere.

- Failover: Se um servidor travar no meio de uma solicitação (isso acontece), o balanceador de carga pode redirecionar o tráfego para um servidor que esteja funcionando bem, sem incomodar o usuário final.

- Persistência da sessão (também conhecida como “aderência”): Às vezes, você quer que um usuário continue acessando o mesmo servidor, tipo durante uma sessão de login. As sessões persistentes tornam isso possível, embora tenham suas desvantagens (falaremos sobre isso mais tarde).

- Terminação SSL: Os balanceadores de carga podem cuidar da descriptografia do tráfego HTTPS, assim os servidores back-end não precisam fazer isso. Isso tira um pouco da carga computacional e mantém tudo rápido.

Equilíbrio de carga vs. balanceador de carga

Só pra constar: “balanceamento de carga” é o conceito (distribuir o tráfego), e um “balanceador de carga” é a ferramenta ou serviço que faz isso acontecer. Você vai ouvir os dois termos sendo usados de forma intercambiável, mas é bom saber a diferença entre eles.

Algoritmos de balanceamento de carga

Embora às vezes os balanceadores de carga simplesmente escolham um servidor aleatoriamente, existem estratégias reais, chamadas algoritmos de balanceamento de carga, que determinam como o tráfego recebido é distribuído pelos recursos de back-end.

Algumas delas são bem simples e previsíveis, enquanto outras se ajustam em tempo real com base no desempenho do servidor, na contagem de conexões ou na velocidade de resposta. Vamos dividi-los em duas grandes categorias.

Algoritmos estáticos

Eles não se adaptam ao que está acontecendo no sistema; eles apenas seguem uma regra pré-definida. Isso faz com que sejam previsíveis e fáceis de implementar, mas nem sempre são ideais sob a pressão do mundo real.

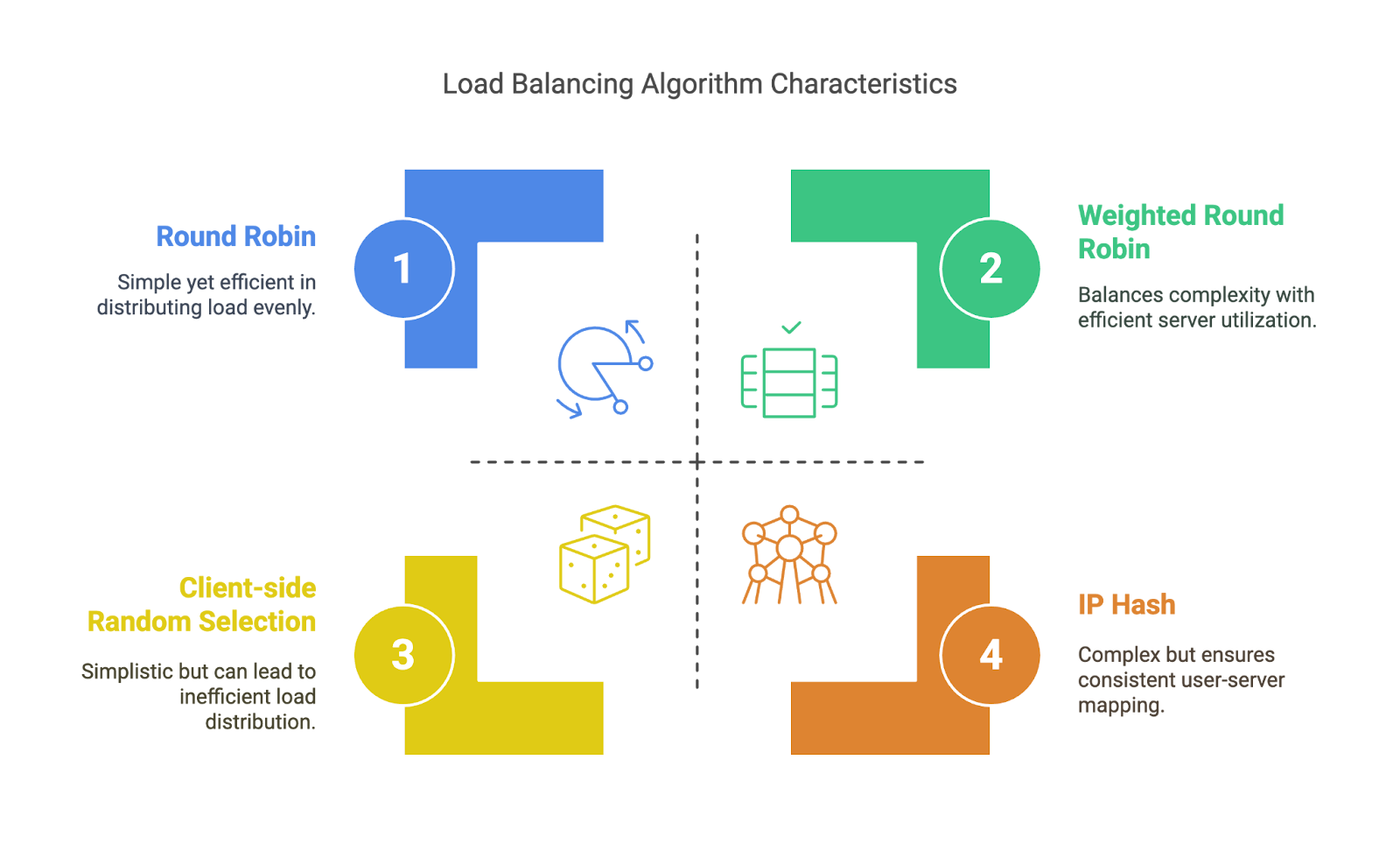

- Rodízio: O balanceador de carga manda as solicitações para os servidores numa ordem rotativa: A, B, C, A, B, C... Simples, mas não leva em conta o quão ocupado cada servidor está.

- Rodízio ponderado: É tipo o Round Robin, mas alguns servidores recebem mais pedidos do que outros, dependendo dos pesos atribuídos - útil se algumas máquinas forem mais potentes do que outras.

- Hash IP: Usa o endereço IP do cliente para decidir para qual servidor encaminhar. Garantir que o mesmo usuário continue acessando o mesmo backend, o que é bom para a aderência básica da sessão.

- Seleção aleatória do lado do cliente: Como o nome já diz, os clientes escolhem um servidor aleatoriamente (geralmente a partir de uma lista fornecida pelo DNS). Isso elimina a sobrecarga do balanceador de carga, mas pode levar a uma distribuição desigual.

Algoritmos estáticos. Imagem do autor

Algoritmos dinâmicos

Esses algoritmos se adaptam com base no que realmente está acontecendo no sistema. Eles são mais inteligentes, mas exigem mais monitoramento e conhecimento do sistema.

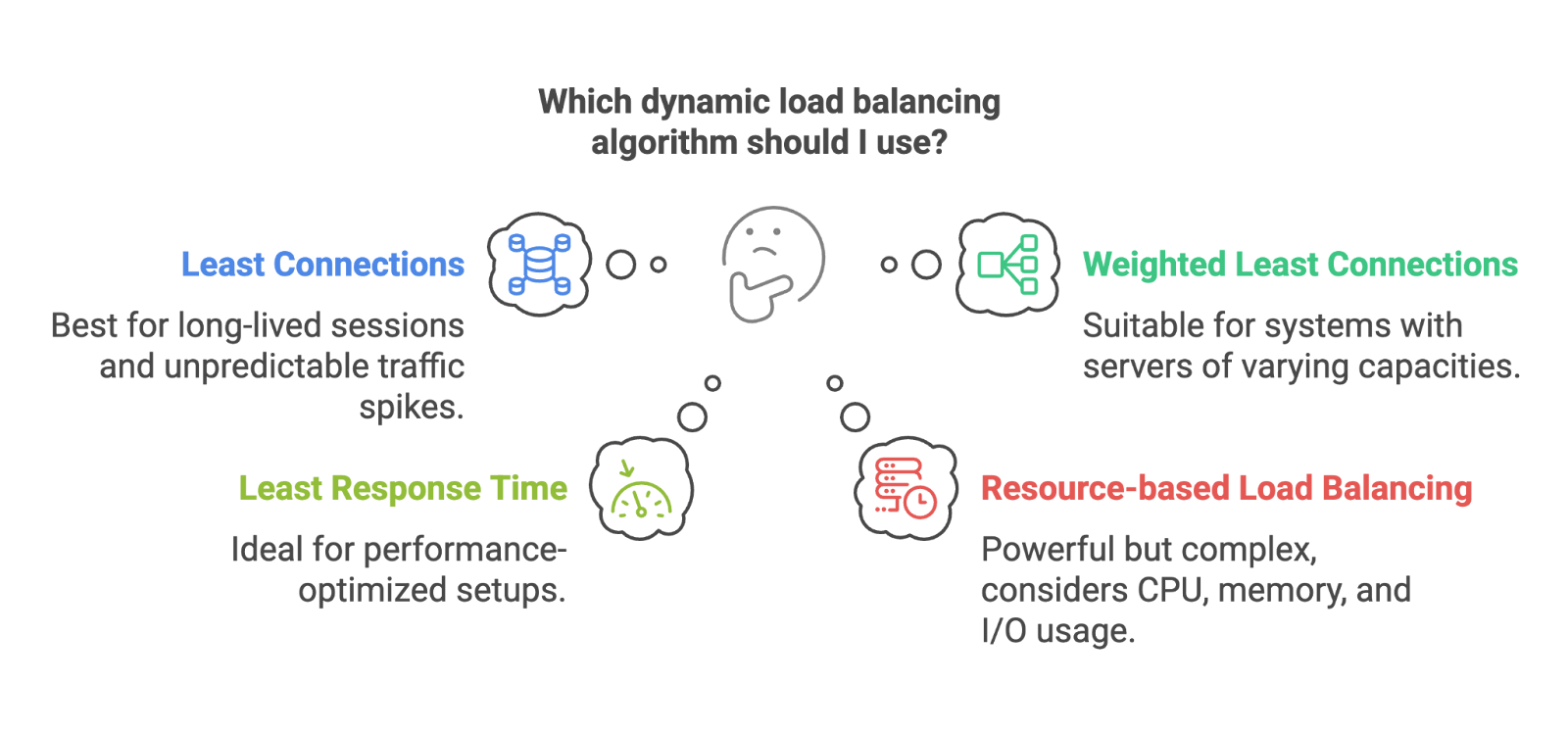

- Menos conexões: Manda a próxima solicitação pro servidor com menos conexões ativas. Ótimo para sistemas com sessões de longa duração ou picos de tráfego imprevisíveis.

- Conexões mínimas ponderadas: A mesma ideia, mas levando em conta os pesos do servidor. Servidores maiores podem lidar com mais conexões, então eles recebem mais tráfego.

- Menor tempo de resposta: Encaminhar as solicitações para o servidor com o tempo de resposta mais rápido. Ótimo para configurações com desempenho otimizado.

- Equilíbrio de carga baseado em recursos: Leva em conta coisas como uso da CPU, memória ou E/S. Se os recursos de um servidor estiverem sobrecarregados, ele receberá menos tráfego. Essa abordagem é poderosa, mas mais complexa de implementar e monitorar.

Algoritmos dinâmicos. Imagem do autor

Os algoritmos estáticos são ótimos quando o tráfego é previsível e os servidores têm recursos parecidos. Os algoritmos dinâmicos são ótimos quando as coisas ficam um pouco mais caóticas.

Ok, agora vamos falar sobre os diferentes tipos de balanceadores de carga: hardware, software, nativos da nuvem e muito mais.

Tipos de balanceadores de carga

Nem todos os balanceadores de carga são iguais. Alguns funcionam em hardware, outros em software, alguns vêm junto com serviços em nuvem e outros são especializados em casos de uso bem específicos. Qual você usa depende da sua arquitetura, da sua escala e, às vezes, só do seu orçamento.

Com base na implantação

Balancadores de carga de hardware

São aparelhos físicos que ficam no seu centro de dados, feitos especialmente para equilibrar o tráfego. Eles são poderosos e rápidos, mas caros e mais difíceis de escalar sob demanda. Pense em grandes empresas e instalações locais.

Balancadores de carga de software

Eles funcionam como aplicativos em servidores de uso geral. Ferramentas de balanceamento de carga (ools) como HAProxy, nginx (de propriedade da F5) ou Envoy se encaixam nessa categoria. São mais baratos, mais flexíveis e mais fáceis de integrar namaioria dos ambientes.

Balancers de carga nativos da nuvem

Se você usa AWS, Azure ou GCP, provavelmente já está usando um balanceador de carga nativo da nuvem, como AWS ELB, Azure Load Balancer ou GCP Load Balancing. Eles são gerenciados para você, escalam automaticamente e se integram perfeitamente a outros serviços.

Se você quer saber como a AWS lida com isso (e várias outras partes da infraestrutura), dá uma olhadano nossocurso Conceitos de tecnologia e serviços em nuvem da AWS.

Você já deve ter ouvido falar em balanceadores de carga elásticos. Eles são feitos pra aumentar ou diminuir conforme a sua carga de trabalho. Eles geralmente fazem parte de sistemas nativos da nuvem, mas o termo “elástico” só quer dizer que eles podem se adaptar dinamicamente ao tráfego, o que é ideal para cargas irregulares ou imprevisíveis.

Baseado na camada OSI

O modelo OSI é uma estrutura conceitual usada para descrever como os dados se movem através de uma rede. Tem sete camadas, desde o fio físico até o aplicativo no seu navegador. Para o balanceamento de carga, as camadas mais relevantes são a camada 4 e a camada 7.

Balanceadores de carga da camada 4 (camada de transporte)

Eles tomam decisões de roteamento com base em endereços IP, portas e tráfego TCP/UDP. Eles são rápidos e eficientes, mas não sabem nada sobre o conteúdo que está sendo enviado.

Balanceadores de carga da camada 7 (camada de aplicação)

Esses analisam o conteúdo real da solicitação, como cabeçalhos HTTP, cookies ou URLs. Isso permite que eles façam coisas mais avançadas, como roteamento com base no caminho da URL, testes A/B ou preferências de idioma. Por exemplo, se você quiser que as solicitações /api/ vão para um cluster e as solicitações /login vão para outro, você vai precisar da Camada 7.

Tipos especializados

Balanceadores globais de carga de servidor (GSLB)

Usado para distribuir o tráfego entre centros de dados geograficamente distribuídos. Ótimo pra configurações com várias regiões, baixa latência ou recuperação de desastres.

Balanceadores de carga internos

Opera totalmente em redes privadas, usada para equilibrar o tráfego entre serviços dentro de uma nuvem ou cluster.

Balanceadores de carga de diâmetro

Especializado em sistemas de telecomunicações que usam oprotocolo Diameter, que geralmente é usado em redes móveis para roteamento, autenticação e solicitações de cobrança.

Balancers de carga HTTP(S)

Eles são otimizados para lidar especificamente com tráfego HTTP e HTTPS. Eles geralmente incluem terminação SSL, roteamento baseado em URL e proteção DDoS integrada.

Cada tipo de balanceador de carga resolve um tipo diferente de problema. Alguns se concentram na escala, outros na latência, segurança ou facilidade de uso. Saber qual escolher pode fazer uma grande diferença na facilidade (ou dificuldade) de operar sua infraestrutura.

Arquiteturas e topologias de balanceadores de carga

Até agora, falamos sobre o que os balanceadores de carga fazem e os tipos que você pode usar, mas e quanto à sua estrutura interna? A arquitetura de um sistema de balanceamento de carga afeta tudo, desde a sua capacidade de escalabilidade até a forma como lida com falhas.

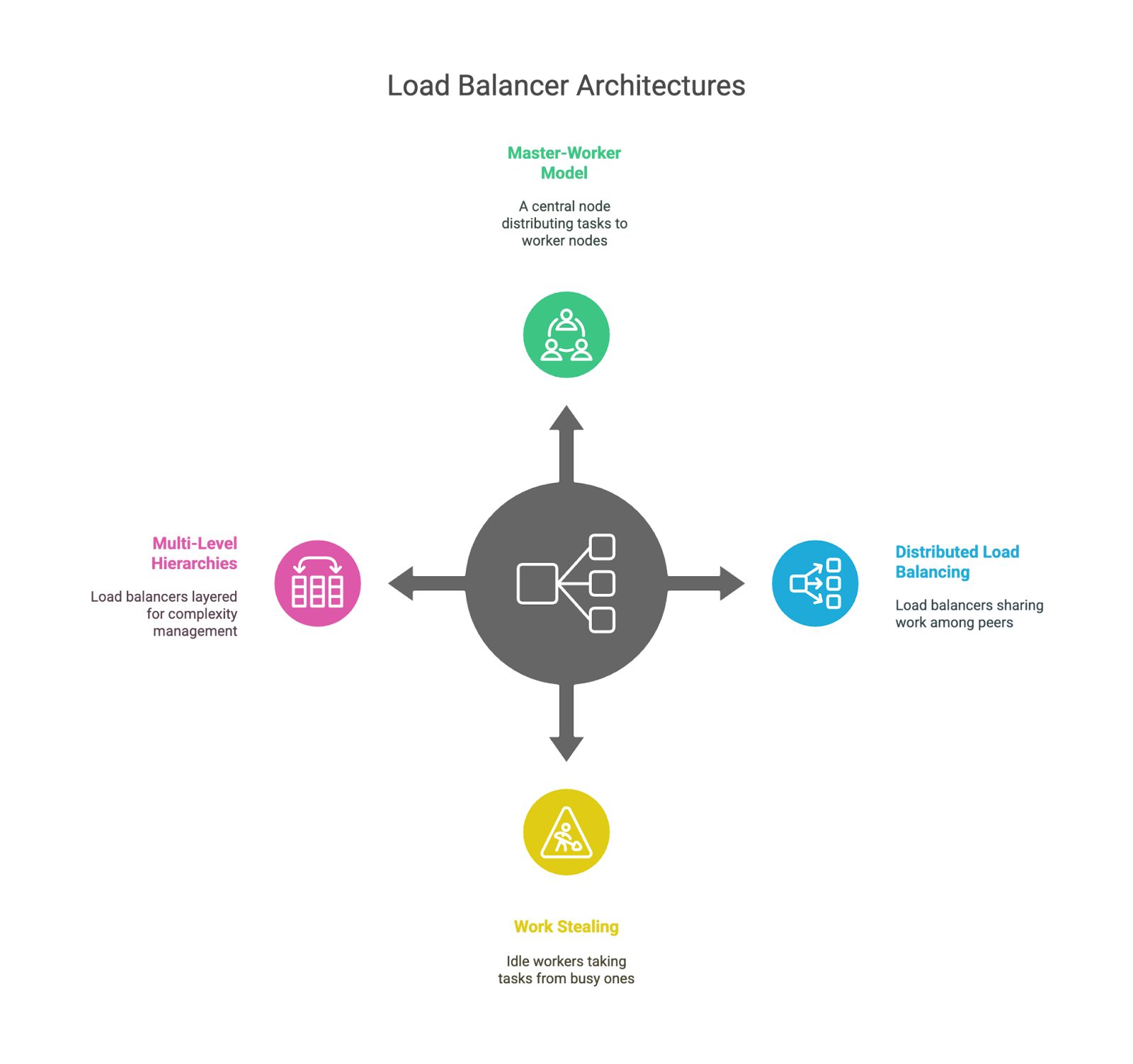

Modelo líder-seguidor

Essa é a configuração clássica: um nó “líder” toma as decisões e distribui o trabalho para vários nós “trabalhadores”. É simples e fácil de entender, mas o líder pode se tornar um gargalo ou um ponto único de falha se não tiver o apoio adequado.

Equilíbrio de carga distribuído

Em vez de um cérebro central, cada balanceador de carga sabe onde estão os outros edivide o trabalho. Isso melhora a tolerância a falhas e a escalabilidade, mas torna a coordenação um pouco mais complicada. Você vai ver isso bastante em sistemas grandes com roteamento anycast ou distribuição baseada em DNS.

Em ambientes de contêineres, principalmente com o Kubernetes, o balanceamento de carga fica ainda mais interessante. Serviços, controladores de entrada e sidecars trabalham juntos para rotear o tráfego de forma inteligente dentro dos clusters. Se você está começando agora nesse mundo, nosso curso Introdução ao Kubernetes é uma maneira prática e sólida de aprender o básico.

Roubo de trabalho

Nessa configuração, os trabalhadores ociosos podem “roubar” tarefas dos ocupados. É normalmente usado em ambientes que exigem muito processamento, como filas de tarefas ou pipelines de processamento de dados, mas não tanto para o tráfego da web. É um padrão útil para equilibrar cargas de trabalho imprevisíveis.

Hierarquias multiníveis

Alguns sistemas organizam seus balanceadores de carga em camadas, como ter um no nível global (por exemplo, em todas as regiões), outro no nível do data center e um terceiro dentro de um cluster de serviços específico. Isso ajuda a gerenciar a complexidade e mantém cada camada focada em um escopo específico.

Arquiteturas de balanceamento de carga.

Cada uma dessas arquiteturas tem suas vantagens e desvantagens. Os modelos centralizados são fáceis de entender, mas podem virar gargalos; os modelos distribuídos escalam melhor, mas são mais complexos; e as topologias em camadas oferecem modularidade, mas podem trazer latência se não forem bem projetadas. Como sempre, não tem uma resposta única pra todo mundo. Depende do tamanho do seu sistema, dos padrões de tráfego e da tolerância ao risco.

Desafios e limitações

O balanceamento de carga é poderoso, mas não é mágico. Embora possa tornar os sistemas mais confiáveis, escaláveis e eficientes, também traz novas camadas de complexidade e possíveis pontos de falha. Vamos falar sobre algumas das dificuldades que os engenheiros enfrentam, tanto do ponto de vista técnico quanto operacional.

Desafios gerais no balanceamento de carga

O próprio balanceador de carga pode virar um gargalo.

É meio irônico, mas a própria ferramenta criada pra distribuir o tráfego pode virar um ponto único de falha se não for bem projetada, principalmente em modelos centralizados ou baseados em líderes. É por isso que muitos sistemas usam vários balanceadores de carga, mecanismos de failover ou até mesmo balanceamento no nível do DNS para distribuir o risco.

Isso aumenta a sobrecarga.

Não importa o quão rápido seja, um balanceador de carga ainda adiciona um salto entre o cliente e o backend. Isso pode causar latência, principalmente em arquiteturas com várias camadas ou com roteamento na camada de aplicação (Camada 7).

A terminação SSL é útil, mas cara

Tratamento do tráfego HTTPS no nível do balanceador de carga (também conhecido como A terminação SSL pode aliviar a carga de trabalho da CPU dos servidores back-end, mas também significa que o balanceador de carga está fazendo mais e se torna responsável por configurações de segurança e certificados confidenciais.

Persistência da sessão versus ausência de estado

As sessões persistentes são úteis para manter os usuários ligados ao mesmo backend (como durante o login), mas complicam o dimensionamento e dificultam a execução de serviços totalmente sem estado. Os engenheiros muitas vezes têm que escolher entre a experiência do usuário e a elegância arquitetônica.

A configuração fica complicada rapidinho

Quanto mais inteligente for a sua lógica de roteamento, mais espaço vai ter para bugs, erros de roteamento ou problemas sutis de desempenho que são difíceis de rastrear. Você vai se sentir esperto quando configurar tudo, mas não tanto quando for acordado às 2 da manhã para resolver problemas de instabilidade na verificação de integridade.

Desafios práticos para engenheiros e administradores

Ajustar algoritmos não é uma coisa que serve para todos.

Cada aplicativo se comporta de maneira diferente sob carga. Escolher entre algoritmos estáticos ou dinâmicos e ajustar coisas como limites de conexão ou intervalos de verificação de integridade pode exigir muita tentativa, erro e experiência.

A resolução de problemas é mais difícil com uma camada intermediária

Quando algo dá errado, o balanceador de carga adiciona outro lugar para procurar. Rotas mal configuradas, solicitações perdidas, camadas de cache ou resultados inconsistentes de verificações de integridade podem confundir tudo.

A segurança adiciona uma complexidade extra

Se o seu balanceador de carga estiver lidando com SSL, você precisa garantir que ele esteja configurado, corrigido e monitorado corretamente. Qualquer erro pode criar vulnerabilidades ou quebrar a comunicação segura.

A observabilidade se torna mais importante

Isso tem um pouco a ver com o que falamos sobre complexidade extra. Você precisa de registros, métricas e rastreamento robustos para entender como as solicitações fluem pelo sistema. Sem uma boa observabilidade, pode ser difícil detectar um balanceador de carga com mau funcionamento e ainda mais difícil corrigi-lo.

Só pra ficar claro, nenhuma dessas coisas é motivo pra não usar o balanceamento de carga no. Essa é a realidade da construção de sistemas resilientes: cada camada que você adiciona pode ajudar, mas também traz novos desafios para gerenciar.

Tendências futuras no balanceamento de carga

Como tudo na tecnologia, o balanceamento de carga está sempre mudando. À medida que os sistemas ficam mais complexos, distribuídos e dinâmicos, as abordagens tradicionais estão sendo testadas e novas estratégias estão sendo experimentadas.

Equilíbrio de carga com IA e ML

Isso é bem óbvio, considerando a tendência global da tecnologia. As plataformas modernas estão começando a integrar machine learning para prever padrões de tráfego e tomar decisões de roteamento mais inteligentes. Em vez de só reagir à carga atual, esses sistemas podem antecipar picos (como o lançamento de um produto ou notícias de última hora) e pré-ajustar o fluxo de tráfego. Ainda é cedo, mas o potencial para uma infraestrutura que se otimiza sozinha é real.

Se você quiser explorar esse lado das coisas, nosso tutorialsobre machine learning, Pipelines, Implantação e MLOps é um ótimo ponto de partida.

Equilíbrio de carga com reconhecimento de aplicativos

Os balanceadores de carga tradicionais não sabem realmente o que seu aplicativo faz; eles só analisam o tráfego. O balanceamento de carga com reconhecimento de aplicativos vai mais a fundo. Ele pode tomar decisões com base na identidade do usuário, no tipo de dispositivo ou na importância comercial da solicitação. Por exemplo, ele pode priorizar usuários conectados durante um pico ou direcionar tráfego sensível para clusters com maior segurança.

Ambientes de nuvem e híbridos

À medida que as empresas distribuem as cargas de trabalho por vários provedores de nuvem (ou misturam recursos locais com a nuvem), os balanceadores de carga estão se adaptando. Eles precisam estar mais atentos à localização, oferecer suporte ao failover entre nuvens e gerenciar o roteamento entre ambientes bem diferentes. Espere ver mais diretores de tráfego global e orquestração em nível de DNS nessas configurações.

Equilíbrio de carga localizada e de ponta

Com o surgimento da computação de ponta, o balanceamento de carga está se aproximando do usuário. Em vez de passar tudo por uma nuvem central, as solicitações são atendidas a partir de nós de borda, reduzindo bastante a latência. O balanceamento de carga na borda precisa ser leve, inteligente e hiperlocal.

Sistemas autônomos e baseados em agentes

Algumas plataformas experimentais estão testando o balanceamento de carga baseado em agentes, onde serviços individuais ajudam a decidir como o tráfego deve fluir com base no que eles estão vendo localmente. É mais distribuído e consegue reagir rápido a mudanças pequenas, mas também traz desafios de coordenação.

Acho que tá bem claro que todas essas tendências apontam para uma coisa: um balanceamento de carga mais dinâmico, inteligente e sensível ao contexto. Os dias do roteamento simples por rodízio ainda estão vivos e bem (por que jogar fora algo que funciona?), mas eles estão começando a dividir o palco com sistemas que aprendem, se adaptam e tomam decisões em tempo real com base em muito mais do que a carga do servidor.

Conclusão

Ao longo deste artigo, vimos o que é o balanceamento de carga, por que ele é importante e como funciona nos bastidores. A gente falou sobre algoritmos, arquiteturas e aplicações no mundo real e, com sorte, fez com que tudo parecesse um pouco menos misterioso nesse processo. Espero que esse artigo tenha te ajudado a entender melhor como tudo se encaixa!

Se você quiser saber mais, inscreva-se nos nossos cursos dedicados. Eu recomendo o curso Introdução ao Kubernetes e o curso Conceitos de tecnologia e serviços em nuvem da AWS d.

Sou um líder técnico voltado para produtos, especializado no crescimento de startups em estágio inicial, desde o primeiro protótipo até a adequação do produto ao mercado e além. Tenho uma curiosidade infinita sobre como as pessoas usam a tecnologia e adoro trabalhar com fundadores e equipes multifuncionais para dar vida a ideias ousadas. Quando não estou criando produtos, estou em busca de inspiração em novos cantos do mundo ou desabafando no estúdio de ioga.

Perguntas frequentes sobre balanceamento de carga

É possível usar o balanceamento de carga com arquiteturas sem servidor?

Mais ou menos. Embora os balanceadores de carga tradicionais geralmente não estejam envolvidos em funções sem servidor, como o AWS Lambda, o próprio provedor de nuvem cuida do dimensionamento e do roteamento nos bastidores. Então, sim, o balanceamento de carga ainda rola, só que você não percebe.

Qual é a diferença entre balanceamento de carga e autoescala?

O balanceamento de carga distribui o tráfego pelos recursos disponíveis, enquanto o autoescalonamento adiciona ou remove esses recursos com base na demanda. Eles funcionam bem juntos: o dimensionamento garante que haja servidores suficientes e o balanceamento de carga garante que esses servidores sejam usados de forma eficiente.

Como o balanceamento de carga afeta o desempenho ou a arquitetura do banco de dados?

Os bancos de dados também podem se beneficiar do balanceamento de carga, principalmente as cargas de trabalho com muitas leituras. Ferramentas como réplicas de leitura, camadas proxy e pool de conexões ajudam a distribuir consultas ao banco de dados, mas as operações de gravação ainda precisam de estratégias de consistência, o que pode ser complicado.