A forma como interagimos com a tecnologia está sempre mudando. Um dos avanços mais legais dos últimos tempos é na área da inteligência artificial (IA), onde as máquinas são treinadas para pensar, aprender e até se comunicar como os humanos. Entre os vários avanços em áreas como a IA generativa, tem uma arte sutil que tá ganhando destaque: a engenharia de prompts.

Imagina ter uma conversa com uma máquina onde você dá uma dica ou uma “sugestão” e ela responde com informações ou ações relevantes. Essa é a essência da engenharia rápida. Trata-se de criar as perguntas ou instruções certas para orientar os modelos de IA, especialmente os Modelos de Linguagem Grande (LLMs), para produzir os resultados desejados. Seja você um entusiasta de tecnologia curioso sobre as últimas novidades em IA ou um profissional que quer aproveitar o poder dos modelos de linguagem, entender a engenharia de prompts é essencial.

Ao longo deste artigo, vamos desmistificar as complexidades técnicas da engenharia de prompts, ao mesmo tempo em que apresentamos uma visão de sua importância no panorama mais amplo da IA. E pra quem quer mergulhar mais fundo no mundo da IA e do processamento de linguagem, a gente incluiu vários recursos pra ajudar você a aprender mais.

Aprimoramento de IA para iniciantes

O que é engenharia de prompts?

No fundo, a engenharia rápida é como ensinar uma criança por meio de perguntas. Assim como uma pergunta bem formulada pode guiar o raciocínio de uma criança, uma sugestão bem elaborada pode direcionar um modelo de IA, especialmente um Modelo de Linguagem Grande (LLM), para um resultado específico. Vamos ver esse conceito com mais detalhes.

Definição e conceitos fundamentais

A engenharia de prompts é a prática de projetar e refinar prompts — perguntas ou instruções — para obter respostas específicas de modelos de IA. Pense nisso como a interface entre a intenção humana e o resultado da máquina.

No mundo da IA, onde os modelos são treinados com um monte de dados, o prompt certo pode fazer toda a diferença entre o modelo entender o que você quer ou não.

Por exemplo, se você já interagiu com assistentes de voz como Siri ou Alexa, você já participou de uma forma básica de engenharia de prompts. A maneira como você formula seu pedido — “Toque uma música relaxante” em vez de “Toque a sinfonia de Beethoven” — pode produzir resultados muito diferentes.

O lado técnico da engenharia de prompts

A engenharia de prompts, embora tenha suas raízes na arte da linguagem, está super ligada às complexidades técnicas dos modelos de IA. Aqui está uma análise mais detalhada do lado técnico:

- Arquiteturas de modelos. Modelos de linguagem grandes (LLMs), como o GPT (Generative Pre-trained Transformer) e o LLaMAda Mata, são feitos com arquiteturas de transformador. Essas arquiteturas permitem que os modelos lidem com grandes quantidades de dados e entendam o contexto por meio de mecanismos de autoatenção. Criar prompts eficazes muitas vezes exige entender essas arquiteturas por trás.

- Dados de treinamento e tokenização. Os LLMs são treinados em grandes conjuntos de dados, transformando os dados de entrada em pedaços menores (tokens) para processamento. A escolha da tokenização (baseada em palavras, pares de bytes, etc.) pode influenciar a forma como um modelo interpreta um prompt. Por exemplo, uma palavra tokenizada de forma diferente pode gerar resultados variados.

- Parâmetros do modelo. Os LLMs têm milhões, se não bilhões, de parâmetros. Esses parâmetros, ajustados durante o processo de treinamento, determinam como o modelo responde a um comando. Entender a relação entre esses parâmetros e os resultados do modelo pode ajudar a criar prompts mais eficazes.

- Temperatura e amostragem Top-k. Ao gerar respostas, os modelos usam técnicas como configuração de temperatura e amostragem top-k para determinar a aleatoriedade e a diversidade dos resultados. Por exemplo, uma temperatura mais alta pode gerar respostas mais variadas (mas talvez menos precisas). Os engenheiros de prompt costumam ajustar essas configurações para otimizar os resultados do modelo.

- Funções de perda e gradientes. Em um nível mais profundo, o comportamento do modelo durante a resposta imediata é influenciado por suas funções de perda e gradientes. Essas construções matemáticas orientam o processo de aprendizagem do modelo. Embora os engenheiros de prompt normalmente não ajustem esses parâmetros diretamente, entender o impacto deles pode ajudar a entender melhor o comportamento do modelo.

Pra quem quer entender como esses modelos funcionam por dentro, nosso tutorial Transformers e Hugging Face oferece uma visão detalhada da mecânica por trás dos LLMs populares.

Por que a engenharia rápida é importante

A engenharia de prompts é a ponte que garante uma comunicação eficaz entre humanos e IA. Não é só sobre dar a resposta certa; é sobre garantir que a IA entenda o contexto, as nuances e a intenção por trás de cada pergunta.

A evolução da engenharia impulsiona

A engenharia de prompts, embora seja uma área relativamente nova, tem raízes profundas na história mais ampla do Processamento de Linguagem Natural (NLP) e do machine learning. Entender sua evolução ajuda a entender por que ela é tão importante hoje em dia.

Os primeiros dias da PNL

As origens da PNL remontam a meados do século XX, com o surgimento dos computadores digitais. Os primeiros esforços em PNL eram baseados em regras, contando com regras feitas manualmente e algoritmos simples. Esses sistemas eram meio rígidos e tinham dificuldade com as complexidades e nuances da linguagem humana.

NLP estatística e machine learning

Com o aumento do poder computacional e o crescimento dos conjuntos de dados, o final do século XX e o início do século XXI viram uma mudança em direção aos métodos estatísticos. Os algoritmos de machine learning começaram a ter um papel importante, permitindo modelos de linguagem mais flexíveis e baseados em dados. Mas esses modelos ainda tinham umas limitações na hora de entender o contexto e criar textos longos que fizessem sentido.

A ascensão dos modelos baseados em transformadores

A introdução da arquitetura transformadora no artigo“Attention is All You Need”(Atençãoé tudo o que vocêprecisa), em 2017, foi um grande ponto de virada. Os transformadores, com seus mecanismos de autoatenção, poderiam processar grandes quantidades de dados e capturar padrões linguísticos complexos. Isso levou ao desenvolvimento de modelos como o BERT do Google, que revolucionou tarefas como classificação de texto e análise de sentimentos.

O impacto do GPT da OpenAI

A série Generative Pre-trained Transformer (GPT) da OpenAI, especialmente o GPT-2 e o GPT-3, levou os transformadores para um outro nível. Esses modelos, com seus bilhões de parâmetros, mostraram uma capacidade sem precedentes de criar textos coerentes, relevantes no contexto e, muitas vezes, quase impossíveis de distinguir dos textos escritos por humanos. O surgimento dos modelos GPT mostrou como a engenharia de prompts é importante, já que a qualidade dos resultados depende muito da precisão e clareza dos prompts.

Engenharia rápida hoje em dia

Com a ampla adoção de modelos baseados em transformadores nas indústrias, na pesquisa e nas aplicações cotidianas, a engenharia rápida surgiu como uma disciplina crucial. É a ponte que garante que esses modelos poderosos sejam aproveitados de forma eficaz, tornando as ferramentas de IA mais acessíveis e fáceis de usar. Com o novo modo o1 pro da OpenAI, a necessidade de prompts eficazes e cheios de detalhes ficou mais clara do que nunca. Tá rolando até ferramentas de IA, tipo o computador da Anthropic, que podem automatizar seu computador com os comandos certos.

Seja pra liberar a criatividade com IA generativa ou usar o chatGPT em projetos de ciência de dados, entender como as prompts funcionam tá ficando cada vez mais importante.

Últimos desenvolvimentos em engenharia de prompt

No final de 2024, a área de engenharia de prompt continua evoluindo rápido, mostrando como a IA e suas aplicações são dinâmicas. Os avanços recentes têm influenciado bastante como a gente interage com os modelos de IA, principalmente os Modelos de Linguagem de Grande Porte (LLMs). Abaixo estão alguns dos principais desenvolvimentos:

Compreensão contextual aprimorada

Os avanços recentes em LLMs, principalmente em modelos como o GPT-4o e outros mais recentes, mostraram melhorias incríveis na compreensão do contexto e das nuances. Esses modelos agora estão mais preparados para entender comandos complexos, pensar em um contexto mais amplo e dar respostas mais precisas e detalhadas. Esse avanço se deve, em parte, aos métodos de treinamento mais sofisticados que usam conjuntos de dados variados e extensos, permitindo que os modelos entendam melhor as sutilezas da comunicação humana.

Técnicas de sugestão adaptativa

O prompt adaptativo é uma tendência nova em que modelos de IA estão sendo desenvolvidos para ajustar suas respostas com base no estilo de entrada e nas preferências do usuário. Essa abordagem de personalização quer deixar as interações com a IA mais naturais e fáceis de usar. Por exemplo, se um usuário costuma fazer perguntas curtas, a IA se adapta para dar respostas curtas, ou vice-versa. Esse desenvolvimento é super promissor pra melhorar a experiência do usuário em aplicativos movidos a IA, tipo assistentes virtuais e chatbots.

Engenharia de prompt multimodal

A integração de recursos multimodais em modelos de IA abriu novas fronteiras na engenharia de prompts. Os modelos multimodais podem processar e responder a comandos que incluem uma mistura de texto, imagens e, às vezes, até entradas de áudio. Esse avanço é importante porque abre caminho para aplicações de IA mais completas, que conseguem entender e interagir de um jeito que imita melhor a percepção e a comunicação humanas.

Otimização instantânea em tempo real

Os avanços na tecnologia de otimização de prompts em tempo real permitiram que os modelos de IA dessem um feedback instantâneo sobre a eficácia dos prompts. Essa tecnologia avalia a clareza da solicitação, o potencial de parcialidade e o alinhamento com o resultado desejado, oferecendo sugestões para melhorias. Essa orientação em tempo real é super valiosa tanto para quem tá começando quanto para quem já tem experiência, simplificando o processo de criar prompts eficazes.

Integração com modelos específicos do domínio

A engenharia de prompts também está vendo integração com modelos de IA específicos para cada domínio. Esses modelos especializados são treinados com dados específicos do setor, o que permite respostas mais precisas e relevantes a solicitações em áreas como medicina, direito e finanças. A combinação de engenharia rápida com esses modelos personalizados melhora a precisão e a utilidade da IA em áreas especializadas.

A arte e a ciência de criar prompts

Criar um prompt eficaz é tanto uma arte quanto uma ciência. É uma arte porque precisa de criatividade, intuição e um entendimento profundo da língua. É uma ciência porque se baseia na mecânica de como os modelos de IA processam e geram respostas.

As sutilezas da sugestão

Cada palavra em um prompt é importante. Uma pequena mudança na formulação pode levar a resultados bem diferentes de um modelo de IA. Por exemplo, pedir a um modelo para “descrever a Torre Eiffel” versus “narrar a história da Torre Eiffel” vai gerar respostas diferentes. O primeiro pode dar uma descrição física, enquanto o segundo fala sobre o significado histórico.

Entender essas diferenças é essencial, principalmente quando se trabalha com LLMs. Esses modelos, treinados com um monte de dados, podem gerar várias respostas com base nas dicas que recebem. Não é só fazer uma pergunta; é pensar nela de um jeito que combine com o que você quer conseguir.

Vimos isso no nosso guia sobre como usar o Midjourney para criar imagens - a diferença entre adicionar pesos às suas instruções para o termo “nave espacial” pode resultar em imagens de naves espaciais de ficção científica ou de um navio navegando pelo espaço.

Elementos-chave de um prompt

Vamos ver os pontos que fazem uma boa sugestão:

- Instrução. Essa é a ideia principal da solicitação. Diz ao modelo o que você quer que ele faça. Por exemplo, “Resuma o texto a seguir” dá uma ação clara para o modelo.

- Contexto. O contexto traz informações extras que ajudam o modelo a entender melhor o cenário ou o contexto geral. Por exemplo, “Considerando a crise econômica, dê conselhos de investimento” dá ao modelo um contexto para moldar sua resposta.

- Insira os dados. Essas são as informações ou dados específicos que você quer que o modelo processe. Pode ser um parágrafo, um conjunto de números ou até mesmo uma única palavra.

- Indicador de saída. Especialmente útil em cenários de dramatização, esse elemento orienta o modelo sobre o formato ou tipo de resposta desejado. Por exemplo, “No estilo de Shakespeare, reescreva a seguinte frase” dá ao modelo uma direção estilística.

No nosso guia específico sobre engenharia de prompts do chatGPT, vimos alguns exemplos específicos de bons prompts para a ferramenta.

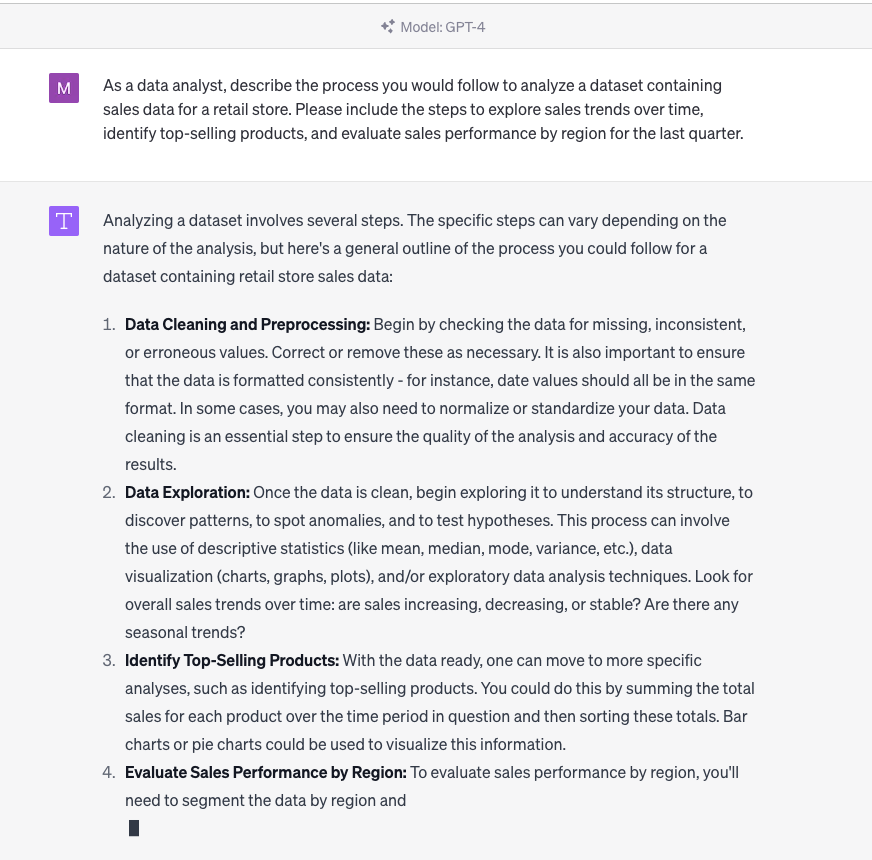

Engenharia de prompts do chatGPT em ação

Pra uma abordagem prática, o curso do DataCamp sobre Criação de Chatbots em Python tem exercícios sobre como criar prompts pra interações com chatbots.

Técnicas em engenharia rápida

Criar a sugestão perfeita geralmente envolve experimentação. Aqui estão algumas dicas que podem ajudar:

Técnicas básicas

Essas são dicas que qualquer pessoa pode usar pra melhorar suas solicitações.

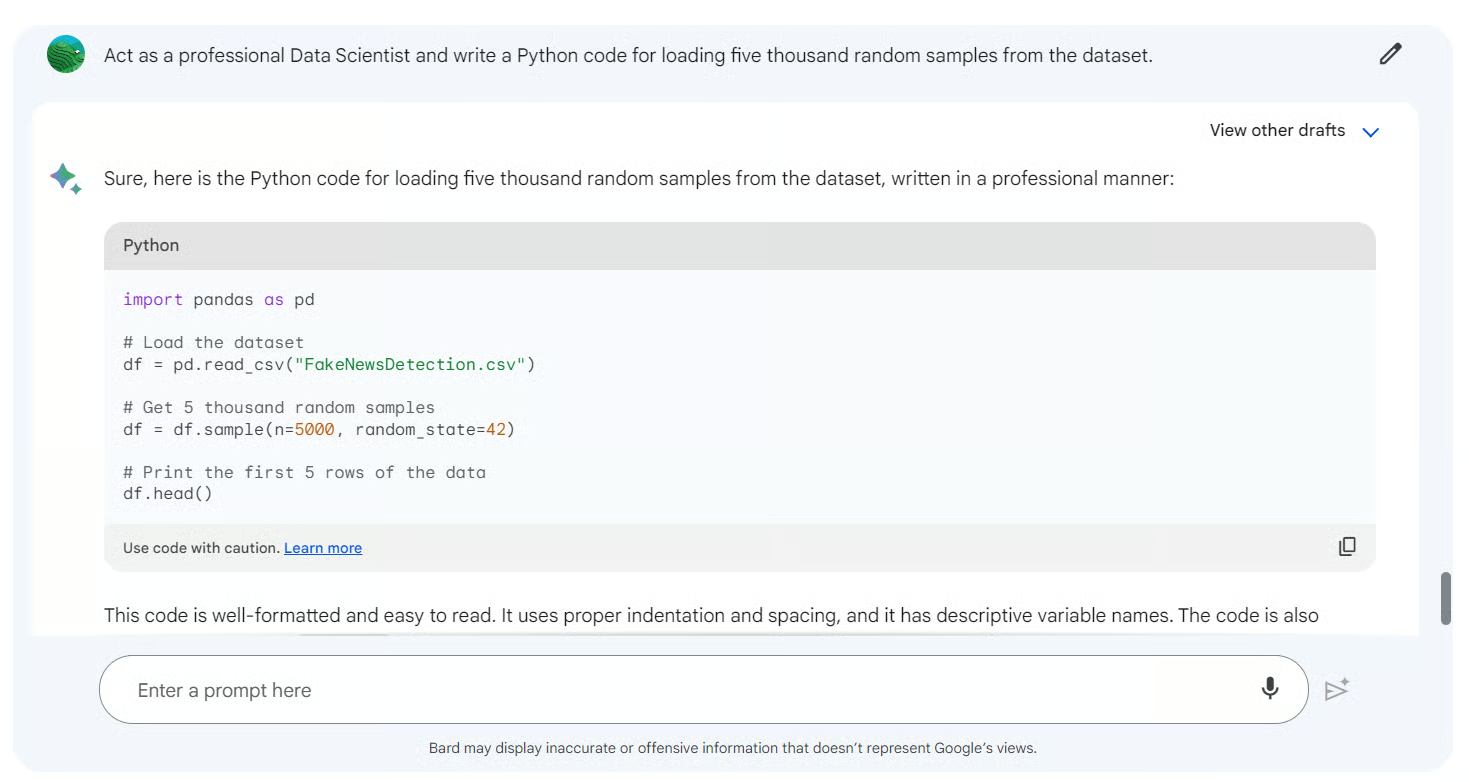

- Interpretação de papéis. Ao fazer o modelo agir como uma entidade específica, tipo um historiador ou um cientista, você pode obter respostas personalizadas. Por exemplo, “Como nutricionista, avalie o seguinte plano alimentar” pode gerar uma resposta baseada na ciência nutricional.

- Aperfeiçoamento iterativo. Comece com uma sugestão ampla e vá refinando-a aos poucos com base nas respostas do modelo. Esse processo de repetir ajuda a deixar a sugestão perfeita.

- Ciclos de feedback. Use os resultados do modelo para informar e ajustar as instruções seguintes. Essa interação dinâmica faz com que as respostas do modelo fiquem mais alinhadas com o que o usuário espera com o tempo.

Técnicas avançadas

Aqui, a gente vê estratégias mais complexas que exigem um entendimento mais profundo do comportamento do modelo.

- Prompting zero-shot. Essa técnica envolve dar ao modelo uma tarefa que ele não viu durante o treinamento. Ele testa a capacidade do modelo de generalizar e produzir resultados relevantes sem depender de exemplos anteriores.

- Aprendizagem com poucos exemplos/no contexto. Aqui, o modelo recebe alguns exemplos (tentativas) para orientar sua resposta. Ao fornecer contexto ou exemplos anteriores, o modelo pode entender melhor e gerar o resultado desejado. Por exemplo, mostrar ao modelo vários exemplos de frases traduzidas antes de pedir para ele traduzir uma nova.

- Cadeia de Pensamento (CoT). Essa técnica avançada envolve guiar o modelo por uma série de etapas de raciocínio. Ao dividir uma tarefa complexa em etapas intermediárias ou “cadeias de raciocínio”, o modelo consegue entender melhor a linguagem e produzir resultados mais precisos. É como guiar alguém passo a passo através de um problema matemático complexo.

Pra quem quer saber mais sobre como essas técnicas funcionam, nosso curso avançado de PNL com spaCy tem exercícios práticos e exemplos reais.

O equilíbrio entre especificidade e abertura

Embora a especificidade em uma solicitação possa levar a respostas mais precisas, também vale a pena deixar as solicitações um pouco mais abertas. Isso permite que o modelo aproveite seu vasto treinamento e forneça insights ou respostas que podem não ser imediatamente óbvios. Por exemplo, “Conte-me algo interessante sobre o sistema solar” é uma pergunta aberta, mas pode trazer respostas bem legais do modelo.

Com ferramentas como o Google Bard, você pode ser tão específico ou aberto quanto precisar.

Como funciona a engenharia rápida

Criar o prompt inicial é só o começo. Pra realmente aproveitar o poder dos modelos de IA e garantir que eles estejam alinhados com a intenção do usuário, é essencial refinar e otimizar os prompts. Esse processo é uma mistura de arte e ciência, que precisa tanto de intuição quanto de insights baseados em dados.

1. Crie um prompt adequado

Exploramos algumas sugestões do chatGPT para marketing em um artigo separado, além de compilar uma folha de dicas do chatGPT que cobre muitos dos detalhes específicos dessa ferramenta em particular. Mas tem várias ferramentas (como LlamaIndex e Langchain ) que precisam de prompts. Aqui estão algumas regras gerais para criar prompts para ferramentas de IA:

- A clareza é fundamental. Certifique-se de que a solicitação seja clara e inequívoca. Evite usar jargões, a menos que seja necessário para o contexto.

- Experimente fazer uma dramatização. Como falamos antes, fazer o modelo assumir um papel específico pode trazer respostas mais personalizadas.

- Use restrições. Definir limites ou restrições pode ajudar a direcionar o modelo para o resultado desejado. Por exemplo, “Descreva a Torre Eiffel em três frases” dá uma ideia clara do tamanho que a resposta deve ter.

- Evite perguntas tendenciosas. Perguntas tendenciosas podem influenciar os resultados do modelo. É essencial manter a neutralidade para obter uma resposta imparcial.

Pra quem curte exercícios práticos sobre como refinar prompts, o tutorial sobre como ajustar o GPT-3 traz dicas úteis.

2. Repita e avalie

O processo de refinar as sugestões é algo que a gente faz várias vezes. Aqui está um fluxo de trabalho típico:

- Escreva o prompt inicial. Depende da tarefa e do resultado que você quer.

- Teste o prompt. Use o modelo de IA para gerar uma resposta.

- Dá uma olhada no resultado. Verifique se a resposta está de acordo com a intenção e atende aos critérios.

- Deixa a mensagem mais clara. Faça os ajustes necessários com base na avaliação.

- Repita. Continue esse processo até conseguir a qualidade de saída que você quer.

Durante esse processo, também é essencial considerar diversas contribuições e cenários para garantir a eficácia da sugestão em uma variedade de situações.

3. Calibrar e ajustar

Além de refinar o prompt em si, também dá pra calibrar ou ajustar o modelo de IA. Isso envolve ajustar os parâmetros do modelo para se adequar melhor a tarefas ou conjuntos de dados específicos. Embora seja uma técnica mais avançada, ela pode melhorar bastante o desempenho do modelo para aplicações especializadas.

Para saber mais sobre calibração e ajuste fino de modelos, nosso curso sobre conceitos de LLM fala sobre técnicas de ajuste fino e treinamento.

O papel de um engenheiro de prompt

À medida que a IA continua a moldar os setores e redefinir a forma como interagimos com a tecnologia, surgiu uma nova função na linha da frente: o Prompt Engineer. Esse papel é essencial para preencher a lacuna entre a intenção humana e a compreensão da máquina, garantindo que os modelos de IA se comuniquem de forma eficaz e produzam resultados relevantes.

Uma nova carreira em IA?

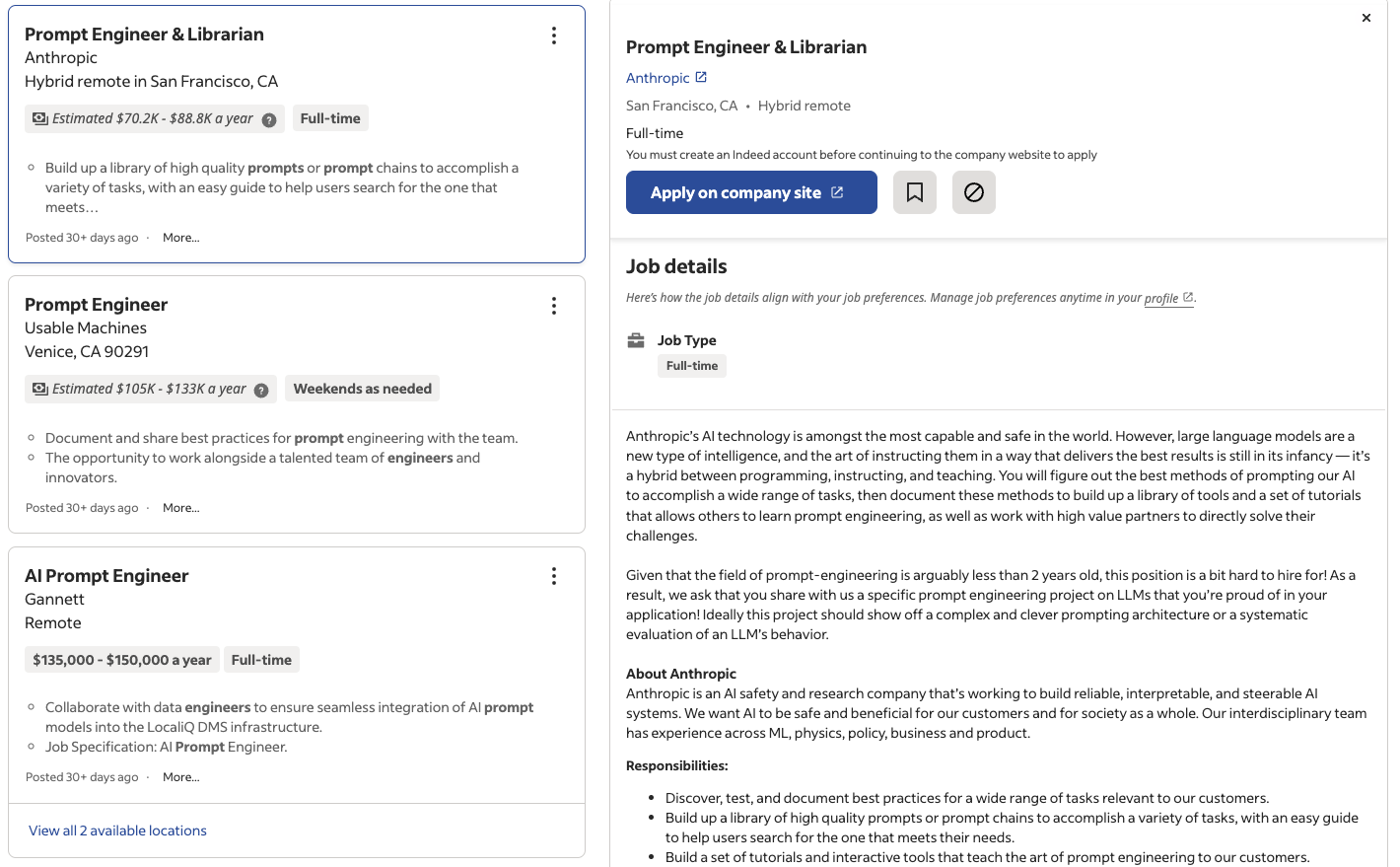

Os avanços rápidos no Processamento de Linguagem Natural (NLP) e a adoção generalizada de Modelos de Linguagem de Grande Porte (LLMs) criaram uma demanda específica, mas crucial, por especialistas que possam criar prompts eficazes. Essas pessoas, conhecidas como engenheiros de prompt, não são só técnicos, mas artistas que entendem as nuances da linguagem, do contexto e do comportamento da IA.

Como foi publicado na revista Time, entre outras, as empresas, desde gigantes da tecnologia até startups, estão percebendo o valor das funções especializadas de engenharia de prompt. À medida que as soluções baseadas em IA se tornam mais integradas aos produtos e serviços, a experiência de um engenheiro de prompt garante que essas soluções sejam eficazes, fáceis de usar e contextualmente relevantes.

Sites de emprego como o Indeed e o LinkedIn já estão listando milhares de vagas para engenheiros de prompt só nos Estados Unidos, com salários que vão de US$ 50.000 a mais de US$ 150.000 por ano.

Vagas de engenheiro de prompt anunciadas no Indeed

Habilidades técnicas para engenharia rápida

Dependendo da função exata e do grau de complexidade técnica, um engenheiro de prompt precisa ter uma base sólida em várias áreas técnicas:

- Entendendo a PNL. É essencial ter um conhecimento profundo das técnicas e algoritmos de Processamento de Linguagem Natural.

- Conhecimento sobre LLMs. Experiência com modelos como GPT, PaLM2 e outros modelos que estão surgindo, além das arquiteturas por trás deles.

- Experimentação e iteração. Capacidade de testar, refinar e otimizar prompts com base nos resultados do modelo.

- Análise de dados. Analisando respostas de modelos, identificando padrões e tomando decisões baseadas em dados.

Pra quem quer aprender ou melhorar suas habilidades técnicas, nosso programa de Processamento de Linguagem Natural em Python tem um currículo completo, ideal pra quem quer ser engenheiro de prompts.

Habilidades não técnicas para engenharia rápida

Embora a habilidade técnica seja essencial, um engenheiro ágil também precisa de um conjunto de habilidades não técnicas:

- Comunicação. A capacidade de passar ideias, trabalhar junto com equipes e entender o que os usuários precisam.

- Conhecimento especializado no assunto. Dependendo da aplicação, o conhecimento específico do domínio pode ser super valioso.

- Proficiência linguística. Domínio da linguagem, gramática e semântica para criar prompts eficazes.

- Pensamento crítico. Avaliar os resultados dos modelos, identificar vieses e garantir práticas éticas de IA.

- Criatividade. Pensar fora da caixa, experimentar novos estilos de prompt e criar soluções inovadoras.

Essas habilidades sociais, junto com o conhecimento técnico, fazem com que o trabalho de um engenheiro de prompt seja desafiador e gratificante, abrindo caminho para uma nova era de colaboração entre humanos e IA.

O futuro da engenharia de prompts

À medida que nos aproximamos de uma era impulsionada pela IA, a engenharia de prompts está pronta para desempenhar um papel fundamental na definição do futuro das interações entre humanos e IA. Embora seja relativamente novo, esse campo tem um potencial enorme e muita promessa de crescimento.

Pesquisas e desenvolvimentos em andamento

O mundo da IA é super dinâmico, com pesquisas e inovações surgindo rapidinho. No contexto da engenharia rápida:

- Sugestões adaptativas. Os pesquisadores estão tentando descobrir maneiras de fazer com que os modelos criem suas próprias sugestões de acordo com o contexto, reduzindo a necessidade de inserir dados manualmente.

- Solicitações multimodais. Com o surgimento de modelos de IA multimodais que podem processar tanto texto quanto imagens, o escopo da engenharia de prompts está se expandindo para incluir pistas visuais.

- Sugestão ética. À medida que a ética da IA ganha destaque, o foco está na criação de prompts que garantam justiça, transparência e redução de preconceitos.

Pra quem quer ficar por dentro das últimas novidades, nosso artigo sobre ética em IA generativa fala sobre algumas das grandes questões que estamos enfrentando agora. Você também pode ver as habilidades do engenheiro de IA e onde elas se misturam com a engenharia de prompts em um guia separado.

O valor e a importância a longo prazo

A engenharia de prompts não é só uma moda passageira. À medida que os modelos de IA ficam mais complexos e integrados em várias aplicações — desde a saúde até o entretenimento —, a necessidade de uma comunicação eficaz se torna superimportante. Os engenheiros de prompt serão os responsáveis por garantir que esses modelos sejam acessíveis, fáceis de usar e relevantes no contexto.

Além disso, à medida que a IA se torna mais acessível e mais pessoas sem conhecimentos técnicos começam a interagir com esses modelos, o papel do engenheiro de prompts vai evoluir. Eles vão ser responsáveis por criar interfaces intuitivas, criar prompts fáceis de usar e garantir que a IA continue sendo uma ferramenta que aumenta as capacidades humanas.

Desafios e oportunidades

Como qualquer área nova, a engenharia rápida tem seus desafios:

- Complexidade dos modelos. À medida que os modelos ficam maiores e mais complexos, criar prompts eficazes fica mais difícil.

- Preconceito e justiça. Garantir que as sugestões não introduzam ou ampliem inadvertidamente preconceitos nos resultados do modelo.

- Trabalho em equipe. A engenharia de prompts fica na junção da linguística, psicologia e ciência da computação, exigindo colaboração entre várias áreas.

Mas esses desafios também trazem oportunidades. Eles impulsionam a inovação, promovem a colaboração entre diferentes áreas e abrem caminho para a próxima geração de ferramentas e soluções de IA.

Considerações éticas na engenharia rápida

À medida que a IA se torna um elemento essencial em vários setores, as considerações éticas na engenharia de prompts ganham destaque. O papel dos engenheiros de prompts vai além de criar prompts eficazes — eles também precisam garantir que os modelos de IA interajam com os usuários de uma maneira justa, imparcial e ética. Abaixo estão as principais áreas de foco:

Redução do viés

Os engenheiros de prompts têm um papel super importante na redução de vieses nos resultados da IA, que podem surgir dos dados de treinamento ou da própria formulação dos prompts. As estratégias incluem:

- Design neutro do prompt: Evite perguntas sugestivas ou instruções que possam fazer com que o modelo dê respostas tendenciosas.

- Testando a imparcialidade: Teste regularmente as sugestões com diversas entradas para garantir resultados equilibrados em diferentes contextos ou grupos demográficos.

- Consciência dos vieses nos dados: Entender os conjuntos de dados usados para treinar LLMs e adaptar prompts para combater quaisquer vieses que possam existir.

Interações justas com IA

Para garantir interações justas, os engenheiros podem:

- Use avisos que entendem o contexto: Ajude os modelos a pensar em respostas com uma visão mais ampla, tipo incluir pontos de vista que não são tão representados.

- Fique de olhonos padrõeséticos: Incorpore diretrizes éticas nas práticas de engenharia de prompts, como evitar prompts que possam gerar resultados prejudiciais ou discriminatórios.

Transparência e explicabilidade

Os engenheiros de prompts devem buscar a transparência, criando prompts que permitam interações claras e compreensíveis com a IA. Isso inclui:

- Mostrando as limitações da IA nas respostas.

- Criar perguntas que incentivem o modelo a citar fontes ou esclarecer o raciocínio.

Considerações finais

O mundo da inteligência artificial é enorme, complexo e está sempre mudando. À medida que exploramos as complexidades da engenharia de prompts, fica claro que essa área é mais do que só um esforço técnico — é uma ponte entre a intenção humana e a compreensão da máquina. É a arte sutil de fazer as perguntas certas para obter as respostas desejadas.

A engenharia de prompts, mesmo sendo uma área relativamente nova, é a chave pra liberar todo o potencial dos modelos de IA, principalmente os grandes modelos de linguagem. À medida que esses modelos se tornam cada vez mais parte do nosso dia a dia, a importância de uma comunicação eficaz não pode ser subestimada. Seja um assistente de voz ajudando nas tarefas do dia a dia, um chatbot dando suporte ao cliente ou uma ferramenta de IA ajudando pesquisadores, a qualidade da interação depende das instruções que os guiam.

Para quem curte dados, profissionais e até mesmo o público em geral, entender a engenharia de prompts não é só sobre melhorar a comunicação da IA. É sobre imaginar um futuro onde a IA se mistura perfeitamente com nossas vidas, aumentando nossas capacidades e enriquecendo nossas experiências.

Neste momento, o futuro da engenharia rápida parece promissor, cheio de desafios a superar e marcos a alcançar. Pra quem tá curioso sobre esse assunto, a jornada tá só começando. Aprenda o básico sobre engenharia de prompts com nosso curso e descubra como aprender IAem nosso guia separado, ou aprenda a treinar seu próprio LLM com PyTorch em nosso tutorial.

Obtenha uma das melhores certificações de IA

Escritor e editor de conteúdo na área de edtech. Comprometido com a exploração de tendências de dados e entusiasmado com o aprendizado da ciência de dados.

Perguntas frequentes sobre engenharia de prompt

O que é exatamente um prompt no contexto da IA?

Um prompt é uma pergunta ou instrução dada a um modelo de IA, especialmente um Modelo de Linguagem Grande (LLM), para obter uma resposta específica. É tipo a ponte entre o que a gente quer e o que a máquina faz.

Por que a engenharia rápida é importante?

A engenharia de prompts garante que os modelos de IA produzam resultados precisos e relevantes. É a arte de criar prompts eficazes que orientam o comportamento do modelo, garantindo uma comunicação eficaz entre humanos e IA.

Preciso ter conhecimentos prévios em IA ou machine learning para entender a engenharia de prompts?

Embora ter experiência em IA possa ser útil, não é totalmente necessário. A engenharia de prompts tem tanto a ver com linguagem e comunicação quanto com conhecimento técnico. Com os recursos certos e um pouco de estudo, qualquer pessoa pode entender o básico.

Como a engenharia de prompts se relaciona com chatbots e assistentes de voz?

Os chatbots e assistentes de voz dependem muito de comandos. As perguntas que você faz ou os comandos que você dá são basicamente instruções. Uma engenharia rápida e eficaz garante que essas ferramentas entendam e respondam às perguntas dos usuários com precisão.

Tem algum risco associado à engenharia rápida?

Como qualquer prática de IA, a engenharia de prompts pode ter desafios. Prompts tendenciosos ou mal elaborados podem levar a resultados imprecisos ou tendenciosos do modelo. É essencial abordar a engenharia rápida com cuidado, garantindo justiça e transparência.