Kurs

In diesem Tutorial zeige ich dir, wie du die DeepSeek API einrichtest und verwendest, damit du sie in deine Projekte integrieren kannst. Du wirst es lernen:

- Verfügbare Modelle: deepseek-chat (V3) & deepseek-reasoner (R1), und wie du über die API auf sie zugreifen kannst.

- Schlüsselparameter: Wie man den Output des Modells kontrolliert und die Preisgestaltung steuert.

- Gedankenkettenpreise: Wie DeepSeek die Kosten basierend auf der Komplexität der Argumentation berechnet.

- Context caching: Ein intelligenter Weg, um die Kosten bei der Nutzung von DeepSeek zu senken.

Am Ende wirst du wissen, wie du DeepSeek nutzen und gleichzeitig die Kosten niedrig halten kannst. Lass uns loslegen!

DeepSeek Modelle

DeepSeek bietet zwei Hauptmodelle, die du über eine API nutzen kannst:

- DeepSeek-V3 (deepseek-chat): Ein generalistisches Modell, das mit einer riesigen Textmenge (15 Billionen Token) trainiert wurde.

- DeepSeek-R1 (deepseek-reasoner): Ein Modell, das für fortgeschrittene Denk-, Mathematik- und Codieraufgaben entwickelt wurde.

Du kannst mehr über den Unterschied zwischen den beiden Modellen in diesem Blog erfahren DeepSeek R1 vs. V3.

KI-Upskilling für Einsteiger

Zugriff auf DeepSeek R1 und V3 über API

So greifst du über die API auf die DeepSeek-Modelle zu:

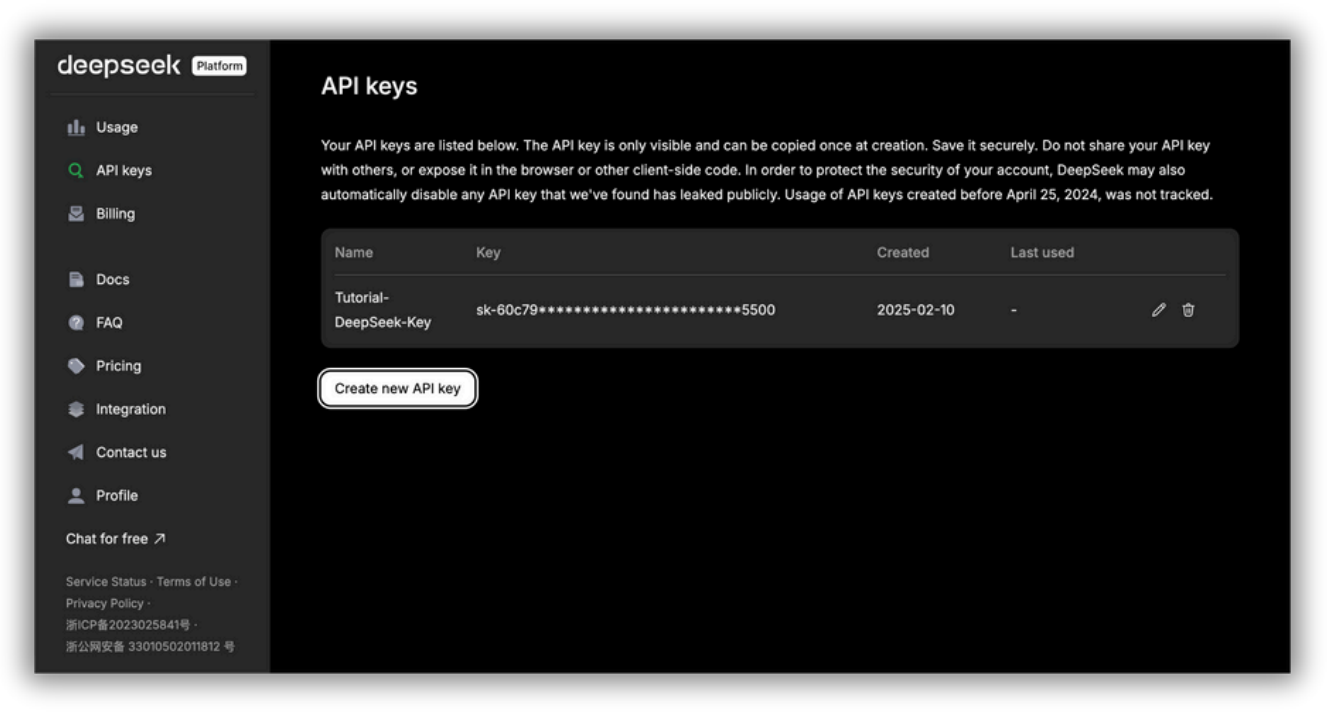

- Hol dir einen API-Schlüssel: Registriere dich auf der DeepSeek API-Plattform und generiere deinen Schlüssel.

- Verwende das OpenAI SDK (Software Development Kit): Richte deinen Code so ein, dass er sich mit den richtigen Einstellungen über das SDK von OpenAI mit der DeepSeek API verbindet. Ein SDK ist eine Sammlung von Tools, Bibliotheken, Dokumentationen und Codebeispielen, die dir helfen, Anwendungen für eine bestimmte Plattform, ein Framework oder eine API zu erstellen. Ein API-SDK (wie das OpenAI SDK) bietet fertige Funktionen, um API-Aufrufe zu vereinfachen, so dass Entwickler nicht alles von Grund auf neu schreiben müssen.

DeepSeek API-Plattform API-Schlüsselverwaltungsseite. Hier kannst du deine API-Schlüssel für den Zugriff auf die KI-Dienste von DeepSeek erstellen und verwalten. Der API-Schlüssel ist nur bei der Erstellung sichtbar und muss sicher aufbewahrt werden; ihn öffentlich zu teilen kann zu Sicherheitsrisiken führen.

Um DeepSeek-V3 zu nutzen, musst du model='deepseek-chat' einstellen und um DeepSeek-R1 zu nutzen, musst du model='deepseek-reasoner' einstellen.

Hier erfährst du, wie du das OpenAI SDK nutzen kannst, um auf die DeepSeek API zuzugreifen:

from openai import OpenAI

client = OpenAI(api_key="<DeepSeek API Key>", base_url="https://api.deepseek.com")

response = client.chat.completions.create(

model="deepseek-chat",

messages=[

{"role": "system", "content": "You are a helpful assistant"},

{"role": "user", "content": "Hello"},

],

stream=False

)

print(response.choices[0].message.content)Schauen wir uns genauer an, was dieses Stück Code macht.

Das Ziel des Codes ist es, eine Chat-Nachricht an das DeepSeek-Modell zu senden und die Antwort des Modells zu drucken.

Zuerst importiert from openai import OpenAI die Klasse OpenAI aus der Bibliothek openai.

Dann erstellt client = OpenAI(...) ein OpenAI Client-Objekt. Dieser Client ist deine Verbindung zur DeepSeek-API. Sie konfiguriert den Client mit deinem API-Schlüssel (Authentifizierung) und gibt die Basis-URL der DeepSeek-API an.

Wichtig! Ersetze <DeepSeek API Key> durch deinen tatsächlichen DeepSeek API Key!

response ist der Teil, der deine Chatnachricht an das DeepSeek-Modell sendet und die Antwort erhält. client.chat.completions.create(...) ruft die DeepSeek-API auf, um eine Antwort vom Modell zu erhalten.

Schauen wir uns messages=[...] an, das ist der Teil, der den Gesprächsverlauf definiert:

- Systemnachricht: {"Rolle": "System", "Inhalt": "Du bist eine hilfreiche Assistentin"}: Damit wird das Verhalten des Modells festgelegt und ihm gesagt, dass es sich wie ein hilfreicher Assistent verhalten soll.

- Benutzernachricht: {"Rolle": "Benutzer", "Inhalt": "Hallo"}: Dies ist die eigentliche Benutzereingabe (dein Prompt), auf die die KI reagieren soll ("Hallo").

Beachte, dass wir in diesem Beispiel DeepSeek-V3 verwenden, da wir model='deepseek-chat’ eingestellt haben, aber denke daran, dass du DeepSeek-R1 verwenden kannst, indem du model='deepseek-reasoner' einstellst.

Der Teil stream=False bedeutet "Gib mir die ganze Antwort auf einmal". Wenn du stream=False einstellst, wartet das Modell, bis es die gesamte Antwort erzeugt hat, bevor es sie zurücksendet. Verwende dies, wenn du die gesamte Antwort auf einmal anzeigen oder analysieren möchtest.

Allerdings musst du bei langen Antworten möglicherweise etwas warten, bis du die Ausgabe erhältst. Wenn du stream=True einstellst, zeigt das Modell die Wörter (bzw. Token) an, während sie generiert werden, sodass du die Antwort in Echtzeit siehst, anstatt auf die vollständige Antwort zu warten.

Zum Schluss extrahiert print(response.choices.message.content) die Antwort des Modells aus dem Response-Objekt und gibt sie auf deiner Konsole aus. Das Antwortobjekt enthält eine Menge Informationen, aber in erster Linie bist du an der Nachricht des Modells interessiert. Die API kann manchmal mehrere mögliche Antworten (Auswahlmöglichkeiten) zurückgeben. Damit wird der erste ausgewählt.

Zum Zeitpunkt der Veröffentlichung dieses Artikels hat DeepSeek die Aufladung von API-Konten mit neuen Geldern pausiert, da die Server kaum noch Ressourcen haben. Das bedeutet, dass du deinem API-Guthaben im Moment kein weiteres Geld hinzufügen kannst. Wenn du bereits über Geldmittel verfügst, kannst du die API trotzdem wie gewohnt nutzen. DeepSeek wird die Aufladungen wahrscheinlich wieder aufnehmen, sobald sie mehr Serverkapazität haben, also halte Ausschau nach Updates!

Verwalten von Parametern zur Kontrolle von Leistung und Preisgestaltung

Das DeepSeek-Team behauptet, seine Modelle seien billiger als die der Konkurrenz. Aber du musst sie trotzdem klug einsetzen, um die Kosten niedrig zu halten und die beste Leistung zu erzielen. Hier sind die wichtigsten Dinge, die du wissen und berücksichtigen musst, wenn du die Modelle von DeepSeek zur Kontrolle der Leistung und Preisgestaltung einsetzt.

Die Wahl des richtigen Modells

Jedes DeepSeek-Modell ist für unterschiedliche Aufgaben konzipiert. Die Wahl des richtigen Produkts kann dir helfen, Kosten und Leistung auf deine Bedürfnisse abzustimmen. Hier ist ein schneller Vergleich:

- deepseek-chat (V3)Billiger, gut für allgemeine Chats und Unterhaltungen.

- deepseek-reasoner (R1) → Teurer, aber großartig für komplexe Schlussfolgerungen und fortgeschrittene Aufgaben.

Token-Kosten

Token sind die kleinste Texteinheit, die das Modell verarbeitet. Das kann ein Wort, eine Zahl oder sogar ein Satzzeichen sein. Die Anzahl der verwendeten Token hängt von der Sprache und der Art und Weise ab, wie das Modell Text verarbeitet.

Hier ist ein allgemeiner Vergleich, wie Zeichen in Token umgewandelt werden:

- 1 englisches Zeichen ≈ 0,3 Token (Ein Satz mit 100 Zeichen würde etwa 30 Token ausmachen).

- 1 chinesisches Zeichen ≈ 0,6 Token (Da chinesische Zeichen mehr Bedeutung pro Zeichen vermitteln).

Um eine genaue Schätzung zu erhalten, überprüfst du am besten die Nutzungsdetails, nachdem du deine Anfrage gestellt hast. Wenn du verstehst, wie Token gezählt werden, kannst du die Kosten besser verwalten und die Leistung bei der Nutzung der DeepSeek-Modelle optimieren.

Hier sind die Preise pro 1 Million Token für jedes der DeepSeek-Modelle (Hinweis: Dies waren die Preise zum Zeitpunkt der Veröffentlichung dieses Artikels - die aktuellsten Kosten findest du hier):

|

Modell |

Kontext Länge |

Max. Kinderbetten-Marken |

Maximale Ausgabe von Token |

1 Mio. Token Eingangspreis (Cache-Treffer) |

1 Mio. Token Eingangspreis (Cache-Miss) |

1 Mio. Token Ausgabepreis |

|

deepseek-chat |

64k |

- |

8k |

$0.07 |

$0.27 |

$1.10 |

|

deepseek-reasoner |

64k |

32k |

8k |

$0.14 |

$0.55 |

$2.19 |

Wie bereits erwähnt, bietet DeepSeek zwei Modelle an, deepseek-chat und deepseek-reasoner. Aber jede hat ihre eigenen Stärken und Kosten. Wenn du weißt, wie sie Informationen verarbeiten und Token berechnen, kannst du sie effizienter nutzen und die Kosten unter Kontrolle halten.

Beide Modelle können bis zu 64.000 Token in einer Konversation verarbeiten, d.h. sie merken sich mehr Kontext für bessere, relevantere Antworten. Allerdings funktionieren sie unterschiedlich.

Der Deepseek-Chat ist für allgemeine Unterhaltungen gedacht und verwendet keine fortgeschrittenen Argumente. Der Deepseek-Reasoner hingegen erlaubt bis zu 32.000 Token für schrittweises Denken (chain-of-thought reasoning - mehr dazu später), bevor er eine endgültige Antwort gibt. Das macht es großartig für die Lösung komplexer Probleme, erhöht aber auch die Anzahl der verwendeten Token, was höhere Kosten bedeutet.

Wenn es um die Länge der Antwort geht, können beide Modelle bis zu 8.000 Token pro Antwort erzeugen. Dieses Limit hilft zu verhindern, dass die Antworten zu lang und teuer werden.

Was die Preise angeht, ist deepseek-chat die budgetfreundlichere Option. Wenn die Eingabe zwischengespeichert wird (d.h. sie wurde schon einmal verwendet), kostet sie 0,07 $ pro Million Token. Für neuen Input steigt der Preis auf 0,27 $ pro Million Token, und der Output kostet 1,10 $ pro Million Token.

Der Deepseek-Reasoner ist teurer, weil er tiefergehende Überlegungen liefert. Zwischengespeicherter Input kostet $0,14 pro Million Token, während neuer Input $0,55 pro Million Token kostet. Mit 2,19 $ pro Million Token ist die Produktion auch teurer, was die Komplexität der Antworten widerspiegelt.

Welches Modell solltest du also verwenden?

Wenn du einfache Chat-Antworten oder schnelle Antworten brauchst, ist deepseek-chat die bessere Wahl, weil es günstiger ist. Wenn du aber detaillierte Schlussfolgerungen ziehen oder komplexe Probleme lösen musst, ist deepseek-reasoner leistungsfähiger - allerdings kostet es mehr.

Um Geld zu sparen, kannst du auch das Caching nutzen. Wenn das Modell eine Eingabe erkennt, die es schon einmal gesehen hat, berechnet es einen niedrigeren Preis. Das ist sehr nützlich bei wiederholten Abfragen oder Gesprächen mit mehreren Personen.

Die DeepSeek-Modelle sind preisgünstig, aber der Tokenverbrauch kann sich schnell summieren. Der beste Weg, die Kosten zu kontrollieren, ist, die Aufforderungen kurz zu halten, wenn möglich Caching zu verwenden und das richtige Modell für die Aufgabe zu wählen. Um mehr zu erfahren, lies diesen Blog über Prompt-Optimierung.

Der Temperaturparameter

Der Temperaturparameter bestimmt, wie zufällig oder vorhersehbar die Antworten des Modells sind. In der Standardeinstellung ist er in DeepSeek auf 1,0 gesetzt, d.h. die Antworten sind ausgewogen zwischen kreativ und deterministisch. Du kannst diese Einstellung jedoch an deine speziellen Bedürfnisse anpassen.

DeepSeek gibt die folgenden Empfehlungen für verschiedene Anwendungsfälle:

|

Anwendungsfall |

Empfohlene Temperatur |

|

Codierung / Mathematik |

0,0 (Deterministisch, präzise) |

|

Datenbereinigung / Datenanalyse |

1,0 (Ausgewogene Antworten) |

|

Allgemeine Konversation |

1.3 (Mehr Vielfalt bei den Antworten) |

|

Übersetzung |

1.3 (Erlaubt Flexibilität bei der Formulierung) |

|

Kreatives Schreiben / Poesie |

1,5 (fördert vielfältige, fantasievolle Arbeit) |

Eine niedrige Temperatur (nahe 0,0) macht das Modell berechenbarer und präziser. Das ist ideal für Aufgaben, die genaue Antworten erfordern, wie Codierung, Mathematik und strukturierte Datenanalyse.

Eine höhere Temperatur (über 1,0) macht das Modell kreativer und abwechslungsreicher und eignet sich für Erzählungen, Gedichte und Übersetzungen, bei denen Flexibilität gefragt ist.

Bei allgemeinen Gesprächen hilft eine Temperatur von etwa 1,3, einen natürlichen und ansprechenden Dialog zu führen, ohne dass er sich zu sehr wiederholt oder zu willkürlich ist.

Während sich die Temperatureinstellung selbst nicht direkt auf die Kosten auswirkt, kann sie indirekt die Anzahl der Ausgabemarken erhöhen:

- Höhere Temperaturen können zu längeren und vielfältigeren Antworten führen, was bedeutet, dass mehr Token erzeugt werden, was wiederum zu höheren Kosten führt.

- Niedrigere Temperaturen führen oft zu kürzeren, direkteren Antworten, was den Tokenverbrauch reduziert und die Kosten senkt.

Antwortformat

Wenn du mit der DeepSeek-API interagierst, kannst du das Format der Antworten steuern, indem du den Parameter response_format angibst. Dies ist besonders nützlich, wenn du mit strukturierten Daten arbeitest, da es hilft, die Konsistenz und Lesbarkeit der Modellausgabe zu gewährleisten.

Um Antworten im JSON-Format zu erhalten, setze:

response_format={'type': 'json_object'}Damit wird das Modell angewiesen, eine strukturierte Ausgabezurückzugeben, damit die Informationen leichter programmatisch verarbeitet werden können. Das JSON-Format wird häufig in Anwendungen verwendet, die strukturierte, maschinenlesbare Antworten erfordern, z. B. bei der Datenextraktion, Automatisierung und API-Integration.

Auch wenn sich die JSON-Formatierung nicht direkt auf die Preisgestaltung auswirkt, kann sie in bestimmten Fällen indirekt die Kosten senken.

- Präzisere Antworten: Da JSON-Antworten einem strukturierten Format folgen, sind sie in der Regel kompakter und verwenden möglicherweise weniger Token als Freitextantworten.

- Verbesserte Genauigkeit: Wenn du ausdrücklich eine strukturierte Ausgabe verlangst, minimierst du das Risiko langer, unnötiger Erklärungen und kannst so die Verwendung von Token kontrollieren.

Die Gedankenkette (CoT) und ihre Kosten verstehen

CoT ist der Denkprozess, den DeepSeek-R1 durchläuft, bevor er eine endgültige Antwort gibt. Das bedeutet, dass das Modell seinen Gedankengang Schritt für Schritt erklärt, bevor es zu einer Schlussfolgerung kommt.

Jeder Token, der für die CoT-Argumentation und die endgültige Antwort verwendet wird, wird mit $2,19 pro Million Token berechnet, da er Teil des Outputs ist. Es ist eine Art Kompromiss: mehr CoT-Token = mehr Kosten, aber auch eine bessere Genauigkeit bei komplexen Aufgaben.

Was kannst du tun, um die Kosten zu kontrollieren, während du CoT nutzt?

- Verwende klare Aufforderungen: Frage nach kurzen, aber effektiven Begründungen anstelle von langatmigen Erklärungen.

- Lernpfad für die Token-Nutzung: Behalte im Auge, wie viele Token CoT im Vergleich zur endgültigen Antwort verwendet.

- Wähle das richtige Modell: Für einfachere Fragen kannst du stattdessen den Deepseek-Chat nutzen, der günstiger ist. In diesem Fall gibt es allerdings keine CoT.

- Verwende das Caching: Wenn ähnliche Fragen wiederholt gestellt werden, kann das Caching die Kosten für die Eingabe von Token reduzieren.

Beispiel: Nicht optimierte Eingabeaufforderung

Um zu veranschaulichen, wie die Chain-of-Thought (CoT)-Ausgabe in DeepSeek-R1 funktioniert und wie sie sich auf die Preisgestaltung auswirkt, betrachten wir ein Beispiel:

from openai import OpenAI

client = OpenAI(

api_key="<Your_DeepSeek_API_Key>",

base_url="https://api.deepseek.com"

)

def generate_response(prompt):

response = client.chat.completions.create(

model="deepseek-reasoner",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": prompt}

],

stream=False

)

return response.choices[0].message.content

# Example usage

prompt = "Calculate the area of a triangle with a base of 6 cm and a height of 4 cm."

result = generate_response(prompt)

print(result)CoT:

Okay, so I need to find the area of a triangle with a base of 6 cm and a height of 4 cm. Hmm, let me remember how to do this. I think the formula for the area of a triangle is something like base multiplied by height divided by two. Wait, is that right? Let me think.

When I was in math class, the teacher mentioned that a triangle is basically half of a parallelogram. So if you have a parallelogram, its area is base times height. If you cut it along the diagonal, you get two triangles. That means each triangle would have half the area of the parallelogram. So yes, the formula should be (base × height) / 2. That makes sense. Let me write that down to visualize it better.

Area = (base × height) / 2

Given the base is 6 cm and the height is 4 cm, I can substitute those values into the formula. Let me plug them in step by step.

First, multiply the base and the height: 6 cm × 4 cm. Let me calculate that. 6 times 4 is 24. So that gives me 24 cm². Now, divide that result by 2. So 24 divided by 2 is 12. Therefore, the area should be 12 cm².

Wait, let me verify that. If the base was 6 and the height 4, multiplying them gives the area of the corresponding parallelogram, which would be 24 cm². Then, since the triangle is half of that, dividing by 2 gives 12 cm². Yes, that seems correct.

Is there another way to check this? Maybe using a different method? Let's see. For a triangle, the area can also be calculated using Heron's formula, but that requires knowing all three sides. Since I only have the base and height, that might not apply here. Alternatively, if it's a right-angled triangle, the area would be (1/2)*base*height, which is the same formula. But even if it's not a right-angled triangle, the formula still applies because the height is given. The height is the perpendicular distance from the base to the opposite vertex, so regardless of the triangle's type, as long as we know the base and the corresponding height, the formula works.

Let me draw a mental picture. Imagine a triangle where the base is 6 cm. The height is 4 cm, which means if I were to drop a perpendicular line from the top vertex to the base, that line would measure 4 cm. So, even if the triangle is slanted, that vertical height is still 4 cm. Multiplying base and height gives the area of the parallelogram, so dividing by two gives the triangle's area.

Another way to think about it: If I have two identical triangles, I can put them together to form a parallelogram. The area of that parallelogram is base times height, so each triangle is half of that. Therefore, the area of one triangle is 1/2 * base * height.

So, plugging the numbers in again: 1/2 * 6 cm * 4 cm. 1/2 of 6 is 3, and 3 times 4 is 12. Yep, 12 cm².

I think that's solid. Let me check with an example. Suppose the base was 2 cm and the height 3 cm. Then the area would be (2*3)/2 = 3 cm². If I draw such a triangle, it should have an area of 3 cm², which seems right. So scaling up, with a base of 6 and height of 4, the area is proportionally larger.

Alternatively, if I consider a rectangle with the same base and height, area would be 6*4=24 cm². The triangle is half of that, so 12 cm². That also checks out.

Wait, but hold on. If the triangle isn't a right triangle, does the formula still hold? Let's think. If I have an obtuse triangle where the height is outside the triangle, does that affect the area? For example, suppose the base is 6 cm, but the height is measured from the base to a vertex that's outside the triangle, making an obtuse triangle. Even in that case, the area is still (base*height)/2. Because the height is the perpendicular distance regardless of where it's located. So even if the triangle is obtuse, the formula remains the same. Therefore, regardless of the triangle type, as long as the height is given, the formula applies.

Therefore, using 6 cm and 4 cm, multiplying them, dividing by two, gives 12 cm². That seems to be the correct answer. I can't see any mistakes in the reasoning.

Let me just recap. The formula for the area of a triangle is 1/2 multiplied by base multiplied by height. Given base = 6 cm, height = 4 cm. Plugging into the formula: 1/2 * 6 * 4 = 12. The units are in centimeters, and since area is in square units, the answer is 12 cm².

Yes, that all lines up. I think I've got it right. The area is 12 square centimeters.Endgültige Antwort:

The area of the triangle is 12 cm².

To calculate the area of a triangle with a base of 6 cm and a height of 4 cm, we use the standard formula:

Area=1/2×base×height

Step-by-Step Calculation

Multiply the base and height: 6 cm×4 cm=24 cm²Divide the result by 2: 24 cm²/ 2=12 cm²Final Answer: 12 cm²

Thus, the area of the triangle is 12 cm².Kostenberechnung

- Verwendete Token = 1165 ungefähr

- Kosten pro Million Token = $2.19

- Konvertiere Token in Millionen: 1165 Token÷1.000.000=0,001165 Millionen Token

- Multipliziere mit den Kosten pro Million Token: 0.001165×2.19=0.002551350.

- Endgültige Kosten ≈ $0,00255 (auf fünf Dezimalstellen gerundet)

Beispiel: Optimierte Eingabeaufforderung

Jetzt wollen wir die Eingabeaufforderung verfeinern und sehen, wie sich die Ausgabe verändert:

Prompt: "Fläche des Dreiecks: Basis 6 cm, Höhe 4 cm. Nur Formel und Ergebnis anzeigen"

CoT:

Okay, so I need to find the area of a triangle with a base of 6 cm and a height of 4 cm. Hmm, let me remember the formula for the area of a triangle. I think it's something like base multiplied by height divided by two. Wait, yeah, right, because a triangle is basically half of a parallelogram, right? So if you have a parallelogram, the area is base times height, and then a triangle would be half of that. So the formula should be (base * height) / 2.

Let me double-check that. Maybe I can visualize a triangle with base 6 and height 4. If I had another identical triangle, I could put them together to form a parallelogram. The base would still be 6, the height would still be 4, so the area of the parallelogram would be 6*4=24. Then the area of one triangle would be half of that, which is 12. So that makes sense.

Alternatively, I remember in school they taught us the formula as A = 1/2 * b * h. So plugging in the values, it should be 1/2 * 6 cm * 4 cm. Let me calculate that. 1/2 of 6 is 3, then 3 times 4 is 12. So the area should be 12 cm².

Wait, but just to be thorough, let me make sure there aren't any other formulas that could apply here. For example, Heron's formula requires the lengths of all three sides, but I only have the base and height here. So Heron's formula isn't necessary. Since we have the base and height given directly, using the standard area formula is the way to go.

Also, units: the base is in centimeters, the height is in centimeters, so when multiplying, the area will be in square centimeters. That checks out.

Another thing to consider: is the height corresponding to the given base? The problem states "base 6 cm, height 4 cm," so yes, they correspond. If the height was relative to a different side, it might complicate things, but here it's specified for the base. So no issues there.

I think that's all. The formula is correct, the calculation seems right. 6 times 4 is 24, divided by 2 is 12. So the area is 12 square centimeters.Endgültige Antwort:

The area of the triangle is calculated using the formula: Area=1/2×base×height

Substituting the given values: Area=1/2×6 cm ×4 cm = 12 cm²

Result: 12 cm²Kostenberechnung

- Verwendete Token = 496 ungefähr

- Kosten pro Million Token = $2.19

- Konvertiere Token in Millionen: 496 Token÷1.000.000=0,000496 Millionen Token

- Multipliziere mit den Kosten pro Million Token: 0.000496×2.19=0.001086240.

- Endgültige Kosten ≈ $0,00109 (gerundet auf fünf Dezimalstellen)

Tabelle für den endgültigen Kostenvergleich

Die folgende Tabelle zeigt, wie sich die Anzahl der verwendeten Token auf die Gesamtkosten eines API-Aufrufs auswirkt:

|

Beispiel |

Verwendete Token |

Kosten (USD) |

|

Nicht optimierte Eingabeaufforderung |

1165 |

$0.00255 |

|

Optimierte Eingabeaufforderung |

496 |

$0.00109 |

Wir haben die Kosten im Vergleich zum Original mit der optimierten Aufforderung um etwa 57 % gesenkt und trotzdem die richtige Antwort erhalten.

Wie du mit DeepSeeks Context Caching Kosten sparen kannst

Aus der Tabelle mit den Preisen, die wir im Abschnitt Token-Kosten gesehen haben, können wir schließen, dass wir durch das Zwischenspeichern etwa 74,07 % der API-Kosten für deepseek-chat und 74,55 % für deepseek-reasoner einsparen, verglichen mit den Kosten für die Verarbeitung neuer (nicht zwischengespeicherter) Eingabe-Token. Das bedeutet, dass durch effektives Caching die Kosten für Input-Token um fast drei Viertel gesenkt werden können.

Sie ist besonders nützlich für lange Prompts, da sie die Wartezeit verkürzt. Außerdem sorgt das System automatisch für die Zwischenspeicherung - du musst deinen Code nicht ändern.

Aber wie funktioniert das Kontext-Caching?

Wenn du eine Anfrage sendest, speichert DeepSeek die Eingabe auf seinen Servern. Wenn du später eine ähnliche Anfrage stellst, ruft das System die gespeicherte Antwort ab, anstatt alles neu zu berechnen. Das macht den Prozess schneller und billiger.

Wann ist Caching am sinnvollsten?

Caching kann in den folgenden Situationen nützlich sein und die Kosten senken:

- Multi-Turn-Gespräche: Chatbots können frühere Antworten wiederverwenden, was die Kosten senken würde.

- Datenanalyse: Wiederholte Abfragen zu denselben Dateien profitieren von zwischengespeicherten Antworten.

- Q&A Assistenten: Lange Anweisungen am Anfang von Gesprächen können zwischengespeichert werden.

- Rollenspiele & interaktive Apps: Charaktereinstellungen und lange Dialoge müssen nicht neu berechnet werden.

- Code-Analyse: Wenn du dieselben Codedateien mehrmals referenzierst, sparst du Token.

- Ein paar Schüsse lernen: Wenn du das Modell mit Beispielen fütterst, kann das Caching Kosten sparen.

Wie man die Kosteneinsparungen maximiert

Um die Kosteneinsparungen zu maximieren, würde ich Folgendes empfehlen:

- Halte wiederverwendeten Text am Anfang: Die API speichert nur den Beginn der Eingaben.

- Verwende ähnliche Eingaben: Vermeide es, die Prompts zu sehr zu verändern, wenn du den Cache treffen willst.

- Design for Repetition: Strukturiere deine Anfragen so, dass du möglichst viele Inhalte aus dem Cache wiederverwendest.

So verfolgst du deine Cache-Nutzung

Um deine Cache-Nutzung mit der DeepSeek-API zu verfolgen, musst du deinen Code nicht ändern. Die Informationen zur Cache-Nutzung sind automatisch in der API-Antwort enthalten. Das Caching-System ist standardmäßig für alle Nutzer aktiviert. Wenn du einen API-Aufruf machst, enthält das Antwortobjekt zwei neue Felder im Abschnitt usage:

prompt_cache_hit_tokens: Anzahl der Eingabe-Token, die aus dem Cache bedient werdenprompt_cache_miss_tokens: Anzahl der nicht im Cache gefundenen Eingabe-Token

Um auf diese Informationen zuzugreifen, musst du das Feld usage in der API-Antwort überprüfen. Hier ist ein Beispiel dafür, wie du auf diese Werte zugreifen kannst:

response = client.chat.completions.create(

model="deepseek-chat",

messages=[

{"role": "user", "content": "You are a helpful assistant."}

]

)

cache_hits = response.usage.prompt_cache_hit_tokens

cache_misses = response.usage.prompt_cache_miss_tokens

print(f"Cache hits: {cache_hits}")

print(f"Cache misses: {cache_misses}")Mit dieser Funktion kannst du überwachen, wie das Caching-System für deinen Anwendungsfall funktioniert.

Das Caching hat jedoch einige Einschränkungen:

- Mindestgröße des Caches: Das System speichert nur Textabschnitte von 64 oder mehr Token. Kürzere Eingaben werden nicht gespeichert.

- Nicht 100% zuverlässig: Das System garantiert nicht, dass jede Anfrage den Cache trifft.

- Der Cache läuft mit der Zeit ab: Wenn sie nicht genutzt werden, werden die zwischengespeicherten Inhalte innerhalb weniger Stunden bis Tage automatisch gelöscht.

Um mehr zu erfahren, lies diesen Blog über Promptes Caching.

Fazit

In diesem Tutorium haben wir gelernt, wie man die DeepSeek-API und ihre beiden Modelle DeepSeek-R1 und V3 verwendet. Wenn du verstehst, wie diese Modelle funktionieren, kannst du intelligente, kosteneffiziente KI-Anwendungen entwickeln.

Behalten Sie die neueste DeepSeek-Dokumentation und Best Practices, um das Beste aus diesen leistungsstarken Modellen herauszuholen.

Viel Spaß beim Codieren!

Ana Rojo Echeburúa ist KI- und Datenspezialistin und hat einen Doktortitel in angewandter Mathematik. Sie liebt es, Daten in verwertbare Erkenntnisse umzuwandeln und hat umfangreiche Erfahrung in der Leitung technischer Teams. Ana arbeitet gerne eng mit ihren Kunden zusammen, um deren Geschäftsprobleme zu lösen und innovative KI-Lösungen zu entwickeln. Sie ist für ihre Problemlösungsfähigkeiten und ihre klare Kommunikation bekannt und hat eine Leidenschaft für KI, insbesondere für generative KI. Ana widmet sich dem kontinuierlichen Lernen und der ethischen KI-Entwicklung sowie der Vereinfachung komplexer Probleme und der Erklärung von Technologien auf verständliche Weise.