Curso

Neste tutorial, mostrarei como configurar e usar a API do DeepSeek para que você possa integrá-la aos seus projetos. Você aprenderá:

- Modelos disponíveisVocê pode encontrar as seguintes informações: deepseek-chat (V3) e deepseek-reasoner (R1), e como acessá-los via API.

- Parâmetros principais: Como controlar a saída do modelo e gerenciar os preços.

- Precificação da cadeia de pensamento: Como o DeepSeek calcula os custos com base na complexidade do raciocínio.

- Cache de contexto: Uma maneira inteligente de reduzir custos ao usar o DeepSeek.

No final, você saberá como usar o DeepSeek e, ao mesmo tempo, manter os custos baixos. Vamos começar!

Modelos DeepSeek

O DeepSeek fornece dois modelos principais que você pode usar por meio de uma API:

- DeepSeek-V3 (deepseek-chat): Um modelo generalista treinado em uma grande quantidade de texto (15 trilhões de tokens).

- DeepSeek-R1 (deepseek-reasoner): Um modelo projetado para tarefas avançadas de raciocínio, matemática e codificação.

Você pode saber mais sobre a diferença entre os dois modelos neste blog sobre DeepSeek R1 vs V3.

Aprimoramento de IA para iniciantes

Como acessar o DeepSeek R1 e V3 via API

Para acessar os modelos do DeepSeek via API:

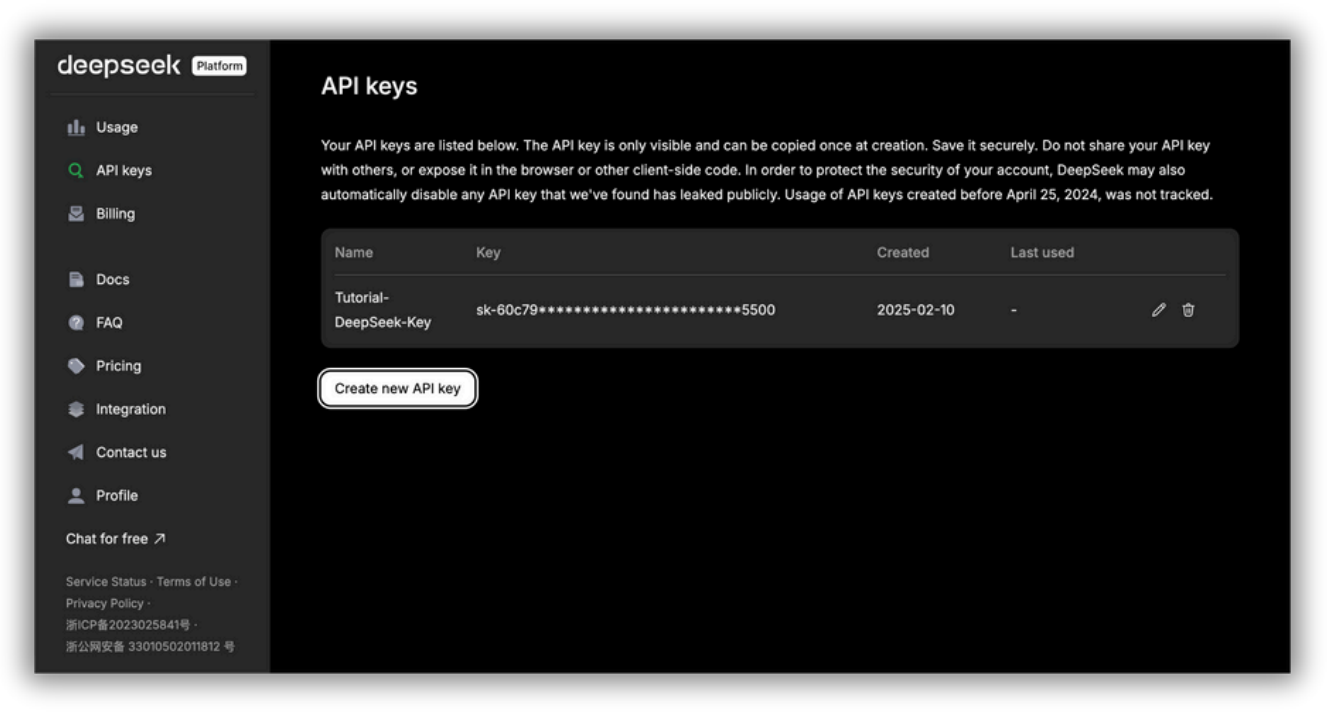

- Obtenha uma chave de API: Registre-se na plataforma DeepSeek API e gere sua chave.

- Use o OpenAI SDK (Kit de desenvolvimento de software): Configure seu código para se conectar à API do DeepSeek usando o SDK da OpenAI com as configurações corretas. Um SDK é uma coleção de ferramentas, bibliotecas, documentação e amostras de código que ajudam você a criar aplicativos para uma plataforma, estrutura ou API específica. Um SDK de API (como o SDK da OpenAI) fornece funções prontas para uso para facilitar as chamadas de API, para que os desenvolvedores não precisem escrever tudo do zero.

Página de gerenciamento de chave de API da plataforma DeepSeek API. Aqui você pode gerar e gerenciar suas chaves de API para acessar os serviços de IA do DeepSeek. A chave da API só é visível na criação e deve ser armazenada com segurança; compartilhá-la publicamente pode levar a riscos de segurança.

Para usar o DeepSeek-V3, você precisará definir model='deepseek-chat' e, para usar o DeepSeek-R1, você precisará definir model='deepseek-reasoner'.

Veja como você pode usar o SDK da OpenAI para acessar a API do DeepSeek:

from openai import OpenAI

client = OpenAI(api_key="<DeepSeek API Key>", base_url="https://api.deepseek.com")

response = client.chat.completions.create(

model="deepseek-chat",

messages=[

{"role": "system", "content": "You are a helpful assistant"},

{"role": "user", "content": "Hello"},

],

stream=False

)

print(response.choices[0].message.content)Vamos dar uma olhada mais de perto no que esse trecho de código faz.

O objetivo do código é enviar uma mensagem de bate-papo para o modelo DeepSeek e imprimir a resposta do modelo.

Primeiro, o site from openai import OpenAI importa a classe OpenAI da biblioteca openai.

Em seguida, client = OpenAI(...) cria um objeto cliente OpenAI. Esse cliente é a sua conexão com a API do DeepSeek. Ele configura o cliente com sua chave de API (autenticação) e especifica o URL de base da API do DeepSeek.

Importante: Substitua <Chave da API do DeepSeek> por sua chave real da API do DeepSeek!

O response é a parte que envia sua mensagem de bate-papo para o modelo do DeepSeek e obtém a resposta. O client.chat.completions.create(...) está chamando a API do DeepSeek para obter uma resposta do modelo.

Vamos dar uma olhada em messages=[...], que é a parte que define o histórico da conversa:

- Mensagem do sistema: {"role": "system", "content": "Você é um assistente útil"}: Isso define o comportamento do modelo, dizendo a ele para agir como um assistente útil.

- Mensagem do usuário: {"role": "user", "content": "Olá"}: Essa é a entrada real do usuário (seu prompt) à qual a IA deve responder ("Hello").

Observe que, neste exemplo, estamos usando o DeepSeek-V3, pois definimos model='deepseek-chat’, mas lembre-se de que você pode usar o DeepSeek-R1 definindo model='deepseek-reasoner'.

A parte stream=False significa "Dê-me a resposta completa de uma vez". Basicamente, quando você define stream=False, o modelo aguarda até que tenha gerado toda a resposta antes de enviá-la de volta. Use essa opção se você quiser exibir ou analisar a resposta completa de uma só vez.

No entanto, talvez você tenha que esperar um pouco por respostas longas antes de receber a saída. Se você definir stream=True, o modelo mostrará palavras (bem, tokens) à medida que forem geradas, para que você veja a resposta em tempo real em vez de esperar pela resposta completa.

Por fim, o site print(response.choices.message.content) extrai a resposta do modelo do objeto de resposta e a imprime no console. O objeto de resposta contém muitas informações, mas o que mais interessa a você é a mensagem do modelo. Às vezes, a API pode retornar várias respostas possíveis (opções). Isso seleciona o primeiro.

No momento da publicação deste artigo, a DeepSeek interrompeu a adição de novos fundos às contas da API porque seus servidores estão com poucos recursos. Isso significa que você não pode adicionar mais dinheiro ao seu saldo de API neste momento. Se já tiver fundos, você ainda poderá usar a API normalmente. O DeepSeek provavelmente retomará as recargas assim que tiver mais capacidade de servidor, portanto, fique de olho nas atualizações!

Gerenciamento de parâmetros para controlar a produção e o preço

A equipe do DeepSeek afirma que seus modelos são mais baratos que os da concorrência. Mas você ainda precisa usá-lo com sabedoria para manter os custos baixos e obter o melhor desempenho. Aqui estão as principais coisas que você deve saber e levar em consideração ao usar os modelos do DeepSeek para controlar a produção e o preço.

Escolhendo o modelo certo

Cada modelo do DeepSeek é projetado para tarefas diferentes. Escolher a opção certa pode ajudar você a equilibrar custo e desempenho com base em suas necessidades. Aqui está uma comparação rápida:

- deepseek-chat (V3)Mais barato, bom para bate-papo e conversas em geral.

- deepseek-reasoner (R1) → Mais caro, mas ótimo para raciocínio complexo e tarefas avançadas.

Custos de token

Os tokens são a menor unidade de texto que o modelo processa, que pode ser uma palavra, um número ou até mesmo um sinal de pontuação. O número de tokens usados depende do idioma e da maneira como o modelo processa o texto.

Aqui está uma comparação geral de como os caracteres são convertidos em tokens:

- 1 caractere inglês ≈ 0,3 tokens (Uma frase de 100 caracteres teria cerca de 30 tokens).

- 1 caractere chinês ≈ 0,6 tokens (Como os caracteres chineses transmitem mais significado por caractere).

Para obter uma estimativa precisa, é melhor verificar os detalhes de uso depois de executar sua solicitação. Se você entender como os tokens são contados, poderá gerenciar melhor os custos e otimizar o desempenho ao usar os modelos do DeepSeek.

Aqui estão os preços por 1 milhão de tokens para cada um dos modelos do DeepSeek (observação: esses eram os preços no momento da publicação deste artigo - verifique os custos mais recentes) aqui):

|

Modelo |

Comprimento do contexto |

Máximo de tokens de berço |

Máximo de tokens de saída |

Preço de entrada de 1 milhão de tokens (acerto no cache) |

Preço de entrada de 1 milhão de tokens (falha de cache) |

Preço de saída de 1 milhão de tokens |

|

deepseek-chat |

64k |

- |

8k |

$0.07 |

$0.27 |

$1.10 |

|

deepseek-reasoner |

64k |

32k |

8k |

$0.14 |

$0.55 |

$2.19 |

Como mencionado anteriormente, o DeepSeek oferece dois modelos, o deepseek-chat e o deepseek-reasoner. Mas cada um deles tem diferentes pontos fortes e custos. Saber como eles processam as informações e cobram pelos tokens pode ajudar você a usá-los com mais eficiência e a manter os custos sob controle.

Ambos os modelos podem lidar com até 64.000 tokens em uma conversa, o que significa que eles se lembram de mais contexto para obter respostas melhores e mais relevantes. No entanto, eles funcionam de forma diferente.

O Deepseek-chat foi projetado para conversas gerais e não usa raciocínio avançado. O Deepseek-reasoner, por outro lado, permite até 32.000 tokens para pensar passo a passo (raciocínio em cadeia - falaremos mais sobre isso daqui a pouco) antes de dar uma resposta final. Isso o torna excelente para resolver problemas complexos, mas também aumenta o número de tokens usados, o que significa custos mais altos.

Quando se trata do tamanho da resposta, ambos os modelos podem gerar até 8.000 tokens por resposta. Esse limite ajuda a evitar que as respostas fiquem muito longas e caras.

Analisando os preços, o deepseek-chat é a opção mais econômica. Se a entrada for armazenada em cache (o que significa que já foi usada antes), ela custará US$ 0,07 por milhão de tokens. Para novas entradas, o preço sobe para US$ 0,27 por milhão de tokens, e a saída custa US$ 1,10 por milhão de tokens.

O Deepseek-reasoner é mais caro porque oferece um raciocínio mais profundo. A entrada em cache custa US$ 0,14 por milhão de tokens, enquanto a nova entrada custa US$ 0,55 por milhão de tokens. Sua produção também é mais cara, com US$ 2,19 por milhão de tokens, refletindo a complexidade das respostas que gera.

Então, qual modelo você deve usar?

Se você precisar de respostas simples de bate-papo ou respostas rápidas, o deepseek-chat é a melhor opção porque é mais barato. Mas se você precisar de raciocínio detalhado ou de solução de problemas complexos, o deepseek-reasoner é mais avançado, embora custe mais.

Para economizar dinheiro, você também pode usar o cache. Quando o modelo reconhece uma entrada que já viu antes, ele cobra uma taxa mais baixa. Isso é realmente útil para consultas repetidas ou conversas com vários turnos.

Os modelos DeepSeek têm preços competitivos, mas o uso de tokens pode aumentar rapidamente. A melhor maneira de gerenciar os custos é manter os prompts curtos, usar o cache quando possível e escolher o modelo certo para o trabalho. Para saber mais, leia este blog sobre otimização imediata.

O parâmetro de temperatura

O parâmetro de temperatura controla o grau de aleatoriedade ou previsibilidade das respostas do modelo. Por padrão, no DeepSeek, ele é definido como 1,0, o que significa que as respostas são equilibradas entre serem criativas e determinísticas. No entanto, você pode ajustar essa configuração de acordo com suas necessidades específicas.

O DeepSeek fornece as seguintes recomendações para diferentes casos de uso:

|

Caso de uso |

Temperatura recomendada |

|

Codificação / Matemática |

0,0 (determinístico, preciso) |

|

Limpeza de dados / análise de dados |

1,0 (respostas equilibradas) |

|

Conversa geral |

1,3 (Mais variedade nas respostas) |

|

Tradução |

1.3 (Permite flexibilidade na redação) |

|

Escrita criativa / Poesia |

1,5 (Incentiva a produção diversificada e criativa) |

Uma temperatura baixa (próxima a 0,0) torna o modelo mais previsível e preciso. Isso é ótimo para tarefas que exigem respostas precisas, como codificação, matemática e análise de dados estruturados.

Uma temperatura mais alta (acima de 1,0) torna o modelo mais criativo e variado, adequado para narração de histórias, poesia e traduções em que a flexibilidade é necessária.

Para conversas gerais, uma temperatura em torno de 1,3 ajuda a produzir um diálogo natural e envolvente sem ser muito repetitivo ou excessivamente aleatório.

Embora a configuração de temperatura em si não afete diretamente os custos, ela pode aumentar indiretamente o número de tokens de saída:

- Temperaturas mais altas podem resultar em respostas mais longas e variadas, o que significa que mais tokens são gerados - o que leva a custos mais altos.

- Temperaturas mais baixas geralmente resultam em respostas mais curtas e diretas, o que reduz o uso de tokens e mantém os custos mais baixos.

Formato da resposta

Ao interagir com a API do DeepSeek, você pode controlar o formato das respostas especificando o parâmetro response_format. Isso é especialmente útil quando você trabalha com dados estruturados, pois ajuda a garantir a consistência e a legibilidade do resultado do modelo.

Para receber respostas no formato JSON, defina:

response_format={'type': 'json_object'}Isso diz ao modelo para retornar saída estruturadafacilitando o processamento das informações de forma programática. O formato JSON é comumente usado em aplicativos que exigem respostas estruturadas e legíveis por máquina, como extração de dados, automação e integrações de API.

Embora a formatação JSON não afete diretamente o preço, ela pode reduzir indiretamente os custos em determinados casos.

- Respostas mais concisas: Como as respostas JSON seguem um formato estruturado, elas tendem a ser mais compactas, podendo usar menos tokens do que as respostas de texto livre.

- Precisão aprimorada: Se você solicitar explicitamente uma saída estruturada, minimizará o risco de explicações longas e desnecessárias, ajudando a controlar o uso de tokens.

Entendendo a cadeia de pensamento (CoT) e seus custos

CoT é o processo de raciocínio pelo qual o DeepSeek-R1 passa antes de dar uma resposta final. Isso significa que o modelo explica seu processo de pensamento passo a passo antes de chegar a uma conclusão.

Cada token usado no raciocínio da CoT e na resposta final é cobrado a US$ 2,19 por milhão de tokens, pois faz parte do resultado. É um pouco como uma troca; mais tokens CoT = mais custo, mas também melhor precisão em tarefas complexas.

O que você pode fazer para controlar os custos ao usar a CoT?

- Use prompts claros: Peça um raciocínio curto, mas eficaz, em vez de explicações longas.

- Rastreie o uso de tokens: Fique de olho em quantos tokens o CoT usa em comparação com a resposta final.

- Escolha o modelo certo: Para perguntas mais simples, considere usar o deepseek-chat, que é mais barato. No entanto, nesse caso, não há CoT.

- Use o cache: Se você fizer perguntas semelhantes repetidamente, o armazenamento em cache pode reduzir os custos do token de entrada.

Exemplo: Prompt não otimizado

Para ilustrar como a saída Chain-of-Thought (CoT) funciona no DeepSeek-R1 e seu impacto no preço, vamos considerar um exemplo:

from openai import OpenAI

client = OpenAI(

api_key="<Your_DeepSeek_API_Key>",

base_url="https://api.deepseek.com"

)

def generate_response(prompt):

response = client.chat.completions.create(

model="deepseek-reasoner",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": prompt}

],

stream=False

)

return response.choices[0].message.content

# Example usage

prompt = "Calculate the area of a triangle with a base of 6 cm and a height of 4 cm."

result = generate_response(prompt)

print(result)CoT:

Okay, so I need to find the area of a triangle with a base of 6 cm and a height of 4 cm. Hmm, let me remember how to do this. I think the formula for the area of a triangle is something like base multiplied by height divided by two. Wait, is that right? Let me think.

When I was in math class, the teacher mentioned that a triangle is basically half of a parallelogram. So if you have a parallelogram, its area is base times height. If you cut it along the diagonal, you get two triangles. That means each triangle would have half the area of the parallelogram. So yes, the formula should be (base × height) / 2. That makes sense. Let me write that down to visualize it better.

Area = (base × height) / 2

Given the base is 6 cm and the height is 4 cm, I can substitute those values into the formula. Let me plug them in step by step.

First, multiply the base and the height: 6 cm × 4 cm. Let me calculate that. 6 times 4 is 24. So that gives me 24 cm². Now, divide that result by 2. So 24 divided by 2 is 12. Therefore, the area should be 12 cm².

Wait, let me verify that. If the base was 6 and the height 4, multiplying them gives the area of the corresponding parallelogram, which would be 24 cm². Then, since the triangle is half of that, dividing by 2 gives 12 cm². Yes, that seems correct.

Is there another way to check this? Maybe using a different method? Let's see. For a triangle, the area can also be calculated using Heron's formula, but that requires knowing all three sides. Since I only have the base and height, that might not apply here. Alternatively, if it's a right-angled triangle, the area would be (1/2)*base*height, which is the same formula. But even if it's not a right-angled triangle, the formula still applies because the height is given. The height is the perpendicular distance from the base to the opposite vertex, so regardless of the triangle's type, as long as we know the base and the corresponding height, the formula works.

Let me draw a mental picture. Imagine a triangle where the base is 6 cm. The height is 4 cm, which means if I were to drop a perpendicular line from the top vertex to the base, that line would measure 4 cm. So, even if the triangle is slanted, that vertical height is still 4 cm. Multiplying base and height gives the area of the parallelogram, so dividing by two gives the triangle's area.

Another way to think about it: If I have two identical triangles, I can put them together to form a parallelogram. The area of that parallelogram is base times height, so each triangle is half of that. Therefore, the area of one triangle is 1/2 * base * height.

So, plugging the numbers in again: 1/2 * 6 cm * 4 cm. 1/2 of 6 is 3, and 3 times 4 is 12. Yep, 12 cm².

I think that's solid. Let me check with an example. Suppose the base was 2 cm and the height 3 cm. Then the area would be (2*3)/2 = 3 cm². If I draw such a triangle, it should have an area of 3 cm², which seems right. So scaling up, with a base of 6 and height of 4, the area is proportionally larger.

Alternatively, if I consider a rectangle with the same base and height, area would be 6*4=24 cm². The triangle is half of that, so 12 cm². That also checks out.

Wait, but hold on. If the triangle isn't a right triangle, does the formula still hold? Let's think. If I have an obtuse triangle where the height is outside the triangle, does that affect the area? For example, suppose the base is 6 cm, but the height is measured from the base to a vertex that's outside the triangle, making an obtuse triangle. Even in that case, the area is still (base*height)/2. Because the height is the perpendicular distance regardless of where it's located. So even if the triangle is obtuse, the formula remains the same. Therefore, regardless of the triangle type, as long as the height is given, the formula applies.

Therefore, using 6 cm and 4 cm, multiplying them, dividing by two, gives 12 cm². That seems to be the correct answer. I can't see any mistakes in the reasoning.

Let me just recap. The formula for the area of a triangle is 1/2 multiplied by base multiplied by height. Given base = 6 cm, height = 4 cm. Plugging into the formula: 1/2 * 6 * 4 = 12. The units are in centimeters, and since area is in square units, the answer is 12 cm².

Yes, that all lines up. I think I've got it right. The area is 12 square centimeters.Resposta final:

The area of the triangle is 12 cm².

To calculate the area of a triangle with a base of 6 cm and a height of 4 cm, we use the standard formula:

Area=1/2×base×height

Step-by-Step Calculation

Multiply the base and height: 6 cm×4 cm=24 cm²Divide the result by 2: 24 cm²/ 2=12 cm²Final Answer: 12 cm²

Thus, the area of the triangle is 12 cm².Cálculo de custos

- Tokens usados = 1165 aproximadamente

- Custo por milhão de tokens = $2.19

- Converta tokens em milhões: 1165 tokens÷1.000.000=0,001165 milhões de tokens

- Multiplique pelo custo por milhão de tokens: 0.001165×2.19=0.002551350.

- Custo final ≈ US$ 0,00255 (arredondado para cinco casas decimais)

Exemplo: Aviso otimizado

Agora, vamos refinar o prompt e ver como o resultado muda:

Prompt: "Área do triângulo: base 6cm, altura 4cm. Mostrar somente a fórmula e o resultado"

CoT:

Okay, so I need to find the area of a triangle with a base of 6 cm and a height of 4 cm. Hmm, let me remember the formula for the area of a triangle. I think it's something like base multiplied by height divided by two. Wait, yeah, right, because a triangle is basically half of a parallelogram, right? So if you have a parallelogram, the area is base times height, and then a triangle would be half of that. So the formula should be (base * height) / 2.

Let me double-check that. Maybe I can visualize a triangle with base 6 and height 4. If I had another identical triangle, I could put them together to form a parallelogram. The base would still be 6, the height would still be 4, so the area of the parallelogram would be 6*4=24. Then the area of one triangle would be half of that, which is 12. So that makes sense.

Alternatively, I remember in school they taught us the formula as A = 1/2 * b * h. So plugging in the values, it should be 1/2 * 6 cm * 4 cm. Let me calculate that. 1/2 of 6 is 3, then 3 times 4 is 12. So the area should be 12 cm².

Wait, but just to be thorough, let me make sure there aren't any other formulas that could apply here. For example, Heron's formula requires the lengths of all three sides, but I only have the base and height here. So Heron's formula isn't necessary. Since we have the base and height given directly, using the standard area formula is the way to go.

Also, units: the base is in centimeters, the height is in centimeters, so when multiplying, the area will be in square centimeters. That checks out.

Another thing to consider: is the height corresponding to the given base? The problem states "base 6 cm, height 4 cm," so yes, they correspond. If the height was relative to a different side, it might complicate things, but here it's specified for the base. So no issues there.

I think that's all. The formula is correct, the calculation seems right. 6 times 4 is 24, divided by 2 is 12. So the area is 12 square centimeters.Resposta final:

The area of the triangle is calculated using the formula: Area=1/2×base×height

Substituting the given values: Area=1/2×6 cm ×4 cm = 12 cm²

Result: 12 cm²Cálculo de custos

- Tokens usados = 496 aproximadamente

- Custo por milhão de tokens = $2.19

- Converta tokens em milhões: 496 tokens÷1.000.000=0,000496 milhões de tokens

- Multiplique pelo custo por milhão de tokens: 0.000496×2.19=0.001086240.

- Custo final ≈ US$ 0,00109 (arredondado para cinco casas decimais)

Tabela de comparação de custos finais

A tabela abaixo mostra como o número de tokens usados afeta o custo total de uma chamada de API:

|

Exemplo |

Tokens usados |

Custo (USD) |

|

Prompt não otimizado |

1165 |

$0.00255 |

|

Aviso otimizado |

496 |

$0.00109 |

Reduzimos os custos em cerca de 57% em comparação com o original com o prompt otimizado, sem deixar de obter a resposta correta.

Como usar o cache de contexto do DeepSeek para reduzir custos

Com base na tabela de preços que vimos na seção Custos de token, podemos concluir que o armazenamento em cache nos economiza cerca de 74,07% em custos de API para o deepseek-chat e 74,55% para o deepseek-reasoner quando comparado ao custo de processamento de novos tokens de entrada (sem armazenamento em cache). Isso significa que o uso eficaz do cache pode reduzir os custos de token de entrada em quase três quartos.

É especialmente útil para prompts longos, pois reduz o tempo de espera. Além disso, o sistema lida automaticamente com o armazenamento em cache - não é necessário alterar seu código.

Mas como funciona o cache de contexto?

Quando você envia uma solicitação, o DeepSeek armazena a entrada em seus servidores. Se você enviar uma solicitação semelhante posteriormente, o sistema recuperará a resposta armazenada em vez de recalcular tudo. Isso torna o processo mais rápido e econômico.

Quando o armazenamento em cache é mais útil?

O armazenamento em cache pode ser útil e reduzir os custos nas seguintes situações:

- Conversas em vários turnos: Os chatbots podem reutilizar respostas anteriores, o que reduziria os custos.

- Análise de dados: Consultas repetidas nos mesmos arquivos se beneficiam das respostas em cache.

- Assistentes de perguntas e respostas: Instruções longas no início das conversas podem ser armazenadas em cache.

- Aplicativos interativos e de interpretação de papéis: As configurações dos personagens e os diálogos longos não precisam ser recalculados.

- Análise de código: A referência aos mesmos arquivos de código várias vezes economiza tokens.

- Aprendizagem com poucos disparos: Se você estiver alimentando o modelo com exemplos, o armazenamento em cache pode reduzir os custos.

Como maximizar a economia de custos

Para maximizar a economia de custos, é isso que eu recomendo:

- Mantenha o texto reutilizado no início: A API armazena em cache apenas o início das entradas.

- Use entradas semelhantes: Evite alterar muito os prompts se você quiser atingir o cache.

- Design for Repetition: Estruture suas solicitações para reutilizar o máximo possível de conteúdo em cache.

Como monitorar o uso do cache

Para rastrear o uso do cache com a API do DeepSeek, você não precisa modificar seu código. As informações de uso do cache são incluídas automaticamente na resposta da API. O sistema de cache é ativado por padrão para todos os usuários. Quando você fizer uma chamada de API, o objeto de resposta incluirá dois novos campos na seção usage:

prompt_cache_hit_tokens: Número de tokens de entrada fornecidos pelo cacheprompt_cache_miss_tokens: Número de tokens de entrada não encontrados no cache

Para acessar essas informações, você precisa verificar o campo usage na resposta da API. Aqui está um exemplo de como você pode acessar esses valores:

response = client.chat.completions.create(

model="deepseek-chat",

messages=[

{"role": "user", "content": "You are a helpful assistant."}

]

)

cache_hits = response.usage.prompt_cache_hit_tokens

cache_misses = response.usage.prompt_cache_miss_tokens

print(f"Cache hits: {cache_hits}")

print(f"Cache misses: {cache_misses}")Esse recurso permite que você monitore como o sistema de cache funciona para o seu caso de uso.

No entanto, o armazenamento em cache tem algumas limitações:

- Tamanho mínimo do cache: O sistema armazena em cache apenas pedaços de texto com 64 tokens ou mais. Entradas mais curtas não serão armazenadas.

- Não é 100% confiável: O sistema não garante que todas as solicitações chegarão ao cache.

- O cache expira ao longo do tempo: Se não for usado, o conteúdo armazenado em cache será automaticamente apagado em algumas horas ou dias.

Para saber mais, leia este blog sobre cache imediato.

Conclusão

Neste tutorial, aprendemos a usar a API DeepSeek e seus dois modelos, DeepSeek-R1 e V3. Se você entender como esses modelos funcionam, poderá criar aplicativos de IA inteligentes e econômicos.

Fique de olho na documentação mais recente do documentação do DeepSeek e nas práticas recomendadas para que você aproveite ao máximo esses modelos avançados.

Boa codificação!

Ana Rojo Echeburúa é especialista em IA e dados, com doutorado em Matemática Aplicada. Ela adora transformar dados em insights acionáveis e tem ampla experiência na liderança de equipes técnicas. Ana gosta de trabalhar em estreita colaboração com os clientes para resolver seus problemas de negócios e criar soluções inovadoras de IA. Conhecida por suas habilidades de resolução de problemas e comunicação clara, ela é apaixonada por IA, especialmente IA generativa. Ana se dedica ao aprendizado contínuo e ao desenvolvimento ético de IA, além de simplificar problemas complexos e explicar a tecnologia de forma acessível.