Lernpfad

GPT-4.5 bietet eine verbesserte Kontexterkennung, Tonhöhenanpassung und Zusammenfassungen, was es zu einer guten Wahl für Chatbots, Schreibwerkzeuge, Automatisierung des Kundensupports und Bildungsanwendungen macht.

In diesem Tutorial gebe ich dir eine Schritt-für-Schritt-Anleitung zur Verwendung von GPT-4.5 über die OpenAI-API. Wir werden herausfinden, wie wir mit Python und der API von GPT 4.5 einen Chatbot bauen können, der es uns ermöglicht, mit GPT 4.5 zu einem Bruchteil der monatlichen Abonnementkosten zu chatten.

Arbeiten mit der OpenAI API

Was ist GPT 4.5?

GPT-4.5 ist OpenAIs neuestes Sprachmodell, das entwickelt wurde, um die Konversationsfähigkeit, das Kontextbewusstsein und die sachliche Genauigkeit zu verbessern. Es baut auf den Vorgängermodellen auf und bietet natürlichere Reaktionen, eine bessere Tonanpassung und weniger HalluzinationenDadurch eignet er sich gut für Anwendungen wie Chatbots, Inhaltserstellung und Aufgabenautomatisierung.

Im Gegensatz zu den Modellen der o-Serie von OpenAI verlässt sich GPT-4.5 jedoch nicht auf schrittweises Denken, sodass es nicht die beste Wahl für komplexe Problemlösungen in Bereichen wie Mathematik oder Programmieren ist. Wenn du ein Argumentationsmodell für deine Anwendung brauchst, kannst du dieses Tutorial lesen OpenAI O1 API.

Für einen tieferen Einblick in die Stärken, Grenzen und Benchmark-Vergleiche von GPT-4.5, schau dir unseren vollständigen Bericht über GPT-4.5.

GPT-4.5 API: Wie man sich mit der API von OpenAI verbindet

In diesem Abschnitt gehen wir die Schritte zur Verbindung mit der OpenAI API durch, einschließlich der Erstellung eines API-Schlüssels und der Einrichtung deiner Python-Umgebung.

Einen API-Schlüssel erstellen

Um die OpenAI API zu nutzen, müssen wir einen API-Schlüssel erstellen. Dieser Schlüssel wird verwendet, um unseren Python-Client bei der API zu authentifizieren.

1. Navigieren Sie zu der OpenAI API Schlüssel Seite.

2. Du musst dich anmelden oder ein OpenAI-Konto erstellen, wenn du noch keins hast.

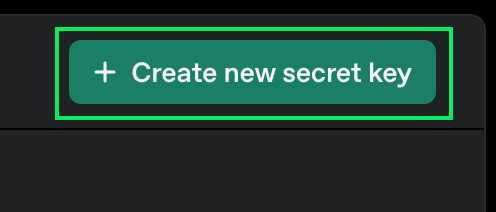

3. Klicke auf die Schaltfläche "Neuencretschlüssel erstellen".

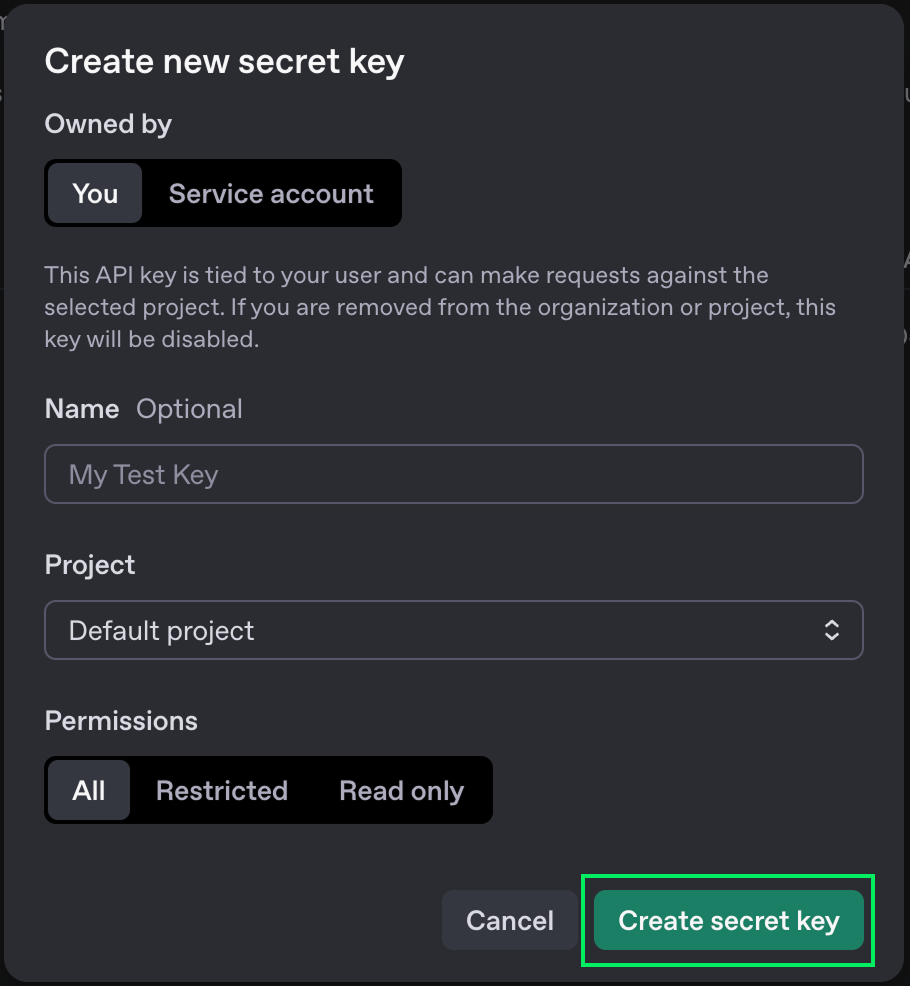

4. Du kannst einen Namen dafür wählen, aber es ist in Ordnung, die Standardoptionen zu belassen.

5. Klicke auf die Schaltfläche "Geheimschlüssel erstellen".

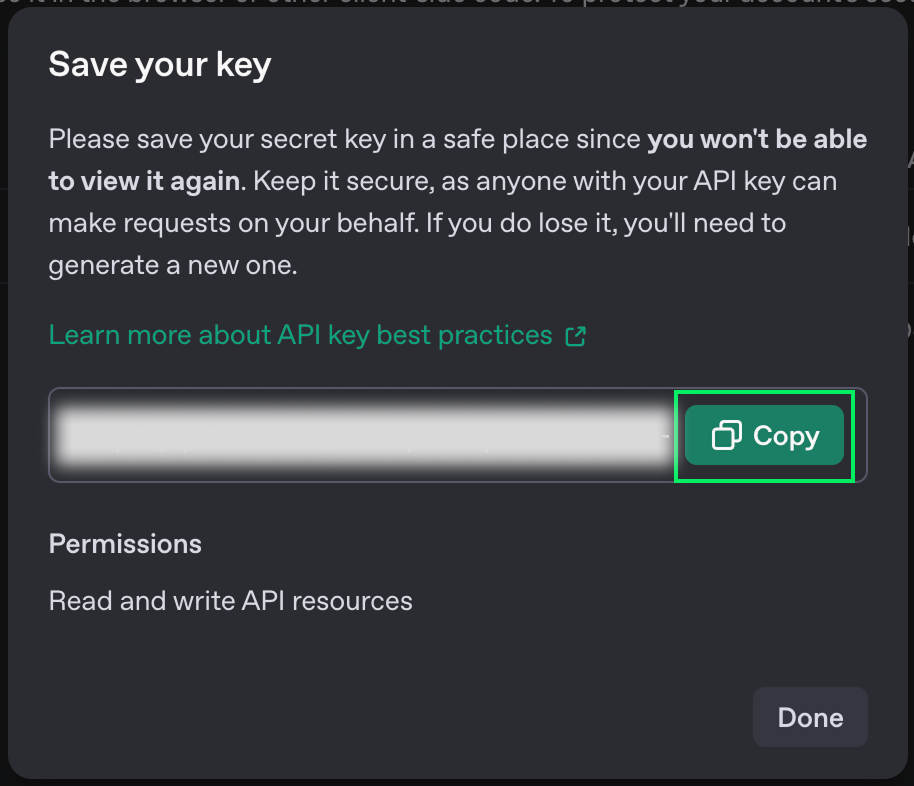

6. Wenn der Schlüssel angezeigt wird, kopiere ihn. Du wirst es später nicht mehr sehen können. Wenn du sie verlierst, kannst du sie jederzeit löschen und eine neue erstellen.

7. Erstelle eine Datei mit dem Namen .env in demselben Ordner, in dem du den Python-Code schreibst, und füge den Schlüssel in folgendem Format ein:

OPENAI_API_KEY=<paste_your_key_here>API-Preise

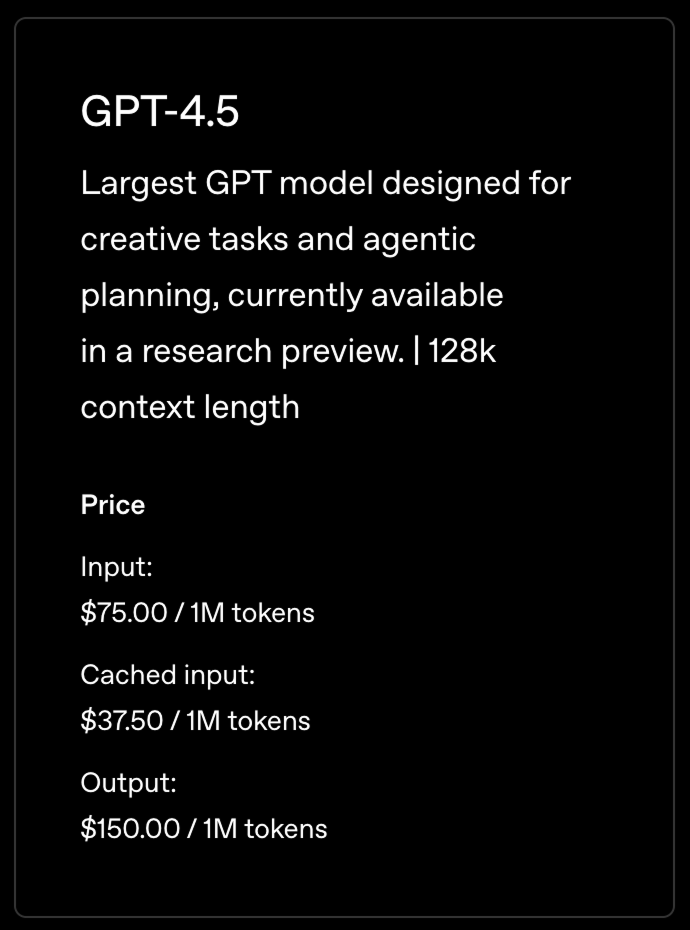

Die OpenAI API ist nicht kostenlos. Je nachdem, welches Modell du nutzt, fallen unterschiedliche Gebühren an. Alle Details zu den Preisen findest du auf der ihrer Preisseite.

Diese Gebühren unterscheiden sich von den Abonnements für die Nutzung von ChatGPT über seine Online-Schnittstelle. Wenn wir die API nutzen, zahlen wir pro Nachricht, anstatt jeden Monat einen festen Betrag zu zahlen. Bei regelmäßiger Nutzung kann dies eine viel günstigere Möglichkeit sein, auf ihre Modelle zuzugreifen.

In diesem Tutorial werden wir das neueste Modell, GPT-4.5, verwenden. Dies ist das am weitesten fortgeschrittene generalistische Modell.

Die Preise werden nicht pro Nachricht, sondern pro Token festgelegt. Wenn wir eine Nachricht an einen LLM senden, wird sie in Token. Es gibt keine verlässliche Formel für die Umwandlung von Wörtern in Token, aber um eine Vorstellung zu bekommen, kann man schätzen, dass ein Token mehr oder weniger 3/4 eines Wortes ist.

Das bedeutet, dass die oben genannten Preise ungefähr 750.000 Wörtern entsprechen.

Um die API zu nutzen, müssen wir Guthaben zu unserem Konto hinzufügen. Dies kann geschehen auf OpenAIs Abrechnungsseite.

Python-Umgebung einrichten

OpenAI stellt einen Python-Client zur Verfügung, der die Interaktion mit ihrer API erleichtert. Um ihn zu benutzen, müssen wir ihn installieren, ebenso wie einige andere Pakete, die uns helfen, den Schlüssel zu laden, den wir zuvor erstellt haben.

Wir verwenden Anaconda um eine Python-Umgebung zu erstellen und die notwendigen Abhängigkeiten zu installieren. Das ist eine sauberere Methode, da sie mögliche Konflikte mit anderen Python-Paketen vermeidet.

Nachdem wir Anaconda installiert haben, können wir die Umgebung mit dem Terminalbefehl erstellen:

conda create -n gpt45 -y python=3.9Mit diesem Befehl wird eine Umgebung namens gpt45 erstellt, die die Version 3.9 von Python verwendet. Die Option -y wird verwendet, um alle Fragen im Erstellungsprozess automatisch mit Ja zu beantworten.

Als Nächstes aktivieren wir die Umgebung mit:

conda activate gpt45Schließlich haben wir die notwendigen Abhängigkeiten installiert.

pip install openai: Installiere die OpenAI-Python-Bibliothek.pip install python-dovenv: Installiere ein Paket, um den API-Schlüssel aus der Datei.envzu laden, die wir zuvor erstellt haben.

Unsere erste API-Anfrage stellen

Jetzt können wir damit beginnen, Python-Code zu schreiben, um Anfragen an die OpenAI-API zu stellen.

Beginne damit, eine Datei namens script.py zu erstellen. Hier werden wir den Code schreiben.

Als nächstes importieren wir die Pakete:

from openai import OpenAI

from dotenv import load_dotenv

import osDann laden wir den API-Schlüssel und initialisieren den Client:

load_dotenv()

api_key = os.getenv("OPENAI_API_KEY")

client = OpenAI(api_key=api_key)Zum Schluss senden wir eine Nachricht. Für den Anfang senden wir einfach "Hallo":

completion = client.chat.completions.create(

model="gpt-4.5-preview",

messages=[

{

"role": "user",

"content": "Hello"

}

]

)

print(completion.choices[0].message.content)Der Parameter model wird verwendet, um das Modell festzulegen, das wir verwenden wollen. Um andere Modelle auszuprobieren, ersetze sie durch ein anderes.

Wir können das Skript mit ausführen:

python script.pyHier ist das Ergebnis:

Hello! How can I help you today?Einen GPT-4.5 Chatbot mit Python erstellen

In diesem Abschnitt bauen wir auf unserem vorherigen Skript auf, um einen interaktiven Chatbot zu erstellen, mit dem wir im Terminal mit GPT-4.5 sprechen können.

Dazu müssen wir unser Skript ändern in:

- Nimm die Eingaben des Nutzers entgegen.

- Behalte den Lernpfad der Konversation im Auge und sende sowohl die vorherigen Nachrichten als auch die neue Aufforderung.

- Wiederhole dies so lange, bis der Benutzer aussteigt.

Den Benutzer eine Eingabeaufforderung eingeben lassen

Um Benutzereingaben auf dem Terminal zu lesen, verwenden wir die Funktion input(). Wenn sie aufgerufen wird, wartet sie darauf, dass der Benutzer einen Text eingibt und gibt ihn dann zurück.

prompt = input("> ")

print(prompt)So sieht es aus, wenn wir es im Terminal ausführen:

> Hello

HelloDie Chatschleife

Um den Chat zu implementieren, verwenden wir eine Schleife, die so lange läuft, bis der Prompt gleich "exit" ist. Dies ist die Logik der Hauptschleife:

while True:

prompt = input("> ")

if prompt == "exit":

exit()

# Prompt processing goes hereBearbeitung der Eingabeaufforderung

Das Modell speichert keine Historie der Nachrichten, die wir zuvor verschickt haben. Es behandelt jede Nachricht als eine neue. Um ein Chat-Verhalten zu erhalten, müssen wir also alle bisher gesendeten Nachrichten zusammen mit dem neuen Prompt bereitstellen. Das erreichen wir, indem wir den Lernpfad des Chats aufzeichnen.

Die Nachrichten der Nutzer sollten das folgende Format haben:

{

"role": "user",

"content": <user prompt>

}Die Antwort des Modells sollte die Rolle "assistant" haben.

{

"role": "assistant",

"content": <model answer>

}In diesem Sinne, hier ist die komplette Chat-Implementierung:

from openai import OpenAI

from dotenv import load_dotenv

import os

load_dotenv()

api_key = os.getenv("OPENAI_API_KEY")

client = OpenAI(api_key=api_key)

# Initialize the chat history

chat_history = []

while True:

prompt = input("> ")

if prompt == "exit":

exit()

# Add the user message to the chat history

chat_history.append({

"role": "user",

"content": prompt,

})

# Send the full chat history

completion = client.chat.completions.create(

model="gpt-4.5-preview", messages=chat_history

)

# Display the answer

answer = completion.choices[0].message.content

print(answer)

# Add the answer to the chat history

chat_history.append({

"role": "assistant",

"content": answer,

})Chat-Beispiel

Um den Chat auszuprobieren, können wir ihn mit dem Befehl ausführen:

python script.pyDann können wir anfangen zu chatten, indem wir unsere Eingabeaufforderung in das Terminal eingeben. Hier ist ein Beispiel für einen Chat:

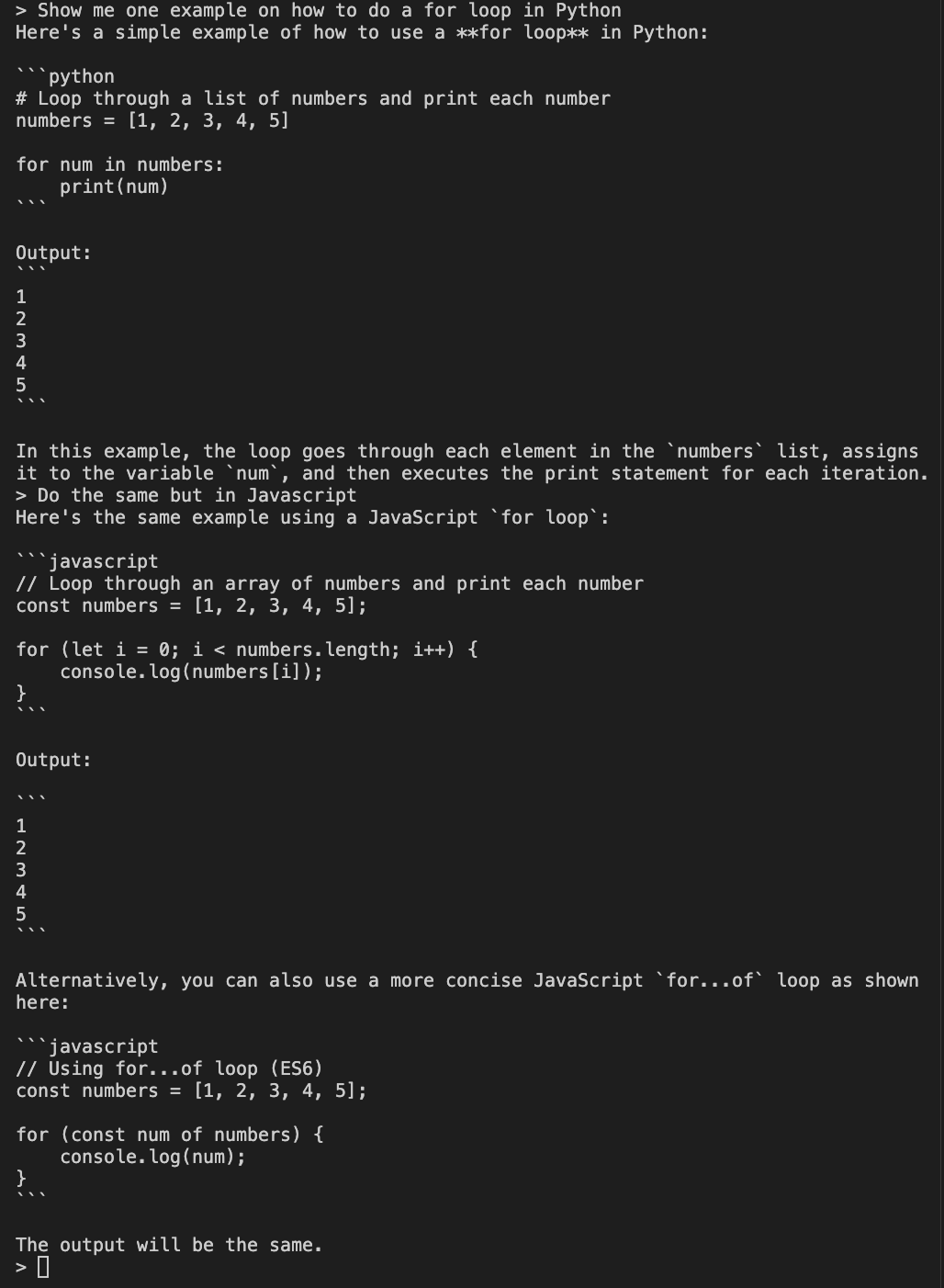

Das Beispiel zeigt zwei Prompts. Zuerst bitten wir das Modell, uns ein Beispiel für eine for Schleife in Python zu zeigen. Um zu testen, ob der Chatverlauf richtig gesendet wird, bitten wir ihn, dasselbe in Javascript zu tun.

Da wir den Chatverlauf zur Verfügung stellen, kann der Modus verstehen, was wir mit "das Gleiche tun" meinen und gibt uns ein Beispiel für eine for Schleife in Javascript.

Fazit

In diesem Tutorial haben wir uns angeschaut, wie man mit Python das GPT-4.5-Modell von OpenAI einrichtet und mit ihm chattet. Wir haben gelernt, wie wir einen OpenAI-API-Schlüssel erstellen und ihn in unserer Python-Umgebung verwenden können, damit wir mit GPT-4.5 auch außerhalb der abonnementbasierten Plattform von OpenAI interagieren können.

Wir haben eine Python-Umgebung mit Anaconda eingerichtet, die notwendigen Pakete installiert und unsere erste Anfrage an die OpenAI-API gestellt.

Schließlich haben wir einen einfachen interaktiven terminalbasierten Chatbot gebaut, der einen Gesprächsverlauf führt.