Lernpfad

Generative künstliche Intelligenz (auch bekannt als generative KI oder GenAI) ist ein Teilbereich der KI, der sich darauf konzentriert, mit verschiedenen KI-Technologien neue Inhalte wie Texte, Bilder oder Videos zu erstellen.

Mit dem Fortschritt der GenAI kommt sie auch in viele andere Tech-Bereiche, wie zum Beispiel die Softwareentwicklung. Ein breites Wissen über die Grundlagen wird in diesen Bereichen immer wichtiger werden.

Für Jobs wie Datenwissenschaftlerund Machine-Learning-Expertenund KI-Ingenieureist generative KI ein wichtiges Thema, das man richtig angehen muss.

Hier sind 30 GenAI-Interviewfragen, die dir während eines Vorstellungsgesprächs gestellt werden könnten.

Verdiene eine Top-KI-Zertifizierung

Grundlegende Fragen zum Thema generative KI für Vorstellungsgespräche

Fangen wir mit ein paar grundlegenden Fragen für Vorstellungsgespräche zum Thema generative KI an. Hier wird dein Verständnis der wichtigsten Konzepte und Prinzipien getestet.

Was sind die wichtigsten Unterschiede zwischen diskriminativen und generativen Modellen?

Diskriminierende Modelle lernen die Entscheidungsgrenze zwischen Klassen und Mustern, die sie voneinander unterscheiden. Sie schätzen die Wahrscheinlichkeits P(y|x), also die Wahrscheinlichkeit , dass ein bestimmtes Label y auftritt , wenn die Eingabedaten x vorliegen . Diese Modelle konzentrieren sich darauf, verschiedene Kategorien zu unterscheiden (z. B.„Ist diese E-Mail Spam?“).

Generative Modelle lernen die Verteilung der Daten selbst, indem sie die gemeinsame Wahrscheinlichkeit P(x,y)modellieren , was das Sammeln von Datenpunkten aus dieser Verteilung beinhaltet. Nachdem das System mit Tausenden von Zahlenbildern trainiert wurde, kann es ein neues Zahlenbild erzeugen.

Mehr dazu findest du in diesem Blog unter „ “ Generative vs. diskriminative Modelle: Unterschiede und Anwendungsfälle.

Was sind Token und Einbettungen im Zusammenhang mit großen Sprachmodellen (LLMs)?

Tokens sind die grundlegenden Texteinheiten, die ein LLM verarbeitet; das können ganze Wörter, Silben oder sogar einzelne Buchstaben sein (zum Beispiel könnte das Wort „generative“ in „gener“, „at“ und „ive“ aufgeteilt werden).

Einbettungen sind die numerischen Vektordarstellungen dieser Token, die sie anhand ihrer Bedeutung in einem mehrdimensionalen Raum platzieren. Durch diese Umwandlung kann das Modell die Bedeutung von Wörtern erfassen und die Beziehungen zwischen ihnen verstehen, zum Beispiel, dass „König“ nah an „Königin“ dran ist.

Kannst du mal die Grundprinzipien von Generative Adversarial Networks (GANs) erklären?

GANs bestehen aus zwei konkurrierenden neuronalen Netzen (daher der Begriff „Adversarial“): einem Generator und einem Diskriminator.

Der Generator macht gefälschte Datenproben, während der Diskriminator sie anhand der echten Trainingsdaten überprüft. Die beiden Netzwerke werden gleichzeitig trainiert:

- Der Generator will Bilder machen, die so echt aussehen, dass der Diskriminator den Unterschied nicht erkennen kann.

- Der Diskriminator soll genau erkennen, ob ein bestimmtes Bild echt oder generiert ist.

Durch dieses konkurrierende Lernen lernt der Generator, echt realistische Daten zu machen, die den Trainingsdaten ähnlich sind.

Was sind ein paar beliebte Anwendungen von generativer KI in der echten Welt?

- Textgenerierung: Verwendet in Chatbots, bei der Erstellung von Inhalten oder bei Übersetzungen (chatGPT, Claude, Gemini).

- Bildgenerierung: Realistische Bilder für Kunst oder Design erstellen (z. B. chatGPT Images, Nano Banana Pro, Stable Diffusion).

- Codierungsmittel: Ich schreibe ganze Codemodule, die in der Softwareentwicklung gebraucht werden.

- Retrieval-Augmented Generation (RAG): Wissen im Unternehmen abrufen, zum Beispiel im Kundenservice oder für interne Wikis.

- Arzneimittelforschung: Entwerfen neuer Molekülstrukturen für Medikamente.

- Datenanreicherung: Erweiterung von Datensätzen mit geringen Datenmengen für maschinelles Lernen.

Was sind die Herausforderungen beim Training und bei der Bewertung von generativen KI-Modellen?

- Rechenaufwand: Hohe Rechenleistung und Hardware-Anforderungen für das Training komplexerer Modelle.

- Komplexität der Schulung: Das Training generativer Modelle kann echt schwierig und voller Feinheiten sein.

- Bewertungskriterien: Es ist echt schwierig, die Qualität und Vielfalt der Modellergebnisse quantitativ zu bewerten.

- Was du an Daten brauchst: Generative Modelle brauchen oft riesige Datenmengen, die echt gut und vielfältig sein müssen. Das Sammeln solcher Daten kann echt zeitaufwendig und teuer sein.

- Voreingenommenheit und Fairness: Unkontrollierte Modelle können die Verzerrungen in den Trainingsdaten verstärken und zu unfairen Ergebnissen führen.

Was sind ein paar ethische Fragen, die man sich beim Einsatz generativer KI stellen sollte?

Die weit verbreitete Nutzung von GenAI und ihre Anwendungsfälle erfordern eine gründliche Bewertung ihrer Leistung in Bezug auf Ethik. Einige Beispiele sind:

- Deepfakes-: Das Erstellen von gefälschten, aber superrealistischen Medien kann zu Fehlinformationen führen oder Leute schlechtmachen.

- Voreingenommene Generations: Verstärkung historischer und gesellschaftlicher Vorurteile in den Trainingsdaten.

- Geistiges Eigentum: Unberechtigte Nutzung von urheberrechtlich geschütztem Material in den Daten.

Wie kann generative KI genutzt werden, um die menschliche Kreativität zu steigern oder zu verbessern?

Auch wenn die Halluzinationen von KI-Modellen zu fehlerhaften Ergebnissen führen können, sind diese generativen Modelle in vielerlei Hinsicht und für viele Anwendungen nützlich. Sie können als kreative Inspiration für Experten in verschiedenen Bereichen dienen:

- Kunst- und Design: Inspiration in Kunst und Design.

- Schreibhilfe: Vorschläge für Titel und Ideen zum Schreiben oder Vervollständigen von Texten.

- Musik: Beats und Harmonien zusammenstellen.

- Programm: Den vorhandenen Code optimieren oder Ideen für die Lösung eines Implementierungsproblems anbieten.

Was ist der Unterschied zwischen einem Basismodell und einem fein abgestimmten Modell?

Ein Foundation-Modell (wie GPT-5.2) wird mit riesigen Mengen an Internetdaten trainiert, um allgemeine Muster, Schlussfolgerungen und Sprachstrukturen zu lernen.

Ein fein abgestimmtes Modell nutzt diese allgemeine Basis und trainiert sie weiter mit einem kleineren, speziell zusammengestellten Datensatz, um eine bestimmte Aufgabe zu meistern, wie zum Beispiel medizinische Diagnosen oder das Sprechen in einer bestimmten Programmiersprache. Feinabstimmung bedeutet, dass man vielseitige Fähigkeiten gegen tieferes Fachwissen in einem bestimmten Bereich eintauscht.

Fragen für Vorstellungsgespräche zum Thema generative KI für Fortgeschrittene

Nachdem wir jetzt die Grundlagen geklärt haben, schauen wir uns ein paar fortgeschrittene Fragen zu generativer KI für Vorstellungsgespräche an.

Was ist „Mode Collapse“ in GANs und wie gehen wir damit um?

Genau wie ein Content-Ersteller, der feststellt, dass ein bestimmtes Videoformat zu mehr Reichweite und Interaktionen führt, könnte sich das generative Modell eines GAN wahrscheinlich auf eine begrenzte Vielfalt von Outputs fixieren, die das Diskriminator-Modell täuschen. Das führt dazu, dass der Generator nur wenige Ergebnisse liefert, was die Vielfalt und Flexibilität der generierten Daten beeinträchtigt.

Mögliche Lösungen dafür könnten sein, sich auf Trainingstechniken zu konzentrieren, indem man die Hyperparameter und verschiedene Optimierungsalgorithmen anpasst, Regularisierungen anwendet, die die Vielfalt fördern, oder mehrere Generatoren kombiniert, um verschiedene Arten der Datengenerierung abzudecken.

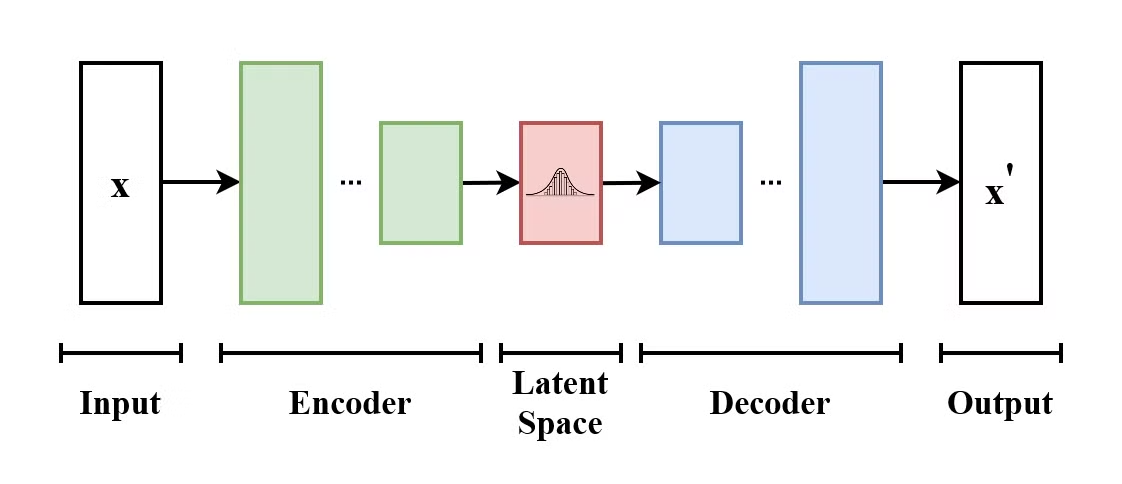

Wie funktioniert ein Variational Autoencoder (VAE)?

Ein Variational Autoencoder (VAE) ist eine Art generatives Modell, das lernt, Eingabedaten in einen latenten Raum zu kodieren und sie wieder zu dekodieren, um die ursprünglichen Eingabedaten zu rekonstruieren. VAEs sind Encoder-Decoder-Modelle:

- Der Encoder ordnet die Eingabedaten einer Verteilung über den latenten Raum zu.

- Der Decoder aus dieser latenten Raumverteilung werden die Eingabedaten wiederhergestellt.

Die Struktur eines Variational Autoencoders. (Quelle: Wikimedia Commons)

Was VAE von herkömmlichen Autoencodern unterscheidet, ist, dass VAE den latenten Raum dazu bringt, einer bekannten Verteilung (wie der Gaußschen) zu folgen. Dadurch sind sie besser geeignet, um neue Daten zu generieren, indem sie aus diesem latenten Raum Proben nehmen.

Erkläre mal den Unterschied zwischen Retrieval-Augmented Generation (RAG) und Fine-Tuning. Wann würdest du das eine gegenüber dem anderen bevorzugen?

RAG ( ) verbindet ein Modell mit externen Datenquellen (wie dem Wiki deines Unternehmens), um aktuelle Fakten abzurufen, ohne das Modell neu trainieren zu müssen. Die Parameter des Modells bleiben gleich; es hat nur Zugriff auf zusätzliche Daten.

Durch Feinabstimmung werden die internen Gewichte des Modells angepasst, um seine Art zu sprechen, sich zu verhalten oder zu denken zu verändern, aber es ist nicht gut, um neues Faktenwissen hinzuzufügen.

Benutz RAG, wenn du aktuelle Infos (Nachrichten, Daten von privaten Unternehmen) oder ein bestimmtes Zitat brauchst. Nutze die Feinabstimmung, wenn das Modell ein neues „Verhalten“, eine neue Sprache oder ein bestimmtes Ausgabeformat lernen soll (z. B. das Sprechen in SQL-Code).

Wie würdest du eine LLM-Bewerbung bewerten? Erklär mal „LLM-as-a-Judge”.

Die Bewertung der generierten Beispiele ist eine knifflige Sache, die davon abhängt, um welche Art von Daten es geht (: Bilder, Texte, Videos usw.). Traditioneller Text Metrikwie Genauigkeit reichen für kreative Aufgaben nicht aus, weil sie nur nach Wortüberschneidungen suchen, nicht nach der Bedeutung.

LLM-Benchmarks und Ranglisten nutzen standardisierte Tests, um zu messen, wie gut ein Modell eine bestimmte Aufgabe erledigt. Sie sind super, um Modelle zu vergleichen und den Fortschritt innerhalb oder zwischen verschiedenen Modalitäten zu verfolgen.

LLM-as-a-Judge ist ein cooles Bewertungssystem, bei dem ein echt starkes „Lehrer”-Modell (wie Gemini 3) die Ergebnisse eines kleineren Modells nach bestimmten Kriterien wie Genauigkeit, Nützlichkeit und Tonfall bewertet. Das ist eine skalierbare Möglichkeit, menschliche Präferenzen zu erfassen, ohne dass es so langsam und teuer ist wie eine manuelle Überprüfung durch Menschen.

Was sind ein paar Techniken, um die Stabilität und Konvergenz des GAN-Trainings zu verbessern?

Die Stabilität und Konvergenz beim GAN-Training zu verbessern ist wichtig, um einen Modus-Kollaps zu vermeiden, ein effizientes Training zu gewährleisten und gute Ergebnisse zu erzielen. Hier sind ein paar Techniken, um die Stabilität und Konvergenz des GAN-Trainings zu verbessern:

- Wasserstein GAN (WGAN): Nutzt die Wasserstein-Distanz als Verlustfunktion, was die Trainingsstabilität verbessert und für glattere Gradienten sorgt.

- Zwei-Zeitskalen-Aktualisierungsregel (TTUR): Unterschiedliche Lernraten für den Generator und den Diskriminator verwenden.

- Label-Glättung: Macht die Etiketten weicher, damit man nicht zu selbstsicher wird.

- Anpassungsfähige Lernraten: Optimierer wie Adam nutzen, um die Lernrate dynamisch zu steuern.

- Gradientenstrafe: Bestrafe große Gradienten im Diskriminator, um dieLipschitz -Stetigkeit ( ) für ein stabileres Training zu erreichen.

Wie kannst du den Stil oder die Eigenschaften von Inhalten, die mit generativen KI-Modellen erstellt werden, steuern?

Es gibt ein paar gängige Techniken, um den Stil der GenAI-Ausgaben zu steuern:

- Prompt Engineering: Sag uns, wie der Text aussehen soll, indem du uns genaue Anweisungen gibst, wie der Stil oder Ton der Inhaltserstellung sein soll. Das ist eine coole und einfache Methode, sowohl bei Text-zu-Text- als auch bei Text-zu-Bild-Modellen. Es ist viel effektiver, wenn du dich an die spezifischen Anforderungen oder die Dokumentation des jeweiligen Modells hältst.

- Temperatur- und Probenahmekontrolle: Der Parameter„ “ (Temperatur ) bestimmt, wie zufällig die Ergebnisse sein werden. Niedrigere Temperaturen bedeuten eine konservativere und vorhersehbarere Token-Auswahl, während höhere Temperaturen eine kreativere Generierung ermöglichen. Andere Parameter wie top-k und top-p, können auch beeinflussen, wie kreativ das Modell bei der Generierung mögliche nächste Token auswählt.

- Strukturierte Ausgaben: Was die Struktur angeht, nutzen moderne Modelle den „JSON-Modus“ oder „strukturierte Ausgaben“, die das Modell dazu zwingen, nur gültige JSON- oder XML-Schemas zu erzeugen, statt Freitext.

- Systemaufforderungen: Systemaufforderungen werden mit jeder neuen Nachricht an das Modell geschickt. Man kann sie nutzen, umdauerhafte Verhaltensanweisungen festzulegen ( ), die Benutzereingaben überschreiben, um bestimmte Persönlichkeiten oder Regeln beizubehalten.

- Stilübertragung (Bilder): Eine andere Technik, die man bei der Inferenz für die unterstützten Modelle nutzen kann, ist, den Stil eines Bildes (Referenzbild) auf ein Eingabebild anzuwenden.

- Feinabstimmung: Wir können ein vortrainiertes Modell nehmen und es auf einen bestimmten Datensatz abstimmen, der den gewünschten Stil oder Ton enthält. Das heißt, das Modell muss mit weiteren Daten trainiert werden, um zusätzliche spezifische Stile oder Eigenschaften zu lernen.

- Verstärkendes Lernen: Wir können das Modell dazu bringen, bestimmte Ergebnisse zu bevorzugen und andere zu vermeiden, indem wir Feedback geben. Dieses Feedback wird genutzt, um das Modell durch verstärktes Lernen anzupassen. Mit der Zeit wird das Modell an die Vorlieben der Nutzer und/oder an Datensätze mit Präferenzen angepasst. Ein Beispiel dafür im Zusammenhang mit LLMs ist das Reinforcement Learning from Human Feedback (RLHF).

Wie kann man das Problem der Voreingenommenheit in generativen KI-Modellen angehen?

Um sicherzustellen, dass das Modell unvoreingenommen und fair ist, sind in jeder Phase immer wieder Anpassungen und Kontrollen nötig.

Zuerst muss man Datenverfälschung verhindern, indem man sicherstellt, dass keine Testdaten in die Trainingsdaten gelangen. In diesem Fall würde das Modell darauf trainiert werden, sich die Daten zu merken, anstatt sie zu verallgemeinern.

Außerdem müssen wir dafür sorgen, dass die Trainingsdaten so vielfältig und inklusiv wie möglich sind. Während des Trainings können wir das Modell zu einer faireren Generierung führen, indem wir Fairness-Ziele in die Verlustfunktion einbauen.

Die Modellausgaben müssen regelmäßig auf Verzerrungen überprüft werden. Um das Vertrauen der Öffentlichkeit zu gewinnen, ist es gut, den Entscheidungsprozess des Modells, die Details des Datensatzes und die Vorverarbeitungsschritte so transparent wie möglich zu machen.

Kannst du mal das Konzept des „latenten Raums“ in generativen Modellen und seine Bedeutung erklären?

Bei generativen Modellen ist der latente Raum ein Raum mit weniger Dimensionen, der die wichtigsten Merkmale der Daten so erfasst, dass ähnliche Eingaben näher beieinander liegen. Durch die Stichprobenentnahme aus diesem latenten Raum können die Modelle neue Daten generieren und bestimmte Attribute oder Merkmale manipulieren (Variationen von Bildern erzeugen).

Latente Räume sind super wichtig, um Ergebnisse zu machen, die man gut im Griff hat, die den Trainingsdaten entsprechen und die vielfältig sind.

Welche Rolle spielt selbstüberwachtes Lernen bei der Entwicklung generativer KI-Modelle?

Die Hauptidee beim selbstüberwachten Lernen ist, einen riesigen Korpus unbeschrifteter Daten zu nutzen, um nützliche Darstellungen zu lernen, ohne dass manuelle Beschriftungen nötig sind. Modelle wie BERT und GPT werden mit selbstüberwachenden Methoden wie der Vorhersage des nächsten Tokens und dem Lernen der Struktur und Semantik von Sprachen trainiert. Dadurch muss man sich nicht mehr so sehr auf beschriftete Daten verlassen, die teuer und zeitaufwendig sind. So können Modelle im Grunde riesige unbeschriftete Datensätze fürs Training nutzen.

Was ist Low-Rank-Adaptation (LoRA)?

Ein riesiges Modell mit 70 Milliarden Parametern neu zu trainieren, ist für die meisten Unternehmen einfach zu teuer und dauert viel zu lange. Low-Rank Adaptation (LoRA) löst das, indem es die Hauptmodellgewichte einfriert und nur eine winzige „Adapter“-Schicht (oft weniger als 1 % der Gesamtparameter) trainiert, die oben drauf sitzt. So kannst du Dutzende verschiedener „benutzerdefinierter” Modelle von einem einzigen Basismodell aus bereitstellen, was die Rechenkosten und den Speicherbedarf echt runterbringt.

Fragen zum Vorstellungsgespräch über fortgeschrittene generative KI

Für alle, die nach höheren Positionen suchen oder ihr tiefes Verständnis von generativer KI zeigen wollen, schauen wir uns ein paar fortgeschrittene Interviewfragen an.

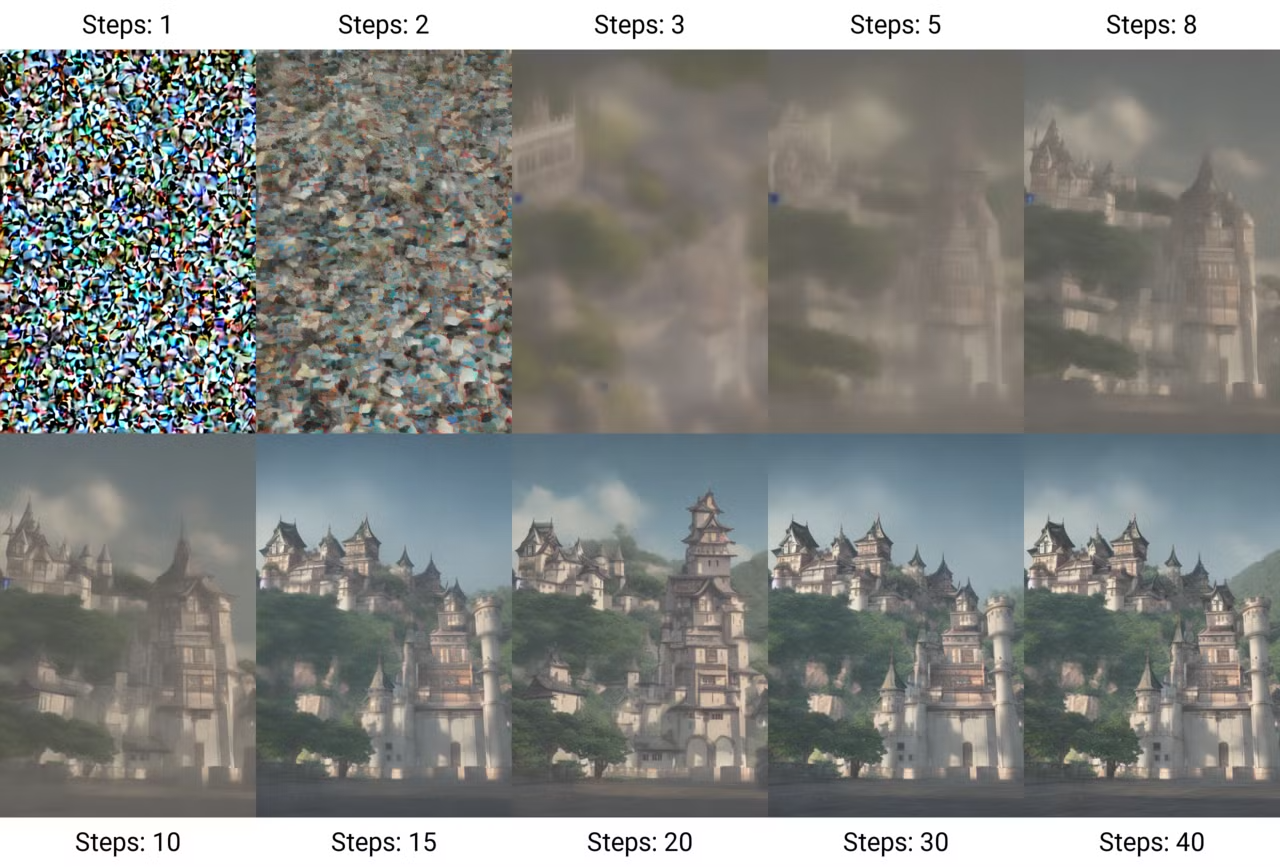

Erkläre mal das Konzept der „Diffusionsmodelle“ und wie sie sich von älteren Architekturen unterscheiden.

Diffusionsmodelle funktionieren im Wesentlichen so, dass sie nach und nach Rauschen zu einem Bild hinzufügen, bis nur noch Rauschen übrig ist – und dann lernen sie, wie man diesen Prozess umkehrt, um aus dem Rauschen neue Samples zu erzeugen. Dieser Prozess heißt„ diffusion“ (). Diese Modelle sind echt beliebt geworden, weil sie super hochwertige und super detaillierte Bilder machen können.

Erzeugung eines Bildes durch Diffusionsschritte. (Quelle: Wikimedia Commons)

Der Prozess zum Trainieren dieser Modelle besteht aus zwei Schritten:

- Der Vorwärtsprozess (Diffusion): Man nimmt ein Bild und fügt nach und nach in mehreren Schritten Rauschen hinzu, bis die Daten komplett zu Rauschen werden.

- Der umgekehrte Prozess (Rauschunterdrückung): Lerne, wie du die Originaldaten aus dem Rauschen herausholen kannst. Dazu wird ein neuronales Netzwerk trainiert, um das Rauschen vorherzusagen, und dann wird das Bild Schritt für Schritt entrauscht, bis die Originaldaten aus dem Rauschen wiederhergestellt sind.

Im Gegensatz zu älteren GANs, die oft Probleme mit der Trainingsstabilität hatten, sind Diffusionsmodelle stabiler und besser skalierbar, können aber wegen ihrer iterativen Natur langsamer sein.

Moderne Varianten wie die latente Diffusion arbeiten in einem komprimierten „latenten Raum“, um die Generierung zu beschleunigen, und Flow-Matching-Architekturen ersetzen jetzt die Standarddiffusion, um eine noch bessere Leistung zu erzielen.

Wie funktioniert die Transformer-Architektur und wo liegt ihr größter Engpass?

Die Transformatorarchitektur , die in dem Artikel „Attention is All You Need”, hat den Bereich der generativen KI, vor allem in der Verarbeitung natürlicher Sprache (Natural Language Processing, NLP), total verändert.

Im Gegensatz zu herkömmlichen rekurrenten neuronalen Netzen (RNNs), die Daten sequenziell verarbeiten, verwenden Transformer den Selbstaufmerksamkeitsmechanismus, um verschiedenen Teilen der Eingabedaten gleichzeitig Gewichte zuzuweisen. Dadurch kann das Modell kontextuelle Beziehungen effektiv erfassen und Sequenzen parallel verarbeiten, was das Training deutlich beschleunigt.

Das Hauptproblem ist, dass dieser Aufmerksamkeitsmechanismus quadratisch mit der Sequenzlänge wächst – wenn man das Kontextfenster verdoppelt, braucht man viermal so viel Rechenleistung. Das macht „unendlichen Kontext“ theoretisch möglich, aber rechnerisch aufwendig, was die Forschung zu effizienteren Aufmerksamkeitsmethoden vorantreibt.

Was ist ein „Reasoning Model“ (System-2-Denken) und wie unterscheidet es sich von einem normalen LLM?

Standard-LLMs denken wie „System 1“-Denker und sagen das nächste Wort sofort voraus, indem sie sich an oberflächlichen Mustern orientieren.

Argumentationsmodelle (wie Gemini 3 oder DeepSeek-R1) sind so trainiert, dass sie eine versteckte „Gedankenkette” bilden, bevor sie eine Antwort geben. So können sie „denken”, planen und Fehler selbst korrigieren. Dadurch sind sie bei komplizierten Matheaufgaben, Programmierung und Logikrätseln echt besser, auch wenn sie langsamer und teurer im Betrieb sind.

Kannst du mal die Probleme bei der Erstellung von hochauflösenden oder langen Inhalten mit generativer KI ansprechen?

Wenn du die Komplexität der KI-Generierung erhöhst, solltest du auch Folgendes angehen:

- Rechenaufwand: Hochauflösende Ausgaben brauchen größere Netzwerke und mehr Rechenleistung.

- Multi-GPU-Training: Größere Modelle passen vielleicht nicht auf eine einzige GPU, sodass ein Multi-GPU-Training nötig ist. Online-Plattformen können die Komplexität der Implementierung solcher Systeme verringern.

- Trainingsstabilität: Größere Netzwerke und kompliziertere Strukturen machen es schwieriger, einen stabilen Trainingsprozess aufrechtzuerhalten.

- Datenqualität: Höhere Auflösung und längere Inhalte brauchen Daten von besserer Qualität.

Was sind ein paar neue Trends und Forschungsrichtungen im Bereich der generativen KI?

Der Bereich der generativen KI entwickelt sich schnell weiter und verändert sich ständig. Das umfasst:

- Multimodale Modelle: Verschiedene Datenformate wie Text, Audio und Bilder zusammenführen.

- Kleine Sprachmodelle (SLMs): Im Gegensatz zu großen Sprachmodellen werden SLMs wegen ihrer Effizienz und Anpassungsfähigkeit immer beliebter. Diese Modelle brauchen weniger Rechenleistung und sind deshalb gut für den Einsatz in Umgebungen mit eingeschränkten Möglichkeiten geeignet – mehr dazu in diesem Blog über Edge-KI.

- Ethische KI-: Entwicklung von Rahmenbedingungen, um die Leistung generativer Modelle aufeinander abzustimmen.

- Generative Modelle für Video-: Fortschritte bei der Erstellung ultrarealistischer und konsistenter Videos durch GenAI. Zu den neuesten Beispielen gehören Sora AI, Meta Movie Genund Runway Act-One.

Wie würdest du ein System entwickeln, das generative KI nutzt, um personalisierte Inhalte für eine bestimmte Branche, wie zum Beispiel das Gesundheitswesen, zu erstellen?

Ein System zu entwickeln, das generative KI für bestimmte Anwendungsfälle in der Industrie nutzt, ist ein ziemlich gründlicher Ansatz. Die allgemeinen Richtlinien können auch für andere Branchen angepasst und geändert werden.

- Die Bedürfnisse der Branche verstehen: Das Fachwissen über eine Branche hat einen großen Einfluss auf die Entscheidungen, die zur Entwicklung eines solchen Systems führen. Der erste Schritt ist, sich ein allgemeines und praktisches Verständnis der Branche, der Grundlagen, Konzepte, Ziele und Anforderungen anzueignen.

- Datenerfassung und -verwaltung: Identifiziere mögliche Datenanbieter. Im Gesundheitswesen heißt das, dass man von den Gesundheitsdienstleistern Infos über Behandlungsdetails, Patientendaten, medizinische Richtlinien und so weiter sammelt. Die branchenspezifischen Regelnfür Datenschutz und -sicherheit von müssen man sich klar machen und einhalten. Stell sicher, dass die Daten hochwertig, genau, aktuell und auch repräsentativ für die verschiedenen Gruppen sind.

- Modellauswahl: Entscheide, ob du vortrainierte Modelle optimieren oder deine Architekturen von Grund auf neu entwickeln willst. Je nach Art des Projekts können die besten generativen KI-Modelle unterschiedlich sein. Ein Modell wie GPT-4o könnte eine gute Plug-and-Play-Lösung sein. Manche Domänen brauchen vielleicht Modelle, die aus Datenschutzgründen lokal gehostet werden. In diesem Fall sind Open-Source-Modelle die beste Lösung. Überleg dir, ob du diese Modelle mit den branchenspezifischen Daten, die du schon gesammelt hast, genauer anpassen solltest.

- Ausgabevalidierung: Mach einen gründlichen Bewertungsprozess, bei dem Experten und Profis die erstellten Inhalte checken, bevor sie umgesetzt werden.

- Skalierbarkeit: Entwickle eine skalierbare Cloud-basierte Infrastruktur, die die erforderlichen Lasten bewältigen kann, ohne dass die Leistung darunter leidet.

- Rechtliche und ethische Überlegungen: Leg klare ethische Regeln für den Einsatz von KI fest und sag klar, wo die Grenzen deines Modells liegen könnten. Respektiere die Rechte an geistigem Eigentum und kümmere dich um alle damit verbundenen Probleme.

- Ständige Verbesserung: Schau dir regelmäßig an, wie das System läuft und was die Experten zu den erstellten Inhalten sagen. Sammle mehr Infos und Daten, um das Modell zu verbessern.

Erklär mal das Konzept des „kontextbezogenen Lernens” im Zusammenhang mit LLMs.

Kontextbezogenes Lernen ist die Fähigkeit von LLMs, ihren Stil und ihre Ergebnisse je nach Kontext anzupassen, ohne dass man sie extra feinabstimmen muss.

Man könnte es auch als Few-Shot-Lernen oder Prompt Engineering Das kann man erreichen, indem man ein oder mehrere Beispiele für die gewünschte Reaktion angibt oder genau beschreibt, wie sich das Modell verhalten soll.

Das kontextbezogene Lernen hat auch seine Grenzen. Es ist kurzfristig und auf bestimmte Aufgaben ausgerichtet, weil das Modell bei anderen Sitzungen, in denen diese Technik angewendet wird, eigentlich kein Wissen behält.

Außerdem braucht das Modell vielleicht viele Beispiele, wenn die gewünschte Ausgabe kompliziert ist. Wenn die Beispiele nicht klar genug sind oder die Aufgabe schwieriger ist, als das Modell bewältigen kann, kann es manchmal falsche oder unlogische Ergebnisse liefern.

Wie kann man Eingabeaufforderungen so gestalten, dass sie das gewünschte Verhalten oder die gewünschten Ergebnisse vom Modell bekommen? Was sind die besten Methoden für effektives Prompt Engineering?

Prompting ist wichtig, um LLMs dazu zu bringen, auf bestimmte Aufgaben zu reagieren. Effektive Eingabeaufforderungen können sogar die Notwendigkeit der Feinabstimmung von Modellen verringern, indem Techniken wie Few-Shot-Lernen, Aufgabenzerlegung und Eingabeaufforderungsvorlagen eingesetzt werden.

Einige bewährte Verfahren für effektives und schnelles Engineering sind:

- Sei klar und prägnant: Gib genaue Anweisungen, damit das Modell genau weiß, welche Aufgabe es ausführen soll. Sei ehrlich und komm direkt auf den Punkt.

- Beispiele verwenden: Für kontextbezogenes Lernen hilft das Zeigen einiger Eingabe-Ausgabe-Paare dem Modell, die Aufgabe so zu verstehen, wie du es möchtest.

- Teile komplexe Aufgaben auf: Wenn die Aufgabe kompliziert ist, kann es die Qualität der Antwort verbessern, wenn man sie in kleinere Schritte aufteilt.

- Legen Sie Einschränkungen oder Formate fest: Wenn du einen bestimmten Ausgabestil, ein bestimmtes Format oder eine bestimmte Länge brauchst, sag das bitte klar in der Anfrage.

Mehr dazu findest du in diesem Blog unter Techniken zur Optimierung von Eingabeaufforderungen.

Welche Techniken gibt's, um die Inferenzgeschwindigkeit generativer KI-Modelle zu verbessern?

- Modellbeschneidung: Entferne unnötige Gewichte/Schichten, um die Modellgröße zu verringern.

- Quantisierung: Die Genauigkeit der Modellgewichte auf fp16/int8 runterfahren.

- Wissensdestillation: Ein kleineres Modell trainieren, damit es ein größeres nachmacht.

- GPU-Beschleunigung: Mit spezieller Hardware.

Kannst du mal das Konzept der „bedingten Generierung” erklären und wie es in Modellen wie bedingten GANs (cGANs) genutzt wird?

Bei der bedingten Generierung macht das Modell Ergebnisse, die auf bestimmten Bedingungen oder Kontexten basieren. Dadurch kann man den erstellten Inhalt besser kontrollieren. Bei bedingten GANs (cGANs) hängen sowohl der Generator als auch der Diskriminator von zusätzlichen Infos ab, wie zum Beispiel Klassenbezeichnungen. So geht's:

- Generator: Nimmt sowohl Rauschen als auch bedingte Infos (z. B. eine Klassenbezeichnung) auf, um Daten zu erzeugen, die mit der Bedingung übereinstimmen.

- Unterscheidungsmerkmal: Überprüft, ob die generierten Daten echt sind, und schaut dabei auch auf die bedingten Infos.

Kannst du mal die Mixture of Experts (MoE)-Architektur erklären? Warum ist es bei großen Modellen besser?

Mixture of Experts (MoE) ersetzt ein einzelnes dichtes neuronales Netzwerk durch viele spezialisierte „Experten”-Subnetzwerke. Für jedes Token wählt ein Router nur die relevantesten Experten aus, um die Daten zu verarbeiten. Das heißt, ein Modell kann 100 Milliarden Parameter haben, aber nur 10 Milliarden für die Inferenz nutzen.

Diese Architektur macht Modelle echt clever (viele Parameter insgesamt), während sie trotzdem schnell und günstig laufen (wenige aktive Parameter).

Fragen für ein Vorstellungsgespräch zum Thema generative KI für einen KI-Ingenieur

Wenn du dich für eine Stelle als KI-Ingenieur mit Schwerpunkt auf generativer KI bewirbst, solltest du dich auf Fragen einstellen, die deine Fähigkeiten beim Entwerfen, Implementieren und Einsetzen generativer Modelle testen.

Was ist ein agenter Workflow im Vergleich zu einem normalen Chatbot?

Ein normaler Chatbot ist eher passiv: Er kriegt eine Frage und gibt dann eine Antwort, die er gelernt hat.

Ein agenter Workflow gibt dem LLM Zugriff auf Tools (wie einen Webbrowser, einen Code-Interpreter oder eine API) und die Freiheit, einen mehrstufigen Prozess zu planen, um ein Ziel zu erreichen. Der Agent könnte planen, das Internet zu durchsuchen, die Daten mit Python-Code zu analysieren und dann einen Bericht zu schreiben, wobei er so lange weitermacht, bis die Aufgabe erledigt ist.

Wie stellst du mit Guardrails die Sicherheit und Robustheit beim Einsatz von LLM sicher?

Die Sicherheit und Robustheit von LLMs zu gewährleisten, bringt einige Herausforderungen mit sich. Eine der größten Herausforderungen ist, dass diese Modelle auf riesigen oder sogar ungefilterten Datenquellen trainiert werden und dadurch möglicherweise schädliche oder irreführende Inhalte erzeugen können.

Ein weiteres großes Problem bei Inhalten, die von LLM generiert werden, ist die Gefahr von Halluzinationen, bei denen das Modell Inhalte erzeugt, die überzeugend klingen, aber eigentlich falsche Infos sind. Eine weitere Herausforderung ist die Sicherheit gegen böswillige Eingaben, die die Sicherheitsmaßnahmen des Modells umgehen und schädliche oder unethische Antworten erzeugen, wie bei verschiedenen Modellen schon oft gezeigt wurde.

Durch den Einsatz von Sicherheitsfiltern und Moderationsschichten kann man schädliche Inhalte, die erstellt werden, besser erkennen und entfernen. Die ständige Überwachung durch Menschen macht das Modell noch sicherer.

Außerdem müssen Ingenieure explizite Schutzvorrichtungen (wie NeMo Guardrails oder Llama Guard) einbauen, die zwischen dem Benutzer und dem Modell stehen. Diese Systeme checken Eingaben, um Versuche von Prompt-Injection oder das Durchsickern von personenbezogenen Daten zu verhindern, und checken auch die Ausgaben, um schädliche oder irreführende Antworten abzufangen, bevor sie den Nutzer erreichen. Das macht eine sichere Ebene, die unabhängig von der Wahrscheinlichkeit des Modells funktioniert.

Erzähl mal von einem anspruchsvollen Projekt mit generativer KI, das du gemacht hast. Was waren die größten Herausforderungen und wie hast du sie gemeistert?

Die Antwort auf diese Frage hängt echt von deinen Projekten und Erfahrungen ab. Du kannst aber diese Punkte im Hinterkopf behalten, wenn du solche Fragen beantwortest:

- Such dir ein bestimmtes Projekt aus mit klaren KI-Herausforderungen wie Voreingenommenheit, Modellgenauigkeit oder Halluzinationen.

- Mach dir klar, was das Problem ist und erkläre die technischen oder betrieblichen Probleme.

- Zeig deinen Ansatz , indem du wichtige Strategien erwähnst, die du genutzt hast, wie zum Beispiel Datenanreicherung, Modelloptimierung oder Zusammenarbeit mit Experten.

- Heb die Ergebnisse raus und die Auswirkungen messen – ob das nun mehr Genauigkeit, mehr Nutzerinteraktion oder die Lösung eines Geschäftsproblems ist.

Kannst du uns was über deine Erfahrungen mit der Implementierung und dem Einsatz generativer KI-Modelle in Produktionsumgebungen erzählen?

Genau wie die Frage oben kannst du diese Frage nach deiner Erfahrung beantworten, aber denk auch daran, dass:

- Konzentrier dich auf die Bereitstellungs: Erwähne die Infrastruktur (Cloud Dienste, MLOps Tools) und wichtige Bereitstellungsaufgaben (Skalierung, Optimierung für niedrige Latenz) erwähnen. Man muss nicht ins Detail gehen. Es reicht, wenn du zeigst, dass du alles im Griff hast.

- Sag mal was zu einer Herausforderung: Es lohnt sich, ein oder zwei häufige Herausforderungen zu erwähnen, die man vermeiden sollte, um deine Expertise zu zeigen.

- Berichte über die Zeit nach dem Einsatz: Überwachungs- und Wartungsstrategien einbauen, um eine gleichbleibende Leistung sicherzustellen.

- Sicherheit ansprechen: Sag uns, welche Maßnahmen du während der Einführung ergriffen hast, um Vorurteile oder Sicherheitsbedenken anzugehen.

Wie gehst du mit dem Phänomen „verloren in der Mitte” in Fenstern mit langen Texten um?

Selbst bei riesigen Kontextfenstern (z. B. 1 Million Token) haben LLMs oft Probleme, Infos zu finden, die mitten in der Eingabe versteckt sind, und konzentrieren sich stattdessen auf den Anfang und das Ende.

Ingenieure machen das wieder wett, indem sie clevere Algorithmen zum Neuanordnen nutzen, die die wichtigsten gefundenen Teile an den Anfang oder das Ende des Kontextfensters verschieben. Eine andere Strategie ist der „Map-Reduce“-Algorithmus, bei dem das Modell Teile des langen Dokuments erst mal unabhängig voneinander zusammenfasst, bevor es sie für eine endgültige Antwort kombiniert.

Wie würdest du die Aufgabe angehen, ein durchgängiges RAG-System aufzubauen?

Ein RAG-System aufzubauen braucht einen systematischen Ansatz. So könnte die Pipeline aussehen:

- Effektives Chunking: Benutze semantische oder rekursive Strategien, um Dokumente in sinnvolle Segmente zu teilen (statt nach willkürlichen Zeichenanzahlen), damit der Kontext erhalten bleibt.

- Vektorspeicher: Bettet diese Teile mit einem leistungsstarken Einbettungsmodell ein und speichert sie in einer Vektordatenbank, zusammen mit umfangreichen Metadaten (wie Daten oder Autoren) für die Vorfilterung.

- Hybride Suche: Mach eine Suchschicht, die die Stichwortsuche (BM25) für exakte Treffer mit der Vektorsuche (semantische Ähnlichkeit) kombiniert, um sowohl bestimmte Begriffe als auch allgemeinere Konzepte zu erfassen.

- Neubewertung: Benutze ein Cross-Encoder-Modell, um die besten Suchergebnisse neu zu bewerten und irrelevante „Störsignale” schon vorher auszusortieren, bevor sie das LLM erreichen.

- Zitieren & Generieren: Fordere das LLM auf, Antworten nur anhand des gegebenen Kontexts zu erstellen und bestimmte Quelldokumente anzugeben, um Halluzinationen zu vermeiden.

Was sind für dich die spannendsten offenen Forschungsfragen oder Bereiche im Bereich der generativen KI?

Die Antwort hängt auch hier von deinen persönlichen Vorlieben ab, aber hier sind ein paar Themen, die du ansprechen kannst:

- Die Interpretierbarkeit von Modellen verbessern: Generative Modelle transparenter und besser verständlich machen.

- Ethische Rahmenbedingungen: Entwicklung von Richtlinien für verantwortungsvolle KI.

- Modalitätsübergreifende Generierung: Erstellen von Inhalten mit verschiedenen Datentypen (Bilder, Text usw.).

- Robustheit gegenüber Angriffen: Modelle widerstandsfähig gegen gegnerische Angriffe machen.

- Fähigkeiten zum logischen Denken: Die Denkfähigkeit von LLMs verbessern.

Fazit

Da generative KI immer mehr Einfluss auf unser Leben und unsere Karrieren nimmt, ist es wichtig, die wesentlichen Themen im Auge zu behalten. Die möglichen GenAI-Fragen, die man in einem Vorstellungsgespräch stellen kann, hängen zwar von der jeweiligen Position und dem Unternehmen ab, aber ich habe versucht, 30 Fragen und Antworten zusammenzustellen, um dir den Einstieg in die Vorbereitung auf dein Vorstellungsgespräch zu erleichtern.

Um mehr Interviewfragen zu entdecken, empfehle ich dir diese Blogs:

Masterstudent der Künstlichen Intelligenz und technischer Redakteur für KI. Ich gebe Einblicke in die neuesten KI-Technologien, mache ML-Forschung zugänglich und vereinfache komplexe KI-Themen, die du brauchst, um ganz vorne mit dabei zu sein.