Lernpfad

Runway ML hat gerade Runway 4.5 rausgebracht, die neueste Version seines KI-Modells, das Texte in Videos verwandelt. Die sagen, ihr Modell sei das bisher beste Text-zu-Video-Modell.

Trotz ihres beeindruckenden Trailers bin ich immer skeptisch, dass die Beispielvideos, mit denen KI-Generierungsunternehmen ihre Modelle präsentieren, sorgfältig ausgewählt sind und dass die Realität oft nicht dem Hype entspricht.

In diesem Artikel zeige ich dir, wie du Runway 4.5 benutzt, und gebe dir ein paar Beispiele, um zu sehen, ob Runway 4.5 wirklich hält, was es verspricht.

Was ist Runway 4.5?

Runway 4.5 ist ein KI-Modell von Runway ML. Während Runway 4 sich darauf konzentriert hat, Videos aus Bildern zu machen, geht es bei Runway 4.5 um Text-Eingaben. Das neue Modell hat im Moment noch keine Soundfunktion, aber laut Runway soll das bald kommen.

Dass es keine Audio-Unterstützung gibt, heißt auch, dass die Sounds im Launch-Trailer extern gemacht wurden und nicht von Runway 4.5.

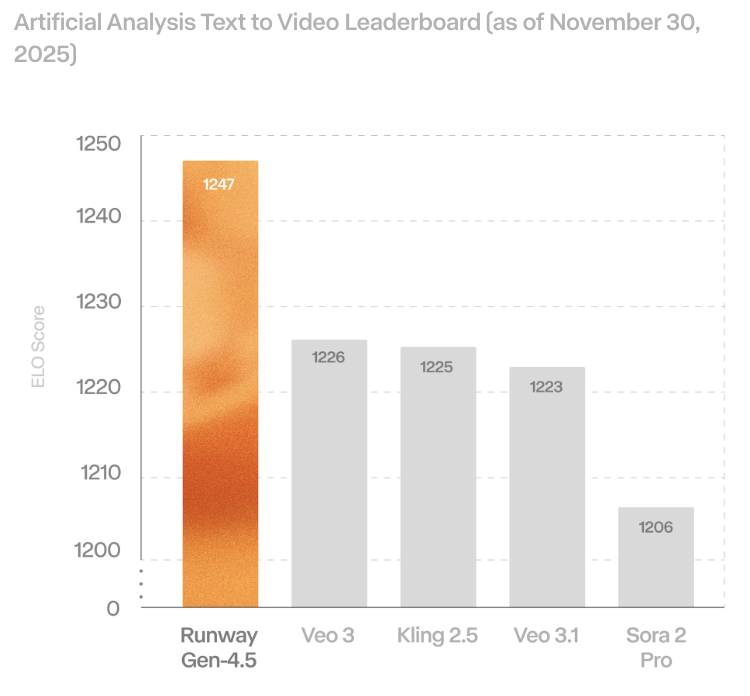

Das neue Modell ist zwar besser als andere Modelle, wenn es um Text-zu-Video-Benchmarks geht, aber das fühlt sich irgendwie wie ein Rückschritt an, weil die alten Modelle einen guten Ton und eine gute Bildqualität hatten.

Ich hab die Erfahrung gemacht, dass Bilder echt wichtig sind, um eine Geschichte zusammenhängend zu machen, denn selbst wenn ein Model sich voll an eine Textvorgabe hält, ist es echt schwierig, die Konsistenz der Figur nur mit Text zu halten.

Wenn du Runway noch nicht kennst, empfehlen wir dir, unsere anderen Artikel zu Runway ML zu lesen:

- Laufbahn Gen 4: Ein Leitfaden mit praktischen Beispielen

- Was ist Runway Gen-3 Alpha? So funktioniert's, Anwendungsfälle, Alternativen und mehr

- Runway Act-One-Leitfaden: Ich hab mich selbst gefilmt, um es zu testen.

Wie komme ich zu Runway 4.5?

Runway 4.5 kannst du über ihre Web-App.

Die Nutzung ist nicht kostenlos und man braucht ein Abonnement. Mehr Infos findest du auf der Preisseite.

Jede Sekunde Videoerstellung für Gen 4.5 kostet 25 Credits. Das günstigste Abonnement hat 625 Credits, mit denen du nur 25 Sekunden Video machen kannst.

Was gibt's Neues in Runway Gen-4.5?

Schauen wir uns mal die neuen Features von Runway Gen 4.5 an:

Genaues Einhalten von Anweisungen

In ihrem Artikel sagen sie, dass Runway 4.5 komplexe Anweisungen ziemlich genau befolgen kann. Es kann nämlich:

- Render komplexe Szenen mit vielen Elementen präzise.

- Erledige detaillierte Kompositionen, sodass du Objekte genau platzieren kannst und Figuren und Objekte in der Szene flüssig bewegen kannst.

- Physikalische Interaktionen mit realistischen Kollisionen und natürlichen Bewegungen genau umsetzen.

- Erstelle ausdrucksstarke Charaktere mit feinen Emotionen, natürlichen Gesten und echt realistischen Details.

Das Video unten zeigt ein Beispiel für jede dieser Funktionen, das von ihrer offiziellen Website kommt:

Stilistische Kontrolle und optische Einheitlichkeit

Gen-4.5 ist wie moderne Text-zu-Video-Modelle wie Veo3.1 und kann mit vielen verschiedenen visuellen Stilen umgehen, von echt aussehenden Filmbildern bis hin zu total stylischen Animationen, und dabei immer einen einheitlichen Look behalten. Insbesondere können wir:

- Mach Videos, die man kaum von echten Aufnahmen unterscheiden kann, mit super realistischen Details und Genauigkeit.

- Mach stylische, ausdrucksstarke Bewegungen mit künstlerischer Freiheit, ohne dich vom Realismus einschränken zu lassen.

- Mach Videos, die wie aus dem Alltag wirken.

- Render Videos mit beeindruckender Tiefe und kinoreifer Qualität.

Hier sind ein paar Beispiele aus ihrer offiziellen Ankündigung, die die oben genannten Funktionen zeigen:

Test der Startbahn 4.5

Die oben gezeigten Beispiele sind von der offiziellen Website. Die sehen echt beeindruckend aus, aber bei KI-Videogenerierungsmodellen ist es oft so, dass wir erst mal eine Menge Videos mit derselben Eingabe generieren müssen, bevor wir was Gutes kriegen.

Man sollte bedenken, dass die Ergebnisse, die wir bei der Ankündigung eines neuen Modells sehen, normalerweise sorgfältig als die besten Videos aus vielen generierten Beispielen ausgewählt werden.

In diesem Abschnitt zeige ich dir die Ergebnisse meiner eigenen Experimente mit Runway 4.5. Bei diesen Experimenten hab ich nicht nur die Rosinen rausgepickt. Für jede Idee, die ich hatte, hab ich ein einziges Video gemacht und nicht versucht, mehrere Versionen zu erstellen, bis ich was Akzeptables hatte.

Um eine gute Eingabeaufforderung zu erstellen, hab ich empfohlen, ihrer Anleitungshandbuchzu befolgen, die folgende Struktur vorschlägt:

[Camera] shot of [a subject/object] [action] in [environment]. [Supporting component descriptions]Physikalische Genauigkeit

Mein erster Test für Runway 4.5 war, zu sehen, ob das Modell die Physik versteht.

Dafür hatte ich die Idee, einen Elefanten und eine Maus auf eine Wippe zu setzen und zu sehen, in welche Richtung sie kippt. Ich wollte nicht in die Eingabeaufforderung schreiben, was passieren würde, um zu sehen, ob das Modell gelernt hat, realistische Physik zu generieren, ohne dass diese beschrieben wird.

Anstatt ein einziges Video zu erstellen, habe ich mich entschieden, zwei Videos zu erstellen:

- Die Maus ist ganz allein auf der Wippe, und der Elefant springt auf die andere Seite. Ich dachte, die Maus würde wegfliegen.

- Der Elefant ist allein auf der Wippe, und die Maus hüpft auf die andere Seite. Ich dachte, dass nichts passieren würde, weil der Elefant viel schwerer ist.

Hier sind die Eingabeaufforderungen, die ich benutzt habe:

Side-on static camera shot of a mouse sitting alone on one end of a wooden see-saw as an elephant falls onto the opposite end in an open grassy field.

The full see-saw and pivot remain visible, the fall completes within the shot, the motion is shown in real-time, and the take is continuous with no cuts.Side-on static camera shot of an elephant sitting alone on one end of a wooden see-saw as a mouse falls onto the opposite end in an open grassy field.

The full see-saw and pivot remain visible, the fall completes within the shot, the motion is shown in real-time, and the take is continuous with no cuts.Und hier ist das Ergebnis:

Auch wenn das Ergebnis nicht ganz so ist, wie ich es mir vorgestellt habe, finde ich, dass Runway 4.5 das physikalisch gesehen ziemlich gut hinbekommt.

Im ersten Video fällt der Elefant nicht wirklich auf die Wippe, aber wenn er drauf tritt, hebt er die Maus hoch, auch wenn es ein paar kleine Unstimmigkeiten gibt.

Im zweiten Video hat die Maus, die auf die Wippe fällt, wie erwartet keinen Einfluss, was gut ist.

Charakter-Emotionen

Als Nächstes wollte ich sehen, ob ich bei den Figuren starke Emotionen auslösen kann. Zuerst wollte ich mal sehen, ob es zu einer unangenehmen Situation kommen könnte, wenn zwei Leute sich anstarren und nach dem Ende eines Gesprächs nichts mehr zu tun haben. Ich hab diese Eingabeaufforderung benutzt:

Two-shot eye-level camera shot of two people holding eye contact after a conversation ends in a small elevator.

Neither speaks, the doors remain closed, and the moment extends slightly longer than comfortable in real time.Hier ist das Video, das mit Runway Gen 4.5 erstellt wurde:

Das Video hat bei mir kein Gefühl von Unbehagen ausgelöst. Ich weiß, dass ich diese Emotion in der Vorgabe nicht ausdrücklich verlangt habe, und vielleicht ist es subjektiv, dass es sich um die Emotion handelt, die durch den langen Blick hervorgerufen wird.

Auch wenn es nicht ganz das war, was ich mir vorgestellt hatte, fand ich, dass die Mimik im Video gut zur Situation passte. Für mich sah es eher so aus, als würden sich die Figuren auf eine schwierige Situation vorbereiten.

Ich hab ein zweites Experiment gemacht, bei dem eine Frau eine traurige SMS bekommen hat und darauf reagiert hat. Das war die Eingabeaufforderung, die ich benutzt habe:

Locked-off close-up camera shot of a young woman reading a very sad message on her phone and slowly lowering it in a quiet subway station.

Her face remains fully visible, background movement continues naturally, and the moment plays out in a single continuous take.Erstellen von komplexen Szenen

Eine Sache, die KI-Modelle meiner Erfahrung nach immer wieder nicht hinbekommen, ist, belebte Szenen mit vielen Leuten zu erzeugen. Normalerweise gibt's viele Artefakte, bei denen Leute und Sachen einfach verschwinden oder aus dem Nichts auftauchen.

Um zu sehen, wie gut Runway 4.5 komplexe Szenen erstellen kann, hab ich es gebeten, ein Video von einem belebten Nachtmarkt zu machen. Dazu hab ich ihm diese Eingabe gegeben:

A crowded open-air night market just after a sudden rainstorm.

Steam rises from food stalls while neon signs in different languages reflect in puddles on the ground.

Dozens of people move through the narrow aisles: vendors cooking, customers eating, children weaving through the crowd, a street musician performing near an intersection.

Some people carry umbrellas, others shake water from their clothes.

Plastic tarps flutter overhead, partially blocking strings of warm lights.

In the background, scooters pass by, and apartment windows glow at different heights.

The scene feels alive, messy, and authentic, with many small interactions happening at once.Das war das Ergebnis:

Insgesamt ist das Ergebnis gar nicht so schlecht. Die Leute vorne bleiben gleich, und das Video hat die meisten der gewünschten Elemente.

Allerdings hat es das gleiche Problem wie andere Modelle, nämlich Schwierigkeiten, die Bewegungen konsistent zu halten.

Zum Beispiel verschwindet irgendwann ein Roller im Hintergrund. Das Gleiche passiert bei manchen Leuten.

Lebensechte Szenen erstellen

Eine der Aussagen in der Ankündigung ist, dass das Modell einfache Alltagsszenen erstellen kann. Um das zu checken, hab ich es gebeten, eine der alltäglichsten Szenen zu generieren, die mir eingefallen ist: jemand, der an der Kasse im Supermarkt bezahlt.

Das war die Eingabeaufforderung, die ich benutzt habe:

Eye-level handheld camera shot of a customer placing items on a checkout counter and waiting in a small local grocery store.

The cashier scans items off-screen, the line behind shifts slightly, and ambient motion continues.Auch wenn das Ergebnis nicht schlecht ist, finde ich, dass das Modell echt Probleme hatte, sich an die Vorgaben zu halten:

Es gibt keine sichtbare Schlange von Kunden, und die Sachen rollen irgendwie komisch über das Förderband und sammeln sich einfach am Ende. Die Szene wirkt auf mich irgendwie unnatürlich und total KI-generiert.

Fantasiewelten erschaffen

Es gibt da was, das ich schon länger machen wollte, aber mit allen Modellen, die ich ausprobiert habe, hat's nicht geklappt. Also hab ich beschlossen, es mit Runway 4.5 zu versuchen. Ich wollte einen Charakter erfinden, der mit einem magischen Pinsel aus schwierigen Situationen rauskommt.

Zum Beispiel könnte er vor bösen Leuten flüchten und damit eine Leiter zeichnen, um aus einer Sackgasse zu entkommen.

Ich hab Runway 4.5 gebeten, diese Szene mit dieser Eingabe zu erstellen:

A fantastical world where painted objects can become real.

A lone character carrying a glowing magical paintbrush runs through a surreal alley as shadowy pursuers close in behind him.

He reaches a dead end: a tall, blank wall with no exits.

Panicked but focused, he turns, presses the brush against the wall, and quickly paints a ladder.

As the final stroke is completed, the painted ladder transforms into a physical object attached to the wall.

The character climbs the ladder and escapes upward just as the pursuers reach the wall below.

The environment feels dreamlike and imaginative, with subtle magical effects reinforcing that art and reality blend together in this world.Das Video hat ein paar Ungereimtheiten, wie zum Beispiel, dass die Bösewichte am Anfang vor der Hauptfigur weglaufen und am Ende nicht die Leiter hochklettern. Trotzdem muss ich sagen, dass ich diese Idee schon bei anderen Modellen ausprobiert habe, aber erst jetzt zum ersten Mal ein Ergebnis erzielt habe, das meinen Vorstellungen auch nur annähernd entspricht.

Erstellen von filmischen Videos

Als letztes Experiment habe ich versucht, ein Video mit einem kinoreifen Look und Feel zu erstellen. Das ist die Eingabeaufforderung, die ich benutzt habe:

A cinematic sequence at dusk in a vast desert landscape.

A solitary figure walks along a windswept ridge as the sky shifts from deep blue to burning orange.

The camera begins wide and slowly pushes in, revealing dust catching the light and fabric moving in the wind.

The character stops, turns toward the horizon, and exhales as distant thunder rolls.

Subtle lens flares, natural motion blur, and layered sound cues suggest scale and tension.

The moment feels quiet, dramatic, and intentional, like a scene from a high-budget film.Hier ist das Ergebnis:

Was das Aussehen und die Atmosphäre angeht, finde ich es echt gut getroffen und es fühlt sich total filmisch an. Das Einzige, was mir nicht gefallen hat, war, dass die Figur gerannt ist, statt zu gehen. Ich finde, das verändert die ganze Stimmung des Videos.

Runway 4.5 im Vergleich zu Veo 3.1

Ich hab ein paar Beispiele ausprobiert, mit denselben Eingaben sowohl bei Runway 4.5 als auch bei Veo 3.1, das ich als direkteren Konkurrenten sehe (beachte, dass die von Veo 3.1 erstellten Videos etwas länger sind).

Ich war echt überrascht, wie viel besser Runway 4.5 bei allen drei Beispielen war. Hier ist ein Vergleich zwischen den Videos, die von beiden Modellen für das Beispiel mit der Wippe und dem darauf sitzenden Elefanten erstellt wurden:

Das Video zu Veo 3.1 hat echt viele Fehler. Zum Beispiel taucht plötzlich eine zweite Maus auf, wenn die Maus fällt. Dann sieht es so aus, als würde die Wippe den Elefanten treffen, aber danach ist der Elefant tatsächlich davor.

Ich hab's noch mal mit einem letzten Beispiel mit komplizierten Bewegungen und physischen Interaktionen versucht:

Slow-motion dolly shot of a line of shopping carts colliding one after another in a steep supermarket parking garage.

Each impact transfers momentum unevenly, carts crumple differently, loose items fly forward, and the final cart barely moves.In diesem Fall haben beide Modelle versagt, aber Veo 3.1 hat noch mehr versagt:

Fazit

In dieser Anleitung habe ich gezeigt, wie man Runway 4.5 benutzt, und es mit ungefilterten Eingaben zu Themen wie Physik, Emotionen, komplexen Menschenmengen, Alltagsmomenten, einer Fantasieflucht und einer Filmszene auf Herz und Nieren geprüft. Ich habe Runway 4.5 auch direkt mit Veo 3.1 verglichen.

Runway 4.5 kann echt gut aussehende, zusammenhängende Videos mit solider Einhaltung der Vorgaben und gelegentlichen herausragenden Momenten erstellen, aber nichts hier fühlte sich wirklich bahnbrechend an.

Runway 4.5 hat immer noch ein paar klare Einschränkungen, vor allem das Fehlen von nativem Sound, das aber bald kommen soll, und ein paar kleine Probleme bei der Konsistenz, die wir bei vielen oder feinen Interaktionen gesehen haben.

Insgesamt scheint Runway 4.5 nach meinen Tests und den veröffentlichten Benchmarks im Moment besser zu sein als Veo 3.1.

Wenn du mehr über die Techniken der KI-Videogenerierung erfahren möchtest, schau dir doch mal unseren Leitfaden zu den besten Videogenerierungsmodellen und unseren Lernpfad „KI-Grundlagen” an.

Runway Gen 4.5 – Häufig gestellte Fragen

Wie komme ich an Runway 4.5 ran?

Du kannst über die Runway-Web-App auf Runway 4.5 zugreifen. Man braucht ein kostenpflichtiges Abonnement.

Wie viel kostet eine Runway 4.5-Generation?

Es kostet 25 Credits pro Sekunde; der günstigste Tarif umfasst 625 Credits (insgesamt etwa 25 Sekunden).

Unterstützt Runway 4.5 Audio?

Zum Zeitpunkt des Verfassens dieses Artikels noch nicht; der Ton im Launch-Trailer wurde extern hinzugefügt, aber es wurde versprochen, dass bald ein nativer Sound kommt.Noch nicht; der Ton im Launch-Trailer wurde extern hinzugefügt, aber es soll bald nativer Sound kommen.

Wie ist Runway 4.5 im Vergleich zu Veo 3.1?

In unseren direkten Vergleichen hat Runway 4.5 sauberere und einheitlichere Ergebnisse gebracht, obwohl beide bei komplizierter Kettenreaktionsphysik Probleme hatten.

Wie soll ich Runway 4.5 aufrufen?

Benutz die empfohlene Struktur – Kamera + Motiv/Objekt + Handlung + Umgebung + unterstützende Details – und leg die Kontinuität fest (Einzelaufnahme, Echtzeit, Bildausschnitt).