Kurs

Der Kern dieses Leitfadens besteht darin, den AWS -Bewerbungsprozess durch eine sorgfältig ausgewählte Liste von Fragen und Antworten für Vorstellungsgespräche verständlicher zu machen. Dieser Bereich deckt alles ab, von den Grundlagen, die das umfangreiche AWS-Ökosystem bilden, bis hin zu detaillierten, szenariobasierten Fragen, die dein tiefes Verständnis und deine praktische Anwendung der AWS-Services testen.

Egal, ob du gerade erst in deine Datenkarriere startest oder schon ein erfahrener Profi bist – dieser Artikel soll dir das Wissen und Selbstvertrauen geben, das du brauchst, um jede Frage in einem AWS-Vorstellungsgespräch zu meistern. Dieser Leitfaden geht auf grundlegende, mittelschwere und fortgeschrittene AWS-Interviewfragen ein und hat auch Fragen aus dem echten Leben dabei. So deckt er alle wichtigen Bereiche ab und sorgt für eine gute Vorbereitung.

Warum AWS?

Bevor wir uns mit den Fragen und Antworten beschäftigen, solltest du wissen, warum es sich lohnt, die AWS Cloud als erste Wahl zu sehen.

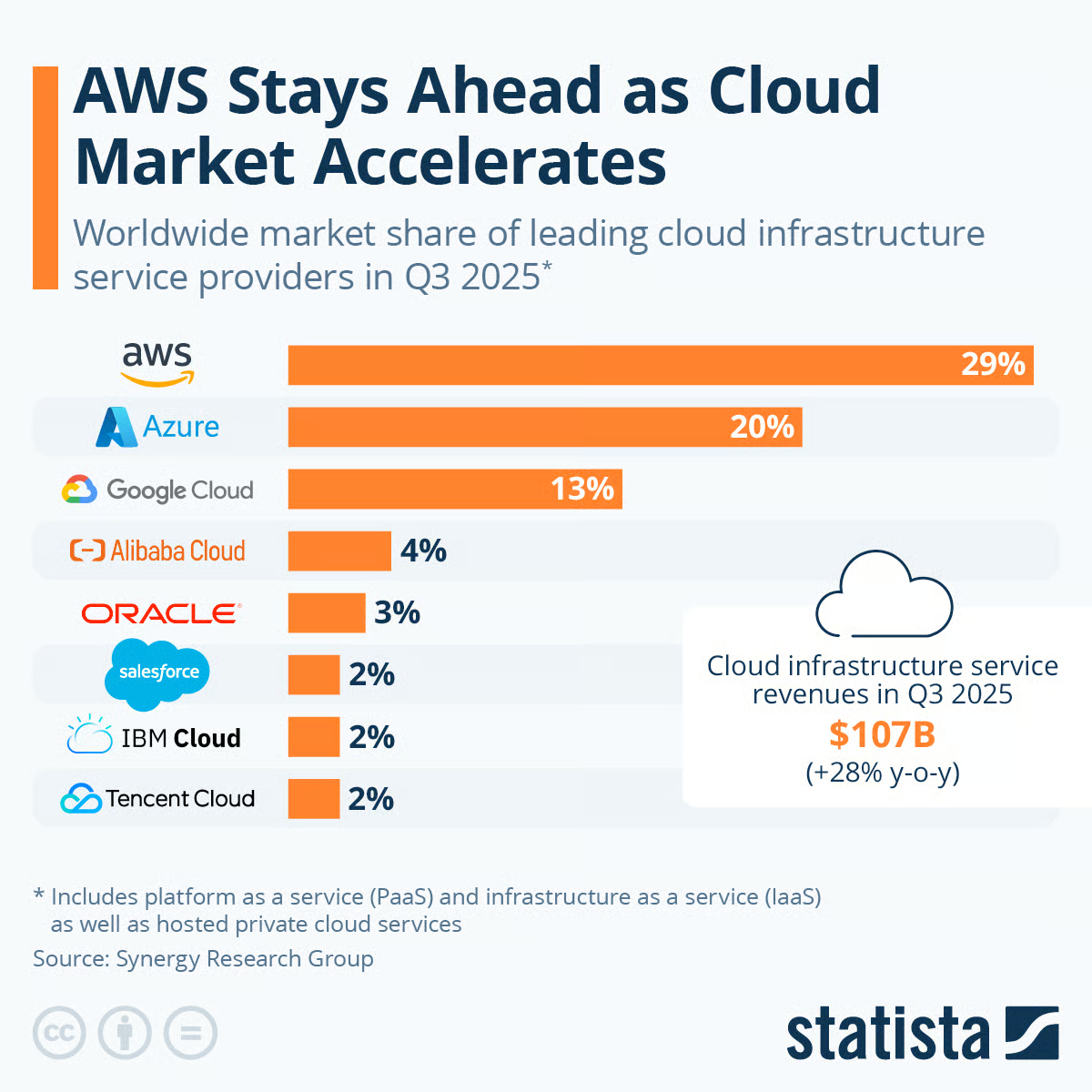

Die Grafik unten zeigt, wie die Marktanteile der großen Cloud-Infrastruktur-Anbieter im dritten Quartal (Q3) 2025 weltweit verteilt sind. Hier ist eine Aufschlüsselung der dargestellten Marktanteile:

- Amazon Web Services (AWS) hat mit 29 % den größten Marktanteil.

- Microsoft Azure kommt mit 20 % gleich danach.

- Google Cloud hat einen Marktanteil von 13 %.

- Alibaba Cloud hat einen Anteil von 4 %.

- Oracle ist auf 3 % gewachsen.

- Salesforce, IBM Cloud und Tencent Cloud liegen mit jeweils 2 % ganz hinten.

Quelle (Statista)

Die Grafik zeigt auch, dass die Daten Platform as a Service (PaaS) und Infrastructure as a Service (IaaS) sowie gehostete Private-Cloud-Dienste beinhalten. Außerdem wird erwähnt, dass die Einnahmen aus Cloud-Infrastrukturdiensten im dritten Quartal 2025 107 Milliarden US-Dollar betrugen, was einen deutlichen Anstieg gegenüber dem dritten Quartal 2024 darstellt, als sie noch bei 84 Milliarden US-Dollar lagen.

Amazon Web Services (AWS) ist auch im dritten Quartal 2025 der große Player auf dem Cloud-Markt und hat einen deutlichen Vorsprung vor seinem nächsten Konkurrenten, Microsoft Azure.

Die Führungsrolle von AWS auf dem Cloud-Markt zeigt, wie wichtig es ist, sich weiterzubilden, und bietet echt gute Karrierechancen, weil AWS so weit verbreitet ist und AWS-Kenntnisse in der Tech-Branche echt geschätzt werden.

Unser Spickzettel „AWS, Azure und GCP Servicevergleich für Data Science & KI” zeigt dir die wichtigsten Dienste, die du für Daten- und KI-bezogene Aufgaben brauchst – von Data Engineering über Datenanalyse und Data Science bis hin zur Erstellung von Datenanwendungen.

Grundlegende Fragen für ein AWS-Vorstellungsgespräch

In diesem Abschnitt geht's um die Grundlagen und du lernst die wichtigsten AWS-Interviewfragen kennen, die du für ein grundlegendes Verständnis brauchst. Es ist genau das Richtige für Leute, die AWS noch nicht kennen oder ihre Kenntnisse auffrischen wollen, und bereitet alles vor für eine genauere Erkundung später.

Was ist Cloud?

Cloud Computing macht es möglich, über das Internet jederzeit auf IT-Ressourcen wie Rechenleistung, Speicherplatz und Datenbanken zuzugreifen. Die Leute zahlen nur für das, was sie wirklich brauchen, statt selbst die ganze Infrastruktur zu besitzen.

Mit der Cloud kannst du flexibel auf Technologiedienste zugreifen, wenn du sie brauchst, ohne große Investitionen im Voraus zu machen. Große Anbieter wie AWS bieten eine breite Palette an Cloud-Diensten an, die man nach Bedarf nutzen und bezahlen kann. Unser Kurs „AWS Cloud Concepts “ geht auf viele dieser Grundlagen ein.

Was ist das Problem beim herkömmlichen IT-Ansatz im Vergleich zur Nutzung der Cloud?

Viele Branchen lassen die klassische IT hinter sich und setzen aus verschiedenen Gründen auf Cloud-Infrastrukturen. Der Grund dafür ist, dass der Cloud-Ansatz im Vergleich zur herkömmlichen IT mehr geschäftliche Flexibilität, schnellere Innovationen, flexible Skalierbarkeit und niedrigere Gesamtbetriebskosten bietet. Hier sind ein paar Sachen, die sie von anderen unterscheiden:

|

Traditionelle IT |

Cloud Computing |

|

|

Wie viele Arten von Bereitstellungsmodellen gibt es in der Cloud?

Es gibt drei verschiedene Arten von Bereitstellungsmodellen in der Cloud, die im Folgenden dargestellt sind:

- Private Cloud: Diese Art von Dienst wird nur von einer einzigen Organisation genutzt und ist nicht öffentlich zugänglich. Es ist für Unternehmen gedacht, die sensible Anwendungen nutzen.

- Öffentliche Cloud: Diese Cloud-Ressourcen gehören und werden von Cloud-Diensten von Drittanbietern wie Amazon Web Services, Microsoft Azure und allen im Abschnitt „Marktanteil von AWS“ genannten Anbietern betrieben.

- Hybrid Cloud: Das ist die Mischung aus privaten und öffentlichen Clouds. Es ist so gemacht, dass ein paar Server vor Ort bleiben, während die restlichen Funktionen in die Cloud verlagert werden. Die Hybrid Cloud bietet die Flexibilität und Kosteneffizienz der Public Cloud.

Was sind die fünf Merkmale von Cloud Computing?

Cloud Computing hat fünf Hauptmerkmale, die im Folgenden erklärt werden:

- Selbstbedienung auf Abruf: Benutzer können Cloud-Dienste nach Bedarf bereitstellen, ohne dass jemand vom Dienstanbieter eingreifen muss.

- Breiter Netzwerkzugang: Die Dienste sind über das Netzwerk verfügbar und können über normale Geräte wie Handys, Laptops und Tablets genutzt werden.

- Mehrfachnutzung und Ressourcenpooling: Die Ressourcen werden gebündelt, um mehrere Kunden zu bedienen, wobei verschiedene virtuelle und physische Ressourcen je nach Bedarf dynamisch zugewiesen werden.

- Schnelle Flexibilität und Skalierbarkeit: Funktionen können flexibel bereitgestellt und schnell und automatisch nach oben oder unten skaliert werden, um die Kapazität an den Bedarf anzupassen.

- Gemessener Service: Die Ressourcennutzung wird überwacht, gesteuert, gemeldet und transparent nach Verbrauch abgerechnet. Die Nutzung kann verwaltet, kontrolliert und gemeldet werden, was für Anbieter und Verbraucher mehr Transparenz bringt.

Was sind die wichtigsten Arten von Cloud Computing?

Es gibt drei Hauptarten von Cloud Computing: IaaS, PaaS und SaaS

- Infrastruktur als Service (IaaS): Bietet grundlegende Bausteine für Cloud-IT wie Rechenleistung, Speicher und Netzwerke, auf die Nutzer nach Bedarf zugreifen können, ohne die zugrunde liegende Infrastruktur verwalten zu müssen. Beispiele: AWS EC2, S3, VPC.

- Plattform als Service (PaaS): Bietet eine verwaltete Plattform oder Umgebung für die Entwicklung, Bereitstellung und Verwaltung von Cloud-basierten Apps, ohne dass die zugrunde liegende Infrastruktur aufgebaut werden muss. Beispiele: AWS Elastic Beanstalk, Heroku

- Software als Dienstleistung (SaaS): Bietet Zugriff auf komplette Endbenutzeranwendungen, die in der Cloud laufen und die Benutzer über das Internet nutzen können. Die Leute kümmern sich nicht um die Verwaltung von Infrastruktur oder Plattformen. Beispiele: AWS Simple Email Service, Google Docs, Salesforce CRM.

Du kannst das alles genauer in unserem Kurs „Cloud Computing verstehen“ anschauen.

Was ist Amazon EC2 und wofür wird es hauptsächlich genutzt?

Amazon EC2 (Elastic Compute Cloud) bietet skalierbare virtuelle Server, die als Instanzen bezeichnet werden, in der AWS Cloud. Damit kann man verschiedene Aufgaben flexibel und kostengünstig erledigen. Einige der wichtigsten Anwendungen sind unten aufgeführt:

- Websites und Webanwendungen hosten

- Backend-Prozesse und Batch-Jobs ausführen

- Hybrid-Cloud-Lösungen einführen

- Hohe Verfügbarkeit und Skalierbarkeit erreichen

- Verkürze die Zeit bis zur Markteinführung neuer Anwendungsfälle.

Was ist Amazon S3 und warum ist es wichtig?

Amazon Simple Storage Service (S3) ist ein vielseitiger, skalierbarer und sicherer Objektspeicherdienst. Es ist die Basis für viele Cloud-basierte Anwendungen und Workloads. Hier sind ein paar Sachen, die zeigen, wie wichtig es ist:

- Super langlebig mit einer Haltbarkeit von 99,999999999 % und einer Verfügbarkeit von 99,99 %, also perfekt für wichtige Daten.

- Unterstützt starke Sicherheitsfunktionen wie Zugriffsrichtlinien, Verschlüsselung und VPC-Endpunkte.

- Lässt sich super mit anderen AWS-Diensten wie Lambda, EC2, EBS und so weiter verbinden.

- Niedrige Latenz und hoher Durchsatz machen es super für Big-Data-Analysen, mobile Apps, Medienspeicherung und -bereitstellung.

- Flexible Verwaltungsfunktionen für Überwachung, Zugriffsprotokolle, Replikation, Versionierung und Lebenszyklusrichtlinien.

- Mit der globalen AWS-Infrastruktur für schnellen Zugriff überall auf der Welt.

Erkläre mal das Konzept von „Regionen“ und „Verfügbarkeitszonen“ in AWS.

- AWS-Regionen sind verschiedene geografische Standorte, an denen sich AWS-Ressourcen befinden. Unternehmen suchen sich Regionen in der Nähe ihrer Kunden aus, um Verzögerungen zu vermeiden, und die regionenübergreifende Replikation sorgt für eine bessere Notfallwiederherstellung.

- Verfügbarkeitszonen bestehen aus einem oder mehreren separaten Rechenzentren mit doppelter Stromversorgung, Netzwerk und Konnektivität. Sie machen es möglich, Ressourcen auf eine fehlertolerantere Art einzusetzen.

Unser Kurs „AWS Cloud Concepts“ gibt dir einen kompletten Überblick über die wichtigsten AWS-Kernservices, die besten Methoden zum Entwerfen von AWS-Anwendungen und die Vorteile von AWS für Unternehmen.

Was ist IAM und warum ist es wichtig?

AWS Identity and Access Management (IAM) ist ein Service, mit dem du den Zugriff auf AWS-Services und -Ressourcen sicher verwalten kannst. Mit IAM kannst du Benutzer, Gruppen und Rollen mit detaillierten Berechtigungen verwalten. Das ist wichtig, weil es dabei hilft, das Prinzip der geringsten Privilegien durchzusetzen, sodass Benutzer nur Zugriff auf die Ressourcen haben, die sie wirklich brauchen, was die Sicherheit und Compliance verbessert.

Unser kompletter Leitfaden zu AWS IAM erklärt den Dienst ganz genau.

Was ist Amazon RDS und wie unterscheidet es sich von herkömmlichen Datenbanken?

Amazon Relational Database Service (RDS) ist ein verwalteter Datenbankdienst, mit dem man Datenbanken einrichten, betreiben und skalieren kann, ohne sich um Infrastruktur-Managementaufgaben wie Backups, Patches und Skalierung kümmern zu müssen. Anders als herkömmliche Datenbanken ist Amazon RDS von Anfang an skalierbar und hochverfügbar, unterstützt automatische Backups und ermöglicht Lese-Replikate und Multi-AZ-Bereitstellungen für Failover und Redundanz.

Für alle, die sich Dinge besser visuell merken können, hier eine Tabelle, die die Unterschiede zwischen RDS und herkömmlichen Datenbanken zeigt:

| Feature | Amazon RDS | Traditionelle Datenbanken |

|---|---|---|

| Skalierbarkeit | Lässt sich einfach vertikal oder horizontal skalieren | Hardware-Upgrades sind nötig; Skalierung kann teuer sein |

| Verfügbarkeit | Unterstützt Multi-AZ-Bereitstellungen für hohe Verfügbarkeit | Die Einrichtung einer Hochverfügbarkeitslösung ist ziemlich kompliziert. |

| Wartung | Von AWS verwaltet, einschließlich Backups, Updates und Patches | Manuell verwaltet, inklusive regelmäßiger Updates und Backups |

| Sicherung und Wiederherstellung | Automatische Backups und Snapshots | Benötigt manuelle Backup-Prozesse |

| Kosten | Nutzungsabhängige Abrechnung | Fixkosten; man muss am Anfang mehr Geld investieren |

Was ist Amazon VPC und wofür wird es genutzt?

Mit Amazon Virtual Private Cloud (VPC) kannst du in AWS ein virtuelles Netzwerk aufsetzen, das einem herkömmlichen Netzwerk in einem lokalen Rechenzentrum ziemlich ähnlich ist. VPC wird benutzt, um Ressourcen zu trennen, den ein- und ausgehenden Datenverkehr zu kontrollieren und Arbeitslasten in Subnetze mit strengen Sicherheitskonfigurationen aufzuteilen. Es bietet eine detaillierte Kontrolle über IP-Bereiche, Sicherheitsgruppen und Netzwerkzugriffskontrolllisten.

Was ist Amazon CloudWatch und was sind seine Hauptkomponenten?

Amazon CloudWatch ist ein Überwachungs- und Beobachtungsdienst, mit dem man verschiedene Metriken verfolgen, Alarme einrichten und automatisch auf Änderungen bei AWS-Ressourcen reagieren kann. Es hilft dabei, die Transparenz in Sachen Anwendungsleistung, Systemzustand und Betriebsprobleme zu verbessern, was es zu einem unverzichtbaren Tool für AWS-Nutzer macht. Hier sind die Hauptkomponenten von CloudWatch:

- Metriken: CloudWatch sammelt Datenpunkte oder Metriken, die Einblicke in die Ressourcennutzung, die Anwendungsleistung und den Betriebszustand geben. Mit diesen Daten kann man Trends analysieren und proaktiv skalieren.

- Alarme: Alarme benachrichtigen die Benutzer oder lösen automatische Aktionen aus, wenn bestimmte Schwellenwerte erreicht werden. Wenn zum Beispiel die CPU-Auslastung einen bestimmten Wert überschreitet, kann ein Alarm losgehen, der die automatische Skalierung startet, um die erhöhte Last zu bewältigen.

- Protokolle: CloudWatch Logs bietet einen zentralen Speicherplatz für Anwendungs- und Infrastrukturprotokolle, was für die Fehlerbehebung und das Erkennen von Problemen echt wichtig ist. Protokolle können gefiltert, überwacht und analysiert werden, um einen reibungslosen Betrieb zu gewährleisten.

- Veranstaltungen: CloudWatch Events (oder Amazon EventBridge) merkt, wenn sich was bei AWS-Ressourcen ändert, und kann dann bestimmte Aktionen starten, wie zum Beispiel eine Lambda-Funktion ausführen, wenn ein bestimmtes Ereignis passiert. Das ermöglicht mehr Automatisierung und eine schnelle Reaktion auf kritische Ereignisse.

Was ist AWS Lambda und wie macht es serverloses Computing möglich?

AWS Lambda ist ein serverloser Rechenservice, bei dem man sich nicht mehr um Server kümmern muss, was es Entwicklern einfacher macht, ihren Code in der Cloud auszuführen. So funktioniert es und warum es Serverless Computing möglich macht:

- Codeausführung auf Abruf: Lambda führt Code nur aus, wenn es durch ein Ereignis ausgelöst wird – wie zum Beispiel eine HTTP-Anfrage oder ein Datei-Upload in Amazon S3. So stellst du sicher, dass du Ressourcen nur dann nutzt, wenn du sie wirklich brauchst, und optimierst so Kosten und Effizienz.

- Automatische Skalierung: Lambda passt sich automatisch an die Anzahl der eingehenden Anfragen an. Es kann von einer einzigen Anfrage bis zu Tausenden pro Sekunde verarbeiten, sodass Anwendungen auch bei schwankendem Datenverkehr reaktionsschnell bleiben.

- Konzentrier dich auf den Code, nicht auf die Infrastruktur: Da Lambda die Server-Infrastruktur abstrahiert, können sich Entwickler voll und ganz aufs Schreiben und Bereitstellen von Code konzentrieren, ohne sich um die Bereitstellung, Verwaltung oder Skalierung von Servern kümmern zu müssen.

Mit diesen Funktionen macht Lambda das Prinzip des serverlosen Rechnens möglich – es nimmt dir die Last der Infrastrukturverwaltung ab und lässt Entwickler Anwendungen mit mehr Flexibilität erstellen, testen und skalieren.

Was ist Elastic Load Balancing (ELB) in AWS?

Elastic Load Balancing (ELB) ist ein Service, der den eingehenden Anwendungsdatenverkehr automatisch auf mehrere Ziele verteilt und so dafür sorgt, dass deine Anwendung reaktionsschnell und ausfallsicher bleibt. ELB hat ein paar Vorteile, die es zu einem wichtigen Teil von skalierbaren AWS-Architekturen machen:

- Verkehrsverteilung: ELB verteilt den eingehenden Datenverkehr clever auf mehrere Ziele, wie EC2-Instanzen, Container und IP-Adressen. Das hilft dabei, eine Überlastung einzelner Ressourcen zu vermeiden und sorgt für eine gleichbleibende Anwendungsleistung.

- Fehlertoleranz und hohe Verfügbarkeit: ELB sorgt für Fehlertoleranz, indem es den Datenverkehr auf mehrere Verfügbarkeitszonen verteilt, sodass deine Anwendung auch dann verfügbar bleibt, wenn in einer Zone Probleme auftreten.

- Verbesserte Zuverlässigkeit und Skalierbarkeit: ELB passt die Traffic-Verteilung automatisch an, wenn sich die Nachfrage ändert, sodass plötzliche Traffic-Spitzen einfacher bewältigt werden können, ohne die Anwendungsleistung zu beeinträchtigen.

Werde Dateningenieur

AWS-Interviewfragen für Fortgeschrittene und Erfahrene

Fragen für Vorstellungsgespräche bei AWS DevOps

Bei den spezialisierten Rollen geht's vor allem darum, wie AWS DevOps-Praktiken unterstützt. Hier geht's um die Automatisierung und Optimierung von AWS-Umgebungen, wo du deine Fähigkeiten bei der Nutzung von AWS für die kontinuierliche Integration und Bereitstellung zeigen kannst. Wenn du dich für eine fortgeschrittene AWS-Position bewirbst, schau dir unseren Blogbeitrag „Interviewfragen für Datenarchitekten” an, um ein paar Fragen zu Dateninfrastruktur und -architektur zu üben.

Wie nutzt man AWS CodePipeline, um eine CI/CD-Pipeline für eine mehrschichtige Anwendung zu automatisieren?

Mit CodePipeline kannst du den Ablauf vom Einchecken des Codes bis zum Erstellen, Testen und Bereitstellen in verschiedenen Umgebungen automatisieren, um die Bereitstellung von Updates zu optimieren und gleichzeitig hohe Qualitätsstandards zu halten.

Die folgenden Schritte kannst du machen, um eine CI/CD-Pipeline zu automatisieren:

- Erstell eine Pipeline: Mach zuerst eine Pipeline in AWS CodePipeline und gib dein Quellcode-Repository an (z. B. GitHub, AWS CodeCommit).

- Build-Phase definieren: Verbinde dich mit einem Build-Dienst wie AWS CodeBuild, um deinen Code zu kompilieren, Tests durchzuführen und einsetzbare Artefakte zu erstellen.

- Setze die Bereitstellungsphasen fest: Richte die Bereitstellungsphasen für jede Ebene deiner Anwendung ein. Nutze AWS CodeDeploy, um die Bereitstellung auf Amazon EC2-Instanzen zu automatisieren, AWS Elastic Beanstalk für Webanwendungen oder AWS ECS für containerisierte Anwendungen.

- Genehmigungsschritte hinzufügen (optional): Für kritische Umgebungen solltest du manuelle Genehmigungsschritte vor den Bereitstellungsphasen einbauen, um Qualität und Kontrolle sicherzustellen.

- Überwachen und wiederholen: Beobachte die Leistung der Pipeline und passe sie bei Bedarf an. Nutze Feedback und Iteration, um den Bereitstellungsprozess immer weiter zu verbessern.

Welche wichtigen Sachen sollte man beachten, wenn man eine Bereitstellungslösung auf AWS entwickelt, um Anwendungen effektiv bereitzustellen, zu konfigurieren, zu implementieren, zu skalieren und zu überwachen?

Eine gut durchdachte AWS-Bereitstellung zu erstellen, heißt, die AWS-Services genau auf die Bedürfnisse deiner App zuzuschneiden, also auf die Anforderungen in Sachen Rechenleistung, Speicherplatz und Datenbanken. Dieser Prozess, der durch den riesigen Servicekatalog von AWS kompliziert wird, umfasst mehrere wichtige Schritte:

- Bereitstellung: Richte die wichtige AWS-Infrastruktur wie EC2, VPC, Subnetze oder verwaltete Dienste wie S3, RDS, CloudFront für die zugrunde liegenden Anwendungen ein.

- Konfigurieren: Passe deine Einstellungen an die spezifischen Anforderungen in Bezug auf Umgebung, Sicherheit, Verfügbarkeit und Leistung an.

- Bereitstellung: Roll App-Komponenten effizient aus oder aktualisiere sie, damit die Versionsübergänge reibungslos laufen.

- Skalierung: Passen die Ressourcenzuteilung dynamisch an, basierend auf vordefinierten Kriterien, um Laständerungen zu bewältigen.

- Überwachung: Behalte den Überblick über die Ressourcennutzung, die Ergebnisse der Bereitstellung, den Zustand der Apps und die Protokolle, um sicherzustellen, dass alles wie erwartet läuft.

Was ist Infrastruktur als Code? Beschreib es mit deinen eigenen Worten.

Infrastructure as Code (IaC) ist eine Methode, um Rechenzentren über maschinenlesbare Definitionsdateien zu verwalten und bereitzustellen, statt über physische Hardwarekonfigurationen oder interaktive Konfigurationstools.

Im Grunde genommen können Entwickler und IT-Teams damit Ressourcen automatisch über Code verwalten, überwachen und bereitstellen, anstatt die Hardware manuell einzurichten und zu konfigurieren.

Außerdem kann man mit IaC konsistente Umgebungen schnell und skalierbar bereitstellen, indem man die Infrastruktur festlegt. Das reduziert menschliche Fehler und macht die Arbeit effizienter.

Wie gehst du mit der kontinuierlichen Integration und Bereitstellung in AWS DevOps um?

Bei AWS DevOps kann die kontinuierliche Integration und Bereitstellung mit den AWS Developer Tools geregelt werden. Fang damit an, den Quellcode deiner Anwendung mit diesen Tools zu speichern und zu versionieren.

Dann kannst du Dienste wie AWS CodePipeline nutzen, um die Build-, Test- und Bereitstellungsprozesse zu organisieren. CodePipeline ist das Rückgrat, das mit AWS CodeBuild für die Kompilierung und das Testen von Code und mit AWS CodeDeploy für die automatische Bereitstellung in verschiedenen Umgebungen zusammenarbeitet. Dieser optimierte Ansatz sorgt für effiziente, automatisierte Arbeitsabläufe für die kontinuierliche Integration und Bereitstellung.

Wie hilft Amazon ECS AWS DevOps?

Amazon ECS ist ein skalierbarer Container-Management-Service, der die Ausführung von Docker-Containern auf EC2-Instanzen über einen verwalteten Cluster vereinfacht und so die Bereitstellung und den Betrieb von Anwendungen verbessert.

Was sind ein paar Strategien für Blue/Green-Bereitstellungen auf AWS?

Blau/Grün-Bereitstellungen halten Ausfallzeiten und Risiken niedrig, indem sie zwei Umgebungen laufen lassen: eine (blau) mit der aktuellen Version und eine (grün) mit der neuen Version. In AWS kann man das mit Diensten wie Elastic Beanstalk, AWS CodeDeploy oder ECS machen. Du kannst den Datenverkehr zwischen Umgebungen mit Route 53 oder einem Application Load Balancer umleiten, die grüne Umgebung sicher testen und bei Bedarf sofort zurücksetzen.

Warum könnte ECS gegenüber Kubernetes bevorzugt werden?

ECS ist flexibler, besser skalierbar und einfacher zu implementieren als Kubernetes, was es für manche Bereitstellungen zur ersten Wahl macht.

Wie würdest du Geheimnisse für eine CI/CD-Pipeline in AWS verwalten und sichern?

Um Geheimnisse in einer AWS CI/CD-Pipeline sicher zu verwalten, kannst du AWS Secrets Manager oder AWS Systems Manager Parameter Store nutzen, um sensible Infos wie API-Schlüssel, Datenbankpasswörter und Zertifikate zu speichern. Beide Dienste lassen sich mit AWS-Diensten wie CodePipeline und CodeBuild verbinden und ermöglichen so einen sicheren Zugriff auf Geheimnisse, ohne dass diese fest in deinem Code verankert werden müssen.

Durch die Steuerung der Zugriffsberechtigungen mit IAM kannst du sicherstellen, dass nur autorisierte Personen auf sensible Daten zugreifen können, was die Sicherheit innerhalb des CI/CD-Prozesses erhöht.

Wie nutzt man AWS Systems Manager in einer Produktionsumgebung?

Mit AWS Systems Manager kannst du deine Infrastruktur in großem Maßstab automatisieren und verwalten. In einer Produktionsumgebung wird es oft für das Patch-Management, die Ausführung von Remote-Befehlen, die Erfassung von Beständen und die sichere Speicherung von Konfigurationsparametern und Geheimnissen genutzt. Es lässt sich mit EC2, RDS und anderen AWS-Diensten verbinden und sorgt so für zentrale Transparenz und operative Kontrolle.

Was ist AWS CloudFormation und wie hilft es bei DevOps-Praktiken?

AWS CloudFormation macht die Bereitstellung und Verwaltung der AWS-Infrastruktur über Code automatisch und ermöglicht so Infrastructure as Code (IaC). Mit diesem Service kannst du deine Infrastruktur als Vorlagen festlegen, was das Versionenmanagement, Testen und Replizieren von Umgebungen in Entwicklung, Staging und Produktion vereinfacht.

In einer DevOps-Umgebung hilft CloudFormation dabei, die Konsistenz zu wahren, manuelle Konfigurationsfehler zu reduzieren und automatisierte Bereitstellungen zu unterstützen, wodurch es zu einem wesentlichen Bestandteil der kontinuierlichen Bereitstellung und Umgebungsreplikation wird.

Zum Abschluss der DevOps-Fragen gibt's hier 'ne Tabelle, die die verschiedenen AWS-Services in diesem Bereich und ihre Anwendungsfälle zusammenfasst:

| Dienstleistung | Zweck | Anwendungsfälle in DevOps |

|---|---|---|

| AWS CodePipeline | Automatisiert CI/CD-Workflows über mehrere Umgebungen hinweg | Kontinuierliche Integration und Bereitstellung für optimierte Updates |

| AWS CodeBuild | Kompiliert Code, führt Tests durch und erstellt einsatzbereite Artefakte. | Automatisierung von Builds, Tests und Artefaktgenerierung |

| AWS CodeDeploy | Verwalte die Bereitstellung von Anwendungen in verschiedenen AWS-Umgebungen (z. B. EC2, Lambda). | Automatisierte Bereitstellungen in verschiedenen Umgebungen mit Rollback-Funktionen |

| Amazon ECS | Container-Management für die Bereitstellung von Docker-Containern | Microservices betreiben, App-Bereitstellung und -Verwaltung vereinfachen |

| AWS Secrets Manager | Speichert und verwaltet sensible Infos sicher | Sichere Speicherung von API-Schlüsseln, Passwörtern und anderen sensiblen Daten |

| AWS CloudFormation | Automatisiert die Einrichtung der Infrastruktur durch Code (IaC) | Infrastrukturkonsistenz, Umgebungsreplikation, Best Practices für Infrastructure as Code |

Fragen für das Vorstellungsgespräch zum AWS-Lösungsarchitekten

Für Lösungsarchitekten geht's darum, AWS-Lösungen zu entwickeln, die genau auf bestimmte Anforderungen zugeschnitten sind. In diesem Abschnitt geht's darum, ob du skalierbare, effiziente und kostengünstige Systeme mit AWS aufbauen kannst, wobei die besten Vorgehensweisen für die Architektur im Fokus stehen.

Was macht ein AWS-Lösungsarchitekt?

Die Lösungsarchitekten von AWS entwickeln und überwachen Anwendungen auf AWS und sorgen dafür, dass sie skalierbar sind und optimal laufen. Sie zeigen Entwicklern, Systemadministratoren und Kunden, wie sie AWS für ihre geschäftlichen Anforderungen effektiv nutzen können, und erklären komplexe Konzepte sowohl technischen als auch nicht-technischen Leuten.

Was sind die wichtigsten Sicherheitsmaßnahmen für AWS EC2?

Zu den wichtigsten EC2-Sicherheitsmaßnahmen gehören die Verwendung von IAM für die Zugriffsverwaltung, die Beschränkung des Zugriffs auf vertrauenswürdige Hosts, die Minimierung von Berechtigungen, die Deaktivierung passwortbasierter Anmeldungen für AMIs und die Implementierung einer Multi-Faktor-Authentifizierung für mehr Sicherheit.

Wie stellst du die Redundanz über mehrere Regionen in einer AWS-Architektur sicher?

Um Redundanz über mehrere Regionen hinweg zu erreichen, solltest du wichtige Ressourcen wie EC2-Instanzen, RDS-Datenbanken und S3-Buckets in mehreren AWS-Regionen bereitstellen. Nutze Route 53 für geobasiertes DNS-Routing und S3 Cross-Region Replication für die Datensicherung. Verwende je nach deiner Failover-Strategie entweder eine Aktiv-Aktiv- oder eine Aktiv-Passiv-Konfiguration und behalte die Leistung und Replikation mit CloudWatch und AWS Global Accelerator im Auge.

Was sind die Strategien, um eine hochverfügbare und fehlertolerante AWS-Architektur für wichtige Webanwendungen zu erstellen?

Um eine hochverfügbare und fehlertolerante Architektur auf AWS aufzubauen, braucht man ein paar Strategien, die die Auswirkungen von Ausfällen verringern und den Betrieb am Laufen halten. Die wichtigsten Grundsätze sind:

- Redundanz über alle Systemkomponenten einbauen, um einzelne Fehlerquellen zu vermeiden

- Mit Lastenausgleich den Datenverkehr gleichmäßig verteilen und für optimale Leistung sorgen

- Einrichten einer automatischen Überwachung für die Echtzeit-Fehlererkennung und -reaktion. Systeme sollten so gemacht sein, dass sie mit unterschiedlichen Lasten klarkommen, und eine verteilte Architektur haben, um die Fehlertoleranz zu verbessern.

- Fehlerisolierung, regelmäßige Backups und Notfallpläne sind echt wichtig für den Datenschutz und eine schnelle Wiederherstellung.

- Das Design für eine elegante Degradation sorgt dafür, dass die Funktionalität auch bei Ausfällen erhalten bleibt, während kontinuierliche Tests und Bereitstellungspraktiken die Zuverlässigkeit des Systems verbessern.

Erklär mal, wie du dich zwischen Amazon RDS, Amazon DynamoDB und Amazon Redshift für eine datengesteuerte Anwendung entscheiden würdest.

Die Entscheidung zwischen Amazon RDS, DynamoDB und Redshift für eine datengesteuerte Anwendung hängt von deinen spezifischen Anforderungen ab:

- Amazon RDS ist super für Anwendungen, die eine klassische relationale Datenbank mit Standard-SQL-Unterstützung, Transaktionen und komplexen Abfragen brauchen.

- Amazon DynamoDB passt super für Anwendungen, die eine super skalierbare nosql-Datenbank mit schneller, vorhersehbarer Leistung in jeder Größenordnung brauchen. Es ist super für flexible Datenmodelle und schnelle Entwicklung.

- Amazon Redshift ist super für Analyse-Anwendungen, die komplizierte Abfragen über große Datensätze brauchen, und bietet schnelle Abfrage-Performance durch Spaltenspeicherung und Data-Warehousing-Technologie.

Was würdest du bedenken, wenn du eine bestehende lokale Anwendung auf AWS umstellst? Nimm ein Beispiel deiner Wahl.

Wenn du die CRM-Software (Customer Relationship Management) eines Unternehmens von einem internen Server auf Amazon Web Services (AWS) umstellst, solltest du unbedingt einen strategischen Rahmen befolgen, der dem von AWS vorgeschlagenen ähnelt und auf dieses spezielle Szenario zugeschnitten ist:

- Erste Vorbereitung und Strategieentwicklung

- Schau dir mal die aktuelle CRM-Konfiguration an, um zu sehen, wo es Einschränkungen gibt und was man besser machen könnte.

- Setz dir klare Ziele für die Migration, wie zum Beispiel eine bessere Skalierbarkeit, bessere Datenanalysefunktionen oder niedrigere Wartungskosten.

- Finde heraus, welche AWS-Lösungen du brauchst, wie zum Beispiel Amazon EC2 für Rechenressourcen und Amazon RDS für die Datenbankverwaltung.

- Bewertung und Strategieplanung

- Schau dir die CRM-Komponenten an, um zu entscheiden, welche Teile zuerst migriert werden sollen.

- Wähle die passenden Migrationstechniken aus, zum Beispiel die Verlagerung der CRM-Datenbank mit AWS Database Migration Service (DMS).

- Sorg während des Umzugs für eine stabile Netzwerkverbindung, vielleicht mit AWS Direct Connect.

- Durchführung und Validierung

- Mach dir einen genauen Plan für die Migration und fang mit den weniger wichtigen CRM-Modulen an, um zu sehen, wie es läuft.

- Hol dir die Zustimmung der wichtigsten Stakeholder, bevor du die Hauptfunktionen des CRM mit AWS-Diensten migrierst.

- Teste die Leistung und Sicherheit des migrierten CRM auf AWS und nimm bei Bedarf Anpassungen vor.

- Umstellung auf Cloud-Betrieb

- Wechsel zur vollständigen Verwaltung der CRM-Anwendung in der AWS-Umgebung, wobei alte lokale Komponenten nach und nach abgeschafft werden.

- Nutze die Überwachungs- und Verwaltungstools von AWS für eine ständige Kontrolle und Optimierung.

- Nutze die Erkenntnisse aus dieser Migration, um zukünftige Übergänge zu planen, und denk dabei an eine breitere Cloud-Einführung für andere Anwendungen.

Dieser Ansatz stellt sicher, dass die CRM-Migration zu AWS mit den strategischen Geschäftszielen übereinstimmt und die Vorteile des Cloud Computing in Sachen Skalierbarkeit, Effizienz und Kosteneinsparungen voll ausnutzt.

Sag mal, wie du AWS-Services nutzen würdest, um eine Microservices-Architektur aufzubauen.

Bei der Umsetzung einer Microservice-Architektur wird eine Software-Anwendung in kleine, unabhängige Dienste aufgeteilt, die über APIs miteinander kommunizieren. Hier ist eine kurze Anleitung zum Einrichten von Microservices:

- Agile Entwicklung einführen: Nutze agile Methoden, um die schnelle Entwicklung und Bereitstellung einzelner Microservices zu vereinfachen.

- Mach das API-First-Design zu deinem Ding: Entwickle zuerst APIs für die Interaktion von Microservices, um eine klare und konsistente Kommunikation zwischen den Diensten sicherzustellen.

- CI/CD-Praktiken nutzen: Mach Continuous Integration und Continuous Delivery (CI/CD) zum Standard, um Tests und Bereitstellungen zu automatisieren und so die Entwicklungsgeschwindigkeit und Zuverlässigkeit zu verbessern.

- Die Zwölf-Faktoren-App-Prinzipien einbauen: Wende diese Prinzipien an, um skalierbare, wartungsfreundliche Dienste zu erstellen, die sich einfach auf Plattformen wie der Cloud AWS bereitstellen lassen.

- Wähle das richtige Architektur-Muster: Überleg dir, ob du API-gesteuerte, ereignisgesteuerte oder Daten-Streaming-Muster nutzen solltest, je nachdem, was deine Anwendung braucht, um die Kommunikation und den Datenfluss zwischen den Diensten zu optimieren.

- Nutze AWS für die Bereitstellung: Nutze AWS-Dienste wie Container-Technologien für skalierbare Microservices oder serverloses Computing, um die Komplexität des Betriebs zu reduzieren und dich auf die Entwicklung der Anwendungslogik zu konzentrieren.

- Serverlose Prinzipien umsetzen: Wenn es passt, kannst du serverlose Architekturen nutzen, um das Infrastrukturmanagement loszuwerden, automatisch zu skalieren und nur für das zu bezahlen, was du wirklich brauchst. So machst du dein System effizienter und kostengünstiger.

- Sorg dafür, dass das System robust bleibt: Entwickle Microservices, die fehlertolerant und robust sind, und nutze die integrierten Verfügbarkeitsfunktionen von AWS, um die Kontinuität der Dienste zu gewährleisten.

- Konzentrier dich auf dienstübergreifende Aspekte: Kümmere dich um verteiltes Monitoring, Logging, Tracing und Datenkonsistenz, um die Systemintegrität und -leistung aufrechtzuerhalten.

- Überprüfung mit dem AWS Well-Architected Framework: Nutze das AWS Well-Architected Tool, um deine Architektur anhand der Best Practices von AWS zu checken und so für Zuverlässigkeit, Sicherheit, Effizienz und Kosteneffizienz zu sorgen.

Wenn Teams diese Punkte genau durchdenken, können sie eine Microservice-Architektur aufbauen, die skalierbar und flexibel ist und genau zu ihren Anwendungsanforderungen passt, und dabei die umfangreichen Cloud-Funktionen von AWS nutzen.

Was ist die Beziehung zwischen AWS Glue und AWS Lake Formation?

AWS Lake Formation nutzt die Infrastruktur von AWS Glue und hat dessen ETL-Funktionen, die Steuerungskonsole, den Datenkatalog und die serverlose Architektur mit eingebaut. Während AWS Glue sich auf ETL-Prozesse konzentriert, bietet Lake Formation Funktionen zum Erstellen, Sichern und Verwalten von Data Lakes und erweitert damit die Funktionen von Glue.

Für Fragen zum Thema AWS Glue im Vorstellungsgespräch ist es wichtig zu wissen, wie Glue die Lake-Formation unterstützt. Bewerber sollten bereit sein, über die Rolle von Glue beim Data Lake Management innerhalb von AWS zu reden und zeigen, dass sie die Integration und Funktionen beider Dienste im AWS-Ökosystem verstehen. Das zeigt, dass du genau weißt, wie diese Dienste zusammenarbeiten, um Daten effizient zu verarbeiten und zu verwalten.

Wie optimiert man die AWS-Kosten für eine Webanwendung mit hohem Datenverkehr?

Um die AWS-Kosten für eine Anwendung mit hohem Datenverkehr zu optimieren, kannst du zunächst AWS Cost Explorer und AWS Budgets nutzen, um die Ausgaben zu überwachen und zu verwalten. Dann denk mal über diese Strategien nach:

- Nutze Reserved Instances für vorhersehbare Workloads und Spot Instances für flexible Workloads.

- Die automatische Skalierung hilft dabei, die Ressourcenzuteilung je nach Bedarf anzupassen und so die Kosten in Zeiten mit wenig Traffic zu senken.

- Mach deinen Speicher mit Amazon S3-Lebenszyklusrichtlinien und S3 Intelligent-Tiering schlanker, indem du Daten, auf die du selten zugreifst, in günstigere Speicherklassen verschiebst.

- Mach Caching mit Amazon CloudFront und Amazon ElastiCache, um wiederholte Anfragen an Backend-Ressourcen zu reduzieren und so Bandbreite und Rechenkosten zu sparen.

Dieser Ansatz sorgt dafür, dass die Anwendung kosteneffizient ist, ohne dass man bei der Leistung oder Verfügbarkeit Abstriche machen muss.

Was sind die wichtigsten Punkte des AWS Well-Architected Frameworks?

Das AWS Well-Architected Framework bietet einen strukturierten Ansatz für die Entwicklung sicherer, effizienter und widerstandsfähiger AWS-Architekturen. Es hat fünf Hauptbereiche:

- Operative Exzellenz: Konzentriert sich auf die Unterstützung von Entwicklung und Betrieb durch Überwachung, Reaktion auf Vorfälle und Automatisierung.

- Sicherheit: Schützt Daten, Systeme und Vermögenswerte durch Identitätsmanagement, Verschlüsselung und Reaktion auf Vorfälle.

- Zuverlässigkeit: Dazu gehört, Systeme zu entwickeln, die sich von Ausfällen erholen können, Ressourcen dynamisch skalieren und Netzwerkprobleme lösen.

- Leistungseffizienz: Fördert die Nutzung von skalierbaren Ressourcen und optimierten Arbeitslasten.

- Kostenoptimierung: Konzentriert sich auf das Kostenmanagement durch die Auswahl der richtigen Ressourcen und die Verwendung von Preismodellen wie Reserved Instances.

Wenn man diese Punkte versteht, können AWS-Architekten ausgewogene Lösungen entwickeln, die den Best Practices für Sicherheit, Leistung, Zuverlässigkeit und Kostenmanagement entsprechen.

Fragen und Antworten für Fortgeschrittene zu AWS-Vorstellungsgesprächen

Fragen für das Vorstellungsgespräch als AWS-Dateningenieur

Dieser Abschnitt richtet sich an Dateningenieure und befasst sich mit AWS-Diensten für die Datenverarbeitung, einschließlich Warehousing und Echtzeitverarbeitung. Es geht um das Know-how, das man braucht, um mit AWS skalierbare Datenpipelines aufzubauen.

Erklär mal den Unterschied zwischen Amazon Redshift, RDS und S3 und wann man die einzelnen Dienste am besten nutzt.

- Amazon S3 ist ein Objektspeicherdienst, der skalierbaren und dauerhaften Speicherplatz für jede Datenmenge bietet. Man kann es nutzen, um rohe, unstrukturierte Daten wie Logdateien, CSVs, Bilder usw. zu speichern.

- Amazon Redshift ist ein Cloud-Data-Warehouse, das für Analysen und Business Intelligence optimiert ist. Es lässt sich mit S3 verbinden und kann die dort gespeicherten Daten laden, um komplexe Abfragen durchzuführen und Berichte zu erstellen.

- Amazon RDS bietet verwaltete relationale Datenbanken wie PostgreSQL, MySQL usw. an. Es kann Transaktionsanwendungen unterstützen, die ACID-konforme Datenbanken mit Funktionen wie Indizierung, Einschränkungen usw. brauchen.

Beschreib mal ein Szenario, in dem du Amazon Kinesis statt AWS Lambda für die Datenverarbeitung nutzen würdest. Was sind die wichtigsten Punkte, die man beachten sollte?

Kinesis kann für die Verarbeitung großer Mengen von Streaming-Daten verwendet werden und ermöglicht das Lesen und Verarbeiten der Streams mit Verbraucheranwendungen.

Einige der wichtigsten Punkte sind unten aufgeführt:

- Datenmenge: Kinesis kann bis zu Megabytes an Daten pro Sekunde verarbeiten, während Lambda nur 6 MB pro Aufruf schafft. Das ist super für Datenströme mit hohem Durchsatz.

- Streaming-Verarbeitung: Kinesis-Nutzer können Daten direkt in Echtzeit verarbeiten, sobald sie ankommen, im Gegensatz zu den Batch-Aufrufen von Lambda, und das hilft bei der Verarbeitung mit geringer Latenz.

- Wiedergabefunktion: Kinesis-Streams speichern Daten für einen bestimmten Zeitraum, sodass sie bei Bedarf wiedergegeben und erneut verarbeitet werden können, während Lambda nicht für die Wiedergabe geeignet ist.

- Bestellung: Kinesis-Shards machen es möglich, zusammengehörige Datensätze in einer bestimmten Reihenfolge zu verarbeiten. Lambda hingegen kann die Verarbeitung in beliebiger Reihenfolge machen.

- Skalierung und Parallelität: Kinesis-Shards können skaliert werden, um die Last zu bewältigen. Lambda braucht vielleicht ein bisschen Koordination.

- Integration: Kinesis lässt sich super mit anderen AWS-Diensten wie Firehose, Redshift und EMR für Analysen verbinden.

Außerdem bietet Kinesis für Fälle mit hohem Volumen, kontinuierlicher, geordneter und wiederholbarer Stream-Verarbeitung, wie zum Beispiel Echtzeitanalysen, native Streaming-Unterstützung, im Gegensatz zum Batch-Ansatz von Lambda.

Wenn du mehr über Daten-Streaming wissen willst, hilft dir unser Kurs „Streaming Data with AWS Kinesis and Lambda” dabei, diese Technologien zu nutzen, um Daten aus Millionen von Quellen zu sammeln und in Echtzeit zu analysieren. Das kann dir helfen, dich besser auf Fragen im Vorstellungsgespräch bei AWS Lambda vorzubereiten.

Was sind die wichtigsten Unterschiede zwischen der Verarbeitung von Daten im Batch-Modus und in Echtzeit? Wann würdest du bei einem Datenengineering-Projekt den einen Ansatz dem anderen vorziehen?

Bei der Stapelverarbeitung werden Daten über einen bestimmten Zeitraum gesammelt und dann in großen Mengen oder Stapeln verarbeitet. Das ist super, um alte, seltenere Daten zu checken.

Echtzeit-Streaming-Verarbeitung analysiert Daten kontinuierlich, sobald sie in kleinen Schritten eintreffen. Damit kann man aktuelle, oft aktualisierte Daten checken.

Für ein Datenengineering-Projekt kann man Echtzeit-Streaming wählen, wenn:

- Du brauchst sofortige Einblicke und kannst nicht warten, bis ein Batch-Prozess läuft. Zum Beispiel Betrugserkennung.

- Die Daten ändern sich ständig und die Analyse muss mithalten, wie zum Beispiel bei der Beobachtung von sozialen Medien.

- Eine niedrige Latenz ist wichtig, zum Beispiel für automatisierte Handelssysteme.

Die Stapelverarbeitung kann besser sein, wenn:

- Historische Daten brauchen komplexe Modelle oder Analysen, wie zum Beispiel bei der Nachfrageprognose.

- Die Daten kommen aus verschiedenen Quellen, die nur ab und zu Daten ausgeben.

- Niedrigere Verarbeitungskosten sind wichtiger als die Verarbeitungsgeschwindigkeit.

Also, Echtzeit ist am besten für schnell wechselnde Daten, die ständig analysiert werden müssen, während Batch für regelmäßig verfügbare Daten gut ist, die historische Modelle brauchen.

Wie kann man die Schemaentwicklung in einer Datenpipeline auf AWS automatisieren?

Die Schemaentwicklung kann mit den dynamischen Frame- und Schema-Inferenzfunktionen von AWS Glue verwaltet werden. Zusammen mit dem Glue Data Catalog kannst du Schemaänderungen automatisch verfolgen. Um Probleme in nachgelagerten Prozessen zu vermeiden, solltest du Schema-Validierungsschritte mit Tools wie AWS Deequ machen oder eigene Logik in deine ETL-Skripte einbauen, um Unstimmigkeiten zu protokollieren und zu beheben.

Wie gehst du mit Schema-on-Read und Schema-on-Write in AWS-Data-Lakes um?

Schema-on-read wird oft in Data Lakes benutzt, wo rohe, halbstrukturierte Daten gespeichert werden (z. B. in S3), und das Schema wird nur während der Abfragezeit mit Tools wie Athena oder Redshift Spectrum angewendet. Dieser Ansatz ist super flexibel für verschiedene Datenquellen. Schema-on-Write, das oft in RDS oder Redshift genutzt wird, sorgt dafür, dass die Struktur von Anfang an klar ist, und ist super für transaktionale oder strukturierte Datensätze, die eine strenge Datenvalidierung brauchen.

Was ist ein operativer Datenspeicher und wie ergänzt er ein Data Warehouse?

Ein Operational Data Store (ODS) ist eine Datenbank, die dazu gedacht ist, Geschäftsabläufe und Analysen in Echtzeit zu unterstützen. Es ist sozusagen eine Zwischenplattform zwischen den Transaktionssystemen und dem Data Warehouse.

Während ein Data Warehouse hochwertige Daten hat, die für Business Intelligence und Berichterstellung optimiert sind, hat ein ODS aktuelle, themenorientierte, integrierte Daten aus verschiedenen Quellen.

Hier sind die wichtigsten Features eines ODS:

- Es liefert Echtzeitdaten für die Überwachung von Vorgängen und die Entscheidungsfindung.

- Bringt Live-Daten aus verschiedenen Quellen zusammen

- Es ist für schnelle Abfragen und Analysen im Vergleich zur Langzeitspeicherung optimiert.

- ODS hat detaillierte, atomare Daten im Gegensatz zu den zusammengefassten Daten im Warehouse.

Ein ODS und ein Data Warehouse sind Systeme, die sich gegenseitig ergänzen. ODS hilft bei Echtzeit-Operationen mit aktuellen Daten, während das Data Warehouse strategische Berichte und Analysen mit integrierten historischen Daten ermöglicht. Zusammen bieten sie eine umfassende Plattform für operative und analytische Anforderungen.

Wie würdest du einen Data Lake auf AWS einrichten und welche Dienste würdest du dafür nutzen?

Um einen Data Lake auf AWS aufzubauen, ist Amazon S3 der wichtigste Dienst, mit dem man anfängt. Damit kann man Rohdaten, strukturierte und unstrukturierte Daten auf eine skalierbare und dauerhafte Art speichern. Hier ist ein Schritt-für-Schritt-Ansatz und die damit verbundenen zusätzlichen Dienstleistungen:

- Speicherschicht: Nutze Amazon S3, um große Datenmengen zu speichern. Ordne Daten mit einer strukturierten Ordnerhierarchie nach Datentyp, Quelle oder Aktualität.

- Datenkatalogisierung: Verwende AWS Glue, um einen Datenkatalog zu erstellen, der das Suchen und Abfragen von in S3 gespeicherten Daten durch das Erstellen von Metadatendefinitionen vereinfacht.

- Datenumwandlung und ETL: Benutze AWS Glue ETL, um Rohdaten vorzubereiten und in ein Format zu verwandeln, das für die Analyse bereit ist.

- Sicherheit und Zugangskontrolle: Setze AWS IAM und AWS Lake Formation ein, um Zugriff, Berechtigungen und Datenverschlüsselung zu verwalten.

- Analysen und Abfragen: Nutze Amazon Athena für Ad-hoc-Abfragen, Amazon Redshift Spectrum für Analysen und Amazon QuickSight für die Visualisierung.

Diese Konfiguration bietet eine flexible, skalierbare Data-Lake-Architektur, die große Datenmengen sowohl für strukturierte als auch für unstrukturierte Analysen verarbeiten kann.

Erkläre die verschiedenen Speicherklassen in Amazon S3 und wann man sie benutzt.

Amazon S3 hat verschiedene Speicherklassen, die alle für bestimmte Anwendungsfälle und Kostenanforderungen optimiert sind. Die folgende Tabelle fasst sie zusammen:

| Speicherklasse | Anwendungsfall | Zugriffshäufigkeit | Kosteneffizienz |

|---|---|---|---|

| S3 Standard | Oft genutzte Daten | Hoch | Standardpreise |

| S3 Intelligent-Tiering | Unvorhersehbare Zugriffsmuster | Automatisch angepasst | Kostengünstig mit automatisierter Speichereinteilung |

| S3 Standard-IA | Selten gebraucht, aber schnell verfügbar | Niedrig | Geringere Kosten, schneller Zugriff |

| S3 One Zone-IA | Seltener Zugriff in einer einzigen AZ | Niedrig | Geringere Kosten, weniger Redundanz |

| S3-Gletscher | Langfristige Archivierung mit seltenem Zugriff | Selten | Günstig, Abruf in wenigen Minuten oder Stunden |

| S3 Glacier Deep Archive | Archivierung für Regulierungs- oder Compliance-Zwecke | Sehr selten | Günstigster Preis, Abruf in 12–48 Stunden |

Wenn du die S3-Speicherklassen verstehst, kannst du die Speicherkosten und Zugriffszeiten nach deinen Datenanforderungen optimieren.

AWS Szenariobasierte Fragen

Diese Fragen konzentrieren sich auf die praktische Anwendung und prüfen die Fähigkeit, Probleme in realistischen Szenarien zu lösen. Dazu muss man genau wissen, wie man AWS-Services einsetzt, um komplexe Herausforderungen zu meistern.

Die folgende Tabelle zeigt Szenarien, die bei AWS-Vorstellungsgesprächen oft auftauchen, zusammen mit einer Beschreibung und möglichen Lösungen:

|

Falltyp |

Beschreibung |

Lösung |

|

Anwendungsmigration |

Ein Unternehmen will seine alte Anwendung auf AWS umstellen. Die Anwendung braucht viele Daten und muss für Leute auf der ganzen Welt schnell erreichbar sein. Welche AWS-Services und welche Architektur würdest du empfehlen, um hohe Verfügbarkeit und niedrige Latenz zu gewährleisten? |

|

|

Notfallwiederherstellung |

Deine Firma will einen Notfallwiederherstellungsplan für ihre wichtigen AWS-Workloads mit einem RPO (Recovery Point Objective) von 5 Minuten und einem RTO (Recovery Time Objective) von 1 Stunde einführen. Sag mal, welche AWS-Services würdest du nutzen, um diese Ziele zu erreichen? |

|

|

Schutz vor DDoS-Angriffen |

Stell dir vor, du musst eine skalierbare und sichere Webanwendungsinfrastruktur auf AWS entwerfen. Die Anwendung sollte mit plötzlichen Traffic-Spitzen klarkommen und vor DDoS-Angriffen schützen. Welche AWS-Services und -Funktionen würdest du in deinem Design nutzen? |

|

|

Echtzeit-Datenanalyse |

Ein IoT-Startup will Echtzeitdaten von Tausenden von Sensoren auf der ganzen Welt verarbeiten und analysieren. Die Lösung muss super skalierbar und kostengünstig sein. Welche AWS-Services würdest du zum Aufbau dieser Plattform nutzen und wie würdest du sicherstellen, dass sie mit der Nachfrage mitwächst? |

|

|

Analyse von großen Datenmengen |

Ein Finanzdienstleister braucht eine Datenanalyselösung auf AWS, um große Mengen an Transaktionsdaten in Echtzeit zu verarbeiten und zu analysieren. Die Lösung muss auch strenge Sicherheits- und Compliance-Standards erfüllen. Wie würdest du diese Lösung mit AWS aufbauen und welche Maßnahmen würdest du ergreifen, um Sicherheit und Compliance zu gewährleisten? |

|

Nicht-technische AWS-Interviewfragen

Neben dem technischen Know-how ist es für ein erfolgreiches Vorstellungsgespräch wichtig, die weitreichenden Auswirkungen von AWS-Lösungen zu verstehen. Hier sind ein paar Fragen und die dazugehörigen Antworten. Die Antworten können je nach Erfahrung und Hintergrund von Kandidat zu Kandidat unterschiedlich sein.

Wie hältst du dich über AWS und Cloud-Technologietrends auf dem Laufenden?

- Was wir von dir erwarten: Der Interviewer will wissen, wie sehr du dich fürs lebenslange Lernen engagierst und wie du deine Fähigkeiten auf dem neuesten Stand hältst. Sie suchen nach bestimmten Ressourcen oder Methoden, mit denen sie sich auf dem Laufenden halten.

- Beispielantwort: Ich bleibe auf dem Laufenden, indem ich die offiziellen AWS-Blogs lese und in Community-Foren wie dem AWS-Subreddit mitmache. Ich gehe auch zu den Treffen und Webinaren der lokalen AWS-Benutzergruppe. Durch diese Sachen bleib ich über die neuesten AWS-Funktionen und Best Practices auf dem Laufenden.

Erzähl mal von einer Situation, in der du jemandem ohne technischen Hintergrund ein kompliziertes AWS-Konzept erklären musstest. Wie hast du das gemacht?

- Was wir von dir erwarten: Diese Frage checkt deine Kommunikationsfähigkeiten und wie gut du komplizierte Infos einfach rüberbringen kannst. Der Interviewer will wissen, ob du gut unterrichten kannst und geduldig bist.

- Beispielantwort: In meinem alten Job musste ich unseren nicht-technischen Stakeholdern die Vorteile von Cloud-Speicher erklären. Ich hab das Vergleichen von Dateien in einer Cloud-Festplatte und einer normalen Festplatte benutzt, um zu zeigen, wie einfach der Zugriff und die Sicherheit sind. Das hat ihnen geholfen, das Konzept zu verstehen, ohne sich mit technischen Details rumschlagen zu müssen.

Was bringt dich dazu, in der Cloud-Computing-Branche zu arbeiten, vor allem bei AWS?

- Was wir von dir erwarten: Der Interviewer will herausfinden, wie sehr du dich für den Bereich begeisterst und was dich antreibt. Sie suchen nach echten Beweggründen, die zur Stelle und zu den Unternehmenswerten passen.

- Beispielantwort: Was mich an Cloud, vor allem AWS, so begeistert, ist, wie es Unternehmen verändern und Innovationen vorantreiben kann. Die ständige Weiterentwicklung der AWS-Services motiviert mich, neue Herausforderungen zu meistern und bei wichtigen Projekten mitzumachen.

Kannst du mal ein anspruchsvolles Projekt beschreiben, das du geleitet hast, und wie du dafür gesorgt hast, dass es ein Erfolg wurde?

- Was wir von dir erwarten: Hier geht's vor allem um deine Fähigkeiten im Projektmanagement und beim Lösen von Problemen. Der Interviewer will wissen, wie du Hindernisse überwindest und Projekte zum Abschluss bringst.

- Beispielantwort: In einem früheren Projekt hatten wir wegen Ressourcenengpässen mit erheblichen Verzögerungen zu kämpfen. Ich habe Aufgaben nach ihrer Wichtigkeit sortiert, um zusätzliche Ressourcen verhandelt und immer klar mit dem Team und den Beteiligten geredet. Dieser Ansatz hat uns geholfen, unsere Projektmeilensteine zu erreichen und das Projekt schließlich pünktlich abzuschließen.

Wie gehst du mit engen Terminen um, wenn mehrere Projekte deine Aufmerksamkeit brauchen?

- Was wir von dir erwarten: Diese Frage checkt, wie du mit deiner Zeit umgehst und Prioritäten setzt. Der Interviewer will wissen, wie du mit Stress und Arbeitsbelastung gut klarkommst.

- Beispielantwort: Ich setze auf Prioritäten setzen und Aufgaben delegieren. Ich schaue mir an, wie dringend und wichtig jedes Projekt ist, setze Prioritäten und gebe Aufgaben weiter, wenn es nötig ist. Ich rede auch regelmäßig mit den Beteiligten über den Fortschritt und welche Anpassungen nötig sind, um die Fristen einzuhalten.

Was glaubst du, was AWS von anderen Cloud-Anbietern unterscheidet?

- Was wir von dir erwarten: Der Interviewer will wissen, wie du das einzigartige Wertversprechen von AWS verstehst. Das Ziel ist, dass du verstehst, warum AWS in der Cloud-Branche führend ist.

- Beispielantwort: AWS hebt sich durch seine riesige globale Infrastruktur ab, die echt unschlagbar in Sachen Skalierbarkeit und Zuverlässigkeit ist. Außerdem macht das Engagement von AWS für Innovation mit einem breiten und tiefen Angebot an Diensten flexiblere und maßgeschneiderte Cloud-Lösungen im Vergleich zu seinen Mitbewerbern möglich.

Wie gehst du vor, wenn du neue AWS-Tools oder -Services lernst, sobald sie auf den Markt kommen?

- Was wir von dir erwarten: Diese Frage checkt, wie anpassungsfähig du bist und wie du am besten lernst. Der Interviewer will sehen, dass du aktiv daran arbeitest, neue Technologien zu meistern, was im schnelllebigen Bereich der Cloud echt wichtig ist.

- Beispielantwort: Wenn AWS einen neuen Service rausbringt, schaue ich mir erst mal die offizielle Doku und die Release Notes an, um zu verstehen, wofür er gedacht ist und wie er funktioniert. Dann schaue ich mir praktische Tutorials an und probiere Sachen in einer Sandbox-Umgebung aus, um praktische Erfahrungen zu sammeln. Wenn ich kann, rede ich mit Kollegen über den Service oder schaue in Foren rein, um zu sehen, wie andere ihn nutzen. Diese Mischung aus Theorie und Praxis hilft mir, mich schnell mit neuen Tools vertraut zu machen.

Erzähl mal, wie du bei der Entwicklung von AWS-Lösungen Sicherheit und Effizienz unter einen Hut bringst.

- Was wir von dir erwarten: Der Interviewer schaut, ob du strategisch über Sicherheit nachdenken kannst und dabei auch die Leistung im Blick behältst. Das Ziel ist, dass du die besten Sicherheitspraktiken mit der Notwendigkeit der betrieblichen Effizienz in Einklang bringen kannst.

- Beispielantwort: Ich finde, dass Sicherheit und Effizienz Hand in Hand gehen. Wenn ich AWS-Lösungen entwerfe, denke ich zuerst an die Sicherheit, indem ich IAM-Richtlinien, Netzwerkisolierung mit VPCs und Datenverschlüsselung einsetze. Um effizient zu sein, achte ich darauf, dass diese Sicherheitsmaßnahmen keine unnötigen Verzögerungen verursachen, indem ich die Konfigurationen optimiere und skalierbare Dienste wie AWS Lambda für rechenintensive Aufgaben wähle. Mein Ansatz ist es, sichere Architekturen zu entwickeln, die auch reaktionsschnell und kostengünstig sind.

Fazit

Dieser Artikel bietet einen umfassenden Leitfaden mit AWS-Interviewfragen für Leute mit unterschiedlichem Fachwissen – von denen, die gerade erst anfangen, sich mit AWS zu beschäftigen, bis hin zu erfahrenen Profis, die ihre Karriere vorantreiben wollen.

Egal, ob du dich auf dein erstes AWS-Vorstellungsgespräch vorbereitest oder eine höhere Position anstrebst, dieser Leitfaden ist eine super Hilfe. Es hilft dir nicht nur dabei, auf Interviewfragen zu antworten, sondern auch, dich intensiv mit der AWS-Plattform auseinanderzusetzen, sodass du ihre umfangreichen Funktionen besser verstehst und anwenden kannst.

Lass dich für deine Traumrolle als Data Engineer zertifizieren

Unsere Zertifizierungsprogramme helfen dir, dich von anderen abzuheben und potenziellen Arbeitgebern zu beweisen, dass deine Fähigkeiten für den Job geeignet sind.

FAQs

Brauche ich eine AWS-Zertifizierung, um einen Job in der Cloud zu kriegen?

Auch wenn es nicht zwingend nötig ist, zeigen AWS-Zertifizierungen wie die AWS Certified Solutions Architect Associate oder AWS Certified Developer Associate, dass du was drauf hast, und machen deinen Lebenslauf besser. Viele Chefs schätzen Zertifikate als Nachweis deiner Fähigkeiten, aber praktische Erfahrung ist genauso wichtig.

Welche AWS-Services sind für Vorstellungsgespräche am wichtigsten?

Die wichtigsten AWS-Services hängen von der Stelle ab, auf die du dich bewirbst. Ein paar ganz wichtige sind:

- Berechnen: EC2, Lambda.

- Lagerung: S3, EBS, Glacier.

- Vernetzung: VPC, Route 53, ELB.

- Sicherheit: IAM, KMS.

- Datenbanken: RDS, DynamoDB.

- DevOps Tools: CloudFormation, CodePipeline.

Welche nicht-technischen Fähigkeiten sind wichtig, um bei einem AWS-Vorstellungsgespräch gut abzuschneiden?

Neben dem Fachwissen checken Arbeitgeber oft auch:

- Problemlösung: Kannst du skalierbare, kostengünstige Lösungen entwickeln?

- Kommunikation: Kannst du technische Konzepte den Beteiligten klar erklären?

- Zeitmanagement: Wie legst du Prioritäten bei Aufgaben fest und schaffst es, Termine in einem dynamischen Umfeld einzuhalten?

- Teamwork: Kannst du gut in Teams mit Leuten aus verschiedenen Bereichen zusammenarbeiten?

Was ist, wenn ich bei einem AWS-Vorstellungsgespräch die Antwort auf eine technische Frage nicht weiß?

Es ist okay, nicht alles zu wissen. Statt zu raten, sei ehrlich:

- Erzähl mal, wie du vorgehen würdest, um die Antwort zu finden (z. B. indem du die AWS-Dokumentation checkst oder Tests machst).

- Zeig dein Verständnis für das Gesamtkonzept, indem du dein Wissen dazu hervorhebst.

Wie kann ich mein Gehalt für einen Job im Bereich AWS verhandeln?

- Schau dir die marktüblichen Gehälter für deine Position und deinen Standort auf Websites wie Glassdoor oder Payscale an.

- Heb deine Zertifizierungen, relevante Erfahrungen und Projekte bei den Verhandlungen hervor.

- Zeig, wie deine Fähigkeiten dem Unternehmen einen Mehrwert bringen können, zum Beispiel durch Kosteneinsparungen oder eine zuverlässigere Infrastruktur.

Was soll ich machen, wenn ich bei einer AWS-Zertifizierungsprüfung oder einem Vorstellungsgespräch durchfalle?

- Finde deine Schwachstellen mithilfe von Feedback oder deinem Prüfungsbericht heraus.

- Mach dir einen Plan, wie du diese Bereiche verbessern kannst.

- Nutze zusätzliche Ressourcen wie Übungsprüfungen oder praktische Übungen.

- Lass dich nicht entmutigen – viele Fachleute schaffen es erst beim zweiten oder dritten Versuch.

Zoumana ist ein vielseitiger Datenwissenschaftler, der sein Wissen gerne mit anderen teilt und anderen etwas zurückgibt. Er erstellt Inhalte auf YouTube und schreibt auf Medium. Er hat Freude am Sprechen, Programmieren und Unterrichten. Zoumana hat zwei Master-Abschlüsse. Den ersten in Informatik mit dem Schwerpunkt Maschinelles Lernen in Paris, Frankreich, und den zweiten in Datenwissenschaft an der Texas Tech University in den USA. Sein beruflicher Werdegang begann als Softwareentwickler bei Groupe OPEN in Frankreich, bevor er als Berater für maschinelles Lernen zu IBM wechselte, wo er End-to-End-KI-Lösungen für Versicherungsunternehmen entwickelte. Zoumana arbeitet bei Axionable, dem ersten nachhaltigen KI-Startup mit Sitz in Paris und Montreal. Dort arbeitete er als Data Scientist und implementierte KI-Produkte, vor allem NLP-Anwendungsfälle, für Kunden aus Frankreich, Montreal, Singapur und der Schweiz. Zusätzlich widmete er 5% seiner Zeit der Forschung und Entwicklung. Zurzeit arbeitet er als Senior Data Scientist bei der IFC, der Weltbankgruppe.