programa

La IA generativa de AWS representa el futuro de los servicios en la nube, ya que permite a las empresas crear contenido automatizado y trabajo basado en el conocimiento a través de modelos básicos que producen texto, imágenes y vídeo en tiempo real.

En este artículo, proporciono una visión general completa de los elementos esenciales de los métodos de implementación y los marcos de gobernanza necesarios para desarrollar soluciones de IA generativa listas para la producción.

AWS es el proveedor líder de servicios en la nube porque ofrece Amazon Bedrock junto con una infraestructura informática especializada y amplias capacidades de integración que superan a otras plataformas en la nube.

Si eres nuevo en AWS, este curso introductoriote proporciona una base sólida antes de sumergirte en los detalles específicos de la IA generativa.

Comprensión de los componentes básicos

En esta sección, exploraremos los componentes básicos que impulsan la IA generativa de AWS.

Ecosistema del modelo básico

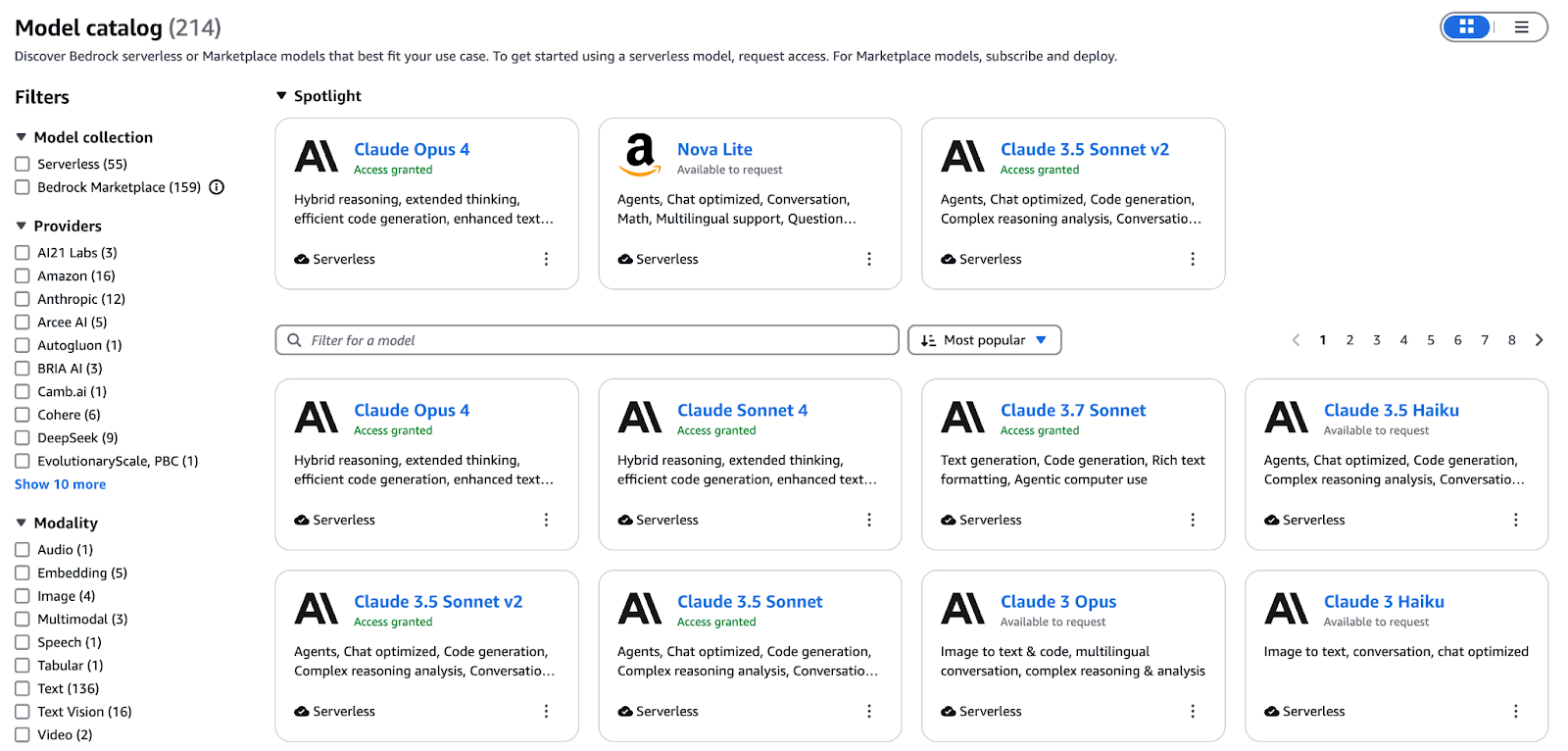

Bedrock sirve como plano de control gestionado para toda la IA generativa en AWS. Ofrece una API coherente para implementar, escalar y proteger modelos básicos, desde el aprovisionamiento de terminales hasta la facturación, para que puedas centrarte en crear indicaciones e integrar la IA en lugar de gestionar la infraestructura.

Diagrama conceptual que ilustra el ecosistema del modelo básico de AWS.

Elcatálogo Bedrockunifica modelos para texto, imágenes, vídeo e incrustaciones en una única interfaz. Las ofertas principales incluyen:

- Titan Text (Premier, Express, Lite): Ventanas de contexto de hasta 32 000 tokens para diálogos complejos.

- Nova Canvas: Generación e retoque de imágenes a partir de texto con alta fidelidad para activos creativos seguros para la marca.

- Nova Reel: Vídeos animados cortos generados a partir de una sola indicación.

- Incrustaciones multimodales Titan G1: Codifica texto e imágenes en un espacio vectorial compartido para la búsqueda de similitudes y RAG.

Ajusta los modelos con tus datos etiquetados o continúa el preentrenamiento en corpus específicos del dominio a través de la consola Bedrock o el SDK. Una vez completada la formación, el conjunto de herramientas de evaluación de Bedrock realiza comparaciones paralelas e informa sobre la precisión, la latencia y el coste por token, para que puedas elegir de forma objetiva la variante óptima para los SLA de producción.

Además de las familias Titan y Nova de AWS, Bedrock te ofrece acceso a modelos de socios como Anthropic, Cohere, Mistral, AI21 Labs y muchos más. Aprovecha esta amplitud para:

- Crea asistentes de conocimiento basados en RAG que ofrecen respuestas precisas a partir de wikis internos.

- Genera textos e imágenes de marketing a gran escala con un tono de marca coherente.

- Integra la finalización y revisión de código impulsadas por IA en los flujos de trabajo de los programadores.

- Amplía los conjuntos de datos de entrenamiento sintetizando texto, imágenes o vídeos adaptados a tu ámbito.

Para profundizar en cómo Bedrock coordina estos modelos básicos en entornos de producción, consulta esta guía completa de Amazon Bedrock.

Infraestructura informática optimizada con IA

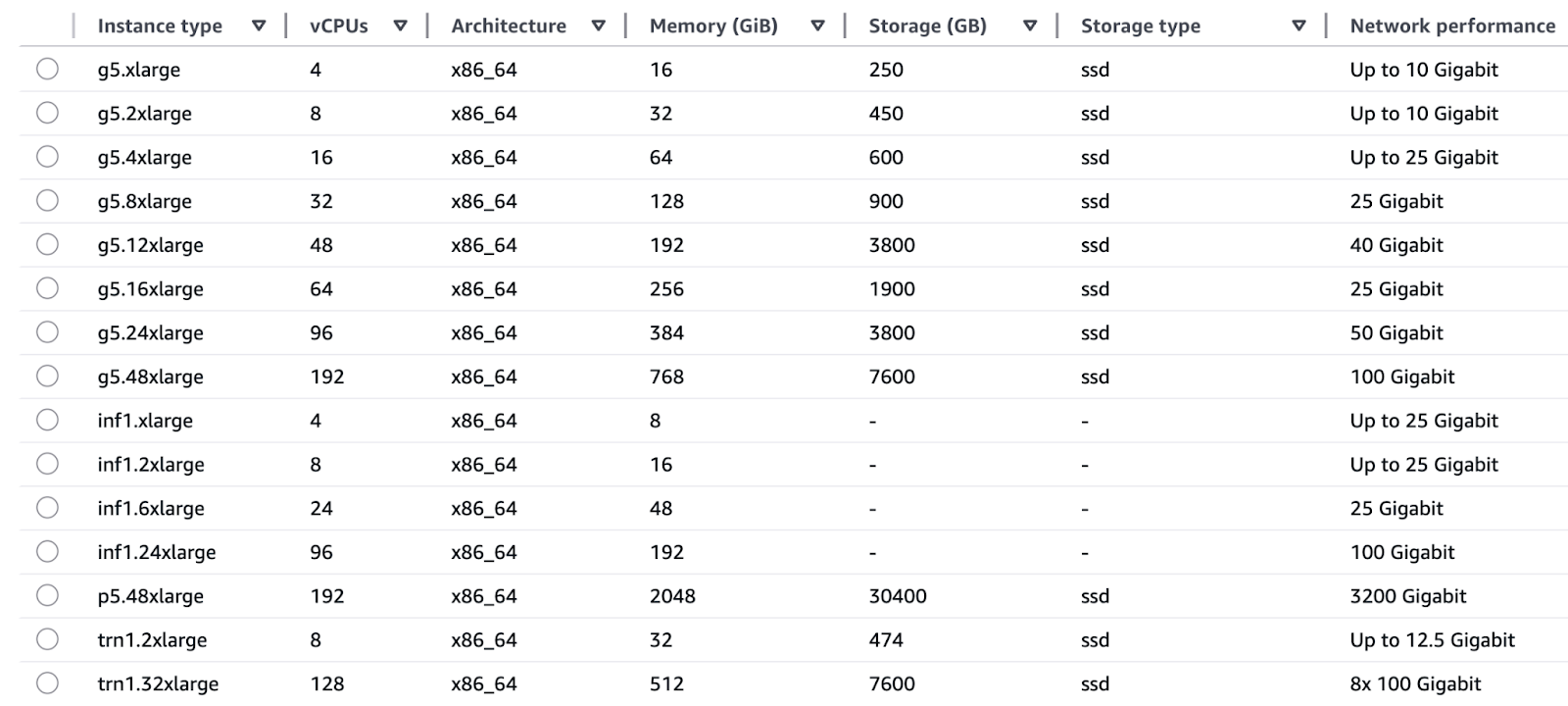

Las familias de instancias EC2 proporcionadas por AWS existen para satisfacer las necesidades específicas de las operaciones de formación e inferencia.

Formación:

- Las instancias Trn1 (Trainium) funcionan con chips AWS Trainium para proporcionar capacidades de formación en aprendizaje profundo, incluidos LLM y modelos de difusión a velocidades tres veces superiores y con un coste por hora reducido en comparación con las instancias basadas en GPU.

- Las GPU P5 y P4 (NVIDIA H100 y A100) ofrecen amplias capacidades de procesamiento paralelo gracias a la compatibilidad con precisión mixta, lo que las hace adecuadas tanto para pruebas a nivel de investigación como para procesos de reentrenamiento a gran escala.

Inferencia:

- Los chips AWS Inferential utilizados en los sistemas Inf1 e Inf2 permiten realizar inferencias en tiempo real con latencias de un solo dígito en milisegundos, al tiempo que ofrecen un coste por inferencia dos veces menor que las alternativas con GPU.

- G5 y G4dn (GPU NVIDIA A10G y T4) proporcionan un equilibrio rentable de rendimiento que se adapta a la aceleración de GPU en tiempo real en aplicaciones de chatbot y motores de recomendación.

Diagrama ilustrativo de la infraestructura informática optimizada para IA de AWS.

AWS logra una integración perfecta entre sus componentes de hardware y software diseñados a medida a través de Trainium para la formación y Inferentia para los chips de inferencia, que funcionan directamente con los servicios de AWS. Esta integración vertical da como resultado:

- La excelente relación calidad-precio en las cargas de trabajo de TensorFlow y PyTorch se traduce en un menor coste total de propiedad.

- La combinación de eficiencia energética y simplificación de las compras ayuda a los equipos a evitar la dependencia de un único proveedor de GPU.

- SageMaker y Bedrock implementan funciones de ajuste automático del tamaño que permiten a los usuarios seleccionar las configuraciones de silicio óptimas con unos simples clics, sin necesidad de gestionar los detalles a nivel de chip.

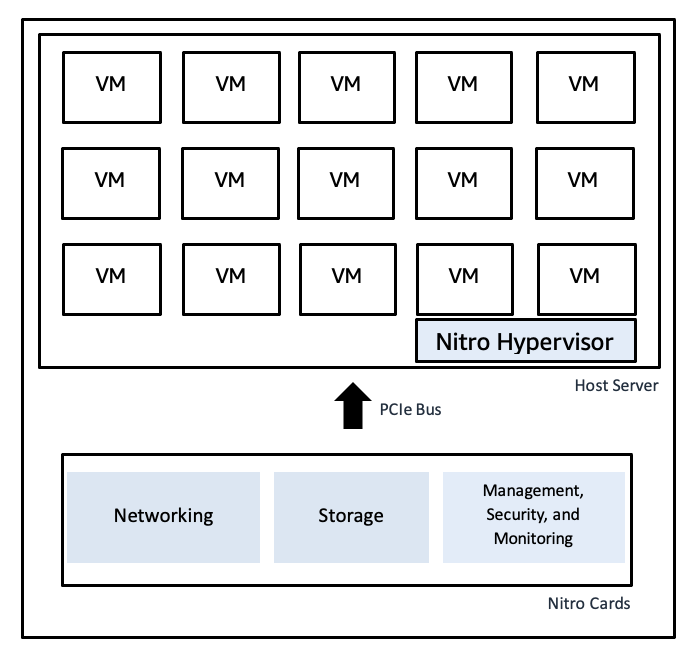

El sistema AWS Nitro utiliza tarjetas de hardware dedicadas para realizar funciones de virtualización, lo que proporciona velocidades rápidas de bare metal junto con un aislamiento seguro:

- El hipervisor Nitro mantiene un código base mínimo, lo que reduce las vulnerabilidades y mantiene las cargas de trabajo separadas entre sí.

- Las rutas de red y almacenamiento aceleradas por hardware funcionan con un alto rendimiento de E/S y bajos niveles de fluctuación, lo que evita picos de latencia y garantiza un rendimiento constante en momentos de carga máxima.

- La integración de Nitro con CloudTrail, CloudWatch y AWS Config proporciona una supervisión del cumplimiento normativo de extremo a extremo sin ninguna pérdida de rendimiento.

Diagrama ilustrativo del hipervisor Nitro de AWS

Diagrama ilustrativo del hipervisor Nitro de AWS

Explora el amplio ecosistema de computación, almacenamiento y análisis en este cursosobre tecnología y servicios en la nube de AWS.

Fundamentos de datos para una IA generativa robusta

El entrenamiento de modelos a alta velocidad y los procesos RAG necesitan acceder a datos limpios y correctamente gestionados:

- El sistema de almacenamiento de datos a escala de petabytes de Amazon S3 se integra con Lake Formation para la ingesta de conjuntos de datos sin procesar y curados, así como para funciones de catalogación y seguridad.

- La solución de almacenamiento de datos Amazon Redshift funciona como una plataforma para tablas estructuradas que proporcionan análisis rápidos y recuperación de datos.

- Las canalizaciones de transformación de datos creadas con AWS Glue y Athena permiten preparar tanto las características como el contexto para cargas de trabajo generativas y la ejecución de consultas ad hoc.

- Los mecanismos de gobernanza y linaje de datos garantizan que el entrenamiento de los modelos utilice entradas fiables, mientras que el conocimiento de la empresa fundamenta los resultados mediante el control de acceso y el seguimiento de la procedencia.

Marco de integración empresarial

Las capacidades de IA generativa de AWS se integran directamente con su amplio ecosistema para ofrecer soluciones integrales aptas para la producción. En esta sección se describe el proceso de combinación de Bedrock con sus servicios complementarios para desarrollar aplicaciones de IA generativa reales.

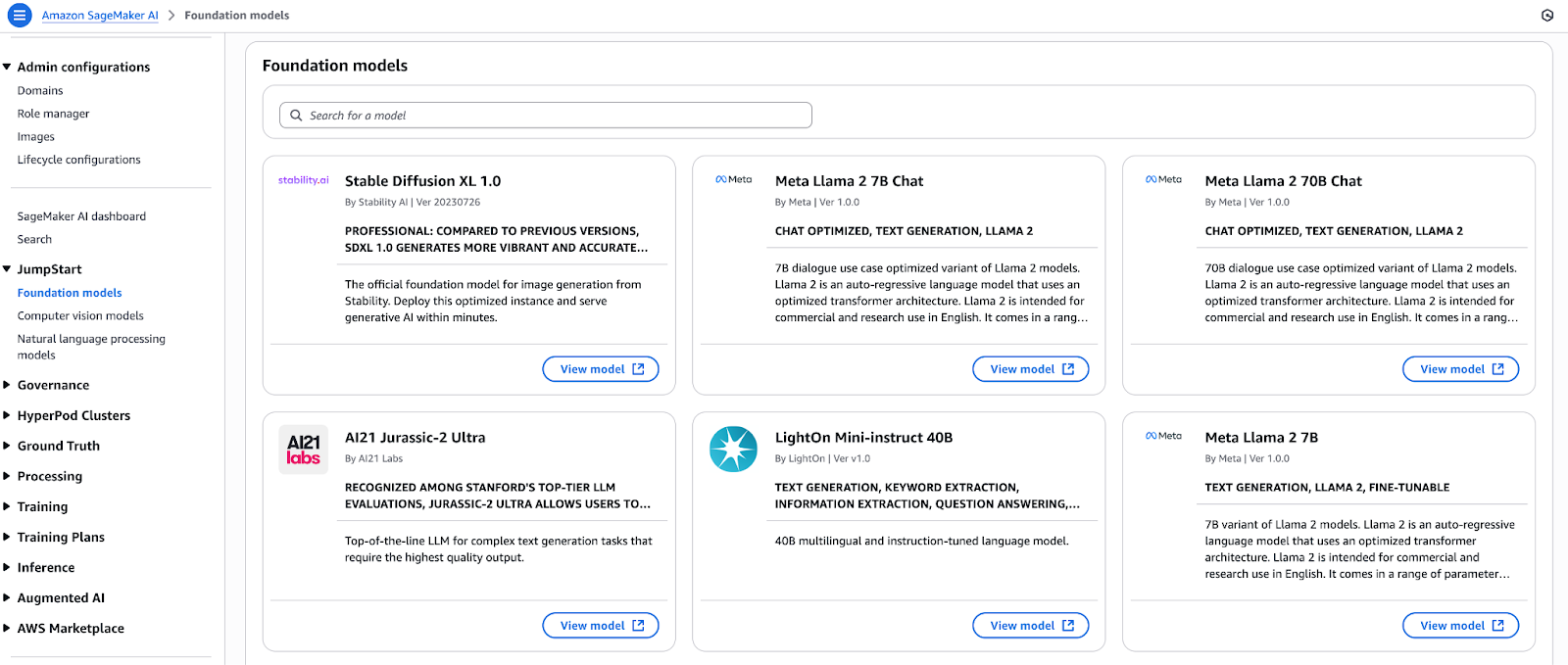

Ciclo de vida unificado de ML con SageMaker JumpStart y Bedrock

Selecciona modelos básicos del centro de modelos de SageMaker JumpStart e impleméntalos de inmediato. Puedes implementar numerosos modelos de código abierto y propietarios con un solo botón antes de registrarlos directamente en Amazon Bedrock. Los modelos introducidos en Bedrock obtienen acceso a:

- La moderación de contenidos y la aplicación de políticas se llevan a cabo mediante funciones de protección.

- Las bases de conocimiento proporcionan capacidades de generación aumentada por recuperación (RAG) para fuentes de datos privadas.

- La API de Converse mantiene la coherencia al proporcionar una capa de abstracción que elimina las variaciones específicas del modelo.

La arquitectura integrada permite a los programadores crear prototiposen SageMaker Studio y, a continuación, mejorarlos en Bedrock antes de implementarlos a través de canalizaciones de CI/CD sin modificar el código.

Este tutorial de SageMaker te guía a través del proceso de ajuste y despliegue de modelos utilizando la plataforma de ML insignia de AWS.

Diagrama ilustrativo que muestra el ciclo de vida unificado del ML con SageMaker JumpStart y Bedrock.

Diagrama ilustrativo que muestra el ciclo de vida unificado del ML con SageMaker JumpStart y Bedrock.

Orquestación de flujos de trabajo con Amazon Bedrock Agents

A través de Bedrock Agents, puedes integrar la IA generativa en tus aplicaciones operativas mediante la obtención automática de datos y su transformación antes de ejecutar acciones. Un agente solo requiere una configuración básica para:

- El sistema establece conexiones seguras con API RESTful, bases de datos y colas de mensajes.

- El sistema recopila documentos, métricas y datos de registro mientras realiza tareas de preprocesamiento antes de poner los datos a disposición de los modelos.

- El sistema realiza varias operaciones en segundo plano, que incluyen la validación del enriquecimiento y la notificación a través de llamadas de función secuenciales.

- El sistema genera resultados estructurados o conversacionales para su consumo por parte de sistemas posteriores.

Las funciones básicas de Agents permiten a los programadores concentrarse en la lógica empresarial en lugar de en el código de integración, lo que acelera la rentabilidad.

Creación de asistentes conversacionales con Amazon Q

Amazon Q es un servicio totalmente gestionado para desarrollar asistentes empresariales basados en RAG.

El servicio integra la funcionalidad multimodelo de Bedrock con:

- El almacén de datos (Redshift), el motor de búsqueda (OpenSearch) y los conectores de herramientas de BI están preconfigurados.

- El sistema incluye funciones integradas para gestionar diálogos de varios turnos, así como el contexto de la sesión y la generación de respuestas con estilo de cita.

- La plataforma cuenta con una herramienta de desarrollo de interfaces de usuario con poco código para crear prototipos rápidamente.

A través de Q, las organizaciones empresariales crean chatbots orientados al cliente, junto con paneles de control ejecutivos y servicios de asistencia técnica específicos para cada dominio, que se implementan en cuestión de semanas en lugar de meses.

La lente de IA generativa bien diseñada implementa las prácticas recomendadas en cada paso del desarrollo de cargas de trabajo generativas.

Lente de IA generativa bien diseñada

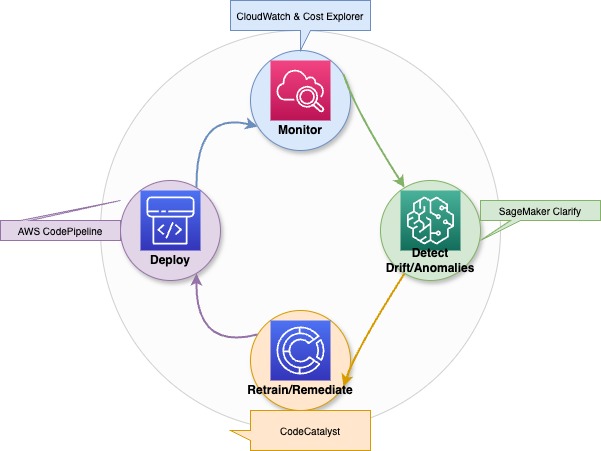

La lente de IA generativa de AWS amplía los cinco pilares delmarco Well-Architected Framework a las cargas de trabajo generativas de AWS. El marco incluye sistemas automatizados de supervisión de modelos y mecanismos de detección de desviaciones, junto con activadores de reciclaje con gestión de artefactos de versión y seguimiento de métricas de inferencia.

Estos son los pilares:

- Seguridad: Aplica la gestión de identidades y acceso con privilegios mínimos, utiliza PrivateLink para los puntos de conexión de Bedrock, cifra los datos en tránsito y en reposo, y aplica medidas de protección con filtrado de contenido.

- Fiabilidad: La solución utiliza la implementación de terminales basada en AZ, el autoescalado, los disyuntores y la implementación Canary para lanzamientos sin riesgos.

- Eficiencia del rendimiento: Elige familias de instancias óptimas, almacena en caché las solicitudes frecuentes y por lotes, y aprovecha los puntos de conexión sin servidor para escalar a cero.

- Optimización de costes: La selección del modelo debe seguir los requisitos de latencia al utilizar capacidad puntual o reservada, la ingeniería rápida debe minimizar el uso de tokens y el análisis de costes debe realizarse en Cost Explorer.

- Sostenibilidad: Dimensiona correctamente la capacidad informática, utiliza chips energéticamente eficientes (Trainium, Inferentia), archiva los datos inactivos en S3 Glacier y adopta canalizaciones sin servidor para reducir los recursos inactivos.

Para aquellos que desean obtener la certificación, el programa AWS Cloud Practitionerse ajusta perfectamente a los conocimientos básicos que se tratan aquí.

Aceleración de la adopción con los socios de AWS

La red de socios de AWS ofrece asistencia a las empresas acelerando su adopción de los servicios de AWS a través de aceleradores de soluciones y servicios de socios. Cada organización empresarial es diferente, por eso AWS ha creado la red de socios con aceleradores de IA generativa específicos para diferentes sectores y casos de uso.

- La red de socios de AWS incluye socios tecnológicos que ofrecen aplicaciones prediseñadas junto con conectores y modelos básicos específicos para cada dominio, disponibles a través de AWS Marketplace.

- El programa Generative AI Accelerator ayuda a las startups ofreciéndoles créditos, junto con tutoría y planes de mejores prácticas para acelerar el desarrollo de la prueba de valor.

- El uso de los marcos de los socios APN, junto con los patrones de soluciones validados por AWS, permite a los equipos reducir el riesgo durante los proyectos piloto mientras implementan la IA generativa en toda la organización con total garantía.

Descripción general de los servicios de IA compatibles con AWS

La capacidad de la IA generativa para crear contenido nuevo no se ajusta a los requisitos de las aplicaciones del mundo real, que necesitan procesar y comprender datos a través de diversos formatos de presentación.

AWS ofrece una colección de servicios de apoyo que se integran con tus procesos generativos para convertir documentos no estructurados en datos estructurados, extraer información de imágenes y permitir conversaciones naturales y la entrega de resultados en cualquier idioma o voz.

Estos son los más populares:

- Amazon Textract

- El sistema detecta automáticamente el texto impreso, las tablas y los datos de formularios dentro de los documentos escaneados y los archivos de imagen.

- El sistema utiliza canalizaciones RAG para procesar documentos específicos del dominio, incluidos contratos, informes y facturas.

- El sistema organiza el contenido desorganizado para prepararlo para plantillas rápidas y ajustar conjuntos de datos.

- Amazon Rekognition

- El sistema utiliza el análisis de imágenes y vídeos para identificar objetos, escenas, texto, rostros y actividades.

- El sistema genera metadatos contextuales (etiquetas, puntuaciones de confianza) para la generación multimodal.

- El sistema permite a los usuarios implementar lógica condicional (por ejemplo, «solo describir imágenes que contengan personas») en sus aplicaciones de usuario final.

- Amazon Polly

- El servicio transforma el texto escrito en audio hablado similar al humano en múltiples voces e idiomas.

- La capacidad de salida de audio transforma los chatbots generativos y los asistentes en interfaces interactivas.

- El sistema admite el marcado SSML para controlar la salida de voz mediante una pronunciación precisa, énfasis y gestión de pausas.

- Para descubrir cómo Polly permite obtener salidas de voz similares a las humanas en aplicaciones reales, consultaeste tutorial práctico.

- Amazon Lex

- El sistema desarrolla interfaces conversacionales mediante el reconocimiento automático del habla (ASR) y la comprensión del lenguaje natural (NLU).

- El sistema sirve como interfaz frontal para los generadores back-end, gestionando la administración de sesiones y las operaciones de relleno de espacios.

- El sistema se conecta directamente a AWS Lambda para ejecutar los puntos finales de Bedrock o SageMaker y generar respuestas dinámicas.

- Amazon Translate

- El servicio ofrece traducción automática neuronal inmediata para más de 70 idiomas diferentes.

- El sistema adapta los resultados generativos para que sean accesibles a un público internacional.

- El sistema estandariza las entradas multilingües, lo que permite que un único modelo dé servicio a usuarios de diferentes regiones.

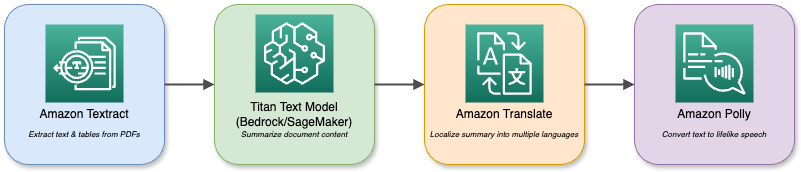

Diagrama ilustrativo de los distintos servicios e interacciones de AWS.

Tus modelos básicos en Bedrock o SageMaker se pueden combinar con estos servicios para crear aplicaciones multimodales complejas.

Un asistente de análisis de documentos, por ejemplo, utiliza Textract para importar archivos PDF y, a continuación, utiliza Titan Text para resumirlos antes de traducir el resumen a varios idiomas y reproducirlo a través de Polly. El ecosistema componible te permite combinar diversas capacidades de IA para satisfacer cualquier requisito empresarial.

Patrones de implementación y casos de uso

La IA generativa ofrece sus mejores resultados cuando utilizas patrones bien diseñados para abordar problemas empresariales reales.

En esta sección se presentan cuatro planes de implementación específicos, que incluyen la generación aumentada con recuperación y los asistentes para programadores y empresas, así como escenarios adicionales de gran valor que puedes implementar hoy mismo.

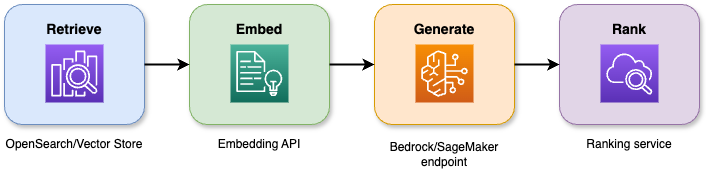

Arquitecturas de generación aumentada por recuperación (RAG)

La combinación de las capacidades de búsqueda con grandes modelos lingüísticos en la generación aumentada por recuperación produce respuestas precisas que se mantienen fieles al contexto. El proceso de cuatro etapas funciona de la siguiente manera:

- El sistema recupera los N documentos o pasajes más relevantes de un almacén vectorial o índice de búsqueda mediante una consulta.

- El sistema transforma tanto los documentos como las consultas de los usuarios en incrustaciones semánticas, lo que permite una mejor alineación contextual.

- El sistema envía tanto la consulta como el contexto recuperado a un modelo básico para generar una respuesta.

- El sistema emplea un modelo secundario o heurístico para puntuar y volver a clasificar los resultados candidatos, presentando la respuesta más adecuada.

Diagrama ilustrativo que muestra una arquitectura de generación aumentada por recuperación (RAG).

Ventajas y ganancia en precisión:

- El sistema reduce las alucinaciones en un 40 % en comparación con los métodos de generación básicos.

- Los proyectos piloto de bases de conocimientos empresariales demuestran que la relevancia de las respuestas mejora entre un 20 % y un 30 %.

- El tiempo medio de interacción del usuario disminuye en un 25 % cuando se utilizan sistemas de asistencia virtual.

Aplicaciones empresariales:

- El contenido interno de la wiki sirve de base para que los chatbots y los asistentes virtuales proporcionen resúmenes de tickets y consejos para la resolución de problemas.

- Los sistemas RAG integrados con interfaces de búsqueda permiten a los usuarios explorar amplias colecciones de documentos mediante búsquedas en lenguaje natural.

- El sistema permite a los asistentes jurídicos, legales y normativos proporcionar citas de pasajes originales cuando los usuarios lo solicitan.

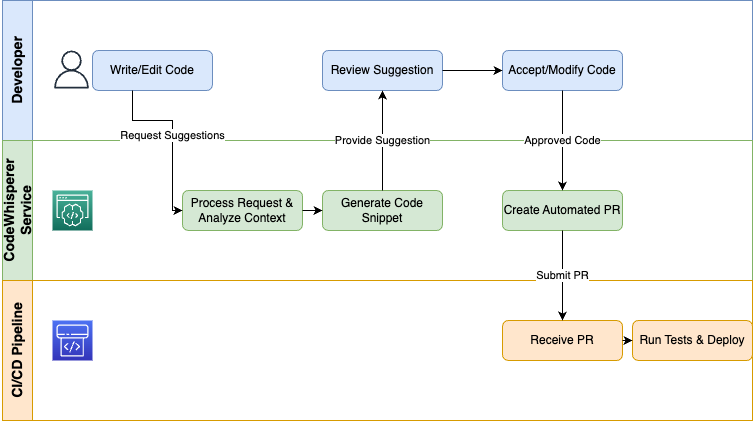

Flujos de trabajo de generación de código

AWS CodeWhisperer ofrece IA generativa directamente a los programadores a través de sus IDE y canalizaciones de CI/CD para automatizar las tareas repetitivas y acelerar los procesos de codificación:

- El sistema ofrece tres funciones principales, que incluyen sugerencias de código en tiempo real, finalización de fragmentos y generación de pruebas que se adaptan al contexto de codificación actual.

- Los equipos logran una entrega de funciones más rápida en un 30 %, mientras que los errores de sintaxis en los prototipos iniciales se reducen en un 50 %.

- El canal CodeCatalyst permite a los usuarios crear automáticamente fragmentos de código IaC de infraestructura, pruebas unitarias y scripts de implementación a través de la integración con CodeWhisperer.

- La plataforma admite múltiples lenguajes de programación, incluidos Python, Java, JavaScript/TypeScript, C#, Go y otros, lo que proporciona ventajas a toda tu pila tecnológica.

Diagrama ilustrativo que muestra un flujo de trabajo de generación de código.

Las organizaciones que utilizan CodeWhisperer como asistente para programadores eliminan el trabajo repetitivo, aplican normas de codificación y permiten a los ingenieros dedicar su tiempo a actividades valiosas de diseño y depuración.

Ten en cuentaque CodeWhisperer pasará a formar parte de Amazon Q Developer.

Asistentes empresariales

Amazon Q Business funciona como una solución de bajo código impulsada por RAG, que permite a los usuarios desarrollar asistentes conversacionales que recuperan datos empresariales a través de preguntas.

Arquitectura:

- El sistema recupera datos de Redshift, OpenSearch, SharePoint y S3 a través de conectores.

- El motor RAG recupera el contexto adecuado antes de activar los modelos básicos.

- El gestor de diálogos controla la gestión de sesiones multiturno, incluyendo el relleno de ranuras y las operaciones de estado.

- La capa de interfaz de usuario responde a los widgets de chat, los canales de voz y las integraciones de Slack.

Escenarios de implementación:

- La transcripción y resumen automáticos de las tareas pendientes a través de los asistentes de reuniones permiten a los equipos ahorrar más de dos horas de trabajo cada semana.

- La implementación de bots de autoservicio desvía las consultas rutinarias, lo que se traduce en una reducción del 30 % en el tiempo de gestión.

- Los paneles ejecutivos proporcionan información en lenguaje natural sobre ventas, inventario e indicadores clave de rendimiento (KPI) para usuarios que no necesitan formación en BI.

Los asistentes ayudan a las organizaciones a optimizar el trabajo intelectual, reducir los costes operativos y permitir a los empleados alcanzar mayores niveles de productividad.

Casos de uso adicionales de alto valor

El valor de la IA generativa va más allá del RAG, la generación de código y los asistentes, y se extiende a otros muchos ámbitos:

- Estos sistemas pueden generar descripciones de productos personalizadas, campañas por correo electrónico e interacciones por chat basadas en perfiles individuales y análisis de comportamiento.

- La combinación de Textract con modelos de análisis sintáctico y generación permite la clasificación, el marcado y el enrutamiento automáticos de facturas, contratos y reclamaciones, así como tareas posteriores (creación de tickets, enrutamiento de aprobaciones y generación de informes) mediante una lógica de decisión basada en modelos.

- El análisis de transcripciones de asistencia técnica, publicaciones en redes sociales y llamadas de ventas mediante análisis conversacional revela tendencias de opinión, riesgos de cumplimiento y recomendaciones prácticas.

Comienza con estos patrones para establecer programas piloto que demuestren un claro retorno de la inversión antes de pasar a la optimización y la ampliación en toda la organización.

Modelo de seguridad y gobernanza

Las empresas deben implementar controles de seguridad y prácticas de gobernanza en todas las etapas del ciclo de vida de la IA cuando adoptan la IA generativa.

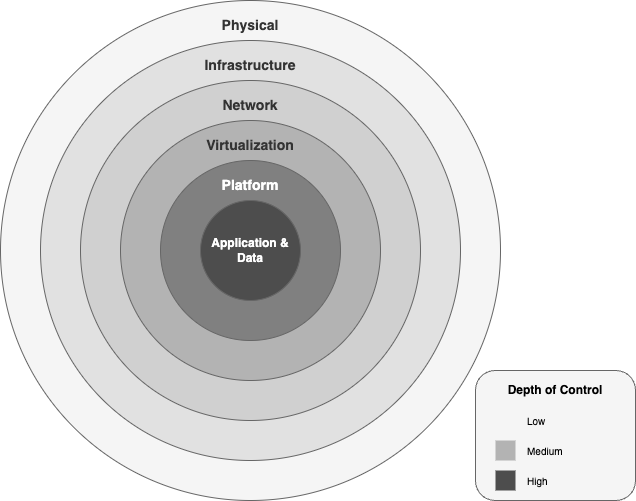

AWS proporciona un marco integral de seguridad y cumplimiento normativo que abarca desde centros de datos físicos hasta políticas a nivel de aplicaciones, lo que permite innovar con confianza.

Arquitectura de protección de datos

AWS protege las cargas de trabajo de IA generativa a través de seis capas de seguridad concéntricas:

- La capa física de los centros de datos cuenta con controles de acceso multifactoriales, selección biométrica y supervisión ininterrumpida, lo que garantiza que el contacto con el hardware quede restringido al personal autorizado.

- La red global de AWS protege el tráfico de IA a través de conexiones de fibra privada y mitigación de DDoS, así como AWS Shield Advanced, al tiempo que mantiene un alto rendimiento de la red mediante la aislar el tráfico de la Internet pública.

- Los puntos finales de los modelos y las canalizaciones de datos permanecen seguros gracias a la combinación de VPC con grupos de seguridad granulares, ACL de red y puntos finales PrivateLink, que operan dentro de tus redes privadas.

- El sistema Nitro transfiere las operaciones de virtualización a componentes de hardware especializados, que proporcionan velocidad y protección basada en hardware desde el nivel del sistema operativo, lo que garantiza un rendimiento óptimo y la máxima seguridad. protección basada en hardware contra el intercambio no autorizado de datos entre máquinas virtuales.

- La capa de plataforma de los puntos finales de Bedrock y SageMaker se integra con AWS KMS para las claves gestionadas por el cliente, utiliza el cifrado TLS 1.2+ para la transmisión de datos y aplica permisos de IAM basados en el principio del privilegio mínimo.

- La capa de aplicación y datos implementa políticas de recursos detalladas con cifrado AES-256 en reposo y en tránsito e integran registro de auditoría a través de CloudTrail y CloudWatch para proteger y registrar todas las llamadas a la API.

Diagrama ilustrativo de las capas de seguridad dentro del marco de IA generativa de AWS.

Aislamiento de datos y cumplimiento normativo:

- Cada instancia de inferencia de Bedrock opera dentro de tu VPC mientras accede y modifica los buckets de S3 que gestionas.

- Seleccionas las CMK gestionadas por el cliente a través de AWS KMS y tienes la opción de utilizar almacenes de claves externos (XKS/HYOK) para cumplir los requisitos de cumplimiento normativo soberano.

- AWS cuenta con múltiples certificaciones, entre las que se incluyen ISO 27001 y SOC 1/2/3 Fed, RAMP High, HIPAA, PCI, DSS y GDPR, que se extienden automáticamente a tus cargas de trabajo de IA generativa sin necesidad de duplicar esfuerzos.

Marco de IA responsable

El desarrollo de la confianza en la IA generativa requiere la implementación de protocolos éticos y de seguridad en cada etapa de la invocación del modelo. AWS implementa una gobernanza responsable de la IA a través del siguiente marco:

- Los principios éticos de AWS priorizan la equidad, la privacidad, la transparencia y la responsabilidad para evitar sesgos discriminatorios en los modelos y mantener una documentación clara del linaje de los datos y la lógica de las decisiones.

- El sistema Bedrock Guardrails proporciona filtros basados en políticas que comprueban tanto los datos de entrada como los resultados de salida en función de categorías que incluyen el discurso de odio y la violencia, la autolesión y la desinformación. Las API Invoke y ApplyGuardrail permiten a los usuarios implementar barreras de seguridad para realizar comprobaciones de seguridad, ya sea de forma independiente o a través de la API Invoke.

- El sistema registra todas las solicitudes y decisiones de protección a través de CloudTrail, mientras que las tarjetas de modelo y los informes de evaluación muestran métricas de rendimiento, posibles sesgos y compensaciones entre coste y latencia.

- El sistema proporciona una supervisión continua a través de la detección de sesgos de SageMaker Clarify y los flujos de trabajo de revisión con intervención humana para los resultados de baja confianza, así como alertas automáticas de detección de desviaciones para el reentrenamiento o la revocación del modelo.

Estas capas y prácticas establecen una postura de defensa en profundidad para la IA generativa empresarial, lo que te permite innovar mientras mantienes los más altos estándares de seguridad, cumplimiento y responsabilidad ética.

Estrategias de optimización de costes

El proceso de control de los presupuestos de IA generativa exige tanto un conocimiento completo de los mecanismos de fijación de precios como prácticas continuas de gestión de costes. En esta sección se explica la estructura de precios de AWS para cargas de trabajo de IA, al tiempo que se presenta un ejemplo de TCO para una implementación de tamaño medio y estrategias para reducir los gastos.

Análisis del modelo de precios

Los precios de la IA generativa de AWS se dividen en cuatro dimensiones principales:

- Calcular los costes

- Horas de endpoint: se cobran por hora de instancia, y varían según la familia.

- Inf1.xlarge a 0,228 $/hora

- G5.xlarge a 1,006 $/hora

- Trabajos de formación: facturados por hora de instancia en hardware Trn1, P4 o P5 (por ejemplo, Trn1.32xlarge a 21,50 $/hora).

- Tarifas por token/solicitud

- Tokens inmediatos: 0,0008 $ por cada 1000 tokens

- Fichas de finalización: 0,0016 $ por cada 1000 fichas.

- Almacenamiento y transferencia de datos

- Artefactos modelo: S3 Estándar a 0,023 $/GB al mes

- Salida de datos: 0,09 $/GB más allá del nivel gratuito

- Personalización y evaluación

- Ajuste: tarifas adicionales por hora de formación por instancia, más gastos mínimos de procesamiento de datos.

- Ejecuciones de evaluación: tarifas de tokens para comparaciones entre valores de referencia y valores personalizados.

Estrategias de optimización de costes

- Selecciona el silicón adecuado: Utiliza Inferentia (Inf1/Inf2) para inferencias de gran volumen y baja latencia, y Trainium (Trn1) para entrenamientos a gran escala con el fin de reducir el coste por hora de TPU.

- Ajustar las indicaciones de lote y caché: Agrupa las solicitudes similares y almacena en caché las respuestas más populares para reducir el gasto repetitivo de tokens.

- Puntos finales multimodelo: Aloja varios modelos más pequeños detrás de un único punto final, sacrificando la latencia máxima a cambio de una reducción significativa de los costes en horas de inactividad.

- Capacidad disponible y reservada: Comprométete a una fracción de la capacidad base con instancias reservadas o utiliza Spot para cargas de trabajo por lotes no críticas.

- Ingeniería rápida: Optimiza las instrucciones para minimizar el uso de tokens por solicitud sin sacrificar la calidad.

Comparación de arquitecturas

|

Arquitectura |

Calcular el factor de coste |

Factor determinante del coste de los tokens |

El más adecuado |

|

Chatbots en tiempo real |

Muchos pequeños terminales que funcionan las 24 horas del día, los 7 días de la semana. |

Alta tasa de solicitudes, tokens pequeños |

Atención al cliente, servicios de asistencia técnica |

|

Generación por lotes |

Instancias grandes de corta duración |

Pocas ráfagas grandes de tokens |

Generación de informes, aumento de datos |

|

Tuberías RAG |

Búsqueda combinada + inferencia |

Token de recuperación + token de generación |

Asistentes basados en el conocimiento |

Modelo de coste total de propiedad

A continuación se muestra un ejemplo de TCO mensual para un proyectopiloto de IA generativa de tamaño medio:

|

Elemento de coste |

Coste unitario |

Uso |

Coste mensual |

|

Puntos finales de inferencia (Inf1.xl) |

0,228 $/hora |

3 criterios de valoración × 24 horas × 30 días |

$492.48 |

|

Uso de tokens (Titan Express) |

0,0024 $ /1 token K |

3 tokens M al día × 30 días |

216,00 $ |

|

Almacenamiento S3 (artefactos de modelo) |

0,023 $/GB al mes |

10 000 GB |

$230 |

|

Salida de datos |

$0.09 /GB |

1 TB |

$90 |

|

Glue ETL (preparación de características) |

0,44 $/DPU-hora |

20 horas DPU |

$8.80 |

|

Total |

$1,037.28 |

Palanca de optimización clave:

- Autoescalado a cero: Elimina los puntos finales inactivos cuando el tráfico disminuye.

- Puntos finales multimodelo: Consolida los modelos para reducir los cargos por horas de inactividad hasta en un 60 %.

- Reservado y Spot: Asegúrate tarifas con descuento para la capacidad básica y activa Spot para los trabajos que no sean sensibles a la latencia.

- Compresión rápida: Refactoriza las indicaciones para recortar tokens superfluos, recortando entre un 10 y un 15 % del gasto en tokens.

Gestión continua de los costes:

- Utiliza la calculadora de precios de AWS paramodelar escenarios antes del lanzamiento.

- Supervisa el uso real en AWS Cost Explorer, establece presupuestos y alertas para detectar anomalías.

- Etiqueta todos los recursos de IA para generar informes claros de reembolso y showback.

La combinación de una arquitectura consciente de los precios con optimizaciones específicas y una supervisión continua te permite escalar la IA generativa sin incurrir en costes excesivos.

Hoja de ruta para la implementación

El proceso de escalado de la IA generativa, desde el concepto hasta la producción, requiere una metodología sistemática por fases. La hoja de ruta ofrece un enfoque paso a paso, que comienza con evaluaciones iniciales, pasa por pruebas piloto de concepto y culmina con la creación de una plataforma resistente y apta para empresas.

Fases de evaluación y piloto

El primer paso consiste en comprobar la viabilidad y obtener el acuerdo de las partes interesadas antes de proceder al desarrollo completo de la arquitectura.

- Análisis de deficiencias y establecimiento de objetivos

- Realizar entrevistas con los propietarios de las empresas para obtener los requisitos de los casos de uso, los criterios de éxito y los objetivos de retorno de la inversión.

- Revisa las fuentes de datos actuales, los controles de calidad de seguridad y las capacidades de ML.

- Identifica las deficiencias en materia de cumplimiento o privacidad (por ejemplo, el tratamiento de la información de identificación personal) que debe abordar tu programa piloto.

- Desarrollo de pruebas de concepto (PoC)

- Selecciona un caso de uso de alto valor (por ejemplo, un bot de asistencia basado en RAG o un resumidor de documentos) para la primera fase.

- Configura una infraestructura mínima: un punto final Bedrock o SageMaker conectado a un pequeño conjunto de datos a través de S3 u OpenSearch.

- Define métricas clave (precisión, latencia, coste por solicitud) e implementa paneles de CloudWatch.

- Prototipado rápido con guías paso a paso

- Utiliza los proyectos de ejemplo de la biblioteca de soluciones de AWS (por ejemplo, RAG Chatbot o la demostración de CodeWhisperer) para crear el prototipo.

- Repite rápidamente las indicaciones y las estrategias de recuperación, y registra lo aprendido en una wiki compartida.

- Validación de las partes interesadas

- Mostrar el prototipo funcional a los usuarios finales y recopilar comentarios sobre la calidad de los resultados y la experiencia de usuario.

- Refina el alcance, añade o elimina fuentes de datos y ajusta los parámetros del modelo en función del uso real.

- Obtener el patrocinio ejecutivo y el presupuesto para la siguiente fase.

Fases de cimentación y escalado

La prueba de concepto da como resultado el desarrollo de la plataforma fundamental antes de que el sistema pueda adoptarse de forma generalizada.

- Construcción de la base de la plataforma

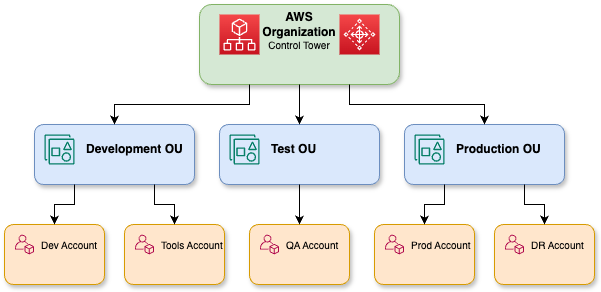

- Es necesario establecer la estructura de cuentas múltiples de AWS Control Tower para los límites de las unidades organizativas de desarrollo, prueba y producción en la zona de aterrizaje.

- Implementa roles y políticas de IAM, AWS SSO y controles de privilegios mínimos para el acceso a modelos y canalizaciones de datos.

- Los VPC deben configurarse con puntos de conexión PrivateLink. Se deben habilitar las CMK de Bedrock/SageMaker KMS y se debe implementar la supervisión de GuardDuty.

- Automatiza el ETL con AWS Glue/Athena, cataloga los activos en Lake Formation y sincroniza los almacenes de conocimientos para RAG.

Una representación detallada de las organizaciones de AWS.

- MLOps y gobernanza de modelos

- El proceso de reentrenamiento, evaluación e implementación del modelo debe automatizarse mediante canalizaciones de CI/CD que utilicen CodeCatalyst o CodePipeline.

- Se debe crear un registro de modelos en SageMaker o un catálogo respaldado por Git para artefactos basados en versiones y ajustados con precisión.

- El sistema debe detectar automáticamente las desviaciones y realizar un reentrenamiento programado para garantizar el rendimiento y el cumplimiento.

- Ampliación a la producción

- Los patrones de tráfico variables deben adaptarse mediante el uso de puntos finales Bedrock o SageMaker con autoescalado.

- El uso de puntos finales multimodelo permite alojar varios FM más pequeños detrás de una API, lo que se traduce en una reducción de hasta el 60 % en los costes de inactividad.

- La implementación debe realizarse en varias zonas de disponibilidad y debe implementarse una implementación gradual para garantizar que las actualizaciones no provoquen interrupciones del servicio.

- Red de socios e innovadores de AWS

- Se debe contratar a socios consultores para aceleradores específicos del sector en finanzas, salud y comercio minorista.

- El AWS Marketplace debe utilizarse para obtener conectores listos para usar y modelos de dominio preentrenados de los socios tecnológicos.

- Los Centros de Innovación de AWS y los Community Builders deben colaborar para acceder a hackatones, revisiones de arquitectura y talleres prácticos con el fin de acelerar la adopción de las mejores prácticas.

El enfoque por fases de la validación, seguido de la creación de bases sólidas y, posteriormente, la ampliación con gobernanza y el apoyo de los socios, te ayudará a transformar tu proyecto piloto de IA generativa en una capacidad sólida para toda la empresa.

Optimizar y gestionar las fases

El perfeccionamiento continuo y las sólidas prácticas de gobernanza, implementadas tras la ampliación de tu plataforma de IA generativa, garantizan el buen funcionamiento del sistema, al tiempo que mantienen la seguridad y el cumplimiento normativo.

Optimización continua

- Supervisión y alertas automatizadas

- Los puntos de conexión de Bedrock/SageMaker requieren métricas de CloudWatch (incluidos latencia, tasas de error y rendimiento) y paneles de Cost Explorer para la instrumentación.

- Configura alarmas de detección de anomalías, por ejemplo, picos repentinos en el gasto de tokens o regresiones en la latencia de inferencia, y activa flujos de trabajo de corrección automática (ampliación/reducción, reversión del modelo).

Diagrama ilustrativo que muestra los procesos de optimización continua, detección de desviaciones y reentrenamiento para modelos de IA generativa.

- Detección de desviaciones y reentrenamiento

- Utiliza detectores de desviación basados en incrustaciones o SageMaker Clarify para señalar cambios en la distribución de los datos.

- Los umbrales de desviación activan procesos de reentrenamiento automatizados a través de CodePipeline/CodeCatalyst para mantener tanto la precisión del modelo como el rendimiento imparcial.

- Ajuste de costes

- Revisa periódicamente los cargos por horas de inactividad y consolida los modelos en puntos finales multimodelo cuando sea posible.

- Ajusta las indicaciones para reducir el uso innecesario de tokens y agrupa las solicitudes de baja prioridad.

Auditorías de gobernanza y cumplimiento normativo

- Auditorías programadas

- Tu organización debe realizar evaluaciones trimestrales de las políticas de IAM y el uso de claves de KMS, junto con las configuraciones de los puntos de conexión de VPC y los registros de CloudTrail, para confirmar el cumplimiento de los estándares de cifrado y acceso con privilegios mínimos.

- AWS Audit Manager y las reglas de AWS Config permiten la recopilación automatizada de pruebas para los mandatos ISO, HIPAA o SOC.

- Aplicación de políticas

- Tu organización debe actualizar Bedrock Guardrails con políticas de contenido y realizar evaluaciones de filtros de categorías durante cada período de lanzamiento.

- Tu canal de CI/CD debe implementar una puerta de aprobación que impida la implementación de la versión del modelo cuando falle la evaluación de seguridad o imparcialidad.

Formación continua y desarrollo de habilidades

- Desarrollador de habilidades de AWS

- El itinerario de aprendizaje de IA generativa debe inscribir a los equipos a través de AWS Skill Builder para que aprendan los fundamentos de Bedrock, los patrones RAG y las prácticas recomendadas para una implementación segura.

- Los laboratorios prácticos enseñan a los alumnos a configurar instancias Trn1/Inf1 mientras configuran Guardrails y realizan la detección de sesgos con SageMaker Clarify.

- Certificación y comunidad

- Los ingenieros deben obtener las credenciales AWS Certified Machine Learning – Specialty y AWS Certified Security – Specialty.

- Los talleres del Centro de Innovación y Constructores de la Comunidad de AWS te permiten mantenerte al día sobre los nuevos servicios, las revisiones de arquitectura y los programas aceleradores.

Al integrar la optimización continua y las auditorías estrictas con prácticas de aprendizaje organizacional, puedes mantener una capacidad de IA generativa resistente, fiable y rentable.

Recursos y primeros pasos

El viaje hacia la IA generativa de AWS se puede acelerar mediante itinerarios de aprendizaje, comunidades y proyectos prácticos que generan confianza e impulsan un impacto real en el negocio.

AWS Skill Builder y recursos de formación

- El itinerario de aprendizaje Generative AI de AWS Skill Builder ofrece formación completa sobre modelos básicos, canalizaciones RAG y prácticas recomendadas para una implementación segura.

- Las plataformas interactivas PartyRock y Bedrock Playground permiten a los usuarios probar la ingeniería rápida, el ajuste fino y la inferencia sin necesidad de configurar infraestructura.

- Los laboratorios guiados muestran a los usuarios cómo crear instancias Trn1 e Inf1 y configurar puntos finales cifrados con KMS antes de implementar flujos de trabajo RAG de extremo a extremo.

Comunidad de programadores y ecosistema de socios

- La comunidad y el centro para programadores de IA generativa de AWS proporcionan acceso a ejemplos de código, foros y documentos técnicos seleccionados sobre la lente de IA generativa bien diseñada.

- La red de socios de AWS proporciona aceleradores preconfigurados, modelos básicos específicos para cada dominio y conectores llave en mano, todos ellos disponibles en AWS Marketplace.

- Los Centros de innovación y los creadores de comunidades de AWS ofrecen talleres, hackatones y sesiones de revisión de arquitectura que te ayudan a acelerar el proceso de implementación.

Guías paso a paso y proyectos de ejemplo

- La plataforma DataCamp ofrece tutoriales paso a pasoy plantillas de soluciones que permiten a los usuarios obtener código para personalizar mediante bifurcación.

- Los repositorios de ejemplos completos muestran cómo utilizar Textract para la ingesta de datos y la coordinación de SageMaker RAG, así como Polly para la salida de voz.

- Los usuarios pueden implementar proyectos totalmente funcionales a través de la plataforma, lo que les permite modificar indicaciones, modelos y procesos para casos de uso empresarial y medición del rendimiento.

Conclusión

La IA generativa de AWS proporciona un sistema completo de extremo a extremo, que incluye modelos básicos, computación optimizada, gobernanza, integración y controles de costes, para ayudar a las empresas a innovar más rápidamente y reducir los gastos operativos, al tiempo que crean aplicaciones multimodales fiables a gran escala.

A través de la experimentación, el aprendizaje continuo y la colaboración con la comunidad, alcanzarás todo el potencial de la IA generativa de AWS para impulsar un impacto real en tu negocio.

Rahul Sharma es embajador de AWS, arquitecto DevOps y bloguero técnico especializado en computación en la nube, prácticas DevOps y tecnologías de código abierto. Con experiencia en AWS, Kubernetes y Terraform, simplifica conceptos complejos para estudiantes y profesionales a través de atractivos artículos y tutoriales. A Rahul le apasiona resolver los retos de DevOps y compartir conocimientos para capacitar a la comunidad tecnológica.