Cursus

L'IA générative AWS représente l'avenir des services cloud, car elle permet aux entreprises de créer du contenu automatisé et des tâches cognitives grâce à des modèles de base qui produisent du texte, des images et des vidéos en temps réel.

Dans cet article, je présente un aperçu complet des éléments essentiels des méthodes de déploiement et des cadres de gouvernance nécessaires pour développer des solutions d'IA générative prêtes à être mises en production.

AWS est le premier fournisseur de services cloud, car il propose Amazon Bedrock ainsi qu'une infrastructure informatique spécialisée et de vastes capacités d'intégration qui surpassent les autres plateformes cloud.

Si vous découvrez AWS, ce cours d'introductionvous permettra d'acquérir des bases solides avant de vous plonger dans les spécificités de l'IA générative.

Compréhension des composants principaux

Dans cette section, nous examinerons les éléments constitutifs qui alimentent l'IA générative d'AWS.

Écosystème du modèle de base

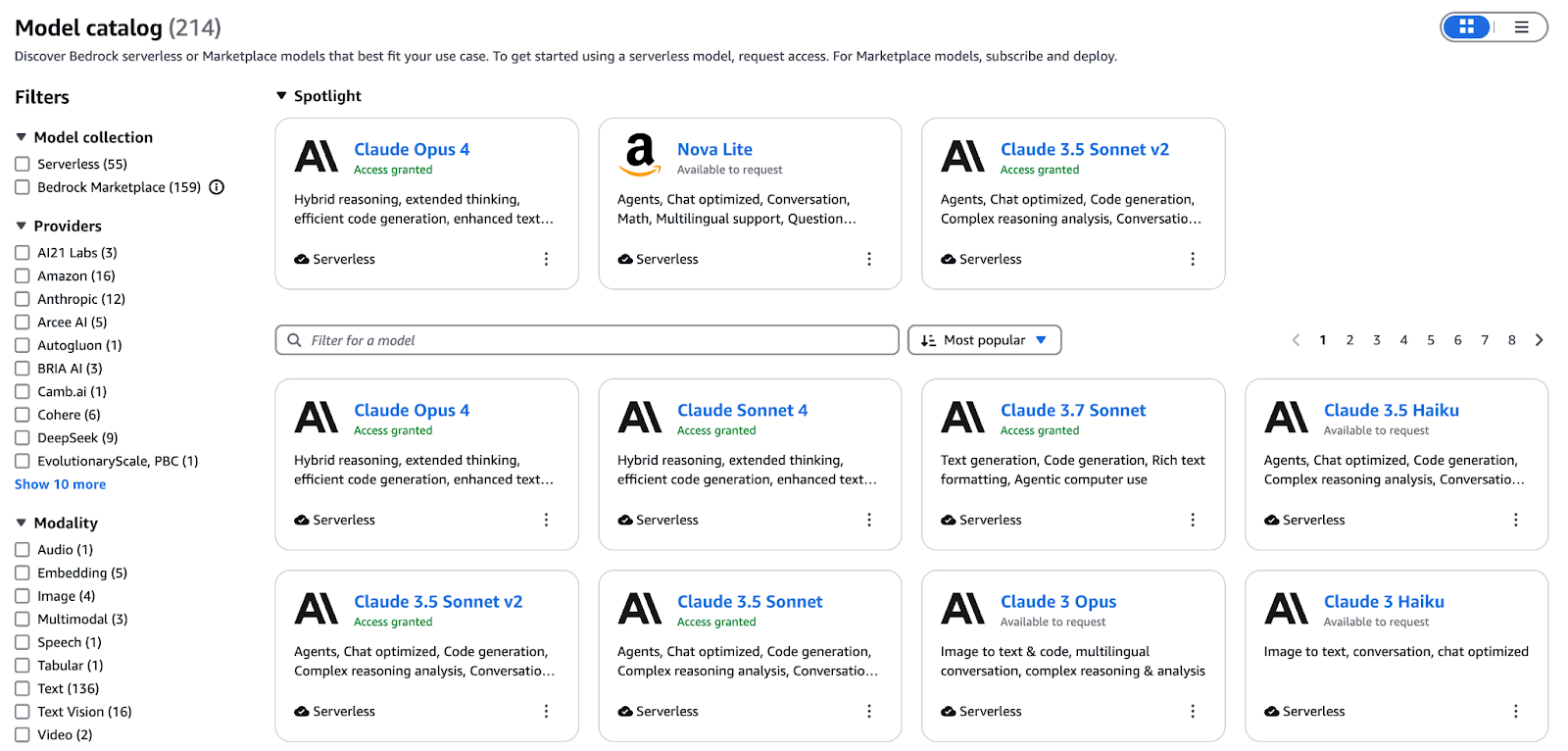

Bedrock sert de plan de contrôle géré pour toute l'IA générative sur AWS. Il fournit une API cohérente pour le déploiement, la mise à l'échelle et la sécurisation des modèles de base, depuis la mise à disposition des terminaux jusqu'à la facturation. Vous pouvez ainsi vous concentrer sur la création d'invites et l'intégration de l'IA plutôt que sur la gestion de l'infrastructure.

Un diagramme conceptuel illustrant l'écosystème du modèle de base AWS.

Lecatalogue Bedrockunifie les modèles pour le texte, l'image, la vidéo et les intégrations sous une seule interface. Nos principales offres comprennent :

- Titan Text (Premier, Express, Lite) : Fenêtres contextuelles pouvant contenir jusqu'à 32 000 tokens pour les dialogues complexes

- Nova Canvas : Génération et restauration haute fidélité de texte en image pour des ressources créatives respectueuses de l'image de marque

- Nova Reel : Courts clips vidéo animés générés à partir d'une seule invite

- Embeddings multimodaux Titan G1 : Encode le texte et les images dans un espace vectoriel partagé pour la recherche de similitudes et le RAG.

Affinez vos modèles à partir de vos données étiquetées ou poursuivez le pré-entraînement sur des corpus spécifiques à votre domaine via la console Bedrock ou le SDK. Une fois la formation terminée, la suite d'évaluation de Bedrock effectue des comparaisons parallèles et génère des rapports sur la précision, la latence et le coût par jeton, ce qui vous permet de choisir objectivement la variante optimale pour les accords de niveau de service (SLA) de production.

Au-delà des familles Titan et Nova d'AWS, Bedrock vous donne accès à des modèles partenaires d'Anthropic, Cohere, Mistral, AI21 Labs et bien d'autres encore. Tirez parti de cette diversité pour :

- Développez des assistants de connaissances alimentés par RAG qui fournissent des réponses précises à partir de wikis internes.

- Créez du contenu marketing et des images à grande échelle tout en conservant une voix de marque cohérente.

- Intégrez la complétion et la révision de code basées sur l'IA dans les workflows des développeurs.

- Enrichissez vos ensembles de données d'entraînement en synthétisant du texte, des images ou des vidéos adaptés à votre domaine.

Pour en savoir plus sur la manière dont Bedrock orchestre ces modèles de base dans les environnements de production, veuillez consulter ce guide complet sur Amazon Bedrock.

Infrastructure informatique optimisée par l'IA

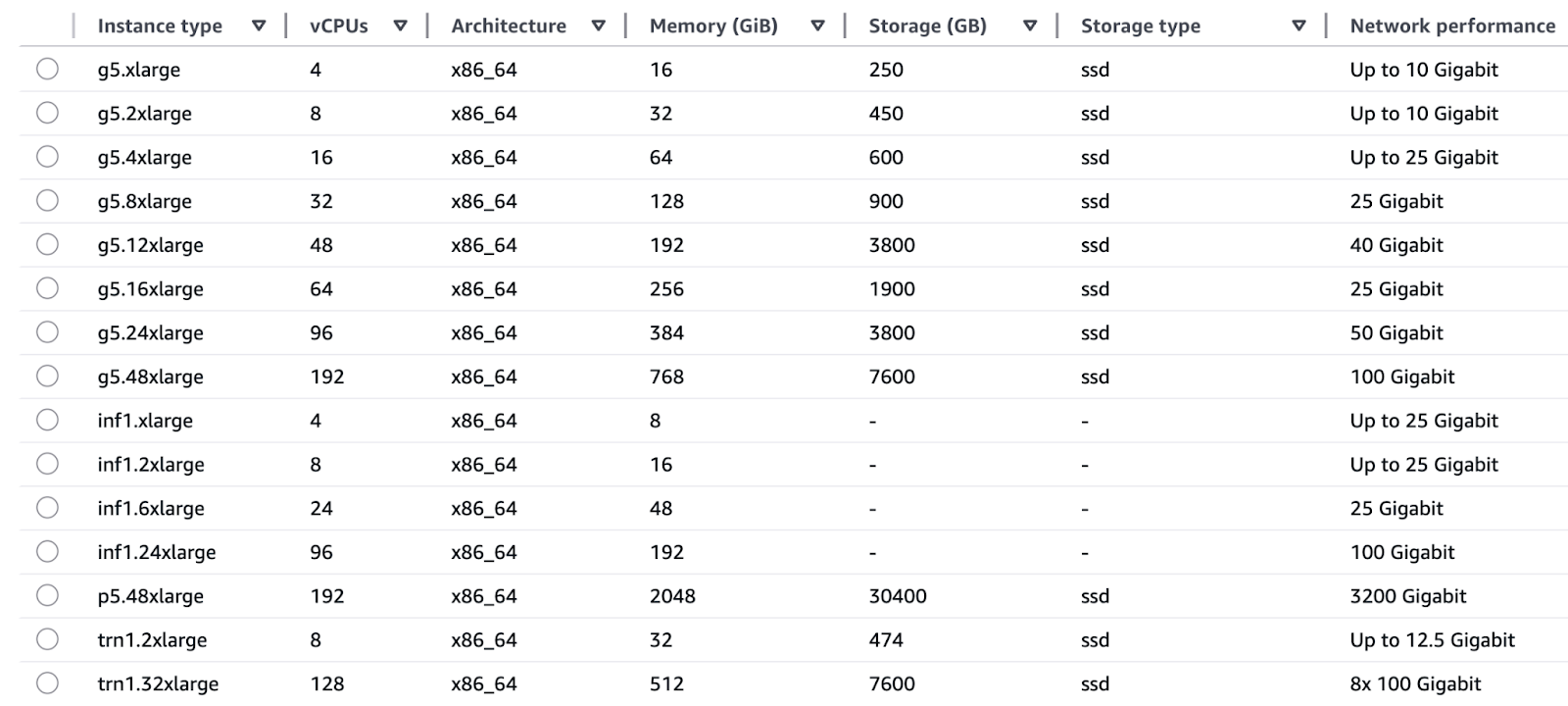

Les familles d'instances EC2 fournies par AWS ont été conçues pour répondre aux besoins spécifiques des opérations de formation et d'inférence.

Formation :

- Les instances Trn1 (Trainium) fonctionnent avec des puces AWS Trainium afin de fournir des capacités de formation en apprentissage profond, notamment des modèles LLM et de diffusion, à une vitesse trois fois supérieure et à un coût horaire réduit par rapport aux instances basées sur GPU.

- Les P5 et P4 (GPU NVIDIA H100 et A100) offrent des capacités de traitement parallèle étendues grâce à la prise en charge de la précision mixte, qui convient aussi bien aux tests de recherche qu'aux processus de réentraînement à grande échelle.

Conclusion :

- Les puces AWS Inferential utilisées dans les systèmes Inf1 et Inf2 permettent des inférences en temps réel avec des latences de l'ordre de quelques millisecondes, tout en offrant un coût par inférence deux fois moins élevé que les alternatives GPU.

- Les processeurs G5 et G4dn (GPU NVIDIA A10G et T4) offrent un rapport performances/prix équilibré, idéal pour l'accélération GPU en temps réel dans les applications de chatbot et de moteur de recommandation.

Un schéma illustratif de l'infrastructure informatique optimisée par l'IA d'AWS.

AWS assure une intégration transparente entre ses composants matériels et logiciels conçus sur mesure grâce à Trainium pour la formation et Inferentia pour les puces d'inférence, qui fonctionnent directement avec les services AWS. Cette intégration verticale permet d'obtenir :

- Le rapport qualité-prix supérieur de TensorFlow et PyTorch pour les charges de travail permet de réduire le coût total de possession.

- La combinaison de l'efficacité énergétique et de la simplification des achats permet aux équipes d'éviter la dépendance vis-à-vis d'un fournisseur de GPU.

- SageMaker et Bedrock intègrent des fonctionnalités de dimensionnement automatique qui permettent aux utilisateurs de sélectionner les configurations de silicium optimales en quelques clics, sans avoir à gérer les détails au niveau des puces.

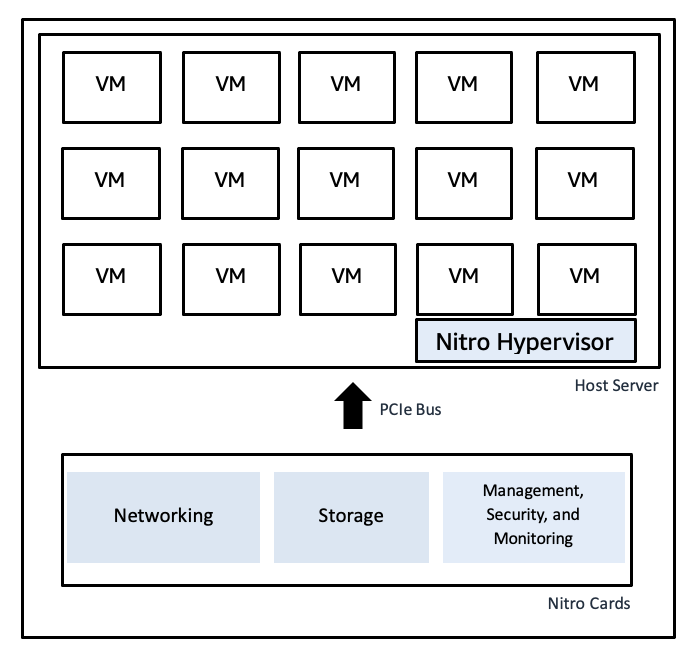

Le système AWS Nitro utilise des cartes matérielles dédiées pour exécuter les fonctions de virtualisation, offrant ainsi des vitesses bare metal rapides et une isolation sécurisée :

- Le Nitro Hypervisor dispose d'un code source minimal, ce qui réduit les vulnérabilités tout en séparant les charges de travail les unes des autres.

- Les chemins réseau et de stockage accélérés par le matériel fonctionnent à un débit d'E/S élevé et avec de faibles niveaux de gigue, ce qui évite les pics de latence et garantit des performances constantes en cas de charge maximale.

- L'intégration de Nitro avec CloudTrail, CloudWatch et AWS Config assure une surveillance de la conformité de bout en bout sans aucune dégradation des performances.

Schéma illustratif du hyperviseur Nitro d'AWS

Schéma illustratif du hyperviseur Nitro d'AWS

Découvrez l'écosystème plus vaste du calcul, du stockage et de l'analyse dans ce courssur la technologie et les services cloud AWS.

Fondements des données pour une IA générative robuste

La formation de modèles à grande vitesse et les pipelines RAG nécessitent l'accès à des données propres et correctement gérées :

- Le système de stockage de données à l'échelle du pétaoctet d'Amazon S3 s'intègre à Lake Formation pour offrir des fonctionnalités de catalogage et de sécurité pour l'ingestion de jeux de données bruts et organisés.

- La solution d'entreposage de données Amazon Redshift fonctionne comme une plateforme pour des tableaux structurés qui fournissent des analyses et une récupération rapide des données.

- Les pipelines de transformation des données créés avec AWS Glue et Athena permettent de préparer les fonctionnalités et le contexte pour les charges de travail génératives et l'exécution de requêtes ad hoc.

- La gouvernance des données et les mécanismes de traçabilité garantissent que la formation des modèles utilise des données fiables, tandis que les connaissances de l'entreprise étayent les résultats grâce au contrôle d'accès et au suivi de la provenance.

Cadre d'intégration d'entreprise

Les capacités d'IA générative d'AWS s'intègrent directement à son écosystème plus large afin de fournir des solutions de bout en bout adaptées à la production. Cette section décrit le processus de combinaison de Bedrock avec ses services associés afin de développer des applications d'IA générative concrètes.

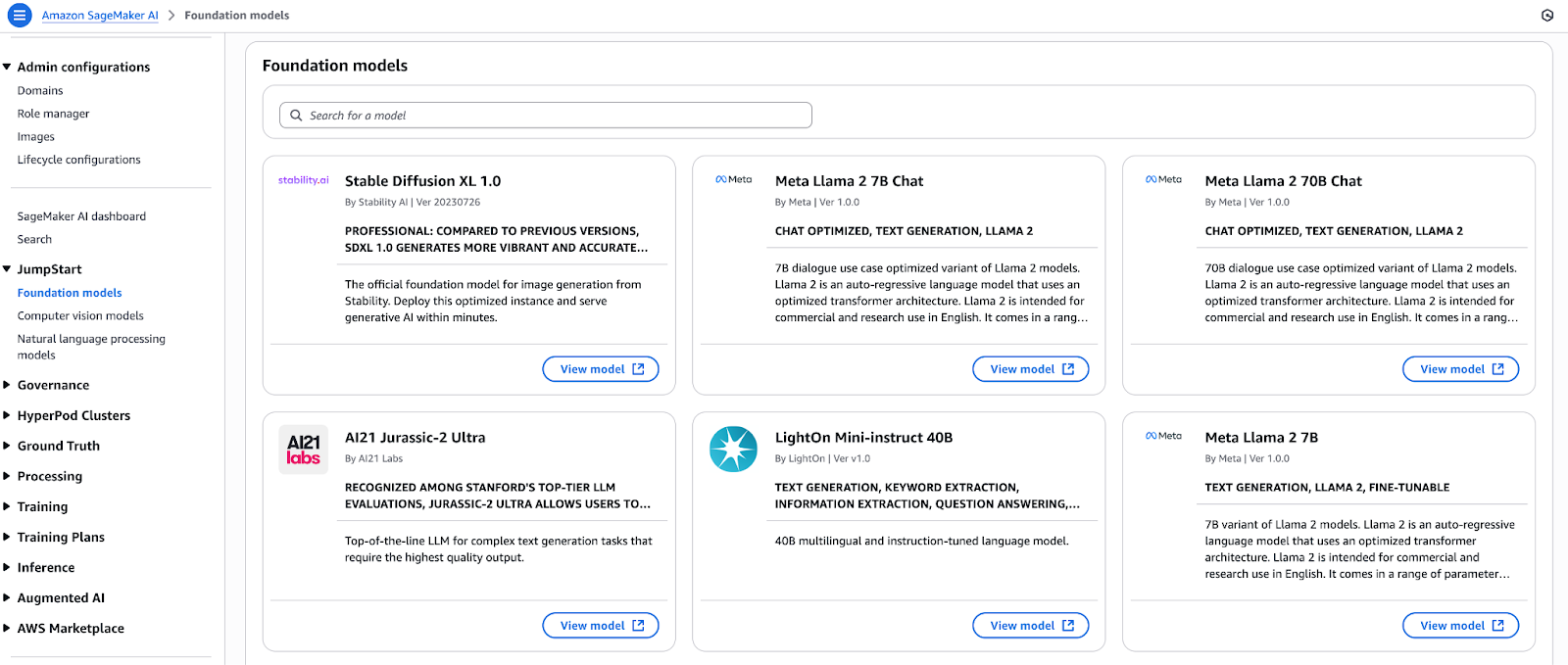

Cycle de vie ML unifié avec SageMaker JumpStart et Bedrock

Sélectionnez des modèles de base dans le hub de modèles SageMaker JumpStart et déployez-les immédiatement. Vous pouvez déployer de nombreux modèles open source et propriétaires à l'aide d'un seul bouton avant de les enregistrer directement dans Amazon Bedrock. Les modèles enregistrés dans Bedrock bénéficient des avantages suivants :

- Modération du contenu et application des politiques grâce à des fonctionnalités de protection.

- Les bases de connaissances offrent des fonctionnalités de génération augmentée par la recherche (RAG) pour les sources de données privées.

- L'API Converse assure la cohérence en fournissant une couche d'abstraction qui élimine les variations spécifiques aux modèles.

L'architecture intégrée permet aux développeurs de créer des prototypesdans SageMaker Studio, puis de les améliorer dans Bedrock avant de les déployer via des pipelines CI/CD sans modification du code.

Ce tutoriel SageMaker vous guide à travers le processus de réglage fin et de déploiement de modèles à l'aide de la plateforme ML phare d'AWS.

Un diagramme illustratif présentant le cycle de vie unifié du ML avec SageMaker JumpStart et Bedrock.

Un diagramme illustratif présentant le cycle de vie unifié du ML avec SageMaker JumpStart et Bedrock.

Orchestration des flux de travail avec Amazon Bedrock Agents

Grâce à Bedrock Agents, vous pouvez intégrer l'IA générative à vos applications opérationnelles en récupérant automatiquement les données et en les transformant avant d'exécuter des actions. Un agent ne nécessite qu'une configuration de base pour :

- Le système établit des connexions sécurisées aux API RESTful ainsi qu'aux bases de données et aux files d'attente de messages.

- Le système collecte les documents, les métriques et les données de journalisation tout en effectuant des tâches de prétraitement avant de mettre les données à la disposition des modèles.

- Le système effectue plusieurs opérations en arrière-plan, notamment la validation de l'enrichissement et la notification par le biais d'appels de fonctions séquentiels.

- Le système génère des résultats structurés ou conversationnels destinés à être utilisés par les systèmes en aval.

Les fonctionnalités de base des agents permettent aux développeurs de se concentrer sur la logique métier plutôt que sur le code d'intégration, accélérant ainsi la rentabilisation.

Création d'assistants conversationnels avec Amazon Q

Amazon Q est un service entièrement géré permettant de développer des assistants professionnels basés sur la technologie RAG.

Le service intègre la fonctionnalité multimodèle Bedrock avec :

- L'entrepôt de données (Redshift), le moteur de recherche (OpenSearch) et les connecteurs d'outils BI sont préconfigurés.

- Le système comprend des fonctionnalités intégrées pour la gestion des dialogues à plusieurs tours de parole, ainsi que le contexte de la session et la génération de réponses de type citation.

- La plateforme comprend un outil de développement d'interface utilisateur à faible code permettant de créer rapidement des prototypes.

Grâce à Q, les entreprises créent des chatbots destinés à leurs clients, ainsi que des tableaux de bord pour les cadres et des services d'assistance spécifiques à leur domaine, qu'elles déploient en quelques semaines au lieu de plusieurs mois.

La lentille IA générative bien conçue met en œuvre les meilleures pratiques à chaque étape du développement des charges de travail génératives.

Lentille IA générative bien conçue

La lentille IA générative d'AWS étend les cinq piliers du cadre Well-Architected aux charges de travail génératives. Le cadre comprend des systèmes automatisés de surveillance des modèles et des mécanismes de détection des dérives, ainsi que des déclencheurs de recyclage avec gestion des artefacts de version et suivi des métriques d'inférence.

Voici les piliers :

- Sécurité : Appliquez une gestion des accès basée sur le principe du moindre privilège, utilisez PrivateLink pour les points de terminaison Bedrock, cryptez les données en transit et au repos, et appliquez des mesures de protection par filtrage de contenu.

- Fiabilité : La solution utilise le déploiement de terminaux basé sur AZ, l'auto-scaling, des disjoncteurs et le déploiement Canary pour des déploiements sans risque.

- Efficacité des performances : Sélectionnez les familles d'instances optimales, mettez en cache les invites fréquentes et les requêtes par lots, et tirez parti des points de terminaison sans serveur pour évoluer vers zéro.

- Optimisation des coûts : La sélection des modèles doit respecter les exigences en matière de latence lors de l'utilisation de la capacité ponctuelle ou réservée, l'ingénierie rapide doit minimiser l'utilisation des jetons et l'analyse des coûts doit être effectuée dans Cost Explorer.

- Durabilité : Dimensionnez correctement vos ressources informatiques, utilisez des puces à faible consommation d'énergie (Trainium, Inferentia), archivez les données inactives dans S3 Glacier et adoptez des pipelines sans serveur afin de réduire les ressources inutilisées.

Pour ceux qui souhaitent obtenir une certification, le cursus AWS Cloud Practitionercorrespond parfaitement aux connaissances fondamentales abordées ici.

Accélérer l'adoption avec les partenaires AWS

Le réseau de partenaires AWS offre un soutien aux entreprises en accélérant leur adoption des services AWS grâce à des accélérateurs de solutions et des services partenaires. Chaque entreprise est unique, c'est pourquoi AWS a mis en place le réseau de partenaires avec des accélérateurs d'IA générative spécifiques pour différents secteurs et cas d'utilisation.

- Le réseau de partenaires AWS comprend des partenaires technologiques qui fournissent des applications préconfigurées ainsi que des connecteurs et des modèles de base spécifiques à un domaine, disponibles via AWS Marketplace.

- Le programme Generative AI Accelerator soutient les start-ups en leur offrant des crédits, un mentorat et des modèles de bonnes pratiques afin d'accélérer le développement de la preuve de valeur.

- L'utilisation des cadres des partenaires APN, associée aux modèles de solutions validés par AWS, permet aux équipes de réduire les risques lors des projets pilotes tout en déployant l'IA générative dans l'ensemble de leur organisation en toute confiance.

Présentation des services d'intelligence artificielle AWS pris en charge

La capacité de l'IA générative à générer de nouveaux contenus ne correspond pas aux exigences des applications du monde réel, qui doivent traiter et comprendre les données sous divers formats de présentation.

AWS fournit un ensemble de services complémentaires qui s'intègrent à vos pipelines génératifs afin de convertir des documents non structurés en données structurées, d'extraire des informations à partir d'images et de permettre des conversations naturelles et la diffusion de résultats dans n'importe quelle langue ou voix.

Voici les plus populaires :

- Amazon Textract

- Le système détecte automatiquement le texte imprimé, les tableaux et les données de formulaire dans les documents numérisés et les fichiers image.

- Le système utilise des pipelines RAG pour traiter des documents spécifiques à un domaine, notamment des contrats, des rapports et des factures.

- Le système organise le contenu non structuré afin de le préparer pour les modèles de réponse rapide et l'ajustement des ensembles de données.

- Amazon Rekognition

- Le système utilise l'analyse d'images et de vidéos pour identifier des objets, des scènes, du texte, des visages et des activités.

- Le système génère des métadonnées contextuelles (étiquettes, scores de confiance) pour la génération multimodale.

- Le système permet aux utilisateurs de mettre en œuvre une logique conditionnelle (par exemple, « décrire uniquement les images contenant des personnes ») dans leurs applications destinées aux utilisateurs finaux.

- Amazon Polly

- Ce service transforme du texte écrit en audio parlé de manière naturelle, dans plusieurs langues et avec différentes voix.

- La fonctionnalité de sortie audio transforme les chatbots et assistants génératifs en interfaces interactives.

- Le système prend en charge le balisage SSML pour contrôler la sortie vocale grâce à une prononciation précise, des accents toniques et une gestion des pauses.

- Pour découvrir comment Polly permet de générer des voix humaines dans des applications réelles, veuillez consulterce tutoriel pratique.

- Amazon Lex

- Le système développe des interfaces conversationnelles grâce à la reconnaissance vocale automatique (ASR) et à la compréhension du langage naturel (NLU).

- Le système sert d'interface frontale pour les générateurs back-end, gérant la gestion des sessions et les opérations de remplissage des emplacements.

- Le système se connecte directement à AWS Lambda afin d'exécuter les points de terminaison Bedrock ou SageMaker pour générer des réponses dynamiques.

- Amazon Traduction

- Le service propose des services de traduction automatique neuronale immédiate pour plus de 70 langues différentes.

- Le système adapte les résultats génératifs afin de les rendre accessibles à un public international.

- Le système normalise les entrées multilingues, ce qui permet à un seul modèle de servir des utilisateurs de différentes régions.

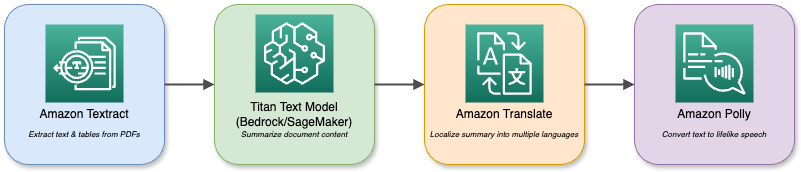

Un diagramme illustratif des différents services AWS et de leurs interactions.

Vos modèles de base dans Bedrock ou SageMaker peuvent être associés à ces services pour créer des applications multimodales complexes.

Un assistant d'analyse de documents, par exemple, utilise Textract pour ingérer des fichiers PDF, puis Titan Text pour les résumer avant de traduire le résumé en plusieurs langues et de le restituer via Polly. L'écosystème modulable vous permet de combiner diverses capacités d'IA afin de répondre à toutes les exigences de votre entreprise.

Modèles de mise en œuvre et cas d'utilisation

L'IA générative offre les meilleurs résultats lorsque vous utilisez des modèles bien conçus pour répondre à des problèmes commerciaux concrets.

Cette section présente quatre plans de mise en œuvre spécifiques, notamment la génération augmentée par la récupération et les assistants pour développeurs et entreprises, ainsi que d'autres scénarios à forte valeur ajoutée que vous pouvez mettre en œuvre dès aujourd'hui.

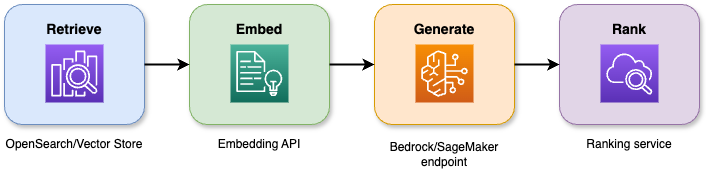

Architectures de génération augmentée par la récupération (RAG)

La combinaison des capacités de recherche et des modèles linguistiques volumineux dans la génération augmentée par la récupération produit des réponses précises qui restent ancrées dans le contexte. Le pipeline en quatre étapes fonctionne comme suit :

- Le système récupère les N documents ou passages les plus pertinents à partir d'un magasin vectoriel ou d'un index de recherche à l'aide d'une requête.

- Le système transforme les documents et les requêtes des utilisateurs en intégrations sémantiques, ce qui permet un meilleur alignement contextuel.

- Le système transmet la requête et le contexte récupéré à un modèle de base afin de générer une réponse.

- Le système utilise un modèle secondaire ou heuristique pour noter et reclasser les résultats candidats, afin de présenter la réponse la plus appropriée.

Un diagramme illustratif présentant une architecture de génération augmentée par la récupération (RAG).

Avantages et gains en termes de précision :

- Le système réduit les hallucinations de 40 % par rapport aux méthodes de génération de base.

- Les projets pilotes de base de connaissances d'entreprise démontrent que la pertinence des réponses s'améliore de 20 à 30 %.

- Le temps moyen d'interaction des utilisateurs diminue de 25 % lors de l'utilisation de systèmes d'assistance virtuelle.

Applications commerciales :

- Le contenu du wiki interne sert de base aux chatbots et aux assistants virtuels pour fournir des résumés de tickets et des conseils de dépannage.

- Les systèmes RAG intégrés à des interfaces utilisateur de recherche permettent aux utilisateurs d'explorer de vastes collections de documents à l'aide de recherches en langage naturel.

- Le système permet aux assistants chargés de la conformité, des questions juridiques et réglementaires de fournir des citations de sources lorsque les utilisateurs en font la demande.

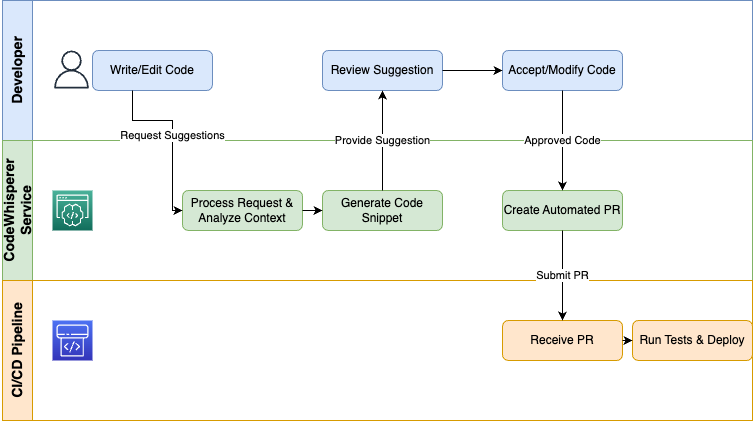

Workflows de génération de code

AWS CodeWhisperer fournit une IA générative directement aux développeurs via leurs IDE et leurs pipelines CI/CD afin d'automatiser les tâches répétitives et d'accélérer les processus de codage.

- Le système offre trois fonctions principales, notamment des suggestions de code en temps réel, la complétion de fragments de code et la génération de tests qui s'adaptent à votre contexte de codage actuel.

- Les équipes accélèrent la livraison des fonctionnalités de 30 % et réduisent de 50 % les erreurs de syntaxe dans les premiers prototypes.

- Le pipeline CodeCatalyst permet aux utilisateurs de créer automatiquement des extraits IaC d'infrastructure, des tests unitaires et des scripts de déploiement grâce à l'intégration de CodeWhisperer.

- La plateforme prend en charge plusieurs langages de programmation, notamment Python, Java, JavaScript/TypeScript, C#, Go et d'autres langages, qui offrent des avantages à l'ensemble de votre pile technologique.

Un diagramme illustratif présentant un processus de génération de code.

Les organisations qui utilisent CodeWhisperer comme assistant de développement éliminent les tâches répétitives, appliquent les normes de codage et permettent aux ingénieurs de consacrer leur temps à des activités de conception et de débogage à forte valeur ajoutée.

Veuillez noterque CodeWhisperer fera désormais partie d'Amazon Q Developer.

Assistants d'entreprise

Amazon Q Business est une solution low-code basée sur la technologie RAG qui permet aux utilisateurs de développer des assistants conversationnels capables de récupérer des données d'entreprise à partir de questions.

Architecture :

- Le système récupère les données de Redshift, OpenSearch, SharePoint et S3 via des connecteurs.

- Le moteur RAG récupère le contexte approprié avant d'activer les modèles de base.

- Le gestionnaire de dialogue contrôle la gestion des sessions multi-tours, y compris le remplissage des emplacements et les opérations d'état.

- La couche UI est compatible avec les widgets de chat, les canaux vocaux et les intégrations Slack.

Scénarios de déploiement :

- La transcription et le résumé automatiques des actions à entreprendre grâce aux assistants de réunion permettent aux équipes de gagner plus de deux heures de travail par semaine.

- La mise en place de robots en libre-service permet de détourner les demandes courantes, ce qui se traduit par une réduction de 30 % du temps de traitement.

- Les tableaux de bord exécutifs fournissent des informations en langage naturel sur les ventes, les stocks et les indicateurs clés de performance aux utilisateurs qui n'ont pas besoin de formation en BI.

Les assistants aident les organisations à rationaliser le travail intellectuel, à réduire les coûts opérationnels et à permettre aux employés d'atteindre des niveaux de productivité plus élevés.

Autres cas d'utilisation à forte valeur ajoutée

La valeur de l'IA générative s'étend au-delà du RAG, de la génération de code et des assistants à divers autres domaines :

- Ces systèmes peuvent générer des descriptions de produits personnalisées, des campagnes par e-mail et des interactions par chat en fonction des profils individuels et de l'analyse comportementale.

- La combinaison de Textract avec des modèles d'analyse syntaxique et de génération permet la classification, le balisage et le routage automatiques des factures, contrats et réclamations, ainsi que les tâches en aval (création de tickets, routage des approbations et génération de rapports) grâce à une logique décisionnelle basée sur des modèles.

- L'analyse des transcriptions d'assistance, des flux de réseaux sociaux et des appels commerciaux à l'aide de l'analyse conversationnelle révèle les tendances en matière de sentiments, les risques de non-conformité et les recommandations exploitables.

Commencez par ces modèles pour mettre en place des projets pilotes démontrant un retour sur investissement clair avant de passer à l'optimisation et à la mise à l'échelle dans l'ensemble de votre organisation.

Modèle de sécurité et de gouvernance

Les entreprises doivent mettre en œuvre des contrôles de sécurité et des pratiques de gouvernance à chaque étape du cycle de vie de l'IA lorsqu'elles adoptent l'IA générative.

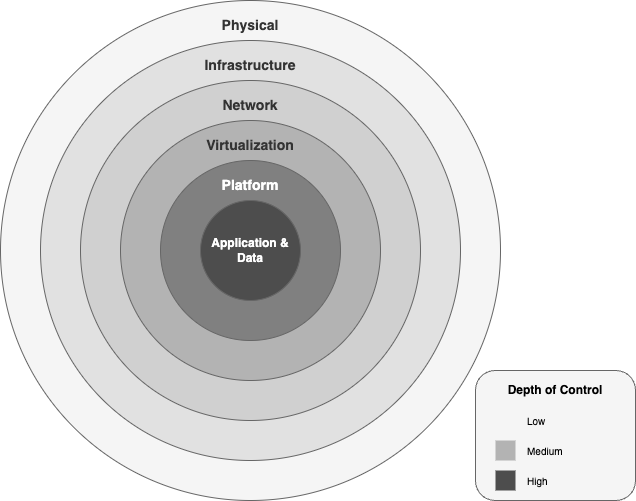

AWS fournit un cadre complet de sécurité et de conformité qui s'étend des centres de données physiques aux politiques au niveau des applications, permettant ainsi d'innover en toute confiance.

Architecture de protection des données

AWS protège les charges de travail d'IA générative grâce à six couches de sécurité concentriques :

- La couche physique des centres de données comprend des contrôles d'accès multifacteurs, un filtrage biométrique et une surveillance 24 heures sur 24, 7 jours sur 7, qui garantissent que l'accès au matériel est réservé au personnel autorisé.

- Le réseau mondial AWS protège le trafic IA grâce à des connexions fibre optique privées et à l'atténuation des attaques DDoS, ainsi qu'à AWS Shield Advanced, tout en maintenant un débit réseau élevé en isolant le trafic isolant le trafic du réseau Internet public.

- Les points de terminaison et les pipelines de données des modèles restent sécurisés grâce à la combinaison de VPC avec des groupes de sécurité granulaires, des listes de contrôle d'accès réseau et des points de terminaison PrivateLink, qui fonctionnent au sein de vos réseaux privés.

- Le système Nitro transfère les opérations de virtualisation vers des composants matériels spécialisés, qui offrent une vitesse et une protection matérielle de niveau bare-metal. une protection matérielle contre le partage non autorisé de données entre les machines virtuelles.

- La couche plateforme des points de terminaison Bedrock et SageMaker s'intègre à AWS KMS pour les clés gérées par le client, utilise le chiffrement TLS 1.2+ pour la transmission des données et applique les autorisations IAM sur la base du principe du moindre privilège.

- La couche application et la couche données mettent en œuvre des politiques de ressources très précises avec un chiffrement AES-256 au repos et en transit et intègrent la la journalisation des audits via CloudTrail et CloudWatch afin de protéger et d'enregistrer chaque appel API.

Un diagramme illustratif des couches de sécurité au sein du cadre d'IA générative AWS.

Isolation des données et conformité :

- Chaque instance d'inférence Bedrock fonctionne au sein de votre VPC tout en accédant aux compartiments S3 que vous gérez et en les modifiant.

- Vous sélectionnez les CMK gérées par le client via AWS KMS et avez la possibilité d'utiliser des magasins de clés externes (XKS/HYOK) pour répondre aux exigences de conformité souveraines.

- AWS dispose de plusieurs certifications, notamment ISO 27001 et SOC 1/2/3 Fed, RAMP High, HIPAA, PCI, DSS et GDPR, qui s'étendent automatiquement à vos charges de travail d'IA générative sans nécessiter d'efforts supplémentaires.

Cadre pour une IA responsable

Le développement de la confiance dans l'IA générative nécessite la mise en œuvre de protocoles éthiques et de sécurité à chaque étape de l'invocation du modèle. AWS met en œuvre une gouvernance responsable de l'IA à travers le cadre suivant :

- Les principes éthiques d'AWS privilégient l'équité, la confidentialité, la transparence et la responsabilité afin d'éviter tout biais discriminatoire dans les modèles et de conserver une documentation claire sur la provenance des données et la logique décisionnelle.

- Le système Bedrock Guardrails fournit des filtres basés sur des politiques qui vérifient à la fois les données entrantes et les résultats sortants par rapport à des catégories comprenant les discours haineux et la violence, l'automutilation et la désinformation. Les API Invoke et ApplyGuardrail permettent aux utilisateurs de mettre en œuvre des garde-fous pour les contrôles de sécurité, soit de manière indépendante, soit via l'API Invoke.

- Le système enregistre toutes les demandes et les décisions prises par le système de contrôle via CloudTrail, tandis que les fiches de modèle et les rapports d'évaluation affichent les indicateurs de performance, les biais potentiels et les compromis entre coût et latence.

- Le système assure une surveillance continue grâce aux workflows de détection des biais et de révision humaine de SageMaker Clarify pour les résultats peu fiables, ainsi qu'à des alertes automatiques de détection des dérives pour le réentraînement ou la révocation des modèles.

Ces couches et pratiques établissent une posture de défense en profondeur pour l'IA générative d'entreprise, vous permettant d'innover tout en respectant les normes les plus strictes en matière de sécurité, de conformité et de responsabilité éthique.

Stratégies d'optimisation des coûts

Le processus de contrôle des budgets consacrés à l'IA générative exige à la fois une connaissance approfondie des mécanismes de tarification et des pratiques de gestion continue des coûts. Cette section explique la tarification AWS pour les charges de travail IA, tout en présentant un exemple de coût total de possession pour un déploiement de taille moyenne et des stratégies pour réduire les dépenses.

Analyse du modèle de tarification

La tarification de l'IA générative AWS s'articule autour de quatre dimensions principales :

- Calculer les coûts

- Heures de point de terminaison : facturées par heure d'instance, en fonction de la famille

- Inf1.xlarge à 0,228 $/heure

- G5.xlarge à 1,006 $/heure

- Tâches de formation : facturées à l'heure d'instance sur du matériel Trn1, P4 ou P5 (par exemple, Trn1.32xlarge à 21,50 $/heure).

- Frais de jeton/demande

- Jetons instantanés : 0,0008 $ par 1 000 jetons

- Jetons d'achèvement : 0,0016 $ par 1 000 jetons

- Stockage et transfert de données

- Modèles d'artefacts : S3 Standard à 0,023 $/Go-mois

- Sortie de données : 0,09 $/Go au-delà du quota gratuit

- Personnalisation et évaluation

- Réglage fin : frais de formation supplémentaires par heure et par instance, plus frais minimes de traitement des données.

- Évaluations : frais de jetons pour les comparaisons de référence et personnalisées.

Stratégies d'optimisation des coûts

- Choisissez le bon silicone: Utilisez Inferentia (Inf1/Inf2) pour les inférences à haut volume et à faible latence, et Trainium (Trn1) pour les formations à grande échelle afin de réduire le coût par heure de TPU.

- r les invites de traitement par lots et de mise en cache: Regroupez les demandes similaires et mettez en cache les réponses courantes afin de réduire les dépenses répétitives en jetons.

- multimodèle des critères d'évaluation: Hébergez plusieurs modèles plus petits derrière un seul terminal, en sacrifiant la latence maximale pour réduire considérablement les coûts liés aux heures d'inactivité.

- s sur les places disponibles et réservées: Engagez-vous sur une fraction de la capacité de base avec les instances réservées ou utilisez Spot pour les charges de travail par lots non critiques.

- s techniques rapides: Simplifiez les instructions afin de réduire l'utilisation de jetons par requête sans compromettre la qualité.

Comparaison des architectures

|

Architecture |

Calculer le facteur de coût |

Facteur de coût des jetons |

Meilleure correspondance |

|

Chatbots en temps réel |

De nombreux petits terminaux fonctionnant 24 heures sur 24, 7 jours sur 7 |

Taux de requêtes élevé, jetons de petite taille |

Assistance clientèle, services d'assistance |

|

Génération par lots |

Instances de grande taille à courte durée de vie |

Peu de pics importants de jetons |

Génération de rapports, augmentation des données |

|

Pipelines RAG |

Recherche combinée + inférence |

Jeton de récupération + jeton de génération |

Assistants basés sur les connaissances |

Modèle de coût total de possession

Vous trouverez ci-dessous un exemple de coût total de possession mensuel pour un projetpilote d'IA générative de taille moyenne:

|

Élément de coût |

Coût unitaire |

Utilisation |

Coût mensuel |

|

Critères d'évaluation de l'inférence (Inf1.xl) |

0,228 $ / heure |

3 critères d'évaluation × 24 heures × 30 jours |

492,48 $ |

|

Utilisation des jetons (Titan Express) |

0,0024 $ / 1 000 jetons |

3 jetons M par jour × 30 jours |

216,00 $ |

|

Stockage S3 (artefacts de modèle) |

0,023 $ / Go par mois |

10 000 GO |

$230 |

|

Sortie des données |

0,09 $ / GO |

1 TO |

$90 |

|

Coller ETL (préparation des fonctionnalités) |

0,44 $ /DPU-heure |

20 heures de travail par jour |

8,80 $ |

|

Total |

1 037,28 $ |

Principauxleviers d'optimisation:

- Auto-échelle à zéro: Supprimez les points de terminaison inactifs lorsque le trafic diminue.

- multimodèle des critères d'évaluation: Consolidez vos modèles afin de réduire les frais liés aux heures d'inactivité jusqu'à 60 %.

- s sur les réservations et les places disponibles: Bénéficiez de tarifs réduits pour la capacité de base et activez Spot pour les tâches non sensibles à la latence.

- s de compression rapide: Refactorisez les invites afin de supprimer les jetons superflus, ce qui permettra de réduire de 10 à 15 % la consommation de jetons.

Gestion continue des coûts :

- Veuillez utiliser le calculateur de prix AWS pourmodéliser différents scénarios avant le lancement.

- Surveillez l'utilisation réelle dans AWS Cost Explorer, définissez des budgets et des alertes en cas d'anomalies.

- Marquez toutes les ressources IA pour obtenir des rapports clairs sur la refacturation et la réimputation.

La combinaison d'une architecture sensible aux prix, d'optimisations ciblées et d'une surveillance continue vous permet de faire évoluer l'IA générative sans coûts excessifs.

Feuille de route pour la mise en œuvre

Le processus de mise à l'échelle de l'IA générative, de la conception à la production, nécessite une méthodologie systématique par étapes. La feuille de route fournit une approche étape par étape, depuis les évaluations initiales jusqu'aux projets pilotes de validation, en passant par la mise en place d'une plateforme résiliente adaptée aux entreprises.

Phases d'évaluation et d'essai

La première étape consiste à vérifier la faisabilité et à obtenir l'accord des parties prenantes avant de procéder au développement complet de l'architecture.

- Analyse des écarts et définition des objectifs

- Menez des entretiens avec les chefs d'entreprise afin de définir les exigences en matière de cas d'utilisation, les critères de réussite et les objectifs de retour sur investissement.

- Veuillez examiner les sources de données actuelles, les contrôles de qualité de la sécurité et les capacités de ML.

- Identifiez les lacunes en matière de conformité ou de confidentialité (par exemple, le traitement des informations personnelles identifiables) auxquelles votre projet pilote doit remédier.

- Développement d'une preuve de concept (PoC)

- Sélectionnez un cas d'utilisation à forte valeur ajoutée (par exemple, un bot d'assistance alimenté par RAG ou un résumeur de documents) pour la première phase.

- Configurez une infrastructure minimale : un point de terminaison Bedrock ou SageMaker connecté à un petit ensemble de données via S3 ou OpenSearch.

- Définissez des indicateurs clés (précision, latence, coût par requête) et configurez des tableaux de bord CloudWatch.

- Prototypage rapide avec des guides étape par étape

- Veuillez utiliser les exemples de projets de la bibliothèque de solutions AWS (par exemple, RAG Chatbot, CodeWhisperer demo) pour créer le prototype.

- Répétez rapidement les invites et les stratégies de récupération, en consignant les enseignements tirés dans un wiki partagé.

- Validation par les parties prenantes

- Présentez le prototype fonctionnel aux utilisateurs finaux et recueillez leurs commentaires sur la qualité du résultat et l'expérience utilisateur.

- Affinez la portée, ajoutez ou supprimez des sources de données et ajustez les paramètres du modèle en fonction de l'utilisation réelle.

- Obtenir le soutien de la direction et le budget pour la phase suivante.

Phases de fondation et d'échelle

La validation du concept aboutit au développement de la plateforme fondamentale avant que le système puisse être largement adopté.

- Construction de la fondation de la plate-forme

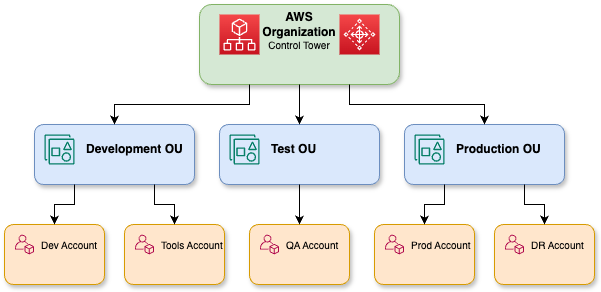

- La structure multi-comptes d'AWS Control Tower doit être établie pour les limites des unités organisationnelles de développement, de test et de production dans la zone d'atterrissage.

- Mettez en œuvre des rôles et des politiques IAM, AWS SSO et des contrôles d'accès minimal pour l'accès aux modèles et aux pipelines de données.

- Les VPC doivent être configurés avec des points de terminaison PrivateLink. Les clés CMK Bedrock/SageMaker KMS doivent être activées et la surveillance GuardDuty doit être déployée.

- Automatisez l'ETL avec AWS Glue/Athena, cataloguez les ressources dans Lake Formation et synchronisez les bases de connaissances pour RAG.

Une représentation détaillée des organisations AWS.

- MLOps et gouvernance des modèles

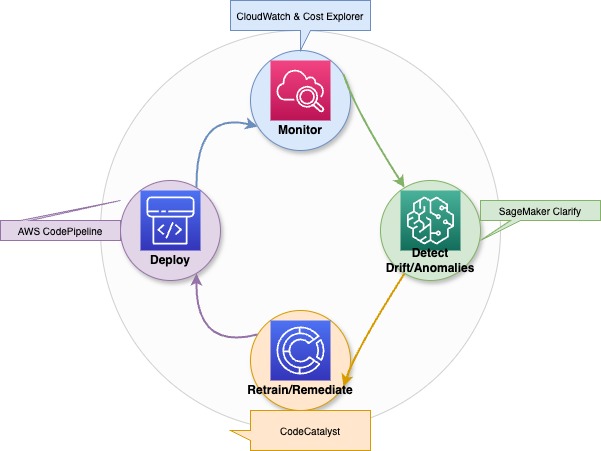

- Le processus de réentraînement, d'évaluation et de déploiement du modèle doit être automatisé via des pipelines CI/CD utilisant CodeCatalyst ou CodePipeline.

- Un registre de modèles devrait être établi dans SageMaker ou dans un catalogue Git afin de versionner et d'affiner les artefacts.

- Le système doit détecter automatiquement les écarts et effectuer des formations supplémentaires programmées afin de garantir les performances et la conformité.

- Passage à la production

- Les modèles de trafic variables doivent être adaptés à l'aide des points de terminaison Bedrock ou SageMaker à mise à l'échelle automatique.

- L'utilisation de points de terminaison multimodèles permet d'héberger plusieurs FM plus petits derrière une seule API, ce qui se traduit par une réduction pouvant atteindre 60 % des coûts d'inactivité.

- Le déploiement doit être effectué sur plusieurs zones de disponibilité et un déploiement progressif doit être mis en œuvre afin de garantir des mises à jour sans interruption de service.

- Réseau de partenaires AWS et centres d'innovation

- Il est recommandé de faire appel à des partenaires consultants spécialisés dans les accélérateurs spécifiques aux domaines de la finance, de la santé et du commerce de détail.

- Veuillez utiliser AWS Marketplace pour obtenir des connecteurs prêts à l'emploi et des modèles de domaine pré-entraînés auprès de nos partenaires technologiques.

- Les centres d'innovation AWS et les Community Builders doivent collaborer afin d'accéder à des hackathons, des revues d'architecture et des ateliers pratiques pour accélérer l'adoption des meilleures pratiques.

L'approche progressive de la validation, suivie de la mise en place des fondations, puis de la mise à l'échelle avec une gouvernance et le soutien des partenaires, vous aidera à transformer votre projet pilote d'IA générative en une capacité robuste à l'échelle de l'entreprise.

Optimiser et gérer les phases

L'amélioration continue et les pratiques de gouvernance rigoureuses, mises en œuvre après la mise à l'échelle de votre plateforme d'IA générative, garantissent les performances du système tout en assurant la sécurité et la conformité réglementaire.

Optimisation continue

- Surveillance et alerte automatisées

- Les points de terminaison Bedrock/SageMaker nécessitent des métriques CloudWatch (notamment la latence, les taux d'erreur et le débit) et des tableaux de bord Cost Explorer pour l'instrumentation.

- Configurez des alertes de détection d'anomalies, par exemple en cas de pics soudains de dépenses de jetons ou de régressions de la latence d'inférence, et déclenchez des workflows de correction automatique (augmentation/réduction de l'échelle, restauration du modèle).

Un diagramme illustratif montrant les processus d'optimisation continue, de détection des dérives et de réentraînement pour les modèles d'IA générative.

- Détection de dérive et rééducation

- Utilisez des détecteurs de dérive basés sur l'intégration ou SageMaker Clarify pour signaler les changements dans la distribution des données.

- Les seuils de dérive déclenchent des pipelines de formation automatique via CodePipeline/CodeCatalyst afin de maintenir à la fois la précision du modèle et l'impartialité des performances.

- Optimisation des coûts

- Veuillez examiner régulièrement les frais liés aux heures d'inactivité et regrouper les modèles dans des terminaux multimodèles lorsque cela est possible.

- Ajustez les invites afin de réduire l'utilisation inutile de jetons et regroupez les demandes de faible priorité.

Audits de gouvernance et de conformité

- Audits planifiés

- Votre organisation doit effectuer des évaluations trimestrielles des politiques IAM et de l'utilisation des clés KMS, ainsi que des configurations des points de terminaison VPC et des journaux CloudTrail, afin de confirmer le respect des normes d'accès et de chiffrement basées sur le principe du moindre privilège.

- AWS Audit Manager et les règles AWS Config permettent la collecte automatisée de preuves pour les exigences ISO, HIPAA ou SOC.

- Application des politiques

- Votre organisation doit mettre à jour Bedrock Guardrails avec les politiques de contenu et effectuer des évaluations des filtres de catégorie pendant chaque période de publication.

- Votre pipeline CI/CD doit mettre en place un processus de validation qui empêche le déploiement d'une version du modèle lorsque l'évaluation de la sécurité ou de l'équité échoue.

Formation continue et perfectionnement des compétences

- Développeur de compétences AWS

- Le parcours d'apprentissage sur l'IA générative doit inscrire les équipes via AWS Skill Builder afin qu'elles acquièrent les connaissances fondamentales sur Bedrock, les modèles RAG et les meilleures pratiques en matière de déploiement sécurisé.

- Les travaux pratiques permettent aux étudiants d'apprendre à configurer des instances Trn1/Inf1 tout en configurant Guardrails et en effectuant une détection des biais avec SageMaker Clarify.

- Certification et communauté

- Les ingénieurs sont encouragés à obtenir les certifications AWS Certified Machine Learning – Specialty et AWS Certified Security – Specialty.

- Les ateliers AWS Community Builders and Innovation Center vous permettent de rester informé des nouveaux services, des analyses d'architecture et des programmes d'accélération.

En intégrant une optimisation continue et des audits rigoureux à des pratiques d'apprentissage organisationnel, vous pouvez maintenir une capacité d'IA générative résiliente, fiable et rentable.

Ressources et mise en route

Le parcours vers l'IA générative AWS peut être accéléré grâce à des parcours d'apprentissage, des communautés et des projets pratiques qui renforcent la confiance et génèrent un impact commercial réel.

AWS Skill Builder et ressources de formation

- Le parcours d'apprentissage sur l'IA générative proposé par AWS Skill Builder offre une formation complète sur les modèles de base, les pipelines RAG et les meilleures pratiques en matière de déploiement sécurisé.

- Les plateformes interactives PartyRock et Bedrock Playground permettent aux utilisateurs de tester rapidement l'ingénierie, le réglage fin et l'inférence sans avoir besoin de mettre en place une infrastructure.

- Les laboratoires guidés montrent aux utilisateurs comment créer des instances Trn1 et Inf1 et configurer des points de terminaison chiffrés KMS avant de déployer des workflows RAG de bout en bout.

Communauté de développeurs et écosystème de partenaires

- La communauté et le centre de développement AWS Generative AI offrent un accès à des exemples de code, des forums et des livres blancs sélectionnés sur le prisme Well-Architected Generative AI.

- Le réseau de partenaires AWS fournit des accélérateurs préconfigurés, des modèles de base spécifiques à un domaine et des connecteurs clés en main, tous disponibles sur AWS Marketplace.

- Les centres d'innovation AWS et les Community Builders proposent des ateliers, des hackathons et des sessions de révision de l'architecture qui vous aideront à accélérer votre processus de mise en œuvre.

Guides étape par étape et exemples de projets

- La plateforme DataCamp propose des tutoriels étape par étapeet des modèles de solutions qui permettent aux utilisateurs d'obtenir du code à personnaliser via le fork.

- Les référentiels d'exemples de bout en bout illustrent comment utiliser Textract pour l'ingestion de données et l'orchestration SageMaker RAG, ainsi que Polly pour la sortie vocale.

- Les utilisateurs peuvent déployer des projets entièrement fonctionnels via la plateforme, ce qui leur permet de modifier les invites, les modèles et les pipelines pour les cas d'utilisation en entreprise et la mesure des performances.

Conclusion

L'IA générative AWS fournit un système complet de bout en bout, comprenant des modèles de base, des ressources informatiques optimisées, des fonctions de gouvernance, d'intégration et de contrôle des coûts, afin d'aider les entreprises à innover plus rapidement et à réduire leurs frais généraux tout en créant des applications multimodales fiables à grande échelle.

Grâce à l'expérimentation, à l'apprentissage continu et à la collaboration communautaire, vous exploiterez tout le potentiel de l'IA générative AWS pour générer un impact réel sur votre activité.

Rahul Sharma est ambassadeur AWS, architecte DevOps et blogueur technique spécialisé dans le cloud computing, les pratiques DevOps et les technologies open-source. Avec une expertise dans AWS, Kubernetes et Terraform, il simplifie les concepts complexes pour les apprenants et les professionnels à travers des articles et des tutoriels engageants. Rahul est passionné par la résolution des défis DevOps et par le partage des connaissances afin d'aider la communauté technologique.