Programa

A IA generativa da AWS é o futuro dos serviços em nuvem, porque permite que as empresas criem conteúdo automatizado e trabalho de conhecimento por meio de modelos básicos que produzem texto, imagens e vídeo em tempo real.

Neste artigo, eu dou uma visão geral completa dos elementos essenciais dos métodos de implantação e estruturas de governança necessários para desenvolver soluções de IA generativa prontas para produção.

A AWS é a líder em nuvem porque oferece o Amazon Bedrock junto com uma infraestrutura de computação especializada e amplos recursos de integração que são melhores que outras plataformas de nuvem.

Se você é novo na AWS, esse curso introdutóriooferece uma base sólida antes de mergulhar nos detalhes da IA generativa.

Entendendo os componentes principais

Nesta seção, vamos ver os blocos que fazem a IA generativa da AWS funcionar.

Ecossistema do modelo básico

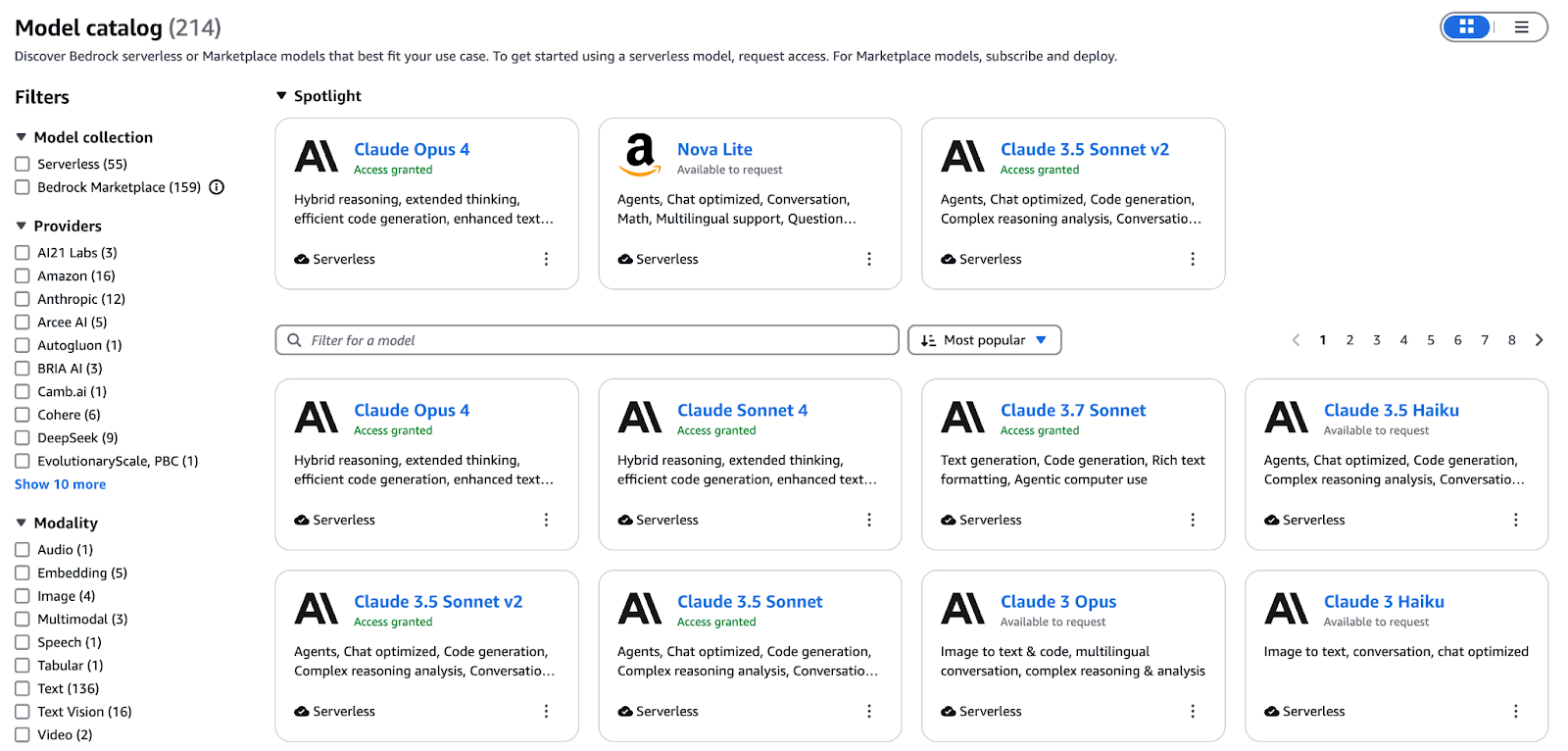

O Bedrock é tipo o plano de controle gerenciado pra toda a IA generativa na AWS. Ele oferece uma API consistente para implantar, dimensionar e proteger modelos básicos, desde o provisionamento de terminais até o faturamento, para que você possa se concentrar em criar prompts e integrar a IA em vez de gerenciar a infraestrutura.

Um diagrama conceitual que mostra o ecossistema do modelo básico da AWS.

O Bedrock cataloune modelos para texto, imagem, vídeo e incorporações em uma única interface. As principais ofertas incluem:

- Texto Titan (Premier, Express, Lite): Janelas de contexto com até 32K tokens para diálogos complexos

- Nova Canvas: Geração e preenchimento de texto em imagem com alta fidelidade para ativos criativos seguros para a marca

- Nova Reel: Clipes curtos de vídeo animado feitos a partir de uma única sugestão

- Incorporações multimodais Titan G1: Codifica texto e imagens num espaço vetorial partilhado para pesquisa de semelhanças e RAG.

Ajuste os modelos com os seus dados rotulados ou continue o pré-treinamento em corpora específicos do domínio usando o console Bedrock ou o SDK. Depois que o treinamento estiver concluído, o pacote de avaliação da Bedrock faz comparações lado a lado, mostrando a precisão, a latência e o custo por token, para que você possa escolher de forma objetiva a melhor opção para os SLAs de produção.

Além das famílias Titan e Nova da AWS, o Bedrock te dá acesso a modelos de parceiros como Anthropic, Cohere, Mistral, AI21 Labs e muito mais. Aproveite essa variedade para:

- Crie assistentes de conhecimento com RAG que mostram respostas precisas de wikis internos

- Crie textos e imagens de marketing em grande escala com uma voz consistente da marca.

- Incorpore a conclusão e revisão de código com IA nos fluxos de trabalho dos desenvolvedores

- Aumente os conjuntos de dados de treinamento sintetizando textos, imagens ou vídeos personalizados para o seu domínio.

Para saber mais sobre como o Bedrock organiza esses modelos básicos em ambientes de produção, dá uma olhada neste guia completo do Amazon Bedrock.

Infraestrutura de computação otimizada por IA

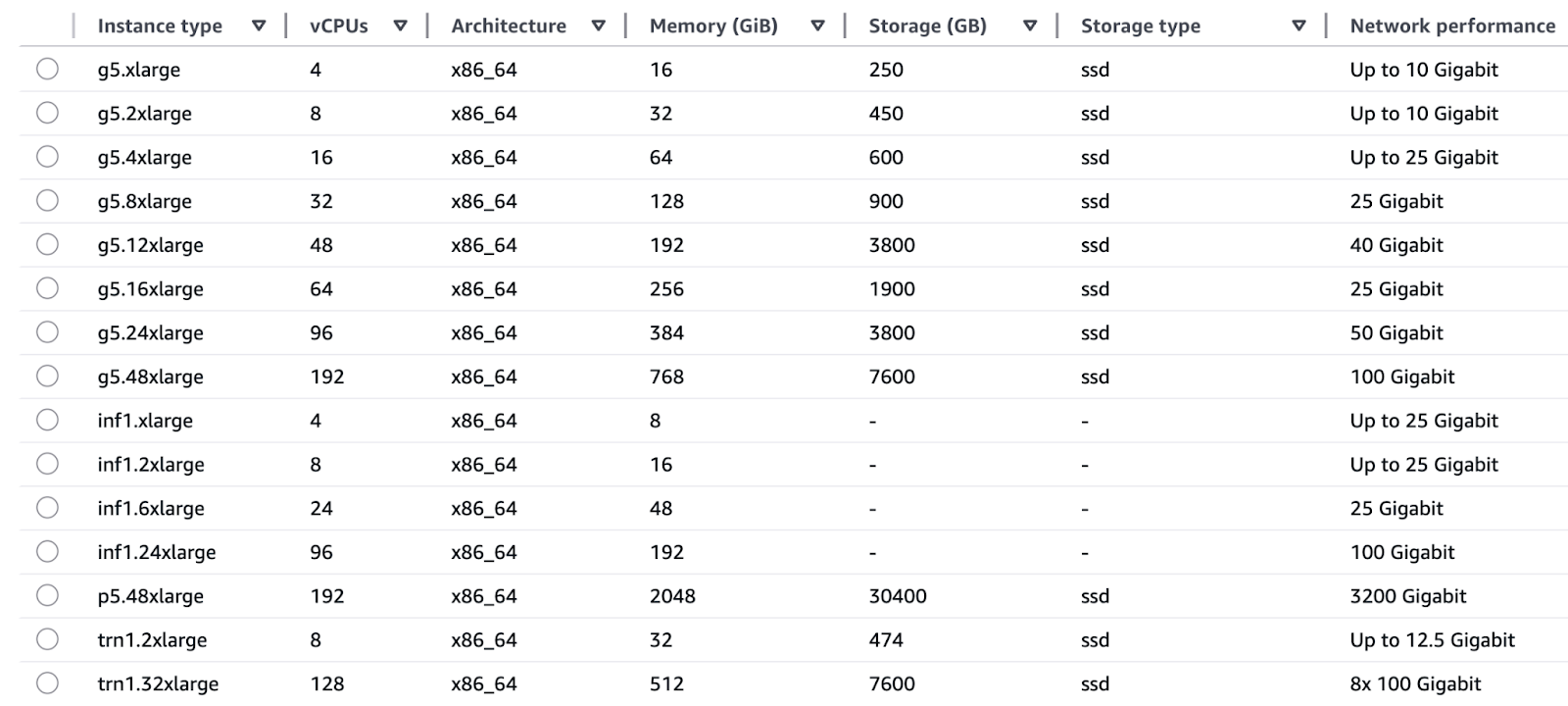

As famílias de instâncias EC2 que a AWS oferece são feitas pra atender às necessidades específicas das operações de treinamento e inferência.

Treinamento:

- As instâncias Trn1 (Trainium) funcionam com chips AWS Trainium para oferecer recursos de treinamento em deep learning, incluindo LLMs e modelos de difusão com velocidades 3 vezes mais rápidas e custo por hora menor em comparação com instâncias baseadas em GPU.

- O P5 e o P4 (GPUs NVIDIA H100 e A100) oferecem recursos incríveis de processamento paralelo com suporte para precisão mista, que é ideal tanto para testes de pesquisa quanto para processos de retreinamento em produção em grande escala.

Conclusão:

- Os chips AWS Inferential usados nos sistemas Inf1 e Inf2 permitem inferências em tempo real com latências de milissegundos, ao mesmo tempo que oferecem um custo por inferência duas vezes menor do que as alternativas de GPU.

- G5 e G4dn (GPUs NVIDIA A10G e T4) oferecem um equilíbrio econômico de desempenho que é ideal para aceleração de GPU em tempo real em aplicativos de chatbot e mecanismos de recomendação.

Um diagrama que mostra como é a infraestrutura de computação otimizada para IA da AWS.

A AWS consegue uma integração perfeita entre seus componentes de hardware e software personalizados por meio do Trainium para treinamento e do Inferentia para chips de inferência, que funcionam direto com os serviços da AWS. Essa integração vertical traz:

- A relação custo-benefício incrível do TensorFlow e do PyTorch faz com que o custo total de propriedade seja menor.

- A combinação de eficiência energética e aquisição simplificada ajuda as equipes a evitar a dependência de um único fornecedor de GPUs.

- O SageMaker e o Bedrock têm recursos automáticos de dimensionamento certo que deixam você escolher as melhores configurações de silício com só alguns cliques, sem precisar se preocupar com os detalhes dos chips.

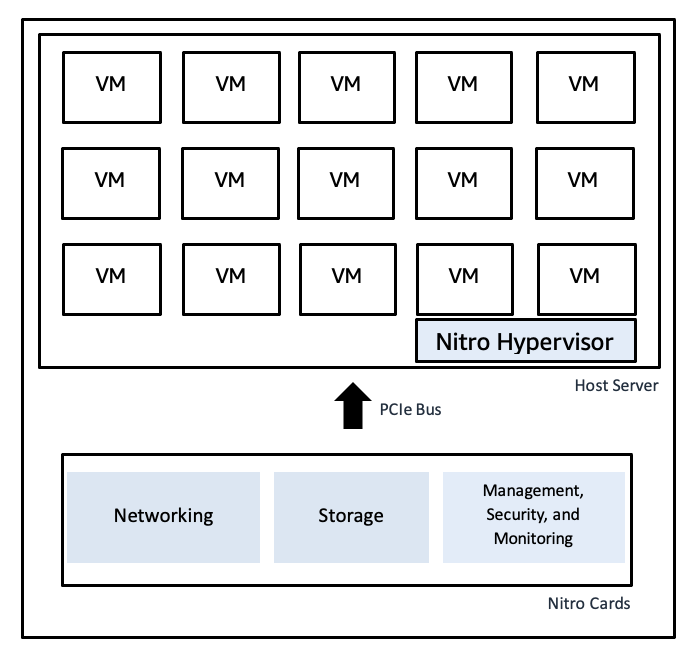

O AWS Nitro System usa placas de hardware dedicadas para fazer as funções de virtualização, dando assim velocidades rápidas de bare metal junto com isolamento seguro:

- O Nitro Hypervisor tem um código bem simples, o que diminui as vulnerabilidades e mantém as cargas de trabalho separadas umas das outras.

- As redes e caminhos de armazenamento acelerados por hardware funcionam com alta taxa de transferência de E/S e baixos níveis de instabilidade, o que evita picos de latência para oferecer um desempenho consistente em picos de carga.

- A integração do Nitro com o CloudTrail, o CloudWatch e o AWS Config oferece monitoramento completo da conformidade sem prejudicar o desempenho.

Um diagrama ilustrativo do Nitro Hypervisor da AWS Nitro Hypervisor

Um diagrama ilustrativo do Nitro Hypervisor da AWS Nitro Hypervisor

Explore o ecossistema mais amplo de computação, armazenamento e análise neste cursosobre Tecnologia e Serviços em Nuvem da AWS.

Fundamentos de dados para uma IA generativa robusta

O treinamento de modelos em alta velocidade e os pipelines RAG precisam de acesso a dados limpos e bem gerenciados:

- O sistema de armazenamento de dados em escala petabyte do Amazon S3 se integra ao Lake Formation para catalogação e recursos de segurança de conjuntos de dados brutos e selecionados.

- A solução de armazenamento de dados Amazon Redshift funciona como uma plataforma para tabelas estruturadas que oferecem análises rápidas e recuperação de dados.

- Os pipelines de transformação de dados criados com o AWS Glue e o Athena permitem a preparação de recursos e contexto para cargas de trabalho generativas e execução de consultas ad hoc.

- A governança de dados e os mecanismos de linhagem garantem que o treinamento do modelo use entradas confiáveis, enquanto o conhecimento da empresa fundamenta os resultados por meio do controle de acesso e do rastreamento da proveniência.

Estrutura de integração empresarial

Os recursos de IA generativa da AWS se juntam direto com o seu ecossistema mais amplo pra oferecer soluções completas e prontas pra produção. Esta seção fala sobre como juntar o Bedrock com os serviços que o acompanham para criar aplicativos de IA generativa de verdade.

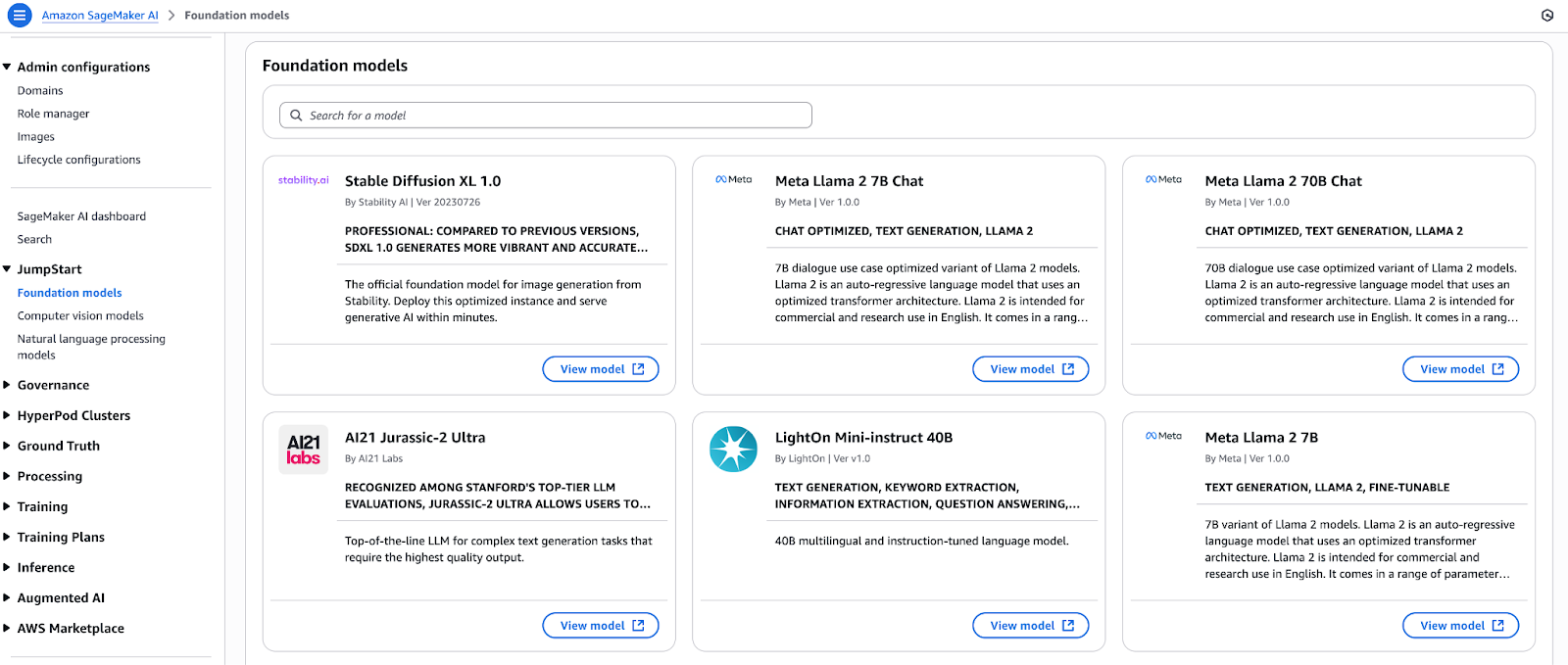

Ciclo de vida de ML unificado com SageMaker JumpStart e Bedrock

Escolha modelos básicos no hub de modelos do SageMaker JumpStart e comece a usá-los rapidinho. Você pode usar vários modelos de código aberto e proprietários com um único clique antes de registrá-los diretamente no Amazon Bedrock. Os modelos que entram no Bedrock têm acesso a:

- A moderação do conteúdo e a aplicação das políticas funcionam através de recursos de proteção.

- As bases de conhecimento oferecem recursos de Geração Aumentada por Recuperação (RAG) para fontes de dados privadas.

- A API Converse mantém a consistência ao fornecer uma camada de abstração que elimina variações específicas do modelo.

A arquitetura integrada permite que os desenvolvedores criem protótiposno SageMaker Studio e depois os aprimorem no Bedrock antes de implantá-los por meio de pipelines de CI/CD sem precisar mexer no código.

Este tutorial do SageMaker mostra como ajustar e usar modelos usando a plataforma de ML da AWS.

Um diagrama que mostra o ciclo de vida unificado do ML com o SageMaker JumpStart e o Bedrock.

Um diagrama que mostra o ciclo de vida unificado do ML com o SageMaker JumpStart e o Bedrock.

Orquestrando fluxos de trabalho com os agentes Amazon Bedrock

Com o Bedrock Agents, você pode integrar IA generativa nas suas aplicações operacionais, pegando dados automaticamente e transformando-os antes de fazer qualquer coisa. Um Agente só precisa de uma configuração básica pra:

- O sistema faz conexões seguras com APIs RESTful, bancos de dados e filas de mensagens.

- O sistema pega documentos, métricas e dados de log enquanto faz o pré-processamento antes de disponibilizar os dados para os modelos.

- O sistema faz várias operações em segundo plano, que incluem validação de enriquecimento e notificação por meio de chamadas de funções sequenciais.

- O sistema gera resultados estruturados ou conversacionais para uso em sistemas posteriores.

As funções de encanamento dos Agentes permitem que os desenvolvedores se concentrem na lógica de negócios em vez de no código de integração, acelerando assim o tempo de retorno do investimento.

Criando assistentes conversacionais com o Amazon Q

O Amazon Q é um serviço totalmente gerenciado para desenvolver assistentes de negócios com RAG.

O serviço junta a funcionalidade multimodelo do Bedrock com:

- O data warehouse (Redshift), o mecanismo de pesquisa (OpenSearch) e os conectores da ferramenta de BI já vêm configurados.

- O sistema tem recursos integrados pra gerenciar diálogos com várias voltas, além do contexto da sessão e geração de respostas no estilo de citação.

- A plataforma tem uma ferramenta de desenvolvimento de interface de usuário com pouco código pra criar protótipos rapidinho.

Com o Q, as empresas criam chatbots para lidar com os clientes, além de painéis de controle para os chefes e serviços de suporte técnico específicos para cada área, e tudo isso em semanas, não em meses.

A lente de IA generativa bem arquitetada usa as melhores práticas em todas as etapas do desenvolvimento de cargas de trabalho generativas.

Lente de IA generativa bem arquitetada

A lente de IA generativa da AWS amplia os cinco pilares da estrutura bem arquitetada para cargas de trabalho generativas. A estrutura inclui sistemas automatizados de monitoramento de modelos e mecanismos de detecção de desvios, além de gatilhos de reciclagem com gerenciamento de artefatos de versão e acompanhamento de métricas de inferência.

Aqui estão os pilares:

- Segurança: Imponha IAM com privilégios mínimos, use o PrivateLink para pontos de extremidade Bedrock, criptografe dados em trânsito e em repouso e aplique proteções de filtragem de conteúdo.

- Confiabilidade: A solução usa implantação de endpoint baseada em AZ, autoescala, disjuntores e implantação Canary para lançamentos sem riscos.

- Eficiência de desempenho: Escolha as famílias de instâncias ideais, armazene em cache solicitações frequentes e em lote e aproveite os pontos de extremidade sem servidor para escalar até zero.

- Otimização de custos: A escolha do modelo precisa seguir os requisitos de latência ao usar capacidade spot ou reservada, a engenharia rápida deve minimizar o uso de tokens e a análise de custos deve ser feita no Cost Explorer.

- Sustentabilidade: Use computação do tamanho certo, chips que economizam energia (Trainium, Inferentia), arquive dados frios no S3 Glacier e adote pipelines sem servidor para reduzir recursos ociosos.

Pra quem tá querendo se certificar, o programa AWS Cloud Practitionercombina bem com o conhecimento básico que a gente aprendeu aqui.

Acelere a adoção com os parceiros da AWS

A Rede de Parceiros da AWS ajuda as empresas a adotarem os serviços da AWS mais rápido com aceleradores de soluções e serviços de parceiros. Cada empresa é diferente das outras, por isso a AWS criou a Rede de Parceiros com aceleradores de IA generativa específicos para diferentes setores e casos de uso.

- A Rede de Parceiros da AWS tem Parceiros de Tecnologia que oferecem aplicativos prontos, junto com conectores e modelos básicos específicos para cada área, disponíveis no AWS Marketplace.

- O programa Generative AI Accelerator ajuda startups oferecendo créditos, mentoria e planos de melhores práticas para acelerar o desenvolvimento de provas de valor.

- Usar as estruturas dos parceiros APN junto com os padrões de solução validados pela AWS ajuda as equipes a reduzir os riscos durante os projetos piloto enquanto implementam IA generativa em toda a organização com segurança.

Visão geral dos serviços de IA da AWS que a gente oferece

A capacidade da IA generativa de criar novos conteúdos não combina com o que as aplicações do mundo real precisam, que é processar e entender dados em vários formatos de apresentação.

A AWS oferece um monte de serviços que se juntam com seus pipelines gerativos pra transformar documentos desestruturados em dados estruturados, extrair insights de imagens e permitir conversas naturais e entrega de resultados em qualquer idioma ou voz.

Aqui estão os mais populares:

- Amazon Textract

- O sistema detecta automaticamente texto impresso, tabelas e dados de formulários em documentos digitalizados e arquivos de imagem.

- O sistema usa pipelines RAG para processar documentos específicos do domínio, como contratos, relatórios e faturas.

- O sistema organiza o conteúdo desorganizado para prepará-lo para modelos rápidos e ajustes nos conjuntos de dados.

- Amazon Rekognition

- O sistema usa análise de imagens e vídeos pra identificar objetos, cenas, textos, rostos e atividades.

- O sistema gera metadados contextuais (rótulos, pontuações de confiança) para geração multimodal.

- O sistema permite que os usuários implementem lógica condicional (por exemplo, “descreva apenas imagens que contenham pessoas”) em seus aplicativos de usuário final.

- Amazon Polly

- O serviço transforma texto escrito em áudio falado de forma parecida com a voz humana, em várias vozes e idiomas.

- A capacidade de saída de áudio transforma chatbots e assistentes generativos em interfaces interativas.

- O sistema aceita marcação SSML pra controlar a saída de voz com pronúncia precisa, ênfase e pausas certas.

- Para saber como a Polly permite saídas de voz parecidas com a humana em aplicações reais, confiraeste tutorial prático.

- Amazon Lex

- O sistema cria interfaces conversacionais usando reconhecimento automático de fala (ASR) e compreensão de linguagem natural (NLU).

- O sistema funciona como a interface frontal para os geradores de back-end, cuidando do gerenciamento de sessões e das operações de preenchimento de vagas.

- O sistema se conecta direto ao AWS Lambda pra executar os endpoints Bedrock ou SageMaker e gerar respostas dinâmicas.

- Amazon Translate

- O serviço oferece tradução automática neural imediata para mais de 70 idiomas diferentes.

- O sistema adapta os resultados gerados para que possam ser acessados por todo mundo.

- O sistema padroniza entradas em vários idiomas, permitindo que um único modelo atenda usuários de diferentes regiões.

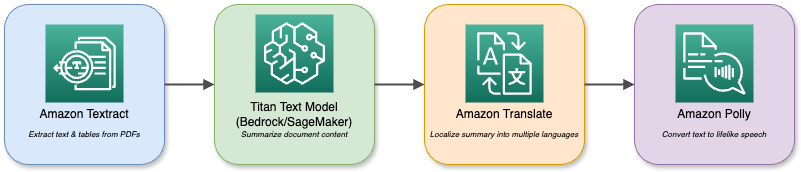

Um diagrama que mostra os vários serviços e interações da AWS.

Os seus modelos básicos no Bedrock ou SageMaker podem ser combinados com esses serviços para criar aplicativos multimodais complexos.

Um assistente de análise de documentos, por exemplo, usa o Textract para pegar PDFs e, depois, usa o Titan Text para resumir tudo antes de traduzir o resumo para vários idiomas e reproduzir com o Polly. O ecossistema modular permite que você combine vários recursos de IA para atender a qualquer necessidade da sua empresa.

Padrões de implementação e casos de uso

A IA generativa dá os melhores resultados quando você usa padrões bem arquitetados para resolver problemas reais de negócios.

Essa seção mostra quatro planos de implementação específicos, incluindo geração aumentada por recuperação e assistentes para desenvolvedores e empresas, além de outros cenários de alto valor que você pode implementar hoje mesmo.

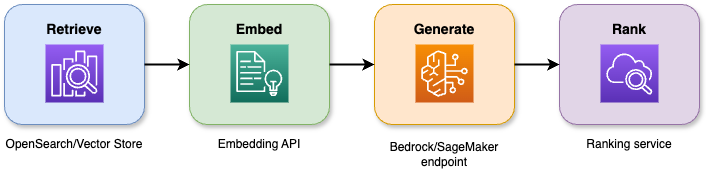

Arquiteturas de geração aumentada por recuperação (RAG)

A combinação de recursos de pesquisa com grandes modelos de linguagem na geração aumentada por recuperação gera respostas precisas que permanecem fundamentadas no contexto. O pipeline de quatro etapas funciona assim:

- O sistema pega os N documentos ou trechos mais relevantes de um armazenamento vetorial ou índice de pesquisa por meio de uma consulta.

- O sistema transforma tanto os documentos quanto as consultas dos usuários em incorporações semânticas, o que permite um melhor alinhamento do contexto.

- O sistema manda tanto a consulta quanto o contexto que achou para um modelo básico para gerar uma resposta.

- O sistema usa um modelo secundário ou heurístico para pontuar e reclassificar os resultados candidatos, apresentando a resposta mais adequada.

Um diagrama que mostra como funciona a geração aumentada por recuperação (RAG).

Benefícios e ganhos em precisão:

- O sistema reduz as alucinações em 40% em comparação com os métodos básicos de geração.

- Os pilotos da base de conhecimento da empresa mostram que a relevância das respostas melhora em 20 a 30 por cento.

- O tempo médio de interação do usuário cai 25% quando se usa sistemas de suporte virtual.

Aplicações comerciais:

- O conteúdo interno do wiki é a base para os chatbots e assistentes virtuais darem um resumo dos tickets e dicas para resolver problemas.

- Os sistemas RAG, que vêm com interfaces de busca, deixam a gente dar uma olhada em um monte de documentos usando a linguagem natural.

- O sistema permite que assistentes jurídicos, regulatórios e de conformidade forneçam citações de passagens da fonte quando os usuários pedirem.

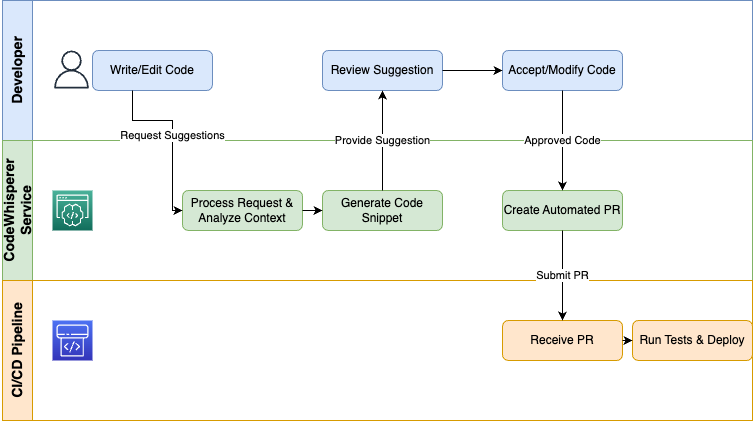

Fluxos de trabalho de geração de código

O AWS CodeWhisperer oferece IA generativa direto para os desenvolvedores através de seus IDEs e pipelines de CI/CD para automatizar tarefas repetitivas e acelerar os processos de codificação:

- O sistema tem três funções principais, incluindo sugestões de código em tempo real, conclusão de trechos e geração de testes que se adaptam ao seu contexto de codificação atual.

- As equipes conseguem entregar recursos mais rápido, tipo 30%, enquanto os erros de sintaxe nos protótipos iniciais caem 50%.

- O pipeline CodeCatalyst permite que os usuários criem automaticamente trechos de IaC de infraestrutura, testes de unidade e scripts de implantação por meio da integração com o CodeWhisperer.

- A plataforma suporta várias linguagens de programação, incluindo Python, Java, JavaScript/TypeScript, C#, Go e outras, que trazem benefícios para toda a sua pilha de tecnologia.

Um diagrama que mostra como funciona a geração de código.

As empresas que usam o CodeWhisperer como assistente de desenvolvedores eliminam o trabalho repetitivo, garantem que os padrões de codificação sejam seguidos e permitem que os engenheiros dediquem seu tempo a atividades importantes, como design e depuração.

Lembre-seque o CodeWhisperer vai passar a fazer parte do Amazon Q Developer.

Assistentes empresariais

O Amazon Q Business funciona como uma solução de baixo código com tecnologia RAG, permitindo que os usuários criem assistentes conversacionais que buscam dados da empresa por meio de perguntas.

Arquitetura:

- O sistema pega os dados do Redshift, OpenSearch, SharePoint e S3 usando conectores.

- O motor RAG pega o contexto certo antes de ativar os modelos básicos.

- O gerenciador de diálogos controla a gestão de sessões com várias voltas, incluindo preenchimento de slots e operações de estado.

- A camada da interface do usuário responde a widgets de bate-papo, canais de voz e integrações com o Slack.

Cenários de implantação:

- A transcrição e o resumo automáticos das ações a serem realizadas por meio de assistentes de reunião permitem que as equipes economizem mais de duas horas de trabalho por semana.

- A implementação de bots de autoatendimento evita perguntas rotineiras, reduzindo em 30% o tempo de atendimento.

- Os painéis executivos oferecem insights em linguagem natural sobre vendas, estoque e KPIs para quem não precisa de treinamento em BI.

Os assistentes ajudam as organizações a simplificar o trabalho de conhecimento, reduzir custos operacionais e permitir que os funcionários alcancem níveis mais altos de produtividade.

Outros casos de uso de alto valor

O valor da IA generativa vai além do RAG, da geração de código e dos assistentes, estendendo-se a vários outros domínios:

- Esses sistemas podem criar descrições personalizadas de produtos, campanhas por e-mail e interações por chat com base em perfis individuais e análises de comportamento.

- A combinação do Textract com modelos de análise de formulários e geração permite a classificação, marcação e encaminhamento automáticos de faturas, contratos e reclamações, bem como tarefas posteriores (criação de tickets, encaminhamento para aprovação e geração de relatórios) por meio de uma lógica de decisão orientada por modelos.

- A análise de transcrições de suporte, feeds de redes sociais e chamadas de vendas por meio de análise conversacional mostra tendências de sentimentos, riscos de conformidade e recomendações práticas.

Comece com esses padrões para criar projetos-piloto que mostrem um retorno sobre o investimento claro antes de passar para a otimização e a expansão em toda a sua organização.

Modelo de segurança e governança

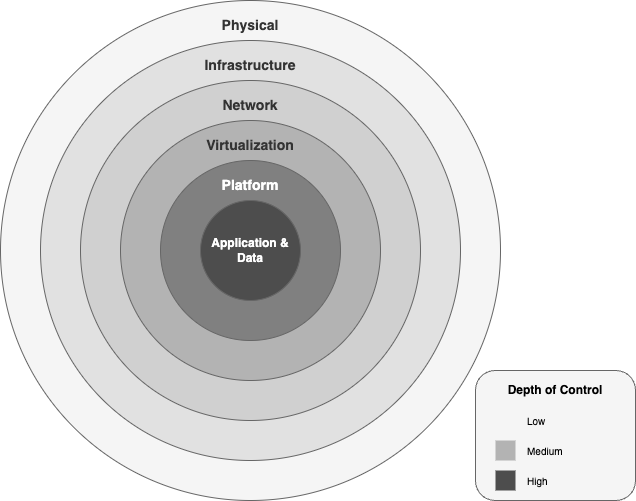

As empresas precisam implementar controles de segurança e práticas de governança em todas as etapas do ciclo de vida da IA quando adotam a IA generativa.

A AWS oferece uma estrutura completa de segurança e conformidade que vai desde centros de dados físicos até políticas no nível de aplicativos, permitindo inovar com confiança.

Arquitetura de proteção de dados

A AWS protege as cargas de trabalho de IA generativa com seis camadas de segurança concentricas:

- A camada física dos centros de dados tem controles de acesso multifatorial, triagem biométrica e monitoramento 24 horas por dia, 7 dias por semana, o que garante que o contato com o hardware fique restrito ao pessoal autorizado.

- A rede global da AWS protege o tráfego de IA por meio de conexões de fibra privada e mitigação de DDoS, além do AWS Shield Advanced, mantendo alta taxa de transferência de rede ao isolando o tráfego da Internet pública.

- Os pontos de extremidade do modelo e os pipelines de dados continuam seguros graças à combinação de VPCs com grupos de segurança granulares, ACLs de rede e pontos de extremidade PrivateLink, que funcionam dentro das suas redes privadas. redes privadas.

- O Nitro System transfere as operações de virtualização para componentes de hardware especializados, que oferecem velocidade e proteção baseadas em hardware bare-metal proteção baseada em hardware contra o compartilhamento não autorizado de dados entre máquinas virtuais.

- A camada de plataforma dos terminais Bedrock e SageMaker se integra com o AWS KMS para chaves gerenciadas pelo cliente, usa criptografia TLS 1.2+ para transmissão de dados e aplica permissões IAM com base no princípio do privilégio mínimo.

- A camada de aplicativos e dados implementa políticas de recursos detalhadas com criptografia AES-256 em repouso e em trânsito e integram registro de auditoria através do CloudTrail e do CloudWatch para proteger e registrar todas as chamadas de API.

Um diagrama que mostra as camadas de segurança dentro da estrutura de IA generativa da AWS.

Isolamento de dados e conformidade:

- Cada instância de inferência do Bedrock funciona dentro da sua VPC enquanto acessa e modifica os buckets S3 que você gerencia.

- Você escolhe as CMKs gerenciadas pelo cliente através do AWS KMS e pode usar armazenamentos de chaves externos (XKS/HYOK) para cumprir os requisitos de conformidade soberana.

- A AWS tem várias certificações, como ISO 27001 e SOC 1/2/3 Fed, RAMP High, HIPAA, PCI, DSS e GDPR, que automaticamente se estendem às suas cargas de trabalho de IA generativa sem precisar fazer nada extra.

Estrutura de IA responsável

A gente precisa criar confiança na IA generativa implementando protocolos éticos e de segurança em cada etapa da invocação do modelo. A AWS faz uma governança responsável da IA usando essa estrutura:

- Os princípios éticos da AWS priorizam a justiça, a privacidade, a transparência e a responsabilidade para evitar preconceitos discriminatórios nos modelos e manter uma documentação clara da linhagem dos dados e da lógica de decisão.

- O sistema Bedrock Guardrails tem filtros baseados em políticas que verificam tanto os dados que entram quanto os resultados que saem, comparando com categorias que incluem discurso de ódio e violência, automutilação e desinformação. A API Invoke e a API ApplyGuardrail permitem que os usuários implementem barreiras de proteção para verificações de segurança de forma independente ou por meio da API Invoke.

- O sistema registra todas as solicitações e decisões de proteção por meio do CloudTrail, enquanto os cartões de modelo e os relatórios de avaliação mostram métricas de desempenho, possíveis vieses e trade-offs entre custo e latência.

- O sistema oferece supervisão contínua por meio da detecção de viés do SageMaker Clarify e fluxos de trabalho de revisão com intervenção humana para resultados de baixa confiança, além de alertas automáticos de detecção de desvios para retreinamento ou revogação do modelo.

Essas camadas e práticas criam uma postura de defesa em profundidade para a IA generativa empresarial, permitindo que você inove e, ao mesmo tempo, mantenha os mais altos padrões de segurança, conformidade e responsabilidade ética.

Estratégias de otimização de custos

O processo de controle dos orçamentos de IA generativa exige tanto um conhecimento completo dos mecanismos de precificação quanto práticas contínuas de gerenciamento de custos. Essa seção explica os preços da AWS para cargas de trabalho de IA, mostrando um exemplo de TCO de implantação de tamanho médio e estratégias para reduzir as despesas.

Análise do modelo de preços

Os preços da IA generativa da AWS se dividem em quatro dimensões principais:

- Calcular custos

- Horas de endpoint: cobradas por hora de instância, variando de acordo com a família

- Inf1.xlarge por US$ 0,228/hora

- G5.xlarge por US$ 1,006/hora

- Trabalhos de treinamento: cobrados por hora de instância em hardware Trn1, P4 ou P5 (por exemplo, Trn1.32xlarge a US$ 21,50/hora)

- Taxas de token/solicitação

- Tokens instantâneos: US$ 0,0008 por 1 K tokens

- Tokens de conclusão: US$ 0,0016 por 1 K tokens

- Armazenamento e transferência de dados

- Modelos de artefatos: Padrão S3 por US$ 0,023/GB por mês

- Saída de dados: US$ 0,09/GB além do nível gratuito

- Personalização e avaliação

- Ajustes finos: taxas extras de treinamento por hora por instância, mais taxas mínimas de processamento de dados.

- Execuções de avaliação: taxas de token para comparações entre linha de base e personalizadas.

Estratégias de otimização de custos

- Escolha o silicone certo: Use Inferentia (Inf1/Inf2) para inferência de alto volume e baixa latência e Trainium (Trn1) para treinamento em grande escala para reduzir o custo por hora de TPU.

- Solicitações em lote e cache: Agrupe pedidos parecidos e guarde as respostas mais populares pra reduzir o uso repetido de tokens.

- Pontos finais multimodelo: Hospede vários modelos menores atrás de um único terminal, trocando a latência de pico por custos significativamente mais baixos nas horas de inatividade.

- Capacidade disponível e reservada: Comprometa-se com uma fração da capacidade básica com Instâncias Reservadas ou use Spot para cargas de trabalho em lote não críticas.

- : Simplifique as instruções para usar menos tokens por solicitação sem perder a qualidade.

Comparando arquiteturas

|

Arquitetura |

Calcular o fator de custo |

Fator determinante do custo do token |

Melhor ajuste |

|

Chatbots em tempo real |

Muitos terminais pequenos funcionando 24 horas por dia, 7 dias por semana |

Alta taxa de solicitação, tokens pequenos |

Suporte ao cliente, Central de ajuda |

|

Geração em lote |

Instâncias grandes de curta duração |

Poucas explosões grandes de tokens |

Geração de relatórios, aumento de dados |

|

Pipelines RAG |

Pesquisa combinada + inferência |

Token de recuperação + token de geração |

Assistentes baseados em conhecimento |

Modelo de custo total de propriedade

Abaixo tá um exemplo de TCO mensal pra um projetopiloto de IA generativa de tamanho médio:

|

Item de custo |

Custo unitário |

Como usar |

Custo mensal |

|

Pontos finais da inferência (Inf1.xl) |

R$ 0,228 /hora |

3 pontos finais × 24 horas × 30 dias |

$492.48 |

|

Uso de tokens (Titan Express) |

R$ 0,0024 /1 token K |

3 fichas M por dia × 30 dias |

$216.00 |

|

Armazenamento S3 (artefatos do modelo) |

R$ 0,023 /GB por mês |

10 000 GB |

$230 |

|

Saída de dados |

R$ 0,09 /GB |

1 TB |

$90 |

|

Colagem ETL (preparação de recursos) |

R$ 0,44 /DPU-hora |

20 horas após a colheita |

$8.80 |

|

Total |

$1,037.28 |

Principaisalavancas de otimização:

- Auto-escalar para zero: Desative os terminais ociosos quando o tráfego diminuir.

- Pontos finais multimodelo: Junte os modelos pra reduzir as taxas de tempo ocioso em até 60%.

- Reservado e Spot: Garanta tarifas com desconto para a capacidade básica e use o Spot para trabalhos que não precisam de latência.

- Compressão rápida: Reestruture os prompts para cortar tokens que não são necessários, reduzindo em 10 a 15% o uso de tokens.

Gerenciamento contínuo de custos:

- Use a Calculadora de preços da AWS paramodelar cenários antes do lançamento.

- Fica de olho no uso real no AWS Cost Explorer, definindo orçamentos e alertas pra qualquer coisa fora do normal.

- Marque todos os recursos de IA para relatórios claros de cobrança e showback.

A combinação de uma arquitetura que leva em conta os preços com otimizações direcionadas e monitoramento contínuo permite que você amplie a IA generativa sem custos excessivos.

Roteiro de implementação

O processo de escalonamento da IA generativa, desde o conceito até a produção, precisa de uma metodologia sistemática em fases. O roteiro dá um passo a passo, começando pelas avaliações iniciais, passando por testes de conceito, até chegar a uma plataforma resiliente e pronta para empresas.

Fases de avaliação e piloto

A primeira etapa é ver se dá pra fazer e conseguir a aprovação de todo mundo antes de começar a desenvolver a arquitetura toda.

- Análise de lacunas e definição de metas

- Conduzir entrevistas com os donos das empresas pra entender os requisitos dos casos de uso, os critérios de sucesso e as metas de retorno sobre o investimento.

- Dá uma olhada nas fontes de dados atuais, nos controles de segurança e nas capacidades de ML.

- Identifique lacunas de conformidade ou privacidade (por exemplo, tratamento de informações pessoais identificáveis) que seu piloto deve resolver.

- Desenvolvimento de prova de conceito (PoC)

- Escolha um caso de uso que valha a pena (por exemplo, um bot de suporte com RAG ou um resumidor de documentos) para a primeira fase.

- Crie uma infraestrutura mínima: um endpoint Bedrock ou SageMaker conectado a um pequeno conjunto de dados via S3 ou OpenSearch.

- Defina métricas importantes (precisão, latência, custo por solicitação) e use os painéis do CloudWatch.

- Prototipagem rápida com guias passo a passo

- Use os projetos de exemplo da Biblioteca de soluções da AWS (por exemplo, RAG Chatbot, demonstração do CodeWhisperer) para criar o protótipo.

- Repita rapidamente as instruções e estratégias de recuperação, registrando o que aprendeu em um wiki compartilhado.

- Validação das partes interessadas

- Mostre o protótipo funcional para os usuários finais e peça o que acham da qualidade do resultado e da experiência do usuário.

- Aperfeiçoa o escopo, adiciona ou tira fontes de dados e ajusta os parâmetros do modelo com base no uso real.

- Garantir o apoio da gerência e o orçamento para a próxima fase.

Fases de fundação e escala

A Prova de Conceito leva ao desenvolvimento da plataforma básica antes que o sistema possa ser usado por todo mundo.

- Construção da base da plataforma

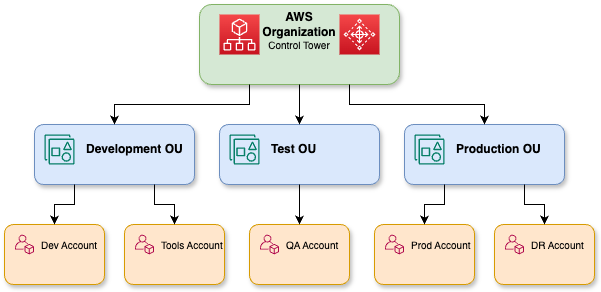

- A estrutura de várias contas do AWS Control Tower precisa ser criada para os limites das UOs de desenvolvimento, teste e produção na zona de aterragem.

- Implementar funções e políticas de IAM, AWS SSO e controles de privilégios mínimos para acesso a modelos e pipelines de dados.

- Os VPCs devem ser configurados com pontos de extremidade PrivateLink. Os CMKs do Bedrock/SageMaker KMS devem estar ativados e o monitoramento do GuardDuty deve ser implementado.

- Automatize o ETL com AWS Glue/Athena, catalogue ativos no Lake Formation e sincronize armazenamentos de conhecimento para RAG.

Uma representação detalhada das organizações da AWS.

- MLOps e governança de modelos

- O processo de retreinamento, avaliação e implantação do modelo deve ser automatizado por meio de pipelines de CI/CD que usam CodeCatalyst ou CodePipeline.

- Um registro de modelos deve ser criado no SageMaker ou em um catálogo baseado em Git para artefatos baseados em versões e ajustados.

- O sistema deve detectar automaticamente desvios e fazer um retreinamento programado para garantir o desempenho e a conformidade.

- Escalonamento para produção

- Os padrões de tráfego variáveis devem ser combinados usando o autoescalonamento do Bedrock ou os pontos de extremidade do SageMaker.

- O uso de pontos finais multimodelo permite hospedar vários FMs menores atrás de uma API, resultando em uma redução de até 60% nos custos de inatividade.

- A implantação deve ser feita em várias Zonas de Disponibilidade, e uma implementação gradual deve ser feita para garantir que as atualizações não causem tempo de inatividade.

- Rede de parceiros e centros de inovação da AWS

- É bom chamar os parceiros de consultoria pra dar uma força em áreas específicas, tipo finanças, saúde e varejo.

- O AWS Marketplace deve ser usado pra conseguir conectores prontos pra usar e modelos de domínio pré-treinados dos Parceiros de Tecnologia.

- Os Centros de Inovação da AWS e os Community Builders devem trabalhar juntos para ter acesso a hackathons, análises de arquitetura e workshops práticos para acelerar a adoção das melhores práticas.

A abordagem em fases da validação, seguida pela construção de bases e, em seguida, pela expansão com governança e apoio de parceiros, vai ajudar você a transformar seu piloto de IA generativa em uma capacidade robusta em toda a empresa.

Otimizar e controlar as fases

O aprimoramento contínuo e práticas sólidas de governança, implementadas depois de expandir sua plataforma de IA generativa, garantem que o sistema funcione bem, mantendo a segurança e a conformidade regulatória.

Otimização contínua

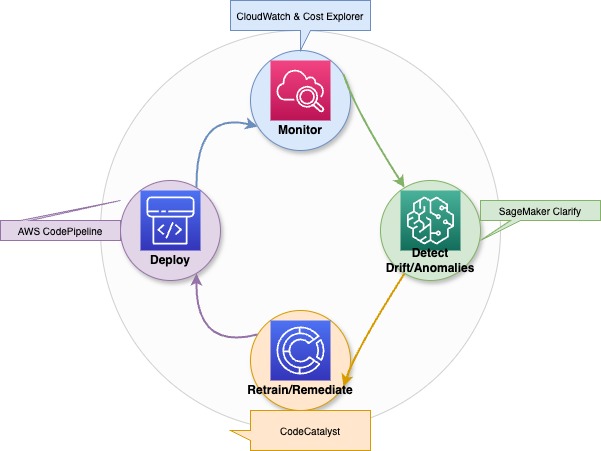

- Monitoramento e alertas automáticos

- Os pontos de extremidade do Bedrock/SageMaker precisam das métricas do CloudWatch (incluindo latência, taxas de erro e taxa de transferência) e dos painéis do Cost Explorer para instrumentação.

- Configure alarmes de detecção de anomalias, como picos repentinos no gasto de tokens ou regressões na latência de inferência, e acione fluxos de trabalho de correção automática (aumento/redução de escala, reversão do modelo).

Um diagrama que mostra como funciona a otimização contínua, a deteção de desvios e os processos de retreinamento para modelos de IA generativa.

- Detecção de desvio e retreinamento

- Use detectores de desvio baseados em incorporação ou o SageMaker Clarify para sinalizar mudanças na distribuição dos dados.

- Limites de desvio acionam pipelines de retreinamento automáticos por meio do CodePipeline/CodeCatalyst para manter a precisão do modelo e o desempenho imparcial.

- Ajuste de custos

- Dá uma olhada regularmente nas taxas de horas ociosas e junta os modelos em pontos finais com vários modelos, se der.

- Ajuste as solicitações para reduzir o uso desnecessário de tokens e agrupe as solicitações de baixa prioridade.

Auditorias de governança e conformidade

- Auditorias programadas

- A sua organização deve fazer avaliações trimestrais das políticas de IAM e do uso de chaves KMS, junto com as configurações de endpoint VPC e os logs do CloudTrail, para garantir que estão seguindo os padrões de acesso com privilégios mínimos e criptografia.

- O AWS Audit Manager e as regras do AWS Config permitem a coleta automática de evidências para as normas ISO, HIPAA ou SOC.

- Aplicação da política

- A sua organização precisa atualizar o Bedrock Guardrails com políticas de conteúdo e fazer avaliações de filtro de categoria durante cada período de lançamento.

- Seu pipeline de CI/CD precisa ter uma etapa de aprovação que impeça a implantação da versão do modelo se a avaliação de segurança ou justiça não der certo.

Treinamento contínuo e desenvolvimento de habilidades

- Construtor de habilidades da AWS

- A trilha de aprendizagem da IA Generativa deve inscrever equipes por meio do AWS Skill Builder para aprender sobre os fundamentos do Bedrock, padrões RAG e práticas recomendadas de implantação segura.

- Os laboratórios práticos ensinam os alunos a configurar instâncias Trn1/Inf1 enquanto configuram Guardrails e fazem a detecção de viés com o SageMaker Clarify.

- Certificação e comunidade

- Os engenheiros devem buscar as certificações AWS Certified Machine Learning – Specialty e AWS Certified Security – Specialty.

- Os workshops do AWS Community Builders and Innovation Center ajudam você a ficar por dentro dos novos serviços, análises de arquitetura e programas aceleradores.

Ao juntar a otimização contínua e auditorias rigorosas com práticas de aprendizagem organizacional, você pode manter uma capacidade de IA generativa resiliente, confiável e econômica.

Recursos e primeiros passos

A jornada da IA generativa da AWS pode ser acelerada por meio de trilhas de aprendizagem, comunidades e projetos práticos que aumentam a confiança e geram impacto real nos negócios.

AWS Skill Builder e recursos de treinamento

- A trilha de aprendizagem Generative AI no AWS Skill Builder oferece treinamento completo sobre modelos básicos, pipelines RAG e as melhores práticas de implantação segura.

- As plataformas interativas PartyRock e Bedrock Playground permitem que os usuários testem engenharia rápida, ajustes finos e inferência sem precisar configurar nenhuma infraestrutura.

- Os laboratórios guiados mostram aos usuários como criar instâncias Trn1 e Inf1 e configurar pontos de extremidade criptografados por KMS antes de implantar fluxos de trabalho RAG de ponta a ponta.

Comunidade de desenvolvedores e ecossistema de parceiros

- A Comunidade e o Centro de Desenvolvedores de IA Generativa da AWS oferecem acesso a exemplos de código, fóruns e white papers selecionados sobre o Well-Architected Generative AI Lens.

- A AWS Partner Network oferece aceleradores pré-construídos, modelos básicos específicos para cada domínio e conectores prontos para uso, todos disponíveis no AWS Marketplace.

- Os Centros de Inovação e os Community Builders da AWS oferecem workshops, hackathons e sessões de revisão de arquitetura que ajudam você a acelerar seu processo de implementação.

Guias passo a passo e projetos de exemplo

- A plataforma DataCamp tem tutoriais passo a passoe modelos de soluções que permitem que os usuários obtenham códigos para personalização por meio de bifurcação.

- Os repositórios de exemplos completos mostram como usar o Textract para pegar dados e o SageMaker RAG para organizar tudo, além do Polly para falar.

- Os usuários podem implementar projetos totalmente funcionais por meio da plataforma, que permite modificar prompts, modelos e pipelines para casos de uso corporativo e medição de desempenho.

Conclusão

A IA generativa da AWS oferece um sistema completo de ponta a ponta, incluindo modelos básicos, computação otimizada, governança, integração e controle de custos, para ajudar as empresas a inovar mais rápido e reduzir as despesas operacionais enquanto criam aplicativos multimodais confiáveis em grande escala.

Com experimentação, aprendizado contínuo e colaboração da comunidade, você vai aproveitar todo o potencial da IA generativa da AWS para gerar um impacto real nos negócios.

Rahul Sharma é embaixador da AWS, arquiteto de DevOps e blogueiro técnico especializado em computação em nuvem, práticas de DevOps e tecnologias de código aberto. Com experiência em AWS, Kubernetes e Terraform, ele simplifica conceitos complexos para alunos e profissionais por meio de artigos e tutoriais envolventes. Rahul é apaixonado por resolver desafios de DevOps e compartilhar insights para capacitar a comunidade de tecnologia.