Curso

Databricks SQL es una potente herramienta diseñada para la gestión y el análisis de datos dentro de la plataforma Databricks Lakehouse. Esta plataforma integra la ingeniería de datos, la ciencia de datos y la analítica empresarial en una experiencia unificada. Por lo tanto, Databricks SQL es importante para los profesionales de datos que buscan agilizar sus flujos de trabajo de datos, la ejecución de consultas y las tareas de BI sin la complejidad de la gestión tradicional de infraestructuras.

En este artículo, exploraré los componentes, características y herramientas de Databricks SQL y mostraré ejemplos prácticos de creación y uso del almacén Databricks SQL. Para empezar, recomiendo encarecidamente seguir el curso Introducción a Databricks de DataCamp para conocer Databricks como solución de almacenamiento de datos para Business Intelligence (BI), que aprovecha las capacidades optimizadas de SQL para crear consultas y analizar datos.

¿Qué es Databricks SQL?

Databricks SQL es una robusta herramienta de análisis dentro de la plataforma Databricks Lakehouse que permite a los profesionales de datos ejecutar consultas SQL, analizar datos y crear cuadros de mando interactivos. Diseñado con una arquitectura sin servidor, Databricks SQL combina la flexibilidad de los lagos de datos con las capacidades de gobernanza y rendimiento de los almacenes de datos.

Los componentes clave de Databricks SQL son los Almacenes SQL, los Editores SQL y los Cuadros de Mando SQL. No te preocupes si no estás familiarizado con cada una de ellas, porque a continuación profundizaré en su significado.

Componentes básicos de Databricks SQL

Los componentes principales de Databricks SQL facilitan la consulta eficaz, la visualización de datos y la colaboración entre usuarios. A continuación encontrarás un resumen de las principales herramientas y funciones disponibles en Databricks SQL.

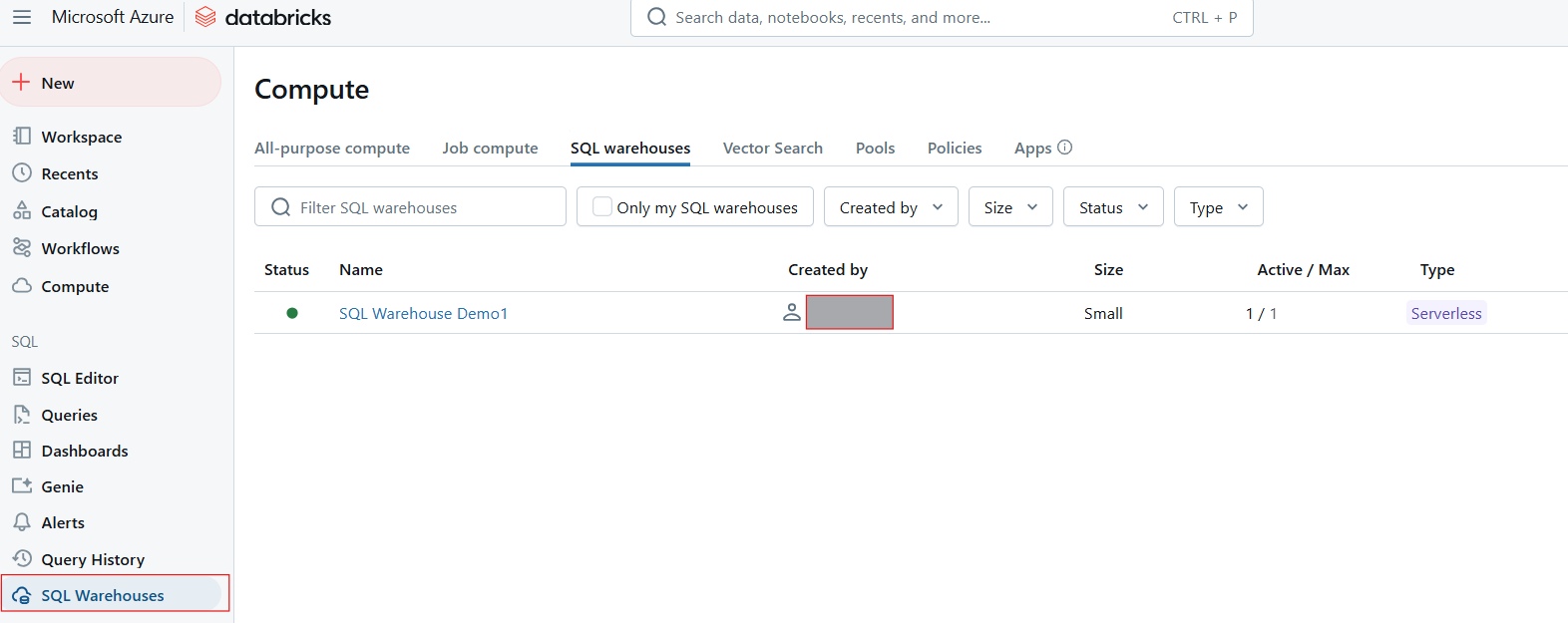

Almacenes SQL

Los Almacenes SQL sirven como recursos computacionales para ejecutar consultas SQL en Databricks SQL. Están diseñados para manejar cargas de trabajo variables y proporcionan optimizaciones de rendimiento basadas en el tipo de almacén seleccionado. Hay tres tipos principales de Almacenes SQL:

- Clásico: Este tipo admite funcionalidades básicas y es adecuado para un rendimiento básico. Utiliza la capa de cálculo existente en tu cuenta en la nube, pero carece de funciones avanzadas como la Gestión Inteligente de la Carga de Trabajo (GIC) y la IO Predictiva.

- Pro: Los Almacenes Pro SQL ofrecen un mayor rendimiento gracias a la compatibilidad con Photon, un motor de consulta vectorizado que acelera las operaciones SQL y mejora las opciones de seguridad.

- Sin servidor Elimina la gestión de la infraestructura mediante el aprovisionamiento automático de recursos, el escalado elástico y la ejecución de consultas con baja latencia. Son ideales para entornos con cargas de trabajo fluctuantes y ofrecen un rendimiento rentable.

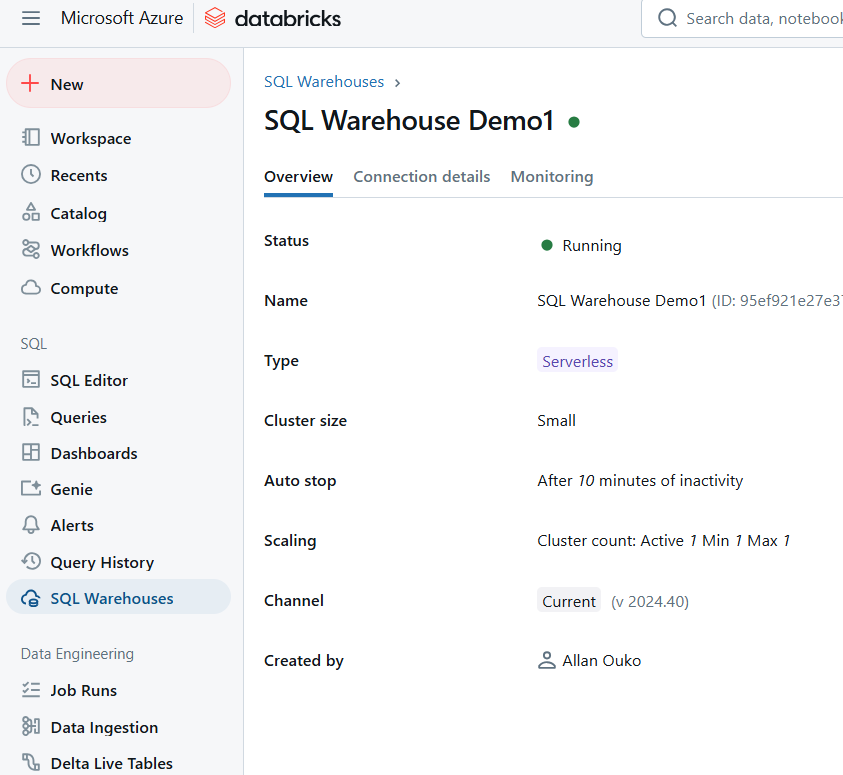

Almacén SQL en Databricks SQL. Imagen del autor.

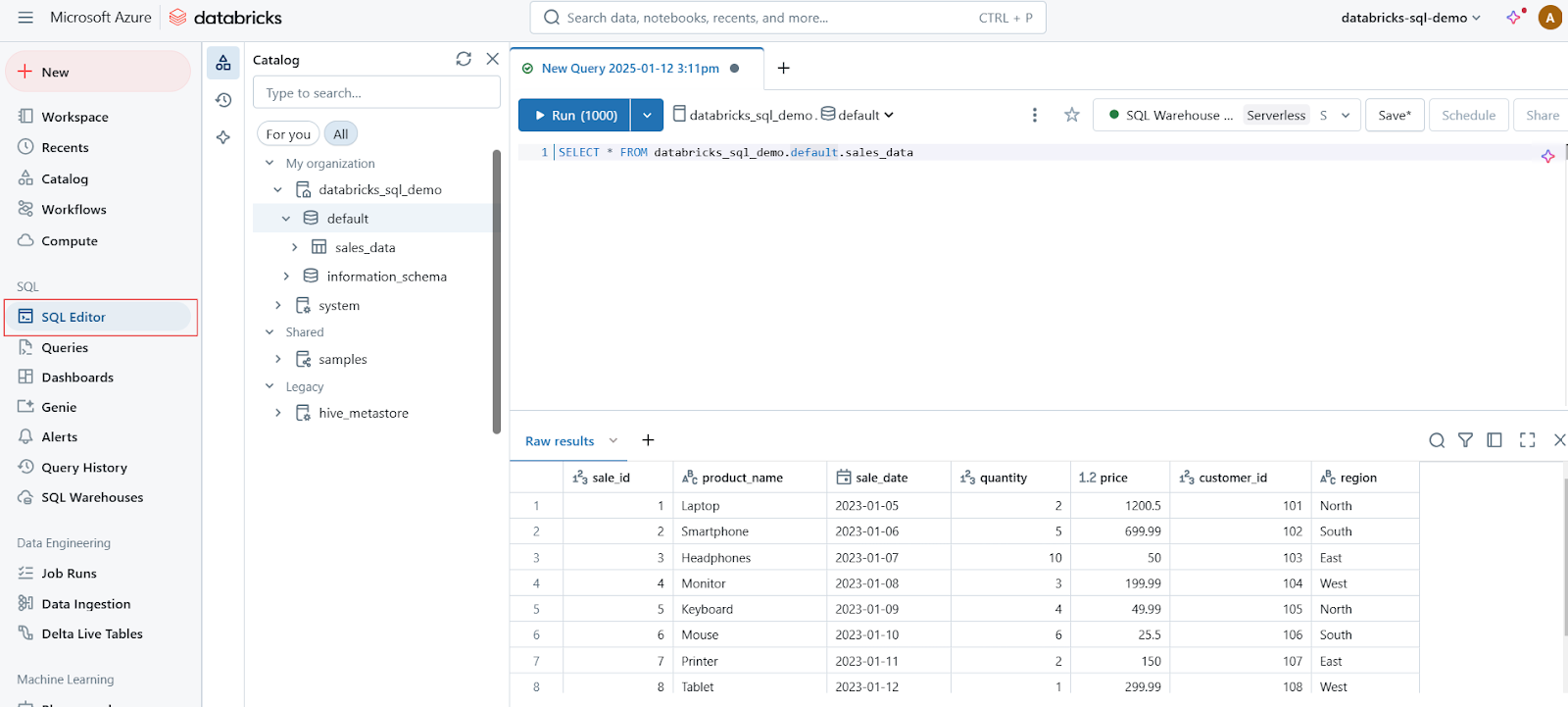

SQL Editor

El Editor SQL es una interfaz fácil de usar que permite a los usuarios escribir, ejecutar y gestionar consultas SQL. Las principales características del Editor SQL son

- Consulta intuitiva: Admite resaltado sintáctico, autocompletado y detección de errores para escribir consultas con eficacia.

- Vista previa de los datos: Los usuarios pueden previsualizar los datos directamente en el editor, lo que facilita la comprensión de los conjuntos de datos antes de ejecutar consultas complejas.

- Almacenamiento en caché del resultado de la consulta: Esta función mejora el rendimiento al almacenar en caché los resultados de consultas anteriores, lo que permite tiempos de respuesta más rápidos en consultas repetidas.

- Consultas parametrizadas: Los usuarios pueden crear consultas dinámicas incorporando parámetros, lo que simplifica el proceso de ejecutar consultas similares con valores diferentes.

Editor SQL en Databricks SQL. Imagen del autor.

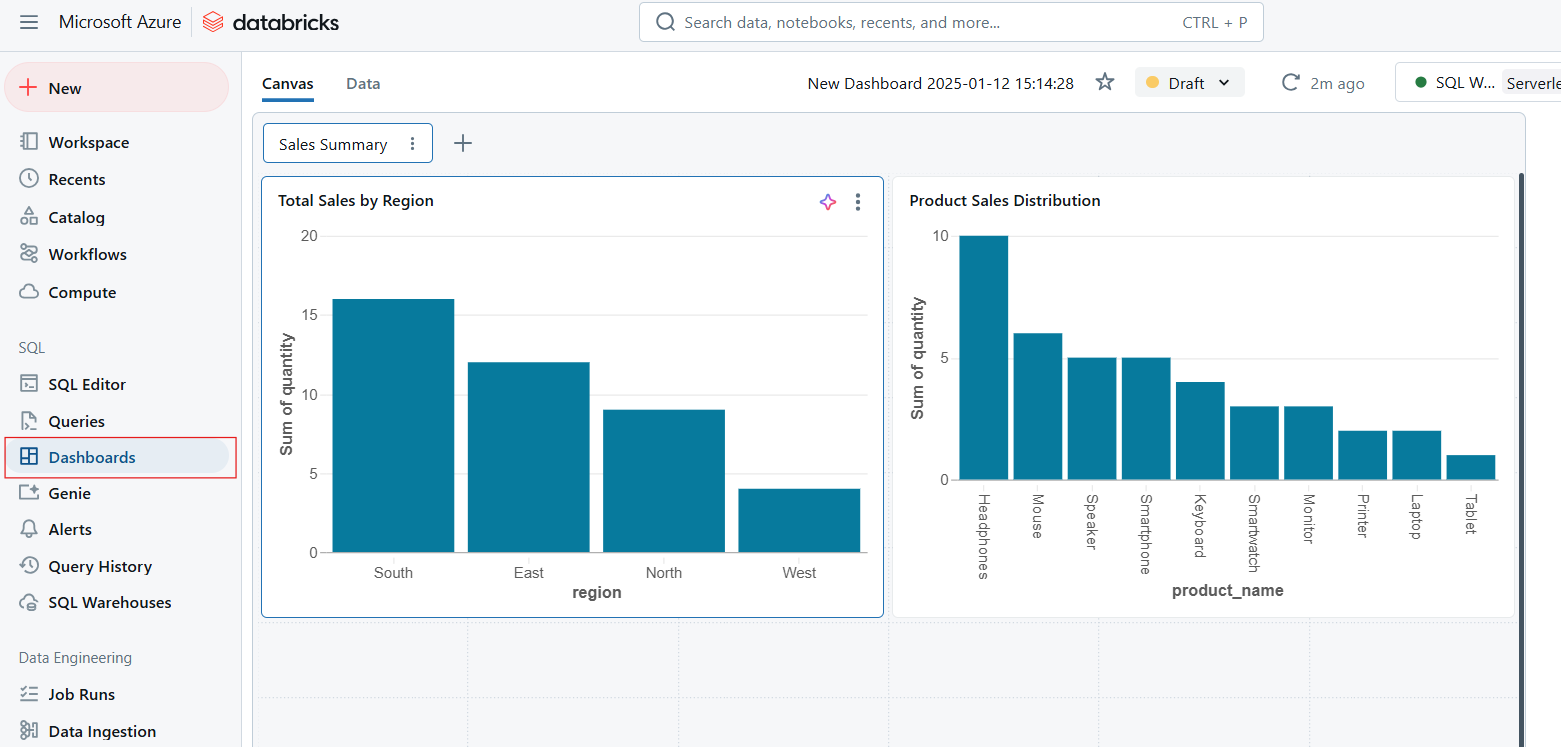

Cuadros de mando

Los cuadros de mando permiten visualizar los datos transformando los resultados de las consultas en tablas, gráficos y widgets interactivos. Los cuadros de mando son ideales para supervisar las métricas clave y comunicar la información de forma eficaz a toda la organización. Las capacidades clave de los cuadros de mando son las siguientes:

- Análisis en tiempo real: Actualiza automáticamente los cuadros de mando en función de los resultados de las consultas en tiempo real.

- Colaboración: Comparte cuadros de mando entre equipos para promover decisiones basadas en datos.

- Personalización: Elige entre una variedad de tipos de visualización y opciones de disposición para adaptarte a necesidades específicas.

Cuadros de mando en Databricks SQL. Imagen del autor.

Alertas

Las alertas en Databricks SQL proporcionan una forma de supervisar los cambios en los datos y activar notificaciones cuando se cumplen las condiciones especificadas. Las alertas son esenciales para mantener la calidad de los datos y garantizar respuestas oportunas a cambios importantes. La función de alerta funciona de la siguiente manera

- Establece las condiciones: Define umbrales o reglas basados en los resultados de la consulta.

- Activar notificaciones: Recibe alertas por correo electrónico, Slack u otras integraciones cuando se cumplan las condiciones.

- Vigilancia proactiva: Mantente informado en tiempo real sobre acontecimientos críticos, como anomalías en los datos o problemas del sistema.

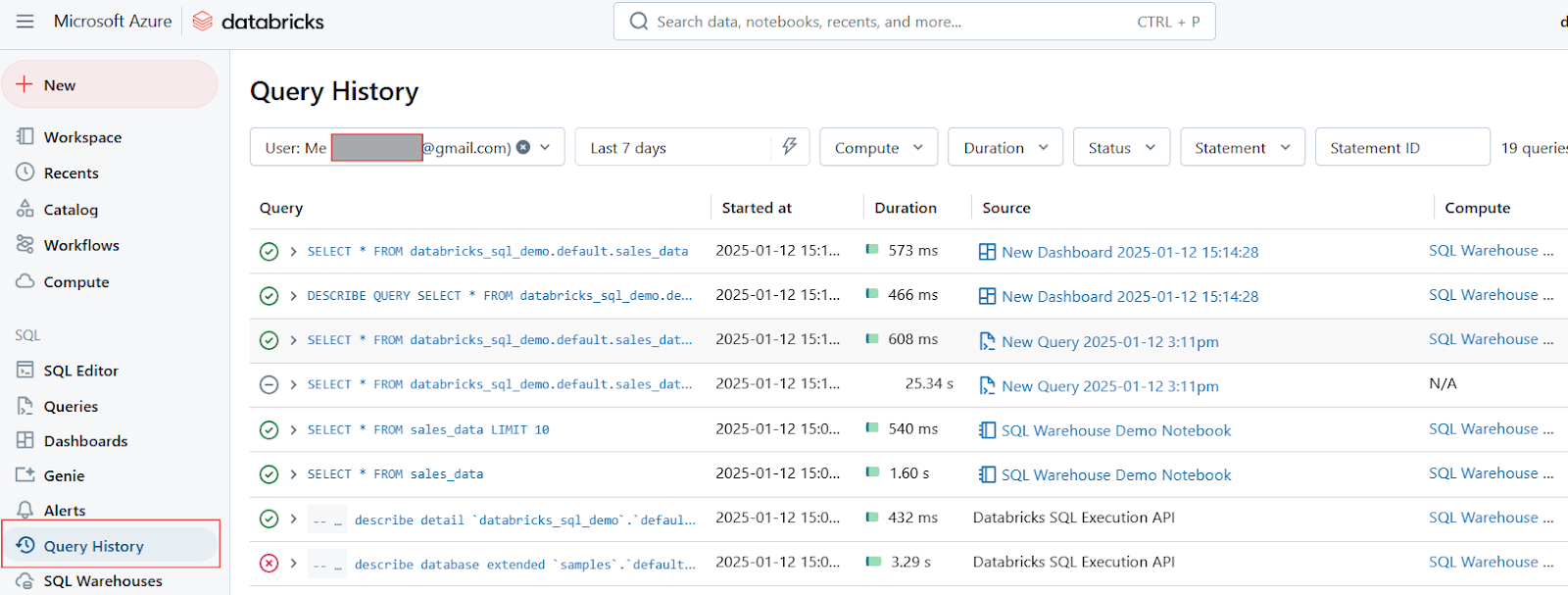

Historial de consultas y perfiles

Por último, quiero decir que Databricks SQL ofrece herramientas para el seguimiento del historial de consultas y la elaboración de perfiles:

- Historial de consultas: Esta función permite a los usuarios revisar las consultas ejecutadas anteriormente, proporcionando información sobre su rendimiento a lo largo del tiempo. Ayuda a identificar tendencias o problemas recurrentes.

- Perfiles de consulta: Las herramientas de perfilado de consultas analizan la eficiencia de las consultas ejecutadas, destacando los cuellos de botella y sugiriendo optimizaciones. Esta capacidad es importante para mejorar el rendimiento general de las consultas y la utilización de los recursos.

Historial de consultas en Databricks SQL. Imagen del autor.

Funciones y herramientas clave de Databricks SQL

Databricks SQL está repleto de funciones y herramientas avanzadas. Estas funciones están diseñadas para mejorar el rendimiento, agilizar los flujos de trabajo y permitir una integración perfecta con otras herramientas. Veamos algunos de los aspectos clave que hacen que Databricks SQL sea una gran elección.

Motor Fotón

El motor Photon es un motor de consulta vectorizado de alto rendimiento desarrollado por Databricks para acelerar significativamente la ejecución de consultas SQL. Las principales ventajas del Motor Fotón son las siguientes:

- Ejecución Vectorizada: A diferencia del procesamiento tradicional fila a fila, Photon utiliza la ejecución vectorizada, que procesa los datos por lotes. Este enfoque le permite aprovechar las instrucciones avanzadas de la CPU como SIMD (Instrucción única, datos múltiples) para una mayor eficiencia.

- Integración con las cargas de trabajo existentes: Photon es totalmente compatible con las API de Apache Spark, lo que significa que los usuarios pueden habilitarlo sin modificar el código existente. Esta integración sin fisuras permite a las organizaciones beneficiarse de un mayor rendimiento sin necesidad de grandes reajustes.

- Almacenamiento en caché y optimización: El motor incluye un optimizador avanzado de consultas y una capa de almacenamiento en caché que selecciona de forma inteligente qué datos almacenar en caché, mejorando aún más el rendimiento de las consultas.

CloudFetch y E/S asíncrona

CloudFetch y Async I/O son funciones diseñadas para aumentar la velocidad de transferencia de datos y mejorar la gestión de archivos pequeños durante la ejecución de consultas. Estas funciones funcionan de las siguientes maneras:

- CloudFetch: Esta función optimiza el modo en que los resultados se escriben en el almacenamiento en la nube, permitiendo escrituras paralelas en todos los nodos de cálculo. Reduce significativamente el tiempo necesario para transferir grandes conjuntos de datos a los clientes, consiguiendo un rendimiento hasta 10 veces más rápido en situaciones reales.

- E/S asíncrona: Esta capacidad mejora el manejo de archivos pequeños al leer varios bloques de datos simultáneamente mientras se procesan los bloques actuales. Este enfoque puede aumentar el rendimiento general de la consulta hasta 12 veces cuando se trata de archivos pequeños (por ejemplo, de 1 MB). Es especialmente eficaz en situaciones en las que hay muchos archivos pequeños o "datos fríos" que no se almacenan en caché.

Integración con herramientas BI

Databricks SQL se integra perfectamente con las herramientas de Business Intelligence (BI) más populares, facilitando a los equipos el análisis y la visualización de los datos. Las integraciones admitidas son las siguientes:

- Power BI: Los usuarios pueden conectar su espacio de trabajo de Databricks directamente con Power BI, lo que permite sincronizar fácilmente los modelos de datos. Por ejemplo, los analistas pueden publicar informes directamente desde Databricks en Power BI, manteniendo relaciones definidas entre tablas sin intervención manual.

- Tableau: Los usuarios pueden aprovechar las conexiones en directo para visualizar los datos almacenados en Databricks SQL. Esta integración permite análisis en tiempo real y cuadros de mando interactivos que reflejan las últimas actualizaciones de datos.

- dbt: Databricks SQL también se integra con dbt (herramienta de construcción de datos), lo que permite a los equipos gestionar sus transformaciones directamente dentro del entorno Databricks. Esta integración admite modelos incrementales y vistas materializadas, agilizando el proceso de construcción y mantenimiento de sólidos conductos de datos.

Arquitectura sin servidor

La arquitectura sin servidor de Databricks SQL elimina la necesidad de gestionar manualmente la infraestructura, al aprovisionar y escalar automáticamente los recursos en función de las demandas de la carga de trabajo. La arquitectura sin servidor ajustará automáticamente los recursos para gestionar cargas de consulta variables sin tiempo de inactividad. Esta función evita que los usuarios tengan que configurar o mantener los clusters manualmente. La arquitectura sin servidor también es rentable, ya que los usuarios sólo pagan por los recursos utilizados durante la ejecución de la consulta.

Por ejemplo, una empresa de venta al por menor experimenta grandes cargas de consultas durante las horas punta. La arquitectura sin servidor aumenta automáticamente los recursos para garantizar un rendimiento constante y los reduce durante las horas de menor actividad para ahorrar costes.

Guía paso a paso para crear y utilizar almacenes SQL de Databricks

Los Almacenes SQL de Databricks son esenciales para ejecutar consultas SQL con eficacia dentro del entorno Databricks. Ahora, en esta sección, te guiaré a través del proceso de creación de almacenes SQL y su uso con cuadernos. Si necesitas refrescar tus conocimientos sobre almacenes de datos, te recomiendo que sigas nuestro curso Conceptos de Almacenamiento de Datos para aprender los fundamentos del modelado de datos y la transformación de datos.

Creación de un almacén SQL Databricks

Sigue estos pasos para crear un Almacén SQL utilizando la interfaz web de Databricks:

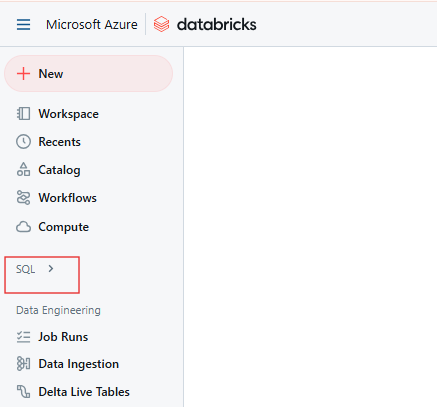

Paso 1: Navega a la página SQL de Databricks

En el espacio de trabajo Databricks, haz clic en el icono SQL de la barra lateral.

Página SQL de Databricks. Imagen del autor.

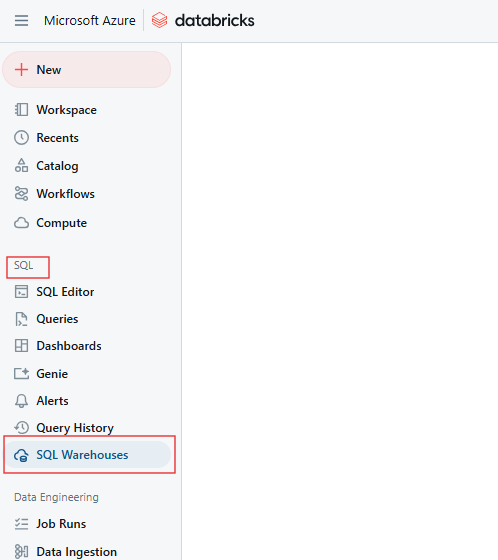

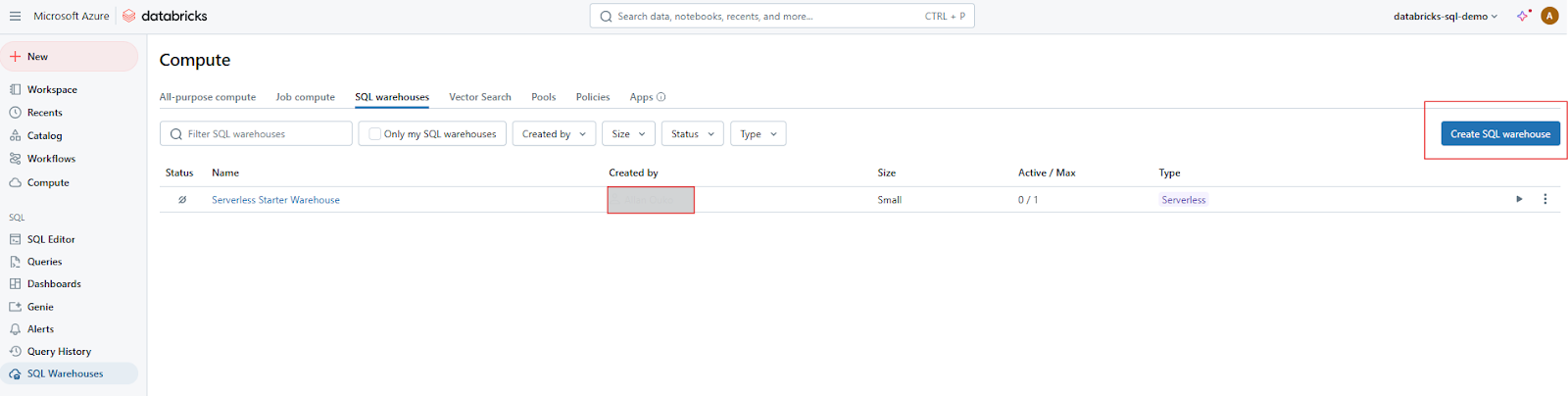

Paso 2: Abre la pestaña Almacenes SQL

En la página SQL, ve a la pestaña Almacenes SQL.

Pestaña Almacén SQL de Databricks. Imagen del autor.

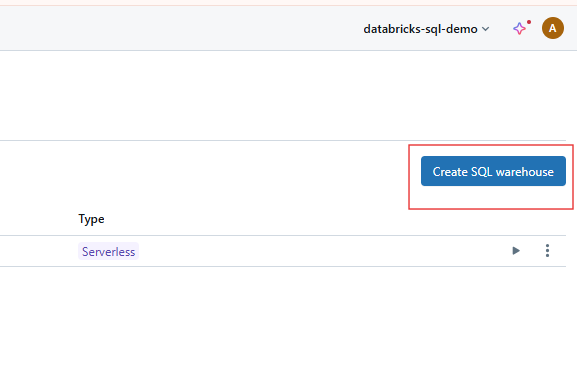

Paso 3: Haz clic en "Crear almacén".

Pulsa el botón Crear Almacén para empezar a configurar tu nuevo Almacén SQL.

Creación de Almacenes SQL en Databricks SQL. Imagen del autor.

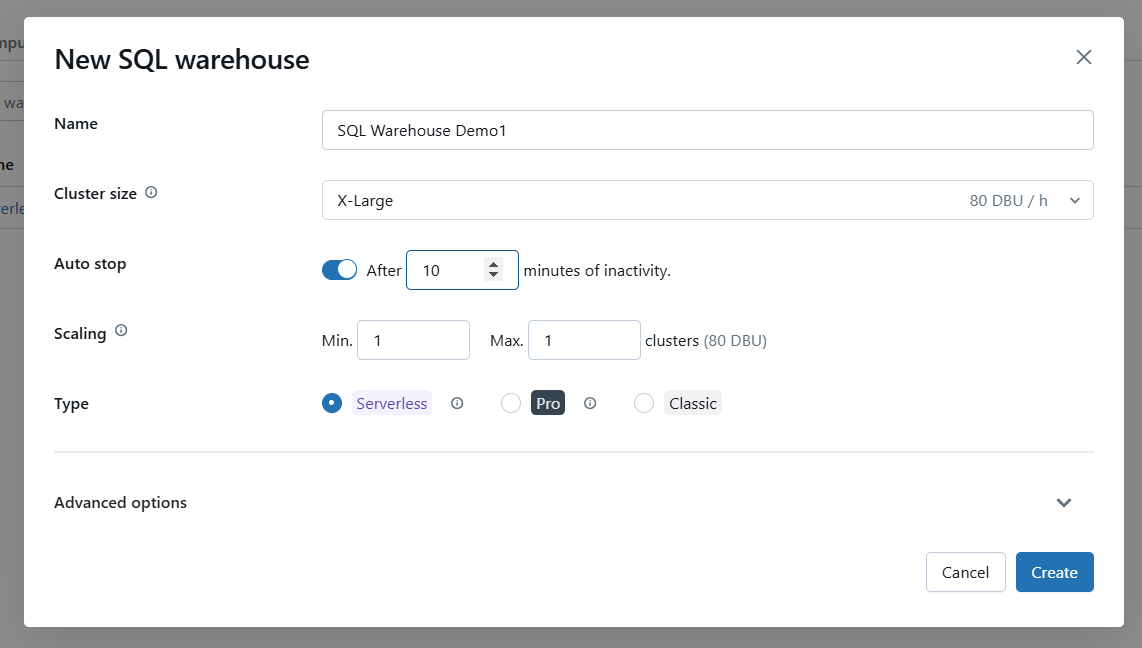

Paso 4: Configura los ajustes básicos

Configura los ajustes del almacén utilizando las siguientes opciones.

- Nombre: Proporciona un nombre único y descriptivo para tu Almacén SQL.

- Tamaño del grupo: Elige el tamaño del clúster en función de los requisitos de tu carga de trabajo. Ni que decir tiene que los clústeres más grandes gestionan más consultas concurrentes y conjuntos de datos más grandes.

- Auto-Stop: Establece el periodo de inactividad para detener automáticamente el almacén cuando no esté en uso. Diez minutos me parecen razonables. Esto ahorra costes al liberar recursos cuando están inactivos.

- Escala: Activa el Autoescalado para ajustar los recursos dinámicamente en función de la carga de la consulta. Especifica el número mínimo y máximo de clusters dentro de los cuales escalar.

- Opción sin servidor: Si está disponible en tu cuenta, elige Almacén SQL sin Servidor para una gestión simplificada y un escalado automático.

Configura las opciones básicas del Almacén SQL de Databricks. Imagen del autor.

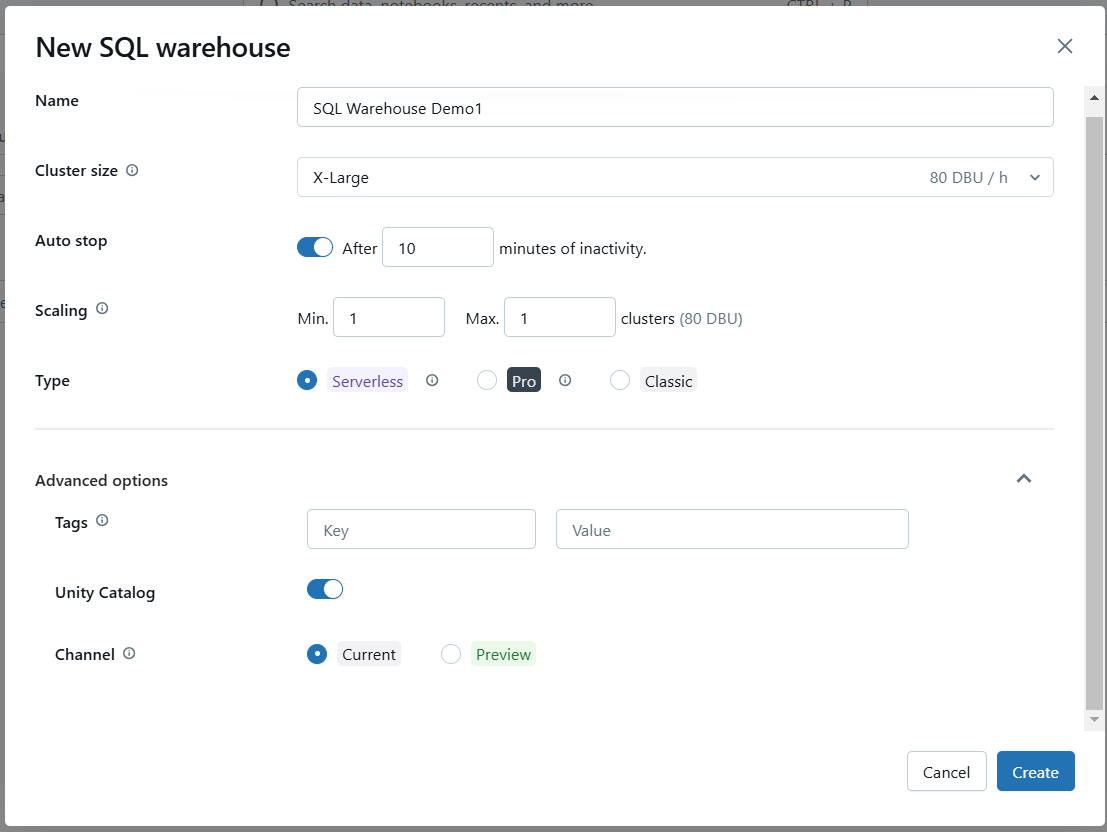

Paso 5: Opciones avanzadas (Opcional)

Si es necesario, configura opciones avanzadas como activar Photon o establecer configuraciones SQL específicas.

Configura las opciones avanzadas del Almacén SQL de Databricks. Imagen del autor.

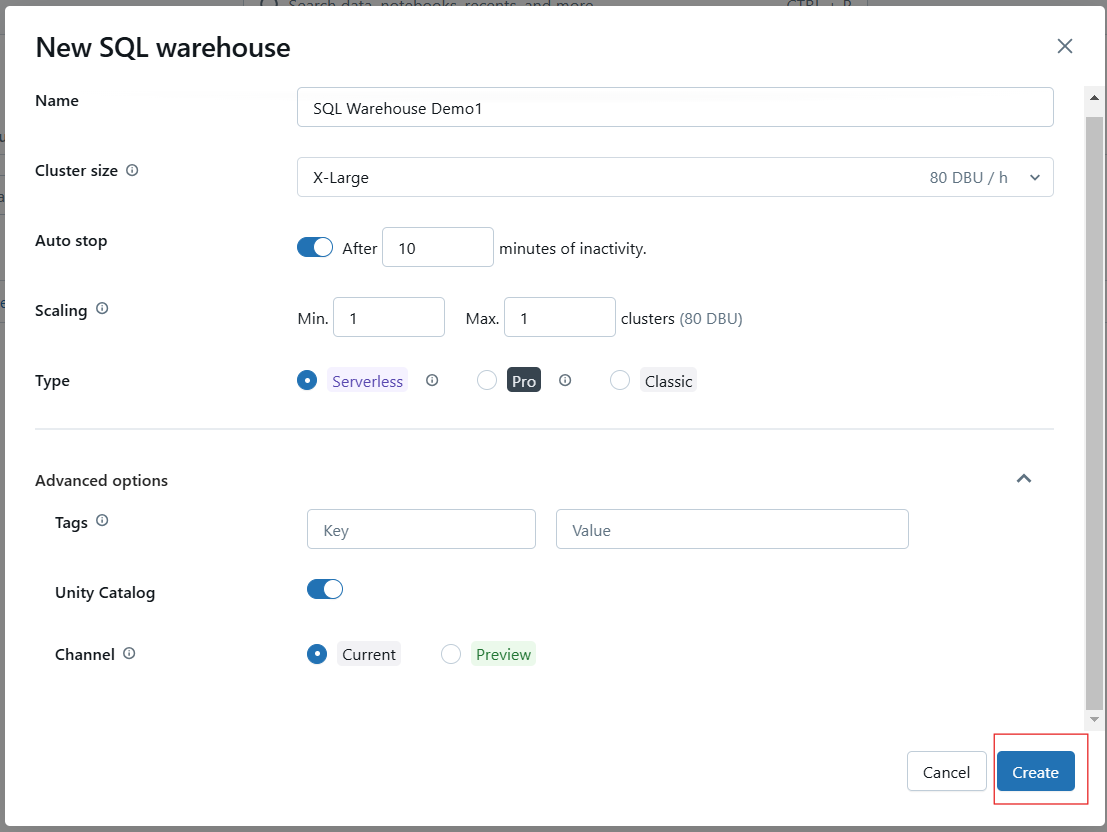

Paso 6: Guarda e inicia el almacén

Haz clic en Crear para guardar tu configuración. Una vez creado, pon en marcha el almacén para hacerlo operativo.

Creación del Almacén SQL de Databricks. Imagen del autor.

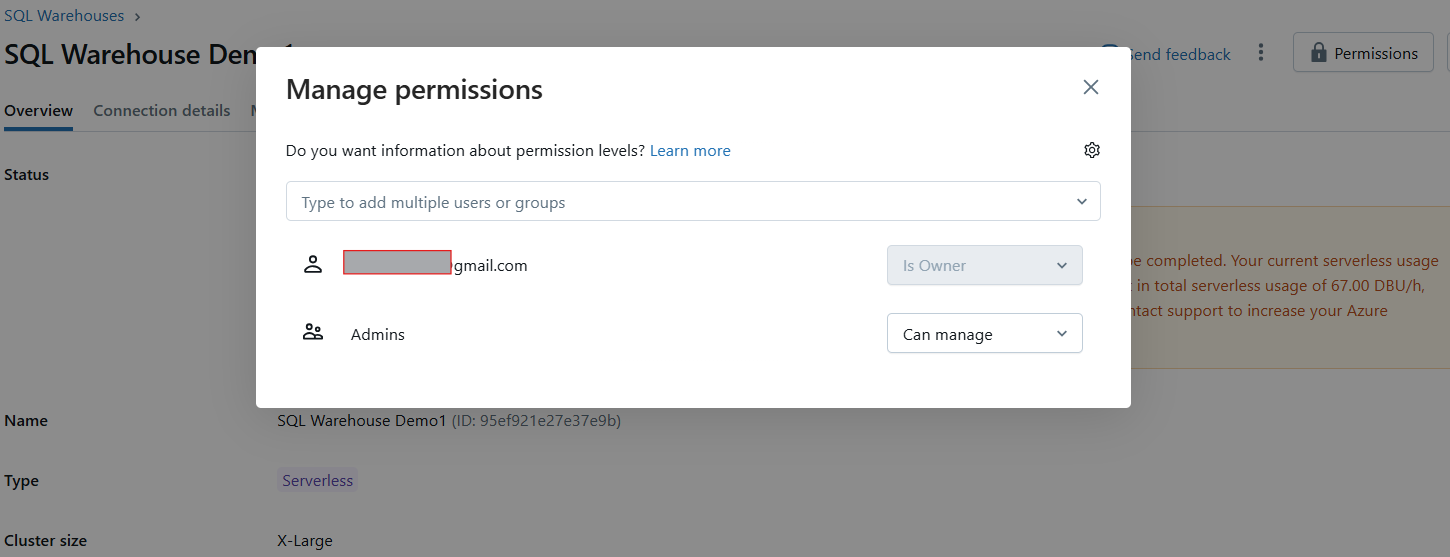

Paso 7: Establecer permisos (Opcional)

Tras la creación, aparecerá un modal de permisos donde podrás conceder a los usuarios o grupos acceso al almacén.

Gestionar los permisos del Almacén SQL de Databricks. Imagen del autor.

Una vez creado, tu almacén SQL se iniciará automáticamente, permitiéndote ejecutar consultas inmediatamente.

Ejemplo de Almacén SQL Databricks. Imagen del autor.

Utilizar un bloc de notas con un almacén SQL de Databricks

Para ejecutar consultas SQL en un bloc de notas utilizando tu almacén SQL recién creado, sigue estos pasos:

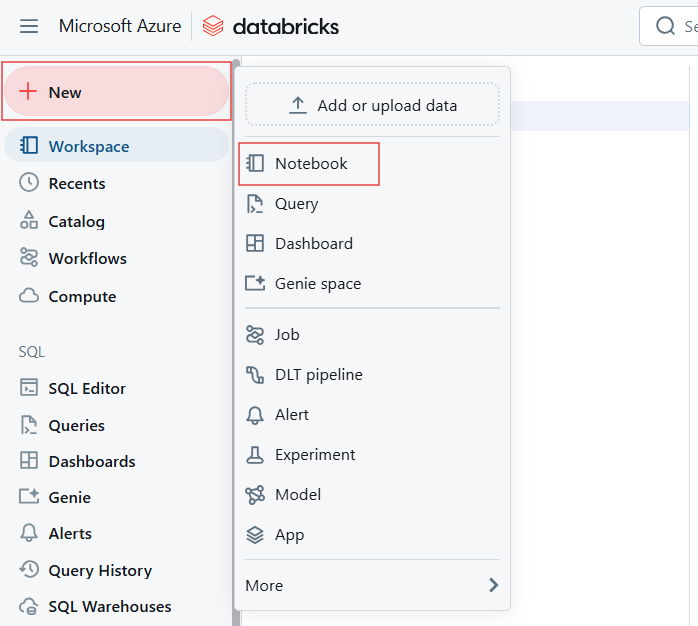

Paso 1: Abrir o crear un bloc de notas

En el espacio de trabajo de Databricks, crea una libreta nueva o abre una existente.

Crear un nuevo Cuaderno para crear Databricks SQL Warehouse. Imagen del autor.

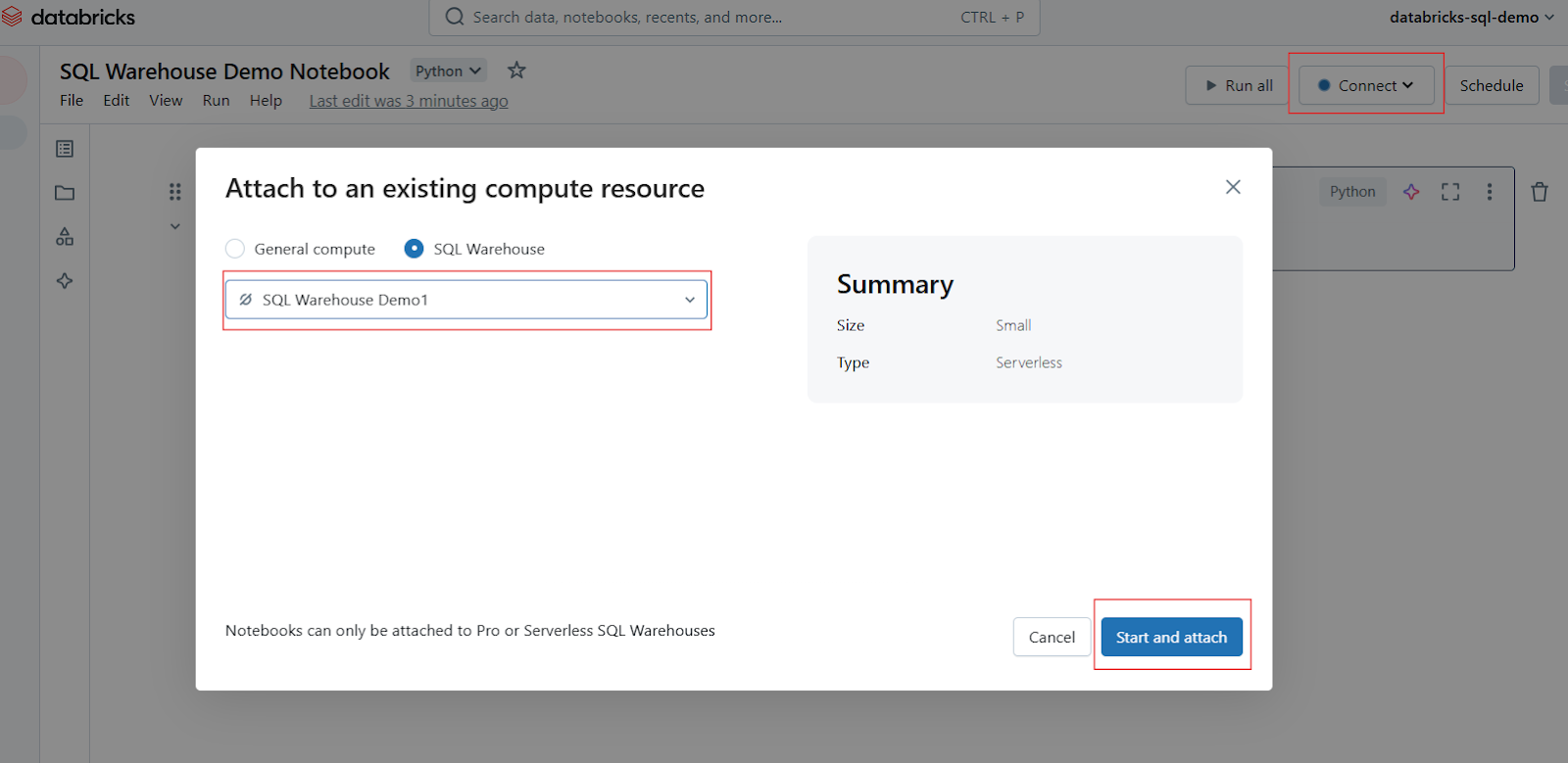

Paso 2: Adjuntar el Almacén SQL

En la barra de herramientas de Libreta, localiza el selector de cálculo o conexión (normalmente aparece en la parte superior). Haz clic en él para abrir un menú desplegable que muestra los recursos informáticos disponibles. Selecciona tu almacén SQL de la lista. Si no está visible, haz clic en Más... para ver todos los almacenes disponibles. Haz clic en el almacén SQL deseado y, a continuación, selecciona Iniciar y adjuntar.

Adjuntar Cuaderno en el Almacén SQL de Databricks. Imagen del autor.

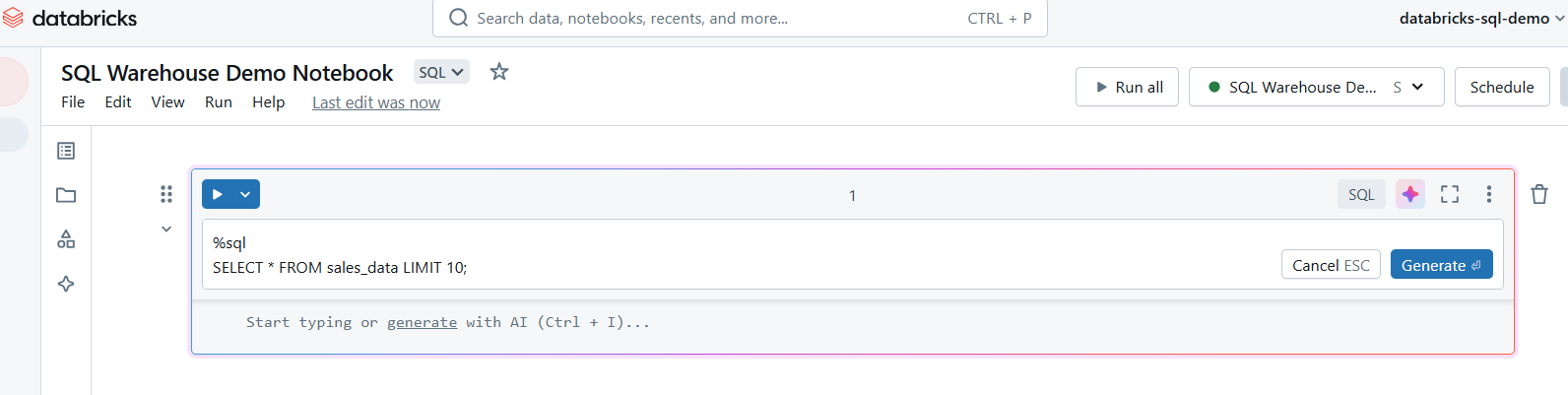

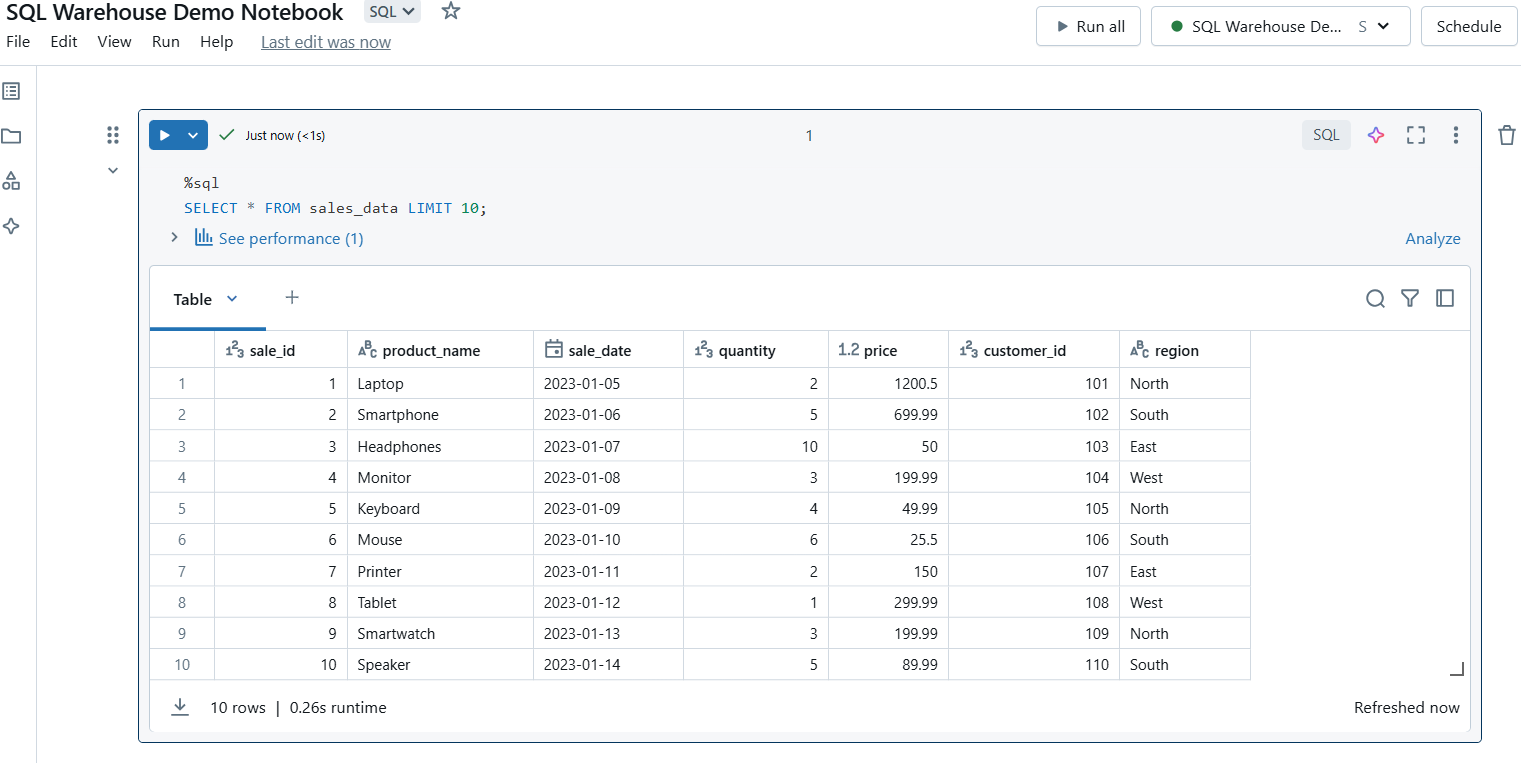

Paso 3: Escribe consultas SQL

Una vez conectado, puedes crear celdas en tu bloc de notas para consultas SQL. Utiliza el comando %sql magic para ejecutar consultas SQL en el bloc de notas.

Escribe consultas SQL en el Almacén SQL de Databricks. Imagen del autor.

Paso 4: Ejecuta las consultas

Ejecuta la celda para ejecutar tu consulta. Los resultados se mostrarán directamente debajo de la celda, facilitando la previsualización de los datos.

Ejecuta consultas SQL en el Almacén SQL de Databricks. Imagen del autor.

Consideraciones para utilizar un Cuaderno con un Almacén SQL

A continuación se exponen algunas consideraciones a tener en cuenta al utilizar cuadernos con Almacenes SQL:

-

Límites de consulta: Los Almacenes SQL están optimizados para consultas analíticas, no para consultas transaccionales frecuentes y de baja latencia.

-

Vista previa de los datos: Para conjuntos de datos grandes, considera la posibilidad de limitar los resultados de tu consulta, por ejemplo utilizando la cláusula

LIMITpara evitar cuellos de botella en el rendimiento. -

Caché de consultas: Aprovecha la caché de resultados para acelerar las consultas repetidas.

-

Uso de recursos: Supervisa la utilización del Almacén SQL para asegurarte de que el tamaño del clúster y los ajustes de escalado satisfacen tus necesidades de carga de trabajo.

Conclusión

Databricks SQL es una potente plataforma que tiende un puente entre los lagos de datos y los almacenes de datos, proporcionando una solución unificada para la analítica moderna de datos y la inteligencia empresarial. Tanto si estás creando cuadros de mando, optimizando consultas o supervisando datos con alertas, Databricks SQL ofrece la flexibilidad y el rendimiento necesarios para afrontar los retos actuales de los datos. Te animo a explorar las funciones y capacidades de Databricks SQL para mejorar tus flujos de trabajo de datos, potenciar la colaboración e impulsar una toma de decisiones más inteligente y rápida.

Si estás interesado en convertirte en un ingeniero de datos profesional, te recomiendo encarecidamente que sigas el curso de DatacMap Comprender la Ingeniería de Datos para aprender cómo los ingenieros de datos almacenan y procesan los datos para facilitar la colaboración con los científicos de datos. También te recomiendo que sigas nuestro curso Toma de Decisiones Basada en Datos en SQL para aprender a utilizar SQL como apoyo a la toma de decisiones mediante proyectos del mundo real. Además, por supuesto, no olvides echar un vistazo a nuestro gran surtido de cursos sobre la nube.

Preguntas frecuentes sobre SQL de Databricks

¿Qué es Databricks SQL y en qué se diferencia de las bases de datos SQL tradicionales?

Databricks SQL es una herramienta de análisis sin servidor diseñada para la plataforma Databricks Lakehouse, que combina la escalabilidad de los lagos de datos con el rendimiento de los almacenes de datos.

¿Cómo puedo optimizar el rendimiento en Databricks SQL?

Utiliza el motor Photon para una ejecución más rápida de las consultas, activa el almacenamiento en caché de los resultados de las consultas y configura el autoescalado en los Almacenes SQL para gestionar las cargas de trabajo de forma eficiente.

¿Se puede integrar Databricks SQL con las herramientas de BI existentes, como Power BI y Tableau?

Sí, Databricks SQL se integra a la perfección con las herramientas de BI más conocidas, lo que permite visualizar los datos en tiempo real y mejorar la colaboración entre equipos.

¿Cuáles son los distintos tipos de almacenes SQL en Databricks SQL, y cómo elijo el adecuado?

Los Almacenes SQL vienen en opciones Clásica, Pro y Sin Servidor. Elige en función de las necesidades de la carga de trabajo: Clásico para consultas básicas, Pro para casos de uso avanzados, y Sin Servidor para simplicidad y escalabilidad.

¿Cómo gestiona Databricks SQL el gobierno y la seguridad de los datos?

Databricks SQL admite controles de acceso de grano fino de seguridad a nivel de fila y columna, y se integra con proveedores de identidad para una gobernanza sólida.