programa

Los modelos de lenguaje grandes (LLM) han revolucionado la forma en que interactuamos con la IA, pero todavía están en gran medida limitados a las interfaces de chat. Pedirle a una IA que analice tus últimos datos de ventas en BigQuery o que compruebe el estado del clúster en GKE suele requerir escribir código de enlace para cada herramienta, cada modelo y cada flujo de trabajo.

Entra en los servidores MCP gestionados por Google: la solución empresarial que conecta los agentes de IA con la potente infraestructura de Google Cloud, como BigQuery, Google Maps, Compute Engine (GCE) y Kubernetes Engine (GKE), sin necesidad de conectores personalizados.

Basados en el estándar abierto Model Context Protocol (MCP) de Anthropic, estos servidores remotos totalmente gestionados proporcionan un acceso seguro y estandarizado, lo que permite a cualquier cliente compatible con MCP (como Gemini CLI o Claude Desktop) convertir la IA en un operador proactivo.

En esta guía, te mostraré la arquitectura práctica de MCP y el portafolio de servidores de Google, y te explicaré los pasos exactos para implementar un servidor MCP listo para producción. Tanto si basas la IA en datos empresariales como si automatizas tareas de DevOps, estarás listo y en funcionamiento en cuestión de minutos.

¿Eres nuevo en Google Cloud? Recomiendo empezar con el curso gratuito Introducción a GCP, que trata temas como la facturación, los proyectos y los servicios básicos.

¿Qué es el Protocolo de Contexto Modelo?

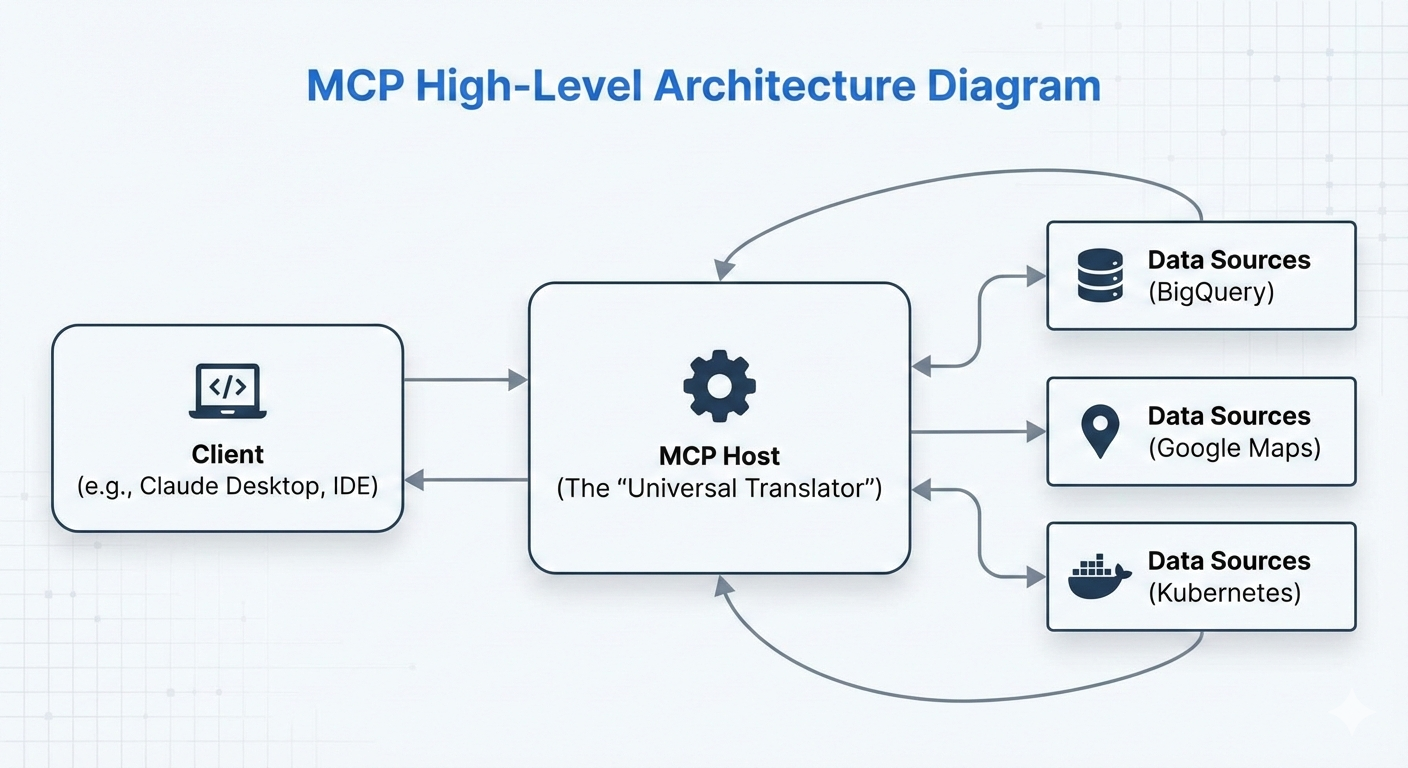

El Protocolo de contexto del modelo (MCP) es un estándar de código abierto introducido por Anthropic en noviembre de 2024. Actúa como una interfaz universal, a menudo descrita como el «USB-C para la IA», que estandariza la forma en que los modelos y agentes de IA se conectan a fuentes de datos, herramientas y sistemas externos.

Antes de MCP, integrar un agente de IA con herramientas como bases de datos, API o servicios en la nube requería crear conectores personalizados para cada modelo de IA (por ejemplo, código independiente para Claude, Gemini o GPT). Esto provocó una explosión de integraciones fragmentadas.

MCP resuelve este problema definiendo un protocolo único y coherente: los programadores implementan una herramienta o fuente de datos una sola vez como servidor MCP, y cualquier cliente de IA compatible con MCP (como Claude Desktop, Gemini CLI o agentes personalizados) puede descubrirlo y utilizarlo sin problemas.

La ventaja principal es la interoperabilidad y la reducción de la duplicación de datos. Escribe un servidor MCP para BigQuery una vez y funcionará en todos los modelos de IA compatibles sin necesidad de adaptadores adicionales. Esto acelera el desarrollo de sistemas de IA agentica, en los que los agentes no solo responden a consultas, sino que también razonan activamente, consultan datos y ejecutan acciones en el mundo real.

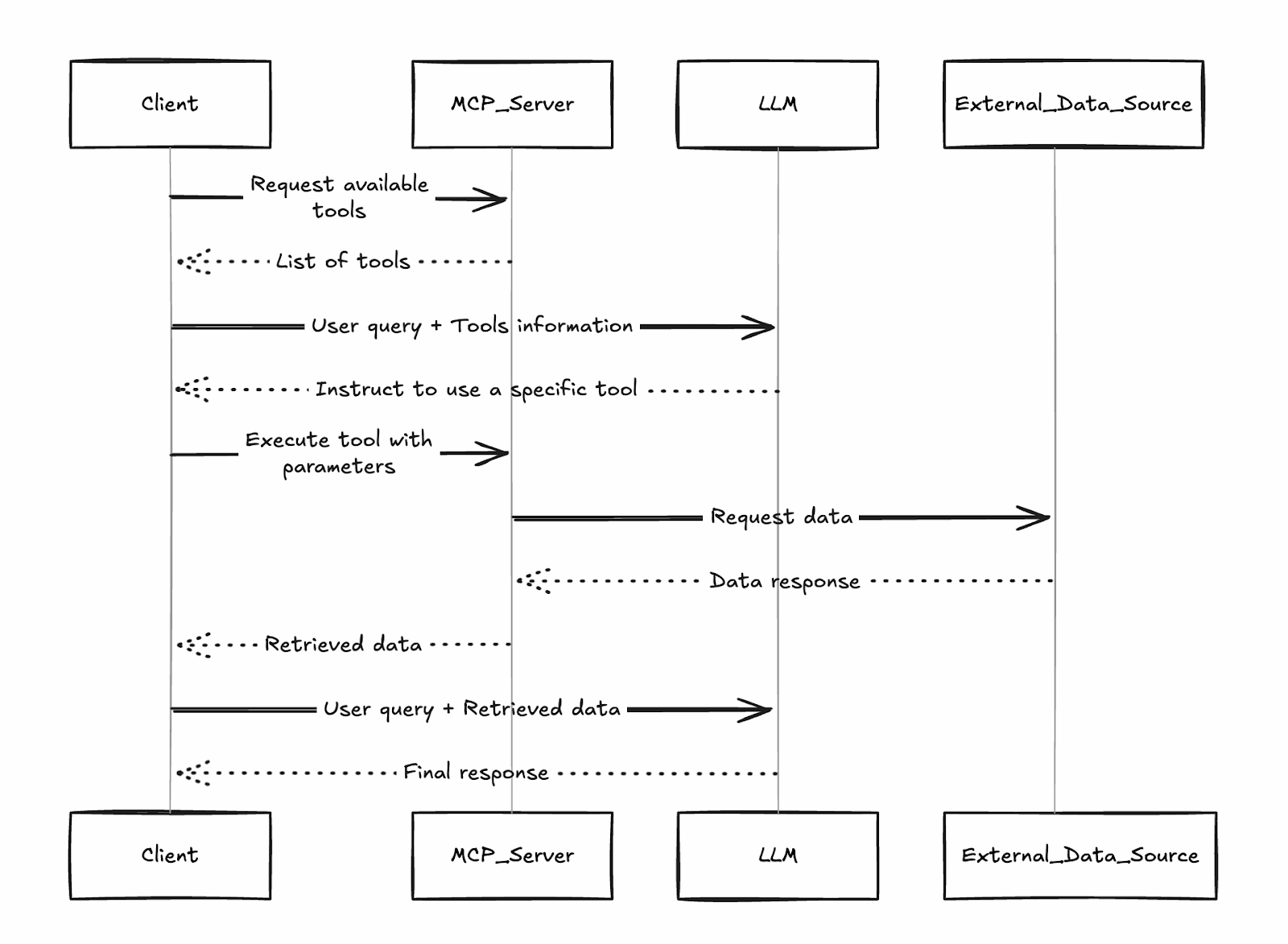

El cliente descubre las herramientas disponibles en los servidores conectados, el LLM decide cuáles llamar y los resultados vuelven para un razonamiento posterior, todo ello estandarizado a través del protocolo basado en JSON-RPC de MCP.

El diseño de este «traductor universal» es la razón por la que Google (y otros) han adoptado rápidamente MCP: sus servidores gestionados se integran directamente en este ecosistema, lo que hace que los servicios de Google en la nube sean accesibles al instante para cualquier cliente de MCP.

¿Qué es un servidor MCP de Google?

Los servidores MCP de Google son implementaciones remotas y totalmente gestionadas por Google del Protocolo de contexto de modelo (MCP). Lanzados en diciembre de 2025, estos servidores de nivel empresarial ofrecen potentes servicios de Google Cloud, empezando por BigQuery, Google Maps, GCE y GKE, como herramientas estandarizadas y fáciles de encontrar que cualquier cliente de IA compatible con MCP puede utilizar al instante.

A diferencia de los servidores MCP comunitarios o de código abierto, que requieren autoalojamiento, mantenimiento, escalabilidad y refuerzo de la seguridad personalizado, los servidores gestionados de Google se ejecutan en la infraestructura de Google. Ofrecen:

- Sin gastos generales de implementación: Solo tienes que habilitar el servicio en tu proyecto y dirigir a tu cliente al punto final oficial (por ejemplo, https://bigquery.googleapis.com/mcp).

- Fiabilidad empresarial: Alta disponibilidad, escalado automático y puntos finales globales.

- Seguridad integrada: Autenticación basada en IAM, Model Armor (el firewall LLM de Google para la protección contra inyección de comandos y exfiltración), registro de auditoría y controles de privilegios mínimos.

- Gobernanza: Habilitación/deshabilitación centralizada por proyecto u organización.

Esta tecnología permite flujos de trabajo agenticos. En lugar de limitarse a explicar cómo funciona una consulta SQL, la IA puede ejecutar la consulta en BigQuery, analizar los resultados y sugerir el siguiente paso a seguir.

Aunque estos agentes pueden actuar de forma autónoma, la implementación de Google admite configuraciones «human-in-the-loop», lo que garantiza que un humano pueda revisar y aprobar los cambios críticos en la infraestructura antes de que se produzcan.

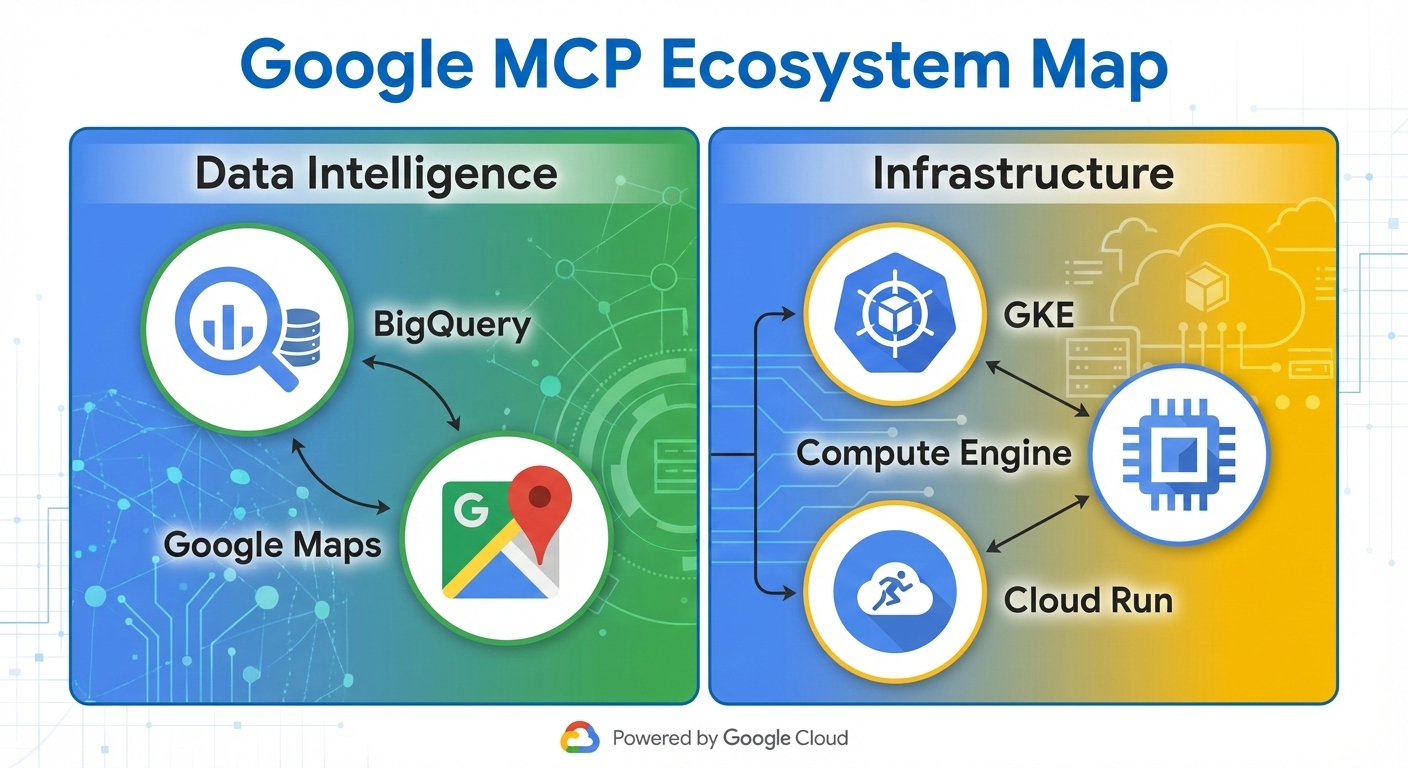

Portafolio de servidores MCP de Google

Google ofrece un conjunto cada vez mayor de servidores MCP totalmente gestionados que ponen a disposición de los agentes de IA servicios clave en la nube de forma instantánea. Estos servidores se clasifican por función, lo que permite a los agentes gestionar todo, desde el análisis de datos hasta la gestión de la infraestructura, sin necesidad de código personalizado.

El ecosistema agrupa los servidores en dos categorías principales:

- Inteligencia de datos: Centrado en la consulta, el análisis y el fundamento en datos del mundo real.

- Operaciones de infraestructura: Permite el control y la supervisión de los recursos informáticos.

Servidores de inteligencia de datos

Los servidores MCP de BigQuery y Maps ofrecen interesantes oportunidades para incluir datos en tu flujo de trabajo.

BigQuery

El servidor MCP de BigQuery permite a los agentes:

- Ejecuta consultas SQL directamente en conjuntos de datos.

- Enumera los conjuntos de datos y tablas disponibles.

- Recuperar metadatos del esquema y datos de muestra

- Ejecuta trabajos analíticos, incluida la inferencia de ML a través de BigQuery ML.

Esto permite a los agentes realizar análisis de datos complejos, generar informes o pronosticar tendencias de forma autónoma.

Google Maps

El servidor MCP de Google Maps funciona con Grounding Lite y la API de Places, y es compatible con:

- Geocodificación y geocodificación inversa

- Búsqueda de lugares y recuperación de detalles

- Cálculo de rutas e indicaciones

- Cálculos de matrices de distancia

Caso de uso: Inteligencia empresarial en tiempo real y optimización logística. Un agente puede consultar datos de ventas en BigQuery, cruzar información con Maps para obtener datos geográficos y recomendar optimizaciones de rutas de entrega, todo ello en un único ciclo de razonamiento.

Servidores de operaciones de infraestructura

En cuanto a la infraestructura, puedes utilizar servidores MCP de Kubernetes Engine (GKE) y Compute Engine (GCE) de Google Cloud Platform (GCP).

Google Kubernetes Engine

El servidor MCP de GKE expone operaciones como:

- Listado de clústeres, nodos y pods

- Comprobación del estado del clúster y la utilización de recursos

- Registros de lectura y eventos

- Ampliación de implementaciones (con los permisos IAM adecuados)

Motor de cómputo de Google

El servidor GCE MCP permite:

- Listado, inicio, detención y reinicio de instancias de VM

- Listar discos o tipos de máquinas

- Consultar metadatos y estado de la instancia

Caso de uso: Solución automatizada de problemas y «ChatOps» para equipos de DevOps. Un agente puede detectar un fallo en un pod mediante las herramientas de GKE, correlacionarlo con las métricas de VM de GCE e iniciar los pasos de corrección, lo que reduce el tiempo medio de resolución de horas a minutos.

Google continúa ampliando este portafolio (con servicios como Cloud Storage y AlloyDB en fase de prueba a principios de 2026), lo que hace que Google Cloud sea más accesible de forma nativa para los agentes.

Arquitectura central del servidor MCP de Google

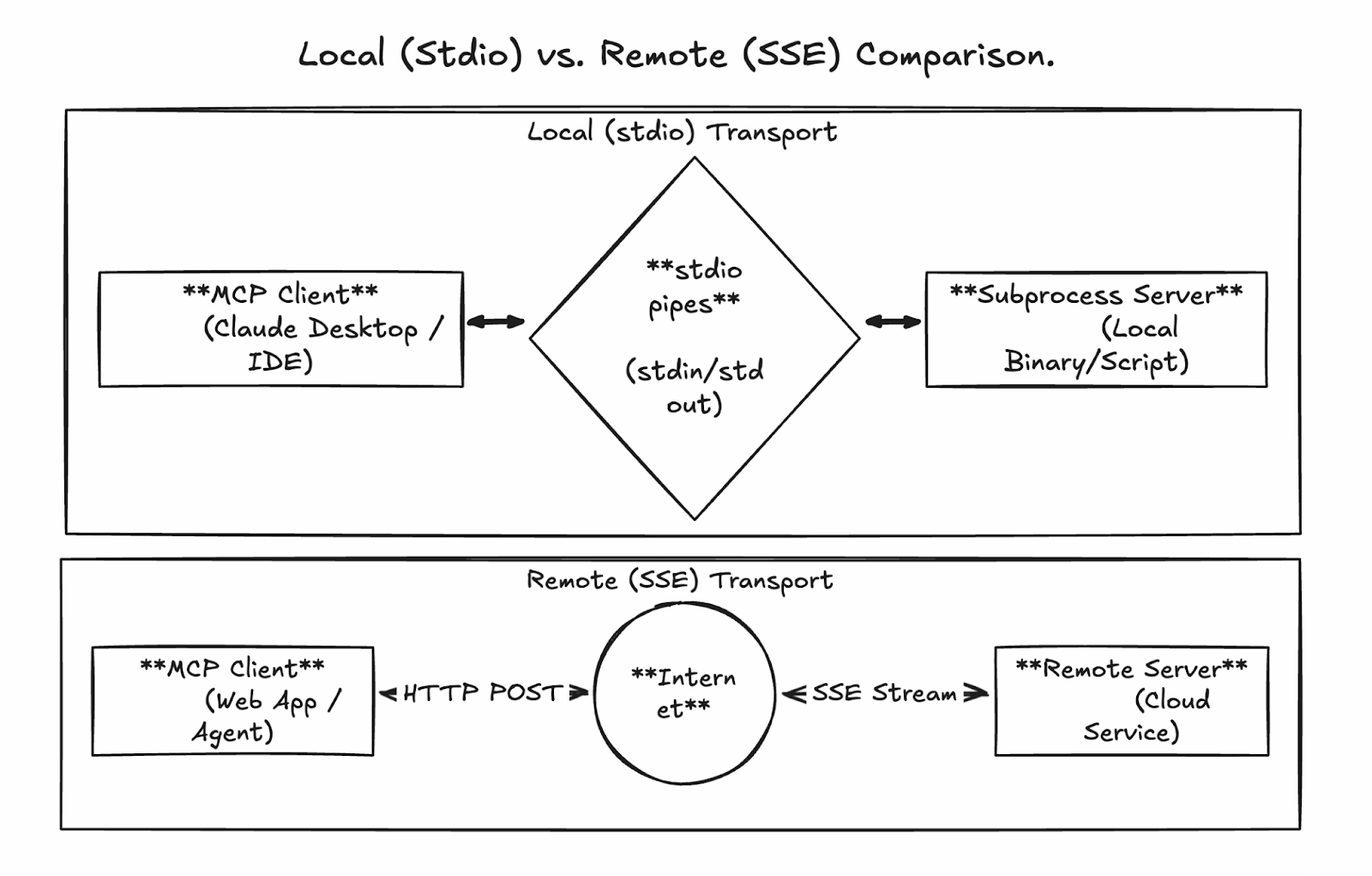

La potencia de MCP reside en sus capas de comunicación flexibles y estandarizadas, que permiten conexiones fluidas tanto si estás creando prototipos a nivel local como si estás ejecutando agentes listos para la producción a gran escala. Los servidores MCP gestionados por Google utilizan principalmente HTTP remoto transmisible para implementaciones empresariales, mientras que el desarrollo local aprovecha stdio.

Comunicación local a través de stdio

El transporte ESI ( stdio, entrada/salida estándar) es la forma más sencilla de ejecutar un servidor MCP. Aquí, el cliente MCP (por ejemplo, Claude Desktop o un agente personalizado) inicia el servidor como un subproceso en la misma máquina, comunicándose a través de canales directos y sin necesidad de red.

Ventajas:

- Configuración extremadamente sencilla para el desarrollo y las pruebas.

- Seguridad inherente (sin puertos expuestos ni superficie de ataque de red)

- Baja latencia

Contras:

- No se puede compartir entre equipos o máquinas.

- Escalabilidad limitada (vinculada al host del cliente)

- Sin concurrencia integrada para múltiples sesiones.

Este modo es perfecto para experimentar con servidores MCP personalizados o probar conexiones antes de conectarte de forma remota.

Comunicación remota a través de HTTP transmisible

Para uso empresarial y de producción, los servidores gestionados de Google (y los personalizados autohospedados) utilizan HTTP transmisible a través de un único punto final persistente. Esto sustituye el anterior enfoque de eventos enviados por el servidor (SSE) por un diseño más robusto que admite:

- Solicitudes HTTP POST para todas las interacciones

- Transmisión bidireccional opcional para respuestas grandes o incrementales (por ejemplo, transmisión de resultados de BigQuery).

- ID de sesión para conversaciones con estado

- Conexiones simultáneas para llamadas paralelas multitarea

Los puntos finales gestionados por Google siguen un patrón coherente, por ejemplo:

- BigQuery: https://bigquery.googleapis.com/mcp

- Mapas: https://mapstools.googleapis.com/mcp

- Calcular: https://compute.googleapis.com/mcp

Todo el tráfico está protegido con tokens de identificación de Google (OAuth2), lo que garantiza que las llamadas se autentiquen y autoricen a través de IAM.

Así es como podría verse un flujo de secuencia:

-

El cliente envía la detección/solicitud de herramientas mediante POST a

/mcp. -

El servidor valida la identidad y la redirige al servicio backend.

-

El backend se ejecuta (por ejemplo, ejecuta SQL en BigQuery).

-

Las respuestas se envían en bloques (formato JSON-RPC) para gestionar de forma eficiente salidas de gran tamaño.

Introducción a Google MCP Server

Una de las mayores ventajas de los servidores MCP de Google es lo poco que hay que configurar en comparación con las alternativas autohospedadas. A medida que avancemos en los pasos, distinguiremos claramente entre servidores gestionados y servidores personalizados.

- Servidores MCP de Google gestionados: Son para servicios como BigQuery, Maps, GCE y GKE, y están totalmente alojados por Google. No es necesario implementar nada: solo tienes que habilitar los puntos finales en tu proyecto, conceder permisos de IAM y configurar tu cliente. Están listos para usar nada más sacarlos de la caja.

- Servidores MCP personalizados: Para herramientas internas, API de terceros o extensiones avanzadas, creas e implementas tu propio servidor (por ejemplo, utilizando MCP Toolbox de Google). Normalmente se implementan en Cloud Run para garantizar la escalabilidad.

Configuración delentorno de nube Googlepara servidores gestionados

Sigue estos pasos (basados en el tutorial oficial) para habilitar y preparar los servidores MCP gestionados.

Requisitos previos

-

Un proyecto de Google Cloud con facturación habilitada.

-

Acceso a Google Cloud Console y Cloud Terminal (o CLI local de

gcloud) -

Tu cuenta de usuario se autentica a través de

gcloud auth login

Configuración del proyecto y habilitación de la API

- Crea o selecciona un proyecto en Google Cloud Console.

- Activa la facturación si aún no lo has hecho.

- Habilita las API de servicios principales (en Cloud Shell o en la terminal local):

gcloud auth list # Verify you're logged in

gcloud config list project # Check current project

gcloud config set project YOUR_PROJECT_ID # If needed

gcloud services enable bigquery.googleapis.com \

compute.googleapis.com \

container.googleapis.com \

mapstools.googleapis.comTen en cuenta que Maps MCP requiere su propia clave API para la facturación y la cuota. Crea uno con el siguiente comando:

gcloud alpha services api-keys create --display-name="Maps-MCP-Key"Copia el código de activación que se muestra ( keyString): lo necesitarás para configurar el cliente.

Habilitar servidores MCP administrados (beta)

Los servicios MCP requieren una habilitación beta explícita:

export PROJECT_ID=$(gcloud config get-value project)

export USER_EMAIL=$(gcloud config get-value account)

gcloud beta services mcp enable bigquery.googleapis.com --project=$PROJECT_ID

gcloud beta services mcp enable mapstools.googleapis.com --project=$PROJECT_ID

gcloud beta services mcp enable compute.googleapis.com --project=$PROJECT_ID

gcloud beta services mcp enable container.googleapis.com --project=$PROJECT_IDConfiguración de IAM

Asigna un rol de usuario a la herramienta MCP en tu cuenta:

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="user:$USER_EMAIL" \

--role="roles/mcp.toolUser"Añade roles específicos del servicio para un acceso con privilegios mínimos, por ejemplo:

-

BigQuery:

roles/bigquery.jobUseryroles/bigquery.dataViewer -

Compute/GKE:

roles/compute.vieweroroles/container.viewer

¡Los servidores gestionados ya están listos! Puntos finales:

- BigQuery: https://bigquery.googleapis.com/mcp

- Mapas: https://mapstools.googleapis.com/mcp

- Computación (GCE y GKE): https://compute.googleapis.com/mcp

Implementación de servidores MCP remotos personalizados en Cloud Run

Para herramientas personalizadas que no forman parte del portafolio gestionado por Google, crea tu propio servidor MCP utilizando bibliotecas como FastMCP (Python) e impleméntalo en Cloud Run para obtener escalabilidad y poder compartirlo con tu equipo. No entraremos en demasiados detalles aquí, pero ofreceremos una visión general del proceso.

Pasos generales:

-

Crea un proyecto Python y añade FastMCP como dependencia (utilizando herramientas como

uv). -

Implementa tu código de servidor (por ejemplo,

server.py) definiendo herramientas personalizadas, utilizandotransport="streamable-http". -

Escribe un archivo Dockerfile ligero (basado en

python:slim) para instalar las dependencias y ejecutar el servidor en$PORT. -

Habilita las API necesarias (Cloud Run, Artifact Registry, Cloud Build).

-

Implementa directamente desde el origen o crea/envía un contenedor.

-

Asegura el servicio: Requiere autenticación IAM (

--no-allow-unauthenticated), concederoles/run.invokera los principales autorizados y utiliza tokens de identidad para las conexiones de los clientes.

gcloud run deploy your-mcp-server \

--source . \

--region=us-central1 \

--no-allow-unauthenticatedEste proceso dura menos de 10 minutos para servidores sencillos y proporciona un alojamiento de nivel profesional con escalabilidad automática.

Configuración e integración del cliente del servidor MCP de Google

Un servidor MCP implementado (o habilitado) se vuelve realmente potente cuando se conecta a un cliente de IA. En esta sección se explica cómo configurar clientes populares para utilizar los servidores MCP gestionados por Google y cómo crear agentes programáticos.

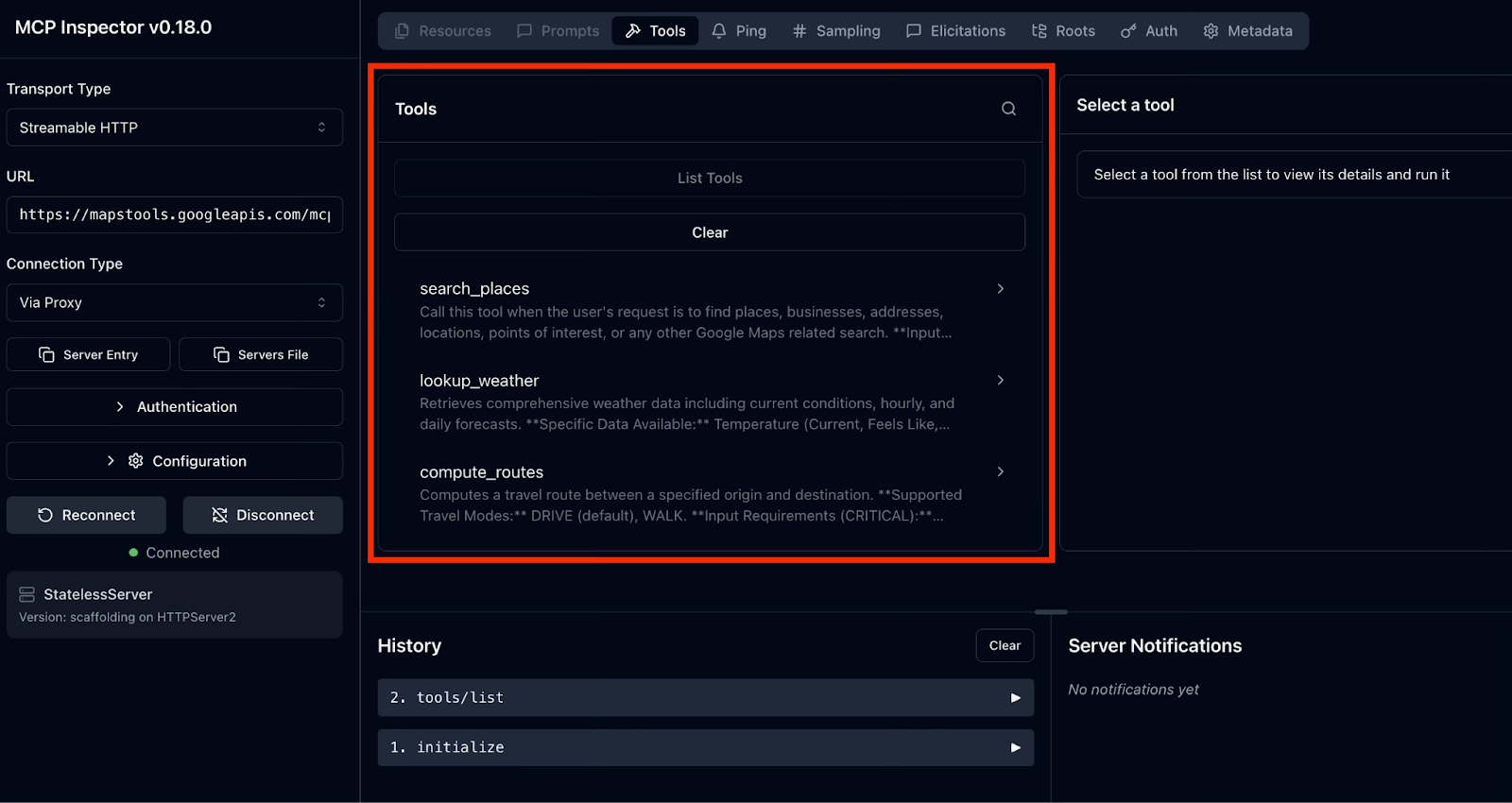

Pruebas con MCP Inspector

El Inspector MCP proporciona una interfaz de usuario web limpia para explorar cualquier servidor MCP, incluidos los gestionados por Google. Es especialmente útil para solucionar problemas de autenticación, descubrir nombres/parámetros exactos de herramientas y ver respuestas reales.

El proceso es el siguiente:

- Iniciar el Inspector

- Conéctate a un servidor MCP gestionado por Google.

- Explora y prueba herramientas

Para iniciar el Inspector, ejecuta este comando en tu terminal:

npx @modelcontextprotocol/inspectorEsto inicia un servidor web local y abre la interfaz de usuario del Inspector en tu navegador predeterminado.

A continuación, nos conectamos a un servidor MCP de Google. Comencemos con Google Maps como ejemplo.

En la interfaz de usuario del Inspector, en la parte izquierda, vamos a configurar el Inspector MCP para conectarse a tu servidor MCP de Google Maps. Sigue las instrucciones e introduce los valores específicos:

-

Tipo de transporte: Seleccionar HTTP transmisible

-

URL: Entra en https://mapstools.googleapis.com/mcp

-

Tipo de conexión: Selecciona «A través de proxy» (esto gestiona la autenticación de Google de forma segura utilizando tus credenciales de gcloud iniciadas).

-

Encabezados personalizados: Añadir un encabezado

-

Clave:

X-Goog-Api-Key -

Valor: Tu clave API de Maps (el

keyStringde la configuración anterior).

-

-

Haz clic en Conectar.

Si todo va bien, deberías ver que MCP Inspector se conecta correctamente al servidor. En el panel derecho, podrás obtener las herramientas compatibles con el servidor MCP de Google Maps haciendo clic en« » (Herramientas de listas).

Exploremos y probemos las herramientas:

- Selecciona cualquier herramienta para ver su esquema JSON completo: descripción, parámetros (con tipos y campos obligatorios) y ejemplos.

- Rellena los parámetros (por ejemplo, consulta: «el mejor café en Pune, Maharashtra») y haz clic en Invocar.

- Los resultados reales aparecen al instante, transmitidos en fragmentos para respuestas grandes.

Para los servidores BigQuery y Compute, el proceso es idéntico, pero más sencillo, ya que no se necesita ningún encabezado de clave API. La autenticación fluye automáticamente a través del proxy.

Configuración de Gemini CLI

Gemini CLI es el agente de terminal oficial de código abierto de Google con una profunda integración nativa para servidores MCP. Es la forma más sencilla de empezar a crear flujos de trabajo agenticos.

Configuración de la CLI de Gemini

Instala la CLI de Gemini con el siguiente comando:

npm install -g @google/gemini-cli@latestAñadir servidores y probar la conexión

Usaremos Maps como ejemplo nuevamente. Para añadir el servidor MCP de Google Maps, utiliza el siguiente comando y recuerda sustituir YOUR_MAPS_API_KEY por la clave API de Maps que hemos creado anteriormente.

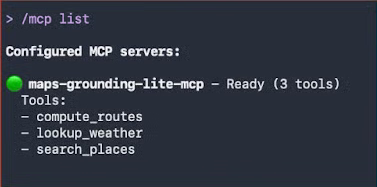

gemini mcp add -s user -t http -H 'X-Goog-Api-Key: YOUR_MAPS_API_KEY' maps-grounding-lite-mcp https://mapstools.googleapis.com/mcpEn una nueva sesión de Gemini, verifica la conexión con el comando /mcp list.

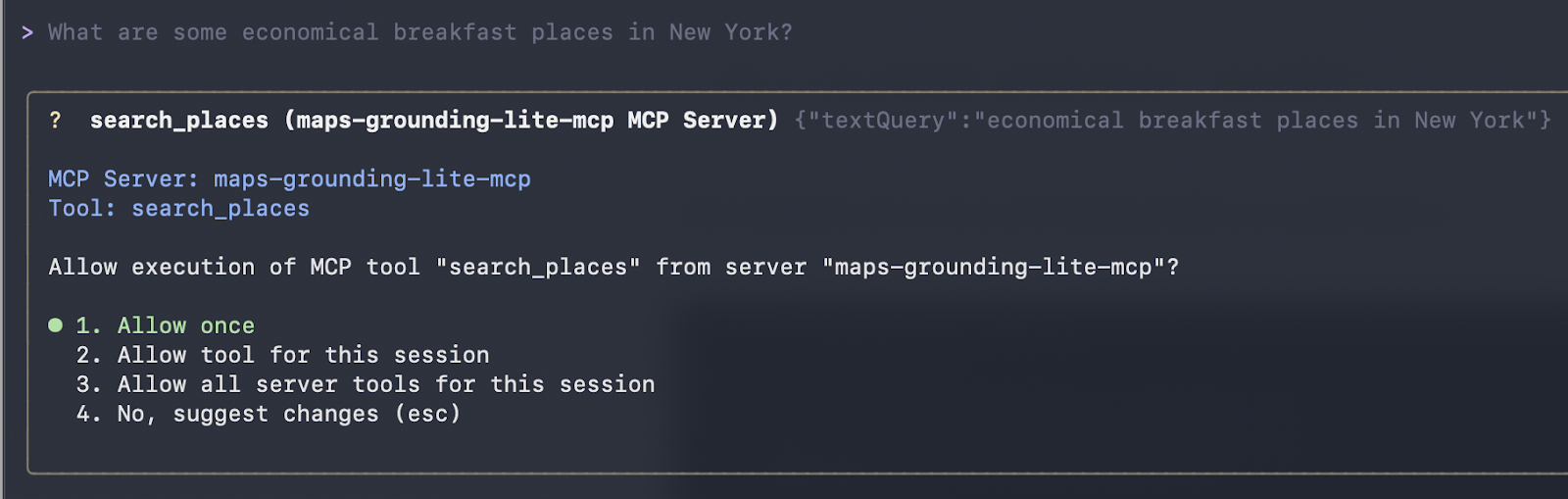

En nuestra primera interacción, hacemos una pregunta sencilla en lenguaje natural:

¿Cuáles son algunos lugares económicos para desayunar en Nueva York?

Gemini selecciona automáticamente las herramientas de Mapas. Una vez que aceptas su ejecución, los llama y devuelve los resultados formateados.

¡Funcionó! Recibimos la siguiente respuesta:

Here are some economical breakfast places in New York:

Good Morning Breakfast is a breakfast restaurant located at 1216 Broadway, New York, NY 10001. It is open from 6:00 AM to 12:00 PM on weekdays and 6:30 AM to 12:30 PM on Saturdays. They serve breakfast and lunch and have vegetarian options. The price range is $1-$10.

Andrews NYC Diner is a diner located at 463 7th Ave, New York, NY 10018. They are open from 6:00 AM to 10:00 PM on weekdays, 6:00 AM to 11:00 PM on Fridays and Saturdays, and 7:00 AM to 11:00 PM on Sundays.

They serve breakfast, lunch, and dinner, and have outdoor seating and a children's menu.

The price range is $10-$20.

George's is an American restaurant located at 89 Greenwich St, New York, NY 10006. They are open from 7:00 AM to 6:00 PM daily. They serve breakfast, lunch, and dinner, and have outdoor seating and a children's menu. The price range is $10-$20.

New York Luncheonette is an American restaurant located at 135 E 50th St, New York, NY 10022. They are open from 7:00 AM to 10:00 PM daily. They serve breakfast, lunch, and dinner, and have a children's menu.

The price range is $10-$20.El clásico momento «Hola, mundo» en Gemini CLI: limpieza de la lista de herramientas tras añadir servidores, seguida de consultas en lenguaje natural que activan llamadas reales a la herramienta Maps.

Uso de Gemini CLI con el servidor MCP de Google Maps

Para poner a prueba habilidades de razonamiento más avanzadas en combinación con los datos de Maps, estamos pasando la siguiente indicación:

Planifica una ruta en coche desde Bombay a Goa con una parada panorámica para almorzar a mitad de camino. Sugiere un buen restaurante allí.

Cuando envías esta indicación, el agente de IA (Gemini o Claude) realiza un sofisticado ciclo de razonamiento de varios pasos utilizando únicamente las herramientas MCP de Google Maps:

-

Cálculo de la ruta completa: El agente llama a

compute_routescon origen «Mumbai» y destino «Goa». El resultado es una distancia de unos 566 km con una duración de unas 11 horas y 41 minutos (teniendo en cuenta el tráfico). -

Razonamiento sobre el punto medio: El agente calcula que la mitad del trayecto (entre 280 y 300 km) transcurre por la región de Konkan, concretamente cerca de Chiplun, famosa por sus vistas al río, sus ghats y su belleza paisajística.

-

Buscando restaurantes con vistas panorámicas: Utiliza

search_placescon búsquedas orientadas hacia Chiplun/Ratnagiri, filtrando por valoraciones altas, vistas al aire libre/paisajes y disponibilidad de almuerzo. -

Seleccionar y describir la mejor opción: Por último, elige un lugar destacado (en tu caso, el restaurante The Riverview en Chiplun) y destaca su terraza al aire libre y su ambiente relajante.

Esta respuesta se genera en tiempo real. La duración de la ruta proviene directamente de la llamada a la herramienta compute_routes que viste en la salida de depuración, y la recomendación del restaurante se basa en datos reales de la API de Places: sin datos codificados, sin alucinaciones, solo un uso seguro y actualizado de la herramienta.

Así es como la CLI de Gemini llama a la herramienta y muestra su recomendación:

compute_routes (maps-grounding-lite-mcp MCP Server) {"destination": {"address": "Goa"}, "origin": {"address": "Mumbai" }}

{

"routes": [

{

"distanceMeters": 566414,

"duration": "42095s"

}

]

}

* A great place to stop for a scenic lunch on your drive from Mumbai to Goa is Chiplun, which is roughly halfway. I recommend The Riverview Restaurant in Chiplun. It offers outdoor seating and is a great spot to relax and enjoy a meal with a view.

The drive from Mumbai to Goa is approximately 566 km and will take about 11 hours and 40 minutes without stops. Enjoy your tripIntegración programática con LangChain o LangGraph

Más allá de clientes interactivos como Gemini CLI o Claude Desktop, el verdadero poder de los servidores MCP gestionados por Google se pone de manifiesto cuando creas agentes de IA personalizados y listos para su uso en producción mediante código. El ecosistema de código abierto LangChain lo hace muy sencillo con el paquete langchain-mcp-adapters, que convierte cualquier servidor MCP remoto en herramientas LangChain estándar.

Este enfoque te ofrece una visibilidad completa del descubrimiento, la autenticación y la invocación de herramientas: perfecto para depurar, crear enrutadores de herramientas personalizados o integrarse en flujos de trabajo asíncronos existentes.

Uso de LangChain para conectarse al servidor MCP de BigQuery

Para que lo entiendas mejor, veamos un ejemplo. El siguiente script completo y ejecutable muestra cómo:

-

Autentícate en la nube de Google con las credenciales predeterminadas de la aplicación.

-

Conéctate al punto final MCP de BigQuery gestionado a través de HTTP transmisible.

-

Descubre todas las herramientas disponibles

-

Invoca una herramienta específica (

list_dataset_ids) e imprime resultados reales.

import asyncio

import google.auth

import google.auth.transport.requests

import httpx

from mcp import ClientSession

from mcp.client.streamable_http import streamable_http_client

from langchain_mcp_adapters.tools import load_mcp_tools

async def list_and_invoke_bigquery():

# 1. Authenticate with Google Cloud (run: gcloud auth application-default login)

credentials, project_id = google.auth.default(

scopes=["https://www.googleapis.com/auth/cloud-platform"]

)

auth_request = google.auth.transport.requests.Request()

credentials.refresh(auth_request)

url = "https://bigquery.googleapis.com/mcp"

print(f"Connecting to: {url}...")

# 2. Setup authenticated HTTP client

async with httpx.AsyncClient(headers={

"Authorization": f"Bearer {credentials.token}",

"x-goog-user-project": project_id,

"Content-Type": "application/json"

}) as http_client:

# 3. Establish streamable HTTP transport and MCP session

async with streamable_http_client(url, http_client=http_client) as (read, write, _):

async with ClientSession(read, write) as session:

await session.initialize()

# 4. Discover all tools exposed by Google's BigQuery MCP server

tools = await load_mcp_tools(session)

print(f"\n--- DISCOVERY: Found {len(tools)} tools ---")

for tool in tools:

print(f"Tool: {tool.name}")

# 5. Invoke a specific tool: list_dataset_ids

print(f"\n--- INVOCATION: Fetching datasets for project '{project_id}' ---")

dataset_tool = next((t for t in tools if t.name == "list_dataset_ids"), None)

if dataset_tool:

try:

result = await dataset_tool.ainvoke({"project_id": project_id})

print("SUCCESS! Datasets in your project:")

print(result)

except Exception as e:

print(f"Error invoking tool: {e}")

else:

print("Tool 'list_dataset_ids' not found.")

if __name__ == "__main__":

asyncio.run(list_and_invoke_bigquery())Cuando se ejecuta en un proyecto GCP correctamente configurado, este script genera un resultado similar al siguiente:

Connecting to: https://bigquery.googleapis.com/mcp…

--- DISCOVERY: Found 5 tools ---

Tool: list_dataset_ids

Tool: get_dataset_info

Tool: list_table_ids

Tool: get_table_info

Tool: execute_sql

--- INVOCATION: Fetching datasets for ‘project’ ---

SUCCESS! Output from BigQuery: (...)Esto confirma:

- Autenticación segura a través de ADC

- Conexión establecida correctamente con el servidor remoto gestionado de Google.

- Detección completa de herramientas

- Ejecución en vivo que devuelve tus conjuntos de datos reales de BigQuery.

Este patrón de bajo nivel resulta muy valioso cuando:

- Depuración de problemas de conexión o permisos

- Creación de una lógica de selección de herramientas personalizada

- Integración de MCP en servicios FastAPI, trabajadores en segundo plano o aplicaciones de streaming

- Necesidad de un control preciso sobre los flujos asíncronos

Una vez que hayas verificado la conectividad de esta manera, puedes ampliar con confianza a marcos de trabajo de nivel superior, como los agentes LangGraph (como se muestra en los ejemplos anteriores), o incorporar estas herramientas en cualquier sistema compatible con LangChain.

Con esta base, los servidores MCP de Google se convierten en una extensión segura y lista para producción de tu pila de IA de Python, sin necesidad de código personalizado.

Prácticas recomendadas de seguridad para Google MCP Server

La seguridad no es una cuestión secundaria con los servidores MCP gestionados por Google. En cambio, está integrado desde el principio. Al funcionar con la infraestructura de Google y estar profundamente integrados con la gestión de identidades y accesos de Google Cloud, estos servidores proporcionan protecciones de nivel empresarial que superan con creces a las de las alternativas autohospedadas o experimentales.

Gestión de identidades y accesos

Google Cloud utiliza su sólido marco IAM (gestión de identidades y accesos) para controlar quién (o qué) puede llamar a tus herramientas MCP.

En el control de acceso basado en roles (RBAC), cada agente de IA debe tener su propia cuenta de servicio dedicada. Este control se basa en dos niveles distintos de autorización:

-

Función de puerta de enlace: Para utilizar cualquier herramienta de Google MCP, la identidad debe tener la función

roles/mcp.toolUser. -

Permisos específicos del servicio: Dado que

mcp.toolUsersolo permite la conexión, aún debes conceder permisos específicos para la acción. Por ejemplo, si la IA necesita consultar datos, necesitaroles/bigquery.jobUser. Por el contrario, si solo necesitas ver el estado de la máquina virtual, debes asignarleroles/compute.viewer, noroles/compute.admin.

Modelo Armor

Model Armor es un servicio de Google Cloud diseñado para mejorar la seguridad y protección de tus aplicaciones de IA. Funciona mediante el análisis proactivo de las indicaciones y respuestas del LLM, protegiendo contra diversos riesgos y garantizando prácticas responsables de IA.

Tanto si implementas IA en Google Cloud como en otros proveedores de servicios en la nube, Model Armor puede ayudarte a prevenir entradas maliciosas, verificar la seguridad del contenido, proteger los datos confidenciales, mantener el cumplimiento normativo y aplicar tus políticas de seguridad y protección de IA de forma coherente en todas tus aplicaciones de IA.

Model Armor actúa como un firewall de aplicaciones web (WAF) especializado para IA:

- Desinfección inmediata: Filtra cada solicitud entrante en busca de ataques de inyección y intentos de jailbreak antes de que la solicitud llegue a tu servidor MCP.

- Seguridad del contenido: Filtra el contenido perjudicial y se puede configurar con plantillas de protección de datos confidenciales (SDP) para ocultar la información de identificación personal (nombres, números de la seguridad social, números de tarjetas de crédito) tanto en las solicitudes como en los resultados de la herramienta.

- Configuración del piso: Google recomienda un «nivel mínimo de seguridad» específico para MCP, que incluye el análisis obligatorio de URL maliciosas y patrones de inyección rápida.

Observabilidad y cumplimiento normativo

Cada llamada a una herramienta realizada a través de un servidor MCP de Google es un evento documentado.

- Registro en la nube: Las acciones de MCP se envían automáticamente a Cloud Logging. Esto incluye el ID del agente, el ID de la sesión, la herramienta específica utilizada y la carga útil.

- Registros de auditoría: Al habilitar los registros de acceso a datos para el servicio mcp.googleapis.com, puedes mantener un registro permanente para las revisiones de cumplimiento, lo que te permite responder a las siguientes preguntas: ¿Quién (qué agente) accedió a qué datos y cuándo?

Conclusión

Se acabaron los frágiles conectores personalizados para cada modelo o herramienta: Los servidores MCP gestionados por Google marcan un punto de inflexión para la IA agencial en la nube de Google. Al adoptar el estándar abierto MCP y ofrecer implementaciones totalmente alojadas y de nivel empresarial para BigQuery, Google Maps, Compute Engine y GKE, Google ha eliminado las mayores barreras para crear agentes fiables y capaces de actuar.

Como hemos visto en esta guía, esta arquitectura estandarizada elimina la pesadilla del «código pegamento» y te permite pasar de prototipos locales a implementaciones de Cloud Run sin tener que reescribir herramientas para cada cliente. Además, con Google Cloud IAM y Model Armor, tus agentes están protegidos de forma nativa contra las amenazas modernas de la IA.

La evolución de «chatbot» a «agente» está teniendo lugar en este momento. Al dominar los servidores MCP de Google, no solo estás creando una IA que responde preguntas, sino que estás creando un compañero de equipo digital capaz de operar tu nube a la velocidad del pensamiento.

¿Estás listo para convertir todo lo que has aprendido en esta guía en experiencia profesional? Inscríbete en nuestro ingeniero asociado de IA para programadores.

Preguntas frecuentes sobre los servidores MCP de Google

¿Puedes utilizar los servidores MCP de Google con modelos de lenguaje grande (LLM) distintos de Gemini (por ejemplo, Claude, GPT o modelos de código abierto)?

Sí. Dado que MCP es un estándar abierto, cualquier cliente compatible con MCP funciona. Claude Desktop, Cursor, Windsurf y marcos como LangGraph/LangChain son compatibles con servidores MCP remotos, lo que te permite acceder a herramientas independientes del modelo.

¿Cuáles son las principales ventajas de utilizar MCP en entornos empresariales?

MCP actúa como un «traductor universal», lo que permite a las empresas crear una herramienta una sola vez y utilizarla en múltiples modelos de IA sin necesidad de código personalizado. Proporciona una forma estandarizada, escalable y segura de dar a los agentes de IA acceso en tiempo real a infraestructuras sensibles como BigQuery o GKE, al tiempo que se mantiene el control centralizado.

¿Cuál es la diferencia entre un servidor MCP «gestionado» y uno «personalizado»?

Gestionado: Google aloja el código, se encarga del escalado y gestiona la seguridad. Solo tienes que habilitarlo (como BigQuery o Maps). Personalizado: Escribes el código (utilizando Python/TypeScript), lo empaquetas en un contenedor Docker y lo implementas tú mismo en una plataforma como Cloud Run.

¿Puedo alojar tu propio servidor MCP en la nube de Google?

Sí. Para herramientas internas o de terceros que no estén incluidas en el portafolio gestionado de Google, puedes crear un servidor personalizado utilizando el SDK de MCP Python o TypeScript e implementarlo en Cloud Run. Esto les da a tus agentes acceso a tus API y bases de datos privadas.

¿En qué se diferencia MCP de la llamada a funciones estándar?

La llamada a funciones suele estar vinculada a la API de un proveedor de LLM específico (por ejemplo, herramientas específicas de OpenAI). MCP es un protocolo universal; se crea la herramienta una vez como servidor MCP y puede ser utilizada por cualquier LLM (Claude, Gemini, GPT) que admita el estándar MCP, sin necesidad de reescribir el código para cada uno.

Escribo y creo en Internet. Experto desarrollador de Google para Google Workspace, licenciado en Informática por la NMIMS y apasionado creador en el ámbito de la automatización y la IA generativa.