programa

Para muchas personas, los modelos de lenguaje grandes (LLM) se utilizan principalmente como interfaces conversacionales. Tú haces una pregunta, el modelo responde y ahí termina la interacción.

Sin embargo, los LLM son capaces de hacer mucho más: se están integrando en sistemas que pueden planificar, recordar y actuar de forma autónoma, lo que da lugar a lo que se conoce como agentes LLM. Los sistemas agénticos están ganando popularidad en los flujos de trabajo empresariales y analíticos modernos.

Al final de este artículo, comprenderás qué son los agentes LLM, cómo se crean, los diferentes tipos de agentes y dónde pueden generar valor.

Para aprovechar al máximo la información de este artículo, combínalo con el Fundamentos de IA programa para refrescar tus conocimientos sobre IA y LLM.

¿Qué es un agente LLM?

Hablemos de las diferencias entre los agentes LLM y los modelos lingüísticos estándar.

Tu interfaz LLM habitual, como un chatbot, solo puede recibir indicaciones y devolver respuestas generadas basadas en su entrenamiento, sin acciones externas ni estado. Por el contrario, un agente LLM utiliza un LLM como motor de razonamiento central (como un cerebro) y lo rodea de componentes de apoyo que te permiten razonar, planificar y ejecutar.

Los agentes LLM cambian el enfoque de la automatización a la autonomía.

La automatización permite a los LLM tomar entradas y seguir una serie de pasos para generar una salida. Con la autonomía, le estamos proporcionando al LLM un conjunto de herramientas y la capacidad de decidir cuál es la mejor manera de llegar a una solución basándose en lo que sabe sobre la situación. Esto proporciona más flexibilidad y complejidad para que el LLM actúe «de forma independiente».

Piensa en un LLM sencillo como un consultor experto que responde preguntas basándose en sus conocimientos. Un agente LLM es como ese experto que lidera un equipo: decide qué preguntas hacer, a qué miembros del equipo (herramientas) consultar y cómo combinar sus respuestas para obtener una solución.

Componentes básicos de un agente LLM

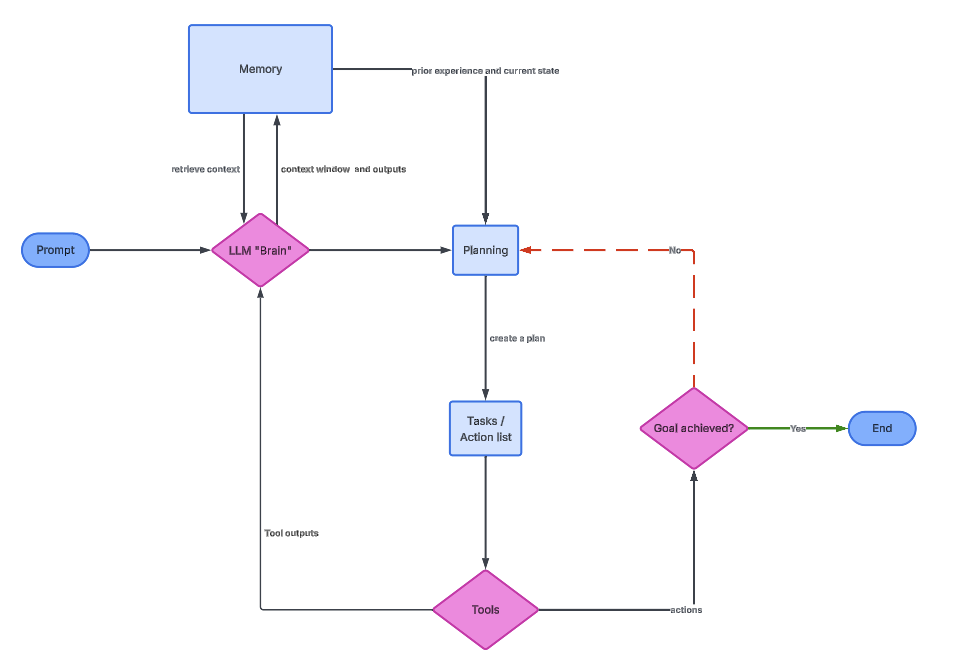

Un agente LLM consta de varios componentes básicos:

- El LLM en sí mismo (el cerebro)

- Lógica de planificación

- Memoria

- Herramientas

El siguiente gráfico muestra la relación entre cada uno de ellos.

El cerebro LLM

El LLM sirve como núcleo cognitivo del agente. Interpreta el objetivo del usuario, razona sobre los pasos intermedios y decide qué acciones tomar. En la práctica, el LLM se invoca repetidamente, no solo una vez.

Cada vez que se invoca el LLM, este recibe un contexto que puede incluir el objetivo original, acciones previas, resultados de herramientas y memoria relevante. Basándose en esta información, decide la siguiente acción. Esto hace que la función LLM se parezca más a un controlador que a un generador de texto estático.

Para los profesionales de los datos, es importante comprender que el LLM no ejecuta directamente código ni consultas. Genera instrucciones estructuradas que otros componentes interpretan. La calidad de un agente suele depender de lo bien que se definan y validen estas instrucciones.

Lógica de planificación

La lógica de planificación es el mecanismo que permite a los agentes resolver problemas complejos dividiéndolos en pasos manejables. Sin planificación, un agente intentaría resolver todo en una sola respuesta, lo que a menudo conduce a errores o alucinaciones.

En una fase de planificación, el agente descompone un objetivo de alto nivel en tareas más pequeñas. Por ejemplo, «Analizar la pérdida de clientes» podría convertirse en «cargar datos de clientes», «calcular la tasa de pérdida», «identificar tendencias» y «resumir conclusiones». A continuación, cada subtarea se ejecuta de forma secuencial o condicional.

Una técnica muy popular es cadena de pensamiento (CoT), que anima al modelo a razonar de forma explícita encadenando una serie de acciones como indicaciones secuenciales.

ReAct (razonamiento y acción) va aún más allá e intercala trazas de razonamiento con acciones invocadas por herramientas y observaciones externas. Esta retroalimentación externa ayuda a los agentes a mantener los pies en la tierra y a corregirse cuando los resultados intermedios no coinciden con las expectativas.

Memoria

La memoria permite a un agente mantener la continuidad entre interacciones y acciones mediante la reutilización de información previa. Sin memoria, cada paso estaría aislado, lo que obligaría al agente a redescubrir el mismo conocimiento una y otra vez.

La memoria a corto plazo suele existir dentro de la ventana de contexto del LLM. Incluye mensajes recientes, razonamientos intermedios y resultados de herramientas. Al igual que la memoria RAM en la arquitectura informática, esta memoria es rápida pero limitada y desaparece una vez que se supera el contexto.

La memoria a largo plazo se implementa externamente, a menudo utilizando bases de datos vectoriales. Técnicas como RAG (generación aumentada por recuperación) permiten al agente recuperar documentos relevantes o interacciones pasadas e incorporarlos al contexto actual.

Herramientas

Las herramientas amplían las capacidades de un agente más allá del lenguaje. Permiten al agente interactuar con el mundo real, incluyendo bases de datos, API y motores de cálculo.

Desde la perspectiva del agente, las herramientas son funciones invocables con entradas y salidas definidas. El LLM decide cuándo utilizar una herramienta, qué argumentos proporcionar y cómo interpretar el resultado. Esta toma de decisiones es lo que diferencia a los agentes de los flujos de trabajo programados.

Las herramientas pueden incluir funciones como búsquedas en Google, ejecución de SQL, intérpretes de Python y API. El agente tiene acceso a las mismas herramientas tecnológicas que nosotros y puede combinarlas para ejecutar soluciones.

La imagen anterior muestra la arquitectura general del agente LLM. El cerebro proporciona información sobre la memoria y la planificación, lo que a su vez inicia una serie de tareas mediante el uso de herramientas.

Tipos de agentes LLM

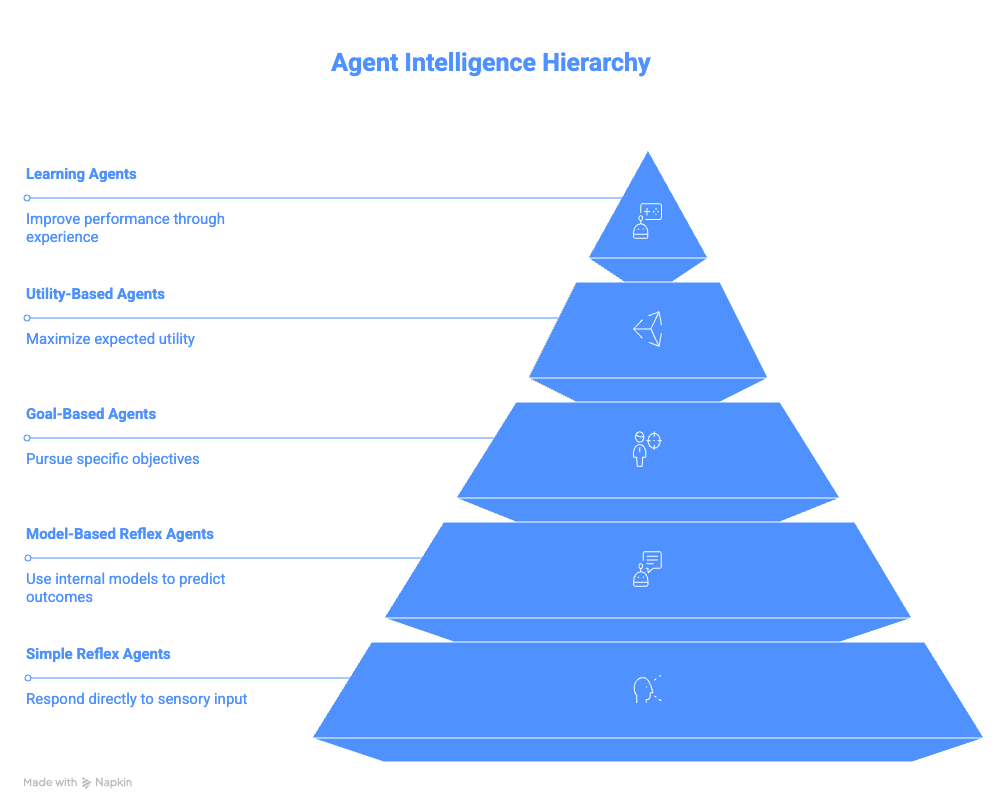

Esta sección resume las diferentes categorías de agentes, desde los agentes reflejos más básicos hasta los agentes de aprendizaje complejos.

Agentes de reflejo simple

Los agentes reflejos simples operan según reglas directas de condición-acción. No tienen en cuenta la historia, las consecuencias futuras ni las acciones alternativas. Si se cumple una condición, la acción correspondiente se ejecuta inmediatamente.

Esta simplicidad hace que sean fáciles de implementar, pero son extremadamente frágiles. Cualquier entrada inesperada o señal perdida puede provocar un comportamiento incorrecto. Tampoco pueden adaptarse a entornos cambiantes.

El ejemplo del bot para darse de baja de correos electrónicos pone de manifiesto esta limitación. Realiza su tarea rápidamente, pero carece de conciencia, lo que puede dar lugar a resultados indeseables.

Agentes reflejos basados en modelos

Los agentes reflejos basados en modelos mejoran los agentes reflejos simples al mantener una representación interna del entorno. Este modelo interno les permite razonar sobre cosas que no son inmediatamente visibles.

Al realizar un seguimiento de un estado a lo largo del tiempo, estos agentes pueden gestionar la observabilidad parcial. Recordáis lo que ya ha sucedido y utilizáis esa información para tomar decisiones sobre acciones futuras.

Los asistentes IDE como Copilot o Cursor AI son buenos ejemplos de ello. Mantienen el conocimiento de los archivos, las variables y las funciones a lo largo de una sesión, lo que permite sugerencias más inteligentes que la simple coincidencia de patrones. También sirven de puente con la siguiente categoría de agentes.

Agentes basados en objetivos

Los agentes basados en objetivos se diseñan en función de los resultados, en lugar de los desencadenantes. Planifican y evalúan las acciones en función de si acercan al sistema al objetivo deseado, en lugar de limitarse a reaccionar.

Estos agentes generan planes que pueden implicar múltiples pasos y ramificaciones condicionales. Si un enfoque falla, pueden intentar una vía alternativa. Esto los hace significativamente más flexibles que los agentes basados en reflejos.

Por ejemplo, crear un itinerario de viaje demuestra cómo un único objetivo de alto nivel puede descomponerse en múltiples acciones coordinadas entre distintos sistemas.

El agente no se limita a responder a una simple solicitud de «dame un itinerario» y a repetir información. En su lugar, podría dividir el objetivo en pequeños subproblemas, tales como:

- ¿Cómo viajamos entre ciudades?

- ¿Cuáles son los mejores restaurantes de cada ciudad?

- ¿Cómo programamos diferentes actividades juntos?

El objetivo de generar un itinerario se logra entonces combinando las soluciones de cada uno de esos problemas.

Agentes basados en la utilidad

Los agentes basados en la utilidad amplían los agentes basados en objetivos al introducir la optimización. En lugar de limitaros a alcanzar un objetivo, evaluáis diferentes resultados utilizando una «función de utilidad».

Una función de utilidad asigna puntuaciones a los resultados basándose en criterios como el coste, el tiempo, el riesgo o las preferencias del usuario. A continuación, el agente selecciona la secuencia de acciones que maximiza la utilidad global.

Este enfoque es habitual en los sistemas de recomendación y los problemas de optimización. Podría tratarse de cosas como encontrar la mejor ruta para llegar a un lugar, recomendar los productos adecuados o incluso elaborar el mejor análisis para mostrar a un usuario concreto.

Agentes de aprendizaje

Los agentes de aprendizaje están diseñados para mejorar su comportamiento con el tiempo sin necesidad de una reprogramación explícita.

Con cada iteración, un agente recibe retroalimentación y utiliza esa información para mejorar su rendimiento. Operan en entornos en los que no se conoce de antemano cuál es el comportamiento óptimo y no requieren una reprogramación explícita para cada nueva situación.

Hay dos componentes principales: un «crítico» y un «elemento de aprendizaje». El «crítico» evalúa los resultados y ofrece comentarios. El «elemento de aprendizaje» utiliza esta información para ajustar las decisiones futuras. Con el tiempo, el agente se adapta cada vez más a las preferencias de los usuarios o a las limitaciones del entorno.

Por ejemplo, imagina un agente LLM que resume las noticias diarias para ti. Podría observar tu comportamiento y adaptarse a tus preferencias. Si el agente observa que rara vez abres los resúmenes de «Deportes», pero te interesa «Comida y bebida», es posible que deje de proporcionarte resúmenes deportivos y se centre en tu interés por determinadas cocinas o restaurantes.

Resumen de los agentes LLM

La siguiente tabla resume las diferenciasentre los tipos de agentes LLM.

|

Agente |

Idea central |

Memoria |

Planificación |

Aprendizaje |

Complejidad |

Ejemplo |

|

Agente de reflejos simples |

Asigna directamente una condición a una acción. |

No |

Ninguno |

No |

Muy bajo |

Archivar automáticamente los correos electrónicos que contengan la palabra «cancelar suscripción». |

|

Agente reflexivo basado en modelos |

Mantiene un modelo interno del entorno. |

Sí (seguimiento del estado) |

Mínimo |

No |

Bajo |

El asistente IDE recuerda las variables o los archivos definidos anteriormente en una sesión. |

|

Agente basado en objetivos |

Toma medidas para alcanzar un objetivo específico. |

Sí |

Sí |

No |

Medio |

Reservar vuelos, hoteles y transporte para un viaje de negocios. |

|

Agente basado en la utilidad |

Elige el mejor resultado en función de las preferencias. |

Sí |

Sí |

No |

Medio a alto |

Agencia de viajes que optimiza el coste, la duración y la comodidad |

|

Agente de aprendizaje |

Mejora el comportamiento basándose en los comentarios recibidos a lo largo del tiempo. |

Sí |

Sí |

Sí |

Alto |

Agencia de noticias que adapta el contenido en función de los patrones de interacción de los usuarios. |

Marcos populares para crear agentes LLM

Esta sección presenta los marcos comunes utilizados para crear sistemas de agentes LLM.

LangChain

LangChain proporciona un marco modular para crear sistemas basados en LLM. La idea central es que se pueden construir flujos de trabajo complejos combinando componentes sencillos. Acepta el reto de comunicarse con diferentes LLM y abstrae ese proceso para el usuario a través de objetos Python.

El concepto clave de LangChain es el de «cadenas», que vinculan indicaciones, modelos y analizadores sintácticos en flujos de trabajo repetibles. Por ejemplo, la idea es que tomes un PromptTemplate, que se introduce en el LLM y se procesa mediante un OutputParser.

LCEL (LangChain Expression Language) proporciona una sintaxis declarativa que permite a los usuarios utilizar tuberías (|) para componer cadenas de forma visual. Así que, en lugar de los flujos de trabajo clásicos de Python, que requieren introducir explícitamente las indicaciones en el modelo, basta con escribir chain = prompt | model y dejar que LangChain se encargue de las plantillas.

Para funciones más complejas, LangChain permite a los usuarios añadir herramientas como Wikipedia, Python REPLy Google Search a sus agentes.

LangGraph se basa en la funcionalidad de LangChain y combina estos conceptos con la memoria para admitir arquitecturas de agentes con estado y aptas para la producción, con un control explícito sobre el flujo de ejecución.

Más allá de LangGraph, el ecosistema de LangChain ha crecido aún más para incluir formas de observar a los agentes más fácilmente (LangSmith) e incluso interfaces de arrastrar y soltar (LangFlow).

LlamaIndex

LlamaIndex destaca en flujos de trabajo centrados en documentos al proporcionar OCR y análisis sintáctico de alta precisión para más de 90 tipos de archivos no estructurados, combinados opcionalmente con flujos de trabajo agenticos para la recuperación y extracción inteligentes.

Tus conectores de datos simplifican la ingesta desde numerosas fuentes, mientras que tus estructuras de indexación optimizan la recuperación. El VectorStoreIndex es la opción más habitual para la búsqueda semántica.

Los motores de consulta coordinan la recuperación y la generación, mientras que los enrutadores introducen una toma de decisiones similar a la de un agente al seleccionar la fuente de datos más adecuada para una consulta determinada.

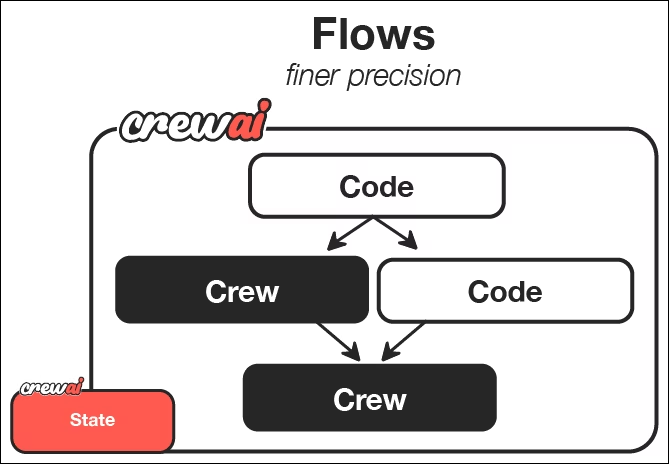

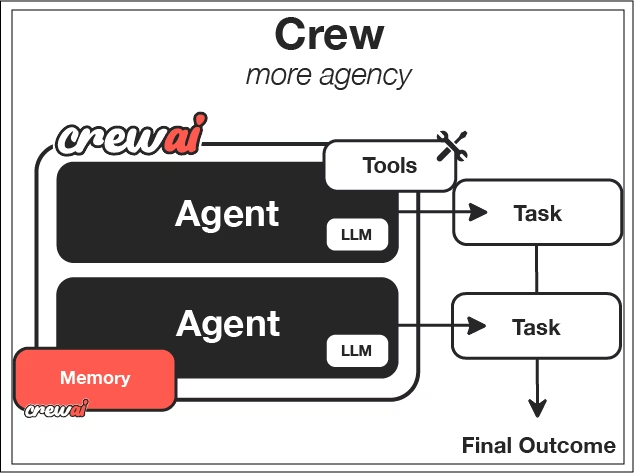

CrewAI

CrewAI está diseñado pensando en la colaboración. En lugar de un único agente, permite que varios agentes con funciones distintas trabajen juntos.

Se centra en la idea de «equipos», que son un conjunto definido de agentes. A cada agente se le asigna una personalidad, un objetivo y una historia, que determinan su comportamiento.

Las tareas definen lo que hay que hacer y cómo se mide el éxito. Tú defines cómo es una tarea individual, proporcionas algunos parámetros, el resultado esperado y qué agentes deben trabajar en esa tarea.

Los procesos determinan cómo se ejecutan las tareas: de forma secuencial, jerárquica o mediante patrones de coordinador-trabajador, en los que un agente principal descompone dinámicamente tareas complejas, imitando a los equipos humanos.

De la documentación de CrewAI, podemos ver que los flujos proporcionan una forma de coordinar y activar a los equipos. Cada equipo utiliza agentes LLM con funciones y tareas definidas para realizar trabajos específicos y crear los resultados deseados.

Elegir el marco adecuado

La elección de un marco depende del ámbito del problema y de las limitaciones. Cada uno de los marcos presentados tiene sus propias fortalezas:

- LangChain: Ofrece flexibilidad y control con la mejor visibilidad sobre cómo funciona cada herramienta.

- LlamaIndex: Destaca en flujos de trabajo centrados en documentos en los que el análisis de la información es fundamental.

- CrewAI: Brilla cuando la colaboración y la separación de funciones son importantes, y tú estás menos centrado en cómo exactamente los agentes realizan su trabajo.

Ten en cuenta la complejidad de tus datos, el nivel de autonomía requerido y las limitaciones operativas. No existe una opción universalmente correcta.

Para ayudarte en tu toma de decisiones, también puedes consultar nuestros artículos en los que se compara LangChain con Llamaindex, respectivamente, CrewAI con LangGraph.

Casos de uso del agente LLM

Los casos de uso de los agentes LLM son básicamente infinitos y solo están limitados por tu imaginación.

Asistentes de codificación

Los asistentes de codificación modernos utilizan flujos de trabajo agenticos para planificar, ejecutar y verificar los cambios. Pueden explorar un código base, generar soluciones, ejecutar pruebas y corregir errores de forma iterativa.

Por ejemplo, Cursor se integra de forma nativa en tu IDE y te ayuda a completar líneas o corregir cambios en los procesos con implicaciones posteriores. Claude Code puede ayudarte a escribir pruebas, crear scripts completos o evaluar inconsistencias en tu código en todo un repositorio. Podemos usar GitHub Copilot para ayudar a escribir solicitudes de extracción y probar código como parte de un flujo de trabajo de solicitudes.

Esto cambia el papel del programador, que pasa de escribir cada línea de código a supervisar y orientar a los sistemas inteligentes. Para los profesionales de los datos, esto puede acelerar considerablemente la experimentación y la creación de prototipos.

Te recomiendo que realices el curso curso «Desarrollo de software con GitHub Copilot» si quieres iniciarte en el uso de los asistentes de programación basados en LLM.

Inteligencia empresarial

Los sistemas de BI agenticos permiten a los usuarios formular preguntas en lenguaje natural y obtener información útil. El agente puede traducir preguntas a SQL, ejecutar consultas y explicar los resultados.

Puedes hablar con tus datos como lo harías con un miembro sénior del equipo y obtener nuevos conocimientos y visualizaciones en tiempo real. Esto reduce la dependencia de los paneles de control y permite realizar análisis exploratorios a los miembros del equipo sin conocimientos técnicos.

Documentación y síntesis de información

Los agentes de investigación automatizan la recopilación y síntesis de información. Buscan en la web, recuperan fuentes y resumen los resultados; algunos sistemas incluyen filtros básicos de calidad de las fuentes. Incluso pueden consultar documentación interna alojada en sitios web como Notion o mensajes dentro de Slack.

Con acceso a todas estas fuentes de información, los agentes LLM no solo pueden sintetizar rápidamente la información, sino también generar documentos completos y resúmenes para que los equipos compartan rápidamente la información.

Esto resulta especialmente valioso en ámbitos que evolucionan rápidamente, donde los conjuntos de datos estáticos quedan obsoletos con rapidez. Los agentes proporcionan información actualizada continuamente.

Para obtener más ideas sobre cómo se utilizan los agentes de IA, consulta nuestra guía sobre los los 10 mejores proyectos de agentes de IA.

Retos clave en los flujos de trabajo de las agencias

Aunque los flujos de trabajo con agentes son increíbles y extremadamente potentes, también plantean sus propios retos. Los agentes pueden tener alucinaciones, malinterpretar los resultados de las herramientas o entrar en bucles largos o no deseados. Las barreras de seguridad, la validación y la observabilidad son fundamentales para los sistemas de producción.

Cada acción del agente suele requerir una llamada LLM. Las tareas complejas pueden implicar docenas de llamadas, lo que aumenta la latencia y los costes de la API. Además, es posible que tengas que pagar por infraestructura adicional, como almacenamiento en la nube, computación en la nube y otros costes para dar soporte al agente LLM.

Los sistemas autónomos son más difíciles de depurar que el código determinista. Para comprender por qué un agente tomó una decisión, es necesario rastrear los pasos del estado, la memoria y el razonamiento.

Dependiendo del marco de trabajo del agente que utilices, esto puede resultar extremadamente complicado. Algunos marcos, como CrewAI, realizan una abstracción mucho más profunda debido a su mayor complejidad en comparación con marcos más sencillos como LangChain, cuyo objetivo es simplificar el acceso a los modelos de lenguaje grande (LLM).

Conclusión

Estamos pasando de chatbots aislados a flujos de trabajo totalmente autónomos que pueden razonar, planificar y actuar. Aunque aún es pronto, este paradigma ya está transformando la forma en que se construyen y utilizan los sistemas de datos.

Para los aspirantes a profesionales de los datos, aprender hoy sobre los agentes LLM supone una gran ventaja para los puestos de trabajo del futuro. Estos sistemas representan el futuro de la automatización inteligente.

Empieza a practicar y a crear estos agentes LLM con nuestro Diseño de sistemas agenticos con LangChain .

Preguntas frecuentes sobre el agente LLM

¿Los agentes LLM escriben y ejecutan código por sí mismos?

Los agentes LLM no ejecutan código por sí mismos de forma inherente. Deciden cuándo llamar a herramientas, como intérpretes de Python, motores SQL o entornos de ejecución en entornos aislados, que luego ejecutan el código y devuelven los resultados al agente.

¿Cuáles son los componentes básicos de un agente LLM?

Los componentes principales son el cerebro LLM, la lógica de planificación, la memoria y las herramientas. Estos componentes funcionan juntos en un bucle de retroalimentación para permitir un comportamiento autónomo.

¿Qué tipos de agentes LLM se utilizan más habitualmente en la actualidad?

La mayoría de los sistemas de producción utilizan agentes basados en objetivos o en utilidad, ya que equilibran la autonomía con el control. Los agentes de aprendizaje están surgiendo, pero son más difíciles de implementar de forma segura a gran escala.

¿Cuáles son los mayores retos que plantean los agentes LLM?

Entre los principales retos se encuentran problemas de fiabilidad, como alucinaciones, mayor latencia, aumento de los costes debido a múltiples llamadas a modelos, así como una mayor complejidad de depuración en comparación con el software tradicional.

¿En qué se diferencia un agente LLM de un chatbot?

Un chatbot responde a una sola pregunta y se centra en un único objetivo. Un agente LLM puede dividir un objetivo en pasos, realizar acciones utilizando herramientas, observar los resultados y adaptar su comportamiento hasta completar la tarea.

Soy un científico de datos con experiencia en análisis espacial, aprendizaje automático y canalización de datos. He trabajado con GCP, Hadoop, Hive, Snowflake, Airflow y otros procesos de ciencia/ingeniería de datos.