Lernpfad

Ich habe vor über 10 Jahren als Software-Ingenieur in der Werbebranche angefangen, mich mit Big Data zu beschäftigen. Damals begannen die Datensätze schnell zu wachsen und in ihrer Größe zu explodieren.

Das war eine große Chance, aber gleichzeitig auch eine Herausforderung.

Abfragen zur Beantwortung grundlegender, aber wichtiger Berichtsfragen dauerten plötzlich Stunden. Als Antwort darauf habe ich 2013 begonnen, spaltenorientierte Datenbanken wie BigQuery zu nutzen.

Diese cloudbasierten Datenbanken ermöglichten es uns, analytische Lasten performant und kostengünstig auszuführen und die Ressourcen bei Bedarf zu skalieren.

In den letzten Jahren habe ich ein großes Team von Dateningenieuren geleitet, das ein 10+ PB BigQuery Data Warehouse aufgebaut hat, um mit einem schnell wachsenden Katalog von Haushaltswaren und wachsenden analytischen Anforderungen Schritt zu halten.

Als CTO von DataCamp leite ich verschiedene technische und inhaltliche Teams, die dafür sorgen, dass unsere Nutzerinnen und Nutzer genau diese Fähigkeiten (und viele andere) erlernen und anwenden können. Ich bin überzeugt, dass Cloud Data Warehouses wie BigQuery viele Arbeitsabläufe viel effizienter und robuster machen können. Deshalb möchte ich in diesem Tutorial meine Erfahrungen mit dir teilen.

In diesem Leitfaden erfährst du, was BigQuery ist, wie es funktioniert und worin es sich von herkömmlichen Data Warehouses unterscheidet. Du lernst, wie du die BigQuery-Konsole verwendest, um öffentliche Datensätze von Google abzufragen, und erfährst anhand eines praktischen Beispiels, wie du Google Trends abfragst, um etwas über beliebte Themen zu erfahren.

Was ist BigQuery?

BigQuery ist ein vollständig verwaltetes Data Warehouse, das von Google entwickelt wurde und bei der Verwaltung und Analyse von Daten hilft. Die serverlose Architektur des Tools ermöglicht es Unternehmen, Einblicke in ihr Geschäft zu erhalten und Fragen schnell zu beantworten. Mit der skalierbaren und verteilten Analyse-Engine von BigQuery können Nutzer auch Petabytes an Daten mit SQL abfragen.

Zu den BigQuery-Schnittstellen gehören die Google Cloud-Konsolenschnittstelle und das BigQuery-Kommandozeilentool. Darüber hinaus bietet es Entwicklern Client-Bibliotheken für beliebte Sprachen wie C#, Go, Java, Node.js, PHP, Python und Ruby.

BigQuery bietet integrierte Funktionen für maschinelles Lernen und ermöglicht die Verwendung von extern trainierten Modellen in Google Cloud Platform (GCP) VertexAI und sogar den Import von benutzerdefinierten Modellen, die außerhalb von BigQuery trainiert wurden.

Dieses Tutorial ist für Datenanalysten, Dateningenieure und Data Warehouse-Administratoren als Einführung in BigQuery geeignet. Wenn du nach diesem Tutorial tiefer in BigQuery einsteigen möchtest, ist unser Kurs Einführung in BigQuery ein guter Startpunkt.

Werde Dateningenieur

Traditionelles vs. Cloud Data Warehouse

Ein traditionelles Data Warehouse wird vor Ort eingerichtet und erfordert in der Regel hohe Vorlaufkosten, ein qualifiziertes Team für die Verwaltung und eine angemessene Planung, um die steigende Nachfrage zu befriedigen, da die Skalierung der Ressourcen im traditionellen Rechenzentrum starr ist.

Eine Cloud-Data-Warehouse-Lösung hingegen wird von einem Cloud-Service-Anbieter verwaltet und gehostet.

Vorteile von Cloud Data Warehouses

Ein Cloud Data Warehouse hat in der Regel mehrere Vorteile gegenüber herkömmlichen Data Warehouses:

- Sie sind auf Skalierung und die Nutzung der Flexibilität der Cloud-Umgebung ausgelegt

- Sie haben Geschwindigkeit und Leistung verbessert

- Flexible Preise und eine Cloud-Umgebung ermöglichen eine Kostenoptimierung (z. B. Verkleinerung in Zeiten geringer Nachfrage)

- Sie können ganz oder teilweise verwaltet werden, was die Betriebskosten senkt.

Zeilen- vs. spaltenorientierte Datenbanken

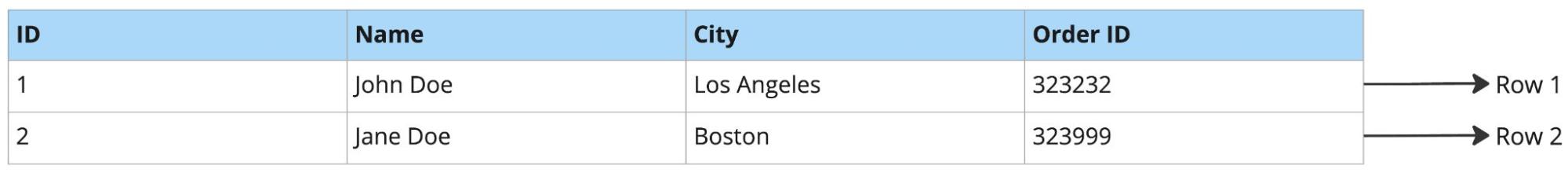

Beispiel für eine zeilenorientierte Datenbank:

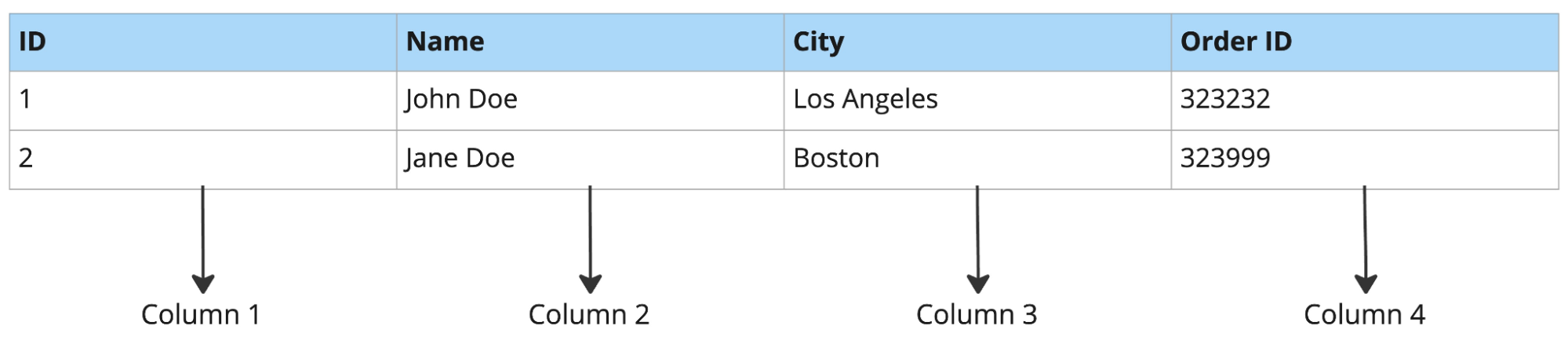

Beispiel für eine spaltenorientierte Datenbank:

Zeilenorientierte Datenbanken eignen sich gut für Arbeitslasten mit vollständigen Zeilensuchen, Einfügen neuer Datensätze und Manipulationen. Umgekehrt sind sie deshalb schlecht für analytische Arbeitslasten geeignet. Die Abfrage einiger weniger Spalten aus einer Tabelle mit Dutzenden von Spalten würde zum Beispiel dazu führen, dass eine große Menge unnötiger Daten ausgelesen wird (dies ist bei analytischen Workloads wie Produktprognosen, Ad-hoc-Analysen usw. üblich).

Zeilenorientierte Datenbanken eignen sich in der Regel gut für die Online-Transaktionsverarbeitung (OLTP) und spaltenorientierte Datenbanken für die analytische Online-Verarbeitung (OLAP).

OLTP vs OLAP

- OLTP ist eine Art von Datenbanksystem, das in transaktionsorientierten Anwendungen eingesetzt wird. "Online" bedeutet, dass von solchen Systemen erwartet wird, dass sie auf Nutzeranfragen reagieren und diese in Echtzeit bearbeiten (d.h. Transaktionen durchführen).

- Der Begriff steht im Gegensatz zum Online Analytical Processing (OLAP), das sich auf die Datenanalyse konzentriert.

Zusammenfassung des Vergleichs:

|

Zeilenorientierte Datenbank |

Spaltenorientierte Datenbank |

||||||

|

Lagerung |

Von Row |

Nach Kolumne |

|||||

|

Datenabruf |

Vollständige Aufzeichnungen |

Aufschlussreiche Spalten |

|||||

|

Typische Anwendung |

OLTP |

OLAP |

|||||

|

Schnelle Operationen |

Einfügen, Aktualisieren, Nachschlagen |

Abfragen für Berichtszwecke |

|||||

|

Daten laden |

In der Regel ein Datensatz nach dem anderen |

Typischerweise im Batch |

|||||

|

Beliebte Optionen |

Postgres, MySQL, Oracle, Microsoft SQL Server |

Snowflake, Google BigQuery, Amazon Redshift |

|||||

Wie funktioniert BigQuery?

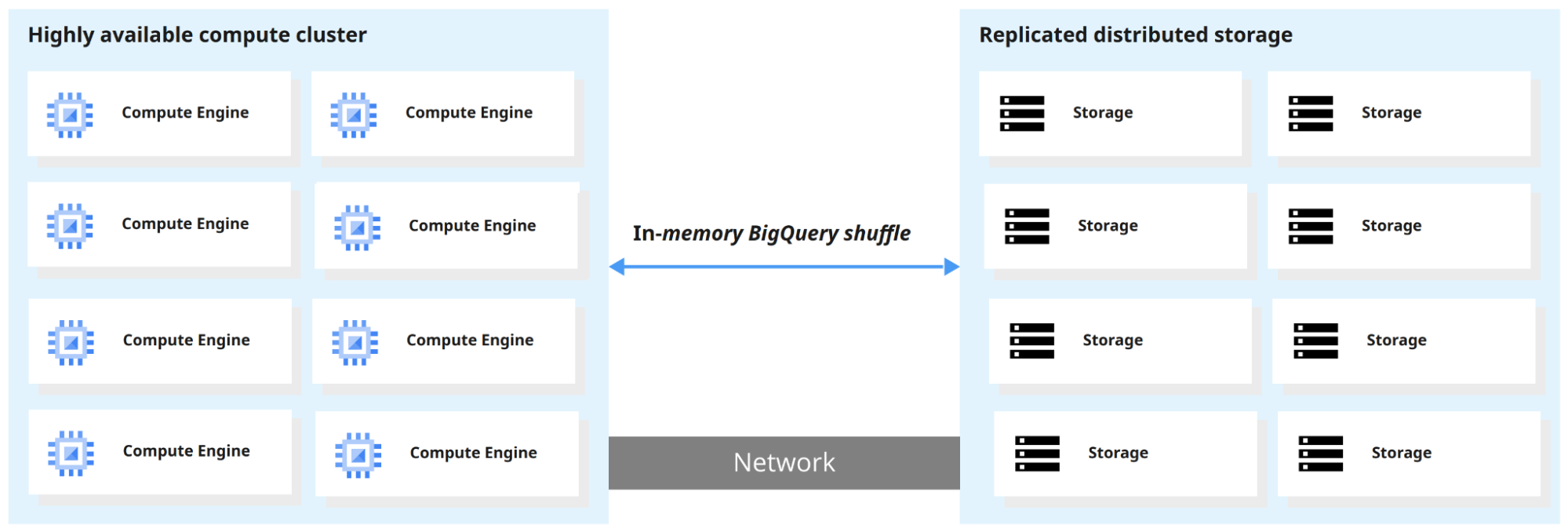

Eines der wichtigsten Merkmale von BigQuery ist die Trennung von Rechenleistung und Speicherplatz, so dass beide getrennt nach Bedarf und auf Anfrage skaliert werden können. So können Nutzerinnen und Nutzer Terabytes an Daten in Sekunden und Petabytes in Minuten abfragen.

Wenn BigQuery eine Abfrage ausführt, verteilt die Abfrage-Engine die Arbeit parallel, scannt die relevanten Tabellen im Speicher, führt die Ergebnisse zusammen und gibt den endgültigen Datensatz zurück.

Wie man mit BigQuery einsteigt

In diesem Abschnitt erfahren wir, wie du auf BigQuery zugreifst und wie du die BigQuery-Sandbox nutzt. Eine Sandbox ist in der Regel eine isolierte Testumgebung, die einfaches Experimentieren ermöglicht. Mit der BigQuery-Sandbox kannst du BigQuery ausprobieren, ohne eine Kreditkarte anzugeben oder ein Abrechnungskonto für dein Projekt zu erstellen.

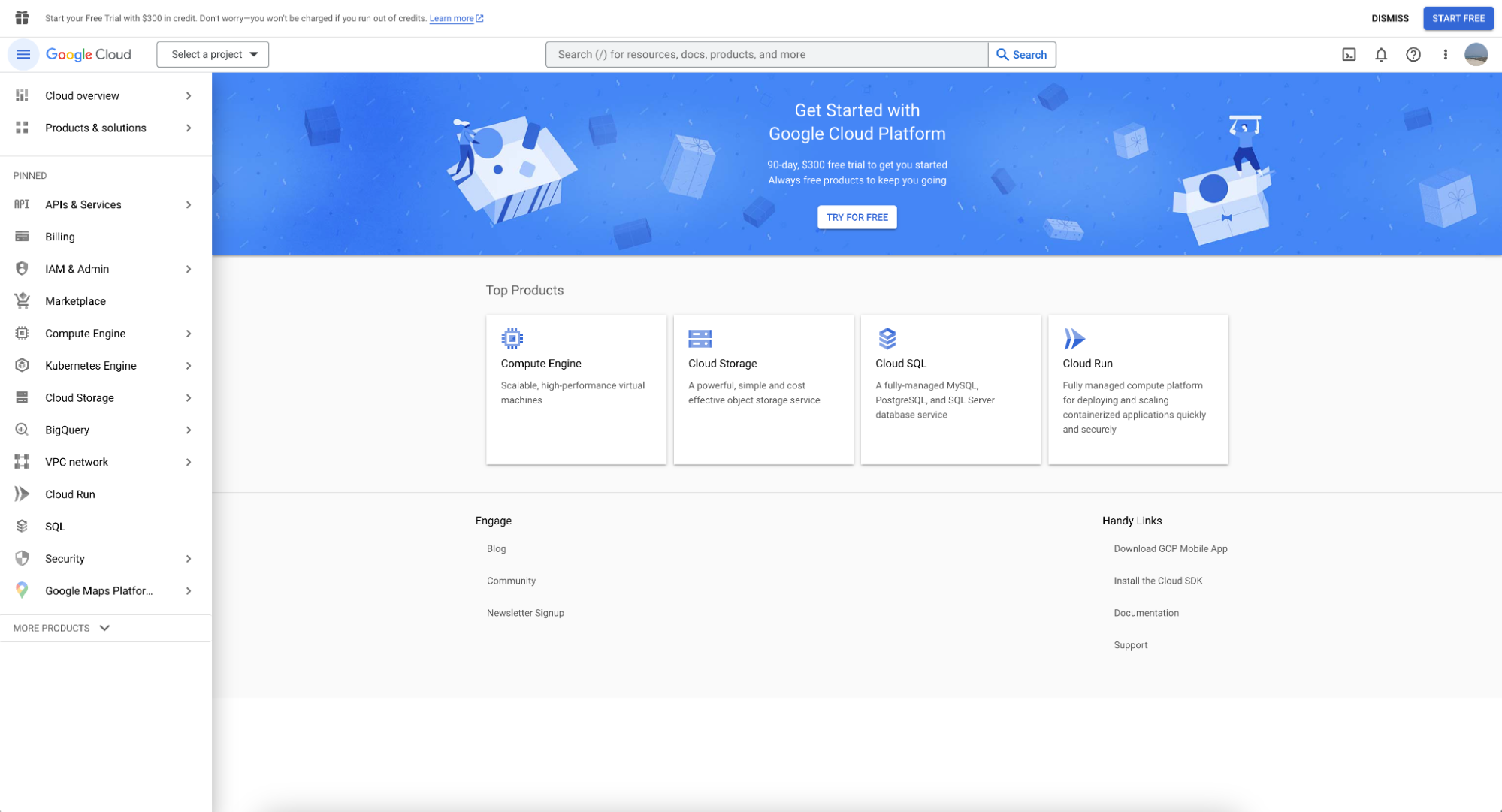

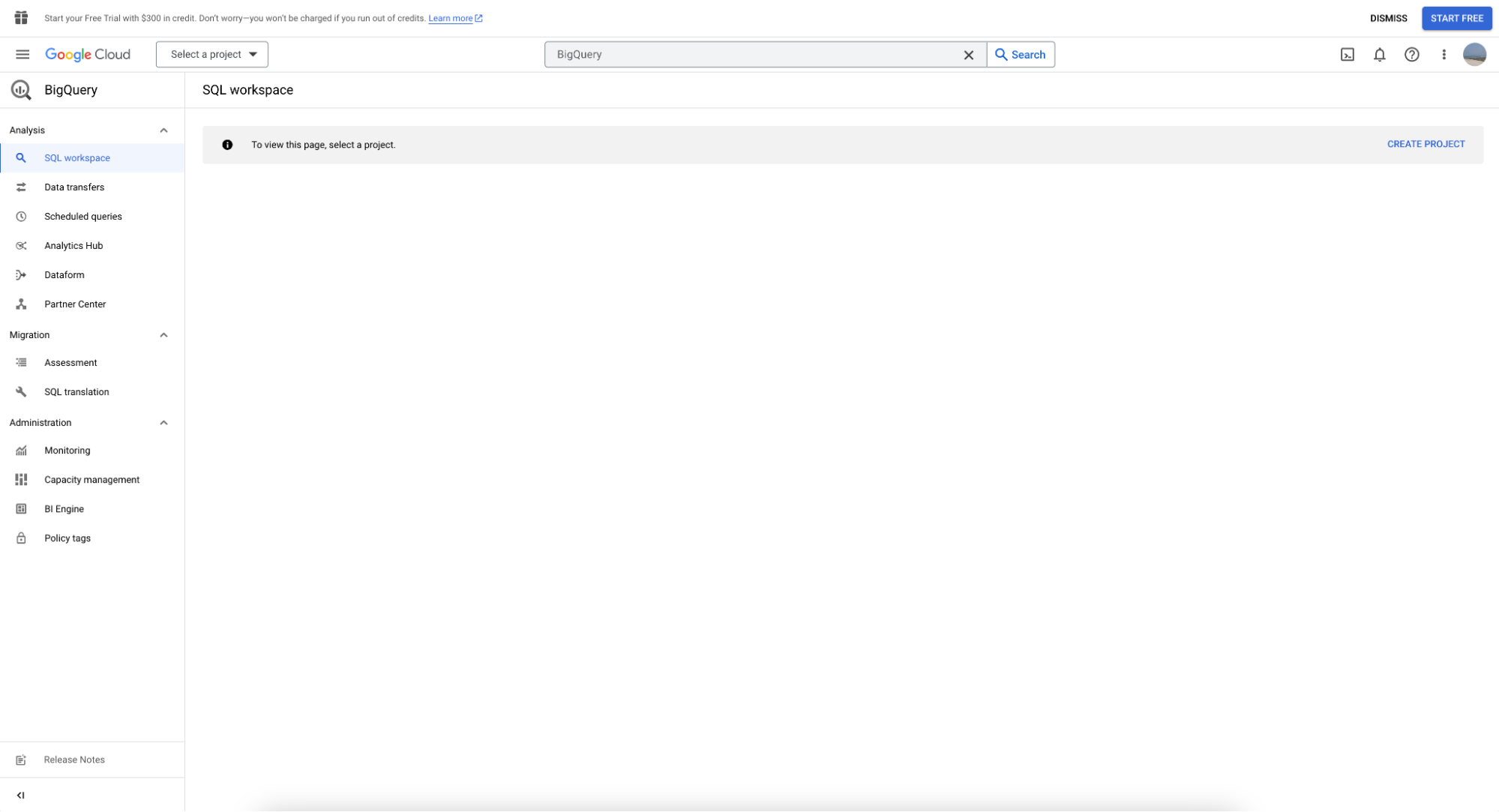

Auf BigQuery kann über die Google Cloud Console zugegriffen werden. Du musst dich mit einem Gsuite-E-Mail-Konto anmelden (oder eines erstellen). Nach der Anmeldung sollte ein Willkommensbildschirm erscheinen:

Du kannst BigQuery in der linken Menüleiste finden. Wenn du darauf klickst, siehst du den folgenden Bildschirm:

Verwendung der BigQuery-Sandbox

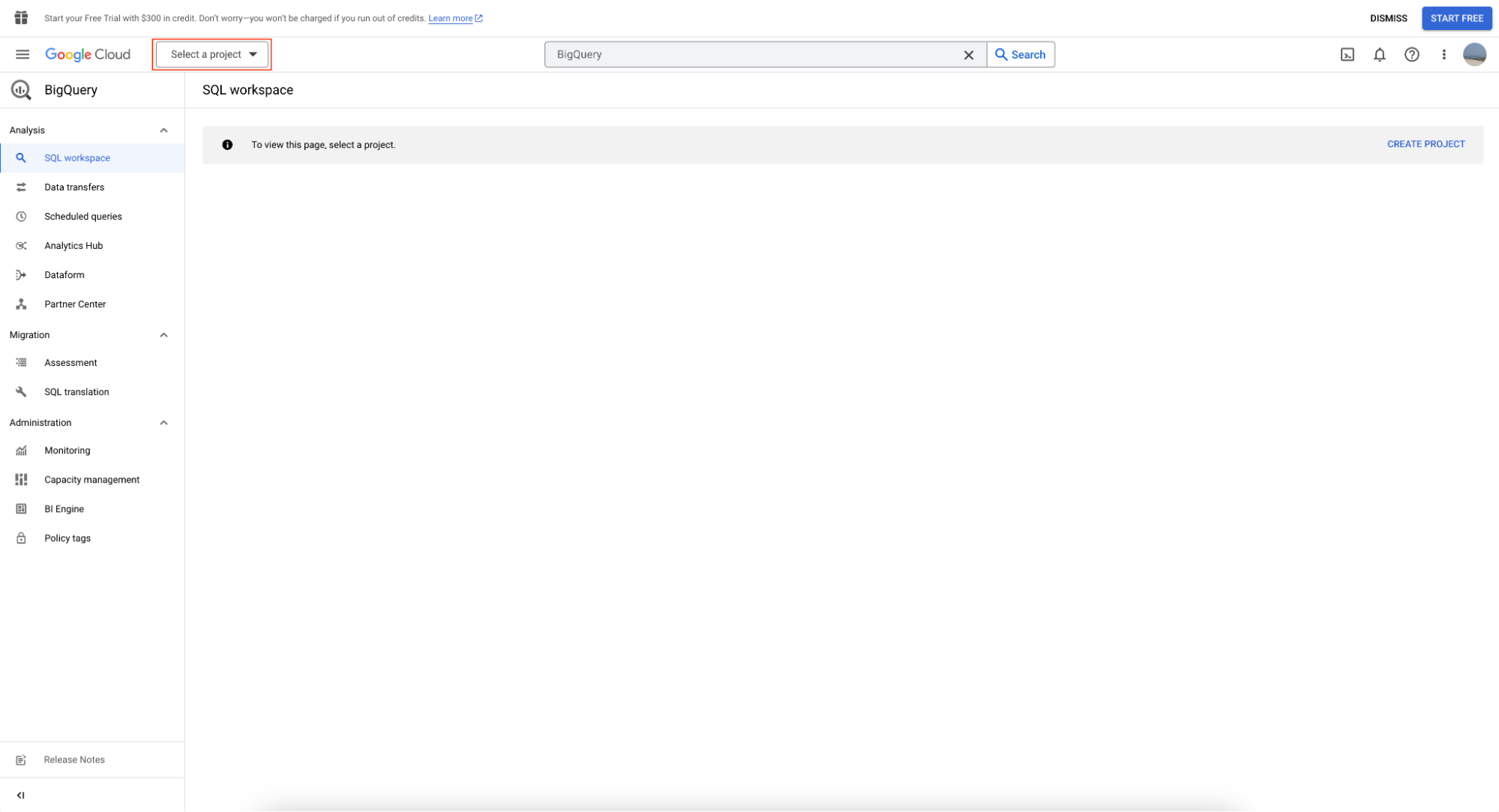

Um die BigQuery-Sandbox zu nutzen, erstellst du zunächst ein Projekt, indem du auf "Projekt auswählen" klickst.

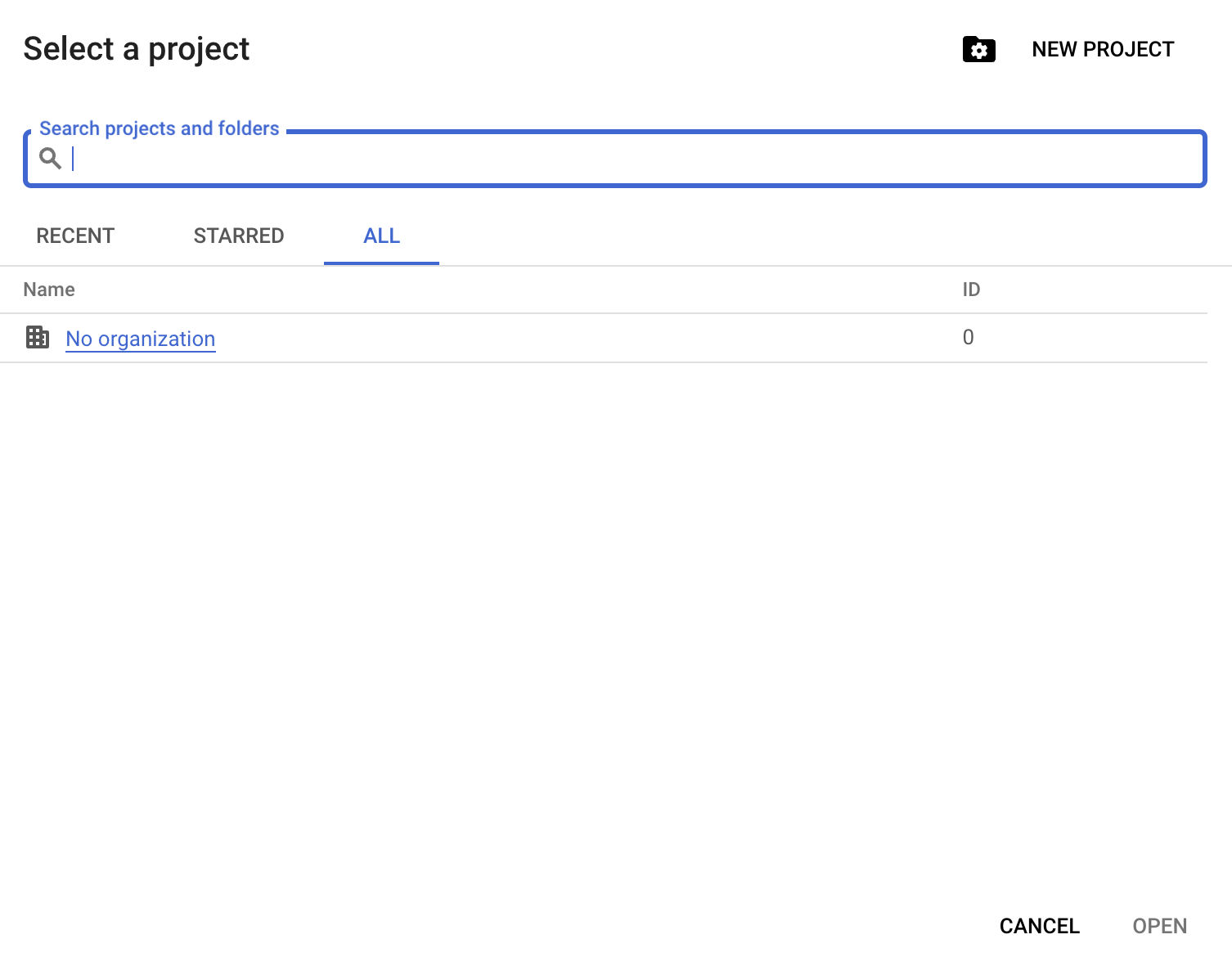

Anschließend klickst du auf "Neues Projekt":

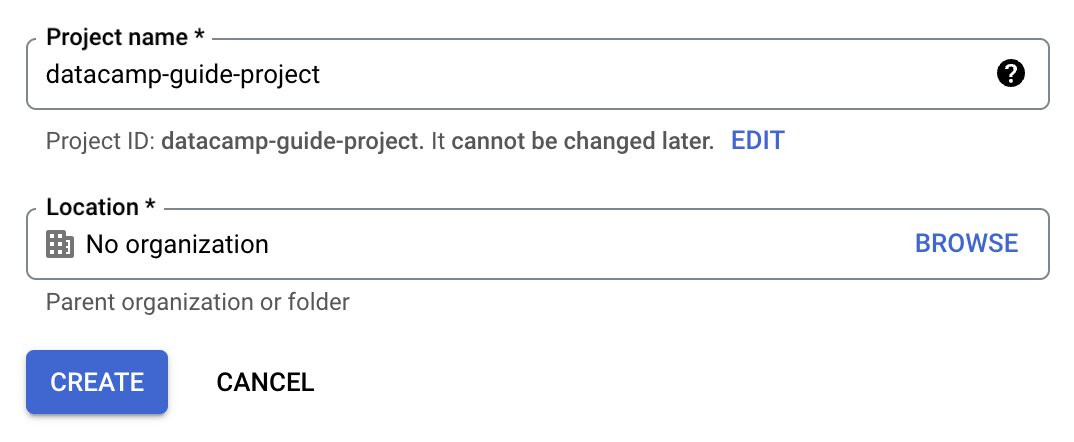

Du musst einen Projektnamen angeben; für diesen Leitfaden verwenden wir datacamp-guide-project

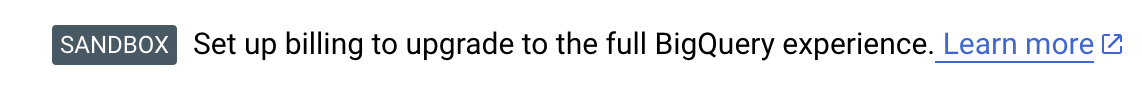

Auf der BigQuery-Seite wird jetzt ein Sandbox-Hinweis angezeigt, der bestätigt, dass du die BigQuery-Sandbox erfolgreich aktiviert hast.

Wenn die BigQuery-Sandbox jetzt aktiviert ist, kannst du dein neues Projekt nutzen, um Daten zu laden und abzufragen sowie öffentliche Google-Datensätze abzufragen.

Erstellen eines Datensatzes und einer Tabelle

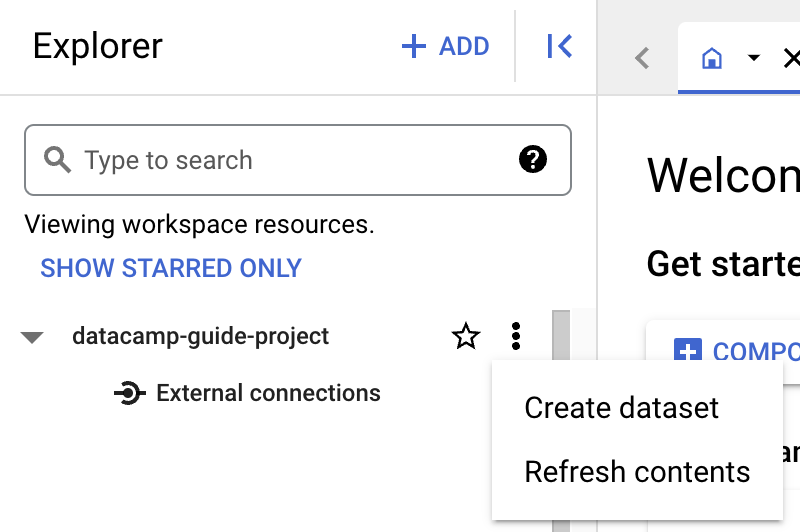

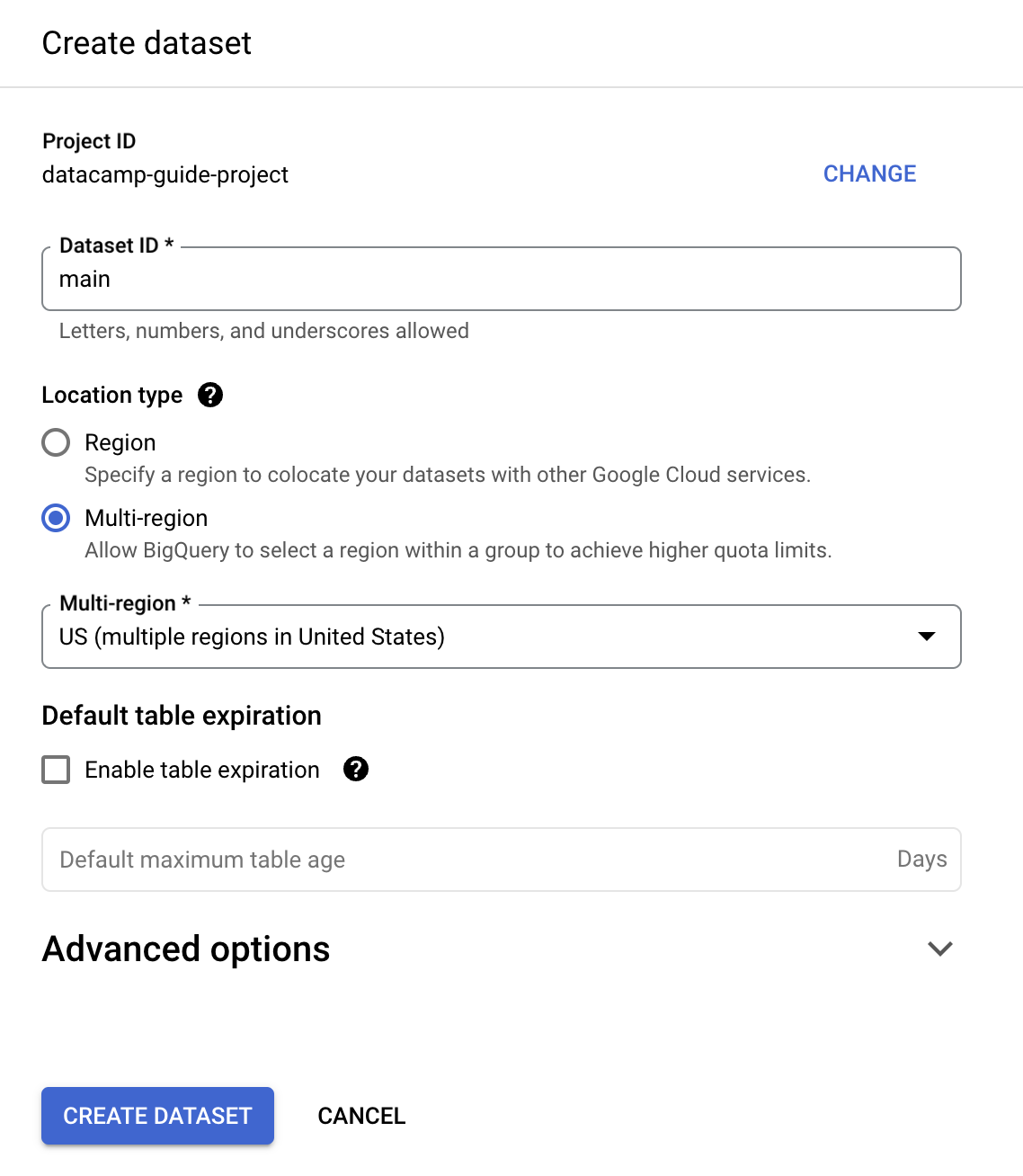

Bevor du eine Tabelle erstellst, musst du ein Dataset in deinem neuen Projekt anlegen. Ein Dataset ist ein übergeordneter Container, der dazu dient, den Zugriff auf eine Reihe von Tabellen und Ansichten zu organisieren und zu steuern. Um einen Datensatz zu erstellen, klicke auf das Symbol "Aktionen" im Projekt:

Für diesen Leitfaden geben wir als "Dataset ID" "main" ein.

Du kannst eine Tabelle mit SQL erstellen. BigQuery verwendet GoogleSQL, das ANSI-konform ist.

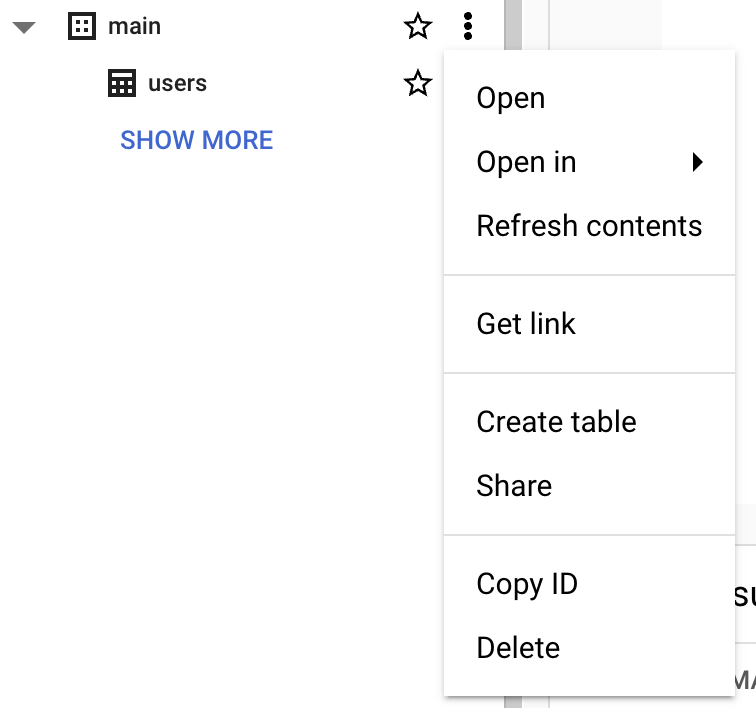

create table datacamp-guide-project.main.users ( id INT64 not null, first_name STRING NOT NULL, middle_name STRING, -- can be null last_name STRING NOT NULL, active_account BOOL NOT NULL, ); Du kannst auch die Oberfläche der BigQuery-Konsole verwenden:

Hinweis: Es ist nicht möglich, in einer Sandbox-Umgebung Daten einzufügen. Wenn du das Einfügen von Daten ausprobieren möchtest, musst du die kostenlose Testversion aktivieren. In den nächsten Abschnitten geht es um die Abfrage öffentlicher Datensätze, die als Teil der Google Cloud bereitgestellt werden.

Abfrage eines öffentlichen Datensatzes mit der BigQuery-Konsole

Um einen öffentlichen Datensatz abzufragen, befolge die folgenden Schritte:

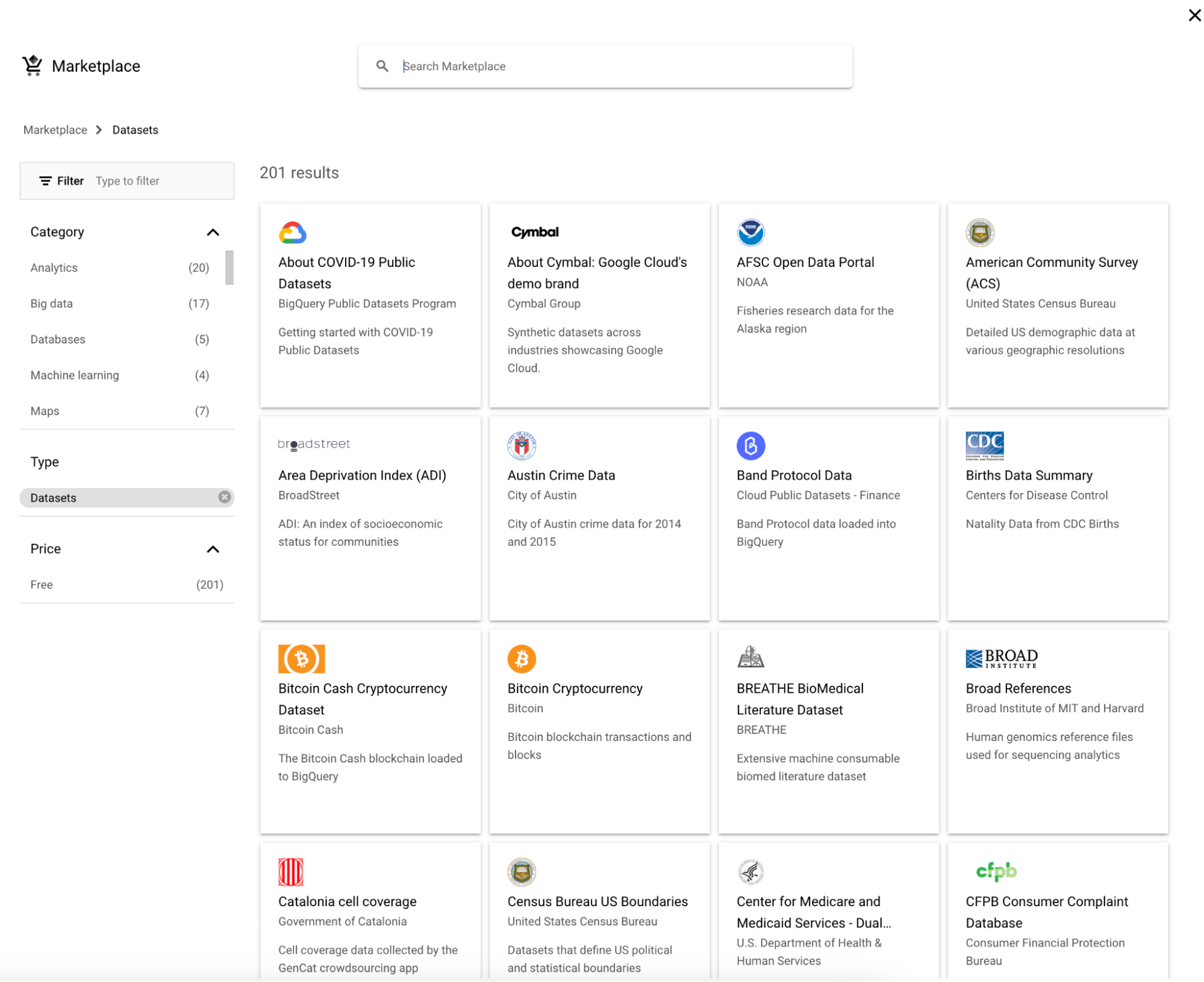

1. Klicke auf "Hinzufügen" neben dem Explorer.

2. Dann wählst du einen Datensatz aus.

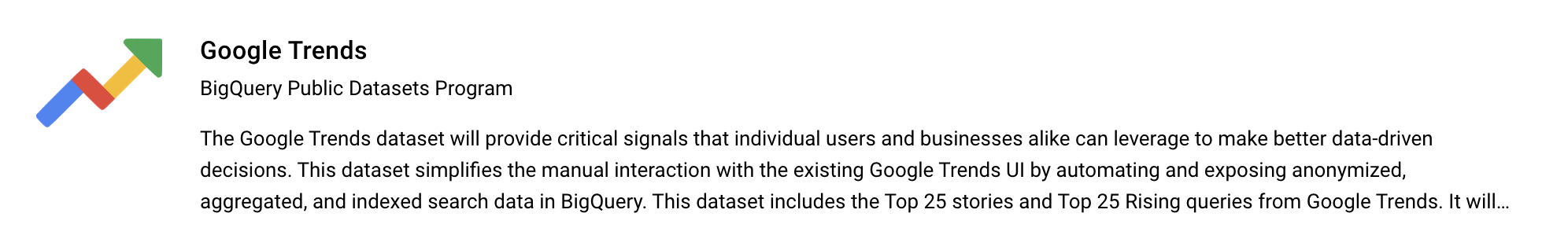

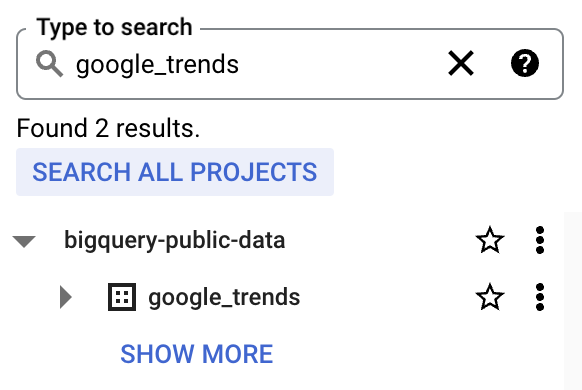

3. Suche nach "Google Trends", wähle Google Trends und klicke dann auf die Schaltfläche "Datensatz anzeigen".

4. bigquery-public-data wird mit einer langen Liste von Datensätzen angezeigt. Star bigquery-public-data, damit es im Explorer "kleben" bleibt

Ein praktisches Beispiel mit dem Google Trends-Datensatz

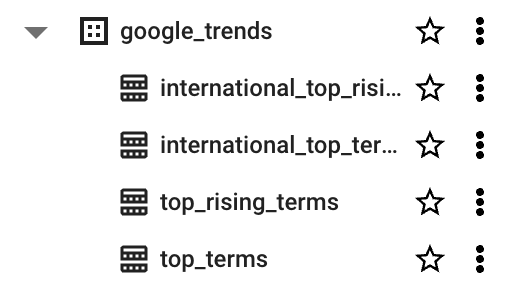

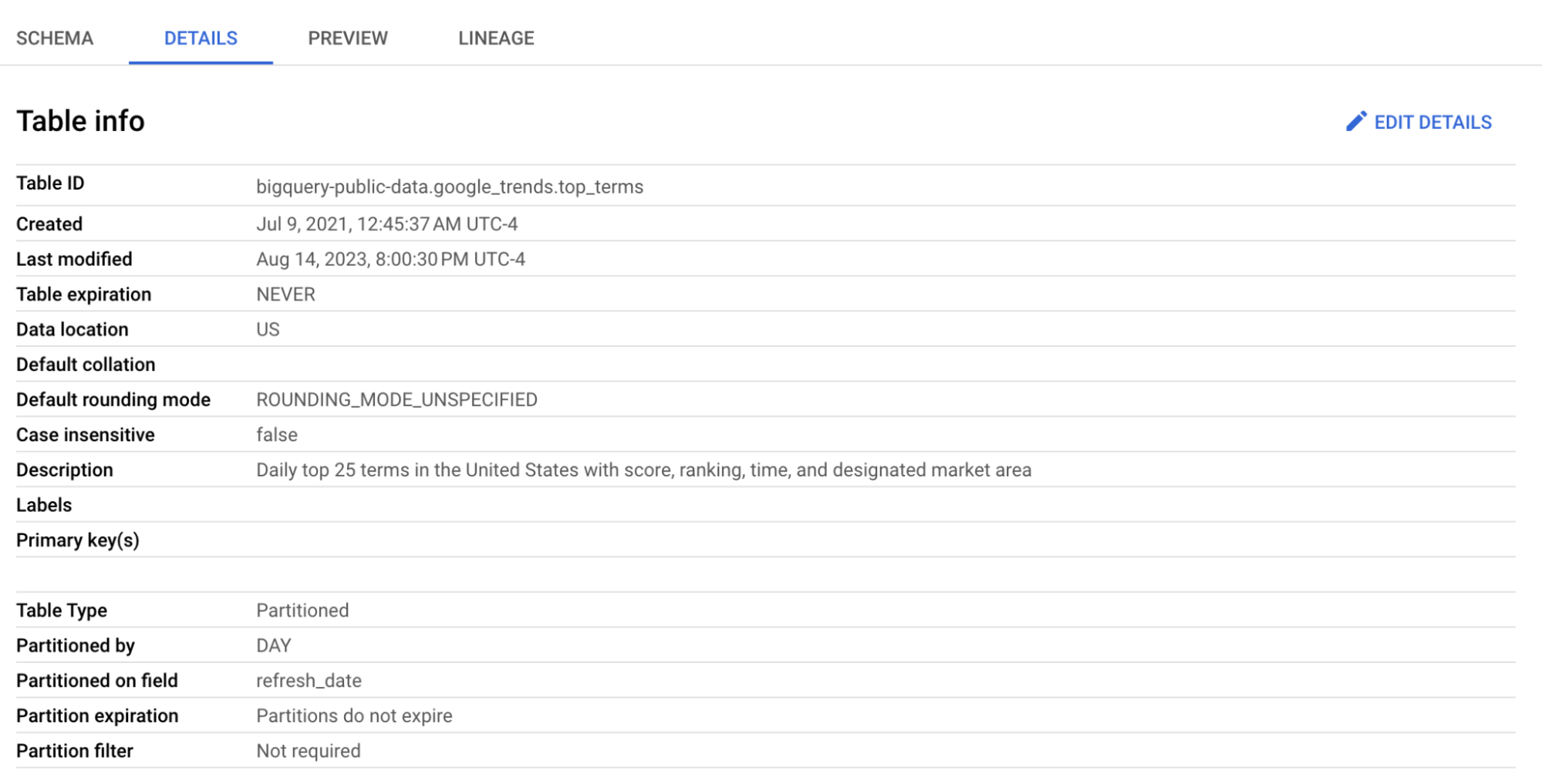

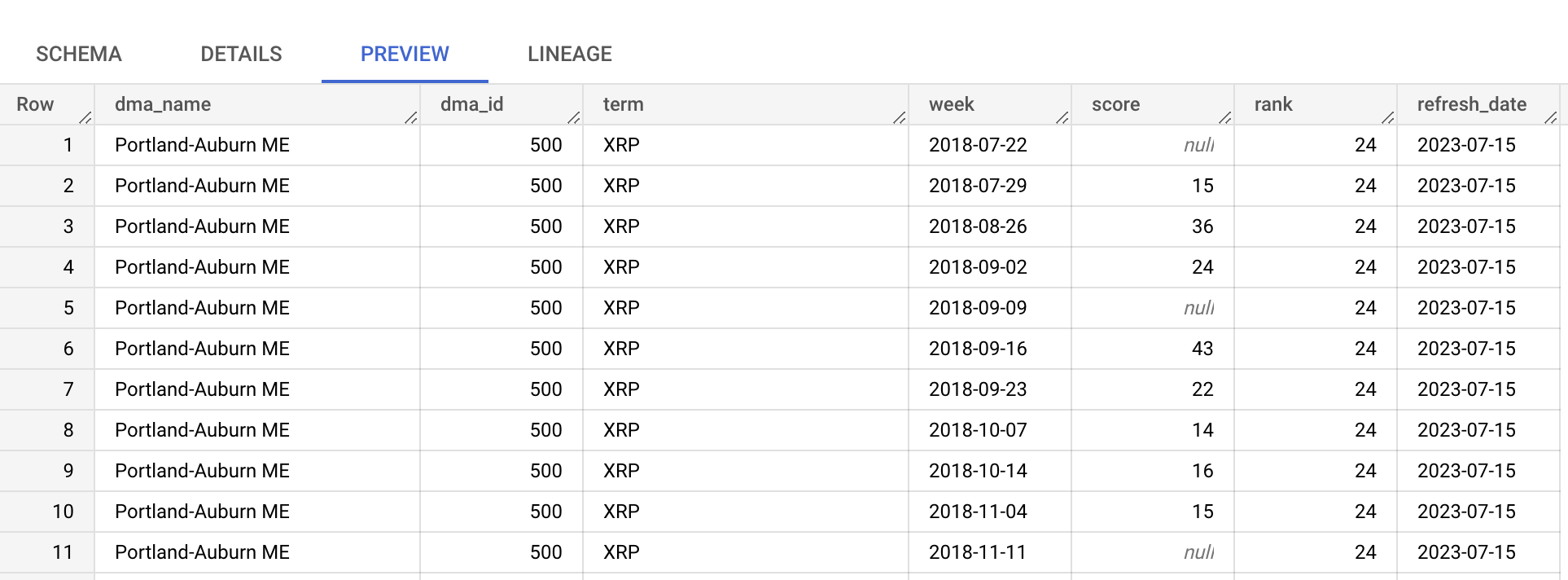

Wir werden die Tabelle top_terms nutzen:

Klicke auf die Tabelle top_terms, um sie zu öffnen, und sieh dir die Tabelle Details und Vorschau an, um mehr über die Daten von top_terms zu erfahren.

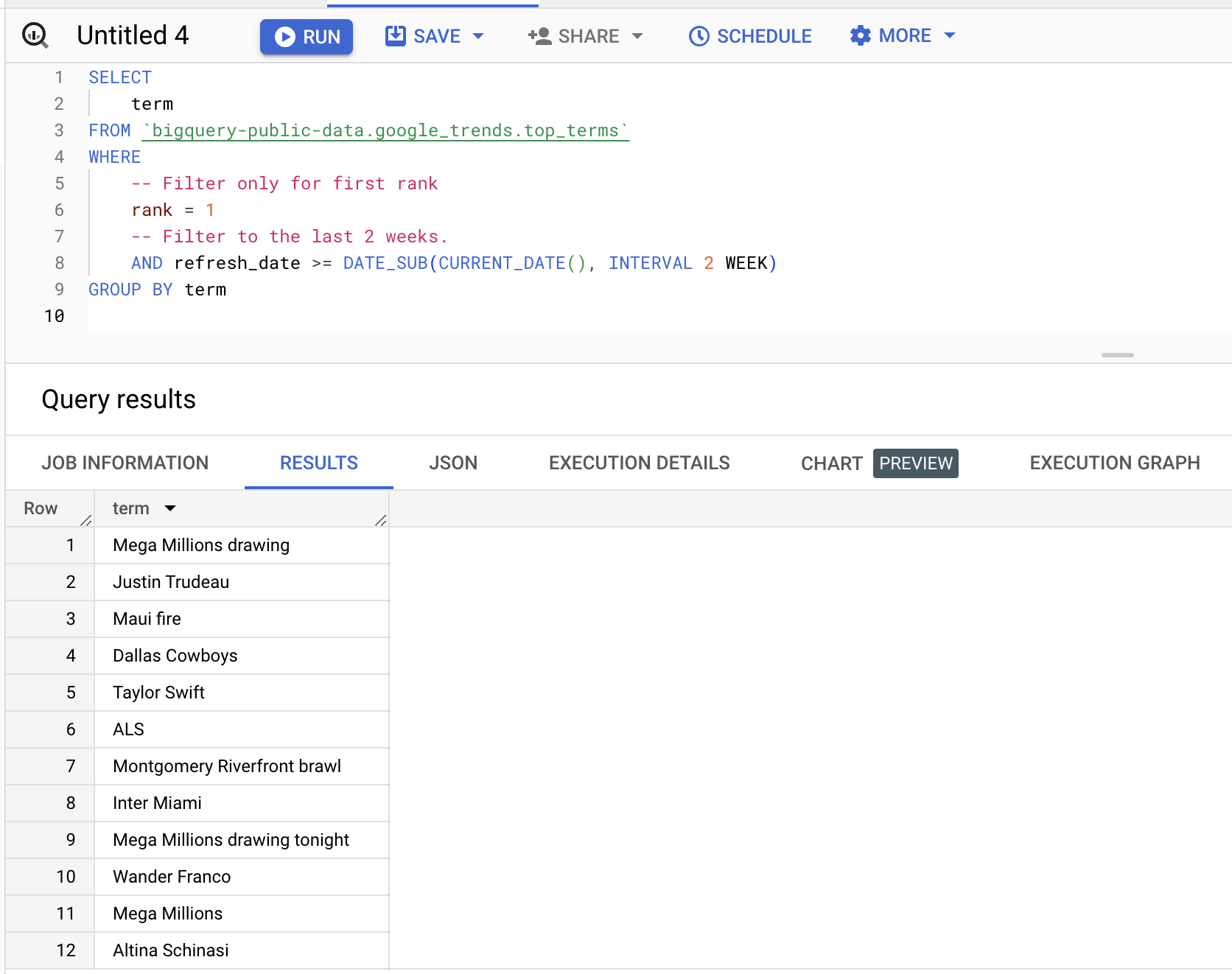

Du kannst den Datensatz abfragen, wie im folgenden Beispiel, um die Begriffe zu finden, die in den letzten zwei Wochen auf der ersten Position standen:

SELECT

term

FROM bigquery-public-data.google_trends.top_terms WHERE -- Filter only for first rank rank = 1 -- Filter to the last 2 weeks. AND refresh_date >= DATE_SUB(CURRENT_DATE(), INTERVAL 2 WEEK) GROUP BY term Ergebnisse (werden variieren):

Nächste Schritte

Du bist jetzt bereit, mit BigQuery loszulegen. Google Cloud bietet eine kostenlose Testversion im Wert von 300 $ an. BigQuery bietet verschiedene Zahlungsmöglichkeiten an. Für die Abfrage bekommst du 1 TB pro Monat kostenlos, darüber hinaus kostet es 6,25 Dollar pro TB. Weitere Informationen zu den Preisen findest du auf der Seite mit den Preisen.

Für diejenigen, die an einem umfassenden Verständnis von Data Engineering interessiert sind, einschließlich der Arbeit mit Cloud-basierten Data Warehouses wie BigQuery, bietet das DataCamp einen Lernpfad für Data Engineers an, der alles von den Grundlagen bis zu fortgeschrittenen Themen abdeckt.

Du kannst dir auch unseren Spickzettel mit einem Vergleich von AWS, Azure und Google Cloud Platform ansehen, um weitere Einblicke in die verfügbaren Tools zu erhalten.

Lass dich für deine Traumrolle als Data Engineer zertifizieren

Unsere Zertifizierungsprogramme helfen dir, dich von anderen abzuheben und potenziellen Arbeitgebern zu beweisen, dass deine Fähigkeiten für den Job geeignet sind.

DataCamp Chief Technology Officer und General Manager der Lernplattform. In meiner Funktion leite ich die Teams, die sich mit der Entwicklung der Technologie und dem Lehrplan befassen, der die Erfahrungen der DataCamp-Teilnehmer/innen ermöglicht.