Kurs

Jeder liebt es, aufzufallen, anders zu sein. Aber das ist nicht die Qualität, die du als Datenwissenschaftler/in in deinen Datenpunkten haben willst. Abweichende Datenpunkte oder Anomalien in einem Datensatz sind eines der gefährlichsten Datenqualitätsprobleme, die fast alle Datenprojekte plagen.

Dieser letzte Satz mag dich überraschen, wenn du bisher nur mit ausgefeilten Open-Source-Datensätzen gearbeitet hast, die oft keine Ausreißer enthalten. Reale Datensätze weisen jedoch immer einige Unterschiede zu den normalen Stichproben auf. Es ist deine Aufgabe, sie zu erkennen und angemessen mit ihnen umzugehen.

In diesem Artikel lernst du die grundlegenden Ideen dieses Prozesses kennen, der oft als Anomalieerkennung bezeichnet wird:

- Die nachteiligen Auswirkungen von Anomalien auf dein Projekt.

- Die Bedeutung der Aufdeckung von Anomalien.

- Reale Anwendungen der Anomalieerkennung.

- Der Unterschied zwischen Anomalien, Ausreißern und Neuerungen.

- Arten von Anomalien und Methoden zur Erkennung von Anomalien.

- Wie man Algorithmen zur Erkennung von Anomalien in Python entwickelt.

- Wie man mit den Herausforderungen der Anomalieerkennung umgeht.

Am Ende wirst du die Grundlagen der Anomalieerkennung beherrschen und das Vertrauen gewinnen, den störenden Einfluss von Ausreißern in deinen Projekten zu verringern.

Was ist Anomalie-Erkennung?

Bei der Erkennung von Anomalien, auch Ausreißer genannt, geht es darum, Muster oder Instanzen in einem Datensatz zu finden, die erheblich vom erwarteten oder "normalen Verhalten" abweichen.

Die Definition von "normalen" und anormalen Daten ist je nach Kontext sehr unterschiedlich. Im Folgenden findest du einige Beispiele für die Erkennung von Anomalien in der Praxis.

1. Finanzielle Transaktionen

Normal: Routinekäufe und regelmäßige Ausgaben einer Person in London.

Ausreißer: Eine massive Abhebung aus Irland von demselben Konto, die auf einen möglichen Betrug hindeutet.

2. Netzwerkverkehr in der Cybersicherheit

Normal: Regelmäßige Kommunikation, stetiger Datentransfer und die Einhaltung des Protokolls.

Ausreißer: Ein plötzlicher Anstieg des Datentransfers oder die Verwendung unbekannter Protokolle weist auf einen möglichen Verstoß oder Malware hin.

3. Überwachung der Vitalparameter des Patienten

Normal: Stabile Herzfrequenz und konstanter Blutdruck

Ausreißer: Plötzlicher Anstieg der Herzfrequenz und Abfall des Blutdrucks, was auf einen möglichen Notfall oder einen Geräteausfall hinweist.

Die Erkennung von Anomalien umfasst viele Arten von unüberwachten Methoden, um abweichende Muster zu identifizieren. Datenspezialisten wählen sie je nach Art der Anomalie, dem Kontext, der Struktur und den Merkmalen des jeweiligen Datensatzes aus. Wir werden sie in den nächsten Abschnitten behandeln.

Anwendungen der Anomalieerkennung in der realen Welt

Auch wenn wir oben schon einige Beispiele gesehen haben, wollen wir uns nun ein Beispiel aus der Praxis ansehen, wie die Erkennung von Anomalien im Finanzbereich funktioniert.

Shaq O'Neal, vierfacher NBA-Sieger, wird von den Miami Heat zu den Phoenix Suns gehandelt. Als Shaq in der leeren Wohnung ankommt, die ihm von den Phoenix Suns zur Verfügung gestellt wurde, will er mitten in der Nacht sofort seine Wohnung einrichten. Also geht er zu Walmart und macht den größten Einkauf in der Geschichte von Walmart für 70.000 $. Oder zumindest versucht er es; seine Karte wird abgelehnt.

Er fragt sich, was das Problem sein könnte (er kann nicht pleite sein!) Um 2 Uhr morgens ruft ihn der Sicherheitsdienst von American Express an und teilt ihm mit, dass seine Karte als gestohlen gilt, weil jemand versucht hat, im Walmart in Phoenix 70.000 Dollar einzukaufen (schau dir die Anekdote an, um die ganze Geschichte zu hören).

Es gibt so viele andere praktische Anwendungen für die Erkennung von Anomalien, die über das Finanzwesen und die Aufdeckung von Betrug hinausgehen:

- Cybersecurity

- Gesundheitswesen

- Überwachung von Industrieanlagen

- Erkennung von Netzwerkeinbrüchen

- Überwachung des Energienetzes

- E-Commerce und Analyse des Nutzerverhaltens

- Qualitätskontrolle in der Produktion

Die Erkennung von Anomalien ist tief in die Dienste, die wir täglich nutzen, eingewoben und oft bemerken wir sie nicht einmal.

Die Bedeutung der Anomalie-Erkennung in der Datenwissenschaft

Daten sind das wertvollste Gut in der Datenwissenschaft, und Anomalien sind die größte Bedrohung für ihre Qualität. Schlechte Datenqualität bedeutet schlecht:

- Statistische Tests

- Dashboards

- Modelle für maschinelles Lernen

- Entscheidungen

und letztlich eine beeinträchtigte Grundlage für fundierte Entscheidungen.

Anomalien verzerren statistische Analysen, indem sie nicht existierende Muster einführen, was zu falschen Schlussfolgerungen und unzuverlässigen Vorhersagen führt. Da sie oft die Extremwerte in einem Datensatz sind, verzerren Anomalien oft die beiden wichtigsten Merkmale von Verteilungen: Mittelwert und Standardabweichung.

Da das Innenleben fast aller maschinellen Lernmodelle stark von diesen beiden Kennzahlen abhängt, ist die rechtzeitige Erkennung von Anomalien entscheidend.

Arten von Anomalien

Die Erkennung von Anomalien umfasst zwei weit gefasste Verfahren: die Erkennung von Ausreißern und die Erkennung von Neuartigkeiten.

Ausreißer sind abnormale oder extreme Datenpunkte, die nur in den Trainingsdaten vorkommen. Im Gegensatz dazu sind Neuheiten neue oder bisher ungesehene Instanzen im Vergleich zu den ursprünglichen (Trainings-)Daten.

Nehmen wir zum Beispiel einen Datensatz mit den täglichen Temperaturen in einer Stadt. An den meisten Tagen liegen die Temperaturen zwischen 20°C und 30°C. Doch eines Tages gibt es eine Spitze von 40°C. Diese extreme Temperatur ist ein Ausreißer, denn sie weicht erheblich von der üblichen täglichen Temperaturspanne ab.

Jetzt stell dir vor, die Stadt installiert eine neue, genauere Wetterstation. Infolgedessen beginnt der Datensatz, durchgehend etwas höhere Temperaturen aufzuzeichnen, die zwischen 25°C und 35°C liegen. Dieser anhaltende Anstieg der Temperaturen ist ein Novum und stellt ein neues Muster dar, das durch das verbesserte Überwachungssystem eingeführt wurde.

Anomalien hingegen ist ein weit gefasster Begriff für Ausreißer und Neuerungen. Er kann verwendet werden, um jede abnormale Instanz in jedem Kontext zu definieren.

Es ist wichtig, die Art der Anomalien zu identifizieren, damit du den richtigen Algorithmus für ihre Erkennung auswählen kannst.

Arten von Ausreißern

So wie es zwei Arten von Anomalien gibt, so gibt es auch zwei Arten von Ausreißern: univariate und multivariate. Je nach Typ verwenden wir unterschiedliche Erkennungsalgorithmen.

- Univariate Ausreißer gibt es in einer einzelnen Variablen oder einem einzelnen Merkmal, das isoliert ist. Univariate Ausreißer sind extreme oder abnormale Werte, die vom typischen Wertebereich für das betreffende Merkmal abweichen.

- Multivariate Ausreißer werden durch die gleichzeitige Kombination der Werte mehrerer Variablen gefunden.

Nehmen wir zum Beispiel einen Datensatz zu den Immobilienpreisen in einer Gegend. Die meisten Häuser kosten zwischen 200.000 und 400.000 $, aber es gibt ein Haus A mit einem außergewöhnlich hohen Preis von 1.000.000 $. Wenn wir nur den Preis analysieren, ist Haus A ein klarer Ausreißer.

Fügen wir nun zwei weitere Variablen zu unserem Datensatz hinzu: die Quadratmeterzahl und die Anzahl der Schlafzimmer. Wenn wir die Quadratmeterzahl, die Anzahl der Schlafzimmer und den Preis betrachten, ist es Haus B, das seltsam aussieht:

- Es hat die Hälfte der Quadratmeterzahl des durchschnittlichen Hauspreises.

- Es hat nur ein Schlafzimmer.

- Es kostet das Spitzenmodell $380.000.

Wenn wir diese Variablen einzeln betrachten, scheinen sie gewöhnlich zu sein. Erst wenn wir sie zusammenfassen, stellen wir fest, dass Haus B ein klarer multivariater Ausreißer ist.

Methoden zur Erkennung von Anomalien und wann man sie einsetzt

Algorithmen zur Aufdeckung von Anomalien unterscheiden sich je nach Art der Ausreißer und der Struktur des Datensatzes.

Für die univariate Ausreißererkennung sind die beliebtesten Methoden:

- Z-Score (Standardwert): Der Z-Score misst, wie viele Standardabweichungen ein Datenpunkt vom Mittelwert entfernt ist. In der Regel werden Instanzen mit einem Z-Score über 3 als Ausreißer ausgewählt.

- Interquartilsbereich (IQR): Der IQR ist der Bereich zwischen dem ersten Quartil (Q1) und dem dritten Quartil (Q3) einer Verteilung. Wenn eine Instanz über Q1 oder Q3 für einen bestimmten Multiplikator des IQR liegt, wird sie als Ausreißer betrachtet. Der gebräuchlichste Multiplikator ist 1,5, sodass der Ausreißerbereich [Q1-1,5 * IQR, Q3 + 1,5 * IQR] ist.

- Modifizierte z-Scores: ähnlich wie z-Scores, aber modifizierte z-Scores verwenden den Median und ein Maß namens Median Absolute Deviation (MAD), um Ausreißer zu finden. Da Mittelwert und Standardabweichung durch Ausreißer leicht verzerrt werden können, gelten modifizierte z-Scores im Allgemeinen als robuster.

Für multivariate Ausreißer verwenden wir in der Regel Algorithmen des maschinellen Lernens. Aufgrund ihrer Tiefe und Stärke sind sie in der Lage, komplizierte Muster in komplexen Datensätzen zu finden:

- Isolation Forest: verwendet eine Sammlung von Isolationsbäumen (ähnlich wie Entscheidungsbäume), die komplexe Datensätze rekursiv unterteilen, bis jede Instanz isoliert ist. Die Instanzen, die am schnellsten isoliert werden, gelten als Ausreißer.

- Lokaler Ausreißerfaktor (LOF): LOF misst die Abweichung der lokalen Dichte einer Probe im Vergleich zu ihren Nachbarn. Punkte mit deutlich geringerer Dichte werden als Ausreißer ausgewählt.

- Clustering-Techniken: Techniken wie k-means oder hierarchisches Clustering unterteilen den Datensatz in Gruppen. Punkte, die zu keiner Gruppe gehören oder sich in eigenen kleinen Clustern befinden, werden als Ausreißer bezeichnet.

- Winkelbasierte Ausreißer-Erkennung (ABOD): ABOD misst die Winkel zwischen einzelnen Punkten. Instanzen mit ungeraden Winkeln können als Ausreißer betrachtet werden.

Neben der Art der Anomalien solltest du auch die Merkmale des Datensatzes und die Projektbeschränkungen berücksichtigen. Isolation Forest zum Beispiel funktioniert bei fast jedem Datensatz gut, ist aber langsamer und rechenintensiver, da es sich um eine Ensemble-Methode handelt. Im Vergleich dazu ist LOF sehr schnell im Training, kann aber nicht so gut abschneiden wie Isolation Forest.

Du kannst einen Vergleich der gängigsten Algorithmen zur Erkennung von Anomalien an 55 Datensätzen aus dem Python Outlier Detection (PyOD) Paket sehen.

Erstellung eines Modells zur Erkennung von Anomalien in Python

Wie für jede andere Aufgabe gibt es auch für die Erkennung von Anomalien viele Bibliotheken in Python. Die besten Anwärter sind:

- Python Outlier Detection (PyOD)

- Scikit-learn

Während scikit-learn fünf klassische Algorithmen für maschinelles Lernen bietet (du kannst sie sowohl für univariate als auch für multivariate Ausreißer verwenden), enthält PyOD über 30 Algorithmen, von einfachen Methoden wie MAD bis hin zu komplexen Deep-Learning-Modellen. Du kannst auch TensorFlow oder PyTorch für benutzerdefinierte Modelle verwenden, aber das würde den Rahmen dieses Artikels sprengen.

Univariate Erkennung von Anomalien

Ich bevorzuge pyod wegen seiner umfangreichen Bibliothek von Algorithmen und einer API, die mit sklearn übereinstimmt. Es braucht nur ein paar Zeilen Code, um mit PyOD Ausreißer aus einem Datensatz zu finden und zu extrahieren. Hier ist ein Beispiel für die Anwendung von MAD auf einen univariaten Datensatz:

import pandas as pd

import seaborn as sns

from pyod.models.mad import MAD

# Load a sample dataset

diamonds = sns.load_dataset("diamonds")

# Extract the feature we want

X = diamonds[["price"]]

# Initialize and fit a model

mad = MAD().fit(X)

# Extract the outlier labels

labels = mad.labels_

>>> pd.Series(labels).value_counts()

0 49708

1 4232

Name: count, dtype: int64Lass uns den Code Zeile für Zeile durchgehen. Zuerst laden wir die notwendigen Bibliotheken für die Datenbearbeitung, das Laden eines Datensatzes und pyod für das Ausreißermodell. Nachdem wir den in Seaborn integrierten Diamanten-Datensatz geladen haben, extrahieren wir die Diamantenpreise.

Dann initialisieren wir ein MAD-Modell (Median Absolute Deviation) und passen es in einer einzigen Zeile an X an. Als Nächstes extrahieren wir die Inlier- und Outlier-Labels mithilfe des Attributs labels_ von mad in labels.

Wenn wir am Ende die Werte von labels ausdrucken, sehen wir, dass 49708 zur Kategorie 0 (Ausreißer) und 4232 zur Kategorie 1 (Ausreißer) gehören. Wenn wir die Ausreißer aus dem Originaldatensatz entfernen wollen, können wir Pandas Subsetting auf diamonds verwenden:

outlier_free = diamonds[labels == 0]

>>> len(outlier_free)

49708labels == 0 erstellt ein Array mit Wahr/Falsch-Werten (boolesches Array), wobei True einen Ausreißer bezeichnet.

Multivariate Erkennung von Anomalien

Der Prozess der Erstellung eines multivariaten Anomalieerkennungsmodells ist ebenfalls derselbe. Die multivariate Ausreißererkennung erfordert jedoch zusätzliche Verarbeitungsschritte, wenn kategoriale Merkmale vorhanden sind:

>>> diamonds.info()

<class 'pandas.core.frame.DataFrame'>

RangeIndex: 53940 entries, 0 to 53939

Data columns (total 10 columns):

# Column Non-Null Count Dtype

--- ------ -------------- -----

0 carat 53940 non-null float64

1 cut 53940 non-null category

2 color 53940 non-null category

3 clarity 53940 non-null category

4 depth 53940 non-null float64

5 table 53940 non-null float64

6 price 53940 non-null int64

7 x 53940 non-null float64

8 y 53940 non-null float64

9 z 53940 non-null float64

dtypes: category(3), float64(6), int64(1)

memory usage: 3.0 MBDa pyod erwartet, dass alle Merkmale numerisch sind, müssen wir kategoriale Variablen kodieren. Dazu werden wir Sklearn verwenden:

from sklearn.preprocessing import OrdinalEncoder

# Initialize the encoder

oe = OrdinalEncoder()

# Extract the categorical feature names

cats = diamonds.select_dtypes(include="category").columns.tolist()

# Encode the categorical features

cats_encoded = oe.fit_transform(diamonds[cats])

# Replace the old values with encoded values

diamonds.loc[:, cats] = cats_encoded

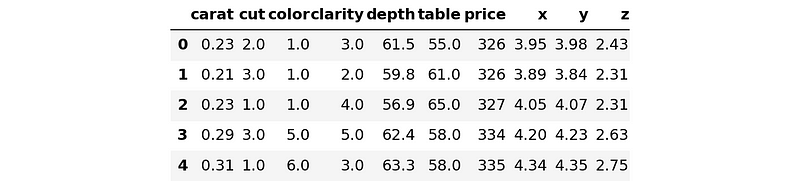

>>> diamonds.head()

Lass uns den Code noch einmal Zeile für Zeile durchgehen. Zunächst importieren wir die Klasse OrdinalEncoder, die ordinale kategoriale Merkmale kodiert, und initialisieren sie. Ordinale Merkmale sind Variablen, die natürliche, geordnete Kategorien haben, wie z.B. bei der Messung der Diamantqualität. Der Schliff und die Klarheit sind ordinal, die Farbe hingegen nicht. Aber um die Dinge nicht zu verkomplizieren, betrachten wir sie erst einmal als ordinal.

Dann extrahieren wir die kategorischen Merkmalsnamen mit der select_dtypes Methode von Pandas DataFrames. Wir verketten die Attribute .columns und .tolist(), um Spaltennamen in einer Liste namens Katzen zu erhalten.

Dann verwenden wir die Liste, um die gewünschten Merkmale mit oe umzuwandeln. Schließlich ersetzen wir die alten Textwerte durch numerische Werte, indem wir einen raffinierten Pandas-Trick mit .loc anwenden.

Bevor wir ein multivariates Modell anpassen, extrahieren wir das Merkmalsfeld X. Das Ziel des diamonds Datensatzes ist es, die Preise von Diamanten anhand ihrer Eigenschaften vorherzusagen. X enthält also alle Spalten außer price:

X = diamonds.drop("price", axis=1)

y = diamonds[["price"]]

Now, let’s build and fit the model:

from pyod.models.iforest import IForest

# Create a model with 10000 trees

iforest = IForest(n_estimators=10000)

iforest.fit(X) # This will take a minute

# Extract the labels

labels = iforest.labels_Je mehr Bäume der IForest Schätzer hat, desto mehr Zeit braucht er, um das Modell an den Datensatz anzupassen.

Nachdem wir die Etiketten haben, können wir die Ausreißer aus den Originaldaten entfernen:

X_outlier_free = X[labels == 0]

y_outlier_free = X[labels == 0]

>>> len(X_outlier_free)

48546

>>> # The length of the original dataset

>>> len(diamonds)

53940Das Modell fand über 5000 Ausreißer!

Herausforderungen bei der Erkennung von Anomalien

Die Erkennung von Anomalien kann eine größere Herausforderung darstellen als andere Aufgaben des maschinellen Lernens, weil sie nicht überwacht wird. Die meisten dieser Herausforderungen können jedoch mit verschiedenen Methoden entschärft werden (siehe nächster Abschnitt für Ressourcen).

Bei der Ausreißererkennung müssen wir diese beiden Fragen stellen:

- Sind die gefundenen Ausreißer tatsächlich Ausreißer?

- Hat das Modell alle Ausreißer in den Daten gefunden?

Beim überwachten Lernen können wir leicht überprüfen, ob das Modell gut funktioniert, indem wir seine Vorhersagen in den Testdaten mit den tatsächlichen Kennzeichnungen abgleichen. Bei der Erkennung von Ausreißern können wir jedoch nicht dasselbe tun, da es keine vorgefertigten Etiketten gibt, die uns sagen, welche Proben Ausreißer und welche Einbrecher sind.

Es kann also sein, dass einige oder die meisten der +5000 Ausreißer aus dem Diamanten-Datensatz gar keine Ausreißer sind! Es gibt keine Möglichkeit, das mit Sicherheit zu wissen. Es kann sein, dass einige Ausreißer als Ausreißer gekennzeichnet wurden, während einige tatsächliche Ausreißer übersehen wurden.

Das größte Problem bei der Erkennung von Anomalien besteht darin, dass man den Kontaminationsgrad (den Prozentsatz der Ausreißer in einem Datensatz) nicht kennt. Aus diesem Grund können wir die Leistung von Ausreißerklassifikatoren nicht zuverlässig messen und ihre Ergebnisse nicht überprüfen.

Aus diesem Grund haben alle Schätzer in pyod einen Parameter namens contamination, der standardmäßig auf 0,1 gesetzt ist. Als Ingenieur für maschinelles Lernen musst du diesen Parameter selbst einstellen.

Natürlich gibt es manchmal Alternativen. Das von Sklearn angebotene Modell IsolationForest verfügt zum Beispiel über einen internen Algorithmus, der den Verschmutzungsgrad automatisch ermittelt. Aber IsolationForest ist kein Allheilmittel für alle Probleme bei der Ausreißererkennung.

Ein weiteres Problem bei der Erkennung von Anomalien ist das Ungleichgewicht der Daten. Anomalien sind im Vergleich zu normalen Instanzen oft selten, was dazu führt, dass die Datensätze unausgewogen sind. Dieses Ungleichgewicht kann zu Schwierigkeiten bei der Unterscheidung zwischen tatsächlichen Anomalien und Unregelmäßigkeiten innerhalb der Mehrheitsklasse führen.

Die Lösung dieser Probleme (und vieler anderer, die wir noch nicht behandelt haben) beinhaltet die Auswahl geeigneter Algorithmen, die Abstimmung von Hyperparametern, die Auswahl von Merkmalen, den Umgang mit Klassenungleichgewichten und so weiter.

Zusammenfassung und nächste Schritte

Wir haben deine (wahrscheinlich) erste Begegnung mit der faszinierenden Welt der Anomalieerkennung beendet. Mit den grundlegenden Konzepten und Fähigkeiten in diesem Lernprogramm kannst du die Anomalieerkennung weiter erforschen.

Um dein Verständnis zu vertiefen, findest du hier einige Ressourcen, die du dir ansehen solltest:

- Kurs "Anomaly Detection in Python" von DataCamp: behandelt Methoden und Techniken, die in diesem Artikel ausführlicher besprochen werden, und erörtert, wie man die im letzten Abschnitt vorgestellten Probleme angeht.

- Anomaly Detection in R Kurs von DataCamp: ein Kurs für Leute, die das gute alte R bevorzugen

Ich bin ein Data Science Content Creator mit über 2 Jahren Erfahrung und einem der größten Follower auf Medium. Ich schreibe gerne ausführliche Artikel über KI und ML mit einem etwas sarkastischen Stil, denn man muss etwas tun, damit sie nicht so langweilig sind. Ich habe mehr als 130 Artikel verfasst und einen DataCamp-Kurs gemacht, ein weiterer ist in Vorbereitung. Meine Inhalte wurden von über 5 Millionen Augenpaaren gesehen, von denen 20.000 zu Followern auf Medium und LinkedIn wurden.