programa

La capacidad de integrar, procesar y analizar datos de forma eficaz es importante para las organizaciones que pretenden obtener información y mantener una ventaja competitiva.

Dos potentes herramientas, Azure Data Factory y Databricks, han surgido como soluciones líderes para gestionar canalizaciones de datos y realizar análisis avanzados en el ecosistema Azure. Aunque estas herramientas puedan parecer similares a primera vista, abordan aspectos diferentes de la ingeniería y el análisis de datos.

En este artículo, exploraremos las capacidades de Azure Data Factory y Databricks, compararemos sus características y daremos ideas sobre cuándo utilizar cada herramienta.

¿Qué es Azure Data Factory?

Azure Data Factory (ADF) es un servicio ETL (Extraer, Transformar, Cargar) basado en la nube que permite la integración, migración y orquestación de datos en varios almacenes de datos. Está diseñado para facilitar el movimiento y la transformación de datos desde fuentes dispares a ubicaciones centralizadas, donde pueden analizarse y aprovecharse para

inteligencia empresarial.

Con ADF, puedes crear y gestionar canalizaciones de datos que automaticen el proceso de extraer datos de múltiples fuentes, transformarlos en un formato utilizable y cargarlos en un destino para su análisis.

Características de Azure Data Factory

Estas son las características más interesantes del ADF, sin ningún orden en particular:

- Interfaz de arrastrar y soltar: ADF ofrece una interfaz intuitiva que te permite crear canalizaciones de datos sin necesidad de una codificación exhaustiva. Este enfoque de fácil uso es ideal para quienes no tienen grandes conocimientos técnicos, pero necesitan gestionar flujos de trabajo de datos complejos.

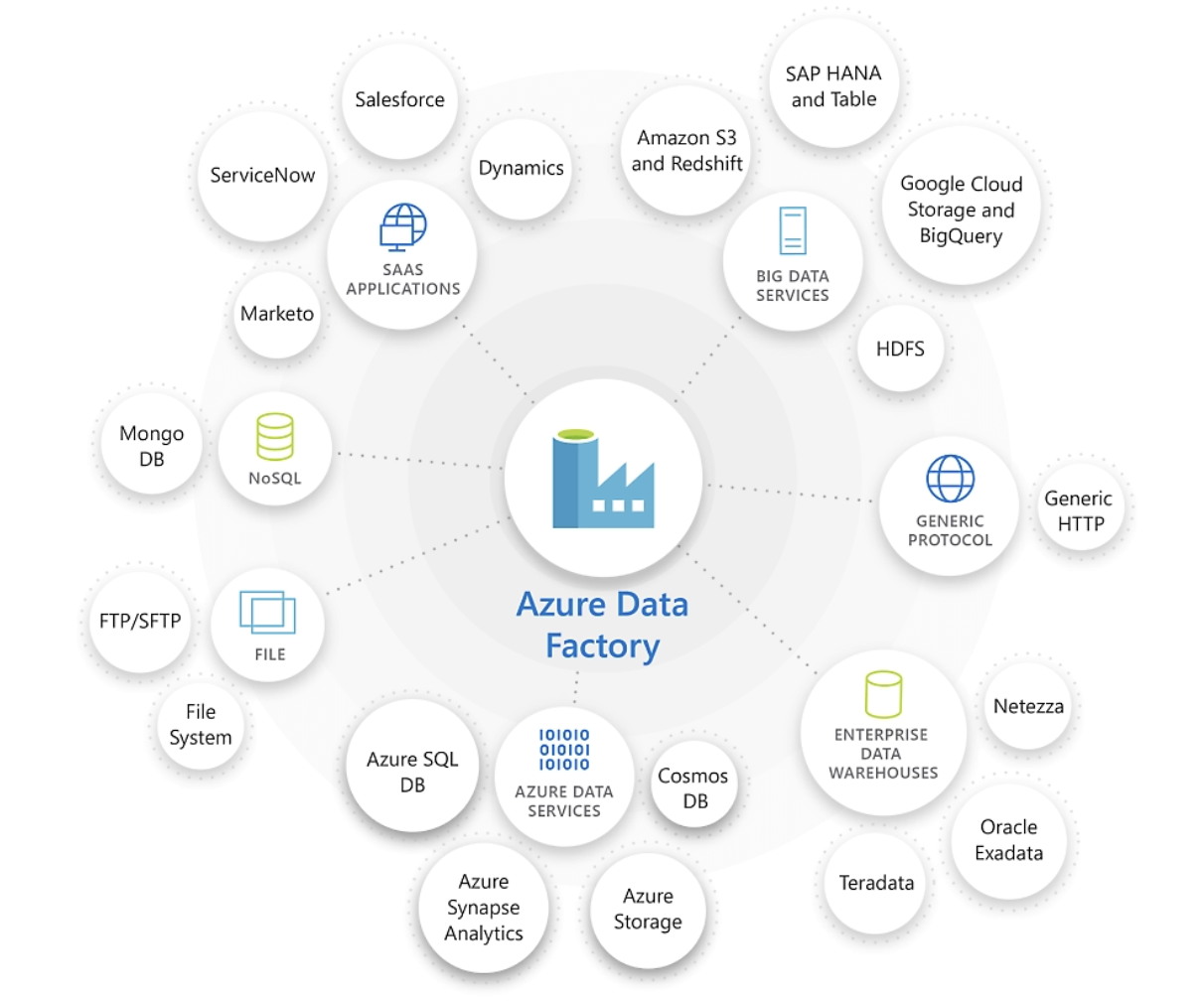

- Integración con una amplia gama de fuentes de datos: ADF admite la integración con fuentes de datos tanto locales como basadas en la nube, lo que lo convierte en una herramienta versátil para equipos con diversos entornos de datos.

- Soporte para transformaciones complejas de datos mediante Flujo de Datos: ADF proporciona capacidades de transformación de datos a través de su función Flujo de Datos, que te permite realizar transformaciones complejas directamente dentro de la canalización.

- Programación y seguimiento: ADF incluye herramientas integradas de programación y supervisión, que te permiten automatizar la ejecución de canalizaciones de datos y supervisar su rendimiento.

- Integración nativa con otros servicios Azure: ADF se integra perfectamente con otros servicios de Azure, como Azure Synapse Analytics y Azure Blob Storageproporcionando una solución integral de gestión de datos dentro del ecosistema Azure.

Como puedes ver, ¡ADF ofrece todo lo que necesitas para crear canalizaciones de datos dentro del ecosistema Azure!

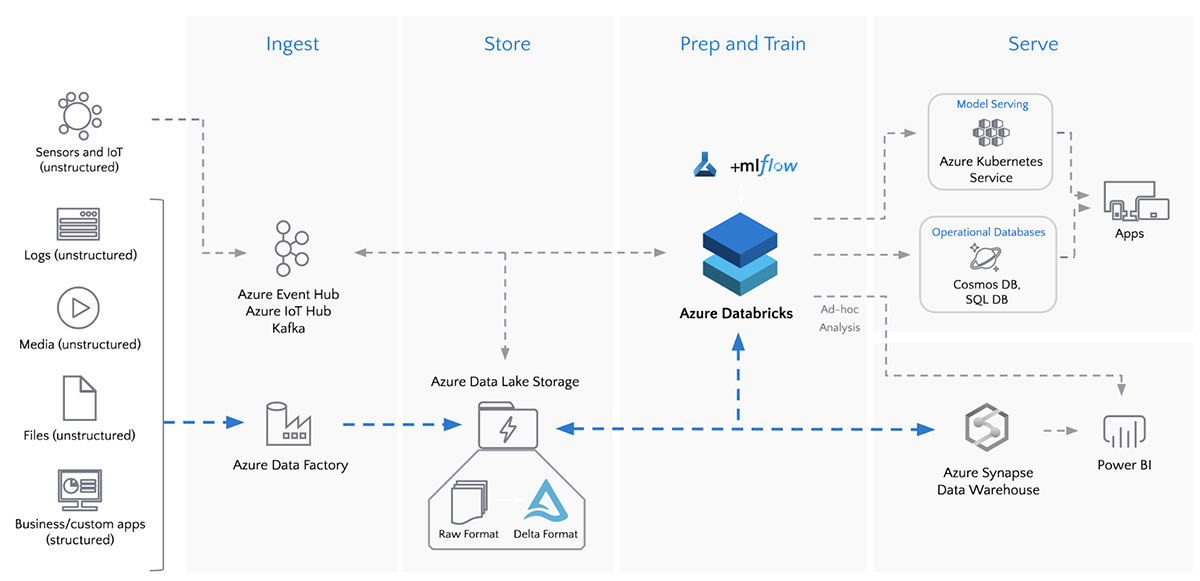

Azure Data Factory destaca en la conexión e integración de diversas fuentes de datos. Fuente de la imagen: Microsoft.

El curso Introducción a Azure es un recurso excelente para los interesados en iniciarse en Azure. El curso de Gestión y Gobernanza de Azure es ideal para los más experimentados.

¿Qué es Databricks?

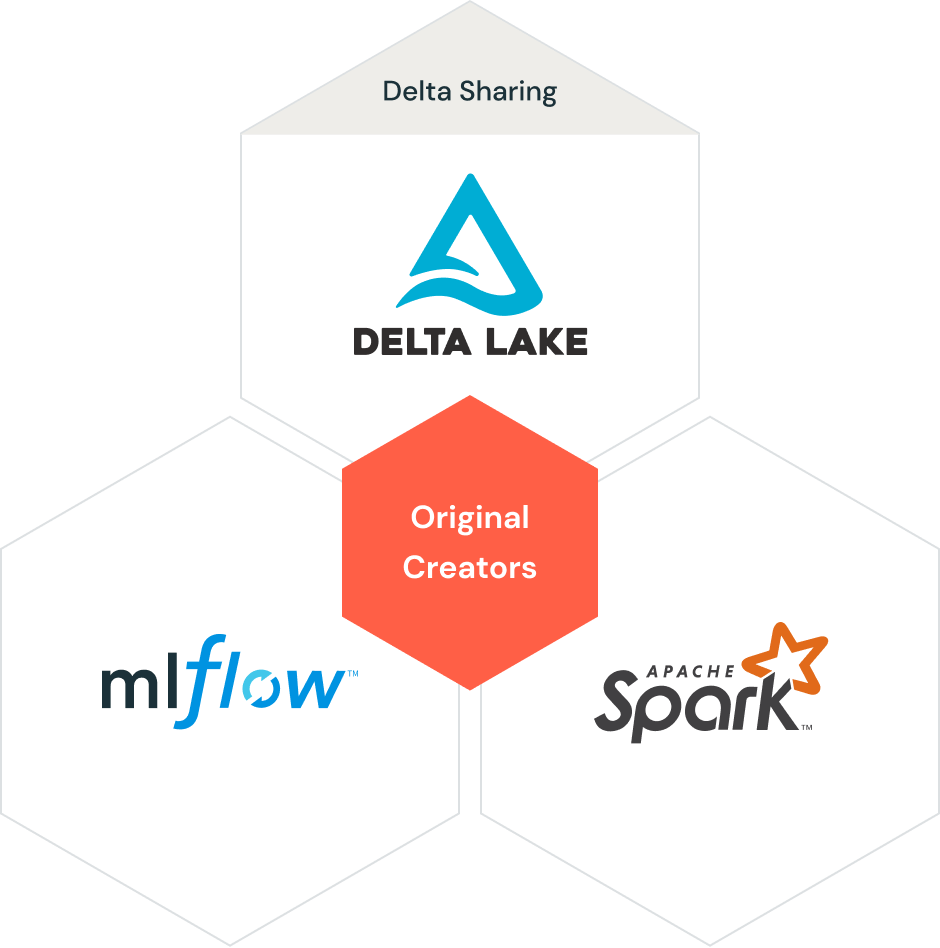

Databricks es una plataforma analítica que proporciona un entorno colaborativo para el procesamiento de big data y el aprendizaje automático. Basado en Apache Spark, Databricks está diseñado para manejar tareas de procesamiento de datos a gran escala, permitiéndote realizar análisis complejos y desarrollar modelos de aprendizaje automático.

Databricks ofrece una plataforma unificada en la que ingenieros de datos, científicos de datos y analistas pueden colaborar para procesar, analizar y visualizar datos en un flujo de trabajo racionalizado.

Características de Databricks

Éstas son algunas de las características que hacen de Databricks una herramienta tan popular:

- Plataforma analítica unificada: Databricks combina el procesamiento de big data y el aprendizaje automático en una única plataforma, lo que te permite realizar análisis de principio a fin en un único entorno.

- Cuadernos colaborativos: Databricks admite cuadernos colaborativos en lenguajes como Python, Scala y SQL, lo que permite a los equipos colaborar en tiempo real en tareas de procesamiento y análisis de datos.

- Procesamiento de datos de alto rendimiento con Apache Spark: Databricks aprovecha la potencia de Apache Spark, un motor de procesamiento de datos distribuido, para manejar grandes conjuntos de datos y realizar transformaciones complejas de forma eficiente.

- Integración con lagos de datos y almacenes de datos: Databricks se integra a la perfección con lagos de datos y almacenes de datos, como Delta Lake, lo que permite un almacenamiento y recuperación de datos eficiente para análisis a gran escala.

- Capacidades avanzadas de análisis e IA/ML: Databricks proporciona herramientas avanzadas de análisis y aprendizaje automático, lo que la convierte en una potente plataforma para desarrollar y desplegar modelos de IA a escala.

- Escalabilidad con clústeres Azure Databricks: Databricks permite a los usuarios escalar rápidamente sus capacidades de procesamiento de datos aprovechando los clústeres de Azure Databricks, garantizando que la plataforma pueda manejar volúmenes de datos y demandas computacionales crecientes.

Elementos de la arquitectura Data Lakehouse de Databricks. Fuente de la imagen: Databricks

¡Ahí lo tienes! Si Databricks llamó tu atención por sus amplias capacidades, puedes empezar con el curso Introducción a Databricks.

Azure Data Factory vs. Azure Data Factory Databricks: Principales diferencias

Llegados a este punto, quizá puedas ver en qué se diferencian ADF y Databricks. Ahora, profundicemos y analicemos dichas diferencias en varias categorías.

Finalidad y casos de uso

Azure Data Factory está diseñado principalmente para la integración y orquestación de datos. Es excelente moviendo datos entre varias fuentes, transformándolos y cargándolos en una ubicación centralizada para su posterior análisis. El ADF es ideal para situaciones en las que necesitas automatizar y gestionar flujos de trabajo de datos en varios entornos.

Por otro lado, Databricks se centra en el procesamiento de datos, la analítica y el aprendizaje automático. Es la plataforma a la que acuden las empresas que desean realizar análisis de datos a gran escala, desarrollar modelos de aprendizaje automático y colaborar en proyectos de ciencia de datos. Databricks es especialmente adecuado para entornos de big data y aplicaciones basadas en IA.

Capacidad de transformación de datos

Azure Data Factory proporciona capacidades de transformación de datos a través de su función Flujo de Datos, que permite a los usuarios realizar diversas transformaciones directamente dentro de la canalización. Aunque potentes, estas transformaciones suelen ser más adecuadas para procesos ETL y pueden no ser tan amplias o flexibles como las que ofrece Databricks.

Databricks, con su base en Apache Spark, ofrece capacidades avanzadas de transformación de datos. Los usuarios pueden aprovechar toda la potencia de Spark para realizar transformaciones complejas, agregaciones y tareas de procesamiento de datos, lo que lo convierte en la opción preferida para escenarios que requieren una gran manipulación y cálculo de datos.

Integración con otros servicios Azure

Tanto ADF como Databricks se integran con otros servicios de Azure, pero lo hacen con enfoques diferentes. ADF está diseñado para ETL y orquestación, lo que lo convierte en la herramienta ideal para gestionar flujos de trabajo de datos que implican múltiples servicios de Azure, como Azure Synapse Analytics y Azure Blob Storage.

Databricks, por su parte, se centra más en la analítica avanzada y la IA, integrándose con servicios como Delta Lake para el almacenamiento de datos y Azure Machine Learning para el despliegue de modelos.

Domina Azure desde cero

Facilidad de uso

La interfaz de arrastrar y soltar de Azure Data Factory hace que sea relativamente fácil de usar, incluso para quienes tienen conocimientos técnicos limitados. Su enfoque en el desarrollo de canalizaciones de bajo código/sin código simplifica la creación y gestión de flujos de trabajo de datos.

Aunque potente, Databricks requiere un mayor nivel de competencia técnica. Su dependencia de la codificación (en lenguajes como Python, Scala y SQL) y sus complejas opciones de configuración lo hacen más adecuado para ingenieros y científicos de datos que se sienten cómodos trabajando con código y marcos de big data.

Escalabilidad y rendimiento

ADF y Databricks son altamente escalables, pero destacan en áreas diferentes. El ADF está diseñado para gestionar tareas de integración y migración de datos a gran escala, por lo que es ideal para orquestar flujos de trabajo ETL complejos.

Databricks, con su base en Apache Spark, ofrece un rendimiento sin igual para el procesamiento y análisis de big data, lo que lo convierte en la opción preferida para escenarios que requieren computación de alto rendimiento y escalabilidad.

Consideraciones sobre los costes

Al considerar el coste de utilizar Azure Data Factory y Databricks, es esencial comprender sus modelos de precios y cómo pueden afectar a tu presupuesto:

- El precio del ADF se basa en el número de actividades de canalización, el movimiento de datos y el volumen de datos. Los costes pueden aumentar con canalizaciones más complejas y mayores volúmenes de datos, pero ADF suele ser rentable para tareas ETL sencillas.

- El precio de Databricks se basa en los recursos informáticos utilizados, que suelen medirse en Unidades Databricks (DBU) por hora. Los costes pueden aumentar significativamente para el procesamiento de datos a gran escala y las cargas de trabajo de aprendizaje automático, especialmente si se requieren clústeres de alto rendimiento.

Al evaluar los costes, ten en cuenta las necesidades específicas de tu organización, como el volumen de datos, la complejidad de las transformaciones y la frecuencia de ejecución de las canalizaciones.

En algunos casos, utilizar ADF para la orquestación y Databricks para el procesamiento puede proporcionar un enfoque equilibrado, aprovechando los puntos fuertes de ambas herramientas a la vez que se gestionan eficazmente los costes.

Azure Data Factory frente a Databricks: Un resumen

A continuación se muestra una tabla comparativa entre Azure Data Factory y Databricks en una amplia gama de aspectos:

|

Categoría |

Azure Data Factory (ADF) |

Databricks |

|

Visión general |

Un servicio de integración de datos basado en la nube para orquestar y automatizar el movimiento y la transformación de datos. |

Una plataforma analítica unificada centrada en el procesamiento de big data y el aprendizaje automático. |

|

Caso de uso principal |

Integración de datos, canalizaciones ETL/ELT, orquestación de datos y automatización del flujo de trabajo. |

Análisis de grandes datos, procesamiento de datos en tiempo real y aprendizaje automático. |

|

Transformación de datos |

Se utiliza principalmente para orquestar transformaciones de datos, utilizando recursos informáticos integrados o externos, como Databricks o pools Spark de Synapse. |

Transformación avanzada de datos a gran escala con Apache Spark y Delta Lake, tanto para procesamiento por lotes como en tiempo real. |

|

ETL/ELT |

Especializado en orquestación ETL/ELT, conectando múltiples fuentes y destinos de datos, con actividades integradas como copiar datos, flujo de datos y servicios Azure. |

Potentes capacidades ETL, especialmente para transformaciones complejas de big data, aprovechando Apache Spark para el procesamiento en memoria. |

|

Motor de cálculo |

No tiene un motor de computación nativo; depende de opciones de computación externas como Azure Databricks, Azure Synapse o Azure HDInsight para la transformación de datos. |

Motor de cálculo basado en Apache Spark para procesamiento en tiempo real y por lotes. |

|

Movimiento de datos |

Ofrece una amplia gama de conectores integrados (por ejemplo, para bases de datos, almacenamiento en la nube, plataformas SaaS), lo que lo hace adecuado para orquestar el movimiento de datos a gran escala en distintos entornos. |

Normalmente se integra con soluciones de almacenamiento como Azure Data Lake, S3 y Delta Lake, pero el movimiento de datos no es el objetivo principal. |

|

Integración de datos |

Sólidas capacidades de integración de datos con soporte para más de 90 conectores, incluidos servicios Azure, bases de datos on-prem y sistemas de terceros. |

La integración de datos se centró principalmente en las plataformas de almacenamiento y procesamiento de big data (Azure Data Lake, Delta Lake). Menos diversidad de opciones de conectores. |

|

Tratamiento de datos |

Aprovecha los flujos de datos para transformarlos a escala mediante un mapeo visual de bajo código. Para transformaciones más avanzadas, utiliza Databricks o Azure Synapse. |

Procesamiento avanzado de datos mediante Spark; optimizado para cargas de trabajo en tiempo real y por lotes a gran escala. |

|

Colaboración |

Colaboración en canalizaciones mediante la integración de Git (Azure DevOps y GitHub). |

Funciones avanzadas de colaboración con Databricks Workspaces y control de versiones integrado con GitHub o Databricks Repos. |

|

Experiencia como desarrollador |

Interfaz de usuario de arrastrar y soltar para crear flujos de trabajo ETL; los usuarios no técnicos pueden crear fácilmente canalizaciones de datos. |

Experiencia avanzada de desarrollador, que ofrece un entorno de bloc de notas y soporte para transformaciones basadas en código (Python, Scala, R, SQL). |

|

Programación y orquestación |

Excelentes capacidades de programación y orquestación, con disparadores y control de ejecución de canalizaciones. |

Capacidades de orquestación limitadas. Los Databricks pueden orquestarse externamente mediante ADF u otras herramientas. |

|

Gobernanza de datos |

Integración con Azure Purview para la gobernanza de datos, el seguimiento del linaje y la gestión de metadatos. |

La gobernanza suele gestionarse externamente, utilizando herramientas como Azure Purview u otras soluciones de terceros. |

|

Monitorización y registro |

Supervisión y registro integrados mediante Azure Monitor, Alertas y el panel de supervisión del ADF. |

Amplias capacidades de registro y supervisión a través de la API REST de Databricks, integración con Azure Monitor y paneles personalizados. |

|

Escalabilidad |

Escala fácilmente con integración y movimiento de datos bajo demanda. Utiliza servicios informáticos externos para escalar el procesamiento de datos. |

Altamente escalable, especialmente para grandes cargas de trabajo de datos y pipelines de aprendizaje automático, con escalado automático del clúster. |

|

Modelo de costes |

Pago por uso basado en el movimiento de datos, la orquestación y los servicios informáticos externos (Databricks, Synapse, etc.) utilizados. |

Pago por uso de almacenamiento y computación. Los clusters pueden autoescalarse para optimizar costes. |

|

Aprendizaje automático |

No incorpora funciones de aprendizaje automático. El aprendizaje automático puede integrarse orquestando servicios como Azure ML o Databricks. |

Bibliotecas de aprendizaje automático integradas, como MLlib, e integraciones con MLflow para el seguimiento y la gestión de modelos. |

|

Seguridad |

Control de acceso basado en roles (RBAC), integración con Azure Active Directory, cifrado de datos incorporado e identidades gestionadas. |

RBAC, cifrado de datos, integración con Azure Active Directory y modelos de seguridad personalizados. |

|

Integración BI |

Puede orquestar canalizaciones de datos y alimentar con datos herramientas de BI como Power BI, Azure Synapse Analytics y otros servicios de Azure. |

Admite la integración con herramientas de BI como Power BI, Tableau y otras para el consumo directo de datos. |

|

Procesamiento de datos en tiempo real |

Puede orquestar la ingesta de datos en tiempo real con disparadores, y utilizar servicios informáticos en tiempo real como Stream Analytics o Databricks. |

Optimizado para el procesamiento de datos en tiempo real mediante Spark Streaming. |

|

Facilidad de uso |

Fácil de usar con una interfaz de bajo código, que facilita a los usuarios no técnicos la creación de canalizaciones de datos. |

Requiere más conocimientos técnicos, ya que está enfocado a ingenieros de big data, científicos de datos y desarrolladores. |

|

Soporte multi-nube |

Centrado principalmente en Azure, pero puede conectarse a algunos otros servicios en la nube mediante conectores. |

Admite entornos multi-nube, incluidos Azure, AWS y GCP. |

|

Despliegue |

Servicio totalmente gestionado con actualizaciones automatizadas y escalado de canalizaciones. |

Servicio gestionado, pero se da más control a los usuarios sobre las configuraciones y el escalado del clúster. |

|

Comunidad y Ecosistema |

Amplia comunidad Azure, con fuerte apoyo de Microsoft e integración en el ecosistema Azure. |

Gran comunidad, con importantes contribuciones de Databricks y de la comunidad de código abierto Apache Spark. |

|

Cumplimiento y certificaciones |

Cumple varias normas del sector, como las certificaciones GDPR, HIPAA e ISO. |

También cumple varias normas y certificaciones del sector, como GDPR, HIPAA y conformidad SOC. |

Cuándo utilizar Azure Data Factory

Azure Data Factory es la opción preferida en escenarios en los que la integración y la migración de datos son las principales preocupaciones. Más concretamente, es ideal para:

- Integración y migración de datos: Cuando las organizaciones necesitan mover datos entre varias fuentes, incluidos los entornos locales y los basados en la nube, el ADF proporciona las herramientas para hacerlo con eficacia.

- Orquestar canalizaciones de datos: El ADF destaca en la gestión y automatización de flujos de trabajo de datos a través de múltiples fuentes de datos, lo que lo hace ideal para organizaciones con entornos de datos complejos.

- Transformaciones de datos de sencillas a moderadas: La función Flujo de Datos del ADF proporciona capacidades suficientes para los procesos ETL que implican transformaciones de datos de básicas a moderadamente complejas.

- Flujos de trabajo ETL que requieren programación y supervisión: Las herramientas integradas de programación y supervisión del ADF facilitan la automatización y el seguimiento del rendimiento de los flujos de trabajo ETL.

Cuándo utilizar Databricks

Databricks es la plataforma de referencia para escenarios que requieren procesamiento de big data, analítica y aprendizaje automático. Es el más adecuado para:

- Procesamiento y análisis de big data: Databricks destaca en el procesamiento de grandes conjuntos de datos, por lo que es ideal para organizaciones que analizan grandes cantidades de datos.

- Aprendizaje automático y desarrollo de modelos de IA: Databricks proporciona herramientas avanzadas para desarrollar e implantar modelos de aprendizaje automático, lo que la convierte en una potente plataforma para aplicaciones basadas en IA.

- Entornos colaborativos de ciencia de datos: Los cuadernos colaborativos de Databricks permiten a los científicos y analistas de datos colaborar en tiempo real, facilitando los proyectos de ciencia de datos en equipo.

- Transformaciones complejas de datos utilizando Apache Spark: Cuando se requiere una manipulación y cálculo de datos pesados, las transformaciones basadas en Apache Spark de Databricks ofrecen la potencia y flexibilidad necesarias para manejar tareas complejas.

Integración de Azure Data Factory y Databricks

En muchos casos, Azure Data Factory y Databricks pueden utilizarse juntos para crear una canalización de datos completa.

ADF puede orquestar la canalización de datos, gestionando la extracción, transformación y carga de datos de diversas fuentes. A continuación, Databricks puede realizar las tareas más complejas de procesamiento y análisis de datos, aprovechando sus capacidades avanzadas de procesamiento de big data y aprendizaje automático.

Por ejemplo, una típica canalización de datos de extremo a extremo puede implicar que ADF extraiga datos de múltiplesfuentes y los cargue en un lago de datos. A continuación, Databricks podría procesar los datos, realizar transformaciones avanzadas y aplicar modelos de aprendizaje automático antes de cargar los resultados en un almacén de datos para su posterior análisis.

ETL por lotes con Azure Data Factory y Azure Databricks. Fuente de la imagen: Databricks

Conclusión

Azure Data Factory y Databricks son herramientas potentes dentro del ecosistema Azure, cada una con sus puntos fuertes y casos de uso ideales. En muchos casos, combinar ADF y Databricks puede proporcionar una solución integral que aproveche lo mejor de ambos mundos.

Quienes deseen profundizar en estas plataformas, pueden explorar los siguientes recursos:

Estos recursos proporcionan una base sólida para comprender Azure Data Factory y Databricks y cómo pueden utilizarse para crear potentes canalizaciones de datos y soluciones analíticas.

Certifícate en el puesto de Ingeniero de Datos de tus sueños

Nuestros programas de certificación te ayudan a destacar y a demostrar que tus aptitudes están preparadas para el trabajo a posibles empleadores.

Preguntas frecuentes

¿Cuáles son las principales diferencias entre Azure Data Factory y Databricks?

Azure Data Factory se utiliza principalmente para la integración, migración y orquestación de datos, mientras que Databricks está diseñado para el procesamiento de big data, la analítica avanzada y el aprendizaje automático.

¿Pueden utilizarse juntos Azure Data Factory y Databricks?

Sí, ADF puede utilizarse para orquestar canalizaciones de datos que impliquen Databricks para tareas complejas de procesamiento de datos, creando una solución integral de gestión de datos.

Qué herramienta es mejor para la transformación de datos: ¿Azure Data Factory o Databricks?

Databricks ofrece capacidades de transformación de datos más avanzadas utilizando Apache Spark, lo que lo hace más adecuado para transformaciones complejas. El ADF es ideal para tareas ETL más sencillas.

¿Cómo se compara el coste de usar Azure Data Factory con el de Databricks?

ADF suele ser más rentable para tareas ETL sencillas, mientras que Databricks puede resultar más caro debido a sus requisitos de recursos informáticos, especialmente para análisis a gran escala y aprendizaje automático.

¿Es Azure Data Factory adecuado para el procesamiento de big data?

Aunque ADF puede manejar grandes volúmenes de datos, se centra más en la integración y orquestación de datos. Para el procesamiento de big data de alto rendimiento, Databricks es la mejor opción.

Consultor Jefe de BI - Certificado en Power BI | Certificado en Azure | ex-Microsoft | ex-Tableau | ex-Salesforce - Autor