Curso

Imagina que tienes un amigo brillante que es increíblemente bueno resolviendo problemas complejos. Sin embargo, cada vez que plantees una nueva pregunta a este amigo, el proceso debe empezar de cero, olvidando por completo todo lo aprendido en problemas anteriores.

Esto sería bastante frustrante, ¿verdad? Ése es exactamente el reto al que nos enfrentamos con los grandes modelos lingüísticos (LLM) cuando se trata de tareas de razonamiento complejas. Los LLM destacan en la generación de texto, pero a menudo tienen dificultades en tareas de razonamiento complejas debido a su incapacidad para retener conocimientos de interacciones anteriores.

Imagina, sin embargo, dar a estos LLM un "cuaderno mental" para almacenar y reutilizar ideas valiosas: ésta es la esencia del Buffer de Pensamientos (BdT) (BdT).

En este tutorial, exploraremos el Buffer of Thoughts (BoT), un nuevo marco que está cambiando la forma en que los LLM resuelven problemas complejos. Empezaré explicando las ideas básicas de BoT, incluyendo el meta-buffer y el gestor de buffers. A continuación, veremos cómo funciona la TdF paso a paso, desde la comprensión del problema hasta la búsqueda y utilización de las plantillas de pensamiento adecuadas: verás cómo la TdF hace que los LLM sean más precisos, eficaces y fiables.

También compartiré algunos impresionantes resultados experimentales de este artículo que muestran lo bien que funciona la BoT en diferentes tareas. Al final de este tutorial, entenderás por qué la BoT es una gran cosa en este momento y cómo puede utilizarse en aplicaciones del mundo real.

¿Qué es el Buffer de Pensamientos (BoT)?

Buffer of Thoughts (BoT) es un nuevo marco diseñado para mejorar la capacidad de razonamiento de los LLM.

La BoT combina dos elementos principales para guiar a los LLM a través de tareas de razonamiento complejas:

- A meta-bufferque es una colección de estrategias de alto nivel para resolver problemas.

- A gestor de búferesun sistema inteligente que organiza y actualiza estas estrategias.

Veamos estos dos componentes con más detalle.

Meta-buffer

El meta-buffer es como una biblioteca de estrategias universales de resolución de problemas. Almacena "plantillas de pensamiento", que son enfoques de alto nivel para resolver problemas. Estas plantillas proceden de diferentes tareas con las que se ha encontrado el LLM.

Piensa en ello como una caja de herramientas llena de herramientas versátiles que pueden adaptarse a muchos trabajos diferentes.

Gestor de búferes

El gestor de búferes es el organizador dinámico del sistema BoT. Su función incluye actualizar el meta-buffer con nuevas plantillas-pensamiento a medida que se resuelven más tareas, seleccionar las plantillas-pensamiento más relevantes para cada nuevo problema y refinar las plantillas existentes en función de su eficacia.

Es como tener un asistente personal que organiza constantemente tus notas, destaca la información más útil y te ayuda a aplicarla a nuevos retos.

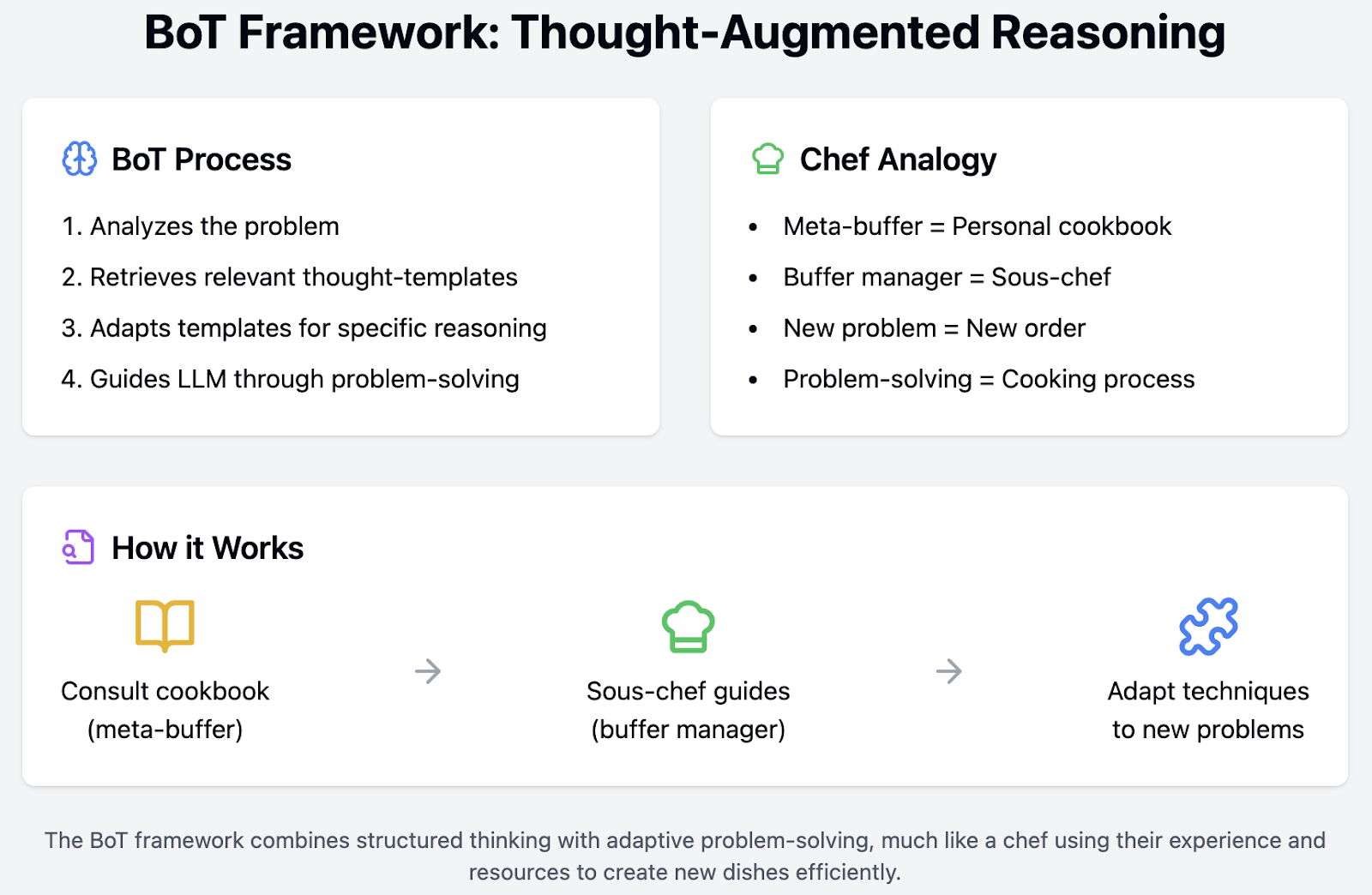

Razonamiento aumentado por el pensamiento

La verdadera magia se produce a través del razonamiento aumentado por el pensamiento. Ante un nuevo problema, el marco de la JdT:

1. Analiza el problema para comprender sus elementos clave.

2. Recupera las plantillas de pensamiento relevantes del meta-buffer.

3. Adapta estas plantillas para crear una estructura de razonamiento específica para el problema.

4. Guía al LLM a través del proceso de resolución de problemas utilizando esta estructura.

Imagina que eres cocinero. El meta-buffer sería tu libro de cocina personal. Este libro de cocina no sólo contiene recetas específicas, sino también diversas técnicas culinarias. Por ejemplo, tiene secciones sobre cómo saltear correctamente las verduras, crear la salsa reductora perfecta o equilibrar los sabores. Estas estrategias de alto nivel pueden aplicarse a una amplia gama de platos.

Ahora, imagina que también tienes un sous-chef que es extremadamente organizado y experto. Este sous-chef es tu gestor de parachoques. Te ayudan a decidir qué técnicas de tu libro de cocina son las más adecuadas para el plato que estás preparando en ese momento. Mientras cocinas, el sous-chef toma notas de lo que ha funcionado bien y lo que no, actualizando tus técnicas y estrategias en consecuencia.

Cuando llega un nuevo pedido, no empiezas de cero. En lugar de eso, consulta tu libro de cocina (meta-buffer) para conocer las mejores técnicas y confía en tu sous-chef (gestor del buffer) para que te guíe por el proceso de forma eficiente. El sous-chef recuerda lo que ha funcionado mejor con platos similares en el pasado y te ayuda a ajustar tu enfoque, asegurándose de que la comida se prepara rápidamente y al más alto nivel.

He aquí cómo funcionaría el proceso en tu cocina:

- Analiza el pedido: Tú (el chef) analizas el nuevo pedido para comprender sus elementos clave: qué tipo de plato es, qué ingredientes se necesitan y cualquier petición especial del cliente.

- Recupera las técnicas pertinentes: Tu sous-chef (gestor del buffer) recupera las técnicas culinarias relevantes (plantillas-pensamiento) de tu libro de cocina (meta-buffer). Por ejemplo, pueden sugerir un método específico para cocinar el ingrediente principal y otro para elaborar una salsa complementaria.

- Adapta las técnicas: Juntos, adaptáis estas técnicas para crear un plan específico para el nuevo plato. Esto puede implicar retocar una receta de salsa para adaptarla al ingrediente principal o ajustar los tiempos de cocción en función del tamaño de las raciones.

- Guía el proceso de cocción: Utilizando este plan a medida, preparas el plato guiado por el enfoque estructurado que tú y tu sous-chef habéis creado.

Cómo funciona el Buffer de Pensamientos (BoT)

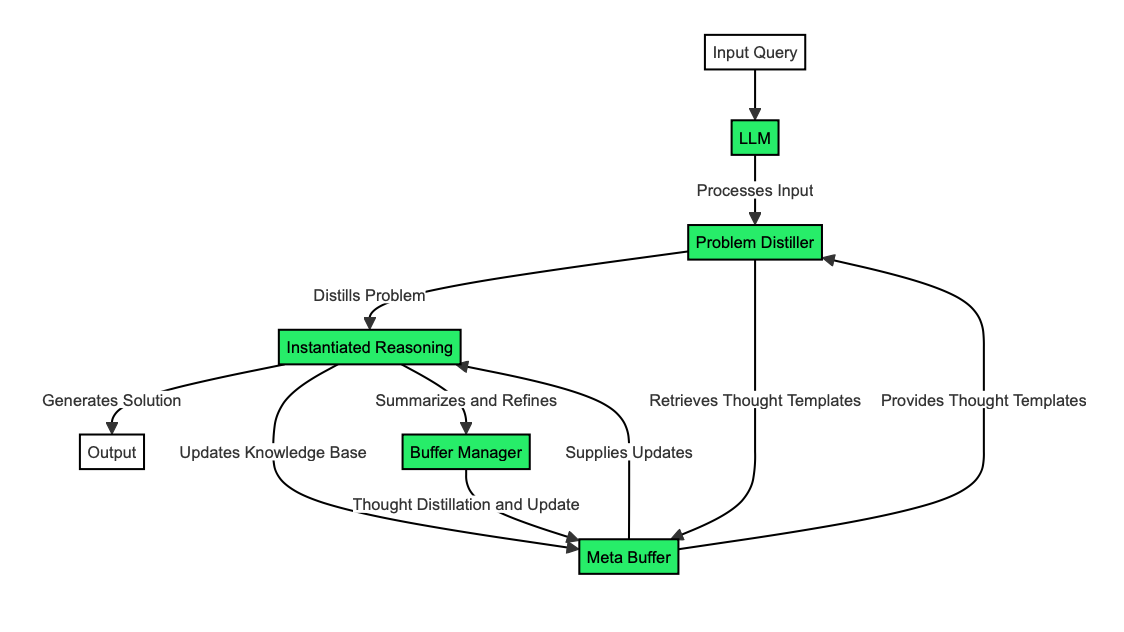

Ahora que entendemos qué es la BoT y sus componentes clave, podemos echar un vistazo a cómo funciona entre bastidores. Lo desglosaremos en cuatro elementos:

- Destilador de problemas

- Metabuffer y recuperación del pensamiento

- Razonamiento instanciado

- Gestor de búferes

Destilador de problemas

El destilador de problemas funciona como un hábil traductor, convirtiendo problemas complejos en un lenguaje que la BoT pueda entender fácilmente y con el que pueda trabajar.

Imagínatelo como un lector meticuloso que extrae la información crítica y las limitaciones del problema de entrada, de forma parecida a como se subrayan las partes más importantes del capítulo de un libro de texto.

Una vez que el destilador de problemas ha identificado estos elementos clave, los organiza en conceptos y estructuras de alto nivel. Este proceso puede compararse con la creación de un resumen conciso de un artículo largo, centrándose en las ideas principales y omitiendo los detalles innecesarios.

Por ejemplo, supón que te dan un problema complejo sobre horarios de trenes. El destilador de problemas extraería cuidadosamente elementos esenciales como "velocidades de los trenes", "horas de salida" y "distancia entre estaciones". A continuación, organizaría estos elementos en un formato estructurado que sea fácil de procesar y comprender para la JdT.

Metabuffer y recuperación del pensamiento

El meta-buffer es el banco de conocimientos de la BoT, que almacena y organiza las plantillas de pensamiento para facilitar su acceso. Contiene plantillas de pensamiento y sus descripciones, categorizándolas para una recuperación eficaz.

Es como una biblioteca bien organizada en la que cada libro (pensamiento-plantilla) tiene una descripción detallada y está colocado en la sección adecuada.

Cuando la BoT necesita recuperar una plantilla de pensamiento, encuentra la más relevante comparando el problema destilado con las descripciones de las plantillas. Este proceso es similar al de un bibliotecario que encuentra rápidamente el libro perfecto basándose en tu descripción de lo que necesitas.

La BoT también puede reconocer cuándo una tarea es totalmente nueva y requiere una nueva plantilla de pensamiento. Es como darte cuenta de que necesitas crear una nueva categoría en tu biblioteca personal para un tipo único de libro.

Siguiendo nuestro ejemplo del problema del tren, BoT tendría varias plantillas de pensamiento en su meta-buffer, cada una con una descripción detallada. Por ejemplo, algunas plantillas pueden estar relacionadas con la gestión del tiempo, otras con el razonamiento espacial y otras con las estrategias de optimización.

Cuando BoT se encuentra con el problema del horario del tren, recupera la plantilla de pensamiento más relevante comparando los elementos destilados del problema, como "velocidad de los trenes", "horas de salida" y "distancia entre estaciones", con las descripciones de su meta-buffer. Por ejemplo, la BoT podría seleccionar un modelo de pensamiento especializado en programación y optimización del tiempo para abordar este problema con eficacia.

Supongamos que la BoT reconoce que el problema del horario del tren implica un elemento único que nunca ha encontrado antes, como un tipo inusual de restricción o un objetivo de optimización novedoso. En ese caso, puede identificar que esta tarea es totalmente nueva y requiere un nuevo pensamiento-plantilla.

Supongamos que el problema consiste en coordinar los horarios de múltiples modos de transporte (trenes, autobuses, vuelos). En ese caso, la BoT podría crear y almacenar una nueva plantilla de pensamiento que aborde la programación multimodal, asegurándose de estar mejor preparada para problemas similares en el futuro.

De este modo, el meta-buffer permite a la BoT almacenar, recuperar y crear eficientemente nuevas estrategias para la resolución de problemas, mejorando su capacidad para manejar tareas complejas.

Razonamiento instanciado

Aquí es donde la BoT aplica las plantillas de pensamiento seleccionadas para resolver el problema específico en cuestión.

Para las plantillas existentes, la plantilla de pensamiento recuperada se adapta para ajustarse al problema actual. Es parecido a utilizar una receta, pero ajustando los ingredientes y las cantidades para un grupo más grande. La BoT afina el modelo de pensamiento para adaptarlo a las particularidades del problema, garantizando una solución personalizada y eficaz.

Cuando se enfrenta a una nueva tarea para la que no hay plantillas disponibles, la BoT recurre a plantillas predefinidas de uso general. Piensa en ello como si utilizaras técnicas básicas de cocina para preparar un plato que nunca has hecho antes. Basarse en principios fundamentales permite a la BoT navegar por problemas desconocidos y desarrollar nuevas estrategias según sea necesario.

Para nuestro problema de programación de trenes, la BdT recuperaría una plantilla de pensamiento centrada en la optimización del tiempo y la programación. Para ajustarse al problema actual, la JdT adaptaría esta plantilla. Por ejemplo, si el pensamiento-plantilla original incluye un método para optimizar el horario de un solo tren, BoT lo modifica para manejar múltiples trenes, velocidades variables y diferentes horas de salida. Este enfoque a medida garantiza que todos los trenes circulen con eficacia y puntualidad, teniendo en cuenta las limitaciones exclusivas del problema actual.

Pero ahora, supongamos que la BoT se encuentra con un nuevo aspecto del problema de los horarios de trenes, como integrar los horarios de trenes con los de autobuses y vuelos para crear un sistema de transporte multimodal sin fisuras. Como no existe una plantilla de pensamiento para este escenario concreto, la BoT utiliza plantillas predefinidas de uso general. La BoT podría aplicar principios fundamentales de programación y optimización, como dividir el problema en partes más pequeñas, analizar cada modo de transporte por separado y luego integrar las soluciones. A través de este proceso, la BoT puede desarrollar nuevas estrategias y plantillas, mejorando su capacidad para abordar problemas similares de programación multimodal en el futuro.

Gestor de búferes

El gestor de búferes es el componente de aprendizaje y optimización del sistema, que mejora constantemente la base de conocimientos de la BoT.

En el proceso de destilación de la plantilla, el gestor del buffer resume el proceso de resolución del problema en pensamientos de alto nivel. Es como redactar un documento de "lecciones aprendidas" tras completar un proyecto, captando la esencia de lo que fue eficaz y por qué.

Para las actualizaciones dinámicas, el gestor de la memoria intermedia actualiza la meta memoria intermedia con nuevas plantillas de pensamiento. Utiliza umbrales de similitud para decidir si añadir nuevas plantillas o actualizar las existentes, garantizando que el meta-buffer siga siendo ligero y eficiente. Es como si un cocinero perfeccionara constantemente su libro de recetas, añadiendo nuevas técnicas y mejorando las existentes, pero manteniendo el libro conciso y práctico.

Imagina que la BoT acaba de resolver un complejo problema de programación de trenes que implica varios trenes, velocidades distintas y diferentes horas de salida. Tras completar esta tarea, el gestor del buffer resume el proceso de resolución del problema en reflexiones de alto nivel, captando las estrategias clave que funcionaron bien, como las técnicas específicas para optimizar los horarios solapados o gestionar las horas punta de viaje.

Ahora, supongamos que la BoT se encuentra en el futuro con un problema de programación de trenes similar pero ligeramente distinto. El gestor del buffer actualiza el meta-buffer con nuevas plantillas-pensamiento basadas en esta experiencia. Por ejemplo, si el nuevo problema implica integrar los horarios de los trenes con los de los autobuses, el gestor de la memoria intermedia podría perfeccionar la plantilla de programación de trenes existente para incluir técnicas de integración multimodal.

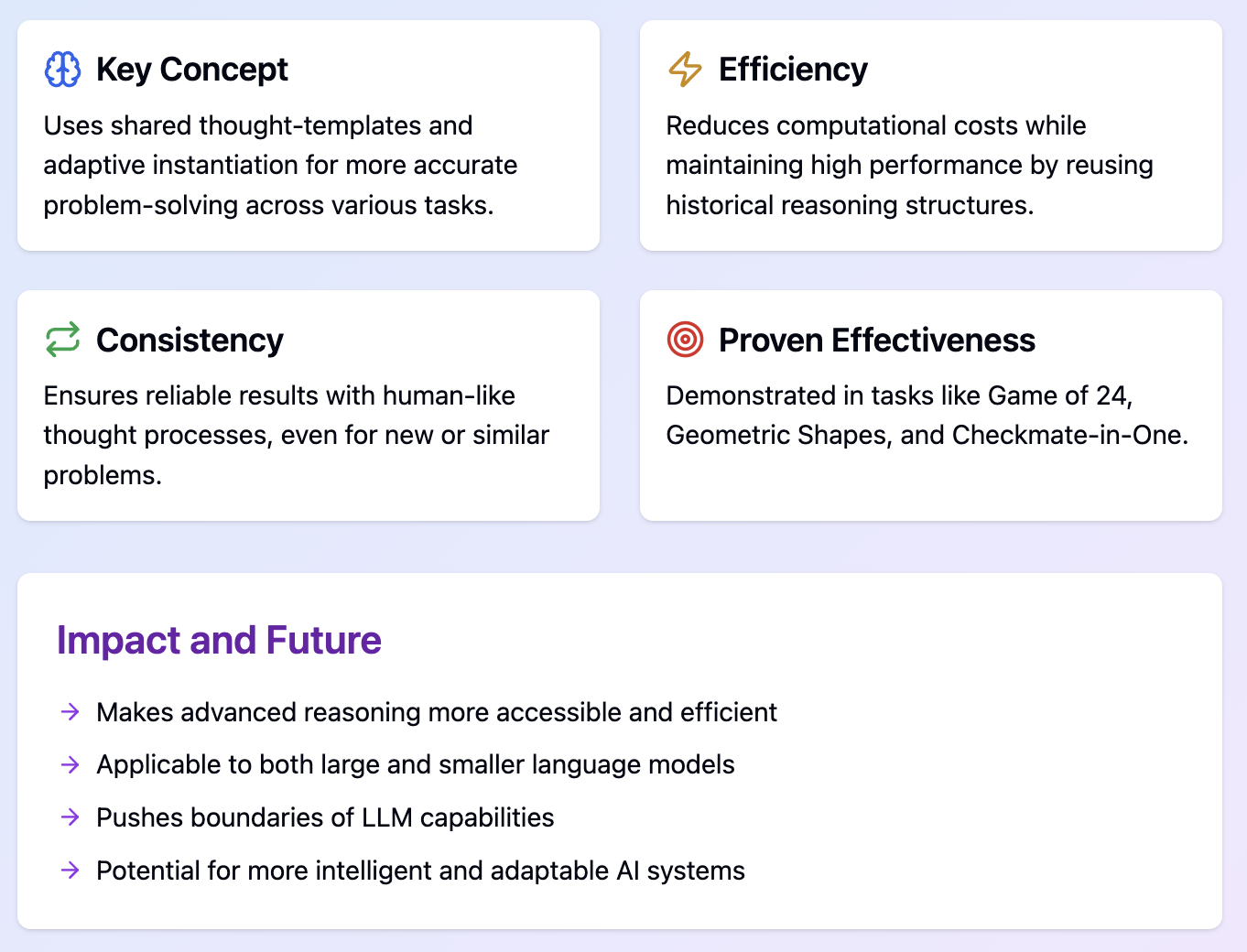

Beneficios del Buffer de Pensamientos (BoT)

El marco del Buffer of Thoughts (BoT) ofrece varias ventajas significativas para desarrollar el razonamiento LLM, como la mejora de la precisión, la eficacia del razonamiento y la robustez del modelo.

Mejora de la precisión

BoT mejora significativamente la precisión de razonamiento de los LLM mediante su nuevo enfoque:

- Plantillas de pensamiento compartidas

- Los LLM comienzan con una base sólida para cada tarea.

- Para ello se utiliza una biblioteca de estrategias probadas de resolución de problemas.

- Instanciación adaptativa

- La TdO no se limita a aplicar rígidamente las plantillas de pensamiento.

- Los adapta al problema concreto que se plantea.

- Enfoque coherente

- La BoT reduce las posibilidades de errores aleatorios.

- Esto se consigue utilizando estrategias similares para problemas similares.

Eficacia del razonamiento

BoT mejora drásticamente la eficacia del razonamiento LLM, ahorrando tiempo y recursos informáticos:

- Utilización de estructuras históricas: En lugar de empezar de cero cada vez, BoT reutiliza y adapta patrones de razonamiento probados.

- Proceso racionalizado: BoT evita la necesidad de complejos procesos de consultas múltiples, habituales en otros métodos de razonamiento LLM.

- Carga computacional reducida: La BoT requiere mucha menos potencia de procesamiento para cada tarea al reutilizar las plantillas de pensamiento.

Robustez del modelo

La BoT mejora la robustez de los LLM, haciéndolos más fiables y consistentes en varias tareas:

- Enfoque coherente de resolución de problemas: La TdO garantiza que problemas similares se aborden de forma similar utilizando un proceso de pensamiento estructurado, similar al humano.

- Adaptabilidad a nuevos escenarios: La capacidad del marco para reconocer nuevas tareas y aplicar plantillas generales lo hace robusto en situaciones desconocidas.

- Sensibilidad reducida a las variaciones de entrada: La TdF se ve menos afectada por pequeños cambios en el enunciado de los problemas porque se centra en estructuras de pensamiento de alto nivel.

Resultados experimentales

El marco del Buffer of Thoughts (BoT) se ha probado en una amplia gama de tareas con resultados impresionantes. Para obtener información más detallada, consulta el papel y repositorio GitHubdonde se presentan con más detalle los resultados tratados en esta sección.

BoT se evaluó en 10 tareas exigentes de razonamiento intensivo, mostrando versatilidad y eficacia. Estas tareas incluían:

- Juego de 24

- Formas geométricas

- Checkmate-en-Uno

- Clasificar palabras

Estas tareas se eligieron para representar una variedad de escenarios de razonamiento complejo, desde la resolución de problemas matemáticos hasta el juego estratégico y la manipulación del lenguaje.

BoT demostró mejoras significativas de rendimiento respecto a los métodos anteriores más avanzados:

- 11% de mejora en Juego de 24

- 20% de mejora en Formas geométricas

- Mejora del 51% en Checkmate-in-One

Lo más impresionante es que BoT ha conseguido estos resultados con sólo un 12% del coste computacional de los métodos de consulta múltiple.

También se comprobó que la aplicación de BoT con modelos lingüísticos más pequeños, como Llama3-8Btiene potencial para superar el rendimiento de modelos más grandes como Llama3-70. Este hallazgo demuestra que la BoT puede mejorar significativamente las capacidades de modelos lingüísticos más compactos y eficientes.

Estos resultados demuestran que la BoT puede mejorar la precisión sin dejar de ser eficiente y robusta en diferentes tareas de razonamiento. Los resultados constantes ponen de relieve las mejoras de rendimiento fiables de la BoT. Sin embargo, son necesarias más verificaciones y pruebas independientes en tareas más diversas para comprender plenamente las capacidades y limitaciones de la BoT.

Conclusión

Hemos cubierto mucho terreno hoy, así que terminemos con algunos puntos clave y reflexiones sobre hacia dónde se dirige la BoT.

Esto es todo para nuestra exploración del Buffer de Pensamientos. Espero que este tutorial te haya proporcionado una comprensión clara de sus conceptos clave, funcionamiento, ventajas e impacto potencial en el razonamiento de la IA.

Gracias por leer, ¡y hasta la próxima!

Si quieres aprender más sobre ingeniería rápida, te recomiendo estos blogs:

Preguntas frecuentes

¿Puede integrarse la BdT en las arquitecturas LLM existentes, o requiere un modelo completamente nuevo?

La BoT está diseñada como un marco complementario que puede integrarse en las arquitecturas LLM existentes. Debería mejorar su capacidad de razonamiento sin requerir una revisión completa del modelo.

¿Existen limitaciones o inconvenientes en el uso de la SdT que debamos conocer?

Entre las limitaciones potenciales se incluyen la excesiva dependencia de las plantillas de pensamiento existentes para los problemas nuevos, la sobrecarga computacional en la gestión del meta-buffer y los retos para mantener el buffer actualizado con la evolución del conocimiento.

¿Hasta qué punto es escalable la BoT para modelos lingüísticos o conjuntos de datos extremadamente grandes?

La BoT está diseñada para ser eficiente, pero la escalabilidad para modelos muy grandes dependería de los detalles de implementación. El tamaño y la frecuencia de actualización del meta-buffer pueden necesitar optimización para escalas extremas.

¿Cómo gestiona BoT la información conflictiva o contradictoria en su meta-buffer?

La TdC emplea estrategias de resolución de conflictos, sopesando la fiabilidad y relevancia de las diferentes plantillas de pensamiento. El gestor del búfer desempeña un papel importante a la hora de resolver conflictos y actualizar las plantillas en consecuencia.

¿Qué tipo de recursos informáticos se necesitan para aplicar eficazmente la TdF?

El BoT pretende mejorar la eficiencia, por lo que no debería requerir muchos más recursos que los LLM estándar. Sin embargo, los requisitos exactos dependerían de la escala de la aplicación y de la complejidad de las tareas.