La Inteligencia Artificial (IA) está transformando Europa a un ritmo asombroso, con más de un tercio de las empresas europeas adoptarán la IA en 2023. Con esta rápida evolución surge la necesidad acuciante de marcos reguladores sólidos que garanticen que las tecnologías de IA son éticasseguras y beneficiosas.

En EE. UU., se publicó el Proyecto de Declaración de Derechos de la IA US Blueprint for AI Bill of Rights y en China se publicaron las Medidas de la IA Generativa en China. Ahora la UE (Unión Europea) ha dado un paso importante al publicar la Ley de AI de la UE.

La Ley de la IA de la UE es una iniciativa innovadora elaborada por la Oficina Europea de IA para regular el futuro de la IA en Europa.

En esta guía resumida, trataremos la Ley de IA de la UE, sus disposiciones clave y cómo afectará a las empresas y los particulares dentro de la UE y en todo el mundo. Si tienes ganas de ponerte manos a la obra con el aprendizaje, echa un vistazo a nuestro programa de habilidades Fundamentos de la Ley de IA de la UE y apúntate a nuestro seminario web sobre Comprender la normativa sobre IA en EE. UU., la UE y en todo el mundo.

¿Qué es la Ley de IA de la UE?

La Ley de IA de la UE es un amplio marco regulador que regula el despliegue y uso de los sistemas de IA en el mercado europeo. Su objetivo es proteger los derechos individuales y garantizar la seguridad y la transparencia de las tecnologías de IA, fomentando al mismo tiempo la innovación en toda la Unión Europea. Al establecer normas estrictas y requisitos de cumplimiento, la Ley aspira a situar a la UE como líder mundial en la gobernanza de la IA.

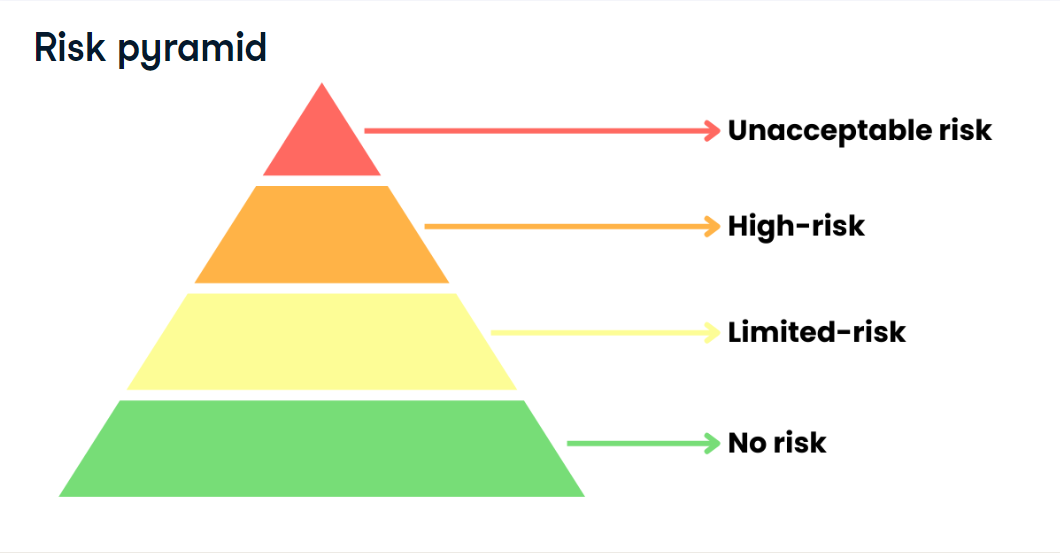

La ley clasifica los sistemas de IA en cuatro niveles de riesgo: inaceptable, alto, limitado y mínimo. Prohíbe las aplicaciones que plantean riesgos inaceptables, como el crédito social gestionado por el gobierno, e impone requisitos estrictos a los sistemas de alto riesgo. La Ley también incluye salvaguardias para la IA de uso general, restricciones a la identificación biométrica y prohibiciones de la IA que explote las vulnerabilidades de los usuarios.

Publicada el 1 de agosto de 2024, tras su aprobación por el Parlamento Europeo y el Consejo de la UE, la Ley tiene plazos de aplicación escalonados en función del tipo de sistema de IA, con prohibiciones de "riesgo inaceptable" a partir de seis meses y normativas de IA de uso general a partir de 12 meses. El incumplimiento puede dar lugar a multas de hasta 35 millones de euros o el 7 % de los ingresos anuales globales, si esta cifra es superior.

La necesidad de regular la IA

Hemos explorado el concepto de regulación en la IA en el podcast de DataFramed sobre confianza y regulación en la IA con Bruce Schneier. Hemos asistido a un gran cambio en el estado de la IA en los últimos años, y el ritmo del cambio es cada vez mayor.

Como sociedad, debemos seguir el ritmo de estas innovaciones para garantizar que los usuarios finales estén protegidos de los riesgos que plantean. También debemos considerar la ética de la IA y disponer de marcos que garanticen su uso responsable. Hay que hacer hincapié en que las organizaciones que crean y aplican estas potentes herramientas de IA lo hagan de forma ética y en interés del público, y no simplemente con ánimo de lucro.

Como explica Bruce Schneier, criptógrafo, profesional de la seguridad informática y especialista en privacidad,

la IA simula ser una persona. La IA simula tener una relación contigo. Y no es así. Y es la confianza social. Así, del mismo modo, confías en tu teléfono, en tu motor de búsqueda, en tu proveedor de correo electrónico. Es una herramienta y, como todas esas cosas, es una herramienta bastante poco fiable. ¿Verdad? Tu teléfono, tu proveedor de correo electrónico, tu plataforma de redes sociales. Todos te espían, ¿verdad? Todos actúan en contra de tus intereses. Lo que me preocupa es que la IA vaya a ser lo mismo, que la IA esté fundamentalmente controlada por grandes empresas con ánimo de lucro.

Bruce Schneier, Security Technologist

Disposiciones clave de la Ley de IA de la UE

Los componentes clave de la Ley de IA de la UE son:

1. Clasificación basada en el riesgo

Los sistemas de IA suelen clasificarse en cuatro categorías principales de riesgo según la Ley de IA de la UE:

- Riesgo inaceptable

- Alto riesgo

- Riesgo limitado

- Riesgo mínimo/sin riesgo.

Según el Informe de la Comisión Europea sobre la Ley de IAcada una de ellas se clasifica en función de dos factores principales:

- Sensibilidad de los datos implicados

- El caso concreto de uso o aplicación de la IA

Los requisitos varían para cada categoría de riesgo, y la mayor parte del texto de la ley se refiere a los sistemas de IA de alto riesgo.

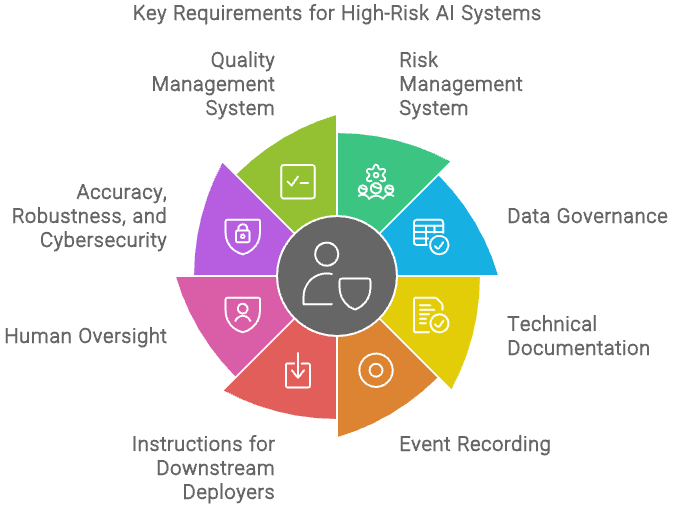

2. Requisitos de los sistemas de IA de alto riesgo

En cuanto a la categoría de alto riesgo, la Ley de IA de la UE impone requisitos que las organizaciones deben cumplir para que estos sistemas puedan implantarse en el mercado de la UE.

Entre ellos están:

- Disponer de un sistema de gestión de riesgos para el ciclo de vida del sistema.

- Crear programas de gobernanza de datos para garantizar que los conjuntos de datos de formación, validación y prueba sean pertinentes y suficientemente representativos. La conducta debe realizarse de la mejor manera posible para que no contenga errores y sea completa de acuerdo con la finalidad prevista.

- Registra la documentación técnica para demostrar el cumplimiento a las autoridades cuando evalúen la conformidad.

- Diseñar su sistema para registrar automáticamente los acontecimientos relevantes para la identificación de riesgos a nivel nacional y modificaciones sustanciales para el mantenimiento de registros. Esto debe hacerse durante todo el ciclo de vida del sistema.

- Proporcionar a los implantadores posteriores instrucciones de uso para permitir el cumplimiento.

- Diseñar para que los implantadores puedan aplicar la supervisión humana.

- Diseñar para alcanzar niveles adecuados de precisión, robustez y ciberseguridad.

- Establecer un sistema de gestión de la calidad para el cumplimiento.

Se especifican en el apartado Cumplimiento de los requisitos (Art. 8–17).

Requisitos de los sistemas de IA de alto riesgo - Creado con Napkin.ai

Además, la Ley exige que las organizaciones garanticen que su personal y otras personas implicadas en el desarrollo o el uso de sistemas de IA posean suficientes conocimientos de IA. Esto incluye comprender la tecnología, sus aplicaciones y los riesgos potenciales.

Las empresas son responsables de proporcionar la formación adecuada para garantizar que los sistemas de IA se manejan de forma responsable y ética, de acuerdo con los contextos específicos de su uso. Más adelante en este artículo, exploraremos cómo DataCamp for Business puede ayudar a tu organización a aumentar sus niveles de alfabetización en IA.

3. Prácticas de IA prohibidas

La Ley de AI de la UE prohíbe explícitamente determinadas prácticas que se consideran inaceptables y suponen riesgos extremos para las personas o la sociedad. Entre ellas están:

- Sistemas de IA que explotan las vulnerabilidades de grupos específicos (por ejemplo, niños, personas con discapacidad).

- Crédito social basado en el análisis de IA del comportamiento

- Uso de técnicas subliminales para manipular comportamientos

Estas prácticas se especifican en Prácticas prohibidas (Art. 5).

Categorías de riesgo según la Ley de IA de la UE

La Ley de IA de la UE clasifica los sistemas de IA en cuatro niveles de riesgo: riesgo inaceptable, alto riesgo, riesgo limitado y riesgo mínimo o nulo. Cada categoría tiene requisitos y medidas reguladoras distintos. En general, a mayor riesgo, más obligaciones normativas.

Fuente: Curso de Introducción a la Ley de IA de la UE, DataCamp

1. Riesgo inaceptable

Se prohíben los sistemas de IA que supongan un riesgo inaceptable para la seguridad o los derechos de las personas. Algunos ejemplos son las aplicaciones de IA que manipulan el comportamiento humano, explotan vulnerabilidades o permiten el escrutinio social por parte de los gobiernos.

Según Artículo 5, Prácticas de IA prohibidasestos sistemas no pueden comercializarse ni utilizarse en la Unión Europea.

Aquí tienes un resumen de las prácticas de IA prohibidas:

- Desplegar sistemas de IA que puedan manipular el comportamiento, las decisiones o las opiniones humanas mediante técnicas subliminales.

- Utilizar sistemas de IA para explotar las vulnerabilidades de grupos concretos (por ejemplo, niños, ancianos con discapacidades).

- Despliegue del crédito social basado en el análisis del comportamiento por IA

- Modelos de IA que implican la clasificación de personas físicas o grupos de personas

- Predecir el riesgo de que una persona física cometa una infracción penal

- Utilizar sistemas de IA que utilicen imágenes faciales de Internet o grabaciones de CCTV para el reconocimiento facial.

- Utilizar la IA para inferir las emociones de una persona física en los ámbitos laboral y educativo

- Categorizar individualmente a las personas físicas en función de sus datos biométricos

- Utilizar sistemas de identificación biométrica a distancia "en tiempo real" que no sean para fines policiales

2. Alto riesgo

Un sistema de IA de alto riesgo, según las Reglas de clasificación para sistemas de IA de alto riesgo (Art. 6), es aquella en la que el sistema de IA está destinado a utilizarse como componente de seguridad de un producto y debe someterse a una evaluación de conformidad por parte de un tercero.

Además, cualquier sistema de IA, como se indica en el Anexo IIIperteneciente a los siguientes casos de uso también se considerará un sistema de IA de alto riesgo:

- Biometría

- Infraestructuras críticas

- Educación

- Empleo

- Servicios esenciales

- Aplicación de la ley

- Migración

- Justicia

3. Riesgo limitado

Los sistemas de IA clasificados como de "riesgo limitado" son los que plantean algunos riesgos potenciales para las personas o la sociedad, pero no se consideran de alto riesgo o inaceptables. Estos sistemas no requieren la estricta supervisión reglamentaria que se aplica a la IA de alto riesgo, pero aun así deben cumplir obligaciones específicas de transparencia.

Para los sistemas de IA de riesgo limitado, la Ley suele exigir a los proveedores que garanticen que los usuarios son conscientes de que están interactuando con un sistema de IA. Esto significa, por ejemplo, que los chatbots u otras interfaces basadas en IA deben revelar claramente que el usuario está interactuando con IA en lugar de con un humano. Esta medida de transparencia pretende evitar confusiones y garantizar que los usuarios estén informados sobre la naturaleza de la tecnología con la que interactúan.

Aunque los sistemas de IA de riesgo limitado están sujetos a estas obligaciones de transparencia, no están sujetos a los requisitos de cumplimiento más rigurosos que se aplican a los sistemas de alto riesgo, como la documentación exhaustiva, los procesos de gestión de riesgos o las evaluaciones obligatorias. Esta categoría está diseñada para equilibrar la necesidad de concienciar a los usuarios con el fomento de la innovación, sin sobrecargar a los desarrolladores y proveedores con una regulación pesada.

Los sistemas de IA que utilizan IA de propósito general (GPAI), como los modelos GPT-4, Midjourney y LLaMA de Meta, también están regulados en esta categoría.

Fuente: Curso de Introducción a la Ley de IA de la UE, DataCamp

Un modelo GPAI es un modelo de IA entrenado con una gran cantidad de datos mediante autosupervisión a escala que muestra una generalidad significativa y puede llevar a cabo una amplia gama de tareas distintas con una gran variedad de integraciones con sistemas o aplicaciones posteriores.

Independientemente de los casos de uso de estos modelos GPAI, se aplican las normas de la Ley de IA de la UE.

Estos son los requisitos:

- Debe registrarse la documentación técnica.

- La información y la documentación deben facilitarse a los proveedores posteriores.

- Hay que elaborar una política que respete la Directiva sobre derechos de autor.

- Debe redactarse un resumen detallado del contenido utilizado para entrenar el modelo GPAI.

Puedes encontrar más información en Artículo 53: Obligaciones de los proveedores de modelos de IA de propósito general.

Si el GPAI resulta ser un Modelo de IA de propósito general con riesgo sistémicose requiere un conjunto diferente de obligaciones de acuerdo con Artículo 55: Obligaciones de los proveedores de modelos de IA de propósito general con riesgo sistémico.

4. Riesgo mínimo

La categoría de riesgo mínimo es una categoría no regulada.

Algunos ejemplos de estos sistemas de IA pueden ser

- Videojuegos con IA

- Filtros de spam.

No existe ninguna regulación actual para los sistemas de IA de esta categoría en la Ley de IA de la UE.

Impacto global en el mercado de la IA

Se espera que la Ley de IA de la UE tenga implicaciones de gran alcance tanto para las personas como para las organizaciones. La ley también se verá probablemente afectada por la futura reglamentación de la UE en virtud de la ley y las orientaciones emitidas por los reguladores de la UE.

He aquí algunas posibles repercusiones que puede tener la aplicación de la Ley de IA de la UE:

Para ChatGPT/AI generativa

Para los grandes modelos lingüísticos existentes con amplia influencia sobre el contenido de Internet y el comportamiento de los usuarios, como ChatGPT de OpenAI, Géminis de Google, Llama 3.1 de Metay Claude AIpodrían ser necesarias medidas de cumplimiento más estrictas para garantizar su uso ético. Esto puede dar lugar a una mayor supervisión y limitaciones sobre cómo pueden utilizarse estos modelos, lo que podría afectar a su popularidad y rentabilidad.

Además, es posible que OpenAI tenga que modificar su modelo ChatGPT para garantizar que no haya prácticas prohibitivas contempladas en el artículo 5 de la Ley de IA de la UE si entra en alguno de los casos de uso prohibidos.

Para las empresas

Esta nueva ley provocará también algunos cambios en las empresas ajenas a estos modelos de LLM.

Las empresas que desarrollen o utilicen sistemas de IA de alto riesgo tendrán que cumplir requisitos estrictos y someterse a pruebas, lo que puede suponer un aumento de los costes de cumplimiento. Las empresas deben invertir más en conocimientos jurídicos y técnicos para garantizar el cumplimiento. En consecuencia, las startups pueden dudar a la hora de adoptar cualquier modelo de IA que implique aplicaciones de mayor riesgo debido a los costes de cumplimiento de la comercialización de la IA.

Este alto coste de escalar un modelo de IA podría llevar a la concentración del mercado en empresas de "gran tecnología" monopolizando la industria.

Otro impacto sería la protección de los secretos comerciales en las empresas cuyos productos principales son los modelos de IA. Esta nueva ley obliga a la transparencia sobre los datos utilizados para entrenar los modelos de IA, que son esenciales para las operaciones en las empresas.

Además, estas leyes estrictas pueden obstaculizar también la innovación y la entrada de nuevas tecnologías en el mercado europeo. Por ejemplo, Meta ocultó a la Unión Europea su último modelo de inteligencia artificial (IA) multimodallo que indica una posible resistencia a la innovación.

A pesar de los retos, la Ley también ofrece oportunidades para la innovación. Estas normas nuevas y claras proporcionan igualdad de condiciones para que las empresas desarrollen tecnologías de IA que cumplan los criterios éticos y de seguridad.

Las organizaciones que dan prioridad al cumplimiento y a las prácticas éticas de la IA pueden obtener una ventaja competitiva, generar confianza entre los consumidores y posicionarse como líderes en IA ética. Esta diferenciación puede atraer a consumidores e inversores con conciencia social, mejorando la reputación de la marca y la cuota de mercado.

Sin embargo, con estos cambios, la necesidad de alfabetización en IA es aún mayor, como veremos más adelante.

Para los consumidores

Para los consumidores, la Ley aporta los mayores beneficios en:

- Mayor transparencia y explicabilidad de los sistemas de IA

- Mayor confianza en los productos de IA aprobados

- Protección fiable frente a las prácticas discriminatorias de la IA

- Disponer de un canal para abordar las preocupaciones

En el futuro, los consumidores podrán exigir el cumplimiento de la Ley de IA de la UE a las empresas que desarrollen o utilicen sistemas de IA de alto riesgo. Esto les permitirá salvaguardar la privacidad de sus datos y garantizar que su información personal no se utiliza de forma poco ética.

Para los Estados miembros de la UE

Los Estados miembros de la UE tendrán que adaptar sus actuales marcos normativos nacionales a la nueva Ley de IA de la UE. La Comisión Europea también puede publicar directrices y directivas más específicas para que las sigan los Estados miembros.

Sin embargo, como se señala en un reciente informe de Reuters,

"La adopción acelerada de la IA el año pasado ha contribuido a poner a Europa en el buen camino para cumplir su Década Digital "-Tanuja Randery, Directora General de AWS

Para las naciones globales

Es probable que la Ley de IA de la UE influya en la regulación de la IA como norma mundial. Como uno de los primeros marcos normativos integrales de la IA, sienta un precedente que otras regiones podrían seguir. Las empresas que operan a escala internacional deben estar al tanto de estos avances para seguir siendo competitivas.

¿Cuándo entra en vigor la Ley de IA de la UE? Calendario de aplicación

He aquí un calendario provisional para la aplicación de la Ley de IA de la UE:

- 1 de agosto de 2024: Fecha de entrada en vigor de la Ley AI

- 2 de febrero de 2025: Comienzan a aplicarse prohibiciones a determinados sistemas de IA (Capítulo 1 y Capítulo 2). Aquí es donde empezarán a aplicarse los requisitos de alfabetización en IA.

- 2 de agosto de 2025: Empiezan a aplicarse las siguientes normas: Organismos notificados (Capítulo III, Sección 4), los modelos GPAI (Capítulo V), Gobernanza (Capítulo VII), Confidencialidad (Artículo 78), Sanciones (Artículos 99 y 100)

- 2 de agosto de 2026: Comienza a aplicarse el resto de la Ley de AI, excepto el artículo 6(1).

- 2 de agosto de 2027: Comienzan a aplicarse el artículo 6.1 y las obligaciones correspondientes del Reglamento.

En resumen, la ley no se aplicará plenamente hasta 2027, lo que dará tiempo a las empresas y a los Estados miembros para adaptarse y cumplir la nueva normativa.

Para consultar el calendario completo, visita Calendario de aplicación de la Ley de AI de la UE.

Ley de IA de la UE: Requisitos de alfabetización en IA

Además de regular cómo se desarrollan los modelos de IA, la Ley de IA de la UE también hace hincapié en la formación del personal en conocimientos de IA.

Según Capítulo I: Disposiciones Generales, Artículo 4: Alfabetización en IA:

"Los proveedores e implantadores de sistemas de IA tomarán medidas para garantizar, en la medida de lo posible, un nivel suficiente de conocimientos de IA de su personal y de otras personas que se ocupen del funcionamiento y uso de los sistemas de IA en su nombre, teniendo en cuenta sus conocimientos técnicos, experiencia, educación y formación y el contexto en el que se van a utilizar los sistemas de IA, y considerando las personas o grupos de personas sobre los que se van a utilizar los sistemas de IA."

En pocas palabras, esto significa que las empresas deben asegurarse de que sus empleados y cualquier otra persona que participe en el desarrollo o el uso de sistemas de IA reciban la formación adecuada para comprender la tecnología, sus aplicaciones y los riesgos potenciales.

Este sentimiento se hace eco de lo que hemos visto en el DataCamp Informe sobre el estado de la alfabetización en datos e Inteligencia Artificial 2024. El 62 % de los líderes consultados creen que la alfabetización en IA es importante para las tareas cotidianas de sus equipos. Del mismo modo, el 70 % de los líderes identificaron la comprensión básica de los conceptos de IA como lo más importante para su equipo, haciendo hincapié en la necesidad de que los equipos comprendan los principios básicos que subyacen a las tecnologías de IA.

A pesar de ello, la formación en datos e IA sigue siendo incipiente en las organizaciones. El 26 % de los líderes afirman que no ofrecen ningún tipo de formación en IA. Otro 26 % de los responsables señalan que la formación en IA se reserva únicamente a las funciones técnicas, mientras que solo el 18 % amplía dicha formación al personal no técnico.

Resulta preocupante que solo el 25 % de los líderes pertenecen a organizaciones que han establecido programas integrales de alfabetización en IA para toda la organización.

Con DataCamp for Business puedes empezar a crear un programa de alfabetización en IA que cubra los conocimientos necesarios sobre datos e IA para asegurarte de que cumples la Ley de IA de la UE, tanto si formas a un equipo de 2 personas como a más de 10 000. Además de aprender a trabajar con herramientas de IA y a crearlas, puedes crear un programa de formación completo que cubra la ética de la IA, la gestión de riesgos y el despliegue de modelos de IA, empezando por nuestro programa de habilidades Fundamentos de la Ley de IA de la UE.

Conclusión

La Ley de IA de la UE representa un hito importante en la regulación de la inteligencia artificial. Presenta un equilibrio entre promover la innovación y garantizar un uso ético y seguro de la tecnología de IA.

Aunque puede plantear retos a las empresas, también ofrece oportunidades de crecimiento y diferenciación. Para los consumidores, proporciona un marco para confiar en las empresas y hacerlas responsables de su uso de la IA. En cuanto a la comunidad mundial, sienta un precedente para la regulación de la IA que puede ser adoptado por otras regiones en el futuro.

¿Estás explorando opciones para dar a conocer mejor la Ley de IA de la UE a tu equipo? Aprende más sobre la nueva ley en nuestro completo curso Comprender la Ley de IA de la UE y obtén una comprensión completa de cómo navegar por la normativa y fomentar la confianza con una IA responsable en nuestro programa de habilidades Fundamentos de la Ley de IA de la UE.

Preguntas frecuentes sobre la Ley de IA de la UE

¿Quién gobierna la Ley de IA de la UE?

La Oficina Europea de AI, creada en febrero de 2024 en el seno de la Comisión, supervisa el cumplimiento y la aplicación de la Ley de AI con los Estados miembros.

¿Cuándo entrará en vigor la Ley de AI de la UE?

La ley entró en vigor el 1 de agosto de 2024, con prohibiciones para determinados sistemas de IA a partir del

2 de febrero de 2025, las normas sobre Organismos Notificados (Capítulo III, Sección 4), Modelos GPAI (Capítulo V), Gobernanza (Capítulo VII), Confidencialidad (Artículo 78), Sanciones (Artículos 99 y 100) se aplicarán el 2 de agosto de 2025, y el resto el 2 de agosto de 2026.

¿Cuáles son las posibles consecuencias del incumplimiento de la Ley de IA de la UE?

El incumplimiento de determinadas prácticas de IA puede dar lugar a multas de hasta 35 millones de euros o el 7 % de la facturación anual de una empresa.

¿Quién evaluará el cumplimiento de la Ley de IA de la UE?

La Ley de IA de la UE establece que cada país miembro debe tener al menos una autoridad responsable de evaluar y supervisar los organismos de evaluación de la conformidad de la IA.

¿A quién se aplicará la Ley de IA?

La Ley de IA de la UE se aplicará a quienes participen en la explotación, distribución o uso de sistemas de IA.