Curso

Imagen creada por DALLE-3.

A medida que la IA se convierte en una parte inseparable de nuestra vida cotidiana, debemos examinar más a fondo sus riesgos y desafíos potenciales. Cuestiones como la parcialidad, la discriminación, la violación de la privacidado las consecuencias no deseadas son algunos de los obstáculos que debemos superar.

La gobernanza de la IA surge como marco para abordar estos retos.

El objetivo de la gobernanza de la IA es garantizar un desarrollo responsable y desarrollo ético, desplieguey el uso de las tecnologías de IA. Si se aplica de forma correcta, esto orienta el panorama de la IA hacia una herramienta beneficiosa y de impacto accesible para la sociedad.

¿Qué es la gobernanza de la IA?

La gobernanza de la IA se refiere a las medidas y métodos sistemáticos diseñados para guiar y supervisar el desarrollo y las aplicaciones de la IA. Garantiza que la IA esté en consonancia con los principios éticos y los valores de la sociedad. Esto incluye leyes reglamentoso cualquier directriz que dirija tanto a los creadores como a los usuarios de la IA.

Para lograr este objetivo, la gobernanza de la IA trata de mantener principios como:

- Minimizar los riesgos: Evitar sesgos y daños potenciales

- Equidad y transparencia: Promover sistemas de IA comprensibles

- Responsabilidad: Establecer la responsabilidad de los resultados de la IA

- Confianza pública: Cómo ve la sociedad las tecnologías de IA

¿Por qué es importante una IA justa?

El desarrollo de aplicaciones de IA es el producto de muchas funciones y prácticas. La mayoría de las veces, las aplicaciones de IA se construyen sobre la base de datos. La recogida, el tratamiento y la manipulación de datos es en sí misma una cuestión delicada y sensible.

Mientras tanto, los productos de IA se utilizan en diversos campos y sectores, potencialmente a muy gran escala. Por ejemplo ChatGPT es utilizado semanalmente por más de 200 millones de usuarios activos según DemandSage.

Dado el gran número de personas que participan en el desarrollo de soluciones basadas en la IA y el amplio alcance de sus usuarios, se puede apreciar realmente la complejidad e intrincación de la IA. Pueden surgir numerosos problemas.

Para ganar perspectiva, imagínate que te presentas a un puesto de trabajo en el que el proceso de contratación se basa en un sistema de IA que te evalúa por ser un candidato adecuado. Este sistema revisa a los candidatos en función de su currículum y perfil y filtra a los que no se consideran aptos para el puesto.

Sin embargo, si este sistema de IA tiene sesgos inherentes o fallos en su algoritmo, podría discriminar injustamente a determinados grupos de personas por factores como la edad, el sexo o la etnia. Si las empresas utilizaran ampliamente un sistema de IA de este tipo, las consecuencias serían importantes.

Este escenario ilustra por qué la imparcialidad de la IA es crucial: para garantizar la imparcialidad, la transparencia y la responsabilidad en los sistemas de IA que pueden tener un impacto significativo en la vida de las personas.

Sorprendentemente, estas discriminaciones tampoco son raras en los humanos. Los investigadores han descubierto que existe una discriminación ilegal sistemática basada en el nombre de las personas en el proceso de solicitud de empleo. Los nombres de minorías étnicas, aunque tengan los mismos currículos que otros candidatos, se enfrentan a menos éxito en su candidatura.

Por lo tanto, si los homólogos humanos de un sistema de IA pueden caer en esas trampas, significa que utilizar la IA para un proceso de toma de decisiones imparcial es difícil, pero también fructífero.

Gobernanza de la IA: Principios y marcos clave

Una gobernanza eficaz de la IA se apoya en el pilar de los valores sociales y humanos. Principios que guían a los expertos en la evaluación de sus sistemas para la alineación. Estos principios incluyen:

- Transparencia: Los sistemas de IA deben ser claros, proporcionando una visión clara de sus mecanismos, recopilación de datos y algoritmos de toma de decisiones.

- Equidad: Garantizar un tratamiento y unas predicciones imparciales identificando y mitigando los sesgos en el desarrollo y despliegue de los sistemas de IA.

- Responsabilidad: Establecer responsabilidades claras para los sistemas de IA, incluyendo protocolos para cuando se produzcan daños.

- Diseño centrado en el ser humano: Priorizar los valores humanos y el bienestar por encima de todo.

- Privacidad: Respetar los derechos individuales de privacidad con medidas sólidas de protección de datos.

- Seguridad y protección: Centrarse en la seguridad del usuario y del sistema seguridad contra consecuencias malintencionadas e involuntarias.

Principales marcos de gobernanza de la IA

Varias organizaciones han desarrollado marcos para orientar las prácticas de gobernanza de la IA. Algunos de los más destacados son:

- Marco de gestión de riesgos de IA del NIST: Desarrollado por EE.UU. Instituto Nacional de Normas y Tecnología, el NIST ofrece un enfoque para reconocer, evaluar y controlar los riesgos asociados de los sistemas de IA en su ciclo de vida.

- Principios de IA de la OCDE: La Organización para la Cooperación y el Desarrollo Económico (OCDE) ha establecido una serie de principios para una inteligencia artificial digna de confianza. Estos principios dan prioridad a los valores centrados en el ser humano, la equidad, la transparencia, la solidez y la responsabilidad.

- IEEE Diseño Éticamente Alineado: El Instituto de Ingenieros Eléctricos y Electrónicos (IEEE) ha desarrollado un marco que proporciona directrices para el diseño ético y la implementación de sistemas autónomos e inteligentes.

- Directrices éticas de la UE para una IA fiable: La Unión Europea ha proporcionado directrices sobre solidez técnica, privacidad, transparencia, diversidad, no discriminación, bienestar social y responsabilidad.

- Marcos específicos de la industria: Diversos sectores han desarrollado sus marcos de gobernanza de la IA adaptados a sus necesidades y obstáculos específicos. Por ejemplo:

- Sanidad: La guía de la OMS sobre ética y gobernanza de la IA para la asistencia sanitaria

- Finanzas: Los Principios FEAT de la Autoridad Monetaria de Singapur (Imparcialidad, Ética, Responsabilidad y Transparencia)

- Automóvil: El marco Safety First para la conducción automatizada

Estos marcos proporcionan una valiosa barrera de protección para las organizaciones que desean implantar prácticas de gobernanza de la IA, incluyendo tanto principios de alto nivel como recomendaciones prácticas.

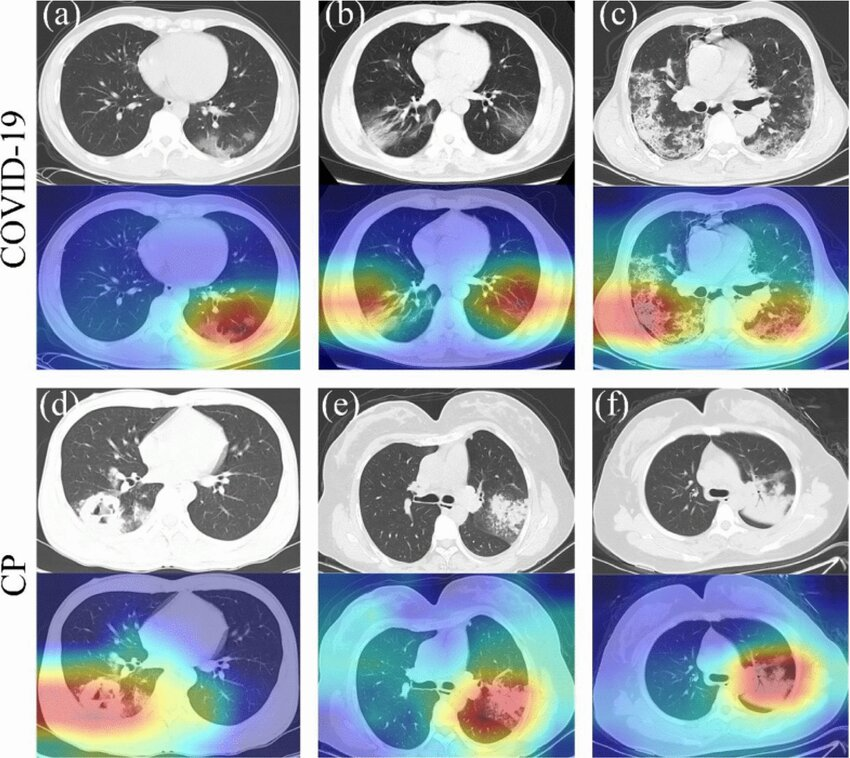

La IA tiene aplicaciones en muchos campos, como sanidad. La interpretabilidad y la transparencia son dos propiedades importantes de estos sistemas. La imagen de abajo es un ejemplo de un sistema de IA que reconoce las infecciones por COVID-19:

Fuente: Peng et al., 2022

Buenas prácticas para implantar la gobernanza de la IA

Poner en práctica la gobernanza de la IA implica adoptar un enfoque holístico que requiere la colaboración de diversas partes interesadas y múltiples aspectos de una organización. He aquí algunas buenas prácticas para poner en marcha la gobernanza de la IA:

Liderazgo y compromiso cultural

El liderazgo y el compromiso cultural son esenciales. Los líderes deben apoyar y defender activamente normas éticas en el desarrollo de la IA, garantizando que estos principios se utilicen en toda la organización.

Esto implica crear y mantener directrices claras y bien documentadas para cada fase de la gestión del sistema de IA, incluidos el desarrollo, las pruebas, el despliegue y la supervisión, para garantizar que las consideraciones éticas se integran en el ciclo de vida de la IA.

Formación y educación

La formación y la educación continuas son igual de importantes. Todo el personal pertinente debe recibir formación periódica centrada en la ética y la imparcialidad de la IA para mantenerse al día sobre las mejores prácticas y los nuevos retos.

También hay que educar a los dirigentes sobre el impacto y la importancia de las tecnologías de IA. Para los desarrolladores de IA, la formación especializada adaptada a sus funciones y proyectos específicos garantiza que tengan los conocimientos necesarios para un desarrollo y una aplicación responsables.

Monitorización de los sistemas de IA

No puedo exagerar la importancia de supervisión de los sistemas de IA. Implanta sistemas de supervisión continua para seguir el rendimiento y las predicciones de la IA. Esto ayuda a identificar y corregir rápidamente cualquier sesgo o consecuencia no deseada.

La evaluación periódica garantiza que los sistemas de IA funcionan según lo previsto y cumplen las normas exigidas.

Documentación

Una documentación exhaustiva es esencial para la transparencia y la responsabilidad en el desarrollo de la IA. Mantén registros detallados de cada paso del proceso de desarrollo de la IA, incluidas las fuentes de datos, las arquitecturas de los modelos y las métricas de rendimiento.

Establecer un marco para la toma de decisiones éticas, ya sea mediante políticas internas o normas externas reconocidas, para apoyar prácticas claras y responsables a lo largo del ciclo de vida de la IA.

Comprometerse con las partes interesadas

Colaborar con las partes interesadas es importante para alinear los sistemas de IA con las diversas necesidades y valores. Comunícate activamente con los usuarios, las comunidades y los expertos para garantizar que los diseños y valores del sistema de IA se entienden bien y abordan las necesidades de todos los implicados.

Valorar las diversas perspectivas ayuda a prevenir daños no deseados y garantiza que los sistemas de IA sean inclusivos y equitativos.

Mejora continua

La mejora continua es clave para mantener un alto nivel en el desarrollo de la IA. Define y realiza un seguimiento de las métricas relacionadas con la ética y la parcialidad para evaluar el rendimiento del sistema de IA y realizar mejoras iterativas basadas en estos datos.

Solicita e incorpora las opiniones de los usuarios y las partes interesadas para asegurarte de que los sistemas de IA se ajustan a las normas éticas.

Herramientas y tecnologías para la gobernanza de la IA

A medida que evoluciona la gobernanza de la IA, se está creando un creciente ecosistema de herramientas y tecnologías para ayudar a las organizaciones a implantar las prácticas de gobernanza adecuadas. Estas herramientas abordan múltiples aspectos de la gobernanza de la IA, desde la detección de sesgos hasta la explicabilidad y la gestión de riesgos.

- Detección y mitigación de sesgos:

- IBM AI Equidad 360: Un conjunto de herramientas de código abierto que "puede ayudar a examinar, informar y mitigar la discriminación y el sesgo en los modelos de aprendizaje automático a lo largo del ciclo de vida de las aplicaciones de IA".

- Aequitas: Un conjunto de herramientas de código abierto para la evaluación del sesgo y la imparcialidad para desarrolladores de ML y analistas de datos.

- Explicabilidad e interpretabilidad:

- LIME (Explicaciones locales interpretables agnósticas del modelo): Una técnica que explica las predicciones de cualquier modelo de aprendizaje automático de caja negra.

- SHAP (exPlanificaciones aditivas SHapley): Un enfoque de teoría de juegos para explicar el resultado de cualquier modelo de aprendizaje automático analizando la importancia de cada característica y su relación entre sí.

- Evaluación y gestión de riesgos:

- Navegador del Marco de Gestión de Riesgos de la IA: Otra herramienta desarrollada por el NIST para ayudar a las organizaciones a identificar y mitigar los riesgos relacionados con el despliegue y el funcionamiento de los sistemas de IA

- Privacidad:

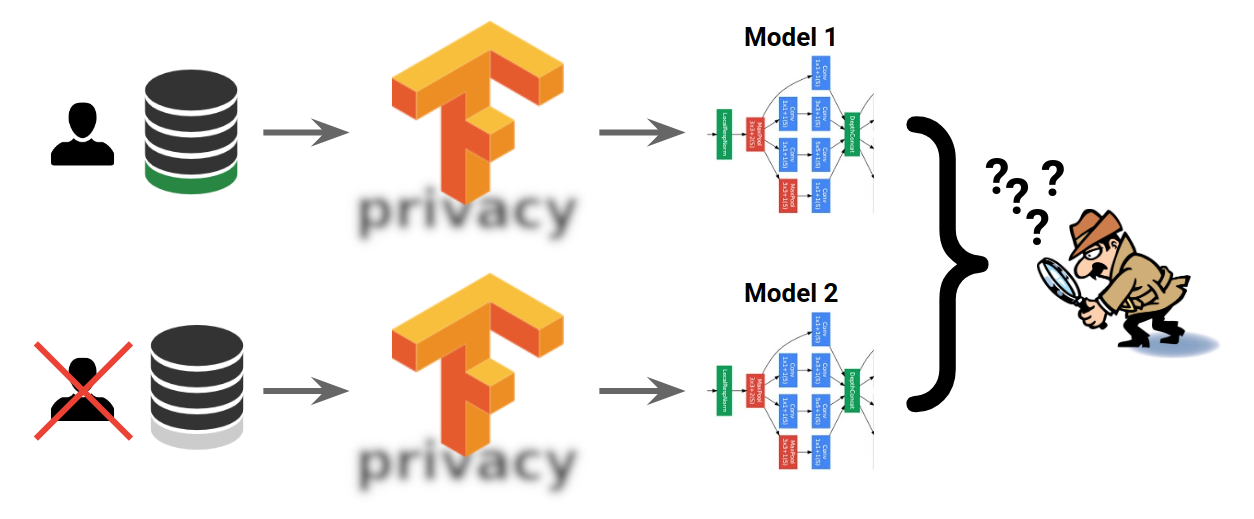

- OpenMined: Un proyecto de código abierto para construir sistemas de aprendizaje automático La privacidad es más crucial que a menudo

- TensorFlow Privacidad: Una biblioteca para entrenar modelos de aprendizaje automático con privacidad para los datos de entrenamiento

- Documentación del modelo:

- Modelo de tarjeta: Un marco de HuggingFace para la presentación transparente de información sobre modelos de IA

- FactSheets: El enfoque de IBM para aumentar la confianza y la transparencia en la IA

Privacidad de TensorFlow. (Fuente: TensorFlow)

Estas herramientas y tecnologías ayudan a garantizar que los sistemas de IA se gestionan y mantienen de forma responsable. Los distintos departamentos y funciones de una organización tienen sus propias herramientas y criterios en relación con la gobernanza de la IA. Sin embargo, es importante tener en cuenta que las herramientas por sí solas no son suficientes. Deben ir de la mano de procesos y supervisión sólidos para ser eficaces.

Estudio de caso: La IA responsable de Microsoft

Varias empresas han adoptado medidas prácticas para aplicar la gobernanza de la IA. Un ejemplo de ello es el Programa de IA Responsable de Microsoft. Microsoft es uno de los principales actores de la IA actual, pero ha tenido su buena ración de proyectos de IA fallidos, sobre todo Tay.

Lanzado originalmente por Microsoft en 2016, Tay era un chatbot que debía aprender e interactuar en Twitter. Debido a la falta de medidas de seguridad, en sólo 24 horas, los usuarios de Twitter han enseñado a Tay a ser fascista, ofensiva y racista. Tay aprendía de ellos sin ningún tipo de barandilla sobre qué aprender y qué evitar. Tay acabó cerrándose, pero se convirtió en una valiosa lección.

Microsoft surgió en el desarrollo e implementación de prácticas de gobernanza de la IA a través de su programa de IA Responsable. Uno de los aspectos destacables del programa de IA Responsable de Microsoft es su estructura operativa. La empresa ha creado un comité ético de IA, conocido como Comité Aether (IA, Ética y Efectos en la Ingeniería y la Investigación), que revisa los proyectos de IA para detectar posibles problemas éticos. Este comité es una reunión de expertos de diversos campos para revisar los impactos de las tecnologías de IA en la sociedad y proporcionar orientación.

Además, Microsoft ha desarrollado y publicado varias herramientas y marcos para ayudar a los desarrolladores a aplicar prácticas responsables de IA en su trabajo diario. El sitio Caja de herramientas de IA responsable es un ejemplo que ayuda a evaluar y mejorar la imparcialidad de los sistemas de IA.

El panorama normativo y político

Los reglamentos y la gobernanza, aunque son diferentes en su definición, surten efecto el uno del otro. Los gobiernos y las organizaciones reguladoras de todo el mundo están elaborando nuevas políticas y normativas para regular el desarrollo y el uso de la IA. Comprender este panorama en evolución es necesario para las organizaciones que están implantando prácticas de gobernanza de la IA en su flujo de trabajo.

Imagen creada por DALLE-3.

La Ley de IA de la UE

Uno de los avances más significativos en la regulación de la IA es la Ley de Inteligencia Artificial de la Unión Europea (Ley de IA de la UE). Los puntos clave de esta Ley son

- Enfoque basado en el riesgo: Los sistemas de IA se clasifican en función de su nivel de riesgo, con requisitos diferentes para cada categoría.

- Prácticas de IA prohibidas: Algunas aplicaciones de la IA, como la puntuación social del gobierno, están prohibidas.

- Sistemas de IA de alto riesgo: Se establecen requisitos estrictos para los sistemas de IA utilizados en áreas críticas como la sanidad, la educación y la aplicación de la ley.

- Requisitos de transparencia: Obligaciones de informar a los usuarios cuándo y de qué forma interactúan con los sistemas de IA.

Otras normativas emergentes

Aunque la Ley de IA de la UE es quizás la normativa más completa sobre IA hasta la fecha, otros organismos también están desarrollando sus propios enfoques.

Canadá propuso la Ley de Inteligencia Artificial y Datos (AIDA) como parte de una reforma más amplia de la privacidad, mientras que el proyecto de ley de seguridad de la IA de California, SB 1047 está, en la fecha de redacción de este artículo, en vías de convertirse en ley.

Implicaciones para las empresas

La evolución del panorama normativo tiene grandes implicaciones para las organizaciones que desarrollan sistemas de IA:

- Requisitos de cumplimiento: Las organizaciones tendrán que asegurarse de que sus sistemas de IA cumplen la normativa. Estas normativas pueden contrastar con sus prácticas actuales, exigiendo eventualmente cambios significativos en sus procedimientos de desarrollo y despliegue.

- Documentación y transparencia: Mayor énfasis en la documentación de los procesos de desarrollo de la IA y en la explicación de las decisiones basadas en la IA. El alcance de esta exigencia de transparencia es, por supuesto, diferente según la ley.

- Gestión del riesgo: Necesidad de una sólida evaluación de riesgos, en particular para los sistemas de IA que puedan clasificarse como de "alto riesgo".

- Consideraciones globales: Las organizaciones que operan en múltiples jurisdicciones tendrán que abordar requisitos normativos potencialmente conflictivos.

- Consideraciones éticas: Muchas normativas incorporan principios éticos, exigiendo a las organizaciones que consideren más explícitamente las implicaciones éticas de sus sistemas de IA.

Que tu organización o equipo esté o no sujeto a estas leyes, depende de tu jurisdicción, del tipo de producto que construyas y del nivel de riesgo asociado al producto.

El debate sobre la regulación de la IA: Ventajas e inconvenientes

La normativa es uno de los temas más debatidos en la IA. Aunque la mayoría de la comunidad de IA está de acuerdo en que "algún" tipo de regulación es beneficiosa, nadie parece ponerse de acuerdo sobre la naturaleza, el alcance y quién debe hacerse cargo de estas leyes.

La complejidad de esta cuestión ha dado lugar a apasionadas discusiones entre la industria, el mundo académico, el gobierno y la sociedad civil, cada uno debatiendo los posibles beneficios e inconvenientes de los marcos reguladores. Comprender estos argumentos es necesario para desarrollar una perspectiva correcta e imparcial.

Imagen generada por DALLE-3 del Cilindro de Ciro-considerada por algunos eruditos como una de las primeras declaraciones de derechos humanos

Argumentos a favor de la regulación de la IA

Los partidarios de la reglamentación de la IA argumentan que estas directrices son esenciales para proteger al público y que una reglamentación bien diseñada puede mantener bajo control los daños potenciales de la IA. La violación de la intimidad, la parcialidad y el desplazamiento laboral son algunos de esos daños potenciales. Creen que un conjunto de leyes y normas claras puede evitar una"carrera a la baja" en términos de ética. Además, estas normas pueden desempeñar un papel crucial en la creación de confianza pública en las tecnologías de IA.

Otro argumento a favor de la regulación es el amplio impacto social de la IA. A medida que estas tecnologías influyen cada vez más en ámbitos como el empleo, las interacciones sociales y los procesos democráticos, los defensores sostienen que es necesaria una supervisión reguladora para garantizar que se tienen en cuenta estos impactos y se gestionan de forma responsable.

Argumentos contra la regulación de la IA

Los críticos de la normativa sobre IA plantean varias preocupaciones sobre sus repercusiones negativas. Uno de los principales argumentos contra las normativas estrictas es el temor a que acaben paralizando la innovación. Les preocupa que unas normas demasiado restrictivas puedan ralentizar la IA, frenando potencialmente los avances beneficiosos en campos como la sanidad, el cambio climático y la investigación científica, y la naturaleza vertiginosa del desarrollo de la IA significa que las normas pueden quedar desfasadas rápidamente, pudiendo llegar a ser irrelevantes o incluso contraproducentes.

Otra preocupación importante son los retos de cumplimiento para las empresas más pequeñas y las nuevas empresas. El coste, la mano de obra y la complejidad del cumplimiento de una amplia normativa podrían resultar opresivos para estas entidades, reduciendo la competencia y la innovación en el sector de la IA. Como resultado, esto podría conducir al monopolio del desarrollo de la IA entre unas pocas grandes empresas tecnológicas que posean los recursos adecuados para abordar estos complejos panoramas normativos.

Muchos expertos en IA se preguntan si regular la IA a nivel de tecnología, en lugar de a nivel de aplicación, es el enfoque correcto. Argumentan que, al igual que otras tecnologías como la electricidad e Internet, la IA no es intrínsecamente maliciosa. El uso que se haga de estas tecnologías puede ser malintencionado o constructivo. La seguridad de la IA es propiedad de las aplicaciones más que de la propia tecnología, como se señala en este artículo.

Responsabilidad del promotor

También es importante señalar que los valores que hacen que los sistemas de IA sean seguros, como la imparcialidad, la parcialidad o la transparencia, aunque tienen sus raíces en la sociedad y en preocupaciones éticas, también son una cuestión técnica.

Es crucial reconocer que los modelos de IA sesgados también son técnicamente defectuosos. Un modelo que presenta sesgos, por definición, no representa ni procesa con precisión todo el espectro de datos que debe manejar.

Esta deficiencia técnica puede provocar un rendimiento reducido, predicciones inexactas y resultados poco fiables. Desde este punto de vista, abordar el sesgo y promover la equidad en los modelos de IA no es sólo una preocupación ética, sino un reto técnico fundamental que repercute directamente en la calidad de los sistemas de IA que construimos.

Estos valores deben ser respetados e inculcados en los sistemas de IA por los desarrolladores que los construyen, incluso sin la exigencia de leyes o normas reguladoras. Los investigadores y desarrolladores que trabajan en la mitigación de la imparcialidad y el sesgo suelen dedicarse a un trabajo profundamente técnico.

Considera un sistema de IA desarrollado para ayudar a los empleados en la evaluación de las solicitudes de préstamo. Si, debido a sesgos históricos en las prácticas de préstamo, los datos de entrenamiento reflejan una pauta en la que a determinados grupos raciales se les denegaron préstamos de forma desproporcionada o se les ofrecieron condiciones menos favorables, el sistema de IA aprende a asociar la raza con las puntuaciones de los solicitantes, entonces este sistema es "técnicamente malo" antes que "éticamente inaceptable". Este ejemplo demuestra que abordar el sesgo en los sistemas de IA no es sólo un incentivo ético, sino también una necesidad técnica.

Las organizaciones y las personas pueden utilizar la transparencia y la documentación a lo largo del ciclo de vida del desarrollo de la IA para abordar las preocupaciones y la confianza pública. Esta "transparencia algorítmica" incluye la comunicación clara de la finalidad de un modelo, las fuentes de datos, la metodología o las posibles limitaciones del sistema. Como desarrollador, puedes ser claro y transparente comunicando la:

- Proceso de entrenamiento del modelo

- Detalles sobre el conjunto de datos utilizado

- Cualquier paso de preprocesamiento de datos

- El algoritmo elegido

Esta transparencia no sólo ayuda a identificar y corregir los fallos técnicos, sino que también demuestra un compromiso con el desarrollo ético de la IA, aumentando así la confianza del público en la tecnología.

Conclusión

Este artículo ha explorado la naturaleza de la gobernanza de la IA, las consideraciones éticas, los marcos normativos y las implementaciones técnicas. La importancia de la gobernanza de la IA reside en su potencial para identificar los riesgos antes de que causen problemas, ganarse la confianza pública y dirigir el poder de la IA en beneficio y por el bien de la sociedad.

También hemos examinado diversos aspectos de la gobernanza de la IA, como las herramientas y tecnologías disponibles, las iniciativas corporativas y el panorama normativo en evolución. También hemos analizado el actual debate en torno a la normativa sobre IA, presentando argumentos a favor y en contra de esta supervisión.

Al final, la responsabilidad del desarrollo ético y responsable de la IA no sólo recae en los organismos reguladores, sino también en las empresas y personas que crean estas tecnologías. Como hemos visto, abordar cuestiones como la parcialidad y la imparcialidad en los sistemas de IA no es sólo una preocupación ética, sino una necesidad técnica.