programa

Las organizaciones luchan por asegurar, gobernar y mover grandes conjuntos de datos en el entorno de datos actual. AWS Lake Formation y AWS Glue son dos servicios que pueden ayudarte a superar estos retos. AWS Glue realiza la limpieza, reestructuración y conversión de tipos de datos, mientras que AWS Lake Formation construye lagos de datos y se encarga de la seguridad y administración de los datos.

En este blog, demostraremos cómo desarrollar una canalización de datos segura y automatizada utilizando AWS Lake Formation y AWS Glue. Desarrollaremos un trabajo ETL utilizando AWS Glue para mover y procesar datos de muestra almacenados actualmente en un bucket S3, y el control de acceso de grano fino se realizará a través de AWS Lake Formation.

¿Qué es la Formación del Lago AWS?

AWS Lake Formation proporciona las herramientas necesarias para crear, administrar y proteger lagos de datos en AWS. Con Lake Formation, crear lagos de datos en Amazon S3 y administrar la seguridad y los permisos es más fácil.

Utilizando AWS Formación de Lagos, puedes:

- Construye rápidamente un lago de datos seguro.

- Centraliza el almacenamiento de datos en S3.

- Define políticas granulares de control de acceso.

- Aplica la encriptación de datos y los registros de auditoría para el cumplimiento.

¿Qué es el pegamento AWS?

AWS Glue es un servicio de integración de datos sin servidor que proporciona funciones de extracción, transformación y carga (ETL) para la preparación de datos. Es un servicio automatizado de preparación de datos que facilita la gestión de la catalogación, transformación y carga de datos. Esto es útil para consolidar datos de varias fuentes, como S3, en almacenes de datos o bases de datos.

Con AWS Glue, obtienes:

- Catálogo de datos de pegamento: Un repositorio centralizado para gestionar metadatos.

- Trabajos ETL: Trabajos sin servidor para transformar y mover datos.

- Glue Studio: Una interfaz visual para diseñar flujos de trabajo ETL.

Si eres nuevo en Glue, consulta nuestro tutorial Introducción a AWS Glue.

¿Por qué integrar AWS Formación de Lagos y AWS Glue?

La integración de AWS Lake Formation y AWS Glue aporta lo mejor de ambos mundos: lagos de datos seguros y canalizaciones ETL automatizadas. Algunas ventajas de esta integración son

- Canalizaciones de datos automatizadas: Automatiza fácilmente la transformación y el movimiento de datos, manteniendo la seguridad.

- Gestión centralizada de datos: Combina el control de acceso de Lake Formation con las capacidades de transformación y catalogación de datos de Glue.

- Seguridad mejorada: Aprovecha los permisos de grano fino de Lake Formation para controlar el acceso a datos sensibles.

Requisitos previos para la integración

Antes de integrar AWS Formación de Lagos y AWS Glue, asegúrate de que tienes lo siguiente:

- Cuenta de AWS: Acceso a AWS Formación de Lagos y AWS Pegamento.

- Conocimientosesenciales: Familiaridad con los lagos de datos, ETL y servicios de AWS.

- Cubo S3: Un bucket S3 preconfigurado para almacenar tus datos.

- Funciones IAM: Para acceder a ambos servicios se requieren los roles y permisos IAM necesarios.

- CloudFormation: Se proporciona una plantilla para desplegar la configuración base. Ypuedes encontrar la plantilla aquí.

Guía paso a paso para la integración

Una vez que tengas los requisitos previos, sólo tienes que seguir estos pasos:

Paso 1: Configurar la formación de lagos de AWS

El primer paso es desplegar los recursos básicos de AWS necesarios para construir un lago de datos seguro antes de iniciar el proceso de integración. La plantilla de AWS CloudFormation ayuda a organizar e implementar todos los recursos necesarios.

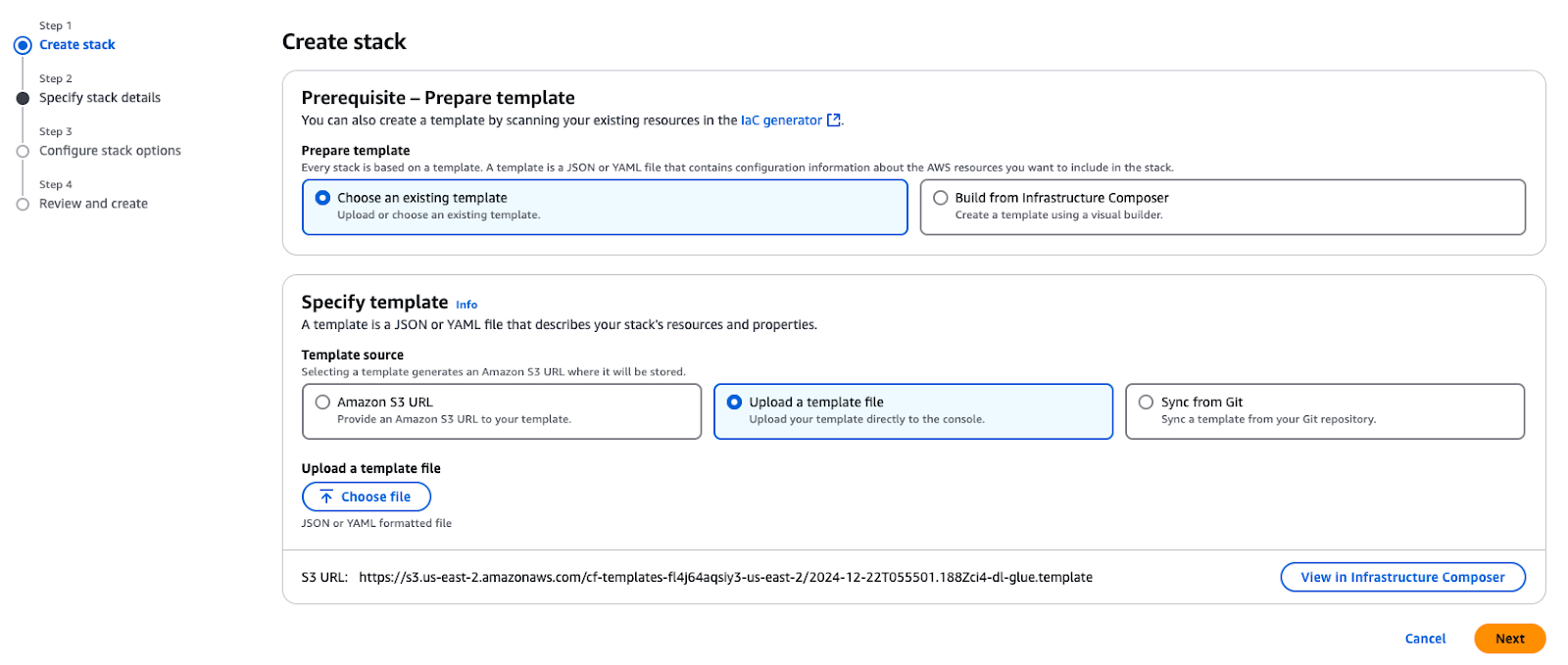

Utiliza la plantilla de CloudFormation proporcionada para crear una pila en tu cuenta de AWS. Esta pila proporciona los recursos esenciales necesarios para los casos de uso descritos en este tutorial.

Crear una pila en AWS CloudFormation

Al desplegar la pila, se crearán los siguientes recursos clave en tu cuenta de AWS:

- Amazon VPC y subred: Una VPC y una subred pública para alojar recursos con las configuraciones de red adecuadas.

- Buckets de Amazon S3:

- Almacena datos, guiones y resultados relacionados con el blog.

- Albergalos datos TPC utilizados para construir el lago de datos.

- Funciones y políticas IAM:

GlueServiceRole: Concede a AWS Glue acceso a los servicios S3 y Lake Formation.DataEngineerGlueServiceRole: Proporciona a los ingenieros permisos para acceder a los datos y procesarlos.DataAdminUseryDataEngineerUser: Usuarios IAM preconfigurados para explorar y gestionar la seguridad de Lake Formation.- Oruga de cola AWS: Un TPC Crawler para escanear y catalogar los datos de parquet almacenados en el bucket S3.

- Instancia de Amazon EC2: Una instancia de ayuda (

EC2-DB-Loader) para precargar y transferir datos de muestra a S3. - Administrador de secretos de AWS: Un secreto (

lf-users-credentials) para almacenar de forma segura las credenciales de usuario de los usuarios IAM precreados.

Una vez creada la pila, tendrás lo siguiente:

- Un ejemplo de base de datos TPC almacenada en Amazon S3.

- Usuarios y roles precreados para explorar patrones de seguridad y controles de acceso.

- Pega configuraciones y rastreadores para catalogar y procesar tus datos.

- Todos los componentes básicos necesarios para seguir los pasos de este blog.

Paso 2: Configurar los permisos de datos

En esta sección, el Administrador del Lago de Datos configurará la Formación del Lago de AWS para que esté disponible para las personas consumidoras de datos, incluidos los ingenieros de datos. El administrador lo hará:

- Crea una nueva base de datos en AWS Formación del Lago para almacenar los datos de la TPC.

- Registra tablas de metadatos para el conjunto de datos TPC en el Catálogo de Datos de AWS Glue.

- Configura las etiquetas y políticas de Formación de Lagos para establecer los permisos de acceso de los distintos usuarios.

Estas configuraciones proporcionan un control de acceso seguro y detallado y una coordinación fluida con otros servicios de AWS.

Configuración del Administrador del Lago de Datos

Un Administrador del Lago de Datos es un usuario o rol de Gestión de Identidades y Accesos (IAM) que puede dar permiso a cualquier principio (incluido él mismo) sobre cualquier entidad del Catálogo de Datos. El Administrador del Lago de Datos suele ser el primer usuario creado para gestionar el Catálogo de Datos y suele ser el usuario al que se le conceden privilegios administrativos para el Catálogo de Datos.

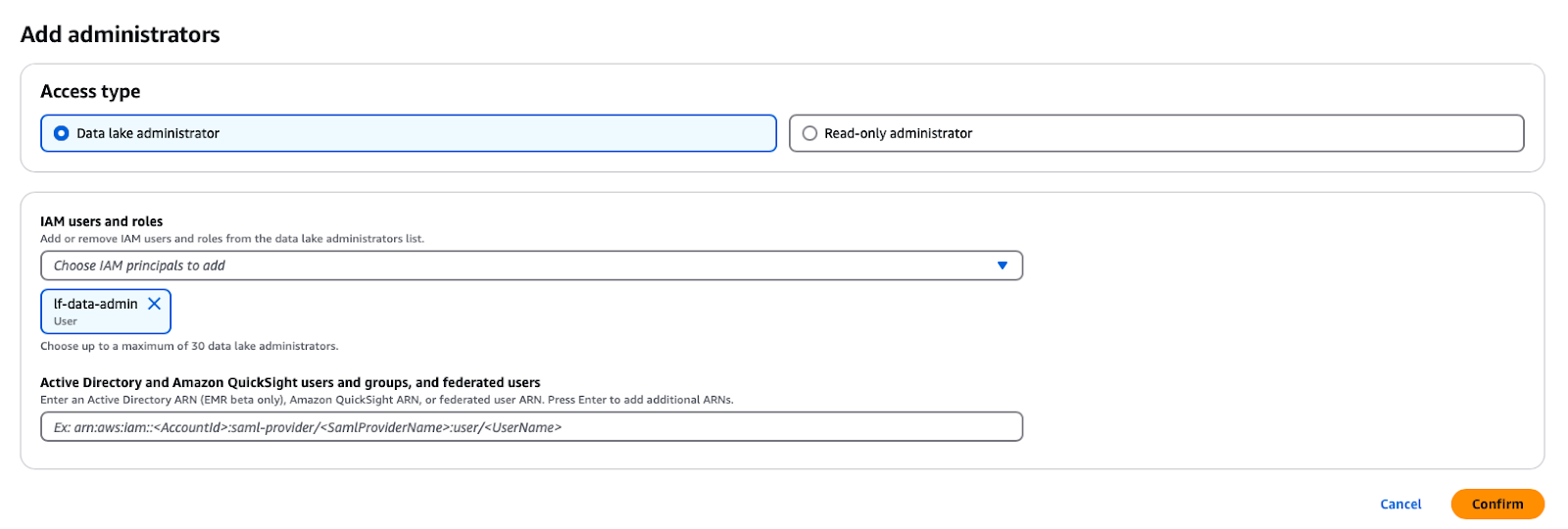

En el servicio AWS Formación de Lagos, puedes abrir la consulta haciendo clic en el botón Funciones y tareas administrativas -> Añadir Administradores en el botón del panel de navegación y, a continuación, seleccionando el usuario IAM lf-data-admin de la lista desplegable.

Añadir un administrador de lago de datos en la formación de lago de AWS

Cambiar la configuración del catálogo

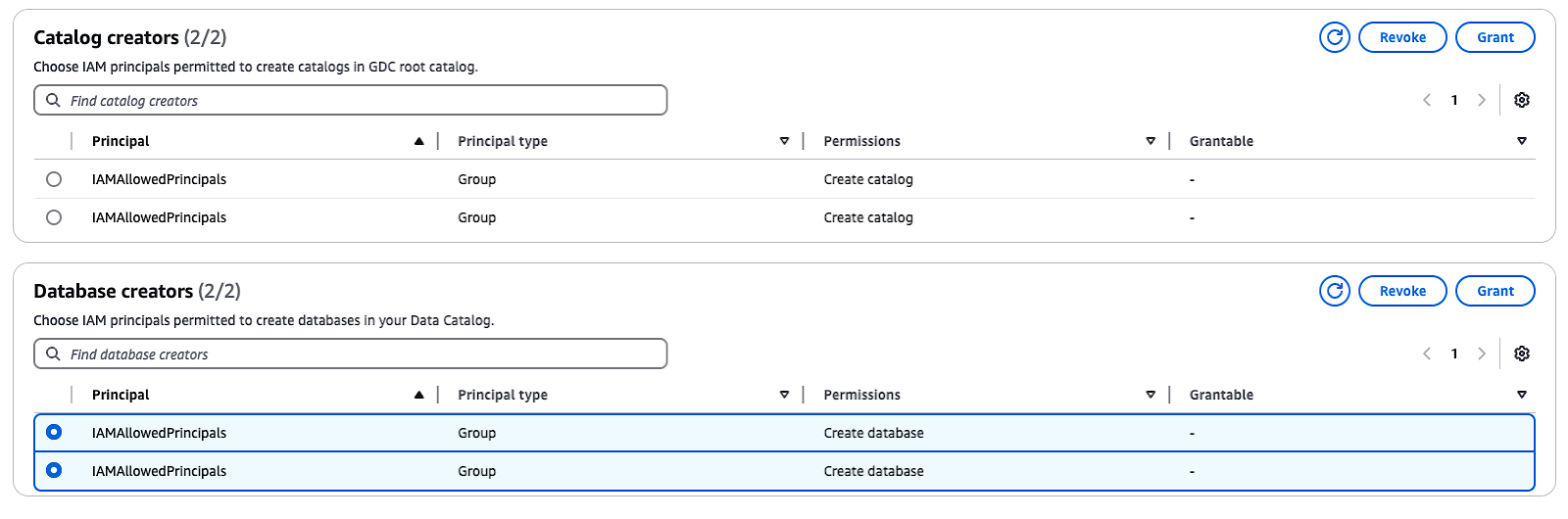

Por defecto, Lake Formation tiene la opción "Utilizar sólo control de acceso IAM", que se selecciona para que sea compatible con el Catálogo de Datos de AWS Glue. Para activar el control de acceso de grano fino con los permisos de Formación de Lagos, debes ajustar estas opciones:

- En el panel de navegación, en Administraciónselecciona Funciones y tareas administrativas.

- Si el grupo

IAMAllowedPrincipalsaparece en Creadores de bases de datosselecciona el grupo y elige Revocar. - En el apartado Revocar permisos confirma que el grupo tiene los permisos Crear base de datos y haz clic en Revocar.

Estos pasos desactivarán el control de acceso IAM por defecto y te permitirán implementar los permisos de Formación de Lagos para mejorar la seguridad.

Administrar creadores de catálogos y bases de datos en AWS Formación del Lago

Paso 3: Uso del catálogo de datos de AWS Glue

Ahora, es el momento de poner en práctica el Catálogo de Datos Pegados.

Crear una base de datos

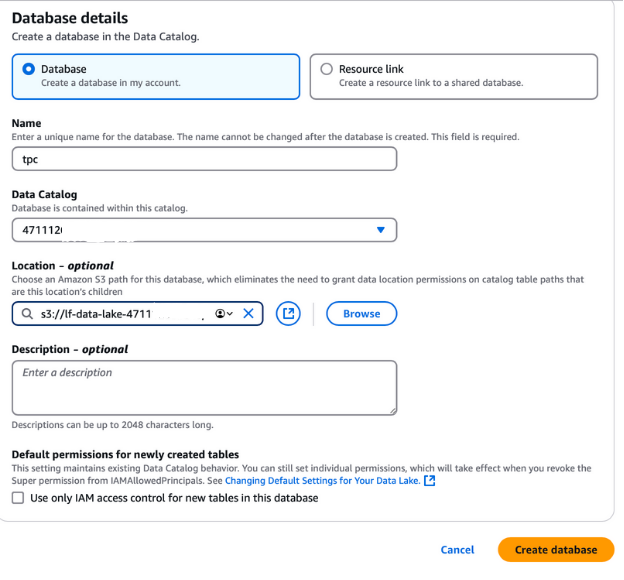

Para crear una base de datos para los datos de la TPC, cierra la sesión actual de AWS y vuelve a entrar como usuario de lf-data-admin. Utiliza el enlace de inicio de sesión proporcionado en la salida de CloudFormation y la contraseña recuperada de AWS Secrets Manager.

- Navega hasta la Formación de lagos de AWS y selecciona Bases de datos en el panel de navegación izquierdo.

- Haz clic en el botón Crear base de datos Crear base de datos.

- Nombra la base de datos "tpc", ya que se utilizará para el lago de datos TPC.

- En el campoUbicación, selecciona la ruta del lago de datos S3 creada por la pila CloudFormation. Esta ruta se encuentra en la pestaña de salida de CloudFormation y se llamará

lf-data-lake-account-ID, dondeaccount-IDes tu número de cuenta de AWS de 12 dígitos. - Desmarca la opción Utilizar sólo control de acceso IAM para nuevas tablas en esta base de datos para activar el control de acceso fino.

- Deja todas las demás opciones en sus valores por defecto y haz clic en Crear base de datos.

Esta base de datos será la base para almacenar y gestionar los metadatos de los datos de la TPC en la configuración de la Formación del Lago.

Crear una base de datos en AWS Formación del Lago

Hidratar el Lago de Datos

Utilizamos un AWS Glue Crawler para crear tablas en el Catálogo de Datos de AWS Glue. Los rastreadores son la forma más común de crear tablas en AWS Glue, ya que pueden escanear varios almacenes de datos a la vez y generar o actualizar los detalles de las tablas en el Catálogo de Datos una vez realizado el rastreo.

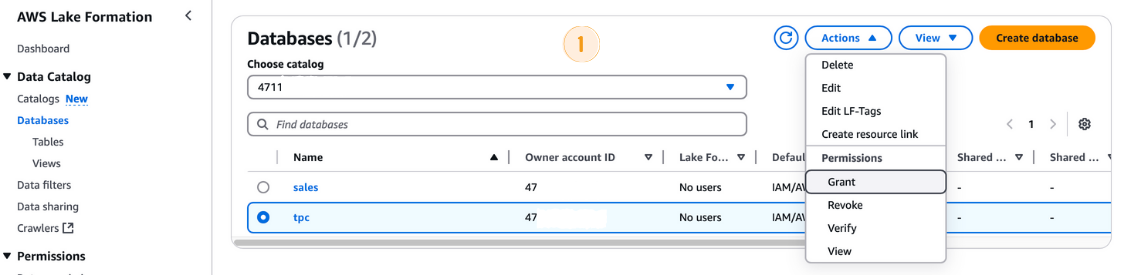

Antes de ejecutar el AWS Glue Crawler, tienes que conceder los permisos necesarios a su rol IAM:

- En la consola de AWS Formación del Lago, navega a Bases de datos y selecciona la

tpcbase de datos. - De las Acciones selecciona Conceder.

- En la sección Conceder permisos :

- En Directoresselecciona el rol IAM

LF-GlueServiceRole. - En los Etiquetas LF o recursos del catálogo asegúrate de que Recursos de catálogo de datos nombrados está seleccionado.

- Selecciona

tpccomo base de datos. - En la sección Permisos de la base de datos marca la casilla Crear tabla de la base de datos.

- Haz clic en Concede.

Concesión de permisos en la Formación del Lago AWS

Ejecutar el rastreador de cola de AWS

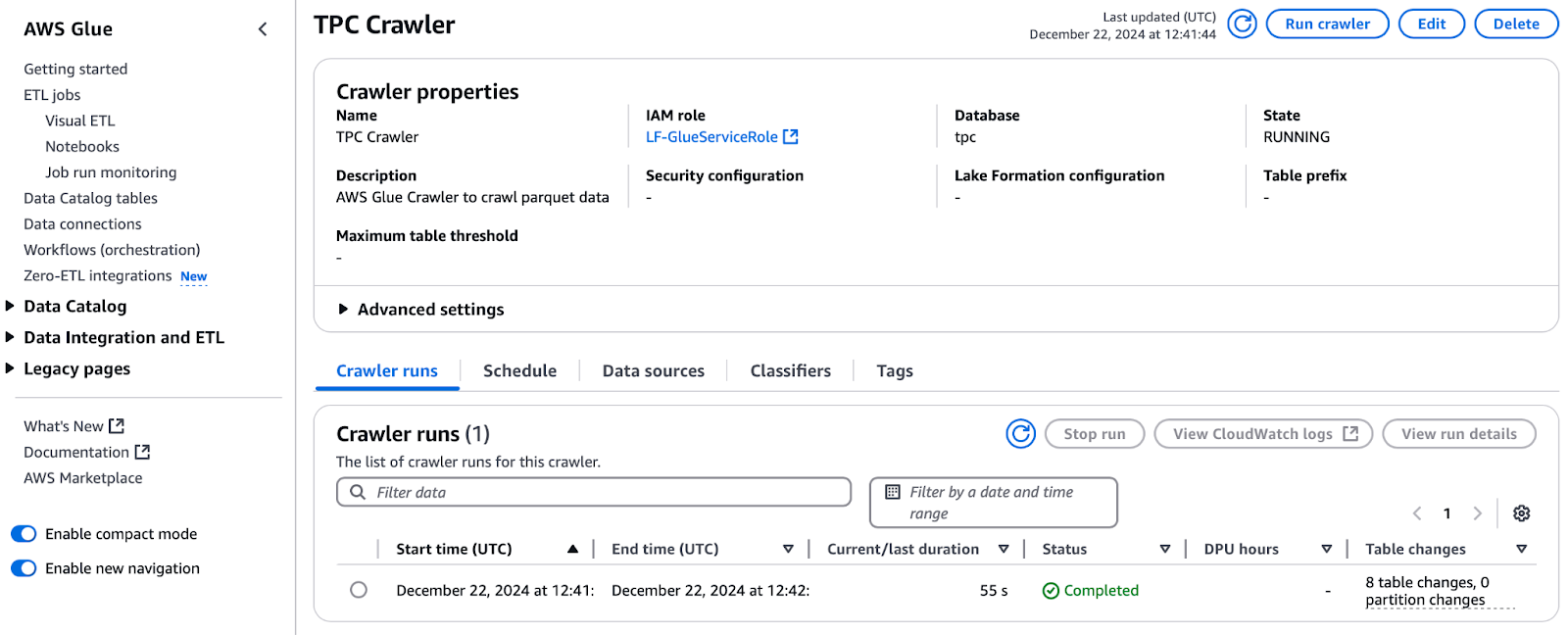

Con los permisos concedidos, procede a ejecutar el rastreador:

- En la consola de AWS Formación de Lagos, navega hasta Rastreadores y haz clic para abrir el Pegamento de AWS de AWS.

- Selecciona el crawler llamado Rastreador TPC y pulsa Ejecutar rastreador.

- Controla el progreso pulsando el botón Actualizar Actualizar.

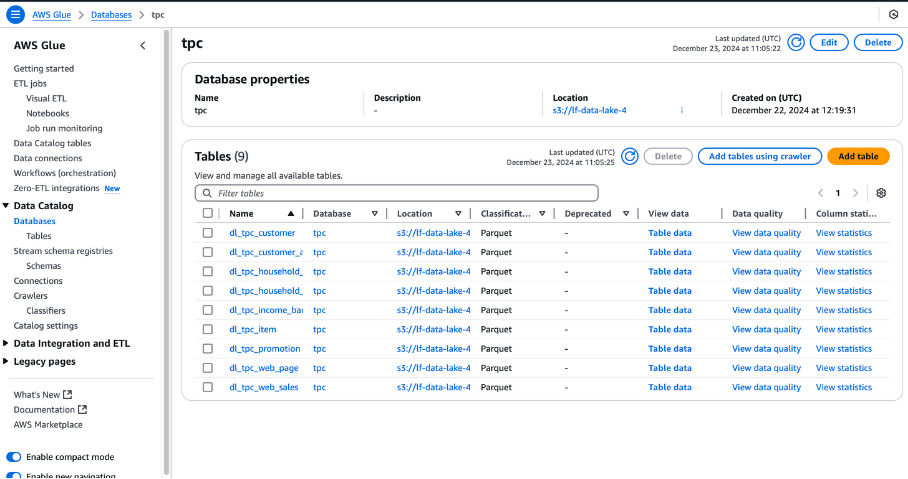

- Una vez completada, la base de datos TPC se llenará con tablas. Comprueba los Cambios en las tablas desde la última ejecución para ver el número de tablas añadidas (por ejemplo, 8 tablas).

Ejecutar el rastreador TPC en AWS Glue

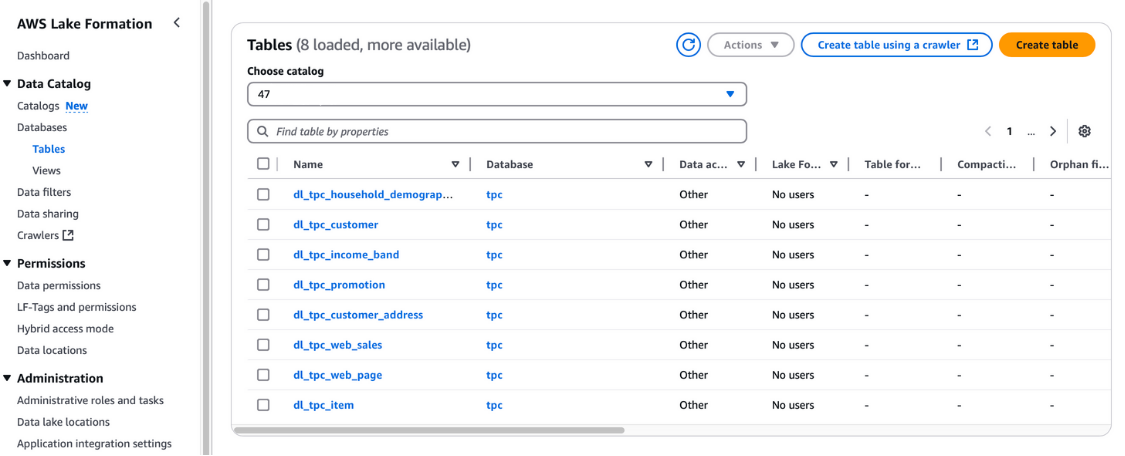

También puedes verificar estas tablas en la consola de AWS Formación del Lago en Catálogo de datos y Tablas.

Visualización de las mesas en la Formación del Lago AWS

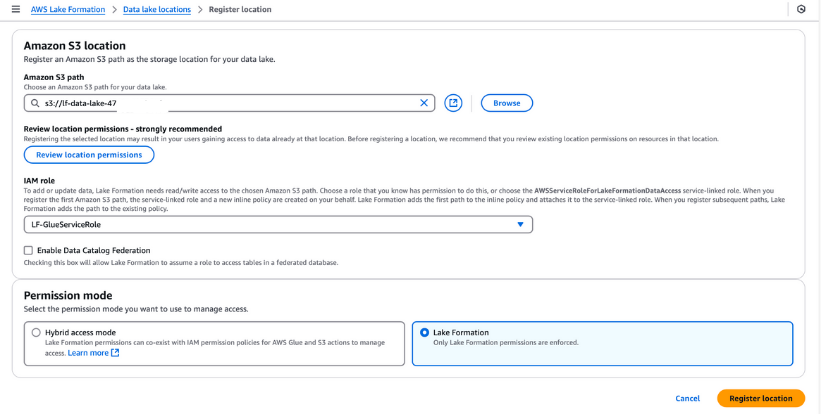

Registrar ubicaciones de Data Lake

Debes registrar el bucket S3 en AWS Formación del Lago para el almacenamiento de tu lago de datos. Este registro te permite aplicar un control de acceso detallado a los objetos del Catálogo de Datos de AWS Glue y a los datos subyacentes almacenados en el bucket.

Pasos para registrar una ubicación de Lago de Datos:

- Navega hasta Ubicaciones de los lagos de datos en la consola de formación de lagos de AWS y haz clic en Registrar ubicación.

- Introduce la ruta al bucket de S3 creado a través de la plantilla de CloudFormation. Este cubo almacenará los datos ingestados durante el proceso de canalización.

- Para el Rol IAMselecciona el

LF-GlueServiceRolecreado por la plantilla CloudFormation. - En Modo de permisoselecciona Formación de lagos para activar las funciones avanzadas de control de acceso.

- Haz clic en Registrar ubicación para guardar tu configuración.

Una vez registrado, comprueba la ubicación de tu lago de datos para asegurarte de que está correctamente configurado. Este paso es esencial para una gestión de datos y una seguridad sin fisuras en tu configuración de Formación del Lago.

Registrar una ubicación de Amazon S3 en AWS Formación de Lagos

Etiquetas de Formación del Lago (LF-Tags)

Las etiquetas LF se pueden utilizar para organizar recursos y establecer permisos en muchos recursos a la vez. Te permite organizar los datos mediante taxonomías y, así, desglosar políticas complejas y gestionar los permisos con eficacia. Esto es posible porque con las etiquetas LF puedes separar la política del recurso y, por tanto, puedes establecer políticas de acceso incluso antes de que se creen los recursos.

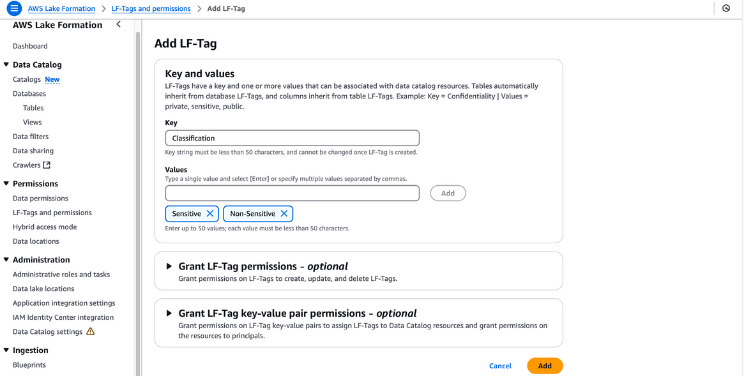

Pasos para crear y asignar etiquetas LF

- Crear etiquetas LF:

- Navega hasta la consola Formación de Lagos en AWS Formación de Lagos.

- En el panel de navegación, selecciona LF-Etiquetas y permisosy haz clic en Añadir etiqueta LF.

- Proporciona "Clasificación" como clave y añade "Sensible" y "No sensible" como valores. Haz clic en Añadir etiqueta LF.

Creación de etiquetas LF en la formación de lagos AWS

- Concede permisos a la etiqueta LF:

- Asegúrate de que el usuario

lf-data-admintiene permisos LF-Tag. Navega hasta Tablas en la consola Formación del Lago. - Selecciona la tabla

dl_tpc_customer, haz clic en acciones y elige Conceder. - En Usuarios y roles IAMselecciona

lf-data-admin. - Para las etiquetas LF o los recursos de catálogo, selecciona Recursos de catálogo de datos nombrados.

- Elige la base de datos

tpcy la tabladl_tpc_customer, concediendo permisos a la tablaAlter. Haz clic en Concede.

Concesión de permisos en la Formación del Lago AWS

- Asigna etiquetas LF a los objetos del Catálogo de Datos:

- Navega hasta Tablas y selecciona la tabla

dl_tpc_customer. Abre los detalles de la tabla y selecciona Editar etiquetas LF en el menú de acciones. - Haz clic en Asignar nueva etiqueta LFproporciona "Clasificación" como clave y establece "No sensible" como valor. Haz clic en Guardar.

- En el menú de acciones de la tabla, selecciona Editar esquema. Selecciona columnas como

c_first_name,c_last_name, yc_email_address, y haz clic en Editar etiquetas LF. - Para la clave heredada

Classification, cambia el valor a "Sensible" y haz clic en Guardar. Guarda esta configuración como una nueva versión. - Aplica etiquetas LF a tablas adicionales:

- Para consultar la tabla

dl_tpc_household_demographics, ve a Acciones y selecciona Editar etiquetas LF. - En el cuadro de diálogo, haz clic en Asignar nueva etiqueta LF. Establecer Grupo como clave y Analista como valor. Haz clic en Guardar para finalizar.

Siguiendo estos pasos, puedes asignar eficazmente etiquetas LF a tus objetos del Catálogo de Datos, garantizando un control de acceso seguro y detallado en todo tu lago de datos.

Paso 4: Crear un trabajo ETL en AWS Glue

AWS Glue Studio es una interfaz de usuario de arrastrar y soltar que ayuda a los usuarios a desarrollar, depurar y monitorizar trabajos ETL para AWS Glue. Los ingenieros de datos aprovechan Glue ETL, basado en Apache Spark, para transformar conjuntos de datos almacenados en Amazon S3 y cargar datos en lagos de datos y almacenes para su análisis. Para administrar eficazmente el acceso cuando varios equipos colaboran en los mismos conjuntos de datos, es importante facilitar el acceso y restringirlo según las funciones.

Conceder permisos con AWS Formación de lagos

Sigue estos pasos para conceder los permisos necesarios al usuario lf-data-engineer y al rol correspondiente DE-GlueServiceRole. Este rol lo utiliza el ingeniero de datos para acceder a las tablas del Catálogo de Datos Glue en los trabajos de Glue Studio.

- Inicia sesión como Administrador del Lago de Datos:

- Utiliza el usuario

lf-data-adminpara acceder a la consola de administración de AWS. Recupera la contraseña de AWS Secrets Manager y la URL de inicio de sesión de la salida de CloudFormation.

- Utiliza el usuario

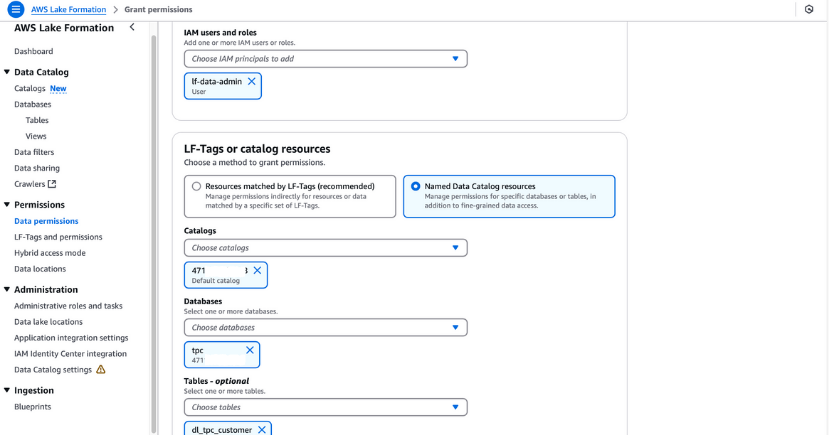

- Conceder permisos de selección para una tabla:

- Navegar a Permisos del lago de datos en la consola Formación del Lago.

- Haz clic en Concedery, en el cuadro de diálogo, proporciona la siguiente información:

- Usuarios y roles IAM: Introduce

lf-data-engineeryDE-GlueServiceRole. - LF-Etiquetas o recursos del catálogo: Selecciona Recursos del catálogo de datos con nombre.

- Bases de datos: Elige

tpc. - Tablas: Elige

dl_tpc_household_demographics. - Permisos de mesa: Selecciona Selecciona y Describe.

- Usuarios y roles IAM: Introduce

- Haz clic en Conceder para guardar los permisos.

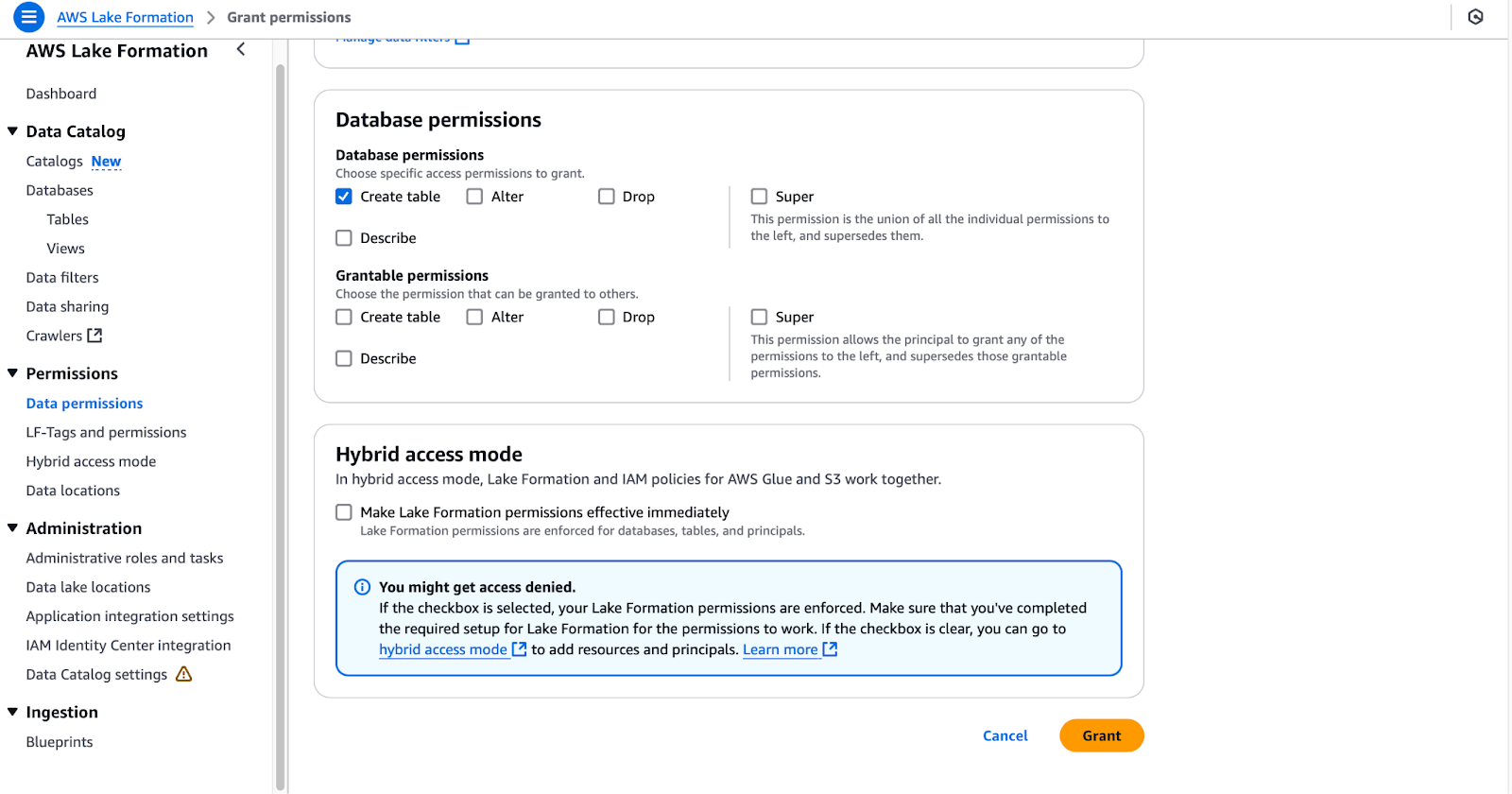

- Conceder permisos de creación de tablas para una base de datos:

- Navegar a Permisos del Lago de Datos de nuevo.

- Haz clic en Concedery, en el cuadro de diálogo, proporciona la siguiente información:

- Usuarios y roles IAM: Entra en

DE-GlueServiceRole. - LF-Etiquetas o recursos del catálogo: Selecciona Recursos del catálogo de datos con nombre.

- Bases de datos: Elige

tpc(deja las tablas sin seleccionar). - Permisos de la base de datos: Selecciona Crear tabla.

- Usuarios y roles IAM: Entra en

- Haz clic en Conceder para finalizar los permisos.

Configurar los permisos de la base de datos en AWS Formación de Lagos

Completar estos pasos dará al usuario lf-data-engineer y al rol DE-GlueServiceRole los permisos necesarios para trabajar con las tablas del Catálogo de Datos Glue y gestionar los recursos en los trabajos de Glue Studio. Esta configuración garantiza un acceso seguro y basado en roles a tu lago de datos.

Creación de trabajos ETL de Glue Studio

En esta sección, crearemos un trabajo ETL en AWS Glue Studio utilizando la Transformación SQL.

- Inicia sesión en AWS como

lf-data-engineer:- Utiliza el usuario

lf-data-engineerpara acceder a la consola de administración de AWS. Recupera la contraseña de AWS Secrets Manager y la URL de inicio de sesión proporcionada por la salida de CloudFormation.

- Utiliza el usuario

- Abre Glue Studio e inicia un nuevo trabajo:

- Navega a la consola de Glue Studio y haz clic en ETL visual.

- Cambia el nombre del trabajo a

LF_GlueStudiopara poder identificarlo fácilmente.

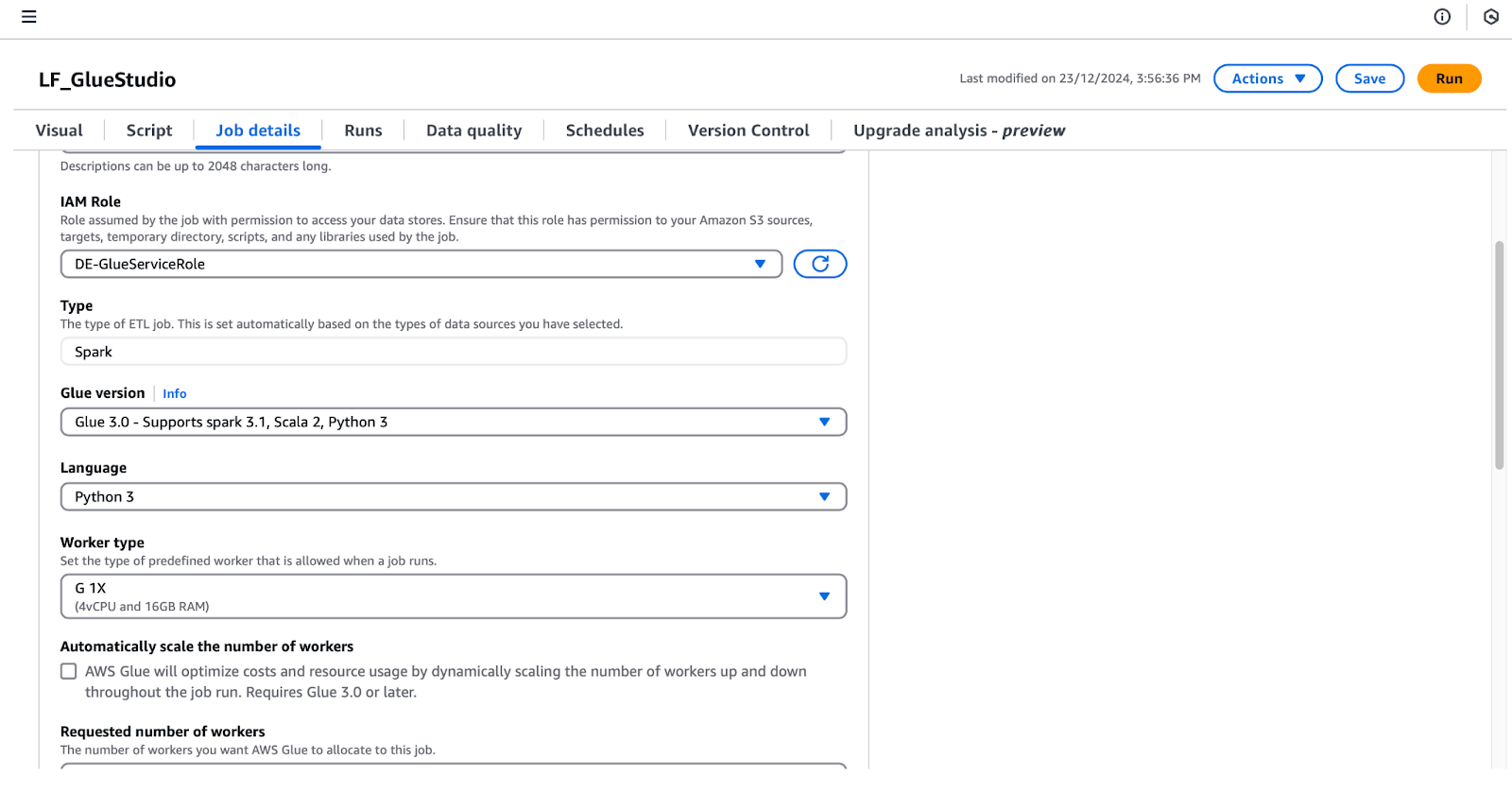

- Configura los detalles del trabajo:

- Haz clic en Detalles del trabajo para establecer las siguientes configuraciones:

- Función IAM: Selecciona

DE-GlueServiceRole. - Versión con pegamento: Selecciona Glue 5.0 - Compatible con Spark 3.1, Scala 2, Python 3.

- Número de trabajadores solicitado: Pon 5.

- Marcador de trabajo: Selecciona Desactivar.

- Número de reintentos: Ponlo a 0.

- Función IAM: Selecciona

- Haz clic en Detalles del trabajo para establecer las siguientes configuraciones:

Configurar los detalles del trabajo en AWS Glue Studio

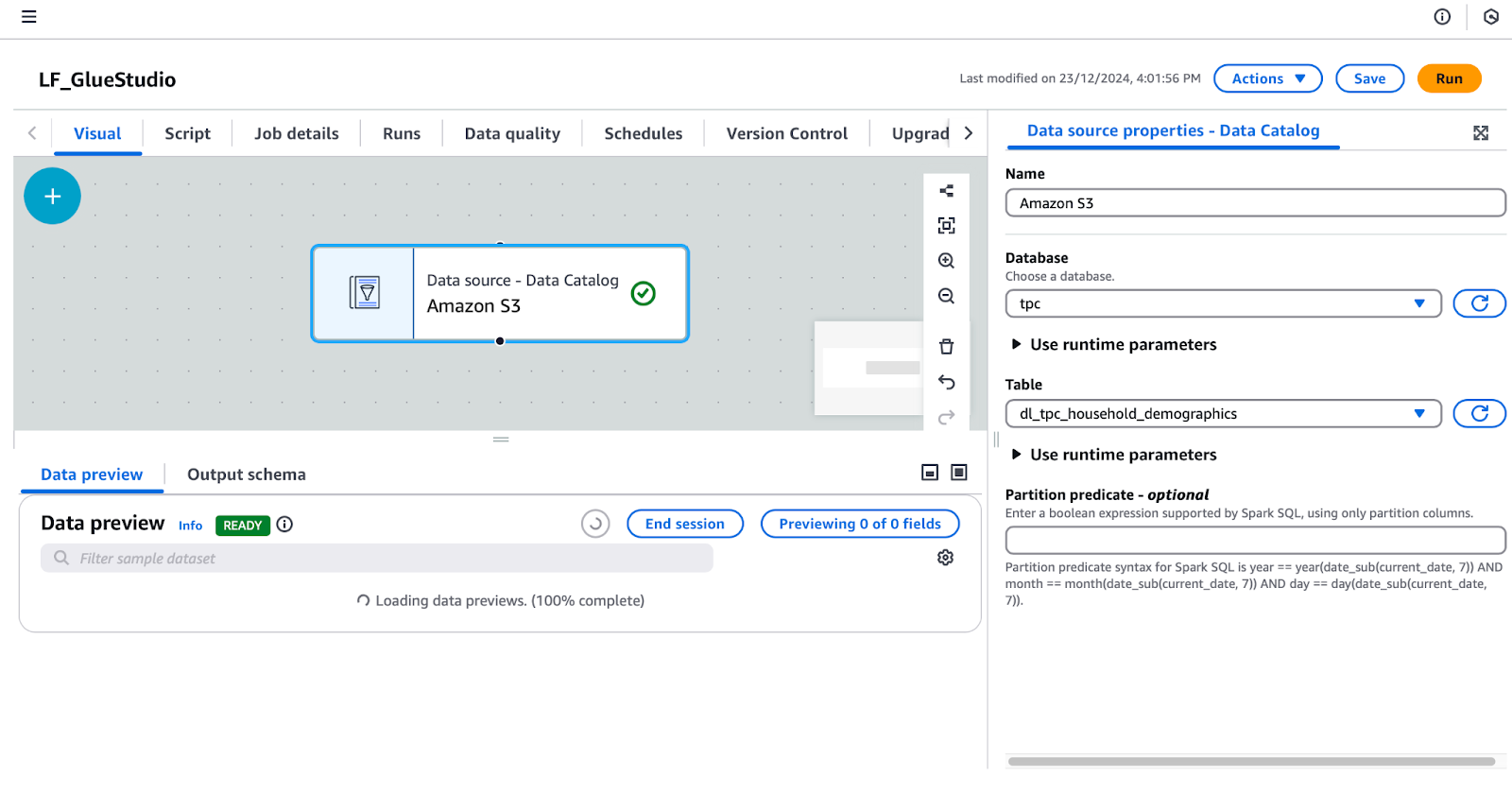

- Añade un nodo de fuente de datos:

- Bajo la Visual haz clic en el botón + y añade un Catálogo de datos de AWS Glue para configurar la fuente de datos. Cambia el nombre de este nodo a "Amazon S3".

- Selecciona Amazon S3 en el editor visual y configura sus propiedades en el panel derecho:

- En Propiedades de la Fuente de Datos - Catálogo de Datosestablece:

- Base de datos:

tpc. - Tabla:

dl_tpc_household_demographics. (Nota: El usuariolf-data-adminsólo tiene concedido el permisolf-data-engineerSeleccionar en esta tabla. Las demás tablas no aparecerán en el desplegable).

Configurar una fuente de datos en AWS Glue Studio

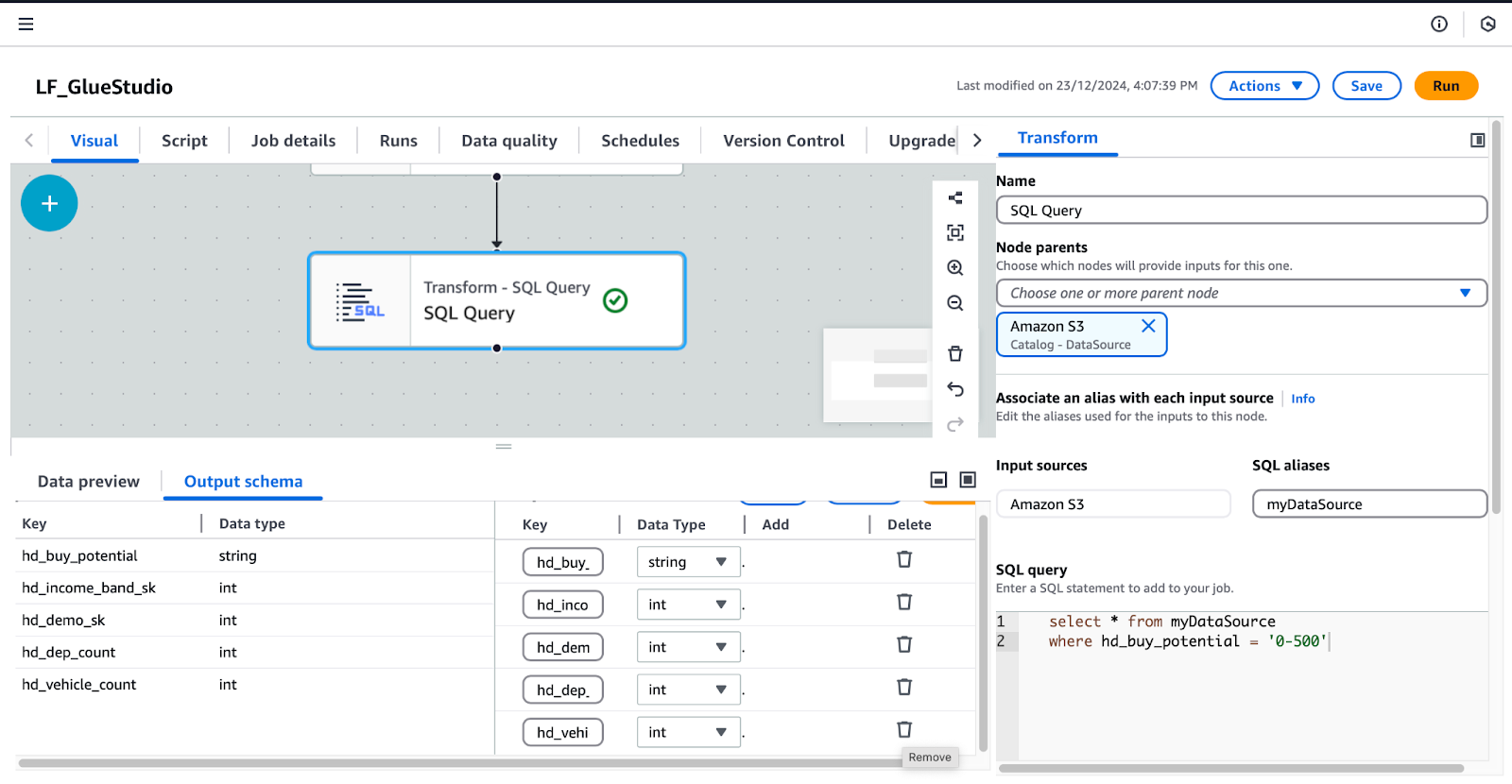

- Añade y configura el nodo Consulta SQL:

- Con el nodo de Amazon S3 seleccionado, haz clic en el botón + y añade un nodo de Consulta SQL como transformación.

- Selecciona la Consulta SQL y configúralo:

- En Transformarintroduce tu consulta SQL en el campo Consulta SQL en el campo Consulta SQL.

- Añade esta consulta:

/* Select all records where buy potential is between 0 and 500 */

SELECT *

FROM myDataSource

WHERE hd_buy_potential = '0-500';-

-

- En Esquema de salidahaz clic en Editar y elimina las claves

hd_dep_countyhd_vehicle_count. Haz clic en Aplica.

- En Esquema de salidahaz clic en Editar y elimina las claves

-

Configuración de la transformación de consultas SQL en AWS Glue Studio

- Añade un nodo de destino de datos:

- Con la Consulta SQL seleccionado, haz clic en el botón + y añade un nodo Destino de Datos. Selecciona Objetivo Amazon S3 en los resultados de la búsqueda.

- Configura el nodo Datos Objetivo-S3 en el panel derecho:

- Formato: Selecciona Parquet.

- Tipo de compresión: Selecciona Rápido.

- Ubicación del objetivo S3: Entra en

s3:///gluestudio/curated/. (Sustituyepor el nombre real del cubo de la pestaña Salidas de CloudFormation). - Opciones de actualización del Catálogo de datos: Selecciona Crear una tabla en el Catálogo de datos y, en ejecuciones posteriores, actualizar el esquema y añadir nuevas particiones.

- Base de datos: Selecciona

tpc. - Nombre de la tabla: Proporciona un nombre para la tabla de salida. Por ejemplo,

dl_tpc_household_demographics_below500. - Guarda y revisa el trabajo:

- Haz clic en Guardar en la esquina superior derecha para guardar el trabajo.

- Opcionalmente, cambia a la función Guión para ver el guión generado automáticamente. Puedes descargar o editar este script si lo necesitas.

Siguiendo estos pasos, crearás un trabajo ETL de Glue Studio totalmente funcional que transforme los datos y escriba los resultados en una carpeta S3 curada, al tiempo que actualiza el Catálogo de Datos de Glue.

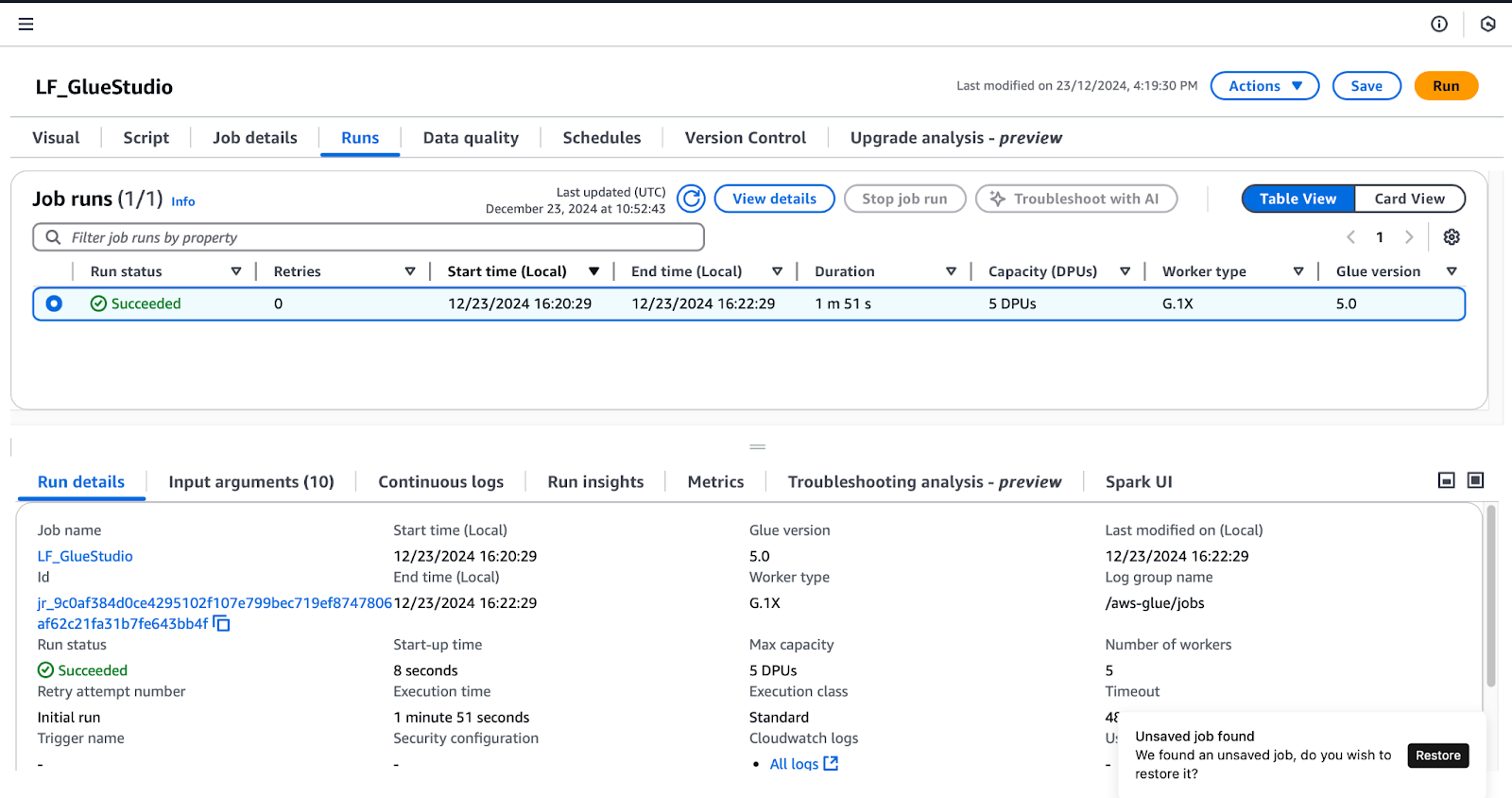

Paso 5: Probar y validar la integración

Para confirmar los permisos concedidos en Lake Formation, sigue estos pasos mientras estás conectado como usuario de lf-data-engineer (como se detalla en la sección Crear trabajos de Glue Studio ):

- Ejecuta el trabajo

LF_GlueStudio: - Navega hasta el LF_GlueStudio y haz clic en el botón Ejecutar de la esquina superior derecha para ejecutar la tarea.

- Supervisa la ejecución del trabajo seleccionando el botón Ejecuciones en la interfaz de la tarea.

Monitorización de la ejecución de trabajos en AWS Glue Studio

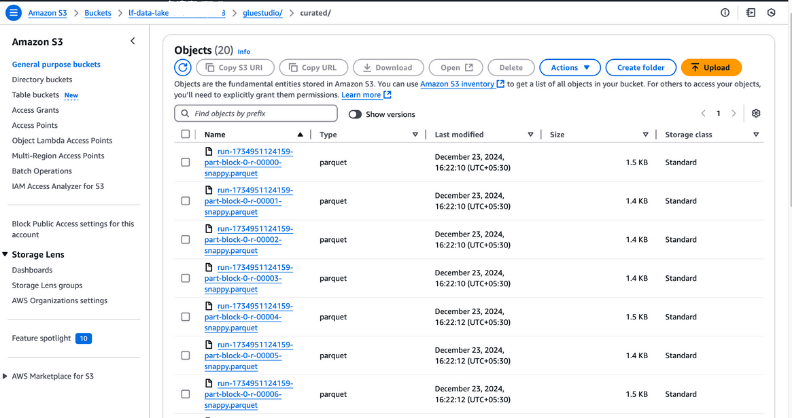

- Verifica la salida del trabajo:

- Una vez que el estado de ejecución del trabajo muestre Succeeded, ve a la carpeta

curatedde tu bucket S3 para comprobar los archivos de salida. Estos archivos deben estar en formato Parquet, tal y como se configuró durante la creación del trabajo.

Ver archivos de salida en Amazon S3

- Verifica la tabla recién creada:

- Abre el Catálogo de Datos Glue y navega hasta la base de datos que especificaste durante la configuración del trabajo.

- Comprueba que la nueva tabla aparece en la base de datos, confirmando que los datos de salida se han catalogado correctamente.

Ver tablas de bases de datos en AWS Glue

Mejores prácticas para integrar AWS Lake Formation y AWS Glue

Al integrar AWS Lake Formation y AWS Glue, seguir las mejores prácticas puede mejorar la seguridad de los datos, agilizar las operaciones y optimizar el rendimiento. A continuación te explicamos cómo puedes aprovechar al máximo estos servicios:

Optimizar los permisos de datos

- Adoptar el principio del menor privilegio: Concede a los usuarios y roles acceso sólo a los recursos que necesiten. Evita asignar permisos amplios que puedan exponer datos sensibles o recursos críticos innecesariamente.

- Auditar periódicamente las políticas de acceso: Revisa y actualiza periódicamente las políticas para cumplir los cambiantes requisitos de seguridad y conformidad. Aprovecha herramientas como AWS IAM Access Analyzer para detectar políticas demasiado permisivas.

- Aprovechar las etiquetas LF para la gestión de políticas: Utiliza las Etiquetas de Formación de Lagos (LF-Tags) para agrupar recursos relacionados y simplificar la gestión de permisos. Aplicando etiquetas como Sensible o No sensible, puedes crear políticas escalables y reutilizables que se apliquen automáticamente a los recursos etiquetados.

- Desvincular las políticas de los recursos: Define los permisos mediante etiquetas LF o plantillas antes de crear los recursos. Esto garantiza un proceso de integración sin fisuras a medida que se añaden nuevas fuentes de datos o tablas.

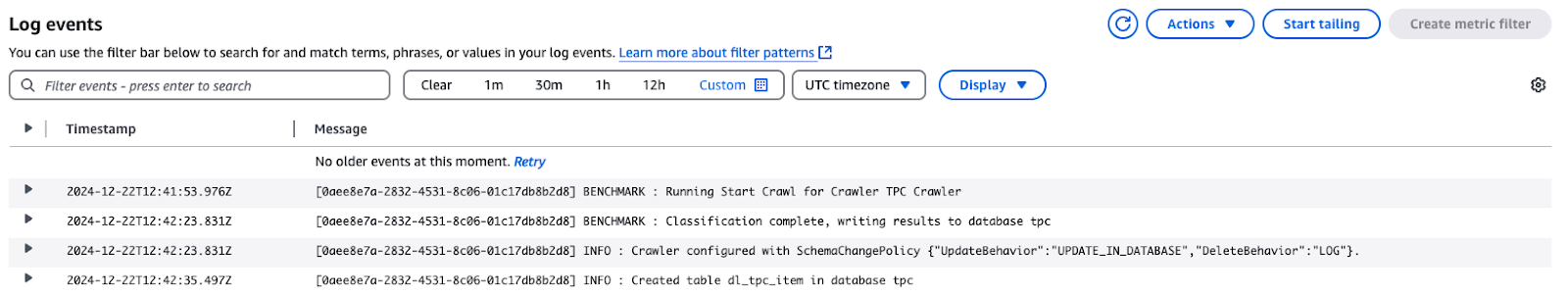

Supervisar y depurar trabajos

- Activar los registros de CloudWatch para los trabajos de Glue: CloudWatch Logs puede capturar registros detallados de las ejecuciones de trabajos de AWS Glue, incluyendo errores y detalles de ejecución. Utiliza estos registros para solucionar problemas rápidamente.

Registrar eventos para TPC Crawler en AWS CloudWatch

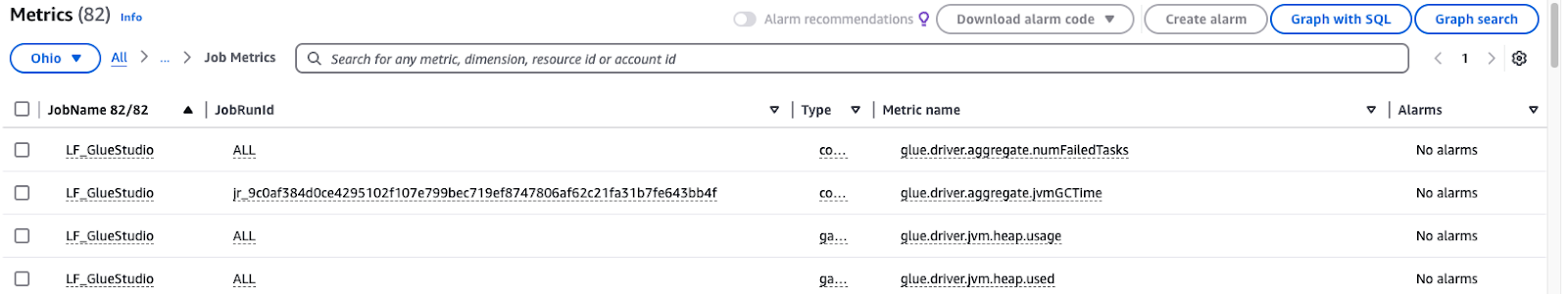

- Monitorizar métricas de pegamento: AWS Glue proporciona métricas para ayudar a identificar ineficiencias o problemas en tus flujos de trabajo ETL. Configura alarmas de CloudWatch para que te notifiquen patrones inusuales.

Monitorización de las métricas de trabajo de AWS Glue Studio

Utiliza la partición y la compresión

- Optimizar la partición de datos: Divide los conjuntos de datos según las características que se piden con frecuencia, como departamento, fecha o región. En Athena o Redshift, por ejemplo, dividir los datos de ventas por meses y años puede acelerar significativamente las consultas y reducir los costes de exploración.

- Elige el formato de compresión adecuado: Utiliza formatos de almacenamiento en columnas diseñados para cargas de trabajo analíticas, como ORC o Parquet. Combínalos con algoritmos de compresión eficaces como Snappy para ahorrar almacenamiento y acelerar las consultas.

- Automatizar la partición en trabajos Glue: Los trabajos de AWS Glue pueden particionar dinámicamente los datos durante el proceso ETL. Especifica claves de partición en la configuración de tu trabajo para garantizar que los datos entrantes se almacenan en un formato estructurado.

- Supervisa y ajusta las estrategias con regularidad: Evalúa lo bien que funcionan la compresión y la partición a medida que aumenta tu volumen de datos. Examina las tendencias de las consultas y, a continuación, modifica el esquema de partición para adaptarlo a las cargas de trabajo cambiantes.

Conclusión

La implementación de AWS Lake Formation y AWS Glue ayuda a la organización a organizar, salvaguardar y procesar los datos. Utilizando las amplias medidas de seguridad de Lake Formation y la automatización de Glue, puedes optimizar tus procesos ETL, cumplir todas las políticas relativas a la gobernanza de datos y facilitar el acceso a los datos a los usuarios, incluidos los ingenieros y científicos de datos.

Los beneficios incluyen:

- Seguridad mejorada: El control de acceso detallado con etiquetas LF garantiza que sólo los usuarios autorizados puedan acceder a los datos confidenciales.

- Automatización: AWS Glue simplifica la preparación y transformación de datos, reduciendo el esfuerzo manual y los errores.

- Escalabilidad: Los permisos dinámicos y la gestión de políticas permiten escalar sin problemas a medida que crecen los datos.

- Eficacia: El almacenamiento optimizado y el rendimiento de las consultas mediante partición y compresión ahorran tiempo y costes.

A medida que profundices en tu comprensión de la integración de datos, es esencial que complementes tu aprendizaje con conocimientos prácticos. Por ejemplo, dominar las canalizaciones de datos con ETL y ELT en Python puede elevar tu capacidad de procesar y transformar datos con eficacia. Del mismo modo, una sólida comprensión de los Conceptos de Gestión de Datos mejorará tu forma de estructurar y manejar los conjuntos de datos. Y para asegurarte de que tus resultados son fiables, es imprescindible comprender los principios que se enseñan en el curso Introducción a la Calidad de los Datos.

Preguntas frecuentes

¿Cuál es el propósito de integrar AWS Formación de Lagos y AWS Pegamento?

Implementando AWS Lake Formation y AWS Glue, es posible desarrollar canalizaciones de datos seguras, automatizadas y escalables. Esta integración proporciona un control de acceso exhaustivo, procesos ETL agilizados y una plataforma unificada de gestión de datos, análisis y cumplimiento.

¿Qué importancia tienen las marcas LF en la Formación Lago AWS?

Las etiquetas LF permiten gestionar los permisos en general, ya que, a través de ellas, los datos se organizan por determinadas taxonomías, por ejemplo, "Sensibles" o "No sensibles". Ayudan a reducir la complejidad de las políticas de acceso, ya que puedes establecer permisos basados en etiquetas, y antes de que se creen realmente los recursos, puedes hacerlo; esto proporciona un cierto nivel de flexibilidad, además de seguridad.

¿Qué papel desempeña AWS Glue Studio en esta integración?

AWS Glue Studio es una herramienta de conversión de datos con una interfaz de arrastrar y soltar. Los usuarios pueden desarrollar, supervisar y controlar los trabajos ETL a través de esta interfaz. Hace que los procesos de transformación de datos sean más eficaces y, por tanto, ayuda a transformar los datos para su posterior análisis.

¿Pueden acceder varios equipos al mismo conjunto de datos de forma segura?

Sí, AWS Formación de Lagos ofrece la posibilidad de un control de acceso detallado, en el que puedes conceder a los usuarios acceso a roles específicos o incluso a LF-Tags. De este modo, cada equipo sólo podrá ver los datos que le conciernan, y los propios datos estarán protegidos.

¿Qué es el conjunto de datos TPC mencionado en el artículo?

El conjunto de datos TPC es un conjunto de datos sintéticos ampliamente disponible para formación, evaluación comparativa y fines educativos. Contiene información sobre diversos productos, clientes, datos demográficos, ventas por Internet y otros datos relacionados con las transacciones, lo que lo hace más realista.

Rahul Sharma es embajador de AWS, arquitecto DevOps y bloguero técnico especializado en computación en la nube, prácticas DevOps y tecnologías de código abierto. Con experiencia en AWS, Kubernetes y Terraform, simplifica conceptos complejos para estudiantes y profesionales a través de atractivos artículos y tutoriales. A Rahul le apasiona resolver los retos de DevOps y compartir conocimientos para capacitar a la comunidad tecnológica.