programa

Las particiones son componentes esenciales dentro de la arquitectura distribuida de Kafka que permiten a Kafka escalar horizontalmente, permitiendo un procesamiento de datos en paralelo eficiente. Son los bloques de construcción para organizar y distribuir datos a través del clúster Kafka.

Piensa en ellos como canales individuales dentro de un tema donde se almacenan los mensajes. Cada partición puede tener varias réplicas repartidas entre distintos corredores, lo que garantiza la tolerancia a fallos y la redundancia de datos.

Además, las particiones proporcionan garantías de orden, asegurando que los mensajes dentro de una partición se procesen en el orden en que se produjeron. Esto hace que las particiones de Kafka sean fundamentales para mantener la integridad y coherencia de los datos, lo que es crucial para los escenarios de procesamiento de datos en tiempo real.

En este artículo, profundizaremos en lo siguiente:

- Aspectos básicos de la arquitectura de Kafka

- Por qué son importantes las particiones en Kafka

- Configurar particiones

- Gestión avanzada de particiones

- Solución de problemas comunes de las particiones

Conceptos básicos de la arquitectura de Kafka

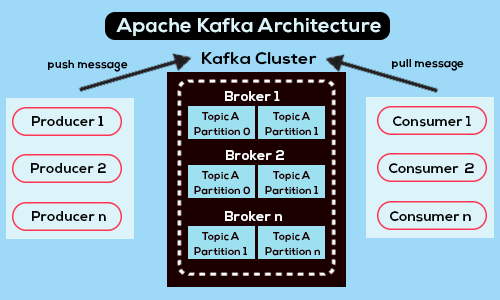

Una visión general de la arquitectura de Kafka - Fuente

Apache Kafka es una plataforma de streaming distribuido de código abierto diseñada para ofrecer un alto rendimiento, tolerancia a fallos y escalabilidad, lo que la convierte en una opción muy popular para crear canalizaciones de datos y aplicaciones en tiempo real.

En su núcleo, Kafka consta de múltiples componentes. Estos componentes incluyen productores, consumidores, intermediarios, temas y particiones, y cada uno desempeña un papel crucial en el sistema global.

- Los productores se encargan de generar datos y enviarlos a los temas Kafka. Publican mensajes a los brokers de Kafka, normalmente en formato clave-valor.

- Los intermediarios son los servidores que almacenan y gestionan los temas Kafka. Se encargan de la replicación, distribución y comunicación de datos entre productores y consumidores.

- Los temas son categorías lógicas o flujos de datos dentro de Kafka. Actúan como colas de mensajes donde los productores publican datos y los consumidores los recuperan.

- Las particiones son la unidad básica de almacenamiento y distribución de datos dentro de los temas Kafka.

- Los consumidores son aplicaciones o procesos que se suscriben a temas de Kafka para recuperar y procesar datos. Leen mensajes de una o varias particiones y pueden agruparse en grupos de consumidores para equilibrar la carga y procesar en paralelo.

La importancia de las particiones Kafka

Las particiones desempeñan un papel clave en la eficacia y robustez de Kafka. Facilitan la distribución de datos a través de los brokers de Kafka, permitiendo el escalado horizontal.

Al dividir los temas en particiones, Kafka puede repartir las cargas de trabajo de procesamiento de datos entre varios servidores, lo que permite una utilización eficiente de los recursos y acomodar volúmenes de datos cada vez mayores sin abrumar a los corredores individuales.

Además, las particiones también permiten el paralelismo en el procesamiento de datos. Los consumidores pueden leer de varias particiones simultáneamente, distribuyendo la carga computacional y mejorando el rendimiento. Este consumo paralelo de datos garantiza una utilización eficaz de los recursos de los consumidores y reduce la latencia en las cadenas de procesamiento de datos.

Otra razón por la que las particiones son importantes en Kafka es que ayudan con las capacidades de tolerancia a fallos de la plataforma. Cada partición puede tener varias réplicas distribuidas en distintos corredores. En caso de fallo de un broker, Kafka puede seguir sirviendo datos desde réplicas alojadas en otros brokers, garantizando la disponibilidad y fiabilidad de los datos.

Esencialmente, las particiones son importantes por múltiples razones. Son cruciales para la arquitectura de Kafka y desempeñan un papel fundamental para permitir la escalabilidad, la tolerancia a fallos, el paralelismo y la coherencia de los datos.

Cómo gestiona Kafka las particiones

Como se ha mencionado antes en el artículo, cada partición actúa como una secuencia segmentada, ordenada e inmutable de registros. Cuando un productor envía datos a Kafka, utiliza la lógica de partición para determinar en qué partición dentro de un tema deben escribirse los datos.

Esta lógica puede basarse en varios factores, como una clave asociada a los datos o un particionador personalizado implementado por el productor. Una vez determinada la partición, Kafka añade los datos al final de la partición, manteniendo el orden de los mensajes en función de sus desplazamientos.

Internamente, los brokers Kafka se encargan del almacenamiento y replicación de los datos de las particiones. Cada partición puede tener varias réplicas distribuidas en distintos corredores para garantizar la tolerancia a fallos.

Se emplea un modelo líder-seguidor en el que un corredor actúa como líder responsable de gestionar las peticiones de lectura y escritura de la partición, mientras que los demás corredores actúan como seguidores replicando los datos del líder. Esta configuración garantiza la durabilidad y disponibilidad de los datos, incluso en caso de fallo del intermediario.

Configurar particiones de Kafka

Antes de configurar una partición Kafka, asegúrate de que Apache Kafka y Zookeeper están instalados, configurados y funcionando en tu máquina local. Esto se recomienda para una compatibilidad óptima. Comprueba también que Java 8 o una versión más reciente está instalada y operativa.

Nota Kafka puede encontrar varios problemas cuando se instala en Windows debido a su falta de compatibilidad nativa con este sistema operativo. Por lo tanto, se recomienda utilizar los siguientes métodos para lanzar Apache Kafka en Windows:

- Considera el uso de WSL2 o Docker para Windows 10 o posterior

- Utiliza Docker para Windows 8 o anterior

Se desaconseja utilizar la JVM para ejecutar Kafka en Windows porque carece de ciertas características POSIX inherentes a Linux. Intentar ejecutar Kafka en Windows sin WSL2 puede provocar eventuales dificultades.

Puedes obtener más información sobre cómo configurar Apache Kafka en Apache Kafka para principiantes: Una guía completa.

Aquí tienes una guía paso a paso para configurar particiones:

Paso 1: Iniciar Zookeeper

Abre el símbolo del sistema y navega hasta el directorio raíz de Kafka. Una vez allí, ejecuta el siguiente comando para iniciar Zookeeper:

bin/zookeeper-server-start.sh config/zookeeper.propertiesPaso 2: Iniciar el servidor Kafka

Abre otro símbolo del sistema y ejecuta el siguiente comando desde la raíz de Apache Kafka para iniciar Apache Kafka:

.\bin\windows\kafka-server-start.bat .\config\server.propertiesPaso 3: Crear un tema con 3 particiones

Para crear un tema con tres particiones, inicia un nuevo símbolo del sistema desde el directorio raíz de Kafka y ejecuta el siguiente comando:

bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 3 --topic my_topicEsto creará un nuevo tema Kafka llamado "mi_tema".

Nota: para confirmar que se ha creado correctamente, al ejecutar el comando se devolverá “Create topic .”

Puedes verificar que el tema se ha creado correctamente ejecutando:

bin/kafka-topics.sh --list --zookeeper localhost:2181Que debería salir:

my_topicGestión avanzada de particiones

Repartición de temas existentes

Reparticionar temas existentes en Kafka implica modificar el recuento de particiones, lo que puede ser necesario para acomodar volúmenes de datos cambiantes, mejorar el paralelismo u optimizar la utilización de recursos.

He aquí algunas técnicas y consideraciones para reparticionar los temas existentes:

Cambiar el recuento de particiones

- Utiliza el comando

kafka-topics.sh --alterpara aumentar el número de particiones de un tema existente. Esto redistribuirá los datos entre las nuevas particiones. - Reducir el número de particiones es más complejo y puede implicar la migración de datos o el reprocesamiento para consolidar los datos de varias particiones en menos particiones.

Redistribución de datos

- Busca una distribución uniforme de los datos entre las particiones para maximizar el paralelismo y la utilización de los recursos.

- Supervisa regularmente la distribución de los datos para identificar cualquier partición con cantidades desproporcionadas de datos y tomar medidas correctoras.

Impacto en los consumidores

- La repartición puede afectar a los grupos de consumidores, especialmente si los consumidores confían en las asignaciones de particiones para la distribución de la carga de trabajo. Planifica los ajustes necesarios en las configuraciones de los grupos de consumidores.

Conservación y durabilidad de los datos

- Asegúrate de que se respetan las políticas de conservación de datos durante la repartición, para evitar pérdidas de datos o incoherencias.

- La repartición no debe comprometer la durabilidad ni la disponibilidad de los datos. Las réplicas deben mantenerse adecuadamente durante todo el proceso.

Tratamiento de datos durante el vuelo

- La repartición puede hacer que los datos de entrada se dirijan a particiones diferentes. Asegúrate de que los productores y los consumidores puedan manejar este escenario con elegancia.

Pruebas y validación

- Realiza operaciones de repartición en un entorno de ensayo para validar el impacto en el procesamiento de datos y el comportamiento del consumidor antes de aplicar los cambios en producción.

- Supervisa el rendimiento del clúster Kafka durante y después de la repartición para identificar cualquier problema y garantizar un rendimiento óptimo.

Equilibrio y optimización de las particiones

Optimizar el uso y el rendimiento de las particiones en Kafka es esencial para garantizar un procesamiento eficaz de los datos, la utilización de los recursos y la escalabilidad general del sistema.

Veamos algunas estrategias para equilibrar y optimizar las particiones:

Recuento óptimo de particiones

- Determina el número óptimo de particiones en función del volumen de datos, los requisitos de rendimiento y los recursos del clúster. Evita crear pocas o demasiadas particiones.

- Reevalúa periódicamente el recuento de particiones a medida que evolucionen los volúmenes de datos y las necesidades de procesamiento.

Configuraciones de grupos de consumidores

- Asegúrate de que las particiones de grupos de consumidores se alinean con las particiones de temas para maximizar el paralelismo y distribuir la carga de trabajo uniformemente entre los consumidores.

- Ajusta la configuración de reequilibrio del grupo de consumidores: Ajusta la configuración del reequilibrio de grupos de consumidores para minimizar las interrupciones y optimizar el uso de recursos durante el reequilibrio de grupos de consumidores.

Estrategias de partición de los productores

- Utiliza la partición basada en claves para garantizar que los mensajes relacionados se dirijan sistemáticamente a la misma partición, preservando el orden y permitiendo un procesamiento eficaz de los datos.

- Considera la posibilidad de asignar mensajes aleatoriamente a las particiones para distribuir la carga de trabajo uniformemente entre los corredores con el fin de equilibrar la carga.

Supervisión y ajuste

- Supervisa continuamente las métricas del clúster Kafka relacionadas con el uso de particiones, el rendimiento, la latencia y la utilización de recursos.

- Ajusta las configuraciones del corredor Kafka, como el tamaño de la pila, el tamaño de los búferes y los grupos de hilos, para optimizar el rendimiento y gestionar eficazmente los picos de carga de trabajo.

Ampliación y actualizaciones de hardware:

- Añade más intermediarios al clúster Kafka para distribuir las réplicas de partición y aumentar el rendimiento general y la tolerancia a fallos.

- Considera la posibilidad de actualizar los recursos de hardware, como la CPU, la memoria y el almacenamiento, para mejorar el rendimiento del clúster Kafka y gestionar mayores volúmenes de datos.

Solución de problemas comunes de las particiones

Kafka se ha convertido en la columna vertebral de muchas aplicaciones de uso intensivo de datos, pero para jugar con las palabras del Tío Ben de Spiderman, con un gran poder viene un mayor potencial de retos complejos.

Al utilizar Kafka pueden surgir algunos problemas comunes de partición. Esto puede deberse a una configuración incorrecta, a limitaciones de recursos, a una distribución desigual de los datos o a otra causa.

En esta sección, profundizaremos en los problemas habituales de las particiones y discutiremos cómo resolverlos.

Distribución desigual de los datos

Cuando los datos se distribuyen de forma desigual por las particiones, algunas de ellas pueden convertirse en puntos calientes, lo que provoca una utilización desigual de los recursos y posibles cuellos de botella en el rendimiento. La forma de evitarlo es supervisar constantemente la distribución de datos, lo que puede hacerse con las herramientas de supervisión de Kafka, como Kafka Manager o Confluent Control Center. Además, considera la posibilidad de aplicar una estrategia de partición personalizada o aumentar el número de particiones para conseguir distribuciones de datos más equilibradas.

Gran tamaño de la partición

Cuando una partición acumula una gran cantidad de datos a lo largo del tiempo, puede provocar una degradación del rendimiento y un aumento de la latencia durante la recuperación y el procesamiento de los datos.

La clave para resolver este problema es controlar regularmente el tamaño de las particiones y dividir las particiones grandes en otras más pequeñas para distribuir los datos de forma más uniforme. Además, ayuda a ajustar las políticas de retención para controlar la cantidad de datos almacenados en las particiones.

Particiones insuficientemente replicadas

Las particiones insuficientemente replicadas se producen cuando el número de réplicas sincronizadas (ISR) cae por debajo del mínimo configurado ante fallos del broker o problemas de red.

Para evitarlo, supervisa el estado de replicación de las particiones e investiga si hay particiones insuficientemente replicadas. Asegúrate de que el factor de replicación está configurado adecuadamente para mantener el nivel deseado de tolerancia a fallos. Aborda con prontitud cualquier problema relacionado con la conectividad de la red o los fallos del intermediario.

Desequilibrio del líder de la partición

Los líderes de las particiones gestionan, leen y escriben peticiones en un clúster Kafka. Un desequilibrio en los líderes de partición entre los corredores puede provocar una utilización desigual de los recursos y posibles problemas de rendimiento.

Esto puede evitarse controlando la distribución de los líderes de partición mediante Kafka Manager o Confluent Control Center y reequilibrando los líderes si es necesario. Además, considera la posibilidad de ajustar las configuraciones de los corredores para distribuir los líderes de partición uniformemente entre los corredores.

Desviación de la partición

El sesgo de partición se produce cuando determinadas particiones reciben un volumen de tráfico desproporcionadamente alto en comparación con otras, lo que provoca una utilización desigual de los recursos y una posible degradación del rendimiento. Por eso es importante analizar los patrones de tráfico.

Considera la posibilidad de aplicar una estrategia de particionamiento personalizada para distribuir los datos entre las particiones de forma uniforme y optimizar las configuraciones de los grupos de consumidores para distribuir la carga de trabajo entre los consumidores de forma uniforme.

Conclusión

Apache Kafka es una robusta plataforma de streaming distribuido que sirve de columna vertebral para numerosas aplicaciones intensivas en datos. En su núcleo se encuentra el concepto de particiones, que son unidades esenciales para organizar y distribuir los datos dentro de los temas de Kafka. Las particiones son fundamentales en el ecosistema de Kafka, ya que permiten la escalabilidad, la tolerancia a fallos, el paralelismo y el procesamiento eficiente de los datos.

Al distribuir los datos entre varios corredores, las particiones permiten a Kafka manejar grandes volúmenes de datos manteniendo un alto rendimiento y fiabilidad. Además, las particiones facilitan el procesamiento paralelo de los datos, garantizando una utilización óptima de los recursos y una latencia reducida.

En última instancia, la comprensión y la gestión eficaz de las particiones son fundamentales para maximizar el rendimiento y la fiabilidad de los clústeres Kafka, convirtiéndolos en componentes indispensables para crear canalizaciones y aplicaciones de datos en tiempo real escalables y resistentes.

Aquí tienes algunos recursos para continuar tu aprendizaje:

Preguntas frecuentes sobre las particiones de Kafka

¿Cuántas particiones tiene Apache Kafka?

El propio Apache Kafka no tiene un número predefinido de particiones. El número de particiones en los temas de Kafka es configurable y puede variar en función de factores como las necesidades de escalabilidad, el paralelismo de los consumidores, los requisitos de replicación y las características de la carga de trabajo. Los administradores o desarrolladores pueden ajustar el número de particiones para optimizar el rendimiento y la utilización de recursos para sus casos de uso específicos.

¿Cuántas particiones debo tener en Kafka?

El número ideal de particiones en Kafka depende de tu caso de uso específico, necesidades de escalabilidad y limitaciones de recursos. En general, busca un equilibrio entre rendimiento, paralelismo y tolerancia a fallos. Empieza con un número conservador y vigila de cerca el rendimiento, aumentando gradualmente si es necesario para satisfacer las demandas de tu aplicación, teniendo en cuenta factores como el paralelismo de los consumidores, la replicación y los recursos del corredor.

¿Para qué sirven las particiones múltiples en Kafka?

El uso de particiones múltiples es para facilitar la alta disponibilidad, la escalabilidad y el procesamiento eficaz de los datos. Para ser más concretos, la ayuda con lo siguiente:

- Escalabilidad: Permiten el escalado horizontal distribuyendo los datos entre varios corredores, lo que permite un mayor rendimiento y un procesamiento paralelo.

- Paralelismo: Cada partición puede ser consumida por un consumidor dentro de un grupo de consumidores, lo que permite procesar en paralelo los flujos de datos y mejorar el rendimiento general del sistema.

- Tolerancia a fallos: La replicación de particiones entre intermediarios garantiza la durabilidad de los datos y la tolerancia a fallos. Si falla un intermediario, otras réplicas pueden tomar el relevo, garantizando la disponibilidad continua de los datos.

Equilibrio de carga: Distribuir los datos entre particiones ayuda a equilibrar la carga de trabajo entre los corredores, evitando los puntos calientes y optimizando la utilización de los recursos.