Programa

As partições são componentes essenciais da arquitetura distribuída do Kafka que permitem que o Kafka seja dimensionado horizontalmente, possibilitando um processamento de dados paralelo eficiente. Eles são os blocos de construção para organizar e distribuir dados no cluster do Kafka.

Pense neles como canais individuais em um tópico em que as mensagens são armazenadas. Cada partição pode ter várias réplicas espalhadas por diferentes brokers, garantindo tolerância a falhas e redundância de dados.

Além disso, as partições oferecem garantias de ordenação, assegurando que as mensagens em uma partição sejam processadas na ordem em que foram produzidas. Isso faz com que as partições do Kafka sejam fundamentais para manter a integridade e a consistência dos dados, o que é crucial para cenários de processamento de dados em tempo real.

Neste artigo, vamos nos aprofundar nos seguintes aspectos:

- Noções básicas sobre a arquitetura do Kafka

- Por que as partições são importantes no Kafka

- Configuração de partições

- Gerenciamento avançado de partições

- Solução de problemas comuns de partição

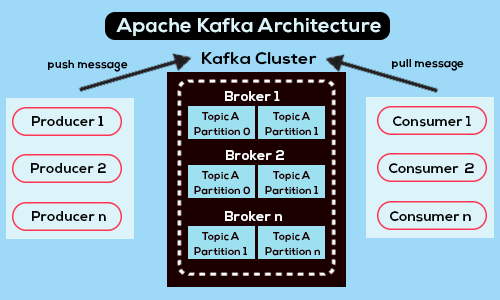

Noções básicas da arquitetura do Kafka

Uma visão geral da arquitetura do Kafka - Fonte

O Apache Kafka é uma plataforma de streaming distribuído de código aberto projetada para alta taxa de transferência, tolerância a falhas e escalabilidade, o que o torna uma opção popular para a criação de pipelines e aplicativos de dados em tempo real.

Em sua essência, o Kafka é composto por vários componentes. Esses componentes incluem produtores, consumidores, corretores, tópicos e partições, e cada um deles desempenha uma função crucial no sistema geral.

- Os produtores são responsáveis por gerar dados e enviá-los aos tópicos do Kafka. Eles publicam mensagens para os agentes do Kafka, geralmente em um formato de valor-chave.

- Os corretores são os servidores que armazenam e gerenciam os tópicos do Kafka. Eles lidam com a replicação, a distribuição e a comunicação de dados entre produtores e consumidores.

- Os tópicos são categorias lógicas ou fluxos de dados no Kafka. Eles funcionam como filas de mensagens em que os produtores publicam dados e os consumidores os recuperam.

- As partições são a unidade básica de armazenamento e distribuição de dados nos tópicos do Kafka.

- Os consumidores são aplicativos ou processos que se inscrevem nos tópicos do Kafka para recuperar e processar dados. Eles leem mensagens de uma ou mais partições e podem ser agrupados em grupos de consumidores para balanceamento de carga e processamento paralelo.

A importância das partições do Kafka

As partições desempenham um papel fundamental na formação da eficiência e da robustez do Kafka. Eles facilitam a distribuição de dados entre os corretores Kafka, permitindo o dimensionamento horizontal.

Ao dividir os tópicos em partições, o Kafka pode distribuir as cargas de trabalho de processamento de dados entre vários servidores, permitindo a utilização eficiente de recursos e acomodando volumes de dados cada vez maiores sem sobrecarregar os brokers individuais.

Além disso, as partições também permitem o paralelismo no processamento de dados. Os consumidores podem ler de várias partições ao mesmo tempo, distribuindo a carga computacional e aumentando a taxa de transferência. Esse consumo paralelo de dados garante a utilização eficiente dos recursos do consumidor e reduz a latência nos pipelines de processamento de dados.

Outro motivo pelo qual as partições são importantes no Kafka é que elas ajudam com os recursos de tolerância a falhas da plataforma. Cada partição pode ter várias réplicas distribuídas em diferentes brokers. No caso de falha de um broker, o Kafka pode continuar a fornecer dados de réplicas hospedadas em outros brokers, garantindo a disponibilidade e a confiabilidade dos dados.

Essencialmente, as partições são importantes por vários motivos. Eles são cruciais para a arquitetura do Kafka e desempenham um papel fundamental para permitir escalabilidade, tolerância a falhas, paralelismo e consistência de dados.

Como o Kafka gerencia as partições

Conforme mencionado anteriormente no artigo, cada partição funciona como uma sequência de registros segmentada, ordenada e imutável. Quando um produtor envia dados para o Kafka, ele usa a lógica de particionamento para determinar em qual partição de um tópico os dados devem ser gravados.

Essa lógica pode ser baseada em vários fatores, como uma chave associada aos dados ou um particionador personalizado implementado pelo produtor. Quando a partição é determinada, o Kafka anexa os dados ao final da partição, mantendo a ordem das mensagens com base em seus offsets.

Internamente, os agentes do Kafka lidam com o armazenamento e a replicação dos dados da partição. Cada partição pode ter várias réplicas distribuídas em diferentes brokers para garantir a tolerância a falhas.

Um modelo de líder e seguidor é empregado, no qual um corretor atua como líder responsável por lidar com solicitações de leitura e gravação para a partição, enquanto os outros corretores atuam como seguidores replicando dados do líder. Essa configuração garante a durabilidade e a disponibilidade dos dados, mesmo em caso de falhas do broker.

Configuração de partições do Kafka

Antes de instalar uma partição do Kafka, certifique-se de que o Apache Kafka e o Zookeeper estejam instalados, configurados e em execução no computador local. Isso é recomendado para uma compatibilidade ideal. Além disso, verifique se o Java 8 ou uma versão mais recente está instalado e funcionando.

Observação: o Kafka pode apresentar vários problemas quando instalado no Windows devido à falta de compatibilidade nativa com esse sistema operacional. Portanto, é recomendável que você utilize os seguintes métodos para iniciar o Apache Kafka no Windows:

- Considere usar o WSL2 ou o Docker para Windows 10 ou posterior

- Use o Docker para Windows 8 ou anterior

O uso do JVM para executar o Kafka no Windows é desaconselhado porque ele não possui determinadas características POSIX inerentes ao Linux. Se você tentar executar o Kafka no Windows sem o WSL2, poderá ter dificuldades.

Você pode saber mais sobre a configuração do Apache Kafka em Apache Kafka para iniciantes: Um guia abrangente.

Aqui está um guia passo a passo para você configurar partições:

Etapa 1: Iniciar o Zookeeper

Abra o prompt de comando e navegue até o diretório raiz do Kafka. Uma vez lá, execute o seguinte comando para iniciar o Zookeeper:

bin/zookeeper-server-start.sh config/zookeeper.propertiesEtapa 2: Iniciar o servidor Kafka

Abra outro prompt de comando e execute o seguinte comando na raiz do Apache Kafka para iniciar o Apache Kafka:

.\bin\windows\kafka-server-start.bat .\config\server.propertiesEtapa 3: Criar um tópico com 3 partições

Para criar um tópico com três partições, inicie um novo prompt de comando no diretório raiz do Kafka e execute o seguinte comando:

bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 3 --topic my_topicIsso criará um novo tópico do Kafka chamado "my_topic".

Observação: para confirmar que ele foi criado corretamente, a execução do comando retornará “Create topic .”

Você pode verificar se o tópico foi criado corretamente executando:

bin/kafka-topics.sh --list --zookeeper localhost:2181O que deve gerar:

my_topicGerenciamento avançado de partições

Repartição de tópicos existentes

O reparticionamento de tópicos existentes no Kafka envolve a modificação da contagem de partições, o que pode ser necessário para acomodar volumes de dados variáveis, melhorar o paralelismo ou otimizar a utilização de recursos.

Aqui estão algumas técnicas e considerações para reparticionar os tópicos existentes:

Alteração da contagem de partições

- Use o comando

kafka-topics.sh --alterpara aumentar a contagem de partições de um tópico existente. Isso redistribuirá os dados entre as novas partições. - A redução do número de partições é mais complexa e pode envolver a migração de dados ou o reprocessamento para consolidar dados de várias partições em menos partições.

Redistribuição de dados

- Procure distribuir uniformemente os dados entre as partições para maximizar o paralelismo e a utilização dos recursos.

- Monitore regularmente a distribuição de dados para identificar quaisquer partições com quantidades desproporcionais de dados e tome medidas corretivas.

Impacto sobre os consumidores

- O reparticionamento pode afetar os grupos de consumidores, especialmente se eles dependerem das atribuições de partição para a distribuição da carga de trabalho. Planeje os ajustes necessários para as configurações do grupo de consumidores.

Retenção e durabilidade de dados

- Certifique-se de que as políticas de retenção de dados sejam mantidas durante o reparticionamento para evitar perda ou inconsistência de dados.

- O reparticionamento não deve comprometer a durabilidade ou a disponibilidade dos dados. As réplicas devem ser mantidas adequadamente durante todo o processo.

Manuseio de dados a bordo

- O reparticionamento pode fazer com que os dados de voo sejam direcionados para partições diferentes. Certifique-se de que os produtores e os consumidores possam lidar com esse cenário de forma adequada.

Teste e validação

- Realize operações de reparticionamento em um ambiente de teste para validar o impacto no processamento de dados e no comportamento do consumidor antes de aplicar as alterações na produção.

- Monitore o desempenho do cluster do Kafka durante e após o reparticionamento para identificar quaisquer problemas e garantir o desempenho ideal.

Balanceamento e otimização de partições

Otimizar o uso e o desempenho da partição no Kafka é essencial para garantir o processamento eficiente de dados, a utilização de recursos e a escalabilidade geral do sistema.

Vamos dar uma olhada em algumas estratégias de balanceamento e otimização de partições:

Contagem ideal de partições

- Determine o número ideal de partições com base no volume de dados, nos requisitos de rendimento e nos recursos do cluster. Evite criar um número muito pequeno ou muito grande de partições.

- Reavalie periodicamente a contagem de partições à medida que os volumes de dados e os requisitos de processamento evoluem.

Configurações de grupos de consumidores

- Certifique-se de que as partições do grupo de consumidores estejam alinhadas com as partições de tópicos para maximizar o paralelismo e distribuir a carga de trabalho uniformemente entre os consumidores.

- Ajuste as configurações de rebalanceamento do grupo de consumidores: Ajuste as configurações de rebalanceamento do grupo de consumidores para minimizar as interrupções e otimizar o uso de recursos durante o rebalanceamento do grupo de consumidores.

Estratégias de particionamento do produtor

- Utilize o particionamento baseado em chaves para garantir que as mensagens relacionadas sejam encaminhadas de forma consistente para a mesma partição, preservando a ordem e permitindo o processamento eficiente dos dados.

- Considere a possibilidade de atribuir mensagens aleatoriamente a partições para distribuir a carga de trabalho uniformemente entre os brokers para fins de balanceamento de carga.

Monitoramento e ajuste

- Monitore continuamente as métricas do cluster do Kafka relacionadas ao uso da partição, à taxa de transferência, à latência e à utilização de recursos.

- Ajuste as configurações do broker do Kafka, como tamanho do heap, tamanho dos buffers e pools de threads, para otimizar o desempenho e lidar efetivamente com picos de carga de trabalho.

Dimensionamento e atualizações de hardware:

- Adicione mais brokers ao cluster do Kafka para distribuir réplicas de partição e aumentar a taxa de transferência geral e a tolerância a falhas.

- Considere a possibilidade de atualizar os recursos de hardware, como CPU, memória e armazenamento, para melhorar o desempenho do cluster Kafka e lidar com volumes de dados maiores.

Solução de problemas comuns de partição

O Kafka se tornou a espinha dorsal de muitos aplicativos com uso intensivo de dados, mas, para usar as palavras do Tio Ben do Homem-Aranha, com grande poder vem um maior potencial para desafios complexos.

Você pode ter alguns problemas comuns de partição ao usar o Kafka. Isso pode ser devido a configurações incorretas, restrições de recursos, distribuição desigual de dados ou outra coisa.

Nesta seção, vamos nos aprofundar nos problemas comuns de partição e discutir como resolvê-los.

Distribuição desigual de dados

Quando os dados são distribuídos de forma desigual entre as partições, algumas dessas partições podem se tornar pontos de acesso, resultando em utilização desigual de recursos e possíveis gargalos de desempenho. A maneira de contornar isso é monitorar constantemente a distribuição de dados, o que pode ser feito com as ferramentas de monitoramento do Kafka, como o Kafka Manager ou o Confluent Control Center. Além disso, considere implementar uma estratégia de particionamento personalizada ou aumentar a contagem de partições para obter distribuições de dados mais equilibradas.

Tamanho grande da partição

Quando uma partição acumula uma grande quantidade de dados ao longo do tempo, isso pode levar à degradação do desempenho e ao aumento da latência durante a recuperação e o processamento de dados.

A chave para resolver esse problema é monitorar regularmente o tamanho da partição e dividir partições grandes em menores para distribuir os dados de forma mais uniforme. Além disso, ele ajuda a ajustar as políticas de retenção para controlar a quantidade de dados armazenados nas partições.

Partições sub-replicadas

As partições sub-replicadas ocorrem quando o número de réplicas em sincronia (ISRs) cai abaixo do mínimo configurado diante de falhas do broker ou de problemas de rede.

Para evitar isso, monitore o status de replicação das partições e investigue se há alguma partição pouco replicada. Certifique-se de que o fator de replicação esteja configurado adequadamente para manter o nível desejado de tolerância a falhas. Resolva prontamente quaisquer problemas relacionados à conectividade da rede ou falhas do broker.

Desequilíbrio do líder da partição

Os líderes de partição manipulam, leem e gravam solicitações em um cluster do Kafka. Um desequilíbrio nos líderes de partição entre os brokers pode levar à utilização desigual de recursos e a possíveis problemas de desempenho.

Isso pode ser evitado monitorando a distribuição do líder da partição usando o Kafka Manager ou o Confluent Control Center e reequilibrando os líderes, se necessário. Além disso, considere ajustar as configurações do broker para distribuir os líderes de partição uniformemente entre os brokers.

Inclinação da partição

A distorção de partição ocorre quando determinadas partições recebem um volume de tráfego desproporcionalmente alto em comparação com outras, o que leva à utilização desigual de recursos e à possível degradação do desempenho. É por isso que é importante analisar os padrões de tráfego.

Considere a possibilidade de implementar uma estratégia de particionamento personalizada para distribuir uniformemente os dados entre as partições e otimizar as configurações do grupo de consumidores para distribuir uniformemente a carga de trabalho entre os consumidores.

Conclusão

O Apache Kafka é uma plataforma robusta de streaming distribuído que serve como espinha dorsal para vários aplicativos com uso intensivo de dados. Em seu núcleo está o conceito de partições, que são unidades essenciais para organizar e distribuir dados nos tópicos do Kafka. As partições são essenciais no ecossistema do Kafka, permitindo escalabilidade, tolerância a falhas, paralelismo e processamento eficiente de dados.

Ao distribuir os dados entre vários brokers, as partições permitem que o Kafka lide com grandes volumes de dados e, ao mesmo tempo, mantenha alta taxa de transferência e confiabilidade. Além disso, as partições facilitam o processamento paralelo de dados, garantindo a utilização ideal dos recursos e a redução da latência.

Por fim, a compreensão e o gerenciamento eficaz das partições são essenciais para maximizar o desempenho e a confiabilidade dos clusters do Kafka, tornando-os componentes indispensáveis na criação de aplicativos e pipelines de dados em tempo real escalonáveis e resilientes.

Aqui estão alguns recursos para você continuar aprendendo:

Perguntas frequentes sobre as partições do Kafka

Quantas partições o Apache Kafka tem?

O próprio Apache Kafka não tem um número predefinido de partições. O número de partições nos tópicos do Kafka é configurável e pode variar com base em fatores como necessidades de dimensionamento, paralelismo do consumidor, requisitos de replicação e características da carga de trabalho. Os administradores ou desenvolvedores podem ajustar o número de partições para otimizar o desempenho e a utilização de recursos para seus casos de uso específicos.

Quantas partições devo ter no Kafka?

O número ideal de partições no Kafka depende do seu caso de uso específico, das necessidades de escalabilidade e das restrições de recursos. Em geral, busque um equilíbrio entre taxa de transferência, paralelismo e tolerância a falhas. Comece com um número conservador e monitore o desempenho de perto, aumentando a escala gradualmente, se necessário, para atender às demandas do aplicativo, considerando fatores como paralelismo do consumidor, replicação e recursos do broker.

Qual é o uso de várias partições no Kafka?

O uso de várias partições facilita a alta disponibilidade, o dimensionamento e o processamento eficiente de dados. Para ser mais específico, você pode ajudar com o seguinte:

- Escalabilidade: Eles permitem o dimensionamento horizontal por meio da distribuição de dados em vários brokers, permitindo maior rendimento e processamento paralelo.

- Paralelismo: Cada partição pode ser consumida por um consumidor em um grupo de consumidores, permitindo o processamento paralelo de fluxos de dados e melhorando o desempenho geral do sistema.

- Tolerância a falhas: A replicação de partições entre os brokers garante a durabilidade dos dados e a tolerância a falhas. Se um broker falhar, outras réplicas poderão assumir o controle, garantindo a disponibilidade contínua dos dados.

Balanceamento de carga: A distribuição de dados entre partições ajuda a equilibrar a carga de trabalho entre os brokers, evitando pontos de acesso e otimizando a utilização de recursos.