programa

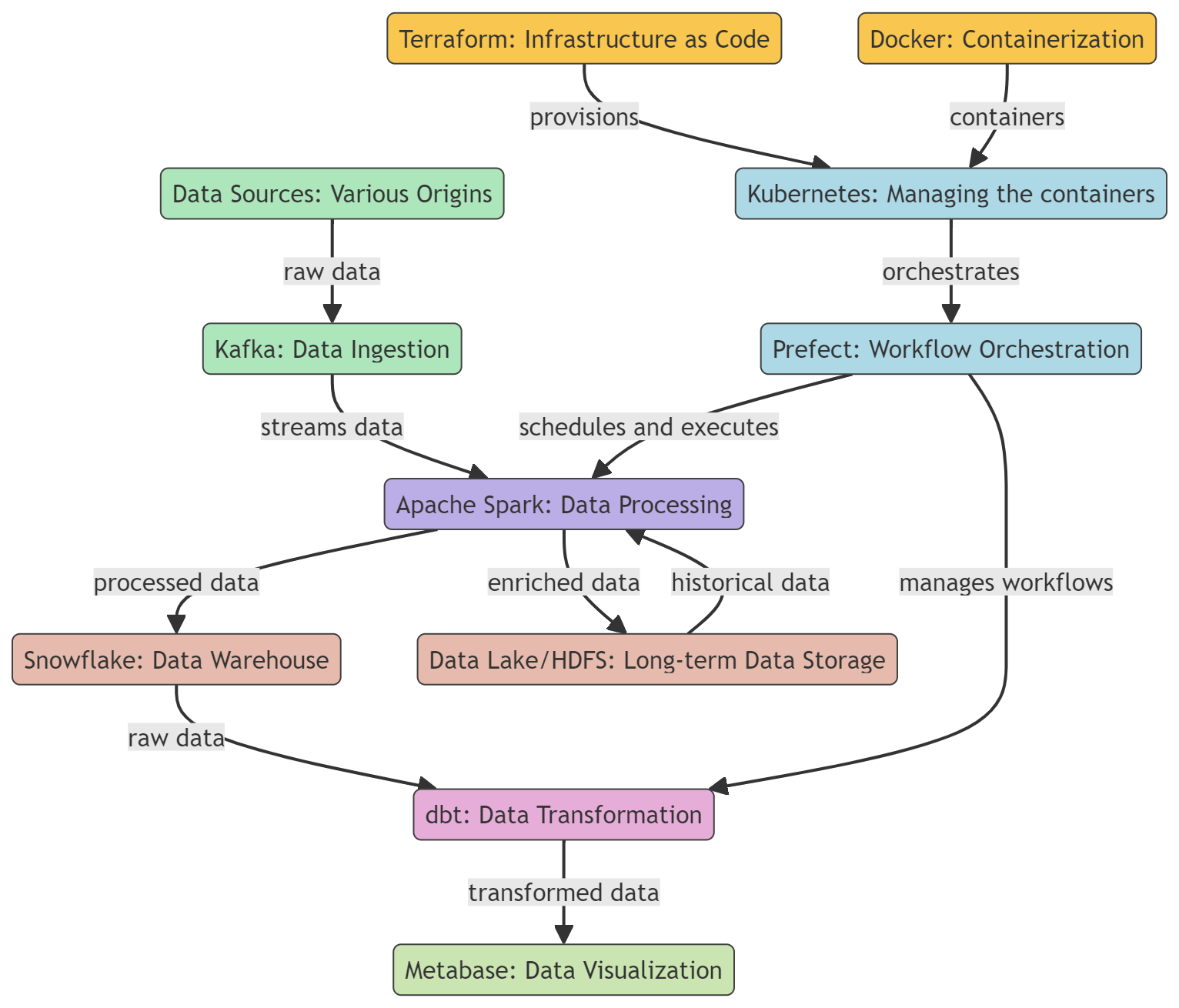

Los ingenieros de datos son responsables de crear canales de datos que puedan recopilar, procesar y enviar datos a diversos puntos finales, como bases de datos, almacenes de datos y plataformas de análisis. Al crear y mantener estos canales de datos, los ingenieros de datos permiten a los científicos y analistas de datos acceder a datos en tiempo real para su análisis y la toma de decisiones.

Se espera que los ingenieros de datos modernos realicen aún más tareas. También deben mantener e implementar soluciones de datos, gestionar flujos de trabajo, supervisar almacenes de datos, transformar y visualizar datos, y utilizar diversas herramientas de procesamiento por lotes y streaming para optimizar, ingestar y procesar diferentes tipos de datos.

Descubre qué es la ingeniería de datos, en qué se diferencia de la ciencia de datos, cuál es su alcance y cómo aprenderla leyendo nuestra guía «¿Qué es la ingeniería de datos?».

En esta publicación, aprenderemos cuáles son las herramientas esenciales más populares y, en ocasiones, necesarias para los ingenieros de datos. Estas herramientas se utilizan para la ingesta, el procesamiento, el almacenamiento, la transformación y la visualización de datos. Además, analizaremos herramientas para la contenedorización y la gestión del flujo de trabajo.

Aprende habilidades esenciales de ingeniería de datos leyendo nuestro blog Cómo convertirse en ingeniero de datos.

Herramientas de contenedorización

Las herramientas de contenedorización proporcionan una forma estandarizada de empaquetar, distribuir y gestionar aplicaciones en diferentes entornos. Garantiza la coherencia, la escalabilidad y la eficiencia de los flujos de trabajo de ingeniería de datos.

1. Docker

Docker es una popular plataforma de contenedorización que se utiliza a menudo en ingeniería de datos para desarrollar, enviar y ejecutar herramientas y aplicaciones de datos. Ofrece una forma ligera, portátil y coherente de empaquetar e implementar herramientas y aplicaciones de datos, lo que lo convierte en la opción ideal para los ingenieros de datos.

Docker se puede utilizar para crear y gestionar contenedores para diversas herramientas de datos, como bases de datos, almacenes de datos, marcos de procesamiento de datos y herramientas de visualización de datos. Echa un vistazo a nuestro tutorial Docker para ciencia de datos para obtener más información.

2. Kubernetes

Kubernetes es una plataforma de código abierto para automatizar la implementación, el escalado y la gestión de aplicaciones en contenedores, incluidas las creadas con Docker.

Docker es una herramienta que se puede utilizar para empaquetar aplicaciones de procesamiento de datos, bases de datos y herramientas de análisis en contenedores. Esto garantiza la coherencia en los entornos y aísla las aplicaciones. Una vez creados los contenedores, Kubernetes interviene para gestionarlos, encargándose de su implementación, escalándolos en función de la carga de trabajo y garantizando una alta disponibilidad.

Más información sobre la contenedorización con Docker y Kubernetes en otro artículo.

Herramientas de infraestructura como código

La infraestructura como código (IaC) agiliza la implementación y el mantenimiento de la infraestructura en la nube mediante el uso de lenguajes de programación de uso general o configuraciones YAML. Este enfoque fomenta la creación de entornos coherentes, repetibles y automatizados, lo que facilita transiciones más fluidas entre las fases de desarrollo, pruebas y producción.

3. Terraform

Terraform es una herramienta de código abierto de infraestructura como código (IaC) creada por HashiCorp. Permite a los ingenieros de datos definir e implementar infraestructura de datos, como bases de datos y canalizaciones de datos, de manera coherente y fiable utilizando un lenguaje de configuración declarativo, que describe el estado final deseado de la infraestructura en lugar de los pasos necesarios para alcanzar ese estado.

Terraform admite el control de versiones, la gestión de recursos mediante código, la colaboración en equipo y la integración con diversas herramientas y plataformas.

4. Pulumi

Pulumi es una herramienta de infraestructura como código de código abierto que permite a los programadores crear, implementar y gestionar infraestructura en la nube utilizando lenguajes de programación de uso general como JavaScript, TypeScript, Java, Python, Go y C#. Es compatible con una amplia gama de proveedores de nube, incluidos AWS, Azure, GCP y Kubernetes.

El marco Pulmi proporciona una interfaz de línea de comandos (CLI) descargable, un kit de desarrollo de software (SDK) y un motor de implementación para ofrecer una plataforma robusta para el aprovisionamiento, la actualización y la gestión de la infraestructura en la nube.

Conviértete en Ingeniero de Datos

Herramientas de coordinación de flujos de trabajo

Las herramientas de coordinación de flujos de trabajo automatizan y gestionan la ejecución de flujos de trabajo complejos de procesamiento de datos, garantizando que las tareas se ejecuten en el orden correcto y gestionando las dependencias.

5. Prefecto

Prefect es una herramienta de código abierto para la coordinación de flujos de trabajo modernos y procesos ETL (extraer, transformar, cargar). Ayuda a los ingenieros y científicos de datos a automatizar y gestionar complejos flujos de datos, garantizando que estos circulen sin problemas desde el origen hasta el destino con fiabilidad y eficiencia.

Prefect ofrece un modelo de ejecución híbrido que combina las ventajas de la gestión de la nube con la seguridad y el control de la ejecución local. Tu interfaz de usuario intuitiva y tu completa API facilitan la supervisión y la resolución de problemas en los flujos de trabajo de datos.

6. Luigi

Luigi es un paquete Python de código abierto que te ayuda a crear complejos flujos de datos de trabajos por lotes de larga duración. Fue desarrollado por Spotify para gestionar la resolución de dependencias, la gestión del flujo de trabajo, la visualización, el manejo de fallos y la integración de la línea de comandos.

Luigi está diseñado para gestionar diversas tareas, como el procesamiento, la validación y la agregación de datos, y puede utilizarse para crear flujos de trabajo de datos sencillos y sofisticados. Luigi se puede integrar con diversas herramientas y plataformas, como Apache Hadoop y Apache Spark, lo que permite a los usuarios crear canalizaciones de datos para procesar y analizar grandes volúmenes de datos.

Herramientas de almacenamiento de datos

Los almacenes de datos ofrecen soluciones en la nube que son altamente escalables para almacenar, consultar y gestionar grandes conjuntos de datos.

7. Snowflake

Snowflake es un almacén de datos basado en la nube que permite el almacenamiento, el procesamiento y la consulta analítica de grandes volúmenes de datos. Se basa en una arquitectura única que separa el almacenamiento y la computación, lo que permite que se amplíen de forma independiente.

Snowflake puede ajustar dinámicamente la cantidad de recursos informáticos en función de la demanda. Esto garantiza que las consultas se procesen de manera oportuna, eficiente y rentable. Es compatible con los principales proveedores de nube, como AWS, GCP y Azure.

Echa un vistazo a nuestro curso Introducción a Snowflake para explorar esta herramienta con más detalle.

8. PostgreSQL

PostgreSQL es un potente sistema de gestión de bases de datos relacionales (RDBMS) de código abierto que también se puede utilizar como almacén de datos. Como almacén de datos, PostgreSQL proporciona un repositorio centralizado para almacenar, gestionar y analizar grandes volúmenes de datos estructurados procedentes de diversas fuentes.

PostgreSQL ofrece funciones como partición, indexación y ejecución paralela de consultas que te permiten gestionar consultas complejas y grandes conjuntos de datos de manera eficiente.

Recuerda que un almacén de datos PostgreSQL es una solución local que puede no escalar tan bien como algunas soluciones totalmente gestionadas. Requiere más administración y mantenimiento manual en comparación con estas soluciones.

Más información en nuestra Guía para principiantes de PostgreSQL.

Herramientas de ingeniería analítica

Las herramientas de ingeniería analítica agilizan la transformación, las pruebas y la documentación de los datos en el almacén de datos.

9. dbt

dbt (data build tool) es una herramienta de línea de comandos y un marco de trabajo de código abierto diseñados para facilitar el flujo de trabajo de transformación de datos y el modelado en un entorno de almacenamiento de datos. Es compatible con todos los principales almacenes de datos, incluidos Redshift, BigQuery, Snowflake y PostgreSQL.

Se puede acceder a dbt a través de dbt Core o dbt Cloud. dbt Cloud ofrece una interfaz de usuario basada en web, una CLI impulsada por dbt Cloud, un entorno alojado, un programador de tareas integrado en la aplicación e integraciones con otras herramientas.

Puedes aprender los fundamentos de dbt con nuestro curso Introducción a dbt.

10. Metabase

Metabase es una herramienta de inteligencia empresarial (BI) y análisis de código abierto que permite a los usuarios crear y compartir paneles interactivos e informes analíticos. Está diseñado para ser fácil de usar, lo que permite a los usuarios sin conocimientos técnicos consultar datos, visualizar resultados y obtener información sin necesidad de conocer SQL u otros lenguajes de consulta.

Ofrece una configuración sencilla, compatibilidad con diversas fuentes de datos, una interfaz de usuario sencilla, funciones de colaboración, notificaciones personalizables y una seguridad sólida para la exploración, el análisis y el intercambio de datos.

El análisis de datos y la creación de paneles de control forman parte de la ciencia de datos. Descubre las diferencias entre un científico de datos y un ingeniero de datos leyendo este artículo: Científico de datos frente a ingeniero de datos.

Herramientas de procesamiento por lotes

Estas herramientas de ingeniería de datos permiten procesar de forma eficiente grandes volúmenes de datos por lotes, ejecutar tareas computacionales complejas, analizar datos y ejecutar aplicaciones de machine learning en entornos informáticos distribuidos.

11. Apache Spark

Apache Spark es un potente marco informático distribuido de código abierto diseñado para el procesamiento y análisis de datos a gran escala. Aunque es conocido por su capacidad para gestionar datos de streaming en tiempo real, Spark también destaca en el procesamiento por lotes, lo que lo convierte en una herramienta muy valiosa en los flujos de trabajo de ingeniería de datos.

Apache Spark cuenta con conjuntos de datos distribuidos resilientes (RDD), API completas para varios lenguajes de programación, procesamiento de datos en múltiples nodos de un clúster e integración perfecta con otras herramientas. Es altamente escalable y rápido, lo que lo hace ideal para el procesamiento por lotes en tareas de ingeniería de datos.

12. Apache Hadoop

Apache Hadoop es un popular marco de código abierto para el almacenamiento y procesamiento distribuido de grandes conjuntos de datos. En el núcleo del ecosistema Hadoop hay dos componentes clave: el sistema de archivos distribuidos Hadoop (HDFS) para el almacenamiento y el modelo de programación MapReduce para el procesamiento.

Apache Hadoop es una herramienta potente y escalable para ingenieros de datos que ofrece almacenamiento rentable, tolerancia a fallos, capacidades de procesamiento distribuido y una integración perfecta con otras herramientas de procesamiento de datos.

Herramientas de streaming

Las herramientas de streaming proporcionan una forma eficaz de crear canalizaciones de datos en tiempo real, lo que permite la ingesta, el procesamiento y el análisis continuos de datos en streaming.

13. Apache Kafka

Apache Kafka es una plataforma distribuida de transmisión de eventos diseñada para el procesamiento de datos en tiempo real de alto rendimiento y la optimización de canalizaciones de datos a gran escala. Se utiliza para crear canalizaciones de datos en tiempo real, análisis de streaming, integración de datos y aplicaciones de misión crítica.

Kafka es un sistema capaz de gestionar grandes cantidades de datos con baja latencia. Almacena datos de forma distribuida y tolerante a fallos, lo que garantiza que los datos sigan estando disponibles incluso si se producen fallos de hardware o problemas de red.

Kafka es altamente escalable y admite múltiples suscriptores. También se integra bien con diferentes herramientas y marcos de procesamiento de datos, como Apache Spark, Apache Flink y Apache Storm.

14. Apache Flink

Apache Flink es una plataforma de código abierto para el procesamiento distribuido de flujos y lotes. Puede procesar flujos de datos en tiempo real, lo que lo convierte en una opción muy popular para crear canalizaciones de datos en streaming y aplicaciones de análisis en tiempo real.

Flink es una herramienta de procesamiento de datos que ofrece capacidades de procesamiento de datos en tiempo real y por lotes de forma rápida y eficiente. Es compatible con varias API (incluidas Java, Scala y Python), permite una integración perfecta con otras herramientas de procesamiento de datos y ofrece una gestión eficiente del estado. Por lo tanto, es una opción muy popular para el análisis en tiempo real, la detección de fraudes y las aplicaciones de IoT debido a su capacidad para procesar datos de alto rendimiento con baja latencia.

Conclusión

Con esto concluye nuestra lista, pero no tiene por qué ser el final de tu viaje por la ingeniería de datos. Inscríbete en el programa formativo «Ingeniero de datos en Python» para aprender sobre Python, SQL, diseño de bases de datos, computación en la nube, limpieza de datos y visualización. Una vez completado el programa, podrás realizar el examen de certificación profesional en ingeniería de datos y convertirte en ingeniero de datos certificado.

Los ingenieros de datos desempeñan un papel fundamental en la creación y el mantenimiento de los canales de datos que alimentan el análisis y la toma de decisiones en las organizaciones. A medida que el volumen y la complejidad de los datos siguen creciendo exponencialmente, los ingenieros de datos deben aprovechar las herramientas adecuadas para ingestar, procesar, almacenar y entregar datos de calidad de manera eficiente.

Hemos cubierto las 14 mejores herramientas de ingeniería de datos para contenedorización, aprovisionamiento de infraestructura, automatización de flujos de trabajo, almacenamiento de datos, ingeniería analítica, procesamiento por lotes y transmisión en tiempo real.

Si eres nuevo en la ingeniería de datos, empieza por aprender Docker, Kubernetes, Terraform, Prefect, Snowflake, dbt, Apache Spark, Apache Kafka y mucho más.

Una vez que domines estas herramientas, te recomendamos que revises Las 21 preguntas, respuestas y ejemplos más frecuentes en entrevistas de ingeniería de datos para prepararte para tu próximo paso profesional.

Certifícate en el puesto de Ingeniero de Datos de tus sueños

Nuestros programas de certificación te ayudan a destacar y a demostrar que tus aptitudes están preparadas para el trabajo a posibles empleadores.

Soy un científico de datos certificado que disfruta creando aplicaciones de aprendizaje automático y escribiendo blogs sobre ciencia de datos. Actualmente me centro en la creación de contenidos, la edición y el trabajo con grandes modelos lingüísticos.