Cours

Si vous travaillez dans le domaine du traitement des big data, vous savez que la gestion et l'analyse de fichiers de données non organisés peuvent s'avérer difficiles et sujettes à des erreurs. Le risque de perdre des données précieuses à cause d'une simple erreur, telle qu'une commande de suppression accidentelle, est une préoccupation constante.

Apache Iceberg relève ces défis en fournissant un format de tableau robuste et fiable qui prend en charge les retours en arrière et la restauration des états précédents de vos données. L'intégrité et la cohérence des données sont ainsi garanties, ce qui rend la gestion des données plus efficace et moins sujette aux erreurs.

Dans ce tutoriel, nous expliquerons ce qu'est Apache Iceberg, pourquoi il est utilisé et comment il fonctionne. Vous apprendrez également à l'utiliser à l'aide d'instructions pratiques, étape par étape, ce qui vous permettra de gérer et d'analyser vos données de manière plus efficace.

Qu'est-ce que l'iceberg Apache ?

Apache Iceberg est un format de tableau ouvert conçu pour traiter efficacement d'énormes ensembles de données analytiques. Il fournit une structure de tableau très performante qui apporte à vos fichiers de données les avantages des bases de données traditionnelles, tels que l'interrogation SQL, la conformité ACID et le partitionnement.

Essentiellement, Apache Iceberg agit comme une lentille, vous permettant de visualiser et de gérer une collection de fichiers de données comme s'il s'agissait d'un tableau unique et cohérent.

Le principal avantage d'Apache Iceberg est sa capacité à traiter des données à grande échelle de manière hautement optimisée. Il prend en charge des fonctionnalités telles que l'évolution des schémas, le partitionnement caché et le déplacement dans le temps, ce qui en fait une solution robuste pour la gestion de flux de données complexes.

En faisant abstraction de la complexité des formats de stockage sous-jacents, Iceberg permet une gestion et une interrogation efficaces des données, ce qui en fait un choix idéal pour le traitement des données volumineuses.

Histoire de l'iceberg Apache

Netflix a développé Apache Iceberg en 2017 pour pallier les limites de Hive, notamment dans la gestion des traitements incrémentaux et des données en streaming. En 2018, Netflix a fait don d'Iceberg à la Apache Software Foundation, ce qui en fait un projet open-source.

Depuis, Apache Iceberg est devenu la pierre angulaire des architectures modernes de lacs de données, et a été largement adopté par de nombreux secteurs d'activité.

Le projet n'a cessé d'évoluer, intégrant des fonctionnalités telles que le partitionnement caché et l'évolution des schémas afin de répondre aux exigences des environnements de données à grande échelle.

En 2024, Databricks a annoncé son accord pour acquérir Tabular, une société de gestion de données fondée par les créateurs originaux d'Apache Iceberg. Cette acquisition vise à unifier Apache Iceberg et Delta Lake, en améliorant la compatibilité des données et en favorisant l'évolution vers une norme d'interopérabilité unique et ouverte.

Chronologie de l'évolution de l'iceberg Apache

|

Année |

Événement |

|

2017 |

Netflix développe Apache Iceberg pour pallier les limites de Hive, en particulier pour le traitement incrémental et les données en continu. |

|

2018 |

Netflix fait don d'Apache Iceberg à la Apache Software Foundation, ce qui en fait un projet open-source. |

|

2019 |

Apache Iceberg est adopté par diverses industries pour ses capacités de gestion de données évolutives et efficaces. Des fonctionnalités telles que l'évolution des schémas et le partitionnement caché sont introduites. |

|

2020 |

Les contributions de la communauté et l'adoption continuent de croître, avec des améliorations de performance et de nouvelles fonctionnalités comme le voyage dans le temps et la gestion des métadonnées. |

|

2021 |

Apache Iceberg gagne une traction significative en tant que format de tableau privilégié pour les lacs de données, en s'intégrant aux principaux outils et plateformes de big data. |

|

2022 |

De nouvelles fonctionnalités et optimisations ont été ajoutées, améliorant le support d'Iceberg pour les flux de données complexes et les environnements de données à grande échelle. |

|

2023 |

Apache Iceberg continue d'évoluer en mettant l'accent sur l'amélioration de la compatibilité et de l'interopérabilité des données avec d'autres formats et systèmes de données. |

|

2024 |

Databricks a annoncé son accord pour l'acquisition de Tabular. Cette acquisition vise à unifier Iceberg et Delta Lake. |

À quoi sert Apache Iceberg ?

Comme nous l'avons vu précédemment, Apache Iceberg est un outil puissant pour la gestion des données et l'analyse dans des environnements à grande échelle.

Voici un aperçu plus spécifique de l'utilisation d'Apache Iceberg.

Analyse des données

L'utilisation de formats de fichiers tels que ORC ou Parquet est facile à mettre en œuvre, mais l'exécution d'analyses sur ces formats est inefficace. Cependant, Iceberg leur fournit un format de tableau avec des informations de métadonnées pour optimiser les requêtes.

Par exemple, les fichiers de données brutes ne contiennent pas d'informations sur le tableau auquel ils appartiennent, alors que les fichiers de métadonnées d'Iceberg en contiennent. Les moteurs de recherche peuvent ainsi décider des tableaux à lire et de ceux à ignorer, ce qui améliore considérablement l'efficacité des requêtes.

Les fichiers de métadonnées stockent ce type d'informations pour permettre une recherche efficace. Les langages d'interrogation recherchent d'abord le nom du fichier concerné dans les métadonnées et ne récupèrent que ce fichier pour une interrogation rapide, réduisant ainsi les lectures de données inutiles.

Élagage des partitions

L'élagage des partitions est une technique qui permet d'ignorer les données non pertinentes et d'effectuer des opérations uniquement sur les données nécessaires.

Par exemple, si votre colonne de partition est "date" et que vous spécifiez une plage de dates spécifique, la requête ne lit que les données comprises dans cette plage. Cela réduit la quantité de données lues sur le disque, ce qui rend l'interrogation des tableaux Iceberg plus rapide et plus efficace.

Voyage dans le temps

Le voyage dans le temps est une fonction qui vous permet d'accéder à des versions plus anciennes de vos données en récupérant des instantanés à partir d'un point précis dans le temps.

Un instantané est un ensemble complet de fichiers de données à un moment donné.

Les fichiers de métadonnées suivent les identifiants des instantanés, les horodatages et les détails de l'historique, ce qui permet d'accéder à chaque instantané par son identifiant ou son horodatage.

Intégrations

De nombreux systèmes de stockage populaires, tels que Google Cloud, AWS et Microsoft Azure, prennent en charge le format de tableau Iceberg. Vous pouvez stocker des fichiers de données sur ces plateformes cloud et utiliser un service de catalogue externe ou intégré pour pointer vers leurs métadonnées.

Une fois le service de catalogue configuré, vous pouvez utiliser des frameworks de traitement des big data comme Apache Spark ou Apache Flink.

Iceberg prend également en charge divers moteurs d'interrogation, tels que SQL, Trino et Presto, ce qui permet une intégration transparente avec les flux de données existants.

Communauté

Apache Iceberg dispose d'une communauté active et d'une présence en ligne sur diverses plateformes de collaboration telles que Twitter et Github. Il dispose également d'un espace de travail Slack dédié pour ceux qui souhaitent participer aux dernières discussions sur le développement.

Les contributeurs de logiciels libres et les développeurs d'Iceberg sont accessibles à la communauté d'apprentissage par le biais de plateformes sociales. Il est ainsi facile d'obtenir une solution lorsque vous rencontrez des problèmes lors de la mise en œuvre des fonctionnalités d'Iceberg.

Concepts de base d'Apache Iceberg

Apache Iceberg présente un ensemble de concepts fondamentaux qui permettent une gestion et une interrogation efficaces des données. Dans cette section, nous allons les passer en revue.

Gestion des métadonnées

Iceberg gère les schémas de tableaux, les partitions, les emplacements de fichiers et bien plus encore grâce à sa couche de métadonnées, qui tient à jour les métadonnées, les listes de manifestes et les fichiers de manifestes au format JSON.

- Fichier de métadonnées : il fait le cursus du schéma et des partitions du tableau.

- Fichiers manifestes : contiennent des informations au niveau du fichier, telles que l'emplacement, la taille, la partition et les statistiques de ligne et de colonne d'un fichier de données.

Iceberg prend en charge le versionnage par le biais de métadonnées d'instantanés. Il stocke des informations sur l'horodatage de l'instantané, la partition et les fichiers de données pertinents. Un instantané est une vue de l'ensemble de vos données à un moment précis.

Évolution du schéma

L'évolution du schéma est le processus qui consiste à modifier le schéma d'un tableau pour l'adapter à de nouveaux éléments de données ou à des besoins changeants. Apache Iceberg prend en charge l'évolution native des schémas, ce qui permet de mettre à jour les schémas sans réécriture ou migration coûteuse des données.

Par exemple, si vous gérez les données relatives aux salariés et que vous souhaitez ajouter une nouvelle colonne pour les indicateurs de performance, vous pouvez ajouter une colonne "employee_performance". Iceberg met à jour ses métadonnées pour inclure cette colonne sans affecter les données existantes. La nouvelle colonne a initialement des valeurs par défaut et est mise à jour au fur et à mesure que de nouveaux enregistrements sont insérés.

Cloisonnement

Le partitionnement divise les données en sous-ensembles plus petits, ce qui vous permet d'accéder uniquement aux données nécessaires à une requête au lieu de lire l'ensemble des données.

Iceberg prend en charge de nombreuses stratégies de partitionnement, par exemple :

- Séparation des gammes : Divise les données en fonction d'une plage de valeurs dans la colonne de partition, telles que des dates spécifiques, des valeurs numériques ou des entrées de chaîne de caractères.

- Partitionnement du hachage : Applique une fonction de hachage à la clé de partition pour diviser les données.

- Tronquer le partitionnement : Tronque les valeurs d'une colonne de partition et regroupe les données. Par exemple, en tronquant les codes postaux 533405, 533404, 533689, 533098, 535209 et 535678 à 3 chiffres, les données sont regroupées en "533" et "535".

- Partitionnement des listes : Fait correspondre les valeurs des clés de partition avec les valeurs d'une liste, en divisant les données en conséquence. Cette méthode convient pour les valeurs catégorielles dans la colonne de partition. Par exemple, la répartition des fabricants d'ordinateurs portables en groupes tels que "Lenovo", "Apple" et "HP".

Instantanés

Un instantané est un ensemble de fichiers manifestes valables à un moment précis. Chaque modification apportée aux données crée un nouvel instantané avec les fichiers de manifeste et les métadonnées mis à jour.

Iceberg utilise une méthode d'interrogation basée sur les instantanés, ce qui signifie que vous pouvez accéder à l'ensemble des fichiers de données à un moment précis en accédant à un horodatage particulier. Cela vous permet d'accéder aux données historiques et de revenir aux versions précédentes en cas de perte de données.

Architecture technique d'Apache Iceberg

Apache Iceberg ne stocke pas les données dans des tableaux. Au lieu de cela, il organise les fichiers de données pour les présenter sous la forme d'un tableau unique.

Passons en revue l'architecture qui rend cela possible.

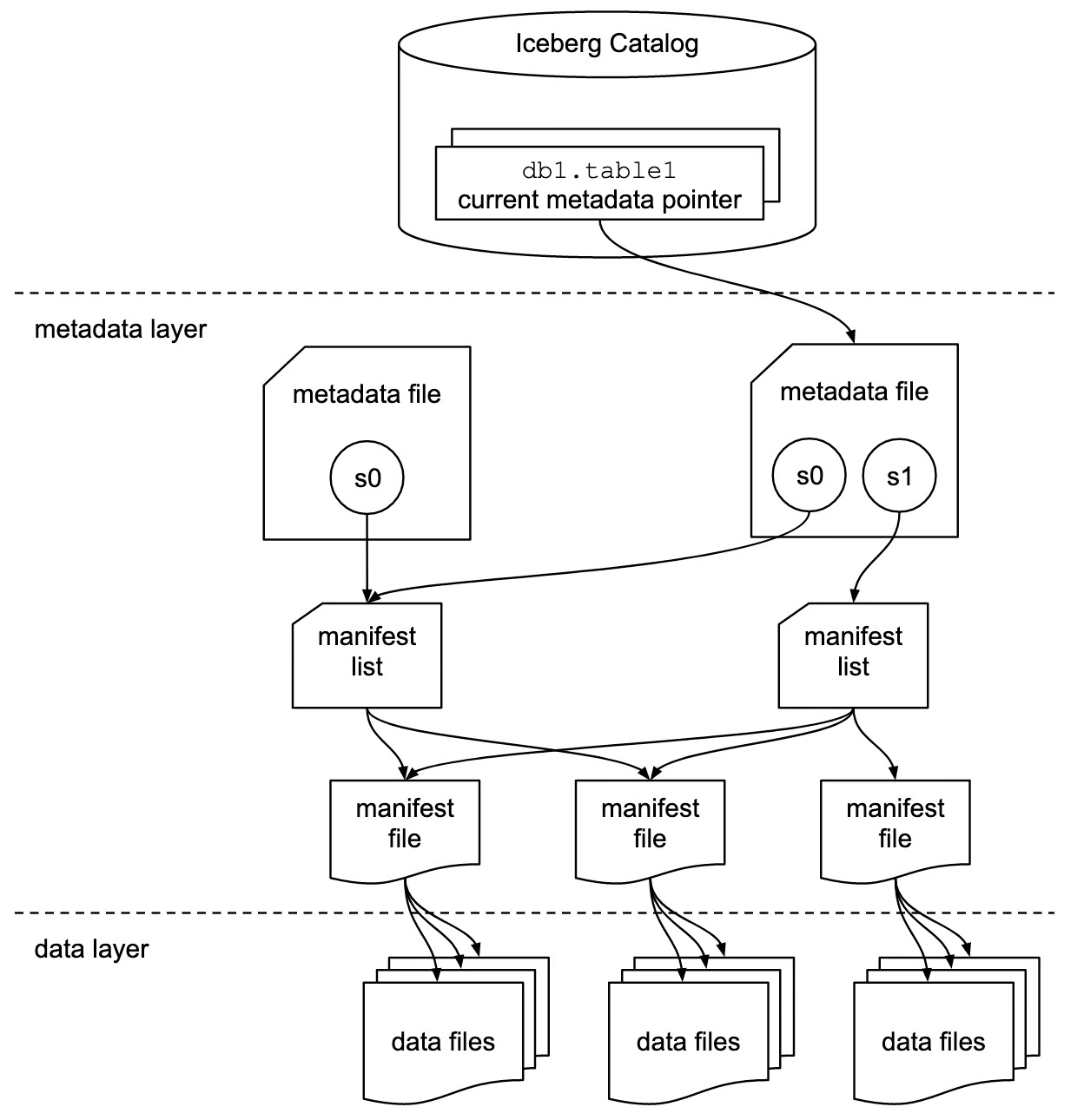

Source de l'image

Catalogue Iceberg

La couche catalogue contient une référence ou un pointeur vers le fichier de métadonnées actuel du tableau. Chaque fois que vous modifiez des données, un nouveau fichier de métadonnées est écrit et le pointeur pointe désormais vers le fichier de métadonnées le plus récent du journal.

Cette couche facilite la conformité ACID des tableaux Iceberg. Par exemple, les modifications en cours ne sont pas visibles par les autres transactions tant qu'elles ne sont pas terminées et validées dans le tableau. Jusqu'alors, le pointeur fait référence au fichier de métadonnées actuel.

Globalement, les catalogues simplifient la gestion de la conformité ACID dans les tableaux Iceberg en pointant vers des versions spécifiques des fichiers de métadonnées.

Couche de métadonnées

Cette couche contient trois types de fichiers :

- Fichiers de métadonnées : Ces fichiers stockent le schéma du tableau, son emplacement, les informations sur les partitions, les horodatages des instantanés et d'autres informations.

- Fichiers manifestes : Les fichiers de manifeste permettent de suivre les métadonnées au niveau du fichier. Ils stockent des informations sur les partitions, des statistiques telles que le nombre de lignes et de colonnes, des détails sur les instantanés et le format de chaque fichier de données.

- Listes de manifestes : Un groupe de fichiers de manifeste qui constitue un instantané unique est une liste de manifeste.

Cette couche maintient la structure et l'intégrité du tableau, ce qui permet une interrogation et une gestion efficaces des données.

Couche de données

La couche de données est le composant de stockage de l'architecture Iceberg où résident les données réelles.

Iceberg prend en charge différents formats de données, notamment Parquet, ORC et Avro. Cette flexibilité permet un stockage optimisé et un traitement efficace des données, en fonction des différents types de données et des cas d'utilisation.

Intégration et compatibilité d'Apache Iceberg

Apache Iceberg s'intègre à de nombreux cadres et moteurs de calcul populaires pour le traitement des données volumineuses.

Intégrations avec des moteurs de traitement de données

Apache Spark

Les tableaux Iceberg fonctionnent comme de grands systèmes de stockage de données sur lesquels vous pouvez utiliser les API Spark pour lire et écrire des données. En plus de l'API DataFrame, vous pouvez utiliser le module Spark SQL pour interroger les tableaux Iceberg.

Apache Spark dispose de deux catalogues : org.apache.iceberg.spark.SparkCatalog et org.apache.iceberg.spark.SparkSessionCatalog. Ces catalogues permettent à Spark de découvrir et d'accéder aux métadonnées des tableaux disponibles.

metadataorg.apache.iceberg.spark.SparkCatalog: Pour utiliser des services de catalogue externes tels que Hive ou Hadoop.org.apache.iceberg.spark.SparkSessionCatalog: Le catalogue intégré de Spark peut gérer des tableaux Iceberg et non Iceberg dans la même session.

Apache Flink

L'intégration d'Apache Flink et d'Iceberg est connue pour le traitement des données en continu. Cette intégration vous permet de diffuser des données directement à partir de diverses sources vers les tableaux Iceberg et facilite l'exécution d'analyses sur les données diffusées en temps réel.

Presto et Trino

Preso et Trino sont connus pour leurs capacités de traitement rapide des données par rapport à Hive ou à d'autres moteurs SQL. Par conséquent, si vous avez des données massives qui doivent être interrogées et analysées, l'intégration d'Iceberg et de Presto/Trino est un excellent choix.

Trino n'a pas de catalogue intégré. Il s'appuie sur des services de catalogue externes comme Hive Metastore ou AWS Glue pour pointer vers les tableaux Iceberg.

Compatibilité avec les lacs de données

Les lacs de données traditionnels ne prennent pas en charge les propriétés ACID, ce qui entraîne des lectures de données incomplètes ou des écritures de données simultanées. Cependant, l'intégration d'un lac de données avec un Iceberg garantit la cohérence et la précision des données.

- Amazon S3 : Amazon S3 est un service de stockage en nuage populaire qui prend en charge différents formats de fichiers. Il est utilisé comme couche de stockage dans l'architecture du lac de données. Pour utiliser Iceberg avec S3, vous devez utiliser AWS glue comme service de catalogue. Une fois le catalogue configuré, vous pouvez utiliser n'importe quel langage d'interrogation pour analyser les tableaux.

- Stockage dans le nuage de Google : Un lac de données sur Google Cloud offre une architecture de données plus évolutive et plus flexible. De nombreuses entreprises disposant d'une infrastructure de données construite autour de Google Cloud peuvent tirer parti du format de tableau Iceberg. Les tableaux d'Iceberg peuvent être interrogés à l'aide de BigQuery de Google ou de langages d'interrogation standard.

- Azure Blob Storage : Il s'agit du système de stockage de Microsoft optimisé pour stocker des quantités massives de données non structurées sur le cloud. Iceberg s'intègre à Azure et fournit un accès rapide et fiable aux données.

Apache Iceberg vs Delta Lake

Apache Iceberg et Delta Lake sont tous deux des formats de tableau avancés conçus pour apporter les propriétés ACID aux lacs de données, mais ils diffèrent dans leurs fonctionnalités, leurs intégrations et leurs cas d'utilisation.

Voici une comparaison détaillée des deux :

Vue d'ensemble du lac Delta

Delta Lake est un format de tableau qui confère des propriétés ACID à une collection de fichiers Parquet, garantissant ainsi que les lecteurs ne verront jamais de données incohérentes.

Développé par Databricks, la société à l'origine d'Apache Spark, Delta Lake est hautement compatible avec Spark pour le traitement et l'analyse des big data.

Delta Lake utilise des journaux transactionnels pour gérer les fonctions de voyage dans le temps. Un journal des transactions est une liste de fichiers JSON qui suivent les modifications apportées au tableau. Chaque insertion, suppression ou mise à jour entraîne la création d'un nouveau fichier journal qui cursus les changements spécifiques.

Le lac Delta crée périodiquement des fichiers de points de contrôle, qui représentent des instantanés de l'ensemble du tableau à des moments précis et sont stockés au format Parquet.

Apache Iceberg vs. Comparaison des caractéristiques du lac Delta

|

Fonctionnalité |

Iceberg Apache |

Delta Lake |

|

Définition |

Le format de tableau Iceberg offre une infrastructure évolutive prenant en charge plusieurs moteurs de traitement. |

Delta Lake est une couche de stockage fiable, particulièrement adaptée à l'écosystème Databricks. |

|

Format de fichier |

Iceberg prend en charge différents formats de fichiers, notamment Parquet, Avro et ORC. |

Delta Lake ne supporte nativement que le format de fichier Parquet. |

|

Prise en charge des propriétés ACID |

Iceberg prend en charge les transactions ACID. |

Le lac Delta offre des propriétés ACID robustes. |

|

Traitement des partitions |

Iceberg prend en charge le partitionnement dynamique, ce qui signifie que les partitions peuvent être mises à jour sans réécrire le schéma. |

Les partitions sont constantes et vous devez les définir lors de la création des tableaux. La modification des partitions définies peut entraîner des réécritures de données. |

|

Voyage dans le temps |

Chaque modification apportée au tableau crée un nouvel instantané. |

Il offre des fonctionnalités de voyage dans le temps grâce aux journaux de transactions, les modifications étant cursusées dans des fichiers JSON. |

|

Intégrations |

Iceberg prend en charge plusieurs moteurs de traitement de données, tels que SQL, Spark, Trino, Hive, Flink, Presto, et bien d'autres encore. |

Delta Lake est étroitement couplé à Apache Spark. |

Apache Iceberg vs. Cas d'utilisation du lac Delta

|

Cas d'utilisation |

Iceberg Apache |

Delta Lake |

|

Flexibilité du moteur |

C'est mieux lorsque vous utilisez plusieurs moteurs, notamment Apache Spark, Flink, Presto, Hive, etc. Il est idéal pour les environnements nécessitant différents moteurs pour différentes tâches de traitement. |

Le meilleur pour les utilisateurs qui utilisent nativement Apache Spark, offrant une intégration étroite et des performances optimales au sein de l'écosystème Spark. |

|

Flux de données |

Prise en charge de l'ingestion continue de données provenant de diverses sources et de leur traitement en temps réel. |

Il unifie le traitement par lots et le traitement en flux, ce qui est idéal pour les cas d'utilisation nécessitant les deux dans un seul pipeline. |

Apache Iceberg vs. Considérations supplémentaires concernant le lac Delta

- Communauté et écosystème : Iceberg et Delta Lake disposent tous deux de communautés actives et d'une vaste documentation. Cependant, Delta Lake bénéficie du soutien de Databricks et offre un support solide au sein de l'écosystème Databricks.

- Performance : Si les deux formats offrent des optimisations de performances, l'intégration étroite de Delta Lake avec Spark peut bénéficier aux flux de travail centrés sur Spark. La flexibilité de l'Iceberg avec différents moteurs permet de gagner en performance dans les environnements multimoteurs.

Dans l'ensemble, Delta Lake est bien adapté aux cas d'utilisation nécessitant un traitement en temps réel et une intégration étroite avec Spark et l'écosystème Databricks. En revanche, Apache Iceberg offre une plus grande flexibilité pour le traitement de données à grande échelle et la possibilité de choisir le meilleur moteur pour des cas d'utilisation spécifiques.

Démarrer avec Apache Iceberg

L'installation et l'utilisation d'Apache Iceberg impliquent la configuration de votre environnement et la compréhension des opérations de base et avancées. Ce guide vous aidera à commencer à l'utiliser.

Installation et configuration

Pour configurer et exécuter les tableaux Iceberg, vous devez avoir les environnements suivants configurés sur votre machine :

- Java JDK

- PySpark

- Python

- Apache Spark

Il est également utile d'avoir une compréhension de base de ces outils et technologies. Vous pouvez les apprendre grâce aux cours suivants :

- Big Data avec PySpark

- Introduction à PySpark

- Introduction à Spark SQL en Python

- Fondamentaux du Big Data avec PySpark

- Programmation en Python

Une fois prêt, vous pouvez suivre les étapes ci-dessous pour mettre en place les tableaux Iceberg :

- Téléchargez les fichiers JAR d'Iceberg et placez-les dans un répertoire de votre machine.

- Créez un nouveau dossier appelé

iceberg-warehousepour stocker vos tableaux Iceberg.

mkdir iceberg-warehouse- Configurez les fichiers jar dans une session Spark, comme indiqué ci-dessous.

from pyspark.sql import SparkSession

spark = SparkSession.builder \

.appName("Iceberg-sample") \

.config("spark.jars", "jars/iceberg-spark-runtime-<version>.jar") \

.getOrCreate()

Remplacez “jars/iceberg-spark-runtime-.jar” par le répertoire actuel des fichiers jar et la version que vous utilisez.

- Configurez PySpark pour qu'il utilise les tableaux Iceberg.

from pyspark.sql import SparkSession

spark = SparkSession.builder \

.appName("Iceberg-Sample") \

.config("spark.jars", "jars/iceberg-spark-runtime-<version>.jar") \

.config("spark.sql.catalog.catalog_name", "org.apache.iceberg.spark.SparkCatalog") \

.config("spark.sql.catalog.catalog_name.type", "hadoop") \

.config("spark.sql.catalog.catalog_name.warehouse", "file:///C:/HP/iceberg-warehouse") \

.getOrCreate()

Remplacez "jars/iceberg-spark-runtime-.jar" par le chemin et la version réels des fichiers JAR d'Iceberg, et assurez-vous que le chemin de l'entrepôt est correct.

Vous pouvez désormais créer et utiliser des tableaux Iceberg à l'aide de PySpark.

Opérations de base

- Créez un tableau Iceberg et insérez-y des données.

spark.sql(""" CREATE TABLE my_catalog.emp_table ( id INT, data STRING ) USING iceberg """)

spark.sql(""" INSERT INTO catalog_name.emp_table VALUES (14, 'james'),('15','john')""")- Commande permettant de supprimer les données des tableaux Iceberg.

spark.sql("DELETE FROM catalog_name.emp_table WHERE id = 14")Opérations avancées

L'ajout, la mise à jour ou la suppression de colonnes sans affecter les données existantes fait partie de l'évolution du schéma.

- Voici comment ajouter une nouvelle colonne.

spark.sql("ALTER TABLE ADD catalog_name.emp_table COLUMN salary INT")L'évolution des partitions consiste à modifier les colonnes des partitions sans écraser les fichiers de données existants.

- Voici comment vous pouvez ajouter une nouvelle colonne de partition.

spark.sql("ALTER TABLE catalog_name.emp_table ADD PARTITION FIELD emp_join_date")Ces étapes et commandes fournissent un cadre de base pour démarrer avec Apache Iceberg et vous donnent une idée de ce à quoi ressemble le travail avec ce format.

Conclusion

Nous avons couvert beaucoup de sujets aujourd'hui ; résumons en quelques points clés.

Apache Iceberg offre une structure de tableau robuste à un ensemble de fichiers de données, en prenant en charge les transactions ACID et en garantissant la cohérence et la fiabilité des données.

Le format Iceberg introduit l'évolution dynamique des schémas, le partitionnement transparent et l'évolutivité des systèmes de stockage. Son intégration avec des moteurs de traitement de données comme Apache Spark et Flink permet de traiter efficacement les données en lot et en flux en temps réel.

Si vous souhaitez approfondir votre connaissance de l'architecture et de la gestion modernes des données, nous vous invitons à consulter ces ressources complémentaires :

FAQ

Apache Iceberg peut-il gérer des structures de données imbriquées complexes ?

Oui, Apache Iceberg peut gérer des structures de données imbriquées complexes. Il prend en charge les types de données imbriqués tels que les structures, les cartes et les tableaux, ce qui le rend adapté à un large éventail de scénarios de données.

Comment Apache Iceberg assure-t-il la cohérence des données lors d'écritures simultanées ?

Apache Iceberg garantit la cohérence des données lors des écritures concurrentes en utilisant un contrôle optimiste de la concurrence. Il cursus les modifications avec une couche de métadonnées versionnées, et chaque opération d'écriture crée un nouvel instantané. En cas d'écritures simultanées, Iceberg vérifie les conflits et veille à ce qu'une seule écriture aboutisse, préservant ainsi l'intégrité des données.

Quelles sont les implications en termes de performances de l'utilisation d'Apache Iceberg par rapport aux lacs de données traditionnels ?

Apache Iceberg peut améliorer considérablement les performances par rapport aux lacs de données traditionnels en optimisant la disposition des données, en prenant en charge le partitionnement dynamique et en permettant une gestion fine des métadonnées. Ces fonctionnalités réduisent la quantité de données analysées lors des requêtes et améliorent les performances globales des requêtes.

Apache Iceberg peut-il être utilisé avec des solutions de stockage en cloud non Hadoop ?

Oui, Apache Iceberg peut être utilisé avec diverses solutions de stockage dans le cloud, notamment Amazon S3, Google Cloud Storage et Azure Blob Storage. Il est conçu pour être agnostique en matière de stockage, ce qui vous permet d'exploiter les capacités d'Iceberg sur plusieurs plates-formes.

Comment Apache Iceberg gère-t-il les changements de schéma sans nécessiter de temps d'arrêt ?

Apache Iceberg gère les modifications de schémas grâce à sa fonction native d'évolution des schémas. Il vous permet d'ajouter, de supprimer ou de mettre à jour des colonnes sans nécessiter de temps d'arrêt ou de réécriture des données existantes. Ces modifications sont appliquées aux métadonnées et les nouvelles données sont écrites conformément au schéma mis à jour.

Existe-t-il une interface utilisateur pour la gestion et l'interrogation des tableaux Iceberg ?

Bien qu'Apache Iceberg ne fournisse pas d'interface utilisateur intégrée, il peut être intégré à diverses plates-formes de données et à des moteurs de recherche qui offrent des interfaces utilisateur. Des outils comme Apache Spark, Trino et Presto peuvent être utilisés pour interagir avec les tableaux d'Iceberg via leurs interfaces utilisateur respectives.

Comment Apache Iceberg se compare-t-il à d'autres formats de tableaux comme Apache Hudi ?

Apache Iceberg et Apache Hudi fournissent tous deux des transactions ACID et des fonctionnalités de voyage dans le temps, mais ils ont des philosophies de conception et des cas d'utilisation différents. Iceberg se concentre sur la fourniture d'un format de tableau haute performance avec prise en charge de plusieurs moteurs, tandis que Hudi met l'accent sur l'ingestion de données en temps réel et le traitement incrémental. Le choix de l'un ou l'autre dépend des cas d'utilisation spécifiques et des besoins d'intégration.

Apache Iceberg peut-il être utilisé pour des flux de travail d'apprentissage automatique ?

Oui, Apache Iceberg peut être utilisé pour les flux de travail d'apprentissage automatique. Sa capacité à gérer efficacement de grands ensembles de données et sa prise en charge de plusieurs formats de fichiers (tels que Parquet et Avro) en font un outil adapté à la préparation et au traitement des données pour les modèles d'apprentissage automatique. L'intégration avec des frameworks de traitement des big data comme Apache Spark renforce encore son utilité dans les workflows de ML.

Comment Apache Iceberg gère-t-il la sécurité des données et le contrôle d'accès ?

Apache Iceberg s'appuie sur les moteurs de stockage et de traitement sous-jacents pour la sécurité des données et le contrôle d'accès. Vous pouvez mettre en œuvre des mesures de sécurité telles que le chiffrement, les stratégies IAM et les contrôles d'accès au niveau de la couche de stockage (par exemple, Amazon S3, Google Cloud Storage) et de la couche de traitement (par exemple, Apache Spark, Flink). En outre, des services de catalogue tels que AWS Glue et Hive Metastore peuvent être utilisés pour gérer les autorisations et les contrôles d'accès.

Srujana est rédactrice technique indépendante et titulaire d'un diplôme de quatre ans en informatique. Écrire sur divers sujets, notamment la science des données, l'informatique en nuage, le développement, la programmation, la sécurité et bien d'autres encore, est pour elle une évidence. Elle aime la littérature classique et la découverte de nouvelles destinations.