Cursus

Apache Spark et Apache Flink sont deux frameworks de traitement de données open-source largement utilisés pour le big data et l'analytique. Bien qu'ils soient tous deux des outils puissants dotés de solides capacités de traitement des données, ils diffèrent par leur architecture et leurs principales fonctionnalités.

Nous explorerons les principales caractéristiques de Spark et Flink, en nous concentrant sur les modèles de traitement, les abstractions de données, la gestion des états et les performances. Nous étudierons également la manière dont chaque cadre gère le traitement des données par lots et en temps réel. Comprendre leurs différences et leurs similitudes vous aidera à choisir le cadre adapté à vos besoins.

L'importance des cadres de traitement des données

Nous savons tous que le volume de données disponibles augmente de manière exponentielle. Les organisations qui tentent d'utiliser les big data peuvent se heurter à des problèmes d'évolutivité et d'efficacité.

Les cadres de traitement des données sont une solution indispensable car ils peuvent prendre en charge une variété d'opérations sur les données, notamment l'ingestion, la transformation et le stockage, même lorsque l'on travaille avec des téraoctets de données. Ils proposent un large éventail d'outils et d'API, qui vous permettent d'effectuer des tâches allant des opérations de base à la modélisation de l'apprentissage automatique. En outre, les cadres de traitement des données vous offrent une abstraction de la complexité qui simplifie les processus de développement et de débogage des applications de traitement des données.

D'une manière générale, les cadres de traitement des données fonctionnent en répartissant la charge de travail sur plusieurs nœuds d'une grappe. Certains frameworks sont spécialement conçus pour traiter les données en temps réel, ce qui vous permet d'analyser les données au fur et à mesure qu'elles arrivent. D'autres sont optimisés pour traiter des données par lots, ce qui est utile pour votre analyse rétrospective.

Qu'est-ce que Spark ?

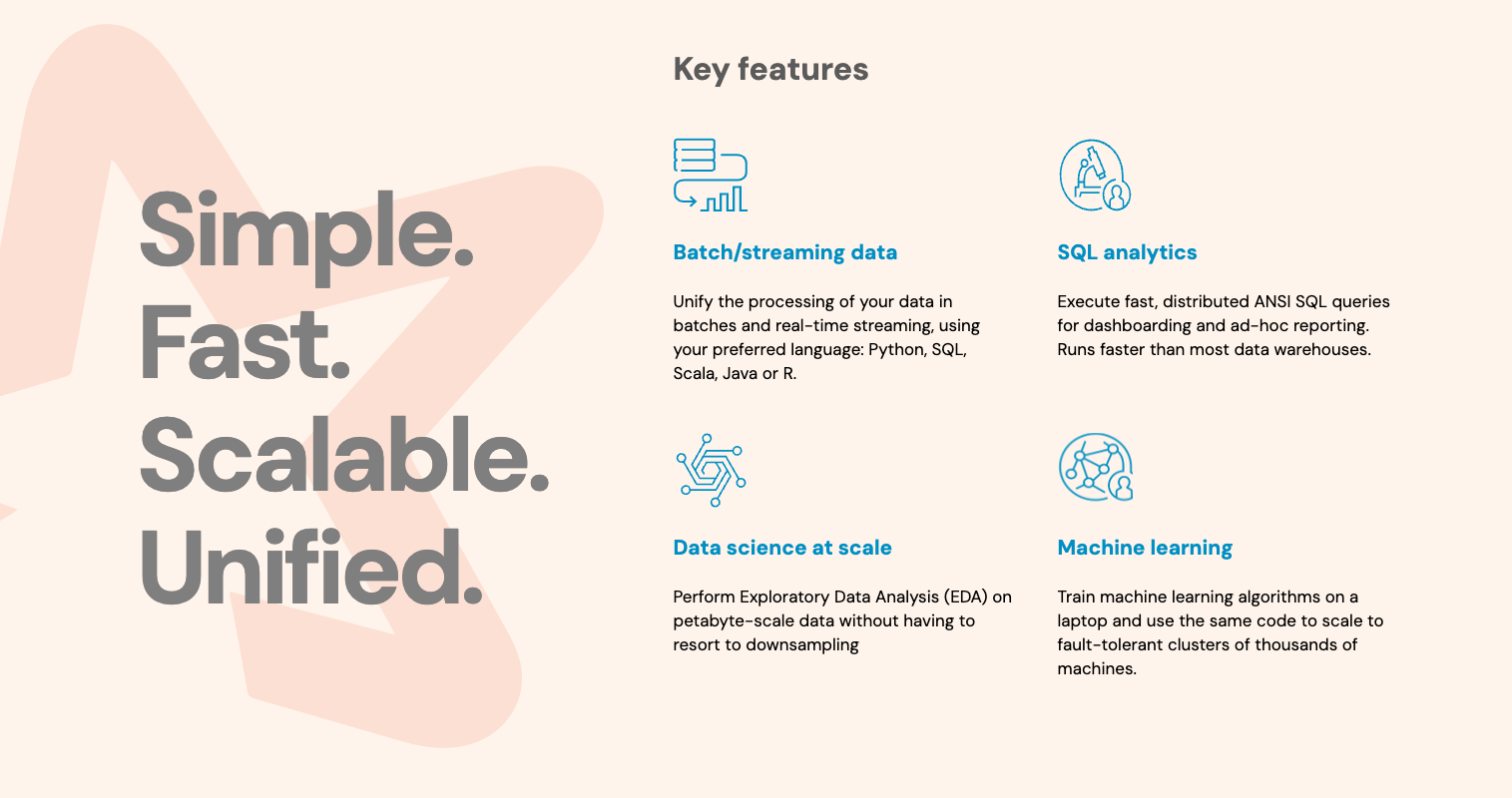

Apache Spark est un framework informatique distribué open-source conçu pour traiter efficacement et rapidement de grands volumes de données. Il utilise un modèle de programmation en mémoire, ce qui signifie qu'il peut stocker des données dans la mémoire principale des nœuds de la grappe, ce qui accélère considérablement le traitement par rapport à d'autres outils qui s'appuient davantage sur l'accès au disque. Son interface facile à utiliser vous permet d'effectuer des opérations de données complexes grâce à un ensemble d'API dans plusieurs langages, tels que Python et R, deux des principaux langages de la science des données.

Apache Spark peut exécuter des opérations de manière résiliente, ce qui signifie qu'il peut tolérer des défaillances dans les nœuds du cluster et se rétablir automatiquement. Cette puissante caractéristique est due à son composant, le Resilient Distributed Dataset (RDD), qui est une collection distribuée d'unités de base contenant des enregistrements de données.

D'autre part, le modèle d'exécution de Spark, Directed Acyclic Graph (DAG), vous permet d'optimiser la façon dont vous exécutez vos tâches en parallèle. Ce composant permet à Spark de répartir les tâches sur différents nœuds d'un même cluster, en tirant parti de toutes les ressources disponibles.

Apache Spark Apache Spark main features. Source

Apache Spark Apache Spark main features. Source

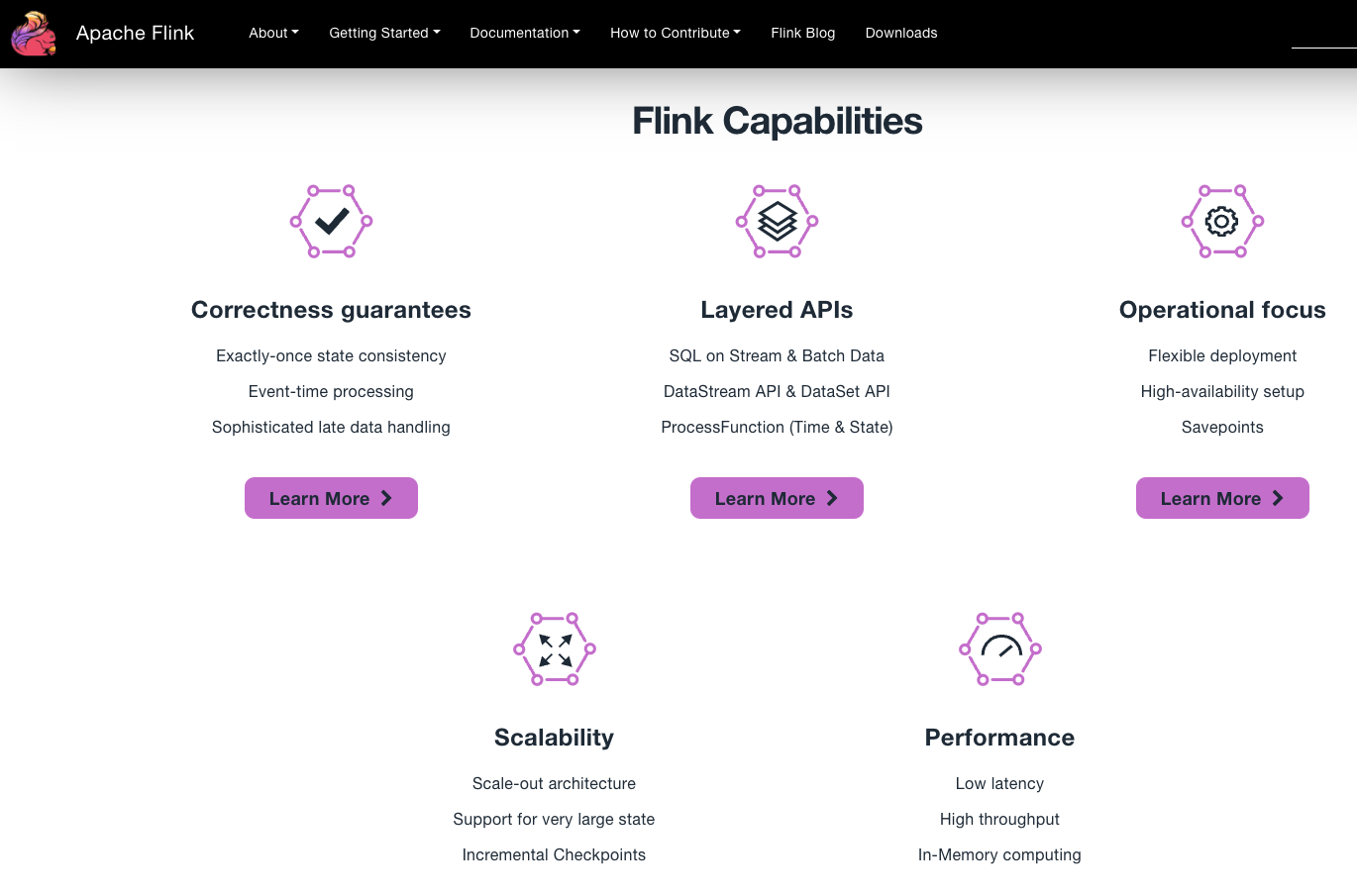

Qu'est-ce qu'Apache Flink ?

Apache Flink est un système de traitement de données open-source qui se distingue lorsque vous devez analyser des données en temps réel et traiter des données volumineuses avec une faible latence et des performances élevées. En utilisant la même infrastructure, Apache Flink peut également traiter des données par lots, ce qui représente un grand avantage lorsque vous devez construire et exécuter des pipelines de données complexes qui traitent des données en temps réel sur des systèmes distribués. Elle propose un ensemble d'API dans plusieurs langages, notamment Python et R, ainsi que des bibliothèques spécialisées qui vous aident à construire des pipelines de traitement d'événements d'apprentissage automatique.

Apache Flink traite vos données comme des flux continus d'événements, ce qui est utile dans les applications où les données sont constamment reçues et traitées. Ce modèle de programmation basé sur le flux est une caractéristique clé qui permet de réduire le temps de latence dans la réponse aux événements. Vous pouvez également créer des pipelines de traitement de données complexes et hautement personnalisés à l'aide des opérations Apache Flink.

Flink gère efficacement l'état des applications de traitement de données en temps réel. Cela signifie que vous pouvez maintenir et mettre à jour l'état de vos applications au fur et à mesure que les données arrivent, avec une tolérance aux pannes.

principales de . Source

principales de . Source

Principaux éléments à prendre en compte lors du choix entre Spark et Flink

L'utilisation des fonctionnalités d'un cadre de traitement des données approprié peut vous aider à améliorer les performances et l'efficacité de votre pipeline de données. Parmi toutes les fonctionnalités offertes par Spark et Flink, il y a quelques points clés que vous devez évaluer lorsque vous choisissez parmi ces outils :

- Modèle de traitement des données : Traitez-vous et analysez-vous des données par lots ou en temps réel ?

- Facile à utiliser : Votre application a-t-elle besoin d'API flexibles ? Quel langage de programmation utilisez-vous ?

- Écosystème et compatibilité : Quels autres outils et technologies intégrez-vous dans votre pipeline de données ? Quels outils et services spécifiques utilisez-vous déjà dans votre infrastructure ?

- Performance et gestion de l'État : Établissez-vous des priorités dans l'utilisation des ressources ? De quel type de charge de travail et de configuration de cluster votre pipeline a-t-il besoin ? Votre application nécessite-t-elle des manipulations d'état complexes ?

Principales similitudes entre Spark et Flink

Même si Spark et Flink se distinguent par des éléments clés, ils partagent plusieurs caractéristiques importantes. Ils sont tous deux conçus pour traiter des tâches de traitement de données à grande échelle avec une faible latence. Ils proposent tous deux un ensemble d'API dans plusieurs langages, notamment Python, Scala, Java et R, et ils sont intégrés à un écosystème d'outils big data plus large. De plus, Spark et Flink mettent en œuvre des optimisations de performance.

Examinons chacune de ces similitudes :

Modèle de traitement des données distribuées

Apache Flink et Apache Spark sont conçus pour traiter de gros volumes de données dans un cluster d'ordinateurs. Cette fonctionnalité vous permet de faire évoluer horizontalement votre application pour traiter d'énormes ensembles de données en allouant et en désallouant dynamiquement les ressources à la charge de travail sur plusieurs nœuds avec une faible latence. Les deux cadres peuvent gérer le traitement des données par lots et en continu.

API de haut niveau

Spark et Flink fournissent tous deux des API de haut niveau et des abstractions mises en œuvre dans plusieurs langages, notamment Scala, Python et Java, qui vous permettent d'écrire et d'exécuter des pipelines dans votre langage préféré. Ces API facilitent l'utilisation de ces frameworks lors du développement d'applications de traitement de données. En outre, Flink comprend des bibliothèques pour l'apprentissage automatique (FlinkML), le traitement des événements complexes (FlinkCEP) et le traitement des graphes (Gelly). Spark propose également des bibliothèques pour l'apprentissage automatique (MLlib), le traitement des graphes (GraphX) et le traitement des données en temps réel (GraphX).

Bonne intégration avec l'écosystème big data

Apache Spark ainsi qu'Apache Flink sont intégrés à un écosystème exhaustif d'outils big data, qui comprend notamment Hadoop Distributed File System, Apache Kafka et des systèmes de stockage dans le cloud tels qu'Amazon S3.

Optimisation des performances

Les deux cadres disposent d'une implémentation d'optimisation des performances qui maximise l'efficacité du traitement des données. Cette fonctionnalité vous permet d'effectuer des tâches complexes en tirant parti de l'exécution parallèle de Spark et Flink, de la planification des tâches et de l'optimisation des requêtes. Spark emploie l'optimiseur Catalyst tandis que Flink dispose d'un optimiseur basé sur les coûts pour le traitement par lots.

Principales différences : Spark vs. Flink

Apache Spark et Apache Flink partagent de nombreuses similitudes si l'on considère leurs capacités de base et leurs approches de traitement des données. Cependant, ils présentent également des différences significatives en ce qui concerne les points forts et les domaines d'intérêt de leurs modèles de traitement, la maturité de leurs écosystèmes et de leur support linguistique, ainsi que leur approche de l'optimisation et de la gestion de l'état.

Modèle de traitement des données

Apache Flink est principalement axé sur le traitement des données en temps réel. En effet, ce cadre est construit sur la base de son runtime de streaming et peut également gérer le traitement par lots. D'autre part, Apache Spark a été conçu à l'origine pour le traitement par lots, ce qui le rend plus adapté à l'analyse rétrospective de grands ensembles de données. En mettant en œuvre une approche par micro-lots, Spark peut également traiter des données en continu, mais avec des latences qui résultent plus élevées que Flink.

API et support linguistique

Comme nous l'avons mentionné, les deux cadres fournissent des API dans plusieurs langages de programmation. Cependant, la prise en charge de Python par Flink est moins mature, ce qui peut représenter une limitation si vous travaillez avec une équipe centrée sur les sciences des données.

Maturité de l'écosystème big data

Même si les deux frameworks disposent d'une bonne intégration avec les outils big data, Apache Spark dispose d'un écosystème plus vaste et plus mature, comprenant une variété de connecteurs, de bibliothèques et d'outils disponibles. Apache Flink dispose de plus en plus d'outils et d'extensions, mais son écosystème n'est pas encore tout à fait au point.

L'écosystème Apache Spark. Source

Gestion des performances et du statut

Apache Flink vous permet de travailler avec une gestion d'état plus avancée et plus flexible, ce qui peut représenter un avantage si vous travaillez avec des pipelines qui ont besoin de maintenir et de mettre à jour l'état en temps réel, comme le traitement des fenêtres de temps d'événement et de temps de traitement, ou des fenêtres pour traiter des modèles d'événements complexes. Spark vous permet d'exécuter une fonctionnalité de fenêtrage de base qui fonctionne bien lorsqu'un traitement par lots et par micro-lots est nécessaire.

Spark vs. Flink : Une comparaison détaillée

Apache Flink et Apache Spark présentent de nombreuses similitudes, mais diffèrent aussi sensiblement dans leur approche de traitement et la latence, les performances et la gestion des états qui y sont associées. En outre, ils ont un écosystème légèrement différent en termes de maturité et de prise en charge des langues. Le choix du cadre dépendra principalement des exigences spécifiques de votre projet. Cependant, il existe certaines fonctionnalités dans lesquelles Spark ou Flink excellent l'un par rapport à l'autre :

Traitement des données

Spark a été conçu à l'origine pour le traitement par lots, mais il prend désormais en charge les données en continu via son module Spark Streaming. Flink, quant à lui, a été spécifiquement développé pour les données en continu, mais il prend désormais également en charge le traitement par lots.

- Gagnant : Cela dépend du cas d'utilisation. Spark est meilleur pour le streaming, et Flink est meilleur pour le traitement par lots.

Performance

Spark utilise des ensembles de données distribués résilients et des techniques de partitionnement des données pour stimuler le traitement parallèle et optimiser l'utilisation des ressources. Flink exploite le chaînage d'opérateurs et l'exécution de pipelines, ce qui améliore l'efficacité du traitement parallèle et de la gestion des ressources. En général, Flink est considéré comme plus rapide et offre de meilleures performances dans les applications de traitement en temps réel.

- Gagnant : Flink en raison de ses meilleures performances globales.

Fenêtrage

Spark offre des fonctionnalités de fenêtrage de base principalement adaptées aux implémentations temporelles, s'adaptant bien aux fenêtres temporelles fixes ou glissantes pour le traitement des données par lots et en continu. Flink offre des possibilités de fenêtrage plus avancées, notamment des fenêtres basées sur les événements et le temps de traitement, des fenêtres de session et des fonctions de fenêtre personnalisées. Les capacités de fenêtrage de Flink sont nettement plus polyvalentes et efficaces, ce qui en fait le choix privilégié pour les besoins complexes.

- Gagnant : Flink en raison de sa flexibilité supérieure dans la gestion des exigences complexes en matière de fenêtrage.

Optimisation

Spark utilise l'optimiseur Catalyst, qui excelle dans l'optimisation des requêtes de transformation et de traitement des données, et intègre le moteur d'exécution Tungsten pour améliorer les performances du framework. Flink dispose d'un optimiseur basé sur les coûts, spécialement conçu pour les tâches de traitement par lots, qui évalue les ressources disponibles et les caractéristiques des données afin de sélectionner l'approche la plus efficace. En outre, l'exécution par pipeline et la planification à faible latence de Flink améliorent considérablement la vitesse de traitement des données. Le choix entre Spark et Flink pour l'optimisation dépend des cas d'utilisation spécifiques, car les deux offrent des avantages distincts.

- Gagnant : Cela dépend du cas. Spark est idéal pour les tâches complexes liées aux données. Flink est plus adapté au traitement rapide par lots.

Tolérance de panne

Spark atteint la tolérance aux pannes grâce à l'utilisation d'ensembles de données distribués résilients (RDD), qui sont des structures de données partitionnées immuables permettant une reconstruction rapide en cas de défaillance. Flink, quant à lui, utilise une approche distribuée basée sur des instantanés, capturant l'état de l'application à des points de contrôle spécifiques, ce qui facilite une reprise rapide en cas de défaillance avec un impact minimal sur les performances. Si les deux frameworks offrent une tolérance aux pannes efficace, la méthode de Flink se traduit généralement par des temps de récupération plus rapides et une moindre perturbation des processus en cours, ce qui en fait le choix préférable dans les scénarios où il est essentiel de minimiser les temps d'arrêt.

- Gagnant : Flink en raison de son mécanisme de tolérance aux pannes plus efficace qui permet un rétablissement plus rapide avec moins de perturbations.

Support linguistique et API

Spark prend en charge un éventail de langages de programmation, notamment Scala, Java, Python et R, ce qui le rend très attractif pour les développeurs et les scientifiques des données en raison de son vaste potentiel de collaboration et d'un ensemble complet d'API pour ces langages. Flink, tout en prenant en charge Java, Scala et Python avec des API intuitives et conviviales, offre des capacités Python plus limitées, ce qui peut freiner son adoption par les équipes de science des données. La prise en charge supérieure de Python par Spark le rend plus attrayant pour les équipes centrées sur les données où Python est principalement utilisé.

- Gagnant : Spark en raison de sa prise en charge supérieure de Python, un langage largement utilisé dans la science des données.

Écosystème

Spark bénéficie d'un écosystème complet et mature, s'intégrant de manière transparente à un large éventail d'outils big data tels que Hadoop, Hive et Pig, entre autres. Cette compatibilité étendue fait de Spark un choix robuste pour les environnements de données complexes nécessitant divers ensembles d'outils. Flink dispose d'une gamme plus limitée d'intégrations avec d'autres outils big data, bien qu'il excelle dans son intégration avec Apache Kafka. En raison de ses intégrations plus complètes et plus matures, Spark présente généralement un écosystème plus solide.

- Gagnant : Spark en raison de son écosystème large et mature, qui offre des intégrations transparentes avec de nombreux outils big data, tels que Hadoop, Hive et Pig.

Flink vs Spark : Un résumé

Vous trouverez ci-dessous un tableau résumant les principales différences entre Spark et Flink :

| Catégories | Spark | Flink | Gagnant |

|---|---|---|---|

| Traitement des données | Modèle axé sur les lots | Modèle orienté temps réel | Cela dépend |

| Performance | RDDs et partitionnement des données | Enchaînement d'opérateurs et exécution de pipelines | Flink |

| Fenêtrage | Fonctionnalités basées sur le temps | Fonctions événementielles, de session et personnalisées | Flink |

| Optimisation | Optimiseur de catalyseur | Optimiseur basé sur les coûts | Cela dépend |

| Tolérance de panne | Réalisé par les RDD | Instantanés distribués | Flink |

| Prise en charge des langues et des API | Un soutien complet | Plusieurs langues, Python non avancé | Spark |

| Écosystème | Intégration complète avec les outils de big data | Intégration avec certains outils, excellent avec Kafka | Spark |

Dernières réflexions

Le choix du cadre de traitement des données le plus approprié peut améliorer les performances de votre pipeline de données. Parmi tous les frameworks, Apache Spark et Apache Flink se distinguent comme deux outils puissants et polyvalents avec leurs forces et capacités distinctes.

Spark est parfaitement adapté au traitement par lots, offrant une variété d'outils, d'API et une intégration complète avec d'autres technologies big data. Si vous souhaitez apprendre à utiliser Spark depuis Python, consultez notre cours d'introduction à PySpark et notre tutoriel Getting Started with Pyspark. Flink se distingue pour le traitement des données en temps réel et en continu, car il offre une gestion efficace des états, des fonctionnalités de fenêtrage et des performances à faible latence.

En fin de compte, le choix entre ces deux cadres dépendra des exigences et des besoins propres à votre projet. Pour bien comprendre ces outils, il est préférable de poursuivre votre lecture et de vous entraîner à l'aide des ressources suivantes.