Lernpfad

Unternehmen stehen bei der Übertragung von Daten vor Herausforderungen, wenn sie Arbeitslasten in die Cloud verlagern oder Backups und Disaster Recovery verwalten. Veraltete Verfahren - wie manuelle Uploads oder benutzerdefinierte Skripte - sind nicht automatisierbar und nicht zuverlässig, was zu höheren Kosten und einem höheren Betriebsaufwand führt.

AWS DataSync macht es einfacher, indem es eine sichere, automatisierte Methode zur Übertragung von Datensätzen zwischen Speichersystemen, vor Ort und AWS-Diensten oder zwischen verschiedenen AWS-Regionen bietet.

In diesem Tutorial führe ich dich durch das Thema:

- AWS DataSync einrichten - Erstellen und Konfigurieren von Agenten für die Datenübertragung.

- Konfigurieren von Datenübertragungsaufgaben - Definieren von Quell- und Zielendpunkten, Filtern von Daten und Planen von Übertragungen.

- Verwendung von DataSync für wichtige Anwendungsfälle - einschließlich Cloud-Migration, Backup und Disaster Recovery.

Was ist AWS DataSync?

AWS DataSync ist ein Datentransfer-Service, der darauf abzielt, große Datenmengen zwischen lokalen Speichersystemen und Cloud-Umgebungen mit AWS-Diensten zu verschieben. Es rationalisiert die Datenübertragungsprozesse, indem es Aufgaben wie die Datenvalidierung und -verschlüsselung übernimmt und Zeitplanungsoptionen bietet. Das macht sie zu einer zuverlässigen Wahl für Migrationen, Datensicherungen und kontinuierliche Datenreplikation.

DataSync beschleunigt die Datenübertragung im Vergleich zu Methoden, die komplizierte Skripte oder manuelle Schritte erfordern, indem es einen schnellen und sicheren automatischen Datenaustausch zwischen verschiedenen Quellen ermöglicht. Es unterstützt Überweisungen zwischen:

- Vor-Ort-Speicher (NFS, SMB, Objektspeicher) und AWS.

- Amazon S3,Amazon EFS, Amazon FSx und Amazon S3 Glacier.

- AWS-Services über verschiedene Regionen und Konten hinweg.

> Wenn du neu bei AWS bist oder die wichtigsten Cloud-Themen auffrischen möchtest, bietet dir derauffrischen möchtest, bietet dir der Kurs AWS Cloud Technology and Services einen soliden Überblick über Kerndienste wie EC2, S3 und IAM.

Merkmale von AWS DataSync

- Hochgeschwindigkeits-Datenübertragung: Die Nutzung paralleler und optimierter Datenströme ermöglicht eine bis zu 10-mal schnellere Datenübertragung.

- Automatisierte Datenvalidierung: Überprüft die Richtigkeit der übertragenen Daten durch Prüfsummenberechnungen, um die Datenintegrität zu gewährleisten.

- Nahtlose Integration mit AWS-Diensten: Unterstützt nativrts Amazon S3,Amazon EFS, Amazon FSx für Windows und FSx für Lustre sowohl als Quelle als auch als Ziel.

- Inkrementelle und planmäßige Übertragungen: Überträgt nur geänderte Daten (Differentialsynchronisation), um die Bandbreitennutzung und die Kosten zu minimieren, und unterstützt die Zeitplanung für die periodische Datensynchronisation.

- Sicherheit und Verschlüsselung: Die Datenübertragungen werden durch eine Ende-zu-Ende-Verschlüsselung mit TLS für die Transitsicherheit und AES 256 für den Schutz der Daten im Ruhezustand gesichert. AWS Identitäts- und Zugriffsmanagement (IAM)bietet auchZugriffskontrolle .

- Regionsübergreifende und kontoübergreifende Überweisungen: Dies erleichtert das Kopieren von Daten zwischen Regionen und Konten auf AWS zur Planung und gemeinsamen Nutzung.

Nun, da der Kontext klar ist, lass uns zum praktischen Teil dieses Tutorials kommen!

Einrichten von AWS DataSync

Bevor du Daten übertragen kannst, musst du AWS DataSync richtig konfigurieren. Dieser Abschnitt behandelt die Voraussetzungen und Einrichtungsschritte, einschließlich der Installation des Agenten, der IAM-Rollen und der Speicherkonfiguration.

Voraussetzungen für AWS DataSync

Wir werden AWS CloudFormation verwenden, um den Bereitstellungsprozess zu automatisieren und uns auf die Datenmigration zu konzentrieren. Wir werden die folgenden Ressourcen erstellen:

- Eine AWS VPC mit öffentlichen Subnetzen für die Netzwerkkonnektivität.

- Ein NFS-Server auf einer Amazon EC2-Instanz, um ein lokales Speichersystem zu simulieren.

- AWS DataSync-Agenten auf EC2-Instanzen, um die Datenbewegung zu erleichtern.

- IAM-Rollen und -Richtlinien, um die erforderlichen Berechtigungen für DataSync-Vorgänge zu erteilen.

Anmeldung bei der AWS-Konsole

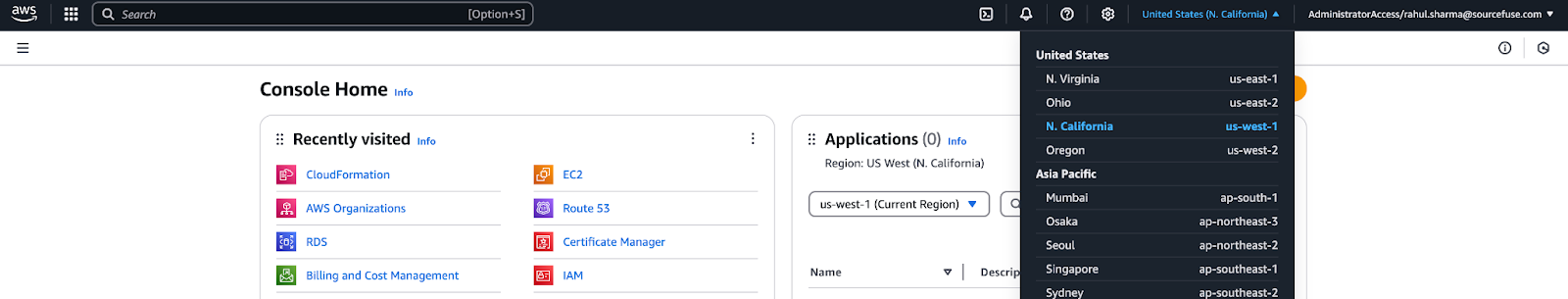

- Melde dichmit deinen Anmeldedatenbei der AWS Management Console an.

- Klicke auf das Dropdown-Menü in der oberen rechten Ecke des Bildschirms und wähle die Option "N. Region "Kalifornien" für dieses Lernprogramm.

Abbildung 1 - Auswahl der AWS-Region in der AWS Management Console

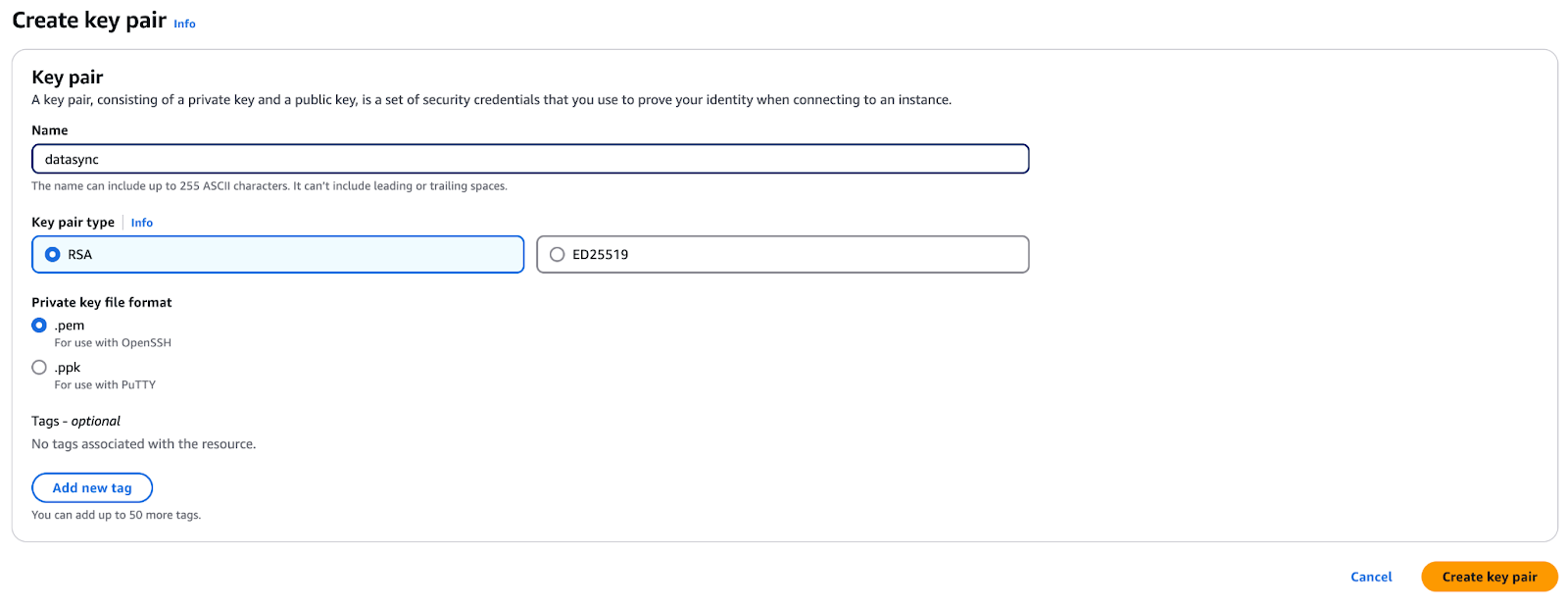

- Gehe zur EC2-Konsole und navigiere zum AbschnittSchlüsselpaar. Stelle sicher, dass du dich in der gleichen AWS-Region befindest wie im vorherigen Schritt.

- Klicke auf Schlüsselpaar erstellen und nenne es "datasync".

Abbildung 2 - Erstellen eines Schlüsselpaars für den sicheren Zugriff in AWS EC2

- Klicke auf erstellenund dein Browser wird eine

datasync.pemDatei herunterladen. - Speichere diese Datei sicher ab - du wirst sie später im Lernprogramm brauchen.

Konfiguriere die Umgebung

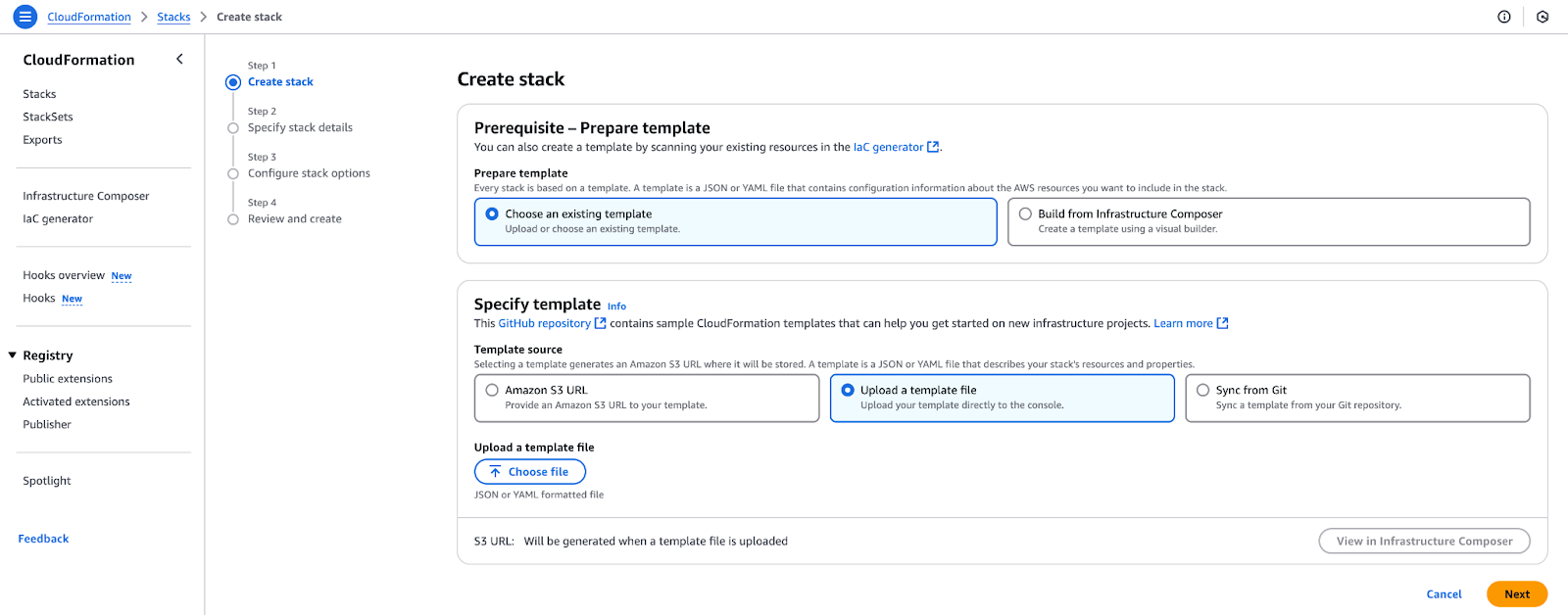

In diesem Schritt verwendest du eine CloudFormation-Vorlage, um die notwendige AWS-Infrastruktur für AWS DataSync einzurichten, die bereits erwähnt wurde.

- Öffne die AWS CloudFormation-Konsole und klicke auf Stack erstellen.

- Wähle " Vorlage ist fertig" und dann " Vorlagendatei hochladen".

Abbildung 3 - Hochladen einer CloudFormation-Vorlage zur Erstellung eines neuen Stacks.

- Lade die Datei von Github Gist herunter und klicke auf Datei auswählen, lade

datasync-onprem.yamlhoch und klicke auf Weiter. - Wähle im Abschnitt Parameter ein EC2-Schlüsselpaar aus, um die SSH-Anmeldung bei den von diesem Stack erstellten Instanzen zu ermöglichen. Bearbeite die Werte für die AMI-IDs nicht, sondern klicke auf Weiter.

- Behalte auf der Seite Stack-Optionen die Standardeinstellungen bei und klicke auf Weiter.

- Überprüfe die Konfiguration und klicke auf Stapel erstellen.

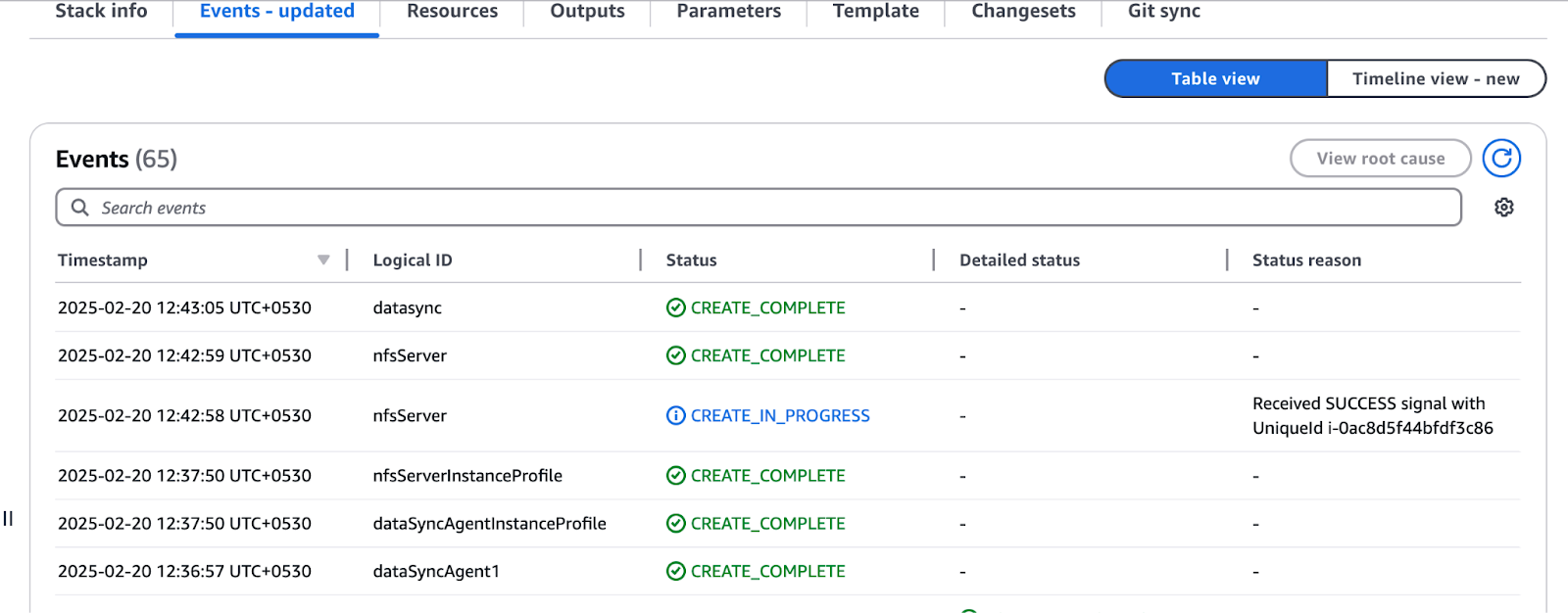

- Du wirst zur CloudFormation-Konsole weitergeleitet, wo der Status "CREATE_IN_PROGRESS" angezeigt wird. Warte, bis die Anzeige auf "CREATE_COMPLETE" wechselt.

Abbildung 4 - Überprüfung des Status der Ressourcenerstellung in AWS CloudFormation

- Sobald du fertig bist, navigiere zum Abschnitt Ausgaben und notiere dir die Werte - du brauchst sie für den Rest des Tutorials.

- Du musst einen anderen Stack einsetzen, indem du die gleichen Schritte wie oben beschrieben ausführst. Diese Vorlage benötigt keine zusätzlichen Parameter. Lade die Vorlage von GitHub Gist herunter und fahre mit der Bereitstellung fort.

Einrichten des DataSync Agenten

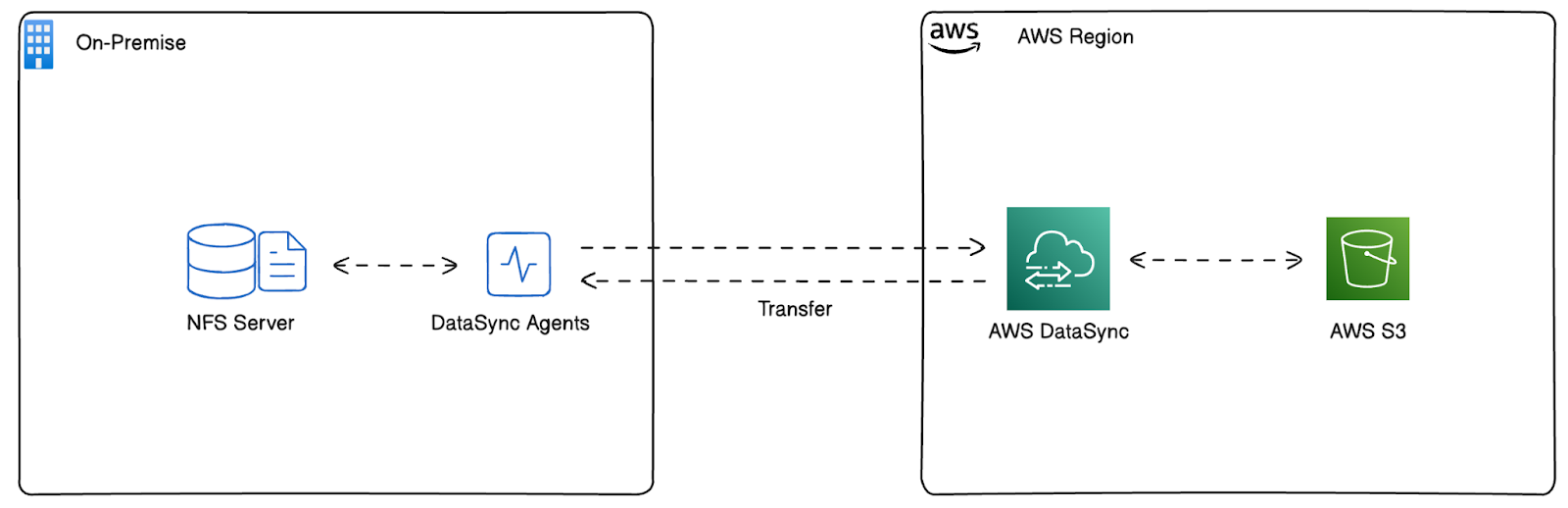

In diesem Lernprogramm replizieren wir eine lokale Umgebung in AWS, um reale Datenübertragungsszenarien mit AWS DataSync zu simulieren.

Anstatt eine Infrastruktur vor Ort zu nutzen, haben wir einen NFS-Server auf einer Amazon EC2-Instanz gestartet, der als Quellspeichersystem dienen wird. So können wir AWS DataSync so testen und konfigurieren, als würden wir Daten von einem Standort vor Ort verschieben.

Wir haben die AWS DataSync Agents auf EC2-Instanzen in derselben Umgebung gestartet, um die Datenbewegung zu ermöglichen. Diese Agenten sind für die Verknüpfung des NFS-Servers mit AWS DataSync zuständig und ermöglichen die Datenübertragung zu Cloud-Speicherdiensten wie Amazon S3.

Diese Architektur ermöglicht es uns, AWS DataSync-Aufgaben zu imitieren, zu konfigurieren und zu validieren, um einen nahtlosen Arbeitsablauf zu erreichen, bevor wir sie in einer realen Umgebung vor Ort implementieren. In diesem Lernprogramm werden wir diese Umgebung nutzen, um den Agenten zu registrieren, die DataSync-Aufgaben zu erstellen und Daten effizient zu verschieben.

Abbildung 5 - Mit AWS CloudFormation bereitgestellte Architektur

Konfigurieren des NFS-Servers für AWS DataSync

Bevor du AWS DataSync einrichtest, musst du wissen, welche Daten du übertragen willst und wie sie organisiert sind. In diesem Abschnitt werden wir einen NFS-Server in unserer AWS-Umgebung so konfigurieren, dass er als lokales Speichersystem fungiert. Mit dieser Einrichtung können wir die Datenmigration zu AWS-Diensten simulieren.

Melde dich zunächst beim NFS-Server an:

- Öffne die AWS Management Console und navigiere zum "N. Region "Kalifornien".

- Wähle EC2 aus der Liste der AWS-Services aus.

- Finde die NFS-Server-Instanz in der EC2-Instanzliste.

- Klicke auf Verbinden und folge den Anweisungen, um dich über Session Manager oder SSH zu verbinden.

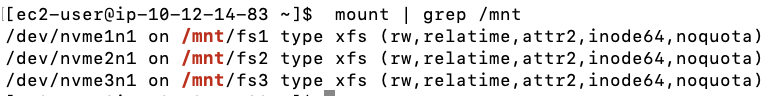

Dann durchsuchst du die Dateisysteme. Der NFS-Server enthält drei 200-GiB-EBS-Volumes, die jeweils mit dem XFS-Dateisystem formatiert und mit Beispieldatensätzen vorbesetzt sind.

- Führe den folgenden Befehl aus, um die eingehängten Dateisysteme zu überprüfen:

mount | grep /mnt

Abbildung 6 - Erwartete Ausgabe des Befehls mount

- Als Nächstes überprüfst du die Datenmenge in jedem Dateisystem:

df -h | grep /mnt

Abbildung 7 - Erwartete Ausgabe des Befehls df

Wie du sehen kannst, enthalten fs1 und fs2 12 GiB an Daten und fs3 enthält 22 GiB an Daten.

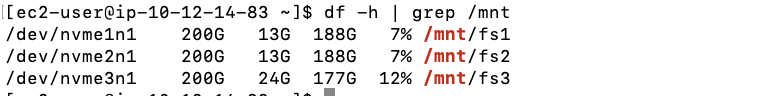

Jetzt konfigurieren wir die NFS-Exporte. Um AWS DataSync-Agenten den Zugriff auf den NFS-Server zu ermöglichen, konfiguriere die Datei /etc/exports:

- Öffne die Datei

/etc/exportsals root mit einem Texteditor:

sudo nano /etc/exports- Füge die folgenden Zeilen hinzu, um Nur-Lese-Exporte (ro) für die DataSync-Agenten zu definieren:

/mnt/fs1 10.12.14.243(ro,no_root_squash) 10.12.14.249(ro,no_root_squash)

/mnt/fs2 10.12.14.243(ro,no_root_squash) 10.12.14.249(ro,no_root_squash)

/mnt/fs3 10.12.14.243(ro,no_root_squash) 10.12.14.249(ro,no_root_squash)Ersetze 10.12.14.243 und 10.12.14.249 durch die privaten IPs deiner DataSync Agent EC2-Instanzen aus den CloudFormation-Ausgaben.

- Wende die neuen Exporteinstellungen an, indem du den NFS-Dienst neu startest:

sudo systemctl restart nfs- Überprüfe die NFS-Exporte:

showmount -e

Abbildung 8 - Erwartete Ausgabe des Befehls showmount

Konfigurieren von CloudWatch und Aktivieren von AWS DataSync-Agenten

Wenn der NFS-Server konfiguriert ist, musst du als Nächstes die AWS CloudWatch-Protokollierung für DataSync aktivieren und die DataSync-Agenten in den "N. Region "Kalifornien". So wird sichergestellt, dass alle Dateiübertragungen protokolliert werden, um Fehler oder Ausfälle zu erkennen.

Bevor AWS DataSync Protokolle an CloudWatch senden kann, müssen wir eine Ressourcenrichtlinie erstellen, die DataSync die erforderlichen Berechtigungen erteilt.

- Kopiere die folgende JSON-Richtlinie und speichere sie als

datasync-policy.jsonauf deinem lokalen Rechner:

{

"Statement": [

{

"Sid": "DataSyncLogsToCloudWatchLogs",

"Effect": "Allow",

"Action": [

"logs:PutLogEvents",

"logs:CreateLogStream"

],

"Principal": {

"Service": "datasync.amazonaws.com"

},

"Resource": "*"

}

],

"Version": "2012-10-17"

}- Dann führst du den folgenden Befehl in deinem Terminal aus:

aws logs put-resource-policy --region us-west-1 --policy-name trustDataSync --policy-document file://datasync-policy.jsonMit dem obigen Befehl kann AWS DataSync Protokolle an CloudWatch schreiben, die bei der Überwachung und Fehlersuche bei Übertragungsproblemen helfen.

Aktivieren wir nun die DataSync-Agenten. Obwohl die EC2-Instanzen des DataSync-Agenten in der "N. Region "Kalifornien", müssen sie vor der Nutzung in dieser Region aktiviert werden.

Hinweis: Wenn du den DataSync-Agenten in VMware oder einer anderen On-Premises-Umgebung installieren musst, lies die offizielle AWS-Anleitung. Da wir jedoch eine On-Premises-Installation mit EC2-Instanzen simulieren, werden die DataSync-Agenten in diesem Tutorial gemäß den AWS Best Practices für Cloud-basierte Installationen bereitgestellt.

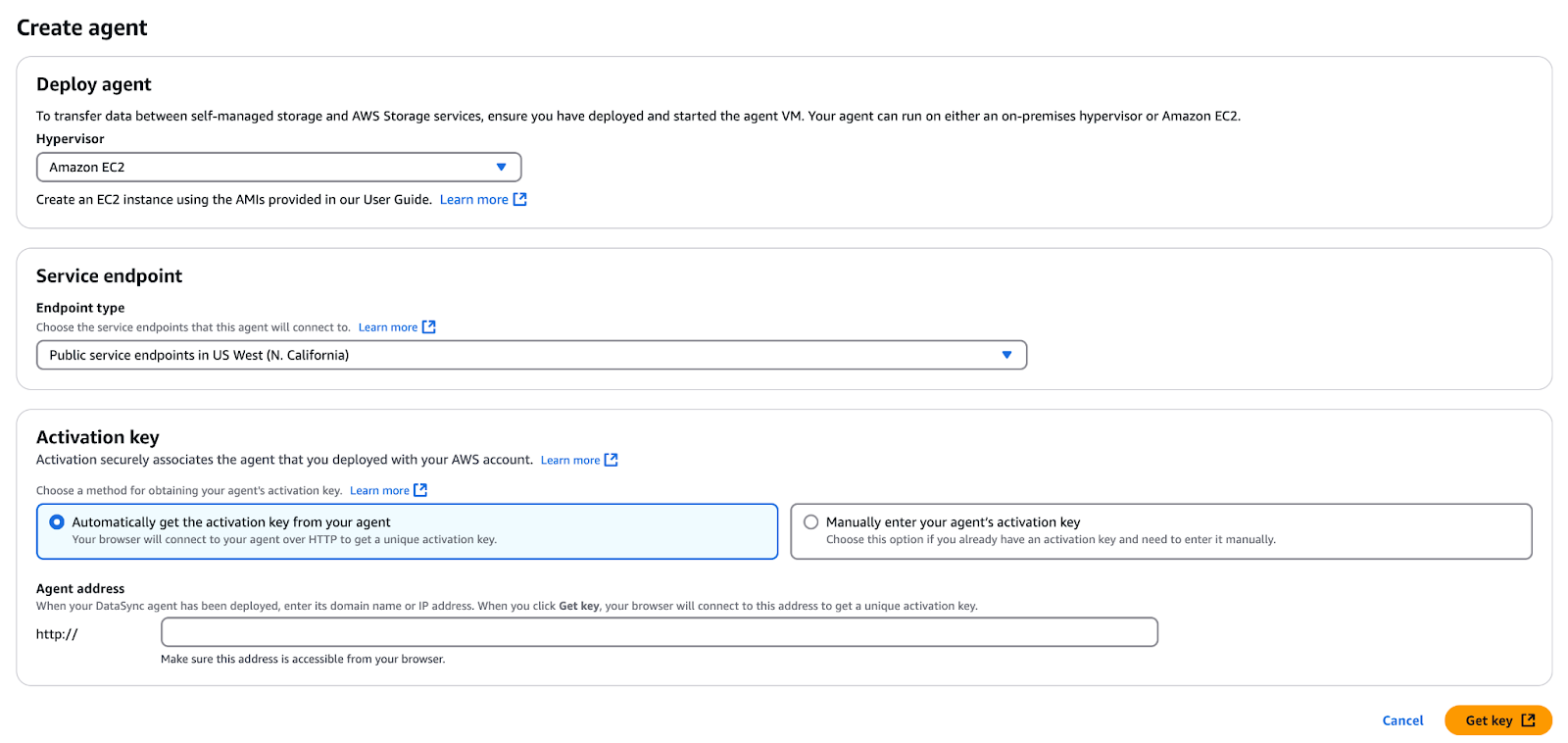

- Navigiere zur AWS-Verwaltungskonsole und wähle die Option "N. Region "Kalifornien".

- Öffne den AWS DataSync Service.

- Wenn es noch keine Agenten gibt, klicke auf Loslegen; andernfalls klicke auf Agent erstellen.

- Im Abschnitt " Dienst-Endpunkt" belässt du es bei "Öffentliche Dienst-Endpunkte...".

- Im Abschnitt Aktivierungsschlüssel gibst du die öffentliche IP-Adresse des ersten DataSync-Agenten aus den CloudFormation-Ausgaben ein:

- Agent 1 Öffentliche IP:

- Agent 2 Öffentliche IP:

- Agent 1 Öffentliche IP:

Abbildung 8 - DataSync-Agent erstellen und aktivieren

- Klick abrufen. Schlüssel um den Aktivierungsschlüssel abzurufen.

- Sobald die Aktivierung erfolgreich war, gibst du einen Agentennamen ein (z. B. "Agent 1" oder "Agent 2").

- Bringe bei Bedarf Markierungen an.

- Klicke auf Agent erstellen.

- Wiederhole die oben genannten Schritte für den zweiten DataSync-Agenten.

Erstellen einer DataSync-Aufgabe

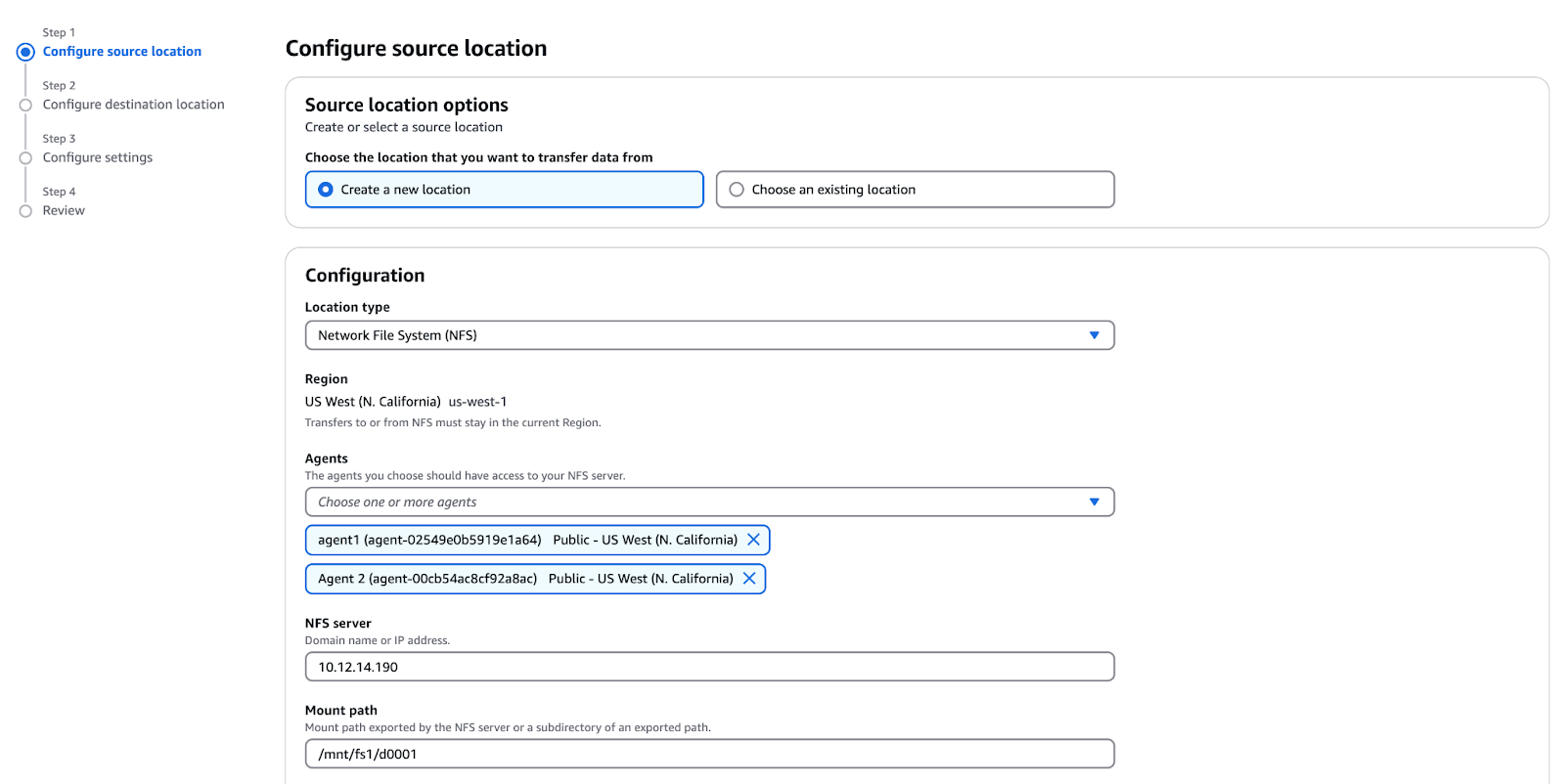

Jetzt können wir endlich eine DataSync-Aufgabe erstellen! Befolge diese Schritte:

- Rufe die AWS DataSync-Konsole auf.

- Klicke auf Aufgaben → Erstellen Aufgabe.

- Quellort erstellen:

- Standort Typ: Netzwerk-Dateisystem (NFS).

- Agenten: Wähle sowohl "Agent 1 private IP" als auch "Agent 2 private IP".

- NFS Server Private IP: NFS private IP.

- Mount Pfad:

/mnt/fs1/d0001(kopiert nur das Verzeichnisd0001).

Abbildung 10 - Konfigurieren des Quellorts für AWS DataSync

- Zielort erstellen:

- Standorttyp: Amazon S3.

- Wähle den S3-Bucket aus den CloudFormation-Ausgaben aus.

- Speicherklasse: Standard.

- IAM-Rolle: Aus CloudFormation-Ausgaben auswählen

Konfigurieren von Datenübertragungsaufgaben

Sobald AWS DataSync eingerichtet ist, ist der nächste Schritt die Konfiguration der Datenübertragungsaufgaben. Diese Aufgaben legen fest, wie, wann und wohin die Daten übertragen werden. AWS DataSync unterstützt verschiedene Optionen zur Optimierung von Übertragungen, einschließlich Dateifilterung, Zeitplanung und Überwachung.

- Konfiguriere die Aufgabeneinstellungen:

- Name der Aufgabe: Test Aufgabe

- Muster ausschließen:

*/.htaccessund*/index.html - Übertragungsmodus: Nur geänderte Daten übertragen (legt fest, ob DataSync nur die Daten und Metadaten überträgt, die sich zwischen der Quelle und dem Ziel unterscheiden).

- Überprüfe die Daten: Wähle "Nur die übertragenen Daten überprüfen".

- Aktiviere die CloudWatch-Protokollierung:

- Log-Gruppe: Wähle

DataSyncLogs-datasync-incloud. - Klicke auf Weiter, überprüfen Sie die Einstellungen und klicken Sie auf erstellen. Aufgabe.

Durchführen von Datenübertragungen mit AWS DataSync

Nachdem du eine DataSync-Aufgabe konfiguriert hast, musst du die Übertragung durchführen und ihren Fortschritt überwachen. In diesem Abschnitt erfährst du, wie du einen Lernpfad manuell oder über die Befehlszeilenschnittstelle (CLI) startest, seinen Status verfolgst und allgemeine Probleme behebst.

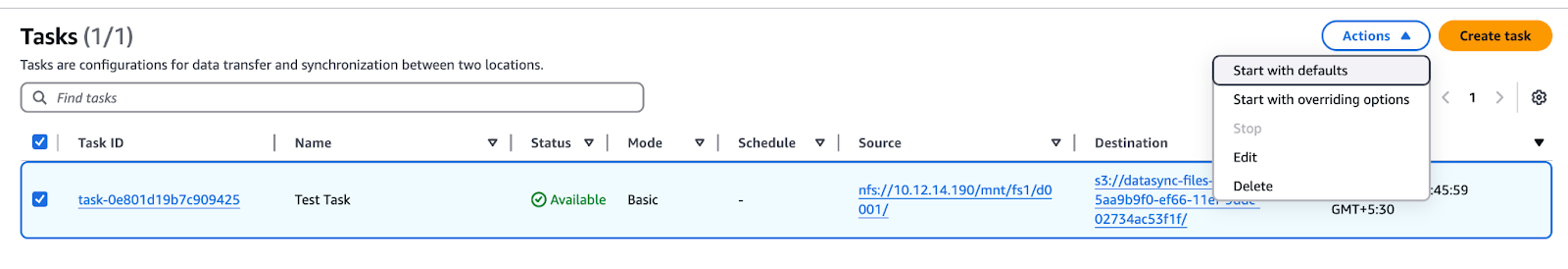

Starten der Datenübertragung

- Warte, bis der Status der Aufgabe von "Erstellen" auf "Verfügbar" wechselt.

- Klicken Sie auf die Start Schaltfläche, überprüfe die Einstellungen und klicke starten..

Abbildung 11 - AWS DataSync-Aufgabenliste mit Optionen zum Starten, Bearbeiten oder Löschen der Aufgabe

- Überwache den Fortschritt der Aufgabe:

- Es wird durch diese Status übergehen: Starten → Vorbereiten → Übertragen → Überprüfen → Erfolg.

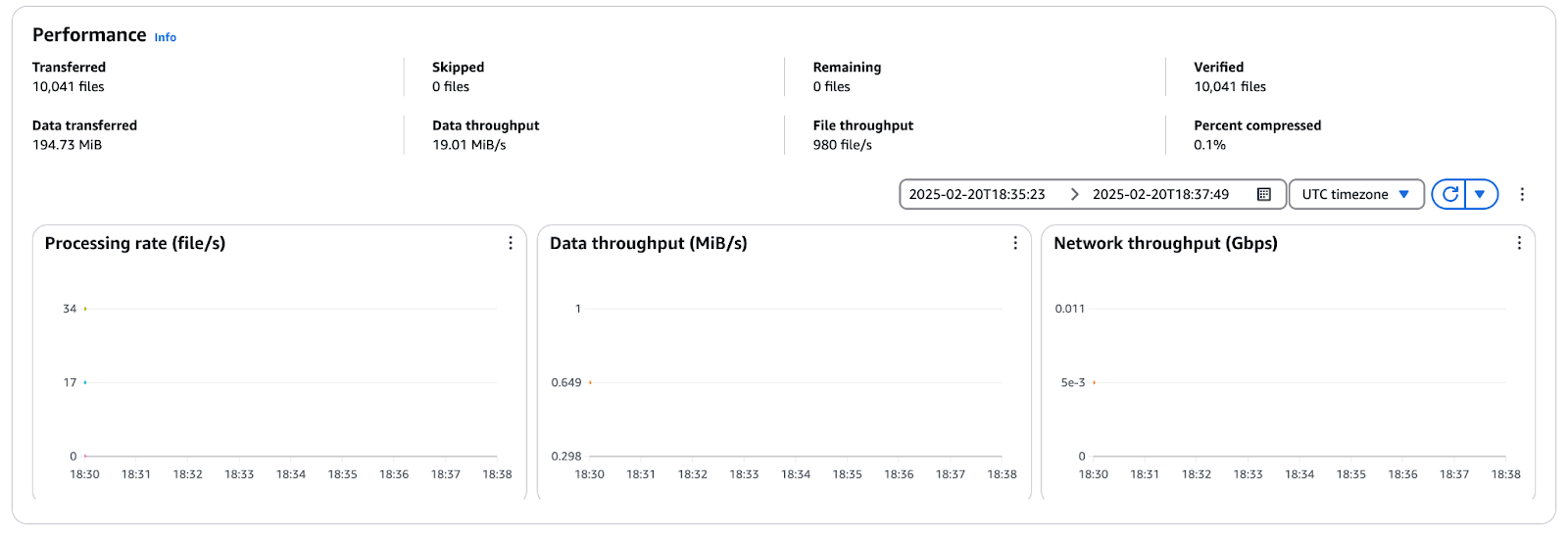

Überwachung des Transferfortschritts

Klicken Sie auf die Aufgabe Verlauf und wähle das Ausführungsobjekt aus, um die Übertragungsstatistiken in der Aufgabe zu sehen.

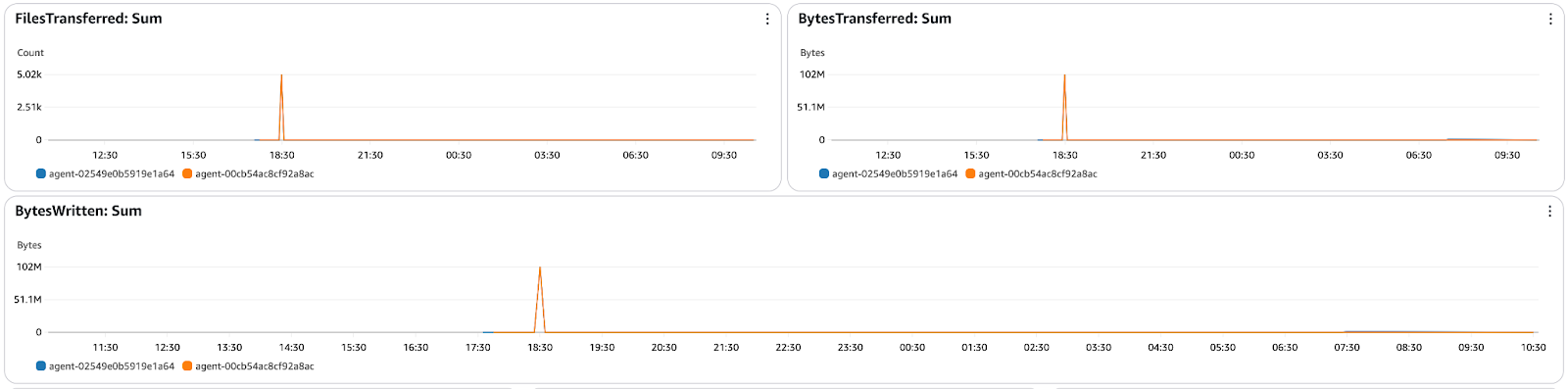

Abbildung 12 - AWS DataSync-Leistungskennzahlen mit Datendurchsatz, Datendurchsatz und Netzwerkauslastung

Behebung von Problemen bei der Datenübertragung

Bei AWS DataSync-Übertragungen können allgemeine Probleme wie Verbindungsfehler, Berechtigungsfehler oder langsame Übertragungsgeschwindigkeiten auftreten. So behebst du Probleme:

- CloudWatch-Protokolle prüfen - Identifiziere Fehler im Zusammenhang mit Dateiberechtigungen, Agentenkonnektivität oder fehlgeschlagenen Übertragungen.

- Überprüfe die Netzwerkkonnektivität - Stelle sicher, dass die DataSync Agenten sowohl die Quelle (NFS/SMB) als auch das Ziel (S3, EFS, FSx) erreichen können.

- Überprüfe die IAM-Berechtigungen - Vergewissere dich, dass die DataSync Service-Rolle die erforderlichen Berechtigungen zum Lesen/Schreiben von Daten hat.

- Prüfen der Agentenkonfiguration - Vergewissere dich, dass die Agenten ordnungsgemäß aktiviert und funktionsfähig sind und mit dem AWS DataSync Service kommunizieren können.

Post-Transfer-Schritte und Datensynchronisation

Sobald die Datenübertragung abgeschlossen ist, ist es wichtig, die Integrität der übertragenen Dateien zu überprüfen und bei Bedarf eine laufende Synchronisierung einzurichten. In diesem Abschnitt wird erklärt, wie du die Datengenauigkeit überprüfst, inkrementelle Synchronisierungen planst und ungenutzte Ressourcen bereinigst, um die Kosten zu optimieren.

Überprüfung der Datenintegrität

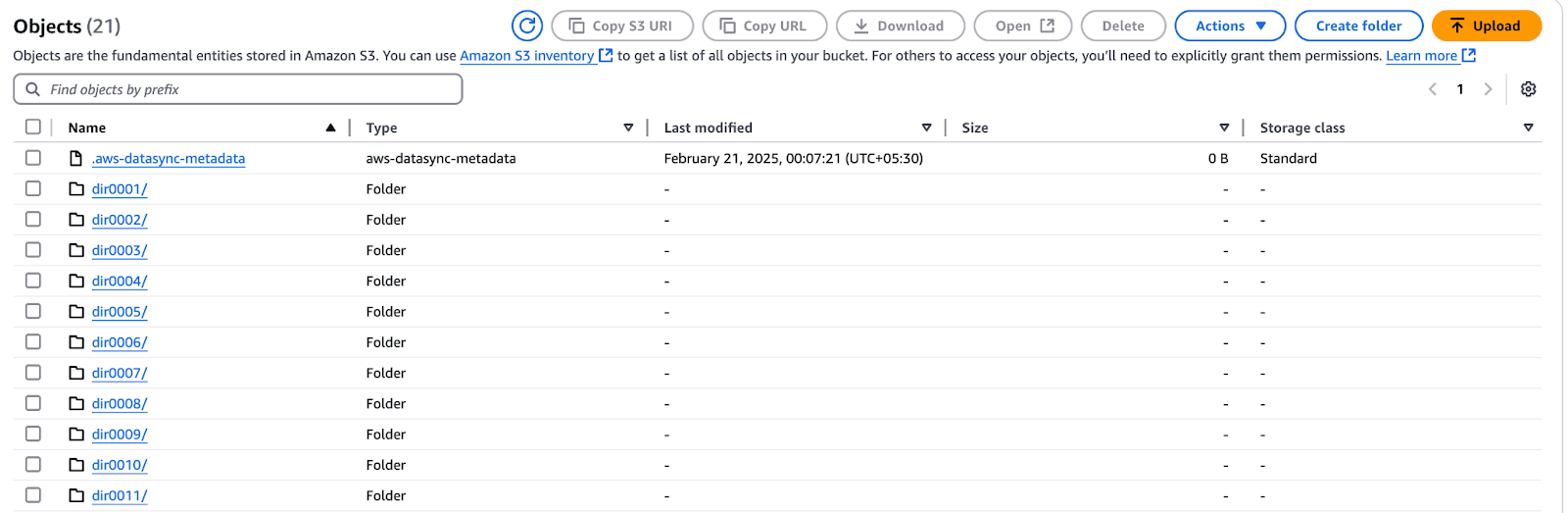

- Öffne die AWS S3-Konsole und navigiere zu dem Bucket, das mit "datasync" beginnt.

- Durchsuche den Bucket und überprüfe, ob alle erwarteten Dateien übertragen wurden.

Abbildung 13 - AWS S3 Bucket mit den über AWS DataSync übertragenen Dateien

- Stelle sicher, dass die Dateien

.htaccessundindex.htmlnicht kopiert wurden.

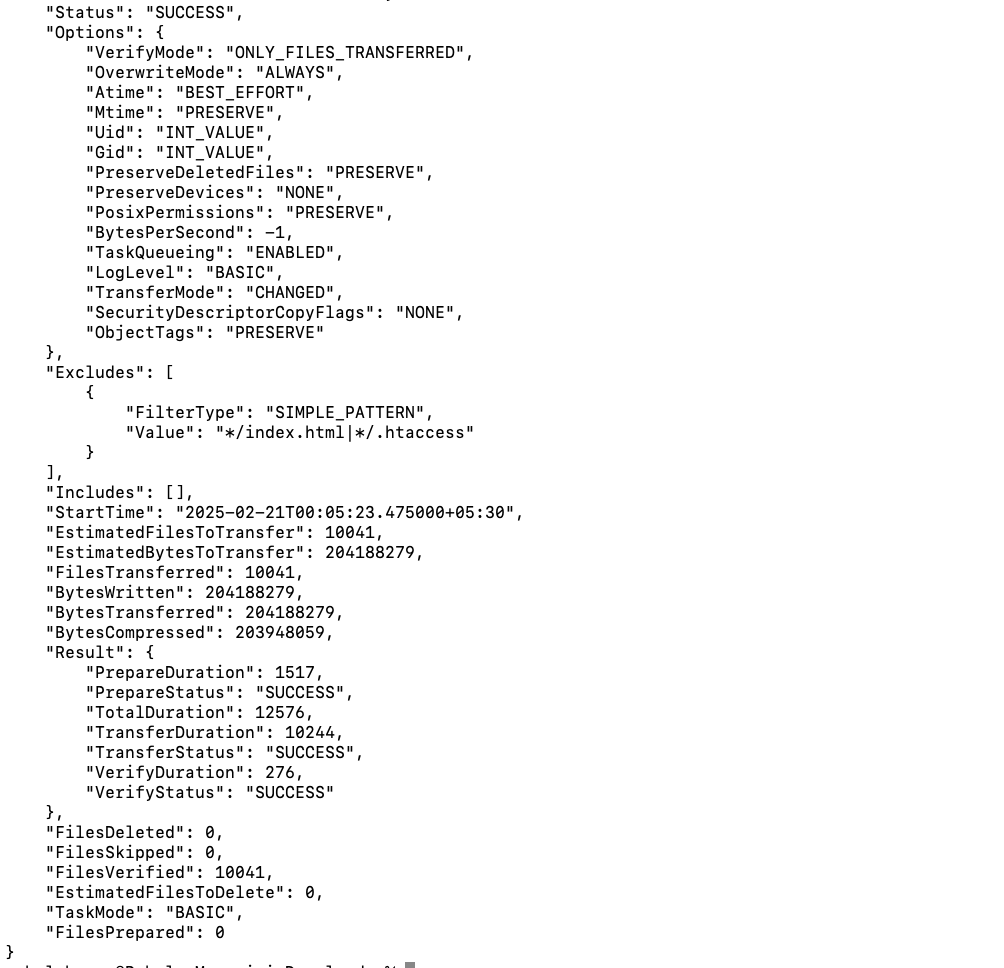

Du kannst die Details der Aufgabenausführung auch über die AWS CLI überprüfen:

- Erhalte die ARN der Aufgabenausführung:

aws datasync list-task-executions --region us-west-1 | grep exec-- Beschreibe die Ausführung der Aufgabe:

aws datasync describe-task-execution --region us-west-1 --task-execution-arn <task-execution-arn>

Abbildung 14 - Details zur Ausführung der AWS DataSync-Aufgabe

- Überprüfe die wichtigsten Leistungskennzahlen:

EstimatedFilesToTransfer,BytesTransferred, Übertragungsgeschwindigkeit und Dauer.

Laufende Datensynchronisation

In der Praxis werden auch nach der ersten Übertragung noch Dateien hinzugefügt und geändert. AWS DataSync unterstützt inkrementelle Übertragungen und stellt sicher, dass nur neue oder geänderte Dateien an das Ziel kopiert werden. In diesem Abschnitt werden wir Daten auf fs2 ändern, eine inkrementelle Übertragung durchführen und den Prozess mithilfe von Filtern optimieren.

Beginnen wir mit dem Ändern von Dateien auf fs2.

- Melde dich über SSH beim NFS-Server an:

ssh ec2-user@<NFS-Server-IP>- Erstelle eine neue Datei und aktualisiere die Manifestliste:

cd /mnt/fs2/d0001/dir0001

dd if=/dev/urandom of=newfile1 bs=1M count=1

echo "newfile1" >> manifest.lstDadurch wird eine neue Datei (newfile1) hinzugefügt und manifest.lst geändert.

Führe die Aufgabe dann erneut aus, um die Änderungen zu synchronisieren:

- Rufe die AWS DataSync-Konsole auf.

- Klicke auf Aufgaben → Test Aufgabe (zuvor erstellte Aufgabe).

- Klicke auf Start um eine neue Ausführung zu starten.

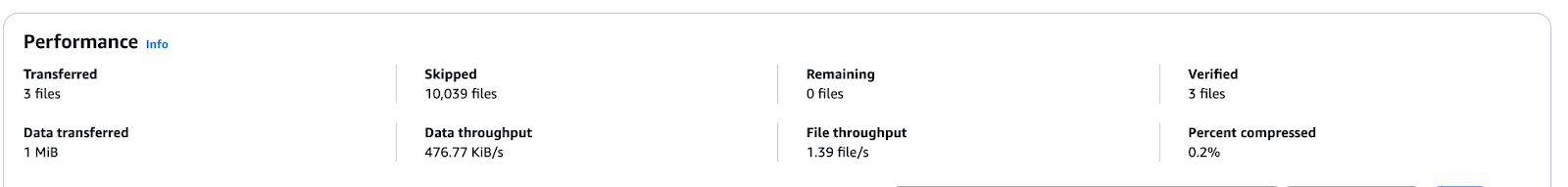

- Überwache die Fortschritte im Rahmen der Aufgabe Verlauf Registerkarte.

- Wenn du fertig bist, überprüfe:

- 3 Dateien übertragen (

newfile1, aktualisiertemanifest.lst, und Ordneraktualisierung). - 1 MiB an Daten in S3 kopiert.

Abbildung 15 - AWS DataSync-Leistungsmetriken für eine inkrementelle Übertragung

- Validiere die Übertragung in S3:

- Gehe zum S3-Bucket und bestätige das Vorhandensein von

newfile1. - Überprüfe

manifest.lstauf einen aktuellen Zeitstempel.

Automatisieren von DataSync-Übertragungen mit geplanten Aufgaben

In Umgebungen, in denen sich die Daten häufig ändern, sorgt die Planung regelmäßiger Synchronisierungen dafür, dass das Ziel mit minimalen manuellen Eingriffen auf dem neuesten Stand bleibt. Mit AWS DataSync kannst du Aufgaben in regelmäßigen Abständen (z. B. stündlich, täglich oder wöchentlich) konfigurieren und so den betrieblichen Aufwand reduzieren.

Wenn du einen wiederkehrenden Zeitplan einrichtest, erkennt DataSync automatisch neue und geänderte Dateien und überträgt sie, um die Bandbreitennutzung und die Übertragungseffizienz zu optimieren.

Um eine Aufgabe zu planen:

- Gehe zur AWS DataSync-Konsole und bearbeite eine bestehende Aufgabe.

- Im Zeitplan wählst du "Täglich", "Wöchentlich", etc.

- Gib die genaue Uhrzeit an (optional).

- Speichere die Einstellungen und DataSync wird die Aufgabe in den angegebenen Intervallen ausführen.

Bereinigung und Kostenoptimierung

Wenn deine Datenübertragung abgeschlossen ist, ist es wichtig, ungenutzte Ressourcen zu bereinigen, um unnötige Kosten zu vermeiden. Befolge diese Schritte:

- Stoppe und lösche DataSync-Aufgaben:

- Gehen Sie zur AWS DataSync-Konsole, wählen Sie die Aufgabe aus und wählen Sie Anhalten wenn sie gerade läuft.

- Klicke auf Aktionen → Löschen um erledigte Aufgaben zu entfernen.

- DataSync-Agenten löschen:

- Navigieren Sie zu Agenten in der DataSync-Konsole.

- Wählen Sie Agenten und klicken Sie auf Löschen um sie zu entfernen.

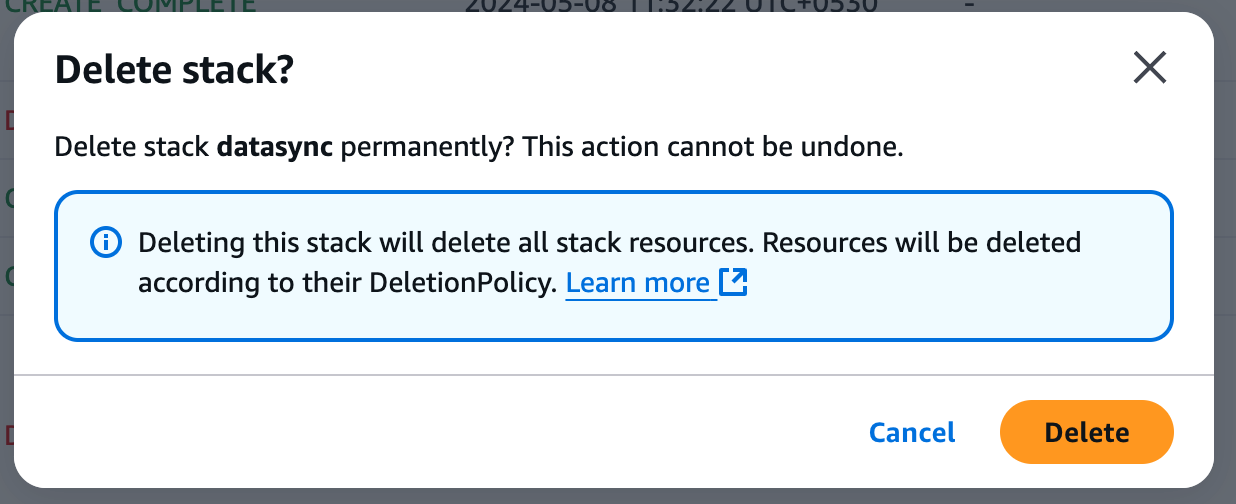

Den CloudFormation Stack löschen

- Öffne die AWS CloudFormation-Konsole.

- Wähle den CloudFormation Stack aus, der während des Tutorials erstellt wurde.

- Klicke auf Löschen (obere rechte Ecke).

Abbildung 15 - Bestätigung der Stack-Löschung in AWS

- Bestätige die Löschung - CloudFormation wird automatisch alle zugehörigen Ressourcen entfernen (dies kann bis zu 15 Minuten dauern).

- Überwache die CloudFormation-Konsole, um sicherzustellen, dass der Stack vollständig gelöscht ist.

Optimiere die AWS DataSync Kosten

Um die Kosten für die Datenübertragung zu minimieren, solltest du diese Best Practices beachten:

- Inkrementelle Übertragungen verwenden - Konfiguriere DataSync so, dass nur neue oder geänderte Dateien übertragen werden, um unnötige Datenbewegungen zu vermeiden.

- Optimiere die Übertragungshäufigkeit - Plane Aufgaben auf der Grundlage von Datenänderungsraten, anstatt kontinuierliche Synchronisierungen durchzuführen.

- Wähle kosteneffizienten Speicher - Speichere Daten, auf die nur selten zugegriffen wird, in Amazon S3 Glacier anstelle von Amazon EFS, das höhere Kosten verursacht.

Wenn du die Ressourcen richtig bereinigst und die Übertragungsstrategien optimierst, kannst du die AWS-Kosten deutlich senken und gleichzeitig eine effiziente Datensynchronisation gewährleisten.

Erweiterte AWS DataSync-Funktionen

Neben einfachen Übertragungen bietet AWS DataSync leistungsstarke Funktionen, die die Leistung, Kosteneffizienz und Sicherheit verbessern. In diesem Abschnitt werden wichtige fortgeschrittene Anwendungsfälle untersucht, darunter die Integration von S3 und die Migration von NFS zu EFS.

Verwendung von DataSync mit Amazon S3

AWS DataSync ist ein leistungsstarkes Tool zum Verschieben großer Datenmengen zu und von S3 und eignet sich ideal für Backup-, Archivierungs- und Cloud-Migrationsaufgaben. Es verbessert die Leistung durch mehrteilige Uploads, bei denen große Dateien in kleinere Teile aufgeteilt und dann parallel übertragen werden. Außerdem hilft die DataSync-Integration mit S3-Speicherklassen den Nutzern, Geld zu sparen, indem sie weniger aktive Daten zu S3 Glacier oder S3 Intelligent-Tiering migrieren.

In diesem Tutorial haben wir erklärt, wie du eine DataSync-Aufgabe konfigurierst, eine NFS-Quelle einrichtest und Dateien in einen S3-Bucket verschiebst und dabei unerwünschte Dateien ausschließt. Mit diesen Schritten kannst du große Datenumzüge mit geringen oder gar keinen betrieblichen Auswirkungen planen.

Umstellung von NFS auf Amazon EFS mit DataSync

Für Unternehmen, die lokale NFS-Freigaben zu Amazon EFS migrieren müssen, gibt es eine automatisierte, sichere und skalierbare Lösung - AWS DataSync. Das Problem ist, dass S3 ein Objektspeicher ist. Gleichzeitig ist Amazon EFS (Elastic File System) ein vollständig verwalteter Dateispeicherservice mit POSIX-Konformität, was ihn zu einer guten Wahl für Anwendungen macht, die einen gemeinsamen Zugriff und eine niedrige Latenzleistung benötigen.

Hier erfährst du, wie DataSync bei der Migration von NFS zu EFS hilft:

- Bewahrt Metadaten - Behält Dateiberechtigungen, Zeitstempel und Eigentümerschaft bei.

- Unterstützt inkrementelle Synchronisationen - Kopiert nur geänderte oder neue Dateien und reduziert so die Übertragungskosten.

- Automatisiert die Migration - Du brauchst keine manuellen Skripte oder komplexe Strategien zur Datenübertragung.

Obwohl diese Anleitung auf der Migration von NFS zu S3 basiert, können dieselben DataSync-Prinzipien auch bei der Migration zu Amazon EFS angewendet werden. Die Hauptvariante ist die Wahl von EFS als Ziel, damit die Datenbewegung für Anwendungen, die ein Dateisystem mit dynamischer Skalierung in AWS benötigen, gut ausgeführt wird.

Best Practices für die Verwendung von AWS DataSync

Um das Beste aus AWS DataSync herauszuholen, ist es wichtig, Best Practices zu befolgen, die Geschwindigkeit, Sicherheit und Kosteneffizienz verbessern. Dieser Abschnitt befasst sich mit den wichtigsten Strategien zur Optimierung von Datenübertragungen, zur Gewährleistung der Datensicherheit und zum effektiven Überwachungsmanagement.

Optimiere die Übertragungsgeschwindigkeit und die Kosten

Für groß angelegte Datenmigrationenist AWS Direct Connect (DX) eine dedizierte private Netzwerkverbindung, die das öffentliche Internet umgeht und schnellere, sicherere Übertragungen mit geringerer Latenz ermöglicht. Wenn DX nicht verfügbar ist, können andere Alternativen, wie VPN-Verbindungen oder VPC-Peering, die Übertragungsgeschwindigkeit erhöhen und gleichzeitig die Sicherheit aufrechterhalten.

Außerdem verfügt AWS DataSync über eine integrierte Komprimierung, die die über das Netzwerk übertragene Datenmenge verringert und so die Geschwindigkeit erhöht und die Bandbreitenkosten minimiert. Da die Komprimierung jedoch CPU-Ressourcen verbraucht, ist es wichtig, die Leistungsvorteile mit dem möglichen System-Overhead zu vergleichen.

Außerdem könnendie Aufgabenplanung und die Konfiguration optimiert werden, um die Leistung von DataSync weiter zu verbessern. Die Verlegung der Übertragungen in die Randzeiten vermeidet Netzwerkverkehr und garantiert die Verfügbarkeit der Bandbreite, vor allem wenn du große Dateien verschiebst. Die Feinabstimmung der Puffergröße und mehrerer paralleler Übertragungsströme auf der Grundlage der Netzwerk- und Speicherkapazität verbessert den Durchsatz drastisch.

Bei kleinen Dateiprozessen verkürzt eine Erhöhung des Parallelitätsgrads die Zeit für die Datenübertragung. Ein effektives Puffermanagement hingegen erhöht die Leistung und Zuverlässigkeit bei großen Dateien.

Datensicherheit gewährleisten

Alle Daten, die AWS DataSync überträgt, werden während der Übertragung über TLSverschlüsselt, um eine sichere Netzwerkübertragung zu gewährleisten. Die Verschlüsselung für Zielspeicherdienste, einschließlich Amazon S3, Amazon EFS und Amazon FSx, sollte ebenfalls aktiviert sein. Um das Schutzniveau bei der Nutzung von S3 zu erhöhen,aktiviert auch die serverseitige Verschlüsselung.

Befolge bei der Zuweisung von IAM-Rollen für DataSync-Aufgaben das Prinzip der geringsten Privilegien. Um Sicherheitsrisiken zu minimieren, erteile nur den DataSync-Agenten und den Rollen für die Aufgabenausführung die erforderlichen Berechtigungen. Verzichte auf Richtlinienschlüssel, die auf Tags basieren, und verwende stattdessen ressourcenbasierte Richtlinien, um unvorhergesehene Datenveränderungen zu vermeiden.

Für VPC-interne Datenübertragungen aktiviere die VPC-Endpunkte, damit sie am DataSync-Verkehr innerhalb des AWS-Netzwerks teilnehmen können, ohne das öffentliche Internet zu nutzen. Dies trägt dazu bei, Sicherheitsrisiken zu verringern und die Leistung beim Verschieben von Daten zwischen verschiedenen AWS-Diensten zu verbessern.

Der DataSync-Agent sollte sicher betrieben werden, indem neue Empfehlungen für die Sicherheit des Betriebssystems und die Netzwerksegmentierung befolgt werden. Außerdem sollte auf dem neuesten Stand sein und AWS-Sicherheitsgruppenrichtlinien sollten durchgesetzt werden, um unbefugten Zugriff zu verweigern.

Überwache und verwalte Transfers effektiv

Eine effektive Überwachung trägt dazu bei, dass die Datenübertragungen in AWS DataSync erfolgreich und optimiert sind. In diesem Lernpfad wurde auch gezeigt, wie man CloudWatch integriert, um die Ausführung von Aufgaben, Übertragungsgeschwindigkeiten, Fehlerraten und den Durchsatz in Echtzeit zu verfolgen. Die Überprüfung von Aufgabenprotokollen hilft dabei, Probleme zu erkennen, die Integrität von Dateien zu überprüfen und Fehler bei fehlgeschlagenen Übertragungen zu beheben.

Abbildung 16 - AWS DataSync CloudWatch Überwachungs-Dashboard mit Anzeige der übertragenen Dateien und Bytes

Außerdembenachrichtigt CloudWatchbei fehlgeschlagenen Übertragungen oder Leistungsproblemen, die vorzeitig auftreten und behandelt werden können, bevor sie zu einem größeren Problem werden.

Fehlersuche bei AWS DataSync

Auch wenn AWS DataSync die Datenübertragung automatisiert, können Verbindungsprobleme, Berechtigungsfehler oder Dateninkonsistenzen auftreten. In diesem Abschnitt findest du Lösungen für häufige Probleme, erfährst, wie du mithilfe von Protokollen Fehler beheben kannst, und erfährst, wie du eine reibungslose Datensynchronisierung sicherstellen kannst.

Häufige Fehler und wie man sie behebt

AWS DataSync-Benutzer können bei Übertragungen auf Zeitüberschreitungen, Berechtigungsprobleme oder Datenintegritätsfehler stoßen. Hier sind einige häufige Probleme und ihre Lösungen:

- Zeitüberschreitung bei Aufgaben oder langsame Übertragungen

- Ursache: Netzwerküberlastung, Bandbreitenbeschränkungen oder eine hohe Anzahl von Dateien.

- Lösung: Erhöhe die Bandbreitenzuweisung und plane Übertragungen außerhalb der Hauptverkehrszeiten.

- Fehler bei verweigerter Erlaubnis

- Ursache: IAM-Rollen oder NFS/SMB-Zugriffsbeschränkungen.

- Lösung: Vergewissere dich, dass die DataSync IAM-Rolle die richtigen Berechtigungen hat und dass die NFS-Export- oder SMB-Freigabeberechtigungen den Agentenzugriff erlauben.

- Probleme mit der Datenintegrität (beschädigte oder fehlende Dateien)

- Ursache: Unvollständige Übertragungen, Unterbrechungen oder Fehlkonfigurationen bei der Überprüfung.

- Lösung: Aktiviere den Datenüberprüfungsmodus in den Aufgabeneinstellungen, überprüfe die Protokolle auf übersprungene oder fehlgeschlagene Dateien und führe die Aufgabe bei Bedarf erneut aus.

- Fehler bei der Agentenverbindung

- Ursache: Falsche Netzwerkkonfiguration, Firewall-Blockaden oder falsche Aktivierung.

- Lösung: Stelle sicher, dass der Agent Internetzugang hat oder konfiguriere VPC-Endpunkte für eine private Verbindung. Falls erforderlich, registriere den Agenten erneut.

Fehlersuche mit Logs und CloudWatch

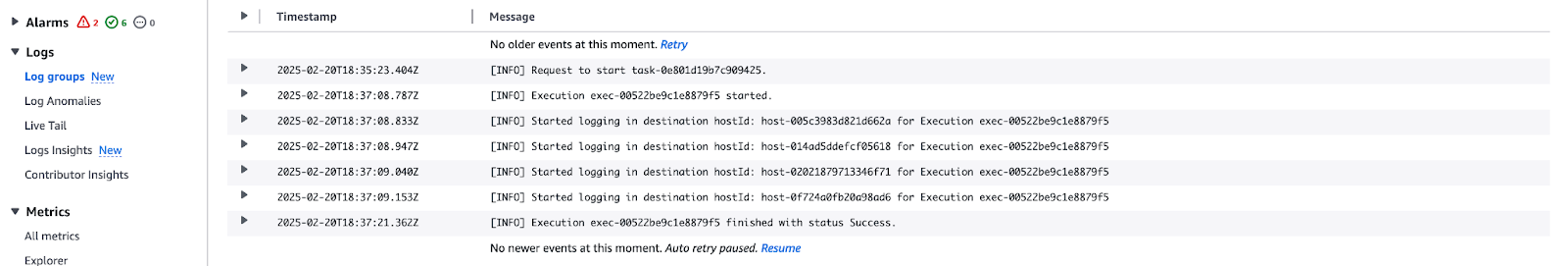

Um AWS DataSync-Aufgaben effektiv zu beheben, bieten Protokolle wertvolle Einblicke in fehlgeschlagene Übertragungen, übersprungene Dateien und Netzwerkfehler. Dieses Tutorial hat die CloudWatch-Integration zur Überwachung und Fehlersuche bei DataSync-Ausführungen gezeigt.

Hier erfährst du, wie du die DataSync-Aufgabenprotokolle überprüfen kannst:

- Navigieren Sie zu CloudWatch Logs → Öffne die Protokollgruppe, die mit der DataSync-Aufgabe verbunden ist.

- Achte auf Fehlermeldungen oder Übertragungsfehler, die mit Berechtigungsproblemen, Zeitüberschreitungen oder Netzwerkfehlern zusammenhängen.

Abbildung 17 - AWS CloudWatch-Protokollstrom für die Ausführung der DataSync-Aufgabe

Richte dann CloudWatch Alarme für Ausfälle ein:

- Gehe zu CloudWatch Metriken → Auswählen AWS/DataSync.

- Erstelle Alarme für hohe Ausfallraten, sinkende Übertragungsgeschwindigkeiten oder Probleme mit der Agentenverbindung.

Fazit

AWS DataSync vereinfacht die automatische, sichere und effiziente Datenübertragung zwischen lokalen Umgebungen und AWS-Speicherdiensten wie Amazon S3, EFS und FSx. Dieses Tutorial bietet einen praktischen Ansatz, um DataSync zu konfigurieren, NFS als Quelle einzurichten und Daten zu übertragen und dabei Sicherheit und Leistung zu gewährleisten.

Wir haben inkrementelle Übertragungen, Aufgabenplanung und CloudWatch-Überwachung untersucht, um DataSync hinsichtlich Kosten, Geschwindigkeit und Zuverlässigkeit zu optimieren. Außerdem helfen Schritte zur Fehlerbehebung und Techniken zur Protokollanalyse dabei, Übertragungsprobleme effektiv zu diagnostizieren und zu beheben.

Wenn du neu bei AWS bist oder dein Wissen über Cloud-Konzepte und -Services vertiefen möchtest, empfehle ich dir, diese Lernressourcen zu lesen:

- AWS-Konzepte

- AWS Cloud Technologie und Dienste

- AWS Sicherheit und Kostenmanagement

- AWS Cloud Practitioner (CLF-C02) Lernpfad

Diese Kurse sind eine gute Möglichkeit, Grundkenntnisse aufzubauen und sich auf reale Cloud-Szenarien mit AWS vorzubereiten!

Rahul Sharma ist ein AWS-Botschafter, DevOps-Architekt und technischer Blogger, der sich auf Cloud Computing, DevOps-Praktiken und Open-Source-Technologien spezialisiert hat. Mit seiner Expertise in AWS, Kubernetes und Terraform vereinfacht er komplexe Konzepte für Lernende und Fachleute durch ansprechende Artikel und Tutorials. Rahul liebt es, DevOps-Herausforderungen zu lösen und Erkenntnisse zu teilen, um die Tech-Community zu unterstützen.