Curso

Imagem criada pelo DALLE-3.

À medida que a IA se torna uma parte inseparável de nossa vida cotidiana, precisamos analisar mais profundamente seus possíveis riscos e desafios. Questões como preconceito, discriminação, violação de privacidadeou consequências não intencionais estão entre os obstáculos que precisamos superar.

Governança de IA surge como uma estrutura para enfrentar esses desafios.

O objetivo da governança de IA é garantir o desenvolvimento responsável e desenvolvimento ético, implantaçãoe uso ético das tecnologias de IA. Se implementado da maneira correta, isso orienta o cenário da IA em direção a uma ferramenta benéfica e impactante, acessível à sociedade.

O que é governança de IA?

A governança de IA refere-se às medidas e aos métodos sistemáticos criados para orientar e supervisionar o desenvolvimento e os aplicativos de IA. Ele garante que a IA esteja alinhada com os princípios éticos e os valores da sociedade. Isso inclui leis, regulamentosou quaisquer diretrizes que orientem tanto os criadores quanto os usuários de IA.

Para atingir esse objetivo, a governança da IA busca manter princípios como:

- Minimização de riscos: Evitar preconceitos e possíveis danos

- Equidade e transparência: Promovendo sistemas de IA compreensíveis

- Prestação de contas: Estabelecer a responsabilidade pelos resultados da IA

- Confiança pública: Como a sociedade vê as tecnologias de IA

Por que a IA justa é importante?

O desenvolvimento de aplicativos de IA é o produto de muitas funções e práticas. Na maioria das vezes, os aplicativos de IA são criados com base em dados. A coleta, o processamento e o manuseio de dados em si é um assunto delicado e sensível.

Enquanto isso, os produtos de IA são utilizados em vários campos e setores, potencialmente em escalas muito grandes. Por exemplo, ChatGPT é usado semanalmente por mais de 200 milhões de usuários ativos, de acordo com a DemandSage.

Considerando o grande número de pessoas envolvidas no desenvolvimento de soluções baseadas em IA e o amplo alcance de seus usuários, é possível avaliar a complexidade e a complexidade da IA. Há vários problemas potenciais que podem surgir.

Para ter uma perspectiva, imagine-se se candidatando a um emprego em que o processo de contratação depende de um sistema de IA que avalia se você é um candidato adequado. Esse sistema analisa os candidatos com base em seu currículo e perfil e filtra aqueles que não são considerados adequados para a posição.

No entanto, se esse sistema de IA tiver preconceitos ou falhas inerentes em seu algoritmo, ele poderá discriminar injustamente determinados grupos de pessoas com base em fatores como idade, gênero ou etnia. Se esse sistema de IA fosse amplamente utilizado pelas empresas, as consequências seriam significativas.

Esse cenário ilustra por que a imparcialidade da IA é crucial - para garantir a imparcialidade, a transparência e a responsabilidade nos sistemas de IA que podem afetar significativamente a vida das pessoas.

Surpreendentemente, essas discriminações também não são raras em humanos. Pesquisadores descobriram que existe discriminação ilegal sistemática com base no nome das pessoas no processo de candidatura a empregos. Os nomes de minorias étnicas, mesmo quando têm os mesmos currículos que outros candidatos, enfrentam menos sucesso em suas candidaturas.

Portanto, se as contrapartes humanas de um sistema de IA podem cair em tais armadilhas, isso significa que usar a IA para um processo de tomada de decisão imparcial é desafiador, mas também proveitoso.

Governança de IA: Princípios e estruturas fundamentais

A governança eficaz da IA se baseia no pilar dos valores sociais e humanos. Princípios que orientam os especialistas na avaliação do alinhamento de seus sistemas. Esses princípios incluem:

- Transparência: Os sistemas de IA devem ser claros, fornecendo informações claras sobre seus mecanismos, coleta de dados e algoritmos de tomada de decisão.

- Equidade: Garantir tratamento e previsões imparciais, identificando e atenuando vieses no desenvolvimento e na implantação de sistemas de IA.

- Prestação de contas: Estabelecer responsabilidades claras para os sistemas de IA, incluindo protocolos para quando ocorrerem danos.

- Design centrado no ser humano: Priorizar os valores humanos e o bem-estar acima de tudo.

- Privacidade: Respeitar os direitos de privacidade individual com medidas robustas de proteção de dados.

- Segurança e proteção: Foco na segurança do usuário e do sistema segurança contra consequências maliciosas e não intencionais.

Estruturas líderes de governança de IA

Várias organizações desenvolveram estruturas para orientar as práticas de governança de IA. Alguns dos mais notáveis incluem:

- Estrutura de gerenciamento de riscos de IA do NIST: Desenvolvido pelos EUA. Instituto Nacional de Padrões e Tecnologia, o NIST oferece uma abordagem para reconhecer, avaliar e controlar os riscos associados dos sistemas de IA em seu ciclo de vida.

- Princípios de IA da OCDE: A Organização para Cooperação e Desenvolvimento Econômico (OECD) estabeleceu um conjunto de princípios para uma inteligência artificial confiável. Esses princípios priorizam os valores centrados no ser humano, a justiça, a transparência, a robustez e a responsabilidade.

- Design Eticamente Alinhado do IEEE: O Instituto de Engenheiros Elétricos e Eletrônicos (IEEE) desenvolveu uma estrutura que fornece diretrizes para o projeto e a implementação éticos de sistemas autônomos e inteligentes.

- Diretrizes éticas da UE para uma IA confiável: A União Europeia forneceu diretrizes para robustez técnica, privacidade, transparência, diversidade, não discriminação, bem-estar social e responsabilidade.

- Estruturas específicas do setor: Vários setores desenvolveram suas estruturas de governança de IA personalizadas para suas necessidades e obstáculos específicos. Por exemplo:

- Cuidados com a saúde: A orientação da OMS sobre ética e governança da IA para a área da saúde

- Finanças: Princípios FEAT da Autoridade Monetária de Cingapura (imparcialidade, ética, responsabilidade e transparência)

- Automotivo: A estrutura Safety First for Automated Driving (Segurança em primeiro lugar para direção automatizada)

Essas estruturas fornecem uma proteção valiosa para as organizações que desejam implementar práticas de governança de IA, incluindo princípios de alto nível e recomendações práticas.

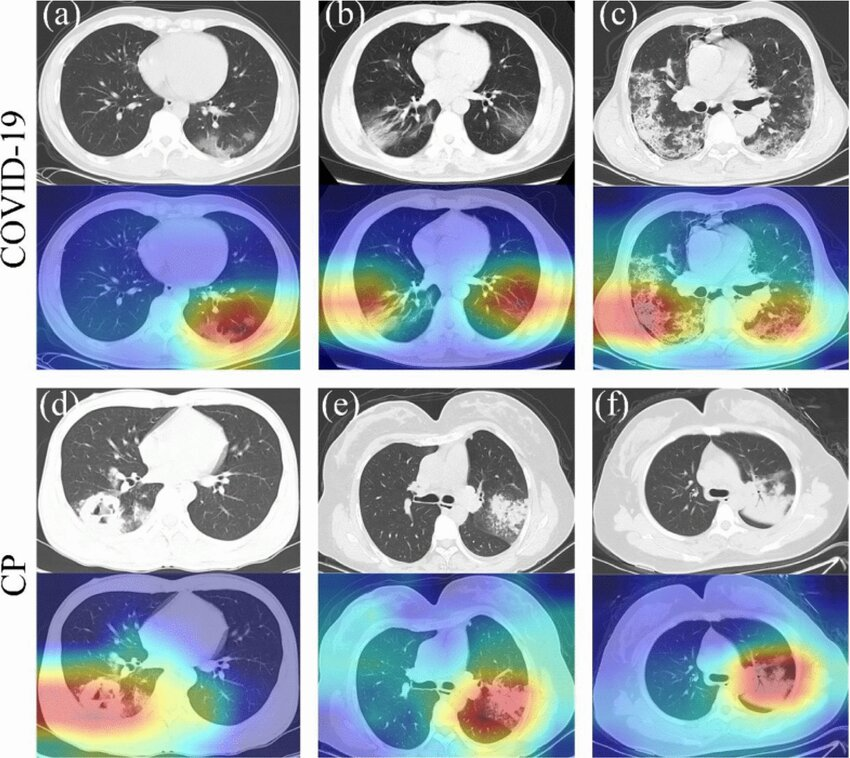

A IA tem aplicações em muitos campos, incluindo saúde. A interpretabilidade e a transparência são duas propriedades importantes desses sistemas. A imagem abaixo é um exemplo de um sistema de IA que reconhece infecções por COVID-19:

Fonte: Peng et al., 2022

Práticas recomendadas para implementar a governança de IA

Colocar a governança de IA em prática envolve a adoção de uma abordagem holística que exige a colaboração de várias partes interessadas e vários aspectos de uma organização. Aqui estão algumas práticas recomendadas para você colocar a governança de IA em ação:

Liderança e compromisso cultural

A liderança e o compromisso cultural são essenciais. Os líderes devem apoiar e defender ativamente os padrões éticos no desenvolvimento de IA, garantindo que esses princípios sejam usados em toda a organização.

Isso envolve a criação e a manutenção de diretrizes claras e bem documentadas para cada fase do gerenciamento do sistema de IA, incluindo desenvolvimento, teste, implementação e monitoramento, para garantir que as considerações éticas sejam integradas ao ciclo de vida da IA.

Treinamento e educação

O treinamento e a educação contínuos são igualmente importantes. Toda a equipe relevante deve receber treinamento regular focado na ética e na justiça da IA para se manter atualizada sobre as melhores práticas e os desafios emergentes.

A liderança também deve ser instruída sobre o impacto e a importância das tecnologias de IA. Para os desenvolvedores de IA, o treinamento especializado adaptado às suas funções e projetos específicos garante que eles tenham o conhecimento necessário para o desenvolvimento e a implementação responsáveis.

Monitoramento de sistemas de IA

Não posso exagerar a importância de você monitoramento dos sistemas de IA. Implemente sistemas de monitoramento contínuo para monitorar o desempenho e as previsões da IA. Isso ajuda a identificar e corrigir prontamente quaisquer vieses ou consequências não intencionais.

A avaliação regular garante que os sistemas de IA operem conforme o esperado e atendam aos padrões exigidos.

Documentação

Uma documentação completa é essencial para a transparência e a responsabilidade no desenvolvimento da IA. Mantenha registros detalhados de cada etapa do processo de desenvolvimento de IA, incluindo fontes de dados, arquiteturas de modelos e métricas de desempenho.

Estabelecer uma estrutura para a tomada de decisões éticas, seja por meio de políticas internas ou de padrões externos reconhecidos, para apoiar práticas claras e responsáveis em todo o ciclo de vida da IA.

Envolvimento com as partes interessadas

O envolvimento com as partes interessadas é importante para alinhar os sistemas de IA às diversas necessidades e valores. Comunique-se ativamente com usuários, comunidades e especialistas para garantir que os projetos e valores do sistema de IA sejam bem compreendidos e atendam às necessidades de todos os envolvidos.

A valorização de diversas perspectivas ajuda a evitar danos não intencionais e garante que os sistemas de IA sejam inclusivos e equitativos.

Melhoria contínua

O aprimoramento contínuo é fundamental para manter altos padrões no desenvolvimento de IA. Definir e rastrear métricas relacionadas à ética e à parcialidade para avaliar o desempenho do sistema de IA e fazer melhorias iterativas com base nesses dados.

Solicite e incorpore o feedback dos usuários e das partes interessadas para garantir que os sistemas de IA estejam alinhados com os padrões éticos.

Ferramentas e tecnologias para governança de IA

À medida que a governança de IA evolui, um ecossistema crescente de ferramentas e tecnologias está sendo criado para apoiar as organizações na implementação das práticas corretas de governança. Essas ferramentas visam vários aspectos da governança de IA, desde a detecção de vieses até a explicabilidade e gerenciamento de riscos.

- Detecção e atenuação de vieses:

- IBM AI Fairness 360: Um kit de ferramentas de código aberto que "pode ajudar a examinar, relatar e mitigar a discriminação e o preconceito em modelos de machine learning durante todo o ciclo de vida do aplicativo de IA".

- Aequitas: Um kit de ferramentas de avaliação de parcialidade e justiça de código aberto para desenvolvedores de ML e analistas de dados.

- Explicabilidade e interpretabilidade:

- LIME (Local Interpretable Model-agnostic Explanations): Uma técnica que explica as previsões de qualquer modelo de machine learning de caixa preta.

- SHAP (SHapley Additive exPlanations): Uma abordagem de teoria dos jogos para explicar o resultado de qualquer modelo de machine learning, analisando a importância de cada recurso e a relação entre eles.

- Avaliação e gerenciamento de riscos:

- Navegador da estrutura de gerenciamento de riscos de IA: Outra ferramenta desenvolvida pelo NIST para ajudar as organizações a identificar e mitigar os riscos relacionados à implantação e à operação de sistemas de IA

- Privacidade:

- OpenMined: Um projeto de código aberto para criar sistemas de machine learning A privacidade é mais crucial do que nunca

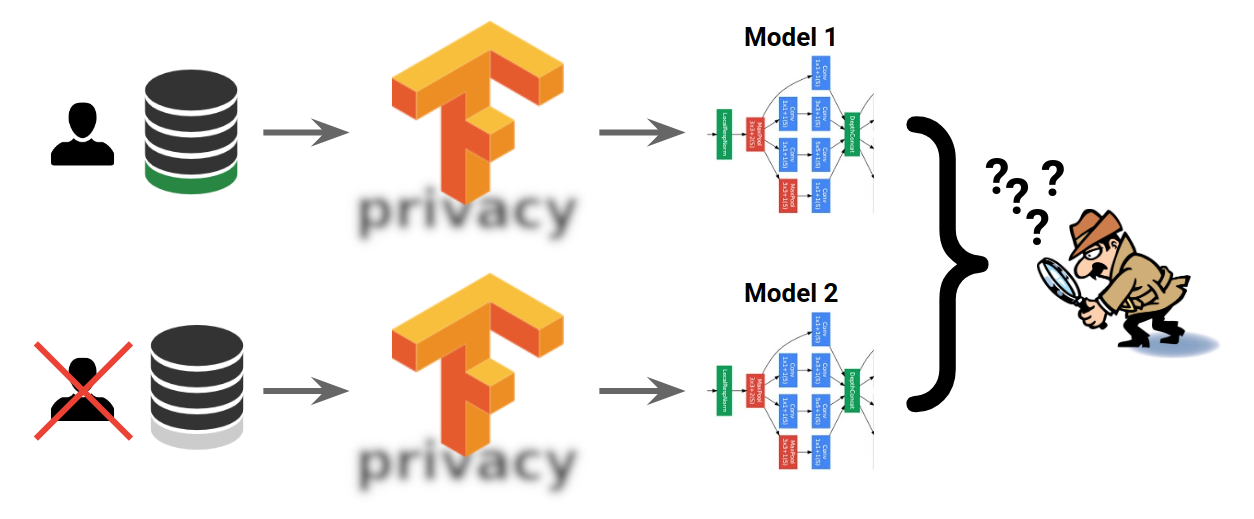

- Privacidade do TensorFlow: Uma biblioteca para treinar modelos de machine learning com privacidade para dados de treinamento

- Documentação do modelo:

- Cartões de modelo: Uma estrutura da HuggingFace para relatórios transparentes de informações de modelos de IA

- Fichas técnicas: A abordagem da IBM para aumentar a confiança e a transparência na IA

Privacidade do TensorFlow. (Fonte: TensorFlow)

Essas ferramentas e tecnologias ajudam a garantir que os sistemas de IA sejam gerenciados e mantidos de forma responsável. Diferentes departamentos e funções em uma organização têm suas próprias ferramentas e critérios em relação à governança de IA. No entanto, é importante observar que as ferramentas por si só não são suficientes. Para serem eficazes, elas devem ser acompanhadas de processos e supervisão robustos.

Estudos de caso: IA responsável da Microsoft

Várias empresas adotaram medidas práticas para implementar a governança de IA. Um exemplo disso é o Programa de IA Responsável da Microsoft. A Microsoft é líder na IA atual, mas já teve seu quinhão de projetos de IA fracassados - principalmente o Tay.

Lançada originalmente pela Microsoft em 2016, Tay era um chatbot que deveria aprender e interagir no Twitter. Devido à falta de medidas de segurança, em apenas 24 horas, os usuários do Twitter ensinaram Tay a se tornar fascista, ofensiva e racista. Tay estava aprendendo com eles sem nenhuma proteção sobre o que aprender e o que evitar. Tay acabou sendo fechada, mas isso se tornou uma lição valiosa.

A Microsoft surgiu no desenvolvimento e na implementação de práticas de governança de IA por meio de seu programa de IA responsável. Um dos aspectos notáveis do programa Responsible AI da Microsoft é sua estrutura operacional. A empresa estabeleceu um comitê de ética de IA, conhecido como Comitê Aether (AI, Ethics, and Effects in Engineering and Research), que analisa os projetos de IA quanto a possíveis preocupações éticas. Esse comitê é uma reunião de especialistas de várias áreas para analisar os impactos das tecnologias de IA na sociedade e fornecer orientações.

Além disso, a Microsoft desenvolveu e lançou várias ferramentas e estruturas para ajudar os desenvolvedores a implementar práticas de IA responsáveis em seu trabalho diário. A caixa de ferramentas de Caixa de ferramentas de IA responsável é um exemplo que ajuda a avaliar e melhorar a imparcialidade dos sistemas de IA.

O cenário regulatório e de políticas

Os regulamentos e a governança, embora sejam diferentes em termos de definição, têm efeito um sobre o outro. Os governos e as organizações reguladoras de todo o mundo estão desenvolvendo novas políticas e regulamentações para reger o desenvolvimento e o uso da IA. Compreender esse cenário em evolução é necessário para as organizações que estão implementando práticas de governança de IA em seu fluxo de trabalho.

Imagem criada pelo DALLE-3.

A Lei de IA da UE

Um dos desenvolvimentos mais significativos na regulamentação de IA é a Lei de Inteligência Artificial da União Europeia (Lei de IA da UE). As principais conclusões dessa lei incluem:

- Abordagem baseada em riscos: Os sistemas de IA são categorizados com base em seu nível de risco, com requisitos diferentes para cada categoria.

- Práticas de IA proibidas: Certos aplicativos de IA, como a pontuação social do governo, são proibidos.

- Sistemas de IA de alto risco: Requisitos rigorosos são definidos para sistemas de IA usados em áreas críticas, como saúde, educação e aplicação da lei.

- Requisitos de transparência: Obrigações de informar aos usuários quando e de que forma eles estão interagindo com sistemas de IA.

Outras regulamentações emergentes

Embora a Lei de IA da UE seja talvez a regulamentação de IA mais abrangente até o momento, outros órgãos também estão desenvolvendo suas próprias abordagens.

O Canadá propôs a Lei de Inteligência Artificial e Dados (AIDA) como parte de uma reforma mais ampla da privacidade, enquanto o projeto de lei de segurança de IA da Califórnia, SB 1047, está a caminho de se tornar lei até a data de redação deste artigo.

Implicações para as empresas

O cenário regulatório em evolução tem grandes implicações para as organizações que desenvolvem sistemas de IA:

- Requisitos de conformidade: As organizações precisarão garantir que seus sistemas de IA cumpram os regulamentos. Esses regulamentos podem estar em contraste com suas práticas atuais, exigindo mudanças significativas em seus procedimentos de desenvolvimento e implantação.

- Documentação e transparência: Maior ênfase na documentação dos processos de desenvolvimento de IA e no fornecimento de explicações para as decisões baseadas em IA. É claro que a extensão desse requisito de transparência varia de acordo com a lei.

- Gerenciamento de riscos: Necessidade de uma avaliação de risco robusta, especialmente para sistemas de IA que podem ser classificados como de "alto risco".

- Considerações globais: As organizações que operam em várias jurisdições precisarão lidar com requisitos regulatórios potencialmente conflitantes.

- Considerações éticas: Muitos regulamentos incorporam princípios éticos, exigindo que as organizações considerem mais explicitamente as implicações éticas de seus sistemas de IA.

Se a sua organização ou equipe está ou não sujeita a essas leis, é uma questão de jurisdição, do tipo de produto que você cria e do nível de risco associado ao produto.

O debate sobre as regulamentações de IA: Prós e contras

As regulamentações são um dos tópicos mais debatidos em IA. Embora a maioria da comunidade de IA concorde que "algum" tipo de regulamentação é benéfico, ninguém parece concordar com a natureza, a extensão e quem deve se encarregar dessas leis.

A complexidade dessa questão levou a discussões acaloradas entre o setor, a academia, o governo e a sociedade civil, cada um debatendo os possíveis benefícios e desvantagens das estruturas regulatórias. Compreender esses argumentos é necessário para desenvolver uma perspectiva correta e imparcial.

Imagem gerada pelo DALLE-3 do Cilindro de Ciro-Considerada por alguns estudiosos como uma das primeiras declarações de direitos humanos

Argumentos a favor das regulamentações de IA

Os defensores das regulamentações de IA argumentam que essas diretrizes são essenciais para proteger o público e que regulamentações bem elaboradas podem manter os possíveis danos da IA sob controle. Violações de privacidade, preconceito e deslocamento de emprego são alguns desses possíveis danos. Eles acreditam que um conjunto de leis e padrões claros pode evitar um "race to the bottom" em termos de ética. Além disso, esses padrões podem desempenhar um papel fundamental na construção da confiança pública nas tecnologias de IA.

Outro argumento a favor das regulamentações é o amplo impacto social da IA. Como essas tecnologias influenciam cada vez mais áreas como emprego, interações sociais e processos democráticos, os defensores argumentam que a supervisão regulatória é necessária para garantir que esses impactos sejam levados em conta e gerenciados de forma responsável.

Argumentos contra as regulamentações de IA

Os críticos das regulamentações de IA levantam várias preocupações sobre seus impactos negativos. Um dos principais argumentos contra regulamentações rígidas é o medo de que elas possam acabar prejudicando a inovação. Eles temem que regras excessivamente restritivas possam desacelerar a IA, o que poderia frear os avanços benéficos em áreas como saúde, mudanças climáticas e pesquisa científica, e a natureza acelerada do desenvolvimento da IA significa que as regulamentações podem ficar desatualizadas rapidamente, tornando-se irrelevantes ou até mesmo contraproducentes.

Outra preocupação importante são os desafios de conformidade para empresas menores e startups. O custo, a mão de obra e a complexidade do cumprimento de regulamentações abrangentes podem ser opressivos para essas entidades, reduzindo a concorrência e a inovação no setor de IA. Como resultado, isso pode levar ao monopólio do desenvolvimento de IA entre algumas grandes empresas de tecnologia que possuem recursos adequados para lidar com esses complexos cenários regulatórios.

Muitos especialistas em IA questionam se a regulamentação da IA no nível da tecnologia, e não no nível do aplicativo, é a abordagem correta. Eles argumentam que, assim como outras tecnologias, como a eletricidade e a Internet, a IA não é inerentemente maliciosa. A forma como você usa essas tecnologias pode ser mal-intencionada ou construtiva. A segurança da IA é propriedade dos aplicativos, e não da tecnologia em si, conforme apontado neste artigo.

Responsabilidade do desenvolvedor

Também é importante observar que os valores que constituem os sistemas de IA como seguros, como justiça, parcialidade ou transparência, embora tenham raízes na sociedade e em preocupações éticas, também são uma questão técnica.

É fundamental reconhecer que os modelos de IA tendenciosos também são tecnicamente falhos. Um modelo que apresenta viés, por definição, não está representando ou processando com precisão todo o espectro de dados com o qual deve lidar.

Essa deficiência técnica pode levar a um desempenho reduzido, previsões imprecisas e resultados não confiáveis. Desse ponto de vista, abordar a parcialidade e promover a justiça nos modelos de IA não é apenas uma preocupação ética, mas um desafio técnico fundamental que afeta diretamente a qualidade dos sistemas de IA que criamos.

Esses valores devem ser respeitados e incutidos nos sistemas de IA pelos desenvolvedores que os criam, mesmo sem a exigência de leis ou padrões regulatórios. Os pesquisadores e desenvolvedores que trabalham na mitigação da imparcialidade e do preconceito geralmente estão envolvidos em um trabalho profundamente técnico.

Considere um sistema de sistema de IA desenvolvido para auxiliar os funcionários do banco na avaliação de solicitações de empréstimo. Se, devido a preconceitos históricos nas práticas de empréstimo, os dados de treinamento refletirem um padrão em que determinados grupos raciais tiveram empréstimos negados de forma desproporcional ou ofereceram termos menos favoráveis, o sistema de IA aprenderá a associar a raça às pontuações dos candidatos, então esse sistema é "tecnicamente ruim" antes de ser "eticamente inaceitável". Esse exemplo mostra que abordar a parcialidade nos sistemas de IA não é apenas um incentivo ético, mas também uma necessidade técnica.

As organizações e os indivíduos podem usar a transparência e a documentação em todo o ciclo de vida do desenvolvimento da IA para abordar as preocupações e a confiança do público. Essa "transparência algorítmica" inclui a comunicação clara da finalidade de um modelo, das fontes de dados, da metodologia ou das possíveis limitações do sistema. Como desenvolvedor, você pode ser claro e transparente comunicando o seguinte:

- Processo de treinamento do modelo

- Detalhes sobre o conjunto de dados usado

- Quaisquer etapas de pré-processamento de dados

- O algoritmo escolhido

Essa transparência não apenas ajuda a identificar e corrigir falhas técnicas, mas também demonstra um compromisso com o desenvolvimento ético da IA, aumentando assim a confiança do público na tecnologia.

Conclusão

Este artigo explorou a natureza da governança da IA, as considerações éticas, as estruturas regulatórias e as implementações técnicas. A importância da governança da IA está em seu potencial para identificar riscos antes que eles causem problemas, ganhar a confiança do público e direcionar o poder da IA para o benefício e o bem da sociedade.

Também examinamos vários aspectos da governança de IA, incluindo as ferramentas e tecnologias disponíveis, iniciativas corporativas e o cenário regulatório em evolução. Também analisamos o debate em andamento sobre as regulamentações de IA, apresentando argumentos a favor e contra essa supervisão.

No final, a responsabilidade pelo desenvolvimento ético e responsável da IA recai não apenas sobre os órgãos reguladores, mas também sobre as empresas e os indivíduos que criam essas tecnologias. Como vimos, abordar questões como parcialidade e justiça nos sistemas de IA não é apenas uma preocupação ética, mas uma necessidade técnica.