programa

Apache Airflow 3.0 por fin está aquí, y es sin duda la versión más importante de la historia del proyecto.

Esta versión cambiará tu forma de pensar sobre la gestión de flujos de trabajo, tanto si eres nuevo en el mundo de los datos como si llevas años trabajando con Airflow.

Tras explorar la nueva versión de primera mano, puedo afirmar con seguridad que es mucho más que una simple actualización incremental.

Algunos de los aspectos más destacados son:

- Una nueva arquitectura orientada a servicios con ejecución remota completa

- Nueva interfaz de usuario basada en React construida sobre FastAPI

- Versionado DAG y seguimiento de cambios

- Activación DAG basada en activos y eventos

- Compatibilidad nativa con los modernos flujos de trabajo de ML

- Vías de actualización claras y división modular de la CLI

Esta guía te guiará a través de Airflow 3.0 y todo lo que puede ofrecerte.

¿Qué es el flujo de aire apache?

Apache Airflow es una plataforma de código abierto que ayuda a los usuarios a crear, programar y supervisar flujos de trabajo de datos mediante programación.

Ha sido el orquestador de referencia para canalizaciones ETL complejas, flujos de trabajo de ingeniería de datos y, más recientemente, canalizaciones de aprendizaje automático.

El concepto fundacional de Airflow es el DAG (un grafo acíclico dirigido que define una secuencia de tareas y sus dependencias).

Las tareas pueden ir desde scripts Python a transformaciones SQL e incluso operaciones en contenedores cuando se trata de utilizar Airflow.

La plataforma es flexible, ampliable y ahora, con la 3.0, más preparada para el futuro que nunca.

Si estás empezando con Airflow, la Introducción a Apache Airflow en Python es un gran recurso que proporciona experiencia práctica.

Breve historia del flujo de aire apache

Airflow fue desarrollado inicialmente por Airbnb en 2014 y de código abierto en 2015.

Más tarde se convirtió en un proyecto Apache y desde entonces se ha convertido en una de las herramientas de orquestación más ampliamente adoptadas en el ecosistema de la ingeniería de datos.

- Flujo de aire 1.x: Introdujo los fundamentos de la creación de DAG, programador y ejecutor basados en Python.

- Flujo de aire 2.0 (2020): Una versión que añadió la API TaskFlow, la API REST y el programador de alta disponibilidad.

- Flujo de aire 2,3-2,5: Introdujo conjuntos de datos, programación consciente de los datos y mejoras en la observabilidad.

- Flujo de aire 3.0 (2025): Marca un rediseño fundamental, que prioriza la modularidad, las capacidades nativas de ML y el soporte nativo de la nube.

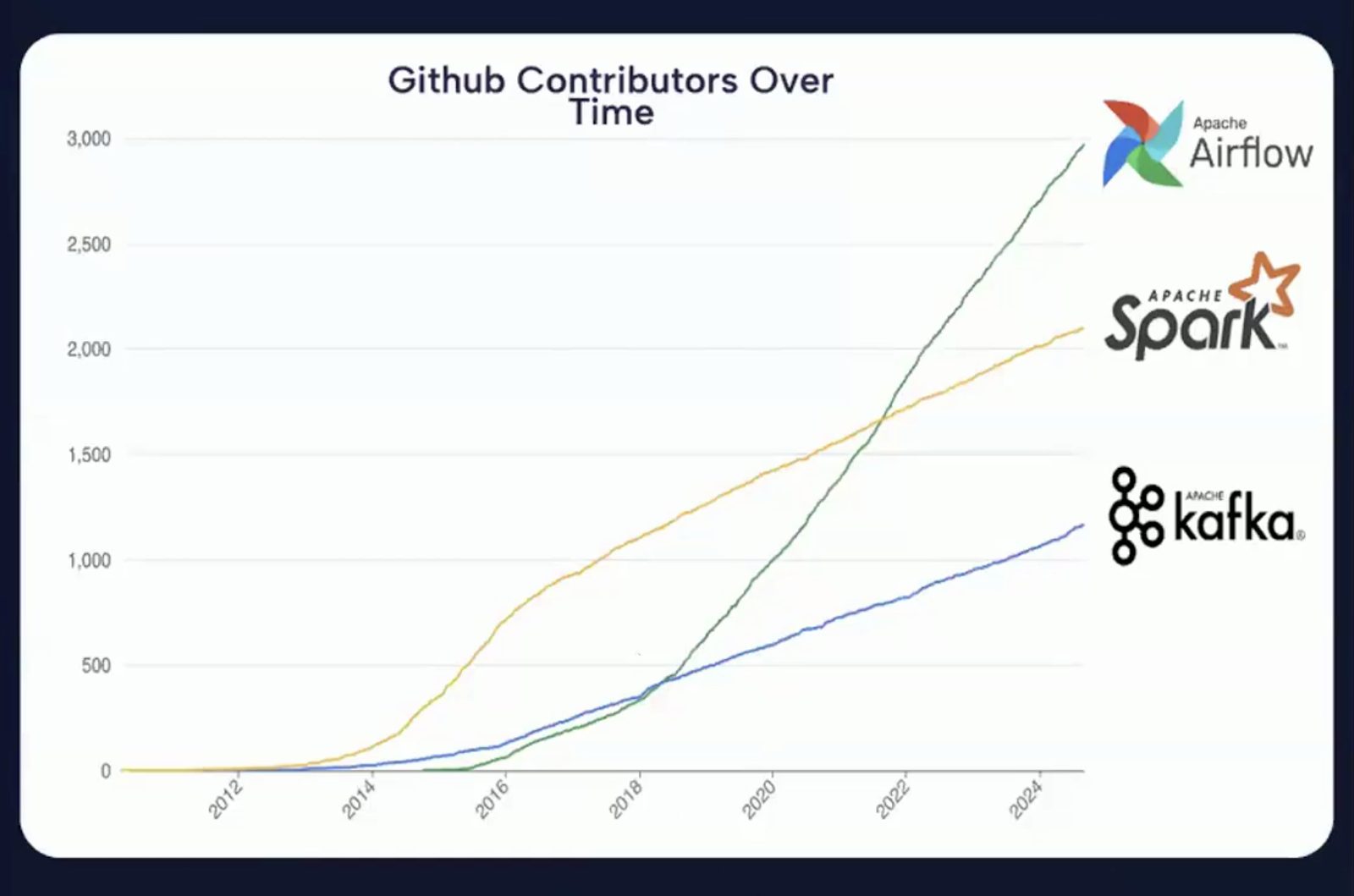

En la siguiente imagen se ve claramente que las contribuciones a GitHub han aumentado significativamente año tras año, lo que demuestra que Apache Airflow es uno de los proyectos de código abierto más activos en el espacio de la orquestación de datos.

Gráfico que muestra el número creciente de contribuciones de GitHub a Apache Airflow a lo largo de los años. Fuente: Vídeo de introducción al flujo de aire 3.0

¿Qué hay de nuevo en Apache Airflow 3.0?

Apache Airflow 3.0 es una versión basada en tres temas fundamentales.

Captura de pantalla de la página de lanzamiento de Apache Airflow 3.0. Fuente: Flujo de aire Apache

Estos temas reflejan la visión del proyecto para satisfacer las demandas de las plataformas de datos modernas, mejorar la experiencia de los desarrolladores y reforzar la posición de Airflow como orquestador central en entornos distribuidos, híbridos y potenciados por ML.

Los temas clave pueden clasificarse a grandes rasgos como sigue:

Imagen que resume los tres temas centrales de Apache Airflow 3.0. Imagen creada con Napkin AI

Más fácil de usar

Uno de los objetivos más significativos de la versión 3.0 es mejorar la usabilidad en todos los ámbitos, desde la línea de comandos hasta la interfaz de usuario y las interacciones subyacentes de la API.

Ahora Airflow es más fácil de aprender, más agradable de usar a diario y está mejor equipado para dar soporte a requisitos operativos complejos.

Mayor seguridad

La seguridad se ha convertido en una preocupación central de la ingeniería de datos, especialmente como resultado de las crecientes normativas sobre privacidad y la escala de la infraestructura de datos.

Airflow 3.0 aborda estas preocupaciones con un soporte arquitectónico más profundo para el aislamiento de tareas y el control de la ejecución.

Las mejoras de seguridad de Airflow 3.0 son tanto proactivas como estratégicas, lo que se ajusta a las necesidades de las implantaciones empresariales, los sectores altamente regulados y las prácticas DevSecOps modernas.

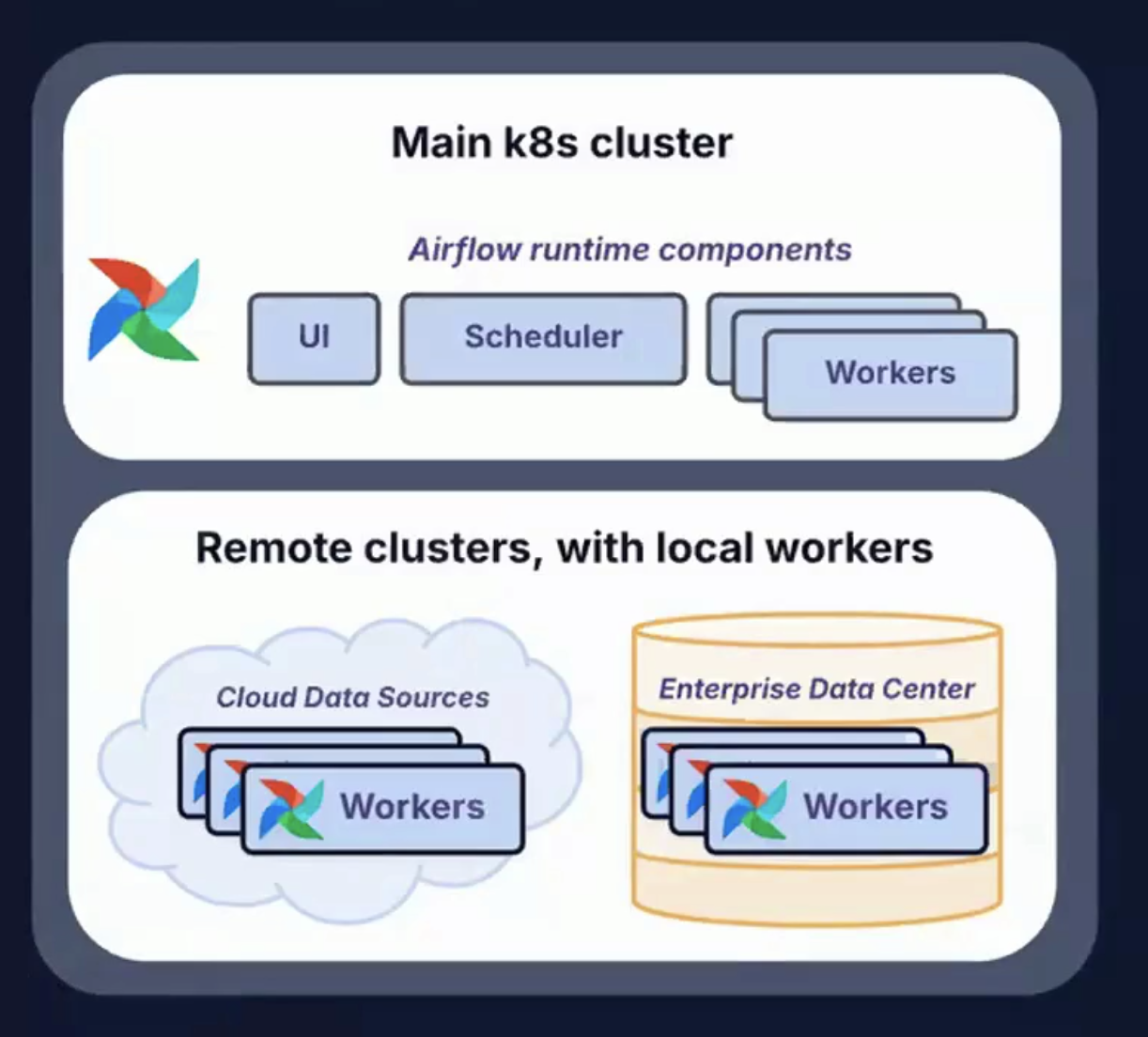

Corre donde quieras y cuando quieras

La pila de datos moderna ya no se limita a los centros de datos locales, ni siquiera a los entornos centralizados en la nube.

Airflow 3.0 responde a este reto con soporte para diversas topologías de despliegue y patrones de ejecución.

Permitir que las tareas se ejecuten en cualquier lugar (y admitir flujos de trabajo que se ejecuten en cualquier momento) proporciona una flexibilidad, resistencia y escalabilidad inigualables para orquestar el moderno ciclo de vida de los datos.

Imagen que muestra clusters remotos con trabajadores locales, utilizados para funcionar en cualquier lugar y en cualquier momento. Fuente: Vídeo de introducción al Astrónomo Airflow 3.0

El resto de esta guía tratará con más detalle aspectos del tema clave del Flujo de Aire 3.0.

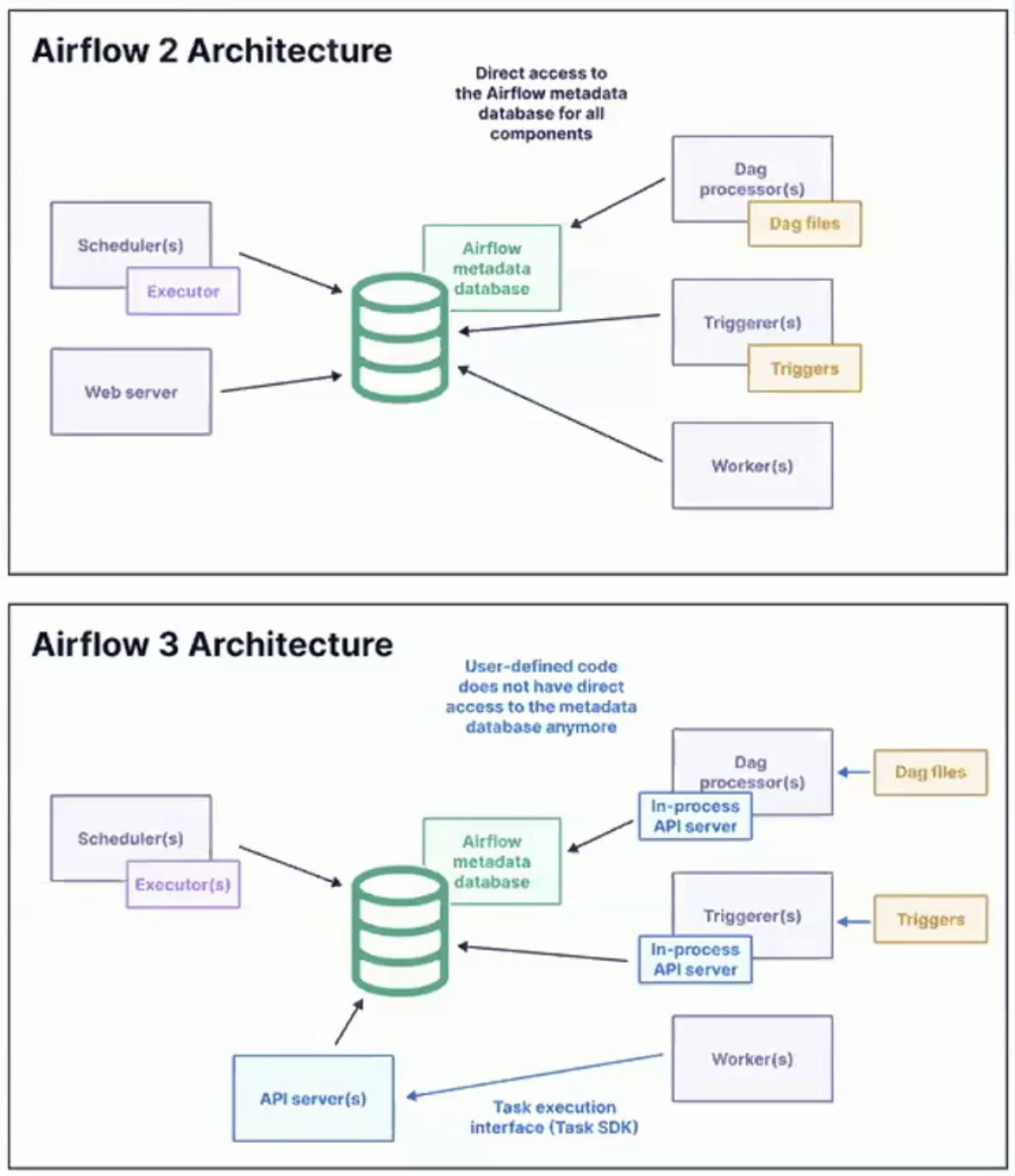

Principales cambios de arquitectura en Airflow 3.0

La versión 3.0 de Apache Airflow reimagina cómo se ejecutan las tareas, dónde pueden ejecutarse y cómo interactúan los desarrolladores y operadores con el sistema.

La atención se centra en el desacoplamiento, la modularización, la escalabilidad y la flexibilidad de despliegue, lo que permite a Airflow satisfacer las demandas de las plataformas de datos híbridas y multi-nube.

Imagen que muestra la arquitectura de Airflow 2 y Airflow 3. Fuente: Vídeo de introducción al Astrónomo Airflow 3.0

API de ejecución de tareas y SDK de tareas

Una de las innovaciones más importantes de Airflow 3.0 es la introducción de una API de Ejecución de Tareas y un SDK de Tareas que la acompaña.

Estos componentes permiten definir y ejecutar tareas independientemente del motor central de ejecución de Airflow.

He aquí algunas implicaciones clave de esto:

- Flexibilidad lingüística: Las tareas ya no se limitan a Python. Con el nuevo SDK, pueden escribirse en lenguajes como Java, Go o R, lo que permite una mayor adopción e integración con diversas pilas tecnológicas.

- Desacoplamiento del entorno: Ahora las tareas pueden ejecutarse en entornos aislados, remotos o en contenedores, separados del programador y los trabajadores. Esto elimina los conflictos de dependencia y mejora la coherencia de la ejecución.

- Flujo de trabajo optimizado para desarrolladores: Una interfaz estandarizada para el desarrollo de tareas simplifica las pruebas y el despliegue, mejora la reutilización del código y reduce el tiempo de incorporación de nuevos desarrolladores.

Esta arquitectura es un gran paso adelante para hacer que Airflow sea más flexible y nativo de la nube.

Se alinea con el cambio más amplio de la ingeniería de datos hacia la diversidad lingüística, la contenedorización y la reproducibilidad a nivel de tarea.

Ejecutor de aristas

El Ejecutor de Aristas es otro añadido de Airflow 3.0 que resulta transformador.

Está diseñado para permitir la ejecución de tareas basada en eventos y distribuida geográficamente.

En lugar de exigir que todas las ejecuciones se produzcan en un clúster centralizado, el Ejecutor Edge permite que las tareas se ejecuten en la fuente de datos o cerca de ella.

Algunas de las principales ventajas de la Ejecución en el Borde son:

Imagen que muestra las ventajas clave de la Ejecución por Flancos. Imagen creada con Napkin AI

- Flexibilidad geográfica: Las tareas pueden ejecutarse en clusters remotos o regionales, centros de datos o incluso en dispositivos periféricos.

- Capacidad de respuesta en tiempo real: Ideal para casos de uso de baja latencia y basados en eventos, como IoT, alimentación de datos financieros o supervisión operativa.

- Reducción de la latencia de la red: Como el cálculo se realiza cerca de la fuente de datos, hay menos sobrecarga en la transferencia de grandes volúmenes de datos a un clúster central.

- Tuberías activadas por eventos: Edge Executor es compatible con el nuevo paradigma de programación basada en eventos introducido en Airflow 3.0.

Aislamiento de tareas y topologías de despliegue

Airflow 3.0 introduce un nuevo nivel de aislamiento de tareas que mejora significativamente tanto la seguridad como el rendimiento.

Permitir que las tareas se ejecuten en entornos aislados reduce el riesgo de fugas de datos y conflictos de recursos.

También permite una gestión más flexible de las dependencias, ya que diferentes tareas o DAGs pueden funcionar con sus propias versiones de bibliotecas, entornos Python o motores de tiempo de ejecución.

Este aislamiento facilita aún más las actualizaciones. Los componentes principales de Airflow pueden actualizarse sin interrumpir las tareas en curso ni romper la compatibilidad.

La arquitectura mejorada también permite una serie de escenarios de despliegue adaptados a las diversas necesidades de infraestructura.

En entornos de nube pública, los trabajadores de Airflow pueden distribuirse fácilmente entre proveedores como AWS, GCP o Azure.

En las configuraciones de nube privada o híbrida, los componentes del plano de control pueden permanecer dentro de una red segura mientras las tareas se ejecutan en una DMZ o en un centro de datos local.

Además, Airflow 3.0 admite despliegues de borde, que permiten casos de uso como la inferencia ML o la detección de anomalías directamente en hardware industrial o móvil.

Estas capacidades soportan el cumplimiento de las normas de localidad de datos, la programación tolerante a fallos y la ejecución acelerada por GPU.

División CLI: airflow y airflowctl

Airflow 3.0 introduce una interfaz de línea de comandos (CLI) dividida, diseñada para complementar el backend modular, que distingue entre el desarrollo local y las tareas operativas remotas.

flujo de aire

- Se utiliza para el desarrollo y las pruebas locales

- Interactúa con los DAG locales, la BD de metadatos y los componentes

- Admite pruebas rápidas, análisis DAG y depuración basada en CLI

airflowctl

- Diseñado para producción y orquestación remota

- Se encarga de la gestión del entorno, el despliegue y la ejecución en la nube

- Útil para pipelines CI/CD, observabilidad y gestión de clusters distribuidos

Esta división simplifica los flujos de trabajo tanto para los desarrolladores individuales como para los equipos de la plataforma.

Para conocer todos los detalles técnicos y la lista completa de cambios, consulta el documento oficial Flujo de aire 3.0 notas de la versión.

Resumen de las mejoras en la arquitectura

Aquí tienes una tabla con un resumen de las mejoras de la arquitectura:

|

Función |

Descripción |

|

Tarea SDK + API |

Escribe y ejecuta tareas en cualquier lenguaje con soporte de ejecución remota |

|

Ejecutor de aristas |

Ejecución de tareas distribuidas cerca de fuentes de datos o a través de geografías |

|

Aislamiento de tareas |

Entornos de tareas seguros e independientes; gestión flexible de dependencias |

|

División CLI |

Distinción clara entre comandos locales (airflow) y remotos (airflowctl) |

|

Topologías de despliegue |

Admite patrones de ejecución híbridos, multi-nube, edge y acelerados por GPU |

Nueva interfaz de usuario basada en React y control de versiones DAG

Airflow 3.0 introduce una interfaz de usuario completamente rediseñada, construida desde cero utilizando React para el frontend y FastAPI como nuevo framework backend.

Interfaz de usuario más rápida y con mayor capacidad de respuesta

La nueva arquitectura de IU ofrece una experiencia de usuario mucho más fluida, sobre todo en entornos con cientos o miles de DAG.

Las páginas se cargan más rápido, los elementos de la interfaz de usuario son más intuitivos y el modelo de navegación es coherente y sensible en las distintas vistas.

Algunas de las principales mejoras de la interfaz de usuario son:

- Mejoras en la vista de cuadrícula: Navegación, búsqueda y filtrado de la línea temporal mejorados. Ahora los usuarios pueden escanear más fácilmente el estado de ejecución de los DAGs y solucionar problemas de tareas fallidas o atascadas.

- Mejoras en la vista gráfica: Mejor zoom, panorámica y exploración interactiva de metadatos de tareas. Esto ayuda a comprender estructuras DAG complejas de un vistazo.

- Panel de activos: Una nueva vista diseñada específicamente para flujos de trabajo basados en activos. Permite a los usuarios visualizar los activos, sus productores y consumidores, y el linaje a través de los DAG.

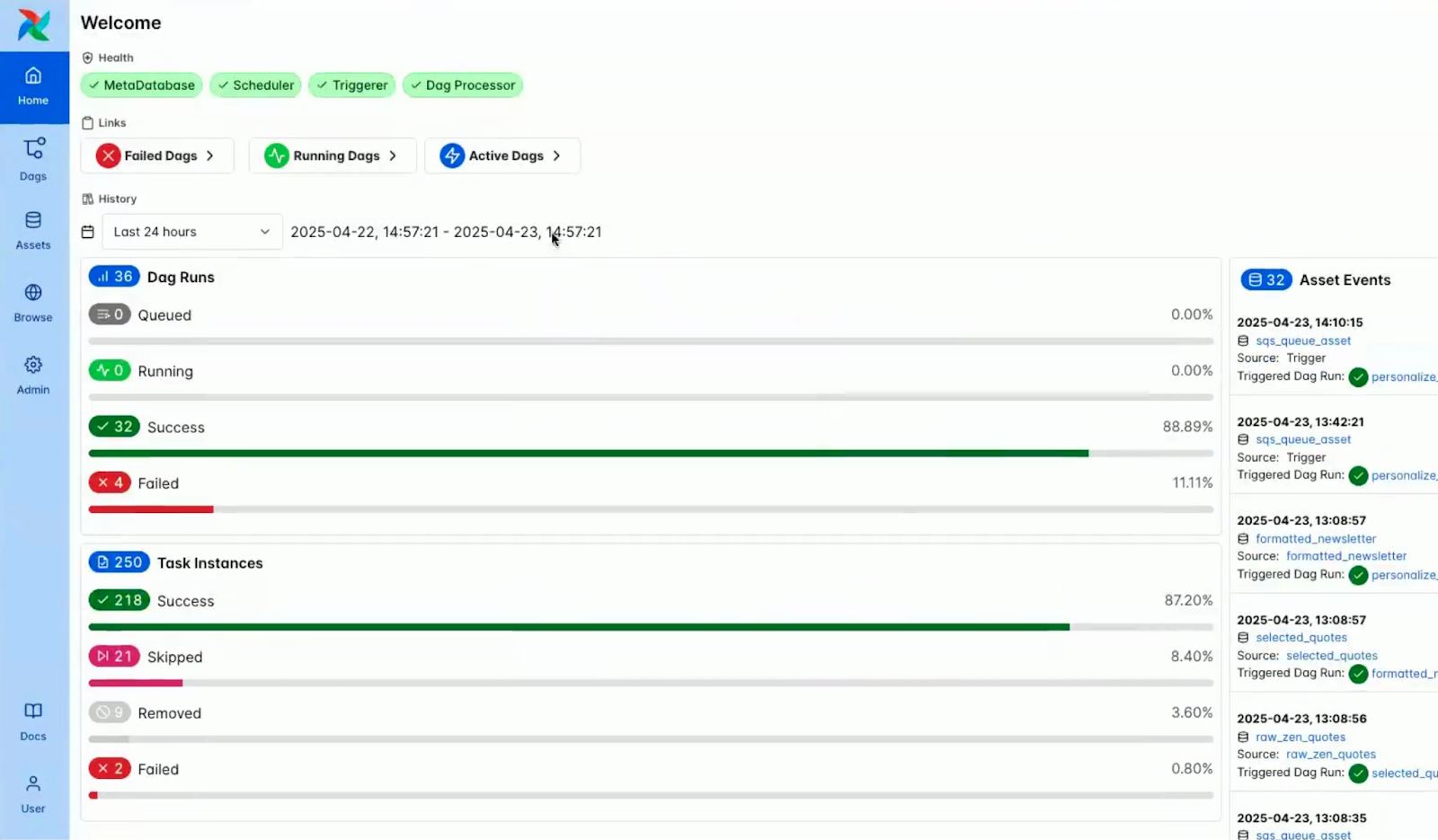

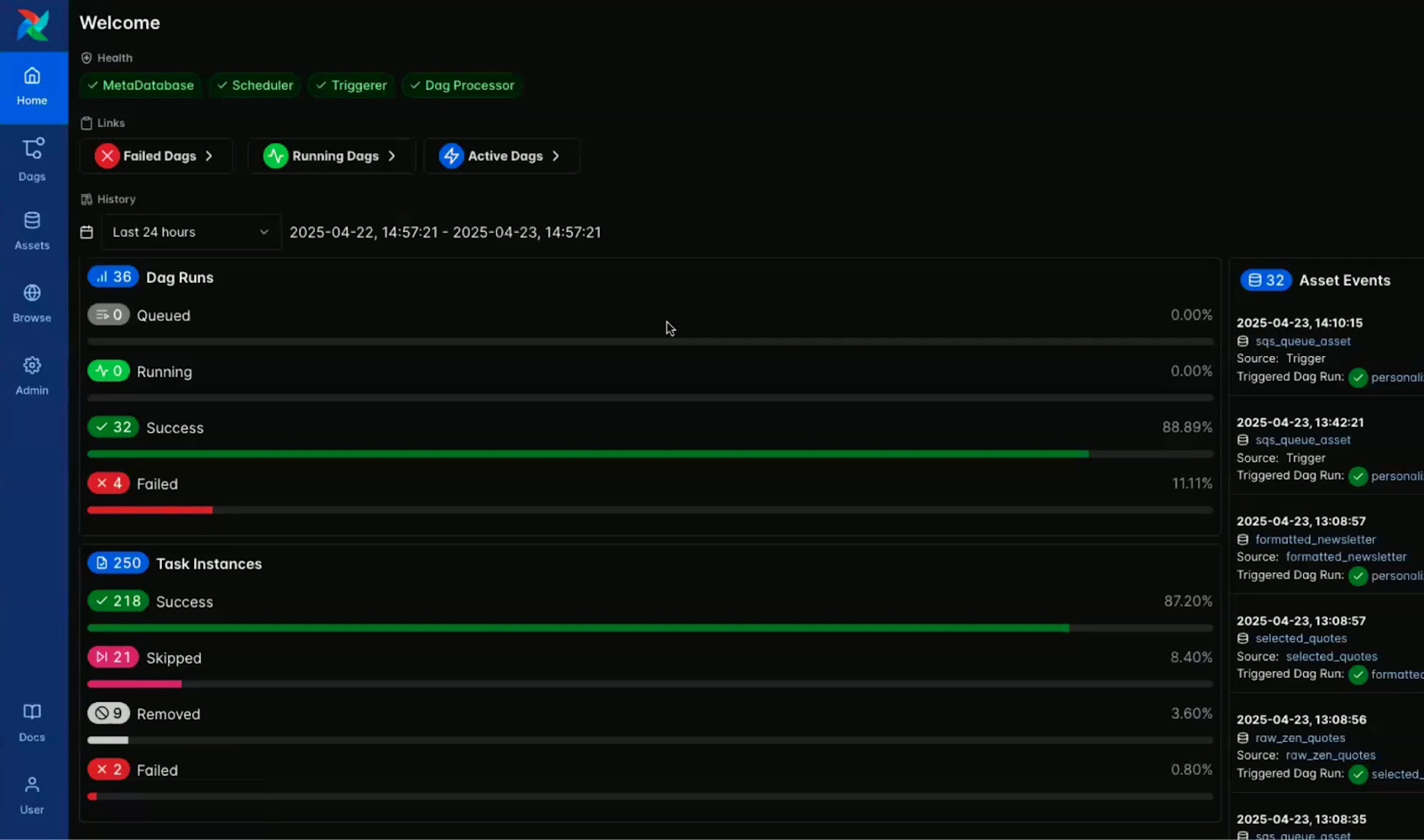

Soporte integrado para modo oscuro

El modo oscuro está ahora integrado de forma nativa y pensada en Airflow, que ofrece una experiencia visual refinada diseñada para la claridad y la comodidad a largo plazo.

Aunque ya existía una versión del modo oscuro en la 2.x, esta versión introduce una capa de diseño totalmente desarrollada y creada a tal efecto.

Está claro que se ha optimizado cuidadosamente para conseguir contraste, legibilidad y reducir la fatiga ocular durante sesiones de trabajo prolongadas.

Como alguien que ha pasado tiempo en el espacio de desarrollo, realmente aprecio esto.

Era una de las funciones más solicitadas por la comunidad y es especialmente valiosa para los desarrolladores que suelen trabajar en entornos con poca luz o que simplemente prefieren una interfaz más oscura.

Las imágenes siguientes resaltan el contraste visual entre los modos claro y oscuro del salpicadero de la consola Airflow.

Captura de pantalla de la consola Airflow en modo luz. Fuente: Vídeo de introducción al Astrónomo Airflow 3.0

Captura de pantalla de la consola Airflow en modo oscuro. Fuente: Vídeo de introducción al Astrónomo Airflow 3.0

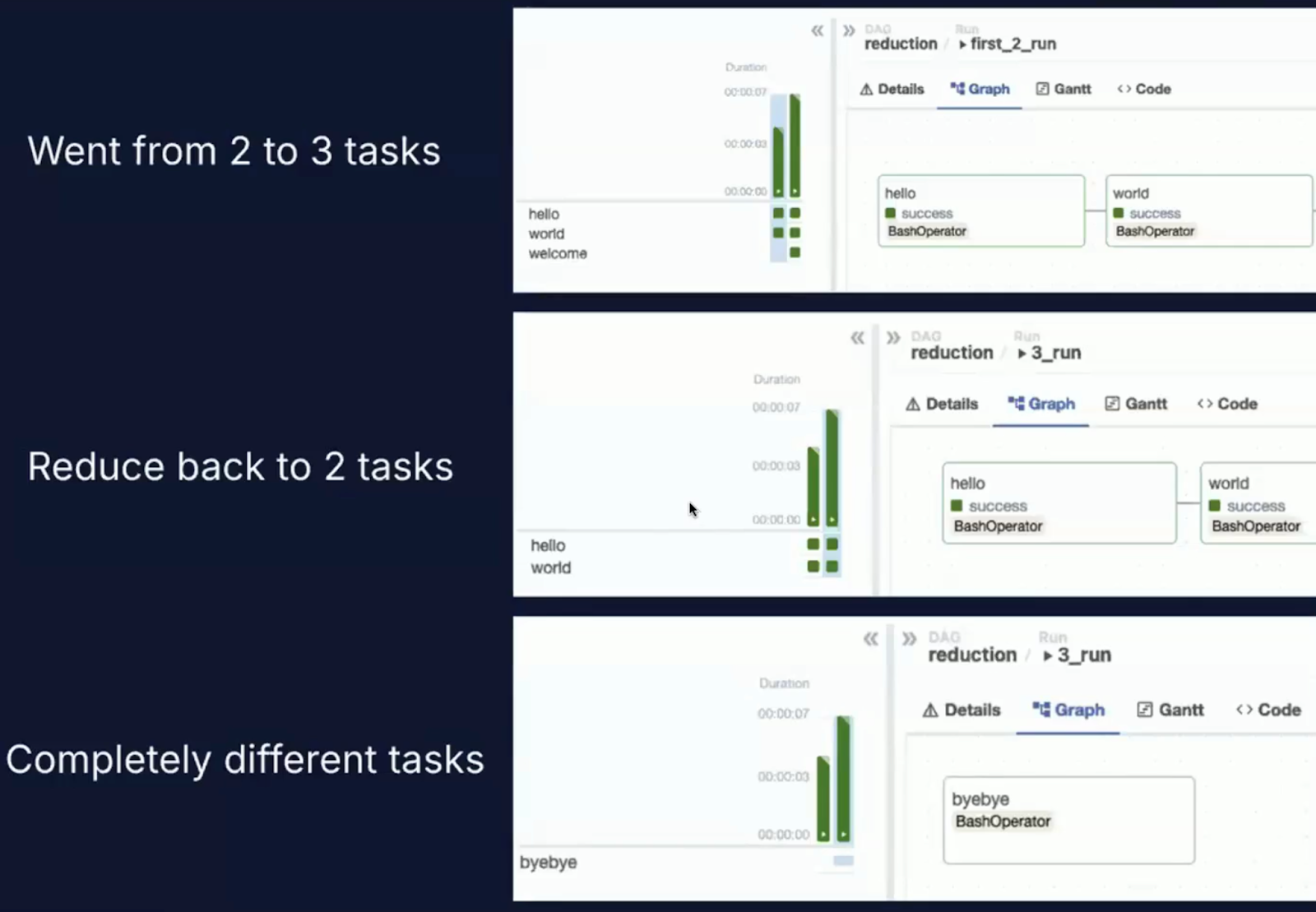

Versionado DAG

Una de las nuevas capacidades más impactantes de Airflow 3.0 es el versionado DAG de primera clase.

El reto en Airflow 2.x

En versiones anteriores de Airflow, los DAG se analizaban a partir de archivos de código fuente, y la última versión del DAG se aplicaba universalmente, incluso con carácter retroactivo, a las ejecuciones de DAG anteriores.

Este planteamiento dio lugar a varios problemas bien conocidos.

Un problema importante era la deriva de la ejecución. Si actualizaste un DAG durante una ejecución, las tareas podrían acabar ejecutándose bajo versiones diferentes del código.

También había una pérdida de auditabilidad, ya que Airflow no tenía un mecanismo nativo para rastrear qué versión de un DAG se utilizó para una ejecución concreta.

Además, la precisión histórica se resentía porque la interfaz de usuario siempre mostraba la última estructura del DAG, independientemente de cuándo se ejecutara realmente, lo que daba lugar a historiales de ejecución incoherentes y potencialmente engañosos.

Qué cambia el flujo de aire 3.0

Airflow 3.0 introduce el seguimiento estructurado de versiones DAG directamente en la plataforma:

- Los DAG se versionan cada vez que se produce un nuevo despliegue o un cambio de código.

- Las ejecuciones históricas se conservan junto con la versión exacta del DAG que las produjo.

- Los usuarios pueden seleccionar una versión concreta de un DAG para inspeccionarla, volver a ejecutarla o analizarla desde la interfaz de usuario.

Aprecio mucho esta función porque, en la práctica, es casi imposible crear un DAG que no necesite cambios.

Los DAG tendrán que evolucionar debido a una nueva lógica empresarial, a la corrección de errores o a la optimización del rendimiento, y tener un versionado incorporado hace que ese proceso sea mucho más transparente y manejable.

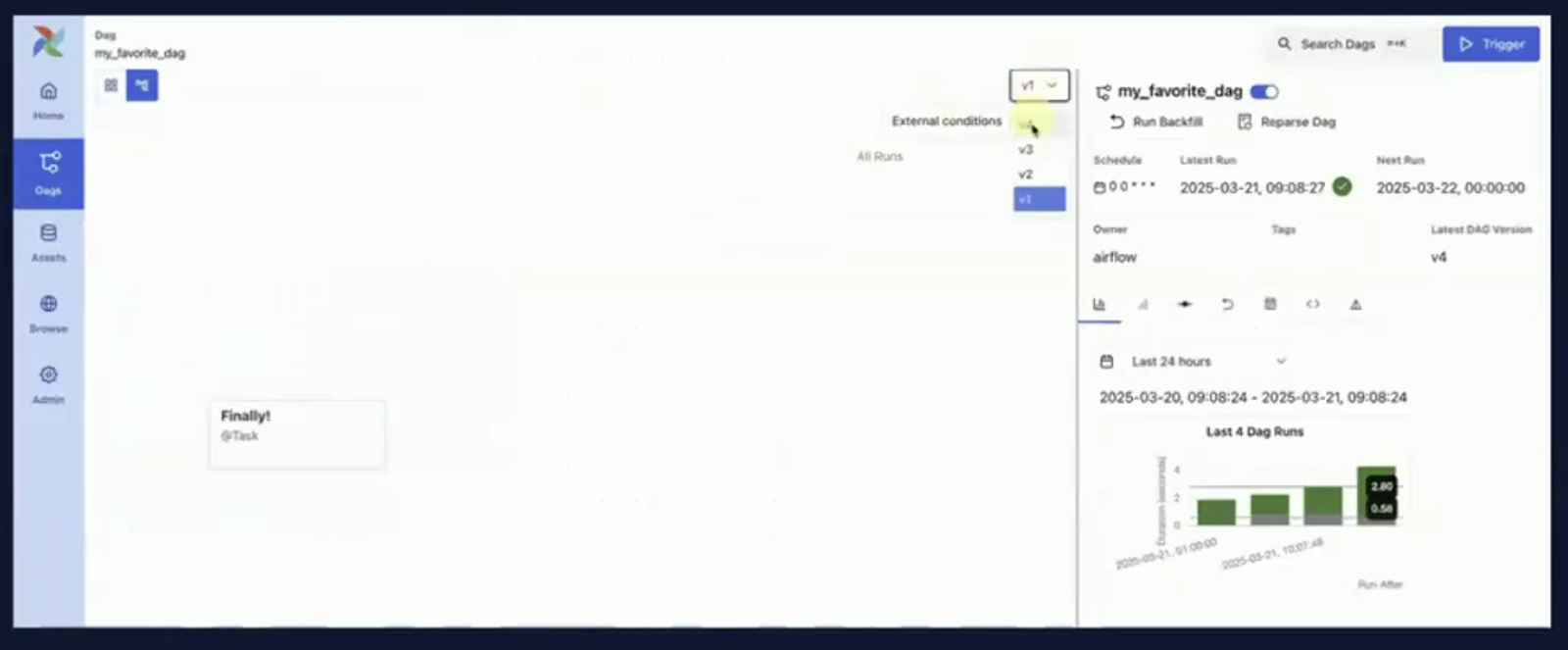

Puedes verlo en acción en las siguientes capturas de pantalla, que muestran la interfaz de orquestación DAG y el nuevo desplegable del historial de versiones.

Imagen de la orquestación DAG. Fuente: Vídeo de introducción al Astrónomo Airflow 3.0

Captura de pantalla de la orquestación DAG con un desplegable del historial de versiones. Fuente: Vídeo de introducción al Astrónomo Airflow 3.0

Por qué es importante el versionado del DAG

El versionado de DAG desempeña un papel crucial en el mantenimiento de flujos de trabajo de datos fiables, trazables y conformes. He aquí por qué es importante:

- Reproducibilidad: Ahora puedes volver a ejecutar de forma fiable un DAG exactamente como se ejecutó en el pasado, aunque el código actual haya cambiado.

- Depurando: Los errores pueden rastrearse hasta la versión concreta del DAG responsable, lo que ayuda al análisis de la causa raíz.

- Gobernanza: En los entornos regulados, el control de versiones ayuda a cumplir la normativa al mantener una pista de auditoría sobre qué código se ha utilizado, cuándo y cómo.

- Integración CI/CD: Los equipos que utilicen flujos de trabajo GitOps pueden vincular las versiones DAG en Airflow a los hashes de commit en el control de código fuente para obtener un canal de entrega totalmente trazable.

Las siguientes capturas de pantalla muestran cómo se muestran algunos de los cambios en la interfaz de usuario, con vistas conscientes de la versión tanto en la vista general del DAG como en el panel de código.

Captura de pantalla del panel de visión general dentro de un DAG en la consola Airflow. Fuente: Vídeo de introducción al Astrónomo Airflow 3.0)

Captura de pantalla del panel de código dentro de un DAG en la consola Airflow. Fuente: Vídeo de introducción al Astrónomo Airflow 3.0

Colaboración y transparencia

El versionado DAG también facilita la colaboración de los equipos de datos. Por ejemplo:

- Los ingenieros pueden revisar los cambios del DAG directamente en la interfaz de usuario, sin necesidad de acceder a Git.

- Los analistas y los equipos de control de calidad pueden verificar el comportamiento histórico sin arriesgarse a interferir con los DAG de producción.

- Los ingenieros de plataforma pueden probar con seguridad las nuevas versiones de DAG junto a las estables.

Programación y rellenos más inteligentes

Airflow 3.0 marca una evolución significativa en la forma de activar, gestionar y coordinar los flujos de trabajo.

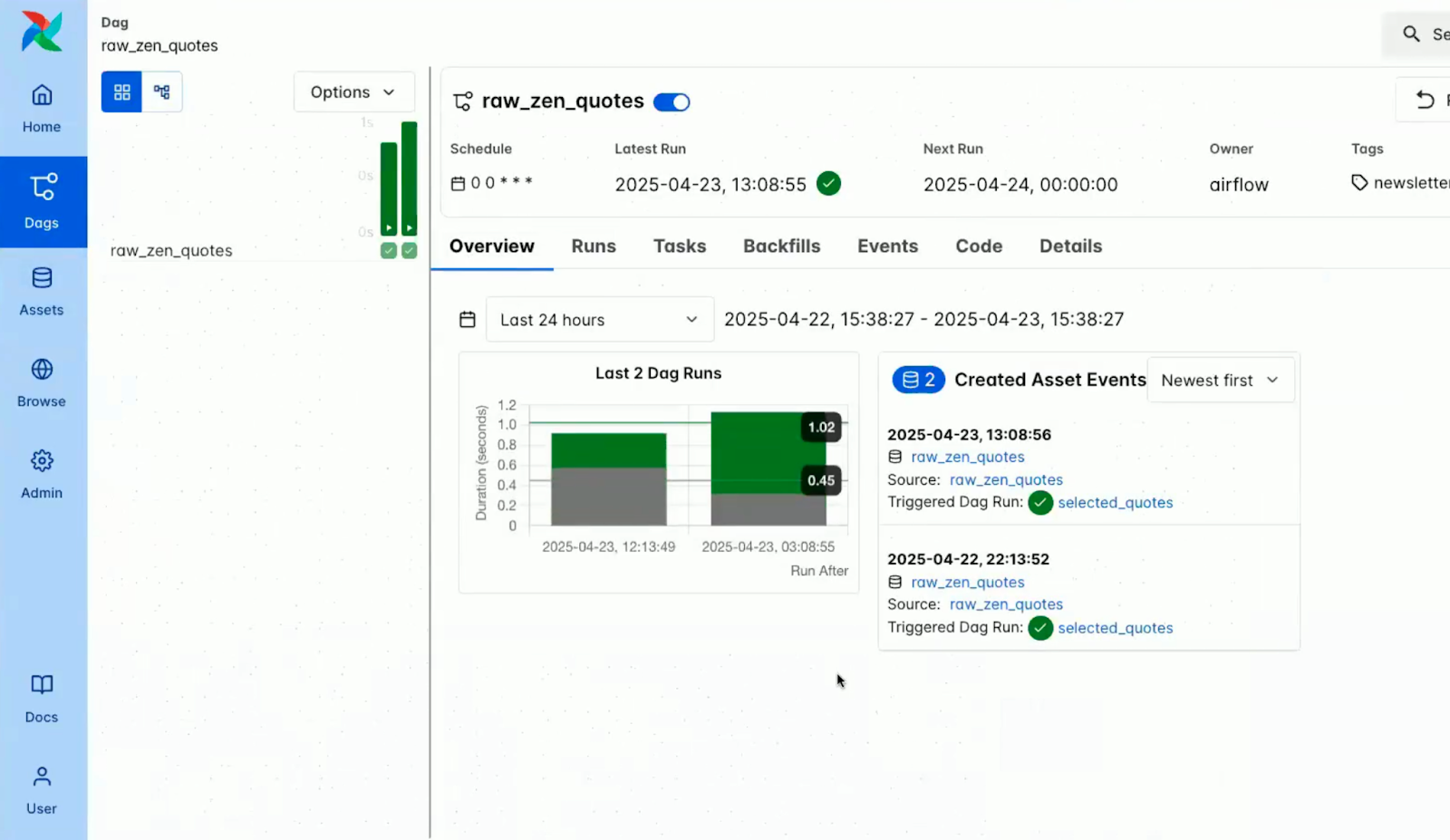

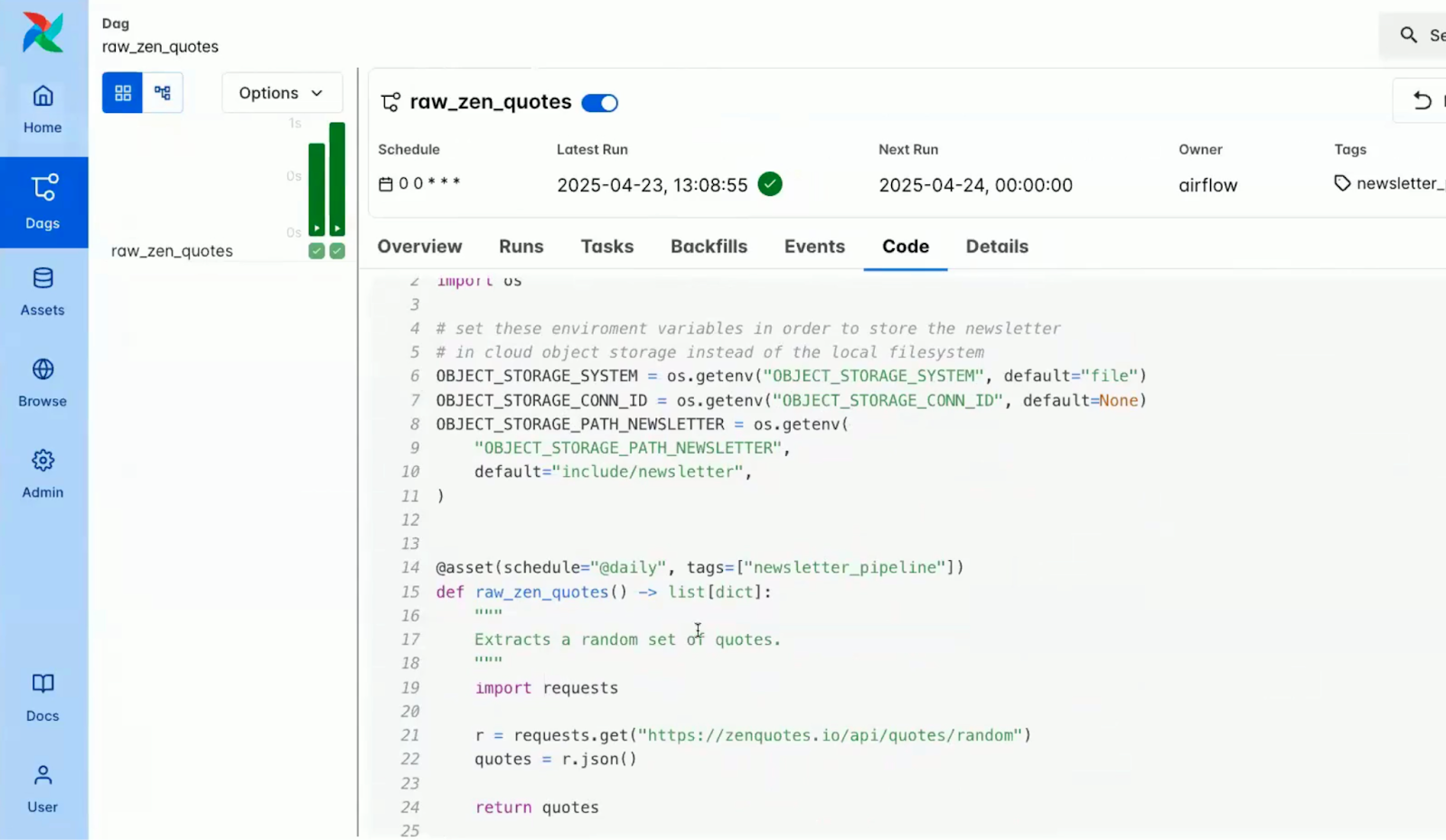

DAG basados en activos

En el núcleo de una programación más inteligente en Airflow 3.0 está el concepto de Activos.

Inspirado en la evolución de los conjuntos de datos introducida en versiones anteriores, el nuevo decorador @activo permite a los usuarios definir canalizaciones impulsadas por la disponibilidad y el estado de entidades de datos lógicas.

¿Qué es un activo?

Un activo en Airflow representa un dato o una salida que es producida, transformada o consumida por un DAG.

Puede ser una tabla de la base de datos, un archivo en el almacenamiento en la nube, un modelo ML entrenado o incluso una respuesta de la API.

Con el decorador @activo:

- Los activos se declaran como funciones Python que devuelven o generan datos.

- Estos activos son tratados como ciudadanos de primera clase en el proceso de orquestación.

- Airflow rastrea automáticamente las dependencias entre activos y DAGs.

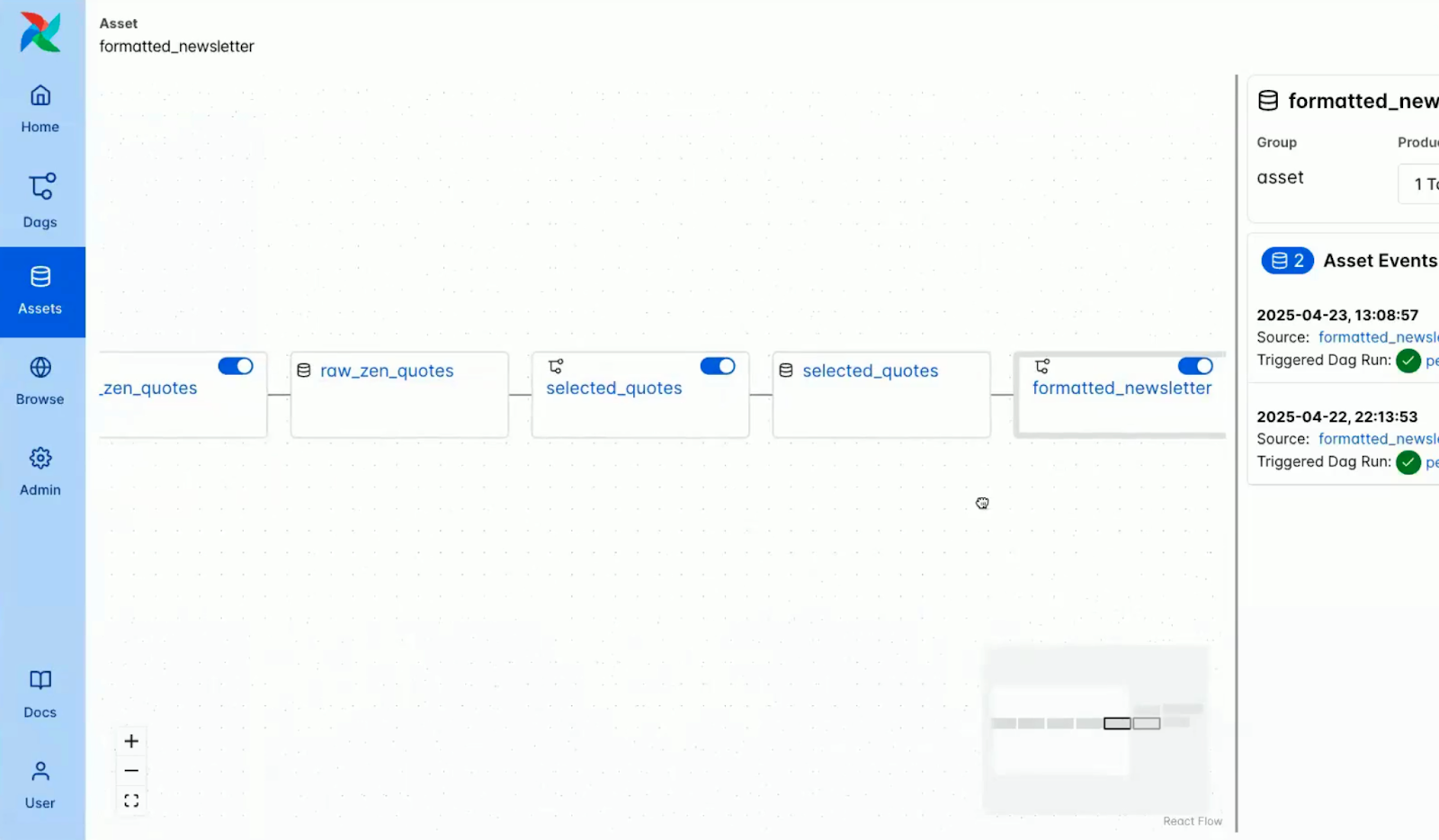

La siguiente captura de pantalla muestra cómo se visualizan los activos en la consola Airflow.

Captura de pantalla de los activos dentro de la consola Airflow. Fuente: Vídeo de introducción al Astrónomo Airflow 3.0

Algunas de las características clave de los activos en Airflow 3.0 son:

Imagen de las características clave de los Activos en Airflow 3.0. Imagen creada con Napkin AI

- Metadatos estructurados: Los activos admiten nombres, URI, identificadores de grupo y campos de metadatos arbitrarios, lo que permite un rico linaje y descubrimiento.

- Diseño componible: Los activos pueden referenciarse entre sí para construir conductos modulares interdependientes.

- Soporte de vigilante: Los activos pueden configurarse con Observadores, que monitorizan las señales externas (actualmente AWS SQS) y activan la ejecución del DAG en respuesta.

Este modelo transforma la programación DAG de "ejecutar cada hora" a "ejecutar cuando los datos relevantes estén listos".

Esto permite flujos de trabajo verdaderamente reactivos que están estrechamente acoplados al estado de los datos, no al reloj.

Para obtener ejemplos más detallados y patrones de producción que utilicen estas nuevas capacidades, la Guía del Astrónomo sobre programación basada en datos ofrece un recorrido detallado. También puedes aprender a implementar una canalización de datos completa con estas funciones en la guía para Construir un canal ETL con Airflow.

Programación de eventos externos

Airflow 3.0 introduce una sólida compatibilidad con la programación externa basada en eventos, que permite iniciar flujos de trabajo basados en desencadenantes del mundo real desde fuera del ecosistema Airflow.

Esta función supone un cambio significativo respecto al enfoque tradicional de Airflow, basado en sondeos.

Las fuentes de eventos soportadas incluyen AWS SQS para integrarse con colas de mensajes en flujos de trabajo desacoplados y nativos de la nube, compatibilidad prevista con Kafka para soportar el streaming y la coordinación de microservicios, y HTTP/webhooks para recibir señales de sistemas de monitorización, API u otras plataformas de orquestación.

Los casos de uso van desde iniciar una canalización de datos cuando llega un nuevo archivo a S3 hasta lanzar un DAG en respuesta a una actualización del registro de modelos ML o coordinar flujos de trabajo de alerta y respuesta a incidentes en tiempo real.

Los DAG basados en eventos permiten que Airflow sea más flexible y potente, capaz de reaccionar ante sistemas externos en tiempo real.

Rellenos gestionados por el programador

Una de las mejoras más esperadas de Airflow 3.0 es la revisión de la mecánica de relleno, el proceso de volver a ejecutar intervalos de datos pasados o reparar DAG fallidos.

Algunos de los retos de Airflow 2.x eran la falta de interfaz de usuario y de API para los rellenos, que tenían que activarse manualmente a través de la CLI.

Como resultado de ello, se introdujeron mejoras en Flujo de aire 3.0 que incluyen:

Imagen que contiene mejoras en Airflow 3.0. Imagen creada con Napkin AI

- Modelo unificado de ejecución: El programador principal se encarga ahora de los rellenos, lo que garantiza la coherencia con las ejecuciones regulares del DAG.

- Activación multimodal: Los rellenos pueden lanzarse a través de la interfaz de usuario, la API o la CLI, lo que ofrece flexibilidad tanto a los usuarios interactivos como a los sistemas automatizados.

- Ejecución asíncrona: Los rellenos se ejecutan ahora de forma no bloqueante y asíncrona; se pueden poner en cola y gestionar simultáneamente varios rellenos.

- Observabilidad total: La interfaz de usuario incluye un seguimiento del progreso del relleno con vistas detalladas de las tareas, registros en tiempo real e indicadores de estado.

- Cancelable corre: Ahora los rellenos pueden pausarse o finalizarse desde la interfaz de usuario, lo que permite a los usuarios responder dinámicamente a los problemas sin reiniciar flujos de trabajo enteros.

Soporte de casos de uso de aprendizaje automático e IA de Airflow 3.0

Airflow 3.0 da un paso importante para convertirse en una herramienta de orquestación de primera clase para los flujos de trabajo modernos basados en el aprendizaje automático (ML) y la IA.

DAG sin intervalo de datos

Uno de los cambios más transformadores de la 3.0 es la eliminación de la restricción de la fecha de ejecución, que existía desde hace tiempo.

En Airflow 2.x y anteriores, cada ejecución DAG debía tener una fecha_de_ejecución única, que estaba vinculada principalmente al intervalo de programación.

Aunque este modelo funcionaba bien para los trabajos ETL basados en el tiempo, creaba fricciones en escenarios experimentales y de inferencia.

Con los DAG sin intervalo de datos, Airflow 3.0 introduce una verdadera independencia de ejecución:

Algunos de los casos de uso potenciados por este cambio son:

- Experimentación con modelos: Ejecuta el mismo DAG varias veces para diferentes configuraciones del modelo o trozos de datos sin preocuparte de que coincidan las fechas de ejecución.

- Ajuste de hiperparámetros: Inicia ejecuciones simultáneas del DAG para diferentes rejillas de parámetros o estrategias de búsqueda, rastreadas por separado pero ejecutadas en paralelo.

- DAGs de inferencia: Invoca continua o repetidamente el mismo DAG para predicciones en tiempo real o por lotes, desencadenadas por nuevos datos, eventos externos o acciones del usuario.

Este desacoplamiento simplifica drásticamente la lógica de orquestación para los ingenieros de ML y permite mayores niveles de automatización, paralelismo y reproducibilidad.

Ejecuta tareas en cualquier momento

Airflow 3.0 admite ahora oficialmente múltiples paradigmas de ejecución, reconociendo que los flujos de trabajo de datos modernos no siempre se ajustan a calendarios fijos.

Esta actualización hace que Airflow sea más adaptable a diversas necesidades operativas y de procesamiento de datos.

Los modos de ejecución admitidos incluyen la ejecución programada (por lotes) tradicional, que utiliza una programación similar a la de cron y es adecuada para trabajos como informes nocturnos, sincronizaciones horarias o canalizaciones ETL por lotes.

Airflow 3.0 también admite la ejecución basada en eventos, en la que los DAG pueden activarse por eventos externos -como la aparición de un nuevo archivo en un cubo de almacenamiento en la nube o la llegada de un mensaje a Kafka-, lo que permite una orquestación con capacidad de respuesta y en tiempo real. Además, ahora es posible la Ejecución Ad Hoc/Inferencia, que permite ejecutar DAGs sin necesidad de una marca de tiempo específica.

Esto es especialmente útil para casos de uso como la inferencia de aprendizaje automático, las comprobaciones de calidad de datos o los trabajos activados por el usuario, en los que la concurrencia y la inmediatez son importantes.

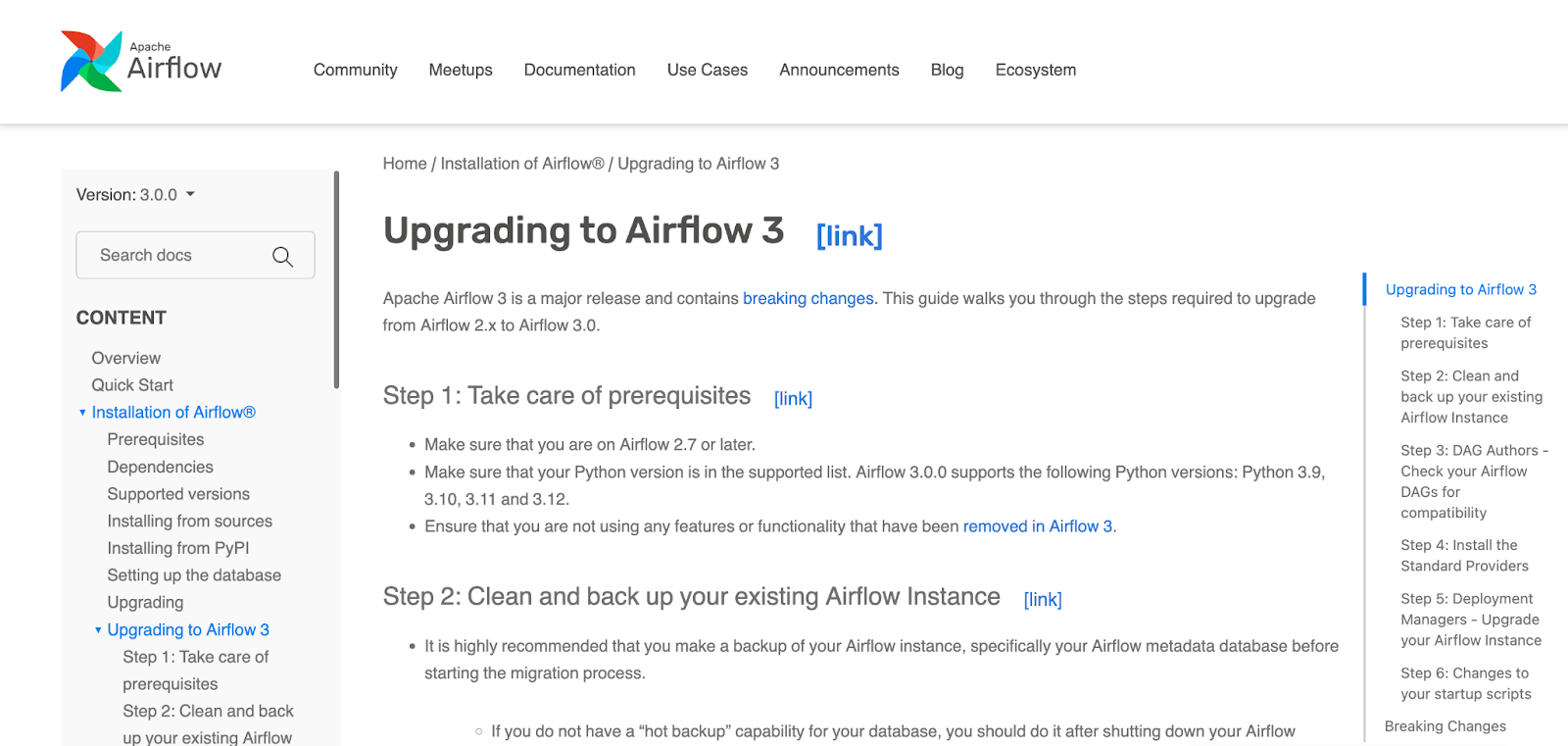

Actualización a Airflow 3.0

Airflow 3.0 introduce mejoras significativas, pero también rompe con los patrones heredados de forma significativa.

Para ayudarte a realizar la transición sin problemas, los colaboradores principales han proporcionado una guía de actualización extensa y bien estructurada.

Se trata de una versión importante, por lo que se recomienda una planificación cuidadosa.

Dicho esto, el proceso de actualización se ha simplificado al máximo con documentación clara, listas de comprobación de la actualización y herramientas de compatibilidad.

Algunos de los aspectos que cubre la guía son

- Configuración del entorno y las dependencias

- Alineación de programador y ejecutor

- Migraciones y copias de seguridad de esquemas de bases de datos

- Diferencias de comportamiento en la ejecución de tareas y el análisis sintáctico de DAGs

Captura de pantalla de la página web de Apache Airflow al actualizar a 3.0. Fuente: Flujo de aire Apache

Es importante que evalúes las siguientes áreas antes de proceder a la actualización:

- Compatibilidad DAG: Asegúrate de que los DAGs utilizan APIs y construcciones compatibles con el SDK de Tareas 3.0, sobre todo si adoptan nuevas funciones de ejecución.

- Transición CLI: Sustituye el uso de CLI obsoleto por airflowctl cuando proceda, especialmente en contextos CI/CD y de ejecución remota.

- Validación de plugins: Confirma que los plugins personalizados y las integraciones de terceros son compatibles con el nuevo diseño arquitectónico y la división CLI.

Si quieres una experiencia de actualización sin problemas, echa un vistazo a toda la Actualización a Airflow 3.0 antes de actualizar Airflow.

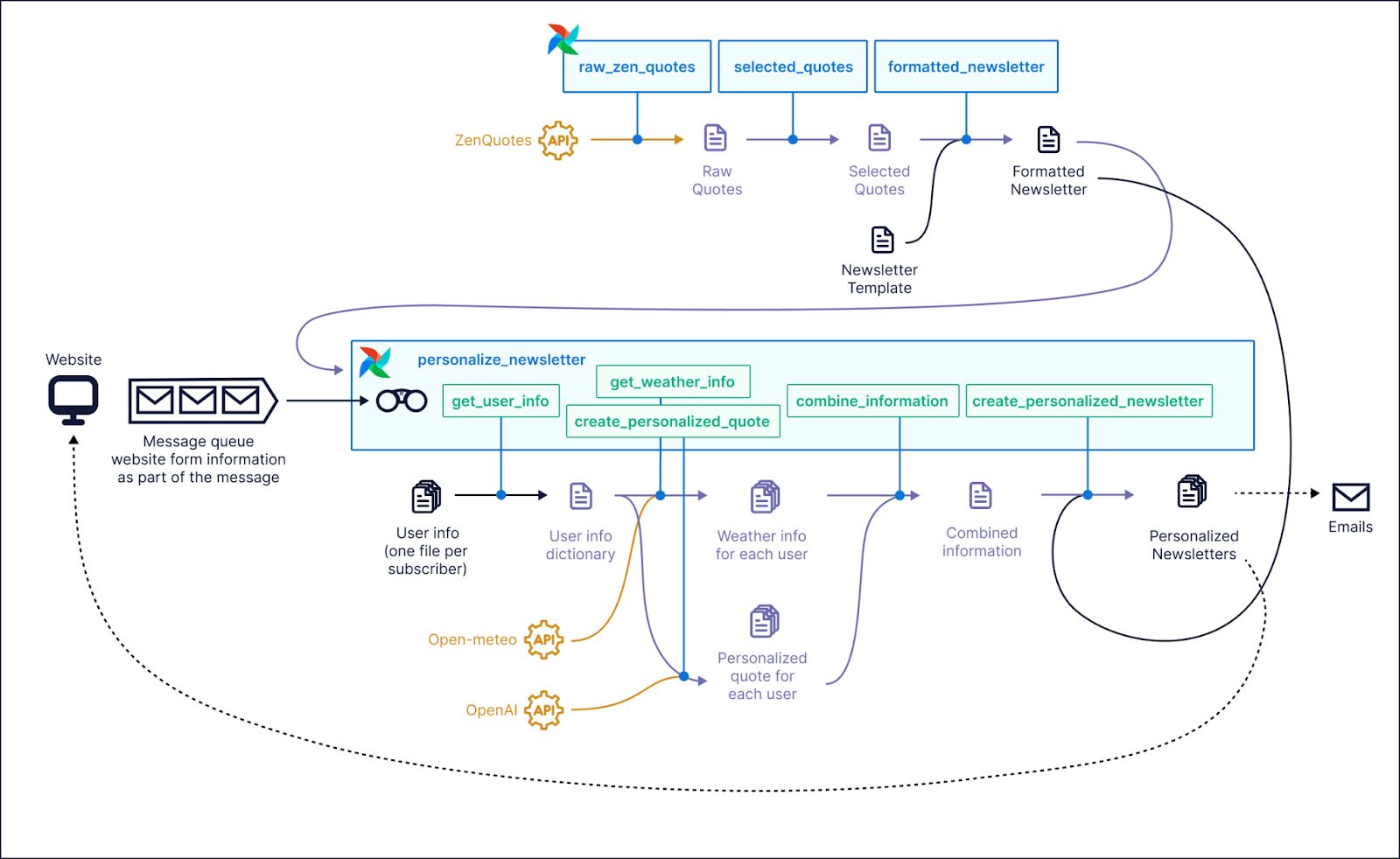

Evaluación demoscópica

Para ver las nuevas funciones de Airflow 3.0 en acción, los DAG de demostración oficiales proporcionados por Astrónomo ofrecen una forma práctica de explorar las últimas capacidades de la plataforma.

Estas demostraciones sirven como escaparate completo y son ideales para comprender cómo funcionan en escenarios reales características como el versionado DAG, los flujos de trabajo basados en activos y la ejecución basada en eventos.

Captura de pantalla de un caso de uso de ejemplo en el que podría utilizarse Airflow 3.0. Fuente: Astronomer GitHub

La interfaz actualizada destacó de inmediato. La vista Activos ofrecía un mapa visual claro de las dependencias y el linaje de los datos, que resultó especialmente útil al trabajar con DAGs basados en activos.

El panel del historial de versiones de DAG fue otro punto destacado. Permitía una rápida inspección de los cambios anteriores, facilitaba la reproducibilidad y hacía fácil correlacionar ejecuciones concretas con el código que las produjo.

Además, el nuevo modo oscuro rediseñado proporcionaba un contraste y una legibilidad excelentes, lo que lo convertía en una mejora bienvenida para las sesiones de depuración prolongadas o el trabajo de desarrollo nocturno.

Si quieres probarlo tú mismo, Astronomer proporciona instrucciones paso a paso y un entorno de demostración listo para funcionar en su repositorio GitHub. Puedes clonar el repositorio, seguir la guía de configuración y explorar las nuevas funciones de Airflow 3.0.

Comunidad y desarrollo futuro

Apache Airflow siempre ha sido impulsado por su comunidad, y esto también se aplica a Airflow 3.0.

Muchas de las características más impactantes de esta versión son respuestas directas a encuestas de la comunidad, debates en GitHub y comentarios de los usuarios.

Si utilizas Airflow, deberías plantearte participar. He aquí cómo puedes influir:

- Únete a la Comunidad Slack de Apache Airflow para compartir opiniones, hacer preguntas y conectar con otros profesionales.

- Involúcrate en GitHub participando en cuestiones, propuestas de funciones y debates sobre diseño para ayudar a dar forma a futuras versiones.

- Participa en las encuestas de características cuando se compartan. El propio Flujo de aire 3.0 se creó gracias a las opiniones de usuarios como tú.

Conclusión

Apache Airflow 3.0 aporta una arquitectura orientada a servicios, ejecución de tareas poliglota, programación más inteligente y una interfaz de usuario completamente modernizada, todo en una sola versión.

El cambio puede parecer drástico, especialmente con la nueva división de la CLI y los ejecutores centrados en los bordes, pero el resultado es una plataforma de orquestación más modular, escalable y preparada para la producción.

También es más flexible para los equipos de ML, las pilas nativas en la nube y los sistemas basados en eventos, donde la capacidad de respuesta y la observabilidad son fundamentales.

Si todavía utilizas una versión anterior de Airflow, merece la pena que te plantees actualizar a la 3.0.

Para ponerte manos a la obra con Airflow, empieza con nuestro curso Introducción a Apache Airflow, o profundiza en los conceptos básicos en Introducción a Apache Airflow en Python.

Preguntas frecuentes sobre Airflow 3.0

¿Cuáles son las principales novedades de Apache Airflow 3.0?

Airflow 3.0 introduce una arquitectura orientada a servicios, una nueva interfaz de usuario basada en React, versionado DAG, programación basada en activos y soporte ML/AI mejorado.

¿Cómo mejora la flexibilidad la nueva API de Ejecución de Tareas?

La API de ejecución de tareas permite que éstas se ejecuten en cualquier lenguaje y entorno, lo que hace que Airflow sea más políglota y nativo de la nube que nunca.

¿Cuál es la diferencia entre los nuevos comandos CLI airflow y airflowctl?

airflow se utiliza ahora para los comandos locales, mientras que airflowctl se encarga de las operaciones remotas, lo que ofrece una mejor separación entre el desarrollo y la implantación.

¿Cómo funciona el versionado DAG en Airflow 3.0?

Airflow 3.0 realiza un seguimiento de los cambios en los DAG a lo largo del tiempo. Esto permite a los usuarios inspeccionar el historial de versiones y mejorar la depuración, la auditoría y la colaboración.

¿Es Airflow 3.0 compatible con los flujos de trabajo de aprendizaje automático?

Sí. Airflow 3.0 admite DAG sin intervalos y ejecuciones bajo demanda, lo que facilita la ejecución de experimentos de ML, el entrenamiento de modelos y los trabajos de inferencia.

¿Es difícil actualizar a Airflow 3.0?

Aunque la mayoría de los DAG funcionarán con cambios mínimos, algunos cambios de última hora y características obsoletas requieren una revisión. Existen guías oficiales de migración.