programa

Docker se ha convertido en la herramienta de contenedorización más popular en el desarrollo de software moderno, especialmente en los flujos de trabajo de DevOps y CI/CD. Simplifica la implementación y la gestión de aplicaciones mediante contenedores, lo que permite entregar software de forma rápida y coherente.

Sus características de escalabilidad y flexibilidad hacen que Docker sea un requisito imprescindible para puestos relacionados con los datos, como la ingeniería de datos, MLOps e incluso la ciencia de datos. Por eso he recopilado las preguntas más frecuentes relacionadas con las entrevistas sobre Docker, que abarcan conceptos básicos y situaciones reales.

Conviértete en Ingeniero de Datos

¿Qué es Docker?

Docker es una plataforma de contenedores que los programadores utilizan para empaquetar aplicaciones con todas sus dependencias, de modo que puedan ejecutarse sin problemas en diferentes entornos.

Aunque los contenedores comparten el mismo núcleo del sistema operativo, cada uno funciona en su propio entorno aislado. Esta configuración minimiza los problemas de compatibilidad, reduce los retrasos y mejora la comunicación entre los equipos de desarrollo, pruebas y operaciones.

Logotipo de Docker. Fuente de la imagen

En 2023, Docker lideró el mercado de la contenedorización con una cuota superior al 32%. Esto pone de relieve su importancia en el desarrollo de software moderno. Por eso, es de esperar que los reclutadores evalúen tus conocimientos sobre Docker en las entrevistas de trabajo relacionadas con los datos.

Preguntas básicas para una entrevista sobre Docker

En primer lugar, familiarízate con algunos conceptos fundamentales de Docker. Estas preguntas básicas te ayudarán a comprender mejor el tema y a prepararte para la fase inicial de la entrevista.

1. ¿Qué es una imagen Docker?

Una imagen de Docker es como un plano que crea contenedores. Tiene todo lo que un programador necesita para ejecutar una aplicación, como por ejemplo:

- Código

- Bibliotecas

- Configuración

Cuando utilizas una imagen de Docker, Docker la convierte en un contenedor, que es un entorno totalmente aislado. Ahí es donde la aplicación se ejecuta de forma independiente.

2. ¿Qué es un host Docker?

Un host Docker es el sistema en el que instalamos Docker. Actúa como el entorno principal que ejecuta y gestiona los contenedores Docker. Podemos configurar un host Docker en un dispositivo local o en un entorno virtual o en la nube.

3. ¿En qué se diferencia un cliente Docker de un demonio Docker? ¿Puedes compartir un ejemplo?

El cliente Docker y el demonio Docker funcionan conjuntamente, pero tienen funciones distintas. El cliente Docker es la herramienta que envía los comandos y el demonio Docker es el motor que ejecuta esos comandos.

Por ejemplo, si escribimos el comando docker run para iniciar un contenedor, el cliente tomará la solicitud y la enviará al demonio Docker. El demonio Docker se encargará entonces del trabajo real iniciando el contenedor.

4. ¿Podéis explicar qué es la red Docker y qué comandos pueden crear un puente y una red superpuesta?

La red Docker permite que los contenedores se conecten y se comuniquen con otros contenedores y hosts. El comando ` docker network create ` nos permite configurar redes definidas por el usuario.

- Red de puentes: Crea una red local para la comunicación entre contenedores en el mismo host Docker.

- Comando:

docker network create -d bridge my-bridge-network - Esto configura una red puente denominada «

my-bridge-network» para los contenedores del mismo host. - Red superpuesta: Permite la comunicación entre contenedores en múltiples hosts Docker, lo que se utiliza a menudo en una configuración Swarm.

- Comando:

docker network create --scope=swarm --attachable -d overlay my-multihost-network - Esto crea una red superpuesta conectable denominad

my-multihost-networkpara contenedores que se ejecutan en diferentes hosts en un Docker Swarm.

5. Explica cómo funciona la red puente de Docker.

La red puente es la configuración predeterminada que utiliza Docker para conectar contenedores. Si no especificamos una red, Docker la vincula a la red puente. Este puente conecta todos los contenedores del mismo host Docker. Cada contenedor tiene una dirección IP única, lo que permite que los contenedores se comuniquen directamente.

Preguntas de entrevista intermedias sobre Docker

Estas preguntas se formulan para evaluar tus conocimientos sobre conceptos de Docker de nivel intermedio.

6. ¿Qué es un Dockerfile? Explica cómo lo escribirías.

Un Dockerfile es un script que define las instrucciones para crear una imagen de Docker. Cada comando del archivo Dockerfile configura una parte específica del entorno. Cuando ejecutamos estos comandos, Docker crea una imagen capa por capa. Así es como podemos escribirlo:

- Primero, elige una imagen base. Contiene herramientas esenciales para la aplicación.

- A continuación, especifica un directorio de trabajo dentro del contenedor. Ahí es donde se almacenarán y ejecutarán los archivos de la aplicación.

- En el tercer paso, utiliza el comando «

COPY . .» para copiar todos los archivos del proyecto en el directorio de trabajo del contenedor. - Utiliza el comando «

RUN» para instalar las dependencias. - Utiliza el comando

EXPOSEpara especificar el puerto en el que se ejecuta tu aplicación. - Ahora, define el comando que Docker debe ejecutar al iniciar el contenedor.

A continuación se muestra un ejemplo sencillo de un archivo Dockerfile para una aplicación web Python:

# Step 1: Choose a base image

FROM python:3.9-slim

# Step 2: Specify the working directory

WORKDIR /app

# Step 3: Copy project files into the container

COPY . .

# Step 4: Install dependencies

RUN pip install -r requirements.txt

# Step 5: Expose the port the app runs on

EXPOSE 5000

# Step 6: Define the default command

CMD ["python", "app.py"]Con el archivo Dockerfile anterior, puedes crear una imagen con docker build -t my-python-app . y ejecutar un contenedor con docker run -p 5000:5000 my-python-app.

7. ¿Qué es Docker Compose y en qué se diferencia de Dockerfile?

Docker Compose es una herramienta para definir y gestionar aplicaciones Docker multicontensor utilizando un archivo YAML (docker-compose.yml). Nos permite configurar servicios, redes y volúmenes en un único archivo, lo que facilita la gestión de aplicaciones complejas.

Diferencias con respecto al archivo Dockerfile:

- Un archivo Dockerfile se utiliza para crear una única imagen Docker definiendo sus capas y dependencias.

- Docker Compose se utiliza para ejecutar y coordinar varios contenedores que pueden depender unos de otros (por ejemplo, un contenedor de aplicaciones web y un contenedor de bases de datos).

Por ejemplo, un archivo docker-compose.yml podría tener el siguiente aspecto:

version: '3.9'

services:

web:

build: .

ports:

- "5000:5000"

depends_on:

- db

db:

image: postgres

volumes:

- db-data:/var/lib/postgresql/data

volumes:

db-data:Este archivo define dos servicios, web y db, con configuraciones de red y volumen.

8. ¿Por qué usamos volúmenes en Docker?

Utilizamos volúmenes Docker para mantener los datos seguros fuera de los contenedores Docker. Proporcionan una ubicación independiente en los hosts donde se almacenan los datos, incluso si se elimina el contenedor. Además, es más fácil gestionar, realizar copias de seguridad y compartir los volúmenes entre contenedores.

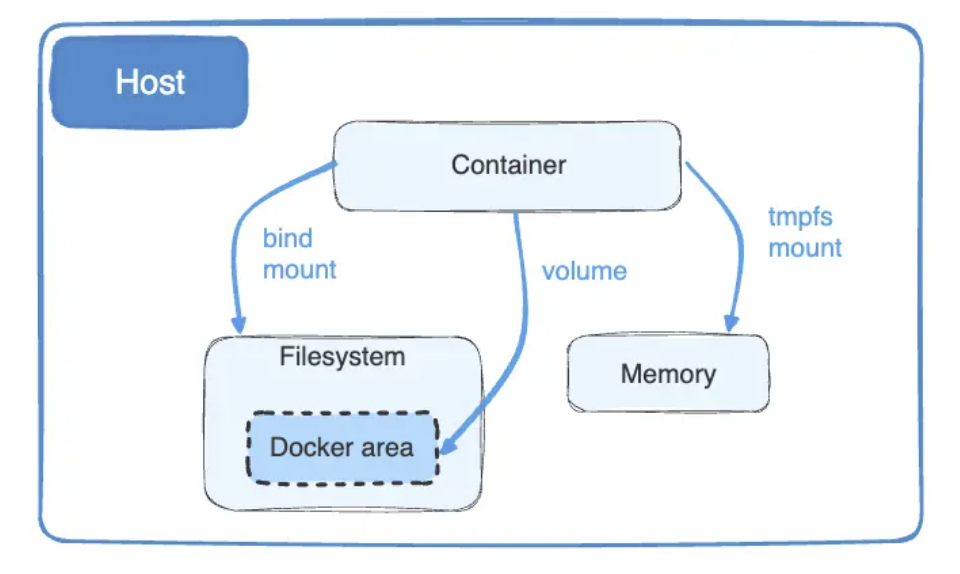

9. ¿Qué son los montajes vinculados de Docker y por qué preferís los volúmenes a los montajes vinculados?

Con los montajes vinculados de Docker, podemos compartir archivos entre la máquina host y un contenedor. Conectan un archivo específico del sistema host a una ubicación del contenedor. Si realizamos algún cambio en los archivos, aparecerá al instante dentro del contenedor.

Los montajes de Docker son adecuados para compartir archivos en tiempo real, pero dependen del sistema operativo host, lo que plantea problemas de seguridad.

Por el contrario, dado que los volúmenes de Docker funcionan de forma independiente, son más seguros que los montajes.

Diagrama de montajes y volúmenes vinculados de Docker. Fuente de la imagen: Docker

10. ¿Qué es Docker Swarm?

Docker Swarm es una herramienta de orquestación de contenedores que gestiona e implementa servicios en un clúster de nodos Docker. Permite una alta disponibilidad, escalabilidad y equilibrio de carga, lo que permite que varios hosts actúen como un único motor Docker virtual.

11. ¿Se puede escalar automáticamente Docker Swarm?

No, Docker Swarm no admite de forma nativa el autoescalado automático. Para lograr el autoescalado, necesitamos integrar herramientas de supervisión y utilizar scripts para ajustar manualmente el número de instancias. Así es como se hace:

- Instala una herramienta de supervisión, como Prometheus o Grafana, para realizar un seguimiento del uso de recursos, como la CPU y la memoria.

- Configura los desencadenantes de escalado. Por ejemplo, podemos definir que un uso de la CPU superior al 82 % activará el aumento de escala.

- A continuación, escribe un script con el comando

docker service scalepara ajustar el número de réplicas. Por ejemplo, para escalar un servicio a 5 réplicas:docker service scale =5

Al combinar herramientas de supervisión, desencadenantes y scripts, puedes implementar una forma de autoescalado en Docker Swarm, aunque no esté integrado.

12. ¿Cómo utilizarías Docker Compose para escalar servicios?

Para escalar servicios utilizando Docker Compose, puedes utilizar el indicador « --scale » con el comando « docker-compose up ». Esto se utiliza normalmente para servicios sin estado, como los servidores web. Por ejemplo, para escalar un servicio web a 3 instancias:

docker-compose up --scale web=3

Es importante asegurarse de que el archivo docker-compose.yml tenga los servicios correctamente definidos y utilice un equilibrador de carga externo o admita instancias escaladas. El escalado de servicios con estado (por ejemplo, bases de datos) requiere una configuración adicional para garantizar la coherencia de los datos.

13. ¿Puede un contenedor reiniciarse por sí solo? Define sus políticas predeterminadas y permanentes.

Sí, un contenedor puede reiniciarse por sí solo. Sin embargo, es necesario establecer una política de reinicio para eso.

Docker tiene diferentes políticas de reinicio que controlan cuándo y cómo deben reiniciarse los contenedores. La política predeterminada es no, lo que significa que un contenedor no se reiniciará si se detiene. Con la política always, Docker reiniciará automáticamente el contenedor cada vez que se detenga.

Podemos usar este comando para aplicar siempre la política:

docker run --restart=always

Preguntas avanzadas para entrevistas sobre Docker

Ahora, pasemos a las preguntas avanzadas de la entrevista sobre Docker.

14. Explica el ciclo de vida de los contenedores Docker.

Un contenedor Docker pasa por un ciclo de vida que define los estados en los que puede encontrarse un contenedor y cómo funciona en cada uno de ellos. Las etapas del ciclo de vida de un contenedor Docker son:

- Crear: En este estado, configuramos un contenedor a partir de una imagen con el comando

docker create. - Ejecutar: Aquí, utilizamos el comando «

docker start» para ejecutar el contenedor, que realiza las tareas hasta que lo detienes o lo pausas. - Pausa: Utilizamos el comando «

docker pause» para detener el proceso. Este estado mantiene intactos la memoria y el disco. Si deseas reanudar el contenedor, utiliza el comando `docker unpause`. - Detente: Si el contenedor está inactivo, entra en la fase de parada, pero esto puede ocurrir por múltiples razones:

- Parada inmediata: El comando `

docker kill` detiene el contenedor sin limpiarlo. - Finalización del proceso: Cuando el contenedor termina la tarea, se detiene automáticamente.

- Sin memoria: El contenedor se detiene cuando consume demasiada memoria.

- Eliminar: En la etapa final, eliminamos el contenedor detenido o creado con el comando

docker rm.

15. ¿Qué es un repositorio de imágenes Docker?

Un repositorio de imágenes de Docker almacena y comparte múltiples imágenes de contenedores con el mismo nombre con los clientes o la comunidad. Podemos etiquetarlos con etiquetas para diferenciar sus distintas versiones. Por ejemplo, app/marketing_campaign:v1 será la primera versión de una aplicación de marketing, y app/marketing_campaign:v2 será la segunda versión.

Docker Hub, el repositorio de imágenes Docker más popular, permite a los usuarios alojar, compartir y extraer imágenes de contenedores de forma pública o privada. Otras alternativas son Amazon ECR, Google Artifact Registry y GitHub Container Registry.

16. Cuéntame tres prácticas recomendadas para mantener seguro un contenedor Docker.

Para mejorar la seguridad de los contenedores y minimizar las vulnerabilidades comunes, sigo estas prácticas recomendadas:

- Elige imágenes ligeras: Utiliza imágenes base mínimas como Alpine para reducir la superficie de ataque.

- Limitar las llamadas al sistema: Dado que los contenedores Docker pueden acceder a llamadas innecesarias, utiliza herramientas como Seccomp para restringir estas llamadas.

- Protege los datos confidenciales: Utiliza los secretos de Docker para gestionar claves API o contraseñas. Cifran los secretos y los hacen disponibles solo durante el tiempo de ejecución.

17. ¿Por qué los contenedores Docker necesitan comprobaciones de estado?

Los contenedores Docker dependen de comprobaciones de estado para garantizar su correcto funcionamiento. Implementar un contenedor que se está ejecutando pero que no procesa solicitudes puede crear problemas para los equipos de implementación. Las comprobaciones de estado supervisan estos problemas en tiempo real y nos informan al instante.

Por ejemplo, se puede añadir una comprobación de estado en un archivo Dockerfile de la siguiente manera:

HEALTHCHECK --interval=30s --timeout=10s --retries=3 CMD curl -f http://localhost:8080/health || exit 1

Esta comprobación de estado envía un ping al punto final de estado del contenedor cada 30 segundos y marca el contenedor como no operativo si falla tres intentos consecutivos. Esta supervisión proactiva ayuda a identificar y resolver los problemas con rapidez.

18. ¿Qué son las imágenes pendientes en Docker y cómo se eliminan?

Las imágenes colgantes en Docker son capas de imágenes sin usar que ya no tienen ninguna etiqueta asociada. A menudo se acumulan cuando creas nuevas imágenes con el mismo nombre y etiqueta, dejando las capas antiguas sin referencias. Estas imágenes pueden ocupar mucho espacio en disco, por lo que es importante eliminarlas. Así es como se hace:

- Ejecuta el comando «

docker images -f dangling=true» para encontrar imágenes colgantes. - A continuación, ejecuta el comando «

docker image prune -f» para eliminar todas las imágenes de una sola vez. - Si deseas eliminar imágenes manualmente, utiliza el comando «

docker rmi -f $(docker images -f dangling=true -q)».

Estos pasos te ayudan a mantener tu sistema limpio y a liberar espacio de almacenamiento de forma eficaz.

Preguntas de entrevista sobre Docker y Kubernetes

Docker y Kubernetes suelen utilizarse juntos, por lo que no sería de extrañar que en una entrevista sobre Docker se plantearan algunas preguntas sobre Kubernetes, especialmente si el puesto está orientado a DevOps. Estas son algunas preguntas que te pueden hacer:

19. ¿Cuál es la principal diferencia entre Docker y Kubernetes?

Docker es una plataforma de contenedorización que te permite crear, enviar y ejecutar contenedores. Se centra en la creación y gestión de contenedores individuales.Kubernetes, por otro lado, es una plataforma de orquestación diseñada para gestionar múltiples contenedores a gran escala. Se encarga de la implementación, el escalado, el equilibrio de carga y la autorreparación en clústeres de nodos.

Más información sobre las diferencias entre Kubernetes y Docker en la entrada del blog.

20. Compara Docker Swarm con Kubernetes.

Kubernetes y Docker Swarm gestionan contenedores, pero funcionan de manera diferente:

- Kubernetes gestiona configuraciones de contenedores grandes y complejas. Sus funciones de autorreparación y supervisión integrada lo convierten en una opción más adecuada para entornos complejos.

- Docker Swarm es adecuado para configuraciones más pequeñas o menos complejas, ya que no ofrece ninguna función integrada como Kubernetes. Podemos integrarlo fácilmente con herramientas de Docker como Docker CLI y Docker Compose.

21. ¿Cómo gestiona Kubernetes un gran número de contenedores Docker?

Aunque Docker es ideal para crear y ejecutar contenedores, para gestionar un gran número de ellos se necesita Kubernetes. Kubernetes coordina los contenedores de manera eficiente mediante:

- Configuración de límites de recursos: Asigna CPU, memoria y otros recursos a cada contenedor para evitar el consumo excesivo.

- Programación de contenedores: Kubernetes decide dónde ejecutar cada contenedor, optimizando la utilización de los recursos en todos los nodos de un clúster.

- Escalado automático: En función de la demanda de carga de trabajo, amplía o reduce los pods (grupos de uno o más contenedores) para mantener el rendimiento y la eficiencia.

Al automatizar estos procesos, Kubernetes garantiza un funcionamiento fluido, incluso cuando se gestionan miles de contenedores. Aunque pueden producirse errores ocasionales, sus capacidades de autorreparación, como el reinicio de contenedores defectuosos, minimizan las interrupciones.

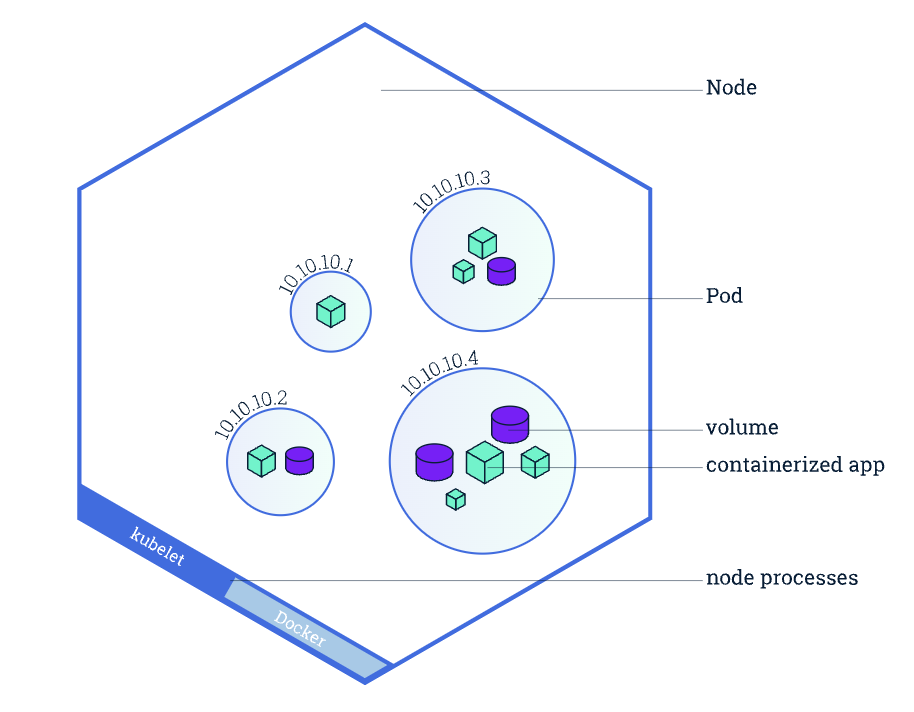

22. ¿Qué es un pod en Kubernetes y en qué se diferencia de un contenedor?

Un pod es la unidad más pequeña que se puede implementar en Kubernetes y representa un grupo de uno o más contenedores que comparten el mismo espacio de nombres de red, almacenamiento y configuración.A diferencia de los contenedores individuales, los pods permiten que varios contenedores estrechamente vinculados trabajen juntos como una sola unidad (por ejemplo, un servidor web y un contenedor de registro sidecar).

Descripción general de un nodo de Kubernetes, con especial atención a los pods y contenedores. Fuente de la imagen: Kubernetes.

23. ¿Cómo puedes gestionar datos confidenciales como contraseñas en Docker y Kubernetes?

- En Docker: Podemos utilizar secretos de Docker, que cifran los datos confidenciales y solo permiten el acceso a contenedores autorizados en tiempo de ejecución.

- En Kubernetes: Utilizamos objetos Secrets, que almacenan datos confidenciales como contraseñas, tokens y claves API. Los secretos se pueden montar como volúmenes o exponer como variables de entorno a los pods de forma segura.

Ejemplo en Kubernetes:

apiVersion: v1

kind: Secret

metadata:

name: my-secret

type: Opaque

data:

password: cGFzc3dvcmQ= # Base64-encoded "password"Preguntas de entrevista sobre Docker basadas en escenarios

El entrevistador formula preguntas basadas en situaciones hipotéticas y en la resolución de problemas para evaluar cómo abordas los problemas del mundo real. Veamos algunas preguntas para que te hagas una idea:

24. Imagina que estás creando una imagen de una API basada en Maven. Ya has configurado el archivo Dockerfile con las configuraciones básicas. Ahora, observas que el tamaño de la imagen es grande. ¿Cómo lo reducirías?

Ejemplo de respuesta:

Para reducir el tamaño de una imagen Docker para una API basada en Maven, seguiría estos pasos:

Crea un archivo .dockerignore en el directorio del proyecto para especificar los archivos y carpetas que no deben incluirse en el contexto de compilación de Docker. Esto evita que se añadan archivos innecesarios a la imagen, reduciendo así su tamaño. Por ejemplo, añadiría lo siguiente a .dockerignore:

.git # Version control files

target # Compiled code and build artifacts

.idea # IDE configuration filesOptimiza el archivo Dockerfile utilizando compilaciones multietapa. Crearía el proyecto Maven en una etapa y copiaría solo los artefactos necesarios (por ejemplo, archivos JAR compilados) en la etapa final para mantener el tamaño de la imagen reducido. Ejemplo de Dockerfile con compilación en varias etapas:

# Stage 1: Build the application

FROM maven:3.8.5-openjdk-11 AS build

WORKDIR /app

COPY pom.xml .

COPY src ./src

RUN mvn clean package

# Stage 2: Create a lightweight runtime image

FROM openjdk:11-jre-slim

WORKDIR /app

COPY --from=build /app/target/my-api.jar .

CMD ["java", "-jar", "my-api.jar"]Al ignorar los archivos innecesarios y utilizar compilaciones en varias etapas, se puede reducir considerablemente el tamaño de la imagen sin perder eficiencia.

25. Imagina que necesitas enviar una imagen de contenedor Docker al Docker Hub con Jenkins. ¿Cómo lo harías?

Ejemplo de respuesta:

Así es como enviaría una imagen de contenedor Docker a Docker Hub con Jenkins:

- Configura un pipeline de Jenkins: Crea un trabajo de canalización de múltiples ramas en Jenkins y vincúlalo al repositorio que contiene el archivo Dockerfile y Jenkinsfile.

- Define el proceso en tu Jenkinsfile: El proceso de gestión de la calidad (

Jenkinsfile) incluiría los siguientes pasos: - Crear la imagen de Docker

- Inicia sesión en Docker Hub (utilizando las credenciales almacenadas de forma segura en Jenkins).

- Envía la imagen a Docker Hub.

- Ejecuta el proceso: Activa la tarea de Jenkins. Creará la imagen, iniciará sesión en Docker Hub y enviará la imagen automáticamente.

26. Imagina que tienes que migrar un contenedor Docker de WordPress a un nuevo servidor sin perder ningún dato. ¿Cómo lo harías?

Ejemplo de respuesta:

Así es como migraría un contenedor Docker de WordPress:

- Haz una copia de seguridad de los datos de WordPress: Exporta los datos persistentes del contenedor (archivos y base de datos de WordPress). Yo utilizaría

docker cpo una herramienta de copia de seguridad de volúmenes para hacer una copia de seguridad de los volúmenes necesarios, normalmente el directoriohtmlpara los archivos de WordPress y el volumen de la base de datos. - Transfiere los archivos de copia de seguridad: Yo utilizaría

scppara copiar de forma segura los archivos de copia de seguridad al nuevo servidor. - Configura WordPress en el nuevo servidor: Implementaría un nuevo contenedor de WordPress y un contenedor de base de datos en el nuevo servidor.

- Reinicia y verifica: Por último, reiniciaría los contenedores para aplicar los cambios y comprobaría que el sitio de WordPress funciona correctamente.

Al realizar una copia de seguridad de los volúmenes y restaurarlos en un nuevo servidor, es posible migrar WordPress sin perder datos. Este método evita depender de extensiones específicas y proporciona un mayor control sobre el proceso de migración.

Consejos para prepararse para una entrevista de trabajo en Docker

Si estás leyendo esta guía, ¡ya has dado un paso importante para destacar en tu próxima entrevista! Pero para los principiantes, prepararse para una entrevista puede resultar abrumador. Por eso he recopilado algunos consejos:

Domina los conceptos básicos de Docker.

Para destacar en una entrevista sobre Docker, empieza por adquirir un conocimiento sólido de sus conceptos básicos.

- Descubre cómo las imágenes de Docker sirven como modelo para los contenedores y practica la creación, ejecución y gestión de contenedores para familiarizarte con sus entornos ligeros y aislados.

- Explora los volúmenes de Docker para gestionar los datos persistentes de forma eficaz y sumérgete en las redes experimentando con redes puente, host y superpuestas para facilitar la comunicación entre contenedores.

- Estudia los archivos Dockerfiles para comprender cómo se crean las imágenes, centrándote en instrucciones clave como

FROM,RUNyCMD. - Además, practica con Docker Compose para gestionar aplicaciones multicontensor y comprender cómo los registros de Docker, como Docker Hub, almacenan y comparten imágenes.

DataCamp ofrece muchos otros recursos para guiarte a lo largo de tu proceso de aprendizaje:

- Para conceptos introductorios sobre Docker: Curso de introducción a Docker

- Para conceptos intermedios de Docker: Curso intermedio de Docker

- Para aprender sobre contenedorización y virtualización: Curso sobre conceptos de contenedorización y virtualización

Adquiere experiencia práctica con Docker.

Una vez que hayas aprendido los conceptos básicos de Docker, es hora de ponerte a prueba con algunos ejercicios prácticos. Aquí tienes 10 excelentes ideas de proyectos Docker para principiantes y usuarios más avanzados. Cuando trabajes en estos proyectos, utiliza la hoja de referencia de Docker de DataCamp para tener a mano los comandos clave.

Documenta tu experiencia

Prepárate para hablar sobre tu experiencia con Docker en las entrevistas. Prepara ejemplos de:

- Proyectos: Destaca las aplicaciones Dockerizadas que has creado o en las que has colaborado.

- Desafíos: Describe los problemas que encontraste, como la depuración de contenedores o la optimización de imágenes, y cómo los resolviste.

- Optimización: Comparte cómo has mejorado los tiempos de compilación, reducido el tamaño de las imágenes u optimizado los flujos de trabajo con Docker Compose.

- Colaboración: Si has trabajado en equipo, explica cómo utilizaste Docker para mejorar los procesos de colaboración, pruebas o implementación.

¡Tus ejemplos del mundo real demostrarán tus conocimientos prácticos y tu capacidad para resolver problemas!

Conclusión

Mientras te preparas para la entrevista, recuerda que estas preguntas son solo un punto de partida. Aunque memorizar respuestas puede ayudar, los entrevistadores valoran a los candidatos que pueden demostrar experiencia práctica y un profundo conocimiento de los conceptos de contenedorización. Debes practicar la aplicación de estos conceptos en situaciones reales y desarrollar tus proyectos.

Si eres principiante, comienza con nuestro curso Introducción a Docker. Al final, el éxito en tu entrevista vendrá de la combinación de conocimientos teóricos con experiencia práctica y la capacidad de expresar tu enfoque para resolver problemas.

Desarrolla hoy tus habilidades MLOps

Preguntas frecuentes

¿Es necesario aprender Kubernetes para utilizar Docker?

No, no es necesario aprender Kubernetes para usar Docker. Docker hace un trabajo completamente diferente al de Kubernetes. Se utiliza para crear, ejecutar y gestionar contenedores en una sola máquina.

¿Se necesita saber programar para usar Docker?

No, no necesitas conocimientos de programación para utilizar Docker. Para realizar la mayoría de las tareas, basta con saber trabajar con los conceptos básicos de la línea de comandos, los archivos YAML y la documentación de Docker. Pero debes aprender cómo funcionan los comandos y las redes de Linux.

¿Cuánto tiempo se necesita para prepararse para la entrevista de Docker?

Si te dedicas por completo, prepararte para una entrevista de Docker puede llevarte entre tres y cuatro semanas. Dedica al menos una semana a aprender los conceptos básicos de Docker. A continuación, pasa a Docker Compose y a las configuraciones multicontensor. En las últimas dos semanas, céntrate en las compilaciones multietapa y la optimización de contenedores. Además, crea un portafolio con ejemplos del mundo real.

Soy una estratega de contenidos a la que le encanta simplificar temas complejos. He ayudado a empresas como Splunk, Hackernoon y Tiiny Host a crear contenidos atractivos e informativos para su público.