Cursus

Docker est devenu l'outil de conteneurisation le plus populaire dans le développement logiciel moderne, en particulier dans les workflows DevOps et CI/CD. Il simplifie le déploiement et la gestion des applications grâce à des conteneurs, ce qui permet de fournir des logiciels rapidement et de manière cohérente.

Sa scalabilité et sa flexibilité font de Docker un outil indispensable pour les postes liés aux données, tels que l'ingénierie des données, le MLOps et même la science des données. C'est pourquoi j'ai compilé les questions fréquemment posées lors des entretiens d'embauche liés à Docker, couvrant les concepts fondamentaux et les scénarios concrets.

Devenez ingénieur en données

Qu'est-ce que Docker ?

Docker est une plateforme de conteneurs que les développeurs utilisent pour regrouper des applications avec toutes leurs dépendances afin qu'elles puissent fonctionner correctement dans différents environnements.

Bien que les conteneurs partagent le même noyau de système d'exploitation, chacun fonctionne dans son propre environnement isolé. Cette configuration minimise les problèmes de compatibilité, réduit les retards et améliore la communication entre les équipes de développement, de test et d'exploitation.

Logo Docker. Source de l'image

En 2023, Docker était leader sur le marché de la conteneurisation avec plus de 32 % de parts de marché. Cela souligne son importance dans le développement logiciel moderne. C'est pourquoi vous pouvez vous attendre à ce que les recruteurs évaluent votre expertise en matière de Docker lors d'entretiens d'embauche liés aux données.

Questions d'entretien de base sur Docker

Tout d'abord, familiarisez-vous avec certains concepts fondamentaux de Docker. Ces questions fondamentales vous aideront à approfondir votre compréhension et à vous préparer pour la phase initiale de l'entretien.

1. Qu'est-ce qu'une image Docker ?

Une image Docker est comparable à un plan qui permet de créer des conteneurs. Il contient tous les éléments nécessaires à un développeur pour exécuter une application, notamment :

- Code

- Bibliothèques

- Paramètres

Lorsque vous utilisez une image Docker, Docker la transforme en conteneur, qui est un environnement entièrement isolé. C'est là que l'application fonctionne de manière autonome.

2. Qu'est-ce qu'un hôte Docker ?

Un hôte Docker est le système sur lequel nous installons Docker. Il sert d'environnement principal pour l'exécution et la gestion des conteneurs Docker. Nous pouvons configurer un hôte Docker sur un appareil local ou dans un environnement virtuel ou cloud.

3. En quoi un client Docker diffère-t-il d'un démon Docker ? Pourriez-vous nous donner un exemple ?

Le client Docker et le démon Docker fonctionnent en parallèle, mais ont des rôles distincts. Le client Docker est l'outil qui envoie les commandes et le démon Docker est le moteur qui exécute ces commandes.

Par exemple, si nous saisissons la commande docker run pour démarrer un conteneur, le client prendra la requête et l'enverra au démon Docker. Le démon Docker se chargera ensuite du travail réel en démarrant le conteneur.

4. Pourriez-vous expliquer ce qu'est le réseau Docker et quelles commandes permettent de créer un pont et un réseau superposé ?

Le réseau Docker permet aux conteneurs de se connecter et de communiquer avec d'autres conteneurs et hôtes. La commande ` docker network create ` nous permet de configurer des réseaux définis par l'utilisateur.

- Réseau de ponts: Crée un réseau local pour la communication entre les conteneurs sur le même hôte Docker.

- Commande :

docker network create -d bridge my-bridge-network - Cela configure un réseau pont appelé

my-bridge-networkpour les conteneurs sur le même hôte. - Réseau superposé: Permet la communication entre les conteneurs sur plusieurs hôtes Docker, souvent utilisée dans une configuration Swarm.

- Commande :

docker network create --scope=swarm --attachable -d overlay my-multihost-network - Cela crée un réseau superposé connectable appelé «

my-multihost-network» pour les conteneurs fonctionnant sur différents hôtes dans un Docker Swarm.

5. Veuillez expliquer le fonctionnement du réseau pont Docker.

Le pont réseau est la configuration par défaut utilisée par Docker pour connecter les conteneurs. Si nous ne spécifions pas de réseau, Docker le relie au réseau bridge. Ce pont relie tous les conteneurs sur le même hôte Docker. Chaque conteneur dispose d'une adresse IP unique, ce qui permet aux conteneurs de communiquer directement entre eux.

Questions d'entretien intermédiaire sur Docker

Ces questions sont posées afin d'évaluer votre connaissance des concepts Docker de niveau intermédiaire.

6. Qu'est-ce qu'un fichier Dockerfile ? Veuillez expliquer comment vous l'écririez.

Un fichier Dockerfile est un script qui définit les instructions pour créer une image Docker. Chaque commande du fichier Dockerfile configure une partie spécifique de l'environnement. Lorsque nous exécutons ces commandes, Docker construit une image couche par couche. Voici comment nous pouvons l'écrire :

- Tout d'abord, veuillez sélectionner une image de base. Il contient les outils essentiels pour l'application.

- Ensuite, veuillez définir un répertoire de travail à l'intérieur du conteneur. C'est là que les fichiers de l'application seront stockés et exécutés.

- Dans la troisième étape, veuillez utiliser la commande

COPY . .pour copier tous les fichiers du projet dans le répertoire de travail du conteneur. - Veuillez utiliser la commande «

RUN» pour installer les dépendances. - Veuillez utiliser la commande `

EXPOSE` pour indiquer le port sur lequel votre application est exécutée. - Veuillez maintenant définir la commande que Docker doit exécuter lorsqu'il démarre le conteneur.

Voici un exemple simple de fichier Dockerfile pour une application web Python :

# Step 1: Choose a base image

FROM python:3.9-slim

# Step 2: Specify the working directory

WORKDIR /app

# Step 3: Copy project files into the container

COPY . .

# Step 4: Install dependencies

RUN pip install -r requirements.txt

# Step 5: Expose the port the app runs on

EXPOSE 5000

# Step 6: Define the default command

CMD ["python", "app.py"]À l'aide du fichier Dockerfile ci-dessus, vous pouvez créer une image avec la commande ` docker build -t my-python-app . ` et exécuter un conteneur avec la commande ` docker run -p 5000:5000 my-python-app`.

7. Qu'est-ce que Docker Compose et en quoi diffère-t-il de Dockerfile ?

Docker Compose est un outil permettant de définir et de gérer des applications Docker multi-conteneurs à l'aide d'un fichier YAML (docker-compose.yml). Il nous permet de configurer les services, les réseaux et les volumes dans un seul fichier, ce qui facilite la gestion des applications complexes.

Différences par rapport au fichier Dockerfile :

- Un fichier Dockerfile est utilisé pour créer une image Docker unique en définissant ses couches et ses dépendances.

- Docker Compose est utilisé pour exécuter et orchestrer plusieurs conteneurs qui peuvent dépendre les uns des autres (par exemple, un conteneur d'application web et un conteneur de base de données).

Par exemple, un fichier docker-compose.yml pourrait se présenter comme suit :

version: '3.9'

services:

web:

build: .

ports:

- "5000:5000"

depends_on:

- db

db:

image: postgres

volumes:

- db-data:/var/lib/postgresql/data

volumes:

db-data:Ce fichier définit deux services, web et db, avec des configurations réseau et de volume.

8. Pourquoi utilisons-nous des volumes dans Docker ?

Nous utilisons les volumes Docker pour assurer la sécurité des données en dehors des conteneurs Docker. Ils fournissent un emplacement distinct sur les hôtes où les données sont conservées même si le conteneur est supprimé. De plus, il est plus facile de gérer, de sauvegarder et de partager les volumes entre les conteneurs.

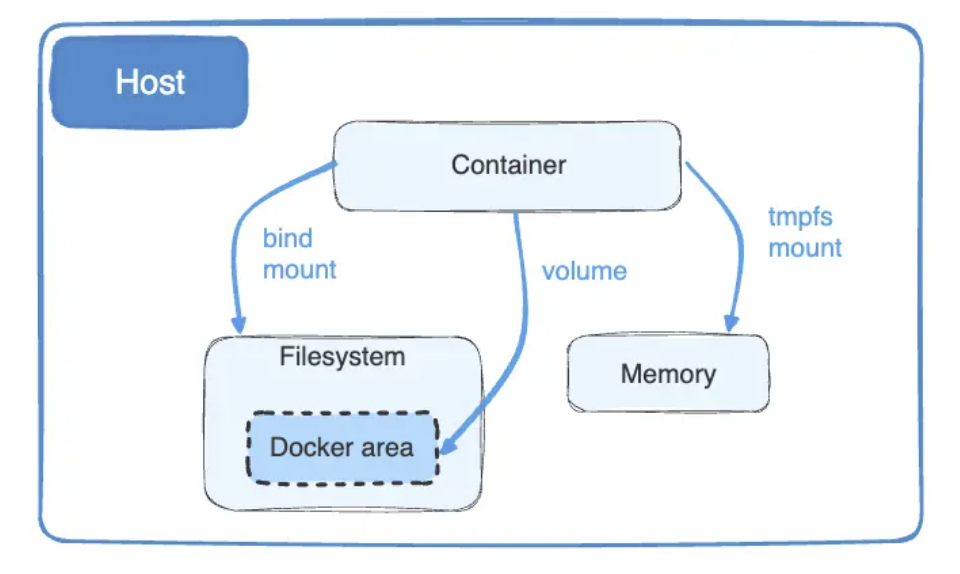

9. Que sont les montages liés Docker et pourquoi privilégions-nous les volumes aux montages liés ?

Grâce aux montages liés Docker, il est possible de partager des fichiers entre la machine hôte et un conteneur. Ils relient un fichier spécifique sur le système hôte à un emplacement dans le conteneur. Si nous apportons des modifications aux fichiers, elles apparaîtront immédiatement dans le conteneur.

Les montages Docker sont adaptés au partage de fichiers en temps réel, mais ils dépendent du système d'exploitation hôte, ce qui soulève des questions de sécurité.

Au contraire, comme les volumes Docker fonctionnent de manière indépendante, ils sont plus sécurisés que les montages.

Schéma des montages et volumes Docker Bind. Source de l'image : Docker

10. Qu'est-ce que Docker Swarm ?

Docker Swarm est un outil d'orchestration de conteneurs qui gère et déploie des services sur un cluster de nœuds Docker. Il offre une haute disponibilité, une évolutivité et un équilibrage de charge, permettant à plusieurs hôtes d'agir comme un seul moteur Docker virtuel.

11. Est-il possible de mettre en place une mise à l'échelle automatique de Docker Swarm ?

Non, Docker Swarm ne prend pas en charge de manière native la mise à l'échelle automatique. Pour réaliser l'autoscaling, il est nécessaire d'intégrer des outils de surveillance et d'utiliser des scripts pour ajuster manuellement le nombre d'instances. Voici comment procéder :

- Veuillez installer un outil de surveillance, tel que Prometheus ou Grafana, afin de suivre l'utilisation des ressources, telles que le processeur et la mémoire.

- Veuillez définir les déclencheurs de mise à l'échelle. Par exemple, nous pouvons définir qu'une utilisation du processeur supérieure à 82 % déclenchera une augmentation de la capacité.

- Ensuite, veuillez rédiger un script à l'aide de la commande

docker service scalepour ajuster le nombre de répliques. Par exemple, pour faire évoluer un service vers 5 répliques :docker service scale =5

En combinant des outils de surveillance, des déclencheurs et des scripts, il est possible de mettre en œuvre une forme d'autoscaling dans Docker Swarm, même si cette fonctionnalité n'est pas intégrée.

12. Comment utiliseriez-vous Docker Compose pour faire évoluer les services ?

Pour faire évoluer les services à l'aide de Docker Compose, nous pouvons utiliser le drapeau ` --scale ` avec la commande ` docker-compose up `. Ceci est généralement utilisé pour les services sans état tels que les serveurs web. Par exemple, pour faire évoluer un service Web vers 3 instances :

docker-compose up --scale web=3

Il est essentiel de s'assurer que le fichier docker-compose.yml définit correctement les services et utilise un équilibreur de charge externe ou prend en charge les instances à échelle variable. La mise à l'échelle des services avec état (par exemple, les bases de données) nécessite une configuration supplémentaire afin de garantir la cohérence des données.

13. Un conteneur peut-il redémarrer de lui-même ? Définissez ses politiques par défaut et permanentes.

Oui, un conteneur peut redémarrer de manière autonome. Cependant, il est nécessaire de définir une politique de redémarrage à cet effet.

Docker dispose de différentes politiques de redémarrage qui déterminent quand et comment les conteneurs doivent redémarrer. La politique par défaut est « non », ce qui signifie qu'un conteneur ne redémarrera pas s'il s'arrête. Avec la politique « always », Docker redémarrera automatiquement le conteneur chaque fois qu'il s'arrête.

Nous pouvons utiliser cette commande pour appliquer la politique « toujours » :

docker run --restart=always

Questions d'entretien avancées sur Docker

Passons maintenant aux questions d'entretien avancées sur Docker.

14. Veuillez expliquer le cycle de vie des conteneurs Docker.

Un conteneur Docker suit un cycle de vie qui définit les états dans lesquels il peut se trouver et son fonctionnement dans ces états. Les étapes du cycle de vie d'un conteneur Docker sont les suivantes :

- Créer : Dans cet état, nous configurons un conteneur à partir d'une image à l'aide de la commande

docker create. - Exécuter: Ici, nous utilisons la commande

docker startpour exécuter le conteneur, qui effectue les tâches jusqu'à ce que nous l'arrêtions ou le mettions en pause. - Pause: Nous utilisons la commande «

docker pause» pour interrompre le processus. Cet état préserve la mémoire et le disque. Si vous souhaitez redémarrer le conteneur, veuillez utiliser la commandedocker unpause. - Arrêt: Si le conteneur est inactif, il entre en phase d'arrêt, mais cela peut se produire pour plusieurs raisons :

- Arrêt immédiat: La commande `

docker kill` arrête le conteneur sans nettoyage. - Achèvement du processus: Une fois la tâche terminée, le conteneur s'arrête automatiquement.

- Mémoire insuffisante: Le conteneur s'arrête lorsqu'il utilise une quantité excessive de mémoire.

- Supprimer: Dans la dernière étape, nous supprimons le conteneur arrêté ou créé à l'aide de la commande

docker rm.

15. Qu'est-ce qu'un référentiel d'images Docker ?

Un référentiel d'images Docker stocke et partage plusieurs images de conteneurs portant le même nom avec les clients ou la communauté. Nous pouvons les étiqueter à l'aide de balises afin de distinguer leurs différentes versions. Par exemple, app/marketing_campaign:v1 sera la première version d'une application marketing, et app/marketing_campaign:v2 sera la deuxième version.

Docker Hub, le référentiel d'images Docker le plus populaire, permet aux utilisateurs d'héberger, de partager et de récupérer des images de conteneurs de manière publique ou privée. D'autres alternatives incluent Amazon ECR, Google Artifact Registry et GitHub Container Registry.

16. Veuillez me présenter trois bonnes pratiques pour assurer la sécurité d'un conteneur Docker.

Afin de renforcer la sécurité des conteneurs et de minimiser les vulnérabilités courantes, je respecte les meilleures pratiques suivantes :

- Veuillez sélectionner des images légères: Veuillez utiliser des images de base minimales telles qu'Alpine afin de réduire la surface d'attaque.

- Limiter les appels système: Étant donné que les conteneurs Docker peuvent accéder à des appels non nécessaires, il est recommandé d'utiliser des outils tels que Seccomp pour limiter ces appels.

- Sécurisez les données sensibles: Veuillez utiliser les secrets Docker pour gérer les clés API ou les mots de passe. Ils cryptent les secrets et ne les rendent accessibles que pendant l'exécution.

17. Pourquoi les conteneurs Docker nécessitent-ils des contrôles de santé ?

Les conteneurs Docker dépendent de contrôles de santé pour garantir leur bon fonctionnement. Le déploiement d'un conteneur qui est en cours d'exécution mais qui ne traite pas les demandes peut poser des problèmes aux équipes de déploiement. Les contrôles de santé surveillent ces problèmes en temps réel et nous informent immédiatement.

Par exemple, un contrôle de santé peut être ajouté dans un fichier Dockerfile comme suit :

HEALTHCHECK --interval=30s --timeout=10s --retries=3 CMD curl -f http://localhost:8080/health || exit 1

Ce contrôle de santé interroge le point de terminaison de santé du conteneur toutes les 30 secondes et marque le conteneur comme non fonctionnel s'il échoue à trois tentatives consécutives. Cette surveillance proactive permet d'identifier et de résoudre rapidement les problèmes.

18. Que sont les images suspendues dans Docker et comment peut-on les supprimer ?

Les images suspendues dans Docker sont des couches d'images inutilisées qui ne sont plus associées à aucune balise. Ils s'accumulent souvent lorsque vous créez de nouvelles images avec le même nom et la même balise, laissant les anciens calques sans références. Ces images peuvent occuper un espace disque important, il est donc essentiel de les supprimer. Voici comment procéder :

- Veuillez exécuter la commande

docker images -f dangling=truepour identifier les images en suspens. - Ensuite, veuillez exécuter la commande

docker image prune -fpour supprimer toutes les images en une seule fois. - Si vous souhaitez supprimer des images manuellement, veuillez utiliser la commande

docker rmi -f $(docker images -f dangling=true -q).

Ces étapes contribuent à maintenir votre système propre et à libérer efficacement de l'espace de stockage.

Questions d'entretien sur Docker et Kubernetes

Docker et Kubernetes sont souvent utilisés conjointement, il n'est donc pas surprenant de rencontrer des questions relatives à Kubernetes lors d'un entretien d'embauche pour un poste chez Docker, en particulier si le poste est orienté DevOps. Voici quelques questions qui pourraient vous être posées :

19. Quelle est la principale différence entre Docker et Kubernetes ?

Docker est une plateforme de conteneurisation qui permet de créer, d'expédier et d'exécuter des conteneurs. Il se concentre sur la création et la gestion de conteneurs individuels.Kubernetes, quant à lui, est une plateforme d'orchestration conçue pour gérer plusieurs conteneurs à grande échelle. Il gère le déploiement, la mise à l'échelle, l'équilibrage de charge et l'auto-réparation à travers des clusters de nœuds.

Pour en savoir plus sur les différences entre Kubernetes et Docker, veuillez consulter l'article de blog.

20. Veuillez comparer Docker Swarm et Kubernetes.

Kubernetes et Docker Swarm gèrent les conteneurs, mais fonctionnent différemment :

- Kubernetes gère des configurations de conteneurs volumineuses et complexes. Ses fonctionnalités d'auto-réparation et de surveillance intégrée en font une option plus adaptée aux environnements complexes.

- Docker Swarm convient aux configurations plus petites ou moins complexes, car il n'offre pas de fonctionnalités intégrées comme Kubernetes. Nous pouvons facilement l'intégrer à des outils Docker tels que Docker CLI et Docker Compose.

21. Comment Kubernetes gère-t-il un grand nombre de conteneurs Docker ?

Bien que Docker soit un excellent outil pour créer et exécuter des conteneurs, la gestion d'un grand nombre d'entre eux nécessite l'utilisation de Kubernetes. Kubernetes coordonne efficacement les conteneurs en :

- Définition des limites de ressources: Il alloue le CPU, la mémoire et d'autres ressources à chaque conteneur afin d'éviter toute surconsommation.

- Planification des conteneurs: Kubernetes détermine où exécuter chaque conteneur, optimisant ainsi l'utilisation des ressources sur l'ensemble des nœuds d'un cluster.

- Mise à l'échelle automatique: En fonction de la charge de travail, il augmente ou diminue le nombre de pods (groupes d'un ou plusieurs conteneurs) afin de maintenir les performances et l'efficacité.

En automatisant ces processus, Kubernetes garantit un fonctionnement fluide, même lors de la gestion de milliers de conteneurs. Bien que des erreurs occasionnelles puissent survenir, ses capacités d'auto-réparation, telles que le redémarrage des conteneurs défaillants, minimisent les perturbations.

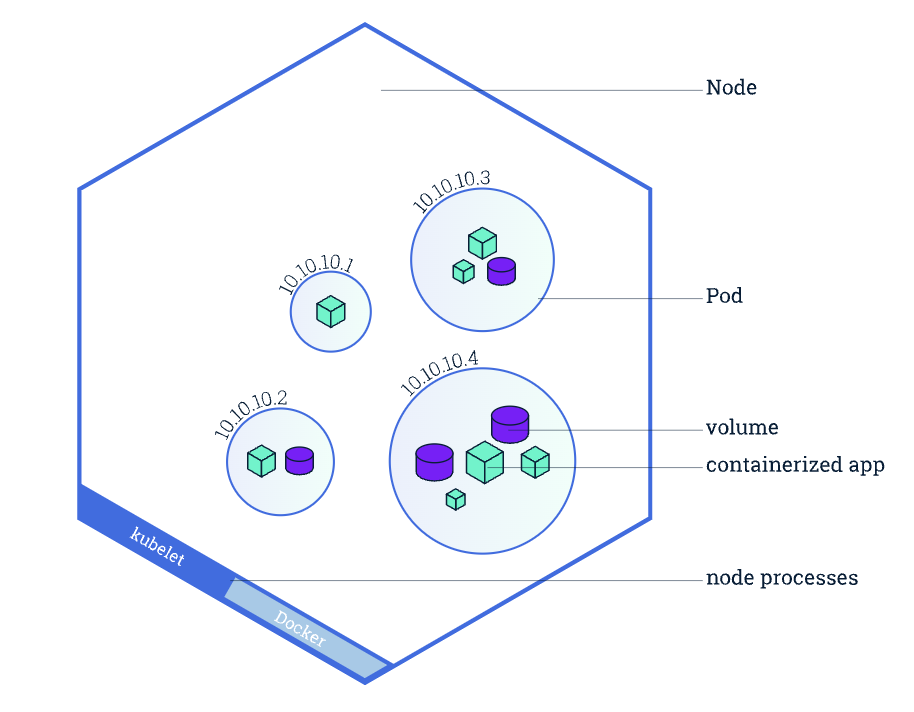

22. Qu'est-ce qu'un pod dans Kubernetes et en quoi diffère-t-il d'un conteneur ?

Un pod est la plus petite unité déployable dans Kubernetes et représente un groupe d'un ou plusieurs conteneurs qui partagent le même espace de noms réseau, le même stockage et la même configuration.Contrairement aux conteneurs individuels, les pods permettent à plusieurs conteneurs étroitement liés de fonctionner ensemble comme une seule unité (par exemple, un serveur web et un conteneur de journalisation sidecar).

Présentation d'un nœud Kubernetes, mettant en évidence les pods et les conteneurs. Source de l'image : Kubernetes.

23. Comment pouvez-vous gérer les données sensibles telles que les mots de passe dans Docker et Kubernetes ?

- Dans Docker : Nous pouvons utiliser les secrets Docker, qui chiffrent les données sensibles et les rendent accessibles uniquement aux conteneurs autorisés lors de l'exécution.

- Dans Kubernetes : Nous utilisons des objets Secrets, qui stockent des données sensibles telles que des mots de passe, des jetons et des clés API. Les secrets peuvent être montés en tant que volumes ou exposés en tant que variables d'environnement aux pods de manière sécurisée.

Exemple dans Kubernetes :

apiVersion: v1

kind: Secret

metadata:

name: my-secret

type: Opaque

data:

password: cGFzc3dvcmQ= # Base64-encoded "password"Questions d'entretien sur Docker basées sur des scénarios

L'intervieweur pose des questions basées sur des scénarios et axées sur la résolution de problèmes afin d'évaluer votre approche face à des situations réelles. Veuillez examiner quelques questions pour vous donner une idée :

24. Veuillez imaginer que vous créez une image d'une API basée sur Maven. Vous avez déjà configuré le fichier Dockerfile avec les paramètres de base. Vous remarquerez que la taille de l'image est importante. Comment pourriez-vous le réduire ?

Exemple de réponse :

Pour réduire la taille d'une image Docker pour une API basée sur Maven, je suivrais les étapes suivantes :

Veuillez créer un fichier .dockerignore dans le répertoire du projet afin de spécifier les fichiers et dossiers qui ne doivent pas être inclus dans le contexte de construction Docker. Cela empêche l'ajout de fichiers inutiles à l'image, réduisant ainsi sa taille. Par exemple, j'ajouterais ce qui suit à .dockerignore:

.git # Version control files

target # Compiled code and build artifacts

.idea # IDE configuration filesOptimisez le fichier Dockerfile à l'aide de builds multi-étapes. Je construirais le projet Maven en une seule étape et ne copierais que les artefacts nécessaires (par exemple, les fichiers JAR compilés) dans l'étape finale afin de conserver une image de petite taille. Exemple de fichier Dockerfile avec compilation en plusieurs étapes :

# Stage 1: Build the application

FROM maven:3.8.5-openjdk-11 AS build

WORKDIR /app

COPY pom.xml .

COPY src ./src

RUN mvn clean package

# Stage 2: Create a lightweight runtime image

FROM openjdk:11-jre-slim

WORKDIR /app

COPY --from=build /app/target/my-api.jar .

CMD ["java", "-jar", "my-api.jar"]En ignorant les fichiers inutiles et en utilisant des compilations en plusieurs étapes, il est possible de réduire considérablement la taille de l'image tout en conservant son efficacité.

25. Veuillez imaginer que vous devez transférer une image de conteneur Docker vers Docker Hub à l'aide de Jenkins. Comment procéderiez-vous ?

Exemple de réponse :

Voici comment je procéderais pour transférer une image de conteneur Docker vers Docker Hub avec Jenkins :

- Veuillez configurer un pipeline Jenkins: Veuillez créer une tâche de pipeline multi-branches dans Jenkins et la relier au référentiel contenant le fichier Dockerfile et le fichier Jenkinsfile.

- Définir le pipeline dans mon fichier Jenkinsfile: Le processus de planification stratégique (

Jenkinsfile) comprendrait les étapes suivantes : - Créer l'image Docker

- Veuillez vous connecter à Docker Hub (en utilisant les identifiants stockés de manière sécurisée dans Jenkins).

- Veuillez transférer l'image vers Docker Hub.

- Veuillez exécuter le pipeline: Veuillez déclencher la tâche Jenkins. Il créera l'image, se connectera à Docker Hub et poussera automatiquement l'image.

26. Veuillez imaginer que vous devez migrer un conteneur Docker WordPress vers un nouveau serveur sans perdre aucune donnée. Comment procéderiez-vous ?

Exemple de réponse :

Voici comment je procéderais pour migrer un conteneur Docker WordPress :

- Veuillez sauvegarder les données WordPress à l': Veuillez exporter les données persistantes du conteneur (fichiers WordPress et base de données). Je recommanderais d'utiliser

docker cpou un outil de sauvegarde de volume pour sauvegarder les volumes nécessaires, généralement le répertoirehtmlpour les fichiers WordPress et le volume de la base de données. - Veuillez transférer les fichiers de sauvegarde à l'adresse suivante :: Je recommanderais d'utiliser

scppour transférer de manière sécurisée les fichiers de sauvegarde vers le nouveau serveur. - Veuillez installer WordPress sur le nouveau serveur: Je déploierais un nouveau conteneur WordPress et un conteneur de base de données sur le nouveau serveur.

- Veuillez redémarrer et vérifier l'. Enfin, je redémarrerais les conteneurs afin d'appliquer les modifications et vérifierais que le site WordPress fonctionne correctement.

En sauvegardant les volumes et en les restaurant sur un nouveau serveur, il est possible de migrer WordPress sans perte de données. Cette méthode évite de dépendre d'extensions spécifiques et offre un meilleur contrôle sur le processus de migration.

Conseils pour se préparer à un entretien d'embauche chez Docker

Si vous lisez ce guide, vous avez déjà franchi une étape importante pour réussir votre prochain entretien. Cependant, pour les débutants, la préparation d'un entretien peut s'avérer difficile. C'est pourquoi j'ai rassemblé quelques conseils :

Maîtrisez les bases de Docker

Pour réussir un entretien chez Docker, commencez par acquérir une solide compréhension de ses concepts fondamentaux.

- Découvrez comment les images Docker servent de modèle pour les conteneurs, et entraînez-vous à créer, exécuter et gérer des conteneurs afin de vous familiariser avec leurs environnements légers et isolés.

- Découvrez les volumes Docker pour gérer efficacement les données persistantes et explorez les réseaux en expérimentant les réseaux pont, hôte et superposés afin de faciliter la communication entre les conteneurs.

- Veuillez étudier les fichiers Dockerfiles afin de comprendre comment les images sont construites, en vous concentrant sur les instructions clés telles que

FROM,RUNetCMD. - De plus, familiarisez-vous avec Docker Compose pour gérer des applications multi-conteneurs et comprendre comment les registres Docker, tels que Docker Hub, stockent et partagent des images.

DataCamp propose de nombreuses autres ressources pour vous accompagner tout au long de votre parcours d'apprentissage :

- Pour les concepts introductifs de Docker : Cours d'introduction à Docker

- Pour les concepts intermédiaires de Docker : Cours intermédiaire sur Docker

- Pour apprendre la conteneurisation et la virtualisation : Cours sur les concepts de conteneurisation et de virtualisation

Acquérez une expérience pratique avec Docker

Une fois que vous avez acquis les connaissances essentielles sur Docker, il est temps de vous mettre au défi avec des travaux pratiques. Voici 10 excellentes idées de projets Docker pour les débutants et les apprenants plus avancés. Lorsque vous travaillez sur ces projets, veuillez utiliser l'aide-mémoire Docker de DataCamp afin d'avoir les commandes clés à portée de main.

Veuillez documenter votre expérience.

Soyez prêt à discuter de votre expérience avec Docker lors des entretiens. Veuillez préparer des exemples de :

- Projets: Veuillez mettre en avant les applications Dockerisées que vous avez développées ou auxquelles vous avez contribué.

- Défis: Veuillez décrire les problèmes rencontrés, tels que le débogage de conteneurs ou l'optimisation d'images, ainsi que la manière dont vous les avez résolus.

- Optimisation: Veuillez partager comment vous avez amélioré les temps de compilation, réduit la taille des images ou rationalisé les flux de travail grâce à Docker Compose.

- Collaboration: Si vous avez travaillé au sein d'une équipe, veuillez expliquer comment vous avez utilisé Docker pour améliorer la collaboration, les tests ou les processus de déploiement.

Vos exemples concrets démontreront vos connaissances pratiques et vos compétences en matière de résolution de problèmes.

Conclusion

Lorsque vous vous préparez pour votre entretien, n'oubliez pas que ces questions ne sont qu'un point de départ. Bien que mémoriser les réponses puisse être utile, les recruteurs apprécient les candidats qui peuvent démontrer une expérience pratique et une compréhension approfondie des concepts de conteneurisation. Il est recommandé de mettre en pratique ces concepts dans des scénarios réels et de développer vos projets.

Si vous êtes débutant, nous vous recommandons de commencer par notre cours Introduction à Docker. En conclusion, la réussite de votre entretien dépendra de votre capacité à combiner vos connaissances théoriques avec votre expérience pratique et à présenter clairement votre approche en matière de résolution de problèmes.

Développez dès aujourd'hui vos compétences en matière de MLOps

Questions fréquentes

Est-il nécessaire d'apprendre Kubernetes pour utiliser Docker ?

Non, il n'est pas nécessaire d'apprendre Kubernetes pour utiliser Docker. Docker remplit une fonction totalement différente de celle de Kubernetes. Il est utilisé pour créer, exécuter et gérer des conteneurs sur une seule machine.

Est-ce que Docker nécessite des compétences en codage ?

Non, il n'est pas nécessaire de posséder des compétences en programmation pour utiliser Docker. Il suffit de maîtriser les bases de la ligne de commande, les fichiers YAML et la documentation Docker pour accomplir la plupart des tâches. Cependant, il est nécessaire d'apprendre comment fonctionnent les commandes Linux et les réseaux.

Combien de temps faut-il pour se préparer à l'entretien chez Docker ?

Si vous vous investissez pleinement, la préparation à un entretien chez Docker peut prendre entre trois et quatre semaines. Veuillez consacrer au moins une semaine à l'apprentissage des bases de Docker. Ensuite, passez à Docker Compose et aux configurations multi-conteneurs. Au cours des deux dernières semaines, nous nous sommes concentrés sur les constructions en plusieurs étapes et l'optimisation des conteneurs. De plus, veuillez constituer un portfolio avec des exemples concrets.

Je suis un stratège du contenu qui aime simplifier les sujets complexes. J'ai aidé des entreprises comme Splunk, Hackernoon et Tiiny Host à créer un contenu attrayant et informatif pour leur public.