Lernpfad

Docker ist mittlerweile das beliebteste Containerisierungstool in der modernen Softwareentwicklung, vor allem bei DevOps- und CI/CD-Workflows. Es macht die Bereitstellung und Verwaltung von Anwendungen durch Container einfacher, was eine schnelle und konsistente Bereitstellung von Software ermöglicht.

Dank seiner Skalierbarkeit und Flexibilität ist Docker ein Muss für datenbezogene Aufgaben wie Data Engineering, MLOps und sogar Data Science. Deshalb hab ich häufig gestellte Fragen zu Docker-Vorstellungsgesprächen zusammengestellt, die sowohl Kernkonzepte als auch reale Szenarien abdecken.

Werde Dateningenieur

Was ist Docker?

Docker ist eine Container-Plattform, mit der Entwickler Anwendungen mit allen ihren Abhängigkeiten packen können, damit sie in verschiedenen Umgebungen reibungslos laufen.

Auch wenn Container denselben Betriebssystemkern haben, läuft jeder in seiner eigenen isolierten Umgebung. Diese Konfiguration minimiert Kompatibilitätsprobleme, reduziert Verzögerungen und verbessert die Kommunikation zwischen Entwicklungs-, Test- und Betriebsteams.

Docker-Logo. Bildquelle

2023 war Docker mit über 32 % Marktanteil der Marktführer im Bereich Containerisierung. Das zeigt, wie wichtig es in der modernen Softwareentwicklung ist! Deshalb kannst du davon ausgehen, dass Personalvermittler deine Docker-Kenntnisse in Vorstellungsgesprächen für datenbezogene Jobs testen werden.

Grundlegende Fragen zu Docker für Vorstellungsgespräche

Mach dich erst mal mit ein paar grundlegenden Docker-Begriffen klar. Diese grundlegenden Fragen helfen dir, ein Verständnis aufzubauen und dich auf die erste Phase des Vorstellungsgesprächs vorzubereiten.

1. Was ist ein Docker-Image?

Ein Docker-Image ist wie ein Bauplan, mit dem Container erstellt werden. Es hat alles, was ein Entwickler braucht, um eine Anwendung zu starten, wie zum Beispiel:

- Code

- Bibliotheken

- Einstellungen

Wenn du ein Docker-Image verwendest, verwandelt Docker es in einen Container, also eine komplett isolierte Umgebung. Da läuft die Anwendung eigenständig.

2. Was ist ein Docker-Host?

Ein Docker-Host ist das System, auf dem wir Docker installieren. Es ist die Hauptumgebung, in der Docker-Container laufen und verwaltet werden. Wir können einen Docker-Host auf einem lokalen Gerät oder in einer virtuellen oder Cloud-Umgebung einrichten.

3. Was ist der Unterschied zwischen einem Docker-Client und einem Docker-Daemon? Kannst du mir ein Beispiel nennen?

Der Docker-Client und der Docker-Daemon arbeiten zusammen, haben aber unterschiedliche Aufgaben. Der Docker-Client ist das Tool, das Befehle verschickt, und der Docker-Daemon ist die Engine, die diese Befehle ausführt.

Wenn wir zum Beispiel den Befehl „ docker run “ eingeben, um einen Container zu starten, nimmt der Client die Anfrage entgegen und schickt sie an den Docker-Daemon. Der Docker-Daemon übernimmt dann die eigentliche Arbeit, indem er den Container startet.

4. Kannst du erklären, was Docker-Netzwerke sind und welche Befehle man braucht, um ein Bridge- und ein Overlay-Netzwerk einzurichten?

Mit Docker-Netzwerken können Container mit anderen Containern und Hosts verbunden werden und mit ihnen kommunizieren. Mit dem Befehl „ docker network create “ können wir benutzerdefinierte Netzwerke einrichten.

- Brückennetzwerk: Macht ein lokales Netzwerk für die Kommunikation zwischen Containern auf demselben Docker-Host.

- Befehl:

docker network create -d bridge my-bridge-network - Damit wird ein Bridge-Netzwerk namens „

my-bridge-network“ für Container auf demselben Host eingerichtet. - Überlagerungsnetzwerk: Macht die Kommunikation zwischen Containern auf mehreren Docker-Hosts möglich, was oft in einer Swarm-Konfiguration genutzt wird.

- Befehl:

docker network create --scope=swarm --attachable -d overlay my-multihost-network - Dadurch wird ein anbindbares Overlay-Netzwerk namens „

my-multihost-network“ für Container erstellt, die auf verschiedenen Hosts in einem Docker Swarm laufen.

5. Erkläre, wie das Docker-Bridge-Netzwerk funktioniert.

Bridge-Netzwerke sind die Standardeinstellung, die Docker zum Verbinden von Containern nutzt. Wenn wir kein Netzwerk angeben, verbindet Docker es mit dem Bridge-Netzwerk. Diese Brücke verbindet alle Container auf demselben Docker-Host. Jeder Container hat eine eigene IP-Adresse, sodass Container direkt miteinander reden können.

Fragen für Fortgeschrittene zum Thema Docker

Diese Fragen sind dazu da, dein Wissen über Docker-Konzepte auf mittlerem Niveau zu checken.

6. Was ist eine Dockerfile? Erklär mal, wie du das schreiben würdest.

Ein Dockerfile ist ein Skript, das Anweisungen zum Erstellen eines Docker-Images enthält. Jeder Befehl in der Dockerfile-Datei richtet einen bestimmten Teil der Umgebung ein. Wenn wir diese Befehle ausführen, baut Docker ein Image Schicht für Schicht auf. So können wir es schreiben:

- Wähle zuerst ein Basisbild aus. Es hat wichtige Tools für die App drauf.

- Als Nächstes legst du ein Arbeitsverzeichnis im Container fest. Da werden die App-Dateien gespeichert und ausgeführt.

- Im dritten Schritt kopierst du mit dem Befehl „

COPY . .“ alle Projektdateien in das Arbeitsverzeichnis des Containers. - Benutze den Befehl „

RUN“, um Abhängigkeiten zu installieren. - Benutze den Befehl „

EXPOSE“, um den Port anzugeben, auf dem deine App läuft. - Jetzt leg fest, welchen Befehl Docker beim Starten des Containers ausführen soll.

Hier ist ein einfaches Beispiel für eine Dockerfile für eine Python-Webanwendung:

# Step 1: Choose a base image

FROM python:3.9-slim

# Step 2: Specify the working directory

WORKDIR /app

# Step 3: Copy project files into the container

COPY . .

# Step 4: Install dependencies

RUN pip install -r requirements.txt

# Step 5: Expose the port the app runs on

EXPOSE 5000

# Step 6: Define the default command

CMD ["python", "app.py"]Mit dem oben genannten Dockerfile kannst du ein Image mit „ docker build -t my-python-app . “ erstellen und einen Container mit „ docker run -p 5000:5000 my-python-app “ starten.

7. Was ist Docker Compose und wie unterscheidet es sich von Dockerfile?

Docker Compose ist ein Tool zum Definieren und Verwalten von Docker-Anwendungen mit mehreren Containern mithilfe einer YAML-Datei (docker-compose.yml). Damit können wir Dienste, Netzwerke und Volumes in einer einzigen Datei einrichten, was die Verwaltung komplexer Anwendungen einfacher macht.

Unterschiede zum Dockerfile:

- Mit einer Dockerfile-Datei kann man ein einzelnes Docker-Image erstellen, indem man seine Ebenen und Abhängigkeiten festlegt.

- Docker Compose wird benutzt, um mehrere Container zu starten und zu koordinieren, die vielleicht voneinander abhängen (z. B. ein Web-App-Container und ein Datenbank-Container).

Eine Datei namens „ docker-compose.yml “ könnte zum Beispiel so aussehen:

version: '3.9'

services:

web:

build: .

ports:

- "5000:5000"

depends_on:

- db

db:

image: postgres

volumes:

- db-data:/var/lib/postgresql/data

volumes:

db-data:Diese Datei legt zwei Dienste fest: „ web “ und „ db “, mit Netzwerk- und Volume-Konfigurationen.

8. Warum nutzen wir Volumes in Docker?

Wir nutzen Docker-Volumes, um Daten außerhalb von Docker-Containern sicher zu speichern. Sie bieten einen separaten Speicherort auf Hosts, wo Daten bleiben, auch wenn der Container entfernt wird. Außerdem ist es einfacher, die Volumes zu verwalten, zu sichern und zwischen Containern zu teilen.

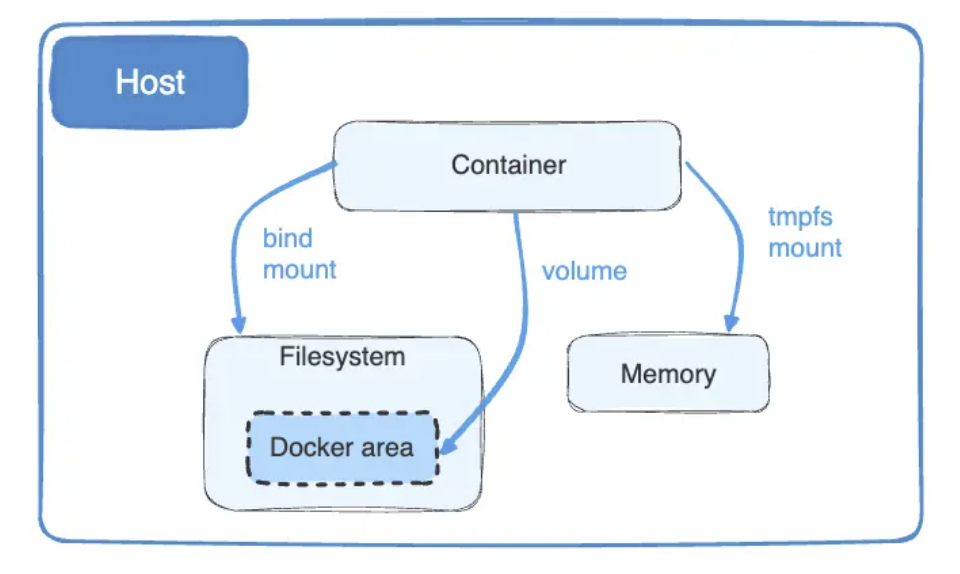

9. Was sind Docker-Bind-Mounts und warum finden wir Volumes besser als Bind-Mounts?

Mit Docker-Bind-Mounts können wir Dateien zwischen dem Host-Rechner und einem Container austauschen. Sie verbinden eine bestimmte Datei auf dem Hostsystem mit einem Speicherort im Container. Wenn wir irgendwelche Änderungen an Dateien machen, werden sie sofort im Container angezeigt.

Docker-Mounts sind super für die Dateifreigabe in Echtzeit – aber sie hängen vom Host-Betriebssystem ab, was Sicherheitsprobleme mit sich bringt.

Im Gegenteil, weil Docker-Volumes unabhängig voneinander laufen, sind sie sicherer als Mounts.

Diagramm von Docker-Bind-Mounts und -Volumes. Bildquelle: Docker

10. Was ist Docker Swarm?

Docker Swarm ist ein Tool, das Container organisiert und Services über einen ganzen Cluster von Docker-Knoten hinweg verwaltet und bereitstellt. Es sorgt für hohe Verfügbarkeit, Skalierbarkeit und Lastenausgleich, sodass mehrere Hosts wie eine einzige virtuelle Docker-Engine funktionieren können.

11. Können wir Docker Swarm automatisch skalieren?

Nein, Docker Swarm hat keine eingebaute Unterstützung für automatische Skalierung. Um eine automatische Skalierung hinzukriegen, müssen wir Überwachungstools einbauen und Skripte nutzen, um die Anzahl der Instanzen manuell anzupassen. So geht's:

- Installier ein Überwachungstool wie Prometheus oder Grafana, um die Ressourcennutzung wie CPU und Speicher zu verfolgen.

- Stell die Skalierungsauslöser ein. Zum Beispiel können wir festlegen, dass eine CPU-Auslastung von über 82 % eine Skalierung nach oben auslöst.

- Als Nächstes schreibst du ein Skript mit dem Befehl „

docker service scale“, um die Anzahl der Replikate anzupassen. Um zum Beispiel einen Dienst auf 5 Replikate zu skalieren:docker service scale =5

Durch die Kombination von Überwachungstools, Triggern und Skripten kannst du eine Art von automatischer Skalierung in Docker Swarm einrichten, auch wenn das nicht standardmäßig drin ist.

12. Wie würdest du Docker Compose zum Skalieren von Diensten nutzen?

Um Dienste mit Docker Compose zu skalieren, können wir das Flag „ --scale “ mit dem Befehl „ docker-compose up “ verwenden. Das wird normalerweise für zustandslose Dienste wie Webserver genutzt. Um zum Beispiel einen Webdienst auf drei Instanzen zu skalieren:

docker-compose up --scale web=3

Es ist wichtig, dass die Datei „ docker-compose.yml “ richtig definierte Dienste hat und einen externen Load Balancer nutzt oder skalierte Instanzen unterstützt. Um zustandsbehaftete Dienste (z. B. Datenbanken) zu skalieren, braucht man zusätzliche Einstellungen, damit die Daten konsistent bleiben.

13. Kann ein Container von selbst neu starten? Legen Sie die Standard- und Always-Richtlinien fest.

Ja, ein Container kann von selbst neu starten. Dafür müssen wir aber eine Neustart-Regel festlegen.

Docker hat verschiedene Neustartrichtlinien, die festlegen, wann und wie Container neu gestartet werden sollen. Die Standardeinstellung ist „Nein“, was bedeutet, dass ein Container nicht neu gestartet wird, wenn er stoppt. Mit der „always“-Richtlinie startet Docker den Container automatisch neu, wenn er mal stehen bleibt.

Mit diesem Befehl können wir die Richtlinie „always“ anwenden:

docker run --restart=always

Fragen für Fortgeschrittene zum Thema Docker

Jetzt geht's weiter mit den fortgeschrittenen Docker-Interviewfragen!

14. Erklär mal den Lebenszyklus von Docker-Containern.

Ein Docker-Container durchläuft einen Lebenszyklus, der festlegt, welche Zustände ein Container haben kann und wie er in diesen Zuständen funktioniert. Die Phasen im Lebenszyklus eines Docker-Containers sind:

- Erstellen: In diesem Zustand erstellen wir einen Container aus einem Image mit dem Befehl „

docker create“. - Laufen: Hier benutzen wir den Befehl „

docker start“, um den Container zu starten, der die Aufgaben ausführt, bis wir ihn stoppen oder pausieren. - Pause: Wir benutzen den Befehl „

docker pause“, um den Prozess zu stoppen. Dieser Zustand hält den Speicher und die Festplatte intakt. Wenn du den Container wieder aufnehmen willst, benutze den Befehl „docker unpause“. - Stop: Wenn der Container nicht läuft, geht er in den Stopp-Modus, aber das kann aus verschiedenen Gründen passieren:

- Sofortiger Stopp: Der Befehl „

docker kill“ stoppt den Container, ohne ihn zu bereinigen. - Prozess abgeschlossen: Wenn der Container fertig ist, hört er automatisch auf.

- Speicher voll: Der Container hört auf zu laufen, wenn er zu viel Speicher braucht.

- Löschen: Im letzten Schritt löschen wir den angehaltenen oder erstellten Container mit dem Befehl „

docker rm“.

15. Was ist ein Docker-Image-Repository?

Ein Docker-Image-Repository speichert mehrere Container-Images mit demselben Namen und teilt sie mit den Clients oder der Community. Wir können sie mit Tags versehen, um ihre verschiedenen Versionen zu unterscheiden. Zum Beispiel wird app/marketing_campaign:v1 die erste Version einer Marketing-App sein und app/marketing_campaign:v2 die zweite Version.

Docker Hub, das bekannteste Docker-Image-Repository, lässt Leute Container-Images öffentlich oder privat hosten, teilen und abrufen. Andere Alternativen sind Amazon ECR, Google Artifact Registry und GitHub Container Registry.

16. Sag mir mal drei gute Tipps, wie man einen Docker-Container sicher hält.

Um die Containersicherheit zu verbessern und häufige Schwachstellen zu minimieren, halte ich mich an diese bewährten Vorgehensweisen:

- Wähle leichte Bilder aus: Benutz möglichst kleine Basis-Images wie Alpine, um die Angriffsfläche zu verkleinern.

- Begrenze Systemaufrufe: Da Docker-Container auf unnötige Aufrufe zugreifen können, solltest du Tools wie Seccomp nutzen, um diese Aufrufe einzuschränken.

- Schütze sensible Daten: Benutze Docker-Geheimnisse, um API-Schlüssel oder Passwörter zu verwalten. Sie verschlüsseln die Geheimnisse und machen sie nur während der Laufzeit zugänglich.

17. Warum brauchen Docker-Container Gesundheitschecks?

Docker-Container brauchen Gesundheitschecks, damit sie reibungslos laufen. Das Bereitstellen eines Containers, der läuft, aber keine Anfragen verarbeitet, kann Probleme für die Bereitstellungsteams verursachen. Gesundheitschecks checken diese Sachen in Echtzeit und sagen uns sofort Bescheid.

Zum Beispiel kann ein Gesundheitscheck in einer Dockerfile wie folgt hinzugefügt werden:

HEALTHCHECK --interval=30s --timeout=10s --retries=3 CMD curl -f http://localhost:8080/health || exit 1

Dieser Gesundheitscheck pingt alle 30 Sekunden den Gesundheitsendpunkt des Containers an und markiert den Container als nicht funktionsfähig, wenn drei aufeinanderfolgende Versuche fehlschlagen. Diese proaktive Überwachung hilft dabei, Probleme schnell zu erkennen und zu lösen.

18. Was sind „Dangling Images“ in Docker und wie kann man sie loswerden?

Dangling Images in Docker sind nicht mehr genutzte Image-Layer, die keine Tags mehr haben. Sie sammeln sich oft an, wenn du neue Bilder mit dem gleichen Namen und Tag erstellst, sodass die alten Ebenen ohne Verweise zurückbleiben. Diese Bilder können viel Speicherplatz belegen, deshalb ist es wichtig, sie regelmäßig zu löschen. So geht's:

- Führ den Befehl „

docker images -f dangling=true“ aus, um fehlende Bilder zu finden. - Dann mach den Befehl „

docker image prune -f“, um alle Bilder auf einmal zu löschen. - Wenn du Bilder manuell löschen willst, benutze den Befehl „

docker rmi -f $(docker images -f dangling=true -q)“.

Diese Schritte helfen dir, dein System sauber zu halten und Speicherplatz effizient freizugeben.

Fragen zum Vorstellungsgespräch zu Docker und Kubernetes

Docker und Kubernetes werden oft zusammen benutzt, also wäre es nicht überraschend, wenn in einem Docker-Vorstellungsgespräch ein paar Fragen zu Kubernetes auftauchen, vor allem wenn die Stelle auf DevOps ausgerichtet ist. Hier sind ein paar Fragen, die dir gestellt werden könnten:

19. Was ist der Hauptunterschied zwischen Docker und Kubernetes?

Docker ist eine Containerisierungsplattform, mit der du Container erstellen, versenden und ausführen kannst. Es geht darum, einzelne Container zu erstellen und zu verwalten.Kubernetes hingegen ist eine Orchestrierungsplattform, die entwickelt wurde, um mehrere Container in großem Maßstab zu verwalten. Es kümmert sich um die Bereitstellung, Skalierung, Lastverteilung und Selbstheilung über Cluster von Knoten hinweg.

Mehr über die Unterschiede zwischen Kubernetes und Docker erfährst du in diesem Blogbeitrag.

20. Vergleich Docker Swarm mit Kubernetes.

Kubernetes und Docker Swarm verwalten Container, aber sie funktionieren unterschiedlich:

- Kubernetes kümmert sich um große und komplizierte Container-Setups. Dank seiner Selbstheilungs- und integrierten Überwachungsfunktionen ist es eine bessere Wahl für komplexe Umgebungen.

- Docker Swarm passt gut für kleinere oder weniger komplizierte Setups, weil es keine eingebauten Funktionen wie Kubernetes hat. Wir können es ganz einfach mit Docker-Tools wie Docker CLI und Docker Compose zusammenbringen.

21. Wie macht Kubernetes das mit der Verwaltung von vielen Docker-Containern?

Docker ist super zum Erstellen und Ausführen von Containern, aber um viele davon zu verwalten, braucht man Kubernetes. Kubernetes organisiert Container effizient, indem es:

- Ressourcenbeschränkungen festlegen: Es teilt jedem Container CPU, Speicher und andere Ressourcen zu, um zu viel Verbrauch zu vermeiden.

- Container-Planung: Kubernetes entscheidet, wo jeder Container läuft, und sorgt so dafür, dass die Ressourcen auf den Knoten im Cluster optimal genutzt werden.

- Automatische Skalierung: Je nach Auslastung skaliert es Pods (Gruppen von einem oder mehreren Containern) nach oben oder unten, um die Leistung und Effizienz aufrechtzuerhalten.

Durch die Automatisierung dieser Prozesse sorgt Kubernetes für einen reibungslosen Betrieb, selbst wenn Tausende von Containern verwaltet werden. Auch wenn manchmal Fehler passieren können, sorgen die Selbstheilungsfähigkeiten, wie zum Beispiel das Neustarten von ausgefallenen Containern, dafür, dass Störungen auf ein Minimum reduziert werden.

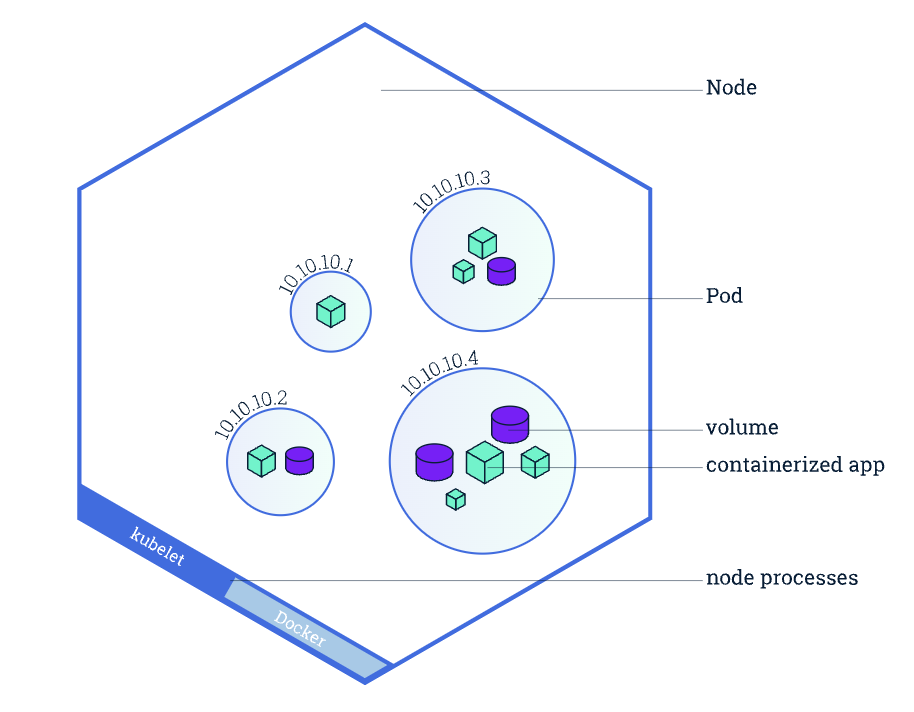

22. Was ist ein Pod in Kubernetes und wie unterscheidet er sich von einem Container?

Ein Pod ist die kleinste einsetzbare Einheit in Kubernetes und besteht aus einem oder mehreren Containern, die denselben Netzwerk-Namespace, denselben Speicher und dieselbe Konfiguration nutzen.Im Gegensatz zu einzelnen Containern ermöglichen Pods, dass mehrere eng miteinander verbundene Container als eine Einheit zusammenarbeiten (z. B. ein Webserver und ein Sidecar-Logging-Container).

Überblick über einen Kubernetes-Knoten, mit Fokus auf Pods und Container. Bildquelle: Kubernetes.

23. Wie kannst du sensible Daten wie Passwörter in Docker und Kubernetes verwalten?

- In Docker: Wir können Docker-Geheimnisse nutzen, die sensible Daten verschlüsseln und sie nur für autorisierte Container zur Laufzeit zugänglich machen.

- In Kubernetes: Wir nutzen Secrets-Objekte, die sensible Daten wie Passwörter, Tokens und API-Schlüssel speichern. Geheimnisse können als Volumes eingebunden oder als Umgebungsvariablen sicher für Pods freigegeben werden.

Beispiel in Kubernetes:

apiVersion: v1

kind: Secret

metadata:

name: my-secret

type: Opaque

data:

password: cGFzc3dvcmQ= # Base64-encoded "password"Szenariobasierte Docker-Interviewfragen

Der Interviewer stellt dir Fragen zu bestimmten Szenarien und zum Lösen von Problemen, um zu sehen, wie du mit echten Problemen umgehst. Schauen wir uns mal ein paar Fragen an, um dir eine Vorstellung zu geben:

24. Stell dir vor, du erstellst ein Image einer Maven-basierten API. Du hast die Dockerfile schon mit den grundlegenden Einstellungen eingerichtet. Jetzt siehst du, dass das Bild ziemlich groß ist. Wie würdest du es reduzieren?

Beispielantwort:

Um die Größe eines Docker-Images für eine Maven-basierte API zu verringern, würde ich diese Schritte machen:

Erstell eine Datei namens „ .dockerignore “ im Projektverzeichnis, um Dateien und Ordner anzugeben, die nicht in den Docker-Build-Kontext aufgenommen werden sollen. Dadurch wird verhindert, dass unnötige Dateien zum Image hinzugefügt werden, was dessen Größe reduziert. Ich würde zum Beispiel Folgendes zu „ .dockerignore “ hinzufügen:

.git # Version control files

target # Compiled code and build artifacts

.idea # IDE configuration filesMach das Dockerfile mit mehrstufigen Builds besser. Ich würde das Maven-Projekt in einer Stufe erstellen und nur die wichtigen Teile (z. B. kompilierte JAR-Dateien) in die letzte Stufe kopieren, damit das Image klein bleibt. Beispiel für eine Dockerfile mit mehrstufigem Build:

# Stage 1: Build the application

FROM maven:3.8.5-openjdk-11 AS build

WORKDIR /app

COPY pom.xml .

COPY src ./src

RUN mvn clean package

# Stage 2: Create a lightweight runtime image

FROM openjdk:11-jre-slim

WORKDIR /app

COPY --from=build /app/target/my-api.jar .

CMD ["java", "-jar", "my-api.jar"]Wenn man unnötige Dateien weglässt und mehrstufige Builds nutzt, kann man die Image-Größe deutlich reduzieren und trotzdem effizient bleiben.

25. Stell dir vor, du musst ein Docker-Container-Image mit Jenkins zum Docker Hub schicken. Wie würdest du das machen?

Beispielantwort:

So würde ich ein Docker-Container-Image mit Jenkins auf Docker Hub hochladen:

- Richte eine Jenkins-Pipeline ein: Mach einen Multi-Branch-Pipeline-Job in Jenkins und verbinde ihn mit dem Repository, das die Dateien „Dockerfile“ und „Jenkinsfile“ enthält.

- Definiere die Pipeline in meiner Jenkinsfile-: Das Programm „

Jenkinsfile” würde folgende Schritte umfassen: - Erstelle das Docker-Image

- Melde dich bei Docker Hub an (mit den sicher in Jenkins gespeicherten Anmeldedaten).

- Schick das Image an Docker Hub

- Mach die Pipeline-: Starte den Jenkins-Job. Es erstellt das Image, loggt sich bei Docker Hub ein und schickt das Image automatisch raus.

26. Stell dir vor, du musst einen WordPress-Docker-Container auf einen neuen Server umziehen, ohne dass dabei Daten verloren gehen. Wie würdest du das machen?

Beispielantwort:

So würde ich einen WordPress-Docker-Container migrieren:

- Sichere die WordPress-Daten: Exportiere die persistenten Daten des Containers (WordPress-Dateien und Datenbank). Ich würde „

docker cp“ oder ein Tool für Volumen-Backups nutzen, um die wichtigen Volumen zu sichern, meistens das Verzeichnis „html“ für WordPress-Dateien und das Datenbank-Volumen. - Verschieb die Backup-Dateien in den Ordner „ “: Ich würde „

scp“ nutzen, um die Backup-Dateien sicher auf den neuen Server zu kopieren. - WordPress auf dem neuen Server einrichten: Ich würde einen neuen WordPress-Container und Datenbank-Container auf dem neuen Server einrichten.

- Mach mal einen Neustart und check, ob funktioniert: Zum Schluss würde ich die Container neu starten, um die Änderungen zu übernehmen, und checken, ob die WordPress-Seite richtig läuft.

Durch das Sichern von Volumes und deren Wiederherstellung auf einem neuen Server kann man WordPress migrieren, ohne Daten zu verlieren. Diese Methode macht dich unabhängig von bestimmten Erweiterungen und gibt dir mehr Kontrolle über den Migrationsprozess.

Tipps zur Vorbereitung auf ein Docker-Vorstellungsgespräch

Wenn du diesen Leitfaden liest, hast du schon einen wichtigen Schritt gemacht, um bei deinem nächsten Vorstellungsgespräch zu glänzen! Aber für Leute, die noch gar keine Erfahrung haben, kann die Vorbereitung auf ein Vorstellungsgespräch echt stressig sein. Deshalb hab ich ein paar Tipps zusammengestellt:

Lerne die Grundlagen von Docker

Um bei einem Docker-Vorstellungsgespräch zu glänzen, solltest du dich erst mal richtig mit den Kernkonzepten auskennen.

- Lerne, wie Docker-Images als Blaupause für Container dienen, und probier mal aus, Container zu erstellen, auszuführen und zu verwalten, um dich mit ihren schlanken, isolierten Umgebungen vertraut zu machen.

- Schau dir Docker-Volumes an, um persistente Daten effektiv zu verwalten, und probier dich an Netzwerken aus, indem du mit Bridge-, Host- und Overlay-Netzwerken experimentierst, um die Kommunikation zwischen Containern zu vereinfachen.

- Schau dir Dockerfiles an, um zu verstehen, wie Images erstellt werden, und konzentriere dich dabei auf wichtige Anweisungen wie „

FROM“, „RUN“ und „CMD“. - Probier außerdem Docker Compose aus, um Anwendungen mit mehreren Containern zu verwalten, und lerne, wie Docker-Registries wie Docker Hub Images speichern und teilen.

DataCamp hat noch viele andere Sachen, die dir auf deiner Lernreise helfen:

- Für ein paar grundlegende Infos zu Docker: Einführung in den Docker-Kurs

- Für fortgeschrittene Docker-Konzepte: Docker-Kurs für Fortgeschrittene

- Zum Lernen von Containerisierung und Virtualisierung: Kurs zu Containerisierung und Virtualisierung

Mach dich mit Docker vertraut

Sobald du die wichtigsten Docker-Themen gelernt hast, ist es Zeit, dich mit ein paar praktischen Aufgaben zu fordern. Hier sind 10 coole Docker-Projektideen für Leute, die gerade anfangen, und für alle, die schon ein bisschen Erfahrung haben. Wenn du an diesen Projekten arbeitest, schau dir das Docker-Spickzettel von DataCamp an, damit du die wichtigsten Befehle immer parat hast.

Dokumentiere deine Erfahrungen

Sei bereit, in Vorstellungsgesprächen über deine Erfahrungen mit Docker zu reden. Bereite Beispiele vor für:

- Projekte: Zeig mal die Docker-Anwendungen, die du entwickelt oder zu denen du beigetragen hast.

- Herausforderungen: Erzähl mal, auf welche Probleme du gestoßen bist, zum Beispiel beim Debuggen von Containern oder beim Optimieren von Images, und wie du sie gelöst hast.

- Optimierungs: Erzähl uns, wie du mit Docker Compose die Build-Zeiten verbessert, die Bildgrößen reduziert oder die Arbeitsabläufe optimiert hast.

- Zusammenarbeit: Wenn du in einem Team gearbeitet hast, erzähl mal, wie du Docker genutzt hast, um die Zusammenarbeit, das Testen oder die Bereitstellungsprozesse zu verbessern.

Deine Beispiele aus der Praxis zeigen dein praktisches Wissen und deine Fähigkeiten, Probleme zu lösen!

Fazit

Denk beim Vorbereiten deines Vorstellungsgesprächs daran, dass diese Fragen nur ein Anfang sind. Auch wenn es helfen kann, Antworten auswendig zu lernen, legen Interviewer mehr Wert auf Leute, die praktische Erfahrung und ein tiefes Verständnis von Containerisierungskonzepten zeigen können. Du solltest üben, diese Konzepte in echten Situationen anzuwenden und deine Projekte aufzubauen.

Wenn du Anfänger bist, fang mit unserem Kurs „Einführung in Docker“ an. Letztendlich kommt es bei deinem Vorstellungsgespräch darauf an, theoretisches Wissen mit praktischer Erfahrung zu verbinden und deinen Ansatz zur Problemlösung gut rüberzubringen!

MLOps-Fähigkeiten heute aufbauen

FAQs

Muss ich Kubernetes lernen, um Docker nutzen zu können?

Nein, du musst Kubernetes nicht lernen, um Docker zu benutzen. Docker macht was ganz anderes als Kubernetes. Damit kann man Container auf einem einzigen Rechner erstellen, ausführen und verwalten.

Braucht man für Docker Programmierkenntnisse?

Nein, du brauchst keine Programmierkenntnisse, um Docker zu nutzen. Wenn du mit den Grundlagen der Befehlszeile, YAML-Dateien und der Docker-Dokumentation klarkommst, reicht das schon, um die meisten Aufgaben zu erledigen. Aber du musst lernen, wie Linux-Befehle und Netzwerke funktionieren.

Wie lange dauert es, sich auf das Docker-Vorstellungsgespräch vorzubereiten?

Wenn du dich voll reinhängst, kannst du für die Vorbereitung auf ein Docker-Vorstellungsgespräch mit 3 bis 4 Wochen rechnen. Nimm dir mindestens eine Woche Zeit für die Grundlagen von Docker. Dann mach weiter mit Docker Compose und Multi-Container-Setups. In den letzten zwei Wochen haben wir uns auf mehrstufige Builds und die Optimierung von Containern konzentriert. Bau dir auch ein Portfolio mit Beispielen aus der Praxis auf.

Ich bin ein Inhaltsstratege, der es liebt, komplexe Themen zu vereinfachen. Ich habe Unternehmen wie Splunk, Hackernoon und Tiiny Host geholfen, ansprechende und informative Inhalte für ihr Publikum zu erstellen.