Curso

La mayoría de las descripciones de puestos de trabajo en el mercado laboral actual enumeran las habilidades en la nube en la sección "Obligatorio" o, como mínimo, en la sección "Es bueno tenerlas" justo debajo. Esta tendencia no es específica de cada función. Tanto si desarrollas aplicaciones, trabajas con datos o te especializas en seguridad, los empresarios necesitan que utilices el proveedor de la nube que hayan elegido.

En los últimos 5 años, he trabajado en muchas startups y, aunque suene a tópico, he llevado muchos sombreros. He trabajado con Google Cloud Platform (GCP) y también he realizado más de 40 entrevistas técnicas en las que he puesto a prueba los conocimientos de otros ingenieros sobre el tema.

Esta guía te ofrece mis mejores consejos para abordar las preguntas de la entrevista de GCP adaptadas a tu nivel de conocimientos y a tu función. Puedes saltar a la sección que te parezca más relevante. Sin embargo, las secciones generales sirven de base para las específicas de cada función, por lo que te recomiendo que las leas primero.

Y antes de empezar: si eres completamente nuevo en la computación en nube, te recomiendo que primero sigas nuestro curso Introducción a la computación en nube. Este curso desglosa los conceptos básicos de la nube, explica términos clave como escalabilidad y latencia, y cubre las ventajas de las herramientas en la nube de proveedores como Google Cloud.

Preguntas básicas de la entrevista sobre GCP

Para los candidatos principiantes, las preguntas y respuestas de las entrevistas sobre GCP tienen pocos o ningún elemento técnico. La idea es medir tu comprensión de las ofertas de GCP y cómo encajan los productos entre sí. Lo más probable es que te encuentres con estas preguntas si nunca has trabajado con GCP, o si el entrevistador no está seguro de tu nivel de conocimientos y quiere empezar por lo básico.

Lo que debes saber

Debes estar familiarizado con los servicios básicos de GCP, como Compute Engine, Kubernetes Engine, Cloud Storage, BigQuery, Cloud SQL y Pub/Sub. También puede haber preguntas sobre:

- Gestión de identidades y accesos (IAM): comprender los roles IAM, los permisos y cómo gestionar el acceso de los usuarios dentro de GCP.

- Almacenamiento de datos y bases de datos: conocimiento de Cloud Storage, Cloud SQL, Cloud Spanner, Firestore y Bigtable, incluidos sus casos de uso y configuraciones.

- Computación sin servidor: familiaridad con Cloud Functions, Cloud Run y App Engine, y cómo desplegar y gestionar aplicaciones sin servidor.

- Supervisión y registro: dominio de la Suite de Operaciones de Google Cloud (antes Stackdriver), incluyendo Supervisión, Registro, Rastreo, Depurador e Informes de Errores para garantizar la fiabilidad y el rendimiento del sistema.

Si estos conceptos te suenan desconocidos y no sabes por dónde empezar, prueba nuestro curso Introducción a GCP. Te dará una base sólida sobre los temas anteriores.

Preguntas que te pueden hacer

Aquí tienes algunas preguntas que podría hacerte un entrevistador, con ejemplos de respuestas:

1. ¿Qué es Google Compute Engine y cuáles son sus principales casos de uso?

Google Compute Engine ofrece máquinas virtuales escalables que funcionan dentro de los centros de datos de Google. Estas máquinas virtuales se utilizan habitualmente para ejecutar aplicaciones web, alojar bases de datos y gestionar tareas de cálculo a gran escala, como cargas de trabajo de procesamiento de datos y machine learning.

2. ¿Qué son las clases de Google Cloud Storage y en qué se diferencian?

Google Cloud Storage ofrece cuatro clases principales de almacenamiento: almacenamiento Standard para datos a los que se accede con frecuencia con un alto rendimiento, almacenamiento Nearline para datos a los que se accede menos de una vez al mes con un coste menor, almacenamiento Coldline para datos a los que se accede menos de una vez al año con un coste aún menor, y almacenamiento Archive para archivar datos a largo plazo y hacer copias de seguridad con el coste más bajo.

Nota: conseguirás puntos extra si puedes dar ejemplos prácticos del tipo de datos que se alojan en cada una de esas clases de almacenamiento. Si estás haciendo una entrevista para una aplicación de redes sociales, por ejemplo, habla sobre las fotos de perfil de los usuarios, los registros de actividad de los usuarios y los datos de cumplimiento.

3. ¿Qué es Google Cloud Pub/Sub y cuáles son sus casos de uso típicos?

Pub/Sub está diseñado para la mensajería en tiempo real y las arquitecturas basadas en eventos para permitir la comunicación asíncrona entre servicios. Algunos de sus casos de uso típicos son los sistemas de registro, las canalizaciones de ingestión de datos, los análisis en tiempo real y la integración de microservicios.

4. ¿Qué es una BigQuery y cómo gestiona grandes conjuntos de datos?

BigQuery es el almacén de datos sin servidor de Google y está diseñado para manejar grandes conjuntos de datos de forma eficiente con SQL. Utiliza almacenamiento columnar, que almacena los datos en disco en columnas en lugar de filas, para optimizar las operaciones de lectura pesada. También aprovecha el procesamiento paralelo, lo que permite distribuir las tareas entre varias máquinas para procesar los datos simultáneamente. Esto permite a BigQuery ejecutar consultas rápidas, incluso en petabytes de datos. Además, se integra con otros servicios de GCP como Dataflow para el procesamiento de datos y Pub/Sub para la ingestión de datos en tiempo real. BigQuery también incluye funciones como BigQuery ML para realizar machine learning directamente dentro de la plataforma.

Preguntas intermedias de la entrevista GCP

Estas preguntas llegarán una vez que tu entrevistador haya comprobado que tienes algunos conocimientos básicos sobre las ofertas de GCP. Suelen ser un poco más técnicas y pondrán a prueba tus conocimientos sobre servicios concretos, sus configuraciones y cómo utilizarlos eficazmente en distintos escenarios.

Es probable que puedas responderlas si tienes experiencia práctica con GCP y has gestionado previamente recursos, implementado políticas IAM, configurado máquinas virtuales, o si has realizado nuestro curso Comprender la computación en nube.

Lo que debes saber

Necesitas ampliar tus conocimientos sobre las ofertas de GCP y mostrar una comprensión más profunda de los siguientes servicios:

- Soluciones de cálculo y escalado: debes conocer a fondo Compute Engine, Kubernetes Engine y App Engine, incluidos conceptos como autoescalado, equilibrio de carga y optimización de recursos.

- Trabajo en red: es esencial estar familiarizado con la Nube Privada Virtual o Virtual Private Cloud (VPC), el emparejamiento de VPC o VPC Peering, la VPC compartida y las VPN, así como con la configuración y gestión de subredes, cortafuegos, rutas, VPN y equilibrio de carga.

- Soluciones de bases de datos: necesitas entender Cloud SQL, Cloud Spanner, Bigtable y Firestore, incluyendo sus configuraciones y casos de uso apropiados.

- IAM: debes conocer las funciones avanzadas de IAM, como los roles personalizados, las cuentas de servicio y la federación de identidades de carga de trabajo.

- Prácticas DevOps y CI/CD: el conocimiento de Cloud Build, Container Registry y automatización de canalizaciones CI/CD es importante para unas prácticas eficientes de desarrollo e implementación.

- Seguridad y cumplimiento: debes conocer las ofertas de seguridad de GCP, incluidos los métodos de encriptación, la gestión de claves de seguridad y la adhesión a las normas de cumplimiento.

- Big Data y Análisis: es necesario un buen dominio de BigQuery, Data Studio, Dataprep y Looker para las tareas de análisis y visualización de datos a gran escala.

No necesitas ser un experto en todos estos temas. El mero hecho de conocer las funciones y las opciones de configuración más comunes ¡te ayudará mucho!

Preguntas que te pueden hacer

Aquí tienes una lista de preguntas habituales en las entrevistas, acompañadas de sugerencias de respuesta:

5. ¿Cómo se configura y gestiona el autoescalado en Google Compute Engine?

Para configurar y gestionar el autoescalado en Google Compute Engine, yo empezaría por configurar grupos de instancias. Después, definiría políticas de autoescalado basadas en métricas relevantes, como la utilización de la CPU y el uso del equilibrio de carga. Esta configuración garantiza que el sistema se amplíe durante los momentos de alta demanda para mantener el rendimiento y se reduzca durante la baja demanda para optimizar la rentabilidad.

6. Explica cómo configurar y utilizar Cloud Pub/Sub para una aplicación de mensajería en tiempo real.

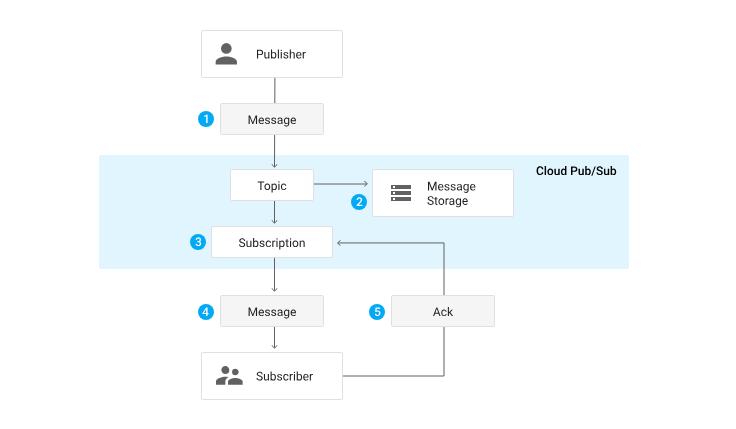

Para configurar y utilizar Cloud Pub/Sub para una aplicación de mensajería en tiempo real, aprovecharía los temas y las suscripciones para gestionar el flujo de mensajes. Configuraría los ajustes de retención de mensajes y acuse de recibo para garantizar una entrega fiable. Dependiendo del caso de uso, podría utilizar suscripciones push para la entrega en tiempo real o suscripciones pull para el procesamiento por lotes. Además, integraría Pub/Sub con otros servicios de GCP como Dataflow para el procesamiento de datos y Cloud Functions para el procesamiento basado en eventos.

Ciclo de vida de un mensaje a través de Pub/Sub. Fuente: documentación GCP Pub/Sub

7. ¿Cómo se utiliza Google Cloud IAM para conceder acceso temporal a los recursos?

Para conceder acceso temporal a los recursos mediante Google Cloud IAM, yo empezaría por crear roles personalizados que solo tuvieran los permisos necesarios, siguiendo el principio del menor privilegio. A continuación, configuraría cuentas de servicio para gestionar el acceso de aplicaciones y servicios. Para las necesidades de acceso a corto plazo, utilizaría Identity-Aware Proxy (IAP) para emitir credenciales de corta duración o generar URL firmadas para el almacenamiento en la nube, con el fin de proporcionar acceso limitado en el tiempo a recursos específicos.

Preguntas avanzadas de la entrevista GCP

En este nivel, los entrevistadores buscarán profundos conocimientos técnicos, experiencia práctica y capacidad para diseñar soluciones complejas en GCP. Esperarán que tus respuestas tengan en cuenta las mejores prácticas para optimizar y proteger los entornos en la nube. Aunque puede haber algunas excepciones, solo deberían hacerte preguntas avanzadas si solicitas un puesto de alto nivel o un puesto con un fuerte componente DevOps.

Lo que debes saber

Además de los conocimientos básicos e intermedios mencionados anteriormente, tu entrevistador podría preguntarte sobre la arquitectura general y el diseño de soluciones escalables en la nube, y cómo aprovechar funciones como las implantaciones multirregión, el equilibrio de carga, el autoescalado y la recuperación ante desastres. También debes saber cómo gestionar soluciones híbridas y multicloud y ser capaz de aplicar prácticas de seguridad avanzadas utilizando IAM, seguridad VPC, cifrado de datos y las herramientas de GCP para la supervisión y protección.

Preguntas que te pueden hacer

A continuación encontrarás posibles preguntas para la entrevista junto con ejemplos de respuestas:

8. Describe cómo configurarías una canalización CI/CD utilizando los servicios de GCP para una aplicación basada en microservicios.

Para configurar una canalización CI/CD utilizando los servicios de GCP para una aplicación basada en microservicios, yo empezaría utilizando Cloud Build para construir y probar el código. Las imágenes de contenedor creadas se almacenarán en Container Registry. Para la implementación, yo utilizaría Kubernetes Engine o Cloud Run, en función de los requisitos de la aplicación. Además, emplearía herramientas de infraestructura como código (Infrastructure as Code, IaC) como Deployment Manager o Terraform para gestionar la infraestructura, y supervisaría las implantaciones con la suite de operaciones de Google Cloud para garantizar un funcionamiento correcto y una rápida resolución de problemas.

9. ¿Cómo supervisas y solucionas los problemas de un entorno GCP complejo?

Para supervisar y solucionar los problemas de un entorno GCP complejo, yo configuraría la suite de operaciones de Google Cloud, que incluye herramientas de supervisión y registro. Crearía paneles personalizados para visualizar las métricas clave y configuraría alertas para eventos críticos. Para la gestión de incidencias, utilizaría herramientas integradas para seguir y resolver los problemas. Depurar aplicaciones implicaría analizar registros y utilizar métricas para identificar cuellos de botella en el rendimiento y otros problemas. Este enfoque integral ayuda a garantizar la fiabilidad y el rendimiento del entorno.

10. ¿Cómo se aprovechan los servicios de machine learning en GCP para una solución de análisis predictivo?

Para aprovechar los servicios de machine learning en GCP para una solución de análisis predictivo, utilizaría AI Platform para entrenar e implementar modelos. Para la creación de modelos personalizados, yo utilizaría AutoML. Para las tareas de machine learning en la base de datos, yo integraría BigQuery ML. Además, utilizaría API preentrenadas para tareas específicas como la visión o el procesamiento del lenguaje natural. Para garantizar la eficacia de toda la canalización, establecería canalizaciones de datos para el preprocesamiento, realizaría ingeniería de características e implementaría procesos de supervisión y reentrenamiento de modelos para mantener la precisión y relevancia de las predicciones.

Preguntas de la entrevista GCP para funciones de científico de datos

Si aspiras a un puesto de científico de datos, tu entrevistador querrá comprobar tu capacidad para trabajar con grandes conjuntos de datos, aplicar métodos estadísticos, crear modelos predictivos y aprovechar los recursos de la nube para el análisis de datos.

Lo que necesitas saber para los puestos de científico de datos

Debes tener un buen conocimiento de los servicios básicos de GCP y comprender sus capacidades, casos de uso y patrones de integración. Los científicos de datos también necesitarán saber sobre:

- Configurar y gestionar un entorno de ciencia de datos: se trata de configurar y optimizar el entorno para un procesamiento y análisis eficaces de los datos.

- BigQuery: las preguntas de la entrevista sobre GCP BigQuery son muy comunes en las entrevistas a científicos de datos, así que asegúrate de que conoces las diferentes características y opciones de optimización del rendimiento que ofrece.

- Herramientas de machine learning: deberías estar familiarizado con AI Platform para entrenar e implementar modelos, AutoML para crear modelos personalizados sin codificación extensa, TensorFlow para construir y entrenar redes neuronales, y BigQuery ML para realizar machine learning directamente dentro de BigQuery.

- Preprocesamiento de datos: comprender cómo utilizar Dataflow para el procesamiento escalable de datos y Dataprep para la limpieza y transformación de datos es crucial. Estas herramientas ayudan a preparar eficazmente los datos para las tareas de análisis y machine learning.

Muchos de estos temas se tratan en nuestro curso Introducción a BigQuery, por si quieres refrescarlos.

Preguntas que te pueden hacer en las entrevistas para científicos de datos

Aquí tienes ejemplos de preguntas y respuestas:

11. ¿Cómo manejas el preprocesamiento de datos y la ingeniería de características en GCP?

Para gestionar el preprocesamiento de datos y la ingeniería de características en GCP, utilizo Cloud Dataflow para tareas de transformación de datos escalables y Dataprep para la limpieza de datos. Aprovecho las capacidades SQL de BigQuery para realizar ingeniería de características, como la creación de nuevas características, la gestión de valores perdidos, la codificación de variables categóricas y el escalado de características para garantizar que estén en el formato adecuado para los modelos de machine learning.

12. ¿Cómo garantizas la reproducibilidad y escalabilidad de tus experimentos de machine learning en GCP?

Para garantizar la reproducibilidad y escalabilidad de mis experimentos de machine learning en GCP, versiono conjuntos de datos y modelos para realizar un seguimiento de los cambios y actualizaciones. Utilizo AI Platform Pipelines para orquestar los flujos de trabajo de ML y ML Metadata para rastrear los metadatos relacionados con los experimentos. Además, utilizo el motor Kubernetes para crear entornos en contenedores, lo que garantiza ejecuciones coherentes y escalables de mis experimentos.

13. ¿Cómo utilizas TensorFlow y AI Platform para proyectos de aprendizaje profundo?

Para utilizar TensorFlow y AI Platform en proyectos de aprendizaje profundo, empiezo configurando un entorno de aprendizaje profundo con TensorFlow, donde creo y entreno redes neuronales. Aprovecho AI Platform para el entrenamiento distribuido y el ajuste de hiperparámetros para optimizar el rendimiento del modelo. Una vez entrenado el modelo, lo despliego utilizando AI Platform para que proporcione predicciones. Para optimizar aún más el rendimiento y gestionar los recursos informáticos, controlo el uso de los recursos y ajusto la infraestructura según sea necesario, garantizando un uso eficiente de la potencia de cálculo.

Preguntas de la entrevista GCP para funciones de ingeniería de datos

Los ingenieros de datos son responsables de diseñar y construir sistemas de datos escalables y fiables, gestionar canalizaciones de datos y garantizar la calidad y fiabilidad de los datos en GCP.

Lo que necesitas saber para las funciones de ingeniería de datos

Debes tener un buen conocimiento de los servicios básicos de GCP y comprender sus capacidades, casos de uso y patrones de integración. Las preguntas de la entrevista para ingeniero de datos de GCP también incluyen los siguientes temas:

- Arquitectura y modelado de datos: debes estar familiarizado con BigQuery, Bigtable, Firestore, Pub/Sub, diseño de esquemas y técnicas de modelado de datos. Esto incluye comprender cómo diseñar arquitecturas de datos eficientes y escalables que satisfagan requisitos empresariales específicos.

- Procesamiento de datos y canalizaciones: es esencial tener conocimientos de Dataflow, Dataproc, Cloud Storage y Cloud Scheduler. Deberías saber cómo utilizar estas tecnologías para el procesamiento por lotes y en flujo, la transformación de datos, la orquestación y la programación para construir sólidas canalizaciones de datos.

- Optimización del rendimiento: debes conocer las técnicas para optimizar el rendimiento y el coste de las soluciones de procesamiento y almacenamiento de datos en GCP. Esto incluye el uso de estrategias de partición, agrupación, indexación, almacenamiento en caché y gestión de recursos para garantizar operaciones de datos eficientes y rentables.

Preguntas que te pueden hacer en las entrevistas de ingeniería de datos

Algunas preguntas y respuestas son:

14. ¿Cómo se gestionan la partición y la fragmentación de datos en un sistema de base de datos distribuida en GCP?

Para gestionar la partición y fragmentación de datos en un sistema de base de datos distribuida en GCP, utilizaría técnicas de partición y fragmentación de datos para garantizar la escalabilidad y el rendimiento. La partición por rangos consiste en dividir los datos basándose en un rango de valores, mientras que la partición hash distribuye los datos basándose en una función hash. La partición compuesta combina varios métodos de partición. Estas estrategias se implementan en servicios como Bigtable, Firestore o Cloud Spanner para gestionar los datos de forma eficiente y garantizar un acceso y recuperación rápidos.

15. ¿Cómo se gestiona la evolución y las versiones de esquemas en una arquitectura de data lake en GCP?

Para gestionar la evolución y el versionado de esquemas en una arquitectura de data lake en GCP, utilizo herramientas como Avro o Protobuf para gestionar los cambios de esquema a lo largo del tiempo. Mantengo un registro de esquemas para versionar esquemas y garantizar la coherencia entre los distintos conjuntos de datos. Además, aplico prácticas de gobernanza de datos para mantener la coherencia de los datos y garantizar la compatibilidad con versiones anteriores, facilitando la gestión de cambios y actualizaciones sin perturbar los flujos de trabajo existentes.

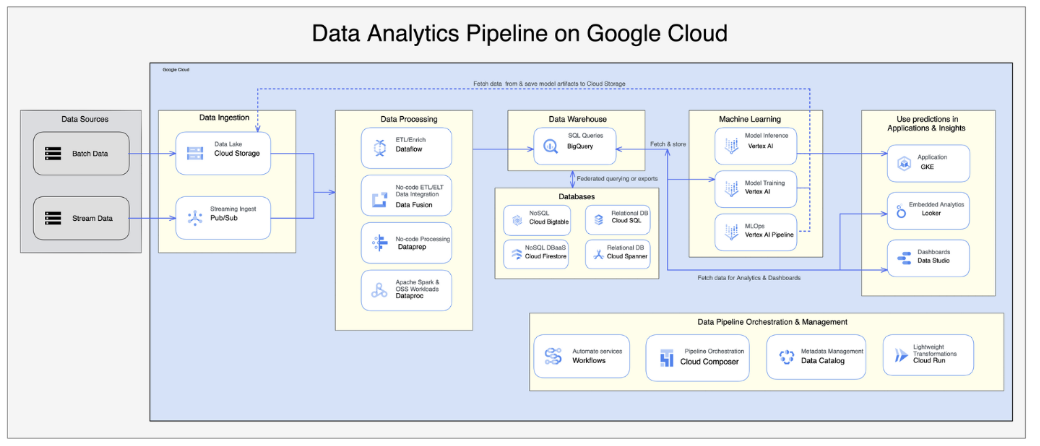

16. ¿Cómo implementarías una canalización de datos utilizando Google Cloud Dataflow y BigQuery?

Para implementar una canalización de datos utilizando Google Cloud Dataflow y BigQuery, yo empezaría por configurar Dataflow para los procesos ETL. Esto implica escribir trabajos de Dataflow para extraer datos de diversas fuentes, transformarlos según sea necesario y cargarlos en BigQuery. Integraría Pub/Sub para la ingestión de datos en tiempo real, garantizando un procesamiento de datos puntual y preciso. Además, manejaría el esquema de datos, aplicaría estrategias de partición y utilizaría técnicas de optimización para garantizar un almacenamiento y una recuperación eficientes de los datos en BigQuery.

Fuente: Artículo sobre la arquitectura de la canalización de datos en GCP

Preguntas de la entrevista sobre GCP para puestos de arquitecto de la nube

La mayoría de las preguntas pondrán a prueba tu experiencia en la arquitectura de soluciones que satisfagan tanto los requisitos empresariales como los técnicos. Tu entrevistador querrá asegurarse de que las soluciones que propones son fiables, seguras y rentables.

Lo que necesitas saber para las funciones de arquitecto de la nube

Debes tener un buen conocimiento de los servicios básicos de GCP y conocer a fondo sus capacidades, casos de uso y patrones de integración.

Como arquitecto de la nube, podrías ser responsable de la migración o integración de sistemas enteros a GCP. Por lo tanto, las preguntas de la entrevista para arquitecto de GCP pueden poner a prueba tus conocimientos sobre arquitecturas híbridas o multinube, y las mejores prácticas para diseñar soluciones fiables en la nube a escala. Apóyate en tu experiencia previa, y habla de casos de uso y escenarios que hayas manejado con éxito en el pasado.

Preguntas que te pueden hacer en las entrevistas de arquitecto de la nube

Algunas preguntas y respuestas son:

17. ¿Puedes explicar los pasos y aspectos a tener en cuenta para migrar una aplicación local de gran escala a GCP?

Para migrar una aplicación local de gran escala a GCP, yo empezaría con una fase de valoración para evaluar la infraestructura actual e identificar las dependencias. En la fase de planificación, diseñaría la estrategia de migración, incluyendo la selección de los servicios GCP adecuados y herramientas como Migrate for Compute Engine para la migración de máquinas virtuales y las opciones de transferencia de datos. Durante la fase de ejecución, rediseñaría la aplicación para la nube, gestionaría las dependencias, realizaría pruebas exhaustivas e implementaría estrategias para minimizar el tiempo de inactividad.

18. ¿Puedes describir los casos de uso y los retos relacionados con las aplicaciones multinube, es decir, la integración de GCP con otros proveedores de nube?

Las aplicaciones multinube se utilizan a menudo para la recuperación ante desastres, el análisis de datos o la distribución de cargas de trabajo. Integrar GCP con otros proveedores de nube implica retos como la conectividad de red, la transferencia de datos, la gestión de identidades y el mantenimiento de la seguridad en todos los entornos. Herramientas como Anthos pueden ayudar a gestionar clústeres Kubernetes multinube, garantizando una integración sin fisuras y un funcionamiento eficiente.

19. Explica cómo gestionarías la recuperación ante desastres y la planificación de la continuidad del negocio en una arquitectura en la nube en GCP.

Para la recuperación ante desastres y la planificación de la continuidad empresarial en una arquitectura en la nube en GCP, yo configuraría la replicación entre regiones para garantizar la redundancia de los datos. Implantar mecanismos de conmutación por error ayudaría a mantener la disponibilidad del servicio en caso de fallos. Las copias de seguridad periódicas son cruciales para la protección de datos, y yo también probaría periódicamente los procedimientos de recuperación ante desastres para asegurarme de que son eficaces y están actualizados.

20. Explica cómo optimizarías el coste de la infraestructura de la nube en GCP, garantizando al mismo tiempo el rendimiento y la escalabilidad.

Para optimizar el coste de la infraestructura en la nube en GCP, yo utilizaría máquinas virtuales Compute Engine Preemptible para una computación rentable. Redimensionar las instancias garantiza que los recursos se asignen adecuadamente en función de su uso. Aprovechar los descuentos por compromiso de uso puede reducir aún más los costes. Además, utilizaría herramientas de gestión de costes como Cost Explorer y Budgets para supervisar y controlar el gasto, manteniendo al mismo tiempo el rendimiento y la escalabilidad.

Nota: Otro tema que a menudo se pasa por alto, pero que surge con bastante frecuencia en las entrevistas, es la optimización de costes. Según el Informe Flexera 2024 sobre el estado de la nubelas empresas hacen de la optimización de costes una prioridad cuando se trata de computación en nube, así que asegúrate de que sabes cómo utilizar las herramientas de gestión de costes en GCP y de que conoces estrategias como el aprovisionamiento de recursos y la asignación de derechos.

Reflexiones finales

Ahora que tienes una idea más clara de lo que puedes esperar en tu entrevista sobre GCP, puedes empezar a llenar las lagunas de tus conocimientos.

Aunque los cursos teóricos son estupendos para empezar, creo que la práctica con escenarios del mundo real es la mejor manera de adquirir experiencia en GCP. Hay muchos recursos por ahí que puedes utilizar, y yo recomendaría los cursos de formación de Google Cloud si puedes permitirte la suscripción mensual de 29 $.

Además, el DataLab de DataCamp es una plataforma excelente para practicar tus habilidades. DataLab es un cuaderno basado en la nube que te permite experimentar con código, analizar datos, colaborar con otros y compartir ideas sin necesidad de instalación. Proporciona un entorno sin fisuras para trabajar con datos del mundo real, lo que la convierte en una herramienta práctica para perfeccionar tus habilidades con los datos.

También puedes llevar tus estudios más allá y añadir una certificación oficial de GCP a tu CV o perfil de LinkedIn para mostrar tus habilidades a posibles empleadores. Para cada certificación, Google proporciona un examen práctico gratuito. Su finalidad es ayudarte a prepararte para el examen oficial, pero también funcionan muy bien para las entrevistas, así que asegúrate de echarles un vistazo.

Espero que esta guía te haya resultado útil, ¡y te deseo mucha suerte en tu entrevista!

Preguntas frecuentes

¿Qué NO debo hacer al prepararme para una entrevista sobre GCP?

Intenta no solamente memorizar datos. En lugar de eso, esfuérzate por comprender los conceptos subyacentes y prepárate para debatir situaciones de la vida real.

¿Necesito memorizar los comandos de GCP?

En absoluto. ¡Para eso está la documentación!

¿Necesito tener experiencia práctica con GCP antes de una entrevista?

Sin duda es beneficioso, pero no es un requisito sine qua non. Demostrar una sólida comprensión de los conceptos de GCP, junto con la voluntad de aprender y adaptarse, puede llevarte muy lejos.

Tengo experiencia con AWS o Azure. ¿Cuánto de ese conocimiento es transferible?

Los proveedores de la nube tienen una terminología diferente y servicios únicos, pero los conceptos fundamentales de la computación en nube son los mismos. Si tienes experiencia previa con otro proveedor de la nube, podrás establecer paralelismos entre los servicios y aprender GCP más rápidamente que si empezaras desde cero.

¿Qué debo hacer si el entrevistador hace una pregunta de la que no sé la respuesta?

Si no sabes la respuesta a una pregunta, ¡que no cunda el pánico! Si la pregunta se refiere a un servicio que no conoces o a un escenario con el que nunca te has encontrado, puedes, a tu vez, hacer preguntas aclaratorias. Tómate un tiempo para pensar, explicar tu proceso de pensamiento y apoyarte en tu experiencia para proponer una respuesta lógica.