Kurs

Die meisten Stellenbeschreibungen auf dem heutigen Arbeitsmarkt führen Cloud-Fähigkeiten im Abschnitt "Erforderlich" oder zumindest im Abschnitt "Nice-to-have" direkt darunter auf. Dieser Trend ist nicht rollenspezifisch. Egal, ob du Anwendungen entwickelst, mit Daten arbeitest oder dich auf Sicherheit spezialisierst: Arbeitgeber brauchen dich, um den von ihnen gewählten Cloud-Anbieter zu nutzen.

In den letzten 5 Jahren habe ich in vielen Start-ups gearbeitet und - so klischeehaft es klingt - viele Hüte getragen. Ich habe mich mit der Google Cloud Platform (GCP) beschäftigt und über 40 technische Interviews geführt, in denen ich das Wissen anderer Ingenieure zu diesem Thema getestet habe.

In diesem Leitfaden findest du meine besten Ratschläge für die Beantwortung von GCP-Interviewfragen, die auf dein Qualifikationsniveau und deine Rolle zugeschnitten sind. Du kannst gerne zu dem Abschnitt springen, der für dich am wichtigsten ist. Die allgemeinen Abschnitte dienen jedoch als Bausteine für die rollenspezifischen Abschnitte, daher würde ich empfehlen, diese zuerst zu lesen.

Und bevor du anfängst: Wenn du ganz neu im Cloud Computing bist, empfehle ich dir, zuerst unseren Kurs Einführung in das Cloud Computing zu besuchen. In diesem Kurs werden die Grundlagen der Cloud erläutert, Schlüsselbegriffe wie Skalierbarkeit und Latenz erklärt und die Vorteile von Cloud-Tools von Anbietern wie Google Cloud vorgestellt.

Grundlegende GCP-Interview-Fragen

Für Berufsanfänger haben die Fragen und Antworten im GCP-Interview wenig oder keine technischen Elemente. Es geht darum, dass du die Angebote von GCP verstehst und weißt, wie die Produkte zusammenpassen. Diese Fragen werden dir höchstwahrscheinlich gestellt, wenn du noch nie mit GCP gearbeitet hast oder wenn der Interviewer sich nicht sicher ist, wie gut du bist und mit den Grundlagen beginnen möchte.

Was du wissen musst

Du solltest mit den Kerndiensten von GCP vertraut sein, wie Compute Engine, Kubernetes Engine, Cloud Storage, BigQuery, Cloud SQL und Pub/Sub. Es könnte auch Fragen geben zu:

- Identitäts- und Zugriffsmanagement (IAM): Verstehen von IAM-Rollen, Berechtigungen und der Verwaltung des Benutzerzugriffs innerhalb von GCP.

- Datenspeicherung und Datenbanken: Kenntnisse über Cloud Storage, Cloud SQL, Cloud Spanner, Firestore und Bigtable, einschließlich ihrer Anwendungsfälle und Konfigurationen.

- Serverloses Computing: Vertrautheit mit Cloud Functions, Cloud Run und App Engine und wie man serverlose Anwendungen einsetzt und verwaltet.

- Überwachung und Protokollierung: Beherrschung der Google Cloud Operations Suite (ehemals Stackdriver), einschließlich Monitoring, Logging, Trace, Debugger und Fehlerberichterstattung, um die Zuverlässigkeit und Leistung des Systems sicherzustellen.

Wenn dir diese Konzepte unbekannt vorkommen und du nicht weißt, wo du anfangen sollst, probiere unseren Kurs Einführung in GCP aus. Es wird dir eine solide Grundlage zu den oben genannten Themen geben.

Fragen, die du bekommen könntest

Hier sind einige Fragen, die ein Interviewer stellen könnte, mit Beispielantworten:

1. Was ist die Google Compute Engine und was sind ihre wichtigsten Anwendungsfälle?

Google Compute Engine bietet skalierbare virtuelle Maschinen, die in den Rechenzentren von Google betrieben werden. Diese VMs werden häufig für die Ausführung von Webanwendungen, das Hosting von Datenbanken und die Bewältigung umfangreicher Rechenaufgaben wie Datenverarbeitung und maschinelles Lernen verwendet.

2. Was sind Google Cloud Storage-Klassen und wie unterscheiden sie sich?

Google Cloud Storage bietet vier Haupt-Speicherklassen an: Standard Storage für Daten, auf die häufig zugegriffen wird, mit hoher Leistung, Nearline Storage für Daten, auf die weniger als einmal im Monat zugegriffen wird, zu geringeren Kosten, Coldline Storage für Daten, auf die weniger als einmal im Jahr zugegriffen wird, zu noch geringeren Kosten, und Archive Storage für die langfristige Datenarchivierung und -sicherung mit den niedrigsten Kosten.

Hinweis: Du bekommst Bonuspunkte, wenn du praktische Beispiele für die Art von Daten nennen kannst, die in jeder dieser Speicherklassen gespeichert werden. Wenn du zum Beispiel ein Vorstellungsgespräch für eine Social Media App führst, solltest du über Profilbilder, Aktivitätsprotokolle und Compliance-Daten sprechen.

3. Was ist Google Cloud Pub/Sub und was sind seine typischen Anwendungsfälle?

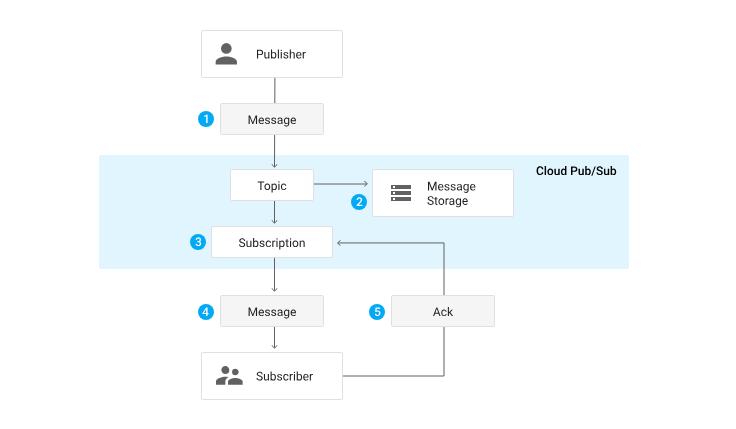

Pub/Sub wurde für Echtzeit-Messaging und ereignisgesteuerte Architekturen entwickelt, um die asynchrone Kommunikation zwischen Diensten zu unterstützen. Zu den typischen Anwendungsfällen gehören Logging-Systeme, Dateneingabe-Pipelines, Echtzeit-Analysen und die Integration von Microservices.

4. Was ist eine BigQuery und wie verarbeitet sie große Datenmengen?

BigQuery ist das serverlose Data Warehouse von Google und wurde entwickelt, um große Datenmengen effizient mit SQL zu verarbeiten. Es verwendet eine spaltenorientierte Speicherung, bei der die Daten auf der Festplatte in Spalten statt in Zeilen gespeichert werden, um leseintensive Vorgänge zu optimieren. Sie nutzt auch die parallele Verarbeitung und ermöglicht die Verteilung von Aufgaben auf mehrere Maschinen, um Daten gleichzeitig zu verarbeiten . Dadurch kann BigQuery selbst bei Petabytes an Daten schnelle Abfragen durchführen. Außerdem lässt es sich mit anderen GCP-Diensten wie Dataflow für die Datenverarbeitung und Pub/Sub für die Datenaufnahme in Echtzeit integrieren. BigQuery enthält auch Funktionen wie BigQuery ML, um maschinelles Lernen direkt auf der Plattform durchzuführen.

GCP-Interview-Fragen für Fortgeschrittene

Diese Fragen werden gestellt, sobald dein Gesprächspartner festgestellt hat, dass du einige Grundkenntnisse über die Angebote von GCP hast. Sie sind in der Regel etwas technischer und testen dein Verständnis für bestimmte Dienste, ihre Konfigurationen und ihre effektive Nutzung in verschiedenen Szenarien.

Du wirst sie wahrscheinlich beantworten können, wenn du praktische Erfahrung mit GCP hast und bereits Ressourcen verwaltet, IAM-Richtlinien implementiert und VMs konfiguriert hast, oder wenn du unseren Kurs "Cloud Computing verstehen" abgeschlossen hast.

Was du wissen musst

Du musst dein Wissen über die Angebote von GCP ausbauen und ein tieferes Verständnis für die folgenden Dienste zeigen:

- Compute- und Skalierungslösungen: Du solltest ein umfassendes Verständnis von Compute Engine, Kubernetes Engine und App Engine haben, einschließlich Konzepten wie Autoskalierung, Lastausgleich und Ressourcenoptimierung.

- Netzwerken: Es ist wichtig, mit Virtual Private Cloud (VPC), VPC Peering, Shared VPC und VPNs vertraut zu sein, sowie mit der Konfiguration und Verwaltung von Subnetzen, Firewalls, Routen, VPNs und Lastverteilung.

- Datenbanklösungen: Du musst Cloud SQL, Cloud Spanner, Bigtable und Firestore verstehen, einschließlich ihrer Konfigurationen und geeigneten Anwendungsfälle.

- IAM: Du solltest fortgeschrittene IAM-Funktionen wie benutzerdefinierte Rollen, Dienstkonten und Workload-Identitätsverbünde kennen.

- DevOps und CI/CD-Praktiken: Kenntnisse von Cloud Build, Container Registry und CI/CD-Pipeline-Automatisierung sind wichtig für effiziente Entwicklungs- und Bereitstellungspraktiken.

- Sicherheit und Compliance: Du solltest die Sicherheitsangebote von GCP kennen, einschließlich der Verschlüsselungsmethoden, der Verwaltung von Sicherheitsschlüsseln und der Einhaltung von Compliance-Standards.

- Big Data und Analytik: Ein gutes Verständnis von BigQuery, Data Studio, Dataprep und Looker ist für umfangreiche Datenanalysen und Visualisierungsaufgaben erforderlich.

Du musst kein Experte für all diese Themen sein. Es reicht schon aus, wenn du die gängigsten Funktionen und Konfigurationsoptionen kennst!

Fragen, die du bekommen könntest

Hier ist eine Liste mit häufigen Interviewfragen und Antwortvorschlägen:

5. Wie konfigurierst und verwaltest du die automatische Skalierung in Google Compute Engine?

Um Autoscaling in Google Compute Engine zu konfigurieren und zu verwalten, würde ich damit beginnen, Instanzgruppen einzurichten. Dann würde ich Richtlinien für die automatische Skalierung definieren, die auf relevanten Metriken wie der CPU-Auslastung und der Nutzung des Lastausgleichs basieren. Diese Konfiguration stellt sicher, dass das System bei hoher Nachfrage hochgefahren wird, um die Leistung zu erhalten, und bei geringer Nachfrage heruntergefahren wird, um die Kosteneffizienz zu optimieren.

6. Erkläre, wie du Cloud Pub/Sub für eine Echtzeit-Messaging-Anwendung einrichtest und nutzt.

Um Cloud Pub/Sub für eine Echtzeit-Messaging-Anwendung einzurichten und zu nutzen, würde ich Themen und Abonnements nutzen, um den Nachrichtenfluss zu verwalten. Ich würde die Einstellungen für die Nachrichtenaufbewahrung und die Bestätigungen konfigurieren, um eine zuverlässige Zustellung zu gewährleisten. Je nach Anwendungsfall verwende ich Push-Abonnements für die Lieferung in Echtzeit oder Pull-Abonnements für die Stapelverarbeitung. Außerdem würde ich Pub/Sub mit anderen GCP-Diensten wie Dataflow für die Datenverarbeitung und Cloud Functions für die ereignisgesteuerte Verarbeitung integrieren.

Lebenszyklus einer Nachricht durch Pub/Sub. Quelle: GCP Pub/Sub Dokumentation

7. Wie nutzt du Google Cloud IAM, um temporären Zugriff auf Ressourcen zu gewähren?

Um mit Google Cloud IAM temporären Zugriff auf Ressourcen zu gewähren, würde ich damit beginnen, benutzerdefinierte Rollen zu erstellen, die nur die notwendigen Berechtigungen haben und dabei das Prinzip der geringsten Privilegien einhalten. Als Nächstes würde ich Dienstkonten konfigurieren, um den Zugriff für Anwendungen und Dienste zu verwalten. Für kurzfristige Zugriffsanforderungen würde ich den Identity-Aware Proxy (IAP) verwenden, um kurzlebige Anmeldeinformationen auszustellen oder signierte URLs für den Cloud-Speicher zu generieren, um zeitlich begrenzten Zugriff auf bestimmte Ressourcen zu ermöglichen.

Fortgeschrittene GCP-Interview-Fragen

Auf dieser Stufe achten die Interviewer auf fundierte technische Kenntnisse, praktische Erfahrung und die Fähigkeit, komplexe Lösungen in GCP zu entwickeln. Sie werden erwarten, dass deine Antworten die besten Praktiken zur Optimierung und Sicherung von Cloud-Umgebungen berücksichtigen. Auch wenn es einige Ausnahmen gibt, sollten dir nur dann fortgeschrittene Fragen gestellt werden, wenn du dich für eine Führungsposition oder eine Stelle mit einer starken DevOps-Komponente bewirbst.

Was du wissen musst

Zusätzlich zu den oben erwähnten Grund- und Mittelstufenkenntnissen könnte dein Gesprächspartner dich nach der allgemeinen Architektur und dem Design skalierbarer Cloud-Lösungen fragen und danach, wie du Funktionen wie den Einsatz mehrerer Regionen, Lastausgleich, automatische Skalierung und Disaster Recovery nutzen kannst. Du solltest auch wissen, wie man hybride und Multi-Cloud-Lösungen verwaltet und in der Lage sein, fortschrittliche Sicherheitspraktiken mit IAM, VPC-Sicherheit, Datenverschlüsselung und den GCP-Tools für Überwachung und Schutz zu implementieren.

Fragen, die du bekommen könntest

Im Folgenden findest du mögliche Interviewfragen mit Beispielantworten:

8. Beschreibe, wie du eine CI/CD-Pipeline mit GCP-Diensten für eine Microservices-basierte Anwendung einrichten würdest.

Um eine CI/CD-Pipeline mit GCP-Diensten für eine Microservices-basierte Anwendung einzurichten, würde ich zunächst Cloud Build zum Erstellen und Testen des Codes verwenden. Die erstellten Container-Images werden dann in der Container Registry gespeichert. Für die Bereitstellung würde ich Kubernetes Engine oder Cloud Run verwenden, je nach den Anforderungen der Anwendung. Außerdem würde ich Infrastructure as Code (IaC) Tools wie Deployment Manager oder Terraform einsetzen, um die Infrastruktur zu verwalten, und ich würde die Einsätze mit der Google Cloud Operations Suite überwachen, um einen reibungslosen Betrieb und eine schnelle Problemlösung sicherzustellen.

9. Wie überwachst du eine komplexe GCP-Umgebung und behebst Fehler?

Um eine komplexe GCP-Umgebung zu überwachen und Fehler zu beheben, würde ich die Operations Suite von Google Cloud einrichten, die Tools zur Überwachung und Protokollierung enthält. Ich würde benutzerdefinierte Dashboards erstellen, um wichtige Metriken zu visualisieren und Warnmeldungen für kritische Ereignisse einzurichten. Für das Incident Management würde ich integrierte Tools verwenden, um Probleme zu verfolgen und zu lösen. Beim Debuggen von Anwendungen werden Logs analysiert und Metriken verwendet, um Leistungsengpässe und andere Probleme zu identifizieren. Dieser umfassende Ansatz trägt dazu bei, die Zuverlässigkeit und Leistungsfähigkeit der Umwelt zu gewährleisten.

10. Wie lassen sich die Dienste für maschinelles Lernen auf GCP für eine Predictive-Analytics-Lösung nutzen?

Um die Dienste für maschinelles Lernen auf GCP für eine Predictive-Analytics-Lösung zu nutzen, würde ich die KI-Plattform verwenden, um Modelle zu trainieren und einzusetzen. Für die Erstellung eigener Modelle würde ich AutoML verwenden. Für datenbankinterne Machine Learning-Aufgaben würde ich BigQuery ML integrieren. Außerdem würde ich für bestimmte Aufgaben wie die Bildverarbeitung oder die Verarbeitung natürlicher Sprache vortrainierte APIs verwenden. Um sicherzustellen, dass die gesamte Pipeline effizient ist, würde ich Datenpipelines für die Vorverarbeitung einrichten, Feature Engineering durchführen und Modellüberwachungs- und Umschulungsprozesse implementieren, um die Genauigkeit und Relevanz der Vorhersagen zu erhalten.

GCP-Interviewfragen für Data Scientist-Rollen

Wenn du dich für eine Stelle als Datenwissenschaftler/in bewirbst, wird dein Gesprächspartner deine Fähigkeit testen wollen, mit großen Datensätzen zu arbeiten, statistische Methoden anzuwenden, Vorhersagemodelle zu erstellen und Cloud-Ressourcen für die Datenanalyse zu nutzen.

Was du für die Rolle des Data Scientist wissen musst

Du solltest dich gut mit den Kerndiensten von GCP auskennen und ein Verständnis für ihre Fähigkeiten, Anwendungsfälle und Integrationsmuster haben. Data Scientists müssen auch über Folgendes Bescheid wissen:

- Einrichten und Verwalten einer Data Science-Umgebung: Dazu gehört, die Umgebung für eine effiziente Datenverarbeitung und -analyse zu konfigurieren und zu optimieren.

- BigQuery: Fragen zu GCP BigQuery werden in Interviews mit Datenwissenschaftlern häufig gestellt, also stelle sicher, dass du die verschiedenen Funktionen und Optionen zur Leistungsoptimierung kennst, die es bietet.

- Machine Learning Tools: Du solltest mit AI Platform für das Training und den Einsatz von Modellen, AutoML für die Erstellung benutzerdefinierter Modelle ohne umfangreiche Programmierung, TensorFlow für den Aufbau und das Training neuronaler Netze und BigQuery ML für die Durchführung von maschinellem Lernen direkt in BigQuery vertraut sein.

- Datenvorverarbeitung: Es ist wichtig zu verstehen, wie man Dataflow für die skalierbare Datenverarbeitung und Dataprep für die Datenbereinigung und -umwandlung nutzt. Diese Tools helfen dabei, Daten für Analysen und maschinelle Lernaufgaben effizient vorzubereiten.

Viele dieser Themen werden in unserem Kurs Einführung in BigQuery behandelt, falls du sie auffrischen möchtest.

Fragen, die dir in Vorstellungsgesprächen mit Data Scientists gestellt werden können

Hier sind Beispielfragen und -antworten:

11. Wie handhabst du die Datenvorverarbeitung und das Feature Engineering in GCP?

Für die Datenvorverarbeitung und das Feature Engineering in GCP verwende ich Cloud Dataflow für skalierbare Datentransformationsaufgaben und Dataprep für die Datenbereinigung. Ich nutze die SQL-Fähigkeiten von BigQuery für das Feature Engineering, z. B. für die Erstellung neuer Features, den Umgang mit fehlenden Werten, die Kodierung kategorischer Variablen und die Skalierung von Features, um sicherzustellen, dass sie das richtige Format für Machine Learning-Modelle haben.

12. Wie stellst du die Reproduzierbarkeit und Skalierbarkeit deiner Machine-Learning-Experimente auf GCP sicher?

Um die Reproduzierbarkeit und Skalierbarkeit meiner Machine-Learning-Experimente auf GCP zu gewährleisten, versioniere ich Datensätze und Modelle, um Änderungen und Aktualisierungen zu verfolgen. Ich verwende AI Platform Pipelines, um ML-Workflows zu orchestrieren, und ML Metadata, um Metadaten zu den Experimenten zu verfolgen. Außerdem verwende ich die Kubernetes Engine, um containerisierte Umgebungen zu erstellen, die eine konsistente und skalierbare Ausführung meiner Experimente gewährleisten.

13. Wie nutzt du TensorFlow und AI Platform für Deep Learning Projekte?

Um TensorFlow und AI Platform für Deep Learning-Projekte zu nutzen, beginne ich damit, eine Deep Learning-Umgebung mit TensorFlow einzurichten, in der ich neuronale Netze erstelle und trainiere. Ich nutze AI Platform für verteiltes Training und Hyperparameter-Tuning, um die Leistung des Modells zu optimieren. Sobald das Modell trainiert ist, setze ich es mit AI Platform ein, um Vorhersagen zu treffen. Um die Leistung weiter zu optimieren und die Rechenressourcen zu verwalten, überwache ich die Ressourcennutzung und passe die Infrastruktur nach Bedarf an, um eine effiziente Nutzung der Rechenleistung zu gewährleisten.

GCP-Interview-Fragen für Data Engineer-Rollen

Data Engineers sind für die Entwicklung und den Aufbau skalierbarer und zuverlässiger Datensysteme, die Verwaltung von Datenpipelines und die Sicherstellung der Datenqualität und -zuverlässigkeit auf GCP verantwortlich.

Was du für Data Engineering Roles wissen musst

Du solltest dich gut mit den Kerndiensten von GCP auskennen und ein Verständnis für ihre Fähigkeiten, Anwendungsfälle und Integrationsmuster haben. GCP Data Engineer Interviewfragen umfassen auch die folgenden Themen:

- Datenarchitektur und -modellierung: Du solltest mit BigQuery, Bigtable, Firestore, Pub/Sub, Schemadesign und Datenmodellierungstechniken vertraut sein. Dazu gehört auch das Wissen, wie man effiziente und skalierbare Datenarchitekturen entwirft, die den spezifischen Geschäftsanforderungen entsprechen.

- Datenverarbeitung und Pipelines: Kenntnisse in Dataflow, Dataproc, Cloud Storage und Cloud Scheduler sind unerlässlich. Du solltest wissen, wie du diese Technologien für Batch- und Stream-Verarbeitung, Datenumwandlung, Orchestrierung und Planung nutzen kannst, um robuste Datenpipelines aufzubauen.

- Performance-Optimierung: Du musst die Techniken kennen, mit denen du die Leistung und die Kosten von Datenverarbeitungs- und Speicherlösungen auf GCP optimieren kannst. Dazu gehört der Einsatz von Partitionierungs-, Clustering-, Indizierungs-, Caching- und Ressourcenmanagementstrategien, um einen effizienten und kostengünstigen Datenbetrieb zu gewährleisten.

Fragen, die du in Vorstellungsgesprächen für Datentechnik bekommen kannst

Hier sind einige Fragen und Antworten:

14. Wie handhabst du Datenpartitionierung und Sharding in einem verteilten Datenbanksystem auf GCP?

Um Datenpartitionierung und Sharding in einem verteilten Datenbanksystem auf GCP zu handhaben, würde ich Datenpartitionierungs- und Sharding-Techniken verwenden, um Skalierbarkeit und Leistung zu gewährleisten. Bei der Bereichspartitionierung werden die Daten anhand eines Wertebereichs aufgeteilt, während bei der Hash-Partitionierung die Daten anhand einer Hash-Funktion verteilt werden. Die zusammengesetzte Partitionierung kombiniert mehrere Partitionierungsmethoden. Diese Strategien werden in Diensten wie Bigtable, Firestore oder Cloud Spanner umgesetzt, um Daten effizient zu verwalten und einen schnellen Zugriff und Abruf zu gewährleisten.

15. Wie handhabt ihr die Schemaentwicklung und -versionierung in einer Data-Lake-Architektur auf GCP?

Um die Schemaentwicklung und -versionierung in einer Data Lake-Architektur auf GCP zu handhaben, verwende ich Tools wie Avro oder Protobuf, um Schemaänderungen im Laufe der Zeit zu verwalten. Ich pflege eine Schemaregistrierung, um Schemata zu versionieren und die Konsistenz zwischen verschiedenen Datensätzen zu gewährleisten. Außerdem setze ich Data-Governance-Praktiken ein, um die Datenkonsistenz zu wahren und die Abwärtskompatibilität zu gewährleisten, sodass Änderungen und Aktualisierungen einfacher zu handhaben sind, ohne die bestehenden Arbeitsabläufe zu stören.

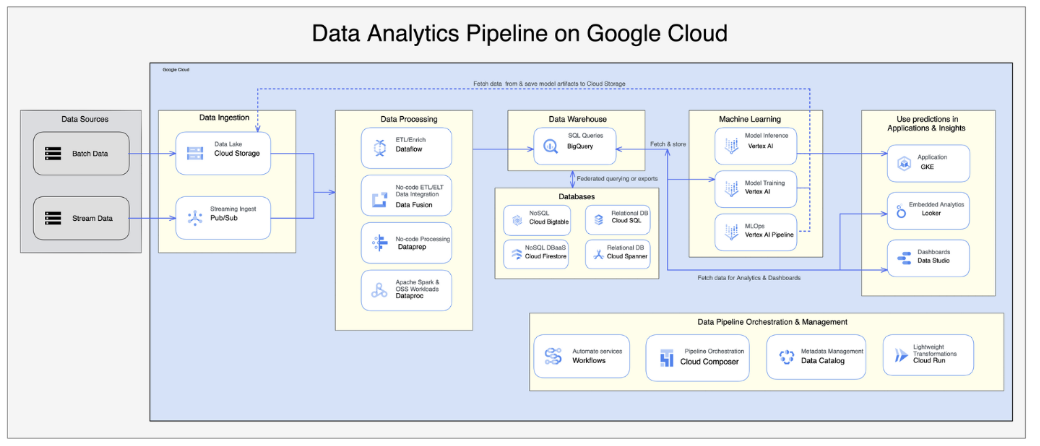

16. Wie würdest du eine Datenpipeline mit Google Cloud Dataflow und BigQuery implementieren?

Um eine Datenpipeline mit Google Cloud Dataflow und BigQuery zu implementieren, würde ich damit beginnen, Dataflow für ETL-Prozesse einzurichten. Dazu gehört das Schreiben von Dataflow-Jobs, um Daten aus verschiedenen Quellen zu extrahieren, sie nach Bedarf umzuwandeln und sie in BigQuery zu laden. Ich würde Pub/Sub für die Datenaufnahme in Echtzeit integrieren, um eine zeitnahe und genaue Datenverarbeitung zu gewährleisten. Außerdem würde ich Datenschemata bearbeiten, Partitionierungsstrategien anwenden und Optimierungstechniken nutzen, um eine effiziente Datenspeicherung und -abfrage in BigQuery zu gewährleisten.

Quelle: GCP Data Pipeline Architektur Artikel

GCP-Interview-Fragen für die Rolle des Cloud-Architekten

Die meisten Fragen hier werden dein Fachwissen bei der Entwicklung von Lösungen testen, die sowohl die geschäftlichen als auch die technischen Anforderungen erfüllen. Dein Gesprächspartner wird sich vergewissern wollen, dass die von dir vorgeschlagenen Lösungen zuverlässig, sicher und kostengünstig sind.

Was du für die Rolle des Cloud-Architekten wissen musst

Du solltest dich gut mit den Kerndiensten von GCP auskennen und ein tiefes Verständnis für deren Fähigkeiten, Anwendungsfälle und Integrationsmuster haben.

Als Cloud-Architekt/in könntest du für die Migration oder Integration ganzer Systeme auf GCP verantwortlich sein. Daher können die Fragen im GCP-Architekten-Interview dein Fachwissen über hybride oder Multi-Cloud-Architekturen und die besten Praktiken für die Entwicklung zuverlässiger Cloud-Lösungen im großen Maßstab testen. Greife auf deine bisherigen Erfahrungen zurück und erzähle von Anwendungsfällen und Szenarien, die du in der Vergangenheit erfolgreich gemeistert hast.

Fragen, die du in Vorstellungsgesprächen als Cloud Architect bekommen könntest

Hier sind einige Fragen und Antworten:

17. Kannst du die Schritte und Überlegungen für die Migration einer großen On-Premises-Anwendung zu GCP erklären?

Um eine große On-Premises-Anwendung auf GCP zu migrieren, würde ich mit einer Bewertungsphase beginnen, um die aktuelle Infrastruktur zu bewerten und Abhängigkeiten zu identifizieren. In der Planungsphase würde ich die Migrationsstrategie entwerfen, einschließlich der Auswahl geeigneter GCP-Dienste und Tools wie Migrate for Compute Engine für VM-Migration und Datenübertragungsoptionen. Während der Ausführungsphase würde ich die Anwendung für die Cloud umgestalten, Abhängigkeiten handhaben, gründliche Tests durchführen und Strategien zur Minimierung von Ausfallzeiten umsetzen.

18. Können Sie die Anwendungsfälle und Herausforderungen im Zusammenhang mit Multi-Cloud-Anwendungen beschreiben, d.h. die Integration von GCP mit anderen Cloud-Anbietern?

Multi-Cloud-Anwendungen werden oft für Disaster Recovery, Datenanalysen oder die Verteilung von Arbeitslasten genutzt. Die Integration von GCP mit anderen Cloud-Anbietern bringt Herausforderungen mit sich, wie z.B. Netzwerkkonnektivität, Datentransfer, Identitätsmanagement und die Aufrechterhaltung der Sicherheit in verschiedenen Umgebungen. Tools wie Anthos können bei der Verwaltung von Multi-Cloud-Kubernetes-Clustern helfen und so eine nahtlose Integration und einen effizienten Betrieb sicherstellen.

19. Erkläre, wie du die Disaster Recovery und Business Continuity Planung in einer Cloud-Architektur auf GCP handhaben würdest.

Für die Notfallwiederherstellung und die Planung der Geschäftskontinuität in einer GCP-Cloud-Architektur würde ich eine regionsübergreifende Replikation einrichten, um Datenredundanz zu gewährleisten. Die Implementierung von Failover-Mechanismen würde dazu beitragen, die Verfügbarkeit von Diensten im Falle von Ausfällen aufrechtzuerhalten. Regelmäßige Backups sind entscheidend für den Datenschutz, und ich würde auch die Disaster-Recovery-Verfahren regelmäßig testen, um sicherzustellen, dass sie effektiv und aktuell sind.

20. Erkläre, wie du die Kosten für die Cloud-Infrastruktur auf GCP optimieren und gleichzeitig Leistung und Skalierbarkeit sicherstellen würdest.

Um die Kosten für die Cloud-Infrastruktur auf GCP zu optimieren, würde ich Compute Engine Preemptible VMs für kostengünstiges Computing verwenden. Das Rightsizing von Instanzen stellt sicher, dass die Ressourcen je nach Nutzung angemessen zugewiesen werden. Die Nutzung von Preisnachlässen für die verbindliche Nutzung kann die Kosten weiter senken. Außerdem würde ich Kostenmanagement-Tools wie Cost Explorer und Budgets verwenden, um die Ausgaben zu überwachen und zu kontrollieren und gleichzeitig die Leistung und Skalierbarkeit zu erhalten.

Hinweis: Ein weiteres Thema, das oft übersehen wird, aber in Gesprächen recht häufig auftaucht, ist die Kostenoptimierung. Laut dem Flexera 2024 State of the Cloud Reportstellen Unternehmen die Kostenoptimierung in den Vordergrund, wenn es um Cloud Computing geht. Stelle also sicher, dass du weißt, wie du die Kostenmanagement-Tools in GCP nutzen kannst und dass du Strategien wie Ressourcenbereitstellung und Rechtevergabe verstehst.

Schlussgedanken

Jetzt, wo du eine bessere Vorstellung davon hast, was dich in deinem GCP-Gespräch erwartet, kannst du damit beginnen, die Lücken in deinem Wissen zu schließen.

Theoretische Kurse sind zwar gut für den Einstieg, aber ich finde, dass die praktische Arbeit mit realen Szenarien der beste Weg ist, um GCP-Kenntnisse zu erwerben. Es gibt viele Ressourcen, die du nutzen kannst. Ich empfehle dir die Google Cloud Training-Kurse, wenn du dir das 29$ Monatsabo leisten kannst.

Außerdem ist das DataLab von DataCamp eine hervorragende Plattform, um deine Fähigkeiten zu trainieren. DataLab ist ein cloudbasiertes Notebook, mit dem du mit Code experimentieren, Daten analysieren, mit anderen zusammenarbeiten und Erkenntnisse teilen kannst, ohne dass eine Installation erforderlich ist. Es bietet eine nahtlose Umgebung für die Arbeit mit realen Daten und ist damit ein praktisches Werkzeug, um deine Datenkenntnisse zu verbessern.

Du kannst dein Studium auch fortsetzen und eine offizielle GCP-Zertifizierung in deinen Lebenslauf oder dein LinkedIn-Profil aufnehmen, um deine Fähigkeiten bei potenziellen Arbeitgebern zu präsentieren. Für jede Zertifizierung bietet Google eine kostenlose Übungsprüfung an. Sie sollen dir helfen, dich auf die offizielle Prüfung vorzubereiten, aber sie eignen sich auch hervorragend für Vorstellungsgespräche, also sieh sie dir unbedingt an.

Ich hoffe, du hast diesen Leitfaden hilfreich gefunden und wünsche dir viel Glück für dein Vorstellungsgespräch!

Häufig gestellte Fragen

Was sollte ich NICHT tun, wenn ich mich auf ein GCP-Interview vorbereite?

Versuche, nicht nur Fakten auswendig zu lernen. Bemühe dich stattdessen, die zugrundeliegenden Konzepte zu verstehen und sei darauf vorbereitet, reale Szenarien zu diskutieren.

Muss ich die GCP-Befehle auswendig lernen?

Ganz und gar nicht. Dafür ist die Dokumentation da!

Muss ich vor einem Vorstellungsgespräch praktische Erfahrung mit GCP haben?

Es ist sicherlich von Vorteil, aber keine zwingende Voraussetzung. Ein gutes Verständnis der GCP-Konzepte und die Bereitschaft, zu lernen und sich anzupassen, können viel bewirken.

Ich habe Erfahrung mit AWS oder Azure. Wie viel von diesem Wissen ist übertragbar?

Die Cloud-Anbieter haben eine unterschiedliche Terminologie und einzigartige Dienste, aber die grundlegenden Konzepte des Cloud Computing sind die gleichen. Wenn du bereits Erfahrung mit einem anderen Cloud-Anbieter hast, kannst du Parallelen zwischen den Diensten ziehen und GCP schneller erlernen, als wenn du bei Null anfängst.

Was soll ich tun, wenn der Interviewer eine Frage stellt, auf die ich keine Antwort weiß?

Wenn du die Antwort auf eine Frage nicht kennst, gerate nicht in Panik! Wenn sich die Frage auf einen Dienst bezieht, den du nicht kennst, oder auf ein Szenario, das dir noch nie begegnet ist, kannst du klärende Fragen stellen. Nimm dir etwas Zeit zum Nachdenken, erkläre deinen Gedankengang und stütze dich auf deine Erfahrung, um eine logische Antwort zu geben.