Curso

A maioria das descrições de cargos no mercado de trabalho atual lista habilidades em nuvem na seção "Necessário" ou, no mínimo, na seção "Desejável" logo abaixo. Essa tendência não é específica da função. Se você estiver desenvolvendo aplicativos, trabalhando com dados ou se especializando em segurança, os empregadores precisam que você utilize o provedor de nuvem escolhido.

Nos últimos 5 anos, trabalhei em muitas startups e, por mais clichê que pareça, tive muitas funções. Trabalhei com o Google Cloud Platform (GCP) e também conduzi mais de 40 entrevistas técnicas nas quais testei o conhecimento de outros engenheiros sobre o assunto.

Este guia oferece meus principais conselhos para você responder às perguntas da entrevista sobre o GCP de acordo com seu nível de habilidade e função. Você pode pular para a seção que achar mais relevante para você. No entanto, as seções gerais servem de base para as seções específicas das funções, portanto, recomendo que você as leia primeiro.

E antes que você comece: Se você é completamente novo em computação em nuvem, recomendo que faça primeiro nosso curso Introdução à Computação em Nuvem. Este curso detalha os conceitos básicos da nuvem, explica os principais termos, como escalabilidade e latência, e aborda as vantagens das ferramentas de nuvem de provedores como o Google Cloud.

Perguntas básicas de entrevistas sobre o GCP

Para candidatos iniciantes, as perguntas e respostas de entrevistas sobre o GCP têm pouco ou nenhum elemento técnico. A ideia é avaliar se você entende as ofertas do GCP e como os produtos se encaixam. Você provavelmente encontrará essas perguntas se nunca tiver trabalhado com o GCP ou se o entrevistador não tiver certeza do seu nível de habilidade e quiser começar com o básico.

O que você precisa saber

Você deve estar familiarizado com os principais serviços do GCP, como Compute Engine, Kubernetes Engine, Cloud Storage, BigQuery, Cloud SQL e Pub/Sub. Também pode haver perguntas sobre:

- Gerenciamento de identidade e acesso (IAM): Compreensão das funções e permissões do IAM e como gerenciar o acesso do usuário no GCP.

- Armazenamento de dados e bancos de dados: Conhecimento de armazenamento em nuvem, SQL em nuvem, Cloud Spanner, Firestore e Bigtable, incluindo seus casos de uso e configurações.

- Computação sem servidor: Familiaridade com Cloud Functions, Cloud Run e App Engine, e como implementar e gerenciar aplicativos sem servidor.

- Monitoramento e registro em log: Proficiência com Operations Suite do Google Cloud (antigo Stackdriver), incluindo monitoramento, registro, rastreamento, depurador e relatório de erros para garantir a confiabilidade e o desempenho do sistema.

Se esses conceitos não lhe parecerem familiares e você não souber por onde começar, experimente nosso curso Introdução ao GCP. Isso dará a você uma base sólida sobre os tópicos acima.

Perguntas que podem lhe fazer

Aqui estão algumas perguntas que um entrevistador pode fazer, com exemplos de respostas fornecidas:

1. O que é o Google Compute Engine e quais são seus principais casos de uso?

O Google Compute Engine oferece máquinas virtuais escalonáveis que operam nos data centers do Google. Essas VMs são comumente usadas para executar aplicativos web, hospedar bancos de dados e lidar com tarefas de computação em grande escala, como processamento de dados e cargas de trabalho de aprendizado de máquina.

2. Quais são as classes Google Cloud Storage e como elas se diferenciam?

O Google Cloud Storage oferece quatro classes principais de armazenamento: Armazenamento padrão para dados acessados com frequência e com alto desempenho, armazenamento Nearline para dados acessados menos de uma vez por mês a um custo menor, armazenamento Coldline para dados acessados menos de uma vez por ano a um custo ainda menor e armazenamento Archive para arquivamento e backup de dados de longo prazo com o menor custo.

Observação: Você ganhará pontos extras se puder dar exemplos práticos dos tipos de dados que vivem em cada uma dessas classes de armazenamento. Se você estiver fazendo uma entrevista para um aplicativo de redes sociais, por exemplo, fale sobre fotos de perfis de usuários, registros de atividades de usuários e dados de conformidade.

3. O que é o Google Cloud Pub/Sub e quais são seus casos de uso típicos?

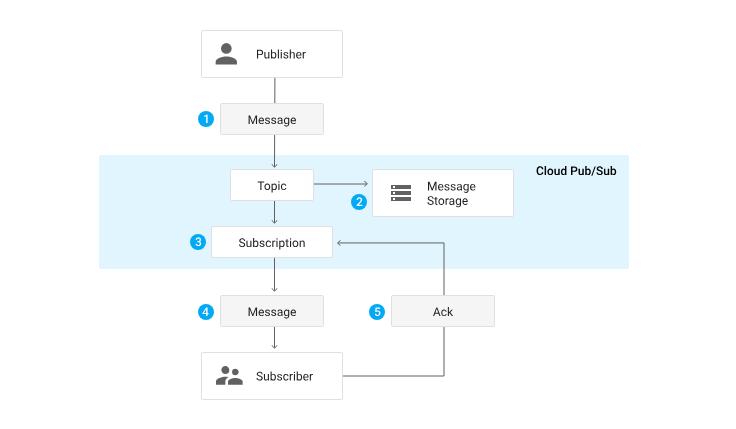

O Pub/Sub foi projetado para mensagens em tempo real e arquiteturas orientadas por eventos para oferecer suporte à comunicação assíncrona entre serviços. Alguns de seus casos de uso típicos incluem sistemas de registro, pipelines de ingestão de dados, análise em tempo real e integração de microsserviços.

4. O que é BigQuery e como ele lida com grandes conjuntos de dados?

O BigQuery é o data warehouse sem servidor do Google e foi projetado para lidar com grandes conjuntos de dados de forma eficiente com SQL. Ele usa armazenamento colunar, que armazena dados no disco em colunas em vez de linhas, para otimizar as operações de leitura pesada. Ele também aproveita o processamento paralelo, permitindo a distribuição de tarefas em várias máquinas para processar dados simultaneamente. Isso permite que o BigQuery execute consultas rápidas, mesmo em petabytes de dados. Além disso, ele se integra a outros serviços do GCP, como o Dataflow para processamento de dados e o Pub/Sub para ingestão de dados em tempo real. O BigQuery também inclui recursos como BigQuery ML para a realização de aprendizado de máquina diretamente na plataforma.

Perguntas intermediárias de entrevistas sobre o GCP

Essas perguntas virão depois que o entrevistador tiver estabelecido que você tem algum conhecimento básico das ofertas do GCP. Geralmente, elas são um pouco mais técnicas e testarão sua compreensão de serviços específicos, suas configurações e como usá-los de forma eficaz em vários cenários.

Você provavelmente conseguirá respondê-las se tiver experiência prática com o GCP e já tiver gerenciado recursos, implementado políticas de IAM, configurado VMs ou se tiver concluído nosso curso Entendendo a Computação em Nuvem.

O que você precisa saber

Você precisa desenvolver seu conhecimento sobre as ofertas do GCP e demonstrar uma compreensão mais profunda dos seguintes serviços:

- Soluções de computação e dimensionamento: Você deve ter uma compreensão completa sobre Compute Engine, Kubernetes Engine e App Engine, incluindo conceitos como dimensionamento automático, balanceamento de carga e otimização de recursos.

- Redes: É essencial que você tenha conhecimento sobre Virtual Private Cloud (VPC), VPC Peering, Shared VPC e VPNs, bem como configuração e gerenciamento de sub-redes, firewalls, rotas, VPNs e balanceamento de carga.

- Soluções de banco de dados: Você precisa entender de Cloud SQL, Cloud Spanner, Bigtable e Firestore, incluindo suas configurações e casos de uso apropriados.

- IAM: Você deve conhecer os recursos avançados do IAM, como funções personalizadas, contas de serviço e federação de identidade de carga de trabalho.

- Práticas de DevOps e CI/CD: Conhecimento sobre Cloud Build, Container Registry e automação de pipeline de CI/CD é importante para práticas eficientes de desenvolvimento e implantação.

- Segurança e conformidade: Você deve estar ciente das ofertas de segurança do GCP, incluindo métodos de criptografia, gerenciamento de chaves de segurança e adesão aos padrões de conformidade.

- Big Data e análise: Você precisa ter um bom conhecimento de BigQuery, Data Studio, Dataprep e Looker para realizar tarefas de análise e visualização de dados em grande escala.

Você não precisa ser um especialista em todos esses tópicos. O simples fato de você conhecer os recursos e as opções de configuração mais comuns já ajuda muito!

Perguntas que podem lhe fazer

Aqui está uma lista de perguntas comuns em entrevistas, juntamente com sugestões de respostas:

5. Como você configura e gerencia o dimensionamento automático no Google Compute Engine?

Para configurar e gerenciar o dimensionamento automático no Google Compute Engine, eu começaria configurando grupos de instâncias. Em seguida, eu definiria políticas de dimensionamento automático com base em métricas relevantes, como utilização da CPU e uso de balanceamento de carga. Essa configuração garante que o sistema seja ampliado durante a alta demanda para manter o desempenho e reduzido durante a baixa demanda para otimizar a eficiência de custos.

6. Explique como configurar e usar o Cloud Pub/Sub para um aplicativo de mensagens em tempo real.

Para configurar e usar o Cloud Pub/Sub para um aplicativo de mensagens em tempo real, eu usaria tópicos e assinaturas para gerenciar o fluxo de mensagens. Eu definiria as configurações de retenção e confirmação de mensagens para garantir uma entrega confiável. Dependendo do caso de uso, posso usar assinaturas push para entrega em tempo real ou assinaturas pull para processamento em lote. Além disso, eu integraria o Pub/Sub a outros serviços do GCP, como Dataflow para processamento de dados e Cloud Functions para processamento orientado por eventos.

Ciclo de vida de uma mensagem por meio do Pub/Sub. Fonte: Documentação do GCP Pub/Sub

7. Como você usa o Google Cloud IAM para conceder acesso temporário a recursos?

Para conceder acesso temporário a recursos usando o Google Cloud IAM, eu começaria criando funções personalizadas que tivessem apenas as permissões necessárias, seguindo o princípio de privilégio mínimo. Em seguida, eu configuraria contas de serviço para gerenciar o acesso a aplicativos e serviços. Para necessidades de acesso de curto prazo, eu usaria o IAP (Identity-Aware Proxy) para emitir credenciais de curta duração ou gerar URLs assinadas para o Cloud Storage para fornecer acesso limitado a recursos específicos.

Perguntas avançadas de entrevistas sobre o GCP

Nesse nível, os entrevistadores buscarão conhecimento técnico profundo, experiência prática e capacidade de projetar soluções complexas no GCP. Eles esperam que suas respostas levem em conta as práticas recomendadas para otimizar e proteger ambientes de nuvem. Embora possa haver algumas exceções, as perguntas avançadas só devem ser feitas se você estiver se candidatando a um cargo sênior ou a uma função com um forte componente de DevOps.

O que você precisa saber

Além do conhecimento básico e intermediário mencionado acima, o entrevistador poderá perguntar a você sobre a arquitetura geral e o design de soluções de nuvem dimensionáveis e como aproveitar recursos como implantações em várias regiões, balanceamento de carga, dimensionamento automático e recuperação de desastres. Você também deve saber como gerenciar soluções híbridas e multinuvem e ser capaz de implementar práticas de segurança avançadas usando IAM, segurança de VPC, criptografia de dados e ferramentas do GCP para monitoramento e proteção.

Perguntas que podem lhe fazer

A seguir, você encontrará possíveis perguntas de entrevistas e exemplos de respostas:

8. Descreva como você configuraria um pipeline de CI/CD usando os serviços do GCP para um aplicativo baseado em microsserviços.

Para configurar um pipeline de CI/CD usando os serviços do GCP para um aplicativo baseado em microsserviços, eu começaria usando o Cloud Build para criar e testar o código. As imagens de contêineres criadas seriam então armazenadas no Container Registry. Para a implantação, eu usaria o Kubernetes Engine ou o Cloud Run, dependendo dos requisitos do aplicativo. Além disso, eu usaria ferramentas de Infraestrutura como Código (IaC), como Deployment Manager ou Terraform, para gerenciar a infraestrutura, e monitoraria as implementações com o Operations Suite do Google Cloud para garantir uma operação tranquila e a rápida resolução de problemas.

9. Como você monitora e soluciona problemas em um ambiente do GCP complexo?

Para monitorar e solucionar problemas de um ambiente do GCP complexo, eu configuraria o Operations Suite do Google Cloud, que inclui ferramentas para monitoramento e registro. Eu criaria painéis personalizados para visualizar as principais métricas e configuraria alertas para eventos críticos. Para o gerenciamento de incidentes, eu usaria ferramentas integradas para rastrear e resolver problemas. A depuração de aplicativos envolveria a análise de registros e o uso de métricas para identificar gargalos de desempenho e outros problemas. Essa abordagem abrangente ajuda a garantir a confiabilidade e o desempenho do ambiente.

10. Como você aproveitaria os serviços de aprendizado de máquina no GCP para uma solução de análise preditiva?

Para aproveitar os serviços de aprendizado de máquina no GCP para uma solução de análise preditiva, eu usaria a AI Platform para treinar e implantar modelos. Para a criação de modelos personalizados, eu utilizaria o AutoML. Para tarefas de aprendizado de máquina no banco de dados, eu integraria o BigQuery ML. Além disso, eu usaria APIs pré-treinadas para tarefas específicas, como visão ou processamento de linguagem natural. Para garantir que todo o pipeline seja eficiente, eu configuraria pipelines de dados para pré-processamento, realizaria engenharia de recursos e implementaria processos de monitoramento e retreinamento de modelos para manter a precisão e a relevância das previsões.

Perguntas de entrevistas do GCP para funções de cientista de dados

Se você estiver se candidatando a uma função de cientista de dados, o entrevistador vai querer testar sua capacidade de trabalhar com grandes conjuntos de dados, aplicar métodos estatísticos, criar modelos preditivos e aproveitar os recursos da nuvem para análise de dados.

O que você precisa saber sobre as funções de cientista de dados

Você deve ter um bom conhecimento dos principais serviços do GCP e entender seus recursos, casos de uso e padrões de integração. Os cientistas de dados também precisarão saber sobre:

- Como configurar e gerenciar um ambiente de ciência de dados: Isso envolve a configuração e a otimização do ambiente para o processamento e a análise eficientes dos dados.

- BigQuery: As perguntas de entrevistas sobre o GCP BigQuery são muito comuns em entrevistas com cientistas de dados, portanto, certifique-se de que você conhece os diferentes recursos e as opções de otimização de desempenho que ele oferece.

- Ferramentas de aprendizado de máquina Você deve estar familiarizado com a AI Platform para treinar e implantar modelos, o AutoML para criar modelos personalizados sem muita codificação, o TensorFlow para criar e treinar redes neurais e o BigQuery ML para executar o aprendizado de máquina diretamente no BigQuery.

- Pré-processamento de dados É fundamental que você saiba como usar o Dataflow para processamento de dados escalonável e o Dataprep para limpeza e transformação de dados. Essas ferramentas ajudam a preparar os dados para análise e tarefas de aprendizado de máquina com eficiência.

Muitos desses tópicos são abordados em nosso curso Introdução ao BigQuery, se você quiser se atualizar.

Perguntas que você pode receber em entrevistas de cientistas de dados

Aqui estão exemplos de perguntas e respostas:

11. Como você lida com o pré-processamento de dados e a engenharia de recursos no GCP?

Para lidar com o pré-processamento de dados e a engenharia de recursos no GCP, uso o Cloud Dataflow para tarefas de transformação de dados dimensionáveis e o Dataprep para limpeza de dados. Aproveito os recursos de SQL do BigQuery para realizar a engenharia de recursos, como criar novos recursos, lidar com valores ausentes, codificar variáveis categóricas e dimensionar recursos para garantir que estejam no formato certo para os modelos de aprendizado de máquina.

12. Como você garante a reprodutibilidade e o dimensionamento dos seus experimentos de aprendizado de máquina no GCP?

Para garantir a reprodutibilidade e o dimensionamento dos meus experimentos de aprendizado de máquina no GCP, eu versionaria conjuntos de dados e modelos para acompanhar as alterações e atualizações. Eu usaria AI Platform Pipelines para orquestrar fluxos de trabalho de ML e ML Metadata para rastrear metadados relacionados a experimentos. Além disso, usaria o Kubernetes Engine para criar ambientes em contêineres, o que garante execuções consistentes e dimensionáveis dos meus experimentos.

13. Como você usa o TensorFlow e a AI Platform para projetos de aprendizagem profunda?

Para usar o TensorFlow e a AI Platform em projetos de aprendizagem profunda, começaria configurando um ambiente de aprendizagem profunda com o TensorFlow, onde criaria e treinaria redes neurais. Utilizaria a AI Platform para treinamento distribuído e ajuste de hiperparâmetros para otimizar o desempenho do modelo. Depois que o modelo fosse treinado, eu o implantaria usando a AI Platform para fornecer previsões. Para otimizar ainda mais o desempenho e gerenciar os recursos computacionais, monitoraria o uso dos recursos e ajustaria a infraestrutura conforme necessário, garantindo o uso eficiente da capacidade computacional.

Perguntas de entrevistas do GCP para funções de engenheiro de dados

Os engenheiros de dados são responsáveis por projetar e criar sistemas de dados dimensionáveis e confiáveis, gerenciar pipelines de dados e garantir a qualidade e a confiabilidade dos dados no GCP.

O que você precisa saber para funções de engenheiro de dados

Você deve ter um bom conhecimento dos principais serviços do GCP e entender seus recursos, casos de uso e padrões de integração. As perguntas de entrevistas de engenheiro de dados do GCP também incluem os seguintes tópicos:

- Arquitetura e modelagem de dados: Você deve estar familiarizado com BigQuery, Bigtable, Firestore, Pub/Sub, design de esquema e técnicas de modelagem de dados. Isso inclui a compreensão de como projetar arquiteturas de dados eficientes e dimensionáveis que atendam a requisitos comerciais específicos.

- Processamento de dados e pipelines: É essencial que você tenha conhecimento sobre Dataflow, Dataproc, Cloud Storage e Cloud Scheduler. Você deve entender como usar essas tecnologias para processamento em lote e em fluxo, transformação de dados, orquestração e agendamento para criar pipelines de dados robustos.

- Otimização de desempenho: Você precisa estar ciente das técnicas para otimizar o desempenho e o custo das soluções de processamento e armazenamento de dados no GCP. Isso inclui o uso de estratégias de particionamento, clustering, indexação, armazenamento em cache e gerenciamento de recursos para garantir operações de dados eficientes e econômicas.

Perguntas que você pode receber em entrevistas de engenheiro de dados

Algumas perguntas e respostas incluem:

14. Como você lida com o particionamento e a fragmentação de dados em um sistema de banco de dados distribuído no GCP?

Para lidar com o particionamento e a fragmentação de dados em um sistema de banco de dados distribuído no GCP, eu usaria técnicas de particionamento e fragmentação de dados para garantir a escalabilidade e o desempenho. O particionamento em intervalos envolve a divisão de dados com base em um intervalo de valores, enquanto o particionamento de hash distribui dados com base em uma função de hash. O particionamento composto combina vários métodos de particionamento. Essas estratégias são implementadas em serviços como Bigtable, Firestore ou Cloud Spanner para gerenciar dados com eficiência e garantir acesso e recuperação rápidos.

15. Como você lida com a evolução e o controle de versão do esquema em uma arquitetura de data lake no GCP?

Para lidar com a evolução e o controle de versão do esquema em uma arquitetura de data lake no GCP, usaria ferramentas como Avro ou Protobuf para gerenciar as alterações de esquema ao longo do tempo. Manteria um registro de esquemas para versionar esquemas e garantir a consistência entre diferentes conjuntos de dados. Além disso, implementaria práticas de governança de dados para manter a consistência dos dados e garantir a compatibilidade com versões anteriores, facilitando o gerenciamento de alterações e atualizações sem interromper os fluxos de trabalho existentes.

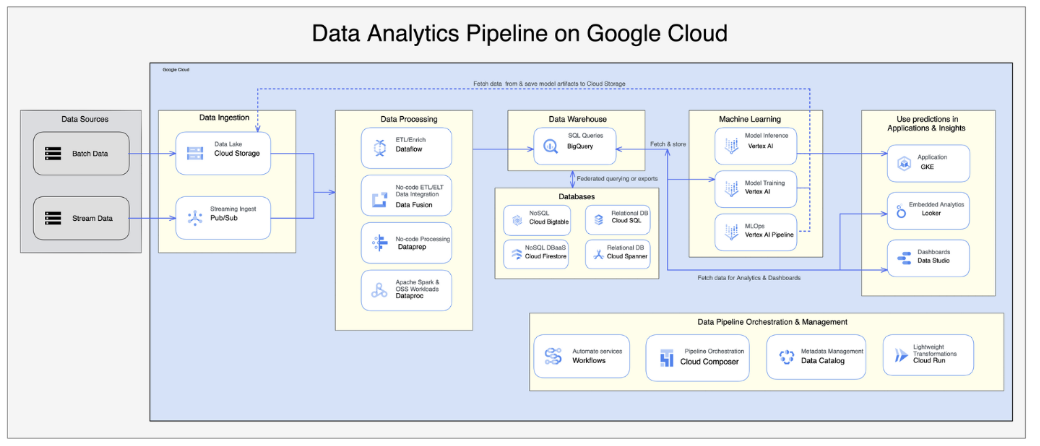

16. Como você implementaria um pipeline de dados usando o Google Cloud Dataflow e o BigQuery?

Para implementar um pipeline de dados usando o Google Cloud Dataflow e o BigQuery, eu começaria configurando o Dataflow para processos de ETL. Isso envolve a criação de trabalhos de fluxo de dados para extrair dados de várias fontes, transformá-los conforme necessário e carregá-los no BigQuery. Eu integraria o Pub/Sub para a ingestão de dados em tempo real, garantindo o processamento oportuno e preciso dos dados. Além disso, eu lidaria com o esquema de dados, aplicaria estratégias de particionamento e usaria técnicas de otimização para garantir o armazenamento e a recuperação eficientes de dados no BigQuery.

Fonte: Artigo sobre a arquitetura do pipeline de dados do GCP

Perguntas de entrevistas do GCP para funções de arquiteto de nuvem

A maioria das perguntas aqui testará sua experiência em projetar soluções que atendam aos requisitos comerciais e técnicos. Seu entrevistador vai querer ter certeza de que as soluções que você propõe são confiáveis, seguras e econômicas.

O que você precisa saber sobre as funções de arquiteto de nuvem

Você deve ter um bom conhecimento dos principais serviços do GCP e uma compreensão profunda de seus recursos, casos de uso e padrões de integração.

Como arquiteto de nuvem, você pode ser responsável pela migração ou integração de sistemas inteiros ao GCP. Portanto, as perguntas de entrevistas de arquiteto do GCP podem testar sua experiência em arquiteturas híbridas ou multinuvem e as práticas recomendadas para projetar soluções de nuvem confiáveis em escala. Aproveite sua experiência anterior e fale sobre casos de uso e cenários com os quais você lidou com sucesso no passado.

Perguntas que podem lhe fazer em entrevistas de arquiteto de nuvem

Algumas perguntas e respostas incluem:

17. Você pode explicar as etapas e considerações para migrar um aplicativo local de grande escala para o GCP?

Para migrar um aplicativo local de grande escala para o GCP, eu começaria com uma fase de avaliação para analisar a infraestrutura atual e identificar as dependências. Na fase de planejamento, eu projetaria a estratégia de migração, incluindo a seleção de serviços e ferramentas apropriados do GCP, como o Migrate for Compute Engine, para opções de migração de VM e transferência de dados. Durante a fase de execução, eu reprojetaria o aplicativo para a nuvem, lidaria com as dependências, realizaria testes completos e implementaria estratégias para minimizar o tempo de inatividade.

18. Você pode descrever os casos de uso e os desafios relacionados a aplicativos multinuvem, ou seja, a integração do GCP com outros provedores de nuvem?

Os aplicativos multinuvem são frequentemente usados para recuperação de desastres, análise de dados ou distribuição de cargas de trabalho. A integração do GCP com outros provedores de nuvem envolve desafios como conectividade de rede, transferência de dados, gerenciamento de identidade e manutenção da segurança entre ambientes. Ferramentas como o Anthos podem ajudar a gerenciar clusters Kubernetes multinuvem, garantindo uma integração perfeita e uma operação eficiente.

19. Explique como você lidaria com a recuperação de desastres e o planejamento da continuidade dos negócios em uma arquitetura de nuvem no GCP.

Para a recuperação de desastres e o planejamento da continuidade dos negócios em uma arquitetura de nuvem do GCP, eu configuraria a replicação entre regiões para garantir a redundância dos dados. A implementação de mecanismos de failover ajudaria a manter a disponibilidade do serviço em caso de falhas. Backups regulares são essenciais para a proteção dos dados, e eu também testaria periodicamente os procedimentos de recuperação de desastres para garantir que sejam eficazes e atualizados.

20. Explique como você otimizaria o custo da infraestrutura de nuvem no GCP e, ao mesmo tempo, garantiria o desempenho e a escalabilidade.

Para otimizar o custo da infraestrutura de nuvem no GCP, eu usaria as VMs preemptivas do Compute Engine para obter uma computação econômica. O dimensionamento correto das instâncias garante que os recursos sejam alocados adequadamente com base no uso. Aproveitar descontos de uso comprometido pode reduzir ainda mais os custos. Além disso, eu usaria ferramentas de gerenciamento de custos, como Cost Explorer e Budgets, para monitorar e controlar os gastos e, ao mesmo tempo, manter o desempenho e a escalabilidade.

Observação: Outro tópico que muitas vezes é ignorado, mas que aparece com frequência em entrevistas, é a otimização de custos. De acordo com o Relatório Flexera de 2024 sobre o estado da nuvemas empresas fazem da otimização de custos uma prioridade quando se trata de computação em nuvem, portanto, certifique-se de que você saiba como usar as ferramentas de gerenciamento de custos no GCP e que entenda estratégias como provisionamento de recursos e dimensionamento correto.

Considerações finais

Agora que você tem uma ideia melhor do que esperar da sua entrevista sobre o GCP, pode começar a preencher as brechas no seu conhecimento.

Embora os cursos teóricos sejam ótimos para você começar, acho que a prática com cenários do mundo real é a melhor maneira de adquirir experiência no GCP. Há muitos recursos disponíveis que você pode usar, e eu recomendaria os cursos do Google Cloud Training se você puder pagar a assinatura mensal de US$ 29.

Além disso, o DataLab do DataCamp é uma excelente plataforma para você praticar suas habilidades. O DataLab é um notebook baseado em nuvem que permite que você faça experiências com código, analise dados, colabore com outras pessoas e compartilhe insights sem a necessidade de instalação. Ele oferece um ambiente perfeito para você trabalhar com dados do mundo real, o que o torna uma ferramenta prática para aprimorar suas habilidades com dados.

Você também pode levar seus estudos adiante e adicionar uma certificação do GCP oficial ao seu currículo ou perfil do LinkedIn para mostrar suas habilidades a possíveis empregadores. Para cada certificação, o Google oferece um exame simulado gratuito. O objetivo deles é ajudar você a se preparar para o teste oficial, mas eles também funcionam muito bem para entrevistas, portanto, não deixe de dar uma olhada.

Espero que este guia tenha sido útil e desejo a você muita sorte na sua entrevista!

Perguntas frequentes

O que NÃO devo fazer ao me preparar para uma entrevista sobre o GCP?

Tente não memorizar apenas fatos. Em vez disso, esforce-se para entender os conceitos subjacentes e prepare-se para discutir cenários da vida real.

Preciso memorizar os comandos do GCP?

De forma alguma. É para isso que serve a documentação!

Preciso ter experiência prática com o GCP antes da entrevista?

Certamente será benéfico, mas não é obrigatório. Demonstrar uma sólida compreensão dos conceitos do GCP, juntamente com a vontade de aprender e se adaptar, pode ajudar muito.

Tenho experiência com AWS ou Azure. Quanto desse conhecimento é transferível?

Os provedores de nuvem têm terminologia diferente e serviços exclusivos, mas os conceitos fundamentais da computação em nuvem são os mesmos. Se você tiver experiência anterior com outro provedor de nuvem, poderá traçar paralelos entre os serviços e aprender sobre o GCP mais rapidamente do que se começasse do zero.

O que devo fazer se o entrevistador fizer uma pergunta para a qual eu não sei a resposta?

Se você não souber a resposta para uma pergunta, não entre em pânico! Se a pergunta for sobre um serviço que você não conhece ou sobre um cenário com o qual nunca se deparou antes, você pode fazer perguntas de esclarecimento. Dedique algum tempo para pensar, explicar seu processo de pensamento e se apoiar em sua experiência para propor uma resposta lógica.