Cours

La plupart des descriptions de poste sur le marché du travail actuel mentionnent les compétences cloud dans la section "requis" ou, à tout le moins, dans la section "souhaitable", juste en dessous. Cette tendance n'est pas spécifique à un rôle. Que vous développiez des applications, que vous travailliez avec des données ou que vous vous spécialisiez dans la sécurité, les employeurs ont besoin que vous utilisiez le fournisseur de cloud qu'ils ont choisi.

Au cours des cinq dernières années, j'ai travaillé dans de nombreuses startups et, aussi cliché que cela puisse paraître, j'ai porté de nombreuses casquettes. J'ai mis la main à la pâte avec Google Cloud Platform (GCP) et j'ai également mené plus de 40 entretiens techniques au cours desquels j'ai testé les connaissances de mes collègues ingénieurs sur le sujet.

Ce guide vous donne mes meilleurs conseils pour répondre aux questions d'entretien sur les BPC en fonction de votre niveau de compétence et de votre fonction. Vous pouvez passer directement à la section qui vous semble la plus pertinente. Toutefois, les sections générales servent de base aux sections spécifiques à un rôle, c'est pourquoi je vous recommande de les lire en premier.

Et avant de commencer : Si vous êtes totalement novice en matière de cloud computing, je vous recommande de suivre d'abord notre cours Introduction au cloud computing. Ce cours présente les bases du cloud, explique des termes clés tels que l'évolutivité et la latence, et couvre les avantages des outils de cloud de fournisseurs tels que Google Cloud.

Questions d'entretien de base sur le GCP

Pour les candidats débutants, les questions et réponses des entretiens sur les BPC ne comportent que peu ou pas d'éléments techniques. L'idée est d'évaluer votre compréhension des offres de GCP et de la manière dont les produits s'articulent entre eux. Vous rencontrerez très probablement ces questions si vous n'avez jamais travaillé avec GCP, ou si votre interlocuteur n'est pas certain de votre niveau de compétence et souhaite commencer par les bases.

Ce que vous devez savoir

Vous devez être familiarisé avec les services GCP de base, comme Compute Engine, Kubernetes Engine, Cloud Storage, BigQuery, Cloud SQL et Pub/Sub. Des questions peuvent également être posées :

- Gestion des identités et des accès (IAM) : Comprendre les rôles IAM, les permissions et comment gérer l'accès des utilisateurs dans GCP.

- Stockage de données et bases de données : Connaissance du stockage dans le cloud, de Cloud SQL, de Cloud Spanner, de Firestore et de Bigtable, y compris leurs cas d'utilisation et leurs configurations.

- L'informatique sans serveur : Familiarité avec Cloud Functions, Cloud Run et App Engine, et comment déployer et gérer des applications sans serveur.

- Surveillance et enregistrement : Maîtrise de la suite d'opérations de Google Cloud (anciennement Stackdriver), y compris la surveillance, la journalisation, la trace, le débogueur et les rapports d'erreur pour assurer la fiabilité et la performance du système.

Si ces concepts ne vous semblent pas familiers et que vous ne savez pas par où commencer, essayez notre cours d'introduction au GCP. Il vous donnera une base solide sur les sujets susmentionnés.

Questions que vous pourriez recevoir

Voici quelques questions qu'un intervieweur pourrait poser, accompagnées d'exemples de réponses :

1. Qu'est-ce que Google Compute Engine et quels sont ses principaux cas d'utilisation ?

Google Compute Engine offre des machines virtuelles évolutives qui fonctionnent dans les centres de données de Google. Ces machines virtuelles sont couramment utilisées pour exécuter des applications web, héberger des bases de données et gérer des tâches de calcul à grande échelle telles que le traitement des données et les charges de travail d'apprentissage automatique.

2. Qu'est-ce que les classes de stockage dans le cloud de Google et en quoi diffèrent-elles ?

Google Cloud Storage propose quatre grandes catégories de stockage : Stockage standard pour les données fréquemment consultées avec des performances élevées, stockage Nearline pour les données consultées moins d'une fois par mois à un coût moindre, stockage Coldline pour les données consultées moins d'une fois par an à un coût encore plus faible, et stockage Archive pour l'archivage et la sauvegarde des données à long terme au coût le plus bas.

Remarque : Vous obtiendrez des points bonus si vous pouvez donner des exemples pratiques du type de données qui se trouvent dans chacune de ces classes de stockage. Si vous passez un entretien pour une application de médias sociaux, par exemple, parlez des photos de profil des utilisateurs, des journaux d'activité des utilisateurs et des données de conformité.

3. Qu'est-ce que Google Cloud Pub/Sub et quels sont ses cas d'utilisation typiques ?

Pub/Sub est conçu pour la messagerie en temps réel et les architectures axées sur les événements afin de prendre en charge la communication asynchrone entre les services. Les systèmes de journalisation, les pipelines d'ingestion de données, l'analyse en temps réel et l'intégration de microservices sont quelques-uns des cas d'utilisation typiques.

4. Qu'est-ce qu'une BigQuery et comment traite-t-elle les grands ensembles de données ?

BigQuery est l'entrepôt de données sans serveur de Google et est conçu pour traiter efficacement de grands ensembles de données avec SQL. Il utilise le stockage en colonnes, qui stocke les données sur le disque en colonnes plutôt qu'en lignes, afin d'optimiser les opérations de lecture intensive. Il s'appuie également sur le traitement parallèle, ce qui permet de répartir les tâches sur plusieurs machines afin de traiter les données simultanément. Cela permet à BigQuery d'exécuter des requêtes rapides, même sur des pétaoctets de données. En outre, il s'intègre à d'autres services GCP tels que Dataflow pour le traitement des données et Pub/Sub pour l'ingestion de données en temps réel. BigQuery comprend également des fonctionnalités telles que BigQuery ML, qui permet d'effectuer de l'apprentissage automatique directement au sein de la plateforme.

Questions d'entretien intermédiaires sur GCP

Ces questions seront posées une fois que votre interlocuteur aura établi que vous avez une connaissance de base des offres de GCP. Ils sont généralement un peu plus techniques et testeront votre compréhension de services spécifiques, de leurs configurations et de la manière de les utiliser efficacement dans différents scénarios.

Vous serez probablement en mesure d'y répondre si vous avez une expérience pratique de GCP et avez déjà géré des ressources, mis en œuvre des politiques IAM, configuré des VM, ou si vous avez suivi notre cours Comprendre le Cloud Computing.

Ce que vous devez savoir

Vous devez développer votre connaissance des offres de GCP et démontrer une compréhension plus approfondie des services suivants :

- Solutions de calcul et de mise à l'échelle : Vous devez avoir une compréhension approfondie de Compute Engine, Kubernetes Engine et App Engine, y compris des concepts tels que l'autoscaling, l'équilibrage de charge et l'optimisation des ressources.

- Mise en réseau : Il est essentiel de connaître le cloud privé virtuel (VPC), le peering VPC, le VPC partagé et les VPN, ainsi que la configuration et la gestion des sous-réseaux, des pare-feu, des routes, des VPN et de l'équilibrage de charge.

- Solutions de base de données : Vous devez comprendre Cloud SQL, Cloud Spanner, Bigtable et Firestore, notamment leurs configurations et les cas d'utilisation appropriés.

- IAM : Vous devez connaître les fonctions IAM avancées telles que les rôles personnalisés, les comptes de service et la fédération des identités de charge de travail.

- Pratiques DevOps et CI/CD : La connaissance de Cloud Build, Container Registry et de l'automatisation des pipelines CI/CD est importante pour l'efficacité des pratiques de développement et de déploiement.

- Sécurité et conformité : Vous devez connaître les offres de sécurité de GCP, y compris les méthodes de cryptage, la gestion des clés de sécurité et le respect des normes de conformité.

- Big Data et analyse : Une bonne maîtrise de BigQuery, Data Studio, Dataprep et Looker est nécessaire pour les tâches d'analyse et de visualisation de données à grande échelle.

Vous n'avez pas besoin d'être un expert dans tous ces domaines. Le simple fait de connaître les caractéristiques et les options de configuration les plus courantes peut s'avérer très utile !

Questions que vous pourriez recevoir

Voici une liste de questions d'entretien courantes, assorties de suggestions de réponses :

5. Comment configurer et gérer la mise à l'échelle automatique dans Google Compute Engine ?

Pour configurer et gérer l'autoscaling dans Google Compute Engine, je commencerais par créer des groupes d'instances. Ensuite, je définirais des politiques de mise à l'échelle automatique basées sur des mesures pertinentes telles que l'utilisation du processeur et l'utilisation de l'équilibrage de charge. Cette configuration garantit que le système augmente en cas de forte demande pour maintenir les performances et qu'il diminue en cas de faible demande pour optimiser le rapport coût-efficacité.

6. Expliquez comment configurer et utiliser Cloud Pub/Sub pour une application de messagerie en temps réel.

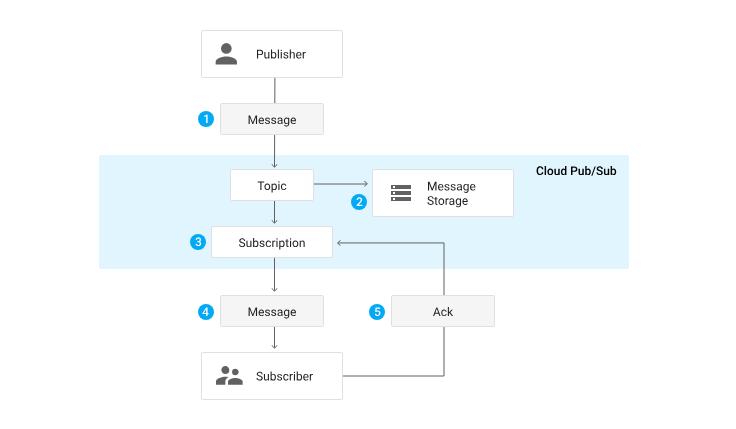

Pour mettre en place et utiliser Cloud Pub/Sub pour une application de messagerie en temps réel, je m'appuierais sur les sujets et les abonnements pour gérer le flux de messages. Je configurerais les paramètres de conservation des messages et d'accusé de réception pour garantir une livraison fiable. En fonction du cas d'utilisation, je peux utiliser des abonnements "push" pour une livraison en temps réel ou des abonnements "pull" pour un traitement par lots. En outre, j'intégrerais Pub/Sub à d'autres services GCP comme Dataflow pour le traitement des données et Cloud Functions pour le traitement basé sur les événements.

Cycle de vie d'un message par Pub/Sub. Source : Documentation Pub/Sub des BPC

7. Comment utiliser Google Cloud IAM pour accorder un accès temporaire aux ressources ?

Pour accorder un accès temporaire aux ressources à l'aide de Google Cloud IAM, je commencerais par créer des rôles personnalisés qui ne disposent que des autorisations nécessaires, en respectant le principe du moindre privilège. Ensuite, je configurerais les comptes de service pour gérer l'accès aux applications et aux services. Pour les besoins d'accès à court terme, j'utiliserais Identity-Aware Proxy (IAP) pour émettre des identifiants de courte durée ou générer des URL signées pour Cloud Storage afin de fournir un accès limité dans le temps à des ressources spécifiques.

Questions d'entretien avancées sur GCP

À ce niveau, les recruteurs rechercheront une expertise technique approfondie, une expérience pratique et la capacité d'élaborer des solutions complexes dans le cadre de GCP. Ils attendront de vos réponses qu'elles prennent en compte les meilleures pratiques d'optimisation et de sécurisation des environnements cloud. Bien qu'il puisse y avoir des exceptions, on ne devrait vous poser des questions avancées que si vous postulez à un poste de haut niveau ou à un poste comportant une forte composante DevOps.

Ce que vous devez savoir

En plus des connaissances de base et intermédiaires mentionnées ci-dessus, votre interlocuteur pourrait vous interroger sur l'architecture générale et la conception des solutions cloud évolutives, et sur la manière d'exploiter des fonctionnalités telles que les déploiements multirégionaux, l'équilibrage de charge, l'autoscaling et la reprise après sinistre. Vous devez également savoir comment gérer des solutions hybrides et multi-cloud et être en mesure de mettre en œuvre des pratiques de sécurité avancées en utilisant l'IAM, la sécurité VPC, le chiffrement des données et les outils de GCP pour la surveillance et la protection.

Questions que vous pourriez recevoir

Vous trouverez ci-dessous des questions d'entretien potentielles ainsi que des exemples de réponses :

8. Décrivez comment vous mettriez en place un pipeline CI/CD utilisant les services GCP pour une application basée sur des microservices.

Pour mettre en place un pipeline CI/CD à l'aide des services GCP pour une application basée sur des microservices, je commencerais par utiliser Cloud Build pour construire et tester le code. Les images des conteneurs construits sont ensuite stockées dans le registre des conteneurs. Pour le déploiement, j'utiliserais Kubernetes Engine ou Cloud Run, en fonction des exigences de l'application. En outre, j'emploierais des outils Infrastructure as Code (IaC) comme Deployment Manager ou Terraform pour gérer l'infrastructure, et je surveillerais les déploiements avec Google Cloud's Operations Suite pour assurer un fonctionnement sans heurts et une résolution rapide des problèmes.

9. Comment surveiller et dépanner un environnement GCP complexe ?

Pour surveiller et dépanner un environnement GCP complexe, je configurerais la suite d'opérations de Google Cloud, qui comprend des outils de surveillance et de journalisation. Je créerais des tableaux de bord personnalisés pour visualiser les indicateurs clés et je mettrais en place des alertes en cas d'événements critiques. Pour la gestion des incidents, j'utiliserais des outils intégrés pour le cursus et la résolution des problèmes. Le débogage des applications implique l'analyse des journaux et l'utilisation de mesures pour identifier les goulets d'étranglement et autres problèmes. Cette approche globale permet de garantir la fiabilité et la performance de l'environnement.

10. Comment tirer parti des services d'apprentissage automatique sur GCP pour une solution d'analyse prédictive ?

Pour exploiter les services d'apprentissage automatique sur GCP dans le cadre d'une solution d'analyse prédictive, j'utiliserais la plateforme AI pour entraîner et déployer des modèles. Pour la création de modèles personnalisés, j'utiliserais AutoML. Pour les tâches d'apprentissage automatique dans la base de données, j'intégrerais BigQuery ML. En outre, j'utiliserais des API préformées pour des tâches spécifiques telles que la vision ou le traitement du langage naturel. Pour garantir l'efficacité de l'ensemble du pipeline, je mettrais en place des pipelines de données pour le prétraitement, j'effectuerais l'ingénierie des caractéristiques et je mettrais en œuvre des processus de surveillance et de recyclage des modèles afin de maintenir la précision et la pertinence des prédictions.

Questions d'entretien sur le GCP pour les rôles de Data Scientist

Si vous postulez à un poste de data scientist, votre interlocuteur voudra tester votre capacité à travailler avec de grands ensembles de données, à appliquer des méthodes statistiques, à construire des modèles prédictifs et à exploiter les ressources du cloud pour l'analyse des données.

Ce que vous devez savoir pour les postes de Data Scientist

Vous devez avoir une bonne connaissance des services de base de GCP et comprendre leurs capacités, les cas d'utilisation et les modèles d'intégration. Les Data Scientists devront également avoir des connaissances en la matière :

- Mise en place et gestion d'un environnement de science des données : Il s'agit de configurer et d'optimiser l'environnement pour un traitement et une analyse efficaces des données.

- BigQuery : Les questions d'entretien concernant GCP BigQuery sont très courantes dans les entretiens avec les data scientists. Assurez-vous donc de connaître les différentes fonctionnalités et options d'optimisation des performances qu'il offre.

- Outils d'apprentissage automatique : Vous devez connaître AI Platform pour l'entraînement et le déploiement de modèles, AutoML pour la création de modèles personnalisés sans codage intensif, TensorFlow pour la construction et l'entraînement de réseaux neuronaux, et BigQuery ML pour l'exécution de l'apprentissage automatique directement dans BigQuery.

- Prétraitement des données : Il est essentiel de comprendre comment utiliser Dataflow pour le traitement évolutif des données et Dataprep pour le nettoyage et la transformation des données. Ces outils permettent de préparer efficacement les données pour les tâches d'analyse et d'apprentissage automatique.

La plupart de ces sujets sont abordés dans notre cours Introduction à BigQuery, si vous souhaitez une remise à niveau.

Les questions que l'on peut vous poser lors d'un entretien avec un Data Scientist

Voici des exemples de questions et de réponses :

11. Comment gérez-vous le prétraitement des données et l'ingénierie des caractéristiques dans GCP ?

Pour gérer le prétraitement des données et l'ingénierie des fonctionnalités dans GCP, j'utilise Cloud Dataflow pour les tâches de transformation de données évolutives et Dataprep pour le nettoyage des données. J'exploite les capacités SQL de BigQuery pour réaliser l'ingénierie des caractéristiques, comme la création de nouvelles caractéristiques, la gestion des valeurs manquantes, l'encodage des variables catégorielles et la mise à l'échelle des caractéristiques pour s'assurer qu'elles sont dans le bon format pour les modèles d'apprentissage automatique.

12. Comment garantir la reproductibilité et l'évolutivité de vos expériences d'apprentissage automatique sur GCP ?

Pour assurer la reproductibilité et l'évolutivité de mes expériences d'apprentissage automatique sur GCP, je versionne les ensembles de données et les modèles pour garder une trace des changements et des mises à jour. J'utilise AI Platform Pipelines pour orchestrer les workflows de ML et ML Metadata pour le suivi des métadonnées liées aux expériences. En outre, j'utilise Kubernetes Engine pour créer des environnements conteneurisés, ce qui garantit des exécutions cohérentes et évolutives de mes expériences.

13. Comment utilisez-vous TensorFlow et AI Platform pour des projets d'apprentissage profond ?

Pour utiliser TensorFlow et AI Platform dans le cadre de projets d'apprentissage profond, je commence par configurer un environnement d'apprentissage profond avec TensorFlow, où je crée et entraîne des réseaux neuronaux. J'utilise AI Platform pour l'entraînement distribué et le réglage des hyperparamètres afin d'optimiser les performances du modèle. Une fois le modèle formé, je le déploie à l'aide de la plateforme AI Platform pour servir les prédictions. Pour optimiser les performances et gérer les ressources informatiques, je surveille l'utilisation des ressources et j'adapte l'infrastructure en fonction des besoins, afin de garantir une utilisation efficace de la puissance de calcul.

Questions d'entretien GCP pour les ingénieurs de données

Les ingénieurs de données sont responsables de la conception et de la construction de systèmes de données évolutifs et fiables, de la gestion des pipelines de données et de la garantie de la qualité et de la fiabilité des données sur GCP.

Ce que vous devez savoir sur les rôles d'ingénierie des données

Vous devez avoir une bonne connaissance des services de base de GCP et comprendre leurs capacités, les cas d'utilisation et les modèles d'intégration. Les questions d'entretien de l'ingénieur de données GCP portent également sur les sujets suivants :

- Architecture et modélisation des données : Vous devez être familier avec BigQuery, Bigtable, Firestore, Pub/Sub, la conception de schémas et les techniques de modélisation des données. Il s'agit notamment de comprendre comment concevoir des architectures de données efficaces et évolutives qui répondent aux besoins spécifiques des entreprises.

- Traitement des données et pipelines : La connaissance de Dataflow, Dataproc, Cloud Storage et Cloud Scheduler est essentielle. Vous devez comprendre comment utiliser ces technologies pour le traitement par lots et par flux, la transformation des données, l'orchestration et l'ordonnancement afin de créer des pipelines de données robustes.

- Optimisation des performances : Vous devez connaître les techniques permettant d'optimiser les performances et le coût des solutions de traitement et de stockage des données sur le GCP. Il s'agit notamment d'utiliser des stratégies de partitionnement, de regroupement, d'indexation, de mise en cache et de gestion des ressources pour garantir l'efficacité et la rentabilité des opérations sur les données.

Questions susceptibles d'être posées lors d'entretiens sur l'ingénierie des données

Voici quelques questions et réponses :

14. Comment gérez-vous le partitionnement et le partage des données dans un système de base de données distribué sur GCP ?

Pour gérer le partitionnement et la répartition des données dans un système de base de données distribué sur GCP, j'utiliserais des techniques de partitionnement et de répartition des données pour garantir l'évolutivité et les performances. Le partitionnement par plage consiste à diviser les données sur la base d'une plage de valeurs, tandis que le partitionnement par hachage distribue les données sur la base d'une fonction de hachage. Le partitionnement composite combine plusieurs méthodes de partitionnement. Ces stratégies sont mises en œuvre dans des services tels que Bigtable, Firestore ou Cloud Spanner pour gérer efficacement les données et garantir un accès et une récupération rapides.

15. Comment gérer l'évolution et la version des schémas dans une architecture de lac de données sur GCP ?

Pour gérer l'évolution et la version des schémas dans une architecture de lac de données sur GCP, j'utilise des outils comme Avro ou Protobuf pour gérer les changements de schémas au fil du temps. Je tiens à jour un registre de schémas pour versionner les schémas et garantir la cohérence entre les différents ensembles de données. En outre, je mets en œuvre des pratiques de gouvernance des données afin de maintenir la cohérence des données et d'assurer la compatibilité ascendante, ce qui facilite la gestion des changements et des mises à jour sans perturber les flux de travail existants.

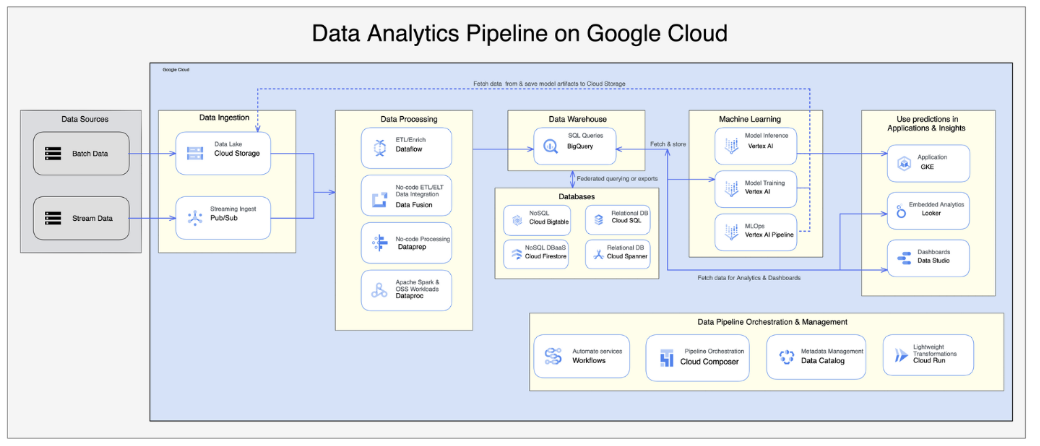

16. Comment mettriez-vous en œuvre un pipeline de données en utilisant Google Cloud Dataflow et BigQuery ?

Pour mettre en œuvre un pipeline de données à l'aide de Google Cloud Dataflow et BigQuery, je commencerais par configurer Dataflow pour les processus ETL. Il s'agit d'écrire des tâches Dataflow pour extraire des données de diverses sources, les transformer si nécessaire et les charger dans BigQuery. J'intégrerais Pub/Sub pour l'ingestion de données en temps réel, ce qui garantirait un traitement rapide et précis des données. En outre, je m'occuperais des schémas de données, j'appliquerais des stratégies de partitionnement et j'utiliserais des techniques d'optimisation pour assurer un stockage et une récupération efficaces des données dans BigQuery.

Source : Article sur l'architecture du pipeline de données GCP

Questions d'entretien GCP pour les rôles d'architecte cloud

La plupart des questions testeront votre expertise en matière d'architecture de solutions qui répondent à la fois aux exigences commerciales et techniques. Votre interlocuteur voudra s'assurer que les solutions que vous proposez sont fiables, sûres et rentables.

Ce qu'il faut savoir sur les rôles d'architecte cloud

Vous devez avoir une bonne connaissance des services de base de GCP et une compréhension approfondie de leurs capacités, des cas d'utilisation et des modèles d'intégration.

En tant qu'architecte cloud, vous pourriez être responsable de la migration ou de l'intégration de systèmes entiers vers GCP. Par conséquent, les questions d'entretien de l'architecte GCP peuvent tester votre expertise sur les architectures hybrides ou multi-cloud, et les meilleures pratiques pour concevoir des solutions cloud fiables à l'échelle. Appuyez-vous sur votre expérience antérieure et évoquez les cas d'utilisation et les scénarios que vous avez gérés avec succès dans le passé.

Questions susceptibles d'être posées lors d'un entretien avec un architecte cloud

Voici quelques questions et réponses :

17. Pouvez-vous expliquer les étapes et les considérations relatives à la migration d'une application sur site à grande échelle vers GCP ?

Pour migrer une application sur site à grande échelle vers GCP, je commencerais par une phase d'évaluation de l'infrastructure actuelle et d'identification des dépendances. Lors de la phase de planification, je concevrais la stratégie de migration, notamment en sélectionnant les services GCP appropriés et des outils tels que Migrate for Compute Engine pour la migration des machines virtuelles et les options de transfert de données. Pendant la phase d'exécution, je réarchitecturais l'application pour le cloud, je gérais les dépendances, j'effectuais des tests approfondis et je mettais en œuvre des stratégies pour minimiser les temps d'arrêt.

18. Pouvez-vous décrire les cas d'utilisation et les défis liés aux applications multi-cloud, c'est-à-dire l'intégration de GCP avec d'autres fournisseurs de cloud ?

Les applications multi-cloud sont souvent utilisées pour la reprise après sinistre, l'analyse des données ou la distribution de la charge de travail. L'intégration de GCP avec d'autres fournisseurs de cloud implique des défis tels que la connectivité réseau, le transfert de données, la gestion des identités et le maintien de la sécurité entre les environnements. Des outils comme Anthos peuvent aider à gérer des clusters Kubernetes multi-cloud, en assurant une intégration transparente et un fonctionnement efficace.

19. Expliquez comment vous géreriez la reprise après sinistre et la planification de la continuité des activités dans une architecture cloud sur GCP.

Pour la reprise après sinistre et la planification de la continuité des activités dans une architecture cloud GCP, je mettrais en place une réplication interrégionale pour assurer la redondance des données. La mise en œuvre de mécanismes de basculement permettrait de maintenir la disponibilité des services en cas de défaillance. Des sauvegardes régulières sont essentielles pour la protection des données, et je testerais aussi périodiquement les procédures de reprise après sinistre pour m'assurer qu'elles sont efficaces et à jour.

20. Expliquez comment vous optimiseriez le coût de l'infrastructure cloud sur GCP tout en garantissant les performances et l'évolutivité.

Pour optimiser le coût de l'infrastructure cloud sur GCP, j'utiliserais les VM préemptibles de Compute Engine pour un calcul rentable. Le rightsizing des instances garantit que les ressources sont allouées de manière appropriée en fonction de l'utilisation. L'utilisation de remises sur l'utilisation engagée peut permettre de réduire davantage les coûts. En outre, j'utiliserais des outils de gestion des coûts tels que Cost Explorer et Budgets pour surveiller et contrôler les dépenses tout en maintenant les performances et l'évolutivité.

Note : L'optimisation des coûts est un autre sujet qui est souvent négligé mais qui revient assez souvent dans les entretiens. Selon le rapport Rapport Flexera 2024 sur l'état du cloudles entreprises font de l'optimisation des coûts une priorité lorsqu'il s'agit de cloud computing, alors assurez-vous de savoir comment utiliser les outils de gestion des coûts dans GCP et de comprendre les stratégies telles que le provisionnement des ressources et le rightsizing.

Réflexions finales

Maintenant que vous avez une meilleure idée de ce qui vous attend lors de votre entretien sur les BPC, vous pouvez commencer à combler les lacunes de vos connaissances.

Bien que les cours théoriques soient excellents pour commencer, je trouve que la pratique avec des scénarios du monde réel est la meilleure façon d'acquérir l'expertise GCP. Il existe de nombreuses ressources que vous pouvez utiliser, et je recommanderais les cours de formation Google Cloud si vous pouvez vous permettre l'abonnement mensuel de 29 $.

En outre, le DataLab de DataCamp est une excellente plateforme pour mettre en pratique vos compétences. DataLab est un bloc-notes basé sur le cloud qui vous permet d'expérimenter avec du code, d'analyser des données, de collaborer avec d'autres personnes et de partager des idées sans aucune installation nécessaire. Il offre un environnement transparent pour travailler sur des données du monde réel, ce qui en fait un outil pratique pour affiner vos compétences en matière de données.

Vous pouvez également aller plus loin dans vos études et ajouter une certification BPC officielle à votre CV ou à votre profil LinkedIn pour mettre en valeur vos compétences auprès d'employeurs potentiels. Pour chaque certification, Google propose un examen pratique gratuit. Leur objectif est de vous aider à vous préparer à l'examen officiel, mais ils sont également très utiles pour les entretiens, alors n'hésitez pas à les consulter.

J'espère que ce guide vous a été utile et je vous souhaite bonne chance pour votre entretien !

Questions fréquemment posées

Que ne dois-je PAS faire lorsque je me prépare à un entretien avec les BPC ?

Essayez de ne pas mémoriser uniquement des faits. Au contraire, efforcez-vous de comprendre les concepts sous-jacents et préparez-vous à discuter de scénarios réels.

Dois-je mémoriser les commandes des BPC ?

Pas du tout. C'est à cela que sert la documentation !

Dois-je avoir une expérience pratique du GCP avant l'entretien ?

C'est certainement un avantage, mais ce n'est pas une exigence stricte. La démonstration d'une bonne compréhension des concepts GCP, ainsi que la volonté d'apprendre et de s'adapter, peuvent s'avérer très utiles.

J'ai de l'expérience avec AWS ou Azure. Dans quelle mesure ces connaissances sont-elles transférables ?

Les fournisseurs de cloud ont une terminologie différente et des services uniques, mais les concepts fondamentaux de l'informatique en nuage sont les mêmes. Si vous avez déjà une expérience avec un autre fournisseur de cloud, vous pourrez établir des parallèles entre les services et apprendre GCP plus rapidement que si vous partiez de zéro.

Que dois-je faire si l'examinateur pose une question à laquelle je ne connais pas la réponse ?

Si vous ne connaissez pas la réponse à une question, ne paniquez pas ! Si la question porte sur un service que vous ne connaissez pas ou sur un scénario que vous n'avez jamais rencontré auparavant, vous pouvez poser des questions de clarification. Prenez le temps de réfléchir, d'expliquer votre raisonnement et de vous appuyer sur votre expérience pour proposer une réponse logique.