programa

Los expertos en Hadoop escriben aplicaciones y analizan datos en constante cambio para obtener información valiosa y mantener la seguridad de los datos. Por eso, los responsables de contratación tienen criterios estrictos para encontrar al candidato más adecuado para el puesto y pueden preguntarte cualquier cosa, desde lo más básico hasta lo más avanzado.

En este artículo, hemos recopilado las 24 preguntas y respuestas más frecuentes en las entrevistas sobre Hadoop.

Este artículo está diseñado para ayudarte a prepararte a fondo para tu próxima entrevista de trabajo relacionada con el big data. Abarca conceptos fundamentales y escenarios avanzados. Tanto si eres principiante como profesional experimentado, encontrarás información valiosa y práctica que te ayudará a ganar confianza y mejorar tus posibilidades de éxito.

Preguntas básicas para una entrevista sobre Hadoop

Los entrevistadores suelen comenzar la entrevista con preguntas básicas para evaluar tus conocimientos sobre Hadoop y su relevancia en la gestión de big data.

Incluso si eres un ingeniero con experiencia, asegúrate de tener claras estas preguntas.

1. ¿Qué es el big data?

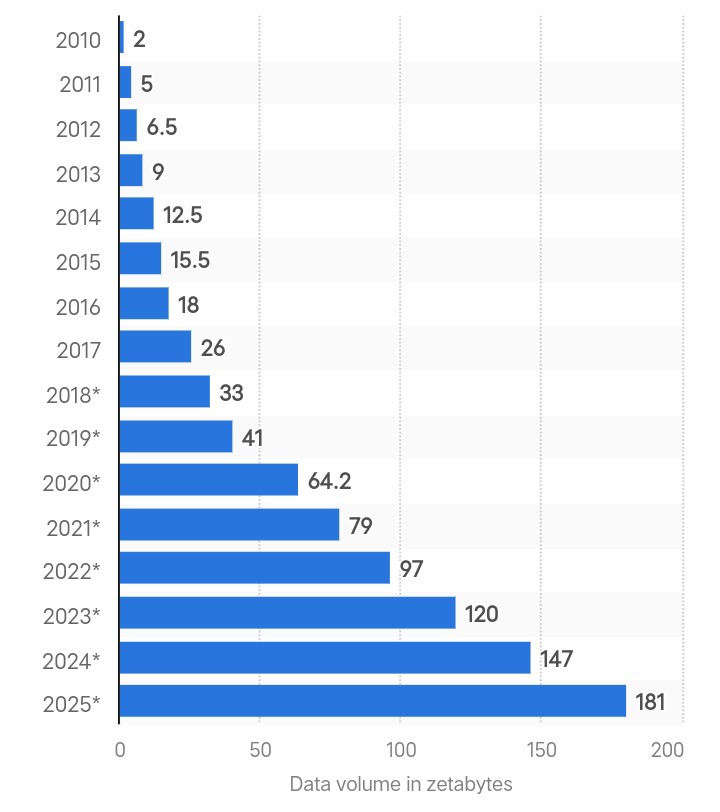

Creación global de datos en zettabytes. Fuente: Statista.

El término «big data» hace referencia a grandes cantidades de datos complejos generados a gran velocidad a partir de múltiples fuentes. La cantidad total de datos creados a nivel mundial fue de 180 zettabytes en 2025 y se prevé que se triplique para 2029.

A medida que se acelera la generación de datos, los métodos de análisis tradicionales no podrán proporcionar un procesamiento en tiempo real ni garantizar la seguridad de los datos. Por eso las empresas utilizan marcos avanzados como Hadoop para procesar y gestionar volúmenes de datos cada vez mayores.

Si deseas iniciar tu carrera profesional en el ámbito del big data, consulta nuestra guía sobre formación en big data.

2. ¿Qué es Hadoop y cómo resuelve el problema del big data?

Hadoop es un marco de código abierto para gestionar grandes conjuntos de datos distribuidos en varios ordenadores. Almacena datos en múltiples máquinas en forma de pequeños bloques utilizando el sistema de archivos distribuidos Hadoop (HDFS).

Con Hadoop, puedes añadir más nodos a un clúster y gestionar grandes volúmenes de datos sin necesidad de costosas actualizaciones de hardware.

Incluso grandes empresas como Google y Facebook confían en Hadoop para gestionar y analizar terabytes y petabytes de datos diarios.

3. ¿Cuáles son los dos componentes principales de Hadoop?

Los siguientes son los dos componentes principales de Hadoop:

- Sistema de archivos distribuidos Hadoop (HDFS): Gestiona el almacenamiento de datos dividiendo los archivos grandes en bloques, cada uno de 128 MB por defecto, y los distribuye entre varios nodos de un clúster.

- MapReduce: Es un modelo de programación en el que se basa Hadoop para el procesamiento de datos. Es un proceso de dos fases que consiste en mapear y reducir trabajos. El mapeo toma los datos y los convierte en otro conjunto de datos. El reductor toma como entrada los pares de valores generados por el trabajo de mapeo y los combina en pares más pequeños. El objetivo es procesarlos en una función de reducción definida por el usuario.

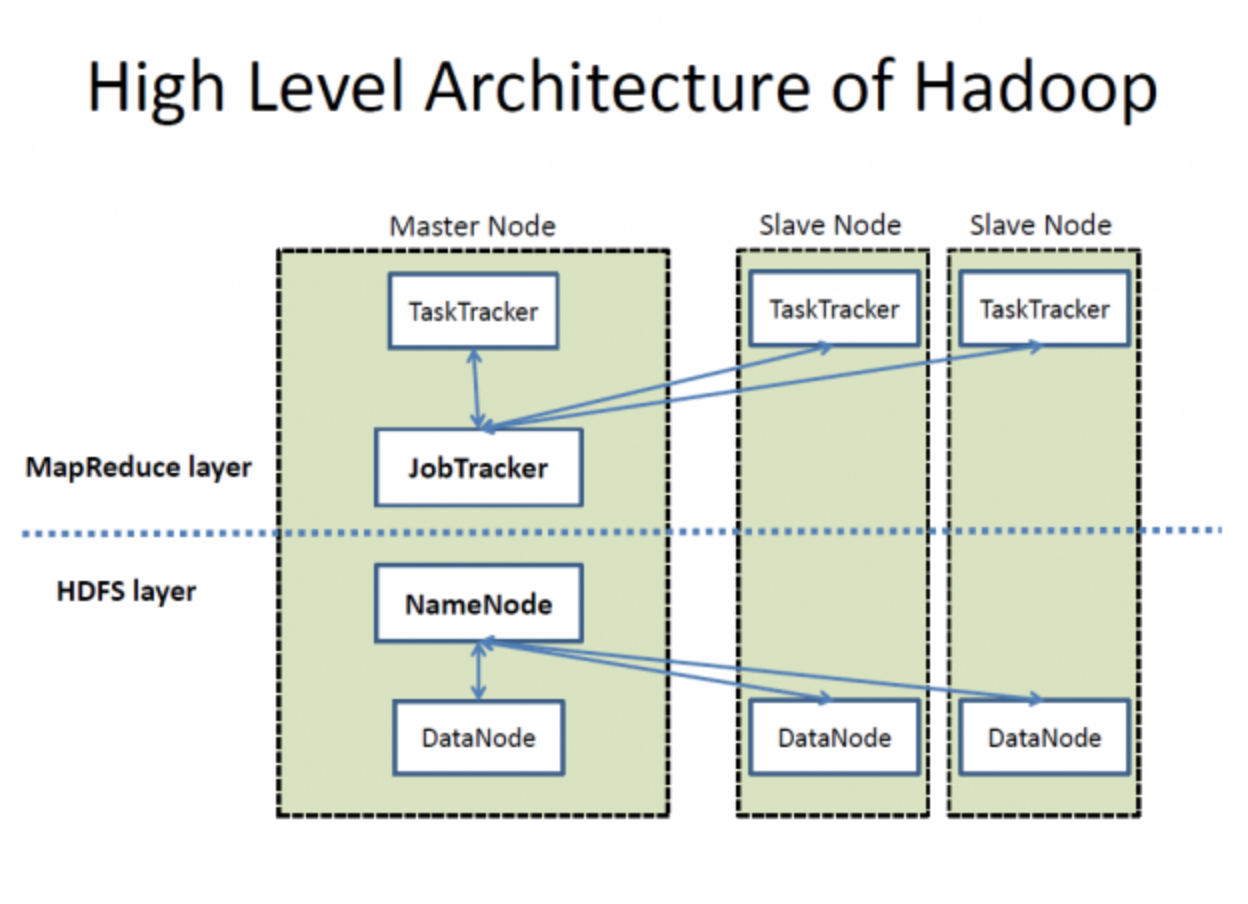

Arquitectura de alto nivel de Hadoop. Fuente: Wikimedia Commons

4. Define la función de NameNode y DataNode en Hadoop.

HDFS consta de un NameNode y varios DataNodes para la gestión de datos, como se ve en la imagen anterior. Así es como funcionan:

- Como servidor maestro en HDFS, NameNode gestiona operaciones como abrir, cerrar y renombrar archivos. Mantiene metadatos de permisos y la ubicación de los bloques.

- Por otro lado, los DataNodes actúan como nodos de trabajo para almacenar los bloques de datos reales de un archivo. Cuando un cliente necesita leer o escribir datos, obtiene la ubicación de los bloques de datos de NameNodes. A continuación, el cliente se comunica directamente con los DataNodes pertinentes para realizar las operaciones necesarias.

5. Explica la función de Hadoop YARN.

En Hadoop 1.x, MapReduce gestiona los recursos y programa los trabajos mediante JobTracker. Sin embargo, la lentitud del procesamiento es un inconveniente importante.

Hadoop 2.0 introdujo YARN (Yet Another Resource Negotiator) para abordar estos problemas. YARN separa la gestión de recursos y la programación de tareas en componentes independientes, lo que mejora la escalabilidad y la utilización de los recursos. Los componentes principales de YARN son:

- ResourceManager (RM): Gestiona los recursos en todo el clúster.

- NodeManager (NM): Gestiona los recursos y supervisa los nodos individuales.

- ApplicationMaster (AM): Gestiona el ciclo de vida de las aplicaciones, incluyendo tus necesidades de recursos y tu ejecución.

Cómo funciona YARN:

- Envío de trabajos: El cliente envía una solicitud al clúster YARN.

- Asignación de recursos: El ResourceManager comienza a asignar recursos coordinándose con el ApplicationMaster.

- Registro en ApplicationMaster: ApplicationMaster se registra en ResourceManager.

- Negociación de contenedores: El ApplicationMaster negocia los recursos (contenedores) con el ResourceManager.

- Lanzamiento del contenedor: Una vez asignados los recursos, ApplicationMaster ordena a NodeManagers que inicien los contenedores.

- Ejecución de la aplicación: El código de la aplicación se ejecuta dentro de los contenedores asignados.

Preguntas de entrevista intermedias sobre Hadoop

Las preguntas intermedias se centran más en evaluar tus conocimientos sobre los aspectos técnicos del marco Hadoop. El entrevistador puede preguntarte sobre el clúster Hadoop, sus retos y la comparación entre diferentes versiones.

6. ¿Qué es un clúster Hadoop? ¿Existe un tamaño de clúster específico que prefieran las empresas?

Un clúster Hadoop es un conjunto de nodos maestros y esclavos interconectados diseñado para almacenar y procesar grandes conjuntos de datos de forma distribuida. La arquitectura en clúster garantiza una alta disponibilidad, escalabilidad y tolerancia a fallos.

Componentes de un clúster Hadoop:

- Nodos maestros: Estos nodos gestionan los recursos del clúster y el sistema de archivos distribuido. Los componentes clave incluyen:

- NameNode: Gestiona el espacio de nombres del sistema de archivos distribuidos Hadoop (HDFS) y regula el acceso a los archivos por parte de los clientes.

- ResourceManager: Gestiona la asignación de recursos para ejecutar aplicaciones.

- Nodos esclavos: Estos nodos son responsables de almacenar datos y realizar cálculos. Los componentes clave incluyen:

- DataNode: Almacena bloques de datos reales en HDFS.

- NodeManager: Gestiona la ejecución de contenedores en el nodo.

Hay dos formas principales de configurar un clúster Hadoop:

- Clúster local: Utiliza componentes de hardware estándar para crear tu clúster. Este enfoque puede ser rentable y personalizable en función de los requisitos específicos.

- de clúster basado en la nube: Opta por servicios en la nube, como Amazon EMR, Google Cloud Dataproc o Azure HDInsight. Este método ofrece flexibilidad, escalabilidad y una reducción de los gastos generales de gestión.

Comparación entre clústeres locales y basados en la nube:

|

Característica |

Clúster local |

Clúster basado en la nube |

|

Costo de instalación |

Mayor inversión inicial |

Modelo de pago por uso |

|

Escalabilidad |

Limitado por el hardware físico |

Prácticamente ilimitado |

|

Mantenimiento |

Requiere gestión interna. |

Gestionado por el proveedor de servicios en la nube |

|

Flexibilidad |

Hardware y software personalizables |

Opciones preconfiguradas |

|

Tiempo de implementación |

Mayor tiempo de configuración |

Implementación rápida y sencilla |

No hay ninguna preferencia específica en cuanto al tamaño del clúster. El tamaño del clúster es fácilmente escalable y depende totalmente de los requisitos de almacenamiento. Las pequeñas empresas pueden basarse en clústeres con alrededor de 20 nodos, mientras que empresas como Yahoo operan (o solían hacerlo) en clústeres tan extensos que contienen hasta 40 000 nodos.

7. ¿Cuáles son algunos proyectos del ecosistema Hadoop?

Las diferentes industrias tienen necesidades específicas de análisis y procesamiento de datos. Por lo tanto, Hadoop ha lanzado muchos proyectos para proporcionar soluciones que se adapten a ellos como parte de su ecosistema. La lista de proyectos de Hadoop es más amplia de lo que puedas imaginar, pero estos son los más importantes:

- MapReduce: Modelo de programación para procesar grandes conjuntos de datos con un algoritmo paralelo y distribuido.

- Apache Hive: Una infraestructura de almacenamiento de datos para la síntesis, consulta y análisis de datos mediante HiveQL.

- Apache HBase: Un almacén de datos masivos escalable que proporciona acceso de lectura/escritura en tiempo real a grandes conjuntos de datos.

- Apache Pig: Una plataforma de alto nivel para crear programas MapReduce con Pig Latin.

- Apache Sqoop: Herramienta para transferir datos masivos entre Hadoop y almacenes de datos estructurados, como bases de datos relacionales.

- Apache Flume: Un servicio para recopilar, agregar y mover de manera eficiente grandes cantidades de datos de registro.

- Apache Oozie: Un sistema de programación de flujos de trabajo para gestionar tareas de Hadoop y sus dependencias.

- Apache Zookeeper: Un servicio centralizado para mantener la información de configuración y proporcionar sincronización distribuida.

- Apache Spark: Un sistema de computación en clúster rápido y de uso general con procesamiento en memoria.

- Apache Storm: Un sistema de cálculo en tiempo real para procesar grandes flujos de datos.

- Apache Kafka: Una plataforma de streaming distribuida para gestionar flujos de datos en tiempo real.

8. ¿Cuáles son algunos de los retos más comunes con Hadoop?

Aunque el marco Hadoop es excelente para gestionar y procesar enormes cantidades de datos valiosos, plantea algunos retos críticos.

Entendámoslos:

- El mayor problema de Hadoop es que su NameNode tiene un único punto de fallo, lo que provoca la pérdida de datos en caso de avería.

- Hadoop es vulnerable a las amenazas de seguridad. No puedes controlar directamente tus datos y no hay forma de saber si se están utilizando de forma indebida.

- El marco MapReduce de Hadoop procesa los datos por lotes y no admite el procesamiento de datos en tiempo real.

- Este marco funciona bien con datos de gran capacidad, pero no puede procesar archivos pequeños. Cuando los datos son más pequeños que el tamaño de bloque predeterminado de HDFS, se sobrecarga el NameNode y se producen problemas de latencia.

9. ¿Qué es HBase y cuál es la función de sus componentes?

HBase es una base de datos diseñada para acceder rápidamente a archivos de gran tamaño. Te permite leer y escribir grandes conjuntos de datos en tiempo real almacenando los datos en columnas e indexándolos con claves de fila únicas.

Esta configuración permite una rápida recuperación de datos y escaneos eficientes, lo que resulta adecuado para tablas grandes y poco pobladas, ya que podemos añadir tantos nodos como sea necesario.

HBase tiene tres componentes:

- HMaster: Gestiona los servidores regionales y es responsable de crear y eliminar tablas.

- Servidor regional: Gestiona las solicitudes de lectura y escritura y administra las divisiones regionales.

- ZooKeeper: Mantiene el estado del clúster y gestiona las asignaciones de servidores.

10. ¿En qué se diferencia Hadoop 2.0 de Hadoop 1.x?

Esta tabla compara ambas versiones de Hadoop:

|

Criterios |

Hadoop 1.x |

Hadoop 2.0 |

|

Gestión de NameNode |

Un único NameNode gestiona el espacio de nombres. |

Varios NameNodes gestionan los espacios de nombres a través de la federación HDFS. |

|

Compatibilidad con sistemas operativos |

No hay compatibilidad con Microsoft Windows. |

Se ha añadido compatibilidad con Microsoft. |

|

Gestión de trabajos y recursos |

Utiliza JobTracker y TaskTracker para la gestión de trabajos y recursos. |

Los sustituí por YARN para separar ambas tareas. |

|

Escalabilidad |

Puede ampliarse hasta 4000 nodos por clúster. |

Puede ampliarse hasta 10 000 nodos por clúster. |

|

Tamaño del DataNode |

Tiene un tamaño de DataNode de 64 MB. |

Ha duplicado el tamaño a 128 MB. |

|

Ejecución de tareas |

Utiliza ranuras que pueden ejecutar tareas Map o Reduce. |

Utiliza contenedores que pueden ejecutar cualquier tarea. |

Si estás solicitando un puesto de trabajo como ingeniero de datos, consulta nuestro artículo completo sobre preguntas frecuentes en entrevistas de trabajo para ingenieros de datos.

Preguntas avanzadas para entrevistas sobre Hadoop

Ahora es cuando las cosas se ponen interesantes. Estas preguntas de la entrevista se formulan para evaluar tus conocimientos a un nivel avanzado. Estas preguntas son especialmente importantes para los ingenieros sénior.

11. ¿Cuál es el concepto de NameNode activo y NameNode en espera en Hadoop 2.0?

En Hadoop 2.0, el Active NameNode gestiona el espacio de nombres del sistema de archivos y controla el acceso de los clientes a los archivos. Por el contrario, el Standby NameNode es una copia de seguridad y mantiene suficiente información para tomar el control si el Active NameNode falla.

Esto soluciona el problema del punto único de fallo (SPOF), habitual en Hadoop 1. x.

12. ¿Cuál es el propósito de la caché distribuida en Hadoop? ¿Por qué HDFS no puede leer archivos pequeños?

HDFS es ineficaz a la hora de procesar miles de archivos pequeños, lo que provoca un aumento de la latencia. Por eso, la caché distribuida te permite almacenar archivos de solo lectura, archivos de archivo y archivos jar, y ponerlos a disposición para tareas en MapReduce.

Supongamos que necesitas ejecutar 40 trabajos en MapReduce y que cada trabajo necesita acceder al archivo desde HDFS. En tiempo real, este número puede aumentar hasta alcanzar cientos o miles de lecturas. La aplicación localizará con frecuencia estos archivos en HDFS, lo que sobrecargará el HDFS y afectará a su rendimiento.

Sin embargo, una caché distribuida puede gestionar muchos archivos de pequeño tamaño y no compromete el tiempo de acceso ni la velocidad de procesamiento.

13. Explica la función de la suma de comprobación en la detección de datos dañados. Además, define el código estándar de detección de errores.

Las sumas de comprobación identifican los datos dañados en HDFS. Cuando los datos entran en el sistema, crean un pequeño valor conocido como suma de comprobación. Hadoop vuelve a calcular la suma de comprobación cuando un usuario solicita la transferencia de datos. Si la nueva suma de comprobación coincide con la original, los datos están intactos; si no, están corruptos.

El código de detección de errores para Hadoop es CRC-32.

14. ¿Cómo logra HDFS la tolerancia a fallos?

HDFS logra la tolerancia a fallos mediante un proceso de replicación que garantiza la fiabilidad y la disponibilidad. Así es como funciona el proceso de replicación:

- Distribución inicial de bloques: Cuando se guarda un archivo, HDFS lo divide en bloques y los asigna a diferentes DataNodes. Por ejemplo, un archivo dividido en bloques A, B y C podría almacenarse en los DataNodes A1, B2 y C3.

- Replicación: Cada DataNode que contiene un bloque replica ese bloque en otros DataNodes del clúster. Por ejemplo, el DataNode A1, que contiene el bloque A, creará copias adicionales en otros DataNodes, como D1 y D2. Esto significa que si A1 falla, las copias de A1 en D1 y D2 estarán disponibles.

- Gestión de fallos: Si DataNode D1 falla, puedes recuperar los bloques necesarios (B y C) de otros DataNodes, como B2 y C3.

15. ¿Se puede procesar un archivo comprimido con MapReduce? En caso afirmativo, ¿qué formatos admite y se pueden dividir?

Sí, es posible procesar archivos comprimidos con MapReduce. Hadoop admite múltiples formatos de compresión, pero no todos ellos son divisibles.

A continuación se indican los formatos compatibles con MapReduce:

- DESINFLAR

- gzip

- bzip2

- LZO

- LZ4

- Ágil

De todos ellos, bzip2 es el único formato divisible.

HDFS divide los archivos muy grandes en partes más pequeñas, cada una de 128 MB. Por ejemplo, HDFS dividirá un archivo de 1,28 GB en diez bloques. A continuación, cada bloque es procesado por un mapeador independiente en una tarea MapReduce. Pero si un archivo no se puede dividir, un único mapeador se encarga de todo el archivo.

Preguntas de la entrevista de Hive

Algunos puestos de trabajo requieren experiencia en la integración de Hive con Hadoop. En un puesto tan específico, el responsable de contratación se centrará en las siguientes preguntas:

16. Define «colmena».

Hive es un sistema de almacenamiento de datos que realiza trabajos por lotes y análisis de datos. Fue desarrollado por Facebook para ejecutar consultas similares a SQL en conjuntos de datos masivos almacenados en HDFS sin depender de Java.

Con Hive, podemos organizar los datos en tablas y utilizar un megastore para almacenar metadatos como esquemas. Es compatible con una amplia gama de sistemas de almacenamiento, como S3, Azure Data Lake Storage (ADLs) y Google Cloud Storage.

17. ¿Qué es un Hive Metastore (HMS)? ¿Cómo diferenciarías un metastore gestionado de un metastore externo?

Hive Metastore (HMS) es una base de datos centralizada para metadatos. Contiene información sobre tablas, vistas y permisos de acceso almacenados en el almacenamiento de objetos HDFS.

Hay dos tipos de tablas HIVE Metastore:

- Metastore gestionado: HIVE almacena y gestiona esta tabla en el servicio JVM de Hive. Podemos localizar estas tablas utilizando este valor predeterminado

/user/hive/warehouse. - Metastore externo: Estas tablas se ejecutan en una JVM externa. Por lo tanto, cualquier cambio en los metadatos de Hive no afecta a los datos almacenados en estas tablas.

18. ¿Qué lenguajes de programación admite Hive?

Hive ofrece un sólido soporte para la integración con múltiples lenguajes de programación, lo que mejora su versatilidad y facilidad de uso en diferentes aplicaciones:

- Python: Análisis de datos y machine learning.

- Java: Aplicaciones empresariales y procesamiento de datos personalizados.

- C++: Aplicaciones críticas para el rendimiento y SerDes personalizados.

- PHP: Aplicaciones basadas en web que acceden a datos de Hive.

19. ¿Cuál es el tamaño máximo de datos que puede manejar Hive?

Gracias a su integración con HDFS y a su arquitectura escalable, Hive puede gestionar petabytes de datos. No hay un límite máximo fijo para el tamaño de los datos que Hive puede gestionar, lo que lo convierte en una potente herramienta para el procesamiento y el análisis de big data.

20. ¿Cuántos tipos de datos hay en Hive?

Hive ofrece un amplio conjunto de tipos de datos para gestionar diferentes requisitos de datos:

- Tipos de datos integrados: Numérico, cadena, fecha/hora y misceláneo para el almacenamiento básico de datos.

- Tipos de datos complejos: arreglo, MAP, STRUCT y UNIONTYPE para representaciones de datos más avanzadas y estructuradas.

Tipos de datos integrados:

|

Categoría |

Tipo de datos |

Descripción |

Ejemplo |

|

Tipos numéricos |

TINYINT |

Entero con signo de 1 byte |

127 |

|

SMALLINT |

Entero con signo de 2 bytes |

32767 |

|

|

INT |

Entero con signo de 4 bytes |

2147483647 |

|

|

BIGINT |

Entero con signo de 8 bytes |

9223372036854775807 |

|

|

FLOTAR |

Punto flotante de precisión simple |

3,14 |

|

|

DOBLE |

Punto flotante de doble precisión |

3,141592653589793 |

|

|

DECIMAL |

Número decimal con signo de precisión arbitraria |

1234567890.1234567890 |

|

|

Tipos de cadenas |

CADENA |

Cadena de longitud variable |

¡Hola, mundo! |

|

VARCHAR |

Cadena de longitud variable con una longitud máxima especificada |

«Ejemplo» |

|

|

CHAR |

Cadena de longitud fija |

«A» |

|

|

Tipos de fecha/hora |

MARCA DE TIEMPO |

Fecha y hora, incluida la zona horaria. |

«01-01-2023, 12:34:56» |

|

FECHA |

Fecha sin hora |

«01-01-2023» |

|

|

INTERVAL |

Intervalo de tiempo |

INTERVALO «1» DÍA |

|

|

Tipos varios |

BOOLEANO |

Representa verdadero o falso. |

VERDADERO |

|

BINARIO |

Secuencia de bytes |

0x1A2B3C |

Tipos de datos complejos:

|

Tipo de datos |

Descripción |

Ejemplo |

|

ARRAY |

Colección ordenada de elementos |

arreglo<STRING> ('manzana', 'plátano', 'cereza') |

|

MAP |

Colección de pares clave-valor |

MAP<STRING, INT> ('clave1' -> 1, 'clave2' -> 2) |

|

ESTRUCTURA |

Colección de campos de diferentes tipos de datos |

STRUCT<nombre: STRING, edad: INT> ('Alice', 30) |

|

TIPO DE UNIÓN |

Puede contener cualquiera de varios tipos especificados. |

UNIONTYPE<INT, DOUBLE, STRING> (1, 2.0, 'tres') |

Preguntas de entrevista basadas en escenarios sobre Hadoop para ingenieros de big data

Estas preguntas evalúan tu capacidad para utilizar Hadoop para resolver problemas de la vida real. Son especialmente relevantes si estás solicitando un puesto de arquitecto de datos, pero pueden preguntarte en cualquier proceso de entrevista que requiera conocimientos de Hadoop.

21. Estás configurando un clúster HDFS con el sistema de replicación de Hadoop. El clúster tiene tres racks: A, B y C. Explica cómo Hadoop replicará un archivo llamado datafile.text.

Así es como Hadoop replicará los datos:

- Primera réplica en el rack A: Hadoop coloca la réplica inicial en un nodo elegido al azar en el rack A. Esta decisión minimiza la latencia de escritura al seleccionar un nodo local o cercano.

- Segunda réplica en el rack B: La segunda réplica se coloca en un nodo de un rack diferente, como el rack B. Esto garantiza que los datos no se pierdan si el rack A falla, lo que mejora la tolerancia a fallos.

- Tercera réplica en el rack B: La tercera réplica se coloca en otro nodo dentro del rack B. Colocarlo en el mismo rack que el segundo ayuda a equilibrar la carga de red entre los racks y reduce el tráfico entre ellos.

La estrategia de replicación de Hadoop en un clúster HDFS con tres racks (A, B y C) está diseñada para optimizar la distribución de la carga, mejorar la tolerancia a fallos y aumentar la eficiencia de la red. De esta manera, el sistema de gestión de datos de campo ( datafile.text ) se replica de forma que se equilibra el rendimiento y la fiabilidad.

22. Estás trabajando en una aplicación basada en Hadoop que interactúa con archivos mediante LocalFileSystem. ¿Cómo gestionarás la integridad de los datos con una suma de comprobación?

El uso de sumas de comprobación en el proceso de carga, transformación y almacenamiento ( LocalFileSystem ) de Hadoop garantiza la integridad de los datos mediante:

- Generación de sumas de comprobación: Creación automática de sumas de comprobación para fragmentos de datos durante la escritura de archivos.

- Almacenamiento de sumas de comprobación: Guardar sumas de comprobación en un archivo oculto

.filename.crcen el mismo directorio. - Verificación de sumas de comprobación: Comparación de las sumas de comprobación almacenadas con los datos reales durante las lecturas.

- Detección de discrepancias: Generar un error «

ChecksumException» en caso de discrepancias.

Siguiendo estos pasos, podemos garantizar que tu aplicación mantenga la integridad de los datos y detecte rápidamente cualquier posible corrupción de datos.

23. Supongamos que estás depurando un trabajo Hadoop a gran escala distribuido en varios nodos y hay casos inusuales que afectan al resultado. ¿Cómo lidiarías con eso?

Esto es lo que podemos hacer:

- Registrar posibles problemas: Utiliza sentencias de depuración para registrar los posibles problemas en

stderr. - Actualizar el estado de la tarea: Incluye las ubicaciones del registro de errores en los mensajes de estado de las tareas.

- Contadores personalizados: Implementa contadores para programar y analizar condiciones inusuales.

- Depuración de la salida del mapa: Escribe información de depuración en la salida del mapa.

- Programa de análisis de registros: Crea un programa MapReduce para el análisis detallado de registros.

Siguiendo estos pasos, podemos depurar sistemáticamente trabajos de Hadoop a gran escala y programar y resolver eficazmente casos inusuales que afecten al resultado.

24. Estás calculando la configuración de memoria para un clúster Hadoop utilizando YARN. Explica cómo configurarías la memoria para los trabajos de NodeManager y MapReduce.

Al configurar los ajustes de memoria para un clúster Hadoop utilizando YARN, es importante equilibrar la asignación de memoria entre los demonios Hadoop, los procesos del sistema y el NodeManager para optimizar el rendimiento y la utilización de los recursos.

Configuración de la memoria para NodeManager:

- Calcula la memoria física total del nodo: Determina la memoria física total disponible en cada nodo del clúster. Por ejemplo, si un nodo tiene 64 GB de RAM, tu memoria física total es de 64 000 MB.

- Deducir memoria para los demonios de Hadoop: Asigna memoria para los demonios Hadoop que se ejecutan en el nodo, como DataNode y NodeManager. Por lo general, entre 1000 y 2000 MB por demonio es suficiente. Por ejemplo, si asignas 1500 MB para el DataNode y el NodeManager, debes reservar 3000 MB.

- Reservar memoria para los procesos del sistema: Reserva memoria para otros procesos del sistema y servicios en segundo plano a fin de garantizar que el sistema operativo y los servicios esenciales funcionen correctamente. Una reserva típica puede ser de 2 GB (2000 MB).

- Asignar la memoria restante para NodeManager: Resta la memoria reservada para los demonios de Hadoop y los procesos del sistema de la memoria física total para determinar la memoria disponible que NodeManager puede asignar a los contenedores.

Configuración de la memoria para trabajos MapReduce:

- Ajustar

mapreduce.map.memory.mb: Este parámetro define la cantidad de memoria asignada para cada tarea de mapeo. Ajusta esta configuración en función de los requisitos de memoria de tus tareas de mapas. - Por ejemplo, si se establece

mapreduce.map.memory.mben 2048 MB, se asignarán 2 GB de memoria a cada tarea de mapa. - Ajustar

mapreduce.reduce.memory.mb: Este parámetro define la cantidad de memoria asignada para cada tarea de reducción. Ajusta esta configuración en función de los requisitos de memoria de tus tareas de reducción. - Por ejemplo, si se establece

mapreduce.reduce.memory.mben 4096 MB, cada tarea de reducción tendrá asignados 4 GB de memoria. - Configura el tamaño del contenedor: Asegúrate de que el tamaño del contenedor esté configurado correctamente en

yarn-site.xmlcon parámetros comoyarn.nodemanager.resource.memory-mb, que deben coincidir con la memoria asignada al NodeManager. - Por ejemplo, si NodeManager tiene 59 000 MB disponibles, puedes establecer

yarn.nodemanager.resource.memory-mben 59 000 MB.

Resumen de la configuración de memoria:

|

Componente |

Configuración |

Valores de ejemplo |

|

NodeManager |

Memoria física total |

64 000 MB |

|

Memoria para los demonios de Hadoop |

3000 MB |

|

|

Memoria para procesos del sistema |

2000 MB |

|

|

Memoria disponible para NodeManager |

59 000 MB |

|

|

Tarea de mapa de MapReduce |

mapreduce.map.memory.mb |

2048 MB |

|

Tarea de reducción de MapReduce |

mapreduce.reduce.memory.mb |

4096 MB |

|

Tamaño del contenedor |

yarn.nodemanager.resource.memory-mb |

59 000 MB |

Reflexiones finales

Después de comprender estas preguntas, debes conocer los términos básicos y tener un

Gran dominio de las complejidades de las aplicaciones Hadoop en la vida real. Además, debes adaptarte a los nuevos proyectos basados en Hadoop para seguir siendo relevante y destacar en tus entrevistas.

También puedes ampliar tus conocimientos sobre otros marcos de big data, como Spark y Flink, ya que son rápidos y tienen menos problemas de latencia que Hadoop.

Pero si buscas un itinerario de aprendizaje estructurado para dominar el big data, puedes consultar los siguientes recursos:

- Fundamentos del Big Data con PySpark: Este curso es un excelente punto de partida para aprender los conceptos básicos del procesamiento de big data con PySpark.

- Big Data con PySpark: Este programa ofrece una introducción completa a los conceptos de big data utilizando PySpark, y abarca aspectos como la manipulación de datos, machine learning y mucho más.

Conviértete en Ingeniero de Datos

Preguntas frecuentes

¿Qué habilidades adicionales debería aprender para complementar tus conocimientos sobre Hadoop?

Para mejorar tus perspectivas profesionales, aprende otros marcos de big data como Apache Spark y Apache Kafka. Es beneficioso comprender las bases de datos SQL y nosql, como MySQL y MongoDB. Es imprescindible tener un buen dominio de Python, Java y Scala, así como de herramientas de almacenamiento de datos como Apache Hive. Los marcos de machine learning como TensorFlow y PyTorch también pueden resultar muy útiles.

¿Cómo puedo adquirir experiencia práctica en Hadoop?

Adquiere experiencia práctica inscribiéndote en cursos y certificaciones en línea en plataformas como DataCamp. Participa en proyectos reales en GitHub o Kaggle. Busca prácticas en empresas que trabajen con big data. Participa en hackatones y concursos de programación. Contribuir a proyectos Hadoop de código abierto es otra forma eficaz de adquirir experiencia y demostrar tus habilidades.

¿Cuáles son las salidas profesionales disponibles para un profesional de Hadoop?

Las trayectorias profesionales para los profesionales de Hadoop incluyen puestos como ingeniero de big data, científico de datos, analista de datos, administrador de Hadoop, programadores de ETL y arquitecto de soluciones. Cada función implica diferentes aspectos del diseño, la gestión y el análisis de sistemas de procesamiento de datos a gran escala utilizando Hadoop y tecnologías relacionadas.

¿Es fácil conseguir un trabajo en Hadoop sin experiencia, o es necesario tenerla?

No hay duda de que las entrevistas de Hadoop son difíciles de superar. Sin embargo, no importa si eres un profesional novato o con experiencia: lo único que necesitas es una sólida comprensión de la teoría y conocimientos prácticos.

¿Cuáles son los retos más comunes a los que se enfrentan los profesionales de Hadoop en vuestras carreras?

Entre los retos más comunes se encuentran garantizar la seguridad de los datos, optimizar el rendimiento de los clústeres Hadoop, integrar diversas fuentes de datos, mantenerse al día con los rápidos avances tecnológicos y gestionar y escalar los clústeres. La gestión eficiente de los recursos para evitar cuellos de botella también es fundamental. Abordar estos retos te ayuda a avanzar en tu carrera como profesional de Hadoop.

Soy una estratega de contenidos a la que le encanta simplificar temas complejos. He ayudado a empresas como Splunk, Hackernoon y Tiiny Host a crear contenidos atractivos e informativos para su público.