Programa

Os especialistas em Hadoop criam aplicativos e analisam dados que mudam o tempo todo para entender melhor as coisas e manter a segurança dos dados. É por isso que os gerentes de contratação têm critérios bem rígidos pra achar a pessoa certa pro cargo e podem perguntar qualquer coisa, desde o básico até o avançado.

Neste artigo, juntamos as 24 perguntas e respostas mais comuns em entrevistas sobre Hadoop.

Esse artigo foi feito pra te ajudar a se preparar direitinho pra sua próxima entrevista de emprego na área de big data. Ele aborda conceitos básicos e cenários avançados. Seja você um iniciante ou um profissional experiente, vai encontrar dicas valiosas e informações práticas para aumentar sua confiança e melhorar suas chances de sucesso.

Perguntas básicas para entrevistas sobre Hadoop

Os entrevistadores geralmente começam a entrevista fazendo perguntas básicas para ver se você entende o Hadoop e como ele é importante para gerenciar big data.

Mesmo que você seja um engenheiro experiente, certifique-se de ter respostas para essas perguntas.

1. O que é big data?

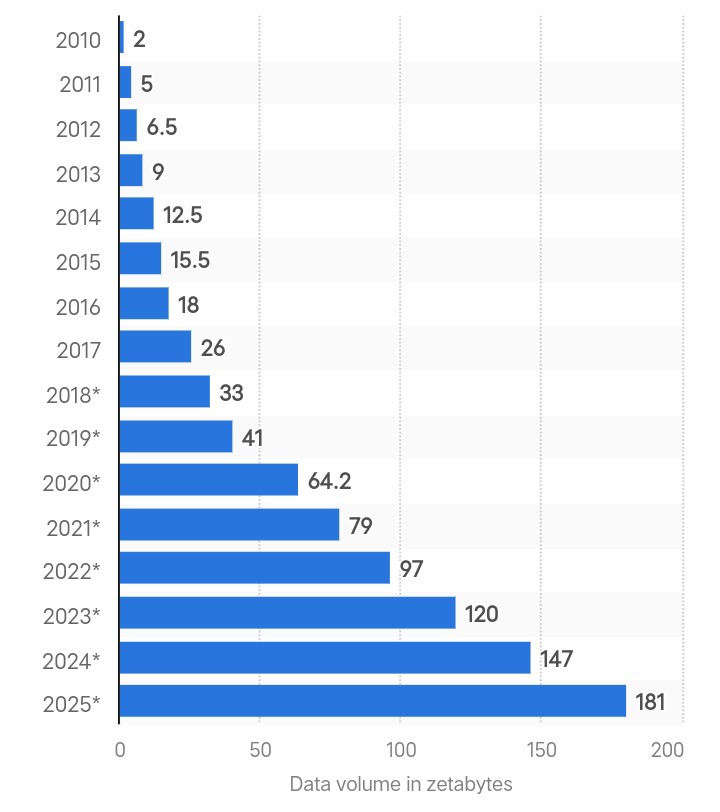

Criação global de dados em zettabytes. Fonte: Statista.

Big data é quando tem um monte de dados complexos que são gerados rapidinho de várias fontes. A quantidade total de dados criados no mundo todo foi de 180 zettabytes em 2025 e deve triplicar até 2029.

À medida que a geração de dados acelera, os métodos tradicionais de análise não vão conseguir oferecer processamento em tempo real e segurança dos dados. É por isso que as empresas usam estruturas avançadas como o Hadoop para processar e gerenciar volumes crescentes de dados.

Se você quer começar sua carreira em big data, dá uma olhada no nosso guia sobre treinamento em big data.

2. O que é o Hadoop e como ele resolve o problema dos grandes volumes de dados?

O Hadoop é uma estrutura de código aberto para lidar com grandes conjuntos de dados distribuídos por vários computadores. Ele guarda dados em várias máquinas como pequenos blocos usando o Sistema de Arquivos Distribuídos Hadoop (HDFS).

Com o Hadoop, você pode adicionar mais nós a um cluster e lidar com grandes volumes de dados sem precisar fazer atualizações caras de hardware.

Até mesmo grandes empresas como Google e Facebook dependem do Hadoop para gerenciar e analisar terabytes a petabytes de dados diariamente.

3. Quais são os dois principais componentes do Hadoop?

Aqui estão os dois principais componentes do Hadoop:

- Sistema de Arquivos Distribuídos Hadoop (HDFS): Ele gerencia o armazenamento de dados dividindo arquivos grandes em pedaços do tamanho de blocos, cada um com 128 MB por padrão, e distribui esses pedaços por vários nós em um cluster.

- MapReduce: É um modelo de programação que o Hadoop usa para processar dados. É um processo de duas etapas que envolve mapear e reduzir tarefas. O mapeamento pega os dados e transforma em outro conjunto de dados. O redutor pega os pares de valores que saem do trabalho de mapeamento como entrada e junta eles em pares menores. O objetivo é processá-los em uma função de redução definida pelo usuário.

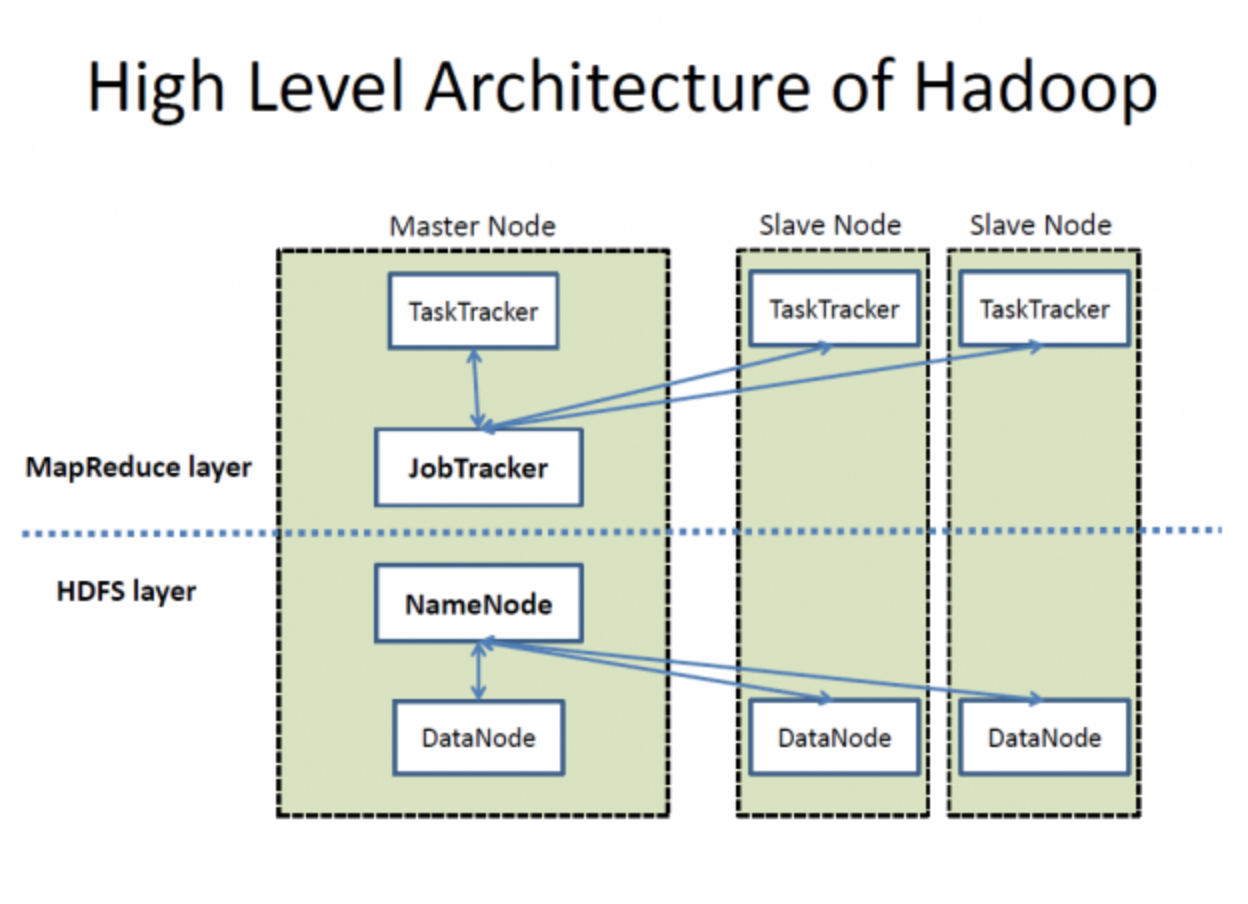

Arquitetura de alto nível do Hadoop. Fonte: Wikimedia Commons

4. Defina o papel do NameNode e do DataNode no Hadoop.

O HDFS é composto por um NameNode e vários DataNodes para gerenciamento de dados, como mostra a imagem acima. Eis como funcionam:

- Como servidor principal no HDFS, o NameNode cuida de operações como abrir, fechar e renomear arquivos. Ele mantém os metadados das permissões e a localização dos blocos.

- Os DataNodes, por outro lado, funcionam como nós de trabalho para guardar os blocos de dados reais de um arquivo. Quando um cliente precisa ler ou gravar dados, ele obtém a localização dos blocos de dados dos NameNodes. Depois disso, o cliente fala direto com os DataNodes certos para fazer o que precisa.

5. Explique o papel do Hadoop YARN.

No Hadoop 1.x, o MapReduce cuida do gerenciamento de recursos e do agendamento de tarefas usando o JobTracker. Mas, o processamento lento é uma grande desvantagem.

O Hadoop 2.0 trouxe o YARN (Yet Another Resource Negotiator) pra resolver esses problemas. O YARN separa o gerenciamento de recursos e o agendamento de tarefas em componentes diferentes, o que melhora a escalabilidade e a utilização dos recursos. Os principais componentes do YARN são:

- ResourceManager (RM): Gerencia os recursos em todo o cluster.

- NodeManager (NM): Gerencia recursos e monitoramento de nós individuais.

- ApplicationMaster (AM): Gerencia o ciclo de vida das aplicações, incluindo suas necessidades de recursos e execução.

Como funciona o YARN:

- Envio de trabalhos: O cliente manda um pedido para o cluster YARN.

- Alocação de recursos: O ResourceManager começa a alocar recursos coordenando-se com o ApplicationMaster.

- Registro no ApplicationMaster: O ApplicationMaster se registra no ResourceManager.

- Negociação de contêineres: O ApplicationMaster negocia recursos (contêineres) com o ResourceManager.

- Lançamento do contêiner: Depois que os recursos são alocados, o ApplicationMaster manda os NodeManagers abrirem os contêineres.

- Execução do aplicativo: O código do aplicativo é executado dentro dos contêineres alocados.

Perguntas intermediárias sobre Hadoop para entrevistas

As perguntas intermediárias são mais focadas em avaliar o seu conhecimento sobre os detalhes técnicos da estrutura Hadoop. O entrevistador pode perguntar sobre o cluster Hadoop, seus desafios e a comparação entre diferentes versões.

6. O que é um cluster Hadoop e as empresas têm um tamanho específico de cluster que preferem?

Um cluster Hadoop é um conjunto de nós mestres e escravos interconectados, projetado para armazenar e processar grandes conjuntos de dados de forma distribuída. A arquitetura em cluster garante alta disponibilidade, escalabilidade e tolerância a falhas.

Componentes de um cluster Hadoop:

- Nós mestres: Esses nós cuidam dos recursos do cluster e do sistema de arquivos distribuído. Os principais componentes incluem:

- : Gerencia o namespace do Hadoop Distributed File System (HDFS) e controla o acesso aos arquivos pelos clientes.

- ResourceManager: Gerencia a alocação de recursos para a execução de aplicativos.

- Nós escravos: Esses nós são responsáveis por guardar dados e fazer cálculos. Os principais componentes incluem:

- : Armazena blocos de dados reais no HDFS.

- NodeManager: Gerencia a execução de contêineres no nó.

Tem duas maneiras principais de configurar um cluster Hadoop:

- Cluster local: Use componentes de hardware comuns para montar seu cluster. Essa abordagem pode ser econômica e personalizável com base em requisitos específicos.

- de cluster baseado em nuvem: Escolha serviços baseados em nuvem, como Amazon EMR, Google Cloud Dataproc ou Azure HDInsight. Esse método oferece flexibilidade, escalabilidade e redução dos custos administrativos.

Comparando clusters locais e baseados em nuvem:

|

Recurso |

Cluster local |

Cluster baseado em nuvem |

|

Custo de instalação |

Maior investimento inicial |

Modelo de pagamento conforme o uso |

|

Escalabilidade |

Limitado pelo hardware físico |

Praticamente ilimitado |

|

Manutenção |

Precisa de gestão interna |

Gerenciado pelo provedor de nuvem |

|

Flexibilidade |

Hardware e software personalizáveis |

Opções pré-configuradas |

|

Tempo de implantação |

Mais tempo de configuração |

Implantação rápida e fácil |

Não tem preferência específica pro tamanho do cluster. O tamanho do cluster é fácil de ajustar e depende totalmente dos requisitos de armazenamento. Pequenas empresas podem usar clusters com cerca de 20 nós, enquanto empresas como o Yahoo operam (ou operavam) em clusters com até 40.000 nós.

7. Quais são alguns projetos do ecossistema Hadoop?

Diferentes setores têm necessidades específicas de análise e processamento de dados. Então, o Hadoop lançou vários projetos pra oferecer soluções que atendem a essas necessidades como parte do seu ecossistema. A lista de projetos Hadoop é maior do que você imagina, mas aqui estão os mais importantes:

- : Um modelo de programação para processar grandes conjuntos de dados com um algoritmo paralelo e distribuído.

- : Uma infraestrutura de warehouse para resumo, consulta e análise de dados usando HiveQL.

- : Um armazenamento de big data escalável que dá acesso de leitura/gravação em tempo real a grandes conjuntos de dados.

- : Uma plataforma de alto nível para criar programas MapReduce com Pig Latin.

- Apache Sqoop: Uma ferramenta para transferir dados em massa entre o Hadoop e armazenamentos de dados estruturados, como bancos de dados relacionais.

- Apache Flume: Um serviço para coletar, juntar e mover grandes quantidades de dados de registro de forma eficiente.

- Apache Oozie: Um sistema de agendamento de fluxo de trabalho para gerenciar tarefas do Hadoop e suas dependências.

- Apache Zookeeper: Um serviço centralizado para manter informações de configuração e fornecer sincronização distribuída.

- Apache Spark: Um sistema rápido de computação em cluster para uso geral com processamento em memória.

- : Um sistema de computação em tempo real para processar grandes fluxos de dados.

- Apache Kafka: Uma plataforma de streaming distribuída para lidar com feeds de dados em tempo real.

8. Quais são alguns dos desafios comuns com o Hadoop?

Embora a estrutura Hadoop seja excelente para gerenciar e processar enormes quantidades de dados valiosos, ela apresenta alguns desafios críticos.

Vamos entender o que são:

- O maior problema do Hadoop é que seu NameNode tem um único ponto de falha, o que faz com que os dados se percam se ele parar de funcionar.

- O Hadoop é vulnerável a ameaças de segurança. Você não pode controlar diretamente seus dados e não tem como saber se eles estão sendo usados de forma errada.

- A estrutura MapReduce do Hadoop processa dados em lotes e não suporta o processamento de dados em tempo real.

- Essa estrutura funciona bem com dados de alta capacidade, mas não consegue processar arquivos pequenos. Quando os dados são menores que o tamanho padrão do bloco HDFS, isso sobrecarrega o NameNode e causa problemas de latência.

9. O que é o HBase e qual é o papel dos seus componentes?

O HBase é um banco de dados feito pra acessar arquivos grandes rapidinho. Ele permite que você leia e escreva grandes conjuntos de dados em tempo real, armazenando os dados em colunas e indexando-os com chaves de linha exclusivas.

Essa configuração permite uma recuperação rápida de dados e varreduras eficientes, o que é ideal para tabelas grandes e pouco preenchidas, porque a gente pode adicionar quantos nós forem necessários.

O HBase tem três componentes:

- HMaster: Ele gerencia servidores regionais e é responsável por criar e remover tabelas.

- Servidor regional: Ele lida com solicitações de leitura e gravação e gerencia divisões de regiões.

- ZooKeeper: Ele mantém o estado do cluster e gerencia as atribuições do servidor.

10. O que faz o Hadoop 2.0 ser diferente do Hadoop 1.x?

Essa tabela compara as duas versões do Hadoop lado a lado:

|

Critérios |

Hadoop 1.x |

Hadoop 2.0 |

|

Gerenciamento do NameNode |

Um único NameNode cuida do namespace. |

Vários NameNodes lidam com namespaces por meio da federação HDFS |

|

Suporte ao sistema operacional |

Não há suporte para o Microsoft Windows. |

Adicionado suporte para Microsoft |

|

Gerenciamento de tarefas e recursos |

Usa o JobTracker e o TaskTracker para gerenciar tarefas e recursos |

Troquei por YARN pra separar as duas tarefas. |

|

Escalabilidade |

Pode escalar até 4.000 nós por cluster |

Pode escalar até 10.000 nós por cluster |

|

Tamanho do DataNode |

Tem um tamanho de DataNode de 64 MB |

Aumentou o tamanho para 128 MB |

|

Execução da tarefa |

Usa slots que podem executar tarefas Map ou Reduce |

Usa contêineres que podem executar qualquer tarefa |

Se você está se candidatando a um emprego na área de engenharia de dados, confira nosso artigo completo sobre perguntas em entrevistas para engenheiros de dados.

Perguntas avançadas sobre Hadoop para entrevistas

Agora é que as coisas ficam interessantes. Essas perguntas da entrevista são feitas pra testar você num nível mais avançado. Essas questões são especialmente importantes para engenheiros seniores.

11. Qual é o conceito de NameNode ativo e NameNode em espera no Hadoop 2.0?

No Hadoop 2.0, o Active NameNode cuida do namespace do sistema de arquivos e controla o acesso dos clientes aos arquivos. Por outro lado, o Standby NameNode é um backup e mantém informações suficientes para assumir o controle caso o Active NameNode falhe.

Isso resolve o problema do ponto único de falha (SPOF), comum no Hadoop 1.x.

12. Qual é o objetivo do cache distribuído no Hadoop? Por que o HDFS não consegue ler arquivos pequenos?

O HDFS não é muito bom em lidar com milhares de arquivos pequenos, o que faz com que a latência aumente. É por isso que o cache distribuído permite que você armazene arquivos somente leitura, arquivos de arquivo e arquivos jar e os disponibilize para tarefas no MapReduce.

Digamos que você precise rodar 40 tarefas no MapReduce, e cada uma delas precisa acessar o arquivo do HDFS. Em tempo real, esse número pode chegar a centenas ou milhares de leituras. O aplicativo frequentemente localizará esses arquivos no HDFS, o que sobrecarregará o HDFS e afetará seu desempenho.

Mas, um cache distribuído consegue lidar com muitos arquivos pequenos e não prejudica o tempo de acesso e a velocidade de processamento.

13. Explique o papel da soma de verificação na detecção de dados corrompidos. Além disso, defina o código padrão de detecção de erros.

As somas de verificação identificam dados corrompidos no HDFS. Quando os dados entram no sistema, eles criam um pequeno valor chamado checksum. O Hadoop recalcula a soma de verificação quando um usuário pede a transferência de dados. Se a nova soma de verificação corresponder à original, os dados estão intactos; caso contrário, estão corrompidos.

O código de detecção de erros para o Hadoop é CRC-32.

14. Como o HDFS consegue tolerância a falhas?

O HDFS consegue tolerância a falhas por meio de um processo de replicação que garante confiabilidade e disponibilidade. Veja como funciona o processo de replicação:

- Distribuição inicial dos blocos: Quando um arquivo é salvo, o HDFS divide-o em blocos e os atribui a diferentes DataNodes. Por exemplo, um arquivo dividido nos blocos A, B e C pode ser armazenado nos DataNodes A1, B2 e C3.

- Replicação: Cada DataNode que tem um bloco replica esse bloco para outros DataNodes no cluster. Por exemplo, o DataNode A1, que guarda o bloco A, vai criar cópias adicionais em outros DataNodes, como o D1 e o D2. Isso quer dizer que, se o A1 travar, as cópias do A1 no D1 e no D2 vão estar disponíveis.

- Lidando com falhas: Se o DataNode D1 falhar, você pode pegar os blocos necessários (B e C) de outros DataNodes, como B2 e C3.

15. Dá pra processar um arquivo compactado com o MapReduce? Se sim, quais formatos ele suporta e eles podem ser divididos?

Sim, dá pra processar arquivos compactados com o MapReduce. O Hadoop suporta vários formatos de compactação, mas nem todos são divisíveis.

Aqui estão os formatos que o MapReduce aceita:

- DESINFLAR

- gzip

- bzip2

- LZO

- LZ4

- Ágil

De todos esses, o bzip2 é o único formato que dá pra dividir.

O HDFS divide arquivos muito grandes em partes menores, cada uma com 128 MB. Por exemplo, o HDFS vai dividir um arquivo de 1,28 GB em dez blocos. Cada bloco é então processado por um mapeador separado em uma tarefa MapReduce. Mas se um arquivo não puder ser dividido, um único mapeador cuidará de todo o arquivo.

Perguntas da entrevista da Hive

Alguns trabalhos exigem experiência em integração do Hive com o Hadoop. Nessa função específica, o gerente de contratação vai se concentrar nessas questões:

16. Defina Hive.

O Hive é um sistema de warehouse de dados que faz trabalhos em lote e análises de dados. Foi desenvolvido pelo Facebook para executar consultas semelhantes a SQL em conjuntos de dados massivos armazenados no HDFS sem depender do Java.

Com o Hive, a gente pode organizar os dados em tabelas e usar um megastore pra guardar metadados, tipo esquemas. Ele suporta uma variedade de sistemas de armazenamento, como S3, Azure Data Lake Storage (ADLs) e Google Cloud Storage.

17. O que é um Hive Metastore (HMS)? Como você diferenciaria um Metastore Gerenciado de um Metastore Externo?

O Hive Metastore (HMS) é um banco de dados centralizado para metadados. Tem informações sobre tabelas, visualizações e permissões de acesso guardadas no armazenamento de objetos HDFS.

Existem dois tipos de tabelas HIVE Metastore:

- Metastore gerenciado: O HIVE guarda e gerencia essa tabela no serviço JVM do Hive. A gente pode achar essas tabelas usando esse valor padrão

/user/hive/warehouse. - Metastore externo: Essas tabelas funcionam em uma JVM externa. Então, qualquer mudança nos metadados do Hive não afeta os dados guardados nessas tabelas.

18. Quais linguagens de programação o Hive suporta?

O Hive oferece um suporte robusto para integração com várias linguagens de programação, aumentando sua versatilidade e usabilidade em diferentes aplicações:

- Python: Análise de dados e machine learning.

- Java: Aplicativos empresariais e processamento de dados personalizados.

- C++: Aplicativos que exigem desempenho crítico e SerDes personalizados.

- PHP: Aplicativos baseados na web que acessam dados do Hive.

19. Qual é o tamanho máximo de dados que o Hive consegue lidar?

Por causa da integração com o HDFS e da arquitetura escalável, o Hive consegue lidar com petabytes de dados. Não tem um limite máximo fixo para o tamanho dos dados que o Hive consegue gerenciar, o que faz dele uma ferramenta poderosa para processamento e análise de big data.

20. Quantos tipos de dados existem no Hive?

O Hive tem um monte de tipos de dados pra lidar com diferentes necessidades:

- Tipos de dados integrados: Numérico, String, Data/Hora e diversos para armazenamento básico de dados.

- Tipos de dados complexos: ARRAY, MAP, STRUCT e UNIONTYPE para representações de dados mais avançadas e estruturadas.

Tipos de dados integrados:

|

Categoria |

Tipo de dados |

Descrição |

Exemplo |

|

Tipos numéricos |

TINYINT |

Inteiro assinado de 1 byte |

127 |

|

SMALLINT |

Inteiro assinado de 2 bytes |

32767 |

|

|

INT |

Inteiro com sinal de 4 bytes |

2147483647 |

|

|

BIGINT |

Inteiro assinado de 8 bytes |

9223372036854775807 |

|

|

FLOAT |

Ponto flutuante de precisão simples |

3,14 |

|

|

DUPLO |

Ponto flutuante de precisão dupla |

3,141592653589793 |

|

|

DECIMAL |

Número decimal com precisão arbitrária e sinal |

1234567890.1234567890 |

|

|

Tipos de string |

STRING |

String de comprimento variável |

Oi, mundo! |

|

VARCHAR |

String de comprimento variável com comprimento máximo especificado |

'Exemplo' |

|

|

CHAR |

String de comprimento fixo |

'A' |

|

|

Tipos de data/hora |

CARIMBO DE DATA/HORA |

Data e hora, incluindo fuso horário |

“01/01/2023 12:34:56” |

|

DATA |

Data sem hora |

“01/01/2023” |

|

|

INTERVALO |

Intervalo de tempo |

INTERVALO '1' DIA |

|

|

Tipos diversos |

BOOLEANO |

Representa verdadeiro ou falso |

VERDADEIRO |

|

BINÁRIO |

Sequência de bytes |

0x1A2B3C |

Tipos de dados complexos:

|

Tipo de Dados |

Descrição |

Exemplo |

|

MATRIZ |

Coleção ordenada de elementos |

ARRAY<STRING> ('maçã', 'banana', 'cereja') |

|

MAP |

Coleção de pares chave-valor |

MAP<STRING, INT> ('chave1' -> 1, 'chave2' -> 2) |

|

STRUCT |

Coleção de campos de diferentes tipos de dados |

STRUCT<nome: STRING, idade: INT> ('Alice', 30) |

|

TIPO DE UNIÃO |

Pode conter qualquer um dos vários tipos especificados |

TIPO DE UNIÃO<INT, DOUBLE, STRING> (1, 2,0, 'três') |

Perguntas de entrevista sobre Hadoop baseadas em cenários para engenheiros de Big Data

Essas perguntas testam sua habilidade de usar o Hadoop para lidar com problemas da vida real. Elas são especialmente importantes se você estiver se candidatando a uma vaga de arquiteto de dados, mas podem ser feitas em qualquer entrevista que exija conhecimento de Hadoop.

21. Você está configurando um cluster HDFS com o sistema de replicação do Hadoop. O cluster tem três racks: A, B e C. Explique como o Hadoop vai replicar um arquivo chamado datafile.text.

Veja como o Hadoop vai replicar os dados:

- Primeira réplica no rack A: O Hadoop coloca a réplica inicial em um nó escolhido aleatoriamente no rack A. Essa decisão minimiza a latência de gravação, selecionando um nó local ou próximo.

- Segunda réplica no rack B: A segunda réplica é colocada em um nó em um rack diferente, como o rack B. Isso garante que os dados não sejam perdidos se o rack A falhar, melhorando a tolerância a falhas.

- Terceira réplica no rack B: A terceira réplica é colocada em outro nó dentro do rack B. Colocá-la no mesmo rack que a segunda ajuda a equilibrar a carga da rede entre os racks e reduz o tráfego entre eles.

A estratégia de replicação do Hadoop em um cluster HDFS com três racks (A, B e C) foi projetada para otimizar a distribuição de carga, aumentar a tolerância a falhas e melhorar a eficiência da rede. Assim, o datafile.text é replicado de uma forma que equilibra desempenho e confiabilidade.

22. Você está trabalhando em um aplicativo baseado em Hadoop que interage com arquivos usando o LocalFileSystem. Como você vai cuidar da integridade dos dados com uma soma de verificação?

Usar checksums no Hadoop's LocalFileSystem garante a integridade dos dados ao:

- Gerando somas de verificação: Criando automaticamente somas de verificação para blocos de dados durante a gravação de arquivos.

- Armazenando somas de verificação: Salvar somas de verificação em um arquivo oculto

.filename.crcno mesmo diretório. - Verificando somas de verificação: Comparando somas de verificação armazenadas com dados reais durante as leituras.

- Detectando incompatibilidades: Gerar uma exceção "

ChecksumException" em caso de discrepâncias.

Seguindo essas etapas, podemos garantir que seu aplicativo mantenha a integridade dos dados e detecte rapidamente qualquer possível corrupção de dados.

23. Digamos que você esteja depurando uma tarefa Hadoop grande, espalhada por vários nós, e tem uns casos estranhos afetando a saída. Como você lidaria com isso?

E aí, o que a gente pode fazer:

- Registre possíveis problemas: Use instruções de depuração para registrar os possíveis problemas em

stderr. - Atualizar status da tarefa: Incluir os locais dos registros de erros nas mensagens de status da tarefa.

- Contadores personalizados: Coloque contadores pra acompanhar e analisar condições fora do normal.

- Depuração da saída do mapa: Escreva informações de depuração na saída do mapa.

- Programa de análise de registros: Crie um programa MapReduce para uma análise detalhada dos registros.

Seguindo essas etapas, podemos depurar sistematicamente tarefas Hadoop em grande escala e programar e resolver com eficácia casos incomuns que afetam a saída.

24. Você está calculando as configurações de memória para um cluster Hadoop usando o YARN. Explique como você configuraria a memória para os trabalhos do NodeManager e do MapReduce.

Ao configurar as definições de memória para um cluster Hadoop usando o YARN, é importante equilibrar a alocação de memória entre os daemons Hadoop, os processos do sistema e o NodeManager para otimizar o desempenho e a utilização dos recursos.

Configurando a memória para o NodeManager:

- Calcule a memória física total do nó: Descubra a quantidade total de memória física disponível em cada nó do cluster. Por exemplo, se um nó tem 64 GB de RAM, sua memória física total é de 64.000 MB.

- Deduza a memória para os daemons do Hadoop: Alocar memória para os daemons do Hadoop em execução no nó, como o DataNode e o NodeManager. Normalmente, 1000 a 2000 MB por daemon é o suficiente. Por exemplo, se você alocar 1500 MB para o DataNode e para o NodeManager, vai precisar reservar 3000 MB.

- Reserve memória para processos do sistema: Reserve memória para outros processos do sistema e serviços em segundo plano para garantir que o sistema operacional e os serviços essenciais funcionem sem problemas. Uma reserva típica pode ser de 2 GB (2000 MB).

- Alocar a memória restante para o NodeManager: Tira a memória reservada para os daemons do Hadoop e os processos do sistema da memória física total para ver a memória disponível que o NodeManager pode alocar para os contêineres.

Configurando a memória para tarefas MapReduce:

- Ajustar

mapreduce.map.memory.mb: Esse parâmetro define a quantidade de memória alocada para cada tarefa do mapa. Ajuste essa configuração com base nos requisitos de memória das suas tarefas de mapa. - Por exemplo, definir

mapreduce.map.memory.mbcomo 2048 MB significa que cada tarefa de mapeamento vai ter 2 GB de memória. - Ajustar

mapreduce.reduce.memory.mb: Esse parâmetro define a quantidade de memória alocada para cada tarefa de redução. Ajuste essa configuração com base nos requisitos de memória das suas tarefas de redução. - Por exemplo, definir

mapreduce.reduce.memory.mbcomo 4096 MB significa que cada tarefa de redução vai receber 4 GB de memória. - Configurar o tamanho do contêiner: Certifique-se de que o tamanho do contêiner esteja definido corretamente em

yarn-site.xmlcom parâmetros comoyarn.nodemanager.resource.memory-mb, que devem estar alinhados com a memória alocada para o NodeManager. - Por exemplo, se o NodeManager tiver 59.000 MB disponíveis, você pode definir

yarn.nodemanager.resource.memory-mbcomo 59.000 MB.

Resumo da configuração da memória:

|

Componente |

Configuração |

Exemplos de valores |

|

Gerenciador de Nós |

Memória física total |

64.000 MB |

|

Memória para daemons Hadoop |

3000 MB |

|

|

Memória para processos do sistema |

2000 MB |

|

|

Memória disponível para o NodeManager |

59.000 MB |

|

|

Tarefa de mapeamento do MapReduce |

mapreduce.map.memória.mb |

2048 MB |

|

Tarefa de redução do MapReduce |

mapreduce.reduce.memória.mb |

4096 MB |

|

Tamanho do contêiner |

yarn.nodemanager.resource.memory-mb |

59.000 MB |

Considerações finais

Depois de entender essas questões, você deve conhecer os termos básicos e ter uma

domínio sólido das complexidades das aplicações Hadoop na vida real. Além disso, você precisa se adaptar aos novos projetos criados no Hadoop para continuar relevante e se sair bem nas entrevistas.

Você também pode expandir seus conhecimentos sobre outras estruturas de big data, como Spark e Flink, pois elas são rápidas e têm menos problemas de latência do que o Hadoop.

Mas se você está procurando uma trilha de aprendizagem estruturada para dominar o big data, dá uma olhada nos recursos a seguir:

- Fundamentos de Big Data com PySpark: Esse curso é um ótimo ponto de partida pra aprender o básico sobre processamento de big data com o PySpark.

- Big Data com PySpark: Esse programa oferece uma introdução completa aos conceitos de big data usando PySpark, cobrindo coisas como manipulação de dados, machine learning e muito mais.

Torne-se um engenheiro de dados

Perguntas frequentes

Que habilidades adicionais devo aprender para complementar meus conhecimentos sobre Hadoop?

Para melhorar suas perspectivas de carreira, aprenda outras estruturas de big data, como Apache Spark e Apache Kafka. É legal entender bancos de dados SQL e nosql, como MySQL e MongoDB. É essencial saber Python, Java e Scala, além de ferramentas de warehouse de dados como o Apache Hive. Estruturas de machine learning como TensorFlow e PyTorch também podem ser úteis.

Como posso ganhar experiência prática em Hadoop?

Ganhe experiência prática fazendo cursos online e certificações em plataformas como o DataCamp. Participe de projetos reais no GitHub ou no Kaggle. Procure estágios em empresas que trabalham com big data. Participe de hackathons e competições de programação. Contribuir para projetos Hadoop de código aberto é outra maneira eficaz de ganhar experiência e mostrar suas habilidades.

Quais são as carreiras disponíveis para um profissional de Hadoop?

As carreiras para profissionais de Hadoop incluem funções como engenheiro de big data, cientista de dados, analista de dados, administrador de Hadoop, desenvolvedor de ETL e arquiteto de soluções. Cada função envolve diferentes aspectos do projeto, gerenciamento e análise de sistemas de processamento de dados em grande escala usando o Hadoop e tecnologias relacionadas.

É fácil conseguir um emprego na área de Hadoop como novato ou preciso ter experiência?

Não tem dúvida que as entrevistas sobre Hadoop são difíceis de passar. Mas, não importa se você é novato ou profissional experiente — o que você precisa é entender bem a teoria e ter conhecimento prático.

Quais são os desafios comuns que os profissionais de Hadoop enfrentam em suas carreiras?

Os desafios comuns incluem garantir a segurança dos dados, otimizar o desempenho do cluster Hadoop, integrar várias fontes de dados, acompanhar os rápidos avanços tecnológicos e gerenciar e dimensionar clusters. A gestão eficiente dos recursos para evitar gargalos também é fundamental. Enfrentar esses desafios ajuda a impulsionar sua carreira como profissional de Hadoop.

Sou um estrategista de conteúdo que adora simplificar tópicos complexos. Ajudei empresas como Splunk, Hackernoon e Tiiny Host a criar conteúdo envolvente e informativo para seus públicos.